Материалы по тегу: ai

|

03.07.2025 [15:13], Руслан Авдеев

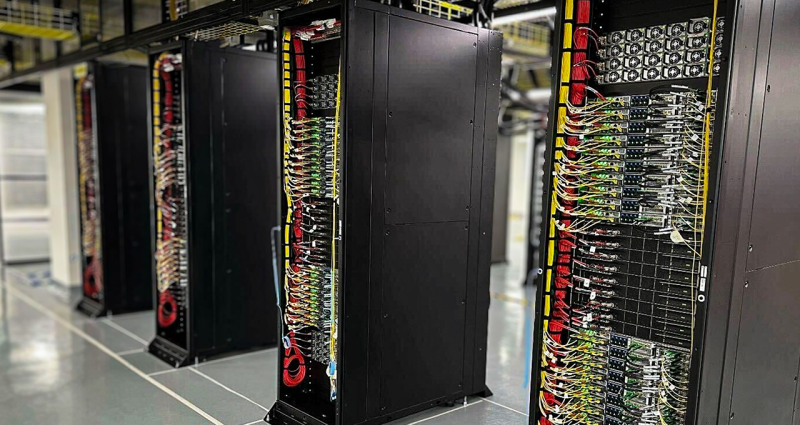

OpenAI арендует у Oracle ещё больше ИИ ЦОД в СШАOpenAI арендует ещё больше мощностей у Oracle в рамках инициативы Stargate. Это свидетельствует о повышении требований к передовым решениям в сфере искусственного интеллекта, сообщает Bloomberg. Как свидетельствуют «знакомые с вопросом» источники, пожелавшие остаться анонимными, OpenAI дополнительно арендует у Oracle 4,5 ГВт мощностей ЦОД в США. Ранее Oracle уже объявила, что подписано облачное соглашение, которое принесёт выручку в размере $30 млрд/год, начиная с 2028 года (помимо других контрактов). Заказчик назван не был, но по словам одного из источников, на данное соглашение приходится как минимум часть проекта Stargate, в котором участвуют OpenAI, Oracle, SoftBank и др. Кроме того, ранее сообщалось, что Oracle рассчитывает найти для OpenAI 5 ГВт мощностей к концу 2026 года Сейчас Oracle совместно с Crusoe строит в Абилине (Abilene, Техас) огромный дата-центр для OpenAI мощностью около 1,2 ГВт, которая со временем может быть доведена до 2 ГВт. Чтобы удовлетворить дополнительный спрос OpenAI, компания с партнёрами планирует несколько дата-центров по всей территории США. В частности, рассматриваются площадки в штатах Мичиган, Техас, Висконсин и Вайоминг в дополнение к расширению площадки в Абилине. Также, по данным одного из источников, OpenAI рассматривает площадки в Нью-Мексико, Джорджии, Огайо и Пенсильвании.

Источник изображения: Jan Folwarczny/unsplash.com Новые проекты станут частью Stargate, а но детали могут измениться. В OpenAI и Crusoe отказались от комментариев, не ответила на запросы и Oracle. После новостей акции Oracle выросли до рекордного максимума в $229,98. Всего в текущем году они подорожали на 38 %, во многом — благодаря энтузиазму инвесторов по поводу облачного бизнеса компании. Сейчас Oracle активно развивает бизнес сдачи в аренду вычислительных мощностей и облачных хранилищ, отчасти за счёт ориентации на клиентов, специализирующихся на работе с ИИ. Это привело к быстрому росту выручки, а также расходов компании. Известно, что сделка на $30 млрд превышает размер всего её текущего облачного бизнеса. Вместе с тем бурное строительство инфраструктуры Oracle создаёт значительную нагрузку на финансы компании и текущие расходы выше, чем ожидалось. Тем не менее, облачная стратегия оценивается экспертами в целом положительно.

24.06.2025 [16:11], Руслан Авдеев

OpenAI ищет управляющего энергетической политикойКомпания OpenAI ищет специалиста по энергетической политике. Должность в первую очередь предусматривает взаимодействие с федеральными властями и руководством отдельных штатов для продвижения энергетических интересов компании в США, сообщает Datacenter Dynamics. В новом объявлении на сайте OpenAI объявляется, что роль сотрудника связана с разработкой позиций и стратегий компании по ключевым вопросам энергетики, включая генерацию и потребление энергии, развитие возобновляемых источников, надёжность энергосетей, вопросы присоединения и регулирования, а также устойчивость инфраструктуры — для обеспечения экобезопасного и эффективного функционирования технологий компании. Роль предполагает выстраивание внутренних коммуникаций в компании, а также контакты с Министерством энергетики (DoE), регулятором FERC и другими госорганами, региональными сетевыми операторами вроде ERCOT, коммунальными службами, экозащитниками и партнёрами в сфере «чистой» энергии. Хотя основное внимание сотрудника должно уделяться внутриамериканским задачам, он также будет играть и ключевую роль в поддержке энергетической стратегии компании в международном контексте.

Источник изображения: LinkedIn Sales Solutions/unsplash.com На позицию могут претендовать кандидаты с 10–15 годами опыта работы, связанной с выстраиванием энергетической политики, инфраструктуры или устойчивого развития. В том числе рассматриваются бывшие государственные служащие, сотрудники коммунальных, энергетических компаний и т.п. Успешный соискатель может рассчитывать на компенсацию $280–$325 тыс. ежегодно и акционерный капитал. Как сообщает Datacenter Dynamics, вероятно, новый сотрудник поможет реализовать проект Stargate. Проект оценивается в $100-500 млрд и предусматривает строительство дата-центров в США и других странах, например, в ОАЭ и открытие офисов, в частности, в Южной Корее. Stargate, по сути, представляет собой комбинацию облачных контрактов, партнёрств и самостоятельных инициатив OpenAI. Что касается требуемых мощностей, в каждом случае необходима разная степень участия компании. Если проект будет реализован, его крупнейшие кампусы будут потреблять по 1–2 ГВт, что потребует тщательного планирования в сфере энергетики.

23.06.2025 [13:48], Руслан Авдеев

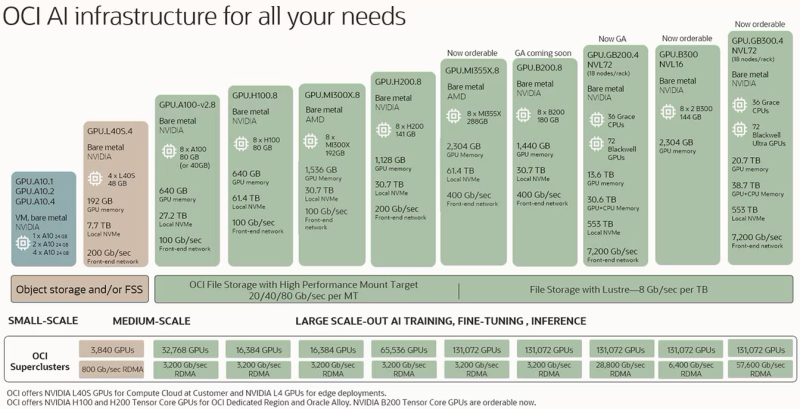

xAI воспользуется облаком Oracle для обучения и инференса GrokOracle частично раскрыла список компаний, использующих облачную инфраструктуру Oracle Cloud Infrastructure (OCI) для обучения ИИ-моделей и инференса. В их числе, несмотря на наличие собственных мощностей, оказался и стартап Илона Маска (Elon Musk) xAI, сообщает Datacenter Dynamics. xAI намерена использовать ИИ-инфраструктуру OCI для обучения моделей нового поколения, стоящих за чат-ботом Grok. Кроме того, OCI будет применяться и для инференса в интересах xAI. Также модели будут предлагаться через ИИ-сервис OCI, предлагающий доступ к моделям генеративного ИИ. По словам представителей xAI, Grok 3 знаменует собой прорыв в возможностях ИИ, а платформа Oracle ускорит его внедрение в корпоративном секторе. У xAI есть собственный ИИ-суперкомпьютер Colossus, который будет расширяться. Компания также намерена построить ещё один ЦОД. Правда, xAI столкнулась с судебным иском, связанным с увеличением мощности импровизированной электростанции из газовых генераторов.

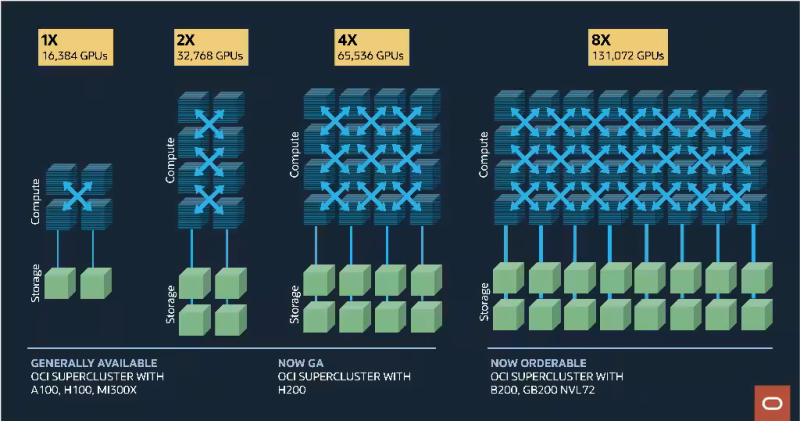

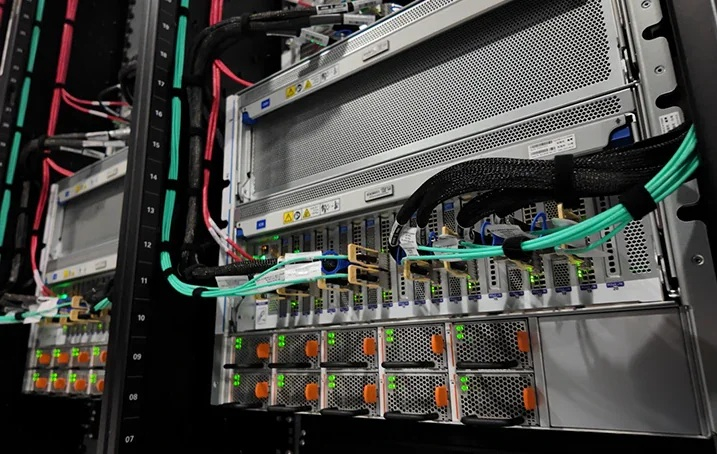

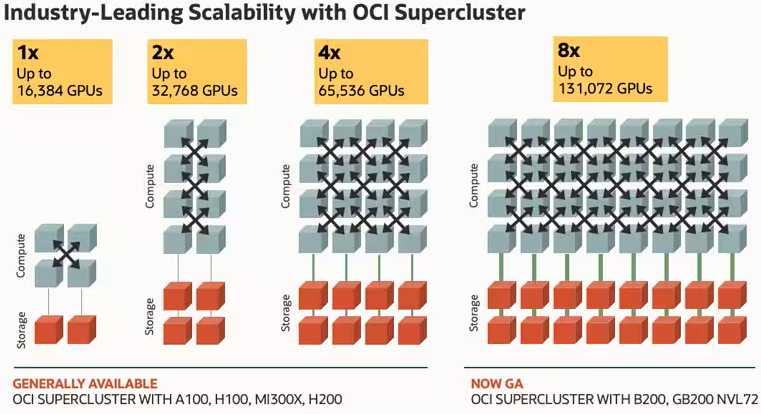

Источник изображения: xAI Помимо xAI клиентами Oracle является множество других компаний. Как сообщил облачный оператор, в их число входят Fireworks AI, Hedra, Numenta, Soniox и даже Meta✴, у которой тоже есть собственные вычислительные мощности. Представители OCI подчёркивают, что площадка является предпочтительным местом для обучения и инференса в любых масштабах. ИИ-инфраструктура OCI обеспечивает доступ к сверхскоростной сети, «оптимизированному» хранилищу и передовым ускорителям, на которые клиенты полагаются для очередных инноваций. Кроме того, Oracle является участником проекта Stargate.

19.06.2025 [16:13], Руслан Авдеев

Здесь ЦОД с ИИ, здесь Grok'ом пахнет: экоактивисты подали в суд на xAI за использование газовых турбин для суперкомпьютера ColossusОснованная Илоном Маском (Elon Musk) компания xAI столкнулась с судебным иском. Её обвиняют в нарушении «Закона о чистом воздухе» (US Clean Air Act) в Мемфисе. Именно там расположен ЦОД с ИИ-суперкомпьютером Colossus, для питания которого используются турбины на природном газе, сообщает Datacenter Dynamics. Истцами выступили НКО NAACP и SELC. Стартап обвиняют в незаконном использовании на объекте турбин, работающих на природном газе. Согласно иску, xAI не получала разрешений на эксплуатацию 26 турбин, установленных на объекте для обеспечения его электричеством. SELC ранее утверждала, что использование газовых турбин осуществлялось без оповещений местного населения и что оно наносит ему ущерб. В NCAAP заявили, что не могут позволить компаниям с оборотами в миллиарды долларов строить загрязняющие атмосферу производства без разрешений. Представители организации пообещали, что xAI не уйдёт от ответственности. В ответ компания заявляет, что имеют право на эксплуатацию турбин в течение 364 дней без отдельного разрешения, поэтому временные установки функционируют в соответствии с законами. Более того, компания намерена доработать турбины для сокращения выбросов в будущем. В SELC заявили, что для турбин таких временных исключений из правил не предусмотрено. Впрочем, срок в 364 дня уже всё равно истёк, а решение xAI установить и эксплуатировать десятки турбин, загрязняющих окружающую среду — явное нарушение Закона о чистом воздухе. В результате xAI можно привлечь к ответственности за незаконный отказ получать разрешения на газовые турбины.

Источник изображения: Call Me Fred/unsplash.com ЦОД, запущенный в июле 2024 года, имел начальную мощность 150 МВт. Объект подключили к электросети местной коммунальной службы TVA, но поначалу xAI выделили всего 8 МВт, поэтому компания развернула около ЦОД газовые турбины. В конце прошлого года подведённую мощность разрешили довести до 150 МВт. В апреле 2025 года выяснилось, что ЦОД увеличил количество число газовых турбин до 35 — это нарушение выданного разрешения на локальную генерацию, поскольку оно допускало использование только 15 турбин. Дополнительные установки обнаружили на аэрофотоснимках. Общая мощность агрегатов, по оценкам, составляет 422 МВт. После этого была продана жалоба в местный департамент здравоохранения, в которой заявлялось, что ЦОД из-за турбин стал крупнейшим промышленным источником азотных загрязнений NOx, формирующих смог в Мемфисе. С тех пор сообщалось, что xAI начала убирать некоторые турбины с площадки после ввода в эксплуатацию новой подстанции. Также было установлено 168 аккумуляторных хранилищ Tesla Megapack. Компания намерена построить в городе второй ЦОД и уже приобрела для этого участок площадью более 92 тыс. м2. Он расположен рядом с газовой электростанцией Southaven Combined Cycle, вырабатывающей 780 МВт электричества. Однако компании надо гораздо больше мощности и она, по-видимому, готова повторить тот же трюк, развернув десятки турбин суммарной мощностью 1,56 ГВт.

18.06.2025 [14:56], Руслан Авдеев

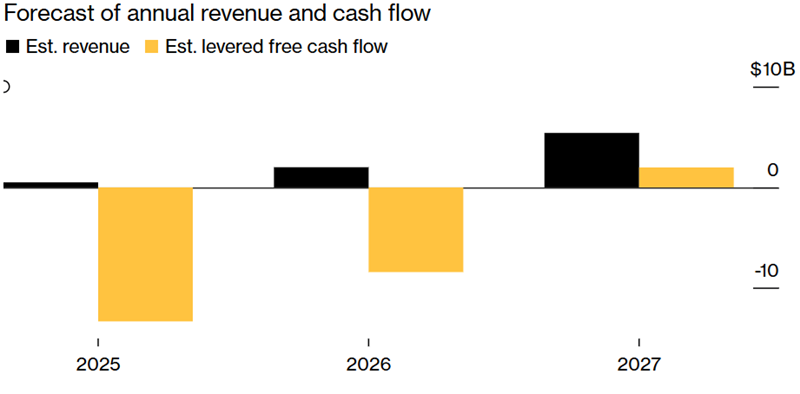

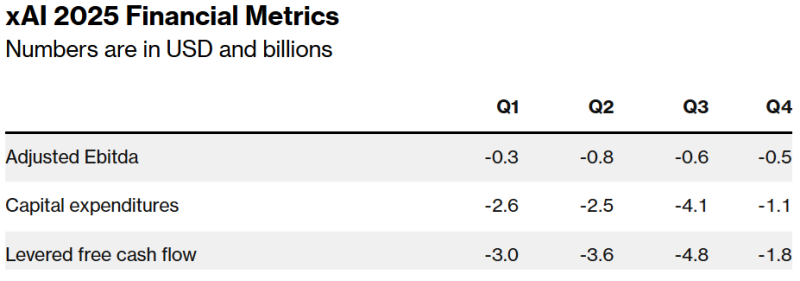

xAI Илона Маска ежемесячно «сжигает» $1 млрд в надежде на будущие прибылиСтартап xAI Илона Маска (Elon Musk) ежемесячно тратит $1 млрд, поскольку стоимость создания компанией передовых ИИ-моделей значительно выше его доходов. Скорость трат средств компанией наглядно демонстрирует огромные финансовые потребности отрасли ИИ, сообщает Bloomberg со ссылкой на собственные источники. Для того, чтобы компенсировать дисбаланс, xAI пытается привлечь $9,3 млрд в долг и в виде акционерного капитала. При этом компания уже намерена потратить более половины из этих средств в ближайшие три месяца. Всего в 2025 году xAI, стоящая за чат-ботом Grok, рассчитывает потратить $13 млрд, но пока её усилия по сбору средств едва поспевают за расходами. Отчасти подобная ситуация обусловлена огромными расходами, с которыми столкнулись все ИИ-компании при создании современных ЦОД и покупке ускорителей для обучения LLM. По данным экспертов Carlyle Group, к 2030 году для удовлетворения спроса на ИИ-инфраструктуру будет потрачено более $1,8 трлн. В компании CreditSights тоже уверены, что разработчики «сожгут много-много денег», поскольку пространство «очень конкурентное».

Источник изображения: Bloomberg При этом компания Маска пока не может зарабатывать столько, сколько OpenAI или Anthropic. Ни одна из этих компаний не раскрывает точных финансовых показателей, но ранее Bloomberg сообщал, что OpenAI ожидает выручить в 2025 году $12,7 млрд, тогда как xAI недавно объявила инвесторам, что в этом году её выручка составит лишь $500 млн, а в следующем — более $2 млрд. Сильная сторона xAI в том, что её глава Илон Маск, самый богатый человек в мире, не раз демонстрировал готовность тратить собственные средства на гигантские футуристические проекты задолго до того, как те начнут приносить деньги. В самой xAI, пытающейся создать «сверхразумный искусственный интеллект», способный конкурировать с людьми, считают, что компания имеет особые преимущества, которые позволят рано или поздно догнать конкурентов. Пока некоторые из компаний арендуют чипы и прочие мощности, xAI платит за большую часть инфраструктуры сама, а также пользуется ресурсами социальной сети X, которая тоже закупала ускорители. По словам Маска, xAI продолжит закупки новых чипов. После недавнего слияния xAI и X руководители ИИ-подразделения компании рассчитывают, что смогут обучать модели на архиве сообщений социальной сети, а не платить за массивы данных на стороне, как другие ИИ-компании. В результате xAI оптимистично рассчитывает стать прибыльной уже к 2027 году. Для сравнения, OpenAI предполагает «выйти в плюс» к 2029 году.

Источник изображения: Bloomberg Оптимистичные прогнозы, популярность Маска и его близость к властям в США привлекают инвесторов. Оценка xAI выросла до $80 млрд в конце I квартала, хотя в конце 2024 года она была на уровне $51 млрд. Среди инвесторов замечены Andreessen Horowitz, Sequoia Capital и VY Capital. Сейчас xAI спешит собрать достаточно денег, чтобы покрыть свои колоссальные расходы. По словам экспертов, с момента основания в 2023 году по июнь текущего компания привлекла $14 млрд акционерного капитала, из них на начало I квартала 2025 года оставалось лишь $4 млрд, оставшиеся средства компания рассчитывала потратить во II квартале. Сейчас компания завершает очередной раунд акционерного финансирования на $4,3 млрд и намерена привлечь ещё $6,4 млрд в следующем году, не считая долга в $5 млрд. Ожидается, что корпоративный долг поможет оплатить развитие ЦОД xAI. Компания также рассчитывает получить скидку в $650 млн от одного из производителей оборудования. По данным Bloomberg, уже есть первые признаки того, что xAI столкнулась с трудностями при привлечении инвестиций на первоначальных условиях. Инвесторы проявляли сдержанность, но после того, как компания изменила условия сделки в их пользу и предоставила дополнительную финансовую информацию, интерес к инвестициям вырос. Morgan Stanley, отвечающая за привлечение долговых средств xAI, отказалась от комментариев.

14.06.2025 [17:04], Владимир Мироненко

Scale AI получила от Meta✴ более $14 млрд, но потеряла гендиректора и рискует лишиться крупных контрактов с Gooogle, Microsoft, OpenAI и xAIИИ-стартап Scale AI, занимающийся подготовкой, оценкой и разметкой данных для обучения ИИ-моделей, объявил о крупной инвестиционной сделке с Meta✴, по результатм которой его рыночная стоимость превысила $29 млрд. Сделка существенно расширит коммерческие отношения Scale и Meta✴. Также её условиями предусмотрен переход гендиректора Scale AI Александра Ванга (Alexandr Wang) и ещё ряда сотрудников в Meta✴. Вместо Ванга, который останется в совете директоров стартапа, временно исполняющим обязанности гендиректора Scale AI назначен Джейсон Дроги (Jason Droege), директор по стратегии, имеющий «20-летний опыт создания и руководства знаковыми технологическими компаниями, включая Uber Eats и Axon». Представитель Scale AI уточнил в интервью ресурсу CNBC, что Meta✴ вложит в компанию $14,3 млрд, в результате чего получит в ней 49-% долю акций, но без права голоса. «Мы углубим совместную работу по созданию данных для ИИ-моделей, а Александр Ванг присоединится к Meta✴ для работы над нашими усилиями по созданию суперинтеллекта», — рассказал представитель Meta✴. Переманивая Ванга, который не имея опыта в R&D, сумел с нуля создать крупный бизнес в сфере ИИ, гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) делает ставку на его организаторские способности, полагая, что укрепить позиции Meta✴ в сфере ИИ под силу опытному бизнес-лидеру, больше похожему на Сэма Альтмана (Sam Altman), чем на учёных, стоящих у руля большинства конкурирующих ИИ-лабораторий, пишет Reuters. Инвестиции в Scale AI станут вторыми по величине в истории Meta✴ после приобретения WhatsApp за $19 млрд. Однако сделка может оказаться не совсем выгодной для Scale AI, предупреждает Reuters, поскольку многие компании, являющиеся клиентами Scale AI, могут отказаться от дальнейшего сотрудничества из-за опасений по поводу того, что Ванг, оставаясь в совете директоров стартапа, будет предоставлять Meta✴ внутреннюю информацию о приоритетах конкурентов. Представитель Scale AI заверил, что инвестиции Meta✴ и переход Ванга не повлияют на клиентов стартапа, и что Meta✴ не будет иметь доступа к его какой-либо деловой информации или данным. Тем не менее, по словам источников Reuters, Google, один их крупнейших клиентов Scale AI, планирует разорвать отношения со стартапом. Источники сообщили, что Google планировала потратить $200 млн только в этом году на услуги Scale AI по подгтовке и разметке данных людьми. После объявления о сделке поисковый гигант уже провёл переговоры с несколькими конкурентами Scale AI. Scale AI получила в 2024 году размере $870 млн, из них около около $150 млн от Google, утверждают источники. По их словам, другие крупные клиенты, включая Microsoft, OpenAI и xAI, тоже планируют отказаться от услуг Scale AI. Официальных подтверждений этой информации пока не поступало. А финансовый директор OpenAI заявил в пятницу, что компания, которой источники тоже приписывают намерение отказаться от услуг Scale AI, продолжит работать со стартапом, как с одним из своих многочисленных поставщиков данных.

14.06.2025 [00:52], Владимир Мироненко

Oracle пообещала построить больше облачных ЦОД, чем все конкуренты вместе взятыеАмериканская корпорация Oracle сообщила финансовые результаты IV квартала и всего 2025 финансового года, закончившегося 31 мая 2025 года. Выручка выросла на 11 % в годовом исчислении в IV квартале до $15,9 млрд при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $15,59 млрд. После публикации квартального отчёта акции Oracle выросли в четверг на 14 % до $201,38, впервые превысив отметку в $200, сообщило агентство Reuters. Чистая прибыль (GAAP) выросла до $3,43 млрд или $1,19 на разводнённую акцию с $3,14 млрд или $1,11 на разводнённую акцию годом ранее. Скорректированная чистая прибыль (Non-GAAP) за квартал равняется $4,88 млрд или $1,70 на разводнённую акцию, что выше консенсус-прогноза от LSEG в размере $1,64 на разводнённую акцию. В I квартале 2026 финансового года Oracle ожидает получить скорректированную прибыль (Non-GAAP) на акцию в размере $1,46–1,50 при росте выручки в диапазоне от 12 до 14 %. Аналитики, опрошенные LSEG, ожидают $1,48 скорректированной прибыли на акцию и $14,96 млрд выручки, что подразумевает рост год к году на 12,4 %. Выручка за IV финансовый квартал от облачных сервисов и поддержки лицензий выросла на 14 % до $11,7 млрд (74 % всей выручки), превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в размере $11,59 млрд. Выручка от лицензирования облачных и локальных продуктов увеличилась на 8 % до $2,01 млрд, превысив консенсус-прогноз StreetAccount в размере $1,82 млрд. Также увеличились, хотя и незначительно, продажи оборудования — на 1 % до $850 млн, но сократилась выручка от сервисов — на 2 % до $1,35 млрд. Между тем компания заявила, что её оставшиеся обязательства по исполнению (RPO), отражающие объём невыполненных работ, выросли на 41 % до $138 млрд.

Источник изображения: NVIDIA Что касается итогов за 2025 финансовый год, то выручка Oracle увеличилась на 8 % до $57,4 млрд. Доходы от облачных сервисов и поддержки лицензий выросли на 12 % до $44,02 млрд, выручка от лицензирования облачных и локальных продуктов выросла на 2 % до $5,20 млрд. Чистая прибыль (GAAP) за год составила $12,44 млрд или $4,34 на разводнённую акцию, а скорректированная чистая прибыль (Non-GAAP) — $17,28 млрд или $6,03 на разводнённую акцию. Генеральный директор Oracle Сафра Кац (Safra Catz) сообщила, что выручка от облачной инфраструктуры должна увеличиться в 2026 финансовом году более чем на 70 % (уже сейчас рост +52 % в отчётном квартале). Компания прогнозирует более $67 млрд выручки в 2026 финансовом году, что превышает консенсус-прогноз аналитиков от LSEG в размере $65,18 млрд. По словам Кац, компания намерена увеличить целевой показатель выручки в размере $104 млрд, установленный ею в сентябре прошлого года на 2029 финансовый год.

Источник изображения: Oracle Также гендиректор Oracle отметила, что капитальные затраты в 2025 финансовом году превысили $21 млрд по сравнению с менее чем $7 млрд в 2024 финансовом году, и в 2026 году должны превысить $25 млрд. «Мы делаем многое, чтобы снизить наши капитальные затраты, — сообщил председатель и технический директор Oracle Ларри Эллисон (Larry Ellison). — Но даже если мы это сделаем, капитальные затраты вырастут, потому что спрос сейчас кажется почти ненасытным». «Я никогда не видел ничего даже отдалённо похожего», — добавил он. Эллисон сообщил, что в настоящее время у компании 23 действующих ЦОД MultiCloud и ещё 47 будут построены в течение следующих 12 месяцев. «Мы ожидаем, что трёхзначный рост выручки MultiCloud продолжится в 2026 финансовом году. Выручка от Oracle Cloud@Customer выросла на 104 % по сравнению с прошлым годом. У нас 29 действующих выделенных ЦОД Oracle Cloud@Customer, и ещё 30 будут построены в 2026 финансовом году. Общий доход от Oracle Cloud Infrastructure вырос на 62 % в IV квартале», — рассказал технический директор. Он добавил, что доход от баз данных MultiCloud в облаках Amazon, Google и Azure вырос на 115 % по сравнению с предыдущим кварталом. Он также сообщил, что недавно Oracle получила заказ от неназванного клиента на всю доступную облачную ёмкость. «Мы никогда раньше не получали такого заказа, — цитирует Эллисона ресурс SiliconANGLE. — Мы сделали всё возможное, чтобы предоставить им необходимую ёмкость». Однако позже он отметил, что китайский интернет-ретейлер Temu, принадлежащий PDD Holdings, согласился перенести большой объём рабочих нагрузок в облачную инфраструктуру Oracle. Эллисон отметил, что сделка с Temu не имеет ничего общего с ИИ, чтобы продемонстрировать, что Oracle преуспевает по нескольким направлениям, включая её флагманскую базу данных, пишет The Register. Напомним, что Oracle сотрудничает с OpenAI, SoftBank Group и базирующейся в Абу-Даби MGX в проекте Stargate, в рамках которого, как ожидается, будет израсходовано в течение следующих пяти лет более $500 млрд на создание инфраструктуры ИИ ЦОД. Примечательно, что Сафра Кац оговорилась, что формально совместное предприятие Stargate всё ещё не создано. В частности, Softbank отложила инвестиции из-за новых пошлин США. Поэтому есть вероятность, что последние сделки Oracle в сфере ЦОД фактически также окажутся связаны со Stargate. В любом случае Stargate позволит частично оправдать рост капитальных расходов Oracle. Сам же Эллисон пообещал построить больше облачных ЦОД, чем все конкуренты вместе взятые.

11.06.2025 [16:12], Руслан Авдеев

OpenAI неожиданно заключила соглашение с Google CloudOpenAI планирует использовать вычислительные мощности Google Cloud. Несмотря на то, что OpenAI в сфере ИИ является прямым конкурентом Google, она намерена использовать эту облачную платформу, чтобы удовлетворить свои потребности в вычислительных ресурсах и диверсифицировать ресурсы, сообщает Reuters. Издание ссылается на информацию трёх источников, отмечая, что соглашение является неожиданным, поскольку подразделение DeepMind компании Google напрямую соперничает с OpenAI в сфере искусственного интеллекта, а ChatGPT с его новыми функциями представляет угрозу поисковым сервисам Google. Последняя, тем не менее предоставит, OpenAI дополнительные вычислительные мощности, чтобы помочь компании обучать и эксплуатировать свои ИИ-модели. Пока нет данных, станет ли OpenAI использовать фирменные TPU Google или будет применять в облаке только ускорители NVIDIA. В OpenAI и Microsoft не комментируют новость. Ранее Microsoft выступала эксклюзивным поставщиком облачных услуг ИИ-стартапу благодаря ранним инвестициям в компанию, но спрос на вычислительные мощности у OpenAI продолжал расти, опережая возможности Microsoft. Поэтому последняя отказалась от эксклюзивного сотрудничества с некоторыми условиями.

Источник изображения: Growtika/unsplash.com OpenAI объявила о проекте Stargate стоимостью $500 млрд в начале текущего года — компания действует в партнёрстве с SoftBank, Oracle и MGX из ОАЭ. Первый кампус строится в Абилине (Abilene, Техас). Предполагается, что Oracle купит для него около 400 тыс. ускорителей NVIDIA GB200. Изучается возможность и строительства кампусов Stargate в других местах, в том числе в ОАЭ. В мае 2025 года OpenAI уже подписала облачное соглашение с CoreWeave на сумму $4 млрд, это стало развитием более ранней сделки с компанией на сумму $11,9 млрд. На этой неделе компания TD Cowen выступила с предположением, что Oracle ищет в США 5 ГВт ЦОД-мощностей для OpenAI, и это помимо общего проекта Stargate. По данным источников Reuters, ранее OpenAI пыталась заключить сделку с Google Cloud, но ей помешали обязательства перед Microsoft.

10.06.2025 [14:44], Руслан Авдеев

В обход Stargate: Oracle рассчитывает найти для OpenAI 5 ГВт на обучение ИИ к концу 2026 годаКомпания Oracle намерена расширить присутствие на рынке дата-центров в США для поддержки рабочих нагрузок OpenAI. Как сообщают аналитики TD Cowen, особое внимание уделяется отдельным объектам мощностью порядка 1 ГВт, энергия которым будет доступна уже в конце 2026 и начале 2027 гг., сообщает Datacenter Dynamics. Партнерство Oracle и OpenAI отчасти обусловлено предпочтением OCI SuperClaster с RDMA-интерконнектом, обеспечивающим высокую пропускную способность и низкие задержки. Сотрудничество также способствует развитию уже существующего проекта OpenAI на базе кампуса Abilene Stargate в Абилине (Техас), построенном Crusoe и Oracle. Вместе с тем TD Cowen полагает, что новая пятилетняя сделка не связана со Stargate и была заключена напрямую между Oracle и OpenAI. В её рамках Oracle закупит мощности ЦОД, соответствующие требованиям OpenAI. За них Oracle будет взимать плату в размере $2,60–$3,00 за каждый ускоритель в час, при этом цены будут зависеть от типа чипов. Всего будет развёрнуто около 2,3 млн ускорителей. Ранее OpenAI заявляла, что намерена не только сотрудничать с партнёрами, но строить и собственные дата-центры. В TD Cowen пока не знают, есть ли у Oracle эксклюзивные права на обслуживание этих 5 ГВт или за них придётся побороться с другими провайдерами. Также известно, что OpenAI подписала соглашение на $12 млрд с CoreWeave, а затем ещё на $4 млрд. Не исключено, что последняя также поборется за контракт.

Источник изображений: Oracle В TD Cowen считают, что вне зависимости от того, кто будет исполнителем, предоставившим необходимые 5 ГВт, это позволит отрасли аренды ЦОД в США добиться рекордных показателей уже в 2025 году. Впрочем, в компании сомневаются, что к концу 2026 году в стране наберётся пять полностью запитанных площадок мощностью 1 ГВт каждая — не считая тех мощностей, которыми располагают некоторые бывшие майнеры криптовалют, сейчас преобразующие их для HPC.  По оценкам компании, капитальные затраты на ускорители составят $92 млрд (из расчёта $42 тыс./шт.), капитальные затраты на ЦОД составят ещё $67 млрд (из расчёта $13,5 млн/МВт). В сумме получает $159 млрд, так что не исключено привлечение сторонних инвесторов. Хотя сделка не обсуждалась в рамках проекта Stargate, вполне возможно, что часть средств будет получено именно от него. На Stargate в США рассчитывают потратить до $500 млрд, также планируется реализация аналогичных проектов по всему миру. Так, в ОАЭ намерены реализовать такой проект. В TD Cowen рассчитывают, что мощность Stargate за рубежом составит 5 ГВт, проект будет подкреплён инвестициями со стороны ряда стран, по некоторым данным, рассматривались Израиль и Малайзия. Сейчас эмиссар OpenAI совершает поездку по Азиатско-Тихоокеанскому региону, ведя переговоры в Индии, Южной Корее, Австралии и Сингапуре. В Европе OpenAI ведёт переговоры с Великобританией, Францией и Германией.

06.06.2025 [17:58], Руслан Авдеев

AMD купила команду разработчика ИИ-чипов Untether AI, но не саму компанию, которая тут же закрыласьКомпания AMD объявила об очередной за несколько дней корпоративной покупке. Она наняла неназванное количество сотрудников Untether AI, разрабатывающей ИИ-чипы для энергоэффективного инференса в ЦОД и на периферии, сообщает Silicon Angle. Первым информацией о сделке поделился представитель рекрутинговой компании SBT Industries, специализирующейся на полупроводниковой сфере. Позже в AMD подтвердили, что компания приобрела «талантливую команду инженеров по аппаратному и программному ИИ-обеспечению» у Untether AI. Новые сотрудники помогут оптимизировать разработку компиляторов и ядер ИИ-систем, а также улучшить проектирование чипсетов, их проверку и интеграцию. Вероятно, сделку завершили в прошлом месяце, причём в команду не вошёл глава Untether Крис Уокер (Chris Walker), перешедший в стартап из Intel и возглавивший его в начале 2024 года. Судя по информации из соцсетей, Уокер покинул компанию в мае. Сделка довольно необычна, поскольку никаких активов компании не покупалось, но Untether AI уже объявила о закрытии бизнеса и поставок или поддержки чипов speedAI и ПО imAIgine Software Development Kit (SDK).

Источник изображения: Untether AI Untether AI была основана 2018 году в Торонто (Канада). В июле 2021 года стартап привлёк $125 млн в раунде финансирования, возглавленном венчурным подразделением Intel Capital. Компания разрабатывала энергоэффективные чипы для инференса для периферийных решений, потребляющих мало энергии. В одной упаковке объединялись модули для вычислений и память. В октябре 2024 года начала продажи чипа speedAI240 Slim (развитие speedAI240). speedAI240 Slim, по данным компании, втрое энергоэффективнее аналогов в сегменте ЦОД. Помимо Intel, Untether AI имела партнёрские отношения с Ampere Computing, Arm Holdings и NeuReality. Буквально в минувшем апреле Уокер сообщил журналистам, что компания отметила большой спрос на свои чипы для инференса со стороны покупателей, ищущих альтернативы продуктам NVIDIA с более высокой энергоёмкостью. Более того, в прошлом году компания договорилась с индийской Ola-Krutrim о совместной разработке ИИ-ускорителей не только для инференса, но и для тюнинга ИИ-моделей. Покупка состоялась всего через два дня после объявления о приобретении малоизвестного стартапа Brium, специализировавшегося на инструментах разработки и оптимизации ИИ ПО. Вероятно, AMD заинтересована в использовании его опыта для оптимизации инференса на отличном от NVIDIA оборудовании. Сделка с Brium состоялась всего через шесть дней после того, как AMD объявила о покупке разработчика систем кремниевой фотоники Enosemi. Это поможет AMD нарастить компетенции в соответствующей сфере, поскольку всё больше клиентов пытаются объединять тысячи ускорителей для поддержки интенсивных ИИ-нагрузок. |

|