Материалы по тегу: ai

|

23.07.2025 [15:46], Руслан Авдеев

Илон Маск объявил, что ИИ-суперкомпьютер xAI Colossus 2 запустят в ближайшие неделиОснователь ИИ-стартапа xAI Илон Маск (Elon Musk) поделился в социальной сети X информацией о будущем второго кампуса ЦОД в Мемфисе (Теннесси). В числе прочего он объявил намерении запустить в эксплуатацию суперкомпьютер Colossus 2 в ближайшие недели, сообщает Commercial Appeal. По его словам, Colossus 2 получит 550 тыс. ИИ-ускорителей. Компания располагает в городе двумя кампусами — Colossus 1 и Colossus 2. Первый расположен на территории бывшего завода Electrolux и включает 230 тыс. укорителей, в том числе 30 тыс. NVIDIA GB200. Система используется только для обучения, инференс осуществляется в облаках партнёров xAI. Второй кампус, Colossus 2 на площадке Тулейн-роуд (Tulane Road), на первом этапе получит 110 тыс. GB200 и GB300, что потребует 170 МВт энергии. Он должен начать работу в течение нескольких недель. Сроки развёртывания оставшихся 440 тыс. ускорителей не определены, поскольку поставки NVIDIA GB300 задерживаются. В феврале дочерняя структура xAI, компания CTC Property, купила более 75 га вдоль Тулейн-роуд за $70,9 млн. С тех пор, как xAI объявил о планах довести количество ускорителей Colossus до 1 млн, всё чаще возникает вопрос, как именно компания намерена снабжать свой проект энергией. В мае Маск объявил, что Colossus 2 станет первым гигаваттным ИИ-кластером. 15 июля в xAI подтвердили, что компания работает с Memphis Light, Gas and Water (MLGW) и Tennessee Valley Authority (TVA) над обеспечением объекта питанием. MLGW подтвердила, что у неё есть договор на поставку 500 кВт объекту xAI на Тулейн-роуд. А 16 июля MXZ Tech LLC, дочерняя компания xAI, приобрела территорию бывшей электростанции Duke Energy (46 га) неподалёку от кампуса Colossus 2. Этот объект сохранил подключение к энергосети TVA. Кроме того, кампус Colossus 2 уже получил 168 модулей Tesla Megapacks. По-видимому, этот кампус тоже не обойдётся без газовых турбин, и использование которых для питания Colossus 1 вызвало недовольство местных экоактививстов NAACP и SELC. Впрочем, пока непонятно, состоится ли серьёзное разбирательство. Совсем недавно Илон Маск сообщил о намерении ввести в эксплуатацию эквивалент 50 млн NVIDIA H100 в течение пяти лет — это ответ на недавнее заявление OpenAI о намерении освоить более 1 млн ускорителей к концу текущего года, а в будущем получить в своё распоряжение 100 млн ускорителей. Сейчас xAI намерена найти ещё $12 млрд на закупку ускорителей.

23.07.2025 [01:39], Владимир Мироненко

Oracle поставит OpenAI два миллиона ИИ-чипов для ЦОДOpenAI объявила о заключении соглашения с Oracle о строительстве дополнительных ЦОД мощностью 4,5 ГВт в США в рамках расширенного партнёрства, что станет дальнейшим развитием проекта Stargate. OpenAI пока не назвала площадки для этих ЦОД, но рассматриваются штаты, Мичиган, Висконсин и Вайоминг, пишет Bloomberg. Компания сообщила, что с учётом строящегося объекта в Абилине (штат Техас), общая мощность дата-центров Stargate в США составит более 5 ГВт, и в них будет использоваться более чем 2 млн чипов для ИИ-задач. Ранее в этом месяце стало известно о планах OpenAI арендовать дополнительные мощности ЦОД у Oracle. В январе OpenAI, Oracle и SoftBank Group объявили о намерении инвестировать $500 млрд в развёртывание ИИ-инфраструктуры на 10 ГВт в США в течение следующих четырёх лет. Теперь OpenAI заявляет, что рассчитывает превысить это обязательство «благодаря сильной динамике сотрудничества с такими партнёрами, как Oracle и SoftBank». Как отметил Bloomberg, хотя OpenAI назвала строительство дополнительных ЦОД совместно с Oracle частью проекта Stargate, SoftBank не участвует в его финансировании. В мае Bloomberg сообщил, что SoftBank столкнулась с трудностями в переговорах о финансировании проекта на фоне общей экономической неопределенности, связанной с пересмотром пошлин США. OpenAI также рассказала о ходе строительства кампуса Stargate I в Абилине (Техас), где часть объекта уже введена в эксплуатацию. Oracle начала поставлять первые стойки с чипами NVIDIA GB200 в прошлом месяце, и часть ЦОД уже работает несколько недель, сообщила компания. Также OpenAI отметила, что Microsoft продолжит предоставлять облачные сервисы для неё, в том числе через Stargate.

22.07.2025 [17:22], Руслан Авдеев

xAI купила за $10 территорию бывшей газовой электростанции неподалёку от будущего ИИ ЦОДxAI приобрела бывшую газовую электростанцию Duke Energy в Саутхейвене (Southaven, Миссисипи), неподалёку от нового дата-центра в Мефисе (Теннесси). Точнее говоря, то, что от неё осталось. Главную ценность представляют земля и коммуникации, сообщает Datacenter Dynamics. Площадка находится на Стентон-роуд (Stanton Road) в штате Миссисипи, в нескольких километрах от Тулейн-роуд (Tulane Road), где xAI намерена возвести ЦОД площадью более 90 тыс. м2, который станет частью уже действующего суперкомпьютера Colossus. xAI уже эксплуатирует дата-центр в Мемфисе и недавно получила разрешение на использование газовых турбин на площадке на постоянной основе, к большому сожалению местных активистов. Ранее местные СМИ сообщали, что бывшая электростанция с территорией была куплена калифорнийской MZT Tech LLC. По официальным данным, xAI контролирует её деятельность. По данным местных властей, формально xAI приобрела собственность у некой Джули Джеймс (Julie M. James) за $10 наличными. Ранее сотрудников xAI уже замечали на площадке, но представитель xAI заявил, что компания не раскрывает происходящего на территории бывшей электростанции. На тот момент, по его словам, сделка была «всё ещё на стадии обсуждения». Электростанция на территории 46 га в Саутхейвене была построена Duke Energy в 2003 году и в своё время могла обеспечить до 640 МВт. Позже владелец продал объект, наряду с семью другими газовыми электростанциями на северо-востоке США, компании Kgen Partners за $475 млн. Спутниковые изображения свидетельствуют, что на площадке осталось немного инфраструктуры, но сохранились подключения к коммунальным сетям — электричеству, газу и воде. Фактически площадка имеет подключение к 200-МВт газовой электростанцией Southaven, управляемой Tennessee Valley Authority (TVA). Компании, похоже, приходится рассматривать самые необычные сценарии для обеспечения своих потребностей в энергии. Пару недель назад её основатель Илон Маск (Elon Musk) заявил, что намерен купить электростанцию за границей и импортировать её в США для обеспечения своих дата-центров электричеством.

22.07.2025 [10:29], Руслан Авдеев

Великобритания и OpenAI подписали новое соглашение о стратегическом сотрудничествеВласти Великобритании подписали с компанией OpenAI договор о новом стратегическом партнёрстве для углубления сотрудничества в области исследований аспектов ИИ-безопасности. Также будут изучаться возможности инвестиций OpenAI в британскую ИИ-инфраструктуру, сообщает Reuters. По словам представителя правительства, искусственный интеллект будет играть основополагающую роль для изменений по всей стране — от улучшения работы системы здравоохранения до устранения барьеров, мешающих экономическому росту. Власти считают, что добиться этого невозможно без компаний вроде OpenAI, которые продвигают новую технологическую революцию на международном уровне. Благодаря новому соглашению значительная часть соответствующих работ будет проводиться в Великобритании. Правительство намерено организовать инвестиции £1 млрд в вычислительную инфраструктуру для развития ИИ, рассчитывая увеличить публичные вычислительные мощности в 20 раз в течение следующих пяти лет.

Источник изображения: Ian Taylor/unsplash.com В гонке технологий искусственного интеллекта в лидеры выходят США, Китай и Индия, а Европа играет роль «догоняющего». Партнёрство с OpenAI, чье взаимодействие с Microsoft в своё время привлекло внимание британского регулятора, возможно, позволит компании расширить лондонский офис и изучить возможность применения ИИ в самых разных областях — при отправлении правосудия, в обороне, для обеспечения безопасности и в образовательных целях. Глава OpenAI Сэм Альтман похвалил правительство за то, что оно признало потенциал ИИ-технологий в рамках проекта AI Opportunities Action Plan, инициатива в реализации которого принадлежит британскому премьеру, планирующему превратить страну в «ИИ-сверхдержаву» — для этого рассматривается даже создание новых АЭС. Правительство лейбористов не особенно справляется с обеспечением экономического роста в первый год у власти и теперь заявляет, что ИИ может повысить производительность на 1,5 % в год, что принесёт £47 млрд ($63,37 млрд) ежегодно в течение десятилетия.

21.07.2025 [18:58], Владимир Мироненко

xAI ищет разработчиков кастомных чипов для ИИ-системИИ-стартап xAI Илона Маска (Elon Musk) разместил вакансии для разработчиков кастомных полупроводников, сообщил ресурс DataCenter Dynamics (DCD). Стартап ищет сотрудников для «создания ИИ-систем нового поколения, охватывающих весь спектр, от полупроводниковых чипов до компиляторов и моделей». Круг должностных обязанностей специалистов включает «разработку и доработку новых аппаратных архитектур для расширения границ вычислительной эффективности», а также использование ИИ в процессе проектирования оборудования. От кандидатов на должность ожидается знание инструментов для создания чипов, таких как Chisel, а также VHDL и Verilog. В идеале претенденты должны иметь опыт «симуляции обучающих рабочих нагрузок на новых аппаратных ИИ-архитектурах». Соответствующий требованиям сотрудник присоединится к команде xAI, работающей над «созданием ИИ-систем нового поколения, которые обеспечат революционную эффективность и масштабируемость на новом оборудовании, компиляторах и моделях».

Источник изображения: xAI Как полагает DCD, команду, о которой идёт речь, возглавляет Сяо Сан (Xiao Sun), ранее работавший в Meta✴, а до этого занимавшийся разработкой аппаратного обеспечения и алгоритмов машинного обучения, а также CMOS-устройств в IBM. DCD отметил, что на данный момент неясно, сотрудничает ли xAI с другой компанией в разработке полупроводниковых чипов, как, например, Google и OpenAI, которые работают с Broadcom над созданием семейства TPU и ИИ-чипа соответственно. Компания Tesla, в которой Маск является крупнейшим акционером, также разработала собственный чип — Dojo D1, ориентированный на обработку видеоданных для обучения полуавтономных автомобилей. Однако большая часть команды, стоящей за чипом Dojo D1, покинула Tesla, и его будущее туманно. Илон Маска показал систему в 2024 году. Годом ранее Маск заявил, что чип используется из-за нехватки ускорителей NVIDIA: «Честно говоря, я не знаю, смогут ли они поставить нам достаточно графических процессоров — возможно, Dojo нам и не нужен, — но они не смогут». Как и Tesla, xAI использует значительное количество ускорителей NVIDIA для своих вычислительных задач, более 200 тыс. из них входят в состав суперкомпьютера Colossus в Мемфисе (США). Маск надеется расширить Colossus до миллиона ускорителей. В свою очередь, xAI приобрела участок под второй дата-центр в Мемфисе.

17.07.2025 [15:47], Руслан Авдеев

OpenAI воспользуется услугами Google Cloud для поддержки ИИ-нагрузокOpenAI воспользуется услугами Google Cloud для обработки своих ИИ-нагрузок, сообщает Silicon Angle. Не так давно в OpenAI признали, что компании не хватает мощностей для работы ChatGPT и других продуктов. Google Cloud поддержит бизнес OpenAI в США, Великобритании, Нидерландах, Норвегии и Японии. Сделка косвенно свидетельствует о нарастающих разногласиях OpenAI и Microsoft. Ранее первая пользовалась исключительно Microsoft Azure для доступа к ИИ-ускорителям. В 2024 году Microsoft объявила, что считает OpenAI конкурентом, хотя и остаётся одним из ключевых спонсоров компании, вложившим в неё миллиарды долларов. Microsoft предлагает собственные ИИ-сервисы, часть которых основана на решениях OpenAI. Эти решения во многом конкурируют с предлагаемыми OpenAI. В январе Microsoft объявила, что компания больше не будет эксклюзивным облачным поставщиком OpenAI, но сохранит право им стать в приоритетном порядке при выборе из нескольких кандидатов, если партнёру будут нужны дополнительные вычислительные ресурсы. При этом компания по-прежнему обладает исключительными правами на API OpenAI.

Источник изображения: Daniel Páscoa/unsplash.com Это дало OpenAI возможность найти облачные мощности, превышающие возможности Microsoft. В список поставщиков облачной инфраструктуры входят Microsoft, Oracle и CoreWeave, а теперь и Google. Для Google Cloud это большая победа, поскольку сервис не настолько крупный как AWS или Azure. При этом Google тоже конкурирует с OpenAI, а бот Gemini часто рассматривается как альтернатива ChatGPT. Впрочем, Google Cloud расширяет свой ИИ-бизнес. Например, она стала поставщиком стартапа Anthropic, который активно поддерживается AWS. В 2024 году OpenAI объявила о партнёрстве с Oracle Cloud Infrastructure для доступа к дополнительным ускорителям. Заявление сделано вскоре после того, как Oracle объявила о партнёрстве с Microsoft для запуска Azure AI в своём облаке, в частности, для поддержки OpenAI. Затем обе компании поддержали инициативу Stargate, предусматривающую создание ИИ-мощностей в США на $500 млрд в ближайшие пять лет. В марте OpenAI объявила о пятилетнем соглашении c CoreWeave на $12 млрд.

17.07.2025 [13:09], Руслан Авдеев

xAI ведёт с Humain переговоры о создании ИИ ЦОД в Саудовской АравииИИ-стартап xAI Илона Маска (Elon Musk) ведёт переговоры об аренде мощностей ЦОД в Саудовской Аравии. Это часть стратегии по расширению инфраструктуры компании в регионах, предлагающих дешёвую электроэнергию и «политическую лояльность», сообщает Bloomberg. По данным источников издания, компания ведёт предварительные переговоры с саудовской Humain, способной дать xAI несколько гигаватт, а также ещё одной компанией, строящей объект всего на 200 МВт, который будет доступен уже в ближайшее время. В обоих случаях xAI будет только арендовать мощности для работы со своими ресурсоёмкими ИИ-моделями. Представители самих компаний ситуацию не комментируют. Проект Humain может быть связан с предыдущими инвестициями Саудовской Аравии в xAI, страна и её власти прилагают большие усилия для укрепления связей с предприятиями Илона Маска.

Источник изображения: Damir Babacic/unsplash.com В течение следующих пяти лет Humain намерена построить в Саудовской Аравии несколько ИИ ЦОД мощностью до 500 МВт, которые получат сотни тысяч передовых ускорителей NVIDIA. Компания финансируется Государственным инвестиционным фондом Саудовской Аравии (Saudi’s Public Investment Fund), но ещё не приступила к строительству значительной части инфраструктуры, которую собиралась представить клиентам. Поэтом соглашение с xAI имеет смысл в долгосрочной перспективе.

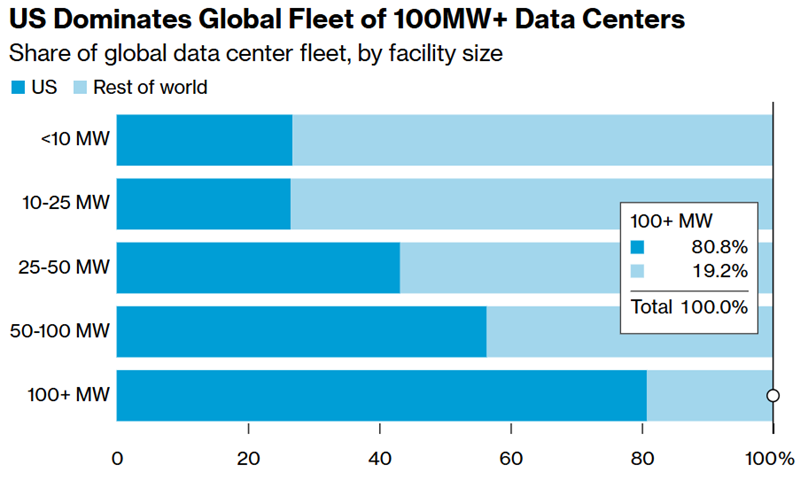

Источник изображения: BloombergNEF По данным источников, Маск ищет регионы с дешёвой электроэнергией и обилием капитала. Задача особенно актуальна на фоне обострения политической и коммерческой напряжённости непосредственно в США, где Маск вступил в конфликт с президентом и регуляторами. xAI уже построила огромный ЦОД в Мемфисе, а также анонсировал строительство второго ЦОД поблизости. Не так давно xAI закрыла раунд финансирования на сумму $10 млрд — за счёт акционерного капитала и заёмных средств. На прошлой неделе Маск сообщил, что у стартапа «много капитала», но механизмы его распределения ещё формируются. xAI также рассматривает возможность строительства ИИ ЦОД в ОАЭ и уже связывалась с G42. В самой G42 информацию не комментируют. Пока что G42 и OpenAI намерены построить в ОАЭ крупнейший ИИ ЦОД проекта Stargate. Источники сообщают, что xAI также рассматривала возможность строительства ЦОД в африканских странах, где есть доступ к недорогой энергии и ниже эксплуатационные расходы. Впрочем, как утверждает один из источников, доступность государственных инвестиций в Саудовской Аравии и возможность страны закупать передовые ИИ-ускорители делают её более привлекательным вариантом для xAI.

15.07.2025 [21:45], Руслан Авдеев

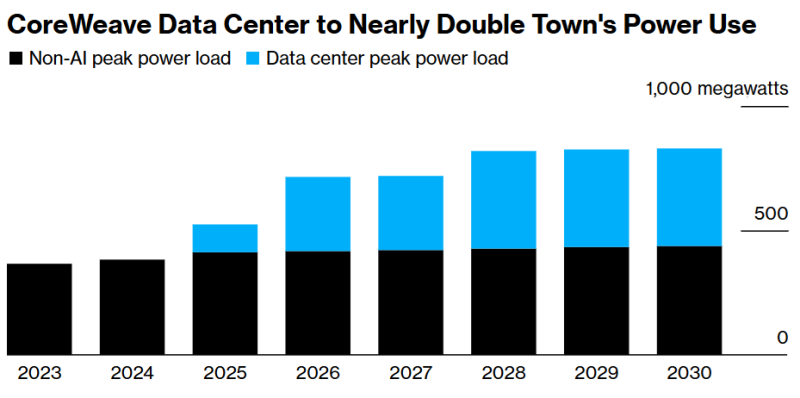

Всё ради OpenAI: дата-центр CoreWeave удвоит энергопотребление техасского городкаКомпания CoreWeave расширит дата-центр в техасском городе Дентон (Denton) в интересах OpenAI. В результате, как прогнозируют эксперты, это удвоит энергопотребление расположенного близ Далласа города — наглядное свидетельство того, как ИИ ЦОД влияют на современную энергосистему, сообщает Bloomberg. Согласно презентации конца 2024 года и электронной корреспонденции, с которой удалось ознакомиться Bloomberg, из-за дата-центра местным властям придётся решать проблему выросшей нагрузки на электросеть. ЦОД строится Core Scientific и будет использоваться OpenAI. При этом буквально на днях CoreWeave объявила о приобретении Core Scientific примерно за $9 млрд ради получения прямого контроля над её кампусами. Население Дентона, расположенного приблизительно в 80 км от Далласа, за последние четверть века почти удвоилось, увеличившись до 166 тыс. человек. Чтобы удовлетворить выросший спрос на электричество, связанный с ИИ-проектами, город перекладывает дополнительные расходы на оператора ЦОД и строит дополнительную сетевую инфраструктуру. По словам представителя коммунальной компании Denton Municipal Electric, для полного обеспечения ЦОД Core Scientific, придётся вложить дополнительные средства в ЛЭП.

Источник изображения: Nils Huenerfuerst/unsplash.com Как и некоторые другие крупные проекты ИИ ЦОД, площадка в Дентоне изначально была ориентирована на майнинг, но в декабре 2024 года было решено сменить её профиль и переключиться на обслуживание ИИ-инфраструктуры. При этом электричества понадобится больше — дата-центр не будет сокращать работу в периоды, когда цены на электроэнергию особенно высоки, что увеличит нагрузку на электросеть. Дата-центр Core Scientific в Дентоне станет крупнейшим объектом компании с потреблением около 390 МВт, на него уйдёт большая часть резервных мощностей города. По данным местных коммунальных служб, это создаст значительную нагрузку на энергосистему, и подключение новых крупных потребителей может привести к перегрузкам. Проблему отчасти планируют смягчить установкой резервных генераторов и аккумуляторов. Дата-центры — крупнейший драйвер энергопотребления в Техасе, новый закон обязывает их использовать резервные генераторы или сокращать нагрузку в чрезвычайных ситуациях.

Источник изображения: Bloomberg ЦОД в Дентоне не получил значимых налоговых льгот. Местные власти ожидают, что объект принесёт более $600 млн в виде налогов. Кроме того, ожидается создание 135 рабочих мест. При этом местный проект гораздо скромнее дата-центра Crusoe в Абилине (Abilene), мощность которого составит 1,2 ГВт. Он создаётся в рамках проекта Stargate при участии Oracle и в интересах OpenAI. Но и он теряется на фоне дата-центра AWS в Индиане, который будет потреблять энергии как половина населения штата. По данным февральского отчёта техасских властей, уже в 2026 году плановые резервы энергосистемы штата могут опуститься буквально до отрицательных значений — энергии будет не хватать из-за дата-центров, нефтегазовых объектов и майнинга криптовалюты. По данным НКО Texas Reliability Entity, оценивающей надёжность систем электроснабжения, огромный новый спрос представляет большую проблему, которая потребует превентивного реагирования, чтобы обычные жители штата не остались без доступа к электричеству. В конце 2024 года Министерство энергетики США сообщало, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. В июне 2025 года регулятор North American Electric Reliability Corp. (NERC) объявил, что подключение к сетям ЦОД в настоящее время весьма рискованно, поскольку дата-центры несут угрозу электросетям США из-за своей непредсказуемости.

09.07.2025 [16:44], Руслан Авдеев

Mistral AI хочет привлечь $1 млрд для конкуренции с OpenAIФранцузский ИИ-стартап Mistral AI ведёт переговоры с базирующимся в Абу-Даби (ОАЭ) фондом MGX и другими структурами о привлечении до $1 млрд акционерного капитала, сообщает Bloomberg со ссылкой на осведомлённые источники. По информации источников, кроме акционерного финансирования Mistral пытается привлечь сотни миллионов евро в кредит — переговоры ведутся с французскими компаниями, включая Bpifrance SACA. На данный момент Bpifrance уже является инвестором Mistral AI. Пока переговоры носят предварительный характер и условия возможной сделки могут быть изменены. Нет точных данных, какой станет капитализация компании после привлечения инвестиций. В самих Mistral, MGX и Bpifrance информацию пока не комментируют. Предполагается, что сделка укрепит связи Франции и ОАЭ в сфере ИИ, где в последнее время всё отчётливее доминируют США и Китай. Mistral — крупнейший в Европе ИИ-стартап, с момента основания в 2023 году привлёкший более €1 млрд ($1,17 млрд). Его капитализация составила $5,8 млрд после прошлогоднего раунда финансирования. Впрочем, компания не успевает угнаться за конкурентами вроде американской OpenAI, поэтому старается переориентироваться на индивидуальные сервисы. Тем не менее, она сохраняет ключевую роль в планах Франции добиться суверенитета в сфере ИИ. Mistral, MGX и NVIDIA уже объединили усилия для строительства крупнейшего в Европе кампуса ИИ ЦОД, а власти ОАЭ обещали выделить €50 млрд на ИИ-проекты в стране.

Источник изображения: Rodrigo Kugnharski/unsplash.com Французские официальные лица заявили, что MGX предоставит первоначальный капитал для инвестиций ОАЭ. Этот фонд является активным инвестором в ИИ и уже поддерживал OpenAI и xAI. Также это участник проекта Stargate, курируемого OpenAI и другого мегафонда для ЦОД, в который входят NVIDIA и Microsoft. Ранее в этом году руководство Mistral заявило, что компания потратит несколько миллиардов евро на вычислительные мощности. В том числе предусмотрено строительство ЦОД, оснащённого новейшими чипами, близ Парижа. В июне 2025 года NVIDIA объявила о намерении содействовать развитию ИИ-облака Mistral Compute во Франции с использованием 18 тыс. новых ускорителей Grace Blackwell. По данным источников, знакомых с планами Mistral, заёмные средства, о которых компания ведёт переговоры, будут истрачены на Mistral Compute. Инвесторами Mistral уже являются Microsoft и американские венчурные фонды Lightspeed Venture Partners, General Catalyst и Andreessen Horowitz.

05.07.2025 [14:25], Руслан Авдеев

Маску дали разрешение на 15 турбин для питания ИИ-суперкомпьютера xAI Colossus, но на снимках по-прежнему видны 24 турбиныПосле нескольких напряжённых месяцев, во время которых эксплуатация газовых турбин на площадке xAI была под вопросом, компания всё-таки получила разрешение на работу нескольких генераторов для питания своего ИИ-суперкомпьютера Colossus в Мемфисе (Теннесси, США). Тем не менее, экоактивисты утверждают, что дело не закончено, сообщает Ars Technica. В минувшую среду Департамент здравоохранения округа Шелби выдал xAI разрешение на определённый объём выбросов, позволяющее эксплуатировать 15 турбин. Срок разрешения истекает 2 января 2027 года, а от xAI требуется уже к 1 сентября установить систему контроля выбросов (BACT). При этом любые нарушения могут привести к санкциям со стороны властей. Жители Мемфиса требуют от властей расследования деятельности xAI, более года эксплуатирующей турбины без BACT. В июне ассоциация NAACP пригрозила компании судебным иском, если xAI откажется от встречи с активистами, обеспокоенными вероятным загрязнением воздуха. Как заявили юристы SELC, представляющие интересы NAACP и уже подававшие иск против xAI, сам факт требования установки BACT не успокаивает потенциальных пострадавших. Проблема в том, что разрешение на выбросы, вероятно, не распространяется на все газовые турбины, стоящие на площадке xAI. На спутниковом снимке от 1 июля видно, что всего на объекте установлены 24 генератора (а было и вовсе 35), хотя только для 15 из них есть разрешение. Утверждается, что даже одна турбина без BACT выбрасывает вещества, вызывающие приступы астмы, проблемы с сердцем и даже онкологические заболевания. При этом данная местность и без того не соответствует многим национальным стандартам, касающимся выбросов. Уровень заболевания астмой и раком здесь в четыре раза выше, чем в среднем по стране. SELC обвиняет власти в закрытии глаз на явные нарушения «Закона о чистом воздухе» и требует большей прозрачности. В частности, даже методика проверки загрязнения воздуха возле дата-центра xAI вызвала вопросы у экологов. Впрочем, если раньше данные о работе генераторов удавалось получать с большим трудом, то теперь xAI обязали подробно отчитываться о каждом запуске каждой турбины и всегда минимизировать их выбросы. Записи должны предоставляться в Департамент здравоохранения раз в полгода, а первый отчёт нужно подготовить к 31 декабря. В разрешении указываются даже такие параметры, как уровень видимости выбросов, время работы и частота запуска генераторов: общая продолжительность работы 15 турбин не должна превышать 110 часов в год, каждую из них можно запускать и останавливать не более 22 раз в год. Также xAI обязана хранить архив записей о запусках и эксплуатации турбин за пять лет, которые власти смогут запросить в любое время. SELC, агентство и его партнёры намерены и дальше контролировать деятельность xAI в районе Мемфиса. Подчёркивается, что компания собирается построить поблизости и второй дата-центр, что вызовет новые экологические проблемы. Например, xAI не сообщила, как намерена обеспечивать питанием новый ЦОД и будет ли использовать для него газовые турбины. Ходили слухи, что xAI может построить 1,56-ГВт газовую электростанцию для очередного ИИ-суперкомпьютера, а то и вовсе привезти её из-за границы. |

|