Материалы по тегу: ии

|

19.11.2023 [23:59], Владимир Мироненко

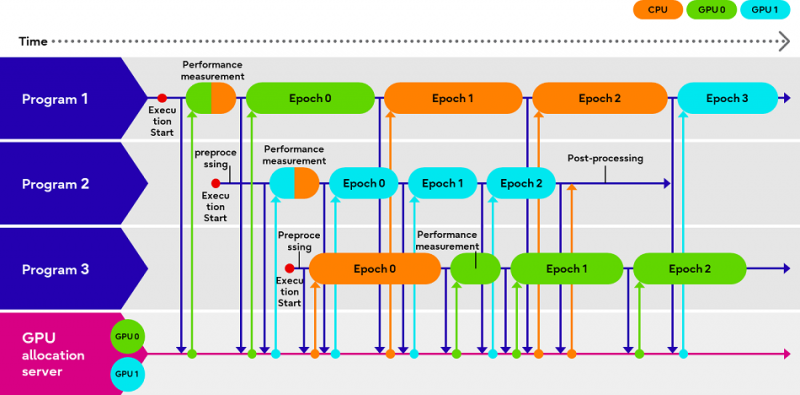

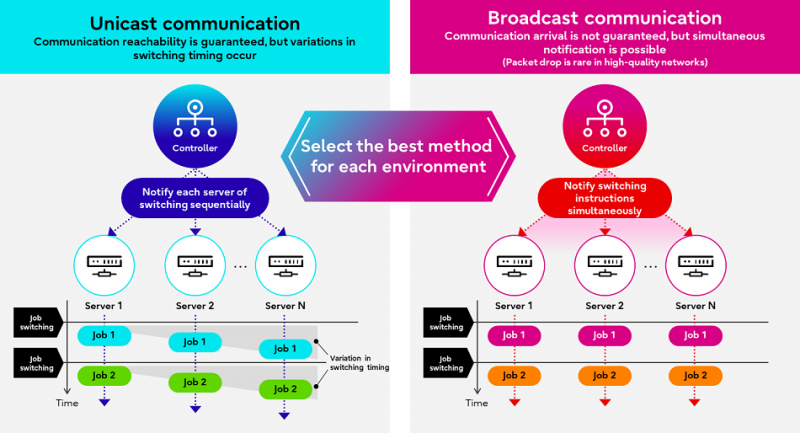

Fujitsu Adaptive GPU Allocator позволит эффективнее использовать дефицитные ИИ-ускорителиКомпания Fujitsu представила технологии Adaptive GPU Allocator и Interactive HPC, позволяющие оптимизировать использования ускорителей и HPC-кластеров. Эти технологии будут использоваться в некоторых из её собственных облачных HPC-продуктов. Компания утверждает, что новые решения призваны помочь решить проблему глобальной нехватки ускорителей в связи с большим спросом на генеративный ИИ, позволяя клиентам оптимизировать использование своих вычислительных ресурсов. По словам Fujitsu, Adaptive GPU Allocator способна динамически определять программы, для работы которых действительно требуется ускоритель, и программы, которым фактически достаточно CPU, и соответствующим образом распределять ресурсы. Технология основана на оценке уровня возможного ускорения при использовании GPU для каждой конкретной программы и выделении ресурсов ускорителей так, чтобы минимизировать общее время обработки всеми программами. Технических деталей о работе этой системы компания не предоставила. Сообщается лишь то, что при запросе программой доступа к ускорителю проводится замер скорости обработки одного и того же кусочка данных на CPU и GPU, на основании чего и принимается решение о дальнейшей обработке на CPU или GPU. Система может измерять производительность кода по мере его выполнения. Как уточняет The Register, что для работы Adaptive GPU Allocator программы должны задействовать фреймворк Fujitsu, который использует TensorFlow и PyTorch. Adaptive GPU Allocator станет частью ИИ-платформы Fujitsu Kozuchi, выход которой ожидается после II половины 2024 финансового года, заканчивающегося 31 марта 2025 года. Чуть раньше появится технология Interactive HPC, которая позволит переключаться между несколькими задачами в HPC-кластерах в режиме реального времени, тогда как, по словам Fujitsu, традиционный подход предполагает отправку узлам команд на переключение по очереди. Деталей компания снова не сообщила, отметив лишь то, что в кластере из 256 узлов Interactive HPC позволила сократить время переключения с одной задачи на другую с нескольких секунд до 100 мс.

19.11.2023 [22:52], Сергей Карасёв

Dell и Hugging Face упростят развёртывание генеративного ИИ на базе локальной инфраструктурыКомпании Dell Technologies и Hugging Face объявили о заключении соглашения о сотрудничестве, цель которого заключается в том, чтобы помочь корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ. Партнёры сформируют новый портал на платформе Hugging Face. Через него будут доступны специальные контейнеры и сценарии, которые помогут заказчикам быстро и безопасно разворачивать открытые ИИ-модели, доступные в репозитории Hugging Face. Ранее похожее решение было представлено для моделей Llama 2.

Источник изображения: pixabay.com Для локального развёртывания ИИ-приложений будет использоваться оборудование Dell — серверы PowerEdge и СХД. Со временем на портале появятся дополнительные контейнеры с оптимизированными моделями для инфраструктуры Dell, предназначенные для внедрения ИИ-систем нового поколения. Ранее компания представила расширеннное портфолио комплексных решений и сервисов для «локализации» генеративного ИИ.

19.11.2023 [22:42], Сергей Карасёв

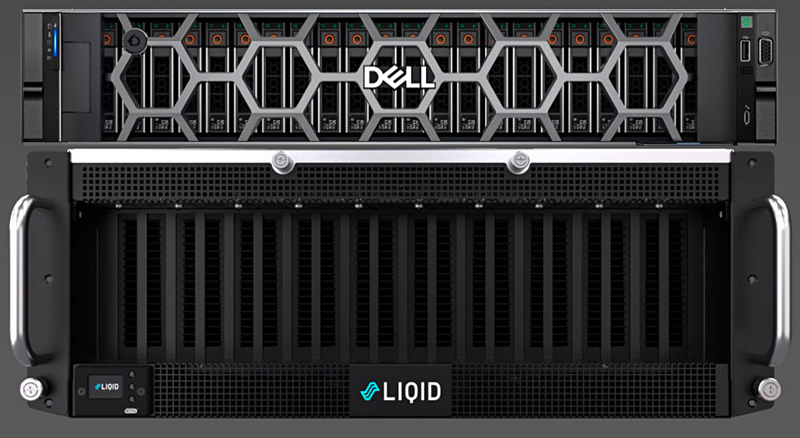

16 ускорителей на один сервер: Liqid и Dell представили платформу UltraStack L40SКомпания Liqid в партнёрстве с Dell Technologies анонсировала эталонную архитектуру UltraStack L40S для формирования систем с высокой плотностью компоновки GPU и иных ускорителей — до 16 шт. на один сервер. Такие платформы могут использоваться для ИИ-приложений, работы с большими языковыми моделями (LLM), задач НРС и пр. Новинка доступна в конфигурациях UltraStack x8 и UltraStack x16. В качестве хост-сервера в составе решения выступает Dell PowerEdge R760xa на базе Intel Xeon Sapphire Rapids: применены два процессора Xeon Gold 6430 (32 ядра; 64 потока; 1,9 ГГц). Объём оперативной памяти в первом случае составляет 1 Тбайт, во втором — 2 Тбайт. К серверу подключаются модули Liqid PCIe Chassis. Версия UltraStack x8 использует два таких модуля: задействованы восемь ускорителей NVIDIA L40S с 48 Гбайт памяти GDDR6 и SSD-хранилище вместимостью 30 Тбайт (NVMe). Вариант UltraStack x16 комплектуется тремя модулями Liqid PCIe Chassis: объединены 16 карт NVIDIA L40S, а ёмкость хранилища составляет 60 Тбайт.

Источник изображения: Liqid Платформа UltraStack L40S предполагает применение восьми двухпортовых сетевых адаптеров NVIDIA ConnectX-7 (16 × 200 Гбит/с), DPU BlueField-3, двух хост-адаптеров Liqid Gen 4.0 x16 HBA, а также коммутатора PCIe 4.0 на 24/48 портов. Среднее энергопотребление UltraStack x8 заявлено на уровне 4,5 кВт, UltraStack x16 — 7,5 кВт. Система базируется на ПО Liqid Matrix. Компания Liqid утверждает, что по сравнению с четырьмя серверами формата 2U, каждый из которых содержит четыре ускорителя NVIDIA L40S, её система UltraStack с 16 такими картами обеспечивает на 35 % более высокую производительность, сокращение энергопотребления на 35 % и снижение общей стоимости владения на 25 %.

19.11.2023 [03:00], Сергей Карасёв

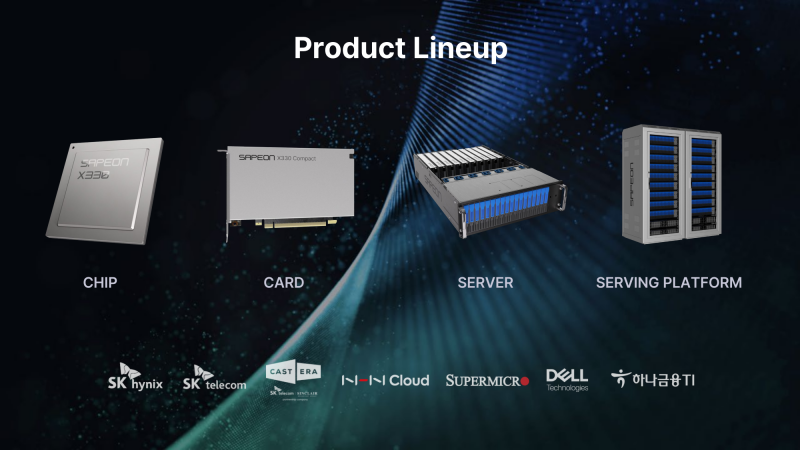

Южнокорейский стартап Sapeon представил 7-нм ИИ-чип X330ИИ-стартап Sapeon, поддерживаемый южнокорейским телекоммуникационным гигантом SK Group, анонсировал чип X330, предназначенный для инференса и обслуживания больших языковых моделей (LLM). Изделие ляжет в основу специализированных ускорителей для дата-центров. Sapeon заявляет, что новый нейропроцессор (NPU) обеспечивает примерно вдвое более высокую производительность и в 1,3 раза лучшую энергоэффективность, чем продукты конкурентов, выпущенные в этом году. По сравнению с предыдущим решением самой компании — Sapeon X220 — достигается увеличение быстродействия в четыре раза и повышение энергоэффективности в два раза. Новинка будет изготавливаться на TSMC по 7-нм технологии. Массовое производство запланировано на I полугодие 2024 года. На базе чипа будут предлагаться два ускорителя — X330 Compact Card и X330 Prime Card. Оба имеют однослотовое исполнение и оснащаются системой пассивного охлаждения. Для подключения применяется интерфейс PCIe 5.0 х16. Карты могут осуществлять вычисления INT8, FP8 и FP16. Модель X330 Compact Card уменьшенной длины несёт на борту 16 Гбайт памяти GDDR6 с пропускной способностью до 256 Гбайт/с. Заявленная производительность на операциях FP8 и FP16 достигает соответственно 367 и 184 Тфлопс. Энергопотребление варьируется в диапазоне от 75 до 120 Вт. Полноразмерная модификация X330 Prime Card получила 32 Гбайт памяти GDDR6 с пропускной способностью до 512 Гбайт/с. Заявленное быстродействие FP8 и FP16 составляет до 734 и 368 Тфлопс. Энергопотребление — 250 Вт. Группа SK в последнее время активно вкладывается в развитие ИИ, инвестируя напрямую или через дочерние структуры как в софт, так и в железо. С ней, в частности, связан ещё один южнокорейский разработчик ИИ-чипов Rebellions, также поддерживаемый правительством страны, которое намерено к 2030 году довести долю отечественных ИИ-чипов в местных дата-центрах до 80 %. Делается это для того, чтобы снизить зависимость от иностранных решений и избежать дефицита. Сама же Sapeon готовит ещё минимум два поколения своих чипов.

19.11.2023 [01:46], Сергей Карасёв

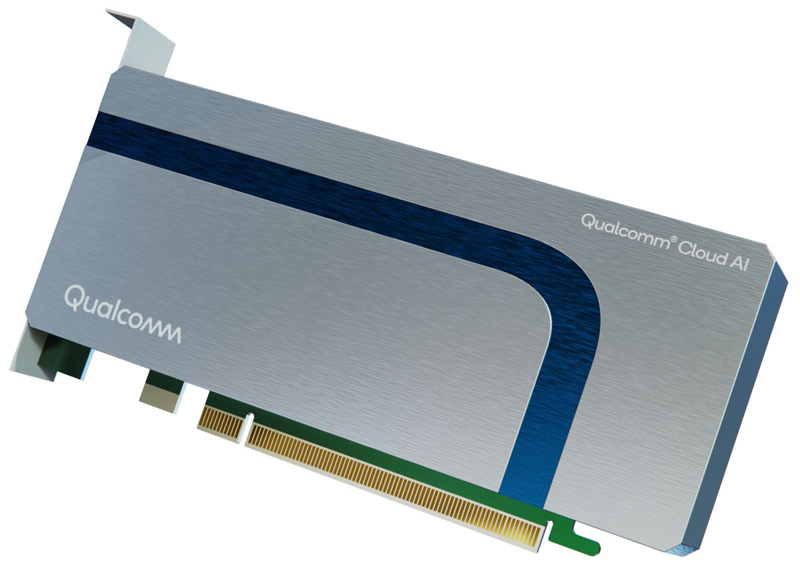

В облаке Cirrascale появились ИИ-ускорители Qualcomm Cloud AI 100Компания Cirrascale Cloud Services сообщила о том, что в её облаке AI Innovation Cloud стали доступны инстансы на основе специализированных ИИ-ускорителей Qualcomm Cloud AI 100. Сервис предназначен для инференса, обработки больших языковых моделей (LLM), генеративных ИИ-систем, приложений машинного зрения и т. п. Решение Qualcomm Cloud AI 100, выполненное в виде однослотовой 75-Вт карты PCIe с пассивынм охлаждением. Ускоритель поддерживает вычисления FP16/32 и INT8/16. Задействованы 16 ядер Qualcomm AI Cores и 16 Гбайт памяти LPDDR4x-2133 с пропускной способностью 136,5 Гбайт/с. Qualcomm Cloud AI 100 обеспечивает быстродействие до 350 TOPS на операциях INT8 и до 175 Тфлопс при вычислениях FP16. Cirrascale Cloud Services предлагает инстансы на базе одной, двух, четырёх и восьми карт Qualcomm Cloud AI 100. Количество vCPU варьируется от 12 до 64, объём оперативной памяти — от 48 до 384 Гбайт. Во всех случаях задействован SSD вместимостью 1 Тбайт (NVMe).

Источник изображения: Qualcomm / Lenovo Разработчики могут использовать комплект Qualcomm Cloud AI SDK, который предлагает различные инструменты в области ИИ — от внедрения предварительно обученных моделей до развёртывания приложений глубокого обучения. Стоимость инстансов варьируется от $329 до $2499 в месяц (при оформлении годовой подписки — от $259 до $2019 в месяц).

18.11.2023 [23:57], Сергей Карасёв

ИИ-суперкомпьютер «под ключ»: HPE и NVIDIA представили HPC-платформу на базе гибридных суперчипов Grace HopperКомпании HPE и NVIDIA анонсировали модульную суперкомпьютерную систему для генеративного ИИ и обучения моделей на основе частных массивов данных. Комплекс ориентирован на крупные предприятия, исследовательские организации и государственные структуры. В основу решения положена аппаратная платформа Cray EX2500. В состав входят суперчипы NVIDIA GH200 Grace Hopper, содержащие 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. Каждый узел системы использует четыре таких суперчипа. Узлы соединены друг с другом при помощи интерконнекта Slingshot. Говорится, что реализованная архитектура позволяет осуществлять масштабирование до тысяч ускорителей. При этом все мощности могут выделяться для решения одной задачи ИИ, что обеспечивает максимальную эффективность использования ресурсов. По сути, новое решение представляет собой мини-версию ИИ-суперкомпьютера Isambard-AI, который разместится в Бристольском университете (Великобритания). HPE и NVIDIA будут предлагать систему в качестве решения «под ключ» с услугами по установке и настройке.

Источник изображения: HPE Кроме того, предусмотрен стек ПО для решения различных ИИ-задач: это среда HPE Machine Learning Development Environment, набор инструментов HPE Cray Programming Environment, а также пакет NVIDIA AI Enterprise. В целом, как отмечается, новая система предлагает заказчикам производительность и масштабируемость, которые позволяют решать наиболее сложные ИИ-задачи, включая обучение больших языковых моделей (LLM) и создание рекомендательных систем.

18.11.2023 [00:38], Владимир Мироненко

NVIDIA и Microsoft развернули в облаке Azure платформу для создания приложений генеративного ИИКомпания NVIDIA представила на конференции Microsoft Ignite 2023 сервис NVIDIA AI Foundry, который позволит предприятиям ускорить разработку и настройку пользовательских приложений генеративного ИИ с использованием собственных данных, развёртываемых в облаке Microsoft Azure. NVIDIA AI Foundry объединяет три элемента: набор базовых моделей NVIDIA AI Foundation, платформу и инструменты NVIDIA NeMo, а также суперкомпьютерные сервисы NVIDIA DGX Cloud AI. Вместе они предоставляют предприятиям комплексное решение для создания пользовательских моделей генеративного ИИ. Компании смогут затем развёртывать свои индивидуальные модели с помощью платформы NVIDIA AI Enterprise для создания приложений ИИ, включая интеллектуальный поиск, обобщение и генерацию контента. «Предприятиям нужны кастомные модели для реализации специализированных навыков, основанных на собственной ДНК их компании — их данных, — сообщил глава NVIDIA Дженсен Хуанг (Jensen Huang), — Сервис NVIDIA AI Foundry сочетает в себе наши технологии моделей генеративного ИИ, опыт обучения LLM и гигантскую фабрику ИИ. Мы создали это в Microsoft Azure, чтобы предприятия по всему миру могли подключить свою собственную модель к ведущим в мире облачным сервисам Microsoft».

Источник изображения: NVIDIA Сервис NVIDIA AI Foundry можно использовать для настройки моделей для приложений на базе генеративного ИИ в различных отраслях, включая корпоративное ПО, телекоммуникации и медиа. При их развёртывании компании смогут использовать метод генерации с расширенным поиском (RAG), чтобы привязать свои модели к базе корпоративных данных для получения актуальных ответов. В сервисе NVIDIA Foundry клиенты смогут выбирать из нескольких моделей NVIDIA AI Foundation, включая новое семейство Nemotron-3 8B в составе каталога моделей Azure AI. Разработчики также могут получить доступ к моделям Nemotron-3 8B в каталоге NVIDIA NGC и к популярным моделям Llama 2, Mistral и Stable Diffusion XL. NVIDIA сообщила, что одними из первых новым сервисом для создания моделей воспользовались SAP, Amdocs и Getty Images. Наконец, в Azure стала доступна и платформа NVIDIA DGX Cloud AI, в рамках которой клиенты смогут арендовать кластеры, состоящие из тысяч ускорителей NVIDIA и воспользоваться ПО NVIDIA AI Enterprise, включая NeMo, для ускорения настройки LLM. Клиенты Azure смогут использовать существующие кредиты Microsoft Azure Consumption Commitment для ускорения разработки ИИ-моделей. Отметим, что первым сервис DGX Cloud получило облако Oracle, где Microsoft арендует ускорители той же NVIDIA для собственных нужд. По слухам, компания также использует ускорители CoreWeave и Lambda Labs, а также разрабатывает более экономичные ИИ-модели. По-видимому, продавать доступ к аппаратным и иным решениям NVIDIA для Microsoft выгоднее, чем использовать для своих нужд. Впрочем, если всё сложится удачно, то компания перейдёт на ИИ-ускорители Maia 100 собственной разработки.

18.11.2023 [00:02], Андрей Крупин

Postgres Pro стала первой отечественной СУБД, сертифицированной по новым требованиям ФСТЭК РоссииКомпания Postgres Professional провела оценку сертифицированных версий систем управления базами данных Postgres Pro Standard и Pro Enterprise согласно новым требованиям Федеральной службы по техническому и экспортному контролю по безопасности информации к СУБД от 14 апреля 2023 года, утверждённых Минюстом в июле 2023 года. Утверждается, что Postgres Pro стала первой отечественной СУБД, сертифицированной по новым требованиям регулятора. Сертификат допускает использование программного комплекса для хранения и обработки данных в критической инфраструктуре первой категории и государственных информационных системах первого класса защищённости.  Ранее сертифицированные версии Postgres Pro в основном уже соответствовали новым требованиям ФСТЭК России и содержали необходимые механизмы защиты. Для полного соответствия новым требованиям в СУБД были доработаны некоторые команды и утилиты, ведены новые роли администратора и ограничены возможности суперпользователя, обновлена документация, а также усовершенствован модуль pg_proaudit, позволяющий регистрировать события, связанные с безопасностью. Обновлённая версия Postgres Pro Certified поддерживает три версии ядра СУБД: 11.21.2, 14.9.2 и 15.4.2. Сертификат соответствия № 3637 переоформлен 20 октября 2023 г. Обновлённая редакция Postgres Pro Enterprise Certified поддерживает четыре версии ядра СУБД: 11.21.2, 13.12.3, 14.9.3 и 15.4.3. Сертификат соответствия № 4063, переоформлен 3 ноября 2023 г. В октябре 2023 года Postgres Professional объявила о выпуске Postgres Pro Standard 16. Её сертифицированная ФСТЭК России версия появится после очередного инспекционного контроля. В декабре компания планирует мажорный релиз новой флагманской Postgres Pro Enterprise 16, в которую войдёт ряд новых крупных решений и доработок. В 2024 году запланирован выпуск очередной сертифицированной версии Postgres Pro Enterprise Certified.

17.11.2023 [14:02], Руслан Авдеев

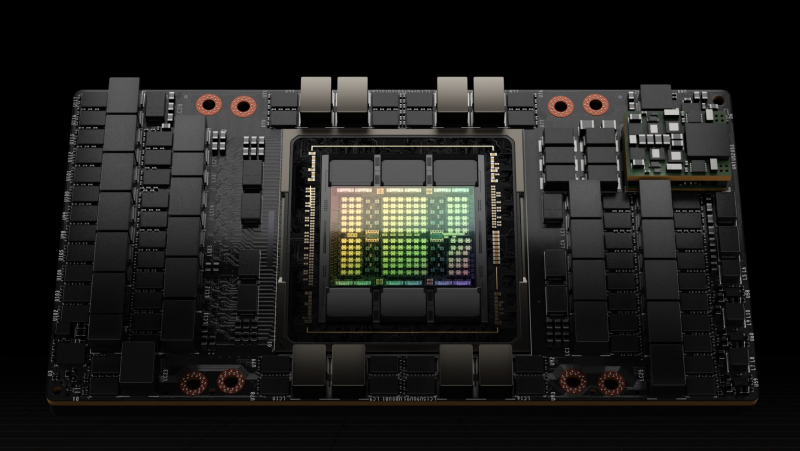

Tencent накопила достаточно ускорителей NVIDIA H800 для поддержания ИИ-разработок в условиях антикитайских санкцийПосле ужесточения антикитайских санкций 17 октября со стороны США бизнес и государственные структуры КНР лишились возможности приобретать даже ухудшенные версии ускорителей NVIDIA. Тем не менее, как сообщает DigiTimes, многие китайские участники рынка успели закупить большое количество ускорителей до вступления новых запретов в силу. По словам президента Tencent Мартина Лау (Martin Lau), перспектива введения более строгих санкций сподвигла компанию к более рациональному использованию уже имеющихся чипов, а также поиску альтернатив на местном рынке, где разработка подобных решений ведётся ударными темпами. В своё время NVIDIA на фоне санкций пришлось наладить для Китая вместо ускорителей A100 и H100 выпуск моделей A800 и H800 с искусственно заниженной производительностью. Но теперь и их экспорт в Поднебесную попал под запрет. Как заявил Лау журналистам, Tencent уже закупила достаточно ускорителей NVIDIA для дальнейшего развития ИИ-платформы Hunyuan. Ожидается, что компании удастся обучить ещё как минимум два поколения ИИ-моделей. В результате, как считают в руководстве Tencent, новейшие антикитайские санкции не смогут повлиять на возможность развития ИИ-технологий компании в краткосрочной перспективе.

Источник изображения: NVIDIA Инвесторам сообщили, что Hunyuan уже может готовить резюме встреч, проводимых на похожей на Zoom платформе Tencent Meeting, даёт рекомендации программистам компании и повышает эффективность создания игр. Также ИИ способен выступать в роли копирайтера для рекламодателей, позволяя более аккуратно адаптировать рекламу под целевую аудиторию, увеличивая её эффективность. В частности, это позволило улучшить показатели видеорекламы Tencent. В обозримом будущем Лау рассчитывает, что ИИ позволит и отвечать на вопросы клиентов — это позволит объединить рекламу и продажи. Как подчеркнул Лау, фактически Tencent находится в числе китайских компаний с самыми большими запасами чипов H800 — в своё время именно она первой начала приобретать их у NVIDIA. В частности поэтому она накопила большие запасы, так что новые запреты способны лишь слегка замедлить работы. По словам Лау, наиболее эффективной будет комбинированная схема, при которой наиболее производительные чипы оставят для тренировки ИИ-моделей, а варианты с меньшей производительностью будут применяться для инференса. Впрочем, несмотря на принятые меры, в Tencent признают, что антикитайские санкции США негативно скажутся на облачном ИИ-сервисе компании. Тем не менее, Лау уверен, что если запасы H800 начнут иссякать, они будут пополнены за счёт китайских решений. Как сообщает The Register, пока таких фактически не существует. Но, судя по всему, в Tencent уверены, что скоро варианты, способные бросить вызов американскому превосходству, окажутся в китайском распоряжении. В III квартале выручка китайского техногиганта составила $21,5 млрд и выросла год к году на 10 %. Операционная прибыль упала на 6 %, но всё ещё составляет $6,8 млрд. Компания принимает ряд мер по оптимизации бизнеса и сейчас её социальные платформы WeChat и QQ насчитывают по 1,336 млрд и 558 млн активных пользователей соответственно, наблюдается небольшой рост год к году. Рост доходов руководство объясняет эффективностью видео- и игрового сервисов.

17.11.2023 [13:35], Сергей Карасёв

Cornelis Networks присоединилась к консорциуму Ultra EthernetКомпания Cornelis Networks, поставщик HPC-интерконнекта на базе технологий Omni-Path, объявила о вступлении в организацию Ultra Ethernet Consortium. Специалисты Cornelis помогут в разработке интерконнекта нового поколения с высокой пропускной способностью. Цель консорциума Ultra Ethernet, сформированного в июле нынешнего года, заключается в создании основанной на Ethernet открытой высокопроизводительной архитектуры с полным коммуникационным стеком, отвечающей задачам современных рабочих нагрузок ИИ и НРС. Cornelis Networks отмечает, что требования к производительности и масштабируемости приложений ИИ обнажают ограничения традиционных коммуникационных решений на основе Ethernet. А поэтому необходима разработка альтернативных систем, способных удовлетворить потребность в высокоскоростных соединениях для обмена огромными массивами данных. Cornelis Networks привнесёт в консорциум свой опыт в области высокопроизводительных сетей, а также базу актуальных и уникальных технологий.

Источник изображения: Cornelis Networks Ожидается, что благодаря сотрудничеству коллективный опыт участников Ultra Ethernet Consortium позволит установить новые стандарты совместимости и производительности, что в конечном итоге приведет к появлению революционных коммуникационных платформ. На сегодняшний день в состав консорциума входят AMD, Arista, Broadcom, Cisco, Eviden, HPE, Intel, Meta✴, Microsoft, Oracle и другие крупные компании. |

|