Материалы по тегу: ии

|

12.10.2024 [17:54], Сергей Карасёв

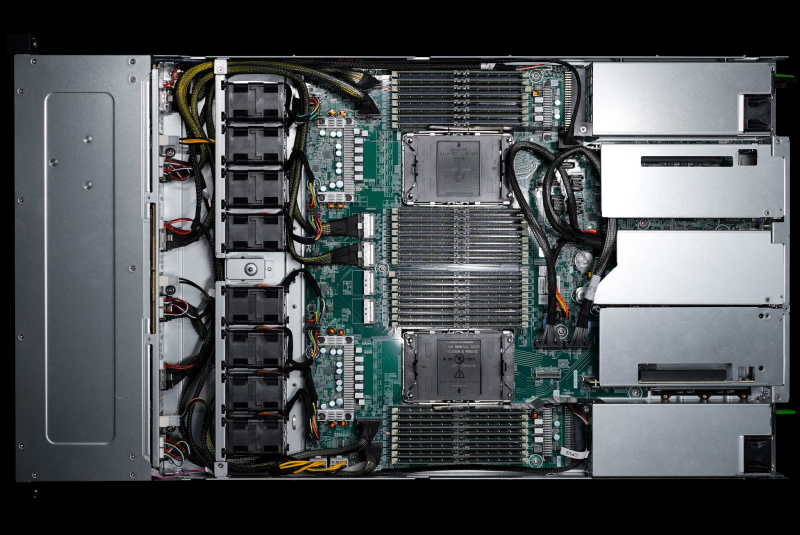

Giga Computing выпустила серверы с чипами AMD EPYC Turin и ускорителями Instinct MI325XКомпания Giga Computing, серверное подразделение Gigabyte, объявила о поддержке новейших процессоров AMD EPYC 9005 Turin, дебютировавших на этой неделе. Эти чипы могут использоваться с более чем 60 моделями серверов и материнских плат. Компания также сообщила о намерении использовать в некоторых своих ИИ-системах ускорители AMD Instinct MI325X. Изделия Instinct входят в состав таких машин как G593-ZX1, G383-R80, G593-SX1 и др. Кроме того, представлены полностью новые продукты, в частности, сервер XV23-ZX0. Эта система выполнена в формате 2U с габаритами 438 × 87 × 900 мм. Возможна установка двух чипов в исполнении Socket SP5 с показателем cTDP до 500 Вт. Есть 24 слота для модулей DDR5-6000. Во фронтальной части расположены отсеки для шести SFF-накопителей NVMe/SATA/SAS-4. Кроме того, предусмотрены два коннектора M.2 2280/22110 PCIe 3.0 x2 и один разъём M.2 2280/22110 PCIe 3.0 x1 для SSD. В общей сложности доступны семь слотов PCIe 5.0 x16 для карт FHFL, в том числе четыре посадочных места для двухслотовых PCIe-ускорителей. В оснащение входят два сетевых порта 10GbE на базе Intel X550-AT2, выделенный сетевой порт управления, контроллер Aspeed AST2600. Спереди и сзади находятся по два порта USB 3.2 Gen1 Type-A. Кроме того, упомянут интерфейс Mini-DP.

Источник изображения: Giga Computing Питание обеспечивают четыре блока мощностью 2000 Вт каждый с сертификатом 80 PLUS Titanium. Применены четыре системных вентилятора охлаждения диаметром 80 мм (15 000 об/мин). Диапазон рабочих температур простирается от +10 до +35 °C.

12.10.2024 [17:51], Сергей Карасёв

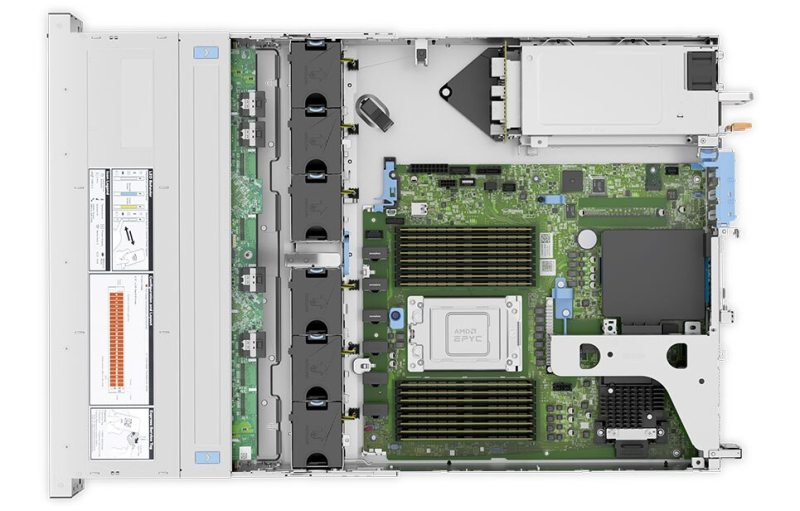

Dell представила ИИ-серверы PowerEdge на базе AMD EPYC TurinКомпания Dell Technologies анонсировала обновлённые серверы PowerEdge, ориентированные на ресурсоёмкие рабочие нагрузки ИИ. В основу положены процессоры AMD серии EPYC 9005 (Turin), насчитывающие до 192 вычислительных ядер. В частности, дебютировала модель PowerEdge XE7745 для тюнинга ИИ-моделей, инференса, НРС-задач и пр. Сервер построен на шасси 4U с воздушным охлаждением. Возможна установка до восьми PCIe-ускорителей двойной ширины или до 16 ускорителей одинарной ширины. Кроме того, доступны восемь дополнительных слотов PCIe 5.0 для сетевых адаптеров. Представлены также серверы PowerEdge R6725 и PowerEdge R7725 стандарта Data Center Modular Hardware Systems (DC-MHS) с расширенными возможностями по организации воздушного охлаждения. Они могут нести на борту два чипа EPYC 9005 с показателем TDP до 500 Вт. Устройства, как утверждается, обеспечивают рекордную производительность при работе со средствами виртуализации, базами данных и ИИ-приложениями. Помимо этого, анонсированы односокетные модели PowerEdge R6715 и PowerEdge R7715, которые будут доступны в различных конфигурациях в форматах 1U и 2U. Говорится о поддержке 24 модулей DIMM (2DPC). Отмечается, что версия R6715 демонстрирует мировые рекорды производительности для задач ИИ и виртуализации. Более подробные технические характеристики всех новых серверов будут раскрыты позднее. Для клиентов, развёртывающих ИИ-системы в больших масштабах, Dell предложит поддержку новейших ускорителей AMD Instinct MI325X в серверах PowerEdge XE. Улучшенный контроллер iDRAC (Integrated Dell Remote Access Controller) благодаря более быстрому процессору, увеличенному объёму памяти и выделенному сопроцессору безопасности упрощает управление серверами и повышает уровень защиты. Решения PowerEdge R6715, R7715, R6725 и R7725 станут доступны в ноябре, тогда как PowerEdge XE7745 поступит в продажу в январе 2025 года.

12.10.2024 [17:46], Сергей Карасёв

HPE представила мощную ИИ-систему ProLiant Compute XD685 с Instinct MI325X и другие серверы на чипах AMD EPYC TurinКомпания HPE сообщила о том, что её серверы ProLiant Gen11 получили поддержку новейших процессоров AMD EPYC 9005 Turin, официально представленных на этой неделе. Кроме того, дебютировала мощная система ProLiant Compute XD685, ориентированная на наиболее сложные нагрузки ИИ. Обновлённые модели ProLiant Gen11 унаследовали ключевые характеристики у аналогичных версий на чипах AMD EPYC Genoa. При этом, как утверждает HPE, благодаря переходу на EPYC 9005 Turin прирост общей производительности достигает 35 %, а энергетической эффективности — 25 %. Эти машины установили 30 новых мировых рекордов. В семейство ProLiant Gen11 входят устройства типоразмера 1U и 2U с поддержкой одного и двух процессоров. Предлагаются гибкие возможности в плане организации подсистемы хранения данных. Серверы уже доступны для заказа в некоторых регионах. В свою очередь, новая система ProLiant Compute XD685, показанная на изображении, выполнена в формате 5U. Она комплектуется двумя чипами EPYC 9005 Turin. В оснащение могут входить до восьми ИИ-ускорителей AMD Instinct MI325X или AMD Instinct MI300X. В стандартной конфигурации используется воздушное охлаждение, а при необходимости может быть развёрнуто прямое жидкостное охлаждение. Вместе с тем HPE Services предлагает полный спектр настраиваемых услуг для развёртывания крупных кластеров ИИ. Приём предварительных заказов на ProLiant Compute XD685 уже начался; организовать поставки НРЕ планирует в I квартале 2025 года.

11.10.2024 [19:55], Алексей Степин

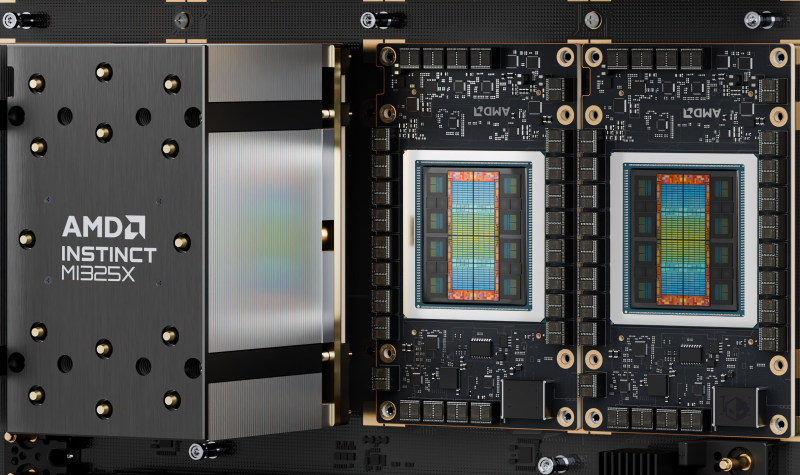

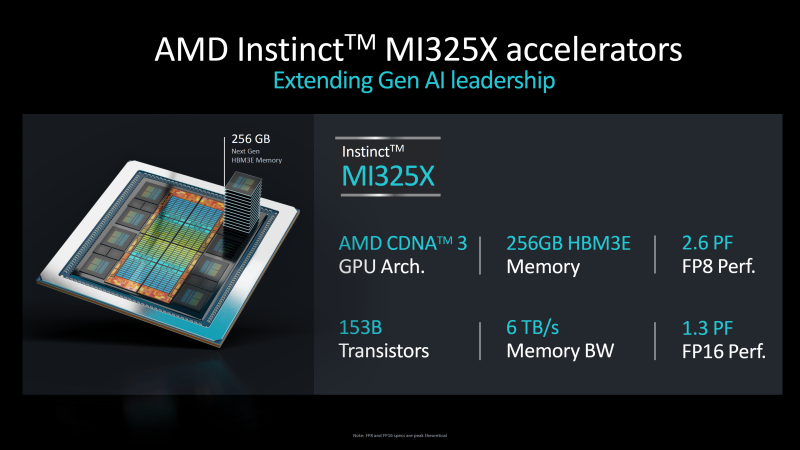

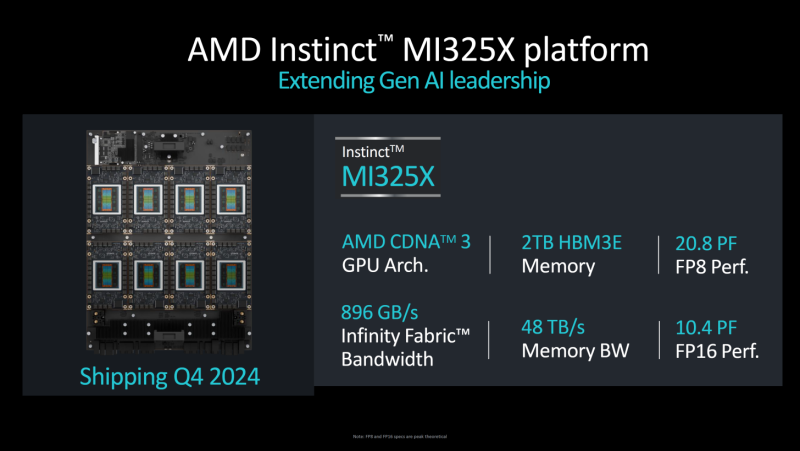

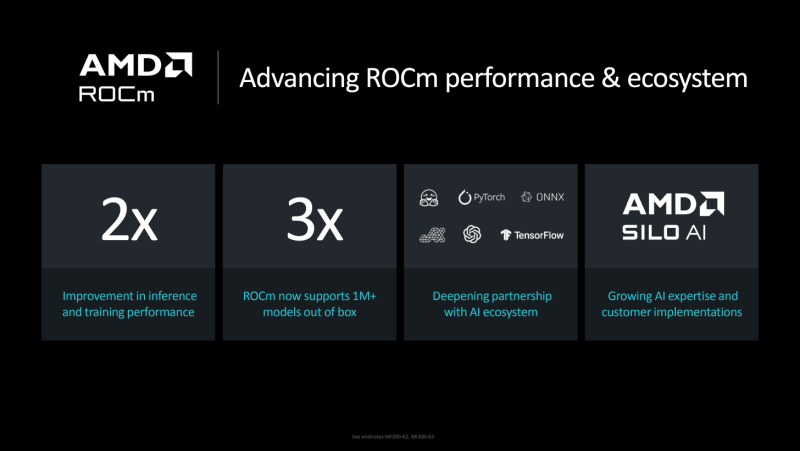

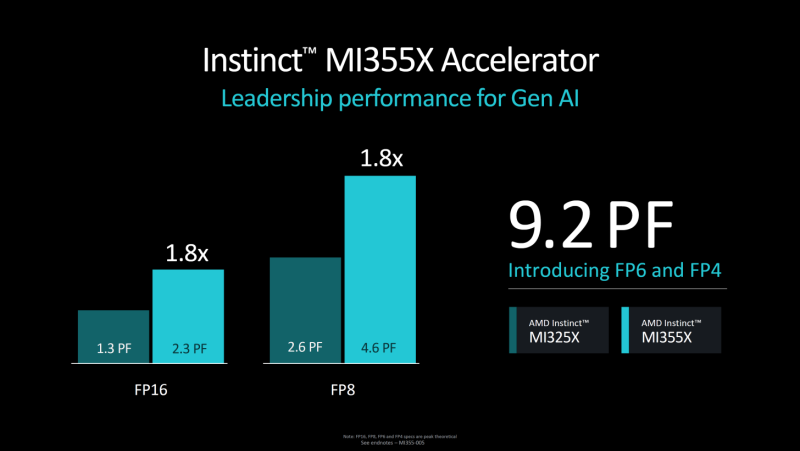

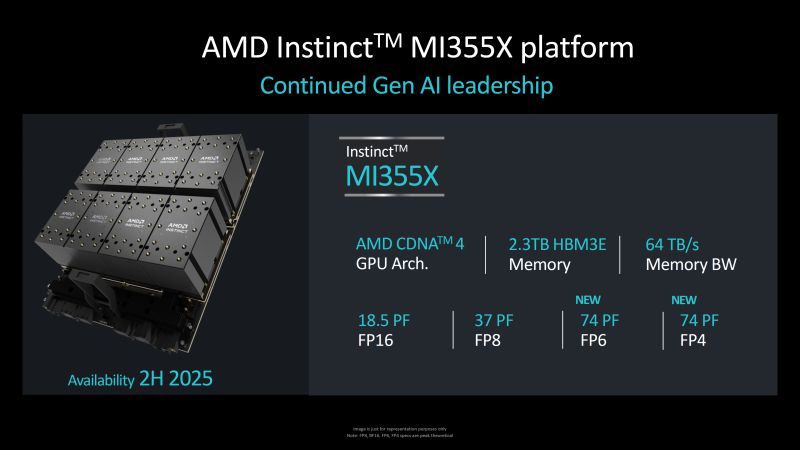

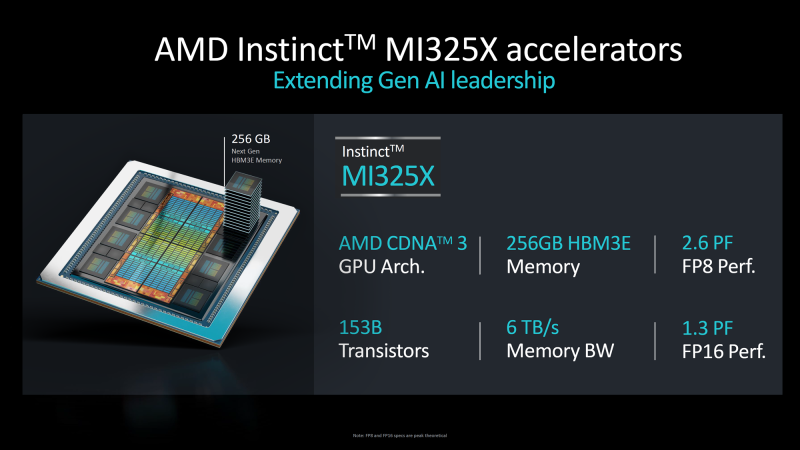

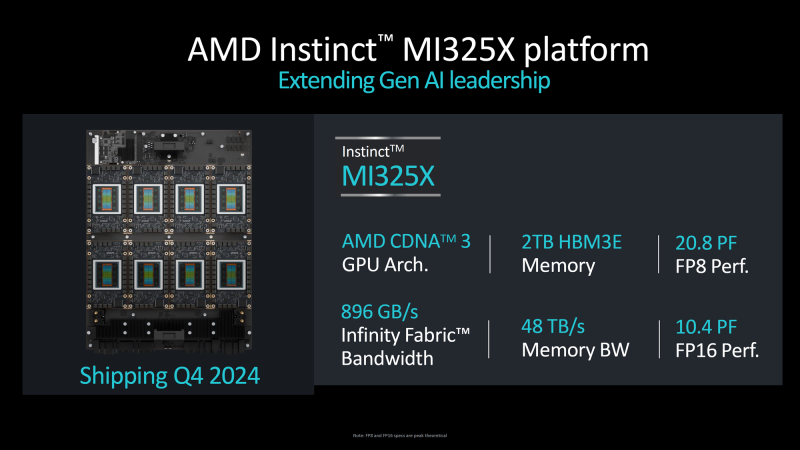

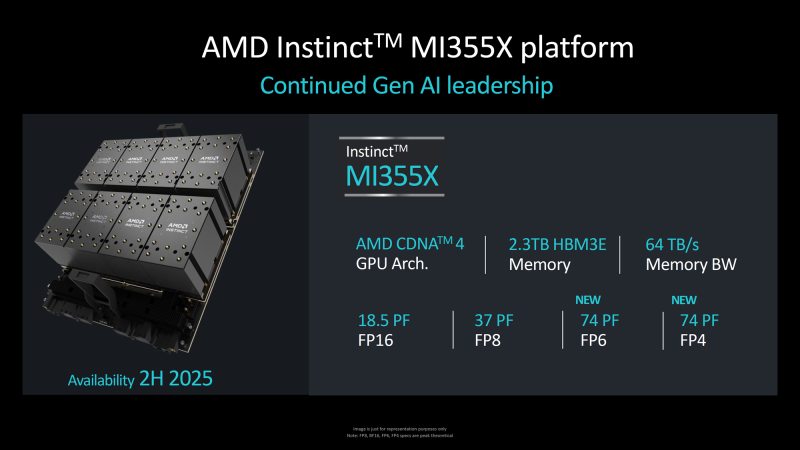

256 Гбайт HBM3e — это хорошо, а 288 Гбайт — ещё лучше: AMD анонсировала ускорители Instinct MI325X и MI355XВчера компания AMD анонсировала серверные процессоры EPYC 9005 (Turin) и ускорители Instinct MI325X. Если верить AMD, новинки устанавливают новые эталоны производительности в своих сферах применения. О процессорах речь пойдёт в отдельном материале, а сейчас попробуем разобраться с Instinct MI325X — чем же именно он отличается от представленного ранее MI300X, архитектура которого в своё время была разобрана достаточно подробно. Сама AMD позиционирует MI325X в качестве наследника MI300X, способного конкурировать с NVIDIA H200 и, возможно, даже с B200. В сравнении с тем, что было опубликовано ранее, характеристики новинки несколько изменились. В частности, новый ускоритель получил 256 Гбайт памяти HBM3e, а не 288 Гбайт, как было обещано ранее. На приведённых слайдах с изображением кристалла MI325X отчетливо видно, что количество сборок HBM по-прежнему равно восьми, однако вместо ожидаемых сборок ёмкостью 36 Гбайт использованы менее ёмкие «стопки» на 32 Гбайт. Это не позволяет говорить о 50 % приросте по объёму, только о 33 %. Но и это немало! Пропускная способность подросла с 5,3 до 6 Тбайт/с. Последнее может быть объяснено повышением тактовой частоты, но из-за тесной интеграции HBM3e с остальными частями ускорителя должна была вырасти и производительность. Тем не менее, AMD приводит же цифры, что и для MI300X —1,3 Пфлопс в режиме FP16 и 2,6 Пфлопс в режиме FP8. По сути, улучшены только характеристики подсистемы памяти. Архитектурно MI325X полностью подобен предшественнику, за исключением блока HBM. Он по-прежнему базируется на CDNA 3, имеет такое же количество транзисторов (153 млрд) и производится с использованием тех же техпроцессов, 5 нм для блоков XCD и 6 нм для IOD. Но теплопакет превышает 750 Вт, в то время как у MI300X данный параметр не достигал столь высокого значения. Ускорители подобного класса невозможно представить вне программной экосистемы. В настоящий момент AMD приводит данные о превосходстве MI325X над NVIDIA H200, варьирующемся в районе 20-40 % (в зависимости от нагрузки). Конечно, отчасти это заслуга памяти, но основной прирост заключается в оптимизации программной среды ROCm. По словам AMD, в задачах обучения и инференса производительность в версии 6.2 была увеличена более чем вдвое. Для сравнения, в первых тестах MI300X в MLPerf Inference 4.1 отстал от NVIDIA H200 примерно на 50 %. Однако для полноты картины следует дождаться результатов тестов, проведённых сторонними источниками. Кроме того, H200 уже не самый совершенный ускоритель NVIDIA — в следующем году MI325X предстоит столкнуться с B200 на базе архитектуры Blackwell. Ускорители Instinct MI325X будут доступны в I квартале 2025 года, но уже сейчас ясно, что усложнить жизнь своему главному конкуренту AMD в состоянии: так, вся обработка Llama 405B, используемой Meta✴, легла на плечи именно на MI300X. Активно используются решения AMD и в ЦОД Microsoft Azure. Что касается следующего поколения ускорителей AMD Instinct MI355X, то оно намечено на II половину 2025 года. Оно получит обновлённую архитектуру CDNA 4, о которой пока нет никаких сведений, кроме упоминания о поддержке режимов FP6 и FP4. Вычислительные тайлы будут переведены на 3-нм техпроцесс, а их количество, как ожидается, возрастёт с 8 до 10. Тем не менее, роста тепловыделения избежать не удастся: заявлен теплопакет до 1000 Вт. В Instinict MI355X получит дальнейшее развитие и подсистема памяти. Объём набортной HBM3e всё-таки достигнет 288 Гбайт, а пропускная способность вырастет с 6 до 8 Тбайт/с. Для связки из восьми MI355X AMD заявляет производительность в 18,5 Пфлопс в режиме FP16, что позволяет говорить о 2,31 Пфлопс для единственного ускорителя — то есть о примерно 80 % прироста в сравнении с MI325X. Делать какие-либо далеко идущие выводы о решениях на базе CDNA 4 рано: вероятнее всего, даже лаборатории AMD ещё не располагают финальной версией MI355X, а кроме того, как уже понятно, огромную роль играет постоянно изменяющаяся и совершенствуемая программная среда, которая ко II половине 2025 года может претерпеть существенные изменения. А вот гибридным решениям AMD планирует положить конец: преемника для Instinct MI300A, сочетающего в себе архитектуры CDNA 3 и Zen 4 не запланировано. Похоже, рынок для таких решений оказался слишком мал.

11.10.2024 [15:51], Руслан Авдеев

Минцифры РФ готовит единое регулирование репозиториев кода в России

git

open source

software

импортозамещение

информационная безопасность

минцифры россии

разработка

россия

санкции

сделано в россии

В России пересмотрели планы создания единого репозитория ПО с открытым кодом. По данным «Коммерсанта», проект, рассматривавшийся с 2020 года, отклонён. Вместо этого готовится единое регулирование существующих в стране разнородных хранилищ. Предполагается, что нормы регулирования будут включать единые стандарты обеспечения кибербезопасности — это должно обеспечить «минимально приемлемый» уровень защиты данных. Как сообщает издание, в недрах Минцифры готовится документ, описывающий регулирование деятельности российских репозиториев. Говорится, что решение об отказе от единого хранилища кода уже принято, поэтому прорабатывается концепция параллельного функционирования нескольких репозиториев с едиными требованиям к их безопасности. В 2020 году в России начали продвигать идею создания российского аналога GitHub, Минэкономики намеревалось выделить на эти цели 2,1 млрд руб. Тогда эксперты сомневались, что такой проект будет востребованным, однако последующая блокировка со стороны GitHub показала необходимость создания собственной экосистемы. В марте 2024 года стало известно, что проект единого отечественного аналога GitHub заморожен из-за отсутствия финансирования. Параллельно крупные IT-игроки в РФ стали создавать собственные альтернативы GitHub. Сейчас некоторые эксперты придерживаются мнения, что требования к репозиториям должны носить лишь рекомендательный характер, при этом стандарты должны идти и «на экспорт».

11.10.2024 [00:35], Владимир Мироненко

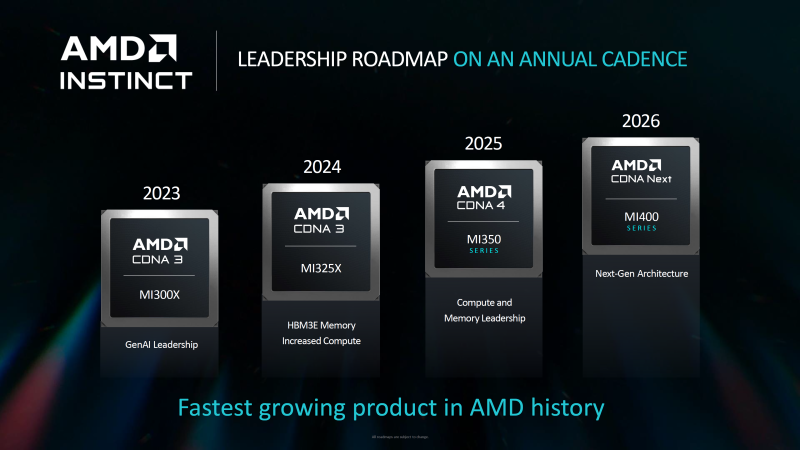

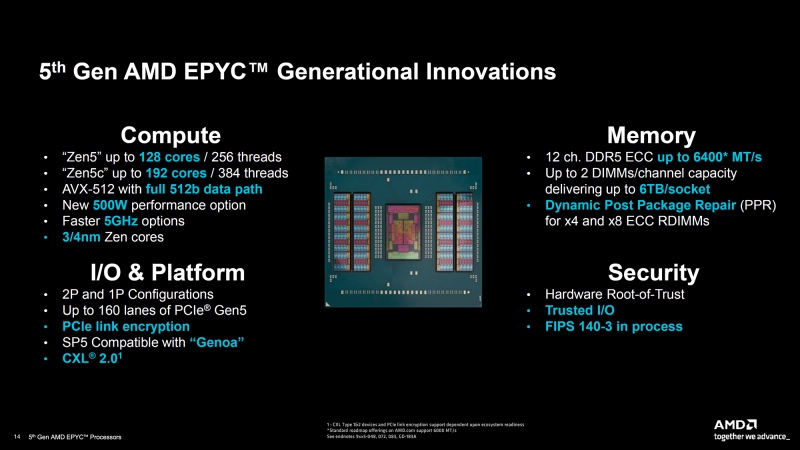

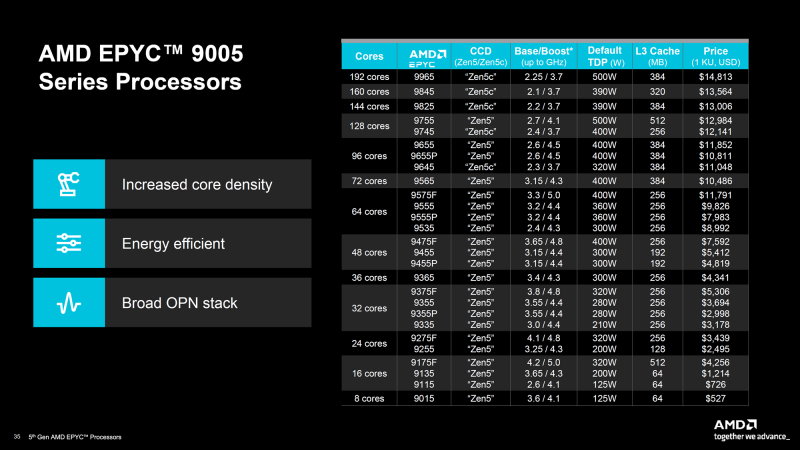

AMD представила серверные процессоры EPYC 9005 Turin и ускорители Instinct MI325XКомпания AMD представила ряд новых решений, включая серверные процессоры серии EPYC 9005 (Turin) и ускорители Instinct MI325X, которые, по словам компании, устанавливают новый стандарт производительности для ЦОД. Процессоры AMD EPYC 5-го поколения под кодовым названием Turin производятся с использованием техпроцесса 3 нм и 4 нм TSMC. Они предлагают тактовую частоту до 5,0 ГГц и от 8 до 192 ядер. AMD сообщила, что новая серия обеспечивает прирост показателя IPC на 17 % по сравнению с EPYC Genoa для корпоративных и облачных рабочих нагрузок и до 37 % в ИИ- и HPC-задачах по сравнению с Zen 4. Серия AMD EPYC 9005 включает 64-ядерный AMD EPYC 9575F, специально разработанный для ИИ-платформ на базе ускорителей, которым требуются максимальные возможности CPU. Турбочастота может достигать 5 ГГц, тогда как решение конкурента ограничено 3,8 ГГц — он до 28 % быстрее обрабатывает и передаёт данные ускорителям, что важно для требовательных рабочих нагрузок ИИ. В серии AMD EPYC 9005 доступны две версии чипов: 128-ядерная версия с классическими ядрами Zen5 и 192-ядерная версия с Zen5c. Оба варианта EPYC 9005 используют сокет SP5 и совместимы с некоторыми существующими платформами для Genoa (Zen4). Новинки поддерживают 12-канальную память DDR5-6400, а также предлагают полноценные обработку инструкций AVX-512 (целиком 512 бит за раз). Как сообщает компания, флагманский процессор серии EPYC 9965 имеет 192 ядра Zen5c и тактовую частоту до 3,7 ГГц. Серверы на базе процессоров AMD EPYC 9965 обеспечивают по сравнению с серверами на базе процессоров Intel Xeon Platinum 8592+ (Emerald Rapids):

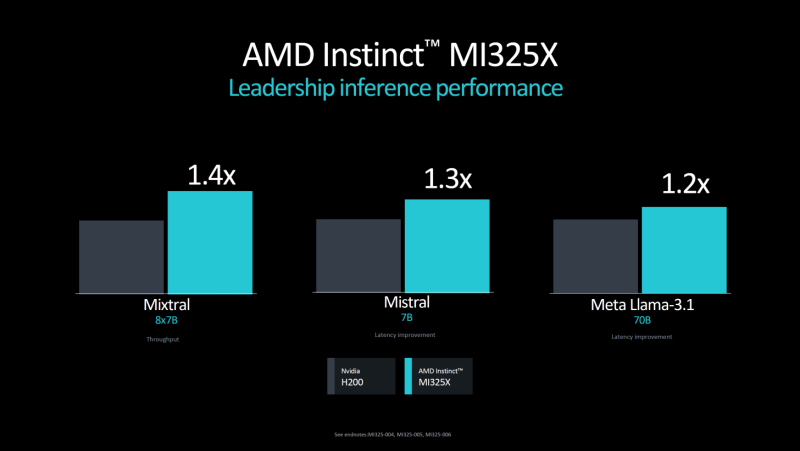

Также сообщается, что в сравнении с конкурентом 192-ядерный процессор EPYC 9965 обеспечивает до 3,7 раза большую производительность на end-to-end рабочих нагрузках ИИ, таких как TPCx-AI, которые имеют решающее значение для эффективного подхода к генеративному ИИ. Что касается AMD Instinct MI325X, то новый ускоритель, построенный на архитектуре AMD CDNA 3, имеет 256 Гбайт памяти HBM3e с пропускной способностью 6,0 Тбайт/с, что соответственно в 1,8 и 1,3 раза больше, чем у NVIDIA H200. Ускоритель обеспечивает 2,6 Пфлопс производительности в режиме FP8, 1,3 Пфлопс производительности в режиме FP16. Как утверждает AMD, по сравнению с H200 новый ускоритель в 1,3 раза быстрее в задачах инференса ИИ-модели Mistral 7B (FP16), в 1,2 раза — Llama 3.1 70B (FP8), в 1,4 раза — Mixtral 8x7B (FP16). Ускорители AMD Instinct MI325X будут доступны с I квартала 2025 года. AMD также анонсировала следующее поколение ускорителей серии AMD Instinct MI350 на основе архитектуры AMD CDNA 4, разработанные для обеспечения 35-кратного улучшения производительности инференса по сравнению с ускорителями на базе AMD CDNA 3. Серия AMD Instinct MI350 получит до 288 Гбайт памяти HBM3e на ускоритель и поддержку форматов FP6/FP4. Новинка будет доступна во II половине 2025 года.

10.10.2024 [21:18], Алексей Степин

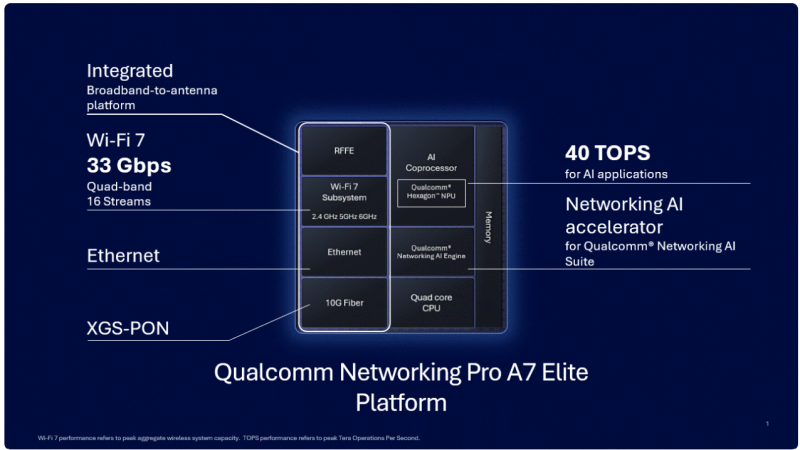

«Элитный» Wi-Fi 7 с ИИ-поддержкой: Qualcomm представила сетевую платформу Pro A7 EliteКомпания Qualcomm объявила о выпуске новой беспроводной сетевой платформы Pro A7 Elite класса «всё-в-одном» с поддержкой беспроводного стандарта Wi-Fi 7 (802.11be) и XGS-PON. Платформа предназначена для размещения на периферии и оснащена широким спектром самых современных сетевых возможностей, дополненных ИИ-функциями. Сердцем новинки является четырёхъядерный процессор, тип и модель которого Qualcomm не разглашает, известно лишь, что в основе лежит 14-нм техпроцесс, а ядра работают на частоте 1,8 ГГц. Процессор работает в паре с памятью DDR3L/DDR4, в качестве накопителя возможно использование флеш-памяти NOR, NAND или eMMC. Зато часть, ответственная за ИИ, хорошо известна — это один из вариантов Qualcomm Hexagon NPU с заявленной производительностью 40 Топс (INT8). Его целью является улучшение работы Wi-Fi, в том числе реализация функций умного классификатора трафика, интеллектуальное управление усилением беспроводного сигнала, детектирование ошибок и др. Платформа может похвастаться развитой сетевой подсистемой: во-первых, в ней реализована поддержка подключений XGS-PON, допускающая работу в качестве шлюза/терминала HGS/ONT или SFU/SFU+ ONU. При этом поддерживается скорость 10 Гбит/с как в восходящем, так и в нисходящем потоках. Проводная Ethernet-часть представлена двумя портами 2.5GbE и одним 10GbE (USXGMII/SGMII+). Wi-Fi-часть Pro A7 Elite предлагает пиковую агрегированную канальную скорость до 33 Гбит/с. Есть поддержка Wi-Fi 7 (802.11be) и Wi-Fi 6/6E (802.11ax), а также совместимость с Wi-Fi 5/4. Радиочасть может обслуживать четыре диапазона одновременно (6/5/2,4 ГГц) и 16 пространственных потоков. Максимальная ширина канала составляет 320 МГц. Для улучшения качества и скорости подключений реализованы технологии Qualcomm Automatic Frequency Coordination (AFC) Service, Simultaneous & Alternating Multi Link и Adaptive Interference Puncturing. Поддерживается WPA3 Personal/Enterprise/Easy Connect. Опционально доступна поддержка 4G/5G FWA, 802.15.4 (Zigbee/Thread) и Bluetooth, реализуемая посредством отдельных модулей. Дополнительно предусмотрено четыре порта PCIe 3.0, порты USB 2.0/3.0, а также интерфейсы I²C, I²S, PTA Coex, SPI и UART. SoC совместима с популярным открытым ПО: OpenWRT, RDK, TiP OpenWiFi, prplOS и OpenSync. Qualcomm уже поставляет образцы Pro A7 Elite.

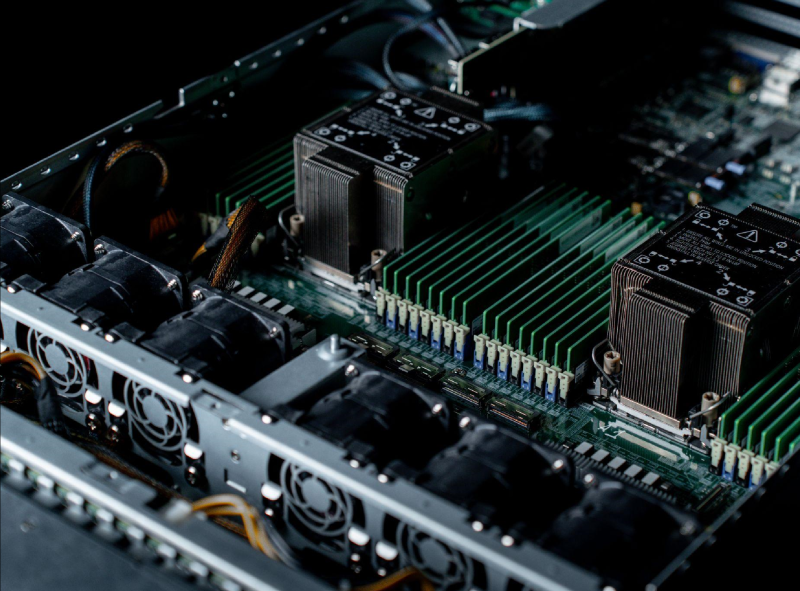

10.10.2024 [20:08], Алексей Степин

Selectel представила первые российские серверы на базе Intel Xeon Sierra Forrest и Granite RapidsКомпания Selectel анонсировала собственную аппаратную платформу, не без оснований претендующую на звание «самого современного российского сервера». Ранее компания собирала серверы из отдельных компонентов других поставщиков, что снижало затраты и степень зависимости от определённого поставщика, но наличие собственной платформы, производимой на контрактных мощностях, должно ещё больше снизить капиталовложения и при этом обеспечить более высокую надежность благодаря контролю за производством. Основой новой платформы является системная плата собственной разработки Selectel, рассчитанная на установку процессоров Xeon 6 (Granite Rapids и Sierra Forest) последнего поколения, а также фирменное шасси, оснащённое двумя блоками питания. При этом в планах Selectel замена прошивок BIOS/UEFI на собственные аналоги, способные обеспечивать нормальную работу сервера и поддержку всех компонентов, а также предоставлять клиентам расширенную функциональность. Впрочем, Selectel продолжит использовать и серверы с системными платами других производителей. В случае собственных серверов Selectel пока речь идёт только о «малом» разъёме Intel LGA 4710, предназначенном для процессоров серий Xeon 6700E (Sierra Forest, до 144 ядер, доступны уже сейчас) и будущих же «малых» вариантов Granite Rapids — Xeon 6700P (до 86 ядер, появятся в I квартале 2025 года). Обе серии характеризуются использованием восьмиканального контроллера памяти DDR5-6400 и теплопакетом до 350 Вт включительно. Для охлаждения использованы мощные вентиляторы со скоростью вращения 16 тыс. об./мин. (шесть или восемь шт.). Новая платформа Selectel имеет двухпроцессорную конфигурацию с 16 разъёмами DIMM на каждый процессор, что позволяет суммарно устанавливать в сервер до 8 Тбайт оперативной памяти. Сервер существует в двух конфигурациях, SSE-I112-G6 (1U) и SSE-I224-G6 (2U). В обоих случаях конфигурацию дополняет сетевой адаптер OCP 3.0 x16. За питание отвечает пара БП CRPS мощностью 1 кВт каждый класса 80+ Platinum с 90-% эффективностью во всем диапазоне нагрузок и возможностью горячей замены. 1U-вариант поддерживает установку 12 SFF NVMe SSD с горячей заменой и двух накопителей M.2 (x2), дополненных двумя ускорителями формата FHHL или тремя — HHHL. 2U-вариант включает до 26 SFF-накопителй — 10 × NVMe + 16 × SAS/SATA — и пару M.2 (x2). При этом ускорителей формата FHHL может быть уже шесть, благо общее количество линий PCIe 5.0 в системе составляет 176 (по 88 на процессор). Удалённое управление сервером осуществляется с помощью BMC с фирменной прошивкой, включающей в себя возможности управления профилями питания и поддержку открытого API Redfish. Новые серверы могут быть арендованы заказчиком в одном из ЦОД компании. Стандартная конфигурация развёртывается в течение 7 мин. с 1/10GbE-подключением и 1-Гбит/с интернет-каналом. но доступны также и произвольные конфигурации с GPU, аппаратными RAID-контроллерами, возможностью апгрейда и сетевым подключением на скоростях до 400 Гбит/с. Также имеется возможность заказа новых серверов Selectel для использования на собственной площадке (on-premise) с арендной моделью оплаты.

10.10.2024 [19:08], Владимир Мироненко

TensorWave привлёк $43 млн на закупку ускорителей AMD Instinct MI300X для своего ИИ-облака, в том числе от самой AMDСтартап TensorWave из Лас-Вегаса провёл раунд финансирования на условиях SAFE (simple agreements for future equity), в результате которого привлёк $43 млн, сообщили ресурсы DataCenter Dynamics и The Register. Условия SAFE означают, что инвесторы имеют право при определённых обстоятельствах конвертировать свои инвестиции в акции компании, но не смогут потребовать возврат денег. Финансовый раунд возглавил вице-президент Nexus, также в нём приняли участие Maverick Capital, Translink Capital, Javelin Venture Partners, Granite Partners и AMD Ventures. Полученные средства TensorWave планирует использовать для оснащения своего основного ЦОД ускорителями AMD Instinct MI300X, на расширение команды, а также на подготовку к внедрению следующего поколения ускорителей Instinct MI325X и запуска новой корпоративной инференс-платформы Manifest в IV квартале 2024 года. По словам компании, Manifest, разработанная для поддержки более крупных контекстных окон ИИ-моделей с уменьшенной задержкой, помимо быстрого инференса позволяет анализировать сложные документы и безопасно обрабатывать и хранить конфиденциальные данные. Основанный в прошлом году стартап TensorWave, в отличие от большинства участников рынка ИИ, использующих ускорители NVIDIA, делает ставку на ускорители AMD Instinct. Разворачивать системы на базе MI300X стартап начал этой весной. Ускоритель MI300X также получил достаточно широкое распространение среди ряда облачных провайдеров. В частности, его использует Microsoft для обслуживания ИИ-модели OpenAI GPT-4 Turbo и многих сервисов Copilot. Oracle готова развернуть кластер из 16 384 MI300X. Также облачный стартап Vultr начал предлагать инстансы на базе MI300X. MI300X имеет больше памяти, чему у того же NVIDIA H100 — 192 Гбайт против 80 Гбайт. С выпуском ускорителей следующего поколения MI325X в конце этого года AMD ещё больше увеличит преимущество, поскольку ёмкость HBM3e-памяти ускорителя вырастет до 288 Гбайт. Это втрое больше, чем у H100, и наполовину больше, чем у будущих ускорителей NVIDIA Blackwell, говорит компания. Больший объём памяти особенно ценен для тех, кто запускает крупные ИИ-модели в FP16-формате. При 1536 Гбайт на узел система на базе MI300X может легко вместить модель Llama 3.1 405B от Meta✴, тогда как при использовании ускорителей H100 для этого её придётся разделить между несколькими системами или ужать с помощью 8-бит квантования. Можно также «втиснуть» несжатую модель в один узел с ускорителями NVIDIA H200, но тогда не останется достаточно места для большего контекстного окна, поддерживаемого моделью.

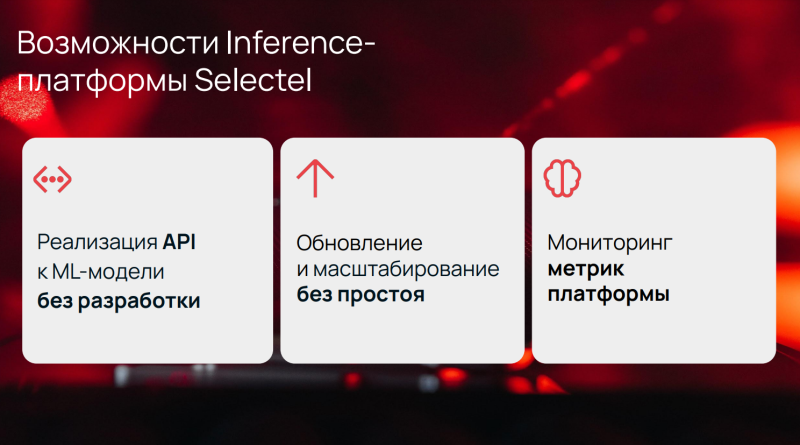

10.10.2024 [14:54], Владимир Мироненко

Selectel запустил бета-тестирование собственной инференс-платформы для ускорения запуска ИИ-моделейРоссийский провайдер сервисов IT-инфраструктуры Selectel приступил к бета-тестированию инференс-платформы собственной разработки, которая позволит упростить запуск ML-моделей в промышленную эксплуатацию и ускорить их работу. Как сообщается на сайте провайдера, с помощью нового сервиса можно всего за несколько минут развернуть готовую модель на вычислительных мощностях провайдера без привлечения разработчиков. Решение нацелено на компании, использующие в работе ИИ-модели для обеспечения функционирования голосовых роботов в колл-центрах, чат-ботов для консультаций сотрудников и клиентов, сервисов распознавания изображений и других задач. С помощью платформы можно загружать модели в объектное хранилище Selectel, а на выходе получить готовые API. Также с её помощью можно регулярно обновлять версии моделей без прекращения обработки поступающих пользовательских запросов. Selectel отметил, что благодаря инференс-платформе можно в несколько раз сократить время вывода ИИ-проектов на рынок, причём с учётом конкретных профилей нагрузок и требований к производительности, которые помогут подобрать и донастроить специалисты ML-команды провайдера. Платформа построена на базе GPU-кластеров Managed Kubernetes с использованием открытых инструментов NVIDIA Triton Inference Server, Ray Serve Cluster и Istio Ingress Controller. Решение полностью независимо от привязки к поставщику (vendor lock) и обеспечивает высокую производительность за счёт встроенных возможностей по повышению пропускной способности и максимальной утилизации ресурсов. |

|