Лента новостей

|

04.04.2025 [08:44], Сергей Карасёв

Объём мирового рынка генеративного ИИ в 2024 году вырос более чем в четыре раза, но заработали на нём в основном поставщики оборудованияКомпания Gartner подвела итоги исследования глобального рынка генеративного ИИ (GenAI) в 2024 году: расходы достигли $364,96 млрд, что на 336,7 % больше по сравнению с предыдущим годом, когда объём отрасли оценивался в $83,57 млрд. Аналитики полагают, что в дальнейшем затраты продолжат увеличиваться, но темпы роста снизятся. Gartner учитывает поставки ИИ-серверов и различного оборудования, включая персональные компьютеры с поддержкой ИИ, а также расходы в сегменте ПО и услуг. Основную часть выручки приносят аппаратные решения. В частности, в 2024 году продажи серверов для задач ИИ, по оценкам, достигли $135,64 млрд — это на 154,7 % больше, чем годом ранее. Всевозможные устройства с функциями ИИ обеспечили $199,6 млрд с ростом на 845,5 % в годовом исчислении. В сегменте ПО отмечен рост на 255,1 % — до $19,16 млрд, тогда как услуги принесли $10,57 млрд, показав прибавку в 177,0 % по отношению к 2023-му. Аналитики Gartner прогнозируют, что в 2025 году затраты на мировом рынке GenAI увеличатся на 76,4 %, достигнув $643,86 млрд. Причём около 80 % от этой суммы придётся на оборудование. Ожидается, что продажи серверов в годовом исчислении поднимутся на 33,1 %, составив $180,62 млрд. Всевозможные устройства с ИИ принесут $398,32 млрд, показав рост на 99,5 %. В сегменте ПО прогнозируется прибавка в 93,9 % — до $37,16 млрд. Услуги обеспечат около $27,76 млрд с ростом на 162,6 % по сравнению с 2024 годом. В целом, аналитики полагают, что технологии ИИ станут неотъемлемой частью многих бизнес-операций и продуктов для корпоративного и потребительского секторов.

03.04.2025 [19:29], Татьяна Золотова

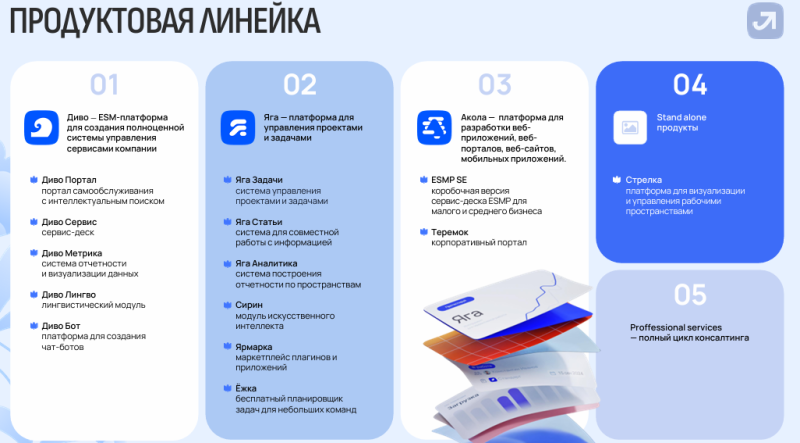

«РТК ИТ Плюс» пополнила ИТ-экосистему «Лукоморье» тремя новыми продуктамиВ экосистему отечественных ИТ-решений «Лукоморье» разработчика программного обеспечения «РТК ИТ Плюс» (входит в ГК «Ростелеком») вошли no-code платформа «Акола», ESM-система «Диво» и система управления пространством «Стрелка». Теперь экосистема состоит из 15 продуктов. В компании надеются, что по итогам 2025 года обновленное «Лукоморье» принесет около 1,5 млрд руб. выручки. «Акола» запущена в августе 2024 года и позволяет создавать корпоративные веб-приложения и сайты без программирования. В семейство no-code платформы входят ESMP SE — коробочная версия сервис-деска ESMP для малого и среднего бизнеса, а также «Теремок» — корпоративный портал. Разработчик утверждает, что у решения нет «прямых аналогов на отечественном рынке», а также что платформа позволяет запускать новые продукты в четыре раза быстрее и в пять раз дешевле по сравнению с традиционным подходом. «Диво» (первое название ESMP) состоит из пяти модулей, автоматизирует работу внутренних ИТ-служб. Встроенный ИИ-модуль классифицирует запросы и предлагает решения. В семейство ESM-системы входят портал самообслуживания с интеллектуальным поиском «Диво Портал», сервис-деск «Диво Сервис», система отчетности и визуализации данных «Диво Метрика», лингвистический модуль «Диво Лингво» и платформа для создания чат-ботов «Диво Бот». По словам генерального директора «РТК ИТ Плюс», внедрение «Диво» позволило «Ростелекому» сэкономить 169 млн руб. в рамках импортозамещения. «Стрелка» (ранее «Интерактивная карта») отвечает за управление рабочим пространством в условиях гибридного формата работы. Система адаптируется к большим офисам и рабочим площадям, а также соответствует требованиям защиты данных госкомпаний. По словам разработчиков, «Стрелка» помогла «Ростелекому», «Теле2» и «ВТБ Капитал» повысить производительность ряда подразделений, процесс размещения персонала стал прозрачнее и занимает меньше времени, сократились конфликты при бронировании переговорных или рабочих мест. Сначала экосистема «Лукоморье» развивалась как набор отдельных решений. В семейство продуктов «Яга» (отечественный вариант Jira, Confluence и др.) входят система управления проектами задачами «Яга Задачи», система для совместной работы с информацией «Яга Статьи», система построения отчетности по пространствам «Яга Аналитика», а также планировщик задач для малых команд «Ёжка», маркетплейс плагинов и приложений «Ярмарка» и ИИ-модуль «Сирин». Кроме того, «Лукоморье» включает Professional services, ориентированные на оказание полного цикла консалтинговых услуг. Выручка «РТК ИТ Плюс» по итогам 2024 года выросла более чем в два раза — до 433,8 млн руб., а штат увеличился на 81 % — до 350 сотрудников. По итогам 2025 года разработчик планирует утроить выручку. Семь разработок компании включены в реестр отечественного программного обеспечения Минцифры.

03.04.2025 [16:47], Руслан Авдеев

Google готовится к аренде ИИ-серверов с ускорителями NVIDIA Blackwell у CoreWeaveКомпания Google близка к тому, чтобы согласиться на сделку с CoreWeave. Предполагается, что гиперскейлер будет арендовать у последней серверы, оснащённые ускорителями серии NVIDIA Blackwell, сообщает The Information. Сделка находится на «поздних стадиях» согласования. Благодаря ей Google сможет получить доступ к большему количеству новейших ИИ-ускорителей. Об этом издание сообщает со ссылкой на два анонимных источника, знакомых с вопросом. Ещё два источника добавили, что Google уже пыталась договориться с конкурентами CoreWeave о доступе к свободным ускорителям — судя по всему, компании не хватает доступных вычислительных мощностей. Возможные партнёры пока не комментируют ситуацию. По информации Seeking Alpha, на момент закрытия торгов в среду акции CoreWeave выросли на 16 %, колебания курсов акций Google и NVIDIA оказались незначительными. По данным The Information, отдельно Google и CoreWeave ведут переговоры об аренде площадей в дата-центрах последней — там Google сможет разместить тензорные ускорители (TPU) собственной разработки, которые компания довольно успешно внедряет наряду с решениями NVIDIA.

Источник изображения: Microsoft Edge/unsplash.com Потенциальное соглашение косвенно свидетельствует о проблемах компаний, желающих пользоваться ускорителями NVIDIA, но не имеющих возможности удовлетворить спрос в полной мере. Уникальные отношения CoreWeave и NVIDIA и возможности оператора ЦОД предоставлять в распоряжение новые ИИ-мощности привлекают крупные облачные сервисы и ключевых ИИ-разработчиков вроде OpenAI и Meta✴. По данным Investing.com, за последние несколько дней крупные ИИ-структуры вроде xAI и OpenAI публично озвучивали необходимость увеличения доступных вычислительных ресурсов. Буквально на днях CoreWeave вышла на IPO — правда, планы развития компании могут оказаться под вопросом, поскольку средств привлечено меньше, чем ожидалось, а капитализация её оказалась значительно меньше, чем рассчитывалось. UPD 29.06.2025: Google действительно арендует ускорители у CoreWeave, но только для того, чтобы сдать их OpenAI. Вероятно, это часть более крупной сделки, в рамках которой OpenAI, по слухам, также начнёт использовать фирменные ускорители Google TPU.

03.04.2025 [16:42], Владимир Мироненко

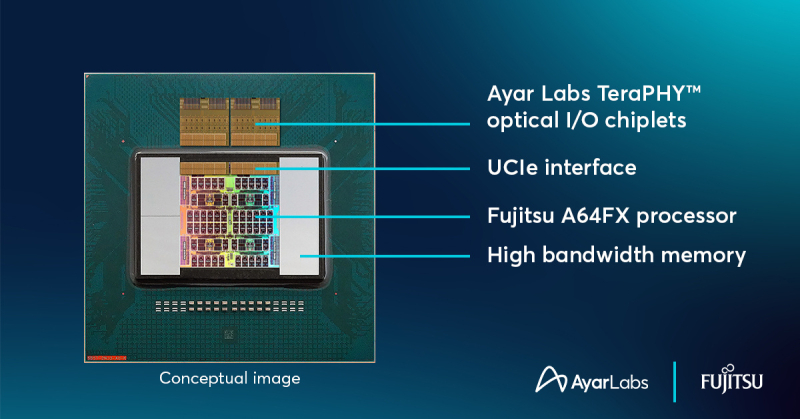

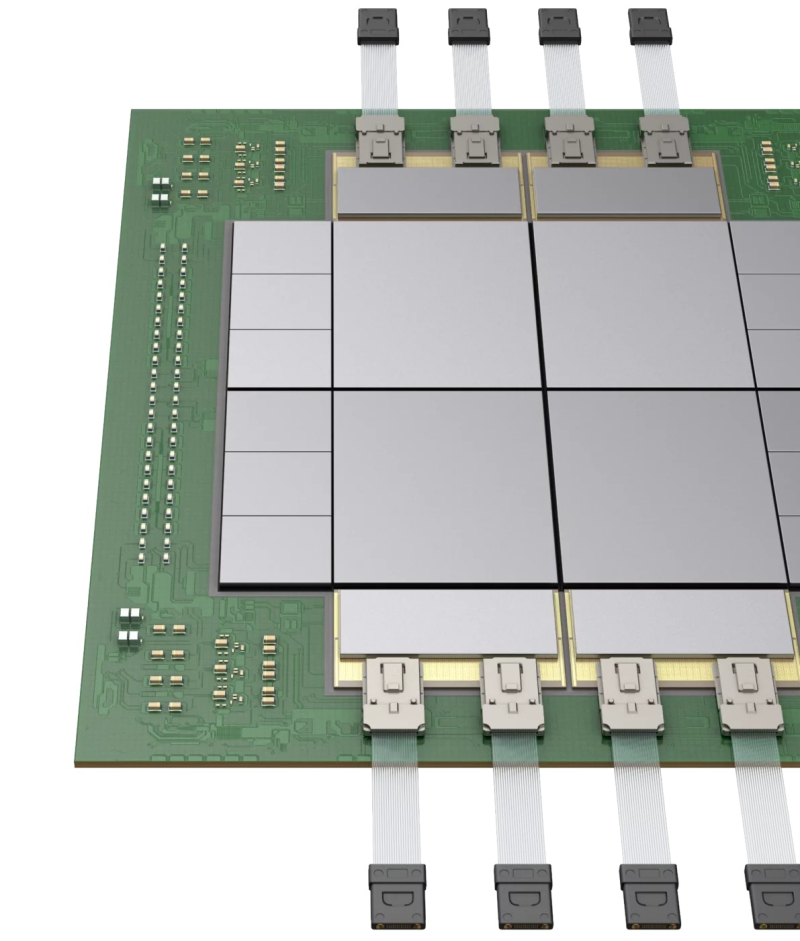

Ayar Labs анонсировала фотонный UCIe-чиплет TeraPHY с пропускной способностью 8 Тбит/сКомпания Ayar Labs, занимающаяся разработкой интерконнекта на базе кремниевой фотоники, анонсировала чиплет оптического I/O TeraPHY, способный обеспечить пропускную способность 8 Тбит/с и использующий оптический источник света SuperNova с поддержкой 16 длин волн. Чиплет поддерживает интерфейс Universal Chiplet Interconnect Express (UCIe), что означает возможность объединения в одном решении чиплетов от разных поставщиков. Ayar Labs отметила, что совместимость со стандартом UCIe позволяет создать более доступную и экономичную экосистему, которая упрощает внедрение передовых оптических технологий, необходимых для масштабирования рабочих ИИ-нагрузок и преодоления ограничений традиционных медных соединений. Ayar Labs сообщила, что объединила кремниевую фотонику с производственными процессами CMOS, чтобы обеспечить использование оптических соединений в форм-факторе чиплета в многочиповых корпусах. Это позволяет GPU и другим ускорителям взаимодействовать на широком диапазоне расстояний, от миллиметров до километров, при этом эффективно функционируя как единый гигантский ускоритель. Ранее компания совместно с Fujitsu показал концепт процессора A64FXс UCIe-чиплетом TeraPHY. Марк Уэйд (Mark Wade), генеральный директор и соучредитель Ayar Labs заявил, что в компании давно увидели потенциал совместно упакованной оптики (CPO), и поэтому занялись внедрением оптических решений в ИИ-приложениях. «Продолжая расширять границы оптических технологий, мы объединяем цепочку поставок, производство, а также процессы тестирования и проверки, необходимые клиентам для масштабного развёртывания этих решений», — подчеркнул он. Среди партнёров Ayar Labs крупнейшие компании отрасли, включая AMD, Intel, NVIDIA и TSMC. В последнем раунде финансирования, прошедшем в декабре прошлого года, компания привлекла $155 млн. Рыночная стоимость Ayar Labs, по оценкам, составляет $1 млрд.

03.04.2025 [15:26], Руслан Авдеев

В Пенсильвании построят газовую электростанцию мощностью 4,5 ГВт для ИИ ЦОД на месте заброшенной угольнойНа месте крупнейшей угольной электростанции Пенсильвании появится новая газовая станция мощностью 4,5 ГВт. Проект предполагает создание ЦОД для ИИ и HPC, а станцию должны ввести в эксплуатацию в 2027 году, сообщает The Register. За реализацию проекта отвечает Homer City Redevelopment (HCR). Потребуется порядка $10 млрд только на развитие энергетической инфраструктуры и подготовку площадки. Ещё миллиарды уйдут на строительство самого дата-центра. Электростанция и ЦОД будут находиться рядом друг с другом. Для преобразования угольных мощностей в газовые потребуется полная перестройка объекта. Зато можно будет использовать оставшуюся энергетическую инфраструктуру, включая линии электропередач и подстанции. HCR не рассказывает о будущих арендаторах, основное внимание уделяется подготовке дата-центра и энергетической инфраструктуре. Проект ориентирован на обеспечение работы ИИ-платформ и гиперскейлеров. Предусмотрено использование газовых турбин General Electric Vernova (GE Vernova), сообщает пресс-служба HCR. Установки предназначены для работы на природном газе, но в будущем их могут перевести и на водород. Впрочем, пока сроки поставок «зелёного» водорода — под вопросом. Хотя предполагается использование в генераторах природного газа, проект позиционируется как «низкоуглеродный», поскольку, по данным HCR, новая станция позволяет сократить выбросы парниковых газов на 60–65 % в сравнении с угольными мощностями, ранее работавшими там же.

Источник изображения: silas Tarus/unsplash.com Место выбрали не случайно. Территория бывшей угольной электростанции в Хомер-Сити (Homer City) уже имеет инфраструктуру, включая линии электропередач, подстанции и доступ к воде. Благодаря этому строительство и подключение к энергосистеме ускорятся и упростятся. Стройка, которую возглавит Kiewit Power Constructors, должна начаться уже в 2025 году, первые турбины планируют установить в 2026 году, а ввод в эксплуатацию намечен на 2027 год, как раз к появлению 600-кВт стоек NVIDIA Rubin Ultra NVL576. Новые электростанции для дата-центров — один из последних трендов в деле обеспечения энергией ИИ ЦОД. Meta✴ строит дата-центр для ИИ в Луизиане и совместно с Entergy готовят газовую электростанцию на 2,2 ГВт. Её также могут перевести на водород в будущем. Microsoft заключила соглашение с Constellation Energy о перезапуске реактора АЭС Three Mile Island. Amazon (AWS) приобрела кампус Cumulus Data в Пенсильвании, расположенный рядом с атомной электростанцией Susquehanna. Meta✴ и Oracle также активно изучают возможности ядерной энергетики. Первая рассчитывает приобрести до 4 ГВт атомной энергии к 2030-м годам, а Oracle намерена построить дата-центр на 1 ГВт с питанием от трёх малых модульных реакторов (SMR). Наконец, в марте появились новости о том, что и Crusoe, и Chevron получат газовые турбины GE Vernova для снабжения электричеством своих ЦОД, тоже по 4,5 ГВт — пока остаётся только догадываться, не идёт ли во всех случаях речь об одних и тех же турбинах. В конце марта сообщалось, что производители газовых генераторов с трудом справляются с заказами для ИИ ЦОД, но расширять производство опасаются из-за возможной низкой маржинальности проектов.

03.04.2025 [13:43], Сергей Карасёв

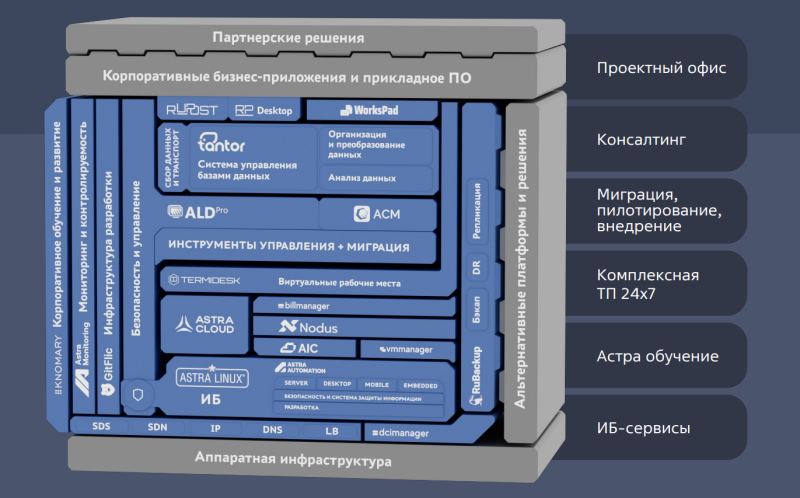

Годовая выручка «Группы Астра» взлетела на 80 %, а прибыль — на 66 %«Группа Астра» отчиталась о работе в 2024 году: выручка поднялась на 80 %, достигнув 17,2 млрд руб. против 9,5 млрд руб. по итогам 2023-го. Столь существенный рост, как отмечается, обусловлен трёхкратным повышением продаж продуктов экосистемы на фоне продолжающегося импортозамещения ПО на российском рынке. Операционная система Astra Linux в 2024 году принесла «Группе Астра» примерно 8,5 млрд руб., что на 35 % больше по сравнению с 6,3 млрд руб., полученными годом ранее. Продукты экосистемы обеспечили 5,5 млрд руб. против 1,7 млрд руб. в 2023 году, что соответствует росту на 213 % в годовом исчислении. По направлению сопровождения ПО отмечен рост на 102 % — с 1,4 млрд руб. до 2,8 млрд руб. Чистая прибыль компании увеличилась на 66 % — с 3,6 млрд руб. до 6,0 млрд руб. Показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) достиг 6,6 млрд руб., поднявшись на 59 % по сравнению с 2023 годом (4,2 млрд руб.). Капитальные затраты на разработку новых продуктов и развитие существующих решений год к году выросли на 108 % — с 1,4 млрд до 2,9 млрд руб. В отчёте отмечается, что «Группы Астра» продолжает расширять штат: в 2024 году он увеличился на 23 % — до 2803 человек, из которых более 70 % составляют IT-специалисты. В июле 2024 года компания запустила первую двухлетнюю мотивационную программу для топ-менеджмента и ключевых сотрудников: её задача заключается в том, чтобы усилить вовлечённость команды в достижение стратегических целей и обеспечить удержание специалистов. Одновременно расширяется взаимодействие с участниками рынка. Количество технологических партнёров увеличилось за год на 26 % — до 1235 компаний. Ассортимент совместимых решений вырос на 28 %, достигнув 3229. В 2024 году «Группа Астра» выпустила обновления для всех своих существующих продуктов, а также представила ряд новых решений, доведя их количество в экосистеме до более чем 35. При этом для повышения управляемости и эффективности разработки, оптимизации продаж, формирования сценариев интеграции и продуктовой стратегии все продукты распределены на восемь блоков: клиентский (Astra Linux), серверный (Astra Linux сервер, Ald Pro), коммуникационный (Rupost, Workspad, Desktop X), данные (Tantor, Tantor DLH), виртуализация (AIC, Termidesk, VMmanager), резервирование, защита данных (RuBackup) и др.

03.04.2025 [12:50], Руслан Авдеев

Ближневосточный след: Cerebras Systems развеяла сомнения регулятора CFIUS в благонадёжности перед выходом на IPOCerebras Systems, разрабатывающая ИИ-ускорители, объявила о решении основных проблем с Комитетом США по иностранным инвестициям (CFIUS) перед выходом на IPO. Главным предметом беспокойства CFIUS стала связь американского стартапа с компанией G42 из ОАЭ, сообщает The Register. На G42, согласно поданным данным о доходах, пришлось более 87 % выручки Cerebras в I половине 2024 года. При этом с середины 2023 года экспорт ИИ-ускорителей в страны Ближнего Востока строго регулируется США. От разработчиков чипов из США требуется получение экспортных лицензий для продажи товаров в регионе. В результате G42 финансировала строительство ИИ-суперкомпьютеров на основе чипов Cerebras на территории США, а общая сумма проектов составила порядка $900 млн. Компания планировала получать к ним удалённый доступ. В рамках IPO G42 также собиралась купить 22 млн акций Cerebras, что, вероятно, вызвало настороженность CFIUS. Ранее G42 уже привлекала внимание американских властей, опасающихся, что закупающая большие объёмы ускорителей на Ближнем Востоке компания может работать на Китай. В результате G42 была вынуждена разорвать связи с рядом партнёров, включая Huawei, рассчитывая «умиротворить» американских регуляторов и устранить препятствия для сотрудничества с Cerebras и Microsoft.

Источник изображения: Nimisha Mekala/unsplash.com В Cerebras заявили, что компания развеяла опасения CFIUS, внеся поправки в соглашение с G42 — последняя сможет приобретать только «неголосующие» акции, поэтому дальнейшая проверка, вероятно, не потребуется. Впрочем, стороны пока не дают дополнительных комментариев. Тем не менее, руководство Cerebras отметило в одной из социальных сетей, что при тесном сотрудничестве с G42 удалось достичь урегулирования с CFIUS. Новости появились менее чем через неделю после того, как ведущие СМИ сообщили, что дебют Cerebras на фондовом рынке был отложен из-за ожидания новых ключевых назначений в администрации США. Условия IPO пока не разглашаются, но ранее сообщалось, что компания намерена привлечь до $1 млрд, а её капитализация составит $7–8 млрд. G42 останется одним из ключевых клиентов Cerebras, но стартап очевидно ориентирован на диверсификацию клиентской базы благодаря платформе «инференс как сервис» и создание масштабной инфраструктуры в США, Канаде и Франции. К концу 2025 года стартап пообещал развернуть более тысячи ускорителей в шести новых ЦОД. Хотя на первый взгляд это не так много в сравнении сотнями тысяч ускорителей, внедряемых xAI и другими компаниями, стоит отметить, что чипы Cerebras размером с целую кремниевую пластину способны обеспечивать производительность до 125 Пфлопс (FP16) — приблизительно в 62 раза выше, чем у моделей серии NVIDIA H100, применяемых для создания суперкомпьютера Colossus с Мемфисе (Теннесси).

03.04.2025 [11:38], Руслан Авдеев

Российская WildTeam выступила генеральным проектировщиком ЦОД общей ёмкостью 350 МВтКомпания WildTeam сегодня является генеральным проектировщиком ряда российских дата-центров общей ёмкостью 350 МВт. Эти объекты должны служить хранилищами, а также инструментами обработки и передачи данных для крупнейших технологических структур Российской Федерации, сообщает пресс-служба компании. WildTeam работает на рынке недвижимости с 2018 года и успешно завершила более 200 проектов — как коммерческих, так и жилых и общественных. Ряд спроектированных ЦОД находятся в Подмосковье — Домодедово и Дубне, а также регионах, расположенных недалеко от российской столицы. В компании утверждают, что проектирование осуществлялось с учётом актуальных требований к надёжности и энергоэффективности объектов. Компания активно внедряет в своих решениях технологии фрикулинга — охлаждения серверов с использованием обычного окружающего воздуха. Это позволяет снизить показатель PUE до 1,15, благодаря чему стоимость эксплуатации ЦОД уменьшается на «десятки процентов». В условиях высоких температур и плотной вычислительной нагрузки дополнительно применяется адиабатическое охлаждение с мелкодисперсным распылением воды и DX (Direct Expansion) системы.

Источник изображения: WildTeam Более того, тепло ЦОД используется для отопления административных помещений, что позволяет экономить до 700 кВт электроэнергии, а эксплуатация объектов становится более экологичной. Вместо традиционных вентиляторных установок применяются строительные вентмашины, что упрощает обслуживание оборудования, ускоряет его ремонт и снижает зависимость операторов от дорогих комплектующих. Дополнительно компания разрабатывает концепции «высокоплотных» ИИ-ЦОД с системами жидкостного охлаждения (СЖО), что обеспечивает оптимальную производительность ресурсоёмких систем нового поколения. Бесперебойное электроснабжение обеспечивается благодаря резервным источникам питания и использованию интеллектуальных систем управления электропитанием. В компании комбинируют ИБП, резервные генераторы, источники возобновляемой энергии и передовые системы мониторинга. Критически важные системы обеспечены питанием даже в случае отказа одной из ДГУ. В результате, даже при перебоях во внешней магистральной электросети и выходе из строя резервных линий, работоспособность объектов сохраняется. ЦОД соответствуют стандартам Uptime Institute Tier III и Tier IV. В WildTeam сообщают, что каждый дата-центр её разработки оснащён административно-бытовыми вспомогательными комплексами с офисами, спортивными залами, переговорными, техническими зонами и другими объектами. В компании ожидают, что её ЦОД станут ориентиром для проектирования современной цифровой инфраструктуры. Инфраструктура ЦОД и сопутствующая энергетика уже в большом дефиците в России. В январе сообщалось, что цены на услуги оборудования в российских ЦОД растут, а в конце февраля поступили данные о том, что в стране скоро может наступить дефицит энергии для обучения ИИ.

03.04.2025 [09:41], Сергей Карасёв

Western Digital выпустила HDD серии Purple Pro ёмкостью 26 Тбайт для систем видеонаблюденияКомпания Western Digital расширила семейство жёстких дисков Purple Pro для интеллектуальных систем видеонаблюдения, анонсировав модель вместимостью 26 Тбайт. Устройство выполнено в LFF-формате, а для подключения служит интерфейс SATA-3. Накопитель использует технологию традиционной магнитной записи (CMR). Конструкция предусматривает наличие 11 пластин, скорость вращения шпинделя составляет 7200 об/мин. Герметичная камера заполнена гелием. Объём буфера равен 512 Мбайт. Скорость передачи информации, согласно техническим характеристикам, достигает 287 Мбайт/с. Новинка способна работать максимум с 64 однопоточными видеокамерами высокой чёткости. Технология AllFrame AI позволяет уменьшить потерю кадров и улучшить воспроизведение, обеспечивая поддержку до 32 потоков данных для аналитики на основе глубокого обучения. Реализована технология OptiNAND, предусматривающая применение флеш-памяти iNAND для поддержания операций по обслуживанию: это помогает поднять производительность и улучшить надёжность. Упомянуты средства WDDA (Western Digital Device Analytics) для управления состоянием. Габариты накопителя составляют 147 × 101,6 × 26,1 мм, масса — 690 г. Диапазон рабочих температур простирается от 0 до +65 °C. Устройство способно поддерживать круглосуточные процессы записи и анализа данных, а нагрузка может достигать 550 Тбайт/год. Показатель MTBF (средняя наработка на отказ) — 2,5 млн часов. Заявленное энергопотребление при чтении/записи — 6,2 Вт, в режиме простоя — 5,7 Вт. Производитель предоставляет на устройство пятилетнюю гарантию.

02.04.2025 [20:32], Владимир Мироненко

Lightmatter анонсировала оптический интерконнект CPO Passage L200 и фотонный 3D-суперчип Passage M1000Lightmatter анонсировала оптический интерконнект 3D co-packaged optics (CPO) Passage L200, разработанный для интеграции с новейшими дизайнами GPU и XPU, а также коммутаторами, предназначенный для обеспечения значительного увеличения скорости обработки ИИ-нагрузок в огромных кластерах из тысяч ускорителей, благодаря устранению узких мест в полосе пропускания интерконнекта. Семейство L200 3D CPO включает версии на 32 Тбит/с (L200) и 64 Тбит/с (L200X), что в 5–10 раз превышает возможности существующих решений. L200 позволяет размещать несколько GPU в одной упаковке, обеспечивая более 200 Тбит/с общей полосы пропускания I/O, что позволяет ускорить обучение и инференс ИИ-моделей до восьми раз.

Источник изображений: Lightmatter В обычных ЦОД ускорители соединены между собой с помощью массива сетевых коммутаторов, которые образуют многоуровневую иерархию. Эта архитектура создает слишком большую задержку, поскольку для того, чтобы один ускоритель мог взаимодействовать с другим, сигнал должен пройти через несколько коммутаторов. Как сообщил ранее в интервью ресурсу SiliconANGLE генеральный директор Lightmatter Ник Харрис (Nick Harris), Passage решает проблему громоздких сетевых соединений, интегрируя свою сверхплотную оптоволоконную технологию в чипы, чтобы улучшить пропускную способность в 100 раз по сравнению с лучшими решениями, используемыми сегодня. «Таким образом, вместо шести или семи слоев коммутации у вас есть два, и каждый GPU может подключаться к тысячам других», — пояснил он. Lightmatter назвала свою архитектуру интерконнекта «I/O без границ» (edgeless I/O) и заявила, что она может масштабировать пропускную способность по всей площади кристалла на GPU, в то время как традиционные кристаллы могут подключаться к другим кристаллам только на краю (shoreline). Интеграция Passage 3D позволяет размещать SerDes-блоки в любом месте кристалла, а не ограничиваться его краями, обеспечивая пропускную способность эквивалентную 40 подключаемых оптических трансиверов. Сообщается, что модульное решение 3D CPO использует стандартный совместимый интерфейс UCIe die-to-die (D2D) и упрощает масштабируемую архитектуру на основе чиплетов для бесшовной интеграции с XPU и коммутаторами следующего поколения. Компания заявила, что грядущий L200 CPO разработан для крупносерийного производства, и она тесно сотрудничает для его подготовки с партнёрами по производству полупроводников, такими как Global Foundries, ASE и Amkor, а также передовыми производителями CMOS. В серийное производство Lightmatter L200 и L200X поступят в следующем году. Lightmatter также анонсировала референсную платформу Passage M1000 — фотонный 3D-суперчип (3D Photonic Superchip), разработанный для XPU и коммутаторов следующего поколения. Passage M1000 обеспечивает рекордную общую оптическую пропускную способность на уровне 114 Тбит/с для самых требовательных приложений ИИ-инфраструктуры. M1000 площадью более 4000 мм² представляет собой многосетчатый активный фотонный интерпозер, который позволяет клиентам создавать свои собственные кастомные соединения с использованием кремниевой фотоники, обеспечивая подключение к множеству GPU в одной 3D-упаковке. Как сообщается, Passage M1000 позволяет преодолеть ограничение по подключению по краям, обеспечивая I/O практически в любом месте на своей поверхности для комплекса кристаллов, размещённых сверху. Интерпозере оснащён обширной и реконфигурируемой сетью волноводов, которая передает WDM-сигналы по всему M1000. Благодаря полностью интегрированному соединению с поддержкой 256 волокон с пропускной способностью 448 Гбит/с на волокно, M1000 обеспечивает на порядок более высокую пропускную способность в меньшем размере корпуса по сравнению с обычными структурами Co-Packaged Optics (CPO) и аналогичными предложениями. Поставки Passage M1000 начнутся этим летом. Среди инвесторов Lightmatter крупные технологические компании, такие как Alphabet и HPE. В последнем раунде финансирования, прошедшем в октябре 2024 года, Lightmatter привлекла $400 млн инвестиций, в результате чего сумма привлечённых компанией средств достигла $850 млн, а её рыночная стоимость теперь оценивается в $4,4 млрд. |

|