…Где рельсы вылезали из кармана страны.

Группа «Мумий Тролль», «Владивосток 2000»

APU

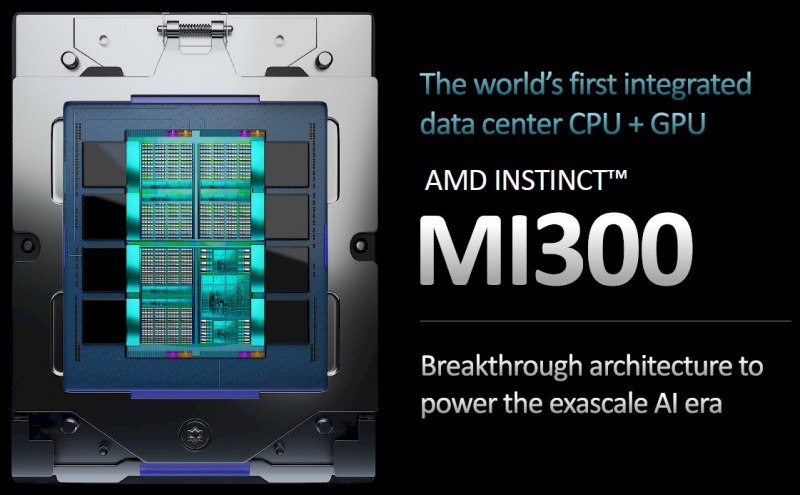

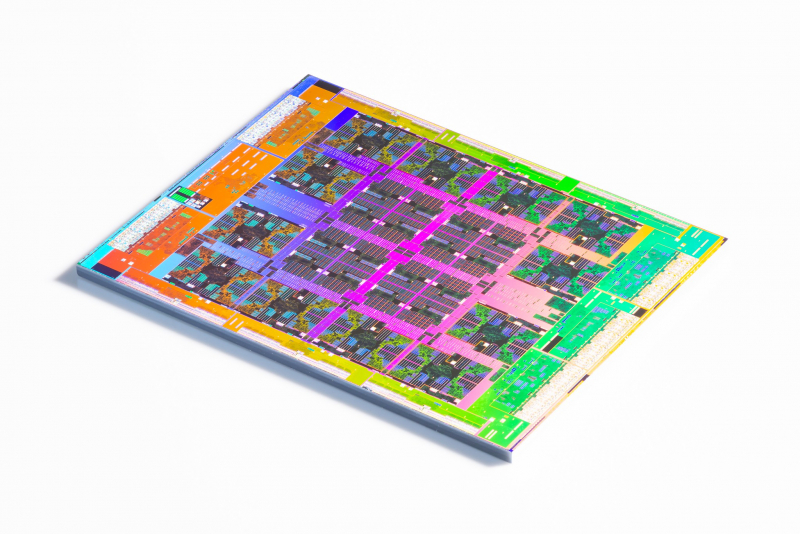

Начнём с самого интересного, с APU, то есть с чипов, объединяющих в своём составе CPU, ускоритель и набортную память. Это не совсем корректный термин, но более привычный. Так вот, в этой области было два главных анонса, от AMD и NVIDIA. В серии Instinct в этом году появятся гибридные MI300, объединяющие 24 ядра Zen 4, ускоритель CDNA 3 и 128 Гбайт общей для обоих вычислительных блоков памяти HBM3. Чип будет дорогим, не массовым и ориентированным на HPC-нагрузки. Он, в частности, станет основой грядущего суперкомпьютера El Capitan с производительностью в 2 экзафлопс.

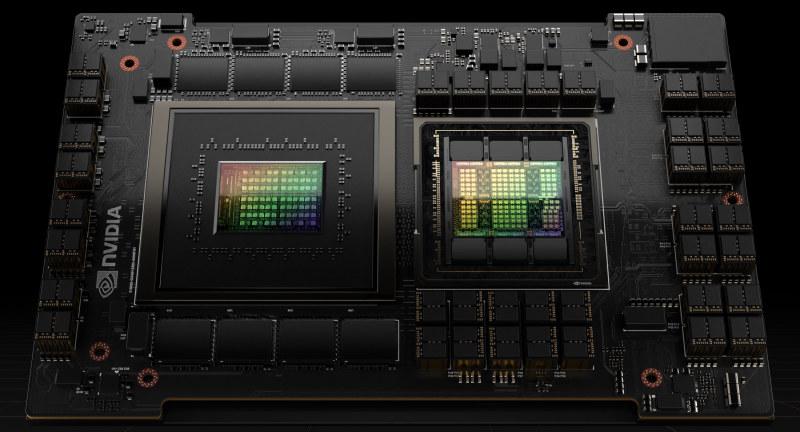

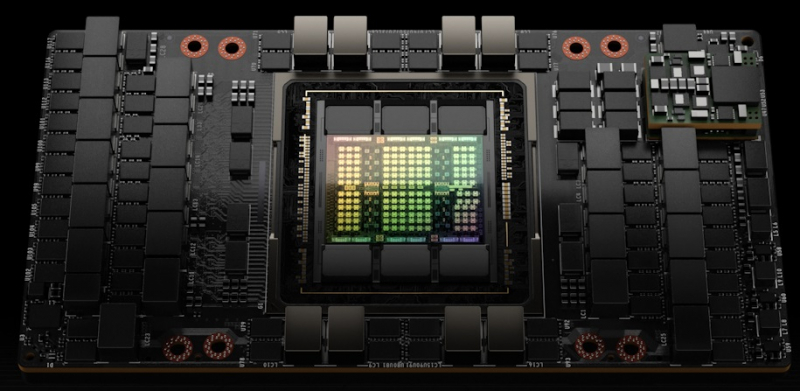

У NVIDIA чуть иной подход — чипы Grace Hopper объединят, как легко догадаться по названию, процессорную часть Grace (половинка Superchip) и ускорительную часть Hopper (H100), чуть подробнее о которых рассказано ниже. Оба чиплета имеют собственную память, но, как и в случае MI300, память будет в той или иной степени общей для всех компонентов (а вот как это будет реализовано на практике, узнаем позже), что позволит не перемещать лишний раз данные между вычислителями разного типа.

Главное, впрочем, что и AMD, и NVIDIA представили новые интерконнекты, которые и позволяют объединить разнородные чиплеты и IP-блоки, собирая как из конструктора SoC с заданной функциональностью. Называются новые интерконнекты Infinity Architecture 4 и NVLink-C2C. Intel, по-видимому, делает ставку на UCIe и в следующем году планирует представить гибридные чипы Falcon Shores, столь же гибко сочетающие x86-ядра и блоки Intel Xe.

Интерконнект и память

Этот раздел неслучайно идёт сразу за APU — по двум причинам. Во-первых, как уже давно и неоднократно говорилось, в индустрии сейчас вообще-то нет особых проблем непосредственно с вычислениями, но есть проблема с эффективной доставкой данных на всех уровнях и масштабированием. APU как раз пытаются решить её, хотя и замыкаясь в себе. Во-вторых, грань и граница между интерконнектом внутри узла и за его пределами становятся всё тоньше. Дальше всех в практическом отношении продвинулась NVIDIA, поскольку NVLink 4 позволяет провязать сразу 256 ускорителей в составе «умной» фабрики, хотя масштабирование выше всё же требует Infiniband.

На физическом уровне все дружно двигаются в сторону интегрированной кремниевой фотоники. Над решениями на уровне межчиповых (и далее) соединений работают, например, Ayar Labs, OpenLight и Intel. Причём две последние компании трудятся над полностью интегрированными решениями, включающими и лазеры. Lightmatter пошла дальше, а точнее глубже, и предложила объединять оптическими соединениями чиплеты внутри чипов. Впрочем, основной проблемой будет не само по себе создание подобных решений, а их удешевление для массового производства.

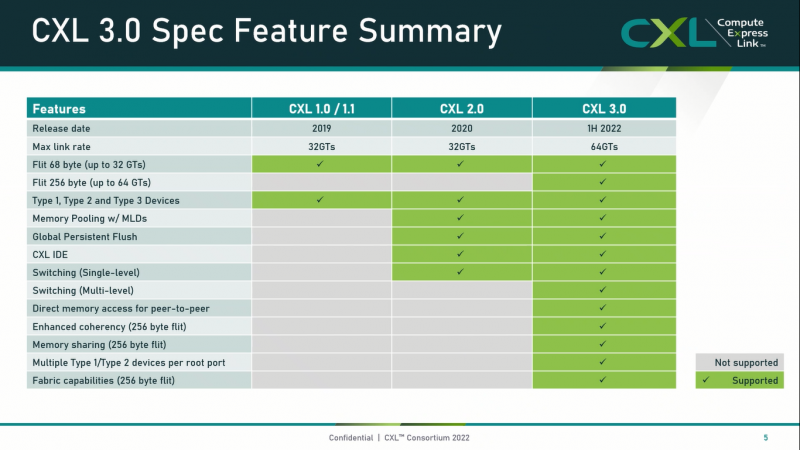

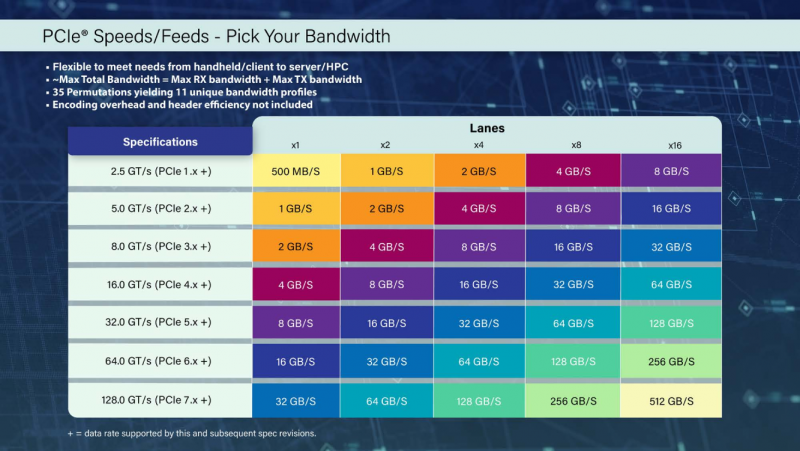

На логическом уровне разброда и шатания уже нет — CXL однозначно победил. Консорциум последовательно вобрал наработки Gen-Z и OpenCAPI (включая OMI), договорился с JEDEC и представил третью версию спецификации, ориентированную в первую очередь на масштабирование. Основой для CXL и в целом для внутриузловых коммуникаций по-прежнему является шина PCIe. Фактически внедрение CXL активно началось с появления PCIe 5.0 в массовых платформах, но задел на будущее уже есть — летом 2022 года PCI-SIG анонсировал PCI Express 7.0.

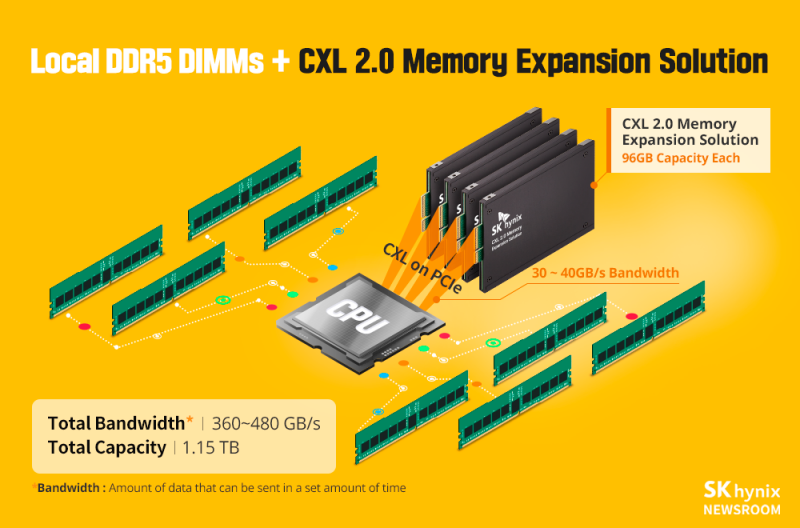

На первом этапе внедрения основным применением CXL станут экспандеры, которые тем не менее позволят экономически эффективно добирать необходимый объём памяти, пусть и с потерей производительности: до уровня стандартных DDR5-4800 и тем более самых быстрых DDR5 MCR DIMM они не дотянут. Ещё одним способом экономии на памяти (если её много не надо) станет использование «небинарных» чипов. Альтернативный подход заключается не в попытке принести как можно больше памяти к вычислителю, а во внедрении вычислителей непосредственно в память.

CXL-память — нативную или в виде адаптеров — предлагают Astera Labs, Microchip, Montage Technology, Samsung и SK hynix. А «умные» CXL-пулы продвигают, например, Tanzanite и Unifabrix. CXL также позволяет создавать любопытные гибриды вроде Memory-Semantic SSD. Фактически CXL в целом ряде задач, где важен объём, а не персистентность, сделал ненужным и Optane PMem, которая окончательно уходит со сцены. Возможно, именно в этом состоит одна из причин полного отказа Intel от 3D XPoint. Хотя сама по себе память типа SCM вряд ли умрёт.

CPU

2022 год начался с анонса большого числа продуктов на базе отечественных Arm-процессоров Baikal-S, которые, равно как и свежие «Эльбрусы», должны были пойти в серию в 2022 году. В результате санкций TSMC не только отказалась выпускать данные CPU, но и уже произведённые партии в Россию не поставила. Однако если в случае с российскими процессорами понятно, кого винить, то в случае с удивительными (давно ли вам в последний раз обещали CPU, который втрое быстрее AMD EPYC 7763 и NVIDIA H100?) чипами Prodigy (128 ядер, 5,7 ГГц, 950 Вт), их разработчик, словацкая компания Tachyum, винит кого угодно, но только не себя. Поставки первых реальных чипов перенесены на первое полугодие 2023-го, но есть сомнения, что компания сдержит обещания.

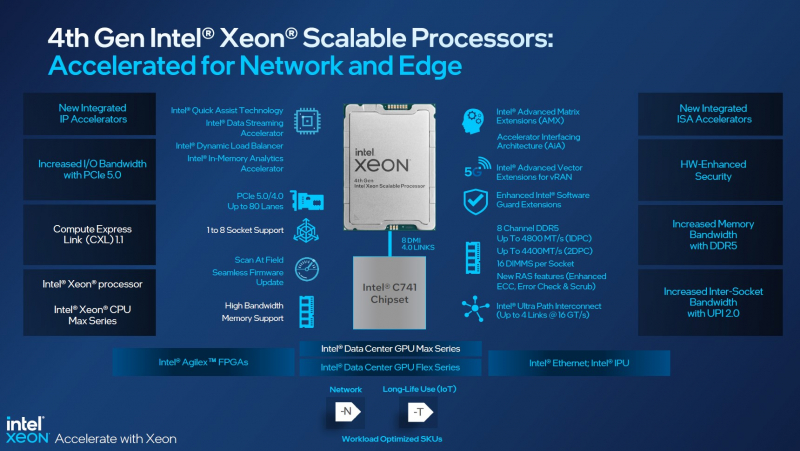

А вот Intel не отрицает свою вину в более чем годовой задержке выхода Xeon Sapphire Rapids (SPR), в результате которой она даже умудрилась подставить NVIDIA. Зато с ними ситуация теперь наверняка будет как с советскими креповыми носками, то есть как минимум по доступности эти чипы у EPYC будут выигрывать. Ну и в некоторых других технических аспектах тоже, но всё равно сравнивать 60 ядер SPR с 96 ядрами (теперь и с AVX-512) у EPYC Genoa как-то даже неудобно, не говоря уж об официальных ценах. Впрочем, правила нынче диктуют гиперскейлеры, так что AMD, склонившая на свою сторону Meta✴, денег, может, много и не заработает, но долю рынка у Intel, которая закончила год с существенными потерями, отъест, даже несмотря на оптимистичные прогнозы в отношении Arm.

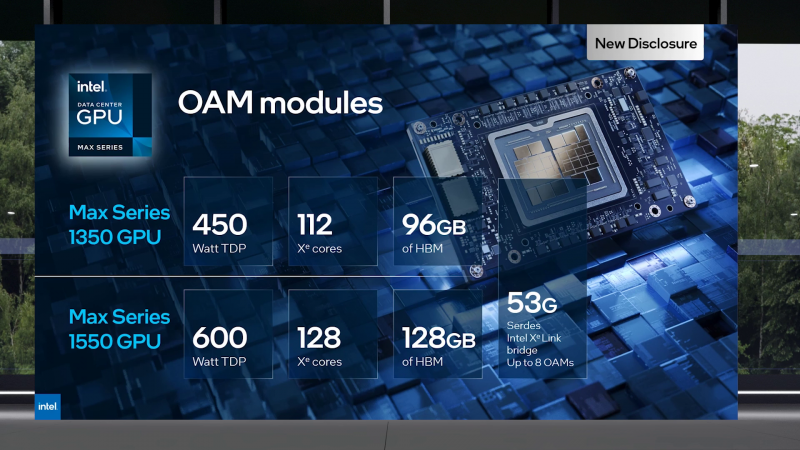

Строго говоря, выход Genoa тоже задержался, что позволило сделать важные улучшения. Но это проблемой не стало, поскольку AMD изначально и не создавала соперника Sapphire Rapids. Intel же, не сумев догнать конкурента по числу ядер, пошла по иному пути, напичкав процессоры ускорителями для различных типов нагрузок, активируемых по запросу и за отдельную плату (On-Demand, ранее SDSi). Вот только схема эта получилась очень запутанной, а про работу самого механизма активации на практике сведений пока нет. Единственным светлым пятном в новом поколении Xeon является отдельная серия Max с набортной HBM2e-памятью, которая должна достойно конкурировать с EPYC Milan-X в HPC-нагрузках.

Но AMD, которой EPYC в прошлом году существенно помогли, уже в этом году пообещала выпустить Genoa-X, Siena и Bergamo. Последние будут ориентированы на гиперскейлеров. Intel для них готовит чипы Sierra Forrest, но они выйдут вместе с Granite Rapids только в следующем году, а в этом компания намерена представить Emerald Rapids, которые будут делить платформу с Sapphire Rapids. Китайская серверная x86-экзотика представлена чипами Zhaoxin Kaisheng KH-40000, а также Montage Jintide 4-го поколения (доработанные Sapphire Rapids). Из «малых» чипов стоит отметить появление Intel Xeon Ice Lake-D и Ryzen Embedded V3000.

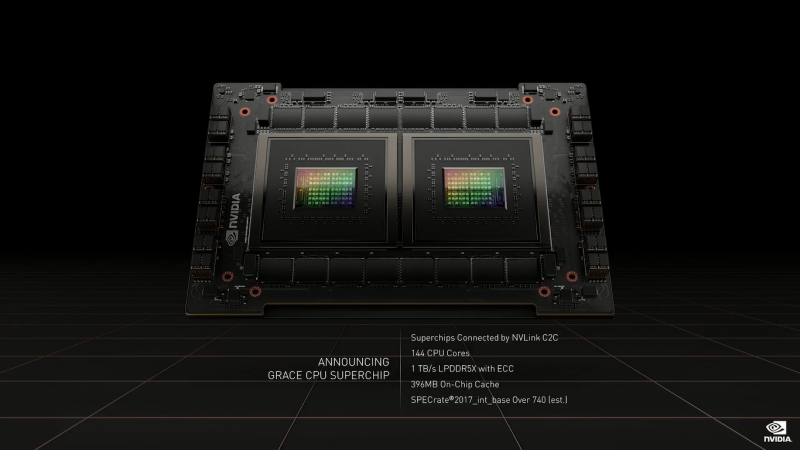

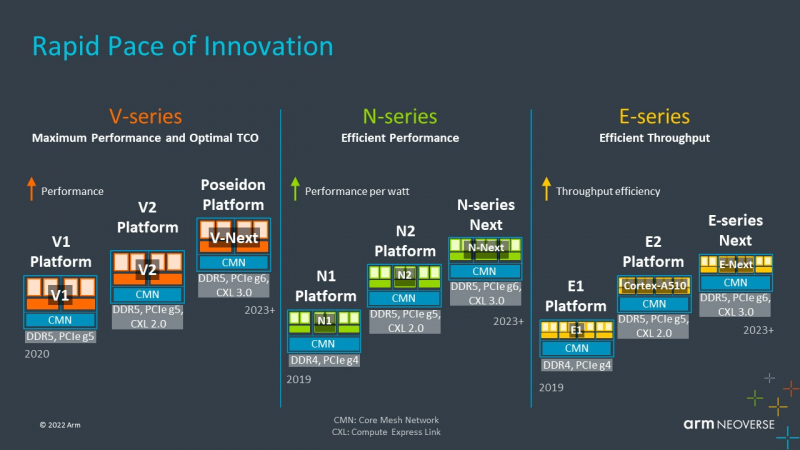

В стане Arm тоже произошло немало интересного. Так, NVIDIA представила 144-ядерные Grace Superchip на базе новых ядер Neoverse V2 (Demeter), несущие на борту сразу 960 Гбайт LPDDR5x-памяти и укладывающиеся при этом в 500 Вт TDP. Сама Arm после срыва сделки с NVIDIA занялась странным. И речь не про экспериментальный сверхбезопасный процессор Morello, а про про иск к Qualcomm, возжелавшей использовать наработки поглощённой Nuvia для возврата на серверный рынок. Это не первая попытка Qualcomm на этом поприще — более подробную историческую справку читайте в обзоре процессора Altra от Ampere Computing.

Последняя, к слову, в этом году представит новое поколение своих CPU. Вообще для Ampere 2022 год был крайне удачным в плане развития экосистемы и доступности — она представила не один десяток платформ, в том числе в облаках. Но главное облако в мире, AWS, продолжает развивать собственную серию Arm-процессоров, которая пополнилась чипом Graviton3E, оптимизированным для HPC-задач. Так что, возможно, Джим Келлер был прав, назвав глупостью отказ AMD от развития серверных Arm-процессоров.

Архитектура RISC-V в ушедшем году отметилась в основном всякими маломощными решениями, даже Intel временно проявила активность в этом направлении, не забывая, однако, и про более серьёзные HPC-решения. Но были и два ярких момента. Во-первых, Google призналась, что использует ядра SiFive совместно со своими ускорителями (тот же подход развивает Евросоюз). Во-вторых, Ventana анонсировала Veyron V1, первый по-настоящему серверный RISC-V-процессор аж на 192 ядра с частотой 3,6 ГГц. Как на ещё одну «домашнюю» архитектуру для CPU общего назначения, на RISC-V внимательно смотрит и Китай, у которого уже есть LoongArch, представленная нынче 32-ядерными Loongson.

Ускорители

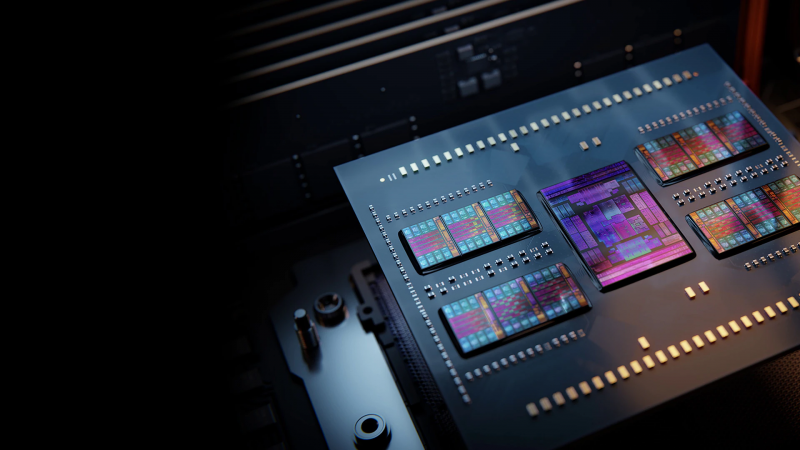

MI300 от AMD, как и говорилось в самом начале, это APU, а вот собирается ли компания представить негибридный ускоритель — неизвестно. Зато AMD сообщила о подготовке платформы XDNA на базе FPGA. NVIDIA же представила как APU, так и «просто ускорители» H100 (Hopper). Intel выпустила подзадержавшиеся Ponte Vecchio под брендом Max и начала готовить наследника — Rialto Bridge. Также компания представила Agilex M и сообщила о подготовке других, более современных FPGA Agilex. Большая тройка также представила или анонсировала и ряд условно малых универсальных ускорителей.

В области исключительно ИИ-решений картинка поживее. Были представлены большие ИИ-комплексы вроде SambaNova DataScale SN30 или Tesla Dojo (D1). Показали себя новые игроки: Moffet и Sapeon (оба для инференс-задач), Biren (весьма мощные решения) и Untether AI (1,5 тысячи ядер RISC-V). Опытные вендоры тоже без дела не сидели — Intel анонсировала Habana Gaudi2 и Greco, а Graphcore рассказала про новые BOW IPU и представила особую версию ускорителя для рынков Китая и Сингапура.

Сделано это было неслучайно — США фактически запретили поставку мощных ускорителей в Китай и Россию. Критерием мощности, то есть производительности, в данном случае стали не флопсы, а скорость обмена данными, которая не должна превышать 600 Гбайт/с, что соответствует уровню NVLink в NVIDIA A100. Ограничение скорости не позволяет эффективно масштабировать нагрузки, объединяя несколько ускорителей. Естественно, производители тут же нашли выход. Так, китайская Biren, которую ненадолго отлучили от TSMC, подкорректировала характеристики своего продукта, а NVIDIA выпустила A800, урезанную версию A100.

Из экзотических решений можно вспомнить фотонные ИИ-ускорители Luminous Computing и Salience Labs, а также российский суперкомпьютер «Тераграф» с уникальной архитектурой и обещания Ceremorphic создать по-настоящему универсальный процессор, отобрав лавры у упомянутой выше Tachyum. В области нейроморфных систем нельзя не упомянуть выпуск плат BrainChip и Intel Kapoho Point, а также российские чипы «Алтай».

К ускорителям в определённом смысле можно отнести и квантовые компьютеры, которыми, как и отдельными ИИ-кластерами, всё чаще планируется дополнять традиционные суперкомпьютеры. Практически все разработчики систем квантовых вычислений стремятся прямо или опосредованно предоставить облачный доступ и облегчить интеграцию с традиционными вычислениями. Рынок ещё молод, но серьёзных потрясений (ни хороших, ни плохих) в ближайшем будущем ждать не стоит. На рынке HPC, который является одним из ключевых потребителей любых ускорителей, к слову, тоже.

DPU

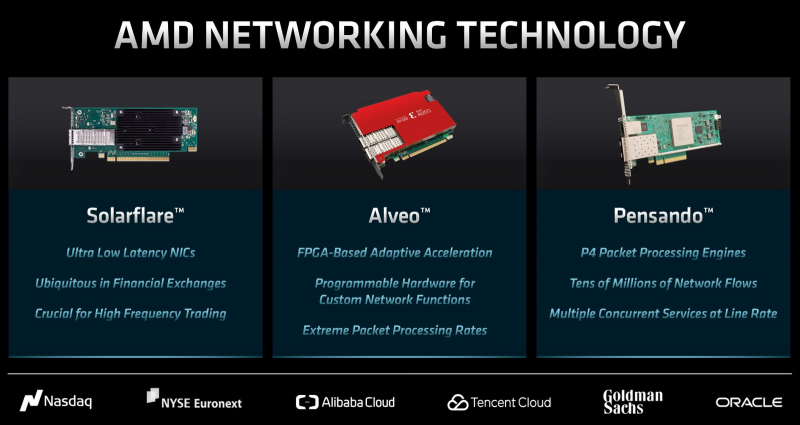

Родоначальник идеи DPU (Data Processing Units), то есть AWS, в ушедшем году представил уже пятое поколение Nitro. Alibaba Cloud тоже решила разработать собственные решения под названием CIPU, а Google, как и планировалось, начала внедрять IPU — они в 2024 году должны дорасти до 400G, а ещё через пару лет освоить и 800G. Meta✴ открыто свои предпочтения не называет, но переманила к себе руководителя разработки IPU. Microsoft же просто поглотила стартап Fungible, одного из пионеров DPU, у которого начались проблемы и который, по слухам, безуспешно пытался продаться Meta✴. От NVIDIA в ушедшем году особенно важных новостей в этой сфере не было, но компания явно готовится к массовому запуску BlueField-3.

Pensando, будучи уже в составе AMD, представила гибридную 400G-платформу Exotic и уже готовит 400G/800G-решения Giglio и Salina, которые появятся в течение двух лет. Для AMD это вообще одна из самых удачных сделок, завершающих формирование «трёх сокетов». У Chelsio тоже вышли 400G-продукты, седьмое поколение Terminator. Да и в целом индустрия постепенно осваивает 400G и 800G, дополняемые если уж не DPU, то хотя бы SmartNIC. Но главное, пожалуй, что в 2022 году поддержка DPU появилась у VMware, а в рамках Linux Foundation запущен проект Open Programmable Infrastructure (ONI), целью которого является разработка открытых программных стандартов для DPU, IPU и SmartNIC.

Хранилище

Помодельно рассматривать все новинки нет смысла, их слишком много, хотя среди них были отдельные жемчужины вроде 26-Тбайт SMR-накопителя от Western Digital или обновлённых Seagate MACH.2 и WD Ultrastar DC HS760 с двумя актуаторами. Но в целом можно отметить, что поставки HDD заметно упали, в том числе из-за роста их ёмкости. Однако внедрение NAND с 200+ слоями и освоение QLC обострило конкуренцию между SSD и HDD, да и в целом резкий рост пророчат только NVMe. И да, новым SSD, вполне возможно, понадобится активное охлаждение. А вот NVMe HDD мы не дождались, но уже есть обходные решения на уровне СХД. Вечно живыми остаются и развиваются ленточные накопители и оптические диски.

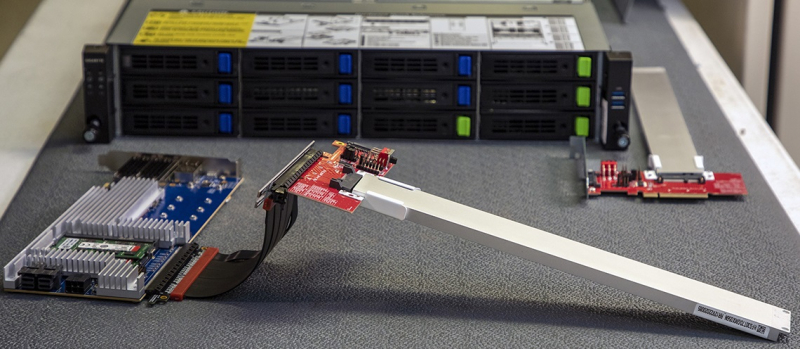

В области хранилищ любопытно использование GPU — соответствующие обновления представили, к примеру, GRAID и Nyriad, а вскоре к ним, похоже, присоединится VAST Data. Специализированные ускорители для СХД показала MaxLinear. А Intel неожиданно решила прекратить поддержку VROC, но затем резко передумала. Она же выпустила и последние Optane SSD. Но есть и позитивные моменты — с появлением Sapphire Rapids сразу несколько крупных вендоров представили массовые платформы с поддержкой EDSFF, в основном E1.S и E3.S.

В прошлом году разработчики также показали различные прототипы и решения в области SmartSSD — Macronix анонсировала «умную» NAND FortiX, LANL и SK hynix протестировали KV-SSD, а Samsung в дополнение к упомянутому выше гибриду Memory-Semantic SSD показала сразу два накопителя, с FPGA Xilinx и тысячеядерным Esperanto ET-SoC-1. Видимо, это направление действительно перспективно, раз даже SNIA выпустила первую версию стандарта вычислительных накопителей. Напоследок отметим уход со сцены важного когда-то игрока — Pavilion Data, которая некогда одной из первых создала сверхбыстрые NVMe-oF СХД, прекратила существование.

ЦОД

Крупнейшей закрытой сделкой формально стала продажа оператора Switch за $11 млрд (если не считать начатой ещё в 2021 году $15-млрд сделки с CyrusOne), а вот вторая по величине сделка — продажа Global Switch за $10 млрд — зашла в тупик. По объёму сделок 2022 год ($48 млрд) чуть-чуть не дотянул до 2021-го ($49 млрд), да и операторы с гиперскейлерами слегка притормозили развитие. Meta✴ даже приостановила строительство ряда кампусов для полной переработки архитектуры своих ЦОД с упором на ИИ и СЖО. А большая тройка облаков начала 2023 год с массовых увольнений и пересмотра политики дальнейшего развития. Intel отказалась от $700-млн лаборатории по развитию решений для ЦОД.

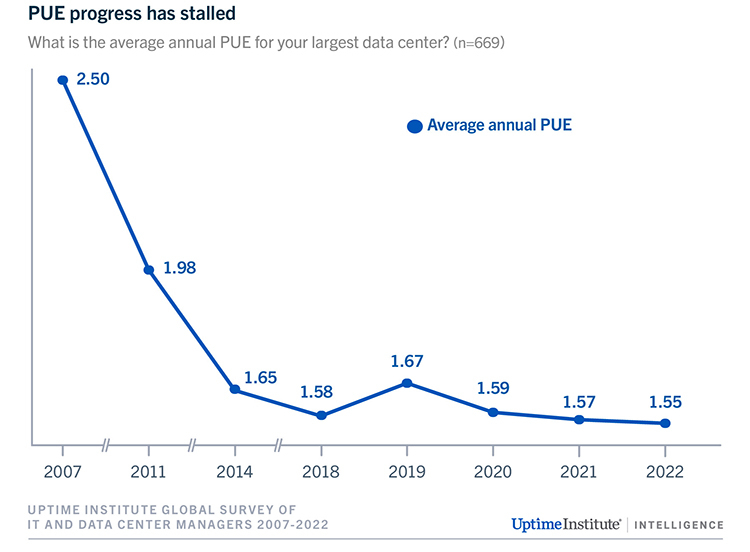

Источник: Uptime Institute

Uptime Institute ожидает замедления темпов миграции в публичные облака, а кто-то уже говорит и о «репатриации» нагрузок. Но в целом рост индустрии сохраняется, хотя проблем меньше не становится: число сбоев не упало (опять пожары), энергоэффективность не растёт который год, местами (особенно в Ирландии, Нидерландах и Сингапуре) наблюдается энергетический кризис (Microsoft пожаловалась, что затраты на электричество оказались на $800 млн выше предполагаемых). Отдельной строкой идут экологические проблемы и новые инициативы регуляторов вроде попыток принудительной отдачи избыточного тепла в системы отопления.

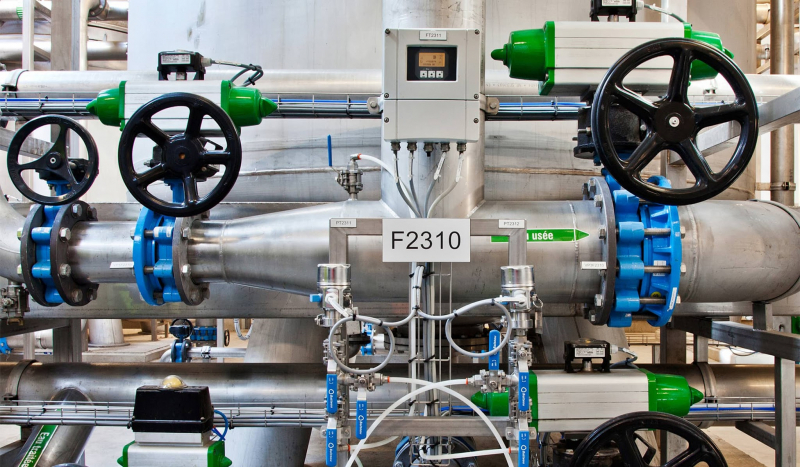

На фоне аномальной жары острее стали и вопросы водопотребления дата-центров, которое напрямую связано с охлаждением, в том числе с попытками внедрить СЖО — а без них, по-видимому, в обозримом будущем уже не обойтись. Equinix и Meta✴, тем не менее, решили поднять температуру в машинных залах ради экономии средств. Особняком на рынке стоит Северная Вирджиния, которая по-прежнему обгоняет по ёмкости сверхкрупных дата-центров и Европу, и Китай. От ЦОД местные жители устали настолько, что готовы судиться с властями.

Заключение

В условиях, как это принято сейчас говорить, не называя вещи своими именами, сложившейся геополитической обстановки Россия оказалась несколько оторвана от мировых тенденций. Большая часть года прошла под двумя тегами: санкции и импортозамещение (по ссылкам информация не только про Россию, но и про Китай). Немалая часть зарубежных IT-компаний покинула Россию, хотя подход к этому процессу был совершенно разным, а кто-то даже и не собирался уходить. Одни действительно окончательно ушли, избавившись тем или иным образом от активов. Другие ушли лишь формально, либо продав или передав местные подразделения в руки локальных менеджеров, нередко с припиской в договоре о приоритетном праве возврата в родное лоно в случае ослабления давления, либо вообще ограничившись общими словами и туманными формулировками на официальных сайтах.

Не обошлось и без казусов, когда сразу несколько новоявленных компаний называли себя официальными наследниками и преемниками одного и того же вендора. Часть не ушла, а резко переориентировалась, например отказавшись от продаж, но сохранив разработку. Кроме того, были и зеркальные действия — ныне крупные международные компании с российскими корнями тоже отделили местные подразделения от глобальных. Заодно часть из них поменяла официальных владельцев, которые попали под санкции. Ещё одна черта — крупные российские игроки стали скупать компании поменьше, причём из областей, далеко не всегда связанных с их основным видом деятельности. Некоторые устроили настоящую охоту за специалистами и целыми командами из ушедших компаний.

Но основная проблема сейчас — это не резко снизившиеся поставки оборудования и компонентов, поскольку параллельный импорт худо-бедно работает, порождая удивительные предложения вроде 2U-серверов с 20 процессорами или вызывая резкий рост облаков. Нет, просто «неожиданно» выяснилось, что Россия сильно зависима от иностранного ПО, без которого аппаратура бесполезна. А параллельно произошёл отток разработчиков и иных IT-специалистов — пример Deutsche Bank один из ярких, но далеко не единственный. Ожидается, что госпрограммы станут основным драйвером импортозамещения, особенно в области информационной безопасности. Но это же усилит и зависимость разработчиков от государства, это совсем иной рынок. Так что хорошо бы в первую очередь думать о людях и не совершать необдуманных поступков, тогда и с последствиями бороться не придётся.

Чтобы ничего не пропустить в новом году, подпишитесь на нас в Twitter, Telegram, LinkedIn, Google News или Zen.