Материалы по тегу: фотоника

|

16.02.2026 [09:35], Сергей Карасёв

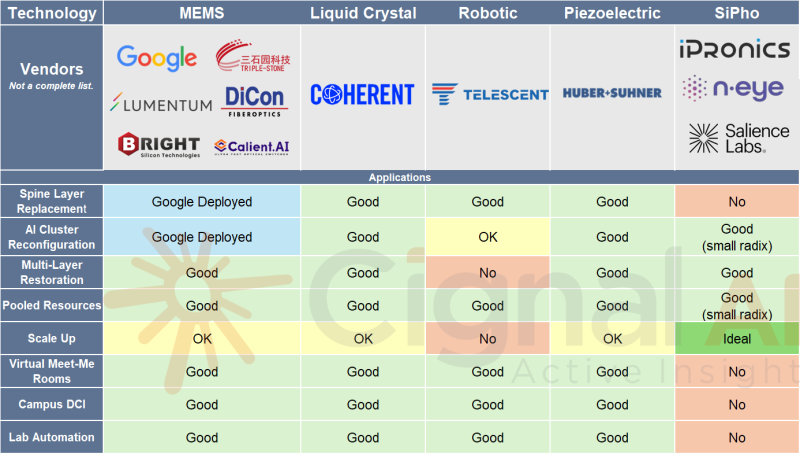

Мировой рынок оптических коммутаторов к 2029 году достигнет $2,5 млрд, но львиная доля всё равно придётся на GoogleИсследовательская компания Cignal AI повысила прогноз по глобальному рынку оптических коммутаторов (OCS). Связано это с ускоренным развёртыванием кластеров ИИ на базе тензорных ускорителей (TPU) Google. Аналитики пришли к выводу, что сектор OCS имеет гораздо больший потенциал, нежели предполагалось ранее. Google применяет оптические коммутаторы собственной разработки Apollo на базе MEMS-переключателей для формированя ИИ-кластеров. По заявлениям Google, решения OCS быстрее, дешевле и потребляют меньше энергии по сравнению с InfiniBand. Cignal AI полагает, что объём мирового рынка OCS в 2026 году окажется в три раза больше, чем ожидалось ранее. Прогноз на 2029 год повышен более чем на 40 % по сравнению с цифрами, опубликованными в декабре: аналитики считают, что к этому времени продажи оптических коммутаторов увеличатся как минимум до $2,5 млрд. Предполагается, что до конца десятилетия большинство развёртываний OCS будут по-прежнему сосредоточены в инфраструктуре Google. При этом в ЦОД на основе GPU-ускорителей применение OCS окажется ограниченным: связано это с тем, что в таких экосистемах переход на оптические коммутаторы сопряжён со значительными техническими сложностями. В целом, внедрение OCS за пределами дата-центров Google пока находится на стадии проверки концепции и раннего тестирования. «Общий потенциал рынка, безусловно, исчисляется миллиардами долларов, но основная часть краткосрочных инвестиций останется в пределах внутренних проектов Google», — говорит Скотт Уилкинсон (Scott Wilkinson), ведущий аналитик Cignal AI. Ранее эксперименты в этом направлении проводила Meta✴. Впрочем, не так давно в рамках OCP появилась отдельный проект OCS (Optical Circuit Switching), направленный на ускорение внедрения технологий оптической коммутации в ИИ ЦОД, что потенциально может ускорить развитие рынка.

10.02.2026 [13:01], Руслан Авдеев

Tower Semiconductor и NVIDIA объединились для создания 1,6-Тбит/с трансиверов на основе кремниевой фотоникиTower Semiconductor объявила, что работает с NVIDIA над созданием оптических модулей, предназначенных для ИИ-инфраструктуры нового поколения и способных передавать данные со скоростью до 1,6 Тбит/с. Для этого будет применяться производственная платформа Tower Semiconductor для кремниевой фотоники (SiPho), сообщает Converge! Digest. Взаимодействие ориентировано на обеспечение высокоскоростных оптических подключений в комбинации с сетевыми протоколами NVIDIA. Tower Semiconductor объявила, что её платформа SiPho может обеспечивать показатели вдвое лучшие, чем предыдущие решения на основе кремниевой фотоники, для обучения ИИ и инференса. Компания позиционирует свою технологию производства как основу для оптических трансиверов и сетевых компонентов, используемых в крупных ЦОД, где оптические решения всё активнее заменяют электрические кабели и применяются на более коротких расстояниях. Источник изображения: Igor Omilaev/unsplash.com По словам Tower Semiconductor, компания продолжает инвестиции в кремний-германиевые решения (SiGe) и кремниевую фотонику в целом. ИИ-решения уже требуют внедрения 800G-интерконнектов, поэтому нужны готовые технологии на основе кремниевой фотоники для выпуска 1,6-Тбит/с решений. Стоит отметить, что в декабре 2025 года появилась новость о том, что NVIDIA в рамках своей стратегии развития зарезервировала крупные объёмы продукции у ключевых поставщиков EML-лазеров, что привело к увеличению сроков их поставки другим клиентам — не ранее 2027 года. В связи с этим производители оптических модулей и облачные провайдеры вынуждены заниматься поиском вторичных поставщиков и альтернативных решений.

30.01.2026 [10:43], Сергей Карасёв

Lightmatter представила оптический VLSP-движок Guide для ИИ-платформ нового поколенияКомпания Lightmatter, специализирующаяся на разработке ИИ-ускорителей и других продуктов на основе фотоники, объявила о «фундаментальном прорыве» в лазерной архитектуре для систем передачи данных: представлена т.н. платформа сверхмасштабируемой фотоники — Very Large Scale Photonics (VLSP). Первым изделием на её основе стал оптический движок Guide, ориентированный на ИИ-системы следующего поколения. Отмечается, что современные решения CPO (Co-Packaged Optics) и NPO (Near-Package Optics) базируются на дискретных лазерных диодах на основе фосфида индия (InP), интегрированных в модули ELSFP (External Laser Small Form Factor Pluggable). Однако эти архитектуры сталкиваются с трудностями, обусловленными ограничениями по мощности. Компоненты, при изготовлении которых используется эпоксидная смола, уязвимы к термическому повреждению. Вместе с тем для удвоения полосы пропускания требуется кратное увеличение количества ELSFP, что приводит к соответствующему повышению стоимости и энергопотребления, а также к увеличению занимаемого пространства. Кроме того, в случае дискретных лазеров могут возникать проблемы с обеспечением точного разнесения длин волн. Изделие Guide VLSP, как утверждается, устраняет существующие ограничения. Новая интегрированная архитектура по сравнению с дискретными лазерными модулями позволяет сократить количество компонентов, предлагая при этом значительно более высокую производительность и улучшенную надёжность. Технология предусматривает возможность масштабирования от 1 до 64+ длин волн при одновременном снижении сложности сборки. В результате значительно повышается плотность компоновки: платформа Guide первого поколения обеспечивает коммутационную способность до 100 Тбит/с в 1U-шасси. Для сравнения, в случае обычных решений потребовалось бы 18 модулей ELSFP в шасси высотой 4U. Движок Guide используется в валидационных платформах Passage M-Series и L-Series (Bobcat). Говорится, что изделие обеспечивает пропускную способность до 51,2 Тбит/с на лазерный модуль в случае NPO и CPO. Выходная мощность составляет не менее 100 мВт в расчёте на оптическое волокно. Возможна генерация 16 длин волн с мультиплексированием. Поддерживаются двунаправленные фотонные каналы связи, в которых две сетки длин волн с шагом 400 ГГц чередуются с точным смещением на 200 ГГц (±20 ГГц). Новая платформа уже доступна заказчикам для тестирования. Между тем компания Lightmatter сообщила о заключении сразу нескольких партнёрских соглашений. В частности, планируется интеграция решений Synopsys в платформу Lightmatter Passage 3D Co-Packaged Optics. В сотрудничестве с Global Unichip Corp. (GUC) Lightmatter намерена заняться разработкой CPO-продуктов для гиперскейлеров, ориентированных на ИИ. Кроме того, Lightmatter и Cadence объединили усилия с целью ускорения разработки передового интерконнекта для ИИ-инфраструктур.

26.01.2026 [09:39], Владимир Мироненко

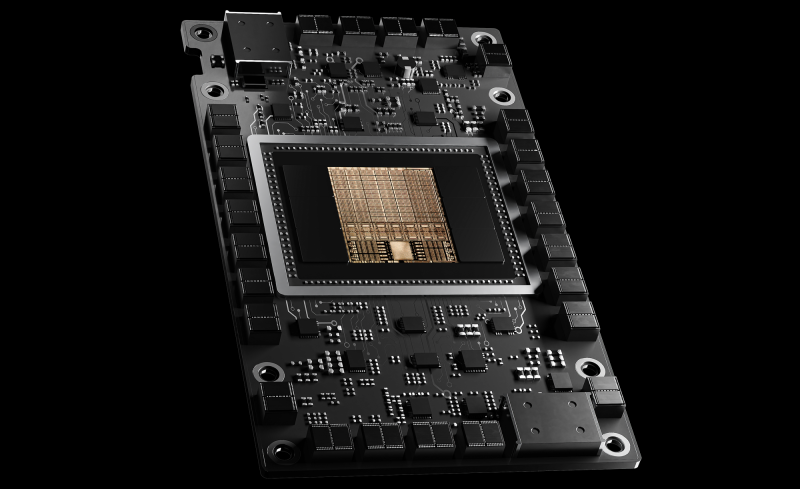

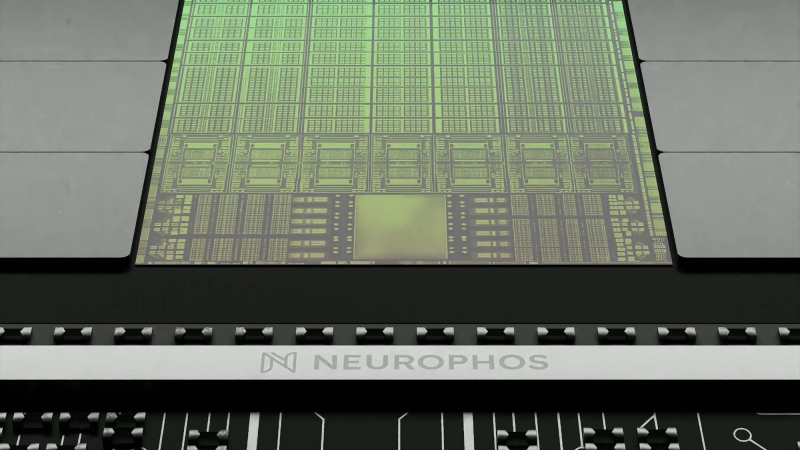

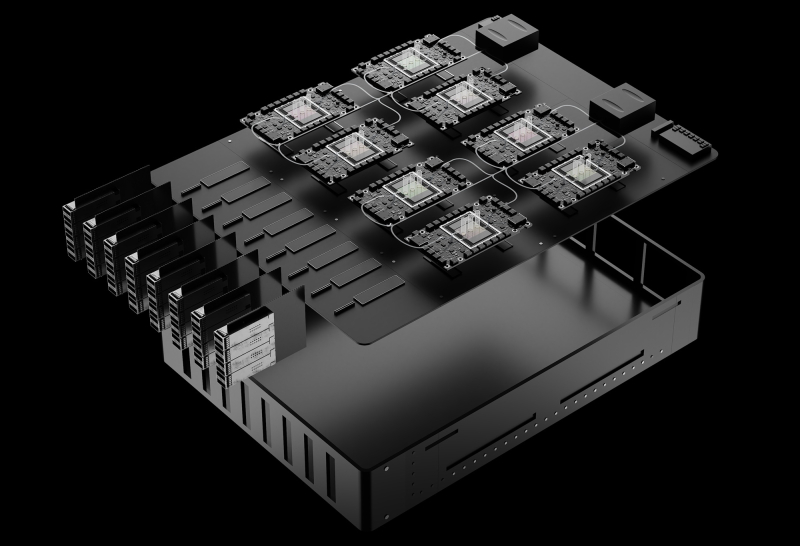

ИИ-расчёты — в OPU: Neurophos готовит 56-ГГц фотонный ускоритель Tulkas T100Стартап Neurophos, специализирующийся на разработках в области фотонных чипов для ИИ-нагрузок, сообщил о привлечении $110 млн в рамках переподписанного раунда финансирования серии А, в результате чего общий объём полученных им инвестиций вырос до $118 млн. Раунд возглавила Gates Frontier Билла Гейтса (Bill Gates) при участии M12 (венчурный фонд Microsoft), Carbon Direct Capital, Aramco Ventures, Bosch Ventures, Tectonic Ventures, Space Capital и др. В число инвесторов также вошли DNX Ventures, Geometry, Alumni Ventures, Wonderstone Ventures, MetaVC Partners, Morgan Creek Capital, Silicon Catalyst Ventures, Mana Ventures, Gaingels и другие. Юридическим консультантом выступает Cooley LLP. Полученные средства компания планирует использовать для ускорения разработки своей первой интегрированной фотонной вычислительной системы. Она включает в себя готовые к использованию в ЦОД модули OPU, полный программный стек и аппаратное обеспечение с ранним доступом для разработчиков. Кроме того, компания расширяет свою штаб-квартиру в Остине и открывает новый инженерный центр в Сан-Франциско для удовлетворения первоначального спроса клиентов. Стартап разработал «метаповерхностный модулятор» с оптическими свойствами, позволяющими его использовать в качестве тензорного процессора для выполнения матрично-векторного умножения. Разработанные стартапом оптические модуляторы на основе метаматериалов микронного масштаба в 10 тыс. раз меньше существующих фотонных элементов, что впервые делает фотонные вычисления реальностью. Эти модуляторы интегрируются с технологией вычислений в памяти для сокращения перемещения данных. «Современные задачи инференса с использованием ИИ требуют колоссальных вычислительных мощностей и ресурсов, — сообщил доктор Марк Трембле (Marc Tremblay), корпоративный вице-президент и технический эксперт по базовой ИИ-инфраструктуре ИИ. — Нам необходим прорыв в вычислительной мощности, сопоставимый с теми скачками, которые мы наблюдаем в самих ИИ-моделях, и именно этим занимается технология Neurophos и ее высококвалифицированная команда». Компания, основанная Патриком Боуэном (Patrick Bowen) и Эндрю Траверсо (Andrew Traverso), включает в себя ветеранов отрасли из NVIDIA, Apple, Samsung, Intel, AMD, Meta✴, ARM, Micron, Mellanox, Lightmatter и др. Neurophos разрабатывает оптический процессор (OPU), который объединяет более миллиона микронных оптических элементов обработки на одном чипе. Он обеспечивает до 100 раз большую производительность и энергоэффективность по сравнению с ведущими современными чипами, утверждает компания. «Закон Мура замедляется, но ИИ не может позволить себе ждать. Наш прорыв в фотонике открывает совершенно новый уровень масштабирования благодаря массивному оптическому параллелизму на одном чипе. Этот сдвиг на уровне физики означает, что как эффективность, так и скорость улучшаются по мере масштабирования, освобождаясь от энергетических барьеров, которые ограничивают традиционные GPU», — говорит Боуэн. «Эквивалент оптического транзистора, который вы получаете сегодня на заводах, огромен. Он имеет длину около 2 мм. Вы просто не можете разместить достаточное количество таких транзисторов на чипе, чтобы получить вычислительную плотность, хотя бы отдалённо конкурирующую с современными CMOS-технологиями», — сообщил ресурсу The Register Боуэн. «В мае мы получили первый кремниевый кристалл, продемонстрировав, что можем сделать это с помощью стандартного CMOS-процесса, что означает совместимость с существующими технологиями производства. На кристалле находится одно фотонное тензорное ядро размером 1000 × 1000 [обрабатывающих элементов]», — сказал он. Это значительно больше, чем обычно встречается в большинстве GPU, которые обычно используют механизмы матричного умножения размером 256 × 256 обрабатывающих элементов. Однако для чипа Neurophos достаточно одного тензорного ядра вместо десятков или даже сотен таких, как в ускорителях NVIDIA. Боуэн говорит, что тензорное ядро в ускорителе Neurophos первого поколения будет занимать примерно 25 мм². Оснащение остальной части микросхемы размером с фотошаблон — это «главная проблема, связанная с поддержкой этого невероятно мощного тензорного ядра», сказал Боуэн. В частности, Neurophos требуется огромное количество векторных процессоров и SRAM, чтобы тензорное ядро не испытывало нехватки данных. Это связано с тем, что само тензорное ядро — которое в чипе будет всего лишь одно — работает на частоте около 56 ГГц. Но поскольку матричное умножение выполняется оптическим методом, единственная потребляемая тензорным ядром энергия уходит на преобразование электрических сигналов в оптические и обратно, сообщил Боуэн. Как сообщает Neurophos, её первый OPU Tulkas T100 получит 768 Гбайт памяти HBM (20 Тбайт/с) и 200 Мбайт L2-кеша. Производительность системы составит 470 POPS (FP4/INT4) или 400 TOPS (FP16/INT16) при потреблении от 1 до 2 КВт под нагрузкой, демонстрируя энергоэффективность до 235 TOPS/Вт. Следует учитывать, что эти цифры пока лишь ориентиры. Чип всё ещё находится в активной разработке, и полномасштабное производство, как ожидается, начнётся не раньше середины 2028 года. Как утверждают в Neurophos, проблем с массовым производством оптических чипов не предвидится, поскольку они могут быть изготовлены с использованием стандартных материалов, инструментов и процессов полупроводниковых фабрик. Боуэн предполагает, что Tulkas T100 будет выполнять аналогичную роль, что и соускоритель NVIDIA Rubin CPX для работы с контекстом и создания KV-кеша. «Текущая концепция, которая может измениться, заключается в том, что мы разместим одну нашу стойку, состоящую из 256 наших чипов, и она будет сопряжена с чем-то вроде стойки NVL576», — сказал он. В долгосрочной перспективе возможен и переход к генерации токенов, но для этого потребуется разработка множества технологий, включая интегрированную оптику. Боуэн сообщил ресурсу TechCrunch, что Neurophos уже заключил контракты с несколькими клиентами (хотя он отказался назвать их имена), и такие компании, как Microsoft, «очень внимательно изучают» продукцию стартапа. Хотя на рынке ИИ-ускорителей и так большая конкуренция, Боуэн уверен, что повышение производительности и эффективности, обеспечиваемое оптическими вычислениями, станет достаточным конкурентным преимуществом чипов стартапа. «Все остальные, включая NVIDIA, в плане фундаментальной физики кремния, скорее эволюционны, чем революционны, и это связано с прогрессом TSMC. Если посмотреть на улучшение техпроцессов TSMC, то в среднем они повышают энергоэффективность примерно на 15 %, и на это уходит пара лет», — сказал он.

09.12.2025 [22:15], Владимир Мироненко

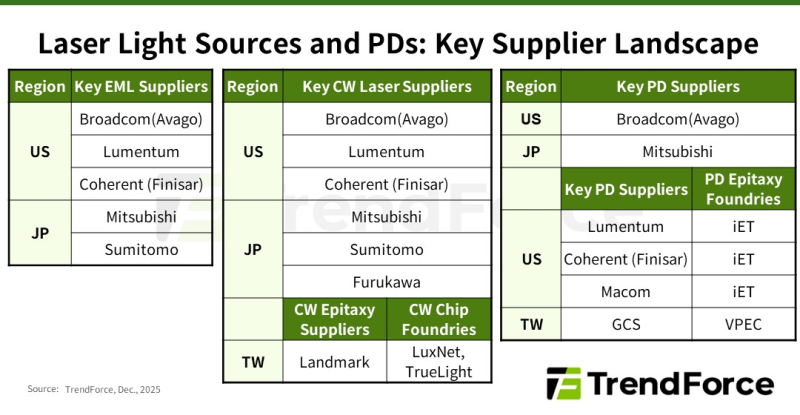

Дефицит добрался и до лазеров: NVIDIA зарезервировала чуть ли не всю продукцию ключевых поставщиковВ настоящее время высокоскоростные оптические соединения играют ключевую роль в обеспечении производительности и масштабируемости ИИ ЦОД, особенно по мере того, как они превращаются в крупные кластеры, сообщается в исследовании TrendForce. Согласно её прогнозу, в 2025 году мировые поставки оптических трансиверов с поддержкой скорости 800 Гбит/с и выше составят 24 млн шт. с последующим ростом в 2,6 раза почти до 63 млн шт. в 2026 году. Аналитики отметили, что резкий рост спроса на оптические трансиверы привёл к значительному дефициту в сфере производства источников лазерного излучения на глобальном рынке. NVIDIA в рамках стратегии развития зарезервировала крупные объёмы продукции у ключевых поставщиков EML-лазеров, что привело к увеличению сроков поставки — не ранее 2027 года. В связи с этим производители оптических модулей и провайдеры облачных услуг (CSP) вынуждены заниматься поиском вторичных поставщиков и альтернативных решений, что ведёт к изменениям в отрасли, отметили в TrendForce. Помимо лазеров VCSEL, используемых в линиях связи малой и средней дальности, оптические модули для линий средней и большой дальности в основном включают два типа лазеров: EML, отличающиеся большой дальностью действия и целостностью сигнала, и лазеры непрерывного излучения (CW). В EML-лазерах все ключевые функции объединены на одном кристалле, что делает их чрезвычайно сложными и трудоёмкими в изготовлении. Их производством занимается всего лишь несколько поставщиков, таких как Lumentum, Coherent (Finisar), Mitsubishi, Sumitomo и Broadcom. Впрочем, о дефиците Mitsubishi предупреждала более года назад. А Broadcom, вероятно, будет отдавать приоритет собственным продуктам. EML-лазеры играют важную роль в масштабировании вычислительных кластеров с увеличением расстояния между ЦОД. Планы NVIDIA по развитию кремниевой фотоники и интегрированной оптики (CPO) реализуются медленнее, чем предполагалось, что приводит к постоянной зависимости от подключаемых модулей для расширения кластеров. Чтобы обеспечить стабильную работу в этом направлении, NVIDIA заранее зарезервировала значительную часть мощностей по производству EML-лазеров, что отразилось на доступности компонента для остальных компаний. CW-лазеры, используемые в паре с кремниевыми фотонными чипами, отличаются более простой конструкцией, обусловленной отсутствием встроенной возможности модуляции, что упрощает производство и расширяет круг поставщиков. В результате CW-лазеры в сочетании с кремниевой фотоникой стали основным альтернативным решением для провайдеров облачных услуг в связи с дефицитом EML-лазеров. Впрочем, здесь тоже наблюдаются проблемы. Производство CW-лазеров сталкивается с растущими ограничениями, обусловленными рядом факторов: длительные сроки поставки оборудования ограничивают расширение производства, а строгие стандарты надёжности требуют трудоемких тестов. В результате многие поставщики передают эти этапы на аутсорсинг, что создает дополнительные узкие места в производственной цепочке. Ввиду того, что экосистема производства CW-лазеров приближается к дефициту мощностей, поставщики вынуждены форсировать усилия по расширению производства. Помимо лазерных передатчиков, для изготовления оптических модулей требуются высокоскоростные фотодиоды (PD) для приёма сигналов. Ведущие поставщики, такие как Coherent, MACOM, Broadcom и Lumentum, выпускают фотодиоды PD 200G с поддержкой скорости передачи данных 200 Гбит/с на канал. Фотодиоды производятся на эпитаксиальных пластинах из фосфида индия (InP), аналогично EML- и CW-лазерам. Поскольку производители лазеров стремятся расширить мощности для эпитаксии, многие из них передают заказы на InP-эпитаксию (процесс выращивания эпитаксиальных листов из фосфида индия на подложке) специализированным заводам, таким как IntelliEPI и VPEC, сообщили в TrendForce. TrendForce прогнозирует, что спрос, обусловленный ИИ, приведёт не только к сокращению предложения модулей памяти, но и отразится на экосистеме производства лазеров в целом. Стремление NVIDIA обеспечить необходимые объёмы поставок EML-лазеров привело к ускорению перехода к CW-решениям и кремниевой фотоники среди других производителей. В то же время общеотраслевая гонка за производственными мощностями меняет роли в цепочке поставок и стимулирует рост производства у поставщиков технологий эпитаксии и обработки полупроводниковых соединений, говорят аналитики.

03.12.2025 [16:37], Руслан Авдеев

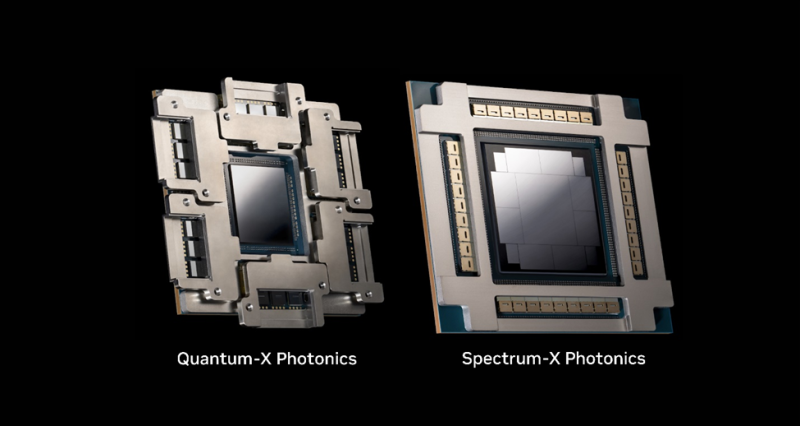

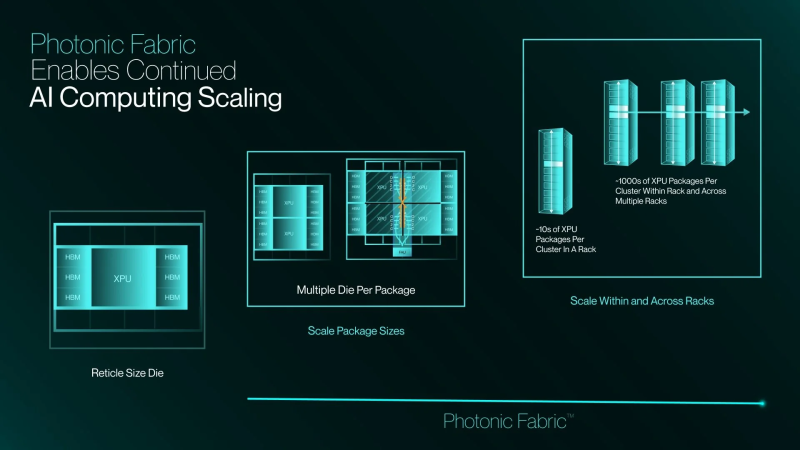

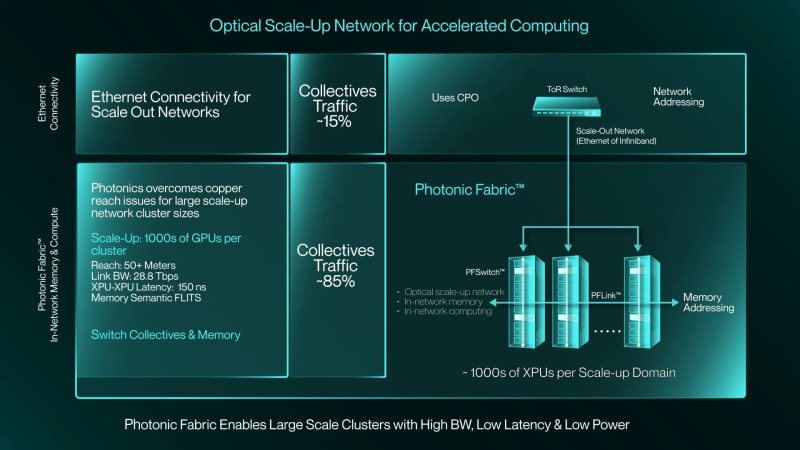

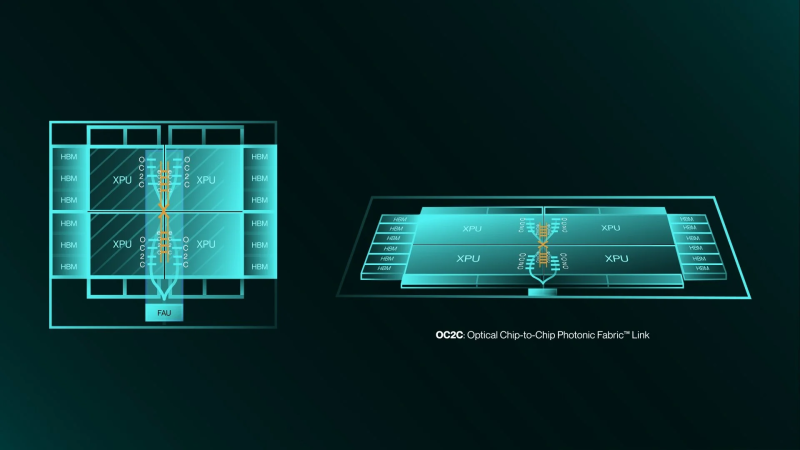

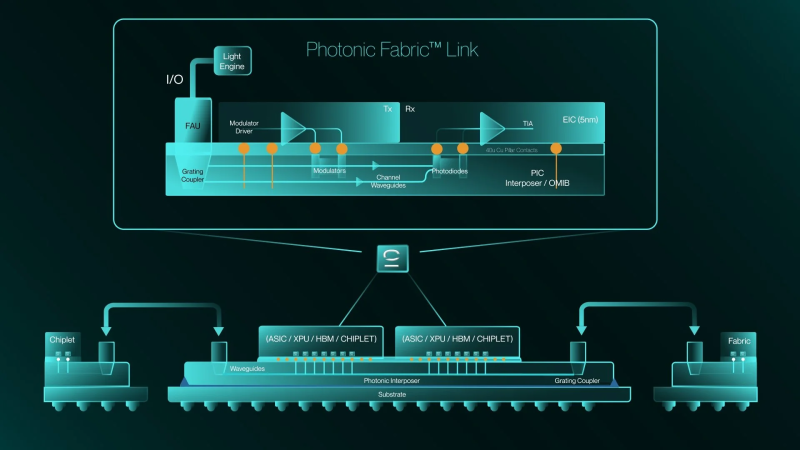

Вперёд в светлое будущее: Marvell купила за $3,25 млрд разработчика фотонного интерконнекта Celestial AIMarvell Technology объявила о заключении окончательного соглашения, предусматривающего покупку компании Celestial AI — пионера в области создания оптических интерконнектов, работающих над технологией Photonic Fabric. Последняя специально разработана для масштабируемых интерконнектов, позволяющих объединять тысячи ИИ-ускорителей и стоек. Это ускорит реализацию стратегии Marvell, связанной с обеспечением подключений в ИИ ЦОД нового поколения и облаках, сообщает HPC Wire. ИИ-системы нового поколения используют многостоечные конструкции, объединяющие сотни XPU. Они требуют интерконнектов с высокой пропускной способностью, сверхнизкой задержкой и возможностью подключения любых устройств. Подобная архитектура позволяет XPU напрямую обращаться к памяти любого другого XPU. Правда, для этого требуются специализированные коммутаторы и протоколы, разработанные для эффективного масштабирования. Оптические интерконнекты показали себя наиболее эффективным решением, а новое приобретение позволит Marvell возглавить технологический переход. С учётом лидерства Marvell в технологиях горизонтального и распределённого масштабирования, компания рассчитывает, что её новая линейка продуктов обеспечит статус поставщика наиболее полных, комплексных решений для дата-центров следующего поколения с сетями с высокой пропускной способностью, низким энергопотреблением и малой задержкой. Компания подчёркивает, что инфраструктура ИИ трансформируется с беспрецедентной скоростью, поэтому будущее за решениями, обеспечивающими высочайшую пропускную способность, энергоэффективность и дальность связи. Комбинация UALink и технологий Celestial AI, позволит клиентам создавать ИИ-системы, способные преодолевать ограничения медных соединений. Это позволит переопределить стандарты архитектуры ИИ ЦОД. В AWS заявляют, что Celestial AI добилась впечатляющего прогресса в разработке оптических интерконнектов и подчеркнули, что объединение с Marvell поможет ускорить инновации в области оптического масштабирования для ИИ нового поколения. Стоит отметить, что сама Amazon владеет небольшой долей акций Marvell. По мере роста требований к пропускной способности и дальности передачи данных каждый узел в дата-центре должен перейти с меди на оптику. На уровне стоек и соединений между ЦОД это уже произошло, следующий этап — переход на оптические соединения в самих стойках. Платформа Celestial AI Photonic Fabric специально разрабатывалась для нового этапа развития. Она позволяет масштабировать крупные ИИ-кластеры как внутри стоек, так и между ними. Энергоэффективность при этом более чем вдвое выше, чем у медных интерконнектов, также обеспечивается большая дальность передачи данных и более высокая пропускная способность. При этом, в сравнении с альтернативными оптическими технологиями, решение Celestial AI обеспечивает чрезвычайно низкое энергопотребление, сверхнизкую задержку на уровне наносекунд и превосходную термоустойчивость. Последнее является важным конкурентным преимуществом Photonic Fabric. Решение обеспечивает надёжную работу в экстремальных температурных условиях, создаваемых многокиловаттными XPU. Благодаря этому оптические компоненты можно размещать поверх вычислительных блоков XPU, а не по его краям, что даёт больше пространства для размещения HBM-стеков. Первым вариантом применения технологии станут полностью оптические интерконнекты для вертикального масштабирования. Чиплет Photonic Fabric включает электрические и оптические компоненты в компактном чипе, обеспечивает скорость передачи данных до 16 Тбит/с (вдвое больше, чем у Ayar Labs TeraPHY). В один XPU можно интегрировать несколько таких чиплетов. При этом таким образом можно объединять и чиплеты внутри чипов, и массивы памяти. Celestial AI уже активно взаимодействует с гиперскейлерами и другими партнёрами. Marvell ожидает, что чиплеты Photonic Fabric станут интегрировать в XPU и коммутаторы, что позволит отрасли обеспечить масштабное коммерческое развёртывание передовых интерконнектов. В компании рассчитывают, что значимый приток выручки от продуктов Celestial AI появится во II половине 2028 финансового года, в IV квартале того же года годовая выручка достигнет $500 млн, а годом позже вырастет до $1 млрд. Первоначальная выплата за Celestial AI составит приблизительно $3,25 млрд. $1 млрд будет выплачен деньгами, а оставшуюся сумму — в виде приблизительно 27,2 млн обыкновенных акций Marvell. Кроме того, акционеры Celestial AI дополнительно получат ещё столько же акций Marvell стоимостью до $2,25 млрд при достижении компанией определённых финансовых показателей. Треть бонусов выплатят, если совокупная выручка Celestial AI составит не менее $500 млн к концу 2029 финансового года Marvell (январь 2030-го). Если же выручка превысит $2 млрд, то акционеры получат сразу все бонусы. Как ожидается, сделка будет завершена в I квартале 2026 календарного года при выполнении обычных условий закрытия и получении необходимых разрешений регуляторов. Celestial AI неоднократно успешно привлекала средства на развитие перспективных интерконнектов. В частности, в марте 2024 года она получила от инвесторов $175 млн, а годом позже — $250 млн.

09.10.2025 [11:42], Сергей Карасёв

Broadcom представила 102,4-Тбит/с СРО-коммутатор TH6-DavissonКомпания Broadcom анонсировала коммутационную систему платформу с интегрированной оптикой CPO (Co-Packaged Optics) третьего поколения Tomahawk 6 — Davisson (TH6-Davisson) для современных кластеров ИИ. Решение обеспечивает пропускную способность до 102,4 Тбит/с. В основу новинки положен чип-коммутатор Tomahawk 6. Утверждается, что TH6-Davisson устанавливает новый стандарт производительности для дата-центров, рассчитанных на наиболее ресурсоёмкие нагрузки. Поддерживаются оптические соединения с пропускной способностью 200 Гбит/с на линию. В случае вертикального масштабирования в один кластер могут быть объединены до 512 XPU. В двухуровневых горизонтально масштабируемых сетях количество XPU может превышать 100 тыс. Решение TH6-Davisson обеспечивает гибкие возможности в плане конфигурации портов. Возможны варианты 64 × 1,6 Тбит/с, 128 × 800 Гбит/с, 256 × 400 Гбит/с, 512 × 200 Гбит/с, 512 × 100 Гбит/с или 512 × 50 Гбит/с. Среди других преимуществ платформы названы возможность замены лазерных модулей ELSFP в полевых условиях и совместимость с DR-оптикой. При изготовлении TH6-Davisson задействована технология TSMC Compact Universal Photonic Engine (TSMC COUPE) вкупе с усовершенствованной многокристальной компоновкой на уровне подложки. Благодаря этому значительно снижаются потери, в результате чего энергопотребление оптического интерконнекта уменьшается на 70 % по сравнению с традиционными решениями. Таким образом, обеспечивается сокращение совокупной стоимости владения, что важно в случае масштабных инфраструктур, ориентированных на ИИ.

06.10.2025 [10:54], Владимир Мироненко

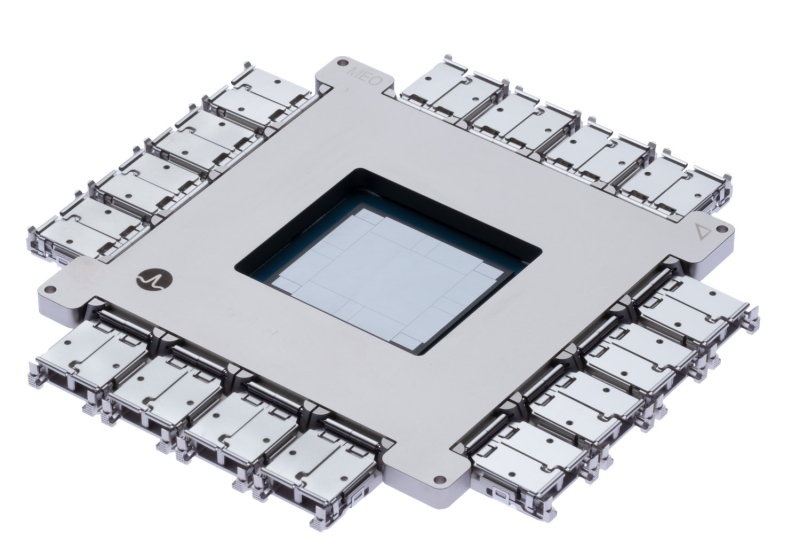

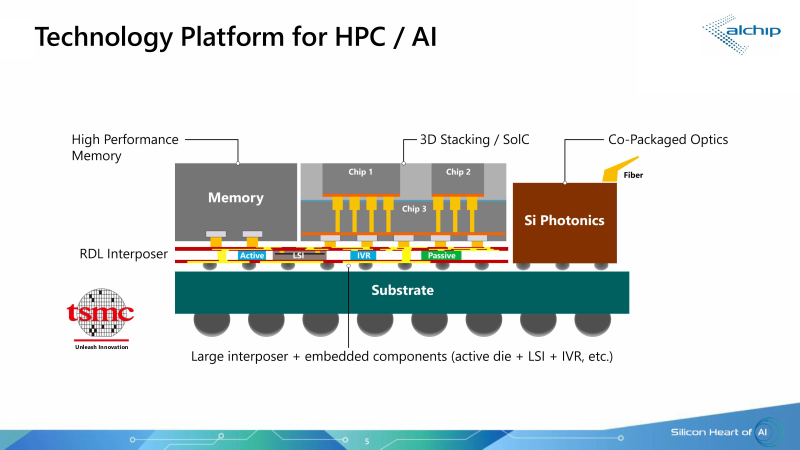

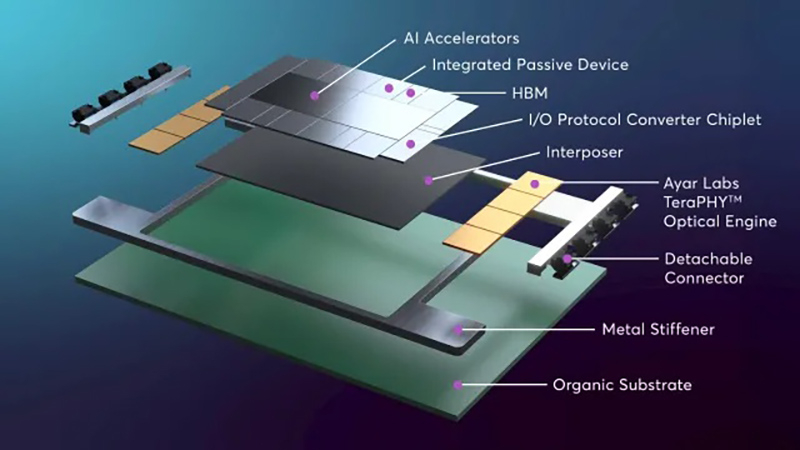

250 Тбит/с на чип: Ayar Labs, Alchip и TSMC предложили референс-дизайн для упаковки ASIC, памяти и оптических модулей в одном чипеКомпания Ayar Labs (США), занимающаяся разработкой интерконнекта на базе кремниевой фотоники, и тайваньский производитель ASIC-решений Alchip Technologies представили референсную платформу проектирования ИИ ASIC с несколькими оптическими IO-модулями на основе технологии кремниевой фотоники TSMC COUPE (Compact Universal Photonic Engine). В начале сентября компании объявили о стратегическом партнёрстве с целью ускорения масштабирования ИИ-инфраструктуры благодаря объединению технологии CPO компании Ayar Labs, экспертизы Alchip в области создания и упаковки кастомных ASIC, а также технологии упаковки и техпроцесса компании TSMC. Как сообщил технический директор Ayar Labs Владимир Стоянович (Vladimir Stojanovic) в интервью EE Times, платформа предназначена для устранения узких мест в передаче данных, замедляющих работу ИИ-инфраструктуры, путём эффективного сокращения времени простоя системы и создания крупных высокопроизводительных ИИ-кластеров нового поколения. Партнёры отметили, что по мере роста ИИ-моделей и размеров кластеров традиционные медные соединения достигают своих физических и энергетических пределов. Путём замены меди на интегрированную оптику (CPO) решение Alchip и Ayar Labs обеспечивает расширенную дальность связи, низкую задержку, энергоэффективность и высокий радикс, необходимые для масштабных развертываний ИИ-ускорителей. «Масштабируемые сети ИИ-кластеров ограничены расстоянием медных соединений. В то же время энергоэффективность сети ограничена плотностью мощности и возможностями систем охлаждения», — пояснил Эрез Шайзаф (Erez Shaizaf), технический директор Alchip, добавив, что CPO снимает эти ограничения. Новое совместное решение включает оптические модули Ayar Labs TeraPHY, размещённые вместе с решениями Alchip на общей подложке, обеспечивая прямой доступ ИИ-ускорителя к оптическому интерфейсу. Такая интеграция обеспечивает пропускную способность 100+ Тбит/с на каждый ускоритель и поддерживает более 256 оптических портов на устройство. TeraPHY не привязан к какому-либо протоколу и обеспечивает гибкую интеграцию с кастомными чиплетами. Референсный дизайн позволяет партнёрам «заложить основу» для быстрого создания подобной системы. Платформа референсного проекта включает два вычислительных кристалла с чиплетами HBM и другими чиплетами, в сочетании с восемью оптическими IO-модулями на базе чиплета TeraPHY. Такая конструкция обеспечит двустороннюю пропускную способность 200–250 Тбит/с для каждой сборки (SiP), что значительно превышает показатели современных крупных GPU, сообщил Стоянович. Это позволит масштабировать систему, а также значительно расширить объём памяти, имеющей пропускную способность, сопоставимую с HBM, добавил он. Оптический модуль Ayar Labs основан на чиплете TeraPHY PIC с двумя дополнительными слоями чиплетов, собранными с помощью TSMC COUPE. Два слоя электронных чиплетов собраны по технологии TSMC SoIC (System on Integrated Chips), которая использует вертикальное размещение нескольких кристаллов друг над другом, чтобы обеспечить более плотное соединение между ними, позволяя снизить энергопотребление, увеличить производительность и уменьшить задержки. По словам Стояновича, такой дизайн будет масштабироваться до уровня UCIe-A и выше как минимум в течение следующего десятилетия.  Совместное решение Alchip и Ayar Labs позволяет масштабировать многостоечную сетевую фабрику без потерь мощности и задержек, характерных для подключаемых оптических кабелей, за счёт минимизации длины электрических трасс и размещения оптических соединений вблизи вычислительного ядра. Благодаря поддержке UCIe для межкомпонентных соединений и гибкому размещению конечных точек на границе чипов, команды разработчиков могут интегрировать масштабируемое решение Alchip и Ayar Labs с существующими вычислительными блоками, стеками памяти и ускорителями, обеспечивая при этом соблюдение требований к производительности, целостности сигнала и температурному режиму на уровне всей сборки. Как сообщается, компании предоставят командам разработчиков дополнительные материалы, референсные архитектуры и варианты сборки. Платформа референсного дизайна включает в себя тестовые программы, позволяющие тестировать сборку и прошивку управления модулем, что облегчает его интеграцию в сборку. «Заказчику нужна поддержка, чтобы он понимал процессы оценки надёжности и испытаний, поэтому мы тесно сотрудничаем с Alchip, чтобы предоставить заказчику доступ ко всему этому пакету», — рассказал Стоянович.

06.10.2025 [09:19], Сергей Карасёв

Corning и GlobalFoundries создадут оптические коннекторы для кремниевой фотоникиАмериканский контрактный производитель полупроводниковых изделий GlobalFoundries и компания Corning, специализирующаяся на производстве стёкол, керамики и т.п., объявили о сотрудничестве. Совместными усилиями партнёры разработают разъёмные волоконно-оптические коннекторы для кремниевой фотоники. Речь идёт о решении GlassBridge для платформы GF Fotonix. Коннектор на основе стеклянного волновода совместим с V-образными канавками GF Fotonix. Система предназначена для удовлетворения растущих потребностей ИИ ЦОД в высокой пропускной способности каналов связи. Разрабатываются также другие механизмы соединения, включая вертикальное разъёмное решение типа Fibre-to-PIC (Photonic Integrated Circuit). Сотрудничество предусматривает использование передовых разработок Corning в области материалов, оптического волокна и средств связи. Это, в частности, стёкла специального состава, стеклянные подложки и методы лазерной обработки. Кроме того, будут применяться оптоволоконные массивы (Fibre Array Unit — FAU) с волокнами со сверхточным выравниванием сердцевины, благодаря которому минимизируются потери. В перспективе разъёмы нового типа помогут повысить удобство развёртывания и эксплуатации высокоскоростного интерконнекта на основе кремниевой фотоники в дата-центрах, ориентированных на ресурсоёмкие приложения ИИ и НРС. Не так давно GlobalFoundries объявила о том, что её платформа кремниевой фотоники выделена в отдельное продуктовое семейство. При этом компания увеличила объём инвестиции в соответствующей сфере в два раза.

29.09.2025 [12:42], Сергей Карасёв

Ciena приобрела разработчика оптических компонентов для высокоскоростного интерконнекта Nubis за $270 млнКомпания Ciena, один из крупнейших поставщиков оптических сетевых решений, объявила о заключении окончательного соглашения о приобретении Nubis Communications — частной фирмы, специализирующейся на разработке высокопроизводительных, компактных и энергоэффективных компонентов для оптического и электрического интерконнекта. Nubis, базирующаяся в Нью-Провиденсе (New Providence) в штате Нью-Джерси (США), основана в 2020 году при поддержке Matrix Partners, Ericsson, GV и TDK Ventures. Штат компании насчитывает свыше 50 специалистов, из которых более половины имеют степень доктора наук. Nubis подала около 100 патентных заявок на технологии, связанные с передовым интерконнектом.

Источник изображения: Nubis Одним из ключевых продуктов Nubis является оптический движок XT1600 High-Density Linear Optical Engine. Он поддерживает 16 передающих и 16 принимающих волокон с пропускной способностью 100 Гбит/с каждое, что обеспечивает полнодуплексную скорость передачи данных до 1,6 Тбит/с. Изделие может быть сконфигурировано для различных стандартов Ethernet, таких как 400G-DR4 или 800G-DR8. На базе таких движков могут формироваться системы с двусторонней пропускной способностью до 6,4 Тбит/с. При этом заявлены малые задержки и низкое энергопотребление. В сочетании с высокоскоростными SerDes от Ciena оптические модули Nubis позволяют создавать решения CPO (Co-Packaged Optics) для эффективной передачи данных внутри стоек и между ними. Ещё одно изделие Nubis — решение Nitro 200G Linear Redriver. Оно позволяет использовать активные медные кабели (ACC) для передачи данных на расстояние до 4 метров со скоростью 200 Гбит/с на линию. В рамках соглашения Ciena заплатит $270 млн за Nubis: осуществить транзакцию планируется полностью за счёт денежных средств. Сделка уже получила одобрение со стороны советов директоров обеих компаний и акционеров Nubis. Ожидается, что слияние будет завершено в IV квартале 2025 финансового года Ciena после получения необходимых разрешений со стороны регулирующих органов. |

|