Материалы по тегу: сжо

|

08.03.2026 [14:50], Сергей Карасёв

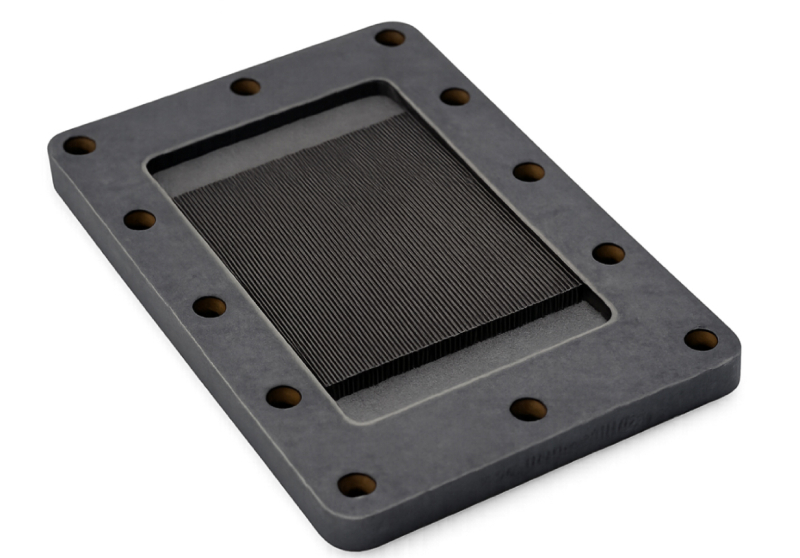

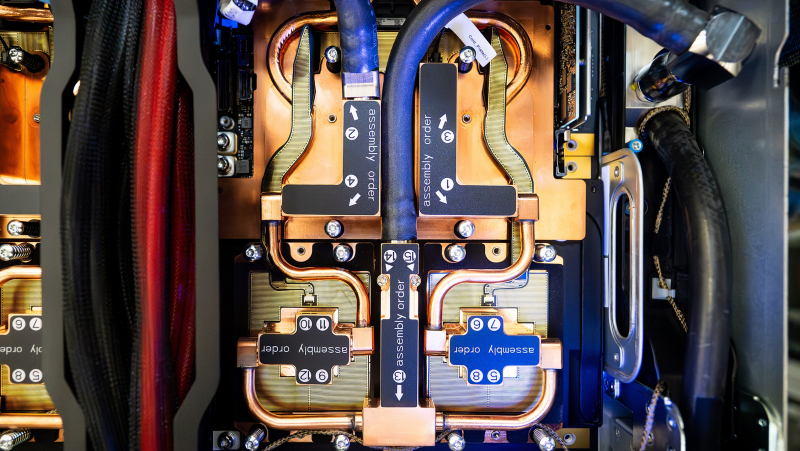

Карборунд-алмазные водоблоки Coherent Thermadite 800 вдвое теплопроводнее и к тому же легче медныхКомпания Coherent анонсировала охлаждающие пластины Thermadite 800 Liquid Cold Plates (LCP) для систем жидкостного охлаждения, рассчитанных на ИИ-ускорители следующего поколения. Новые изделия, как утверждается, способны снизить температуру чипа более чем на 15 °C по сравнению с обычными медными аналогами. Thermadite представляет собой композитный материал на основе реакционно-связанного карбида кремния (RB-SiC), который формируется путём инфильтрации кремния в пористую заготовку из карбида кремния и углерода. А благодаря включению алмаза в матрицу SiC материал Thermadite обеспечивает высокую теплопроводность, низкий коэффициент теплового расширения, жёсткость и стабильность размеров. Такие характеристики позволяют использовать Thermadite для отвода тепла от мощных электронных компонентов, в частности, от GPU в передовых ИИ-ускорителях. По заявлениям Coherent, Thermadite 800 обладает теплопроводностью 800 Вт/м⋅К — примерно вдвое больше, чем у меди. Кроме того, материал имеет приблизительно на 60 % меньшую плотность, чем медь, что позволяет использовать его в системах, к массе которых предъявляются жёсткие требования. При этом устраняются проблемы с деформацией и надёжностью, которые могут возникать в обычных металлических охлаждающих пластинах при работе под высоким давлением. Пластины Thermadite 800 имеют сложную микроканальную архитектуру, оптимизированную под конкретные чипы: это даёт возможность эффективно отводить тепло от наиболее горячих зон при минимизации расхода охлаждающей жидкости. В результате, снижаются общие эксплуатационные расходы.

06.03.2026 [16:01], Сергей Карасёв

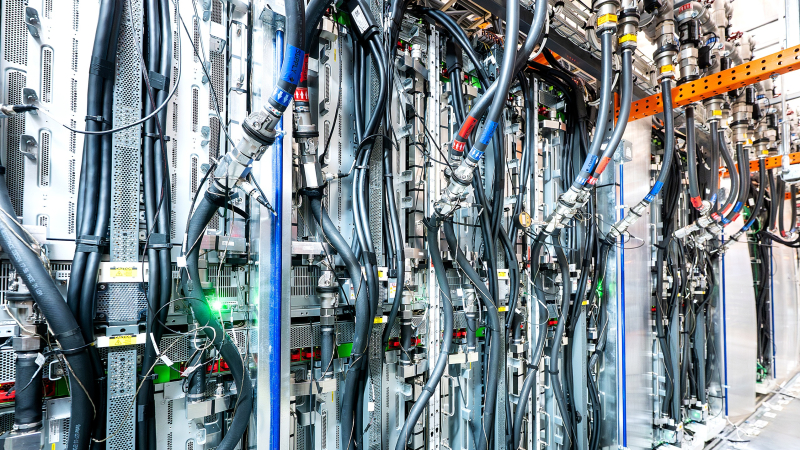

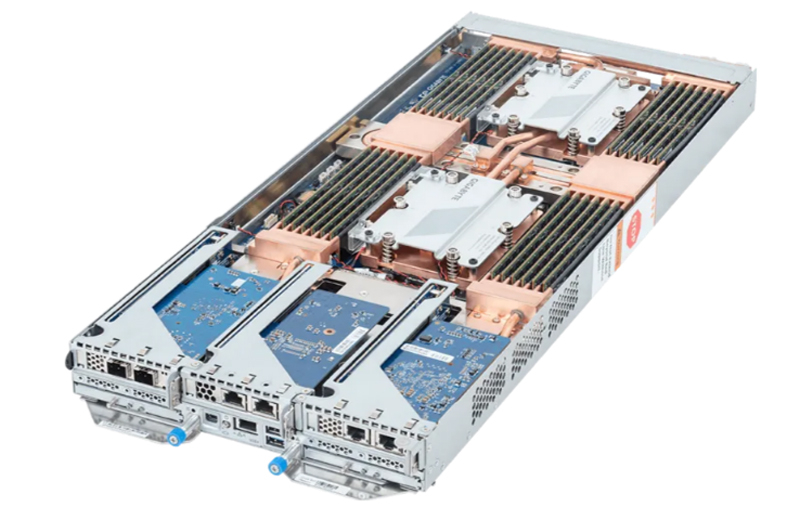

10-узловой сервер Gigabyte B683-Z80-LAS1 на платформе AMD EPYC Turin оснащён СЖОКомпания Gigabyte Technology анонсировала сервер B683-Z80-LAS1 высокой плотности, предназначенный для облачного хостинга, вычислительных ИИ-нагрузок и других ресурсоёмких приложений. Устройство выполнено в форм-факторе 6U с десятью узлами. Каждый узел рассчитан на установку двух процессоров AMD EPYC 9005 Turin или EPYC 9004 Genoa в исполнении Socket SP5 (LGA 6096), показатель TDP которых может достигать 500 Вт. Реализована 12-канальная подсистема оперативной памяти с 24 слотами для модулей DDR5-4800/6400. Конфигурация узлов включает контроллер ASPEED AST2600 с интерфейсом Mini-DP, сетевой порт управления 1GbE (RJ45), три коннектора для низкопрофильных карт расширения PCIe 5.0 x16, два порта USB 3.2 Gen1 Type-A (5 Гбит/с) и два посадочных места для накопителей типоразмера E3.S (NVMe). Сервер оснащён системой прямого жидкостного охлаждения, которая охватывает не только CPU, но и все другие ключевые компоненты, в том числе модули ОЗУ, накопители, а также карты расширения. Утверждается, что применённое решение позволяет отводить до 90 % генерируемого тепла, что обеспечивает высокую эффективность даже при больших нагрузках. Кроме того, задействованы четыре системных вентилятора диаметром 80 мм. Диапазон рабочих температур — от +10 до +35 °C.

Источник изображений: Gigabyte Technology Питание обеспечивают 12 блоков мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Собственно серверное шассе оборудовано двумя дополнительными сетевыми портами управления. Габариты устройства составляют 447 × 262,3 × 900 мм, масса — около 38 кг.

06.03.2026 [14:36], Руслан Авдеев

Шведская Alfa Laval представила экологичную СЖО для ЦОД FreeWaterLoopШведская промышленная группа Alfa Laval выходит на рынок оборудования для дата-центров. Она анонсировала выпуск новую внешнюю систему жидкостного охлаждения FreeWaterLoop. По словам компании, в новой СЖО используется комбинация передовых инженерных решений с сфере насосостроения, высокопроизводительных технологий теплообмена и фильтрации — они объединены в единый, полностью интегрированный модуль. Alfa Laval сообщила, что система использует стабильные температуры и теплопроводность природных водоёмов и минимизирует водопотребление, возвращая чистую воду туда, откуда она была забрана. Кроме того, FreeWaterLoop позволяет уменьшить размер охладительных установок дата-центров, занимая меньше пространства, чем классические системы воздушного охлаждения оборудования. По словам Alfa Laval, наблюдаются беспрецедентные изменения на рынке ЦОД, поскольку развитие ИИ ведёт к росту тепловых нагрузок, заказчику тем временем требуют всё более устойчивую инфраструктуру. Alfa Laval использует свои сильные стороны для создания нового поколения эффективных и надёжных решений в сфере терморегулирования. Основанная в 1883 году шведская компания Alfa Laval занимается как разработкой, так и производством. Она поставляет бойлеры, вентили, насосы, теплообменники и прочие компоненты для судостроения, энергетики и пищевой промышленности. Компания заявила, что в случае с FreeWaterLoop речь идёт об одном из самых быстрых циклов разработки для решений такого масштаба. Это отражает общие амбиции Alfa Laval, свидетельствует о быстром процессе принятия решений в компании и активной поддержке ЦОД с помощью масштабируемых инноваций. Ещё в 2024 году сообщалось, что через несколько лет СЖО займут треть рынка систем охлаждения для ЦОД. Впрочем, новости февраля 2026 года свидетельствуют о том, что с повсеместным внедрением придётся повозиться. AWS резко сократила развёртывание СЖО для Trainium3, решив обойтись преимущественно воздушным охлаждением, хотя ранее сама с нуля разработала собственную систему жидкостного охлаждения в кратчайшие сроки.

28.02.2026 [09:48], Сергей Карасёв

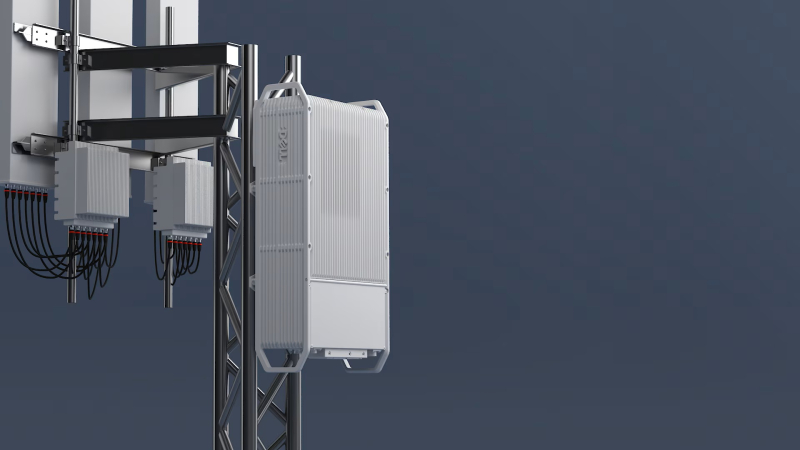

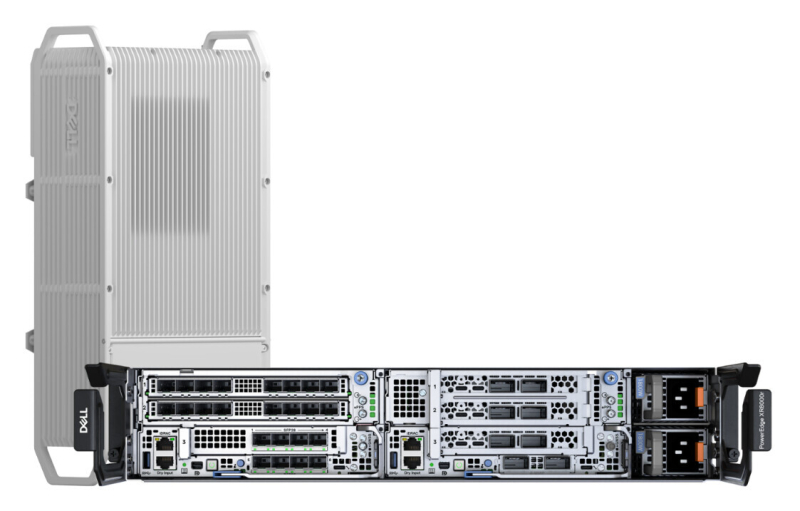

Dell представила подвесной уличный сервер PowerEdge XR9700 с замкнутой СЖОDell анонсировала сервер PowerEdge XR9700, предназначенный для инфраструктур Cloud RAN и ИИ-приложений на периферии. Устройство рассчитано на эксплуатацию в неблагоприятных условиях, в том числе на открытом воздухе: оно может монтироваться на опорах линий электропередач, крышах и фасадах зданий. Новинка заключена в корпус объёмом около 15 л. Говорится о сертификации IP66 и GR-3108 Class 4: серверу не страшны пыль, влага и воздействие прямого солнечного излучения. Диапазон рабочих температур простирается от -40 до +46 °C. В основу PowerEdge XR9700 положена аппаратная платформа Intel Xeon 6 SoC — Granite Rapids-D (до 72 P-ядер, TDP до 325 Вт). Также возможна установка ИИ-ускорителей и различных сетевых карт, в том числе для обработки L1-трафика. Задействована система жидкостного охлаждения с замкнутым контуром, а ребристая внешняя поверхность работает в качестве радиатора. Без СЖО с таким уровнем тепловыделения CPU/GPU и в таком компактном корпусе уже вряд ли можно обойтись. Отмечается, что с технической точки зрения устройство идентично модели PowerEdge XR8720t, которая дебютировала в октябре прошлого года. В зависимости от конфигурации это решения располагает четырьмя или восемью слотами для модулей DDR5. Возможна установка до трёх SSD формата M.2 (NVMe). В оснащение могут входить два порта 100GbE QSFP и восемь портов 10/25GbE SFP. Реализованы интерфейсы USB 3.0 Type-A, UCB Type-C, Mini-DisplayPort и пр. Заявлена поддержка Wind River SUSE Linux Enterprise Server/RT, Ubuntu Server LTS и Red Hat Enterprise Linux/RT. Интегрированный контроллер удалённого доступа Dell (iDRAC) обеспечивает мониторинг и управление. Говорится о совместимости с существующим набором решений для периферийных вычислений в области телекоммуникаций. В продажу PowerEdge XR9700 поступит во II половине текущего года.

22.02.2026 [16:03], Сергей Карасёв

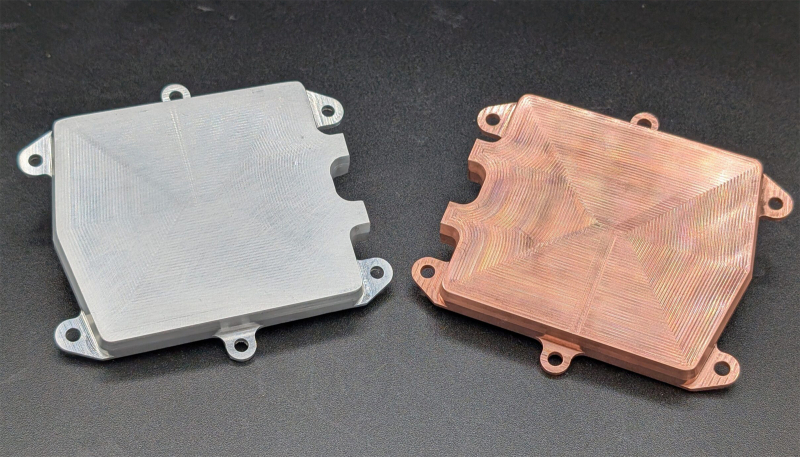

Johnson Controls купила разработчика СЖО Alloy EnterprisesПроизводитель климатического оборудования, средств автоматизации, безопасности и пожаротушения Johnson Controls, по сообщению Datacenter Dynamics, заключил соглашение о приобретении Alloy Enterprises — бостонской компании, занимающейся разработкой компонентов для систем охлаждения. Стартап Alloy Enterprises основан в 2020 году. Он специализируется на решениях в области теплотехники, механики и материаловедения. Компания, в частности, производит компоненты для СЖО, такие как водоблоки, тепловые трубки и пр. В качестве материала используются алюминий и медь. При этом применяется фирменная технология Stack Forging: изделия сочетают особую внутреннюю микрогеометрию с монолитной конструкцией, благодаря чему обеспечивается эффективное охлаждение под высоким давлением без утечек. Финансовые условия сделки между Johnson Controls и Alloy Enterprises не раскрываются, но отмечается, что стороны намерены закрыть её в III квартале текущего года. Предполагается, что Johnson Controls будет использовать приобретённые разработки и технологии для развития своего ассортимента продуктов, ориентированных на дата-центры. Это позволит укрепить позиции на быстро расширяющемся рынке. Johnson Controls поставляет и внедряет решения для ЦОД в более чем 150 странах по всему миру. В 2024 году компания сформировала специализированное подразделение по разработке продуктов для дата-центров: речь идёт об интегрированных системах, которые предлагаются клиентам в глобальном масштабе. Кроме того, в составе Johnson Controls действует структура Silent-Aire, специализирующаяся на модульных ЦОД, а также на системах кондиционирования, вентиляции и охлаждения для дата-центров.

21.02.2026 [14:38], Сергей Карасёв

Nautilus представила универсальный 4-МВт CDUКомпания Nautilus анонсировала блок распределения охлаждающей жидкости EcoCore FCD CDU, разработанный специально для крупномасштабных дата-центров, ориентированных на нагрузки ИИ и НРС. Утверждается, что новинка может быть интегрирована с СЖО любого типа, в том числе прямого и погружного. Мощность решения в зависимости от модификации варьируется от 2 до 4 МВт. Герметичная конструкция исключает риск утечек; говорится о возможности использования пресной, морской и промышленной воды. Опционально доступны дополнительные фильтры. Система спроектирована для бесшовной интеграции в существующие машинные залы: это обеспечивает максимально эффективное использование доступного пространства без ущерба для производительности, говорит компания. Допускается подача воды сверху и снизу, что позволяет адаптировать решение к конструктивным особенностям конкретного ЦОД. Благодаря точному контролю температуры достигается стабильное и надёжное охлаждение с учётом предъявляемых требований. Возможно масштабирование: в единой инфраструктуре могут быть объединены до шести модулей EcoCore FCD CDU. Реализованы протоколы Modbus RT, Modbus TCP, OPC UA для удалённого управления и мониторинга. Блок оснащён датчиками расхода, температуры и давления в первичном и вторичном контурах. Поддерживается резервирование по схеме N+2. Используются два источника питания; максимальное заявленное энергопотребление составляет 42 кВт. Габариты системы — 2,7 × 1,7 × 2,1 м, «сухая» масса — 3520–3550 кг.

16.02.2026 [11:16], Руслан Авдеев

Попутного ветра: AWS резко сократила развёртывание СЖО для Trainium3, решив обойтись преимущественно воздушным охлаждениемAmazon Web Services (AWS) резко увеличит долю воздушного охлаждения в серверах на базе ускорителей Trainium3. Производство серверов намерены нарастить во II квартале 2026 года, но жидкостное охлаждение в них будут применять далеко не так активно, как ожидалось, сообщает DigiTimes. Если ранее планировалось применять системы жидкостного и воздушного охлаждения с соотношением 1:1, то теперь на первые будет приходиться лишь 10 % от общего числа, что способно замедлить внедрение СЖО в ЦОД. При этом ранее отраслевые эксперты прогнозировали, что проникновение СЖО на рынок ИИ-серверов вырастет с менее 20 % в 2025 году до более 50 % в 2026-м. Это должно было случиться за счёт расширения поставок GPU- и ASIC. AWS даже смогла разработать в рекордно короткие сроки собственную платформу СЖО, что привело к падению акций Vertiv, одного из бенефициаров ИИ-бума. Новый подход к оборудованию Trainium3 ставит под вопрос будущее и динамику перехода к жидкостному охлаждению. Тем не менее, рост производства Tranium 3 в любом случае поддержит спрос на продукцию ключевых партнёров AWS: Wiwynn, Accton, Auras, Taiwan Microloops и Nan Juen International (Repon). Вероятно, спрос позволит загрузить производственные мощности до конца 2026 года. По мнению аналитиков, решение AWS во многом связано с TDP ускорителей на уровне 800 Вт (хотя раньше говорили об 1000 Вт) — для них, вероятно, достаточно и для современного воздушного охлаждения, что снижает необходимость перехода на более дорогие и сложные СЖО. По данным AWS, Trainium3 приблизительно на 40 % производительнее в сравнении с ускорителями предыдущего поколения. Также компания объявила о капитальных затратах до $200 млрд на расширение ИИ-инфраструктуры, в т.ч. производство собственно ускорителей — на 2027 год запланированы поставки уже Trainium4. Так или иначе, даже после снижения доли СЖО спрос на компоненты у партнёров должен увеличиться за счёт роста производства в целом. Рост популярности жидкостного охлаждения в ИИ ЦОД в последние годы во многом обусловлен ростом TDP ускорителей NVIDIA. Если у H200 показатель был на уровне около 700 Вт, то у B200 — порядка 1000 Вт, а у B300 — уже 1400 Вт. Для будущих архитектур с двумя чипами значения будут ещё выше. В результате операторам ЦОД требуется эффективный отвод тепла, что могут обеспечить СЖО. Кроме того, это позволяет повысить плотность размещения оборудования. В сегменте ASIC рост TDP заметно ниже. Так, для Trainium2 речь шла об около 500 Вт, у Trainium3 — всего 800 Вт, поэтому воздушное охлаждение — вполне рабочий вариант, за исключением некоторых сценариев, например, с высокой плотностью размещения оборудования. Также источники в цепочке поставок подчёркивают, что жидкостные системы дороже устанавливать и обслуживать в сравнении с современными воздушными вариантами. При этом экосистема производства и обслуживания СЖО часто оценивается как «менее зрелая». Благодаря этому организовать поставки серверов с воздушным охлаждением можно быстрее, и они будут более стабильными. Беспокойство операторов ЦОД может вызывать и репутация жидкостных систем. Например, в конце января Wave Power объявила о том, что некоторые проданные компоненты СЖО для ИИ-систем привели к повреждению оборудования, поэтому компании пришлось выложить $4,5 млн, чтобы заключить мировое соглашение. По мнению экспертов, утечки в СЖО — довольно распространённое явление, не привязанное к конкретному вендору, но каждый подобный инцидент свидетельствует о потенциальных проблемах, которые заказчикам приходится принимать в расчёт. Хотя системы жидкостного охлаждения технически предпочтительнее для самых энергоёмких нагрузок благодаря высокой эффективности теплоотвода, потенциалу снижения показателя PUE и способности обеспечить экономию пространства, на примере Trainium3 можно оценить, как совокупность факторов, включая совокупную стоимость владения (TCO) и операционные риски влияют на сроки внедрения СЖО. Изменение планов AWS может повлиять на всю индустрию ИИ ЦОД, которая может замедлить повсеместный переход на жидкостное охлаждение, по крайней мере, в краткосрочной перспективе. Вместе с тем даже для ИИ-платформ нынешнего поколения гиперскейлеры разработали гибридные варианты охлаждения, позволяющие использовать современные системы в старых ЦОД, не рассчитанных изначально на крупномасштабные СЖО. Так, Meta✴ «растянула» суперускорители NVIDIA GB200 на шесть стоек вместо одной, чтобы разместить там теплообменники, а Microsoft с той же целью «пристроила» к стойке с оборудованием модуль шириной в ещё пару стоек. Google же предпочитает для своих TPU именно СЖО.

15.02.2026 [15:46], Владимир Мироненко

Legrand приобрела Kratos и инвестировала в Accelsius для расширения предложений для ИИ ЦОДLegrand, французский поставщик решений для электротехнической и цифровой инфраструктуры зданий, обслуживающей жилой, коммерческий, промышленный рынки и ЦОД, объявил о приобретении Kratos Industries из Арвады (Arvada, штат Колорадо), производителя низковольтного (НВ) и средневольтного (СВ) силового оборудования. Также Legrand сообщила об участии в раунде финансирования серии B компании Accelsius, специализирующейся на двухфазном прямом жидкостном охлаждении. «В совокупности эти шаги значительно расширяют возможности Legrand в области распределения электроэнергии и передового управления тепловыми процессами, позволяя ЦОД удовлетворять растущие потребности в ИИ и высокоплотных вычислительных средах», — отметила Legrand в пресс-релизе. «Принимая Kratos в состав Legrand, мы расширяем наши возможности по обслуживанию всей системы электропитания ЦОД, гарантируя нашим клиентам наличие единого, надёжного партнёра для всей их экосистемы электропитания», — заявила компания. Kratos использует вертикально интегрированную модель с подходом «проектирование под заказ». Благодаря её приобретению Legrand может предложить более надёжный портфель решений для критически важных систем электропитания на рынке ЦОД, охватывая весь спектр решений от кабельных лотков с нагрузочными стендами до шинопроводов и блоков распределения питания (PDU) для стоек. Что касается инвестиций Legrand в Accelsius, то в рамках партнёрства компании планируют совместные инициативы по разработке СЖО для интеграции в инфраструктуру на уровне стоек, ориентированные в ИИ-фабрики и другие высокопроизводительные вычислительные среды. Хотя большая часть бизнеса Legrand приходится на электротехнические решения для жилых и коммерческих зданий, ИИ оказал преобразующее воздействие на компанию, заявил генеральный директор Legrand Бенуа Кокар (Benoit Coquart) агентству Reuters. По его словам, на решения для ЦОД приходится 26 % выручки компании в 2025 году, и этот показатель может достичь 40 %. Выручка Legrand в 2025 году составила €9,48 млрд ($11,26 млрд, рост год к году на 9,6 %), что немного выше прогноза аналитиков, равного €9,46 млрд. Скорректированная операционная прибыль компании выросла год к году на 10,5 % до $1,96 млрд, что соответствует ожиданиям аналитиков. Legrand ожидает рост продаж в 2026 году на 10–15 %, скорректированную операционную маржу на уровне 20,5–21 %.

11.02.2026 [15:00], Руслан Авдеев

Trane Technologies приобрела поставщика СЖО для ЦОД LiquidStackИндустрия ИИ находится на пике популярности, стимулируя слияния и поглощения в сегменте продуктов для систем охлаждения ЦОД. Так, компания Trane Technologies, занимающаяся разработкой кондиционеров и смежных решений, приобрела стартап LiquidStack, специализирующийся на СЖО, сообщает The Register. Trane инвестировала в LiquidStack в 2023 году. Также в компанию инвестировали Tiger Global Management ($20 млн) и Wiwynn ($10 млн). LiquidStack была одной из первых компаний, разрабатывавших двухфазное иммерсионное охлаждение для систем майнинга криптовалюты. Фактически компания появилась в 2012 году в результате реорганизации Allied Control Limited (ACL, подразделение The Bitfury Group), которая изначально занималась созданием СЖО для майнинговых систем. Технологию LiquidStack протестировала в 2021 году Microsoft. С тех пор компания пополнила портфолио системами одно- и двухфазного погружного охлаждения, а также решениями прямого охлаждения чипов (DLC), в т.ч. CDU. Сообщается, что после закрытия сделки LiquidStack будет работать в составе подразделения Commercial HVAC. Технологии купленной компании пополнят портфолио продуктов Trane, предназначенных для дата-центров. По данным LiquidStack, покупка включает команду стартапа и производственные мощности, а также инженерные и научно-исследовательские подразделения в Техасе и Гонконге.

Источник изображения: LiquidStack По прогнозам экспертов Dell'Oro Group, к 2030 году рынок физической инфраструктуры ЦОД превысит $80 млрд. Одним из самых быстрорастущих сегментов в нём являются системы управления тепловыми режимами, среднегодовой темп прироста составит 20 %. Эксперты уверены, что к концу десятилетия рынок DLC СЖО достигнет оборота $8 млрд, во многом благодаря ИИ-технологиям. Жидкостное охлаждение сегодня перестало быть желательным дополнительным элементом и стало обязательным для получения максимальной отдачи от современного оборудования ИИ ЦОД. Покупка LiquidStack — не первая попытка Trane выйти на рынок технологий жидкостного охлаждения. Ещё в декабре 2025 года была куплена Stellar Energy, выпускавшая модульные охлаждающие решения и CDU, в том числе для ЦОД. Впрочем, это лишь последние из многих слияний и поглощений на рынке физической инфраструктуры для дата-центров, инициированных бумом ИИ-технологий. В конце 2024 года Schneider Electric купила контрольный пакет акицй Motivair. В декабре 2023 года Vertiv приобрела CoolTera. Почти сразу же после этого она запустила производство на полную мощность, увеличив выпуск CDU в 45 (!) раз.

04.02.2026 [12:11], Руслан Авдеев

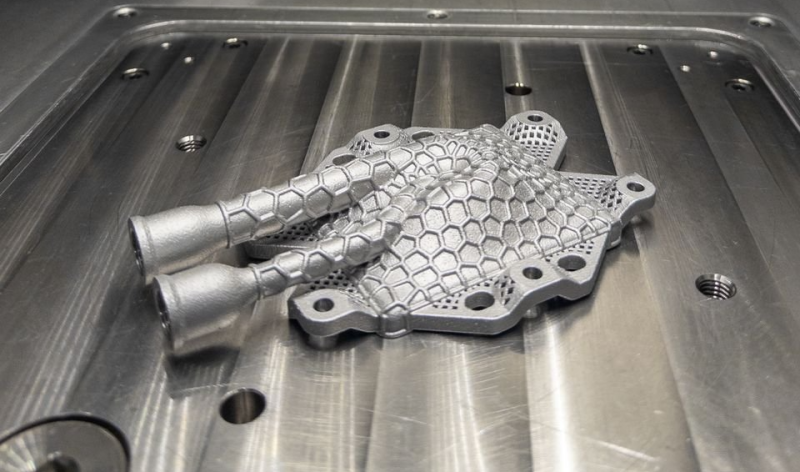

Датские исследователи напечатали в 3D испарительную камеру для пассивной двухфазной СЖОГруппа учёных создала один из ключевых компонентов системы жидкостного охлаждения (СЖО) дата-центров с использованием 3D-печати. В проекте приняли участие исследователи и специалисты практики из Дании, Бельгии и Германии, сообщает Datacenter Dynamics. Датский технологический институт (Danish Technological Institute) совместно с компанией Heatflow (Дания), бельгийской Open Engineering и занимающимся прикладными исследованиями немецким институтом Fraunhofer IWU разработали, напечатали на 3D-принтере и протестировали компонент системы охлаждения для дата-центров и высокопроизводительных компьютеров. В новом решении охлаждающая жидкость испаряется на горячей поверхности. Пар, отводя тепло, поднимается, а потом конденсируется и под действием силы тяжести возвращается к источнику тепла. Ключевой компонент — испарительная камера — изготовлена с помощью 3D-печати компанией Heatflow и Датским технологическим институтом. в ходе испытаний достигнута мощность охлаждения 600 Вт, это на 50 % больше, чем планировалось (400 Вт). Насосы этим элементом системы не используются, что снижает энергопотребление.

Источник изображения: Danish Research Institute Как заявили представители Датского технологического института, благодаря 3D-печати можно интегрировать необходимые функции в единую деталь. Благодаря этому отпадает надобность в узлах соединения, снижается риск протечек и повышается надёжность компонента. Кроме того, используется только один материал, поэтому переработка упрощается. Проект — часть европейской исследовательской инициативы AM2PC. Он поддерживается европейской сетью M-ERA.NET за счёт средств гранта Датского инновационного фонда (Danish Innovation Fund). Основной задачей проекта была разработка и производство испарительной камеры, а также проверка его рабочих характеристик. По словам Heatflow, наблюдается тенденция к беспрецедентному росту удельной мощности серверов, поэтому классического воздушного охлаждения уже недостаточно, а новое двухфазное решение позволяет пассивно отводить тепло без использования насосов и вентиляторов, это значительно снижает энергопотребление.

Источник изображения: Danish Research Institute Основанная в 2018 году Heatflow является поставщиком систем охлаждения для электроники. Компания специализируется на двухфазном охлаждении. Испарительная камера изготовлена благодаря лазерному спеканию порошковых слоёв (PBF-LB). При этом методе лазер используется для формирования металлических заготовок. Решение отводит тепло при температурах 60–80 °C и потенциально применимо в системах централизованного теплоснабжения, применяющих отработанное тепло дата-центров. Учёные подчёркивают, что не уделяли особого внимания интеграциям с системами центрального отопления, но наглядно продемонстрировали, что подобная технология обеспечивает такую возможность. Утверждается, что речь идёт о важном шаге на пути создания более энергоэффективных дата-центров, способных внести позитивный вклад в общий энергетический баланс. Развитие технологий охлаждения особенно важно, поскольку, по данным исследования Rest of World, около 80 % всех дата-центров мира построены в неподходящих климатических условиях, речь идёт о почти 7 тыс. объектов. |

|