Материалы по тегу: суперкомпьютер

|

17.06.2024 [08:53], Руслан Авдеев

Cerebras и Dell предложат заказчикам современные ИИ-платформыРазработчик ИИ-суперчипов Cerebras Systems анонсировал сотрудничество с Dell. Вместе компании займутся созданием передовых вычислительных инфраструктур для генеративного ИИ. В рамках сотрудничества будут создаваться масштабируемые решения для ИИ-суперкомпьютеров Cerebras с платформами Dell на базе процессоров AMD EPYC Genoa. По словам участников проекта, новые технологические решения дадут возможность обучать модели, на порядки более крупные, чем те, что есть на данный момент. В частности, будут задействованы системы Dell PowerEdge R6615 на базе AMD EPYC 9354P, которые предоставят потоковый доступ к 82 Тбайт памяти — для обучения моделей практически любого размера. Совместные платформы Cerebras и Dell будут включать ИИ-системы и суперкомпьютеры. Также будет предложена тренировка ИИ-моделей и иные сервисы поддержки машинного обучения. Как утверждают в самой Cerebras, сотрудничество с Dell станет поворотной точкой, открывающие каналы глобальной дистрибуции. Компании предоставят ИИ-оборудование, ПО и экспертизу, что позволит заказчикам упростить и ускорить внедрении современных ИИ-технологий, попутно снизив TCO. В марте Cerebras представила новейшие суперчипы Cerebras WSE-3, а в мае появилась новость, что совместно с Core42 из ОАЭ компания создаст суперкомпьютер Condor Galaxy 3 (CG-3) со 172,8 млн ИИ-ядер.

16.06.2024 [16:25], Сергей Карасёв

Холодный приём: новый национальный суперкомпьютер Норвегии разместят в руднике и охладят водой из фьордаВласти Норвегии, по сообщению ресурса HPC Wire, подписали контракт стоимостью Kr225 млн ($21 млн) с корпорацией HPE, предусматривающий создание нового национального суперкомпьютера A2 (постоянное имя системе дадут позже). Он станет самым мощным в истории страны и значительно ускорит исследования и разработки в различных областях, в том числе в сфере ИИ. За закупку и эксплуатацию НРС-систем в Норвегии отвечает государственная компания Sigma2 AS. Вычислительные услуги предоставляются в сотрудничестве с университетами Бергена, Осло, Тромсё, а также Норвежским университетом естественных и технических наук (NTNU) в рамках проекта NRIS. В основу нового суперкомпьютера ляжет платформа HPE Cray EX4000. Известно, что в состав комплекса войдут 76 узлов с четырьмя гибридными суперчипами NVIDIA GH200 (всего 304 ускорителя), 252 узла с двумя 128-ядерными AMD EPYC Turin (64 512 ядер) и 5,3-Пбайт хранилище HPE Cray ClusterStor E1000. Узлы объединит интерконнект HPE Slingshot. Ожидаемая производительность системы составит порядка 10 Пфлопс. Монтаж системы планируется выполнить в течение весны–лета 2025 года. Машина расположится в дата-центре Лефдаль (Lefdal Mine Datacenter, LMD), развёрнутом на базе бывшего рудника. Этот объект имеет большую площадь и предоставляет гибкие возможности в плане масштабирования. Новый суперкомпьютер HPE станет первой национальной высокопроизводительной системой, установленной в этом ЦОД.

Источник изображения: Sigma2 Несмотря на то, что готовящийся комплекс будет значительно мощнее высокопроизводительных вычислительных систем Sigma2 предыдущего поколения, его энергопотребление окажется меньше примерно на 30 %. Для охлаждения будет использоваться холодная вода из близлежащего фьорда. Нагретая вода затем может быть направлена на нужды местных предприятий, в том числе, например, рыбных ферм. Ожидается, что суперкомпьютер сможет удовлетворить потребности Норвегии в НРС-ресурсах в течение следующих пяти лет. Он будет доступен исследователям по всей стране. В дальнейшем суперкомпьютер может дополнительно получить 119 808 CPU-ядер и/или 224 ускорителя. В целом же Норвегия рассчитывает, что современные ЦОД станут для страны «новой нефтью».

15.06.2024 [18:04], Владимир Мироненко

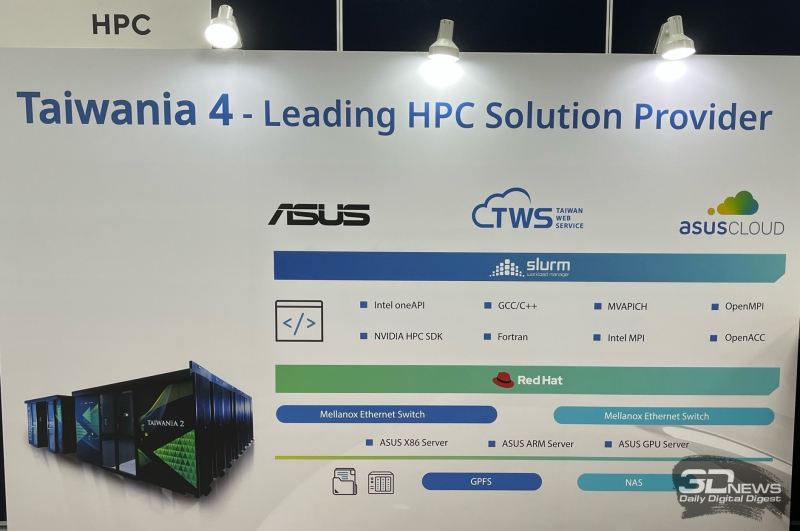

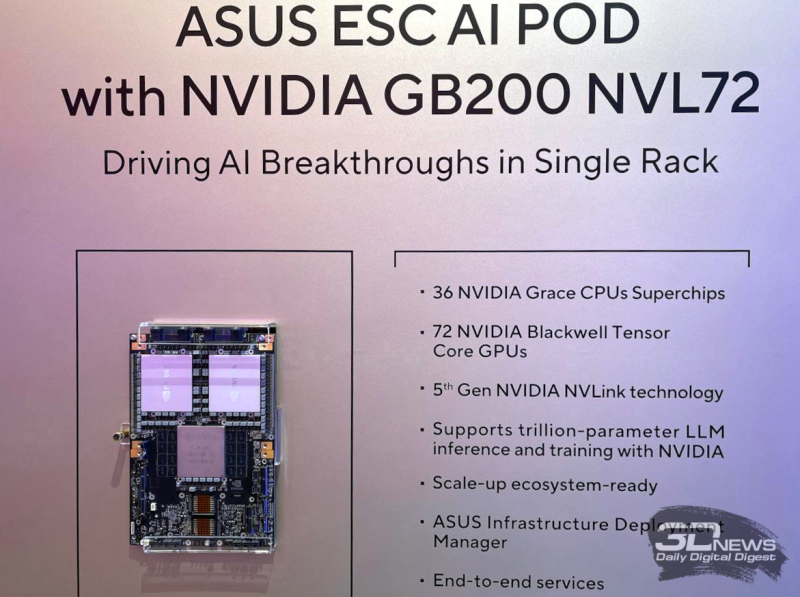

ASUS осваивает строительство суперкомпьютеров, ЦОД и комплексных ИИ-системПроизводитель потребительской электроники ASUS уже давно работает на рынке серверов и ЦОД. Пока он занимает на нём не очень большую долю, но как сообщил ресурсу The Register старший вице-президент ASUS Джеки Сюй (Jackie Hsu), высокопроизводительных вычислений (HPC) и серверов стал для компании «областью большого роста». Сюй рассказал, что ASUS участвовала в строительстве на Тайване суперкомпьютера Taiwania 2 производительностью 9 Пфлопс, занявшего в рейтинге TOP500 двадцатую позицию после дебюта в 2018 году. А в прошлом году ASUS выиграла тендер на участие в создании суперкомпьютера Taiwania 4. Сюй сообщил, что ASUS построила ЦОД для Taiwania 4. Причём PUE новой площадки составляет 1,17, что является неплохим показателем для любого подобного объекта, а тем более для Тайваня, отличающегося климатом с высокими температурой и влажностью. Также ASUS участвовала в ряде проектов в области ИИ, включая разработку собственной большой языковой модели (LLM) Formosa Foundation со 176 млрд параметров. Модель была обучена на наборах данных на местном языке для генерации текста с традиционной китайской семантикой. Благодаря накопленному опыту ASUS начала предлагать услуги на рынке ИИ. Компания уже заключила несколько контрактов, в рамках которых она проектирует и создаёт мощные системы для работы с ИИ, предлагая большую часть программного и аппаратного стека, необходимого для обработки ИИ-нагрузок. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) назвал ASUS в числе компаний, с кем NVIDIA будет сотрудничать в работе над созданием так называемых фабрик ИИ. На Computex 2024 компания представила новые серии серверов ASUS RS700-E12 и RS720-E12 с процессорами Intel Xeon 6, разработанные специально для обработки высокопроизводительных рабочих нагрузок, а также серверы хранения семейства VS320D, предназначенные для использования в составе инфраструктур SAN для работы с базами данных, системами виртуализации и пр. Также ASUS представила ИИ-систему ESC AI POD на базе суперускорителей NVIDIA GB200 NVL72.

14.06.2024 [14:05], Сергей Карасёв

Срок эксплуатации суперкомпьютеров растёт, несмотря на прекращение поддержки оборудованияНаучные учреждения и организации, по сообщению HPC Wire, увеличивают период эксплуатации установленных суперкомпьютеров, несмотря на то что их поставщики прекращают поддержку соответствующего оборудования. В результате, срок службы НРС-комплексов может достигать уже 10 лет. Типичный жизненный цикл суперкомпьютера составляет около пяти–шести лет. После этого требуется замена в связи с моральным устареванием, а также в свете появления более производительных и энергоэффективных компонентов. Кроме того, по прошествии примерно пяти лет дальнейшее обслуживание оборудования обычно становится слишком дорогим. Однако японский Институт физико-химических исследований (RIKEN) намерен эксплуатировать существующую систему Fugaku в течение десяти лет. Этот вычислительный комплекс на базе Arm-процессоров Fujitsu A64FX в 2020 году стал самым производительным суперкомпьютером в мире. В текущем рейтинге ТОР500 система занимает четвёртое место с быстродействием приблизительно 442 Пфлопс. Таким образом, Fugaku продолжит активно использоваться вплоть до 2030 года, когда ожидается появление суперкомпьютера FugakuNEXT. Сатоши Мацуока (Satoshi Matsuoka), директор японского Центра вычислительных наук RIKEN, отметил, что зачастую НРС-системы всё ещё годны для эксплуатации спустя пять лет после запуска. Но организациям приходится устанавливать новые комплексы, поскольку производители попросту прекращают поддержку имеющихся платформ. Мацуока подчёркивает, что подобная практика должна быть прекращена. Ливерморская национальная лаборатория им. Э. Лоуренса (LLNL) Министерства энергетики США также заявляет о том, что некоторые её НРС-системы служат в течение 7–10 лет. Большое значение для продления срока службы суперкомпьютеров имеет оптимизация ПО. Отмечается, что средний возраст систем в списке ТОР500 по состоянию на июнь 2024 года составляет около 35 месяцев, что является рекордным показателем. Для сравнения: в период с 1995 по 2011 год это значение варьировалось в среднем от 5 до 10 месяцев. В целом, суперкомпьютеры эксплуатируются дольше, поскольку создание новых систем обходится очень дорого. А некоторые эксперты полагают, что нынешнее поколение сверхкрупных машин и вовсе будет последним в своём роде.

11.06.2024 [17:09], Руслан Авдеев

Foxconn построит на Тайване передовой вычислительный центр на базе суперускорителей NVIDIA BlackwellПроизводитель электроники Foxconn намерен построить на острове передовой вычислительный центр в Гаосюне (Тайань). Datacenter Dynamics информирует, что центр, который будет готов в 2026 году, получит 64 суперускорителя NVIDIA Blackwell GB200 NVL72. Foxconn и NVIDIA будут сотрудничать и над созданием «цифровых двойников» для производственных компаний, электромобилей и систем умного города. Проекты будут реализованы на платформе NVIDIA Omniverse. В NVIDIA заявили, что сейчас происходит расцвет новой эры вычислений, ставшей драйвером спроса на дата-центры для генеративного ИИ. Также в компании подчеркнули, что Foxconn является ведущим поставщиком вычислительных решений NVIDIA и одним из ключевых новаторов в деле внедрения генеративного ИИ в промышленности и робототехнике. Используя платформы NVIDIA Omniverse и Isaac, компания задействует передовые ИИ-технологии и систему цифровых двойников для создания передового вычислительного центра в Гаосюне. Основанная в 1974 году компания Foxconn в последнее время стремится расширить долю рынка в полупроводниковой индустрии на фоне медленного роста продаж смартфонов. Дочерняя компания Ingrays выпускает серверы, системы хранения данных и HPC-компоненты, включая HPC-платформы на основе чипов NVIDIA. Ранее появилась информация о том, что компания намерена превратить опосредованно принадлежащий ей завод Sharp по выпуску LCD-панелей в дата-центр, но тот расположен в Япони и к текущему проекту не имеет прямого отношения.

11.06.2024 [11:55], Сергей Карасёв

ParTec обвинила Microsoft в нарушении патентов в области ИИ-суперкомпьютеровНемецкая компания по производству суперкомпьютерного оборудования ParTec и её лицензионный агент BF exaQC AG, по сообщению ресурса HPC Wire, подали иск против Microsoft. Редмондская корпорация обвиняется в нарушении патентов на технологии, которые применяются при создании мощных современных суперкомпьютеров для задач ИИ. В материалах дела речь идёт о разработках, связанных с динамической модульной системной архитектурой (dMSA). Технология обеспечивает эффективное взаимодействие CPU, GPU и других чипов в составе НРС-систем. Отмечается, что dMSA имеет основополагающее значение при построении мощных вычислительных комплексов для обучения ИИ-моделей и инференса. Важность патентов ParTec AG подтверждается использованием соответствующих разработок в ведущих европейских суперкомпьютерах, таких как Leonardo в Болонье (Италия), Jupiter в Юлихе (Германия) и Meluxina в Люксембурге. Все они построены с применением dMSA и признаны новаторскими платформами, говорит компания.

Источник изображения: pixabay.com Кроме того, ParTec ведёт переговоры о лицензировании своих технологий с известным американским производителем чипов. А с властями США компания обсуждает возможность использования разработок в строящемся крупнейшем в мире суперкомпьютере экзафлопсного уровня. Вероятно, имеется в виду система El Capitan, которая обеспечит производительность более 2 Эфлопс (FP64). Ввод комплекса в эксплуатацию намечен на середину нынешнего года. В рамках разбирательства с Microsoft компания ParTec просит суд наложить запрет на дальнейшее незаконное использование запатентованных технологий. Кроме того, немецкий разработчик требует обязать ответчиков выплатить компенсацию. Корпорация Microsoft ситуацию никак не комментирует.

07.06.2024 [15:42], Руслан Авдеев

«ИИ-гигафабрика» xAI разместится в гигантском дата-центре в ТеннесиИИ-стартап xAI, курируемый Илоном Маском (Elon Musk), намерен построить гигантский дата-центр с самым производительным в мире ИИ-суперкомпьютером. По данным Datacenter Dynamics, ЦОД разместится в окрестностях Мемфиса (штат Теннесси), а пока ожидает одобрения властей. В обозримом будущем компания должна получить сотни тысяч ускорителей для обучения новых моделей, в частности, чат-бота Grok, предлагаемого, например, по подписке в социальной сети X (Twitter). Ранее в Сеть утекла информация, что NVIDIA передаст xAI чипы, изначально предназначавшиеся для Tesla — Маск весьма вольно распоряжается активами подконтрольных ему бизнесов, часто вызывая недовольство инвесторов. Пока проект ожидает окончательного разрешения от местного бизнес-инкубатора Memphis Shelby County Economic Development Growth Engine (EDGE), а также муниципальных и федеральных властей. Впрочем, гораздо важнее дождаться одобрения энергетической компании Tennessee Valley Authority (TVA). Реализация проекта сулит появление высокооплачиваемых рабочих мест и увеличение доходов штата, что поможет поддерживать и модернизировать местную инфраструктуру. Муниципальные власти уже назвали проект «крупнейшей мультимиллиардной инвестицией в истории Мемфиса, а Маск окрестил ЦОД «гигафабрикой для вычислений» по аналогии с Tesla Gigafactory. По данным местных СМИ, приглянувшаяся Маску площадка принадлежит инвесткомпании Phoenix Investors, сотрудничающей с xAI и местными властями. Ранее объект управлялся компанией Electrolux. Неизвестно, насколько масштабной будет первая фаза проекта и сколько средств на неё потратят. Ранее Маск заявлял, что xAI развернёт в ближайшие месяцы 100 тыс. ускорителей NVIDIA H100, а кластер из ещё 300 тыс. B200 введут в эксплуатацию следующим летом. Считается, что xAI арендует около 16 тыс. H100 у Oracle Cloud, также компания пользуется услугами AWS и свободными мощностями X (Twitter).

04.06.2024 [12:10], Руслан Авдеев

Илон Маск готовит для xAI суперкомпьютер c 300 тыс. NVIDIA B200, но пока придётся обойтись H100Илон Маск (Elon Musk) заявляет, что к лету 2025 года его ИИ-стартап xAI введёт в эксплуатацию суперкомпьютер c 300 тыс. новейших ускорителей NVIDIA B200 и SuperNIC ConnectX-8, передаёт Datacenter Dynamics. Заодно Маск пообещал уже в ближайшие месяцы ввести в эксплуатацию кластер из 100 тыс. ускорителей NVIDIA H100 с жидкостным охлаждением. При этом важно помнить, что Маск нередко даёт обещания, которые потом никогда не выполняет или выполняет совсем не так, как ожидалось. Например, на днях The Information сообщала, что 100 тыс. ускорителей H100 должны заработать только следующим летом. Вероятнее всего, компания построит компактный и относительно недорогой кластер, который позже расширится до 100 тыс. ускорителей. Такую же схему могут реализовать и с системой из 300 тыс. ускорителей. Предполагается, что такой суперкомпьютер будет стоить десятки миллиардов долларов — больше, чем xAI привлекла от инвесторов. По словам главы NVIDIA Дженсена Хуанга (Jensen Huang), один B200 стоит $30-40 тыс. Даже если Маску удастся приобрести ускорители подешевле, речь будет идти о $9 млрд. С учётом того, что компании понадобится инфраструктура, связь, классические процессоры, земля и коммунальное обслуживание, речь будет идти о ещё более дорогостоящем проекте — даже не принимая во внимание стоимости потребляемой воды и электроэнергии. В прошлом месяце xAI привлекла $6 млрд в ходе очередного раунда финансирования, что подняло стоимость компании до $24 млрд. В совокупности с предыдущим раундом, в ходе которого удалось собрать $1 млрд, средств будет достаточно для покупки 100 тыс. H100, оплату работы персонала и текущих вычислительных потребностей — пока xAI арендует около 16 тыс. ускорителей H100 у Oracle Cloud, а недавно сообщалось о намерении xAI потратить $10 млрд на серверы в облаке Oracle.

26.05.2024 [22:25], Александр Бенедичук

«Гигафабрика» для ИИ: стартап xAI Илона Маска хочет построить суперкомпьютер со 100 тыс. NVIDIA H100Как сообщает Reuters со ссылкой на The Information, Илон Маск планирует построить гигантский суперкомпьютер для своего ИИ-стартапа xAI для работы над следующей версией чат-бота Grok. Запуск предполагаемого суперкомпьютера ожидается к осени 2025 года, при этом, по словам Маска, xAI может сотрудничать с Oracle. Для обучения Grok 2 использовалось около 20 тыс. ускорителей NVIDIA H100, а для Grok 3 и более поздних версий потребуется уже 100 тыс. NVIDIA H100. После завершения строительства суперкомпьютер будет как минимум в четыре раза больше самых больших существующих на сегодняшний день GPU-кластеров, утверждается в презентации, сделанной для инвесторов в мае. Семейство ускорителей NVIDIA доминирует на рынке ИИ-чипов для ЦОД, но из-за высокого спроса их может быть трудно приобрести. Маск основал xAI в прошлом году в качестве конкурента OpenAI и Google. Маск также был соучредителем OpenAI и членом совета директоров до 2018 года. В феврале этого года он подал иск к OpenAI и соучредителям Альтману и Брокману, посчитав, что они нарушили соглашение о некоммерческом характере деятельности.

26.05.2024 [13:24], Руслан Авдеев

Эрик Шмидт: будущие суперкомпьютеры США и Китая будут окружены пулемётами и колючей проволокой и питаться от АЭС

hardware

hpc

аэс

безопасность

ии

информационная безопасность

китай

суперкомпьютер

сша

цод

энергетика

Бывший генеральный директор Google Эрик Шмидт (Eric Schmidt) прогнозирует, что в обозримом будущем в США и Китае большие суперкомпьютеры будут заниматься ИИ-вычислениями под защитой военных баз. В интервью Noema он подробно рассказал о том, каким видит новые ИИ-проекты, и это будущее вышло довольно мрачным. Шмидт поведал о том, как правительства будут регулировать ИИ и искать возможности контроля ЦОД, работающих над ИИ. Покинув Google, бизнесмен начал очень тесно сотрудничать с военно-промышленным комплексом США. По его словам, рано или поздно в США и Китае появится небольшое число чрезвычайно производительных суперкомпьютеров с возможностью «автономных изобретений» — их производительность будет гораздо выше, чем государства готовы свободно предоставить как своим гражданам, так и соперникам. Каждый такой суперкомпьютер будет соседствовать с военной базой, питаться от атомного источника энергии, а вокруг будет колючая проволока и пулемёты. Разумеется, таких машин будет немного — гораздо больше суперкомпьютеров будут менее производительны и доступ к ним останется более широким. Строго говоря, самые производительные суперкомпьютеры США принадлежат Национальным лабораториям Министерства энергетики США, которые усиленно охраняются и сейчас. Как заявил Шмидт, необходимы и договорённости об уровнях безопасности вычислительных систем по примеру биологических лабораторий. В биологии широко распространена оценка по уровням биологической угрозы для сдерживания её распространения и оценки уровня риска заражения. С суперкомпьютерами имеет смысл применить похожую классификацию. Шмидт был председателем Комиссии национальной безопасности США по ИИ и работал в Совете по оборонным инновациям. Также он активно инвестировал в оборонные стартапы. В то же время Шмидт сохранил влияние и в Alphabet и до сих пор владеет акциями компании стоимостью в миллиарды долларов. Военные и разведывательные службы США пока с осторожностью относятся к большим языковым моделям (LLM) и генеративному ИИ вообще из-за распространённости «галлюцинаций» в таких системах, ведущих к весьма правдоподобным на первый взгляд неверным выводам. Кроме того, остро стоит вопрос сохранения секретной информации в таких системах. Ранее в этом году Microsoft подтвердила внедрение изолированной от интернета генеративной ИИ-модели для спецслужб США после модернизации одного из своих ИИ-ЦОД в Айове. При этом представитель Microsoft два года назад предрекал, что нынешнее поколение экзафлопсных суперкомпьютеров будет последним и со временем все переберутся в облака. |

|