Материалы по тегу: облако

|

02.11.2024 [13:36], Сергей Карасёв

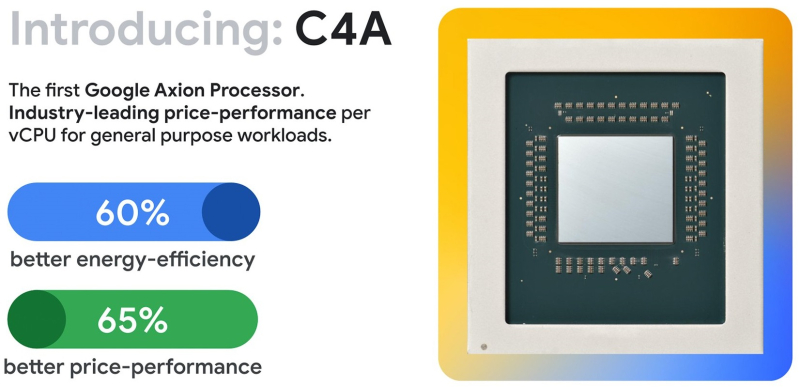

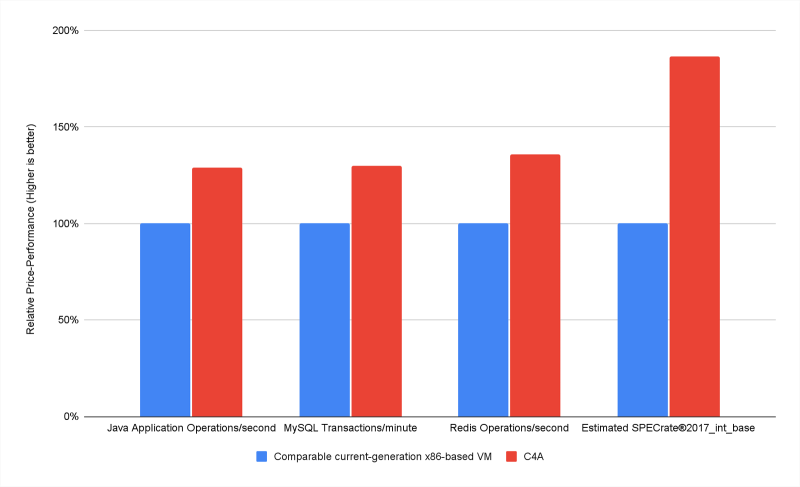

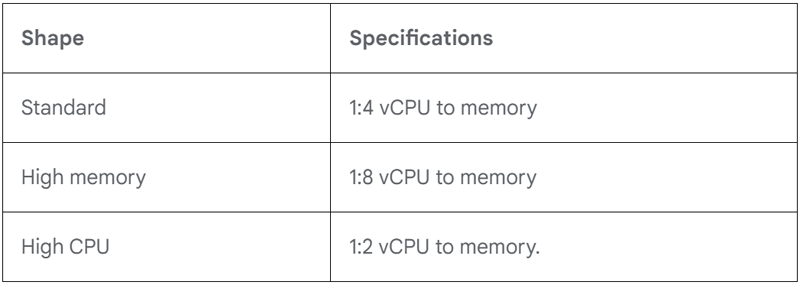

Arm-процессоры Google Axion прописались в инстансах C4A: до 72 vCPU и 576 Гбайт RAMОблачная платформа Google Cloud анонсировала инстансы C4A — первые виртуальные машины, построенные на фирменных Arm-процессорах Axion собственной разработки. Утверждается, что C4A по соотношению цена/производительность обеспечивают выигрыш до 10 % по сравнению с аналогичными предложениями конкурентов. Напомним, чипы Axion дебютировали в апреле нынешнего года. Они оснащены Armv9-ядрами Neoverse V2 (Demeter), которые функционируют в связке с контроллерами Titanium (отвечают за работу с сетью, защиту и разгрузку IO-операций). Инстансы C4A предназначены для нагрузок общего назначения. Среди них названы веб-серверы, контейнерные микросервисы, СУБД, серверы приложений, аналитика данных, обработка мультимедийных материалов и инференс. Google заявляет, что по сравнению с виртуальными машинами на основе x86-процессоров текущего поколения инстансы C4A обеспечивают повышение энергетической эффективности до 60 % и улучшение соотношения цена/быстродействие до 65 %. Учитывая эти преимущества, ключевые службы Google, такие как Bigtable, Spanner, BigQuery, F1 Query, Blobstore, Pub/Sub, Google Earth Engine и YouTube Ads, уже начали переход на Axion. Инстансы C4A доступны в трёх вариантах: standard, highcpu и highmem. Во всех версиях количество vCPU (фактически ядер) варьируется от 1 до 72. В случае стандартных модификаций на один vCPU выделяет 4 Гбайт памяти, а для highcpu и highmem — 2 Гбайт и 8 Гбайт соответственно. Таким образом, объём памяти может составлять до 576 Гбайт. Стандартная пропускная способность сетевого подключения — до 50 Гбит/с, а для приложений с интенсивным трафиком показатель может достигать 100 Гбит/с. Кроме того, доступно хранилище Hyperdisk последнего поколения с производительностью до 350 тыс. IOPS и пропускной способностью до 5 Гбайт/с.

Источник изображения: Google Клиенты Google Cloud могут использовать C4A для многих сервисов, включая Google Compute Engine, Google Kubernetes Engine (GKE), Batch и Dataproc. Виртуальные машины поддерживают большинство популярных редакций Linux — RHEL, SUSE Linux Enterprise Server, Ubuntu, Rocky Linux и др. Программное обеспечение, совместимое с архитектурой Arm, доступно в Google Cloud Marketplace.

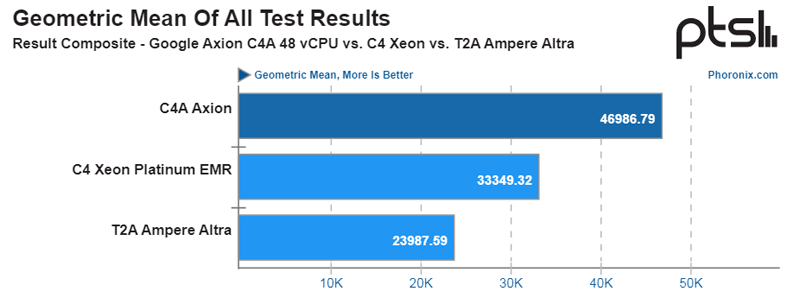

Источник изображения: Phoronix Согласно тестам Phoronix, инстансы C4A с 48 vCPU обеспечивают 1,4-кратный прирост производительности по сравнению с C4 на базе Intel Xeon. А по отношению к инстансам T2A на Arm-чипах Ampere Altra новые машины C4A демонстрируют увеличение быстродействия в 1,95 раза. При этом с финансовой точки зрении новинки оказываются выгоднее других решений.

02.11.2024 [13:06], Владимир Мироненко

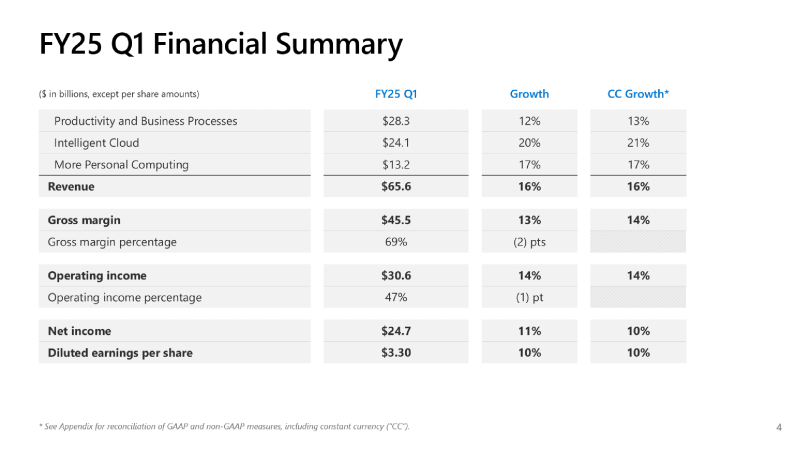

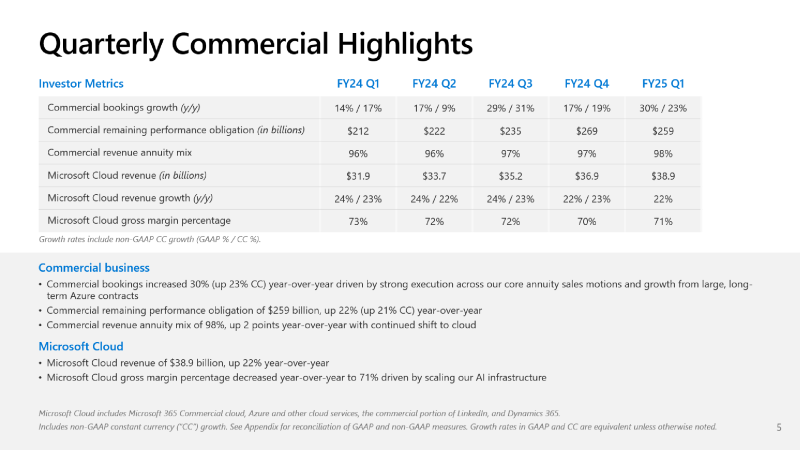

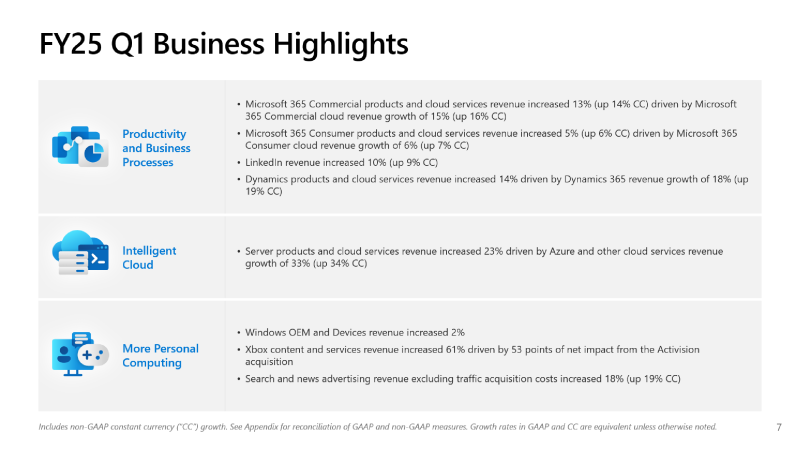

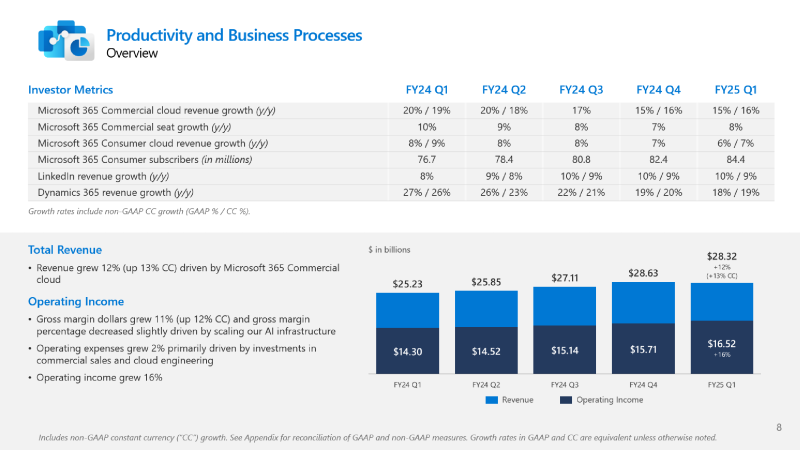

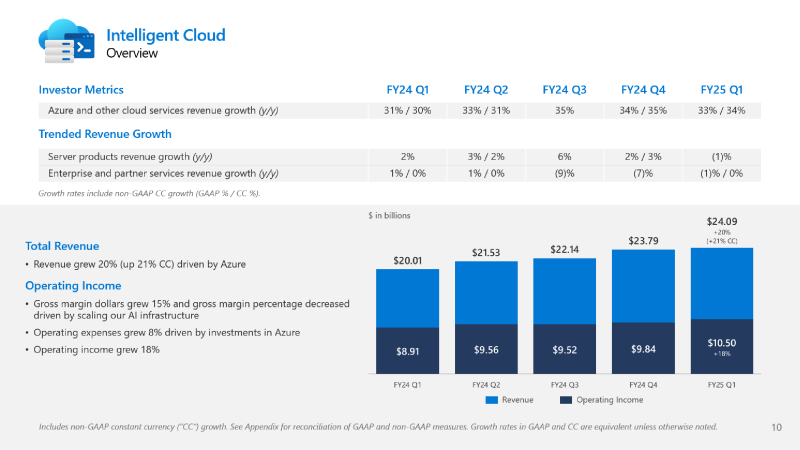

Microsoft не хватает ресурсов для обслуживания ИИ, но компания готова и далее вкладываться в ЦОД, хотя инвесторам это не по нравуMicrosoft сообщила о результатах работы в I квартале 2025 финансового года, завершившемся 30 сентября. Показатели компании превысили прогнозы аналитиков, но её ожидания и планы вызвали опасения инвесторов, так что акции упали в четверг на 6 %. До этого акции компании падали столь значительно 26 октября 2022 года — на 7,7 %, за месяц до публичного релиза ChatGPT, после которого начался бум на ИИ. В этот раз инвесторов не устроили планы компании по увеличению расходов на искусственный интеллект (ИИ) в текущем квартале и ожидаемое замедление роста облачного бизнеса Azure, что свидетельствует о том, что крупных инвестиций в ИИ было недостаточно, чтобы справиться с ограничениями мощности ЦОД компании — Microsoft попросту не хватает ресурсов для обслуживания заказчиков. Выручка Microsoft выросла год к году на 16 % до $65,6 млрд, что выше средней оценки аналитиков в $64,5 млрд, которых опросила LSEG. Чистая прибыль увеличилась на 11 % до $24,67 млрд, в то время как аналитики прогнозировали $23,15 млрд. Чистая прибыль на акцию составила $3,30 при прогнозе Уолл-стрит в рамзере $3,10. Сегмент Intelligent Cloud компании Microsoft, который охватывает облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, показал рост выручки на 20 % в годовом исчислении до $24,1 млрд. Azure и другие облачные сервисы увеличили выручку на 33 %. При этом ИИ внес 12 п.п. в рост выручки Azure в отчётном квартале по сравнению с 11 п.п. в предыдущем трёхмесячном периоде. Большинство направлений бизнеса Microsoft показали значительный рост: LinkedIn — 10 %; продукты Dynamics и облачные сервисы — 14 %, в том числе Dynamics 365 — 18 %; серверные продукты и облачные сервисы — 23 %. Выручка Microsoft 365 Commercial Cloud выросла на 15 %, а потребительского Microsoft 365 и сопутствующих облачных сервисов — на 5 %. Вместе с тем внешние поставщики запаздывают с поставкой инфраструктуры ЦОД для Microsoft, что означает, что компания не сможет удовлетворить спрос во II финансовом квартале. Бретт Иверсен (Brett Iversen), вице-президент Microsoft по связям с инвесторами, подтвердил, что Microsoft не сможет решить проблему ограничений мощности ИИ до II половины финансового года. Microsoft прогнозирует замедление роста выручки Azure во II финансовом квартале до 31–32 %, что отстает от среднего роста в 32,25 %, ожидаемого аналитиками, согласно Visible Alpha. Наряду с замедлением роста выручки Azure у инвесторов вызывает обеспокоенность и то, что Microsoft вкладывает огромные средства в создание инфраструктуры ИИ и расширение ЦОД. Microsoft заявила, что за квартал капитальные затраты выросли на 5,3 % до $20 млрд по сравнению с $19 млрд в предыдущем квартале. Это выше оценки Visible Alpha в размере $19,23 млрд. Сообщается, что в основном средства пошли на расширение ЦОД. Всего за 2025 финансовый год, начавшийся в июле, по оценкам аналитиков Visible Alpha, компания потратит более $80 млрд, что на $30 млрд больше, чем в предыдущем финансовом году. Компания считается лидером среди крупных технологических компаний в гонке ИИ благодаря своему эксклюзивному партнёрству с OpenAI, разработчиком ИИ-чат-бота ChatGPT. Доход Microsoft от бизнеса ИИ пока невелик, хотя компания прогнозирует, что он станет более существенным. В текущем квартале компания планирует достичь выручки в размере $10 млрд в годовом исчислении. Также Microsoft сообщила об отказе от предоставления клиентам в аренду ускорителей для обучения новых моделей ИИ, сделав приоритетным инференс. «На самом деле мы не продаем другим просто GPU для обучения [ИИ-моделей], — сказал Сатья Наделла (Satya Nadella). — Это своего рода бизнес, от которого мы отказываемся, потому что у нас очень большой спрос на инференс» для поддержки различных Copilot и других услуг ИИ. Как сообщает The Register, финансовый директор Эми Худ (Amy Hood), в свою очередь заявила, что Microsoft рассматривает доход, полученный от инференса, как источник средств для оплаты будущих инициатив по обучению ИИ-моделей. Сейчас компания стремительно наращивает закупки суперускорителей NVIDIA GB200 NVL72, стремясь получить их до того, как они станут доступны другим игрокам. Кроме того, Azure станет посредником в процессе расширения ИИ-инфраструктуры OpenAI.

02.11.2024 [12:12], Сергей Карасёв

У VK Cloud появился ИИ-консультант по облачным сервисамОблачная платформа VK Cloud объявила о внедрении так называемого «Верховного архитектора мультиоблака» — консультанта на основе ИИ, отвечающего за мгновенную техническую поддержку. Этот помощник в виде бота Telegram работает в круглосуточном режиме. Отмечается, что ассистент обучен на масштабной базе знаний по продуктам VK Cloud объёмом более 6000 документов по 600 разделам. Помощник выполнен на базе LLM с RAG. При обучении консультанта были задействованы такие ИИ-технологии, как HyDE — для точного сопоставления запроса с документами, Router — для выбора наиболее подходящего направления поиска и Reranker — для дополнительной проверки и сортировки найденных ответов. Помощник работает только с публичной документацией и не имеет доступа к внутренним системам VK Cloud. Ассистент готов помочь с любыми вопросами, связанными с работой облачной платформы VK Cloud. Задавать вопросы можно в произвольной форме, а в ответ он напишет подробные инструкции, скрипты, манифесты Terraform. Система постоянно обновляется с учетом изменений в сервисах и документации VK Cloud. Среди преимуществ ИИ-бота названы глубокое понимание контекста, помощь в любое время дня и ночи, а также быстрые ответы, на генерацию которых требуются считаные секунды. Если консультант не сможет оперативно помочь, пользователь может обратиться в традиционную службу техподдержки. Фактически, как заявляет VK Cloud, это личный помощник разработчика и DevOps-инженера.

01.11.2024 [12:28], Руслан Авдеев

1 ГВт для AMD Instinct: TECfusions сформирует для ИИ-облака TensorWave масштабную инфраструктуру ЦОДСпециализирующаяся на строительстве и управлении ЦОД американская TECfusions заключила соглашение с TensorWave, предусматривающее предоставление последней ИИ-инфраструктуры. По информации Datacenter Dynamics, в рамках договора TensorWave будет арендовать у оператора 1 ГВт ёмкости ЦОД. По словам представителя TECfusions, сотрудничество знаменует собой переломный момент в развитии ИИ-инфраструктуры. Как говорит компания, в ЦОД в Кларксвилле (Clarksville) уже размещён один из крупнейших в мире кластеров ускорителей, а сделка является свидетельством готовности TECfusions к самым ресурсоёмким проектам. Развёртывание 1 ГВт будет происходить поэтапно, но доступ к значимой доле ёмкости должен появиться уже к началу 2025 года. Tecfusion намерена использовать локальные генерирующие мощности, функционирующие в основном на природном газе, для обеспечения стабильных поставок энергии и во избежание скачков цен на неё. Компания уже владеет микросетями на территории ЦОД в Нью-Кенсингтоне (200 МВт, Пенсильвания) и Кларксвилле (220 МВт, Вирджиния).

Источник изображения: Henry Deng/unsplash.com Партнёрство сформировано по итогам SAFE-раунда финансирования TensorWaves, в ходе него привлечено $43 млн. Основанный в 2023 году стартап из Лас-Вегаса предоставляет клиентам доступ к вычислительным ИИ-мощностям на основе ускорителей AMD. На полученные средства TensorWave оснастит ЦОД ускорителями AMD Instinct MI300X, расширит команду и начнёт подготовку к внедрению следующего поколения ускорителей Instinct MI325X. На IV квартал намечен запуск новой инференс-платформы Manifest в IV. Как заявляют в TensorWave, способность TECfusions выводить на рынок масштабные, готовые к ИИ-задачам ёмкости за считанные месяцы значительно ускорит освоение рынка компанией. Партнёрство имеет ключевое значение для сохранения конкурентоспособности в ИИ-секторе. Сейчас TECfusions управляет тремя действующими ЦОД — в Аризоне, Пенсильвании и Вирджинии. В сентябре оператор объявил о завершении строительства третьего зала для ИИ-оборудования в Кларксвилле. Теперь общая ёмкость этого дата-центра достигла 34,5 МВт. До конца года будет оснащён четвёртый зал на 13,5 МВт.

31.10.2024 [15:40], Сергей Карасёв

МТС запустит публичную облачную платформуОператор МТС объявил о планах своей дочерней компании MWS (MTS Web Services) по запуску публичной облачной платформы. Речь идёт о развёртывании экосистемы инфраструктурных и сетевых сервисов, инструментов для хранения и обработки данных, а также PaaS-сервисов со средствами обеспечения безопасности. Ввод облака в эксплуатацию будет происходить в несколько этапов. До конца 2024 года в превью-режиме заработает объектное хранилище. Работу сервиса будут поддерживать два ЦОД в инфраструктуре MWS, что обеспечит сохранность информации и ее высокую доступность. Во II квартале 2025-го хранилище будет дополнено другими вычислительными и сетевыми службами. Они позволят решать задачи по размещению сайтов и приложений, интернет-магазинов, внутренних IT-систем, созданию катастрофоустойчивых решений и пр. В III четверти следующего года планируется внедрение набора PaaS: системы управления базами данных PostgreSQL и Redis, распределённая система обмена сообщениями между серверными приложениями в режиме реального времени Apache Kafka, а также служба автоматического развёртывания, масштабирования и управления контейнерами Managed Kubernetes.

Источник изображения: MWS Ожидается, что новая облачная платформа станет основой для ключевых систем MWS. Поверх неё будут разворачиваться ИИ-решения, базы данных и офисное ПО для удовлетворения различных запросов клиентов. «В рамках одного окна бизнес сможет получить самые передовые облачные сервисы, созданные в соответствии с лучшими мировыми практиками», — говорит вице-президент по развитию инфраструктуры МТС, генеральный директор MWS.

29.10.2024 [18:36], Владимир Мироненко

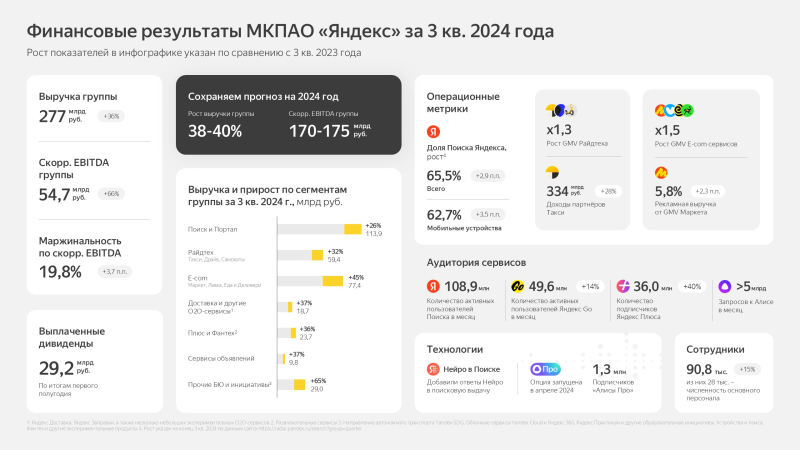

«Яндекс» увеличил в III квартале выручку более чем на треть, сократив убыткиМКПАО «Яндекс» объявило неаудированные финансовые результаты за III квартал 2024 года, завершившийся 30 сентября. Как и в предыдущем квартале выручка компании выросла год к году более чем на треть (36 %) до 276,8 млрд руб. При этом операционная прибыль выросла на 14 % до 25,4 млрд руб., а чистый убыток сократился на 62 % до 7,6 млрд руб. Скорректированная прибыль выросла более чем вдвое — на 118 % до 25,1 млрд руб. Также значительно увеличился скорректированный показатель EBITDA — на 66 % до 54,7 млрд руб. Компания сохранила свой прогноз по росту общей выручки в 2024 году в диапазоне от 38 до 40 % год к году, а по скорректированному показателю EBITDA — от 170 до 175 млрд руб. В сегменте «Прочих бизнес-юнитов и инициатив», включающем, в то числе, облачные сервисы Yandex Cloud и Яндекс 360, выручка компании увеличилась на 65 % до 29,0 млрд руб. Убыток по скорректированному показателю EBITDA при этом сократился на 4 % до 10,8 млрд руб., а рентабельность скорректированного показателя EBITDA составила –37,3 % (26,9 п.п. год к году).

29.10.2024 [14:36], Руслан Авдеев

Загадочная компания намерена построить в Италии ЦОД за €30 миллиардовМинистр промышленности Италии Адольфо Урсо (Adolfo Urso) объявил о желании неназванной компании реализовать в стране проект строительства ЦОД общей стоимостью €30 млрд ($33 млрд). По информации Reuters, проект предложен неназванной иностранной корпорацией. По словам министра, представитель компании заявил, что выбор пал на Итали потому, что её можно назвать идеальным местом для дата-центров. Страна — участница «большой семёрки», находится в средиземноморском бассейне, на перекрёстке мировых информационных маршрутов. Дополнительные подробности не раскрываются. Как предполагают эксперты, подобная инвестиция способна обеспечить строительство гигаваттных кампусов ЦОД — при этом Италия всегда считалась рынком вторичным рынком дата-центров. Для сравнения, в £10 млрд ($13,3 млрд) обойдётся 1,1-ГВт проект QTS (Blackstone) в Великобритании, отмечает DataCenter Dynamics.

Источник изображения: Jack Ward/unsplash.com Немногие операторы ЦОД вообще имеют доступ к таким финансовым ресурсам. При этом каждый из облачных гиперскейлеров, включая Microsoft, Google, Oracle и AWS (Amazon) уже имеют дата-центры в стране. Так, облачный регион Microsoft расположен в Милане. Компания анонсировала регион Italian Azure в мае 2020 года, а запустила его в 2023 году. Недавно компания анонсировала намерение инвестировать в расширение местной облачной инфраструктуры ещё €4,3 млрд ($4,75 млрд). Это был последний из американских гиперскейлеров, запустивший своё облако в Италии. AWS запустила регион в Милане в 2020 году и намерена инвестировать ещё. Oracle свой первый облачный регион тоже запустила в Милане в конце 2021 года. Ранее в этом году компания анонсировала планы создания второго региона в Турине при сотрудничестве с телеком-оператором Telecom Italia (TIM). Первый облачный регион Google открылся всё в том же Милане в 2022 году, с тех пор второй регион Google Cloud Platform (GCP) запустили в Турине.

29.10.2024 [13:39], Руслан Авдеев

Группа Open Cloud Coalition будет продвигать открытость на облачном рынке — Microsoft уже назвала её «искусственным газоном, созданным Google»На днях была основана новая группа Open Cloud Coalition (OCC), намеренная продвигать «открытость и совместимость» на рынке облачных услуг. По данным Computer Weekly, она будет поддерживать антимонопольные ведомства, надзирающие за бизнес-практиками гиперскейлеров. Новый проект пришёлся по вкусу не всем облачным операторам. OCC основана 10 компаниями, призывающими к большей открытости, совместимости и честной конкуренции на облачном рынке. Участники также обязуются публиковать исследовательские данные и консультировать регуляторов в Европе, исследующих антиконкурентное поведение. Примечательно, что в число основателей входит Google Cloud, недавно подавшая жалобу в Еврокомиссию на неконкурентные практики облачного лицензирования Microsoft. Не так давно ассоциация облачных провайдеров CISPE уже жаловалась европейским властям на Microsoft, но в итоге последняя урегулировала проблему, заплатив небольшим компаниям более $20 млн. Google, по слухам, предлагала в разы больше, чтобы более мелкие игроки не отказывались от претензий, но компанию и AWS оставили один на один с Microsoft, а последняя заявляла, что конкуренты «мутят воду», только притворяясь слабыми.

Источник изображения: jean wimmerlin/unsplash.com Теперь, по данным СМИ, Google фактически запускает собственную версию CISPE, включающую Centerprise International, Civo и Gigas, а также других мелких игроков, в том числе ControlPlane, DTP Group, Prolinx, Pulsant, Clairo и Room 101. Представители коалиции заявляют, что в будущем привлекут новых участников, а соответствующие переговоры уже ведутся. Новость о появлении коалиции обнародована на фоне вестей с мирового облачного рынка, где активно расследуется антиконкурентное поведение как Microsoft, так и Amazon (AWS). В частности, соответствующие расследования ведёт Управление по конкуренции и рынкам (CMA) Великобритании с подачи регулятора Ofcom, в сферу внимания которого попали Microsoft и AWS, не в последнюю очередь с подачи Google. Похожие расследования ведутся в Испании и Дании. В условиях, когда облачная инфраструктура становится незаменимой, многие компании попали в ловушки, связанные ограничительными соглашениями, фактически не дающими возможности реализовать «мультиоблачные» стратегии. Этот тренд и намерена изменить OCC, продвигая более конкурентные практики и открытые стандарты, а также принципы, позволяющие легко менять провайдеров. Впрочем, в Microsoft уже раскритиковали инициативу, назвав организацию «искусственным газоном, созданным Google». Хотя Google формально не является лидером коалиции, предполагается, что именно она является теневым «кукловодом». В Microsoft утверждают, что конкурент добивается двух целей — пытается отвлечь от антимонопольных расследований по всему миру, проводящихся против самой Google, и пытается изменить вектор внимания регуляторов в свою пользу вместо того, чтобы состязаться честно.

28.10.2024 [11:48], Сергей Карасёв

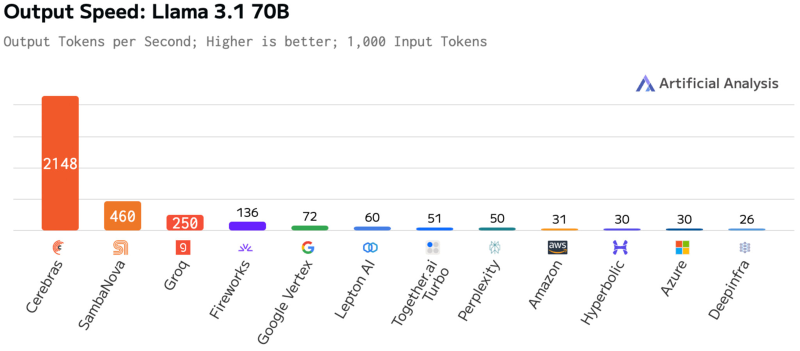

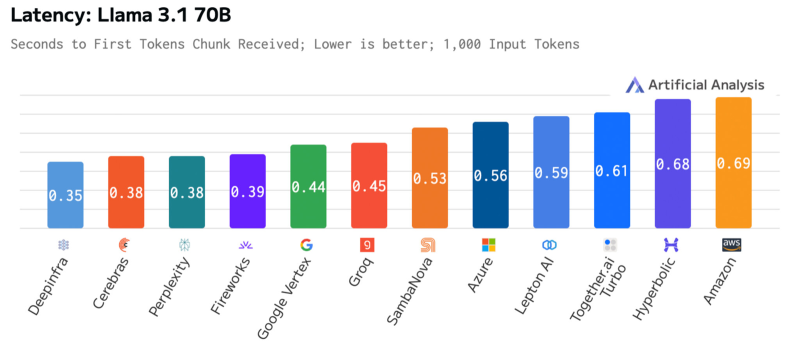

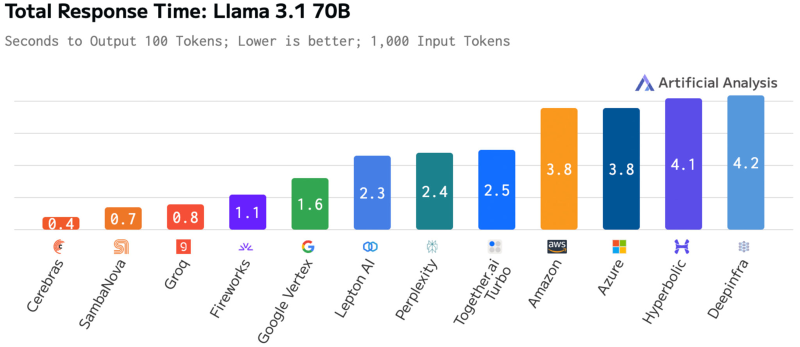

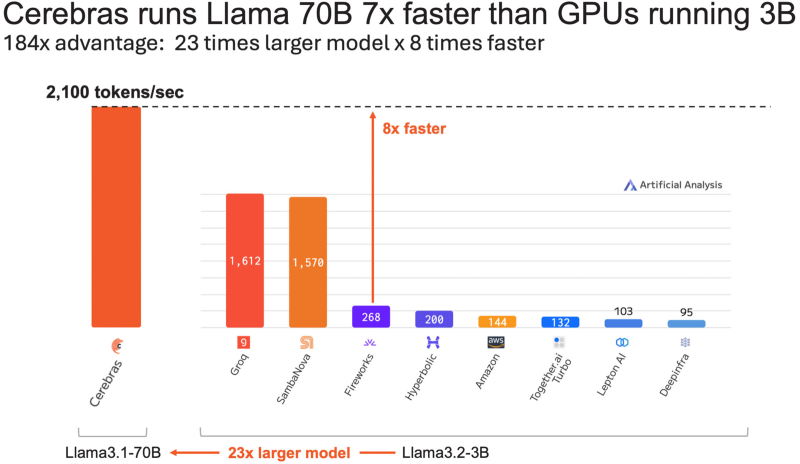

Cerebras втрое повысила производительность своей инференс-платформыАмериканский стартап Cerebras Systems, специализирующийся на разработке ИИ-ускорителей, объявил о самом масштабном обновлении ИИ-платформы Cerebras Inference с момента её запуска. Производительность системы поднялась примерно в три раза. Первый релиз Cerebras Inference состоялся в августе 2024 года. Основой облачной платформы являются ускорители собственной разработки WSE-3. На момент запуска быстродействие составляло до 1800 токенов в секунду на пользователя для ИИ-модели Llama3.1 8B и до 450 токенов в секунду для Llama3.1 70B (FP16). Разработчик заявлял, что Cerebras Inference — это «самая мощная в мире» ИИ-платформа для инференса. Однако в сентябре нынешнего года у Cerebras Inference появился серьёзный конкурент. Компания SambaNova Systems запустила облачный сервис SambaNova Cloud, также назвав его «самой быстрой в мире платформой для ИИ-инференса». Система на основе чипов собственной разработки SN40L демонстрирует быстродействие до 461 токена в секунду при использовании Llama 3.1 70B. В ответ Cerebras Systems усовершенствовала своё решение путём «многочисленных улучшений программного обеспечения, оборудования и алгоритмов». Утверждается, что обновлённая платформа Cerebras Inference при обслуживании Llama3.1 70B обеспечивает быстродействие 2148 токенов в секунду. Для сравнения: у AWS — лидера мирового облачного рынка — этот показатель равен 31 токену в секунду. А у Groq значение находится на уровне 250 токенов в секунду. Данные получены по результатам тестов Artificial Analysis. Время до получения первого токена имеет решающее значение для приложений реального времени. Cerebras находится на втором месте с показателем 0,38 с, уступая только Deep Infra (0,35 с). Вместе с тем Cerebras лидирует по общему времени отклика для 100 токенов на выходе с показателем 0,4 с против 0,7 с у SambaNova, которая находится на втором месте. В целом, как отмечается, платформа Cerebras Inference при работе с Llama3.1 70B опережает сервисы конкурентов на основе GPU, обрабатывающие модель Llama3.1 3B, которая в 23 раза меньше.

25.10.2024 [19:02], Владимир Мироненко

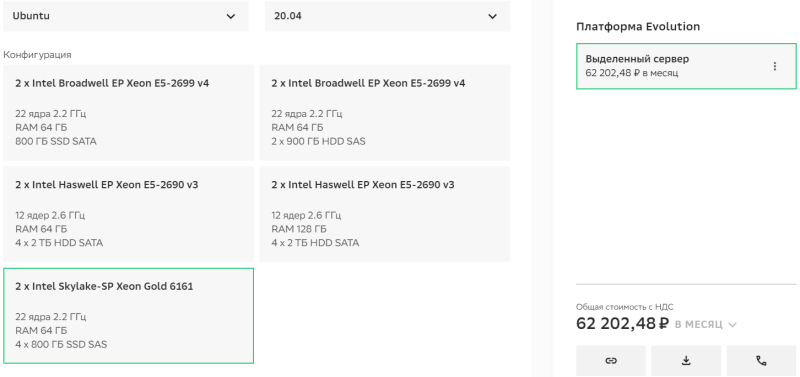

В Cloud.ru появилась аренда bare metal серверовОблачный провайдер Cloud.ru сообщил о запуске сервиса Evolution Bare Metal, с помощью которого пользователь может получить выделенный сервер из личного кабинета без обращения за помощью к службе техподдержки. Сервис позволит арендовать выделенные серверы для систем, которым требуется доступ к аппаратной части. Evolution Bare Metal интегрирован с кроссплатформенными сервисами Cloud.ru. Пользователь может выбрать нужную из готовых конфигураций для разных типов задач, различающихся типом процессоров, объёмом памяти и характеристиками дисков. После заказа клиент получает доступ к серверу менее, чем за минуту без учёта времени на установку операционной системы. Для управления сервером доступны VNC и API. Сценарии использования сервиса Evolution Bare Metal:

Как указано в пресс-релизе, Evolution Bare Metal позволит использовать выделенные физические серверы с облачной инфраструктурой, гибкой конфигурацией и удобным управлением для аналитических задач, работы с высоконагруженными корпоративными приложениями и базами данных в цифровом банкинге, финтехе, e-commerce, онлайн-стриминге. Впрочем, пока что на выбор предлагаются всего пять конфигураций готовых серверов серии Light на базе 12- и 22-ядерных CPU Intel Xeon поколения Haswell-EP/Broadwell-EP и Skylake-SP с 64 или 128 Гбайт RAM и SAS/SATA SSD/HDD. Для установки доступны ОС Ubuntu Linux и Oracle Linux. |

|