Материалы по тегу: ии

|

16.07.2024 [22:32], Владимир Мироненко

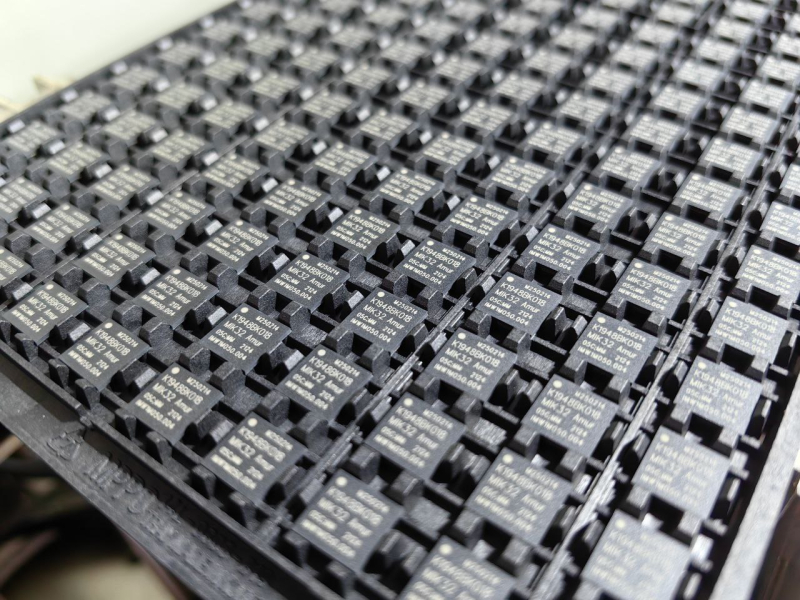

GS Group отгрузила 100 тыс. российских микроконтроллеров «MIK32 Амур» на базе RISC-V — ещё 400 тыс. на подходеПредприятие GS Nanotech из Калининграда, входящее в холдинг GS Group, сообщило о сборке и отгрузке по заказу АО «Микрон» стотысячной партии микроконтроллеров «MIK32 Амур» на открытой архитектуре RISC-V. По словам АО «Микрон», в связи с высоким спросом и в целях наращивания объёмов корпусирования изделий, дополнительно к собственному сборочному производству компания использует мощности предприятия GS Nanotech, которое в рамках соглашения до конца года соберёт в корпус до 0,5 млн микроконтроллеров «Амур». «Мы имеем большой опыт по корпусированию микроконтроллеров и рады применить его в сотрудничестве с нашим давним партнёром», — заявил вице-президент GS Group по развитию производства. Как сообщается, в ходе выполнения заказа GS Nanotech использовала опыт, накопленный ранее при крупносерийной сборке чипов в корпусах BGA, LGA, а также сложных многовыводных микросхем, в том числе по технологии SiP (системы-в-корпусе). Благодаря этому показатель выхода годной продукции составил 99,2 %. Также предприятием была разработана тестовая программа для контроля полного соответствия заявленным характеристикам микроконтроллеров. «MIK32 Амур» (К1949ВК018) представляет собой первый полностью отечественный 32-бит микроконтроллер с ядром на архитектуре RISC-V, который был разработан и производится в России ГК «Элемент» (разработка совместно с НИИМА «Прогресс», производство «Микрона»). Изделие включено в Единый реестр российской радиоэлектронной продукции (ПП РФ 878) и его производство не зависит от лицензируемой зарубежной интеллектуальной собственности.

16.07.2024 [16:04], Руслан Авдеев

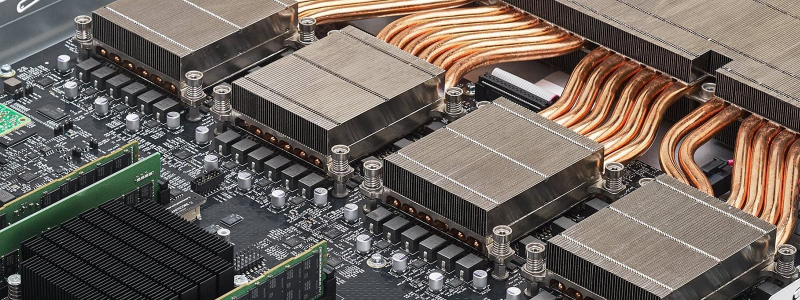

ИИ-серверы вместо лекарств: Supermicro попала в индекс Nasdaq 100, вытеснив Walgreens Boots AllianceВедущий поставщик аппаратных решений для дата-центров Supermicro занял место в биржевом индексе Nasdaq 100. По данным HPC Wire, производитель серверов, СХД и иных решений вытеснил из индекса фармацевтический холдинг Walgreens Boots Alliance. В индексе отслеживаются показатели 100 крупнейших по капитализации компаний, торгующихся на бирже Nasdaq, но не относящихся к финансовому сектору. Для сохранения присутствия в индексе есть целый ряд требований, учитывающих капитализацию, объём торгов, долю акций на бирже и т.д. Попадание в Nasdaq 100 косвенно свидетельствует о влиянии, прибыльности и успешности компании. Общая стоимость индекса составляет сегодня порядка $20 трлн., это рекордное значение.

Источник изображения: Woldai Wagner/unsplash. По словам президента и генерального директора Supermicro Чарльза Ляна (Charles Liang), компания считает за честь быть включенной в индекс. Глава компании заявил, что Supermicro по-прежнему будет фокусироваться свою деятельность на уникальных для рынка инновациях, «зелёных» вычислениях, продолжит оставаться в лидерах рынка ИИ и по-прежнему будет уделять много внимания устойчивому развитию, в то же время обеспечивая высокую стоимость акций. Ранее Supermicro попала в рейтинг S&P 500, а её выручка год к году продолжает увеличиваться. Бизнес продолжает инвестиции в технологии и решения для конечных пользователей, расширяет новые производственные мощности для удовлетворения растущего спроса участников индустрии ЦОД. Так, компания намерена стремительно нарастить долю продуктов с СЖО. По информации портала Trading View, Walgreens потеряла долю в Nasdaq 100, поскольку её акции в этом году упали в цене более чем на 50 %, из-за чего рыночная капитализация упала до $10 млрд или около 0,05 % рыночной стоимости индекса. В то же время внимание Supermicro к ИИ-системам позволило значительно укрепить позиции компании в 2024 году. С начала года компания подорожала более чем на 200 % до $52 млрд или более 0,25 % стоимости Nasdaq 100, причём признаки стремительного роста были очевидны ещё в феврале.

16.07.2024 [10:43], Владимир Мироненко

«Искра Технологии» запустила серийное производство российских GPON-роутеровКомпания «Искра Технологии» запустила серийное производство роутеров с поддержкой технологии GPON. Как сообщается на сайте компании, массовое производство домашних абонентских шлюзов GPON по заказу «Ростелекома» стартовало в июне на базе производственной площадки в Екатеринбурге. «Это первый проект производства массового абонентского оборудования, который реализуется в интересах ПАО “Ростелеком”. Текущие производственные мощности позволят предприятию выпускать несколько сотен тысяч изделий в год», — сообщила компания. В октябре прошлого года было объявлено о заключении «Ростелекомом» контракта с компанией «Электра» на разработку и поставку Wi-Fi роутеров на сумму 2,7 млрд руб., включая 1,1 млрд руб. на разработку и внедрение 350 тыс. FTTB CPE и 1,6 млрд руб. — на 450 тыс. GPON ONT. Как отметил директор департамента технологий доступа АО «Искра Технологии», создание производства роутеров в России на собственной производственной базе позволит не только удовлетворить растущий спрос на высокотехнологичное оборудование, но и будет способствовать созданию новых рабочих мест и укреплению технологического суверенитета страны. Абонентская база «Ростелекома» во II квартале 2023 года составляла по данным «TMT консалтинга» порядка 12,6 млн человек. То есть, потенциал для расширения производства роутеров для АО «Искра Технологии» имеется даже в случае сотрудничества только с одним «Ростелекомом».

15.07.2024 [14:49], Руслан Авдеев

ВТБ потратит на импортозамещение ПО 90 млрд рублейВ 2021–2024 гг. общие расходы ВТБ на импортозамещение IT-систем и сервисов составят 90 млрд руб, в первую очередь речь идёт о расходах на программное обеспечение. По данным «Ведомостей», больше всего средств — более 50 млрд — будет потрачено в 2024 году. По словам председателя правления ВТБ, львиная доля IT-инвестиций приходится на закупки отечественного ПО, развитие и поддержку программных решений. Работы по замещению самых сложных систем начаты ещё в 2021 году, а в 2025–2026 гг. планируется завершить переход на российские аналоги. На отечественное ПО в ВТБ перевели 85 % внутренних систем финансовой организации, тогда как на конец 2023 года этот показатель находился на уровне 70 %. При этом в условиях сложной инфраструктуры ВТБ переход осуществляется неравномерно, речь идёт о 800 прикладных системах и 875 тыс. объектов — для каждого предусмотрены свои критерии оценки импортозамещения. По итогам 2024 года речь должна идти о замещении на уровне 95 %.

Источник изображения: Wes Hicks/unsplash.com Одним из важных и масштабных шагов на пути к импортозамещению стал переход на российскую ОС Astra Linux, а также переход с офисных продуктов Microsoft на российский «МойОфис». Кроме того, начато внедрение российской системы резервного копирования RuBackup, предлагаемой группой «Астра», со временем она должна полностью вытеснить иностранную NetBackup в экосистеме ВТБ. Наконец, в колл-центрах американская платформа Avaya заменена на российское ПО Naumen, позволяющее автоматизировать поддержку. VDI-решения отечественного «Базиса» внедряют вместо Citrix, до конца года на российскую платформу должны перевести большинство сотрудников банка. В целом банк отказывается от иностранных систем виртуализации, среди которых лидером были решения VMWare. Почти полностью компания отказалась и от разработок SAS, обеспечивавших аналитику на основе больших данных. Импортозамещение ПАК Oracle Exadata и Teradata началось ещё в 2021 году, до конца текущего года банк планирует заместить 85 % соответствующих комплексов иностранного происхождения. Инфраструктура компании пока в некоторой степени зависима от ПО для СУБД Oracle и Microsoft SQL, но его доля уже снизилась с 80-90 % до менее 25 %. Со временем произойдёт полный переход на российские решения компаний T1 или Postgress Professional. По мнению отраслевых экспертов, наибольшая часть расходов ВТБ, связанных с импортозамещением, вероятно, придётся именно на замену продуктов Oracle и миграцию средств виртуализации. Кроме того, много средств будет потрачено на «связующий» софт (middleware), а также средства обеспечения кибербезопасности. Некоторые эксперты считают, что до 2025 года заменить всё ПО банк не успеет, но в этом нет и необходимости — государство, вероятно, пойдёт навстречу столь крупному игроку и сроки импортозамещения будут продлены. Продолжается и программа цифровой трансформации. Речь идёт о более широком понятии, чем импортозамещение, поскольку речь в числе прочего идёт и об уходе от бумажного документооборота, а также замещении старых аппаратных комплектующих. С 2020 по 2024 гг. ВТБ намерен инвестировать в цифровую трансформацию полтриллиона рублей.

15.07.2024 [09:23], Владимир Мироненко

HPE построит самый мощный в Японии ИИ-суперкомпьютер ABCI 3.0 на базе NVIDIA H200Японский национальный институт передовых промышленных наук и технологий (AIST) объявил о планах по строительству в Касива (Kashiwa, префектура Тиба) нового суперкомпьютера AI Bridging Cloud Infrastructure 3.0 (ABCI 3.0), представляющего собой очередное обновление ИИ-платформы ABCI, запущенной в 2018 году. Новый суперкомпьютер будет предлагаться в качестве облачного сервиса как государственным, так и частным организациям страны, сообщается в блоге NVIDIA. В качестве подрядчика выступает HPE, которая построит систему с использованием платформы Cray XD с ускорителями NVIDIA H200, объединённых 200G-интерконнектом NVIDIA Quantum-2 InfiniBand. HPE не стала раскрывать подробности об общем количестве узлов, стоимости системы и сроках её ввода в эксплуатацию. Как полагает ресурс The Register, речь идёт о системе с 5U-узлами Cray XD670, способными вместить восемь ускорителей NVIDIA H200/H100 и пару Intel Xeon Emerald Rapids. Кроме того, готовится машина ABCI-Q на базе ускорителей NVIDIA H100, ориентированная на исследования в области квантовых и гибридных вычислений. HPE сообщила, что ABCI 3.0, как ожидается, станет самым быстрым ИИ-суперкомпьютером в Японии — примерно 6,2 Эфлопс (FP16?) или 410 Пфлопс (FP64). Проект ABCI 3.0 реализуется при поддержке Министерства экономики, торговли и промышленности Японии (METI) с целью укрепления вычислительных ресурсов страны через Фонд экономической безопасности. Это часть более широкой инициативы METI стоимостью $1 млрд, которая включает в себя как программу ABCI, так и инвестиции в облачные вычисления на базе ИИ.

13.07.2024 [22:42], Владимир Мироненко

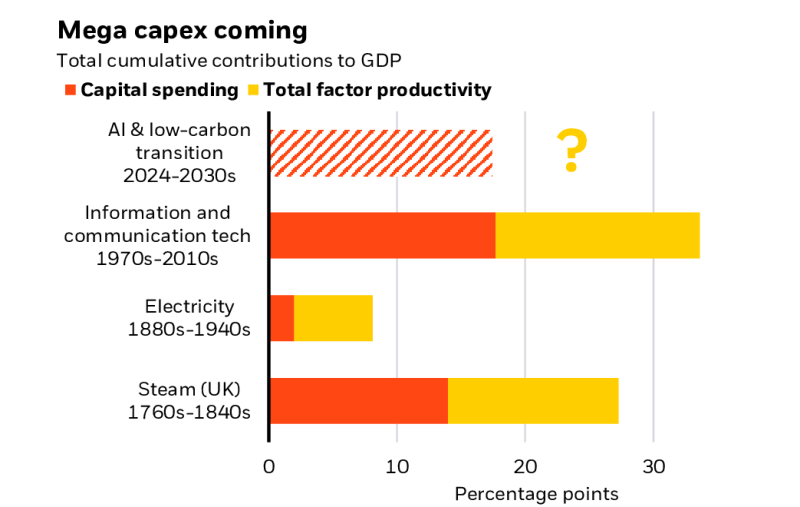

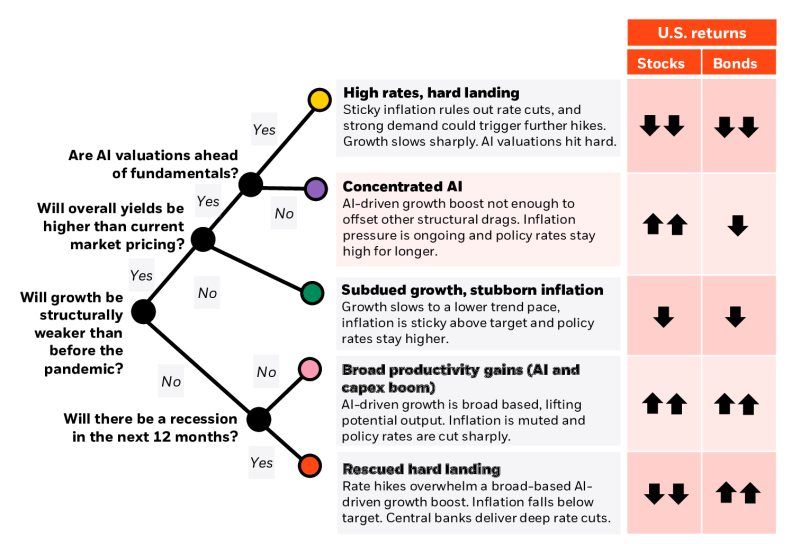

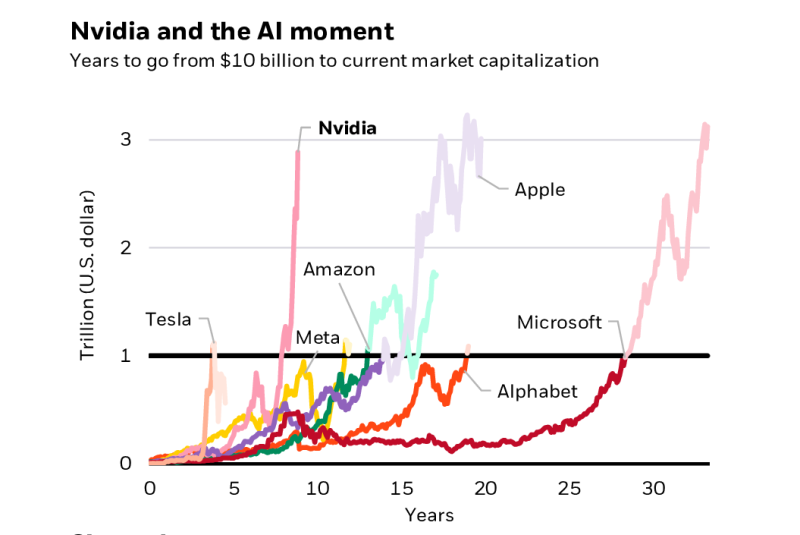

BlackRock: ИИ — это новая промышленная революция, которая подстегнёт быстрое развитие ЦОДСогласно исследованию 2024 Midyear Global Outlook инвестиционной компании BlackRock, опубликованному на прошлой неделе, в ближайшие годы ЦОД будут играть ключевую роль в развитии искусственного интеллекта (ИИ). BlackRock утверждает, что мир переживает технологическую трансформацию, сопоставимую с промышленной революцией, и ожидает, что ЦОД укрепят свои позиции в качестве важнейшего компонента инфраструктуры. Причём на фоне растущего спроса на ИИ потребность в них в ближайшем будущем резко возрастёт. Вэй Ли (Wei Li), главный глобальный инвестиционный стратег BlackRock, сообщил, что рост рынка ЦОД ИИ может составить в ближайшие годы 60–80% в годовом исчислении. Жан Буавен (Jean Boivin), глава Инвестиционного института BlackRock, отметил, что эта оценка во многом основана на ожиданиях отраслевых аналитиков. Ли подчеркнул, что в исследовании показано, как гонка за расширением возможностей ИИ уже стимулирует крупные капитальные расходы. «ИИ и переход к низкоуглеродным технологиям могут стимулировать исторически крупные капитальные расходы — и в гораздо более короткий промежуток времени, чем предыдущие технологические революции», — говорится в исследовании. По оценкам BlackRock, капитальные затраты на ИИ уже сопоставимы с крупнейшими вложениями в истории в рамках крупных глобальных преобразований, включая промышленную революцию. BlackRock тоже стремится извлечь выгоду из бума ИИ, поэтому вкладывает средства в развёртывание ЦОД в Северной Вирджинии (США) и во Франкфурте (Германия). В комментарии Data Center Knowledge главный аналитик Omdia Алан Ховард (Alan Howard) отметил, что бум строительства ЦОД начался давно. «Пандемия стала важным катализатором роста спроса на цифровую инфраструктуру, а затем появился новый спрос на ИИ, который снова увеличил спрос на ЦОД», — пояснил он. Ховард также заявил, что во II половине 2024 года появится ещё больше новостей о новых проектах и инициативах на рынке ЦОД. «Инвестсообщество, особенно фонды прямых инвестиций в инфраструктуру, уже давно вкладывает значительные средства в ЦОД, но возможности ИИ вдохнут новую жизнь в отрасль, поскольку капитала для хорошо проверенных проектов ЦОД предостаточно», — сказал Ховард, добавив, что сдержать взрывной рост ИИ могут проблемы в цепочках поставок оборудования, а также высокие затраты и доступность ЦОД. «Эти факторы могут побудить многих потребителей перейти на ИИ-сервисы гиперскейлеров или других облачных провайдеров уровня Tier 2. Эта эволюция займёт пару лет, и главным вопросом станет то, как производители ИИ-серверов будут конкурировать с NVIDIA», — говорит аналитик.

12.07.2024 [15:48], Руслан Авдеев

Oracle арендует у майнеров Crusoe Energy дата-центр, чтобы разместить там ускорители NVIDIA для OpenAIOracle намерена взять в аренду ЦОД Crusoe Energy, более всего известной проектами в сфере криптомайнинга. По данным Datacenter Dynamics, речь идёт о крупной сделке в интересах облака Oracle Cloud Infrastructure, которое в свою очередь будет обслуживать OpenAI. ИИ-стартап xAI Илона Маска (Elon Musk), отказавшись от сделки с Oracle по созданию крупного ИИ-кластера, походя сообщил о другом партнёре Oracle, готовом разместить в своих ЦОД ускорители NVIDIA GB200. Теперь же выяснилось, что этим партнёром и является Crusoe Energy, а компании уже близки к заключению сделки. Crusoe сдаст ЦОД в аренду Oracle, а та разместит как минимум часть из 100 тыс. ускорителей, предназначенных для нужд Microsoft. Microsoft же предоставит их в пользование OpenAI. Ранее с Crusoe Energy сотрудничала Lancium, строившая ЦОД для криптомайнинга в техасском Абилине (Abilene). Получивший добро в 2021 году Project Artemis описывался как кампус ЦОД с питанием от возобновляемой энергии, площадью более 320 га и ёмкостью до 200 МВт с возможностью расширения до 1 ГВт. Строительство должно было начаться в I квартале 2022 года. Основанная в 2018 году Crusoe Energy начала с поставок контейнерных ЦОД на нефтяные поля, где те могли использовать попутный природный газ из скважин для генерации электричества. Сейчас компания постепенно переходит от размещения модульных ЦОД рядом с нефтяными скважинами к строительству стационарных кампусов ЦОД и предлагает типовой проект ёмкостью до 100 МВт с возможностью размещения до 100 тыс. ускорителей. Также компания предлагает HPC/ИИ-ресурсы, в том числе посредством Crusoe Cloud. В последнем ESG-докладе Crusoe заявляла, что располагает ЦОД ёмкостью порядка, а около трети облака Crusoe Cloud снабжалось энергией за счёт газа с нефтяных скважин, оставшаяся ёмкость приходилась на сторонние ЦОД. Она, в частности, арендует мощности у atNorth и Digital Realty. Также компания намерена получить ещё 100 МВт от ветряной электростанции. Многие криптовалютные компании перепрофилируют деятельность под связанные с ИИ проекты, создавая облака на основе собственных ускорителей и/или размещая чужое оборудование на своих объектах. В числе подобных компаний — CoreWeave, Core Scientific, Northern Data, Hut 8 и Applied Digital.

12.07.2024 [11:32], Руслан Авдеев

SoftBank приобрела британского разработчика ИИ-ускорителей GraphcoreЯпонская SoftBank, уже владеющая британским разработчиком процессоров Arm, приобрела британскую же компанию Craphcore, занятую разработкой ИИ-ускорителей. По данным The Register, сумма потенциальной сделки не называется, но по некоторым оценкам она составит $600 млн — для сравнения, Graphcore привлекла $700 млн в ходе всех раундов финансирования. Graphcore официально объявила о сделке в четверг, а её глава Найджел Тун (Nigel Toon) публично одобрил её, подчеркнув, что спрос на ИИ-вычисления сейчас высок и продолжает расти, а SoftBank является тем партнёром для Graphcore, который поможет «изменить ландшафт» ИИ-технологий. Штаб-квартира компании по-прежнему останется в Бристоле. Ключевые активы компании — ИИ-ускорители Intelligence Processing Units (IPU), а также стек ПО. Хотя вычислительные системы BOW POD16 оказались производительнее NVIDIA DGX A100, процветания в компании не дождались и рассматривали продажу ещё в феврале 2024 года.

Источник изображения: Graphcore Несмотря на первоначальный успех, бизнес не смог стать прибыльным. В 2022 году выручка составила всего $2,7 млн — на 46 % меньше год к году, операционные расходы составили $206,8 млн. После этого начались увольнения — по словам представителей компании, необходимые для того, чтобы удержать бизнес на плаву. Более того, компания даже стала получать иски. Сотрудничество с китайскими бизнесами могло бы вывести Graphcore из тупика, но США ограничили продажи высокопроизводительных ускорителей в КНР. Тем временем NVIDIA закрепила своё влияние на рынке решений для генеративных ИИ-систем. Тун прогнозирует, что SoftBank, наконец, даст возможность Graphcore составить конкуренцию лидерам отрасли. По словам SoftBank Investment Advisers, новое поколение полупроводников и вычислительных систем имеет чрезвычайное значение для работ над т.н. «общим искусственным интеллектом» (AGI), поэтому SoftBank рада сотрудничать с Graphcore. При этом в SoftBank не акцентируют внимание на том, что компания уже является владельцем контрольного пакета акций британской Arm, на решениях которой строятся многие современные полупроводники. Последняя имеет собственные амбиции и намерена представить альтернативу решениям NVIDIA. Graphcore предлагает ещё одну альтернативу и уже имеет готовое техническое решение. С учётом финансовых ресурсов SoftBank и связей с Arm, компания, возможно, получит второе дыхание для нового старта. Другими словами, сектор ИИ-инфраструктуры сможет стать более конкурентным, что в любом случае пойдёт на благо покупателей.

11.07.2024 [23:57], Владимир Мироненко

Нет NGFW в своём отечестве: исследование МТС RED говорит, что полной замены зарубежным решениям в РФ пока не создано

брандмауэр

импортозамещение

информационная безопасность

исследование

мтс

россия

сделано в россии

сети

В настоящее время на рынке нет отечественного многофункционального сетевого экрана нового поколения (Next Generation Firewall, NGFW), способного полностью заменить решения зарубежных вендоров, включая тех, кто покинул Россию в 2022 году, считает более половины (64 %) участников опроса, проведённого компанией МТС RED, дочерним предприятием оператора МТС, передаёт ТАСС. В опросе приняло участие более 100 сотрудников служб информационной безопасности российских компаний, в 36 % которых персонал составляет до 1 тыс. человек, в 45 % — до 5 тыс. человек, а в 19 % — свыше 10 тыс. человек. К началу июля лишь 16 % компаний внедрили отечественные средства сетевой безопасности, и лишь половина из них использует NGFW для фильтрации основного объёма сетевого трафика. В числе причин нежелания переходить на отечественные NGFW участники опроса назвали низкий уровень отказоустойчивости (½ респондентов), сбои в ходе анализа трафика и возникновение проблем уже на этапе внедрения. Большинство (82 %) считает надёжность одним из ключевых критериев оценки работы NGFW. 40 % опрошенных отметили важность уровня сервисной и технической поддержки. Также компании обращают внимание на скорость обработки трафика и масштабируемость решений. Около 55 % респондентов заявили, что отечественные NGFW не соответствуют их требованиям по этим показателям. В МТС RED отметили, что, несмотря на существующее несоответствие ожиданиям некоторых характеристик отечественных NGFW, российские компании продолжают искать замену зарубежным решениям. 27 % участников опроса сообщили, что сейчас проводят тестирование российских разработок. При этом некоторые считают целесообразным использовать сразу несколько продуктов. При этом отечественный рынок NGFW активно развивается. По оценкам МТС RED он вырастет с 24 млрд руб. в 2023 году до 50 млрд руб. к 2029 году. Среднегодовой темп прироста (CAGR) за этот период составит 13 %.

11.07.2024 [16:05], Андрей Крупин

Состоялся релиз «Кибер Инфраструктуры» версии 6.0 с улучшенной производительностью и отказоустойчивостьюКомпания «Киберпротект» сообщила о выпуске новой версии «Кибер Инфраструктуры» 6.0 — универсального решения, которое сочетает в одном продукте программно-определяемое хранилище и платформу виртуализации и содержит все необходимые компоненты для построения масштабируемой IT-инфраструктуры предприятия. Обновлённый комплекс получил поддержку технологии EVC для настройки режима эмуляции ЦП виртуальных машин (полезна для работы в кластере из смешанного оборудования), средства импорта внешних систем хранения данных и возможность использования внешних СХД по протоколу iSCSI для размещения томов с операционной системой, приложениями и данными виртуальных машин, развёрнутых в вычислительном кластере.

Источник изображения: cyberprotect.ru/products/infrastructure Среди прочих нововведений отмечается возможность массовой настройки дисков хранилища с управлением ролями всех накопителей на одном экране, а также выбора группы дисков для назначения им ролей или сброса ранее назначенной конфигурации. Были расширены возможности по созданию метро-кластера, в конфигурацию которого включены варианты схемы репликации из 4 реплик и схемы избыточного кодирования с повышенным количеством блоков чётности. Реализована настройка уровня чувствительности кластера к отказу узлов и поддержка записи в хранилище после полной потери избыточности. Благодаря поддержке Tagging и Lifecycle продукт обеспечивает более эффективное управление объектами в S3-хранилищах. Дополнительно в «Кибер Инфраструктуре» 6.0 реализована возможность увеличения количества реплик панели управления до 7 экземпляров, что соответствует отказоустойчивости кластера на уровне 3 узлов. Это обеспечивает повышенную устойчивость к сбоям и гарантирует непрерывность работы критически важных приложений и сервисов. Также разработчиками расширен спектр совместимого оборудования и внесено в продукт множество других улучшений и изменений, направленных на повышение его производительности, отказоустойчивости и удобства работы с хранилищами. «Кибер Инфраструктура» может быть развёрнута на стандартном серверном оборудовании и обеспечивает централизованное управление всеми компонентами системы. Решение включено в реестр российских программ Минцифры России и подходит для замещения зарубежных продуктов. |

|