Материалы по тегу: бенчмарк

|

28.03.2024 [14:31], Сергей Карасёв

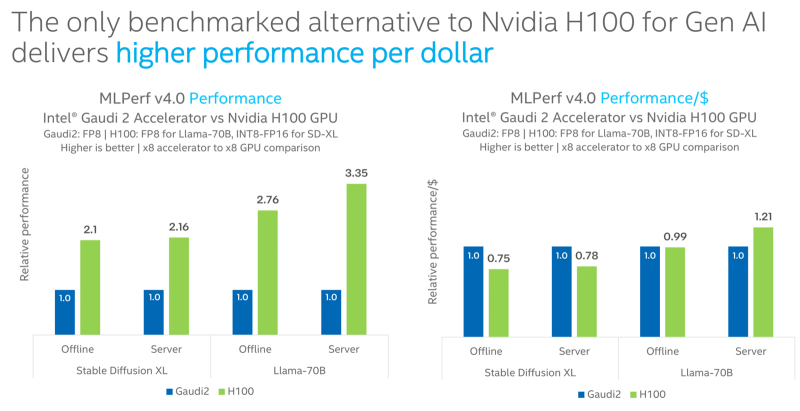

Intel Gaudi2 остаётся единственным конкурентом NVIDIA H100 в бенчмарке MLPerf InferenceКорпорация Intel сообщила о том, что её ИИ-ускоритель Habana Gaudi2 остаётся единственной альтернативой NVIDIA H100, протестированной в бенчмарке MLPerf Inference 4.0. При этом, как утверждается, Gaudi2 обеспечивает высокое быстродействие в расчёте на доллар, хотя именно чипы NVIDIA являются безоговорочными лидерами. Отмечается, что для платформы Gaudi2 компания Intel продолжает расширять поддержку популярных больших языковых моделей (LLM) и мультимодальных моделей. В частности, для MLPerf Inference v4.0 корпорация представила результаты для Stable Diffusion XL и Llama v2-70B. Согласно результатам тестов, в случае Stable Diffusion XL ускоритель H100 превосходит по производительности Gaudi2 в 2,1 раза в оффлайн-режиме и в 2,16 раза в серверном режиме. При обработке Llama v2-70B выигрыш оказывается более значительным — в 2,76 раза и 3,35 раза соответственно. Однако на большинстве этих задач (кроме серверного режима Llama v2-70B) решение Gaudi2 выигрывает у H100 по показателю быстродействия в расчёте на доллар. В целом, ИИ-ускоритель Gaudi2 в Stable Diffusion XL показал результат в 6,26 и 6,25 выборок в секунду для оффлайн-режима и серверного режима соответственно. В случае Llama v2-70B достигнут показатель в 8035,0 и 6287,5 токенов в секунду соответственно. Говорится также, что серверные процессоры Intel Xeon Emerald Rapids благодаря улучшениям аппаратной и программной составляющих в бенчмарке MLPerf Inference v3.1 демонстрируют в среднем в 1,42 раза более высокие значения по сравнению с чипами Xeon Sapphire Rapids. Например, для GPT-J с программной оптимизацией и для DLRMv2 зафиксирован рост быстродействия примерно в 1,8 раза.

27.03.2024 [22:29], Алексей Степин

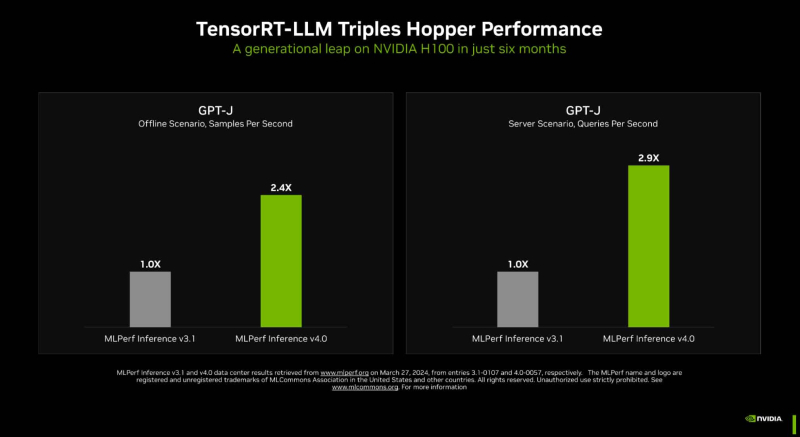

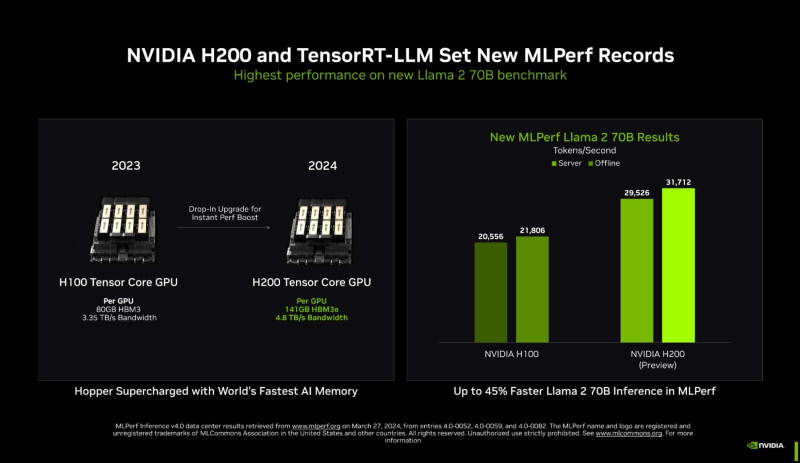

Новый бенчмарк — новый рекорд: NVIDIA подтвердила лидерские позиции в MLPerf InferenceКомпания NVIDIA опубликовала новые, ещё более впечатляющие результаты в области работы с большими языковыми моделями (LLM) в бенчмарке MLPerf Inference 4.0. За прошедшие полгода и без того высокие результаты, демонстрируемые архитектурой Hopper в инференс-сценариях, удалось улучшить практически втрое. Столь внушительный результат достигнут благодаря как аппаратным улучшениям в ускорителях H200, так и программным оптимизациям. Генеративный ИИ буквально взорвал индустрию: за последние десять лет вычислительная мощность, затрачиваемая на обучение нейросетей, выросла на шесть порядков, а LLM с триллионом параметров уже не являются чем-то необычным. Однако и инференс подобных моделей тоже является непростой задачей, к которой NVIDIA подходит комплексно, используя, по её же собственным словам, «многомерную оптимизацию». Одним из ключевых инструментов является TensorRT-LLM, включающий в себя компилятор и прочие средства разработки, учитывающие архитектуру ускорителей компании. Благодаря ему удалось почти втрое повысить производительность инференса GPT-J на ускорителях H100 всего за полгода. Такой прирост достигнут благодаря оптимизации очередей на лету (inflight sequence batching), применению страничного KV-кеша (paged KV cache), тензорному параллелизма (распределение весов по ускорителям), FP8-квантизации и использованию нового ядра XQA (XQA kernel). В случае ускорителей H200, использующих ту же архитектуру Hopper, что и H100, важную роль играет память: 141 Гбайт HBM3e (4,8 Тбайт/с) против 80 Гбайт HBM3 (3,35 Тбайт/с). Такой объём позволяет разместить модель уровня Llama 2 70B целиком в локальной памяти. В тесте MLPerf Llama 2 70B ускорители H200 на 28 % производительнее H100 при том же теплопакете 700 Вт, а увеличение теплопакета до 1000 Вт (так делают некоторые вендоры в своих MGX-платформах) даёт ещё 11–14 % прироста, а итоговая разница с H100 в этом тесте может доходить до 45 %. В специальном разделе новой версии MLPerf NVIDIA продемонстрировала несколько любопытных техник дальнейшей оптимизации: «структурированную разреженность» (structured sparsity), позволяющую поднять производительность в тесте Llama 2 на 33 %, «обрезку» (pruning), упрощающую ИИ-модель и позволяющую повысить скорость инференса ещё на 40 %, а также DeepCache, упрощающую вычисления для Stable Diffusion XL и дающую до 74 % прироста производительности. На сегодня платформа на базе модулей H200, по словам NVIDIA, является самой быстрой инференс-платформой среди доступных. Результатами GH200 компания похвасталась ещё в прошлом раунде, а вот показатели ускорителей Blackwell она не предоставила. Впрочем, не все считают результаты MLPerf показательными. Например, Groq принципиально не участвует в этом бенчмарке.

11.03.2024 [10:02], Сергей Карасёв

Viavi купит Spirent за $1,28 млрдАмериканская компания Viavi Solutions объявила о заключении соглашения по приобретению конкурирующей британской фирмы Spirent Communications. Сумма сделки, осуществить которую планируется за счёт денежных средств, составляет немногим более £1 млрд, или приблизительно $1,277 млрд. Viavi, базирующаяся в Чандлере (Аризона, США), производит оборудование для тестирования и мониторинга сетей. Кроме того, компания специализируется на оптических технологиях для различных сфер применения, включая контроль качества материалов, выявление фальшивых денежных знаков и т.д. В 2023 финансовом году выручка Viavi составила $1,1 млрд, что на 14 % меньше, чем годом ранее. В свою очередь, Spirent со штаб-квартирой в Кроули (Западный Суссекс, Великобритания) предоставляет продукты и услуги для решения задач в области тестирования, обеспечения качества и автоматизации технологий, в том числе для 5G, SD-WAN, облачных платформ и автономных транспортных средств. По условиям соглашения, акционеры Spirent получат £1,725 (около $2,22) за каждую ценную бумагу. Сделка будет финансироваться за счёт имеющихся у Viavi денежных средств, кредита на семь лет в размере $800 млн от Wells Fargo Bank и инвестиций в $400 млн со стороны Silver Lake. Завершить слияние планируется во II половине 2024 года при условии одобрения акционеров и получения необходимых разрешений со стороны регулирующих органов. Путём совмещения активов стороны намерены укрепить положение в различных отраслях. Объединённая компания намерена вывести на рынок передовые решения, нацеленные на поставщиков облачных услуг, корпоративные сети, IT-инфраструктуры, частные сети 5G/6G и пр.

26.02.2024 [23:34], Владимир Мироненко

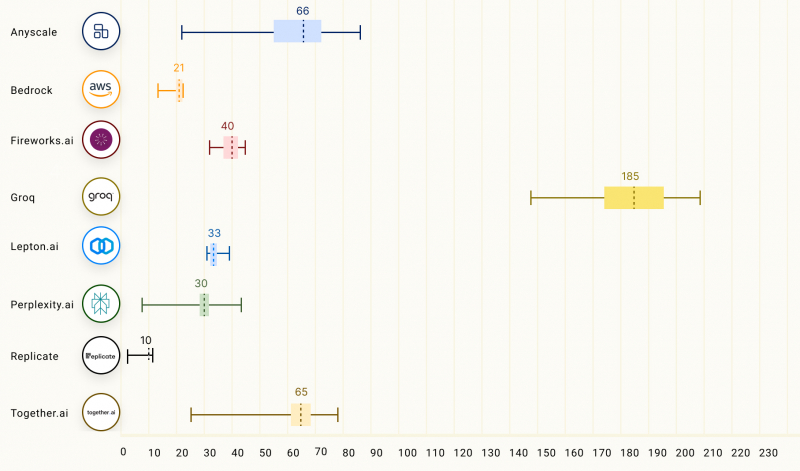

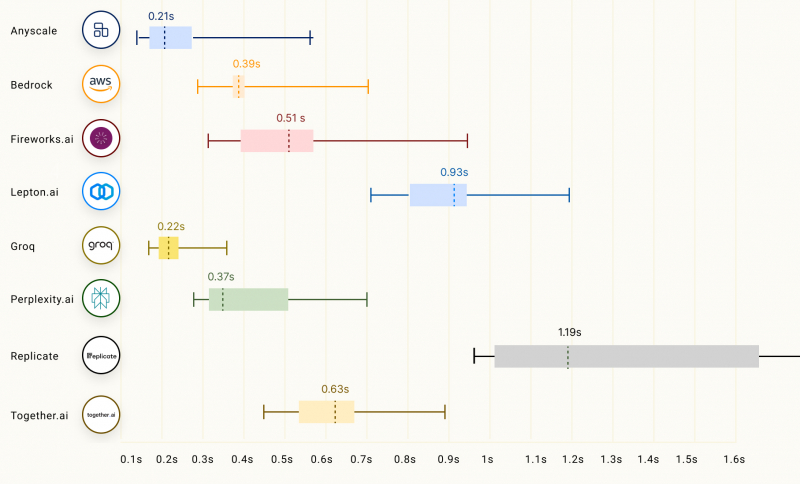

Groq LPU способен успешно конкурировать с ускорителями NVIDIA, AMD и IntelСтартап Groq сообщил о значительных достижениях в области инференса с использованием ускорителя LPU, разработанного для запуска больших языковых моделей (LLM), таких как GPT, Llama и Mistral. Groq LPU имеет один массивно-параллельный тензорный процессор TSP, который обеспечивает производительность до 750 TOPS INT8 и до 188 Тфлопс FP16. LPU Groq оснащён локальной SRAM объемом 230 Мбайт с пропускной способностью 80 Тбайт/с. Как сообщает компания, при запуске модели Mixtral 8x7B ускоритель LPU обеспечил скорость инференса 480 токенов в секунду, что является одним из ведущих показателей инференса в отрасли. В таких моделях, как Llama 2 70B с длиной контекста 4096 токенов, Groq может обеспечить скорость инференса 300 токенов/с, тогда как в меньшей модели Llama 2 7B с 2048 токенами контекста скорость инференса составляет 750 токенов/с.

Изображение: Groq Согласно рейтингу бенчмарка LLMPerf, LPU Groq превосходит результаты систем облачных провайдеров на базе традиционных ИИ-ускорителей в деле запуска LLM Llama в конфигурациях от 7 до 70 млрд параметров. Groq лидирует по скорости инференса и занимает второе место по показателю задержки. Для сравнения, бесплатный чат-бот ChatGPT на базе GPT-3.5 обеспечивает обработку около 40 токенов/с. Текущие LLM с открытым исходным кодом, такие как Mixtral 8x7B, могут превосходить GPT 3.5 в большинстве тестов, и теперь могут работать со скоростью почти 500 токенов/с. Опубликованные данные наглядно подтверждают, что предлагаемый Groq ускоритель LPU Groq значительно превосходит системы для инференса, предлагаемые NVIDIA, AMD и Intel, говорит компания. Groq не раскрывает имена своих заказчиков, но в настоящее время её ИИ-решения используются, например, Аргоннской национальной лабораторией Министерства энергетики США.

10.02.2024 [20:32], Алексей Степин

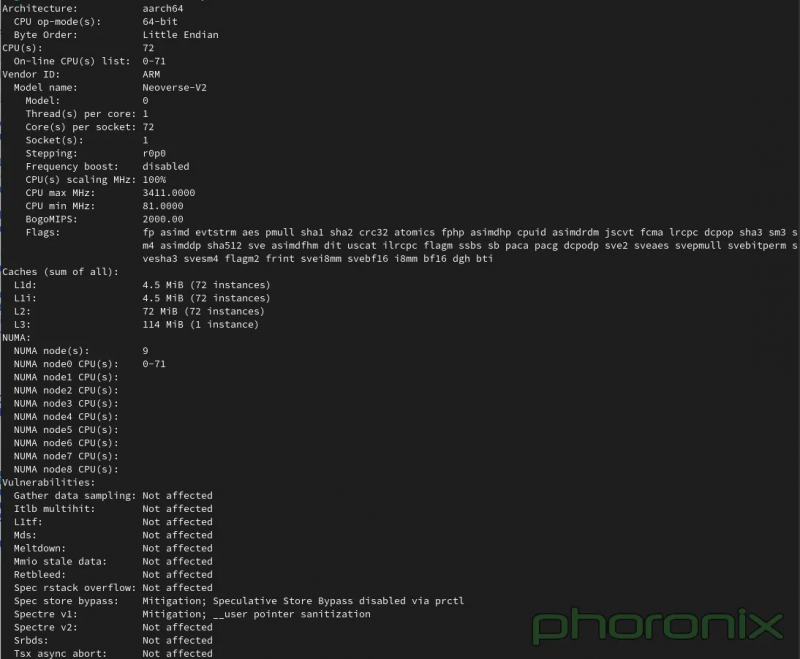

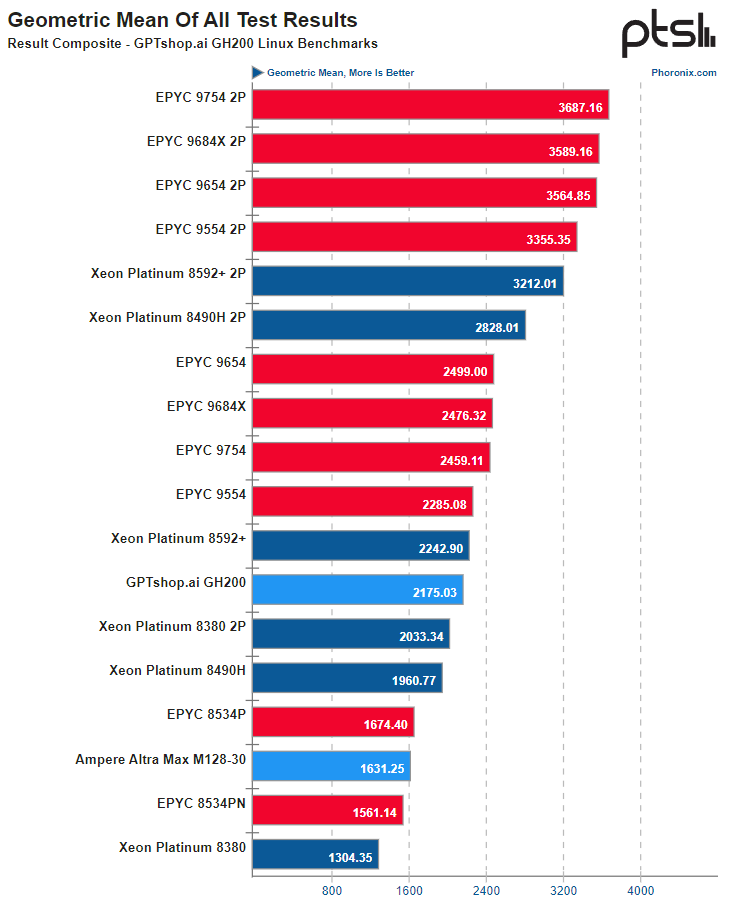

Опубликованы результаты тестирования рабочей станции на базе NVIDIA GH200Поскольку NVIDIA со своим проектом Grace явно метит в мир высокопроизводительных многоядерных процессоров, результаты тестирования новых чипов представляют существенный интерес для всех, кто интересуется решениями подобного класса. Ресурс Phoronix опубликовал результаты проведённого тестирования NVIDIA GH200, причём в составе рабочей станции. Это, напомним, гибридное решение, включающее в себя 72-ядерный Arm-процессор и ускоритель H100. Сборка также включает в себя 480 Гбайт памяти LPDDR5 для процессорной части, а ускоритель располагает собственной высокоскоростной памятью HBM3e объёмом 96 Гбайт или 144 Гбайт. Связаны CPU и GPU высокоскоростной шиной NVLink-C2C с пропускной способностью 900 Гбайт/с. С периферийными устройствами GH200 может общаться посредством четырёх комплексов PCIe 5.0 по 16 линий каждый, а со стороны ускорителя имеется 18 линий NVLink 4 (900 Гбайт/с совокупно). Систему на тестирование предоставил магазин GPTshop.ai, позиционирующий решения на базе GH200 в качестве «настольных суперкомпьютеров». Рабочая станция в башенном корпусе включает в себя модуль GH200 на плате QCT и два блока питания мощностью 2000 Ватт, твердотельные накопители и сетевые карты NVIDIA ConnectX/Bluefield — по желанию заказчика. Стоимость стартует с отметки €47,4 тыс. В качестве ОС может использоваться любой дистрибутив Linux с поддержкой AArch64. В Phoronix использовали Ubuntu 23.10 с ядром версии 6.5 и стоковым компилятором GCC 13. В сравнении приняли участия системы на базе Intel Xeon Emerald Rapids, AMD EPYC и Ampere Altra Max. В зависимости от сценария система на базе GH200 выступила с переменным успехом, но в среднем производительность процессорной части оказалась примерно на уровне 64-ядерных x86-процессоров — Xeon Platinum 8592+ или EPYC 9554. А 128-ядерный Altra Max M128-30 решение от NVIDIA уверенно обгоняет за счёт и более совершенной архитектуры, и более производительной подсистемы памяти.

Источник: Phoronix К сожалению, вопрос энергоэффективности пока остался непроясненным, поскольку система не предоставляет интерфейсов RAPL/PowerCap/HWMON в Linux и точных метрик потребления получить невозможно, доступно лишь примерное значение потребления системы в целом через IPMI. Потенциал у GH200, определённо, есть, хотя временами и сказывается недостаточная оптимизация программного обеспечения под архитектуру AArch64. Конкуренции двухпроцессорным решениям Intel или AMD GH200 не составляет, однако в распоряжении NVIDIA имеется и 144-ядерный вариант Grace Superchip. Тестирование такой системы уже значится в планах Phoronix.

10.02.2024 [14:50], Сергей Карасёв

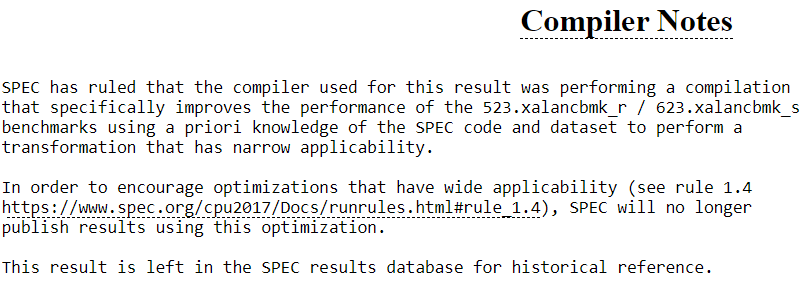

Более 2000 результатов Intel Xeon в бенчмарке SPEC CPU 2017 поставлены под сомнениеНекоммерческая организация Standard Performance Evaluation Corporation (SPEC), по сообщению ServeTheHome, по сути, аннулировала более 2000 результатов своего бенчмарка SPEC CPU 2017 для процессоров Intel. Причина заключается в специальной оптимизации для целочисленных вычислений, что теперь считается недопустимым. Установлено, что компилятор Intel oneAPI DPC++ фактически «обманывает» стандарты SPEC с помощью целевой оптимизации. Во многих результатах SPEC CPU 2017 в разделе «Примечания для компилятора» появилось уведомление о неточности данных.

Источник: SPEC «SPEC пришла к выводу, что компилятор, использованный для получения этого результата, выполнял компиляцию, которая искусственно завышает производительность тестов 523.xalancbmk_r/623.xalancbmk_s, используя предварительное знание кода и набора данных», — сказано в сообщении. Отмечается, что SPEC больше не будет публиковать результаты, полученные с использованием указанной оптимизации. В тесте производительности, на который нацелена эта оптимизация компилятора, результат может увеличиться более чем на 50 %. Таким образом, можно добиться повышения общего результата на несколько процентов. С другой стороны, оптимизация имеет узкую применимость: например, 623.xalancbmk_s — это только один из десяти тестов в наборе. Оптимизация влияет на платформу Intel oneAPI версий с 2022.0 по 2023.0, тогда как более новые модификации, в частности, 2023.2.3 проблеме не подвержены. Кроме того, оптимизация не распространяется на процессоры AMD.

13.07.2022 [16:13], Алексей Степин

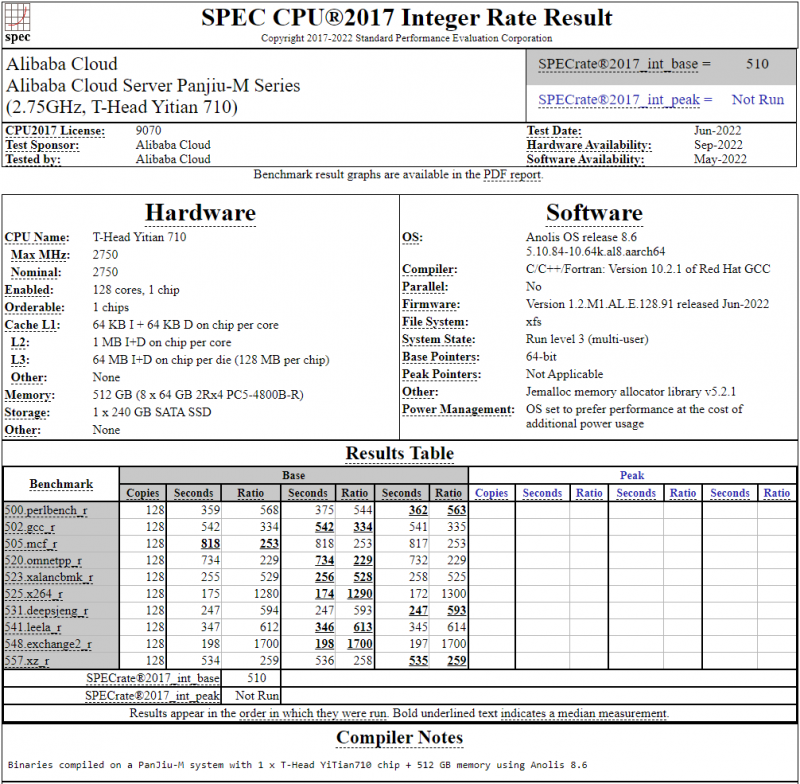

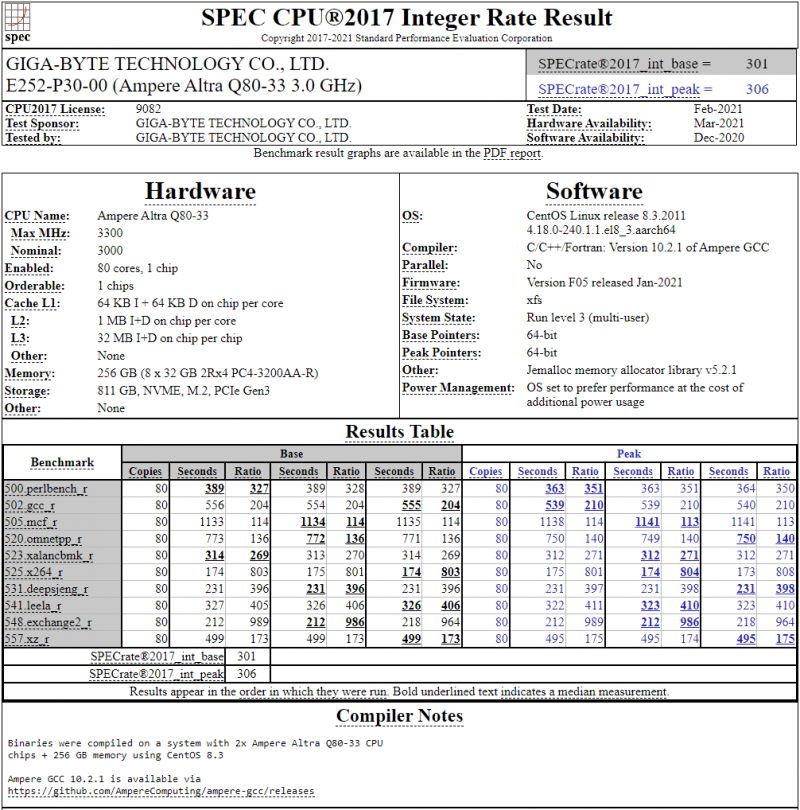

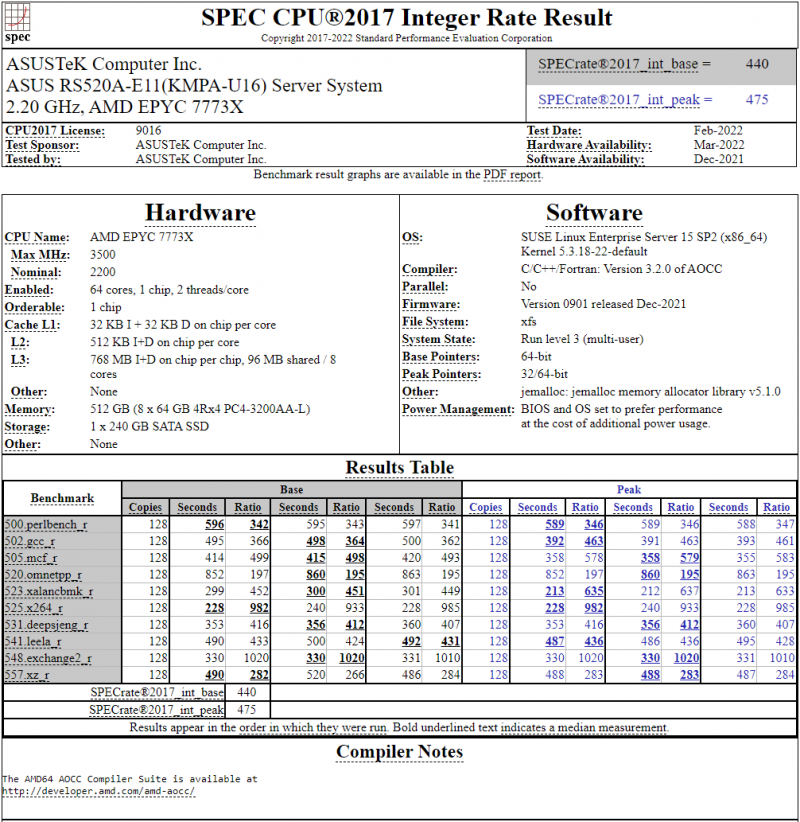

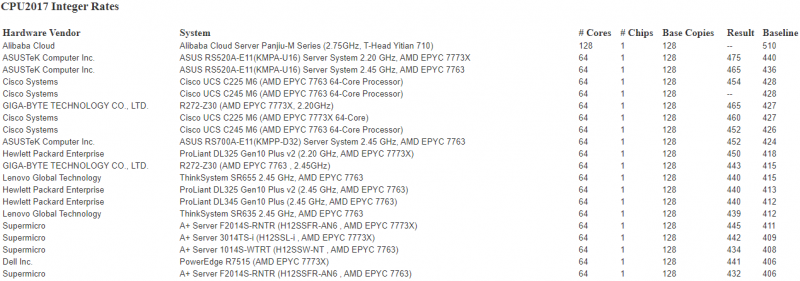

128-ядерный Arm-процессор Alibaba T-Head Yitian 710 показал отличные результаты в SPEC CPU2017Не секрет, что китайские гиганты, такие, как Huawei и Alibaba Cloud, разрабатывают собственные серверные процессоры на базе архитектуры Arm. Однако информации об этих чипах, как правило, не очень много и пользоваться общепринятыми на западе тестами и рейтингами разработчики не спешат, что, к слову, характерно и для китайских суперкомпьютеров. Alibaba Cloud представила чип Yitian 710 ещё осенью прошлого года. Этот процессор построен на базе архитектуры Armv9 и максимально может иметь 128 ядер с частотой до 3,2 ГГц. Однако результаты проверки чипа в популярном тесте SPEC CPU2017 были опубликованы только сейчас. Процессор тестировался в составе референс-сервера Panjiu. Применялась 128-ядерная версия с частотой 2,75 ГГц, 1 Мбайт кеша L2 на ядро и 64 Мбайт кеша L3 на кристалл (128 Мбайт на сборку). Последнее позволяет говорить о том, что Alibaba также использует в своих процессорах чиплетную компоновку. Результаты оказались существенно более высокими, нежели у Ampere Altra Q80-33; правда, стоит сделать скидку на то, что у Ampere использовалась 80-ядерная версия, а не более новая 128-ядерая Altra Max. Но в аутсайдерах оказался также и AMD EPYC 7773X (64 ядер/128 потоков, 2,2-3,5 ГГц, 768 Мбайт L3), показавший 440 очков против 510 у Yitian 710. Увеличенный объём кеша не слишком помог детищу «красных». Таким образом, процессор на базе архитектуры Armv9 занял первое место там, где традиционно господствовали решения с архитектурой x86 — достаточно взглянуть на Топ-20 в рейтинге CPU2017 Integer. Можно сказать, что 128-ядерный процессор не вполне корректно сравнивать с 64-ядерным с поддержкой SMT, однако если технологии и архитектура позволяют разместить вдвое больше полноценных ядер в сопоставимом по размеру с AMD EPYC корпусе, так ли это важно? К сожалению, пока речь идёт только о целочисленных вычислениях. По неизвестной причине, Alibaba Cloud не опубликовала результаты CPU2017 Floating Point, где сравнение вышло бы существенно интереснее. В любом случае, монополия AMD на первые места пошатнулась; что же касается Intel, то в классе однопроцессорных систем самым мощным вариантом является 36-ядерный Xeon Platinum 8351N, который заведомо проиграет 64-128 ядерным монстрам AMD, Ampere, а теперь уже и Alibaba Cloud. |

|