Материалы по тегу: s

|

29.10.2024 [14:42], Владимир Мироненко

ГК «Солар» приобрела 10 % долю в Luntry, специализирующейся на контейнерной безопасности

kubernetes

software

инвестиции

информационная безопасность

контейнеризация

россия

ртк-солар

сделано в россии

сделка

финансы

Группа компаний «Солар» сообщила о завершении сделки по покупке 10 % доли разработчика решений контейнерной безопасности Luntry (ООО «Клаудран»). Сумма сделки не раскрывается. Как предположил один из опрошенных «Ведомостями» экспертов, стоимость Luntry исходя из публичной отчётности может составлять до 500 млн руб., а сумма сделки — порядка 50 млн руб. В ГК «Солар» отметили, что это была первая сделка в рамках недавно созданного фонда Solar Ventures, который нацелен на стимулирование роста отрасли ИБ. Согласно пресс-релизу, сделка позволит «Солару» «усилить компетенции по защите микросервисных архитектур и контейнеризации и сформировать дополнительный пакет сервисов и услуг для защиты таких инфраструктур». Luntry предлагает решение для комплексной защиты на всём жизненном цикле контейнерных приложений и средств оркестрации на базе Kubernetes. В числе клиентов компании, работающей на российском рынке с 2021 года, крупнейшие банки, страховые и ИТ-компании, ретейлеры федерального значения. Luntry обладает командой квалифицированных специалистов с более чем десятилетним опытом и широкой партнёрская сетью. Решение Luntry cлужит источником данных для SOC о Kubernetes и работающих контейнерах, помогает в расследовании инцидентов, обнаружении первопричин инцидентов и сбоев, обеспечивает высокий уровень защищённости в рамках быстрого цикла разработки, эффективное взаимодействие между командами для принятия решений и осведомленность о всех запретах и ограничениях ИБ. В Luntry отметили, что сделка с ГК «Солар» не изменит общей стратегии развития, но при этом позволит совместными усилиями обеспечивать защиту критичных государственных информационных систем, использующих контейнеризацию. В свою очередь, в ГК «Солар» сообщили, что данная сделка выполнена в рамках реализации инвестиционной стратегии, рассчитанной на период до конца 2025 года. Ранее ГК «Солар» приобрела доли в компаниях Digital Security, «Secure-T», «Элвис-Плюс» и «НТБ» и создала СП Солар-ТЗИ. По оценке ГК «Солар», российский рынок безопасности контейнеров составил в 2023 году 1,1 млрд руб., в том числе за счёт функциональности, реализованной на платформах управления контейнерами. К 2027 году его объём может достичь 2,0–2,5 млрд руб. и Luntry может занять до 20 % рынка.

28.10.2024 [11:48], Сергей Карасёв

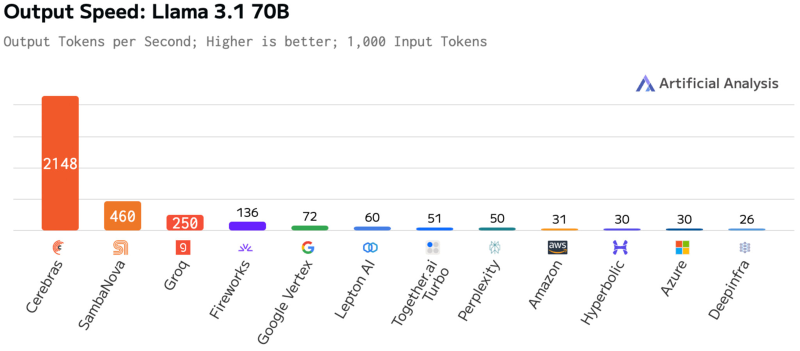

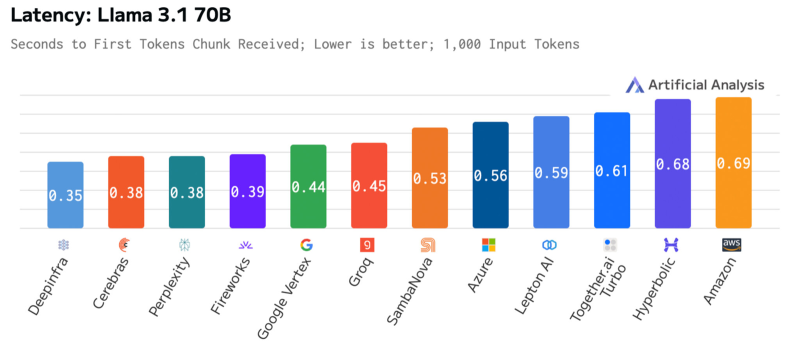

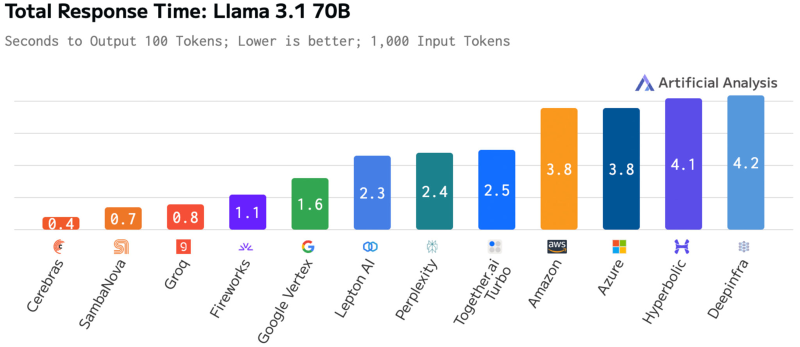

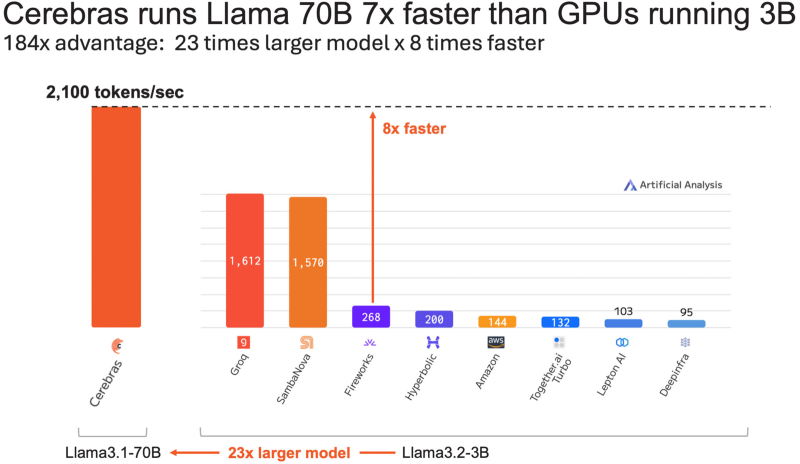

Cerebras втрое повысила производительность своей инференс-платформыАмериканский стартап Cerebras Systems, специализирующийся на разработке ИИ-ускорителей, объявил о самом масштабном обновлении ИИ-платформы Cerebras Inference с момента её запуска. Производительность системы поднялась примерно в три раза. Первый релиз Cerebras Inference состоялся в августе 2024 года. Основой облачной платформы являются ускорители собственной разработки WSE-3. На момент запуска быстродействие составляло до 1800 токенов в секунду на пользователя для ИИ-модели Llama3.1 8B и до 450 токенов в секунду для Llama3.1 70B (FP16). Разработчик заявлял, что Cerebras Inference — это «самая мощная в мире» ИИ-платформа для инференса. Однако в сентябре нынешнего года у Cerebras Inference появился серьёзный конкурент. Компания SambaNova Systems запустила облачный сервис SambaNova Cloud, также назвав его «самой быстрой в мире платформой для ИИ-инференса». Система на основе чипов собственной разработки SN40L демонстрирует быстродействие до 461 токена в секунду при использовании Llama 3.1 70B. В ответ Cerebras Systems усовершенствовала своё решение путём «многочисленных улучшений программного обеспечения, оборудования и алгоритмов». Утверждается, что обновлённая платформа Cerebras Inference при обслуживании Llama3.1 70B обеспечивает быстродействие 2148 токенов в секунду. Для сравнения: у AWS — лидера мирового облачного рынка — этот показатель равен 31 токену в секунду. А у Groq значение находится на уровне 250 токенов в секунду. Данные получены по результатам тестов Artificial Analysis. Время до получения первого токена имеет решающее значение для приложений реального времени. Cerebras находится на втором месте с показателем 0,38 с, уступая только Deep Infra (0,35 с). Вместе с тем Cerebras лидирует по общему времени отклика для 100 токенов на выходе с показателем 0,4 с против 0,7 с у SambaNova, которая находится на втором месте. В целом, как отмечается, платформа Cerebras Inference при работе с Llama3.1 70B опережает сервисы конкурентов на основе GPU, обрабатывающие модель Llama3.1 3B, которая в 23 раза меньше.

24.10.2024 [12:15], Сергей Карасёв

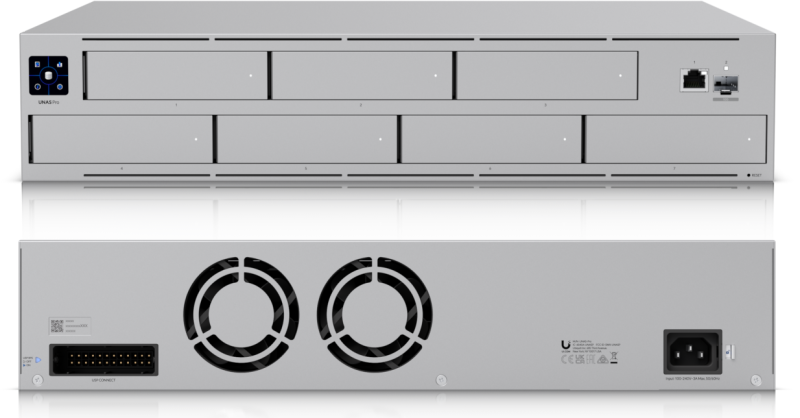

Ubiquiti представила сетевое хранилище UniFi UNAS Pro на семь LFF-накопителейКомпания Ubiquiti анонсировала сетевое хранилище UniFi UNAS Pro (UniFi UNAS Professional Rackmount NAS), ориентированное на корпоративных заказчиков. Устройство выполнено в форм-факторе 2U. В новинке применён неназванный процессор с четырьмя вычислительными ядрами Arm Cortex-A57, функционирующими на тактовой частоте 1,7 ГГц. Объём оперативной памяти DDR4 составляет 8 Гбайт. В оснащение также входят 32 Мбайт памяти SPI NOR и 8 Гбайт флеш-памяти. Во фронтальной части предусмотрены семь отсеков для HDD/SSD в форм-факторе LFF/SFF с интерфейсом SATA-3; допускается горячая замена. Имеется сенсорный дисплей с диагональю 1,3", который служит для управления и отображения информации о работе NAS. Предусмотрены по одному сетевому порту 1GbE RJ45 и 10GbE SFP+: разъёмы для подключения кабелей выведены на лицевую панель. Кроме того, есть контроллер Bluetooth 4.1. Габариты UniFi UNAS Pro составляют 442 × 325 × 87 мм, вес — 9,2 кг (без крепления для монтажа в стойку и накопителей). Диапазон рабочих температур простирается от -5 до +40 °C. В тыльной части расположены два вентилятора охлаждения. Максимальное энергопотребление заявлено на уровне 160 Вт, а энергобюджет для накопителей — 135 Вт. Устройство имеет встроенный блок питания (100–240 В AC или 11,5 В DC). Имеется порт резервного питания с поддержкой UniFi Power Backup, что делает хранилище устойчивым к перебоям в энергоснабжении. Приобрести новинку можно по ориентировочной цене $500.

22.10.2024 [12:49], Владимир Мироненко

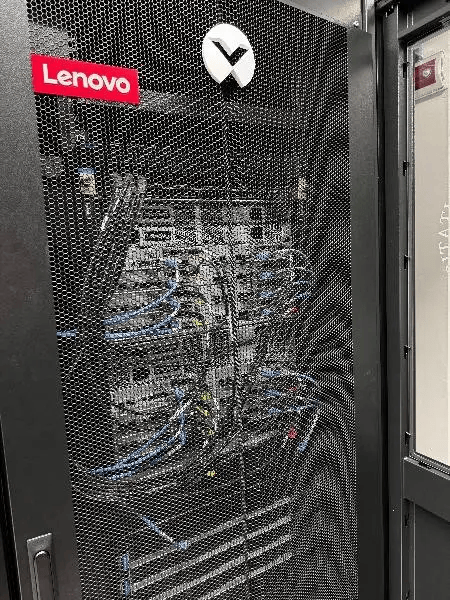

В Пизанском университете установили суперкомпьютер Lenovo на базе Intel Xeon MaxКомпания Lenovo сообщила об установке в дата-центре Пизанского университета (UniPi) нового кластера, благодаря чему HPC-платформа UniPi стала крупнейшей среди университетских суперкомпьютеров в Италии. Система размещена в ЦОД Green Data Center, который включает 104 стойки, где уже размещено 700 узлов (30 тыс. ядер, более ускорителей разных поколений).

Источник изображения: Lenovo Новая HPC-система Lenovo состоит из 16 узлов SD650 V3 с двумя процессорами Intel Xeon Max 9480 (Sapphire Rapids с HBM). Используемая СЖО Lenovo Neptune Direct Water-Cooling позволяет отводить до 98 % тепла, вырабатываемого суперкомпьютером, а также снизить энергопотребление на 40 %. Как утверждает компания, благодаря повышенной эффективности СЖО температура процессоров не достигает критических значений, что позволяет избежать снижения максимальной частоты ядер. Аналогичная платформа используется в суперкомпьютере Cassandra для Европейско-Средиземноморского центра по изменению климата (CMCC) в Лечче (Италия). Как отметил UniPi, решающим фактором при выборе решения Lenovo была адаптивность системы, поскольку проект был изначально разработан с учётом минимального воздействия на окружающую среду с целью создания экологичного ЦОД. Кроме того, стандартизированный подход Lenovo к созданию HPC-узлов упростила и ускорила её установку в ЦОД UniPi. Как ожидается, новый суперкомпьютер будет способен поддерживать рабочие нагрузки HPC и ИИ последнего поколения в течение следующих нескольких лет. UniPi имеет три ЦОД в Пизе. В 2016 году университет запустил проект строительства нового «Зелёного дата-центра» (Green Data Centre) для размещения HPC-нагрузок. По словам UniPi, новый университетский ЦОД является единственным объектом в стране, получившим классификацию «A» от AgID в начале этого года.

21.10.2024 [21:39], Руслан Авдеев

Японская Ubitus, обслуживающая Nintendo и Sega, тоже захотела запитать новый ИИ ЦОД от АЭСЯпонская технологическая компания Ubitus K.K., предоставляющая облачную инфраструктуру некоторым из ключевых участников игровой индустрии, включая Nintendo и Sega, намерена построить новый ЦОД рядом с действующей атомной электростанцией, передаёт Bloomberg со ссылкой на главу компании Уэсли Куо (Wesley Kuo). Сейчас Ubitus в партнёрстве с NTT управляет двумя дата-центрами в Токио и Осаке. Ранее в этом году компания получила инвестиции от NVIDIA. Участок для строительства ещё не выбран, но компания рассчитывает возвести объект ёмкостью до 50 МВт. Компания искала землю для нового ЦОД в районе Киото, Симане или на Кюсю. Третья площадка должна помочь расширить портфолио компании ИИ-сервисами, а поскольку для обучения моделей близость к конечному потребителю и низкий уровень задержки не так важны, на первый план выходят другие параметры. Новому ЦОД на начальном этапе потребуется всего 2–3 МВт, а до 50 МВт он может быть масштабирован позже. По словам Куо, пока не появится энергии лучше, эффективнее и дешевле, чем атомная, именно она останется наиболее конкурентоспособной по многим параметрам. И для ИИ она подходит как нельзя лучше. Однако доступ к атомной энергии в Японии жёстко ограничен после катастрофы на Фукусиме. В этом важное отличие от, например, США. Ранее в этом году AWS приобрела за $650 млн кампус ЦОД у Talen Energy рядом с АЭС Susquehanna в Пенсильвании. Потенциально АЭС способна обеспечить до 960 МВт. В мае AWS получила разрешение на возведении на участке площадью 650 га 15 зданий ЦОД. В сентябре Microsoft анонсировала перезапуск 837-МВт АЭС Three Mile Island для питания исключительно её ЦОД течение 20 лет. Также компания заключила несколько PPA с другими АЭС. Oracle намерена построить 1-ГВт кампус ЦОД с питанием от трёх малых модульных реакторов (SMR), а на прошлой неделе Google анонсировала сделку с Kairos Power, в рамках которой она получит SMR мощностью 500 МВт.

21.10.2024 [13:21], Сергей Карасёв

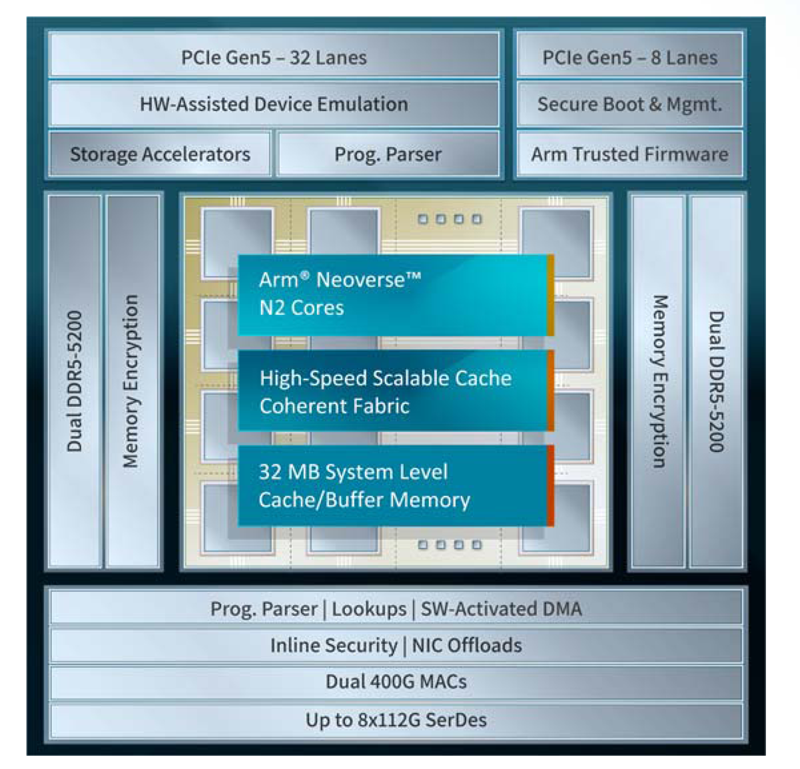

Xsight Labs представила 400GbE DPU серии E1Компания Xsight Labs анонсировала, как утверждается, самую производительную на рынке программно-определяемую «систему на чипе» (SoC), предназначенную для создания DPU с поддержкой RoCEv2 и UET (Ultra Ethernet Transport). Изделие под названием E1 станет доступно заказчикам для тестирования во II квартале 2025 года. Чип будет предлагаться в модификациях E1-32 и E1-64. Первая содержит 32 ядра Arm Neoverse N2 v9.0-A, имеет 16 Мбайт кеша и использует конфигурацию памяти 2 × DDR5-5200. Показатель TDP равен 65 Вт. У второго варианта количество ядер составляет 64, размер конфигурируемого кеша/буфера — 32 Мбайт. Конфигурация памяти — 4 × DDR5-5200, величина TDP — 90 Вт. В обоих случаях используется полное шифрование памяти на лету (AES-XTS). Новинка использует до восьми блоков SerDes, обеспечивая сетевую пропускную способность до 800 Гбит/с. Возможны следующие конфигурации портов: 2 × 400GbE, 4 × 200GbE и 8 × 100/50/25/10GbE. Заявлена производительность на уровне 200 Mpps и 20 млн подключений в секунду. Также есть пара 1GbE-портов для внешнего управления. Доступны программируемые DMA-движки (до 3 Тбит/с) и разгрузка типовых операций, включая шифрование AES-GCM (для IPSec) и AES-XTS (для СХД) на лету.

Источник изображения: Xsight Labs Есть восемь двухрежимных контроллеров и 40 (32+8) линий PCIe 5.0, а также поддержка P2P-коммутации PCIe. Упомянуты поддержка до четырёх хостов/устройств, SR-IOV (64K PF/VF), а также программная эмуляция и пространства MMIO. Реализована поддержка интерфейсов I2C/I3C/SMBus, SPI/QSPI, SMI, UART, GPIO, 1588 RTC, JTAG. Говорится о высоком уровне обеспечения безопасности: возможно создание изолированных и защищённых сред, которые аутентифицируют каждого клиента. Поддерживается функция безопасной загрузки UEFI Secure Boot with Arm Trusted Firmware (TF-A). Заявлена возможность работы «из коробки» в Debian, Ubuntu, SONiC и Lightbits Labs LightOS, а также совместимость с Netdev, VirtIO, XNA/XDP и DPDK/SPDK. В частности, возможна эмуляция NVMe-, RDMA- и сетевых устройств. Изделие E1 производится по 5-нм технологии TSMC. Оно, как утверждает Xsight Labs, обеспечивает беспрецедентную энергоэффективность и вычислительные возможности, устанавливая новый стандарт производительности для DPU SoC. Новинка ориентирована на облачные платформы и периферийные дата-центры, поддерживающие интенсивные ИИ-нагрузки. DPU позволяет создавать SDN/SDS-решения, брандмауэры, NVMe-oF СХД, вычислительные хранилища, CDN-платформы, балансировщики и т.п.

17.10.2024 [15:56], Руслан Авдеев

AWS запитает свои ЦОД от модульных реакторов X-energyПо данным пресс-службы Amazon (AWS), компания готовится к инвестициям в атомную энергетику. Она анонсировала три новых энергетических проекта, предполагающих постройку нескольких малых модульных реакторов (SMR). Компания уже заявила о переходе на 100 % возобновляемую электроэнергию — на семь лет раньше, чем планировалось. Атомные проекты — часть плана по переходу на полностью безуглеродную энергетику. AWS объявила о подписании как минимум трёх соглашений для поддержки развития атомных проектов, включая помощь в строительстве новых SMR. Гиперскейлер утверждает, что такие решения помогут удовлетворить спрос клиентов и добиться нулевого выброса CO2 в ходе всех операций к 2040 году. Кроме того, инвестиции помогут и в разработке новых атомных технологий, которые обеспечат генерацию энергии в ближайшие десятилетия. AWS делает ставку на решения компании X-energy. IT-гигант является одним из ключевых инвесторов раунда финансирования серии C, в ходе которого планируется привлечь $500 млн. Благодаря поддержке AWS консорциумом Energy Northwest (шт. Вашингтон) получит четыре малых модульных реактора X-energy Xe-100 мощностью 80 МВт каждый, которые используют топливо TRISO-X, разработанное совместно с Министерством энергетики США (DoE). В дальнейшем мощность планируется довести до 960 МВт, но не факт, что вся она достанется AWS. Всего к 2039 году X-energy рассчитывает построить 5 ГВт мощностей.

Источник изображения: Amazon В Вирджинии AWS подписала соглашение с Dominion Energy. Вместе компании изучат возможность строительства SMR рядом с принадлежащей Dominion атомной станцией North Anna, которые добавят не менее 300 МВт мощностей. Ранее AWS купила за $650 млн кампус Cumulus Data, запитанный напрямую от действующей АЭС Susquehanna. В рамках сделки будет обеспечен доступ к 480–960 МВт для питания 15 дата-центров. Инвестиции в атомные проекты, помимо сохранения прежних реакторов и создания новых, будут способствовать экономическому развитию местных сообществ, говорит AWS.

Источник изображения: Amazon AWS не единственный гиперскейлер, желающий использовать атомную энергию. Microsoft наняла специалиста для контроля разработки SMR для своих ЦОД, до этого было подписано PPA с поддерживаемым Сэмом Альтманом (Sam Altman) энергетическим стартапом Helion. Дополнительно компания заключила PPA на 20 лет с Constellation Energy, которое позволит «оживить» реактор АЭС Three Mile Island, заглушенный в 2019 году из-за нехватки финансирования. В сентябре Oracle анонсировала получение разрешений на строительство трёх SMR для питания ЦОД ёмкостью более 1 ГВт. Собственные амбиции в этой сфере имеются и у Google, которая объявила о намерении покупать энергию от SMR Kairos Power. Впрочем, рабочих реакторов у Kairos пока нет, а коммерческие модели, вероятно, не появятся до 2035 года.

17.10.2024 [14:36], Руслан Авдеев

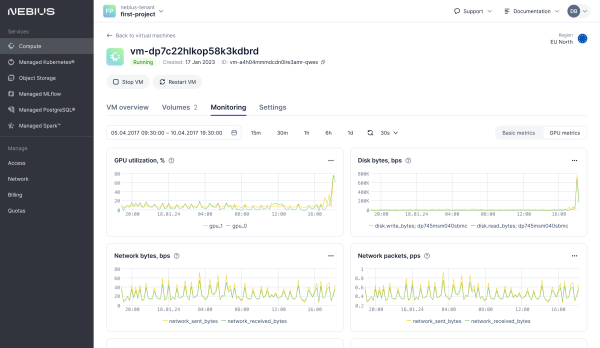

Nebius, бывшая Yandex, представила облачную ИИ-платформу с ускорителями NVIDIA H100 и H200ИИ-компания Nebius, сформированная из бывшей Yandex N.V., представила облачную платформу с современными ускорителями NVIDIA. Как уточняет Datacenter Dynamics, речь идёт о моделях NVIDIA H100 и H200, а также L40S. В скором будущем компания рассчитывает добавить и новейшие суперускорители GB200 NVL72. Облачное хранилище обеспечивает агрегированную скорость чтения до 100 Гбайт/с и 1 млн IOPS. Платформа также предлагает управляемые Apache Spark и MLFlow, а ВМ по умолчанию включают ИИ-библиотеки и драйверы. По словам компании, она прислушалась к запросам клиентов, нуждавшихся в самостоятельном доступе и инфраструктуре, отлично от просто «базовой». Речь идёт о крупномасштабных кластерах с InfiniBand-подключением на базе эталонной архитектуры NVIDIA, но с кастомизированным оборудованием и проприетарной программной облачной платформой. После введения антироссийских санкций Nebius дистанцировалась от «Яндекса», основная часть активов которого была продана группе российских инвесторов. У Nebius остался дата-центр в Финляндии, ёмкость которого она намерена утроить в обозримом будущем. Там разместятся более 60 тыс. ускорителей. В августе сообщалось, что компания увеличила облачную выручку на 60 % год к году во II квартале.

16.10.2024 [18:44], Руслан Авдеев

У семи CEO Atos без глазу: тонущий французский IT-гигант назначил очередного гендиректораИспытывающая немалые проблемы с бизнесом компания Atos привлекла к руководству нового генерального директора. Datacenter Dynamics напоминает, что речь идёт о назначении уже седьмого главы бизнеса за последние три года. На пост Жана-Пьера Мюстье (Jean-Pierre Mustier) придёт новый CEO Филипп Салль (Philippe Salle), который приступит к работе 1 февраля 2025 года. А прямо сейчас он займёт пост президента компании. Мюстье стал CEO Atos в июле 2024 года, но к компании он присоединился ещё в прошлом октябре. У Салля богатый опыт работы в сфере IT-консалтинга, в своё время бизнесмен был главой Altran Group (позже ставшей Capgemini). Его предшественник Мюстье стал генеральным директором Atos после Пола Салеха (Paul Saleh), работавшего в должности с января 2024 года. Тот, в свою очередь, сменил Ива Бернера (Yves Bernaert), проработавшего CEO чуть более года. Наконец, до него директорами были Нурдин Бихман (Nourdine Bihmane), Филипп Олива (Philippe Oliva) и Диана Гальб (Diane Galbe). Последняя вступила в должность, когда от руководства отстранили Родольфа Бельмера (Rodolphe Belmer), не сумевшего продержаться в должности и года. Примечательно, что в первые 20 лет деятельности у Atos было всего четыре генеральных директора. Мюстье сообщил, что решение о выборе нового CEO принято с учётом его «обширного послужного списка». Правда, не последнюю роль, вероятно, сыграл и тот факт, что Салль сам намерен инвестировать в Atos €9 млн ($9,8 млн). Предлагающая локальную и облачную инфраструктуру, услуги консалитинга и IT-сервисы компания Atos годами стремилась справиться с долгами, но в итоге её акции значительно упали в цене на фоне массы иных финансовых проблем. Сейчас в Atos работают над планом реструктуризации, который, как ожидается, позволит контролировать задолженность бизнеса и решит вопрос с многолетней финансовой неопределённостью. Компания предложила и утвердила с кредиторами ряд мер по выходу из кризиса — облигации и долг в объёме €2,9 млрд ($3,1 млрд) будут конвертированы в капитал. Также компании дадут в долг ещё €1,68 млрд ($1,81 млрд) и вольют €233 млн ($250,7 млн) новых инвестиций в капитал. Ранее французские власти намеревались выкупить часть бизнеса за €1 млрд ($1,09 млрд), чтобы сохранить критически важные для страны технологии, но теперь сделка, похоже, не состоится. В сентябре Atos опубликовала отчёт, в котором сообщалось о сокращении прогнозируемой выручки в ближайшие три года из-за не лучших результатов работы в I половине 2024 года.

16.10.2024 [14:20], Руслан Авдеев

Blackstone потратит €15 млрд на ЦОД в испанском АрагонеКомпания Blackstone готова построить в муниципалитете Калаторао в Арагоне (Испания) кампус ЦОД ёмкостью 300 МВт. По данным Datacenter Dynamics, объектом будет управлять подконтрольный Blackstone оператор дата-центров QTS. Как заявляют представители властей Арагона, регион находится на пути к тому, чтобы стать Северной Вирджинией Южной Европы — именно в этом штате США сконцентрированы мощности ЦОД не только страны, но даже мира. Blackstone намерена инвестировать €7,5 млрд ($8,2 млрд) в строительство в рамках инициативы Project Rodes — проект будет реализован на участке площадью 224 га. Сначала застроят около половины участка, позже на освоение второй половины потратят ещё €7,5 млрд. Blackstone приобрела QTS в 2021 году за $10 млрд, в июле 2023 года компания взяла на себя обязательство потратить дополнительные $8 млрд на ЦОД в связи с бумом ИИ, поскольку события такого масштаба случаются «раз в поколение». При этом компания действует и на других европейских рынках. Так, Blackstone вложит £10 млрд в создание крупнейшего ЦОД в Европе ЦОД в Великобритании.

Источник изображения: Des Mc Carthy/unsplash.com QTS активно ведёт бизнес в США, но также управляет европейским кампусом в Гронингене (Нидерланды). Ранее Blackstone и QTS также объявили о намерении построить кампус на 1,1 ГВт в Нортумберленде (Великобритания). Первые данные о том, что Blackstone и подконтрольная ей QTS оценивают целесообразность расширение парка дата-центров в Испании, появились ещё в 2022 году. В Арагоне активно строятся новые кампусы ЦОД. В частности, Microsoft вложит в дата-центры в регионе около €8,6 млрд, AWS — €15,7 млрд, а Oracle — €0,9 млрд. |

|