Материалы по тегу: intel

|

23.01.2026 [23:54], Владимир Мироненко

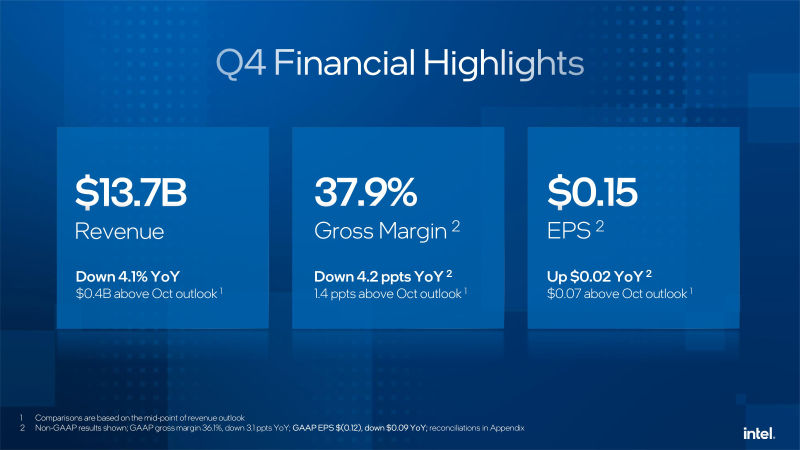

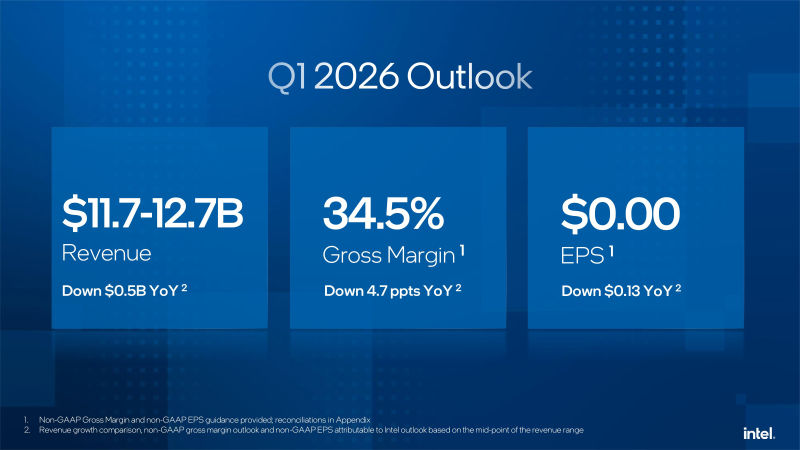

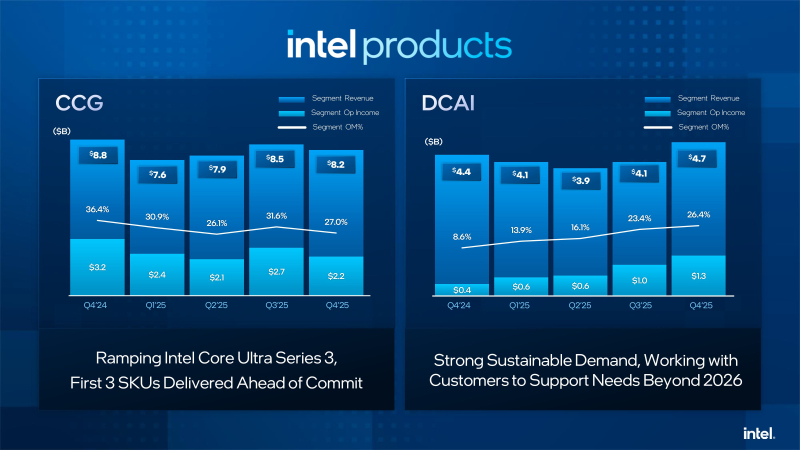

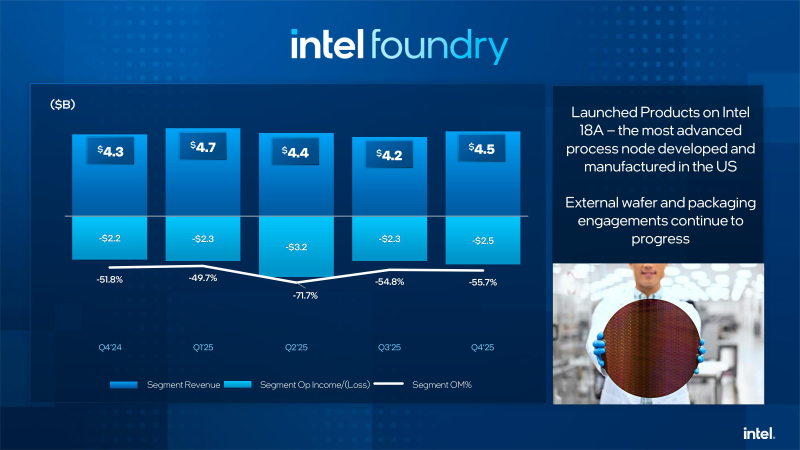

Слабый прогноз из-за дефицита компонентов уронил акции Intel, которая решила сосредоточиться на серверных продуктахКомпания Intel объявила результаты за IV квартал и 2025 финансовый год, завершившийся 27 декабря 2025 года. Хотя результаты за квартал превзошли ожидания Уолл-стрит, из-за слабого прогноза на текущий квартал, а также предупреждения о дефиците поставок, акции компании упали в пятницу на 15 %, сообщил ресурс CNBC. Впрочем, несмотря на падение акций после квартального отчёта, компания по-прежнему демонстрирует уверенный старт в 2026 году и с начала года её ценные бумаги выросли в цене на 47 %. Выручка Intel за IV квартал составила $13,7 млрд, что на 4 % меньше год к году, но выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $13,4 млрд. Скорректированная прибыль на акцию (non-GAAP) равняется 15¢ при прогнозе аналитиков от LSEG в 8¢. Компания сообщила о чистом убытке (GAAP) за отчётный квартал в размере $591 млн, или 12¢ на разводнённую акцию. Годом ранее у неё тоже был чистый убыток, но меньше — $126 млн, или 3¢ на акцию. Intel объявила, что в текущем квартале рассчитывает на безубыточность по скорректированной прибыли на акцию и выручку в диапазоне от $11,7 до $12,7 млрд. Оба показателя оказались ниже прогноза аналитиков, опрошенных LSEG, ожидающих прибыль в размере 5¢ на акцию при выручке в $12,51 млрд. Как сообщает ресурс SiliconANGLE, финансовый директор Intel Дэвид Зинснер (David Zinsner) объяснил снижение прогноза проблемами с поставками компонентов, которых не хватает для удовлетворения сезонного спроса. По его словам, компания пытается решить эту проблему, повышая эффективность производства или выход годной продукции, чтобы увеличить поставки. «Наша производительность соответствует нашим внутренним планам», — сказал генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan), отметив, что она по-прежнему ниже того уровня, которого ему хотелось бы достичь. Выручка подразделения Datacenter and AI Group (DCAI), которое специализируется на продуктах для ЦОД и ИИ, выросла год к году на 9 % до $4,74 млрд. Операционная прибыль подразделения составила $1,25 млрд. Выручка потребительской группы Client Computing Group (CCG) упала на 7 % до $8,19 млрд. Подразделение Intel Foundry, которое занимается производством чипов, получило выручку в размере $4,51 млрд, что выше год к году на 4 %. При этом его операционный убыток составил $2,51 млрд. Годом ранее подразделение тоже сработало с убытком, составившим $2,25 млрд при выручке $4,34 млрд. Как отметил The Register, по сравнению с катастрофой, которой стал для Intel 2024 финансовый год, прошедший год был значительно лучше. В 2025 году компания понесла убытки всего в $267 млн при выручке в $52,9 млрд. Это значительно лучше рекордных убытков в $18,8 млрд годом ранее. В ходе общения с аналитиками Зинснер признал, что компания оказалась в затруднительном положении после того, как неправильно оценила спрос на свою продукцию для ЦОД, что привело к дефициту мощностей в течение квартала. Дело в том, что полгода назад почти все гипескейлеры говорили о планах заказать меньшее количество чипов с большим количеством ядер, но затем их позиция изменились, и спрос на продукты Intel Xeon значительно вырос в III и IV кварталах. Платформа Intel Xeon 6 широко используется в ИИ-системах, таких как NVIDIA DGX B200 и B300, а также во многих системах с AMD Instinct. Чтобы удовлетворить этот спрос, компания «перенаправляет как можно больше ресурсов в ЦОД», отметил Зинснер. При этом он заверил, что компания не откажется от своего клиентского бизнеса «полностью» в погоне за доходами от ИИ в ЦОД. «В клиентском сегменте мы фокусируемся на среднем и высоком сегментах, а на низком — не так сильно. В той мере, в какой у нас есть избыточные мощности, мы направляем их производство для ЦОД», — сказал финансовый директор. Ранее в этом месяце Тан заявил, что технология производства 18A, конкурирующая с 2-нм техпроцессом TSMC, «превзошла ожидания» в 2025 году. Он указал в годовом отчёте, что Intel «активно работает» над увеличением поставок продукции, изготовленной по техпроцессу 18A, для удовлетворения «высокого спроса со стороны клиентов». Зинснер сообщил ресурсу CNBC, что клиенты для следующего техпроцесса 14A от Intel появятся во II половине года. При этом компания не собирается публично об этом объявлять. «Как только мы их получим, нам нужно будет вкладывать значительные средства в развитие 14A, и тогда вы поймёте, что происходит», — сказал он. Вместе с тем аналитики RBC Capital Markets предупредили, что «значительный вклад в выручку» от клиентов продуктов согласно техпроцессу 14A может появиться не раньше конца 2028 года.

23.01.2026 [13:07], Руслан Авдеев

Застопорившаяся сделка с Intel заставила SambaNova искать $500 млн дополнительных инвестицийПоставщик ИИ-ускорителей SmabaNova рассчитывает привлечь до $500 млн в ходе раунда финансирования после того, как приостановились переговоры с Intel. Последняя рассматривала возможность покупки SambaNova, пишет Bloomberg. Ранее появилась информация, что компании вели расширенные дискуссии о возможном поглощении SambaNova, включая долг, компанией Intel за $1,6 млрд, но окончательное решение так и не было принято. Переговоры пока не принесли результатов, и поставщик ИИ-решений теперь ищет инвестиции из других источников — технологических компаний и производителей полупроводников. При этом глава Intel Лип-Бу Тан (Lip-Bu Tan) одновременно является председателем SambaNova. Первые слухи о том, что SambaNova рассматривает возможность продажи, появились в октябре 2025 года. По данным источников The Information, компания наняла инвестиционную структуру для того, чтобы та курировала потенциальную покупку. В 2021 году SambaNova оценивалась в $5 млрд, а всего с момента основания привлекла более $1,1 млрд от инвесторов, включая GV, Intel Capital, BlackRock и SoftBank Vision Fund. Однако BlackRock, владеющая акциями SambaNova, ранее снизила оценку до $2,4 млрд. Теперь же, по-видимому, даже оценка в $1,6 млрд не является корректной. Основанная в 2017 году SambaNova изначально ориентировалась на обучение ИИ-моделей, но затем переключилась на услуги облачного и локального инференса с использованием собственных ИИ-чипов SN40L, представленных в сентябре 2023 года.

22.01.2026 [12:45], Сергей Карасёв

Индустриальный мини-компьютер OnLogic CL260 получил чип Intel Twin Lake и 8 Гбайт ОЗУКомпания OnLogic пополнила ассортимент индустриальных компьютеров моделью CL260 в небольшом форм-факторе. Устройство предназначено для применения в составе платформ автоматизации, инфраструктур интернета вещей, в системах периферийных вычислений и пр. В основу положен процессор Intel поколения Twin Lake. В зависимости от модификации задействован чип Intel Processor N150 (4C/4T; 0,8/3,6 ГГц; TDP 6 Вт) или Intel Processor N250 (4C/4T; 1,3/3,8 ГГц; TDP 6 Вт). В состав этих изделий входит ускоритель Intel UHD Graphics с частотой соответственно 1,0 и 1,25 ГГц. Объём оперативной памяти LPDDR5-4800 в обоих случаях составляет 8 Гбайт. Новинка может быть укомплектована SSD типоразмера M.2 2280 с интерфейсом PCIe 3.0 x2 или SATA-3 вместимостью от 128 Гбайт до 2 Тбайт.

Источник изображения: OnLogic Устройство несёт на борту двухпортовый сетевой контроллер 1GbE на базе Realtek RT8111G-CG. Дополнительно может быть установлен адаптер Wi-Fi 6E и Bluetooth в виде модуля M.2 Key-E (PCIe Gen3 x1, USB 2.0). Допускается вывод изображения одновременно на два монитора через интерфейсы DisplayPort 1.4 (Type-C). OnLogic CL260 располагает четырьмя портами USB 3.0 Type-A, двумя гнёздами RJ45 для сетевых кабелей. Может быть также задействован последовательный порт RS-232/422/485 (через 10-контактный коннектор). За безопасность отвечает модуль TPM 2.0. Для подачи питания (12–24 В) служит трёхконтактный разъём. Мини-компьютер имеет размеры 115 × 82 × 30 мм и весит примерно 400 г. Диапазон рабочих температур простирается от 0 до +50 °C. Допускается монтаж на стену и DIN-рейку, а также на монитор посредством крепления VESA. Заявлена совместимость с Windows 11 IoT Enterprise LTSC 2024, Windows 11 Professional, Ubuntu 24.04 Desktop и Ubuntu 24.04 Server. Цена начинается примерно с $640.

21.01.2026 [13:03], Сергей Карасёв

Dell представила All-Flash СХД PowerStore 5200Q для QLC SSDКомпания Dell расширила ассортимент СХД серии PowerStore, анонсировав модель 5200Q типа All-Flash. Новинка позволяет сформировать интеллектуальное хранилище, обеспечивающее ускорение работы с блочными, файловыми и виртуальными томами. Устройство выполнено на аппаратной платформе Intel. Применены два контроллера, функционирующие в режиме «активный — активный». В общей сложности задействованы четыре неназванных процессора Xeon с 96 вычислительными ядрами, работающими на частоте 2,2 ГГц. Объём оперативной памяти составляет 1152 Гбайт. СХД имеет типоразмер 2U. Во фронтальной части расположены 25 отсеков для SFF-накопителей NVMe. Могут применяться SSD на основе чипов памяти QLC вместимостью 15,36 и 30,72 Тбайт. Питание обеспечивают два блока с резервированием. В общей сложности могут быть использованы до 24 сетевых Front-end-портов в следующей конфигурации: 16 × FC16/32, 24 × 10GbE, 24 × 10/25GbE или 8 × 100GbE. Секция Back-end включает порты 100GbE QSFP. Кроме того, предусмотрен выделенный сетевой порт управления 1GbE. Говорится о поддержке протоколов FC, NVMe/FC, iSCSI, NVMe/TCP, NFSv3/4/4.1/4.2; CIFS SMB 2/3.0/3.02/3.1.1, FTP и SFTP. В связке с СХД могут функционировать до трёх модулей расширения формата 2U, рассчитанных на 24 накопителя SFF (NVMe) каждый. Таким образом, в общей сложности система с учётом устройств расширения может содержать до 93 накопителей SFF и четыре изделия NVRAM. В составе кластера количество SSD может достигать 372 штук при суммарной вместимости 23,6 Пбайт с учётом компрессии. В качестве программной платформы применяется PowerStore OS.

20.01.2026 [23:54], Владимир Мироненко

Intel переманила «крёстного отца» экзафлопсного суперкомпьютера FrontierIntel провела кадровые перестановки в руководящем составе, наняв двух специалистов «со стороны» в рамках запланированного развития на рынке ИИ-инфраструктуры, сообщил ресурс CRN со ссылкой на служебную записку компании. Согласно документу, Николя Дюбе (Nicolas Dubé) ранее занимавший пост старшего вице-президента в Arm, был назначен на должность главы подразделения систем для ЦОД, а Эрик Демерс (Eric Demers), бывший топ-менджер Qualcomm, на должность главы подразделения разработки GPU. О назначениях объявил вице-президент и генеральный директор группы ЦОД Intel Кеворк Кечичян (Kevork Kechichian), которому будут непосредственно подчиняться оба руководителя. После реорганизации ему также будет подчиняться Жан-Дидье Аллегруччи (Jean-Didier Allegrucci), вице-президент по разработке SoC для ИИ. Генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan) назвал способность конкурировать с чипами NVIDIA и других участников рынка одним из своих главных приоритетов в рамках плана возвращения компании на рынок после того, как она столкнулась с трудностями в привлечении клиентов к своим предыдущим ускорителям. «Объединение усилий в области Xeon, сетевых технологий и телекоммуникаций, а теперь и ИИ, укрепляет позиции x86, что является одним из ключевых преимуществ по мере того, как ИИ смещается в сторону инференса и агентных систем», — написал Кечичян в служебной записке. Эта реорганизация представляет собой отмену решения Тана, который в апреле прошлого года вывел группу разработчиков ИИ-ускорителей из подразделения, ранее называвшегося группой ЦОД и ИИ. Этот шаг снова меняет организационную структуру Intel: Кечичян принимает на себя обязанности по разработке ИИ-ускорителей от Тана. Генеральный директор возглавил её в ноябре прошлого года после того, как предыдущий руководитель команды, Сачин Катти (Sachin Katti), внезапно покинул компанию в связи с переходом в OpenAI. По поводу решения Тана вернуть команду разработчиков ИИ-ускорителей в группу ЦОД, Кечичян пояснил: «ИИ и современный ЦОД фундаментально связаны». В качестве руководителя подразделения Intel по системам и решениям для ЦОД Дюбе будет «определять техническую архитектуру и стратегию [группы ЦОД] в направлении создания комплексных систем и решений, от микросхем до приложений, обеспечивая интегрированные решения в области вычислительных ресурсов, хранения данных и сетей», — сообщил Кечичян в служебной записке. Дюбе также возьмёт на себя руководство командой Intel по интегрированным решениям в области кремниевой фотоники, которая ранее подчинялась исполнительному директору компании Джеффу Маквейгу (Jeff McVeigh). При этом Дюбе будет использовать свой опыт системной инженерии в Arm, а также опыт 13 лет работы в HPE, где «он руководил проектированием, реализацией и внедрением» программы компании по созданию первого в США экзафлопсного суперкомпьютера Frontier. По поводу обязанностей Демерса, Кечичян заявил, что топ-менджер, ранее возглавлявший разработку GPU в Qualcomm, будет руководить разработкой IP-блоков для GPU и курировать решения Intel для ЦОД на базе GPU. Круг его обязанностей будет включать в себя «координацию работы по архитектуре, компиляторам и драйверам для успешной разработки интегрированного аппаратного и ПО», добавил он. Демерс «будет тесно сотрудничать» с Лизой Пирс (Lisa Pearce), корпоративным вице-президентом и генеральным директором группы разработки ПО компании, а также с командой разработчиков ПО для GPU, чтобы «оптимизировать работу команд и рабочий процесс для достижения максимального эффекта», указал Кечичян в служебной записке.

20.01.2026 [12:12], Сергей Карасёв

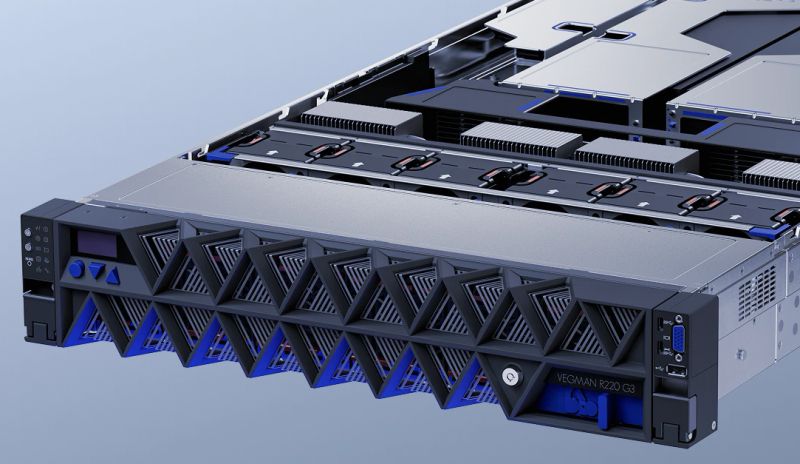

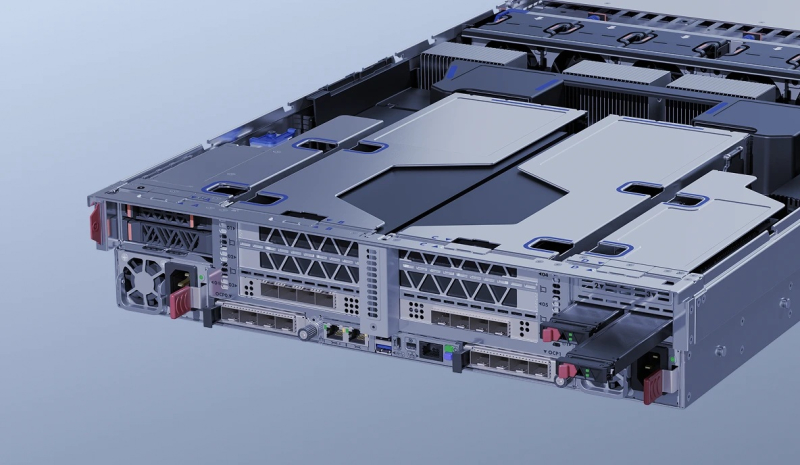

YADRO выпустила отечественные серверы Vegman R220 G3 на базе Intel Xeon Emerald RapidsКомпания YADRO, входящая в «ИКС Холдинг», объявила о доступности универсальных серверов Vegman R220 G3 на аппаратной платформе Intel. Устройства подходят для широкого спектра задач — от хранения и аналитики данных до НРС-приложений и нагрузок ИИ, говорит компания. Новинки выполнены в форм-факторе 2U. Допускается установка двух процессоров Xeon Sapphire Rapids или Xeon Emerald Rapids с показателем TDP до 350 Вт. Возможно использование до 8 Тбайт оперативной памяти DDR5-4400/5600 RDIMM в конфигурации 32 × 256 Гбайт. Во фронтальной части в зависимости от модификации могут быть установлены до 12 накопителей LFF (SAS/SATA/NVMe) или до 24 накопителей SFF (SAS/SATA плюс 16 × NVMe). Сзади предусмотрены посадочные места для четырёх изделий SFF (или 2 × SFF и 2 × M.2/E1.S). Допускается формирование массивов RAID 0/1/10/5/50/6/60. Реализована поддержка CXL 1.1. Есть два сетевых порта 1GbE и выделенный сетевой порт управления 1GbE (все с разъёмами RJ45). Доступны до 11 слотов PCIe 5.0 с учетом OCP 3.0 SFF и гнезда под контроллер RAID/HBA. Спереди находятся два порта USB 3.1 Type-C, по одному разъёму USB 2.0 Type-A и D-Sub, сзади — два порта USB 3.1 Type-A, последовательный интерфейс (разъём USB Type-C) и коннектор Mini DisplayPort (BMC). Питание обеспечивают два блока мощностью до 2700 Вт с сертификатом 80 PLUS Platinum. Применено воздушное охлаждение с шестью вентиляторами диаметром 60 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C при относительной влажности от 20 % до 80 %. Заявлена совместимость с Astra Linux, ALT Linux, RED OS, zVirt и пр. С серверами поставляется ПО управления «YADRO Суприм» и набор инструментов Vegman Satellites. Реализована поддержка доступа через IPMI 2.0, WebUI, CLI, SNMP, Redfish. Устройства Vegman R220 G3 включены в Единый реестр российской радиоэлектронной продукции Минпромторга, что подтверждает соблюдение требований локализации.

19.01.2026 [13:54], Сергей Карасёв

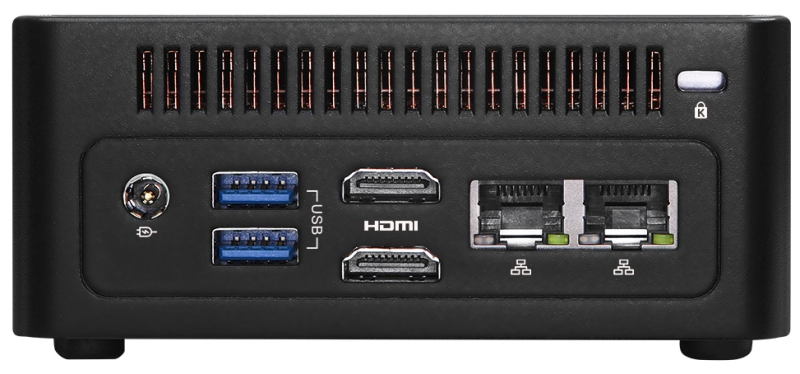

ASRock Industrial представила мини-компьютеры NUC(S) Ultra 300 Box на базе Intel Panther LakeКомпания ASRock Industrial анонсировала компьютеры небольшого форм-фактора NUC(S) Ultra 300 Box, предназначенные для использования в коммерческой и промышленной сферах. Устройства могут применяться в том числе для выполнения аналитики в реальном времени или поддержания ИИ-приложений на периферии. Новинки выполнены на аппаратной платформе Intel Panther Lake-H. Максимальная конфигурация включает процессор Ultra X7 358H с 16 ядрами (4Р+8Е+4LPE); тактовая частота составляет до 4,8 ГГц в турбо-режиме. В состав чипа входят графический ускоритель Intel Arc B390 и нейропроцессорный узел (NPU) с ИИ-производительностью до 50 TOPS на операциях INT8. Доступны два слота SO-DIMM для модулей оперативной памяти DDR5-7200 суммарным объёмом до 128 Гбайт.

Источник изображений: ASRock Industrial Устройства располагают слотами M.2 Key M 2280 (PCIe 5.0 x4) и M.2 Key M 2242 (PCIe 4.0 x4) для SSD. В оснащение входят адаптеры Wi-Fi 7 и Bluetooth 6.0, а также звуковой кодек Realtek ALC256. Возможен вывод изображения одновременно на четыре монитора через два интерфейса HDMI 2.1, разъёмы USB4/Thunderbolt 4 (DP 2.1) и USB 3.2 Type-C (DP1.4a). Модель NUC Ultra 300 Box несёт на борту сетевые контроллеры Intel I226LM и Intel I226V с поддержкой 2.5GbE (есть два коннектора RJ45). Во фронтальной части располагается один порт USB 3.1 Type-A, в тыльной — два. Габариты составляют 117,5 × 110 × 49 мм, масса — около 1 кг.  В свою очередь, модификация NUCS Ultra 300 Box получила только один сетевой контроллер — Intel I226LM с поддержкой 2.5GbE (RJ45). При этом спереди и сзади предусмотрены по два порта USB 3.1 Type-A. Этот компьютер имеет размеры 117,5 × 110 × 38 мм и весит примерно 1 кг. Диапазон рабочих температур у обоих устройств простирается от 0 до +40 °C. Заявлена совместимость с Windows 10/11. Возможен монтаж посредством крепления VESA.

13.01.2026 [09:03], Руслан Авдеев

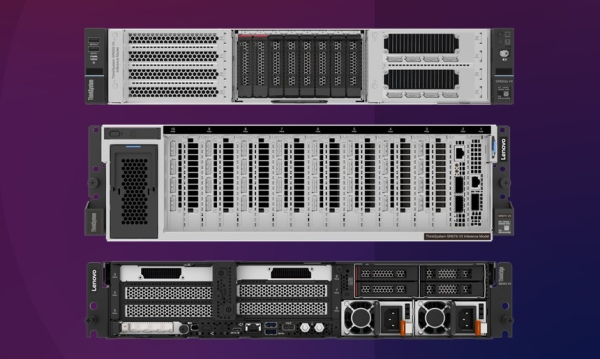

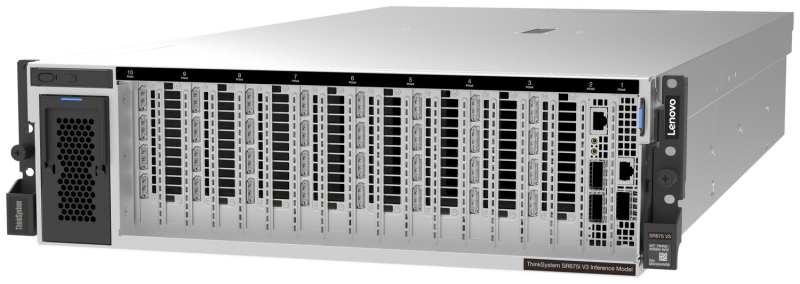

Lenovo представила серверы для ИИ-инференса: ThinkSystem SR675i V3/SR650i V4 и ThinkEdge ThinkEdge SE455i V4Lenovo представила новые серверные системы серии Lenovo Hybrid AI Advantage, оптимизированные для ИИ-инференса: ThinkSystem SR675i V3, ThinkSystem SR650i V4 и ThinkEdge SE455i V4. Если ранее акцент делался на решениях для обучения всё более производительных ИИ-моделей, то теперь бизнес обращает всё больше внимания на продукты для инференса. Новинки предлагаются параллельно с ПО для оптимизации инференса — для унификации и получения данных из разных источников для использования ИИ-моделями. Флагманской версией серии является ThinkSystem SR675i V3 в исполнении 3U на платформе AMD EPYC Turin 9535 (64C/128T, 2,4 ГГц, TDP 300 Вт). Сервер получил 1,5 Тбайт DDR5-6400 (24 × 64 Гбайт). За хранение данных отвечают до двух E3.S NVMe SSD по 3,84 Тбайт (PCIe 5.0 x4) и до двух M.2 NVMe SSD по 960 Гбайт (PCIe 4.0 x4). Возможна установка восьми ускорителей NVIDIA RTX PRO 6000 Blackwell Server Edition, а также пяти DPU NVIDIA BlueField-3 (4 × 400G, 1 × 200G). IPMI в данной модели не доступен. Для карт расширения доступно до шести слотов PCIe 5.0 х16 и один слот OCP 3.0 x8/x16. За питание отвечают четыре блока Titanium второго поколения (по 2300 Вт), а за охлаждение — пять вентиляторов. ThinkSystem SR650i V4 позиционируется в качестве системы для инференса и корпоративных рабочих нагрузок. Этот 2U-сервер получил два Intel Xeon Granite Rapids-SP 6530P (32C/64T, 2,3 ГГц, TDP 225 Вт), 512 Гбайт DDR5-6400 (8 × 64 Гбайт), два ускорителя RTX PRO 6000 Blackwell Server Edition. За хранение отвечают два 3,84-Тбайт U.2 NVMe SSD (PCIe 5.0 x4), хотя всего таких слотов восемь, а также RAID1-массив из пары 960-Гбайт M.2 SATA SSD. Всего доступно шесть слотов расширения PCIe 5.0 x16 и два слота OCP 3.0 x8/x16. Имеется двухпортовый 25GbE-адаптер Broadcom 57414 (SFP28). За питание отвечают два Titanium-блока мощностью 2700 Вт каждый, а за охлаждение шесть вентиляторов, но есть и опция установки фирменной СЖО Neptune. Наконец, Lenovo ThinkEdge SE455i V3 (2U) глубиной всего 440 мм представляет собой компактную модель, предназначенную для периферийного инференса — в ретейле, телекоммуникациях и промышленности. Сервер имеет защищённую конструкцию и может работать при температурах от -5 до +40 °C. Сервер построен на базе одного процессора AMD EPYC Embedded 8534P (64C/128T, 2,3 ГГц, TDP 200 Вт), дополненного 576 Гбайт DDR5-4800 (6 × 96 Гбайт) и двумя ускорителями NVIDIA L4 24 Гбайт (PCIe 4.0 x16). В комплекте идёт один 3,84-Тбайт NVMe SSD и один 960-Гбайт SATA SSD. Имеется два блока питания Platinum второго поколения с возможностью горячей замены. Для карт расширения есть до двух слотов PCIe 5.0 x16 и до четырёх слотов PCIe 4.0 x8, а также один слот OCP 3.0 (PCIe 5.0 x16). Установлен двухпортовый OCP-адаптер Broadcom 57416 (10GbE). IPMI отключён. Фактически компания предлагает готовые конфигурации, которые можно переконфигурировать лишь слегка, чаще всего добавив накопители и/или сетевые адаптеры. Платформы будут доступны в рамках подписки TruScale. Также компания анонсировала новые сервисы Hybrid AI Factory Services, в том числе консультации по инференсу, которые помогают развёртывать оборудование и управлять им для оптимизации ИИ-производительности.

12.01.2026 [13:16], Сергей Карасёв

Supermicro представила SuperBlade-сервер на базе Intel Xeon 6900 с СЖОКомпания Supermicro анонсировала сервер SBI-622BA-1NE12-LCC семейства SuperBlade, предназначенный для построения вычислительных платформ высокой плотности. Устройство будет предлагаться в вариантах с воздушным и прямым жидкостным охлаждением: в первом случае в шасси типоразмера 6U могут быть размещены пять узлов, во втором — десять. Каждый узел SuperBlade поддерживает установку двух процессоров Intel Xeon 6900 поколения Granite Rapids, насчитывающих до 128 производительных P-ядер. Показатель TDP может достигать 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400/8800 суммарным объёмом до 3 Тбайт. Предусмотрены два посадочных места для накопителей E1.S. Опционально могут быть также установлены два NVMe SSD формата M.2 2280 или M.2 22110. Реализованы три слота PCIe 5.0 x16 для карт формата FHHL, HHHL/LP и OCP 3.0. В оснащение входят контроллер Aspeed AST2600 и адаптер Intel E810-XXVAM2, на базе которого реализованы два сетевых порта 25GbE. Шасси, в которое монтируются серверные узлы SBI-622BA-1NE12-LCC, оснащено модулями управления и Ethernet-коммутаторами с резервированием. Питание обеспечивают восемь блоков с сертификатом 80 Plus Titanium. Диапазон рабочих температур — от +10 до +35 °C. По заявлениям Supermicro, передовой дизайн шасси 6U обеспечивает сокращение количества кабелей на 93 % и экономию пространства на 50 % по сравнению с серверами в форм-факторе 1U с сопоставимой конфигурацией. Новинка ориентирована на решение НРС-задач в таких областях, как производство, финансы, научные исследования, энергетика, моделирование климата и пр.

30.12.2025 [12:49], Руслан Авдеев

NVIDIA потратила $5 млрд на акции Intel, но уже заработала на этом $2,5 млрдСентябрьская сделка NVIDIA с Intel, в ходе которой первая потратила на акции своего конкурента $5 млрд в сентябре, уже принесла ей ощутимую выгоду — пакет купленных акций Intel теперь оценивается в $7,58 млрд, сообщает The Register. В сентябре глава NVIDIA Дженсен Хуанг (Jensen Huang) и руководитель Intel Лип-Бу Тан (Lip-Bu Tan) заключили соглашение, в рамках которого NVIDIA зафиксировала цену покупки акций Intel по $23,28 за ценную бумагу. Сделка привлекла пристальное внимание Федеральной торговой комиссии (FTC) США, заинтересовавшейся, не противоречит ли покупка NVIDIA доли конкурента в объёме приблизительно 4 % антимонопольному законодательству Соединённых Штатов. 18 декабря сделке дали «зелёный свет». Согласно документам, поданным Intel американским регуляторам, сделка по покупке 214 млн простых акций завершена 26 декабря. В понедельник торги акциями компании закрылись на отметке $36,68. По условиям сделки, компании будут вместе разрабатывать несколько поколений чипов для ЦОД и ПК, увеличивая долю на всех профильных рынках, от ПК до крупных корпоративных клиентов. Ранее уже сообщалось, что партнёры обеспечат объединение архитектур NVIDIA и Intel с использованием NVIDIA NVLink. Так, ожидается появление x86-процессоров, специально разработанных для NVIDIA. Также Intel будет способна создавать x86-чипсеты (SoC) с интегрированными GPU NVIDIA RTX. Соглашение Intel и NVIDIA похоже на то, что вызвало недовольство регуляторов ещё в 2021 году, когда NVIDIA попыталась целиком купить британского разработчика Arm за $40 млрд. На тот момент FTC заявила, что сделка обеспечила бы крупному игроку на рынке чипов контроль над одним из своих конкурентов — это могло бы стать крупнейшей сделкой в полупроводниковой сфере за всю историю. Подчёркивалось, что такая покупка обеспечила бы одному из крупнейших производителей чипов контроль над разработками конкурентов, поэтому компания получила бы «средства и стимулы» для «удушения» технологий следующего поколения Тогда FTC подала в суд, и через два месяца NVIDIA приняла решение отказаться от сделки. На тот момент FTC отметила, что речь идёт о «редкой внесудебной победе» для ведомства. |

|