Материалы по тегу: hardware

|

09.06.2025 [08:23], Сергей Карасёв

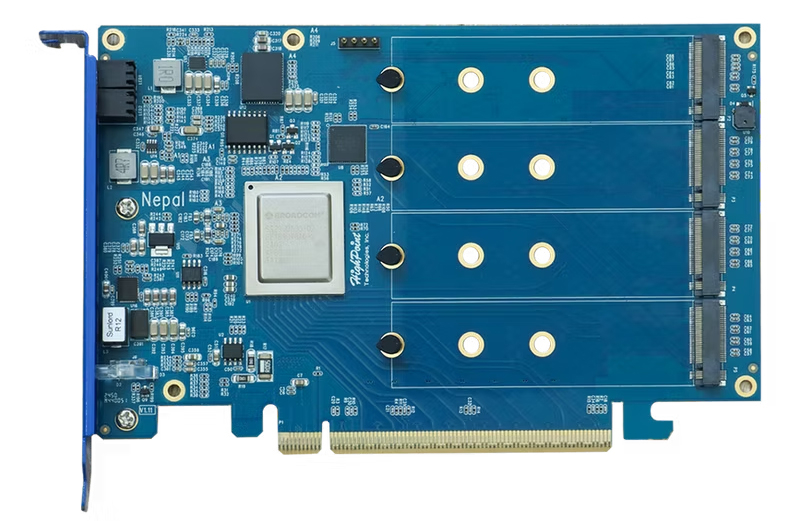

HighPoint представила первую в мире RAID-карту с поддержкой четырёх M.2 SSD стандарта PCIe 5.0Компания HighPoint анонсировала карту расширения Rocket 7604A RAID AIC: это, как утверждается, первый в мире RAID-адаптер с возможностью установку четырёх SSD типоразмера М.2 с интерфейсом PCIe 5.0. Устройство предназначено для использования в высокопроизводительных рабочих станциях, системах для периферийных вычислений и пр. Новинка имеет форм-фактор FHHL с длиной 167 мм. Задействован PCIe-коммутатор Broadcom PEX89048 с поддержкой 48 линий PCIe 5.0. Предусмотрены четыре слота для накопителей M.2 2242/2260/2280 (PCIe 5.0 x4 для каждого из разъёмов). Суммарная вместимость установленных SSD может достигать 32 Тбайт (4 × 8 Тбайт) с быстродействием до 56 Гбайт/с и до 12 млн IOPS. Встроенный RAID-контроллер позволяет формировать массивы RAID 0/1/10. Заявлена совместимость с платформами Windows 10/11, Windows Server 2016/2019/2022, Debian, Ubuntu, Fedora, Proxmox, RHEL, Rocky Linux (ядро Linux 3.10 и выше). Для настройки, управления и мониторинга служит фирменное ПО с веб-интерфейсом и CLI. Карта имеет однослотовое исполнение; для её установки требуется разъём PCIe 5.0 x16. Изделие оснащено радиатором и 80-мм вентилятором, который, по словам компании, обладает низким уровнем шума. Диапазон рабочих температур — от +5 до +55 °C. Заявленный показатель MTBF (средняя наработка на отказ) — 920 585 часов.  Карта расширения Rocket 7604A RAID AIC доступна для заказа по ориентировочной цене $1000. А за $900 можно приобрести вариант Rocket 1604A Switch AIC, который обладает аналогичными техническими характеристиками, но не содержит RAID-контроллера.

08.06.2025 [23:35], Владимир Мироненко

Marvell получила рекордную выручку и рассчитывает на дальнейшее успешное сотрудничество с гиперскейлерамиАмериканская компания Marvell Technology, специализирующаяся на производстве процессоров, микроконтроллеров и телекоммуникационных решений, сообщила результаты I квартала 2026 финансового года, завершившегося 3 мая 2025 года, отметив рекордную выручку в размере $1,89 млрд, что на 63 % больше год к году и на $20 млн превысило собственный прогноз в средней точке диапазона. Также показатель превысил консенсус-прогноз аналитиков, опрошенных LSEG, в размере $1,88 млрд, пишет Reuters. Чистая прибыль компании (GAAP) составила за I квартал 2026 финансового года $177,9 млн, или $0,20 на разводненную акцию, тогда как годом ранее у неё были убытки в размере $215,6 млн или $0,25 на разводнённую акцию. Скорректированная прибыль (Non-GAAP) равняется $540,0 млн или $0,62 на разводнённую акцию.

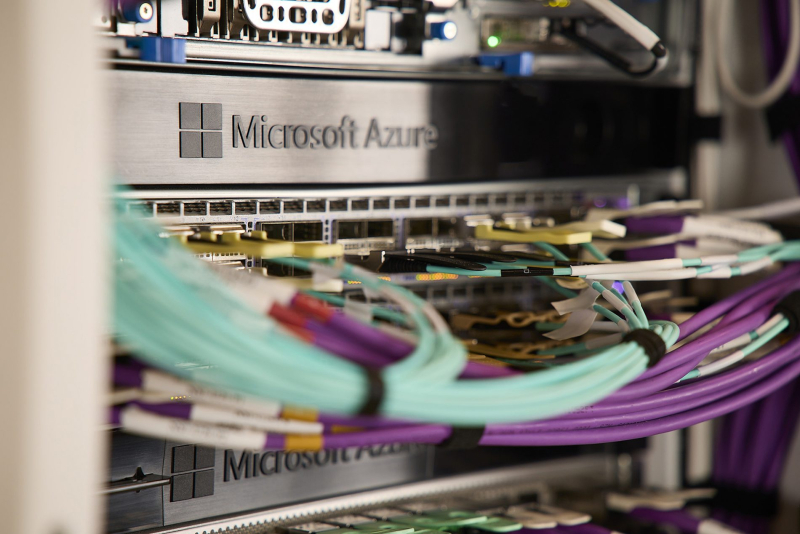

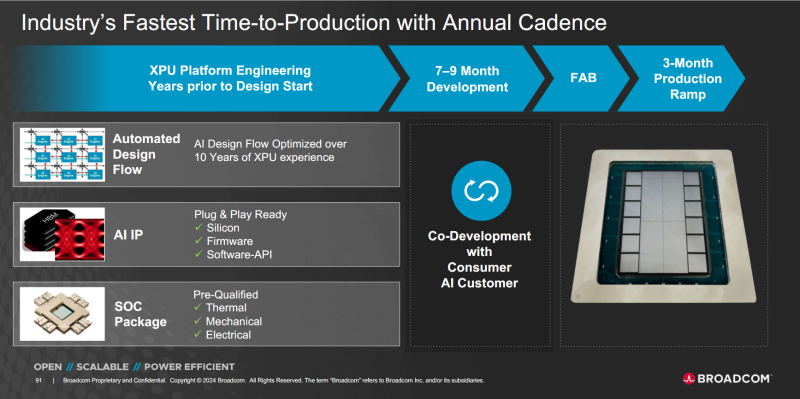

Источник изображений: Microsoft Выручка сегмента решений для ЦОД, на который приходится 76 % от общего дохода компании, составила $1,44 млрд, увеличившись год к году на 76 % во многом благодаря сделкам по разработке ИИ-ускорителей AWS Trainium и Microsoft Maia. По словам Мэтта Мерфи (Matt Murphy), председателя и гендиректора Marvell Technology, программа по разработке XPU для крупного американского клиента-гиперскейлера продвигается успешно, она стала ключевым источником дохода для бизнеса, связанного с заказами. Broadcom уже разрабатывает ИИ-ускорители для трёх крупных клиентов и обсуждает разработку с ещё четырьмя потенциальными клиентами. «Как я упоминал в прошлом квартале, мы активно сотрудничаем с этим заказчиком в разработке следующего поколения чипов, и я хочу сообщить, что теперь мы обеспечили производство 3-нм пластин и усовершенствованной упаковки и планируем начать производство в 2026 году. В то же время наша команда архитекторов работает с заказчиком, чтобы поддержать подгтовку следующего поколения», — сообщил Мерфи. Речь идёт об AWS, и Мерфи имеет в виду находящийся в производстве Trainium 2, платформу для Trainium 3 и спецификации для будущего Trainium 4, пояснил ресурс The Next Platform. Мерфи добавил, что проект по созданию ИИ-ускорителя следующего поколения, разработанного для другого американского гиперскейлера, по всей видимости, чипа Maia 100 для Microsoft, «продолжает успешно развиваться» и что компания уже сотрудничает с тем же заказчиком в разработке следующего ИИ XPU с предположительным названием Maia 200. 17 июня Marvell планирует провести мероприятие, на котором, возможно, предоставит более подробную информацию о текущих разработках и о своих планах по дальнейшему развитию этого бизнеса. В сегменте корпоративных сетевых продуктов, включая коммутаторы Prestera и Innovium, и сетевые интерфейсные платы, выручка выросла на 16 % до $177,5 млн, в сегменте операторских инфраструктур — на 93 % до $138,4 млн. В потребительском сегменте продажи выросли год к году на 50 % до $61,1 млн, но упали последовательно на 29 %, что связано с сезонными изменениями в спросе. Сегмент решений для автомобильной сферы и промышленной отрасли принёс $75,7 млн, что на 12 % меньше, чем в предыдущем квартале и на 2 % меньше, чем годом ранее. В текущем, II квартале 2026 финансового года Marvell ожидает получить выручку в размере $2,0 млрд ± 5 % по сравнению со средней оценкой аналитиков в $1,98 млрд согласно данным опроса аналитиков компанией LSEG. Прогнозируемая прибыль (GAAP) на разводнённую акцию равна $0,21 ± $0,05, ожидаемая скорректированная прибыль (Non-GAAP) на разводнённую акцию — $0,67 ± $0,05.

07.06.2025 [23:11], Владимир Мироненко

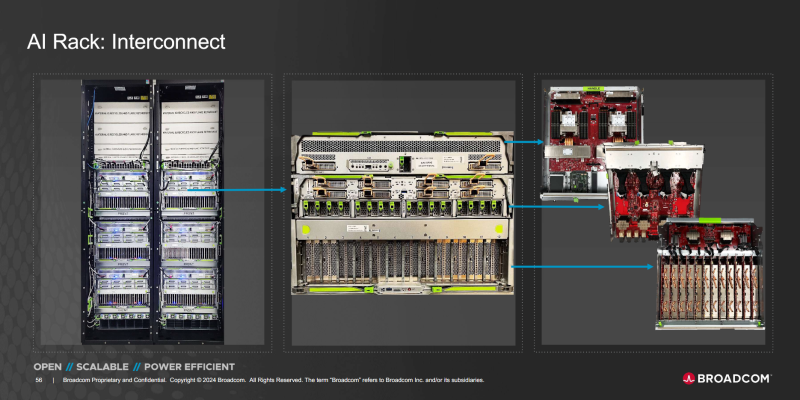

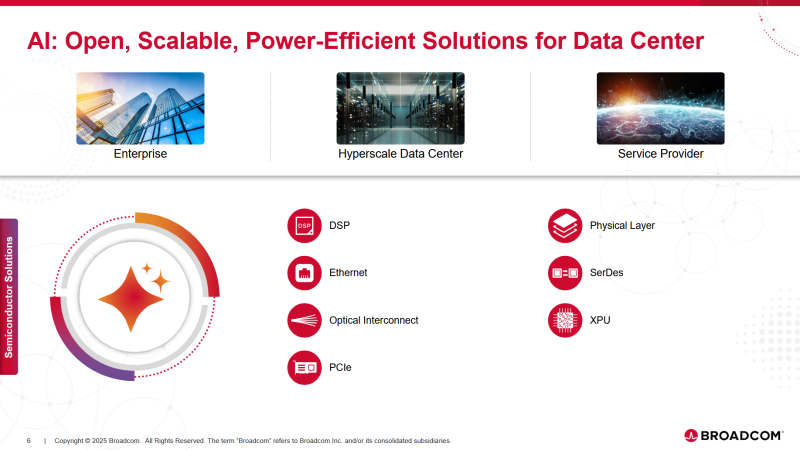

Акции Broadcom упали из-за слабого прогноза, несмотря рост прибыли и выручкиBroadcom опубликовала финансовые результаты II квартала 2025 финансового года, завершившегося 4 мая. Несмотря на успешные итоги квартала, превысившие прогнозы аналитиков Уолл-стрит, акции компании упали на 4 % на расширенных торгах из-за слабого прогноза на III финансовый квартал после роста примерно на 12 % в этом году и более чем двукратного роста в прошлом, пишет Reuters. Прогноз на текущий квартал не впечатлил инвесторов, которые ожидали существенного роста, обусловленного достижениями в области ИИ. Выручка Broadcom во II финансовом квартале выросла год к году на 20 % до $15,00 млрд, превысив прогноз аналитиков, опрошенных LSEG, в размере $14,99 млрд. Скорректированная чистая прибыль (Non-GAAP) составила $1,58 на разводнённую акцию, что выше прошлогоднего показателя на $0,48 и немного больше прогноза аналитиков от LSEG — на $0,02. Чистая прибыль (GAAP) за II финансовый квартал выросла на 134 % до $4,97 млрд или $1,03 на разводнённую акцию с $2,12 млрд или $0,44 на разводнённую акцию годом ранее. Скорректированный показатель EBITDA увеличился до $10,00 млрд с $7,43 млрд в прошлом году (рост год к году — 35 %), составив 67 % выручки. Выручка от ИИ-решений выросла год к году во II финансовом квартале на 46 % $4,4 млрд, что обусловлено устойчивым спросом на сетевые решения для ИИ, сообщил Хок Тан (Hock Tan), президент и гендиректор Broadcom. По его словам, в текущем квартале компания ожидает увеличить выручку от ИИ-решений до $5,1 млрд, что означает рост в течение десяти кварталов подряд. Тан заявил, что компания по-прежнему успешно сотрудничает с тремя крупными клиентами в разработке кастомных ИИ-ускорителей, а также ведёт работу в этом направлении с ещё четырьмя потенциальными клиентами. Он отметил, что партнёры «непоколебимы» в своих планах инвестировать в ИИ-инфраструктуру. Группа полупроводниковых решений Semiconductor solutions принесла Broadcom на 17 % больше выручки, составившей $8,41 млрд (56 % всей выручки), превысив прогноз аналитиков, опрошенных StreetAccount, в размере $8,34 млрд. Разработчики ПО (Infrastructure software), включая VMware, получили выручку в размере $6,60 млрд (рост 25 %), превзойдя оценку StreetAccount. Broadcom заявила, что ожидает получить в III финансовом квартале около $15,8 млрд выручки, что на 21 % больше, чем за аналогичный период предыдущего года, против $15,7 млрд, прогнозируемых аналитиками Уолл-стрит.

07.06.2025 [22:49], Владимир Мироненко

От «железа» до агентов: «К2 НейроТех» представил ПАК-AI для разработки и внедрения ИИ на предприятиях«К2 НейроТех», подразделение компании «К2Тех», представило программно-аппаратный комплекс ПАК-AI, позволяющий оперативно интегрировать ИИ в действующую ИТ-среду организации в соответствии с её требованиями и политиками безопасности. ПАК-AI включает аппаратную часть, программную платформу, а также инструменты для работы с данными, ИИ-моделями, промтами, визуализациями, API-интеграцией и т. д. Первый вариант ПАК-AI построен на базе оборудования YADRO: шесть серверов, включая ИИ-сервер с восемью GPU и сетевые коммутаторы KORNFELD. Управление ПАК-AI осуществляется через портал — специализированную GUI-платформу, служащую единой точкой входа для работы с вычислительными ресурсами, для запуска моделей, настройки среды и контроля загрузки. Платформа обеспечивает управление виртуальными машинами с ускорителями для изолированных задач и контейнерами Kubernetes для обеспечения гибкости и масштабируемости. Платформа обеспечивает доступ к предустановленному ПО: ОС (Astra Linux, CentOS, РЕД ОС), ML-инструментам, моделям и средам разработки.

Источник изображений: «К2 НейроТех» Клиенту доступны функции маршрутизации данных, оркестрации, мониторинга, управления файловыми системами и каталогами, резервного копирования и обеспечения безопасности. Использование ресурсов фиксируется автоматически с отображением их стоимости в разделе биллинга. Разработчикам предоставляется весь необходимый стек инструментов для администрирования моделей. Помимо доступа к востребованным средам, таким как TensorFlow, PyTorch, Keras, HuggingFace Transformers, специалисты имеют возможность разворачивать собственные окружения в виде ВМ или контейнеров, устанавливать дополнительные библиотеки, использовать кастомные образы и конфигурации. Также предоставляется возможность построения MLOps-конвейеров с использованием MLflow, Hydra, Optuna. Прикладной слой платформы представляет собой каталог готовых агентов и моделей, разработанных К2 НейроТех. Он включает решения как на базе открытых, так и вендорских моделей, в том числе YandexGPT mini, GigaChat lite, DeepSeek, Llama, Qwen и другие. Пользователи смогут их обучать на корпоративных данных, адаптировать под бизнес-процессы и применять в прикладных сценариях: от обработки документов и генерации контента до автоматизации клиентского взаимодействия, производственной аналитики и других узкоспециализированных прикладных задач. В ПАК-AI может использоваться отечественное оборудование любых вендоров и ПО, разработанное как на основе решений из реестров Минцифры и Минпромторга России, так и на открытом ПО, что позволяет менять конфигурацию с соответствии с требованиями регуляторов. ПАК-AI реализован в формате IaaS (предоставление вычислительных ресурсов), PaaS (маркетплейс приложений для ML-команд с предоставлением доступа к нужной инфраструктуре и сервисам), SaaS (доступ к предустановленным приложениям от сторонних вендоров). Также с его помощью можно организовать внутренний сервис ИИ-как-услуга (AIaaS) для предоставления LLM и агентов.

07.06.2025 [16:35], Сергей Карасёв

HPE представила отказоустойчивые системы Nonstop Compute на базе Intel Xeon Sapphire RapidsКомпания HPE пополнила семейство отказоустойчивых решений Nonstop Compute двумя новинками — системой начального уровня NS5 X5 и флагманской моделью NS9 X5. Архитектура платформ объединяет вычислительные мощности, ресурсы хранения, сетевые функции и сопутствующее ПО. Решение Nonstop Compute NS5 X5 ориентировано на сравнительно небольших корпоративных заказчиков. Система формата 36U/42U может нести на борту до четырёх процессоров Intel Xeon Bronze 3400 поколения Sapphire Rapids. Объём оперативной памяти достигает 128 Гбайт в расчёте на CPU, что в сумме даёт до 512 Гбайт. Возможна установка до 100 SAS SSD вместимостью 1,6 Тбайт каждый. Допускается также подключение внешних массивов хранения HPE XP8. В общей сложности могут использоваться до 20 сетевых портов, в том числе 10GbE.

Источник изображения: HPE В свою очередь, модель Nonstop Compute NS9 X5 ориентирована на ресурсоёмкие нагрузки, такие как обработка транзакций в реальном времени в больших масштабах и интенсивная работа с данными. Максимальная конфигурация включает 16 процессоров Xeon Gold 6400 семейства Sapphire Rapids с 512 Гбайт памяти в расчёте на CPU, что в сумме обеспечивает до 8 Тбайт ОЗУ. Система может быть оборудована 2700 SAS SSD ёмкостью до 1,6 Тбайт каждый. Предусмотрена возможность использования до 270 сетевых портов на систему, в том числе 25GbE. В целом, решения Nonstop Compute ориентированы на сегмент рынка, где требуется менее высокая стоимость по сравнению с традиционными мейнфреймами, но при этом предъявляются более высокие требования в плане надёжности и масштабируемости, чем к стандартным серверам. IDC относит продукты Nonstop Compute к системам с доступностью класса Availability Level 4 (AL4): это означает, что показатель безотказной работы составляет от 99,999 % до 99,9999 %. Таким образом, системы подходят для применения в том числе в финансовом секторе. HPE утверждает, что шесть из десяти крупнейших мировых банков используют устройства Nonstop Compute.

07.06.2025 [16:31], Сергей Карасёв

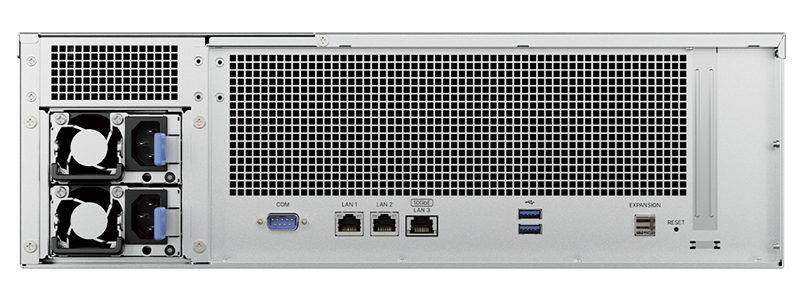

Synology выпустила стоечное хранилище RackStation RS2825RP+ с процессором AMD Ryzen EmbeddedКомпания Synology анонсировала сетевое хранилище данных RackStation RS2825RP+ для предприятий малого и среднего бизнеса. Устройство, рассчитанное на монтаж в стойку, выполнено на аппаратной платформе AMD, а в качестве ОС применяется фирменная система DiskStation Manager (DSM) на основе веб-интерфейса. Новинка несёт на борту процессор Ryzen Embedded V1780B с четырьмя ядрами (восемь потоков), работающими на частоте до 3,6 ГГц. Базовая конфигурация включает 8 Гбайт оперативной памяти DDR4 ECC с возможностью расширения до 32 Гбайт (два модуля UDIMM). Во фронтальной части расположены 16 отсеков для накопителей LFF/SFF с интерфейсом SATA-3. Поддерживается формирование массивов RAID 0/1/5/6/10. При необходимости можно добавить модуль расширения RX1225RP, предоставляющий ещё 12 посадочных мест для накопителей LFF/SFF. Допускается горячая замена.

Источник изображений: Synology Хранилище RackStation RS2825RP+ располагает двумя сетевыми портами 1GbE и портом 10GbE (все на основе разъёмов RJ45), двумя портами USB 3.0 и коннектором Mini-SAS HD. Есть также слот PCIe 3.0 x8, в который может быть установлен адаптер для M.2 SSD, сетевой контроллер 10GbE или 25GbE. Новинка выполнена в форм-факторе 3U с размерами 132,3 × 482 × 656,5 мм, а масса составляет 17,3 кг. Установлены два блока питания мощностью 550 Вт каждый. В системе охлаждения задействованы три вентилятора диаметром 80 мм. Диапазон рабочих температур — от 0 до +35 °C.  Для устройства заявлена поддержка протоколов SMB1/2/3 (CIFS), NFSv3/4/4.1, NFS Kerberized sessions, iSCSI, HTTP(S), FTP, SNMP, LDAP, CalDAV. Производительность достигает 3519 Мбайт/с при последовательном чтении и 1790 Мбайт/с при последовательной записи. Приём заказов на хранилище уже начался.

07.06.2025 [00:30], Сергей Карасёв

«Аквариус» анонсировала защищённую платформу СХД S2-1 с российским процессором Baikal-S

arm

baikal-s

hardware

micro-atx

аквариус

информационная безопасность

материнская плата

россия

сделано в россии

сервер

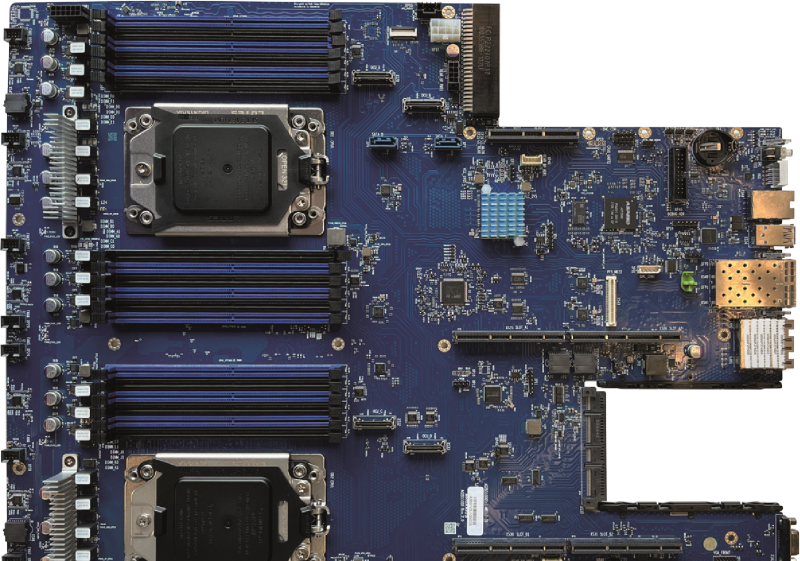

схд

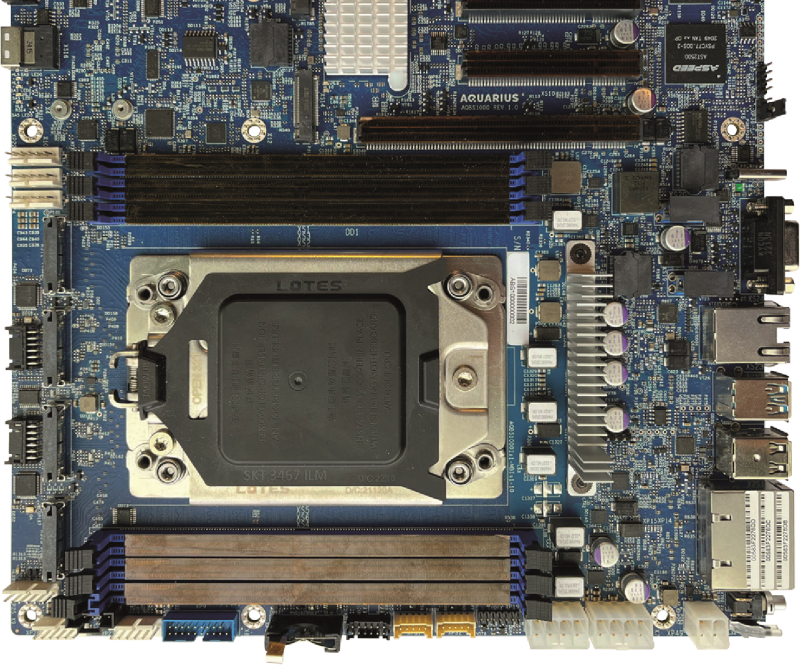

Компания «Аквариус» сообщила о разработке аппаратной платформы СХД под названием S2-1, которая предназначена для построения защищённой IT-среды. Решение ориентировано на государственные учреждения, финансовые организации и объекты критической информационной инфраструктуры (КИИ). В основу платформы положены сервер Aquarius AQ2BS1000 и российский процессор Baikal-S (BE-S1000), разработанный компанией «Байкал Электроникс». Характеристики этого чипа включают 48 ядер Arm Cortex-A75 с частотой более 2 ГГц, шесть каналов памяти DDR4-3200 ECC, 80 линий PCIe 4.0, два интерфейса 1GbE, а также 32 × GPIO, 2 × UART, 1 × QSPI и пр. Материнская плата (476 × 427 мм) включает два процессорных сокета LGA3467, 24 слота DIMM (суммарно до 1,5 Тбайт RAM), OCP-слот, а также BMC ASPEED AST2500. UEFI разработан «Байкал Электроникс», а для BMC используется прошивка OpenBMC от «Аквариус». Полные технические характеристики платформы S2-1 пока не раскрываются. Как отмечает «Аквариус», на сегодняшний день готовы инженерные образцы СХД. По заявлениям разработчика, система отличается высокой гибкостью и возможностью быстрой адаптации под конкретные задачи заказчика. Используются безопасные серверы, которые не содержат недокументированных функций, что «обеспечивает высокий уровень доверия и прозрачности». Кроме того, реализована защита от физического вторжения: данные остаются в сохранности даже при непосредственном доступе злоумышленника к устройству. «Мы создаём не просто железо — мы строим крепость для данных, которая адаптируется под любые вызовы времени. Наши решения — это надёжность, проверенная временем, и безопасность, которая не подведёт даже в самых сложных условиях. В этом контексте аппаратная платформа СХД S2-1 является опорой для бизнеса и государства в мире цифровых угроз», — подчёркивает директор департамента по развитию серверных решений группы компаний «Аквариус».

Aquarius AQBS1000 (Источник изображения: «Аквариус») Кроме того, «Аквариус» имеет однопроцессорную платформу AQBS1000 для Baikal-S. Материнская плата по формату близка к Mini-ATX (476 × 427 мм) и несёт шесть DIMM-слотов, один слот PCIe 4.0 x16 и три слота x8, четыре OCuLink-разъёма PCIe 4.0 (x8 или два x4), разъём Mini-SAS HD (4 × SATA-3), два слота M.2 2280 M-Key (SATA-3/NVMe PCIe 3.0), по паре портов USB 2.0 и 3.0 Type-A, два 1GbE-порта R45, а также выделенный 1GbE-порт для BMC ASPEED AST2500.

06.06.2025 [17:58], Руслан Авдеев

AMD купила команду разработчика ИИ-чипов Untether AI, но не саму компанию, которая тут же закрыласьКомпания AMD объявила об очередной за несколько дней корпоративной покупке. Она наняла неназванное количество сотрудников Untether AI, разрабатывающей ИИ-чипы для энергоэффективного инференса в ЦОД и на периферии, сообщает Silicon Angle. Первым информацией о сделке поделился представитель рекрутинговой компании SBT Industries, специализирующейся на полупроводниковой сфере. Позже в AMD подтвердили, что компания приобрела «талантливую команду инженеров по аппаратному и программному ИИ-обеспечению» у Untether AI. Новые сотрудники помогут оптимизировать разработку компиляторов и ядер ИИ-систем, а также улучшить проектирование чипсетов, их проверку и интеграцию. Вероятно, сделку завершили в прошлом месяце, причём в команду не вошёл глава Untether Крис Уокер (Chris Walker), перешедший в стартап из Intel и возглавивший его в начале 2024 года. Судя по информации из соцсетей, Уокер покинул компанию в мае. Сделка довольно необычна, поскольку никаких активов компании не покупалось, но Untether AI уже объявила о закрытии бизнеса и поставок или поддержки чипов speedAI и ПО imAIgine Software Development Kit (SDK).

Источник изображения: Untether AI Untether AI была основана 2018 году в Торонто (Канада). В июле 2021 года стартап привлёк $125 млн в раунде финансирования, возглавленном венчурным подразделением Intel Capital. Компания разрабатывала энергоэффективные чипы для инференса для периферийных решений, потребляющих мало энергии. В одной упаковке объединялись модули для вычислений и память. В октябре 2024 года начала продажи чипа speedAI240 Slim (развитие speedAI240). speedAI240 Slim, по данным компании, втрое энергоэффективнее аналогов в сегменте ЦОД. Помимо Intel, Untether AI имела партнёрские отношения с Ampere Computing, Arm Holdings и NeuReality. Буквально в минувшем апреле Уокер сообщил журналистам, что компания отметила большой спрос на свои чипы для инференса со стороны покупателей, ищущих альтернативы продуктам NVIDIA с более высокой энергоёмкостью. Более того, в прошлом году компания договорилась с индийской Ola-Krutrim о совместной разработке ИИ-ускорителей не только для инференса, но и для тюнинга ИИ-моделей. Покупка состоялась всего через два дня после объявления о приобретении малоизвестного стартапа Brium, специализировавшегося на инструментах разработки и оптимизации ИИ ПО. Вероятно, AMD заинтересована в использовании его опыта для оптимизации инференса на отличном от NVIDIA оборудовании. Сделка с Brium состоялась всего через шесть дней после того, как AMD объявила о покупке разработчика систем кремниевой фотоники Enosemi. Это поможет AMD нарастить компетенции в соответствующей сфере, поскольку всё больше клиентов пытаются объединять тысячи ускорителей для поддержки интенсивных ИИ-нагрузок.

06.06.2025 [11:08], Руслан Авдеев

Endeavour предложила ЦОД натриевые батареи TiamatВладеющая оператором дата-центров Edged компания Endeavour предложила дата-центрам натриевые аккумуляторы взамен литиевых. На этой неделе она объявила о стратегическом партнёрстве с производителем АКБ Tiamat для поставки батарей для ИИ ЦОД и систем стабилизации энергосетей, сообщает пресс-служба Endeavour. В Endeavour утверждают, что технология Tiamat даёт возможность полностью заряжать и разряжать аккумуляторы более 60 раз в час, тогда как Li-Ion варианты обеспечивают лишь 1–3 подобных цикла. Как заявляют в компании, такие показатели в сочетании с длительным сроком службы и высокой плотностью хранения энергии делают АКБ подходящими для работы с нестабильными ИИ-нагрузками без неконтролируемого перегрева аккумуляторов в процессе работы. В батареях Tiamat используются уникальные химические процессы в сравнении с сопоставимыми натриевыми решениями. В течение последнего года они тестируются с реальными рабочими ИИ-нагрузками с сотнями тысяч циклов заряда/разряда. Партнёры планируют глобальное внедрение этих решений.

Источник изображения: Tiamat Tiamat основана в 2017 году во Франции и её аккумуляторы, помимо прочего, будут использоваться в дата-центрах Edged, принадлежащей Endeavour. Поставки другим компаниям, в том числе гиперскейлерам, будут осуществляться при эксклюзивном посредничестве Endeavour. В Tiamat подчёркивают, что чрезвычайно довольны партнёрством. За последний год, как утверждают в компании, стало ясно, что такая технология АКБ — единственная, способная сегодня справиться со сложными требованиями, предъявленными инженерами Endeavour к уровню нагрузки и долговечности.

Источник изображения: Tiamat Endeavour создана основателем Aligned Якобом Карнемарком (Jakob Carnemark). ЦОД-подразделение Edged имеет дата-центры, которые либо уже работают, либо находятся на стадии строительство в Бильбао, Мадриде и Барселоне (Испания), Лиссабоне (Португалия), а также в США (Миссури, Аризона, Техас, Джорджия, Огайо и Иллинойс). У Endeavour есть и другие перспективные разработки. Так, система безводного охлаждения ThermalWorks поддерживает до 70 кВт на стойку при воздушном охлаждении и до 200 кВт — при жидкостном. Партнёры не одиноки в своём стремлении использовать натриевые аккумуляторы. Около года назад появилась информация, что стартап Unigrid намерен наладить выпуск недорогих натрий-ионных аккумуляторов для ЦОД.

06.06.2025 [10:19], Руслан Авдеев

Castrol запустила сервис управления оборотом жидкостей для охлаждения дата-центровCastrol представила сервис управления оборотом жидкостей для систсем жидкостного охлаждения (СЖО) дата-центров. Это должно помочь операторам ЦОД в переходе с воздушных систем на жидкостные — последние всё более востребованы при использовании высокоплотных серверных стоек, сообщает Datacenter Dynamics. Принадлежащая BP компания Castrol заявляет, что новый сервис охватывает все четыре фазы жизненного цикла работы СЖО, включая запуск системы, текущее обслуживание, устранение неисправностей, утилизацию жидкостей. Предполагается, что это поможет преодолеть барьеры на пути внедрения СЖО в дата-центрах. В Castrol отмечают, что операторы уже осознали преимущества жидкостного охлаждения, но им нужны гарантии долгосрочной сервисной поддержки. Тем временем Castrol десятилетиями осуществляет её в других сферах, например — в автоиндустрии. Теперь этот опыт будет использован и для обслуживания дата-центров. Новая услуга будет оказываться с помощью партнёрской сети Castrol с привлечением сторонних компаний. Цель — избавиться от «операционной и технической неопределённости», замедлившей внедрение жидкостных систем. Утверждается, что в СЖО охлаждающая жидкость является единственной «точкой отказа» и ухудшение условий эксплуатации снижает эффективность работы оборудования и может привести к его поломке. Тем временем «структурированный» подход Castrol обеспечивает поддержку на каждом этапе. Ранее компания разработала линейку охлаждающих жидкостей для СЖО, включая ON Direct Liquid Cooling PG 25, представленную в декабре 2024 года. В том же году компания ввела в эксплуатацию модульный ЦОД в Оксфордшире (Oxfordshire) на площадке собственного исследовательского центра для тестирования и демонстрации собственных решений. Активно занимаются разработкой технологий и решений для СЖО и другие компании из нефтегазовой и смежных отраслей: Shell, SK Enmove, ExxonMobil, Perstorp, Gulf Oil. |

|