Материалы по тегу: hardware

|

07.04.2025 [10:03], Владимир Мироненко

В отрасли ЦОД готовятся к резкому росту цен на серверы из-за торговой политики ТрампаТорговая политика президента США Дональда Трампа неизбежно приведёт к росту цен на серверы для бизнеса, по крайней мере в краткосрочной перспективе, поскольку неопределённость распространяется на цепочку поставок, считают эксперты, о чём пишет The Register. Белый дом США ввёл с 5 апреля базовый тариф на весь импорт в размере 10 %. Затем с 9 апреля США добавят «взаимные тарифы» для многих стран в ответ на собственные импортные пошлины этих стран. Больше всего это ударит по крупнейшим мировым производителям технологического оборудования, включая Китай, Таиланд, Вьетнам и Тайвань. До этого Трамп заявил о намерении ввести тарифы на ввоз полупроводников, произведённых за пределами США, а также призывал установить 25-процентный сбор на импорт процессоров. По мнению экспертов, ввод тарифов на поставки чипов из Китая никак не отразится на США, чего не скажешь о Тайване, Японии или Южной Корее, где производится большая часть микросхем памяти и процессоров, используемых в тех же серверах. «Я действительно думаю, что могут быть некоторые краткосрочные последствия», — заявила глава AMD Лиза Су (Lisa Su) на прошлой неделе, добавив, что сейчас ещё слишком рано говорить о долгосрочных последствиях — для этого нужно понаблюдать, как будут развиваться события в течение следующих нескольких месяцев. На процессоры AMD приходится почти четверть всех проданных в III квартале 2024 года серверных чипов x86. При этом они производятся компанией TSMC на Тайване. HPE сообщила о предполагаемом снижении выручки во II квартале 2025 года из-за негативного влияния торговой политики Трампа на цепочки поставок. «Недавние объявления о тарифах создали неопределённость для нашей отрасли, в первую очередь затронув наш серверный бизнес», — сообщила финансовый директор HPE Мари Майерс (Marie Myers) в марте в ходе телефонной конференции с аналитиками. Она отметила, что компания работает над планами по смягчению последствий этого с помощью мер оптимизации работы цепочки поставок и изменения ценообразования. Dell заявила в ходе последнего квартального отчёта, что ей также, вероятно, придется поднять цены в связи с введением тарифов. Вице-председатель и главный операционный директор Джефф Кларк (Jeff Clarke) сообщил, что построенная компанией ведущая в отрасли цепочка поставок помогает минимизировать влияние торговых правил, тарифов на её клиентов и акционеров, но с ростом расходов цены всё же придётся скорректировать. В отличие от многих других компаний, китайский производитель Lenovo сохраняет оптимизм. Генеральный директор Lenovo Юаньцин Ян (Yuanqing Yang) заявил, что глобальное присутствие, а также гибкость и устойчивость помогут компании адаптироваться к различным сценариям. «Мы уверены, что не только сможем обеспечить свою конкурентоспособность на рынке, но и защитить нашу прибыль и производительность», — сообщил гендиректор. Комментарий компании Supermicro из США, которая поставляет серверы гиперскейлерам, был более сдержанным. «Компания активно отслеживает динамику ситуации с торговлей и тарифами, сотрудничая с государственными органами, и мы соответствующим образом сообщим о любых будущих последствиях», — заявил её представитель ресурсу The Register. По данным IDC, мировой рынок серверов за IV квартал 2024 года достиг рекордной отметки в $77,3 млрд выручки, что означает рост год к году в размере 91 %. Ресурс The Register спросил у IDC, не было ли зафиксировано какое-либо влияние объявления о введении тарифов, например, на то, что поставщики начали накапливать запасы в США, прежде чем они вступят в силу. «Пока об этом рано говорить», — ответила Лидице Фернандес (Lidice Fernandez), вице-президент группы по WW Enterprise Infrastructure. Она отметила, что несколько компаний объявили о планах открыть объекты в США, чтобы избежать пошлин, но поскольку это касается производства серверов, на это могут уйти годы. «Мы ожидаем, что растущие расходы будут переложены на конечных пользователей, и пока нет никаких признаков накопления, но это может измениться в ближайшем будущем. Компании всё ещё приспосабливаются к новой реальности», — сообщила Фернандес. В компании Omdia, отслеживающей рынок серверов и ЦОД, рассказали, что данные по продажам поставщиков за I квартал будут опубликованы только в июне, поэтому сейчас вряд ли удастся получить чёткую картину какого-либо влияния тарифов. «Мы пока не видим никаких скачков цен на рынке серверов. Цепочка поставок серверов и производство в основном находятся на Тайване, и тайваньские поставщики готовятся к этой ситуации», — говорит Манодж Сукумаран (Manoj Sukumaran), главный аналитик направления Datacenter IT. Он выразил мнение, что рост тарифов станет проблемой клиентов, а не поставщиков. «Цепочка поставок серверов стала очень сложной с появлением ИИ-серверов, которые сейчас становятся стоечными системами (например, NVL72), а пул поставщиков очень ограничен в отличие от серверов общего назначения. Кроме того, нелегко внезапно перенести производство в другую страну, и это займёт довольно много времени», — рассказал аналитик. Большую обеспокоенность экспертов вызывает неопределённость ситуации, поскольку Трамп может сегодня заявить о грядущем росте тарифов, а на следующий день отменить своё решение. Главный аналитик Synergy Research Джон Динсдейл (John Dinsdale) сказал ресурсу The Register, что неопределённость — худший аспект для большинства в отрасли. «Во многих отношениях неопределённость хуже, чем уже известные плохие новости. Поэтому я совершенно не сомневаюсь, что операторы ЦОД и поставщики соответствующего оборудования принимают меры для смягчения любых проблем, которые могут возникнуть», — сказал он.

07.04.2025 [09:29], Сергей Карасёв

В России значительно выросло количество сбоев IT-оборудования и системного ПОИсследование, проведённое компанией КРОК, говорит о том, что интенсивность поломок IT-оборудования и сбоев системного ПО в России в течение последних двух лет значительно увеличилась и продолжает расти. Связано это в том числе с устаревающей инфраструктурой, обновление которой затруднено в условиях сформировавшейся геополитической обстановки. В ходе исследования были проанализированы 400 проектов, размещённых на платформе «Контур.Закупки». Кроме того, специалисты КРОК опросили около ста IT-руководителей предприятий крупного бизнеса. Выяснилось, что примерно 80 % крупных компаний использует гибридную IT-инфраструктуру, включающую в себя решения от разных российских и зарубежных поставщиков, а также собственные системы. Из-за этого ухудшается надёжность. Так, почти треть (30 %) респондентов отметили рост количества инцидентов, требующих оперативного привлечения внешних экспертов. Во многих опрошенных организациях наблюдается устаревание оборудования и ПО: определённые компоненты эксплуатируются более восьми лет. В результате, возникает необходимость в обновлении или замене, однако реализовать это в текущих условиях непросто. В частности, нужно выбрать наиболее подходящие продукты, а также провести модернизацию инфраструктуры и приложений с минимальным влиянием на пользователей. На этом фоне около 40 % IT-бюджетов крупных компаний уходит на обновление парка оборудования и ПО, тогда как 46 % технических директоров планируют увеличить затраты на модернизацию инфраструктуры и снижение количества собственных IT-систем. Наблюдающаяся ситуация приводит к трансформации рынка сервис-провайдеров. Так, в 2024 году доля запросов на поддержку оборудования сократилась с 45 % до 32 %, в то время как спрос на поддержку приложений вырос с 18 % до 25 %. Кроме того, крупные компании в три раза чаще стали указывать в своих запросах модернизацию ПО, помимо стандартного набора сервисных услуг по доработке.

07.04.2025 [09:25], Сергей Карасёв

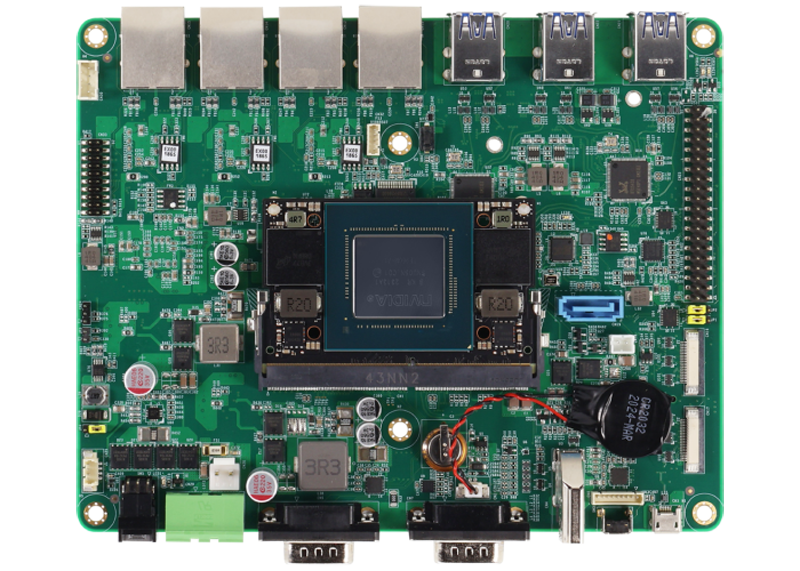

Комплект для ИИ-разработчиков AAEON NV8600-Nano содержит модуль NVIDIA Jetson Orin NanoКомпания AAEON представила под брендом UP комплект NV8600-Nano AI Developer Kit для разработчиков, создающих устройства с поддержкой ИИ. В основу новинки положен модуль NVIDIA Jetson Orin Nano Super с производительностью 67 TOPS (на операциях INT8). Названное изделие содержит процессор с шестью вычислительными ядрами Arm Cortex-A78AE и 8 Гбайт оперативной памяти LPDDR5. Присутствует GPU на архитектуре NVIDIA Ampere с 1024 ядрами CUDA и 32 тензорными ядрами. Интерфейсная плата набора NV8600-Nano AI Developer Kit располагает четырьмя сетевыми портами 1GbE с опциональной поддержкой PoE (25,6 Вт на каждый порт), шестью разъёмами USB 3.2 Gen2 Type-A, коннектором HDMI 1.4a, последовательным портом RS-232(RX/TX/GND)/422/485, SATA-разъёмом для подключения накопителя, двумя коннекторами MIPI-CSI, а также 40-контактной колодкой, совместимой с NVIDIA Jetson Orin Nano Developer Kit.

Источник изображения: AAEON На тыльной стороне платы находятся коннекторы M.2 2230 E-Key для комбинированного модуля Wi-Fi / Bluetooth, M.2 2242/3042/3052 B-Key (плюс слот для SIM-карт) для сотового модема и M.2 2280 M-Key для накопителя. Установлен NVMe SSD вместимостью 256 Гбайт. Диапазон рабочих температур простирается от -25 до +70 °C. Габариты составляют 166 × 133 мм, масса — около 190 г. В комплект поставки входят внешний адаптер питания мощностью 60 Вт, кулер с радиатором и вентилятором, а также камера Raspberry Pi Camera Module 2. Говорится о совместимости с Linux (NVIDIA Jetpack 6.0 и выше). Приобрести набор NV8600-Nano AI Developer Kit можно по ориентировочной цене $650.

07.04.2025 [09:23], Сергей Карасёв

Госзаказчиков в РФ могут обязать закупать серверы по 100 % предоплатеПервый заместитель председателя правительства России Денис Мантуров, как сообщает газета «Коммерсантъ», поручил Минпромторгу и Минфину разработать проект постановления, предусматривающий внесение аванса в размере 100 % по государственным контрактам на поставку отдельных видов российской радиоэлектронной продукции. Новые требования затронут государственных и муниципальных заказчиков. Ранее российские производители электроники пожаловались на слабые продажи, а также на недостаточную загруженность мощностей по выпуску продукции. С целью решения проблем, как считает автономная некоммерческая организация «Вычислительная техника» (АНО ВТ; входят YADRO, «Аквариус», Kraftway и др.), необходимо принятие дополнительных мер поддержки, включая госсубсидии и ограничение параллельного импорта. В соответствии с поручением Мантурова, предоплата в размере 100 % при госзакупках распространится на серверы, компьютеры и некоторые другие виды продукции. Кроме того, предлагается исключить из списка параллельного импорта ряд иностранных поставщиков. Ожидается, что это повысит конкурентоспособность российских производителей и укрепит их позиции на внутреннем и внешнем рынках. Кроме того, полное авансирование госзаказа позволит частично нивелировать негативный эффект от высокой ключевой ставки Банка России, которая составляет 21 %. В компании Fplus (производитель электроники) полагают, что введение авансовых платежей при госзакупках поможет покрыть расходы производителей на покупку компонентов и прочие издержки. С другой стороны, считает вице-президент, директор по закупкам «Ростелекома», 100 % предоплата не стимулирует предприятия к своевременной и качественной поставке продукции — такая модель «необязательна для отечественной электронной промышленности, поскольку в стоимость товара уже заложена маржа, не требующая предоплаты».

07.04.2025 [08:36], Руслан Авдеев

Google, Meta✴, Microsoft и Amazon намерены закупать «зелёную» сталь для своих ЦОДКомпания Google присоединилась к коалиции Sustainable Steel Buyers Platform (SSBP), организованной американской НКО RMI, занимающейся вопросами «зелёной» энергетики и экоустойчивости в целом. В SSBP уже входят Meta✴, Microsoft и Amazon. Вместе с Google она объединяет восемь участников, сообщает Datacenter Dynamics. SSBP призвана объединить усилия крупных корпораций в технологическом, строительном и производственном секторе для продвижения закупки в Северной Америке стали, выпускаемой с низкими углеродными выбросами. Группа названа «первой в своём роде». Она заработала при поддержке нескольких партнёров, имеющих опыт работы с экопроектами: First Mover Coalition, Climate Group и Responsible Steel. В III квартале 2023 года платформа запросила информацию о технологиях производства стали предприятиями соответствующего профиля, в том числе данных о наличии технологий с почти нулевыми выбросами. После этого был объявлен запрос предложений (RFP), чтобы упростить прямые закупки «экологичной» стали, согласовать спрос с техническими требованиями и решить проблемы измерения, проверки и отчётности по выбросам.

Источник изображения: Viktor Forgacs/unspalsh.com Запрос предложений был открыт для всех производителей железа и стали, а также их партнёров по цепочке поставок. Цель — найти поставщиков, способных поставить североамериканским заказчикам от 1 до 2 млн тонн «зелёной» стали с почти нулевыми выбросами к 2030 году. Участники должны соблюдать строгие нормы выбросов на уровне производства и предоставлять прозрачные данные о жизненном цикле продукции. После закрытия RFP покупатели могут заключать индивидуальные соглашения о закупке на основе согласованной «зелёной премии», спецификаций стали и других условий. Сталь является критически важным материалом в создании дата-центров. Она применяется не только при возведении зданий, но и для производства стоек, систем охлаждения, генерации энергии и др. AWS уже выразила приверженность использованию «зелёной» стали, после оформления партнёрства с SSAB в ноябре прошлого года. Проект AWS предусматривает использование экобезопасной стали в одном из трёх своих новых ЦОД в Швеции. «Зелёная» сталь будет применяться при укладке крыши и создания стен в ЦОД AWS Västerås. Поставками материала займётся подразделение SSAB — Ruukki Construction.

06.04.2025 [23:05], Руслан Авдеев

TikTok окончательно «заселилась» в норвежский кампус ЦОД Green Mountain

bytedance

green mountain

hardware

tiktok

информационная безопасность

конфиденциальность

норвегия

цод

Серверы TikTok заработали во всех трёх дата-центрах кампуса Green Mountain OSL2-Hamar в Норвегии. Речь идёт о части т. н. Project Clover — инициативы стоимостью €12 млрд ($13,2 млрд), призванной обеспечить хранение данных европейских пользователей в границах Европы. Кроме того, проект должен отвечать европейским стандартам безопасности, сообщает Datacenter Dynamics. В рамках Project Clover компания также использует ЦОД в Ирландии, который заработал в 2023 году. Планы Green Mountain по обеспечению социальной сети новыми дата-центрами были оглашены в марте 2023 года. Первый из них собирались ввести в эксплуатацию во II квартале 2024-го, однако в итоге партнёрам пришлось несколько отклониться от планов — европейские данные начали перемещать в новый кампус только в октябре-ноябре 2024 года. Летом того же года представитель Green Mountain заявлял, что реализация проекта замедлилась из-за проблем с получением разрешений для новой электроподстанции. После того, как в Норвегии заработали все три дата-центра, TikTok наняла европейскую компанию NCC Group для независимой проверки и верификации безопасности хранения, обработки и передачи данных, заявив, что такой уровень прозрачности недостижим для других онлайн-платформ. Также социальная сеть работает с Green Mountain над возможностью передачи тепла ЦОД на нужды отопления местных объектов. Для обслуживания трёх ЦОД пришлось нанять около 200 человек, включая IT-специалистов, электриков и экспертов в области систем охлаждения. Тем временем в минувшую пятницу президент США издал указ, продляющий работу социальной сети на территории США ещё на 75 дней — для того, чтобы ту можно было «честно» продать американскому бизнесу — речь идёт о продаже американской части сети под предлогом защиты конфиденциальности данных американцев. С 2022 года в рамках Project Texas данные американских пользователей хранятся только на серверах Oracle.

06.04.2025 [14:05], Сергей Карасёв

Начато создание европейского суперкомпьютера Daedalus с производительностью 89 ПфлопсЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) сообщило о подписании соглашения с компанией НРЕ на создание суперкомпьютера Daedalus, который расположится в Греции и будет интегрирован с ИИ-фабрикой Pharos. Контракт с НРЕ заключён при участии Национальной инфраструктуры исследований и технологий GRNET S.A. в Афинах. Общая стоимость создания Daedalus оценивается в €36 млн. Из этой суммы 35 % предоставит EuroHPC JU, а остальные 65 % будут привлечены в рамках Национального плана восстановления и обеспечения устойчивости «Греция 2.0». В проекте также участвуют Кипр, Черногория и Северная Македония, вошедшие в специально сформированный консорциум Daedalus. Производительность нового суперкомпьютера составит более 89 Пфлопс (FP64). С таким показателем быстродействия в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500 комплекс Daedalus мог бы занять 17-е или 18-е место. Для НРС-платформы предусмотрено применение возобновляемых источников энергии и передовых систем охлаждения, которые значительно повысят энергетическую эффективность. Суперкомпьютер Daedalus станет доступен в начале 2026 года широкому кругу пользователей по всей Европе, включая научное сообщество, промышленную сферу и государственный сектор. Машина расположится в новом дата-центре в здании бывшей электростанции Технологического культурного парка Лаврион Национального технического университета Афин (NTUA). Доступ к вычислительным ресурсам комплекса будет совместно управляться EuroHPC JU и консорциумом Daedalus пропорционально их инвестициям. Ожидается, что Daedalus ускорит научные достижения Европы в различных областях, включая ИИ, медицину, метеорологию, анализ больших данных и разработку интеллектуальных транспортных систем. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они разместятся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Аналогичные комплексы также появятся в Австрии, Болгарии, Франции, Германии, Польше и Словении.

06.04.2025 [13:55], Сергей Карасёв

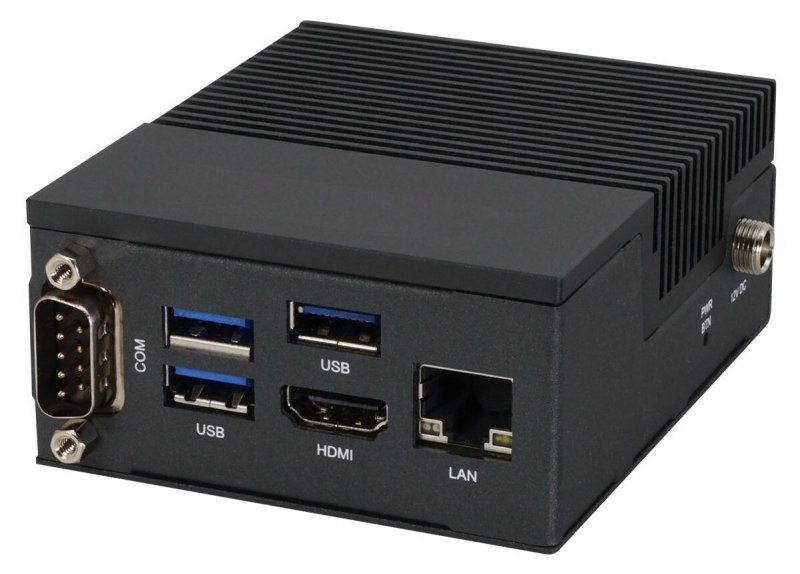

AAEON выпустила сверхкомпактный промышленный компьютер UP 710S EdgeКомпания AAEON анонсировала промышленный мини-компьютер UP 710S Edge — своё самое компактное решение, выполненное на аппаратной платформе Intel Alder Lake-N. Устройство заключено в корпус с габаритами 92 × 77 × 38,5 мм, а масса составляет около 0,3 кг. В зависимости от модификации применяется чип Intel Processor N200 (4C/4T; до 3,7 ГГц; 6 Вт), Intel Processor N100 (4C/4T; до 3,4 ГГц; 6 Вт), Intel Processor N97 (4C/4T; до 3,6 ГГц; 12 Вт) или Intel Processor N50 (2C/2T; до 3,4 ГГц; 6 Вт). Используется интегрированный графический контроллер Intel UHD. Объём оперативной памяти LPDDR5 достигает 8 Гбайт. Новинка наделена флеш-модулем eMMC вместимостью до 64 Гбайт. Есть слот M.2 2230 E-Key (PCIe x1, USB 2.0), в который может быть установлен комбинированный модуль Wi-Fi / Bluetooth. Имеется сетевой контроллер 1GbE с разъёмом RJ45. Устройство располагает тремя портами USB 3.2 Gen2 Type-A, интерфейсом HDMI 1.4b, последовательным портом RS-232/422/485, а также колодкой GPIO (PWM, I2C, SPI). Предусмотрен модуль TPM 2.0. Устройство довольствуется пассивным охлаждением, а ребристая поверхность корпуса выполняет функции радиатора. Диапазон рабочих температур простирается от -5 до +60 °C. Допускается монтаж посредством крепления VESA или DIN-рейки. Питание (12 В) подаётся через DC-разъём. Заявлена совместимость с Windows 11 IoT Enterprise 24H2 LTSC, Ubuntu 22.04.4+ LTS и Yocto 4.0. Новинка может использоваться, например, в качестве шлюза IoT.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

05.04.2025 [10:35], Сергей Карасёв

Представлен первый в Китае высокопроизводительный процессор RISC-V для серверов — чип LingyuКитайская компания RiVAI Technologies, по сообщению ресурса Tom's Hardware, представила первый высокопроизводительный серверный процессор с открытой архитектурой RISC-V, полностью разработанный в КНР. Презентация изделия под названием Lingyu состоялась в Шэньчжэне: появление чипа отражает стремление страны к снижению зависимости от зарубежных изделий в условиях усиливающихся санкций со стороны США. Чип Lingyu насчитывает в общей сложности 40 ядер. Это 32 универсальных вычислительных ядра (CPU) и восемь специализированных ядер (LPU), предназначенных для нагрузок, связанных с ИИ, включая работу с большими языковыми моделями (LLM). Такая конфигурация ориентирована на достижение баланса между производительностью и энергоэффективностью, благодаря чему снижается общая стоимость владения (TCO). Прочие характеристики процессора пока не раскрываются. Основателем компании RiVAI Technologies является Чжанси Тан (Zhangxi Tan). Он получал образование под наставничеством Дэвида Паттерсона (David Patterson) — американского учёного в области информатики, профессора Калифорнийского университета в Беркли (UC Berkeley) и лауреата премии Тьюринга 2017 года. Паттерсон, разработавший в 1990–2000 гг. несколько вариантов RISC-архитектур, выступает в качестве консультанта RiVAI Technologies. Отмечается, что RiVAI Technologies заключила партнёрские соглашения с более чем 50 компаниями, включая Lenovo и SenseTime, с целью развития экосистемы вокруг своих чипов RISC-V. Сотрудничество направлено на внедрение Lingyu в различных отраслях. Предполагается, что усилия будут способствовать дальнейшему развитию RISC-V в Китае. В целом, КНР ведёт активные исследования и разработки в области RISC-V. В частности, ранее ряд китайских компаний, включая T-Head (принадлежит гиганту Alibaba Group Holding), Shanghai Shiqing Technology, Juquan Optoelectronics, Xinsiyuan Microelectronics и StarFive, сформировали патентный альянс в сфере RISC-V. Кроме того, Пекин планирует запустить государственную программу с целью стимулирования широкого использования RISC-V по всей стране. Разработкой RISC-V-процессоров занимается Китайская академия наук. |

|