Материалы по тегу: hardware

|

09.04.2025 [11:48], Сергей Карасёв

Kingston выпустила SSD серии DC3000ME с интерфейсом PCIe 5.0 для дата-центровКомпания Kingston анонсировала SSD семейства DC3000ME, ориентированные на корпоративный сектор. Накопители могут применяться в составе облачных платформ и систем, предназначенных для задачи ИИ, НРС, периферийных приложений и пр. Устройства выполнены в форм-факторе SFF U.2 с толщиной 15 мм. Для обмена данными служит интерфейс PCIe 5.0 x4 (NVMe). В основу положены чипы флеш-памяти 3D eTLC NAND. Реализована поддержка TCG Opal 2.0 и AES-256. В серию DC3000ME вошли модели вместимостью 3,84, 7,68 и 15,36 Тбайт. Скорость последовательного чтения информации у всех достигает 14 000 Мбайт/с, а скорость последовательной записи — 5800, 10 000 и 9700 Мбайт/с соответственно. Величина IOPS (операций ввода/вывода в секунду) при произвольных чтении/записи блоками по 4 Кбайт у перечисленных устройств составляет до 2,7 млн / 300 тыс., 2,8 млн / 500 тыс. и 2,7 млн / 400 тыс. Все накопители способны выдерживать до одной полной перезаписи в сутки (1 DWPD) на протяжении пяти лет. Гарантированный объём записанной информации (величина TBW) достигает 7008 Тбайт у версии на 3,84 Тбайт, 14 016 Тбайт у модификации вместимостью 7,68 Тбайт и 28 032 Тбайт у варианта на 15,36 Тбайт. Значение MTBF (средняя наработка на отказ) заявлено на уровне 2 млн часов. SSD семейства DC3000ME имеют габариты 100,5 × 69,8 × 14,8 мм. Диапазон рабочих температур простирается от 0 до +70 °C. Максимальное энергопотребление при записи составляет 24 Вт, при чтении — 8,2 Вт, при простое — 8 Вт. Упомянуты средства Power Loss Protection (PLP), которые отвечают за сохранность данных при внезапном отключении питания.

09.04.2025 [08:26], Владимир Мироненко

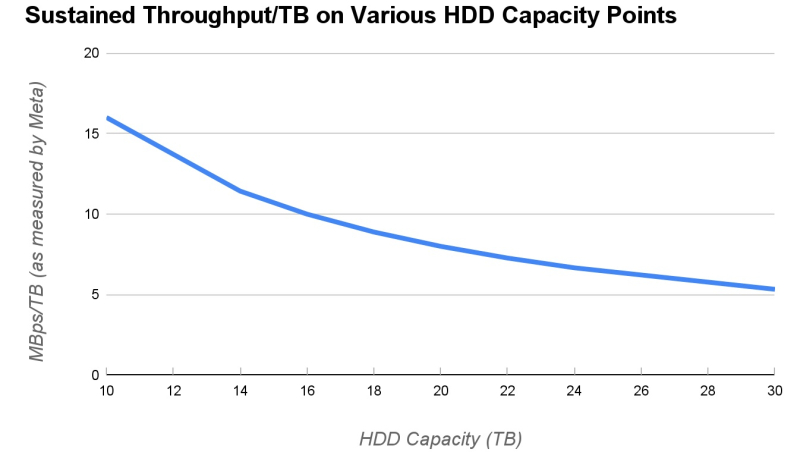

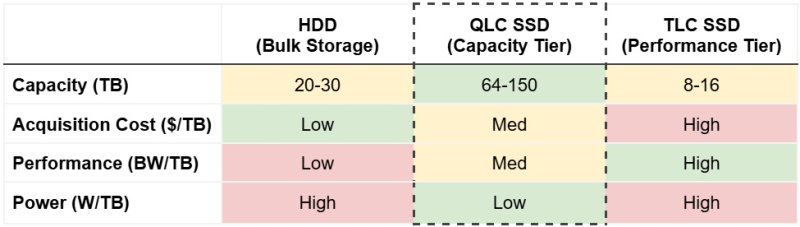

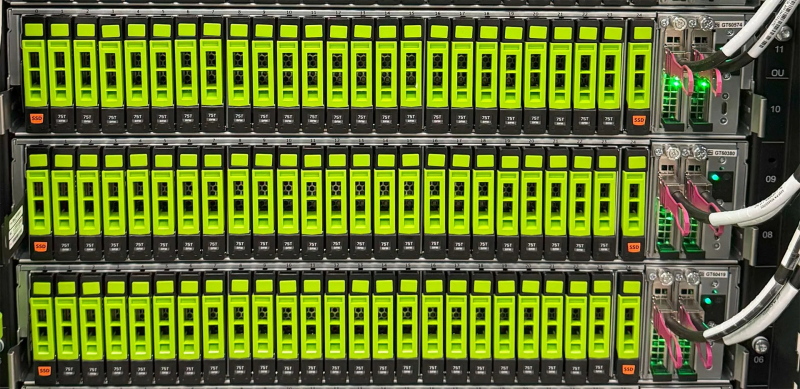

QLC SSD начали вытеснять HDD из дата-центров Meta✴ — они более ёмкие и эффективныеВ ходе последнего квартального отчёта Pure Storage с гордостью сообщила о заключении сделки с неназванным гиперскейлером, что позволило внедрить её решения DirectFlash в крупномасштабные среды, где традиционно доминируют жёсткие диски. Как и предполагалось, речь шла о сделке с Meta✴, которой Pure поставит фирменные флеш-накопители, пишет ресурс Blocks & Files. Подразумевается, что закупки HDD гиперскейлером существенно снизятся в результате этой сделки. Сама Pure Storage надеется, что после 2028 года SSD полностью вытеснят HDD из ЦОД. Blocks & Files также отмечает, что финансовые аналитики Wedbush рассматривают сделку как «чрезвычайно позитивный результат для Pure Storage, учитывая существенное количество Эбайт, который она, вероятно, поставит» По словам Pure, её технология «станет стандартом де-факто для хранения данных Meta✴, за исключением некоторых очень требовательных нагрузок». Blocks & Files полагает, что Meta✴ работает с Pure Storage над накопителями, контроллерами и управляющим ПО (Purity), так что поставщикам готовых массивов All-Flash, по-видимому, не удастся заключить крупные контракты с Meta✴. Pure Storage утверждает, что её проприетарные QLC-накопители DFM (Direct Flash Module) ёмкостью 150 Тбайт (а вскоре и 300 Тбайт) позволят значительно сэкономить место в стойке и снизить затраты на питание и охлаждение по сравнению с хранением стольких же Эбайт данных на жёстких дисках ёмкостью 30–50 Тбайт. В блоге Pure Storage говорится, что «DFM радикально снижают энергопотребление по сравнению с устаревшими решениями на базе HDD, позволяя гиперскейлерам консолидировать несколько уровней хранения на единой платформе».

Источник изображений: Meta✴ Кроме того, «Pure Storage предоставляет гиперскейлерам и предприятиям единую оптимизированную архитектуру, которая поддерживает все уровни хранения, от экономичных архивных решений до высокопроизводительных критически важных рабочих нагрузок и самых требовательных рабочих ИИ-нагрузок, поскольку технология DirectFlash обеспечивает «оптимальный баланс цены, производительности и плотности». В блоге Meta✴ отмечается, что «HDD растут по плотности, но не производительности, а флеш-память TLC остаётся в ценовом диапазоне, который ограничивает масштабирование. Технология QLC решает эти проблемы, занимая промежуточный уровень между HDD и TLC SSD. QLC обеспечивает более высокую плотность, улучшенную энергоэффективность и лучшую стоимость, чем существующие TLC SSD». Также отмечается, что целевые рабочие нагрузки требуют высокой пропускной способности при чтении при сравнительно низких требованиях к пропускной способности при записи. «Поскольку основная часть энергопотребления в любом флеш-носителе NAND приходится на запись, мы ожидаем, что наши рабочие нагрузки будут потреблять меньше энергии с QLC SSD», — сообщили в Meta✴, добавив, что компания сотрудничает с Pure Storage, используя её накопители DFM и платформу DirectFlash для формирования надёжного хранилища на базе QLC. Компания сообщила, что также работает с другими поставщиками NAND для интеграции стандартных NVMe QLC SSD в свои ЦОД. Meta✴ предпочитает форм-фактор U.2 вместо EDSFF E.3, поскольку «он позволяет потенциально масштабировать ёмкость до 512 Тбайт… DFM от Pure Storage можно масштабировать до 600 Тбайт с той же технологией упаковки NAND». Сервер с поддержкой DFM позволяет также использовать накопители в формате U.2. «Эта стратегия позволяет нам извлечь максимальную выгоду из конкуренции по стоимости, скорости внедрения, энергоэффективности и разнообразия поставщиков», — сообщила Meta✴. Таким образом, Meta✴ признаёт потенциал флеш-памяти QLC в области оптимизации стоимости хранения, производительности и энергопотребления для рабочих нагрузок ЦОД. Поскольку поставщики флеш-памяти продолжают инвестировать в развитие памяти и увеличивают объёмы производства QLC, следует ждать существенного снижения затрат на её использование. Это не сулит ничего хорошего для производителей HDD, которые надеются, что технология HAMR позволит сохранить существующую разницу в цене между HDD и SSD. «Мы хотели бы отметить, что хотя Pure Storage, вероятно, вытеснит часть жёстких дисков, мы также считаем, что требования Meta✴ к HDD должны вырасти в 2025–2026 гг.», — сообщили аналитики Wedbush. Другими словами, из-за флеш-памяти Meta✴ пока не стала отказываться от жёстких дисков, но ограничила темпы роста использования HDD. «Любой значимый переход с HDD на SSD в облачных средах, по-видимому, должен привести к более высокому долгосрочному среднегодовому темпу роста флеш-памяти, что в конечном итоге должно положительно сказаться на поставщиках памяти (Kioxia, Micron, Sandisk и т. д.)», — подытожили в Wedbush.

08.04.2025 [17:41], Алексей Степин

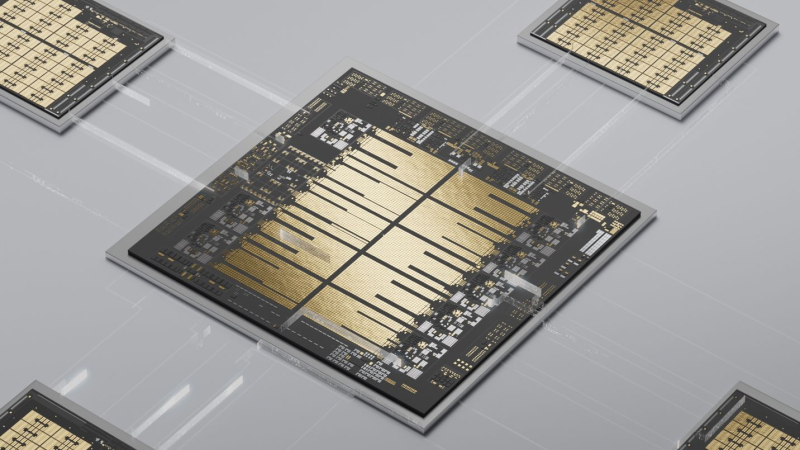

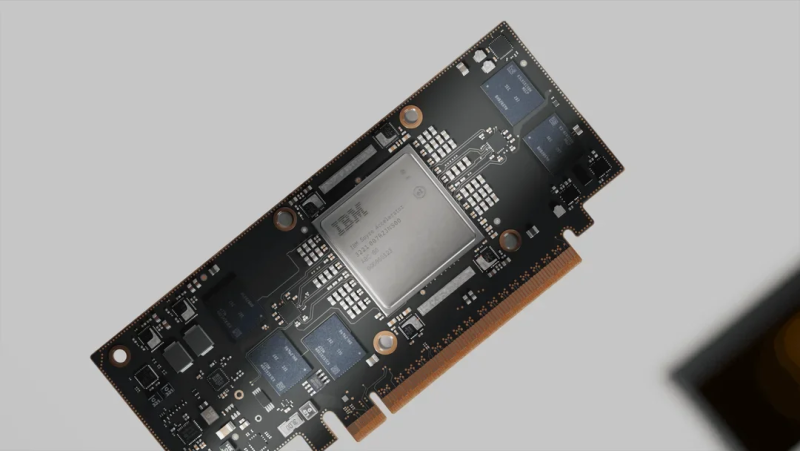

Мейнфрейм для ИИ: IBM представила платформу z17 с восьмиядерными процессорами Telum II и ускорителями SpyreХотя слово «мейнфрейм» и может вызвать ассоциации с катушками магнитной ленты и зелёными символами на экране терминала, системы такого класса продолжают оставаться ключевыми для крупного бизнеса: 71 % компаний из списка Fortune 500 используют для критических задач именно мейнфреймы. Объём рынка мейнфреймов в прошлом году составил $5,3 млрд, так что это весьма лакомый кусок, упускать который главный производитель этих систем, компания IBM, не собирается. Сегодня она анонсировала мейнфреймы z17 — они идут на смену поколению z16 и обладают куда большей производительностью в актуальных на сегодня ИИ-сценариях. В основе новой платформы лежат анонсированные осенью прошлого года процессоры Telum II с архитектурой z/Architecture. Это поколение чипов использует техпроцесс Samsung 5HPP и включает в себя восемь улучшенных ядер Telum с частотой 5,5 ГГц с переработанной и существенно усиленной подсистемой кеширования. Новые веяния в полной мере коснулись Telum II: каждый процессор получил поддержку форматов INT8/FP16, а также ИИ-сопроцессор с производительностью 25 Топс (768 Топс для полностью сконфигурированного мейнфрейма). По нынешним меркам эти цифры не выглядят слишком высокими, однако в составе z17 процессоры Telum II будут работать совместно с 32-ядерными ИИ-ускорителями Spyre. На момент анонса речь идёт о 48 чипах Spyre в составе каждого мейнфрейма z17, что при 300 Топс на ускоритель суммарно даёт 14,4 Попс (петаопс), но в течение года планируется нарастить этот показатель вдвое — до 96 ускорителей на мейнфрейм, что с учётом возможностей самих Telum II даст уже 30 Попс. Переварить объёмы данных, характерные для современных ИИ-моделей платформе поможет интегрированный в Telum II блок DPU. Согласно анонсу, z17 может обработать за день до 450 млрд. инференс-операций, что на 50 % больше показателей предыдущегоz16. При проектировании z17 IBM потратила более 2 тыс. часов, исследуя отклики от более чем сотни клиентов. Компания считает новинку универсальным решением с более чем 250 вариантами использования в ИИ-задачах, в том числе в качестве платформы для генеративного ИИ.  Первые поставки z17 начнутся 18 июня, однако пока без плат ускорителей Spyre — последние дебютируют позднее, в IV квартале. Для новой платформы IBM готовит и новую операционную систему z/OS 3.2, которая должна дебютировать в III квартале. В ней появится родная поддержка аппаратных ускорителей ИИ, а также ИИ-элементы управления самой системой. Кроме того, в z/OS 3.2 будет реализована поддержка новых типов доступа к данным, баз данных типа NoSQL, а также гибридных облачных вычислений.

08.04.2025 [15:42], Руслан Авдеев

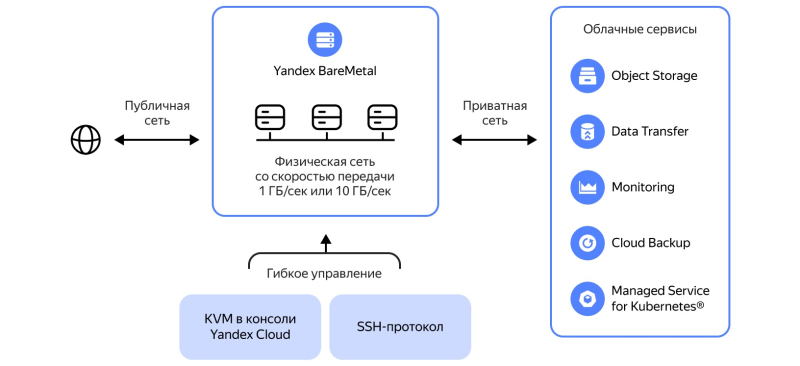

В Yandex Cloud появились серверы Bare MetalВ Yandex Cloud стал доступен сервис аренды выделенных физических серверов Yandex BareMetal. Посредством Cloud Interconnect их можно интегрировать с другими облачными сервисами и инфраструктурами, формируя единую вычислительную среду. Как сообщает пресс-служба компании, «в публичном превью с сервисом можно работать по API» — это упростит интеграцию Yandex BareMetal с бизнес-приложениями «Яндекса». Дополнительно сообщается, что права доступа к серверу можно гранулярно распределять между сотрудниками. По словам представителя Yandex Cloud, у компании большая команда инженеров, годами поддерживающих серверную инфраструктуру. Этот опыт «инвестирован» в Yandex BareMetal, поэтому компании могут полностью доверить обслуживание железа провайдеру, сосредоточившись на развитии IT-продуктов. Кроме того, для Yandex BareMetal доступны облачные инструменты резервного копирования, миграции данных и мониторинга. По статистике Yandex Cloud, 59 % компаний из России начали пользоваться сервисами BareMetal лишь в последние полтора года. Причина в том, что в этот период у бизнеса стало меньше ресурсов и возможностей для самостоятельной закупки оборудования и его обслуживания. Кроме того, вырос спрос на инфраструктуру для развития ИИ. Наиболее распространённый сценарий применения BareMetal — для хранения и обработки данных. 70 % респондентов используют арендуемую инфраструктуру именно для этого, 66 % применяют выделенные серверы для собственных развёртываний OpenStack или VMware, 47 % — для хостинга бизнес-приложений и 44 % — для задач бэкофиса. В любом случае респонденты отмечали значимость возможной интеграции BareMetal с технологиями защиты от DDoS-атак (59%), резервного копирования (48 %) и 46 % — интеграции с т.н. «облачным роутером» — сетью между выделенными серверами и облаками провайдера. В марте «Яндекс» впервыеотчиталась о результатах работы Yandex B2B Tech. Выручка Yandex Cloud увеличилась год к году в 1,5 раза, составив 19,8 млрд руб. 51 % суммы принесли контракты с крупными компаниями. Количество клиентов Yandex Cloud увеличилось год к году в 1,5 раза до 44 тыс., количество партнёров-интеграторов выросло в 1,3 раза — до 674.

08.04.2025 [14:11], Руслан Авдеев

Meta✴ планирует потратить почти $1 млрд на ЦОД в ВисконсинеMeta✴ Platforms намерена потратить около $1 млрд на строительство кампуса ЦОД в Висконсине (США). Это лишь часть проекта IT-гиганта по наращиванию инвестиций в ИИ и облачную инфраструктуру, сообщает Bloomberg. По информации издания, в феврале штат заключил «стимулирующую» сделку с неназванной компанией, предусматривающей строительство кампуса ЦОД с многолетними инвестициями общим объёмом $837 млн. По данным источников, за проектом стоит именно Meta✴. В самом IT-гиганте информацию комментировать отказались, а представитель Wisconsin Economic Development Corporation заявил, что традиционно принято публично называть компании, с которыми заключен договор только после того, как получено официальное одобрение сделки. В последние годы ключевые IT-компании стремятся увеличить ёмкость доступных дата-центров для удовлетворения запроса на облачные вычислительные мощности, также учитывая рост сложности ИИ-моделей. Meta✴ заявила, что всего в текущем году намерена потратить до $65 млрд на инфраструктуру, основной фокус — на ИИ ЦОД, в том числе крупный кампус в Луизиане. У IT-гигант уже есть дата-центры на Среднем Западе, в том числе в Айове и в Иллинойсе.

Источник изображения: taro ohtani/unsplash.com Впрочем, инвесторы задаются вопросом — стоит ли строить новые ЦОД, особенно на фоне отказа Microsoft от некоторых своих проектов, развития семейств менее ресурсоёмких ИИ-моделей, а также потенциального негативного эффекта от пошлин, вводимых администрацией США. Meta✴ применяет ИИ во всех сферах своего бизнеса, от подбора контента в лентах пользователей соцсетей до таргетирования рекламы. Также ИИ применяется и в пользовательском оборудовании, от AR-гарнитур Meta✴ Quest до серии очков Ray-Ban Meta✴. В январе глава компании Марк Цукерберг (Mark Zuckerberg) заявил, что Meta✴, вероятно, потратит на ИИ сотни миллиардов долларов. В феврале власти города Бивер-Дам (Beaver Dam) в лице Beaver Dam Area Development Corporation сообщили, что планируют с Alliant Energy строительство ЦОД стоимостью около $500 млн. Сообщалось, что предварительно одобрены соглашения о строительстве и водоснабжении, но пока требуется разрешение центральных органов власти США. Для проекта Stargate компании OpenAI Висконсин также назван в качестве одной из локаций для строительства наряду с, например, Техасом.

08.04.2025 [13:29], Сергей Карасёв

Eviden создаст для Сербии суперкомпьютер стоимостью €36 млнВласти Сербии, по сообщению ресурса Datacenter Dynamics, заключили контракт с Eviden (подразделение Atos Group) на создание нового суперкомпьютера. Речь идёт о приобретении системы BullSequana последнего поколения, которая будет поставлена к концу текущего года. Технические подробности проекта пока не раскрываются. Отмечается лишь, что контракт с Eviden является частью более широкого соглашения стоимостью €50 млн, подписанного между правительствами Сербии и Франции. Из этой суммы €36 млн пойдёт непосредственно на создание суперкомпьютера. Оставшаяся часть средств будет потрачена на ИИ-инициативы в таких сферах, как здравоохранение, энергетика, транспорт и государственное управление. На сегодняшний день, как отмечается, Сербия эксплуатирует как минимум один неназванный НРС-комплекс, созданный NVIDIA и размещённый в государственном дата-центре в Крагуеваце (столица административного региона Шумадия). Система, запущенная в декабре 2021 года, обошлась в €30 млн. В перспективе в модернизацию этого суперкомпьютера планируется инвестировать €40 млн, что позволит поднять его производительность в семь раз.

Источник изображения: Правительство Сербии Глава сербского управления по IT и электронному правительству Михайло Йованович (Mihailo Jovanovic) заявил, что новый суперкомпьютер, поставкой которого займётся Eviden, будет насчитывать «в 20 раз больше чипов, чем [нынешняя] система NVIDIA», и получит почти в 30 раз больше памяти. Какие именно чипы имеются в виду, Йованович уточнять не стал. Работа над государственным ЦОД в Крагуеваце стоимостью €30 млн началась в 2019 году, а открытие состоялось в 2020-м. Дата-центр состоит из двух объектов общей площадью около 14 тыс. м2 — это примерно в пять раз больше по сравнению с прежней ЦОД-площадкой в Белграде. Комплекс в Крагуеваце соответствует стандарту Tier IV: он предоставляет услуги хостинга для предприятий и правительственных структур.

08.04.2025 [11:42], Сергей Карасёв

Стоечное хранилище Blackmagic Cloud Backup 8 рассчитано на SATA-накопителиКомпания Blackmagic Design анонсировала стоечную систему хранения Cloud Backup 8, предназначенную прежде всего для резервного копирования и архивирования медиафайлов и проектов DaVinci Resolve. Устройство доступно для заказа по ориентировочной цене $1500. Новинка выполнена в форм-факторе 1U. Во фронтальной части располагаются восемь отсеков для HDD типоразмера LFF с интерфейсом SATA-3. Предусмотрена светодиодная индикация состояния накопителей: каждый слот подсвечивается световым кольцом, которое даёт наглядное представление об активности. Есть дополнительная защитная планка для фиксации дисков на месте. Система располагает четырьмя сетевыми портами 10GbE с разъёмами RJ45. Кроме того, есть порт USB 3.0 Type-C с поддержкой Ethernet Over USB. Заявленное энергопотребление составляет 180 Вт. Диапазон рабочих температур — от 0 до +40 °C. Новинка оснащена интерфейсом HDMI (1080p50, 1080p59.94, 1080p60): через него на мониторе или телевизоре может отображаться подробная информация о работе установленных HDD, загруженности сетевых подключений, подключенных пользователях и пр. Говорится о совместимости с Windows 10/11 и macOS 14/15 и выше. Реализована поддержка SMB 3 Multichannel. Одним из основных преимуществ платформы Cloud Backup 8 перед облачными хранилищами разработчик называет полное отсутствие подписок и каких-либо ежемесячных сборов. Пользователи получают локальный контроль над системой, что обеспечивает улучшенную безопасность: устройство можно применять без подключения к интернету.

08.04.2025 [08:30], Владимир Мироненко

Поставщики памяти, накопителей и СХД в основном проиграют от торговой войны СШАВведение президентом США пошлин отразится на американских компаниях, у которых компоненты многонациональной цепочки поставок и готовая продукция импортируются в Америку, а также на цене продукции иностранных поставщиков, импортируемой в США, пишет ресурс Blocks & Files. Торговая война также затронет американских поставщиков систем хранения, экспортирующих в те страны, которые в ответ тоже повышают пошлины. Таким образом, можно говорить о трёх группах компаний, которые столкнутся с различными проблемами после роста пошлин. США назначили Китаю самую высокую пошлину в 54 %. И это не предел, поскольку в связи с решением Китая повысить в ответ пошлины на 34 % США, в свою очередь, могут повысить ставку до 104 %, пишет The Register. За Китаем следует Камбоджа с пошлиной в 49 %, Лаос — 48 %, Вьетнам — 46 %, Таиланд — 37 %, Индонезия и Тайвань — по 32 %, Индия — 27 %, Южная Корея — 26 %, Япония — 24 %, Евросоюз — 18,5 %, Филиппины — 18 %. Среди компаний, поставляющих товары в США, введение пошлин может затронуть поставщиков DRAM, NAND, SSD, лент и ленточных приводов, а также тех, кто производит контроллеры СХД и серверные процессоры. Следует учесть, что согласно приложению II Гармонизированного тарифного графика США (HTSUS), полупроводниковые чипы освобождены от пошлин, но не товары, которые содержат их в качестве компонентов. Так, Micron производит DRAM, NAND и SSD. DRAM выпускается в Бойсе (штат Айдахо), а также в Японии, Сингапуре и на Тайване. Освобождение от пошлин может применяться к чипам DRAM и NAND, но не обязательно к SSD, содержащим NAND, поскольку для них нет специального освобождения. На товары будут действовать пошлины для страны происхождения, установленные администрацией США. Samsung, производит DRAM и NAND в основном в Южной Корее, но часть NAND выпускается в Китае. Сборка SSD сосредоточена в Южной Корее, поэтому они, скорее всего, подпадают под 26-% пошлину. SK hynix, производит чипы DRAM, NAND и SSD в Южной Корее, в то время как её дочерняя компания Solidigm производит SSD в Китае. То есть на её ценах отразится 54-% пошлина на SSD из Китая и 26-% — на продукцию из Южной Кореи. Kioxia, производит NAND и SSD в Японии, при ввозе в США её продукты будут облагаться 24-% пошлиной. NAND-память SanDisk производится в Японии (совместно с Kioxia), но часть SSD выпускается на заводах в Китае, что подразумевает применение 54-% пошлины. Это означает, что SSD Kioxia, Samsung и SK hynix, могут оказаться дешевле, чем SSD Sandisk, а вот SSD Solidigm — нет.

Источник изображения: The New York Public Library / Unsplash У HDD Seagate довольно сложная и интегрированная международная цепочка поставок, включающая Китай, Таиланд, Сингапур и Малайзию. Компания производит пластины для дисков и часть самих HDD (например, Exos) в Китае, а двигатели, узлы привода головок и жёсткие диски других серий — в Таиланде. Кроме того, пластины и некоторые другие диски собираются в Сингапуре и Малайзии. Новые пошлины будут применяться при импорте дисков в США и будут зависесть от страны происхождения. Столь резкое увеличение цен из-за пошлин может вызвать шок у клиентов, отметил ресурс Blocks & Files. Western Digital собирает свои диски в Малайзии и Таиланде, и поэтому столкнётся с пошлинами в размере 24 % и 36 % соответственно. Жёсткие диски Toshiba производятся в Китае, на Филиппинах и в Японии, что подразумевает импортные пошлины США в размере 54, 18 и 24 % соответственно. Записываемые диски Blu-ray и DVD производятся в Китае, Индии, Японии и на Тайване — они точно так же будут облагаться пошлинами в зависимости от страны выпуска. IBM производит ленточные накопители, проприетарные и LTO, в Тусоне (штат Аризона), поэтому её коснутся только пошлины на любые компоненты иностранного производства, которые она будет импортировать. Fujifilm производит LTO-накопители в Бедфорде (штат Массачусетс), а Sony — в Японии, что означает 24-процентную пошлину на ввоз в США. Fujifilm — в выигрыше от ввода пошлин, а Sony — наоборот. Контроллеры хранения данных и серверные процессоры в основном производятся Intel, некоторые — компанией AMD. У Intel есть фабрики в Орегоне (Хиллсборо), Аризоне (Чандлер) и Нью-Мексико (Рио-Ранчо). Сборочные, испытательные и упаковочные мощности для CPU имеются в Израиле, Малайзии, Вьетнаме, Китае и Коста-Рике. Часть продукции выпускается завод в графстве Килдэр (Ирландия). AMD во много зависит от тайваньских фабрик TSMC. Однако обе компании, а заодно и производители Arm-чипов, пошлины не затронут. Зато экспорт в Китай подпадёт под ответные 34-% пошлины. Массивы хранения данных в основном производятся в США, где находятся все производства Dell, HPE и NetApp. А вот Hitachi Vantara производит свои хранилища в Японии, поэтому на них будет действовать 24-%. СХД Lenovo фактически являются OEM-массивами NetApp, поэтому она может избежать пошлин. СХД Infinidat выпускаются на производственных мощностях Arrow Electronics, которая имеет глобальную цепочку поставок с США в роли главного хаба. Где именно по факту производятся массивы, Infinidat не говорит. Поставщики неамериканских СХД в США столкнутся с пошлинами в зависимости от страны их базирования. Чтобы избежать этого, компании могут инвестировать в американские подразделения, хотя для многих в нынешней ситуации это может быть не очень целесообразно. Третья группа поставщиков СХД — это американские компании, экспортирующие продукцию, например, в Китай, который в ответ повышает собственные пошлины на ввоз товаров из США — с 10 апреля она составит 34 %. Одним из победителей в этой торговой войне Blocks & Files назвал Huawei, которая не поставляет товары в США.

07.04.2025 [17:30], Руслан Авдеев

AirTrunk будет снабжать свои ЦОД в Малайзии переработанными сточными водамиОператор AirTrunk заключил соглашение с принадлежащей штату Джохор (Малайзия) водоснабжающей компанией Johor Special Water (JSW). Совместно будет реализована инициатива по снабжению кампусов JHB1 и JHB2 переработанными сточными водами, сообщает Datacenter Dynamics. По данным партнёров, проект — крупнейший в своём роде для Малайзии. Вода, в частности будет использоваться для СЖО в дата-центре JHB1, развёрнутой в прошлом году. Очищенная на месте вода будет обеспечивать потребности дата-центров AirTrunk в Джохоре, а традиционные водные ресурсы планируется сохранить для местных жителей. Как заявляют в компании, сотрудничество с местными подрядчиками способствует экономическому росту штата. Соглашение также предусматривает значимые инвестиции компании в развитие очистных мощностей и водопроводной инфраструктуры региона. Кампус JHB1 заработал в июле 2024 года. На начальных стадиях он обеспечивает более 50 МВт ёмкости для крупных клиентов. Площадь 20 помещений превышает 22 тыс. м2. Со временем ЦОД вырастет до 150 МВт. Строительство 270-МВт кампуса JHB2 в городе Искандар Путери (Iskandar Puteri), тоже в Джохоре, было анонсировано в феврале. Таким образом, общие инвестиции компании в Малайзию вырастут до RM9,7 млрд ($2,2 млрд). В прошлом сентябре Blackstone и Canada Pension Plan Investment Board приобрели AirTrunk за $16,1 млрд, что стало рекордной сделкой в отрасли.

Источник изображения: Ajay Kumar Jana/unsplash.com В последние годы использование переработанных сточных вод для охлаждения ЦОД становится всё популярнее. Обычно дата-центры применяют питьевую воду. При этом из-за обработки воды химикатами для ЦОД для удаления бактерий и накипи, вода становится непригодной для питья после прохождения через системы объектов. В результате операторы ЦОД обратили внимание на переработанные сточные воды, которые проходят многоступенчатый процесс очистки, устраняющий 99 % загрязнений. AWS, Google, Microsoft и Meta✴ все активно применяют технологии переработки сточных вод и намерены стать «водно-положительными» к 2030 году.

07.04.2025 [11:38], Руслан Авдеев

Министерство энергетики США приглашает строить ЦОД на своих землях — но могут помешать новые пошлиныВ Министерстве энергетики США (DoE) выступили с новой инициативой — власти готовы выделить собственные земли для строительства ЦОД рядом с энергогенерирующими мощностями. Представители министерства сообщают, что действуют в соответствии с указами президента, связанными с энергетикой, а также призванными устранить барьеры, мешающие развитию ИИ, сообщает The Register. Всего выбрано 16 площадок для быстрого строительства дата-центров на федеральных землях. Проблема в том, что новые тарифы, введённые самим президентом в отношении большинства стран мира, могут помешать реализации новых планов. По мнению аналитиков, техногиганты, готовые к инвестициям, могут столкнуться с серьёзными трудностями, поскольку ключевые поставщики оборудования находятся в Китае, на Тайване и в Южной Корее. Высокие пошлины повысят цены на ключевую электронику, включая смартфоны, ПК, а также оборудование ЦОД — импорт таких товаров в США составил в прошлом году около $486 млрд. По мнению экспертов DA Davidson, оборудование для ЦОД несомненно подорожает, Microsoft уже начала более сбалансированно подходить к расширению инфраструктуры ЦОД. При этом на некоторых площадках уже имеется развитая энергетическая инфраструктура, также может быть упрощено получение разрешений на создание новых энергетических объектов вроде атомных реакторов. В первую очередь речь идёт о площадках, находящихся в распоряжении лабораторий самого Министерства энергетики, в том числе Лос-Аламосской, Окриджской, Аргоннской, и др. В Министерстве заявляют, что ожидают информации от строителей ЦОД, энергокомпаний и прочих бизнесов, желающих развивать проекты. Строительство должно начаться в конце текущего года, а работоспособность некоторых объектов должны обеспечить уже к концу 2027-го. Министр энергетики Крис Райт (Chris Wright) заявил, что США жизненно важно сохранить первенство в сфере ИИ. Он сравнил текущие процессы с гонкой по созданию атомной бомбы и прямо заявил о «новом Манхэттенском проекте», заодно сообщив, что США могут и должны победить. По его словам, сейчас США принимают важные меры по использованию местных ресурсов для обеспечение революции в сфере ИИ, при этом продолжая предоставлять доступную, надёжную и безопасную энергию жителям страны. В министерстве рассчитывают содействовать государственно-частным партнёрствам в этой сфере, промышленникам предложат шанс взаимодействовать с исследовательскими лабораториями мирового класса с целью развития как энергосистем для снабжения ЦОД, так и получения оборудования для ЦОД нового поколения. Согласно докладу Национальной лаборатории им. Лоуренса в Беркли, на дата-центры в США в 2023 году пришлось около 4,4 % всего энергопотребления страны, прогнозируется, что к 2028 году речь может идти уже о 12 %. В докладе основной причиной таких высоких показателей называется развитие ИИ. По имеющимся данным, энергопотребление ЦОД с 2017 по 2023 гг. выросло более чем вдвое, во многом из-за роста использования ресурсоёмких серверов для обучения ИИ-моделей. Впрочем, спешит развивать индустрию ЦОД не только США. В январе британское правительство представило программу AI Opportunities Action Plan, предусматривающую создание «зон роста ИИ» с приоритетным доступом к энергосетям и минимизацией бюрократии при строительстве. В то же время бывший глава Google Эрик Шмидт (Eric Schmidt) с соавторами опубликовал статью «Стратегия сверхразума» (Superintelligence Strategy), в которой высказывается мнение о том, что США следует воздержаться от реализации аналога «Манхэттенского проекта» для достижения превосходства в области ИИ, поскольку это спровоцирует упреждающие киберответы со стороны, например, Китая. |

|