Материалы по тегу: h100

|

30.11.2023 [13:52], Сергей Карасёв

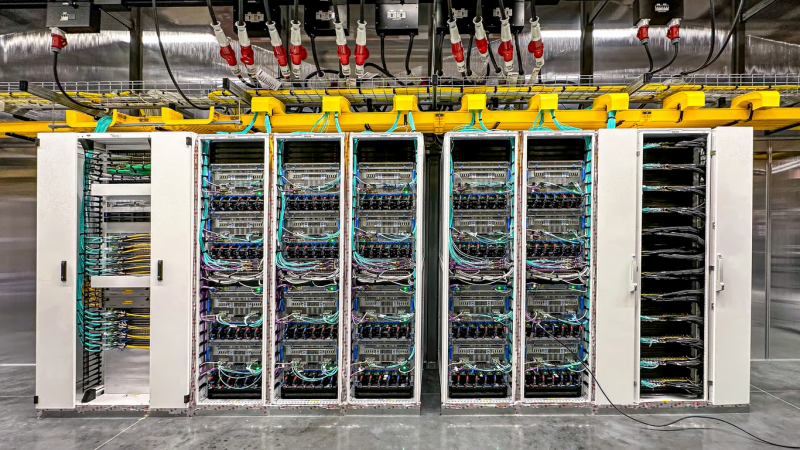

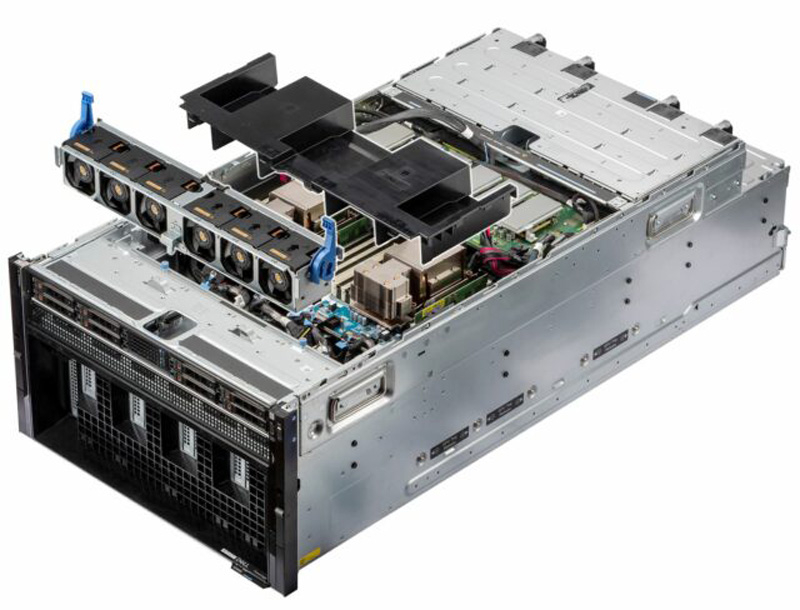

Dell построит ИИ-кластер из 10 тыс. NVIDIA H100 для компании ImbueНезависимая исследовательская ИИ-компания Imbue и Dell Technologies объявили о заключении соглашения по созданию нового высокопроизводительного вычислительного кластера на основе серверов PowerEdge для обучения базовых моделей. Проект оценивается в $150 млн. Imbue разрабатывает собственные базовые ИИ-модели, оптимизированные специально для рассуждений: они способны при необходимости запрашивать дополнительную информацию, анализировать и критиковать свои собственные результаты, а также разбивать сложную задачу на несколько более простых для повышения эффективности выполнения.

Источник изображения: Dell Imbue уже использует кластер на базе серверов Dell PowerEdge XE9680 с ускорителями NVIDIA H100. Новый проект предполагает развёртывание платформы, насчитывающей почти 10 тыс. чипов H100. Отмечается, что Imbue и Dell разработали систему, включающую в себя сравнительно небольшие кластеры, которые позволяют проводить эксперименты с ИИ-моделями на новых архитектурах. Такие узлы могут быть объединены в крупный кластер для эффективного обучения крупномасштабных базовых моделей. Основная цель Imbue заключается в создании специализированных ИИ-агентов, не требующих постоянного контроля со стороны пользователей. Они смогут выполнять самые разные задачи, включая написание программного кода, анализ сложных данных и пр. Ранее в текущем году Imbue привлекла на развитие $200 млн. Деньги поступили в том числе от NVIDIA.

28.11.2023 [18:11], Руслан Авдеев

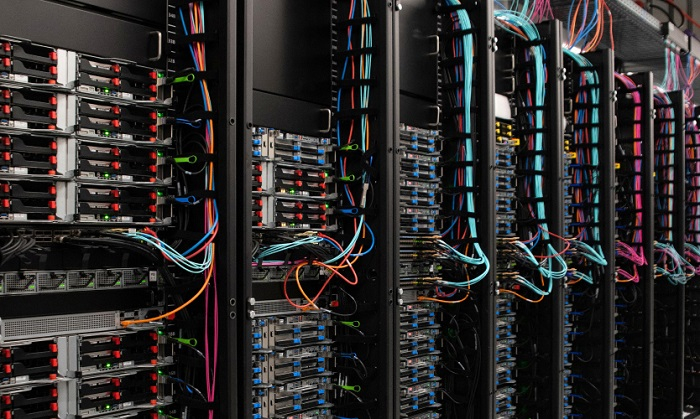

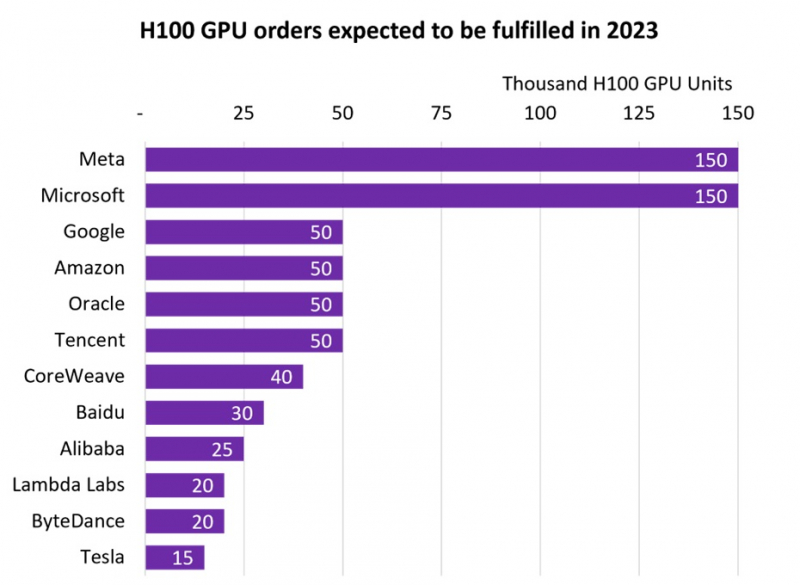

NVIDIA продала более 500 тыс. ИИ-ускорителей H100, но менее дефицитными они не сталиВ III квартале 2024 фискального года, завершившегося в октябре 2023-го, компания NVIDIA заработала впечатляющие $14,5 млрд на решениях для дата-центров. Как сообщает Tom’s Hardware, значительная часть выручки приходится на передовые ускорители H100 для ИИ и HPC-систем. Данные опубликовала компания Omdia, отслеживающая активность на рынке IT-решений. Согласно её анализу, крупнейшими покупателями ускорителей H100 стали гиперскейлеры вроде Meta✴ и Microsoft, значительно обогнавших по объёмам закупок Google, Amazon, Oracle и Tencent. Если Microsoft и Meta✴ приобрели по 150 тыс. ускорителей, то их «коллеги» по IT-рынку — по 50 тыс. При этом гиперскейлерам отдаётся очевидный приоритет при выполнении заказов. В Omdia пришли к выводу, что до конца года будет поставлено почти 650 тыс. H100. В то же время срок выполнения новых заказов на серверы на базе ускорителей компании вырос с 36 до 52 недель. Так, Dell, HPE и Lenovo не могут полностью удовлетворить свои потребности в ускорителях для своих серверов в кратчайшие сроки. В итоге год к году поставки серверов в количественном выражении рухнут на 17–20 %, однако общая выручка поднимется на 6–8 %.

Источник изображения: Omdia В 2027 году рынок серверов должен вырасти до $195,6 млрд, причём основное предпочтение будет отдаваться специализированным вариантам под конкретные задачи, оснащённым специальными сопроцессорами. Запрос на серверы с кастомными конфигурациями становится новой нормой по мере того, как заказчики осознали экономическую эффективность применения сопроцессоров и ускорителей. Пионерами в этой сфере стали компании, связанные с ИИ и медиаконтентом, но привлекательность таких решений, как ожидается, в ближайшем будущем будет оценена и в других секторах.

22.11.2023 [01:23], Владимир Мироненко

NVIDIA в рекордные сроки завершила строительство первой фазы израильского ИИ-суперкомпьютера Israel-1Компания NVIDIA объявила во вторник о досрочном завершении сборки первой фазы ИИ-суперкомпьютера Israel-1, анонсированного летом этого года. Сообщается, что суперкомпьютер уже доступен для использования исследовательскими и опытно-конструкторскими группами компании, а также её отдельными партнёрами. После завершения строительства Israel-1 станет самым мощным ИИ-суперкомпьютером в Израиле. По данным NVIDIA, первая фаза компьютерной системы была построена менее чем за 20 недель или почти на два месяца раньше намеченных сроков — это намного быстрее, чем требуется для создания традиционных суперкомпьютеров, которые могут создаваться и несколько лет. Первая фаза Israel-1, обеспечивающая производительность при обработке ИИ-нагрузок в 4 Эфлопс (FP8) и при научных вычислениях в 65 Пфлопс (FP64), послужит испытательным стендом для разработанной в Израиле сетевой Ethernet-платформы NVIDIA/Mellanox Spectrum-X, предназначенной для повышения производительности и эффективности облачных ИИ-сервисов. В конечном итоге Israel-1 будет содержать 256 систем NVIDIA HGX H100, включающих в общей сложности 2048 ускорителей NVIDIA H100 с более чем 34 млн ядер CUDA и 1 млн тензорных ядер четвёртого поколения, 2560 единиц DPU BlueField-3 и 80 коммутаторов Spectrum-4. Первая фаза суперкомпьютера включает 128 серверов Dell PowerEdge XE9680 на базе платформы NVIDIA HGX H100, 1280 единиц DPU BlueField-3 и более 40 коммутаторов Spectrum-4.

21.11.2023 [04:04], Владимир Мироненко

Scaleway предложила экономичные ИИ-инстансы на базе Ampere Altra и расширила сотрудничество с NVIDIAФранцузский провайдер инфраструктуры облачных вычислений Scaleway SAS объявил о доступности так называемых оптимизированных по стоимости (Cost-Optimized) инстансов на базе архитектуры Arm (COP-ARM), предназначенных для обработки нагрузок ИИ и HPC. Инстансы COP-ARM используют процессоры Ampere Altra. Компания утверждает, что процессоры Altra могут стать более доступным вариантом для клиентов, желающих запускать обучение и инференс больших языковых моделей (LLM). По словам компании, они специально созданы для обработки рабочих нагрузок ИИ в реальном времени, таких как чат-боты, анализ данных и анализ видеоконтента. Директор по продуктам Ampere Джефф Виттич (Jeff Wittich) заявил, что CPU идеально подходят для инференса. «В целом модели ИИ станут меньше и более ориентированными на конкретные задачи», — прогнозирует Виттич. Именно здесь может потребоваться энергоэффективность инстансов Scaleway. Он заявил, что запуск модели OpenAI Whisper на 128-ядерном процессоре Altra Max потребляет в 3,6 раза меньше энергии, чем при использовании ускорителя NVIDIA A10. Scaleway также объявила о сотрудничестве с NVIDIA с целью предоставить европейским стартапам доступ к ускорителям NVIDIA, программному обеспечению NVIDIA AI Enterprise и сервисам для ускорения разработки больших языковых моделей (LLM) и приложений генеративного ИИ. В рамках бесплатной программы NVIDIA Inception, предоставляющей техническое руководство, обучение и скидки, стартапы полагаются на возможности суверенных облачных вычислений инфраструктуры Scaleway. В частности, новый суперкомпьютер Scaleway Nabuchodonosor на базе NVIDIA DGX SuperPOD со 127 узлами DGX H100 поможет стартапам во Франции и по всей Европе масштабировать рабочие нагрузки ИИ. Региональные участники Inception также получат доступ к ПО NVIDIA AI Enterprise на Scaleway Marketplace, включая платформу NVIDIA NeMo и предварительно обученные LLM, NVIDIA RAPIDS, а также NVIDIA Triton и NVIDIA TensorRT-LLM.

17.11.2023 [14:02], Руслан Авдеев

Tencent накопила достаточно ускорителей NVIDIA H800 для поддержания ИИ-разработок в условиях антикитайских санкцийПосле ужесточения антикитайских санкций 17 октября со стороны США бизнес и государственные структуры КНР лишились возможности приобретать даже ухудшенные версии ускорителей NVIDIA. Тем не менее, как сообщает DigiTimes, многие китайские участники рынка успели закупить большое количество ускорителей до вступления новых запретов в силу. По словам президента Tencent Мартина Лау (Martin Lau), перспектива введения более строгих санкций сподвигла компанию к более рациональному использованию уже имеющихся чипов, а также поиску альтернатив на местном рынке, где разработка подобных решений ведётся ударными темпами. В своё время NVIDIA на фоне санкций пришлось наладить для Китая вместо ускорителей A100 и H100 выпуск моделей A800 и H800 с искусственно заниженной производительностью. Но теперь и их экспорт в Поднебесную попал под запрет. Как заявил Лау журналистам, Tencent уже закупила достаточно ускорителей NVIDIA для дальнейшего развития ИИ-платформы Hunyuan. Ожидается, что компании удастся обучить ещё как минимум два поколения ИИ-моделей. В результате, как считают в руководстве Tencent, новейшие антикитайские санкции не смогут повлиять на возможность развития ИИ-технологий компании в краткосрочной перспективе.

Источник изображения: NVIDIA Инвесторам сообщили, что Hunyuan уже может готовить резюме встреч, проводимых на похожей на Zoom платформе Tencent Meeting, даёт рекомендации программистам компании и повышает эффективность создания игр. Также ИИ способен выступать в роли копирайтера для рекламодателей, позволяя более аккуратно адаптировать рекламу под целевую аудиторию, увеличивая её эффективность. В частности, это позволило улучшить показатели видеорекламы Tencent. В обозримом будущем Лау рассчитывает, что ИИ позволит и отвечать на вопросы клиентов — это позволит объединить рекламу и продажи. Как подчеркнул Лау, фактически Tencent находится в числе китайских компаний с самыми большими запасами чипов H800 — в своё время именно она первой начала приобретать их у NVIDIA. В частности поэтому она накопила большие запасы, так что новые запреты способны лишь слегка замедлить работы. По словам Лау, наиболее эффективной будет комбинированная схема, при которой наиболее производительные чипы оставят для тренировки ИИ-моделей, а варианты с меньшей производительностью будут применяться для инференса. Впрочем, несмотря на принятые меры, в Tencent признают, что антикитайские санкции США негативно скажутся на облачном ИИ-сервисе компании. Тем не менее, Лау уверен, что если запасы H800 начнут иссякать, они будут пополнены за счёт китайских решений. Как сообщает The Register, пока таких фактически не существует. Но, судя по всему, в Tencent уверены, что скоро варианты, способные бросить вызов американскому превосходству, окажутся в китайском распоряжении. В III квартале выручка китайского техногиганта составила $21,5 млрд и выросла год к году на 10 %. Операционная прибыль упала на 6 %, но всё ещё составляет $6,8 млрд. Компания принимает ряд мер по оптимизации бизнеса и сейчас её социальные платформы WeChat и QQ насчитывают по 1,336 млрд и 558 млн активных пользователей соответственно, наблюдается небольшой рост год к году. Рост доходов руководство объясняет эффективностью видео- и игрового сервисов.

16.11.2023 [21:31], Сергей Карасёв

Суперкомпьютер ISEG отделившейся от «Яндекса» компании Nebius стал одним из самых мощных в мире

gigabyte

h100

hardware

hpc

intel

nebius

nvidia

sapphire rapids

top500

xeon

нидерланды

суперкомпьютер

Компания Nebius N.V. со штаб-квартирой в Нидерландах, созданная бывшими сотрудниками «Яндекса», вошла в первую двадцатку ноябрьского рейтинга мощнейших суперкомпьютеров мира TOP500 со своей НРС-системой ISEG. Этот вычислительный комплекс, названный в честь сооснователя «Яндекса» Ильи Сегаловича, расположился на 16-й строке списка. В основу ISEG положены HGX-узлы Gigabyte G593-SD0 с двумя процессорами Intel Xeon Sapphire Rapids и восемью ускорителями NVIDIA H100 (SXM). В частности, задействованы чипы Platinum 8468 (48 ядер; 96 потоков; 2,1–3,8 ГГц; 350 Вт). Общее количество ядер в составе суперкомпьютера достигает 218 880. Применён интерконнект Infiniband NDR400. Производительность ISEG достигает 46,54 Пфлопс (FP64), пиковое быстродействие — 86,79 Пфлопс. С такими показателями система оставляет далеко позади все российские суперкомпьютеры. В частности, самый мощный НРС-комплекс РФ — «Червоненкис» компании «Яндекс» — располагается только на 36-й позиции с результатом 21,53 Пфлопс. Таким образом, по быстродействию этот суперкомпьютер уступает системе ISEG более чем в два раза.

Источник изображения: Nebius Forbes отмечает, что в процессе создания ISEG интеллектуальная собственность и технологии «Яндекса» не использовались. Тестирование суперкомпьютера для рейтинга TOP500 проводилось с ОС Ubuntu Linux 20.04. Энергопотребление системы составило 1,32 МВт. В списке Green500 машина занимает 15-е место.

16.11.2023 [16:23], Сергей Карасёв

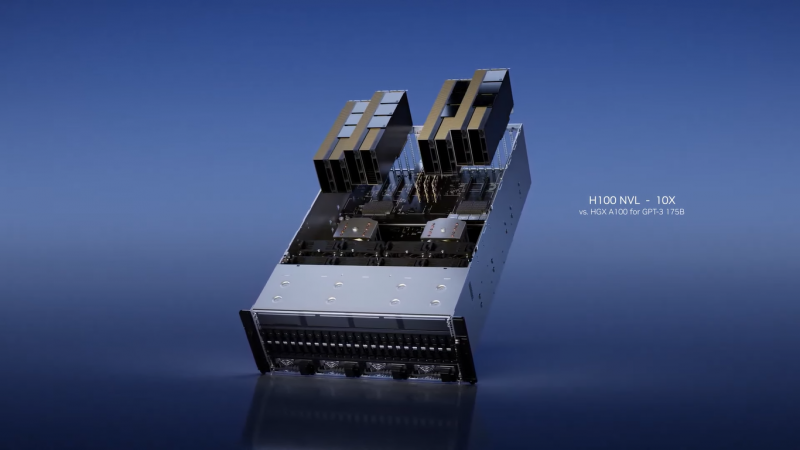

В облаке Microsoft Azure появились первые в отрасли ИИ-инстансы на базе NVIDIA H100 NVLКорпорация Microsoft объявила о том, что на базе облака Azure стали доступны виртуальные машины NC H100 v5 для HPC-вычислений и нагрузок ИИ. Это, как отмечается, первые в отрасли облачные инстансы на базе ускорителей NVIDIA H100 NVL. Данное решение объединяет два PCIe-ускорителя H100, соединённых посредством NVIDIA NVLink. Объём памяти HBM3 составляет 188 Гбайт, а заявленная FP8-производительность (с разреженностью) достигает почти 4 Пфлопс. Инстансы H100 v5 основаны на платформе AMD EPYC Genoa. В зависимости от реализации, доступны 40 или 80 vCPU и 320 и 640 Гбайт памяти соответственно. В первом случае задействован один ускоритель NVIDIA H100 NVL с 94 Гбайт памяти HBM3, во втором — два ускорителя с суммарно 188 Гбайт памяти HBM3. Пропускная способность сетевого подключения — 40 и 80 Гбит/с. В отличие от виртуальных машин серии ND, рассчитанных на самые крупные модели ИИ, инстансы NC оптимизированы для обучения и инференса моделей меньшего размера, которым не требуются сверхмасштабные массивы данных. Виртуальные машины Azure NC H100 v5 также хорошо подходят для определённых НРС-нагрузок: это гидродинамика, молекулярная динамика, квантовая химия, прогнозирование погоды и моделирование климата, а также финансовая аналитика. В 2024 году Microsoft добавит в облако Azure виртуальные машины с новейшими ускорителями NVIDIA H200: оно смогут обрабатывать более крупные модели ИИ без увеличения задержки. А уже сейчас клиентам Azure стал доступен сервис DGX Cloud.

13.11.2023 [16:16], Сергей Карасёв

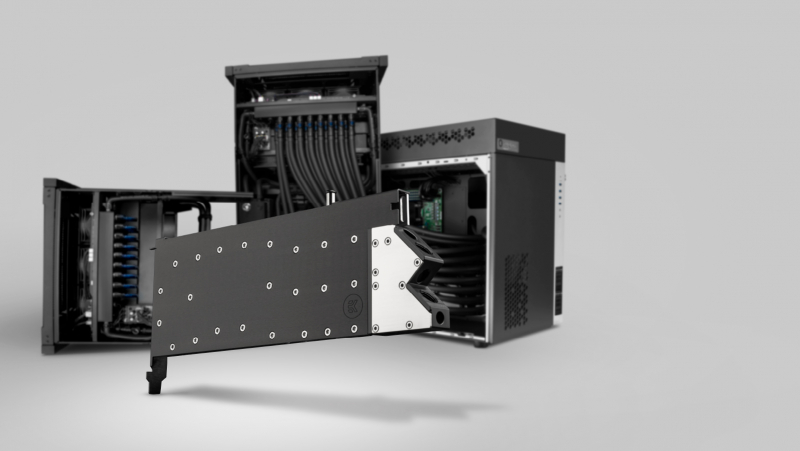

OSS представила защищённый ИИ-сервер Gen 5 AI Transportable на базе NVIDIA H100Компания One Stop Systems (OSS) на конференции по высокопроизводительным вычислениям SC23 представила сервер Gen 5 AI Transportable, предназначенный для решения задач ИИ и машинного обучения на периферии. Устройство, рассчитанное на монтаж в стойку, выполнено в корпусе уменьшенной глубины. Новинка соответствует американским военным стандартам в плане устойчивости к ударам, вибрации, диапазону рабочих температур и пр. Сервер может применяться в составе мобильных дата-центров, на борту грузовиков, самолётов и подводных лодок. Возможна установка четырёх ускорителей NVIDIA H100 и до 16 NVMe SSD суммарной вместимостью до 1 Пбайт. Говорится о поддержке до 35 одновременных ИИ-нагрузок. Кроме того, могут применяться сетевые решения стандарта 400 Гбит/с. При необходимости можно подключить NAS-хранилище в усиленном исполнении.

Источник изображения: OSS Для сервера доступны различные варианты охлаждения: воздушное, автономное жидкостное или внешний теплообменник с жидкостным контуром. Поддерживаются различные варианты организации питания с переменным и постоянным током для использования на суше, в воздухе и море. При использовании СЖО ускорители H100, по всей видимости, комплектуются водоблоком EK-Pro NVIDIA H100 GPU WB. Реализована фирменная архитектура Open Split-Flow: она обеспечивает высокую эффективность охлаждения даже при небольшой скорости потока жидкости, что позволяет применять не слишком мощные помпы или помпы, работающие с невысокой скоростью. Микроканалы, фрезерованные на станке с ЧПУ, обладают минимальным гидравлическим сопротивлением потоку. Водоблок имеет однослотовое исполнение. Предусмотрено проприетарное ПО U-BMC (Unified Baseboard Management Controller) для динамического управления скоростью вентиляторов, мониторинга системы и пр. Сервер подходит для монтажа в большинство 19″ стоек.

22.03.2023 [20:32], Алексей Степин

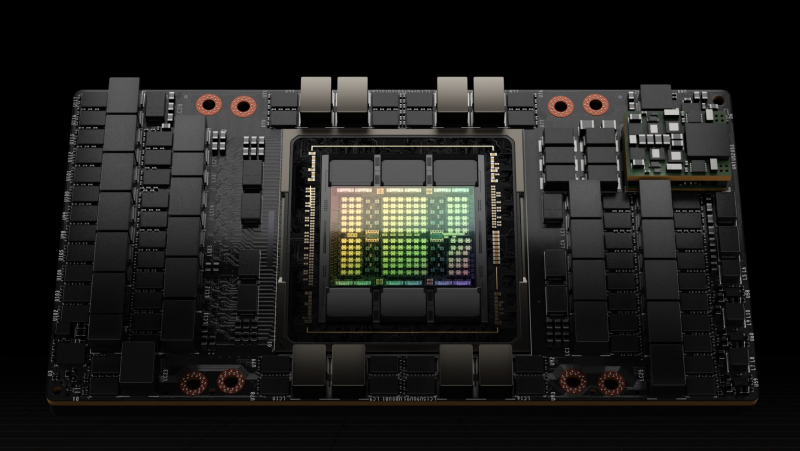

Экспортный китайский вариант NVIDIA H100 получил модельный номер H800В связи с санкционными ограничениями некоторые разновидности сложных микроэлектронных чипов запрещено экспортировать в Китайскую Народную Республику. Однако производители находят выход. В частности, компания NVIDIA анонсировала экспортный вариант ускорителя H100, не нарушающий никаких санкций. Модельный номер у такого варианта изменён на H800. Введённые правительством США в 2022 году санкции сделали «невыездными» два наиболее продвинутых продукта NVIDIA: A100 и H100. Такие процессоры сегодня являются основой наиболее динамично развивающейся вычислительной отрасли — нейросетевой. Именно на кластерах из таких ускорителей «натаскивают» мощные нейросети вроде ChatGPT и подобных.

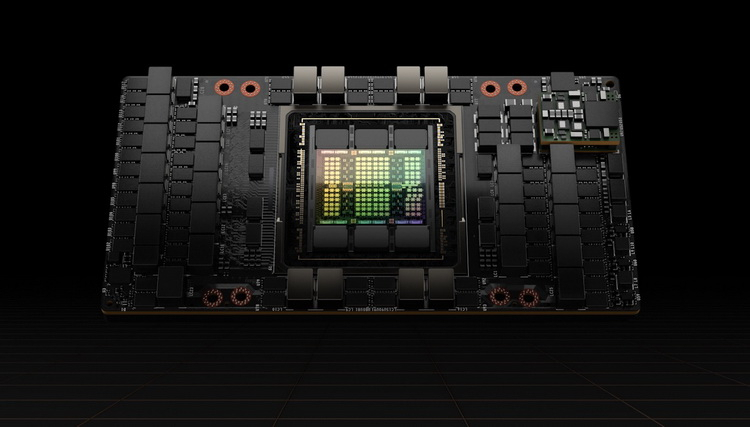

Ускоритель Hopper H100 в SXM-исполнении. Источник изображений здесь и далее: NVIDIA Ещё осенью прошлого года NVIDIA анонсировала A800 — экспортный вариант A100, не попадающий под ограничения за счёт некоторого снижения пропускной способности NVLink, с 600 до 400 Гбайт/с. Сейчас пришло время архитектуры Hopper, которая запущена в массовое производство. По аналогии с флагманом Ampere модернизированный чип получил модельный номер H800. Ограничения в нём реализованы схожим образом: как известно, NVLink в H100 имеет производительность 900 Гбайт/с в базовом SXM-варианте.

H100 также существует в PCIe-варианте Версия H800 использует примерно половину этого потенциала, что, впрочем, не делает её в Китае менее популярной: новинка уже используется китайскими облачными гигантами, такими, как Alibaba, Baidu и Tencent. Есть ли у H800 другие отличия от H100, не говорится — NVIDIA пока отказывается предоставлять такую информацию. Достоверно известно лишь то, что они полностью соответствуют всем санкционным ограничениям. Интересно, появится ли в будущем вариант H800 NVL на базе NVIDIA H100 NVL.

21.03.2023 [20:45], Владимир Мироненко

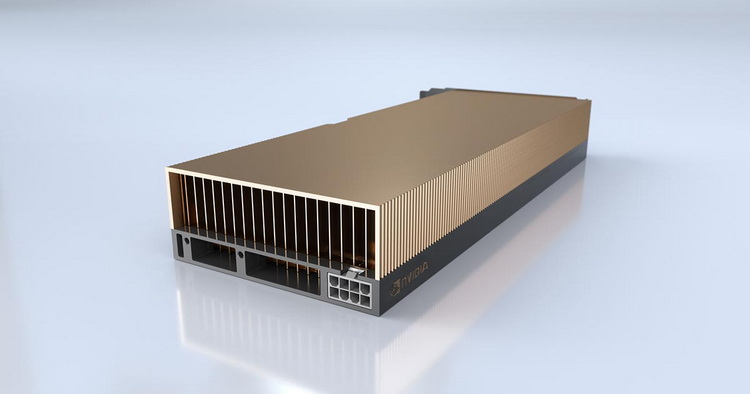

NVIDIA запустила облачный сервис DGX Cloud — доступ к ИИ-супервычислениям прямо в браузереNVIDIA запустила сервис ИИ-супервычислений DGX Cloud, предоставляющий предприятиям доступ к инфраструктуре и программному обеспечению, необходимым для обучения передовых моделей для генеративного ИИ и других приложений. DGX Cloud предлагает выделенные ИИ-кластеры NVIDIA DGX в сочетании с фирменным набором ПО NVIDIA. С его помощью предприятие сможет получить доступ к облачному ИИ-суперкомпьютеру, используя веб-браузер и без надобности в приобретении, развёртывании и управлении собственной HPC-инфраструктурой. Правда, удовольствие это всё равно не из дешёвых — стоимость инстансов DGX Cloud начинается от $36 999/мес., причём деньги получает в первую очередь сама NVIDIA. Для сравнения — полностью укомплектованная система DGX A100 в Microsoft Azure обойдётся примерно в $20 тыс. Облачные кластеры DGX предлагаются предприятиям на условиях ежемесячной аренды, что гарантирует им возможность быстро масштабировать разработку больших рабочих нагрузок. «DGX Cloud предоставляет клиентам мгновенный доступ к супервычислениям NVIDIA AI в облаках глобального масштаба», — сообщил Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA.

Источник изображения: NVIDIA Развёртыванием инфраструктуры DGX Cloud компания NVIDIA будет заниматься в сотрудничестве с ведущими поставщиками облачных услуг. Первым среди них стала платформа Oracle Cloud Infrastructure (OCI), предлагающая суперкластер (SuperCluster) с объединёнными RDMA-сетью (в том числе на базе BlueField-3 и Connect-X7) системами DGX (bare metal), которые дополняет высокопроизводительное локальное и блочное хранилище. Cуперкластер может включать до 32 768 ускорителей, но этот рекорд был поставлен с использованием DGX A100, а вот предложение DGX H100 пока что ограничено. В следующем квартале похожее решение появится в Microsoft Azure, а потом в Google Cloud и у других провайдеров. Первыми пользователями DGX Cloud стали Amgen, одна из ведущих мировых биотехнологических компаний, лидер рынка страховых технологий CCC Intelligent Solutions (CCC) и провайдер цифровых бизнес-платформ ServiceNow. «Мощные вычислительные и многоузловые возможности DGX Cloud позволили нам в 3 раза ускорить обучение белковых LLM с помощью BioNeMo и до 100 раз ускорить анализ после обучения с помощью NVIDIA RAPIDS по сравнению с альтернативными платформами», — сообщил представитель Amgen. Для управления нагрузками в DGX Cloud предлагается NVIDIA Base Command. Также DGX Cloud включает в себя набор инструментов NVIDIA AI Enterprise для создания и запуска моделей, который предоставляет комплексные фреймворки и предварительно обученные модели для ускорения обработки данных и оптимизации разработки и развёртывания ИИ. DGX Cloud предоставляет поддержку экспертов NVIDIA на всех этапах разработки ИИ. Клиенты смогут напрямую работать со специалистами NVIDIA, чтобы оптимизировать свои модели и быстро решать задачи разработки с учётом сценариев отраслевого использования. |

|