Материалы по тегу: ff

|

23.02.2024 [19:06], Сергей Карасёв

Meta✴ ищет в Индии и США специалистов для разработки ИИ-ускорителей и SoC для дата-центровКомпания Meta✴, по сообщению The Register, опубликовала множество объявлений о поиске специалистов для разработки интегральных схем специального назначения (ASIC). Речь идёт о создании собственных ускорителей для машинного обучения и ИИ, а также SoC для дата-центров. Сейчас для ИИ-задач Meta✴ массово применяет решения NVIDIA. Кроме того, компания присматривается к ускорителям AMD Instinct MI300. С целью снижения зависимости от сторонних поставщиков и сокращения расходов Meta✴ также проектирует собственные аппаратные компоненты. В частности, весной прошлого года Meta✴ анонсировала свой первый кастомизированный процессор, разработанный специально для ИИ-нагрузок. Изделие под названием MTIA v1 (Meta✴ Training and Inference Accelerator) представляет собой ASIC в виде набора блоков, функционирующих параллельно. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра RISC-V. Кроме того, компания создала чип MSVP (Meta✴ Scalable Video Processor) для обработки видеоматериалов. В разработке также находятся собственные ИИ-ускорители Artemis.

Источник изображения: Meta✴ Как теперь сообщается, Meta✴ ищет ASIC-инженеров с опытом работы в области архитектуры, дизайна и тестирования. Необходимы специалисты в Бангалоре (Индия) и Саннивейле (Калифорния, США). В некоторых вакансиях работодателем указана собственно Мета✴, тогда как в других случаях указан Facebook✴. От кандидатов в числе прочего требуется «глубокий опыт в одной или нескольких ключевых сферах, связанных с созданием сложных SoC для дата-центров». Тестировщикам необходимо иметь опыт проверки проектов для ЦОД, связанных с машинным обучением, сетевыми технологиями и пр. Некоторые вакансии были впервые опубликованы в соцсети LinkedIn в конце декабря 2023 года и обновлены в феврале нынешнего года. Претендентам обещаны неплохие зарплаты. Для каких именно задач компании Meta✴ требуются аппаратные решения, не уточняется. Но сетевые источники отмечают, что это может быть инференс, создание новых ИИ-платформ и т.п.

23.05.2023 [19:36], Руслан Авдеев

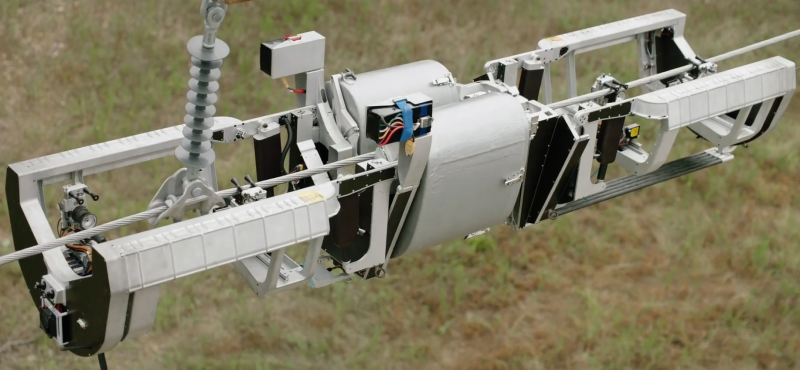

Meta✴ лицензирует робота Bombyx, предназначенного для прокладки оптоволоконных интернет-кабелей по ЛЭПРобот Meta✴ Bombyx — это специальное устройство, способное прокладывать оптоволоконные кабели, передвигаясь по линиям электропередач. Bombyx переводится с латыни как «мотылёк шелкопряда». Разработка робота была начата Facebook✴ и ULC Robotics ещё в 2018 году. Теперь Meta✴ сделала ставку на сторонний бизнес, который готов взять реализацию проекта на себя — робота лицензируют для дальнейшей разработки японской IT-компанией. Лицензию получит японская Hibot, обладающая десятилетиями опыта в разработке роботов различного назначения. В компании уже заявили, что считают большой честью получение лицензии и намерены работать над проектом уже существующими партнёрами и теми, кто пожелает присоединиться к разработке. Робот Bombyx поддержит прокладку оптических линий в труднодоступных местностях, где проникновение интернета оставляет желать лучшего.

Источник изображения: Meta✴ В дополнение к возможности прокладки кабеля, Hibot будет использовать инновационные технологии Meta✴ для создания машины, пригодной для проверки уже существующей инфраструктуры и, возможно, для модернизации электросетей. Хотя оптоволоконные кабели являются недорогими и эффективным решением для создания информационных сетей, сама прокладка обычно обходится значительно дороже самого кабеля и представляет собой относительно сложный процесс.

Источник изображения: Meta✴ В случае Bombyx кабель обвивается вокруг проводов на линиях электропередач. При этом снятие напряжения не требуется, а протяжённость кабеля может быть весьма велика. Правда, речь идёт о специальном кабеле в кевларовой рубашке, который значительно легче традиционных вариантов (менее 13 кг/км). Bombyx может преодолевать препятствия, используя механизмы машинного зрения и сенсоры для ориентации в пространстве.

19.05.2023 [10:20], Сергей Карасёв

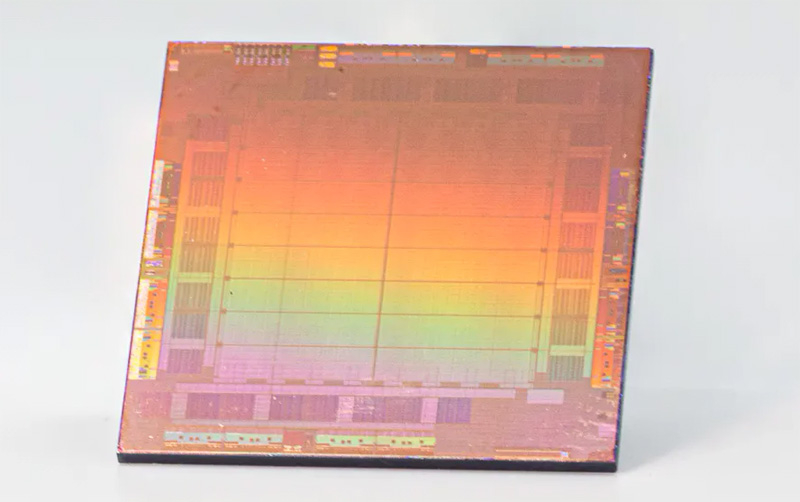

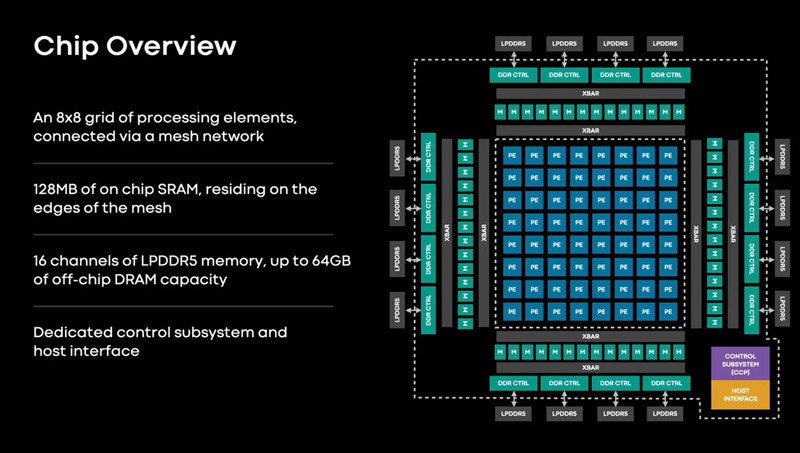

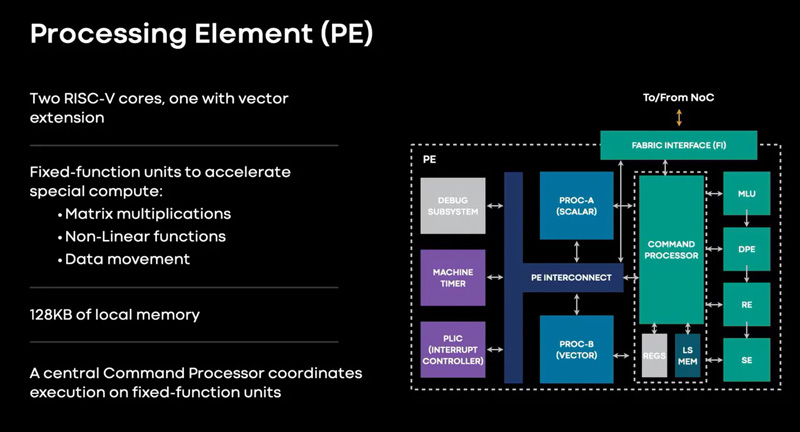

Meta✴ представила ИИ-процессор MTIA для дата-центров — 128 ядер RISC-V и потребление всего 25 ВтMeta✴ анонсировала свой первый кастомизированный процессор, разработанный специально для ИИ-нагрузок. Изделие получило название MTIA v1, или Meta✴ Training and Inference Accelerator: оно оптимизировано для обработки рекомендательных моделей глубокого обучения. Проект MTIA является частью инициативы Meta✴ по модернизации архитектуры дата-центров в свете стремительного развития ИИ-платформ. Утверждается, что чип MTIA v1 был создан ещё в 2020 году. Это интегральная схема специального назначения (ASIC), состоящая из набора блоков, функционирующих в параллельном режиме.

Источник изображений: Meta✴ Известно, что при производстве MTIA v1 используется 7-нм технология. Конструкция включает 128 Мбайт памяти SRAM. Чип может использовать до 64/128 Гбайт памяти LPDDR5. Задействован фреймворк машинного обучения Meta✴ PyTorch с открытым исходным кодом, который может применяться для решения различных задач в области компьютерного зрения, обработки естественного языка и пр.  Процессор MTIA v1 имеет размеры 19,34 × 19,1 мм. Он содержит 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра с архитектурой RISC-V. Тактовая частота достигает 800 МГц, заявленный показатель TDP — 25 Вт. Meta✴ признаёт, что у MTIA v1 присутствуют «узкие места» при работе с ИИ-моделями большой сложности: требуется оптимизация подсистем памяти и сетевых соединений. Однако в случае приложений низкой и средней сложности платформа, как утверждается, обеспечивает более высокую эффективность по сравнению с GPU.  В дальнейшем в семействе MTIA появятся более производительные изделия, но подробности о них не раскрываются. Ранее говорилось, что Meta✴ создаёт некий секретный чип, который подойдёт и для обучения ИИ-моделей, и для инференса: это решение может увидеть свет в 2025 году.

26.04.2023 [19:50], Сергей Карасёв

Meta✴ вынужденно пересмотрела архитектуру своих ЦОД из-за отказа от выпуска собственных ИИ-чипов в пользу ускорителей NVIDIAКомпания Meta✴, по сообщению Reuters, была вынуждена пересмотреть конфигурацию своих дата-центров из-за отставания от конкурентов в плане развития ИИ-платформ. Компания, в частности, решила отказаться от дальнейшего внедрения инференс-чипов собственной разработки. Отмечается, что до прошлого года Meta✴ применяла архитектуру, в которой традиционные CPU соседствуют с кастомизированными решениями. Однако выяснилось, что такой подход менее эффективен по сравнению с применением ускорителей (GPU). При этом ранее компания отказалась от ИИ-ускорителей Qualcomm, указав на недоработки ПО, которые, судя по всему, были устранены только недавно. А с Esperanto, вероятно, отношения у Meta✴ пока не сложились. Впрочем, теперь компании интересен генеративный ИИ, а не только рекомендательные системы, что накладывает иные требования к оборудованию.

Источник изображения: Meta✴ В течение почти всего 2022 года Meta✴ активно инвестировала в развите инфраструктуры, однако в конце года стало известно, что она приостановила строительство целого ряда ЦОД, а затем пересмотрела расходы на дата-центры. Компания решила кардинально переосмыслить архитектуру своих ЦОД, сделав ставку на СЖО. Как теперь выясняется, связано это с тем, что Meta✴ отказалась от собственных ИИ-чипов в пользу ускорителей NVIDIA: объём заказов последних исчисляется «миллиардами долларов». Соответствующую платформу Grand Teton компания показала в конце прошлого года.

Источник изображения: Meta✴ Но ускорители потребляют больше энергии и выделяют больше тепла, нежели CPU или узкоспециализированные ASIC. Кроме того, ускорители должны физически находиться довольно близко друг к другу, хотя с интерконнектом компания тоже уже экспериментирует. Всё это влияет на архитектуру ЦОД. Тем не менее, Meta✴ всё же разрабатывает некий секретный чип, который сгодится и для обучения ИИ-моделей, и для инференса. Ожидается, что это решение увидит свет в 2025 году. Пока что для обучения ИИ компания намерена использовать собственный ИИ-суперкомпьютер RSC и облачные кластеры Microsoft Azure. Похожий путь избрала Microsoft, решившая создать свой ИИ-чип, не отказываясь пока от ускорителей NVIDIA. The Information добавляет, что вице-президент Microsoft по разработке «кремния» Жан Буфархат (Jean Boufarhat) присоединится к Meta✴. Он возглавит команду Facebook✴ Agile Silicon Team (FAST), чтобы помочь компании в реализации проектов по созданию чипов. Ранее Meta✴ переманила из Intel руководителя разработки сетевых решений для дата-центров. У Google и Amazon уже есть свои ИИ-чипы для обучения и инференса.

22.04.2023 [00:15], Алексей Степин

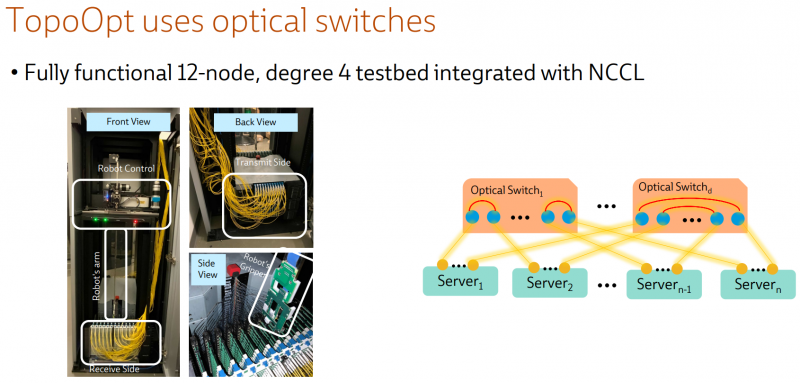

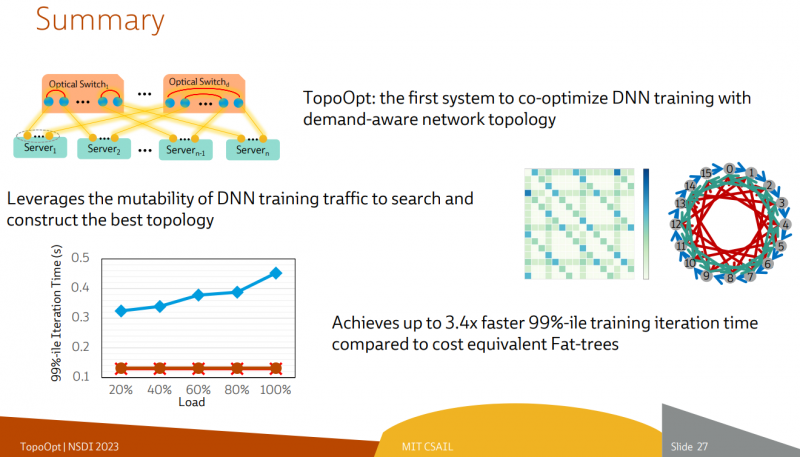

Ловкость роборук: TopoOpt от Meta✴ и MIT поможет ускорить и удешевить обучение ИИТехнологии искусственного интеллекта (ИИ) сегодня бурно развиваются и требуют всё более серьёзных вычислительных мощностей. Но наряду с наращиванием этих мощностей растут требования и к сетевой подсистеме, поэтому крупные компании и исследовательские организации ищут всё новые способы оптимизации инфраструктуры. Компания Meta✴ в сотрудничестве с Массачусетским технологическим институтом (MIT) и рядом прочих исследовательских организаций опубликовала данные любопытного эксперимента, в котором ИИ-кластер мог менять топологию своего интерконнекта с помощью механической «роборуки». Система получила название TopoOpt, поскольку вычислительные узлы в ней использовали полностью оптическую сеть с оптической же патч-панелью. Эта сеть объединяла 12 вычислительных узлов ASUS ESC4000A-E10, каждый из которых был оснащён ускорителем NVIDIA A100, сетевыми адаптерами HPE и Mellanox ConnectX-5 (100 Гбит/с) с оптическими трансиверами. Наиболее интересное устройство в эксперименте — оптическая патч-панель Telescent, оснащённая механическим манипулятором, способным производить перекоммутацию на лету. Эта «роборука» работала под управлением специализированного ПО, целью которого ставилось нахождение оптимальной сетевой топологии и сегментации сети применительно к различным задачам машинного обучения.

Система с перекоммутируемой оптической сетью не требует энергоёмких высокоскоростных коммутаторов и обеспечивает ряд других преимуществ Такая роботизированная патч-панель не столь расторопна, как оптические коммутаторы Google с микрозеркальной механикой, но стоит впятеро дешевле и имеет больше портов. Опубликованные экспериментальные данные уверенно свидетельствуют о том, что топология «толстого дерева» (fat tree), использующая несколько слоёв коммутаторов, не оптимальна и даже избыточна для ряда нейросетевых задач. К тому же перекоммутируемая оптическая сеть без традиционных высокоскоростных коммутаторов требует меньше оборудования, а значит, может быть не только быстрее сети fat tree в ряде ИИ-задач, но и существенно дешевле в развёртывании и поддержании в рабочем состоянии — как минимум за счёт отсутствия затрат на питание множества коммутаторов.

25.11.2022 [16:33], Алексей Степин

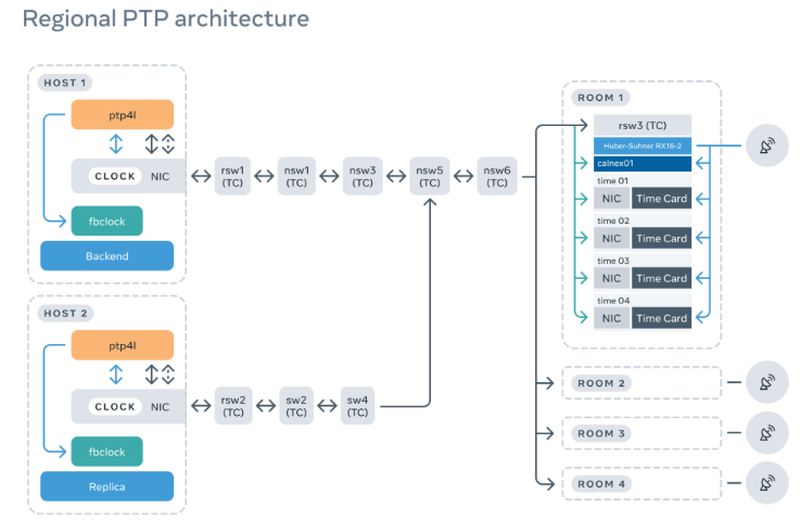

Meta✴ переходит на использование протокола синхронизации времени PTPВ отличие от широко известного протокола сетевой координации времени NTP, разработанный изначально для локальных сетей, PTP (Precision Time Protocol, IEEE 1588) способен обеспечивать точность синхронизации в пределах десятков наносекунд, тогда как у NTP это значение находится в диапазоне единиц или десятков миллисекунд. С точки зрения владельцев крупных ЦОД возможность повысить точность синхронизации может представлять существенный интерес, поскольку позволяет точнее привести серверы к единому времени. И такой возможностью заинтересовалась компания Meta✴, которая в течение некоторого времени тестировала PTP локально, а в настоящее время заявила о переводе всех серверов на новый стандарт синхронизации.  Поскольку масштабы сети серверов Meta✴ действительно велики, влияние неточностей при использовании NTP может накапливаться и приводить к задержкам, сбоям или даже сетевым отказам. Тем более сверхточная синхронизация важна для проекта метавселенной, в котором огромная виртуальная вселенная должна функционировать как единое целое. Однако внедрение PTP требует поддержки со стороны не только программного, но и аппаратного обеспечения, поэтому компания разработала в рамках OCP систему Open Time Server, в основе которой лежит плата точного времени Facebook✴ Time Card с приёмником сигналов GNSS. Требований со стороны сервера немного: использование сетевых интерфейсов с поддержкой PPS и Hardware Timestamps и процессоров с VT-d.

Facebook✴ Time Card Программная часть состоит из ОС Linux с драйвером ocp_ptp и демонов Chrony/NTPd и ptp4u/ptp4l, работающих с устройствами dev/ptpX карты времени и сетевого адаптера. В официальном репозитории Open Time Server приведена подробная информация на этот счёт. На уровне ЦОД это означает появление выделенных стоек PTP, оснащённых соответствующим оборудованием. Подчёркивается также важность наличия качественной антенны для приёма GNSS-сигналов, гарантирующей точность позиционирования менее 10 м — лишь при такой точности можно вести речь о наносекундном уровне синхронизации. Каждая стойка PTP также содержит устройство Calnex Sentinel 2.0, ответственное за мониторинг состояния системы: расхождение между Time Card и сетевым адаптером должно укладываться в окно размером не более 50 нс.

21.10.2022 [13:26], Сергей Карасёв

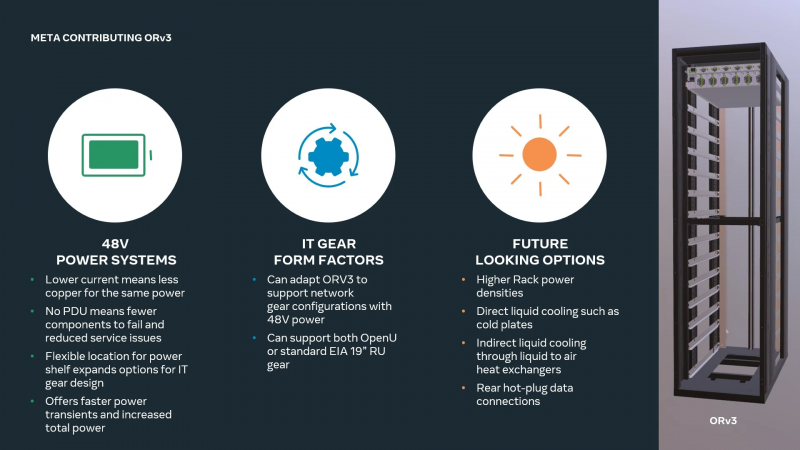

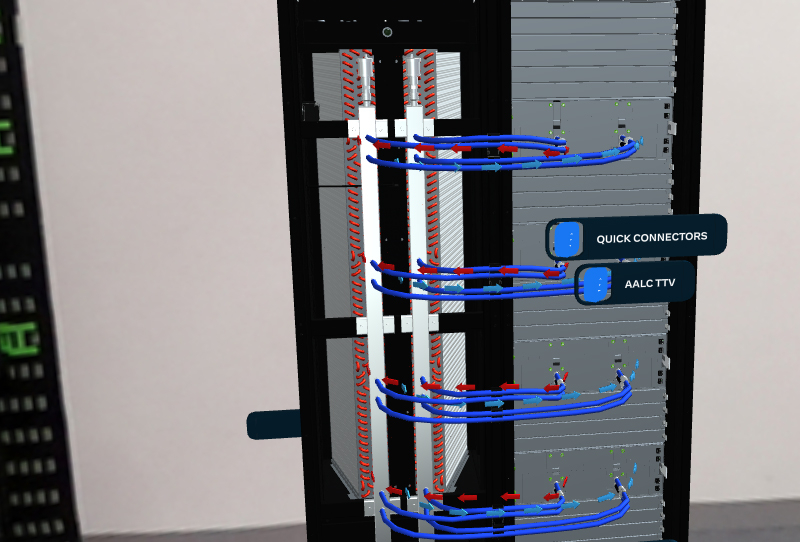

Meta✴ готова к массовому внедрению СЖО в своих дата-центрахКомпания Meta✴ в ходе саммита OCP (Open Compute Project) рассказала о планах по внедрению жидкостного охлаждения в своих ЦОД. Речь идёт об использовании гибридной системы AALC (Air-Assisted Liquid Cooling), предусматривающей совмещение компонентов воздушного охлаждения и жидкостного контура. Отмечается, что по мере развития машинного обучения и метавселенных всё острее встаёт проблема эффективного отвода тепла от оборудования. Дело в том, что внедряемые алгоритмы требуют больших вычислительных мощностей, что приводит к увеличению энергозатрат. Система AALC предназначена для охлаждения серверов в ЦОД, которые изначально могли быть и не спроектированы под использование СЖО. Отметим, что QCT уже представила аналогичное, полностью интегрированное решение.

Источник изображений: Meta✴ AALC совместима со стойкой Open Rack v3 (ORV3), которая, впрочем, может интегрироваться и с другими вариантами СЖО. Система AALC в исполнении Meta✴ использует водоблоки для самых горячих компонентов, которые подключаются к отдельной стойке с помпами и прочим оборудованием. На задней панели или двери стойки располагается теплообменник, позволяющий охлаждать жидкость за счёт воздуха, циркулирующего в ЦОД. Прототипы решения справляются с охлаждением оборудования мощностью до 40 кВт на стойку. ORV3 также предлагает общую архитектуру стойки и подсистемы питания для устранения разрыва между нынешними и будущими ЦОД. Обеспечивается широкий спектр вариантов использования, включая поддержку Grand Teton. Модуль питания для общей на всю стойку шины 48 В DC не имеет жёстко определённого расположения и может устанавливается в любом месте стойки, что обеспечивает гибкость конфигурации. При этом он может быть не один, так что пиковая мощность может достигать 30 кВт на стойку. Усовершенствованный ИБП обеспечивает работу в течение 4 мин. при мощности 15 кВт (против 1,5 мин. у решения предыдущего поколения). Этот блок также может монтироваться в любом месте стойки, а дополнительно возможно применение второго резервного блока. Всё это позволит Meta✴ уже сейчас развёртывать в ЦОД высокоплотную инфраструктуру для ИИ и иных требовательных к питанию и охлаждению решений.

26.07.2022 [10:56], Сергей Карасёв

Kioxia представила корпоративные SSD серии CM7 с PCIe 5.0 и NVMe 2.0Компания Kioxia анонсировала твердотельные накопители CM7 корпоративного класса, оптимизированные для использования в высокопроизводительных и высокоэффективных серверах, а также системах хранения данных. Уже начаты отгрузки устройств некоторым заказчикам. Изделия серии CM7 доступны в двух вариантах исполнения: EDSFF E3.S и SFF толщиной 15 мм. Задействован интерфейс PCIe 5.0 (спецификация NVMe 2.0): утверждается, что по сравнению с накопителями предыдущего поколения производительность увеличилась в два раза. Заявленная скорость чтения информации достигает 14 Гбайт/с; скорость записи не уточняется. Заказчики смогут выбирать между устройствами с разным уровнем надёжности: 1 DWPD (полных перезаписей в сутки) и 3 DWPD. В первом случае вместимость достигает 30,72 Тбайт, во втором — 12,80 Тбайт.

Источник изображения: Kioxia Накопители CM7 имеют двухпортовую конструкцию. Среди поддерживаемых функций названы SR-IOV, CMB, Multistream writes, SGL. Говорится о поддержке TCG-Opal в соответствии со стандартом FIPS 140-3. Наконец, упомянуты средства обеспечения безопасности Flash Die Failure Protection.

29.04.2022 [22:04], Алексей Степин

Meta✴ синхронизирует время в своих дата-центрах с помощью модулей Orolia Spectratime на базе рубидиевых атомных часовТакой масштабный проект, как метавселенная, создаваемая ныне Meta✴, будет включать в себя огромное количество серверов в дата-центрах по всей планете, которые будут обслуживать единое виртуальное пространство. Функционирование столь сложного проекта, естественно, не может не зависеть от точной синхронизации часов, и чем точнее этот процесс, тем лучше. С целью обеспечения идеальной точности синхронизации Meta✴ будет использовать в своих серверах «карты времени» Orolia. Они используют открытый протокол и разработаны в сотрудничестве с самой Meta✴. Модули Orolia Spectratime mRO-50 пользуются компактными рубидиевыми атомными часами, чья точность уступает лишь гораздо более дорогим цезиевым собратьям, используемым в качестве первичного стандарта частоты.

Плата Orolia/Meta✴ имеет форм-фактор FHHL и интерфейс PCI Express x4 Благодаря использованию новых плат синхронизации Meta✴ надеется добиться снизить максимальное расхождение часов в разных ЦОД до уровня менее 100 мкс. Ранее Meta✴ удалось снизить этот параметр с 10 мс до 100 мкс благодаря использованию сигналов GNSS. В 2021 году был показан прототип PCIe-адаптера, которым компания поделилась с инициативой Time Appliance Project (TAP), действующей в рамках Open Compute Project (OCP).

Модуль рубидиевых атомных часов Orolia mRO-50 На основе разработок Meta✴ Time Card в итоге и был создан адаптер точного времени Orolia ART Card. Сейчас пришло время для второго поколения, которое получило название ART2. Сам модуль Orolia Spectratime mRO-50 генерирует стабильный сигнал частотой 10 МГц, отклонения которой не превышают 4×10-10 при изменении температуры и 1×10-11 в день в процессе трёхмесячной эксплуатации.

29.04.2022 [21:35], Руслан Авдеев

Новые дата-центры Meta✴ для метавселенной будут построены из «зелёного» бетона, созданного с помощью ИИКомпания Meta✴ приступила к расширению кампуса дата-центров DeKalb в штате Иллинойс (США), которые, как предполагается, будут применяться для дальнейшего развития метавселенной. Для того, чтобы разработать материал для новых построек, Meta✴ прибегла к помощи искусственного интеллекта — специально подобранные «зелёные» компоненты позволят частично заменить традиционный бетон. Цемент является основой множества современных строительных материалов, применяемых в промышленных масштабах — по имеющейся статистике на его производство приходится порядка 8 % всех углеродных выбросов в мире. Для того, чтобы создать более приемлемую для экологии альтернативу, Meta✴ объединила усилия с Университетом Иллинойса в Урбане-Шампейне (UIUC), Массачусетским технологическим институтом (MIT) и IBM.

Источник изображения: tech.fb.com При участии системы искусственного интеллекта была обработана база данных со сведениями о характеристиках и компонентах бетонов. В результате проведённой работы была подобрана смесь летучей золы и шлака, способная частично заменить классический цемент. Полученные данные были переданы поставщику бетона — компании Ozinga, которая оптимизировала смесь исходя из своего опыта и доступности материалов, сохранив при этом необходимую прочность. Новый «зелёный» бетон, по оценкам Meta✴, обеспечивает на 40 % меньший углеродный выброс при создании. Помимо двух уже строящихся зданий для кампуса будут построены ещё три с использованием новых технологий. По имеющимся сведениям, новую смесь уже применили при строительстве второстепенных объектов. Общая площадь зданий ЦОД составит более 222 тыс. м2.

Источник изображения: tech.fb.com Как и многие штаты, Иллинойс предложил в 2019 году налоговые льготы на ЦОД-оборудование для привлечения операторов. Meta✴ так и не воспользовалась данными преимуществами, но от послаблений при расчётах налога на собственность не отказалась. После введения объектов в эксплуатацию новые ЦОД не только будут способствовать расширению метавселенной, но и обеспечат работой более 200 человек. На момент первого анонса проекта Meta✴ обещала, что кампус будет использовать 100 % возобновляемой энергии, а строения получат золотой сертификат Leadership in Energy and Environmental Design (LEED) за экологическую безопасность конструкции. Общий объёмы инвестиций в кампус в Иллинойсе составят более $1 млрд. Ранее сообщалась, что Meta✴ активно наращивает инвестиции в строительство ЦОД и сетевую инфраструктуру по всему миру. |

|