Материалы по тегу: mit

|

31.01.2026 [20:37], Сергей Карасёв

RISC-V, Wi-Fi 6, Bluetooth 5.2 и 10GbE SFP+: представлен одноплатный компьютер Milk-V Jupiter 2Компания Shenzhen MilkV Technology (Milk-V), по сообщению ресурса CNX Software, готовит к выпуску одноплатный компьютер Jupiter 2 на архитектуре RISC-V. Это, как утверждается, первое изделие в своём классе с поддержкой профиля RVA23. Устройство может использоваться для работы с приложениями ИИ. В основу положен чип SpacemiT K3 в составе модуля K3-CoM260 (Jupiter 2 NX). Процессор объединяет восемь 64-бит вычислительных ядер RISC-V X100 с тактовой частотой до 2,4 ГГц и восемь ИИ-ядер RISC-V A100. Заявленная производительность на операциях INT4 достигает 60 TOPS. В состав изделия входит графический ускоритель Imagination Technologies BXM4-64-MC1 с поддержкой Vulkan 1.3, OpenGL 3.0 и OpenGL ES 1.1/2.0/3.2. Блок VPU обеспечивает возможность декодирования материалов H.265, H.264, VP9 в формате до 4K (120 к/с) и кодирования H.265, H.264 до 4K (60 к/с). Объём оперативной памяти LPDDR5-6400 достигает 32 Гбайт, вместимость флеш-накопителя UFS — 256 Гбайт. Есть слот microSD. Модуль K3-CoM260 подключается через 260-контактный коннектор SO-DIMM. Одноплатный компьютер несёт на борту адаптеры Wi-Fi 6 и Bluetooth 5.2. Доступны разъём M.2 M-Key 2280 для SSD с интерфейсом PCIe 3.0 x4 и коннектор M.2 B-Key 2242/3052 (PCIe x2 + USB 2.0) для модема 4G/5G (плюс слот для карты Nano SIM). Реализованы сетевые порты 10GbE SFP+ на базе RealTek RTL8127 и 1GbE RJ45 на основе RealTek RTL8211. Присутствуют интерфейсы USB 3.2 Type-C (DP 1.2 Alt Mode и USB PD) и USB 3.2 Type-C OTG, а также четыре разъёма USB 2.0 Type-A. Новинка выполнена в форм-факторе Pico-ITX Plus с размерами 100 × 86 мм (103 × 90,5 × 35 мм с радиатором охлаждения). Питание может подаваться через 2-контактный коннектор ATX или порт USB Type-C. Говорится о совместимости с Bianbu 3.0 OS, Ubuntu 26.04, OpenHarmony 6.0, OpenKylin 2.0, Deepin 25 и Fedora. Цена — от $200.

28.04.2025 [12:54], Сергей Карасёв

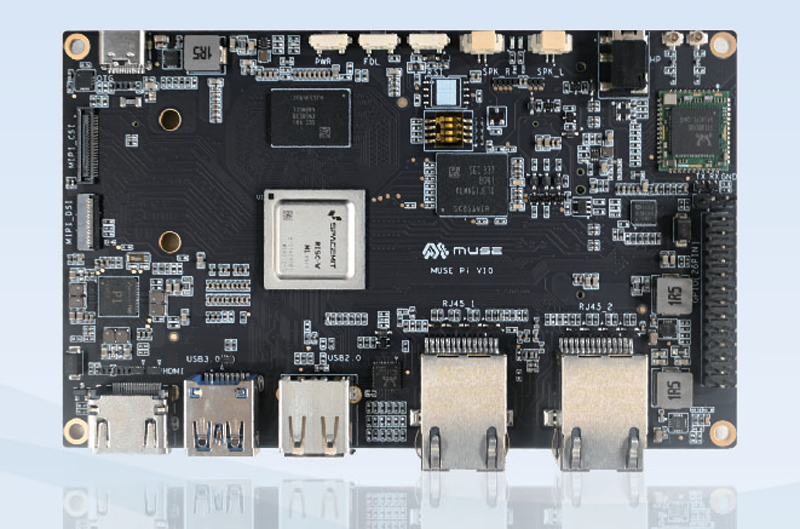

Одноплатный компьютер Muse Pi Pro оснащён чипом RISC-V, адаптерами Wi-Fi 6 и Bluetooth 5.2Китайская компания SpacemiT, по сообщению ресурса CNX Software, выпустила одноплатный компьютер Muse Pi Pro — более компактную модификацию изделия Muse Pi, которое дебютировало в июне 2024 года. Новинка уже доступна для заказа по ориентировочной цене от $122. Как и оригинальная версия, модель Muse Pi Pro несёт на борту процессор SpacemiT M1 с восемью ядрами X60 с архитектурой RISC-V, работающими на частоте до 1,8 ГГц. В состав чипа входят графический ускоритель Imagination IMG BXE-2-32 с поддержкой OpenGL ES3.2, Vulkan 1.2 и OpenCL 3.0, а также VPU-блок с возможностью кодирования/декодирования материалов H.265/H.264 1080p60. Кроме того, имеется нейропроцессорный узел (NPU) с ИИ-производительностью до 2 TOPS (INT8).

Источник изображения: CNX Software Одноплатный компьютер может комплектоваться 8 или 16 Гбайт оперативной памяти LPDDR4X-2400, а также флеш-чипом eMMC 5.1 вместимостью 64 или 128 Гбайт. Есть слот microSD (UHS-II), коннектор M.2 M-Key 2230 для NVMe SSD и коннектор miniPCIe (PCIe 2.1 x1) для сотового модема 4G/5G. В оснащение входят адаптеры Wi-Fi 6 и Bluetooth 5.2, сетевой контроллер 1GbE. Устройство располагает разъёмом HDMI 1.4 (1080p60), четырьмя портами USB 3.0 Type-A и одним портом USB 2.0 Type-C OTG, гнездом RJ45 для сетевого кабеля, интерфейсами MIPI CSI на четыре и две линии, 40-контактной колодкой GPIO и 3,5-мм аудиогнездом. Габариты составляют 85 × 56 мм. Диапазон рабочих температур простирается от -20 до +70 °C у обычной версии и от -40 до +85 °C у индустриального варианта. Питание (5/9/12 В, до 3 A) подаётся через разъём USB Type-C. Говорится о совместимости с Bianbu Desktop, Ubuntu, OpenKylin, Deepin, Fedora и др.

21.04.2025 [08:46], Сергей Карасёв

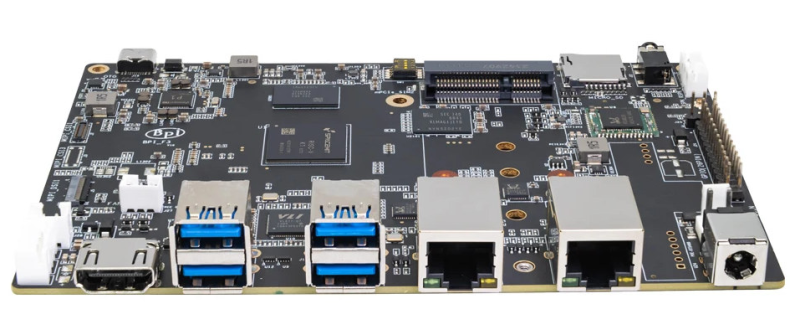

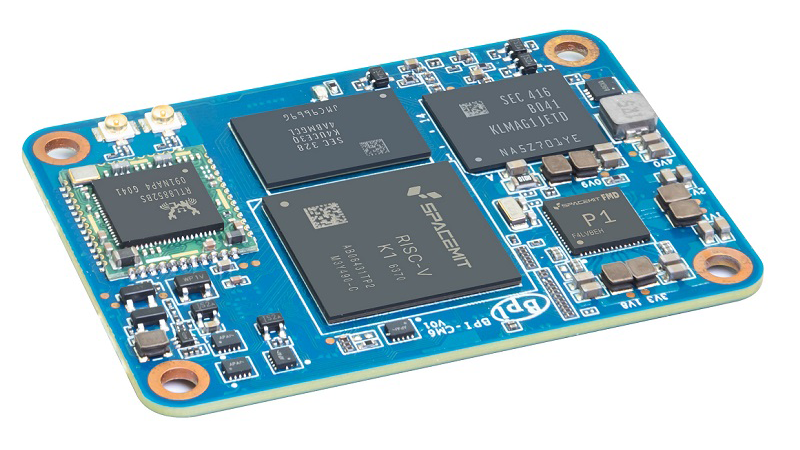

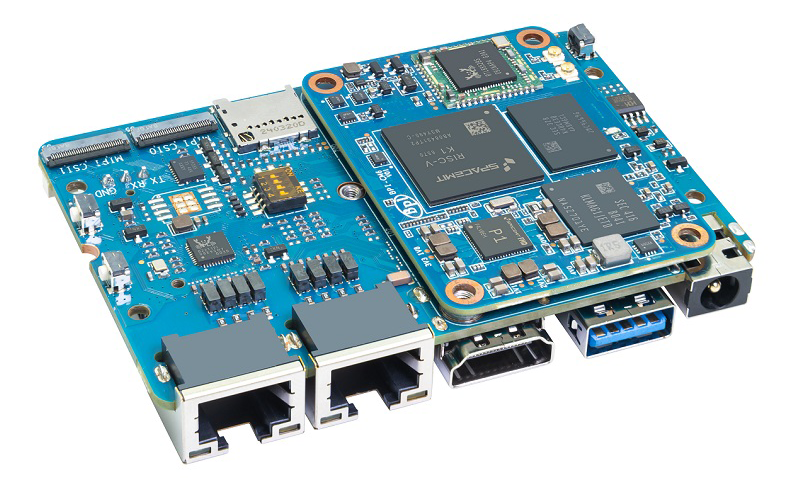

Представлен модуль Banana Pi BPI-CM6 — аналог Raspberry Pi CM4 на базе RISC-VВ ассортименте Banana Pi появился вычислительный модуль BPI-CM6 — это альтернатива Raspberry Pi CM4, выполненная на процессоре с открытой архитектурой RISC-V вместо Arm. Новинка подходит для создания систем промышленного контроля и автоматизации, NAS-устройств, робототехники, периферийных решений и пр. По форме, габаритам и расположению коннекторов новинка идентична Raspberry Pi CM4. Задействован чип SpacemiT K1, который объединяет восемь 64-битных ядер RISC-V, графический блок Imagination BXE-2-32 с поддержкой OpenCL 3.0, OpenGL ES3.2 и Vulkan 1.3, а также нейропроцессорный узел (NPU) с производительностью до 2 TOPS для ускорения ИИ-операций.

Источник изображений: Banana Pi Модуль Banana Pi BPI-CM6 располагает 8 Гбайт оперативной памяти LPDDR4 (максимум 16 Гбайт) и чипом eMMC вместимостью 16 Гбайт (максимум 128 Гбайт). Реализована поддержка Bluetooth и Wi-Fi, PCIe 2.1 (5 линий), USB 3.0 и USB 2.0 (×2), HDMI 1.4, MIPI DSI и MIPI CSI (×3). Размеры составляют 40 × 55 мм. Диапазон рабочих температур простирается от -40 до +85 °C. Говорится о совместимости с Ubuntu Linux.  Для новинки доступна сопутствующая интерфейсная плата, которая содержит по одному разъёму HDMI, USB 3.0 Type-A, USB 2.0 Type-A и USB Type-C OTG, два сетевых порта 1GbE RJ45 и слот для карты microSD. Кроме того, есть два коннектора M.2 M-Key (PCIe х2) для подключения SSD, 26-контактная колодка GPIO, два интерфейса MIPI CSI (4 линии) и один интерфейс MIPI DSI (4 линии). Питание (12 В) подаётся через DC-коннектор. Габариты — 56 × 85 мм.

01.07.2024 [12:35], Сергей Карасёв

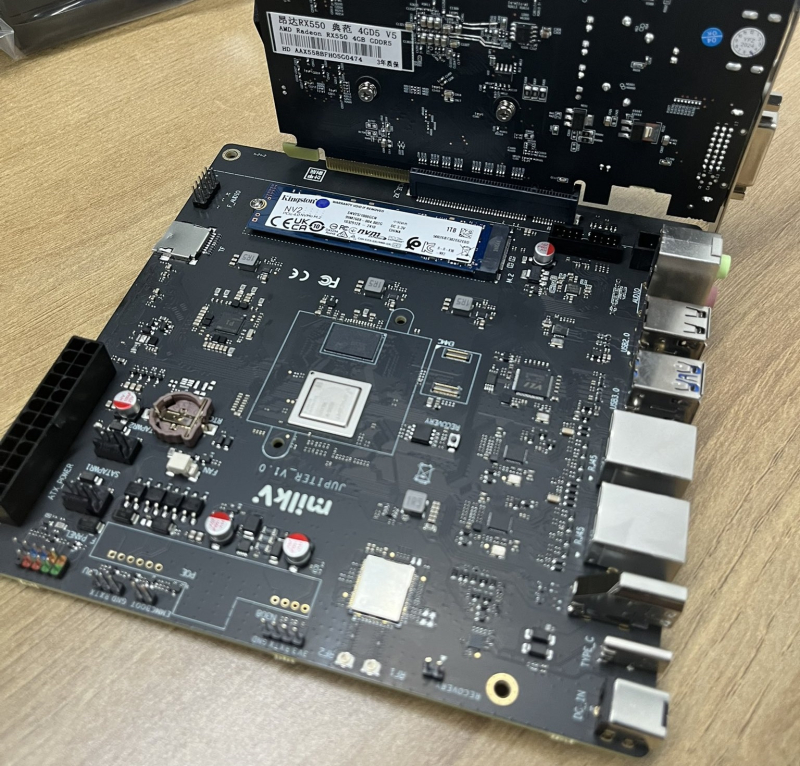

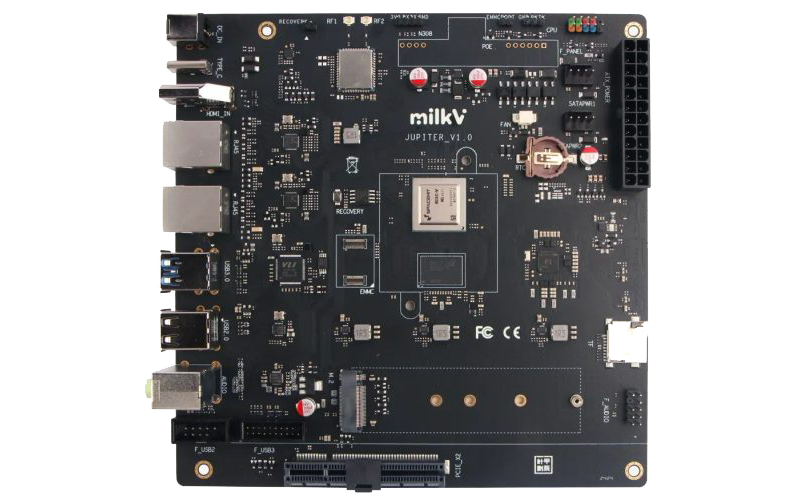

Mini-ITX плата Milk-V Jupiter получила чип RISC-V с восемью ядрамиКомпания Shenzhen MilkV Technology (Milk-V), по сообщению ресурса Liliputing, подготовила к выпуску плату под названием Jupiter, оснащённую процессором на архитектуре RISC-V. Новинка имеет типоразмер Mini-ITX, благодаря чему совместима с разнообразными существующими корпусами. Габариты изделия составляют 170 × 170 мм. В зависимости от модификации применяется процессор SpacemiT K1 или M1 с восемью ядрами SpacemiT X60 на базе RISC-V. В состав чипа входят графический ускоритель Imagination BXE-2-32 и нейропроцессорный модуль (NPU) с производительностью до 2 TOPS. Объём оперативной памяти LPDDR4x может составлять 4, 8 или 16 Гбайт (напаяна на плату, что исключает возможность апгрейда).

Источник изображения: Liliputing Доступны коннектор для SSD формата M.2 2280 с интерфейсом PCIe 2.0 x2 и слот для карты microSD. Кроме того, может быть добавлен чип eMMC. Есть также слот PCIe 2.0 х8 для карт расширения, например, GPU или дополнительных SSD. Поддерживается беспроводная связь Wi-Fi 6 и Bluetooth 5.2. Набор разъёмов включает порты USB 2.0 Type-C, USB 3.0 Type-A (×2) и USB 2.0 Type-A (×2), интерфейс HDMI (до 1920 × 1440 пикселей; 60 Гц), 3,5-мм аудиогнёзда (аудиовыход, вход для микрофона), два коннектора RJ-45 для сетевых кабелей (адаптер 1GbE), DC-гнездо для подачи питания (12 В). Через разъёмы на самой плате также можно задействовать по два дополнительных порта USB 3.0 и USB 2.0. Среди прочего упомянуты коннектор RTC для батарейки стандарта CR1220 и разъём для подключения вентилятора с ШИМ-управлением. Опционально доступна поддержка технологии PoE.

10.06.2024 [08:11], Сергей Карасёв

Одноплатный компьютер SpacemiT Muse Pi оснащен 8-ядерным чипом RISC-VКитайская компания SpacemiT анонсировала одноплатный компьютер Muse Pi, оснащённый процессором SpacemiT M1 на архитектуре RISC-V. Новинка доступна для заказа в конфигурации с 8 Гбайт оперативной памяти LPDDR4x-4266 и флеш-модулем eMMC вместимостью 32 Гбайт по ориентировочной цене $200. В плане форм-фактора изделие аналогично модели Banana Pi BPI-F3, которая оснащена чипом SpacemiT K1 на базе RISC-V с восемью ядрами, а также нейропроцессорным модулем (NPU) с производительностью до 2 TOPS. По заявлениям SpacemiT, процессор М1 по сравнению с К1 обладает более высокой производительностью. Он содержит восемь ядер с тактовой частотой до 1,6 ГГц и поддерживает стандарты RISC-V 64GCVB и RVA22.

Источник изображения: SpacemiT Одноплатный компьютер Muse Pi получил два сетевых порта 1GbE на основе разъёмов RJ-45, адаптеры Wi-Fi 6 (частотные диапазоны 2,4 и 5 ГГц) и Bluetooth 5.0 (с поддержкой Bluetooth Low Energy). Есть интерфейс HDMI 1.4 с поддержкой видео Full HD (1920 × 1080 пикселей; 60 Гц). Присутствуют порты USB 2.0 OTG Type-C (подача питания и обмен данными), USB 3.0 Type-A и USB 2.0 Type-A. Среди прочего упомянуты интерфейсы MIPI DSI (4 линии) и 2 × MIPI CSI (4 линии), 26-контактная колодка GPIO и слот для карты microSD. Говорится об использовании кастомизированного чипа P1 для управления питанием. В качестве программной платформы применяется Bianbu OS — сборка Linux, основанная на Debian и оптимизированная для процессоров SpacemiT с архитектурой RISC-V.

10.05.2024 [21:34], Сергей Карасёв

Восьмиядерный RISC-V с NPU: одноплатный компьютер Banana Pi BPI-F3 получил чип SpacemiT K1Banana Pi, по сообщению ресурса CNX Software, начала поставки одноплатного компьютера BPI-F3, особенностью которой является использование процессора SpacemiT K1 на открытой архитектуре RISC-V. Изделие подходит для работы с приложениями ИИ. Новинка была анонсирована в феврале этого года. Чип SpacemiT K1 объединяет восемь 64-бит RISC-V ядер, неназванный графический блок с поддержкой OpenCL 3.0, OpenGL ES3.2 и Vulkan 1.2, а также нейропроцессорный модуль (NPU) с производительностью до 2 TOPS. Говорится о возможности кодирования/декодирования материалов H.265, H.264, VP9, VP8.

Источник изображения: Banana Pi Объём оперативной памяти LPDDR4 может составлять 2 или 4 Гбайт, вместимость флеш-модуля eMMC — 8 или 16 Гбайт. Есть слот для карты microSD и коннектор M.2 Key-M для SSD с интерфейсом PCIe 2.1 x1 или SATA. Опционально могут быть добавлены флеш-чипы SPI NAND на 32 Мбайт и SPI NOR на 4 Мбайт. В оснащение входят два порта 1GbE (RJ-45) на контроллере Realtek RTL8211F с опциональной поддержкой PoE (через плату RT5400), а также адаптеры Wi-Fi 5 (2,4/5 ГГц) и Bluetooth 4.2 на базе Realtek RTL8852BS. Дополнительно предлагается модем 4G в виде модуля mPCIe (плюс слот для SIM-карты). Доступны четыре порта USB 3.0 Type-A, разъём USB 2.0 Type-C и коннектор HDMI 1.4 (до 1080p60). Поддерживаются интерфейсы MIPI DSI (4 линии) и 2 × MIPI-CSI (4 линии). Кроме того, упомянуты 26-контактная колодка GPIO, инфракрасный порт и разъём для подсоединения вентилятора. Питание (12 В / 3 A) подаётся через DC-гнездо. Габариты составляют 148 × 100 мм, вес — около 200 г. Цена начинается примерно с $63.

22.04.2023 [00:15], Алексей Степин

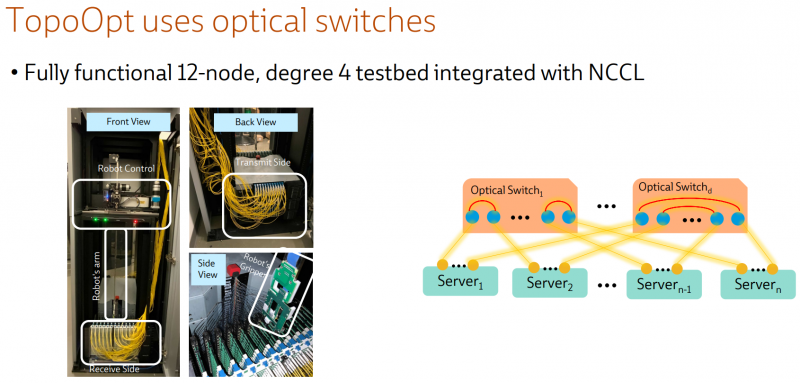

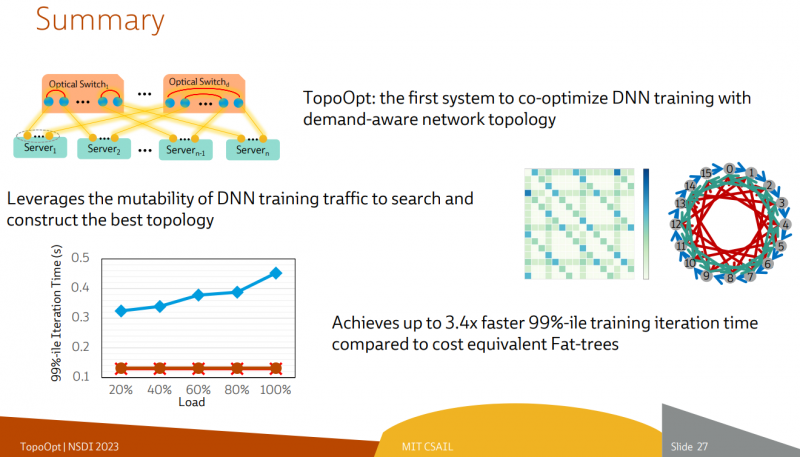

Ловкость роборук: TopoOpt от Meta✴ и MIT поможет ускорить и удешевить обучение ИИТехнологии искусственного интеллекта (ИИ) сегодня бурно развиваются и требуют всё более серьёзных вычислительных мощностей. Но наряду с наращиванием этих мощностей растут требования и к сетевой подсистеме, поэтому крупные компании и исследовательские организации ищут всё новые способы оптимизации инфраструктуры. Компания Meta✴ в сотрудничестве с Массачусетским технологическим институтом (MIT) и рядом прочих исследовательских организаций опубликовала данные любопытного эксперимента, в котором ИИ-кластер мог менять топологию своего интерконнекта с помощью механической «роборуки». Система получила название TopoOpt, поскольку вычислительные узлы в ней использовали полностью оптическую сеть с оптической же патч-панелью. Эта сеть объединяла 12 вычислительных узлов ASUS ESC4000A-E10, каждый из которых был оснащён ускорителем NVIDIA A100, сетевыми адаптерами HPE и Mellanox ConnectX-5 (100 Гбит/с) с оптическими трансиверами. Наиболее интересное устройство в эксперименте — оптическая патч-панель Telescent, оснащённая механическим манипулятором, способным производить перекоммутацию на лету. Эта «роборука» работала под управлением специализированного ПО, целью которого ставилось нахождение оптимальной сетевой топологии и сегментации сети применительно к различным задачам машинного обучения.

Система с перекоммутируемой оптической сетью не требует энергоёмких высокоскоростных коммутаторов и обеспечивает ряд других преимуществ Такая роботизированная патч-панель не столь расторопна, как оптические коммутаторы Google с микрозеркальной механикой, но стоит впятеро дешевле и имеет больше портов. Опубликованные экспериментальные данные уверенно свидетельствуют о том, что топология «толстого дерева» (fat tree), использующая несколько слоёв коммутаторов, не оптимальна и даже избыточна для ряда нейросетевых задач. К тому же перекоммутируемая оптическая сеть без традиционных высокоскоростных коммутаторов требует меньше оборудования, а значит, может быть не только быстрее сети fat tree в ряде ИИ-задач, но и существенно дешевле в развёртывании и поддержании в рабочем состоянии — как минимум за счёт отсутствия затрат на питание множества коммутаторов. |

|