Материалы по тегу: ff

|

07.06.2024 [10:31], Сергей Карасёв

Western Digital представила SSD серии Ultrastar DC SN861 с интерфейсом PCIe 5.0 для ИИ-нагрузокКомпания Western Digital анонсировала SSD корпоративного класса семейства Ultrastar DC SN861, рассчитанные на поддержание ресурсоёмких нагрузок, связанных с большими языковыми моделями (LLM), инференсом, приложениями ИИ и пр. Изделия будут предлагаться в трёх вариантах исполнения — U.2, E1.S и E3.S. Решения U.2 выполнены в SFF-формате толщиной 15 мм. Используется интерфейс PCIe 5.0 х4 (NVMe 2.0). В серии представлены модификации вместимостью 1,60, 1,92, 3,2, 3,84, 6,4 и 7,68 Тбайт. Заявлена поддержка TCG Opal 2.01. Средства Power Loss Protection отвечают за сохранность данных при внезапном отключении питания. Скорость чтения информации у всех накопителей достигает 13 700 Мбайт/с, а скорость записи варьируется от 3600 до 7500 Мбайт/с. Показатель IOPS при чтении — от 2,1 млн до 3,3 млн, при записи — от 165 тыс. до 665 тыс. Изделия могут выдерживать до одной полной перезаписи в сутки (показатель DWPD), а версии на 3,2 и 6,4 Тбайт — до трёх. Решения стандарта E1.S, в свою очередь, имеют ёмкость 1,92, 3,84 и 7,68 Тбайт. Они выполнены в корпусе толщиной 15 мм. Применяется интерфейс PCIe 5.0 х4 (NVMe 1.4b). Скорость чтения варьируется от 12 100 до 13 700 Мбайт/с, скорость записи — от 3400 до 7000 Мбайт/с. Устройства обладают показателем IOPS от 1,55 млн до 3,2 млн при чтении и от 140 тыс. до 235 тыс. при записи. Величина DWPD равна 1. Все накопители рассчитаны на эксплуатацию при температурах от 0 до +70 °C. Средняя наработка на отказ (MTTF) заявлена в 2,5 млн часов. Гарантия производителя — пять лет. Характеристики устройств формата E3.S пока не раскрываются. Кроме того, Western Digital объявила о расширении семейства накопителей Ultrastar DC SN655. Теперь в него входят модели вместимостью до 64 Тбайт. Наконец, компания сообщила о начале пробных поставок HDD серии Ultrastar DC HC690 на основе технологии UltraSMR ёмкостью 32 Тбайт.

19.05.2024 [18:07], Игорь Осколков

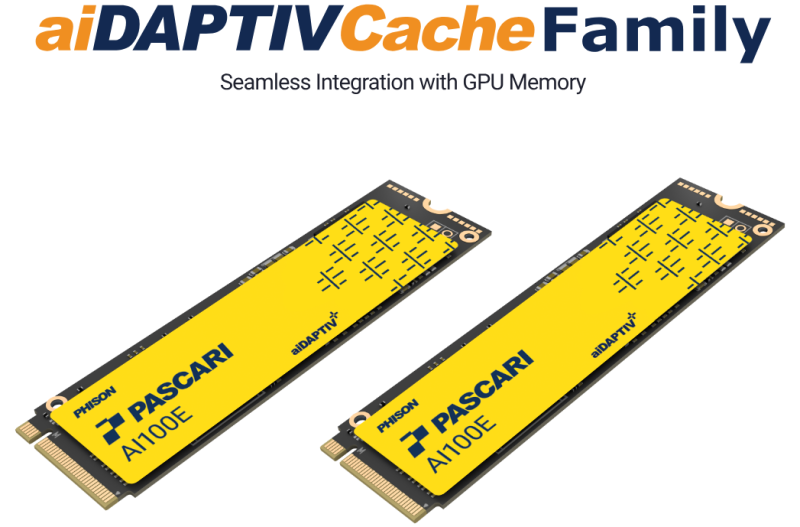

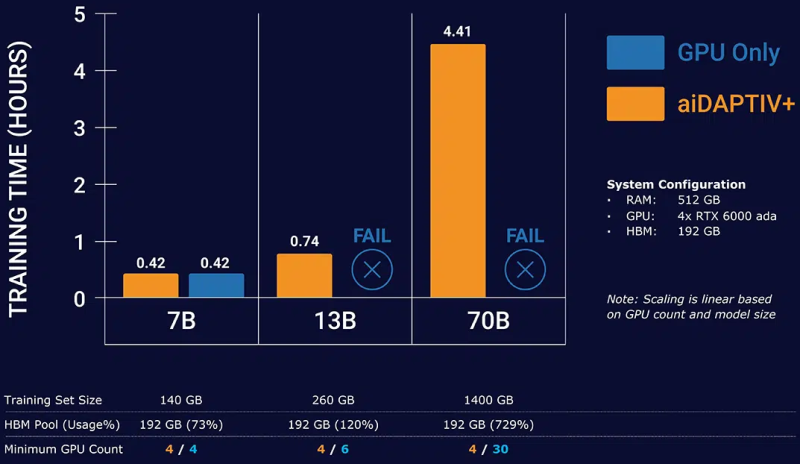

Phison представила новый бренд серверных SSD PASCARI и накопители X200 с PCIe 5.0Phison представила собственный бренд SSD корпоративного класса PASCARI, который включает сразу несколько различных серий: X, AI, D, S и B. Новинки представлены в форм-факторах E1.S, E3.S, U.3/U.2, M.2 2280/22110 и SFF 2,5″ и наделены интерфейсами SATA-3 и PCIe 4.0/5.0. Наиболее интересна серия AI (или aiDAPTIVCache), которая фактически является частью программно-аппаратного комплекса aiDAPTIV+. Пока упоминается только один M.2 SSD — AI100E. Это сверхбыстрые и сверхнадёжные 2-Тбайт NVMe-накопители на базе SLC NAND (вероятно, всё же eSLC) с DWPD, равным 100 на протяжении трёх или пяти лет (в материалах указаны разные сроки). Аналогичные накопители, хотя и в более крупном форм-факторе, предлагают Micron и Solidigm, а Kioxia в прошлом году анонсировала накопители на базе XL-Flash второго поколения с MLC NAND. Во всех случаях, по сути, речь идёт об SCM (Storage Class Memory). Наиболее ярким представителем данной категории была почившая серия продуктов Intel Optane. Phison переняла общую идею перестройки иерархии памяти, где SCM является ещё одним слоем между DRAM и массивом SSD, приложив её к задачам обучения ИИ. AI100E являются кеширующими накопителями, расширяющими доступную память. Программная прослойка aiDAPTIVLink общается с ускорителями NVIDIA и SSD с одной стороны и с PyTorch (также есть упоминание TensorFlow) — с другой. aiDAPTIVLink позволяет автоматически и прозрачно переносить на SSD неиспользуемые в текущий момент части обучаемой LLM и по необходимости отправлять их сначала в системную RAM, а потом и в память ускорителя, что и позволяет обходиться меньшим числом ускорителей при тренировке действительно больших моделей. Естественно, никакого чуда здесь не происходит, поскольку время обучения от этого нисколько не сокращается, но с другой стороны, обучение становится в принципе возможным на системах с малым количеством ускорителей или просто с относительно слабыми GPU и относительно небольшим же объёмом системной RAM. Среди уже поддерживаемых моделей упомянуты некоторые LLM семейств Llama, Mistral, ResNet и т.д. Для них, как заявляется, не нужны никакие модификации для работы с aiDAPTIV+. Также упомянута возможность горизонтального масштабирования при использовании данной технологии. Точные характеристики AI100E компания не приводит, но это и не так существенно, поскольку напрямую продавать эти накопители она не собирается. Вместо этого они будут предлагаться в составе готовых и полностью укомплектованных рабочих станций или серверов. Семейство PASCARI X включает сразу четыре серии накопителей. Так, X200E (DWPD 3) и X200P (DWPD 1) — это двухпортовые накопители на базе TLC NAND с интерфейсом PCIe 5.0 x4, представленные в форм-факторах U.2 и E3.S. Пиковые скорости последовательного чтения и записи составляют 14,8 Гбайт/с и 8,35 Гбайт/с соответственно. На случайных операциях с 4K-блоками производительность чтения достигает 3 млн IOPS, а записи — 900 тыс. IOPS у X200E и 500 тыс. IOPS у X200P. Здесь и далее даны только крайние показатели в рамках серии, а не отдельного накопителя. Ёмкость X200E составляет 1,6–12,8 Тбайт, но также готовится 25,6-Тбайт U.2-версия. У X200P диапазон ёмкостей простирается от 1,92 Тбайт до 15,36 Тбайт, но опять-таки будет 30,72-Тбайт вариант в U.2-исполнении. Отмечается поддержка MF-QoS (QoS для различных нагрузок), поддержка 64 пространств имён, MTBF на уровне 2,5 млн часов, сквозная защита целостности передаваемых данных, улучшенная защита от потери питания и т.д. У X100E (DWPD 3) и X200P (DWPD 1) среди возможностей дополнительно упомянуты поддержка TCG Opal 2.0, NVMe-MI, шифрования AES-256, безопасной очистки и т.д. От X200 эти накопители отличаются в первую очередь интерфейсом PCIe 4.0 x4 (возможны два порта x2). Выпускаются они только в форм-факторе U.3/U.2. X100E предлагают ёмкость от 1,6 Тбайт до 25,6 Тбайт, а X100P — от 1,92 Тбайт до 30,72 Тбайт. Пиковые скорости последовательного чтения и записи в обоих случаях достигают 7 Гбайт/с. Произвольное чтение 4K-блоками — до 1,7 млн IOPS, а вот запись у X100E упирается в 480 тыс. IOPS, тогда как у X100P и вовсе не превышает 190 тыс. IOPS. В семейство PASCARI D входит всего одна серия компактных накопителей D100P на базе TLC NAND с интерфейсом PCIe 4.0 x4 (один порт, NVMe 1.4), представленная в форм-факторах M.2 2280 (от 480 Гбайт до 1,92 Тбайт), M.2 22110 (от 480 Гбайт до 3,84 Тбайт) и E1.S (тоже от 480 Гбайт до 1,92 Тбайт). Производительность M.2-вариантов составляет до 6 Гбайт/с и 2 Гбайт/с на последовательных операциях чтения и записи, а на случайных — до 800 тыс. IOPS и 60 тыс. IOPS соответственно. E1.S-версия чуть быстрее в чтении — до 6,8 Гбайт/с. Надёжность — 1 DWPD. Среди особенностей вендор выделяет сквозную защиту целостности данных, LPDC-движок четвёртого поколения, поддержку NVMe-MI и т.п. PASCARI B включает серию загрузочных накопителей B100P: M.2 2280 (будет и 22110), TLC NAND, PCIe 4.0 x4, 1 DWPD и те же функции, что у D100P. Доступны только накопители ёмкостью 480 Гбайт и 960 Гбайт. Скоростные характеристики относительно скромны. Последовательные чтение и запись не превышают 5 Гбайт/с и 700 Мбайт/с, а произвольные — 450 тыс. IOPS и 30 тыс. IOPS. Также к PASCARI B принадлежит серия BA50P: SATA-накопители в форм-факторах M.2 2280 и SFF 2,5″ на базе TLC NAND с DWPD 1 и ёмкостью 240/480/960 Гбайт. Скорости чтения/записи не превышают 530/500 Мбайт/с при последовательном доступе, и 90/20 тыс. IOPS при случайном доступе 4K-блоками. Наконец, семейство PASCARI S представлено тремя сериями SFF-накопителей (2,5″) с TLC-памятью и интерфейсом SATA-3, отличающихся в первую очередь опять-таки показателем надёжности: SA50E (3 DWPD), SA50P (1 DWPD) и SA50E (>0,4 DWPD). SA50E имеют ёмкость от 480 Гбайт до 3,84 Тбайт, SA50P — от 480 Гбайт до 7,68 Тбайт, а SA50E — от 1,92 Тбайт до 15,36 Тбайт. Отличаются и максимальные скорости произвольного чтения/записи 4K-блоками: 98/60 тыс., 98/40 тыс. и 97/20 тыс. IOPS соответственно. А вот последовательные чтение и запись естественным образом ограничены самим интерфейсом, т.е. не превышают 530 Мбайт/с и 500 Мбайт/с соответственно. В описании упомянуты сквозная защита целостности данных, LPDC-движок и улучшенная защита от потери питания. Для вообще всех накопителей заявленный диапазон рабочих температур простирается от 0 до 70 °C. А вот срок гарантии не указан, так что показатели DWPD теряют смысл. Кроме того, Phison практически для каждой серии говорит о возможности кастомизации. Например, для X100 предлагаются услуги IMAGIN+.

26.04.2024 [11:47], Сергей Карасёв

Meta✴ увеличит инвестиции в развитие инфраструктуры ИИ и готовит крупнейшие капиталовложения в истории компанииКомпания Meta✴, по сообщению ресурса Datacenter Dynamics, на фоне стремительного развития ИИ и больших языковых моделей (LLM) намерена увеличить инвестиции в дата-центры и серверное оборудование «на миллиарды долларов». Эти затраты, по заявлениям генерального директора Meta✴ Марка Цукерберга, жизненно необходимы, чтобы стать «ведущей ИИ-компанией в мире». По итогам I квартала текущего финансового года, который был завершён 31 марта, Meta✴ получила выручку в размере $36,46 млрд. Это на 27 % больше результата годичной давности, когда была зафиксирована сумма в $28,65 млрд. Чистая прибыль при этом подскочила на 117 % — с $5,71 млрд до $12,37 млрд.

Источник изображения: Meta✴ В финансовом отчёте говорится, что капитальные затраты по итогам квартала оказались на уровне $6,72 млрд, что несколько ниже по сравнению с прошлогодними $7,09 млрд. Тем не менее, Meta✴ намерена нарастить общие капвложения: ожидается, что в 2024 году в целом они достигнут $35–$40 млрд, тогда как ещё в феврале называлась цифра в диапазоне $30–$37 млрд. Это будут крупнейшие капиталовложения в истории компании. «Мы ожидаем, что капитальные затраты продолжат расти и в следующем году, поскольку мы активно инвестируем средства в исследования в области искусственного интеллекта», — отмечает финансовый директор Meta✴ Сьюзен Ли (Susan Li). По словам Цукерберга, в ближайшие годы компания будет наращивать инвестиции в создание и внедрение передовых ИИ-моделей, а также запуск ведущих мировых сервисов на базе ИИ. При этом Meta✴ намерена активно использовать собственные ИИ-ускорители Artemis в качестве альтернативы решениям NVIDIA и AMD.

23.04.2024 [11:42], Сергей Карасёв

Бывший вице-президент Meta✴ по инфраструктуре присоединился к ЦОД-подразделению MicrosoftДжейсон Тейлор (Jason Taylor), бывший исполнительный директор Meta✴ Platforms, по сообщению The Information, перешёл на работу в Microsoft, где занял пост старшего руководителя команды дата-центров. Его непосредственным начальником станет технический директор Microsoft Кевин Скотт (Kevin Scott). Тейлор проработал в Meta✴ почти 14 лет. Занимая должность вице-президента по инфраструктуре, он в числе прочего курировал расширение сети ЦОД и создание серверных чипов Meta✴. Тейлор ушёл из компании Марка Цукерберга (Mark Zuckerberg) в сентябре 2022 года. Согласно информации профилю LinkedIn, с тех пор он официально работал только в Intrepid Ventures.

Источник изображения: LinkedIn / Datacenter Dynamics Отмечается, что в Microsoft Тейлор будет исполнять обязанности, аналогичные тем, что были возложены на него в Meta✴. В настоящее время Microsoft активно развивает направление дата-центров, что связано со стремительным внедрением технологий ИИ. В частности, совместно с OpenAI создаётся масштабный кампус ЦОД под названием Stargate стоимостью около $100 млрд. Мощность объектов в составе этого комплекса суммарно составит до 5 ГВт. Кроме того, Microsoft продолжает закупать ускорители на базе GPU для решения ИИ-задач: планируется, что количество таких изделий в составе вычислительной ИИ-инфраструктуры корпорации к концу 2024 года достигнет 1,8 млн штук. Ожидается, что Тейлор примет участие в расширении сети дата-центров Microsoft, а также возьмёт на себя некоторые обязанности Брайана Гарри (Brian Harry), старшего руководителя команды ЦОД, который планирует уйти на пенсию. Сама корпорация назначение Тейлора никак не комментирует. Два месяца назад Microsoft также переманила к себе Ахмеда Шихаба (Ahmed Shihab), ответственного ранее за аппаратные решения облака AWS. На новом месте он займётся «созданием передовых сервисов хранения данных для платформы Azure».

22.04.2024 [16:35], Руслан Авдеев

Meta✴ и Alphabet X разрабатывают системы прямого захвата углекислоты из воздуха с помощью тепла ЦОДКомпания Meta✴ и Alphabet X работают над технологиями Direct Air Capture (DAC) для извлечения углекислого газа с последующей его утилизацией. По данным Datacenter Dynamics, для высвобождения углекислоты из сорбентов будет применяться тепло, выделяемое оборудованием дата-центров. Meta✴ ведёт соответствующие работы над DAC как минимум с 2021 года. Похоже, история началась с лабораторного прототипа технологии удаления углекислоты, интегрированной в системы охлаждения ЦОД. С тех пор проект претерпел некоторые изменения, но исследования по-прежнему продолжаются, как с жидкими сорбентами, так и с твёрдыми. Для регенерации поглощающих элементов действительно предполагается использовать «мусорное» тепло ЦОД.

Источник изображения: Ella Ivanescu/unsplash.com После захвата CO2 из воздуха сорбент способен при нагревании высвобождать его для хранения где угодно, например, в подземных полостях. По последним данным, Meta✴ работает над новой системой DAC, использующей для высвобождения углекислоты нагрев до невысокой температуры — это значительно снизит издержки. О проекте Alphabet X Development известно мало. Компания в 2021 году подала патентную заявку, описывающую методы и системы для высвобождения из DAC-сорбентов CO2 с использованием тепла от производственных процессов. Сам был опубликован в 2023 году. Судя по описанию, «промышленное» тепло используется в комбинации с одним и более тепловым насосом для отделения CO2 от твёрдого или жидкого сорбента. Некоторые из участников проекта с тех пор перешли в Amazon. Похожую патентную заявку, посвящённую системе захвата углерода с помощью тепла дата-центров, подавала и Microsoft. Тепло ЦОД пытаются использовать повсеместно — от подогрева ферм по выращиванию угрей до нагрева воды в плавательных бассейнах. Нет ничего удивительного, что со временем возникла идея использования его для захвата углерода. Одной из проблем была необходимость нагревать сорбенты до высоких температур, что само по себе приводит к углеродным выбросам. К счастью, в прошлом году компания Spiritus представила сорбент, который можно нагревать до температур ниже 100℃. Как заявляют в Meta✴, ключевыми покупателями нового материал являются именно ЦОД. По данным Spiritus, целесообразно устанавливать DAC в дата-центрах, способных отдавать 20–50 МВт избыточного тепла, а кампусы, способные генерировать 300 МВт тепла способны захватывать три мегатонны углекислоты ежегодно в сравнении с мегатонной, доступной более ранним DAC-технологиям, целесообразность которых тоже была под вопросом. Так, в рамках не связанного с ЦОД проекта Orchard One компания будет удалять из атмосферы по две мегатонны CO2 каждый год. При этом в Spiritus отказались сообщать, участвует ли она в проектах Meta✴ или X. Впрочем, будущее всех подобных проектов пока под вопросом, поскольку природные или искусственные полости для закачки туда углекислоты есть далеко не везде, а транспортировка CO2, возможно, не получит одобрения регуляторов. Другими словами, ЦОД с системами подобной очистки можно будет строить лишь в некоторых местах. Alphabet и Meta✴ входят в проект Frontier Climate, в рамках которого осуществляется покупка «углеродных кредитов» у компаний, использующих самые разные технологии захвата углекислоты из атмосферы, включая DAC. Frontier Climate является инвестором в другие проекты вроде Lithos, CarbonCapture Inc., Airhive, Inplanet, Living Carbon и Heirloom. Google, инвестировавшая $35 млн в проект по захвату углерода, заявила, что недавно покупала углеродные кредиты у Frontier, но деталей сделки не раскрыла.

22.04.2024 [08:59], Владимир Мироненко

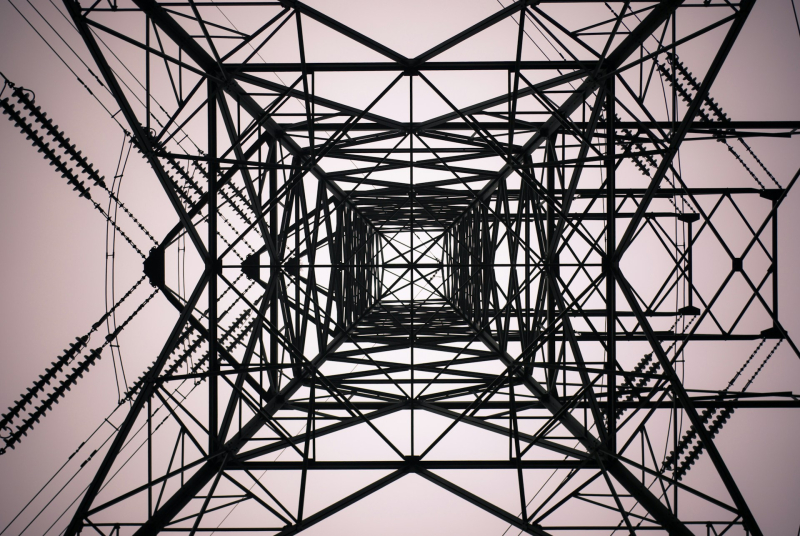

Цукерберг: ограниченные поставки электроэнергии — главная проблема при строительстве крупных ЦОД для ИИГендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) назвал главным препятствием в строительстве более крупных ЦОД для ИИ-нагрузок ограничения по поставкам электроэнергии, пишет ресурс DatacenterDynamics. Об этом глава компании сообщил в подкасте Dwarkesh, согласившись с мнением представителей отрасли. Цукерберг отметил, что ПО регулируется лишь «отчасти», в то время как энергетическая отрасль является строго регулируемым сектором. И если вести речь о строительстве новых крупных электростанций или о значительном укрупнении существующих, а также о строительстве линий электропередачи, пересекающих государственные или частные земли, то этот процесс может затянуться на долгие годы. В частности, два года назад Meta✴ была вынуждена отказаться от гигантского 1,38-ГВт кампуса ЦОД в Нидерландах, где назрел энергетический кризис. Возведение крупного объекта для ИИ-вычислений, а также его ввод в эксплуатацию Цукерберг назвал «очень долгосрочным проектом». Эти ограничения сдерживают развитие собственных дата-центров ЦОД Meta✴. В конце 2022 года компания отказалась от планов по строительству ряда ЦОД, объявив о намерении кардинально изменить подход к их созданию и сейчас разрабатывает ряд модернизированных объектов. «Полагаю, что мы бы создали более крупные кластеры, чем можем сейчас, если бы у нас была энергия для этого», — сообщил Цукерберг. «Никто ещё не построил ЦОД мощностью 1 ГВт. Я думаю, что это произойдёт, но не в следующем году. Это лишь вопрос времени», — добавил он, отметив, что для питания такого кампуса может понадобиться уже АЭС. Напомним, что по данным ресурса The Information, Microsoft и OpenAI обсуждают проект строительства к 2030 году объектов для решения задач в области ИИ мощностью 5 ГВт.

11.04.2024 [02:16], Владимир Мироненко

Второе поколение ИИ-ускорителей Meta✴ MTIA втрое быстрее первогоКомпания Meta✴ поделилась подробностями о следующем собственных ИИ-ускорителей Meta✴ Training and Inference Accelerator. Новый чип отличается более высокой производительностью по сравнению со чипом MTIA v1, представленным в мае прошлого года, и будет играть решающую роль в обеспечении работы ИИ-моделей Meta✴. Следующее поколение крупномасштабной инфраструктуры Meta✴ рассчитано на поддержку новых продуктов и услуг в области генеративного ИИ, рекомендательных систем и передовых исследований в области ИИ. Создание нового чипа является частью инвестиций в инфраструктуру. В ближайшие годы, как ожидается, затраты в этом направлении будут расти, поскольку требования к вычислительным ресурсам для поддержки моделей будут расти вместе с усложнением последних.

Источник изображений: Meta✴ Архитектура чипа ориентирована на обеспечение «правильного баланса вычислений, пропускной способности и объёма памяти» даже при относительно небольших размерах обрабатываемых последовательностей. MTIA v2 в сравнении с MTIA v1 в 3,5 раза быстрее в обычных вычислениях и в 7 раз — в разреженных. Новый чип изготавливается по 5-нм техпроцессу TSMC и имеет габариты 25,6 × 16,4 мм (упаковка 40 × 50 мм). Ускоритель работает на частоте 1,35 ГГц, а его TDP составляет 90 Вт, тогда как 7-нм MTIA v1 работал на частоте 800 МГц и имел TDP всего 25 Вт. Готовая стоечная система вмещает до 72 ускорителей и состоит из трёх шасси с 12 платами, на каждой из которых размещено по два ускорителя. Для дальнейшего масштабирования можно добавить RDMA-сеть.  Чип состоит из 64 вычислительных элементов (PE). У каждого PE есть небольшой блок локальной памяти объёмом 384 Кбайт с ПСП 1 Тбайт/с. На весь чип приходится 256 Мбайт SRAM (2,7 Тбайт/с), а внешняя память представлена 128 Гбайт LPDDR5 (204,8 Гбайт/с). Для подключения к хосту используется интерфейс PCIe 5.0 x8 (32 Гбайт/с). При работе с матрицами чип развивает 177 (FP16/BF16) и 354 (INT8) Тфлопс, в разреженных вычислениях — вдвое больше. SIMD-блоки выдают 2,76 Тфлопс для FP32 и 5,53 Тфлопс для INT8/FP16/BF16. В векторных расчётах значения те же, только для INT8 показатель составляет уже 11,06 Тфлопс. MTIA v2 совместим с кодами, разработанными для MTIA v1. Стек MTIA ориентирован на PyTorch 2.0 и включает компилятор Triton-MTIA. Предварительные испытания MTIA v2 на четырёх ключевых ИИ-моделях компании показали, что он втрое быстрее MTIA v1 чип первого поколения. А на уровне платформы достигнуто шестикратное увеличение пропускной способности модели и рост производительности на Вт в 1,5 раза. Чипы MTIA уже развёрнуты в ЦОД компании. Правда, для обучения Meta✴ их пока не использует.

24.03.2024 [02:19], Сергей Карасёв

WEKApod для SuperPOD: WekaIO представила платформу хранения данных для ИИ-кластеров NVIDIAКомпания WekaIO, разработчик решений для хранения данных, анонсировала высокопроизводительное All-Flash хранилище WEKApod, оптимизированное для работы с платформой NVIDIA DGX SuperPOD на базе NVIDIA DGX H100. Новинка объединяет специализированное ПО WekaIO и «лучшее в своем классе оборудование». Хранилище WEKApod спроектировано для ресурсоёмких нагрузок ИИ. Базовая конфигурация состоит из восьми 1U-узлов, обеспечивающих суммарную вместимость в 1 Пбайт. Показатель IOPS (операций ввода-вывода в секунду) достигает 18,3 млн. Заявленная пропускная способность при чтении составляет до 720 Гбайт/с, при записи — до 186 Гбайт/с. Утверждается, что восемь узлов WEKApod обеспечивает производительность, необходимую для 128 систем NVIDIA DGX H100. При этом WEKApod может масштабироваться до сотен узлов блоками по четыре узла. Таким образом, можно сформировать систему необходимой вместимости с высокой отказоустойчивостью для обучения больших языковых моделей (LLM), ИИ-приложений, работающих в реальном времени, и пр.

Источник изображения: WekaIO Отмечается, что архитектура WEKApod обеспечивает снижение энергопотребления благодаря оптимальному использованию пространства, улучшенному охлаждению и средствам энергосбережения в режиме простоя. В результате, достигается потенциальное сокращение углеродного следа до 260 т/Пбайт. WEKApod использует адаптеры NVIDIA ConnectX-7 и NVIDIA Base Command Manager для мониторинга и управления. Каждый из узлов несёт на борту процессор AMD EPYC 9454P (48C/96T; 2,75–3,80 ГГц; 290 Вт) и 384 Гбайт памяти DDR5-4800. Есть посадочные места для 14 накопителей формата E3.S с интерфейсом PCIe 5.0. Производительность в расчёте на узел достигает 90 Гбайт/с при чтении и 23,3 Гбайт/с при записи, а величина IOPS равна 2,3 млн при произвольном чтении и 535 тыс. при произвольной записи.

14.03.2024 [00:06], Сергей Карасёв

Meta✴ подала в суд на бывшего вице-президента за кражу сверхсекретных планов ЦОДКомпания Meta✴, по сообщению ресурса The Register, подала в суд на бывшего вице-президента по инфраструктуре Дипиндера Сингха Хурану (Dipinder Singh Khurana), который подозревается в краже «сверхсекретных планов», касающихся дата-центров. Хурана, также известный как Т. С. Хурана (T. S. Khurana), проработал в Meta✴ / Facebook✴ в общей сложности приблизительно 12 лет. Он покинул эту корпорацию в июне 2023 года, перейдя на должность старшего вице-президента по операциям в некоем стартапе, который всё ещё работает в скрытом режиме. Название этой фирмы в судебных документах не раскрывается.

Источник изображения: Meta✴ После подачи заявления об уходе Хурана якобы использовал имеющиеся у него права доступа для кражи «проприетарных, крайне секретных, конфиденциальных и закрытых документов о бизнесе и сотрудниках Meta✴». Говорится, что похищенные файлы содержат внутреннюю информацию о дата-центрах Meta✴, поставщиках компании и проектах, связанных с технологиями ИИ. Кроме того, в этих документах содержатся данные о бизнес-операциях Meta✴ и расходах, связанных с закупками. Meta✴ подчёркивает, что при уходе из компании Хурана получил «щедрую компенсацию», но, тем не менее, решил похитить корпоративные данные. Украденные файлы якобы были загружены в его персональные аккаунты Google Drive и Dropbox. Более того, многие из этих файлов были скопированы в папки с именем нового работодателя. Meta✴ считает, что похищенные сведения использовались в том числе для поиска сотрудников для нового работодателя, который специализируется на облачных ИИ-технологиях. Meta✴ выдвинула против Хураны пять обвинений, включая нарушение условий контракта, неосновательное обогащение и нарушение фидуциарных обязанностей. Истцы требуют от своего бывшего вице-президента возмещения ущерба.

07.03.2024 [14:58], Руслан Авдеев

Кеш на 10–20 МВт: Meta✴ изучает возможность строительства в Индии небольшого ЦОД для обслуживания ReelsDatacenter Dynamics сообщает со ссылкой на публикации в местных СМИ о планах Meta✴ по строительству своего первого в Индии дата-центра для удовлетворения роста спроса на её сервисы в регионе. По данным одного из локальных источников, речь идёт о небольшом ЦОД ёмкостью 10–20 МВт для кеширования материалов социальных сетей. Отчасти рост потребностей Meta✴ в местном дата-центре связан с увеличением спроса на платформу Reels, конкурирующую с TikTok по всему миру. В Индии TikTok находится под запретом, поэтому обеспечить здесь инфраструктуру для Reels особенно важно для компании. Пока единственный дата-центр Meta✴ в Азитаско-Тихоокеанском регионе расположен в Сингапуре, многочисленные кампусы ЦОД имеются у компании в США и несколько — в Евросоюзе. Индия запретила TikTok и ещё более 100 китайских приложений ещё в июне 2020 года, сославшись на угрозу национальной безопасности. Принадлежащий Meta✴ сервис Reels доступен пользователям через социальные сети Instagram✴ и Facebook✴, где он появился в 2020 и 2021 гг. соответственно. |

|