Материалы по тегу: ff

|

28.08.2024 [14:26], Руслан Авдеев

Meta✴ будет снабжать свои ЦОД в США энергией из петротермальных источниковВ Meta✴ намерены снабжать свои американские дата-центры геотермальной (петротермальной) энергией. По данным Datacenter Dynamics, компания анонсировала сделку со стартапом Sage Geosystems об использовании технологий последнего для обеспечения ЦОД электричеством. Sage Geosystems будет использовать разработку Geopressured Geothermal System (GGS) для поставки клиенту «зелёной» энергии. Первая фаза проекта должна заработать в 2027 году. В Meta✴ рассчитывают получить до 150 МВт базовой петротермальной мощности для своих объектов. Пока не сообщается, какие именно ЦОД будут снабжаться энергией из «безуглеродных» источников. Впрочем, в Sage проговорились, что речь идёт о местности к востоку от Скалистых гор. В Sage Geosystems назвали проект прекрасным примером того, как государственный и частный сектор могут сотрудничать в деле перехода на «чистую» энергию и поблагодарили Министерство энергетики (DOE) за поддержку коммерциализации инновационных решений. Как сообщают в компании, в основном геотермальная энергия используется в штатах Невада, Юта и Калифорния. Что касается Meta✴, то компания заключила контракты на поставку более 12 ГВт электричества из возобновляемых источников по всему миру, став одним из крупнейших корпоративных покупателей возобновляемой энергии в мире.

Источник изображения: Job Savelsberg/unsplash.com В Sage заявляют, что петротермальные системы — более распространённый и доступный источник энергии, чем гидротермальные скважины. Петротермальные системы прокачивают в замкнутом контуре воду между поверхностью Земли и подземными горячими породами. Можно бурить как собственные скважины, так и перепрофилировать некоторые «сухие» нефтяные скважины. Также Sage работает над технологиями долговременного хранения энергии. В прошлом году небольшой пилотный проект смог обеспечить 200 кВт в течение более 18 часов и 1 МВт — в течение 30 минут. Техасская Sage Geosystems основана в 2020 году бывшими сотрудниками Shell. В раунде финансирования серии A компания привлекла $17 млн. Средства будут направлены на строительство первого коммерческого GGS-проекта компании мощностью 3 МВт в Техасе, недалеко от Сан-Антонио. Геотермальная электростанция должна заработать ещё до конца 2024 года. Ранее Sage подписала сделку с американской армией для обеспечения энергией военных объектов в Нью-Мексико и Техасе. Также она изучает возможность использования геотермальной энергетики в интересах базы ВВС США в Хьюстоне (Техас).

Источник изображения: Federica Bisso/unsplash.com Ранее Google заключила контракт с Fervo Energy и NV Energy на покупку более 100 МВт геотермальной энергии в Неваде. Соглашение о покупке «чистой» энергии (PPA) заключила с Contact Energy в Новой Зеландии компания Microsoft, также она строит геотермальный кампус в Кении вместе с G42. В Индонезии Star Energy обсуждает с операторами ЦОД строительство объектов недалеко от геотермальных электростанций, PDG также подписала «геотермальный» контракт для своих ЦОД в Индонезии. На Филиппинах Converge заключила соглашение о поставках аналогичной энергии с местной электрокомпанией. В Калифорнии стартап CalEthos намерен построить крупный кампус с энергоснабжением из аналогичных источников. Наконец, итальянский стартап Geoveda Srl намерен построить небольшой ЦОД с геотермальным питанием в Тоскане.

09.08.2024 [22:50], Алексей Степин

Звание самого быстрого SSD перешло к Samsung PM1753На мероприятии FMS 2024 компания Samsung показала новые серверные SSD PM1753 и BM1743. Последний был ансонирован месяц назад, а на FMS был впервые показана модификация объёмом 128 Тбайт, ставшая достойным ответом решениям Solidigm, Pascari (Phison) и Western Digital.

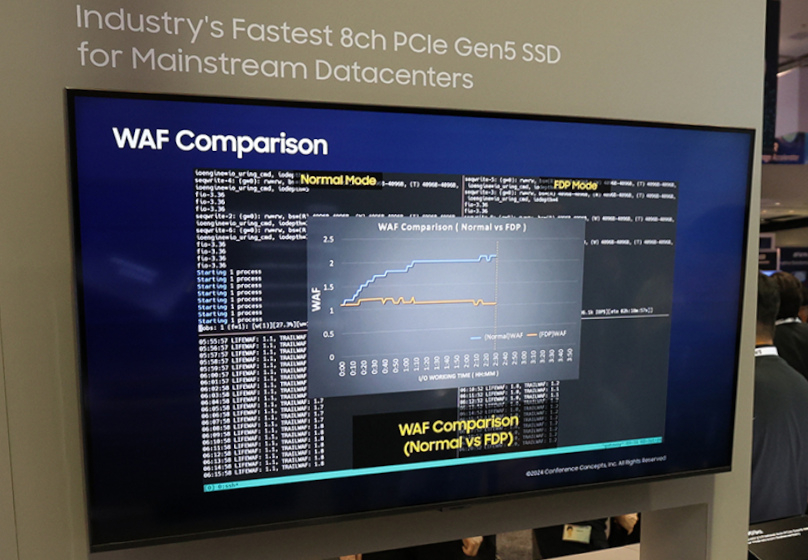

Источник изображений: Samsung Несмотря на использование QLC (v7 vNAND), у BM1743 достаточно высокие показатели производительности: линейные скорости чтения и записи составляют 7,5 Гбайт/с и 3,5 Гбайт/с соответственно. На случайных операциях SSD развивает 1,6 млн и 45 тыс IOPS. BM1743 использует форм-фактор U.2 и интерфейс PCIe 4.0, а с последними версиями прошивки он стал заметно экономичнее и потребляет в режиме простоя лишь около 2 Вт. Где-то в 2024–2026 гг. Samsung должна представить массовые решения объёмом 256 Тбайт, а в следующие за ним пару лет довести ёмкость и до 512 Тбайт. В последнем случае, как ожидается, накопители будут представлены исключительно в форм-факторе EDSFF E3.L. К 2035 году компания намеревается выпустить SSD объёмом 1 Пбайт. А вот Samsung PM1753 относится к совсем иному классу решений. Новинка ориентирована на ЦОД нового поколения с инфраструктурой PCI Express 5.0 и будет поставляться в форм-факторах U.2 и E3.S. Предельный объём здесь составляет 32 Тбайт, зато производительность благодаря 16-канальному контроллеру у него приличная: чтение 14,8 Гбайт/с, запись 11 Гбайт/с. Для случайных операций заявлены 3,4 млн и 600 тыс IOPS соответственно. Таким образом, меньше чем за месяц звание самого быстрого SSD перешло от Micron 9550 к Solidigm D7-PS1010, а теперь и к Samsung PM1753, если, конечно, не учитывать формальный рекорд Kioxia CM7-R ещё двухлетней давности. В основе PM1753 лежит девятое поколение TLC V-NAND, обеспечивающее повышенную в 1,6–1,7 раза энергоэффективность в сравнении с решениями предыдущего поколения. В простое PM1753, как обещается, будет потреблять лишь 4 Ватта. Естественно, новинки ориентированы на современные ИИ-инфраструктуры.  Интересны и Samsung PM9D3a, представленные в форм-факторах M.2, U.2 и E1.S/E3.S 1T. В первом случае ёмкость ограничена значением 4 Тбайт, более крупные форматы включают в себя модели объёмом до 32 Тбайт. Они используют 8-канальный контроллер с PCIe 5.0, обеспечивающий при записи до 50 тыс IOPS на каждый Тбайт. Производительность при случайном чтении у этой новинки достигает 1,8 млн IOPS, линейные скорости чтения и записи составляют 12 Гбайт/с и 7 Гбайт/с, соответственно. PM9D3a являются первыми накопителями Samsung с технологией Flexible Data Placement (FDP), которая позволяет группировать данные для совместной записи по команде хоста. Эти накопители отличаются высокой гибкостью конфигурирования, улучшенной энергоэффективностью, предсказуемой и настраиваемой производительностью, а также низким TCO. Поэтому нацелены они в первую очередь на гиперскейлеров.

08.08.2024 [11:56], Сергей Карасёв

Solidigm и Phison анонсировали SSD ёмкостью 122 Тбайт, а Western Digital — 128 Тбайт

edsff

hardware

nvme

pci express 4.0

pci express 5.0

phison

qlc nand

solidigm

ssd

u.2

u.3

western digital

Компании Western Digital, Solidigm и Phison анонсировали SSD большой вместимости, предназначенные прежде всего для использования в дата-центрах, ориентированных на задачи ИИ. Во всех изделиях применяются чипы флеш-памяти QLC NAND (четыре бита информации на ячейку). Новинка Western Digital имеет ёмкость 128 Тбайт. Применены 218-слойные чипы Kioxia BiCS8 QLC NAND. Образец устройства продемонстрирован на выставке FMS 2024 (the Future of Memory and Storage). Решение будет предлагаться в форм-факторах U.2/U.3. Прошивка накопителя оптимизирована для обслуживания контрольных точек ИИ — рабочей нагрузки, которая включает в себя всплески последовательной записи, но также требует, чтобы SSD поддерживал приемлемую производительность для одновременных операций чтения. На этих задачах скорость достигает соответственно 6,32 Гбайт/с и 3,13 Гбайт/с. В свою очередь, Solidigm показала на FMS 2024 QLC-накопитель формата U.2, способный хранить 122 Тбайт информации. Работа устройства, оснащённого интерфейсом PCIe 4.0, была показана в составе сервера типоразмера 2U. Достигается скорость последовательного чтения данных до 7186 Мбайт/с и скорость последовательной записи до 3307 Мбайт/с. Показатель IOPS (операций ввода/вывода в секунду) при произвольном чтении блоков по 4 Кбайт — 1,27 млн. Поставки таких SSD планируется организовать в начале 2025 года. Phison представила QLC-накопители Pascari D200V в форматах U.2, E3.S и E3.L. Их ёмкость варьируется от 30,72 до 122,88 Тбайт. Задействован интерфейс PCIe 5.0. Заявленная скорость последовательного чтения составляет до 14 000 Мбайт/с, скорость последовательной записи — до 2100 Мбайт/с. Значение IOPS при произвольном чтении (4 Кбайт) достигает 3 млн, при произвольной записи (16 Кбайт) — 15,6 тыс. Реализована поддержка TCG Opal 2.0 и AES-XTS 256. Диапазон рабочих температур — от 0 до +70 °C.

06.08.2024 [23:55], Алексей Степин

Самый быстрый SSD и подходит для ИИ: Solidigm представила PCIe 5.0 накопители D7-PS1010 и D7-PS1030Компания Solidigm представила серию производительных SSD D7-PS1010 и D7-PS1030 на базе новой 176-слойной флеш-памяти SK hynix. Главным нововведением можно назвать переход на более новую версию интерфейса: если D7-P5x20 использовали PCI Express 4.0, то в D7-PS10x0 используется PCI Express 5.0. Это позволило довести скорость чтения до 14,5 Гбайт/c и, чуть-чуть обогнав Micron 9550 по этому показателю, назвать новинки самыми производительными в мире SSD. Новые накопители ориентированы на сценарии с высокой интенсивностью IO-операций ввода-вывода, характерных, в числе прочего, и для ИИ-нагрузок. Оба модельных ряда представлены в форм-факторах E3.S (7,5 мм) и U.2 (15 мм). В иерархии накопителей Solidigm новинки расположились сразу за D7-P5810, которые используют флеш-память в режиме SLC. Третья цифра в обозначении новых моделей означает число полных перезаписей в день (DPWD) в течение 5 лет. Таким образом, D7-PS1010 представляют собой SSD для смешанных нагрузок с показателем PBW в 28 Пбайт для старшей модели (1 DWPD), а D7-PS1030 покажут большую надёжность в сценариях с активной записью данных (3 DWPD), поскольку гарантированно выдержат до 70 Пбайт записи. Для всех вариантов заявлена наработка на отказ на уровне 2,5 млн часов. Наличие защиты от сбоев по питанию и коррекции ошибок в SRAM позволяет заявить о высоком уровне надёжности (UBER) — по словам производителя, он в 100 раз превышает требования JEDEC. Новинки соответствуют стандартам NVMe v2.0, NVMe-MI v1.2, OCP v2.0r21, TCG-OPAL 2.02, DMTF SPDM 1.1.0 и поддерживают Secure Boot, подписанные прошивки, безопасное стирание, управление жизненным циклом и т.д. Модельный ряд PS1010 стартует с отметки 1,92 Тбайт и заканчивается версией объёмом 15,36 Тбайт, а PS1030 в силу ориентации на повышенную надёжность выпускаются объёмами от 1,6 до 12,8 Тбайт. Показатели линейной скорости записи начинаются с 4,1 Гбайт/с, версии объёмом 3,2/3,84 Тбайт развивают 8,2 Гбайт/с, а наиболее ёмкие варианты — 9,3 Гбайт/с. Производительность на случайных операциях лежит в пределах 2,35–3,1 млн IOPS при чтении и 0,15–0,8 млн IOPS при записи. Новые SSD очень экономичны, удельное соотношение производительности к энергопотреблению, по словам Solidigm, у них на 70 % лучше, нежели у решений иных производителей. При этом производительность новинок в нагрузках с высокой долей случайных операций чтения на 46 % выше, чем у конкурентов. Вкупе с поддержкой GPUDirect это делает D7-PS1010 и D7-PS1030 идеальным выбором при построении ИИ-кластеров, говорит производитель.

02.08.2024 [18:01], Руслан Авдеев

ИИ и ЦОД: капитальные затраты Meta✴ во II квартале выросли до $8,5 млрдВ Meta✴ продолжают активно вкладывать средства в серверы, дата-центры и сетевую инфраструктуру — компания выстраивает экосистему для искусственного интеллекта. По информации Datacenter Dynamics, капитальные затраты во II квартале составили $8,5 млрд, ожидается, что они будут расти и в дальнейшем. Выручка за отчётный период превзошла прогнозы экспертов и составила $39,07 млрд, на 22 % больше в сравнении с аналогичным периодом прошлого года. Чистая прибыль в прошедшем квартале — $13,46 млрд, рост составил 73 %. Прогноз выручки на следующий квартал — $38,5-$41 млрд. Капитальные затраты оказались несколько ниже ($8,5 млрд), чем предполагали отраслевые эксперты ($9,51 млрд), тем не менее рост составил 32,8 % год к году. Компания ожидает и дальнейшего значительного роста капитальных вложений в 2025 году, при этом имеется достаточный запас гибкости. Та же инфраструктура, что построена для обучения генеративного ИИ, будет использована и для инференса. Кроме того, инфраструктуру можно будет модифицировать для других задач, включая ранжирование, рекомендательные системы и др. Как утверждают в Meta✴, несмотря на рост инвестиций, генеративный ИИ не должен стать значимым драйвером выручки в 2024 году. Впрочем, по словам главы компании Марка Цукерберга (Mark Zuckerberg), он скорее рискнёт создать лишнюю ёмкость до того, как она понадобится, чем станет добиваться её строительства с опозданием, с учётом довольно длительной реализации новых внутренних проектов. Ожидается, что для тренировки ИИ-модели Llama 4 понадобится почти в 10 раз больше вычислительных мощностей, чем было необходимо для Llama 3. Для последующих моделей потребуется ещё больше. К концу года компания будет использовать ускорители эквивалентные по вычислительной способности 600 тыс. экземпляров NVIDIA H100. По словам финансового директора Meta✴ Сьюзан Ли (Susan Li), компания применяет стратегию поэтапного строительства ЦОД, позволяющую быстро увеличивать общую ёмкость для удовлетворения спроса. При этом в будущем капитальные затраты снизятся, поскольку не будет необходимости сразу сдавать большие объекты.

02.08.2024 [13:17], Сергей Карасёв

SSD с «компрессором»: ScaleFlux представила вычислительные NVMe-накопители CSD5000Компания ScaleFlux анонсировала высокопроизводительные вычислительные SSD семейства CSD5000 на базе фирменного контроллера FX5016, предназначенные для поддержания ресурсоёмких рабочих нагрузок, связанных с ИИ, машинным обучением, аналитикой данных и НРС. Устройства будут доступны в исполнениях U.2/U.3, E3.S, E1.S и E1.L. Для обмена данными служит интерфейс PCIe 5.0 (NVMe 2.0b): один порт x4 или два x2. Заявлена поддержка TCG Opal 2.02 и шифрования AES-256, NVMe Thin Provisioned Namespaces Virtualization (48PF/32VF), ZNS, FDP, а также совместимость со спецификациями OCP, в том числе в части телеметрии и мониторинга задержек. Реализовано сжатие информации непосредственно на SSD: разработчик подчеркивает, что это позволяет значительно увеличить долговечность накопителей по сравнению с обычными изделиями. В семейство входят модели вместимостью 3,84, 7,68, 15,36, 30,72, 61,44 и 122,88 Тбайт. С учётом компрессии эффективная ёмкость может достигать приблизительно 256 Тбайт. Заявленная скорость последовательного чтения информации составляет до 14 Гбайт/с, скорость последовательной записи — до 11 Гбайт/с. Показатель IOPS (операций ввода/вывода в секунду) при произвольных чтении и записи данных блоками по 4 Кбайт находится на уровне 3,2 млн и 430 тыс. соответственно. При использовании сжатия 2:1, как утверждает разработчик, скорость последовательной записи возрастает до 13 Гбайт/с, а значение IOPS при произвольной записи — до 1,2 млн. ScaleFlux заявляет, что устройства семейства CSD5000 обеспечивают до 3 раз более высокую производительность в расчёте на ватт затрачиваемой энергии по сравнению с конкурирующими изделиями Samsung и Kioxia, поддерживающими интерфейс PCIe 5.0. Энергопотребление составляет менее 18 Вт в активном режиме и менее 5 Вт в режиме простоя. Средняя наработка на отказ (величина MTBF) — 2 млн часов.

01.08.2024 [11:23], Сергей Карасёв

Swissbit представила SSD серии D2200 в форматах U.2 и E1.S с интерфейсом PCIe 5.0Компания Swissbit анонсировала SSD семейства D2200, ориентированные на дата-центры и системы корпоративного класса. В серию вошли изделия в форматах U.2 и E1.S, выполненные на чипах флеш-памяти 3D NAND eTLC. Задействован интерфейс PCIe 5.0 х4 (NVMe 2.0b). SFF-решения D2200 U.2 (SFF-8639) имеют размеры 100,2 × 69,85 × 15 мм. Они представлены в вариантах вместимостью 7,68 и 15,36 Тбайт, а позднее появится версия ёмкостью 30,72 Тбайт. Габариты устройства типоразмера D2200 E1.S (SFF-TA-1006) составляют 111,25 × 33,7 × 9,5 мм. Доступен только вариант на 7,68 Тбайт; в дальнейшем выйдет модификация на 15,36 Тбайт. У всех накопителей скорость последовательного чтения информации достигает 14 000 Мбайт/с, скорость последовательной записи — 10 000 Мбайт/с. Показатель IOPS (операций ввода/вывода в секунду) при произвольных чтении и записи — до 2,6 млн и 500 тыс. соответственно. Среднее заявленное энергопотребление при смешанных нагрузках равно 19,5 Вт. Конструкция включает буфер DDR4 DRAM. Устройства могут выдерживать одну полную перезапись в сутки (1 DWPD) на протяжении пяти лет. Диапазон рабочих температур — от 0 до +70 °C. Средняя наработка на отказ (MTBF) превышает 2 млн часов. В новинках реализована поддержка TCG Opal 2.0 и AES-XTS 256. Предусмотрены функции Secure Boot и Crypto Erase, а также средства защиты от сбоев электропитания. Поставки SSD начнутся в конце августа.

24.07.2024 [01:11], Владимир Мироненко

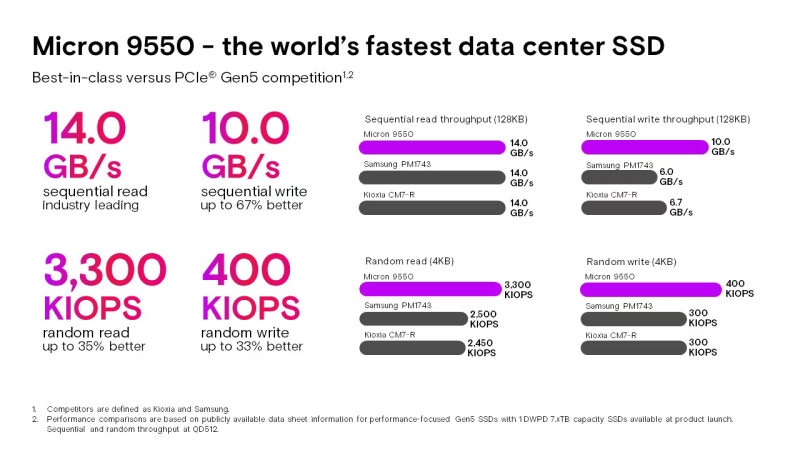

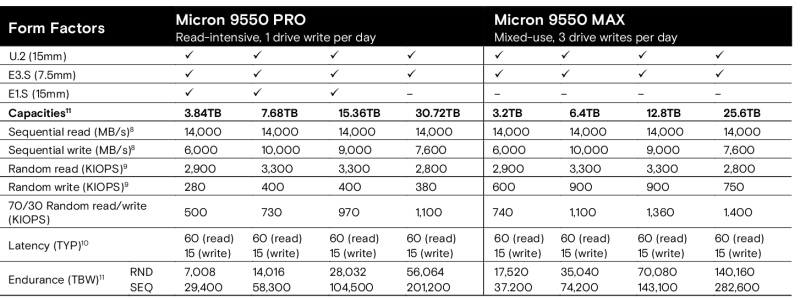

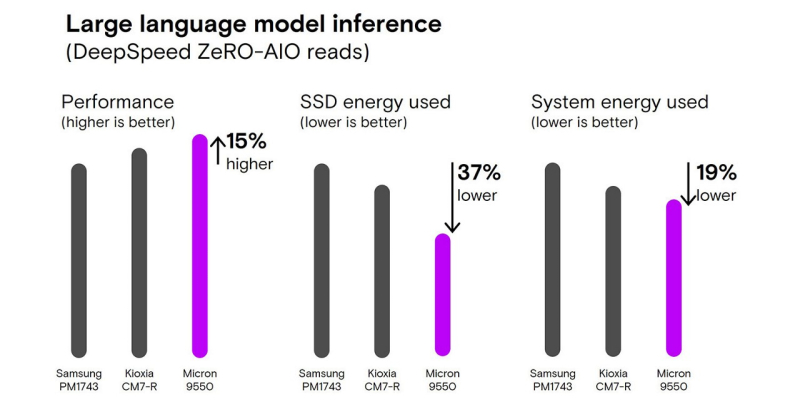

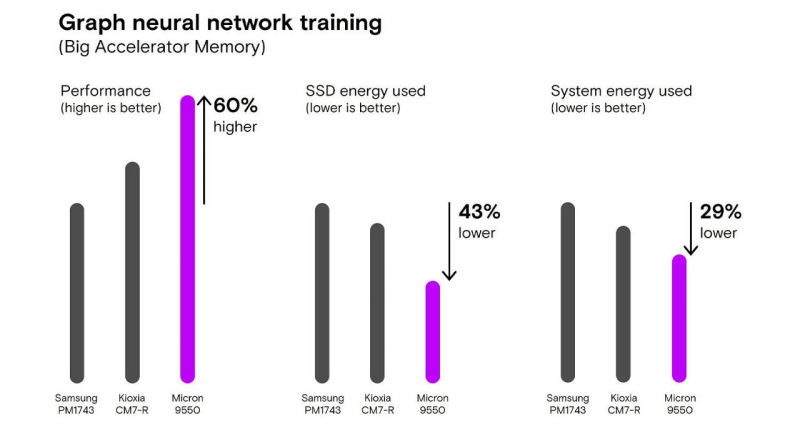

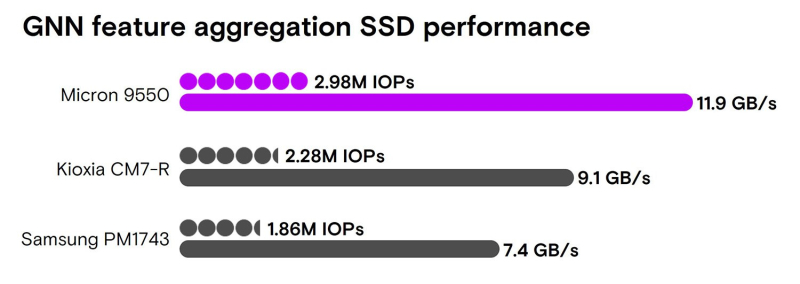

Самый быстрый SSD для ИИ: Micron представила серию накопителей 9550 ёмкостью до 30,72 ТбайтКомпания Micron Technology объявила о доступности серии NVMe-накопители Micron 9550, которые позиционируются как самые быстрые в мире PCIe 5.0 SSD для ЦОД с лучшими в отрасли показателями энергоэффективности и производительности для ресурсоёмких рабочих нагрузок, таких как ИИ. Новинки используют 232-слойную флеш-память TLC NAND, предлагаются в форм-факторах U.2 (15 мм), E3.S (1T) и E1.S (15 мм), а их ёмкость составляет от 3,2 до 30,72 Тбайт. Micron 9550 обеспечивает скорость последовательного чтения до 14,0 Гбайт/с и последовательной записи до 10,0 Гбайт/с, что превышает на 67 % показатели твердотельных накопителей аналогичного класса от конкурентов, говорит компания, подразумевая решения Kioxia и Samsung. Производительность накопителя на операциях случайного чтения и записи составляет 3,3 млн IOPS и 400 тыс. IOPS соответственно, что до 35 % и до 33 % выше, чем у предложений конкурентов. Накопители Micron 9550 поддерживают TCG Opal 2.01, SPDM 1.2, телеметрию по стандарту OCP 2.5, шифрование данных (SED), сквозную поддержку целостности данных, подписанное встроенное ПО, изолированный анклав Micron Secure Execution Environment, защиту от потери питания, а также соответствуют стандартам NVMe v2.0b и OCP 2.0 (r21). Доступны и варианты с сертификацией FIPS 140-3 Level 2 и TAA. Компания предлагает две версии Micron 9550: 9550 PRO для интенсивного чтения с 1 DWPD (допустимое количество перезаписей всего объёма накопителя в день) в течение пятилетнего гарантийного периода и 9550 MAX для смешанных нагрузок с надёжностью 3 DWPD. E1.S-вариант есть только 9550 PRO. Доступная ёмкость 9550 PRO составляет 3,84/7,68/15,36/30,72 Тбайт. Версия накопителя 9550 MAX предлагает меньшую ёмкость — 3,2/6,4/12,8/25,6 Тбайт. Как отметила Micron, ИИ-нагрузки требуют высокопроизводительных решений для хранения данных. Показатели последовательного и случайного чтения и записи SSD 9550 позволяет использовать его именно в таких в сценариях. Накопители поддерживают архитектуры Big Accelerator Memory (BaM) и GPU-Initiated Direct Storage (GIDS). Например, большие языковые модели (LLM) требуют высокой скорости последовательного чтения, а графовые сети (GNN) требуют высокой производительности случайного чтения. Компания заявила, что Micron 9550 превосходит предложения конкурентов в работе с ИИ-нагрузками: время выполнения сокращается до 33 %, агрегация в BaM происходит до 60 % быстрее, обеспечивается до 34 % более высокая пропускная способность при использовании Magnum IO GPUDirect Storage (GDS). Согласно пресс-релизу, Micron 9550 обеспечивает лучшую в отрасли энергоэффективность для поддержки различных рабочих ИИ-нагрузок, в том числе:

Micron 9550 имеет вертикально интегрированную архитектуру с использованием технологий, разработанных Micron, обеспечивающую гибкий выбор конструкции и расширенные возможности безопасности, говорит компания. Кроме того, Micron сотрудничает с NVIDIA и разработчиками решений с открытым исходным кодом, чтобы гарантировать соответствие решений потребностям самых требовательных ИИ-нагрузок.

26.06.2024 [08:32], Владимир Мироненко

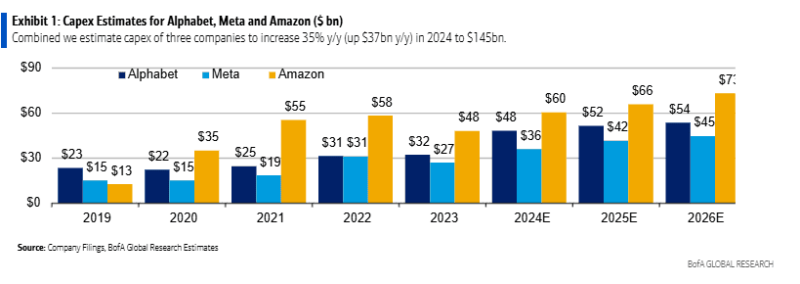

Данные стали «валютой» для ИИ, но для их обработки нужно немало реальной валютыВ эпоху ИИ данные рассматриваются как «валюта». Поэтому спрос на инструменты для интеграции, хранения и обработки данных становится растущим приоритетом среди предприятий, пишет IEEE ComSoc. Ожидается, что к 2025 году объём генерируемых в мире данных достигнет 180 Збайт по сравнению со 120 Збайт в 2023 году. И всё это потребует немало оборудования. Согласно оценкам BofA Global Research, средний размер наборов данных, необходимых для обучения моделей ИИ, увеличился с 5,9 млн записей в 2010 году до 750 млрд в 2023 году. В опросе BofA 150 IT-профессионалов в качестве ключевых вариантов использования ИИ были указаны потоковая обработка данных (44 %) и машинное обучение (37 %). Кроме того, ИИ подталкивает к переносу данных в облака. По оценкам Gartner, к 2027 году 74 % платформ управления данными будет развёрнуто в облаках по сравнению с 60 % в 2023 году. Затраты на инфраструктурное ПО для работы с данными представляют собой главную статью расходов ИТ-отделов. По оценкам участников опроса, на такое ПО приходится 35 % от общих расходов на ИТ. При этом ожидается, что бюджеты вырастут на 9 % в течение следующих 12 месяцев. Публичные облака вошли в тройку лидеров среди поставщиков таких решений. Они же получают и немало выручки. Согласно подсчётам BofA, оборот индустрии инфраструктурного ПО (хранилища и озёра, работа с неструктурированными данными и т. д.) в настоящее время составляет около $96 млрд, и он может вырасти до $153 млрд в 2028 году. Что касается «железа», то BofA прогнозирует стремительное увеличение капитальных затрат у Amazon, Alphabet/Google и Meta✴/Facebook✴ — в 2024 году они вырастут на 43 % в годовом исчислении до $145 млрд. Большая часть увеличения придётся на серверы и оборудование:

Также исследователи отметили, что Meta✴ лидирует по соотношению капвложений и выручки (% от выручки), и с 2022 года компания постоянно наращивает капитальные затраты на ИИ (собственный суперкомпьютер, LLM и т. д.). Расходы Meta✴ по объёму сравнимы с расходами более крупных гиперскейлеров. Одним из возможных результатов может быть появления нового облачного решения для рекламодателей.

22.06.2024 [14:34], Сергей Карасёв

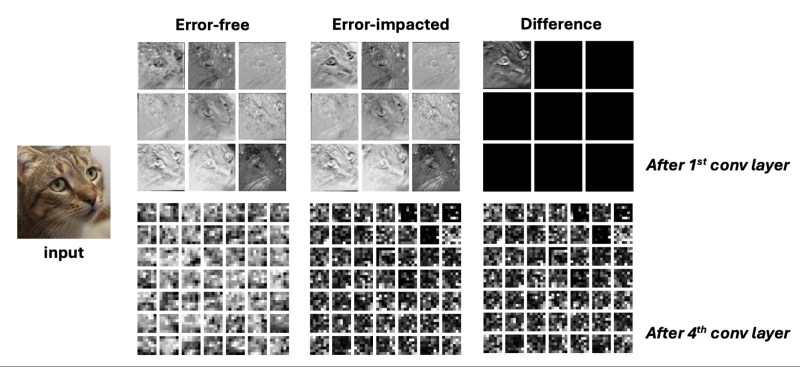

Галлюцинации от радиации: аппаратные сбои могут провоцировать ошибки в работе ИИ-системКомпания Meta✴, по сообщению The Register, провела исследование, результаты которого говорят о том, что ошибки в работе ИИ-систем могут возникать из-за аппаратных сбоев, а не только по причине несовершенства алгоритмов. Это может приводить к неточным, странным или просто плохим ответам ИИ. Говорится, что аппаратные сбои способны провоцировать повреждение данных. Речь идёт, в частности, о так называемом «перевороте битов» (bit flip), когда значение ячейки памяти может произвольно меняться с логического «0» на логическую «1» или наоборот. Это приводит к появлению ложных значений, что может обернуться некорректной работой ИИ-приложений. Одной из причин ошибок является космическое излучение, причём с ростом плотности размещения ресурсов его влияние нарастает. Впрочем, в современных комплексных системах такие ошибки по разным причинам могут возникать на любом из этапов хранения, передачи и обработки информации.

Ошибка в одном бите одного параметра существенно меняет ответ ИИ (Источник: Meta✴) Такие необнаруженные аппаратные сбои, которые не могут быть выявлены и устранены «на лету», называют тихими повреждениями данных (Silent Data Corruption, SDC). Подобные ошибки могут провоцировать изменения ИИ-параметров, что, в конечном счёте, приводит к некорректному инференсу. Утверждается, что в среднем 4 из 1000 результатов инференса неточны именно из-за аппаратных проблем. «Растущая сложность и неоднородность платформ ИИ делает их всё более восприимчивыми к аппаратным сбоям», — говорится в исследовании Meta✴. При этом изменение одного бита может привести к тому, что ошибки будут расти как снежный ком. Для оценки возможных неисправностей предлагается ввести новую величину — «коэффициент уязвимости параметров» (Parameter Vulnerability Factor, PVF). PVF показывает вероятность того, как повреждение конкретного параметра в конечном итоге приведёт к некорректному ответу ИИ-модели Эта метрика, как предполагается, позволит стандартизировать количественную оценку уязвимости модели ИИ к возможным аппаратным сбоям. Показатель PVF может быть оптимизирован под различные модели и задачи. Метрику также предлагается использовать на этапе обучения ИИ и для выявления параметров, целостность которых надо отслеживать. Производители аппаратного оборудования также принимают меры к повышению надёжности и устойчивости работы своих решений. Так, NVIDIA отдельно подчеркнула важность RAS в ускорителях Blackwell. Правда, делается это в первую очередь для повышения стабильности сверхкрупных кластеров, простой которых из-за ошибок обойдётся очень дорого. |

|