Материалы по тегу: dpu

|

21.10.2024 [13:21], Сергей Карасёв

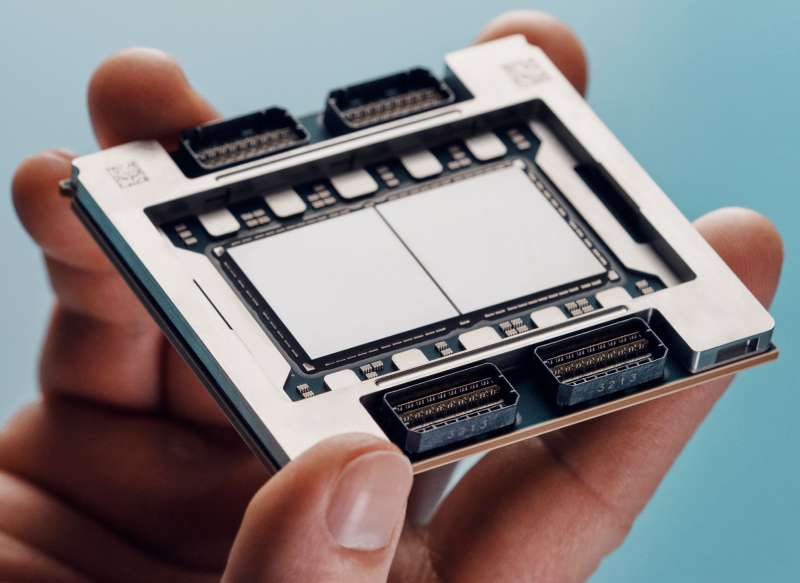

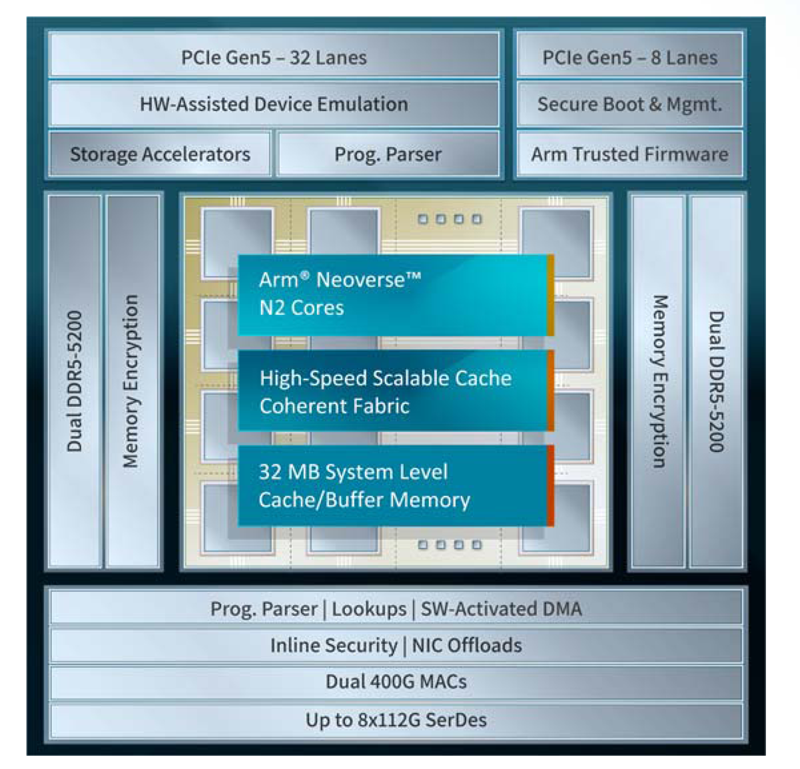

Xsight Labs представила 400GbE DPU серии E1Компания Xsight Labs анонсировала, как утверждается, самую производительную на рынке программно-определяемую «систему на чипе» (SoC), предназначенную для создания DPU с поддержкой RoCEv2 и UET (Ultra Ethernet Transport). Изделие под названием E1 станет доступно заказчикам для тестирования во II квартале 2025 года. Чип будет предлагаться в модификациях E1-32 и E1-64. Первая содержит 32 ядра Arm Neoverse N2 v9.0-A, имеет 16 Мбайт кеша и использует конфигурацию памяти 2 × DDR5-5200. Показатель TDP равен 65 Вт. У второго варианта количество ядер составляет 64, размер конфигурируемого кеша/буфера — 32 Мбайт. Конфигурация памяти — 4 × DDR5-5200, величина TDP — 90 Вт. В обоих случаях используется полное шифрование памяти на лету (AES-XTS). Новинка использует до восьми блоков SerDes, обеспечивая сетевую пропускную способность до 800 Гбит/с. Возможны следующие конфигурации портов: 2 × 400GbE, 4 × 200GbE и 8 × 100/50/25/10GbE. Заявлена производительность на уровне 200 Mpps и 20 млн подключений в секунду. Также есть пара 1GbE-портов для внешнего управления. Доступны программируемые DMA-движки (до 3 Тбит/с) и разгрузка типовых операций, включая шифрование AES-GCM (для IPSec) и AES-XTS (для СХД) на лету.

Источник изображения: Xsight Labs Есть восемь двухрежимных контроллеров и 40 (32+8) линий PCIe 5.0, а также поддержка P2P-коммутации PCIe. Упомянуты поддержка до четырёх хостов/устройств, SR-IOV (64K PF/VF), а также программная эмуляция и пространства MMIO. Реализована поддержка интерфейсов I2C/I3C/SMBus, SPI/QSPI, SMI, UART, GPIO, 1588 RTC, JTAG. Говорится о высоком уровне обеспечения безопасности: возможно создание изолированных и защищённых сред, которые аутентифицируют каждого клиента. Поддерживается функция безопасной загрузки UEFI Secure Boot with Arm Trusted Firmware (TF-A). Заявлена возможность работы «из коробки» в Debian, Ubuntu, SONiC и Lightbits Labs LightOS, а также совместимость с Netdev, VirtIO, XNA/XDP и DPDK/SPDK. В частности, возможна эмуляция NVMe-, RDMA- и сетевых устройств. Изделие E1 производится по 5-нм технологии TSMC. Оно, как утверждает Xsight Labs, обеспечивает беспрецедентную энергоэффективность и вычислительные возможности, устанавливая новый стандарт производительности для DPU SoC. Новинка ориентирована на облачные платформы и периферийные дата-центры, поддерживающие интенсивные ИИ-нагрузки. DPU позволяет создавать SDN/SDS-решения, брандмауэры, NVMe-oF СХД, вычислительные хранилища, CDN-платформы, балансировщики и т.п.

11.10.2024 [11:55], Сергей Карасёв

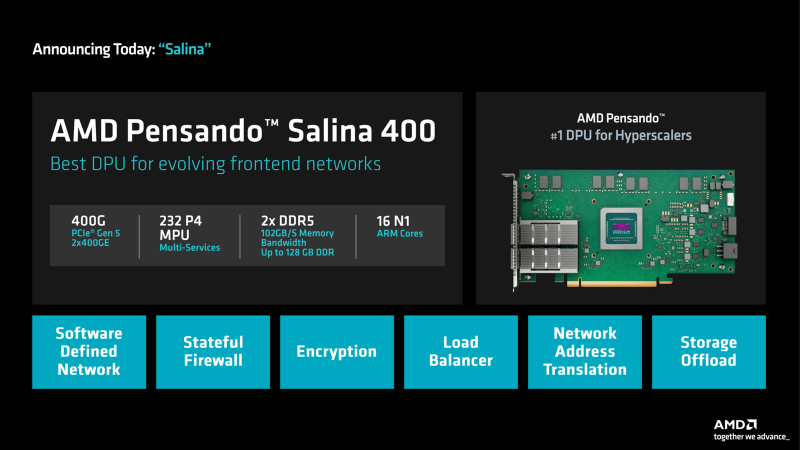

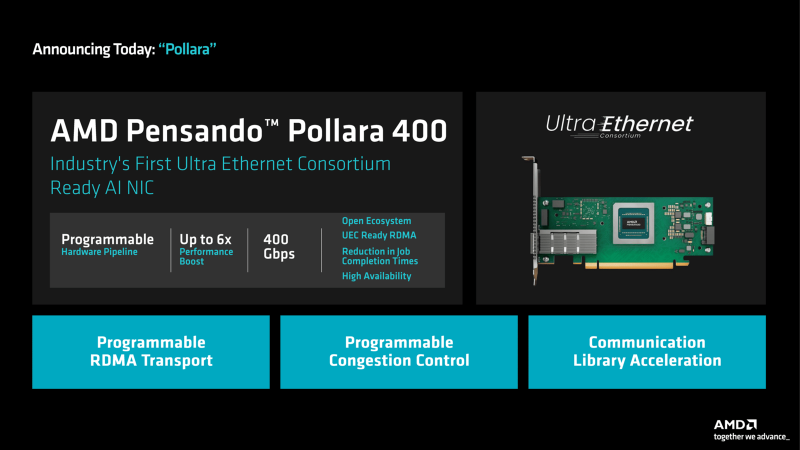

DPU + UEC: AMD представила 400G-адаптеры Pensando Salina и PollaraКомпания AMD анонсировала сетевой сопроцессор (DPU) третьего поколения Pensando Salina 400, а также сетевую карту Pensando Pollara 400, ориентированную на применение в составе ИИ-систем. Образцы изделий станут доступны заказчикам в текущем квартале, тогда как массовые продажи начнутся в I половине 2025 года. Решение Pensando Salina 400, рассчитанное на сетевые кластеры гиперскейлеров, обеспечивает пропускную способность до 400 Гбит/с. Утверждается, что по сравнению с DPU предыдущего поколения производительность увеличилась в два раза. Устройство Pensando Salina 400 выполнено в виде карты PCIe 5.0 с двумя портами 400GbE. Задействованы 16 ядер Arm Neoverse-N1 и 232 ядра P4 MPU. Объём памяти DDR5 достигает 128 Гбайт, её пропускная способность — 102 Гбайт/с. Новинка будет применяться в том числе в интеллектуальных коммутаторах, предназначенных для решения различных задач во внешней зоне: это может быть распределение данных, балансировка нагрузки, обеспечение безопасности, шифрование и пр. В свою очередь, Pensando Pollara 400 представляет собой интеллектуальный сетевой адаптер с одним портом 400 Гбит/с. Изделие выполнено на том же чипе, что и Pensando Salina 400. Компания AMD называет Pensando Pollara 400 первой в мире сетевой картой для приложений ИИ, соответствующей стандартам, которые определяет консорциум Ultra Ethernet (UEC). Примечательно, что первые спецификации консорциум намерен представить не раньше конца текущего года. Цель UEC — разработка основанной на Ethernet открытой высокопроизводительной архитектуры с полным коммуникационным стеком, отвечающей задачам современных рабочих нагрузок ИИ и НРС. Благодаря программируемой архитектуре P4 адаптер можно настраивать с учётом конкретных требований. В целом, как утверждается, новинка является мощным решением для повышения производительности рабочих нагрузок ИИ и улучшения надёжности сети.

08.09.2024 [23:18], Владимир Мироненко

Стартап Xockets обвинил NVIDIA и Microsoft в нарушении патентов на DPU и требует запретить выпуск ИИ-систем на базе BlackwellТехасский стартап Xockets подал в Окружной суд США по Западному округу Техаса в городе Уэйко (Waco) на NVIDIA и Microsoft, обвинив их в нарушении антимонопольного законодательства и патентных прав. Сам иск был опубликован на этой неделе на сайте Xockets. Согласно иску, NVIDIA незаконно использунт запатентованную Xockets технологию нового класса процессоров — Data Processing Unit (DPU), изобретённую соучредителем Xockets Парином Далалом (Parin Dalal) в 2012 году. Эта технология повышает эффективность облачной инфраструктуры, позволяя разгружать CPU, перенося на DPU рабочие нагрузки с интенсивным использованием данных, такие как обеспечение безопасности, обслуживание сетей и хранилищ, которые делают возможными распределённые вычисления в облачных ЦОД, а также обучение больших языковых моделей. Xockets подала свою первую патентную заявку на DPU в мае 2012 года и теперь владеет несколькими патентами, которые касаются её архитектуры и компоненты DPU. Как утверждает Xockets, технология является основополагающей для систем ИИ на базе ускорителей NVIDIA и ИИ-платформ Microsoft. По её словам, решения NVIDIA BlueField, ConnectX и NVLink Switch, основаны на её запатентованной технологии. Xockets сообщила, что её патенты были изначально нарушены компанией Mellanox после того, как DPU Xockets был продемонстрирован на конференции в 2015 году. И NVIDIA продолжила деор Mellanox после её приобретения в марте 2019 года за $6,9 млрд. Microsoft также указана в качестве нарушителя патентных прав, поскольку, являясь клиентом NVIDIA, имеет «привилегированный доступ к нарушающим права GPU-серверам NVIDIA для ИИ».

Источник изображения: Xockets После подачи иска Xockets заявила: «Использование NVIDIA запатентованной технологии DPU Xockets позволило NVIDIA монополизировать сферу серверов ИИ на базе GPU, а Microsoft — сферу ИИ-платформ на базе GPU, что имеет решающее значение для их успеха и рыночной капитализации». Xockets также обвинила компании в картельном соглашении, выразившемся в создании организации под названием RPX по управлению патентными рисками, которая, по словам стартапа, была «сформирована по просьбе крупных технологических компаний для создания картелей покупателей интеллектуальной собственности», чтобы избежать уплаты справедливой рыночной цены за запатентованную технологию DPU Xockets. В иске указано, что Xockets пыталась лицензировать свою технологию NVIDIA и Microsoft, но компании заключили соглашение о проведении любых переговоров по лицензированию через RPX, которая также указана в иске в числе ответчиков. Xockets потребовала установить судебный запрет на деятельность незаконного картеля и выпуск новых ИИ-систем на базе ускорителей NVIDIA Blackwell, а также использование Microsoft систем Blackwell для своих платформ генеративного ИИ. Xockets также требует возмещения ущерба в максимально допустимом законом объёме.

30.08.2024 [23:53], Алексей Степин

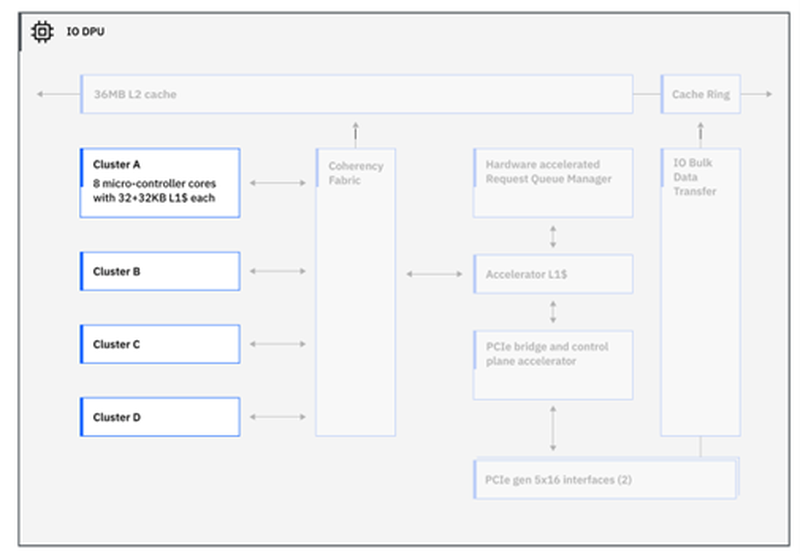

IBM представила процессор Telum II: 8 × 5,5 ГГц, 2,88 Гбайт L4-кеш, улучшенный ИИ-ускоритель и встроенный DPUНесмотря на доминирование архитектур x86 и Arm, а также растущую популярность RISC-V, востребованность классических мейнфреймов IBM на базе z/Architecture по-прежнему остаётся высокой, и компания продолжает активно развивать данное направление. На этой неделе IBM представила наследника Telum — процессор Telum II, в котором не только получили развитие заложенные ранее идеи, но и были реализованы достаточно серьёзные нововведения. Telum II будет выпускаться Samsung по 5-нм техпроцессу 5HPP (43 млрд транзисторов, 600 мм2). Он по-прежнему имеет восемь ядер с фиксированной рабочей частотой 5,5 ГГц. Сами ядра подверглись усовершенствованию, пусть и достаточно минорному: повышена точность предсказания ветвлений, улучшены механизмы сквозной записи и трансляции адресов. Это должно обеспечить новинке 20 % преимущества в пересчёте на процессорный разъём в сравнении с предшественником. Также благодаря новому техпроцессу удалось снизить площадь ядра на 20 %, а энергопотребление — на 15 %. Для поддержания постоянной тактовой частоты в Telum II используется новый блок управления напряжениями. Серьёзно улучшена подсистема кешей: объём кеш-памяти подрос на 40 %, всего разделов L2-кеша десять. Каждый из них имеет объём 36 Мбайт, а латентность не превышает 3,6 нс. Объёмы виртуальных кешей L3 (11,5 нс) и L4 (48,5 нс) выросли до 360 Мбайт (на процессор) и 2,88 Гбайт (на узел) соответственно. Сама технология виртуального кеширования такова, что текущее свободное место в L2 может использоваться для любой задачи, где может быть востребовано. На 30 % повышена пропускная способность связи чипа с внешним миром, а общение на межузловом уровне теперь шифруется. Встроенный ИИ-блок в Telum II в сравнении с предыдущим поколением стал вчетверо быстрее — 24 Топс. Сам сопроцессор имеет архитектуру, оптимальную для работы с LLM и нагрузками, в которых активно используется сравнительный анализ структурных или текстовых массивов данных. Есть поддержка INT8/FP16. При этом любой ИИ-ускоритель Telum II может работать с любым из ядер в пределах узла (drawer), что в предельной конфигурации даёт производительность на уровне 192 Топс, а для полностью сконфигурированной системы этот показатель равен 768 Топс. «Снаружи» ИИ-ускоритель доступен в виде набора CISC-инструкций.  А вот блок DPU дебютировал в Telum II впервые. Что интересно, архитектурно он не располагается «позади» PCI Express, как это бывает в системах на базе x86 или Arm, а имеет когерентное подключение к кешу L2 процессорных ядер, и при этом имеет свою подсистему кешей. Применение DPU, по словам IBM, позволило снизить энергозатраты на обслуживание операций ввода-вывода на 70 %. DPU жизненно необходим, поскольку на мейнфреймах будут работать тысячи инстансов, а самим системам теперь полагается и внешний ИИ-ускоритель Spyre.  Всего в состав DPU входит четыре кластера по по восемь программируемых микроядер, каждое из которых имеет кеш L1 объёмом 32+32 Кбайт и работает под управлением кастомных протоколов, разработанных IBM. DPU предоставляет шину PCI Express 5.0 и в полной конфигурации c 32 процессорами и 12 модулями расширения по 16 слотов x16 в каждом система на базе Telum II может работать со 192 адаптерами PCIe.  Компания-производитель позиционирует новые системы, как enterpise-решения широкого спектра для сценариев с использованием ИИ, в том числе, в режиме Ensemble AI, в котором одновременно над задачей могут работать модели разного размера и сложности. В этом режиме малая модель выявления мошеннических атак может работать как быстрое средство, а для отдельных, особенно важных транзакций в работу включается более сложная, но и более эффективная модель класса LLM. Процессоры Telum II станут основой как новых мейнфреймов IBM Z, работающих под управлением классической z/OS, так и Linux. Ожидается, что платформы IBM z17 на базе Telum II будут доступны уже в следующем году.

29.07.2024 [10:00], Сергей Карасёв

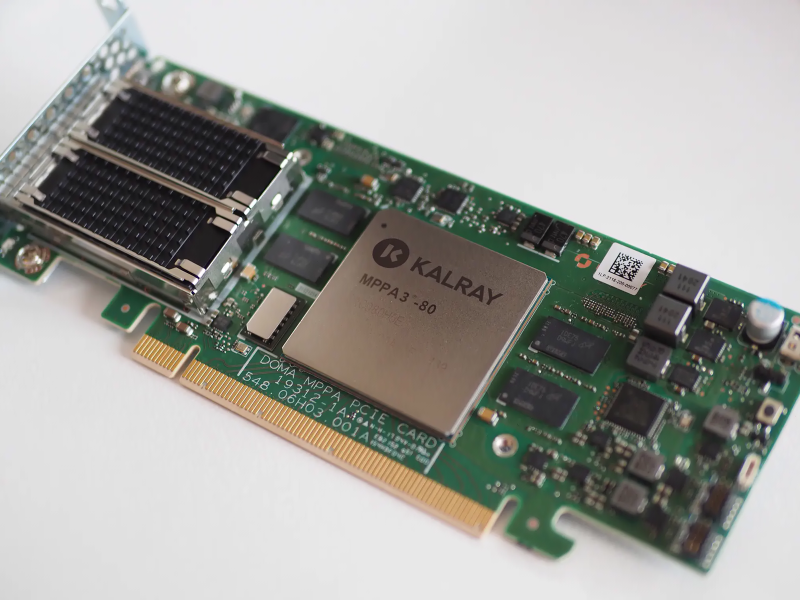

Kalray и Pliops объединятся для разработки передовых решений для генеративного ИИКомпании Kalray и Pliops, по сообщению ресурса Storage Newsletter, подтвердили информацию о слиянии. Объединённая структура, как утверждается, займётся разработкой передовых решений SoC (System-on-Chips) для генеративного ИИ и ускорения обработки данных. О том, что стартапы Kalray и Pliops ведут переговоры о слиянии, стало известно в июне 2024 года. Kalray проектирует DPU-ускорители на основе чипов с фирменной архитектурой MPPA. В свою очередь, Pliops разрабатывает ускорители Extreme Data Processor (XDP) для различных задач, включая реляционные базы данных, разнородные СУБД NoSQL, платформы 5G и IoT, приложения ИИ и пр.

Источник изображения: Kalray Объединив технологии Pliops и архитектуру Kalray MPPA, стороны намерены предоставить заказчикам высокопроизводительные SoC для обработки данных в системах ИИ. Слияние будет осуществлено путём обмена ценными бумагами, при этом акционеры Kalray сохранят контрольный пакет. В рамках сделки стороны рассматривают возможность привлечения дополнительных средств из различных источников для ускорения развития. При этом Kalray уже получила финансирование в размере €15 млн в рамках возобновляемого банковского кредита. «Слияние представляет собой важную стратегическую возможность для обеих компаний. Объединив наши сильные стороны, мы намерены стать мировым лидером в области решений по ускорению обработки информации для платформ хранения данных и систем ИИ», — говорит Эрик Баиссус (Eric Baissus), генеральный директор Kalray. Отмечается, что технологии Pliops играют ключевую роль в повышении производительности массивов хранения данных на основе накопителей NVMe и приложений баз данных. Pliops привлекла около $200 млн с момента основания в 2017 году; компания насчитывает примерно 120 сотрудников в Израиле, США и Китае. В число её инвесторов входят AMD, Intel Capital, NVIDIA, SoftBank Ventures Asia, Western Digital и др. После завершения слияния существующие акционеры Pliops станут акционерами Kalray.

01.07.2024 [08:44], Сергей Карасёв

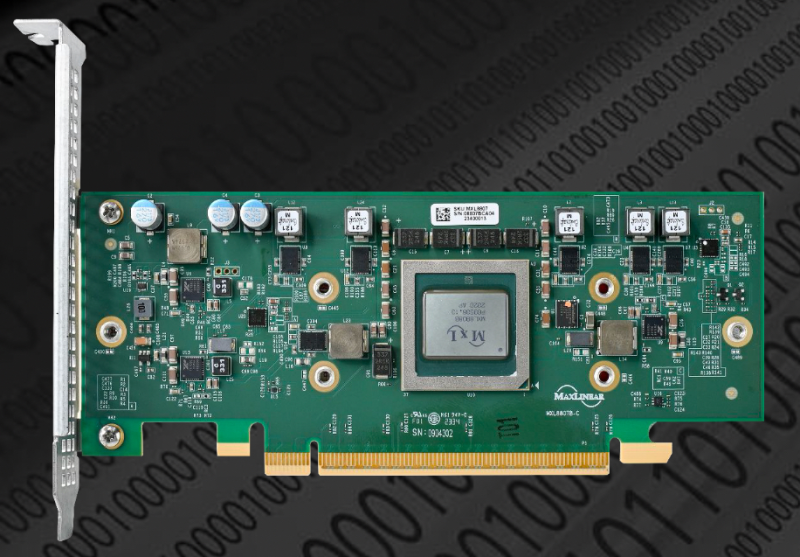

MaxLinear представила DPU MxL8900 для NVMe-хранилищКомпания MaxLinear, по сообщению ресурса Blocks & Files, разработала ускорители обработки данных Panther III серии MxL8900, предназначенные для использования в ЦОД. В семейство вошли изделия с интерфейсом PCIe 4.0, а в дальнейшем планируется реализовать поддержку PCIe 5.0. Устройства берут на себя выполнение таких задач, как сжатие данных, дедупликация, кодирование/декодирование и шифрование. Благодаря этому снижается нагрузка на CPU, что позволяет поднять производительность и энергоэффективность серверов. Panther III является разновидностью DPU (Data Processing Unit), но MaxLinear предпочитает не использовать этот термин. Директор компании по маркетингу Марк Моран (Mark Moran) говорит, что у многих клиентов DPU ассоциируется с применением Arm-чипа, но в устройствах Panther III такие процессоры не применяются из-за недостаточно высокой производительности. В серию MxL8900 вошли варианты с интерфейсом PCIe 4.0 х4, PCIe 4.0 х8 и PCIe 4.0 х16 с пропускной способностью 25, 50, 100 и 200 Гбит/с. Ускорители выпускаются в виде карт PCIe HHHL и OCP NIC SFF. Задержки при кодировании и декодировании информации заявлены на уровне 40 мкс и 25 мкс. До 16 карт можно объединить в каскадную конфигурацию, чтобы увеличить пропускную способность до 400–3200 Гбит/с. Возможно шифрование по алгоритму AES. Поддерживается сжатие GZIP Level 9, ZLIB Level 9, Deflate Level 9, XP10 Level 6/11, LZS/eLZS. Говорится о коэффициенте компрессии до 15:1 для структурированных данных и 12:1 для неструктурированных данных, что увеличивает эффективную ёмкость NVMe-накопителей в 15 и 12 раз соответственно.

25.06.2024 [21:49], Алексей Степин

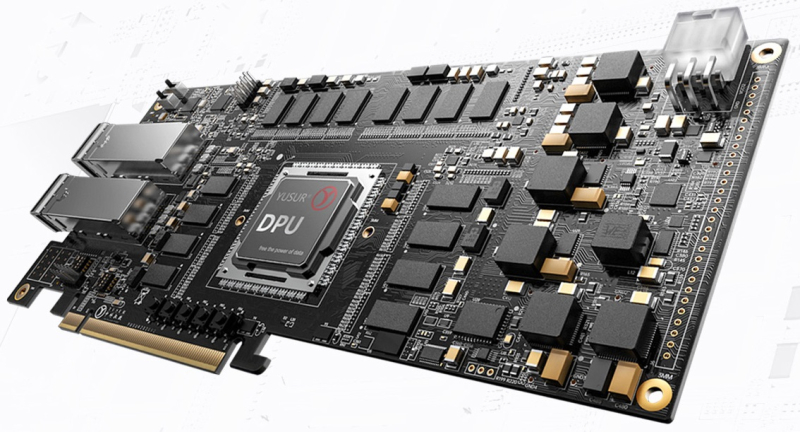

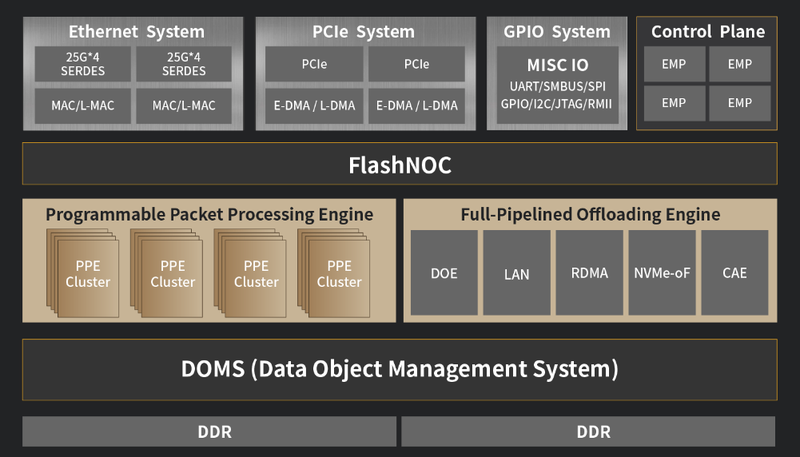

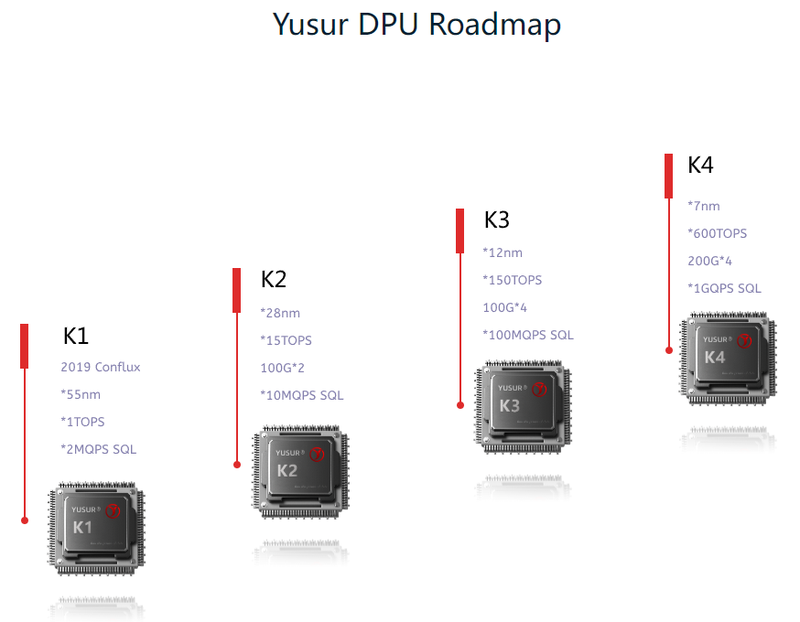

Китайский стартап Yusur наладил массовое производство DPU третьего поколения K2-ProСопроцессоры DPU уже нельзя назвать какой-то экзотикой. Их разрабатывают многие компании, преимущественно американские. Несмотря на растущее давление со стороны западных стран, не собирается проигрывать в этой гонке и Китай. Разработчик сопроцессоров и программно определяемых ускорителей из КНР, стартап Yusur, работающий в союзе с Китайской Академии Наук уже шесть лет, представил третье поколение DPU под названием K2-Pro. При этом, по словам компании, уже налажено массовое производство новинки. Первый DPU Yusur K1 был представлен ещё в 2019 году. И это была «проба пера», проверка самой возможности создания собственного DPU, способного ускорять работу сети, СУБД и ИИ. Чип использовал 55-нм техпроцесс, обеспечивал обработку 2 млн запросов SQL в секунду и имел производительность порядка 1 Топс. Уже в 2022 году был представлен полноценный DPU Yusur K2. Созданный с использованием 28-нм техпроцесса, он уже имел пару собственных интерфейсов 100GbE, мог обрабатывать 10 млн запросов SQL и развивал мощность 15 Топс. K2-Pro имеет схожие характеристики, но, как сообщает глава Yusur, на 30% экономичнее предшественника. Что касается сетевой производительности, то речь идёт об обработке до 80 млн пакетов в секунду при совокупной пропускной способности интерфейсов 200 Гбит/с.

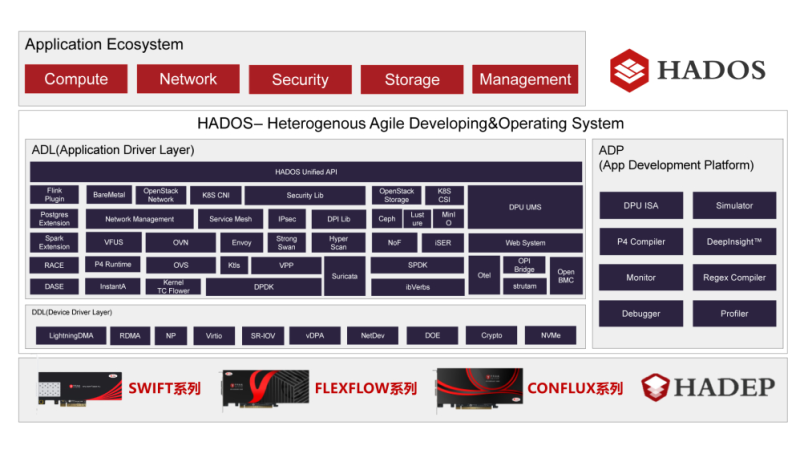

Архитектура K2-Pro. Источник: Yusur Технически в основе DPU Yusur серии K лежит программно-определяемая архитектура KPU с набором инструкций собственной разработки, работающая под управлением программной платформы HADOS, сочетающей в себе операционную систему, набор движков и API для реализации самых различных функций, а также все необходимые средства разработки. Поддерживается совместимость с P4, что упрощает разработку сетевых приложений для данной архитектуры. Также в составе K2-Pro имеется квартет управляющих ядер и набор движков, отвечающих за поддержку сетевых интерфейсов, разгрузку ряда сетевых операций, криптографии, SR-IOV, RDMA и NVMe-oF. В состав DPU входит BMC-контроллер на базе OpenBMC. Есть и два набора по 16 линий PCIe 3.0.

Планы Yusur относительно разработки следующих поколений DPU. Источник: Yusur Планы по дальнейшему развитию данной серии DPU весьма серьёзные: в следующем поколении, K3, вычислительная мощность должна вырасти в 10 раз, с 15 до 150 Топс. В поколении K4 производительность как минимум утроится, а сетевая часть будет включать уже четыре интерфейса 200GbE. Конкретных сроков исполнения своих планов Yusur не приводит, однако серьёзные намерения КНР в этой сфере очевидны. Представитель Китайской инженерной академии, профессор Чжэн Вэйминь (Zheng Weimin) отметил, что КНР обязана покончить с монополией на иностранные чипы класса DPU, дабы обеспечить суверенность и независимость в сфере ИТ-технологий.

24.06.2024 [12:14], Сергей Карасёв

DPU-разработчики Kalray и Pliops ведут переговоры о слиянииСтартапы Kalray и Pliops, по сообщению Blocks & Files, на протяжении нескольких месяцев ведут переговоры о слиянии. Объединив активы, компании, как ожидается, смогут укрепить позиции на рынке специализированных сопроцессоров для обработки данных (DPU). Фирма Kalray, базирующаяся во Франции, была основана в 2008 году. Стартап отделился от Комиссариата по атомной и альтернативным видам энергии Франции (СЕА). Kalray разрабатывает DPU-ускорители на основе чипов с фирменной архитектурой MPPA. В 2018-м Kalray осуществила первичное публичное размещение акций (IPO) на площадке Euronext Paris, получив €47,7 млн. В свою очередь, израильская компания Pliops учреждена в 2017 году. В число её инвесторов входят AMD, Intel Capital, NVIDIA, SoftBank Ventures Asia, Western Digital и др. Стартап разрабатывает ускорители Extreme Data Processor (XDP) для широкого спектра приложений, включая реляционные базы данных, разнородные СУБД NoSQL, резидентные базы данных, платформы 5G и IoT, задачи ИИ и машинного обучения и пр. Генеральный директор Kalray Эрик Байссус (Eric Baissus) заявил, что планируемое слияние с Pliops представляет собой «значительную стратегическую возможность». Сообща стороны смогут претендовать на мировое лидерство в сегменте DPU — решения обеих компаний ориентированы на работу с данными и хранилищами, а не на управление инфраструктурой (IPU). Председатель правления Pliops Эял Уолдман (Eyal Waldman) добавляет, что сделка откроет новые бизнес-возможности для обеих компаний. В случае заключения окончательного соглашения о слиянии 65 % объединённой структуры будет принадлежать Kalray, а оставшиеся 35 % — Pliops. При этом Kalray выпустит новые ценные бумаги для акционеров Pliops. Отмечается, что доля Pliops может вырасти до 40 %, если будут достигнуты определенные бизнес-показатели. На сегодняшний день капитализаций Kalray оценивается в €140 млн, тогда как рыночная стоимость объединённой структуры составит приблизительно €240 млн. Таким образом, оценка Pliops находится в диапазоне от €84 млн до €96 млн.

23.04.2024 [11:43], Сергей Карасёв

MaxLinear повысит производительность и эффективность СХД Dell PowerMaxКомпании MaxLinear и Dell Technologies объявили о заключении соглашения о сотрудничестве, которое направлено на повышение производительности и эффективности систем хранения Dell PowerMax на основе накопителей NVMe SSD и процессоров Intel Xeon. В рамках партнёрства платформы PowerMax 2500 и 8500 будут оснащены ускорителем MaxLinear Panther III. Это решение было представлено в августе 2022 года. Изделие содержит 16 аппаратных движков для хеширования, шифрования/дешифрования, компрессии/декомпрессии и сквозной защиты данных (RTV). Утверждается, что пропускная способность превышает 200 Гбит/c. Кроме того, обеспечивается дедупликация данных вплоть до 12:1. В случае СХД семейства PowerMax применение MaxLinear Panther III позволит оптимизировать ресурсы хранения и снизить общую стоимость владения. Заявленный коэффициент сокращения объёмов данных достигает 5:1, тогда как эффективная вместимость массивов может достигать 18 Пбайт. При этом время отклика составляет менее 18 мкс. Обеспечивается высокий уровень безопасности, что важно при работе с критической информацией.

Источник изображения: Dell Отмечается, что сотрудничество между MaxLinear и Dell знаменует собой важную веху в развитии решений хранения данных для бизнеса на основе ИИ. Утверждается, что массивы PowerMax 2500 и 8500 устанавливают новый стандарт для корпоративных СХД, позволяя организациям раскрыть весь потенциал своей инфраструктуры и стимулировать бизнес-инновации. Причём развёртываться СХД могут как в локальных ЦОД, так и в гибридных облачных средах.

19.04.2024 [22:51], Владимир Мироненко

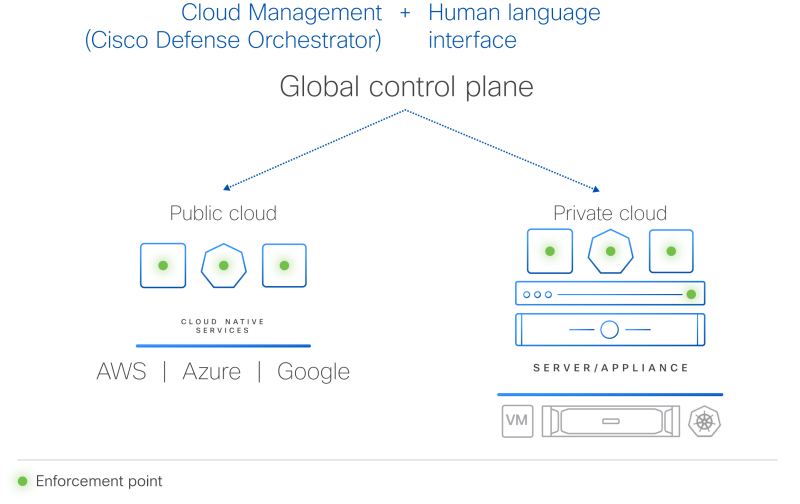

Гиперщит с ИИ: Cisco представила систему безопасности HypershieldCisco представила комплексную распределённую систему безопасности нового поколения Hypershield, призванную укрепить защиту ЦОД и облачной инфраструктуры. Cisco Hypsershield предназначена для защиты приложений, устройств и данных в различных средах, включая государственные и частные ЦОД, облака и физические устройства. Как утверждает компания, благодаря интеграции ИИ новая технология позволяет добиться более высоких результатов в области безопасности, чем это было возможно с помощью людей. Hypershield использует постоянно дообучающийся ИИ, а платформа изначально построена и спроектирована как автономная система с возможностью прогнозирования. Hypershield создана на основе технологии, изначально разработанной для гиперскейлеров. Система представляет собой скорее структуру безопасности, позволяющую применять политики безопасности везде, где это необходимо: для каждой службы приложений, кластера Kubernetes, контейнера, виртуальной машины или сетевого порта. По словам компании, Hypershield может обеспечить безопасность везде, где нужно клиенту — в программном окружении, на сервере и в будущем даже в сетевом коммутаторе. В распределённой системе, которая может включать сотни тысяч точек применения политик (Enforcement Point), упрощённое управление имеет решающее значение, отмечает Cisco. Hypershield предлагает распределённую защиту от эксплойтов, применяя в течение нескольких минут после появления информации об атаках различные компенсаторные механизмы, в том числе меняя конфигурацию сети на лету. В случае проникновения атакующего в сеть система автоматически делает сегментацию. Кроме того, Hypershield автономно тестирует обновление ПО и политик, применяя их сначала внутри цифрового двойника и оценивая последствия вносимых изменений. В программных средах Hypershield использует в первую очередь eBPF, причём ранее Cisco приобрела ведущего поставщика решений в этой области. На аппаратном уровне она позволяет задействовать DPU, в скором будущем компания представит новые коммутаторы с интегрированными DPU. Как ожидается, Cisco Hypershield станет доступна в августе этого года. Лицензию придётся покупать на каждую рабочую нагрузку, но точные критерии расчёта стоимости компания пока не раскрывает. |

|