Материалы по тегу: all-flash

|

02.12.2025 [09:39], Владимир Мироненко

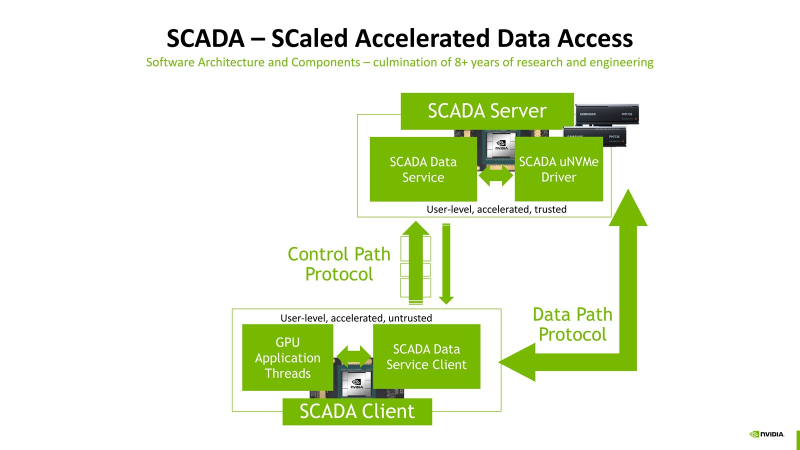

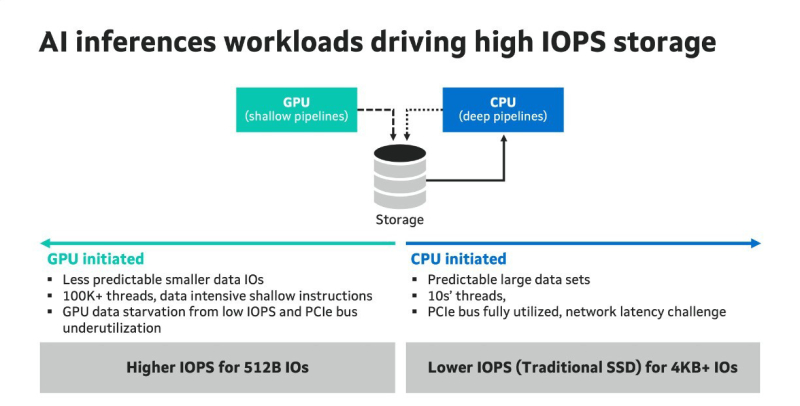

Миллионы IOPS, без посредников: NVIDIA SCADA позволит GPU напрямую брать данные у SSDNVIDIA разрабатывает SCADA (Scaled Accelerated Data Access, масштабируемый ускоренный доступ к данным) — новую IO-архитектуру, где GPU инициируют и управляют процессом работы с хранилищами, сообщил Blocks & Files. SCADA отличается от существующего протокола NVIDIA GPUDirect, который, упрощённо говоря, позволяет ускорить обмен данными с накопителями, напрямую связывая посредством RDMA память ускорителей и NVMe SSD. В этой схеме CPU хоть и не отвечает за саму передачу данных, но оркестрация процесса всё равно ложится на его плечи. SCADA же предлагает перенести на GPU и её. Обучение ИИ-моделей обычно требует передачи больших объёмов данных за сравнительно небольшой промежуток времени. При ИИ-инференсе осуществляется передача небольших IO-блоков (менее 4 Кбайт) во множестве потоков, а время на управление каждой передачей относительно велико. Исследование NVIDIA показало, что инициирование таких передач самим GPU сокращает время и ускоряет инференс. В результате была разработана схема SCADA. NVIDIA уже сотрудничает с партнёрами по экосистеме хранения данных с целью внедрения SCADA. Так, Marvell отмечает: «Потребность в ИИ-инфраструктуре побуждает компании, занимающиеся СХД, разрабатывать SSD, контроллеры, NAND-накопители и др. технологии, оптимизированные для поддержки GPU, с акцентом на более высокий показатель IOPS для ИИ-инференса. Это будет принципиально отличаться от технологий для накопителей, подключенных к CPU, где главными приоритетами являются задержка и ёмкость». По словам Marvell, в рамках SCADA ускорители используют семантику памяти при работе с накопителями. Однако сами SSD мало подходят для таких задач, поскольку не могут обеспечить необходимый уровень IOPS, когда во время инференса тысячи параллельных потоков запрашивают наборы данных размером менее 4 Кбайт. Это приводит к недоиспользованию шины PCIe, «голоданию» GPU и пустой трате циклов. В CPU-центричной архитектуре, которая подходит для обучения моделей, параллельных потоков данных десятки, а не тысячи, а блоки данных крупные — от SSD требуется высокие ёмкость и пропускная способность, а также малая задержка, поскольку свою задержку в рамках СХД также внесут PCIe и Ethernet. Внедрение PCIe 6.0 и PCIe 7.0, конечно, само по себе ускорит обмен данными, но контроллеры SSD также нуждаются в обновлении. Они должны уметь использовать возможности SCADA, иметь оптимальные схемы коррекции ошибок для малых блоков данных и быть мультипротокольными (PCIe, CXL, Ethernet). Компания Micron также участвует в разработке SCADA. В рамках SC25 Micron показала прототип SCADA-хранилища на базе платформы H3 Platform Falcon 6048 с PCIe 6.0 (44 × E1.S NVMe SSD + 6 × GPU/DPU/NIC), оснащённой 44 накопителями Micron 9650 (7,68 Тбайт, до 5,4 млн на случайном чтении 4K-блоками с глубиной очереди 512, PCIe 6.0), тремя коммутаторами Broadcom PEX90000 (144 линии PCIe 6.0 в каждом), одним процессором Intel Xeon (PCIe 5.0) и тремя ускорителями NVIDIA H100 (PCIe 5.0). Micron заявила, что система «демонстрирует линейное масштабирование производительности от 1 до 44 SSD», доходя до 230 млн IOPS, что довольно близко к теоретическому максимуму в 237,6 млн IOPS. «В сочетании с PCIe 6.0 и высокопроизводительными SSD архитектура [SCADA] обеспечивает доступ к данным в режиме реального времени для таких рабочих нагрузок, как векторные базы данных, графовые нейронные сети и крупномасштабные конвейеры инференса», — подытожила Micron.

24.11.2025 [09:09], Сергей Карасёв

IBM утроила вместимость СХД Storage Scale System 6000 — до 47 Пбайт на стойкуКорпорация IBM объявила о выпуске обновлённой СХД Storage Scale System 6000, предназначенной для работы с ресурсоёмкими ИИ-приложениями, а также с нагрузками, которым требуется интенсивный обмен большими объёмами информации. Платформа Storage Scale System 6000 дебютировала в конце 2024 года. Устройство типоразмера 4U оснащено двумя контроллерами, работающими в режиме «активный — активный». Применяются процессоры AMD EPYC Genoa 7642 (48C/96T; 2,3–3,3 ГГц; 225 Вт) или EPYC Embedded 9454 (48C/96T; 2,75–3,8 ГГц; 290 Вт), а максимальный объём оперативной памяти в расчёте на систему составляет 3072 Гбайт. Допускается установка 48 NVMe-накопителей. Также поддерживаются фирменные FCM-модули со сжатием на лету. Вместимость оригинальной версии достигала 2,2 Пбайт (при использовании комбинации SSD на 30 и 60 Тбайт). При подключении девяти дополнительных JBOD-массивов показатель вырастал до 15 Пбайт. Заявленная производительность — до 13 млн IOPS. Пропускная способность при чтении — до 330 Гбайт/с, при записи — до 155 Гбайт/с.

Источник изображения: IBM В случае обновлённой модификации Storage Scale System 6000 реализована поддержка QLC-накопителей вместимостью до 122 Тбайт. Кроме того, представлены новые модули расширения All-Flash Expansion Enclosure стандарта 2U, рассчитанные на 26 двухпортовых накопителей QLC. В результате, общая ёмкость СХД в конфигурации в виде стойки 42U достигает 47 Пбайт, что примерно втрое больше по сравнению с оригинальным вариантом. При этом быстродействие поднялось до 28 млн IOPS, а пропускная способность в режиме чтения — до 340 Гбайт/с. В состав All-Flash Expansion Enclosure входят DPU NVIDIA BlueField-3 (до 4 шт.). Каждый модуль расширения может обеспечить пропускную способность до 100 Гбайт/с. Решение оптимизировано для обучения больших языковых моделей, инференса, НРС-задач и пр. В продажу изделие поступит в декабре; тогда же станет доступно улучшенное ПО для СХД — IBM Storage Scale System 7.0.0.

30.10.2025 [11:55], Сергей Карасёв

Компактное хранилище QNAP NASbook TBS-h574TX рассчитано на накопители E1.S SSDКомпания QNAP Systems анонсировала сетевое хранилище NASbook TBS-h574TX в компактном «настольном» форм-факторе, ориентированное на профессиональных пользователей, которые занимаются видеомонтажом, созданием визуальных эффектов и анимации. Устройство выполнено на аппаратной платформе Intel Alder Lake. Применён процессор Core i5-1235U с десятью ядрами (2P+8E), функционирующими на тактовой частоте до 4,4 ГГц. В состав чипа входит графический ускоритель Intel Iris Xe. Объём оперативной памяти составляет 16 Гбайт (без возможности расширения), интегрированной флеш-памяти — 5 Гбайт. Кроме того, доступны модификации с 12-ядерным чипом Core i5-1340PE (4P+8E) с тактовой частотой до 4,5 ГГц и 8-ядерным процессором Core i3-1320PE (4P+4E) с такой же максимальной частотой. Объём ОЗУ у этих версий составляет соответственно 16 и 12 Гбайт. Новинка располагает пятью отсеками для накопителей. Могут устанавливаться SSD типоразмера E1.S толщиной до 15 мм с интерфейсом PCIe 3.0 x2 или M.2 2280 (NVMe) с радиатором охлаждения толщиной до 4,5 мм. Покупателям, в частности, предлагаются варианты с пятью предустановленными SSD стандарта E1.S вместимостью 1,92 или 3,84 Тбайт каждый с суммарной ёмкостью соответственно 9,6 и 19,2 Тбайт. Хранилище оснащено сетевыми портами 2.5GbE и 10GbE, интерфейсом HDMI 1.4b, разъёмом USB 2.0, двумя портами USB 3.2 Gen2, а также двумя портами Thunderbolt 4, которые можно использовать для прямого подключения к рабочим станциям под управлением Windows и macOS. Для охлаждения применяются два вентилятора диаметром 40 мм. Диапазон рабочих температур — от 0 до +40 °C. Габариты составляют 60 × 215 × 199 мм, масса — 2,24 кг (без установленных накопителей). Питание устройство получает от сетевого адаптера мощностью 120 Вт; заявленное типовое энергопотребление — 46 Вт. Производитель предоставляет трёхлетнюю гарантию.

01.10.2025 [15:40], Владимир Мироненко

YADRO анонсировала поддержку NVMe over TCP — более доступной и производительной альтернативы FC и iSCSIКомпания YADRO объявила о предстоящем выходе технологии NVMe over TCP (Non-Volatile Memory Express с транспортным протоколом TCP), которая станет доступна с осенним релизом v3.2 СХД TATLIN.UNIFIED. Новое решение YADRO позволяет снизить задержки, увеличить производительность и достигнуть максимальной простоты работы с данными. Уже сейчас его можно протестировать в режиме предварительного доступа. Компания отметила, что работа по протоколу Fibre Channel (FC) становится сложнее из-за выросшей стоимости использования и сложности обслуживания оборудования, в то время как протокол iSCSI часто не отвечает требованиям задач бизнеса из-за ограничений по производительности и проблем с надёжностью и отказоустойчивостью. Согласно данным внутреннего тестирования, при использовании NVMe/TCP ускорение операций ввода-вывода по сравнению с FC составило до 30 %, сокращение задержек — 25 %. По сравнению с iSCSI новое решение обеспечивает производительность выше на 62 %. NVMe over TCP снижает нагрузку на операционную систему, упрощает процесс обнаружения изменений в хранилище и легко интегрируется с ОС на базе ядра Linux, позволяя оптимизировать скорость работы с ресурсоёмкими задачами и высоконагруженными корпоративными приложениями. Встроенная функция многопутевого ввода-вывода (Native NVMe Multipath) обеспечивает стабильную работу даже при подключении тысячи ресурсов/логических томов. Также следует отметить доступную стоимость внедрения и простоту эксплуатации новой технологии. Для перехода на неё с iSCSI не требуется дополнительное оборудование, а при переходе с FC компания предлагает заказчикам решение на базе сетевых коммутаторов KORNFELD, которые поддерживают NVMe/TCP и интегрированы с СХД TATLIN для построения единой end-to-end NVMe-инфраструктуры. В настоящее время YADRO ведёт проработку интеграции технологии с решениями технологических партнёров. Некоторые из них уже выпустили или готовят к выпуску в ближайшее время собственных решений с использованием NVMe over TCP. Компания отметила, что помимо NVMe/TCP в релизе 3.2 будет представлен целый ряд улучшений, включая поддержку LACP на виртуальных портах для файлового доступа, VLAN на виртуальных портах для блочного и файлового доступа и Root squash для файловых ресурсов. Также будут увеличены лимиты ресурсов на систему и повышена производительность и безопасность.

29.08.2025 [23:15], Владимир Мироненко

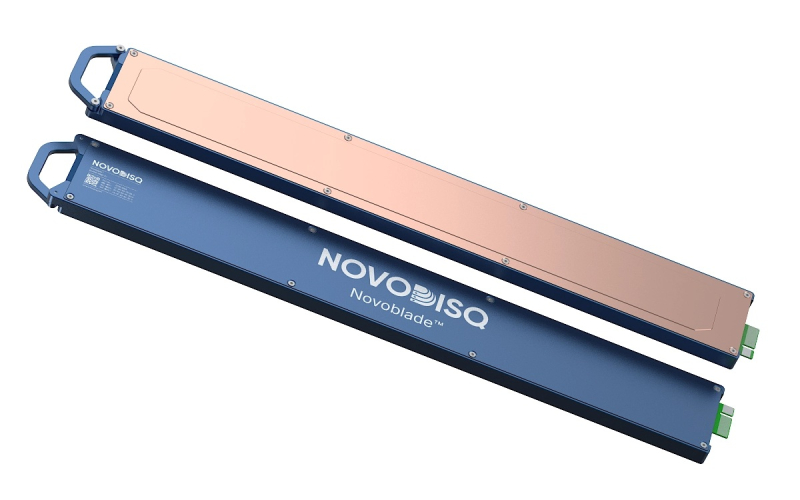

11,5 Пбайт в 2U: Novodisq представил блейд-сервер для ИИ и больших данныхСтартап Novodisq представил блейд-сервер формата 2U ёмкостью 11,5 Пбайт с функцией ускорения ИИ и др. задач. Гиперконвергентная кластерная система разработан для замены или дополнения традиционных решений NAS, SAN и публичных облачных сервисов. Новинка поддерживает платформы Ceph, MinIO и Nextcloud (также планируется поддержка DAOS), предлагая доступ по NFS, iSCSI, NVMe-oF и S3. Сервер содержит до 20 модулей Novoblade с фронтальной загрузкой. В каждом из них имеется до четырёх встроенных E2 SSD Novoblade объёмом 144 Тбайт каждый, на базе TLC NAND с шиной PCIe 4.0 x4. Накопители поддерживают NVMe v2.1 и ZNS, обеспечивая последовательную производительность чтения/записи до 1000 Мбайт/с, а на случайных операциях — до 70/30 тыс. IOPS. Надёжность накопителей составляет до 24 PBW. Энергопотребление: от 5 до 10 Вт. Система Novoblade предназначена для «тёплого» и «холодного» хранения данных. Модули Novoblade объединяют вычислительные возможности, ускорители и хранилища. Основной модулей являются гибридные SoC AMD Versal AI Edge Gen 2 (для ИИ-нагрузок) или Versal Prime Gen 2 (для традиционных вычислений) c FPGA, 96 Гбайт DDR5, 32 Гбайт eMMC, модулем TPM2 и двумя интерфейсам 10/25GbE с RoCE v2 RDMA и TSN. Энергопотребление не превышает 60 Вт. Есть функции шифрования накопителей, декодирования видео, ускорения ИИ-обработки, оркестрации контейнеров и т.д. Платформа специально разработана для задач с большими объёмами данных, таких как геномика, геопространственная визуализация, видеоархивация и периферийные ИИ-вычисления. Сервер может работать под управлением стандартных дистрибутивов Linux (RHEL и Ubuntu LTS) с поддержкой Docker, Podman, QEMU/KVM, Portainer и OpenShift. 2U-шасси глубиной 1000 мм рассчитано на установку до двадцати модулей Novodisq и оснащено двумя (1+1) БП мощностью 2600 Вт каждый (48 В DC). Возможно горизонтальное масштабирование с использованием каналов 100–400GbE. В базовой конфигурации шасси включает четыре 200GbE-модуля с возможностью горячей замены, каждый из которых имеет SFP28-корзины, а также управляемый L2-коммутатор. Предусмотрен набор средств управления, включая BMC с веб-интерфейсом, CLI и поддержкой API Ansible, SNMP и Redfish. Novoblade поддерживает локальное и удалённое управление, может интегрироваться в существующий стек или предоставляться с помощью инструментов «инфраструктура как код» (Infrastructure-as-Code). По словам разработчика, система Novoblade обеспечивает плотность размещения примерно в 10 раз выше, чем у сервера на основе жестких дисков, и снижает энергопотребление на 90–95 % без необходимости в механическом охлаждении. Novodisq утверждает, что общая стоимость владения системой «обычно на 70–90 % ниже, чем у традиционных облачных или корпоративных решений в течение 5–10 лет». «Это обусловлено несколькими факторами: уменьшенным пространством в стойке, низким энергопотреблением, отсутствием платы за передачу данных, минимальным охлаждением, длительным сроком службы и значительным упрощением управления. В отличие от облака, ваши расходы в основном фиксированы, а значит, предсказуемы, и, в отличие от традиционных систем, Novodisq не требует дорогостоящих лицензий, внешних контроллеров или постоянных циклов обновления. Вы получаете высокую производительность, долгосрочную надёжность и более высокую экономичность с первого дня», — приводит Blocks & Files сообщение компании. Для сравнения, узлы Dell PowerScale F710 и F910 на базе 144-Тбайт Solidigm SSD ёмкостью 122 Тбайт, 24 отсеками в 2U-шасси и коэффициентом сжатия данных 2:1 обеспечивают почти 6 Пбайт эффективной емкости, что почти вдвое меньше, чем у сервера Novoblade.

23.07.2025 [09:37], Владимир Мироненко

SSD не нужны: OFP обещает на порядок повысить плотность All-Flash СХД и наполовину снизить расходы на инфраструктуруИнициатива Open Flash Platform (OFP) призвана полностью пересмотреть работу с флеш-памятью в ИИ ЦОД. Участники OFP — Hammerspace, Linux Foundation, Лос-Аламосская национальная лаборатория (LANL), ScaleFlux, SK hynix и Xsight Systems — намерены отказаться от традиционных All-Flash хранилищ и контроллеров. Вместо них предложено использовать флеш-картриджи с минимумом аппаратной начинки, а доступ к таким массивам предоставлять посредством DPU и pNFS. Как отмечено в пресс-релизе, OFP отвечает многим фундаментальным требованиям, возникающим в связи со следующим этапом развития СХД для ИИ. Для ИИ требуются поистине огромные массивы данных, но вместе с тем ЦОД сталкиваются с дефицитом энергии, повышением температуры и недостатком свободного места. Именно поэтому в OFP решили, что инфраструктуры хранения для ИИ лучше разработать с чистого листа. Если 10 лет назад технология NVMe вывела флеш-память на новый уровень производительности благодаря отказу от устаревших шин данных и контроллеров, то теперь OFP обещает раскрыть возможности флеш-памяти, исключив посредников в виде серверов хранения и проприетарных программных стеков. OFP же опирается на открытые стандарты и open source решения, в частности, Parallel NFS (pNFS) и стандартный Linux, для размещения флеш-памяти непосредственно в SAN. А отказ от традиционных СХД обеспечит на порядок большую плотность размещения данных, существенную экономию энергии и значительно более низкую совокупную стоимость владения. OFP отметила, что существующие решения изначально привязаны к модели сервера хранения, которая требует чрезмерных ресурсов для повышения производительности и возможностей. Конструкции всех современных поставщиков AFA не оптимизированы для достижения максимальной плотности размещения флеш-памяти и привязаны к сроку службы CPU (обычно пять лет), тогда как срок службы флеш-памяти в среднем составляет восемь лет. Эти серверы хранения также предлагают проприетарные структуры и уровни хранения данных, что приводит к увеличению количества копий данных и добавлению расходов на лицензирование для каждого узла. Комментируя инициативу, ресурс Blocks & Files отметил, что Pure Storage и другие поставщики AFA уже предлагают оптимизированные схемы лицензирования и подписки, в том числе с обновлением контроллеров и дисковых полок. Та же Pure Storage предлагает более высокую плотность хранения, чем многие другие поставщики, хотя и использует проприетарные решения. Поддержкой DPU тоже удивить нельзя. Например, VAST Data уже поддерживает работу своего ПО на NVIDIA BlueField-3. А большинство поставщиков флеш-массивов и так поддерживают RDMA и GPUDirect. OFP выступает за открытый, основанный на стандартах подход, включающий несколько основных элементов:

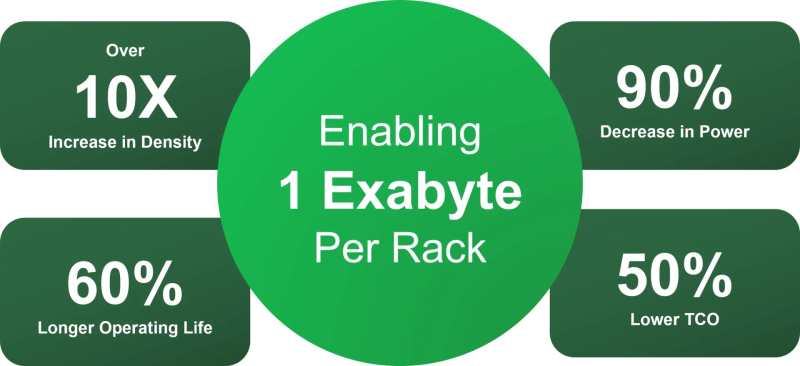

Благодаря использованию открытых архитектур и компонентов, соответствующих отраслевым стандартам, реализация OFP приведёт к значительному повышению эффективности хранения данных, утверждают основатели инициативы. Так, обещано десятикратное увеличение плотности размещения данных, что позволит «упаковать» в одну стойку 1 Эбайт, попутно снизив энергопотребление на 90 %, увеличив срок службы флеш-памяти на 60 % и уменьшив совокупную стоимость владения (TCO) на 60 % по сравнению со стандартными массивами хранения. По мнению Blocks & Files, в текущем виде OFP выглядит скорее как маркетинговая инициатива, от которой в первую очеред выиграют её участники. Концепция же «сетевых» SSD сама по себе не нова. Весной Kioxia показала SSD с «оптикой». Да, тут речь идёт скорее о блочном доступе и NVMe-oF, но, например, Nimbus Data в прошлом году представила ExaDrive EN с поддержкой NFS.

07.07.2025 [14:05], Сергей Карасёв

Суперкомпьютер Doudna получит смешанное All-Flash хранилище IBM и VAST DataНациональная лаборатория им. Лоуренса в Беркли (Berkeley Lab), принадлежащая Министерству энергетики США (DOE), сообщила о том, что суперкомпьютер Doudna получит передовую подсистему хранения данных на основе технологий IBM и VAST Data. Эта платформа сможет с высокой эффективностью справляться с интенсивными нагрузками, связанными с обучением ИИ-моделей и инференсом. НРС-комплекс Doudna (NERSC-10) расположится в Национальном вычислительном центре энергетических исследований США (NERSC) в составе Berkeley Lab. Основой суперкомпьютера послужат системы Dell Integrated Rack Scalable Systems и серверы PowerEdge с ускорителями NVIDIA Vera Rubin. По предварительным данным, машина обеспечит FP64-быстродействие до 790 Пфлопс при потреблении 5,8–8,7 МВт. С целью достижения стабильной и предсказуемой производительности в задачах, требующих анализа данных в режиме, близком к реальному времени, для Doudna выбрана гибридная подсистема хранения, включающая зоны QSS (Quality-of-service Storage System) и PSS (Platform Storage System). Первая ориентирована прежде всего на ИИ-нагрузки: предполагается применение решений VAST Data, включая платформу VAST AI OS. Эта платформа, как утверждается, «объединяет возможности хранения информации, базы данных, вычислений, обмена сообщениями и рассуждений в единую инфраструктуру, созданную с нуля для ИИ и программных агентов». В свою очередь, PSS использует в качестве основы программно-определяемое решение IBM Storage Scale: этот сегмент будет функционировать как быстродействующая параллельная файловая система. Говорится о высокой производительности, масштабируемости и эффективности, что поможет устранить узкие места и оптимизировать рабочие процессы, связанные с обработкой данных. Для обоих сегментов СХД предусмотрено использование архитектуры All-Flash, то есть, будут задействованы исключительно SSD. Как отмечает Berkeley Lab, гибридная подсистема хранения обеспечит в пять раз более высокую производительность, нежели нынешний НРС-комплекс NERSC. Это позволит справляться с крупномасштабными рабочими нагрузками в таких областях исследований, как молекулярная динамика и геофизическое моделирование. Ввести суперкомпьютер в эксплуатацию планируется в 2026 году.

20.06.2025 [09:11], Владимир Мироненко

Pure Storage анонсировала All-Flash СХД FlashArray//XL R5, FlashArray//ST и FlashBlade//S R2Pure Storage вместе с запуском EDC также расширила портфель All-Flash массивов хранения, представив решения FlashArray//XL, FlashArray//ST и FlashBlade//S следующего поколения. FlashArray//XL R5 устанавливает новый стандарт производительности, отметил ресурс StorageReview.com. Новая модель обеспечивает вдвое больше IOPS на единицу стойки и до 50% больше «сырой» емкости, чем у предшественника, позволяя клиентам консолидировать различные рабочие нагрузки на одной платформе. Эта консолидация обеспечивает простоту эксплуатации и экономию средств, что является критически важными преимуществами для организаций, управляющих крупномасштабными средами. Реализована поддержка FC, iSCSI/RoCE и NFS/SMB. Задержка составляет 150 мкс, пропускная способность — 45 Гбайт/с. Предлагаются модели:

Источник изображения: Pure Storage В свою очередь, FlashArray//ST специально создана для наиболее чувствительных к задержкам рабочих нагрузок, таких как базы данных в памяти, OLTP, запись журналов, масштабируемые или сегментированные базы данных NoSQL. Предоставляя более 10 млн IOPS всего в пяти стойках, FlashArray//ST обеспечивает производительность с низкой задержкой и высокой пропускной способностью, необходимую для приложений следующего поколения, говорит компания. Во FlashArray также была добавлена поддержка объектного хранилища, что позволяет организациям консолидировать блочное, файловое и объектное хранилище в одной СХД единую систему. Наконец, FlashBlade//S R2 также предназначено для чувствительных к задержкам рабочих нагрузок, таких как крупномасштабные конвейеры данных, ИИ-нагрузки, OLTP, запись журналов и масштабируемые или сегментированные базы данных NoSQL. Базовая конфигурация FlashBlade//S R2 включает 7–10 «лезвий» на 5U-шасси, до четырёх 37,5-Тбайт модулей DFM на узел //S100. Также есть 1U-шасси XFM, пара которых обеспечивает 16 подключений 400GbE.

04.06.2025 [09:44], Сергей Карасёв

YADRO представила All-Flash СХД Tatlin.AFAРоссийская компания YADRO представила высокопроизводительную систему хранения данных Tatlin.AFA, предназначенную для решения задач крупных корпоративных клиентов. Утверждается, что это первое в России решение типа All-NVMe с возможностью установки SSD с интерфейсом PCIe 4.0/5.0 и поддержкой End-to-end NVMe. Устройство выполнено в форм-факторе 2U и оснащено двумя контроллерами в режиме Symmetric Active–Active. Каждый из контроллеров оборудован двумя процессорами Intel Xeon поколения Emerald Rapids. Объём памяти DDR5 ECC составляет 1,5 Тбайт. Предусмотрены дублированные батареи для обеспечения сохранности данных в кеше. СХД располагает 24 отсеками для NVMe SSD стандарта U.2 / U.3 вместимостью до 30 Тбайт каждый, что в сумме даёт до 720 Тбайт «сырой» ёмкости. Кроме того, могут быть подключены два модуля расширения S24N, каждый из которых также содержит два двухпроцессорных контроллера, 24 слота для накопителей и два 200GbE-порта с RocE. Таким образом, общая вместимость в конфигурации с двумя модулями S24N превышает 2 Пбайт. Заявленное быстродействие на операциях ввода/вывода в секунду (IOPS) составляет более 2 млн, а пропускная способность достигает 50 Гбайт/с. Поддерживаются протоколы FC, iSCSI, NVMe/TCP, NVMe/RoCE. Заявлена совместимость с VMWare Sphere 7.x / 8.x, «РЕД ОС Виртуализация», «Альт Сервер Виртуализация», ECP Veil / SE, zVirt 3.x / 4.x, «Горизонт ВС», BASIS (DE), ОС Windows Server 2016/2019/2022, Oracle Linux 7.x/8.x/9.x, Rocky Linux 9.x, SUSE Linux 12/15, Ubuntu Server, IBM AIX 7.2 / 7.3 (VIOS), Astra Linux 1.x, «РЕД ОС» 7.3/7.3.1/8.0, «Альт Сервер».

Источник изображения: YADRO В зависимости от конфигурации доступны до 16/32 портов 10/25GbE, до 16 портов 100GbE или до 20 портов FC16/32/64. Предусмотрены пять слотов PCIe 5.0 x16 для сетевых адаптеров. Установлены два блока питания мощностью 3200 Вт с резервированием 1+1, поддержкой горячей замены и аккумуляторным модулем. Диапазон рабочих температур простирается от +10 до +30 °C. Упомянута собственная технология T-RAID с поддержкой различных схем защиты, резервирования компонентов и моментальных снимков. Реализованы следующие уровни защиты T-RAID: 8 + 1, 8 + 2, 8 + 3, 8 + 4, 8 + 5, 8 + 6, 8 + 7, 8 + 8, 10 + 1, 10 + 2, 10 + 3, а также 14 + 1 и 14 + 2. Использует программная платформа Tatlin.OS.

02.06.2025 [15:20], Владимир Мироненко

YADRO представила на ЦИПР первую отечественную All-NVMe систему хранения данных TATLIN.AFAКомпания YADRO объявила о выходе первой на российском рынке All-Flash системы хранения данных TATLIN.AFA с end-to-end NVMe-архитектурой — от накопителей до протоколов доступа, представленной на десятой конференции «Цифровая индустрия промышленной России» (ЦИПР-2025). В настоящее время система проходит серии внутренних нагрузочных испытаний и в ближайшее время станет доступна для тестирования в прикладных сценариях у заказчиков. TATLIN.AFA — система хранения данных старшего уровня с рекордной производительностью, высокой надёжностью и отказоустойчивостью для решения самых амбициозных и требовательных задач настоящего и будущего. Продукт, полностью разработанный инженерами YADRO и произведённый в России, нацелен на использование в крупных организациях с повышенными требованиями к скорости, надёжности и масштабируемости ИТ-инфраструктуры. Решение позволяет успешно справляться с самыми ресурсоёмкими задачами — от поддержки критически важных и высоконагруженных приложений и баз данных, до обслуживания таких перспективных нагрузок, как машинное обучение и ИИ. TATLIN.AFA, флагманская СХД линейки TATLIN, разработанная на базе собственной модульной аппаратной платформы компании YADRO TATLIN.X, отличается высокой производительностью: до 2 млн операций ввода-вывода в секунду (IOPS) и пропускная способность 50 Гбайт/с. Такая эффективность стала возможной благодаря использованию современных технологий в платформе YADRO TATLIN.X: мощнейших процессоров, PCIe 5.0, кеш-памяти объёмом не менее 1,5 Тбайт DDR5. Система объединяет два контроллера хранения и 24 NVMe-накопителя в 2U-шасси. Запланирована возможность расширения дисковой ёмкости путём добавления до двух интеллектуальных дисковых модулей S24N с 24 накопителями NVMe. Что немаловажно, TATLIN.AFA поддерживает протокол NVMe-over-Fabrics, который позволяет раскрыть потенциал флеш-накопителей и обеспечивает максимально эффективный доступ к данным с приростом производительности до 50 % в типовых сценариях работы с высоконагруженными базами данных, аналитическими системами и многопользовательскими приложениями. Также отмечено, что система обеспечивает самый высокий уровень надёжности. Предлагаемые наряду с уже известными и пользующимися на рынке заслуженной репутацией технологиями YADRO — такими как режим работы контроллеров хранения Symmetric Active-Active, резервирование ключевых компонентов и оригинальная технология защиты данных T-RAID, гарантирующая бесперебойную работу и сохранность информации даже при одновременном выходе из строя до восьми накопителей — системы TATLIN.AFA получили дополнительные степени защиты. В их числе, например, дублирование аккумуляторных батарей, каждая из которых способна обслуживать весь объём кеша в случае сбоя, и резервирование системных накопителей в контроллерах. Встроенная компрессия на лету с аппаратным ускорением эффективно оптимизирует использование хранилища без ощутимого падения производительности. Также обновлённая версия T-RAID с возможностью использования схемы защиты до 14+2 обеспечивает высокую полезную ёмкость при гарантированной надёжности. «TATLIN.AFA — это результат всего накопленного практического опыта YADRO в сфере разработки высокопроизводительных СХД. Мы создавали продукт, который поможет бизнесу не просто работать с данными, а уверенно расти и масштабироваться в условиях возрастающих требований и цифровой трансформации. В систему заложены самые современные технологии, чтобы обеспечивать надёжную работу в самыми ресурсоёмкими нагрузками. TATLIN.AFA станет оптимальным выбором для цифровых платформ, финансового и промышленного сектора, государственных организаций и всех компаний с потребностью в высокопроизводительной ИТ-инфраструктуре», — отметил Егор Литвинов, директор продуктового направления TATLIN YADRO. |

|