Лента новостей

|

20.11.2023 [08:52], Сергей Карасёв

Gartner: мировые затраты на публичные облака в 2024 году достигнут почти $680 млрдКомпания Gartner опубликовала прогноз по глобальному рыку публичных облачных сервисов на 2023–2024 годы. Аналитики полагают, что отрасль продолжит демонстрировать устойчивый рост, несмотря на сложную макроэкономическую обстановку, кризис в США и высокий уровень инфляции. По оценкам, в 2022-м мировые затраты в обозначенной сфере составили около $478,3 млрд. Из них $174,4 млрд пришлось на платформы SaaS (программное обеспечение как услуга), приблизительно $120,3 млрд — на сервисы IaaS (инфраструктура как услуга), примерно $119,6 млрд — на службы PaaS (платформа как услуга). Ещё $61,6 млрд принесли решения BPaaS (бизнес-процессы как услуга), $2,4 млрд — DaaS (десктоп как сервис).

Источник изображения: pixabay.com В 2023 году, как прогнозирует Gartner, объём рынка увеличится до $563,6 млрд, что будет соответствовать росту на 17,8 % в годовом исчислении. При этом SaaS останется крупнейшим сегментом с выручкой в размере $205,2 млрд. Около $145,3 принесут услуги PaaS, приблизительно $143,9 млрд — IaaS. На BPaaS и DaaS придётся соответственно $66,3 млрд и $2,8 млрд. В 2024-м мировая отрасль публичных облаков, по мнению аналитиков, покажет прибавку на уровне 20,4 % — до $678,8 млрд. Услуги SaaS обеспечат $244,0 млрд, решения IaaS — $182,2 млрд, сервисы PaaS — примерно $176,5 млрд. На BPaaS придётся $72,9 млрд, на DaaS — $3,2 млрд. Таким образом, как прогнозируется, в 2024 году во всех сегментах облачного рынка будет наблюдаться увеличение затрат. Наибольший рост ожидается в сферах IaaS — плюс 26,6 %, а также PaaS — около 21,5 %.

19.11.2023 [23:59], Владимир Мироненко

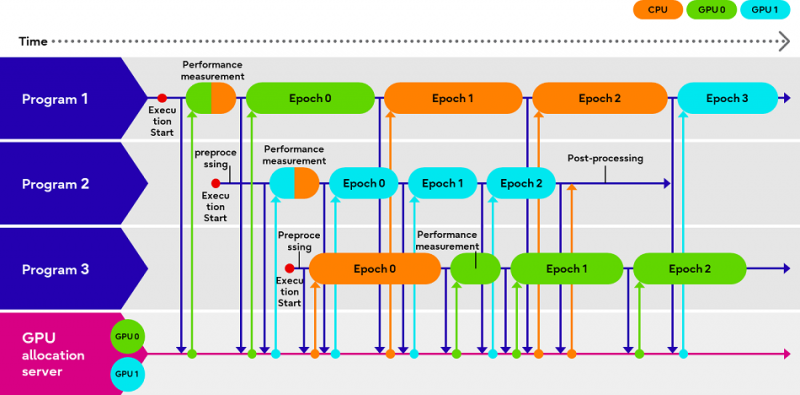

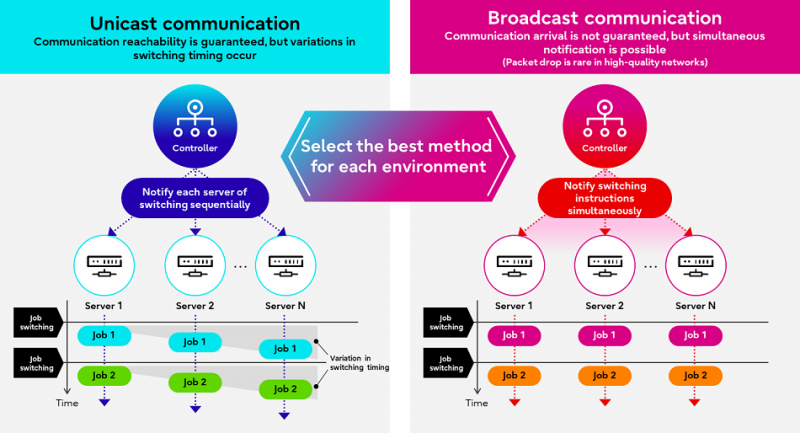

Fujitsu Adaptive GPU Allocator позволит эффективнее использовать дефицитные ИИ-ускорителиКомпания Fujitsu представила технологии Adaptive GPU Allocator и Interactive HPC, позволяющие оптимизировать использования ускорителей и HPC-кластеров. Эти технологии будут использоваться в некоторых из её собственных облачных HPC-продуктов. Компания утверждает, что новые решения призваны помочь решить проблему глобальной нехватки ускорителей в связи с большим спросом на генеративный ИИ, позволяя клиентам оптимизировать использование своих вычислительных ресурсов. По словам Fujitsu, Adaptive GPU Allocator способна динамически определять программы, для работы которых действительно требуется ускоритель, и программы, которым фактически достаточно CPU, и соответствующим образом распределять ресурсы. Технология основана на оценке уровня возможного ускорения при использовании GPU для каждой конкретной программы и выделении ресурсов ускорителей так, чтобы минимизировать общее время обработки всеми программами. Технических деталей о работе этой системы компания не предоставила. Сообщается лишь то, что при запросе программой доступа к ускорителю проводится замер скорости обработки одного и того же кусочка данных на CPU и GPU, на основании чего и принимается решение о дальнейшей обработке на CPU или GPU. Система может измерять производительность кода по мере его выполнения. Как уточняет The Register, что для работы Adaptive GPU Allocator программы должны задействовать фреймворк Fujitsu, который использует TensorFlow и PyTorch. Adaptive GPU Allocator станет частью ИИ-платформы Fujitsu Kozuchi, выход которой ожидается после II половины 2024 финансового года, заканчивающегося 31 марта 2025 года. Чуть раньше появится технология Interactive HPC, которая позволит переключаться между несколькими задачами в HPC-кластерах в режиме реального времени, тогда как, по словам Fujitsu, традиционный подход предполагает отправку узлам команд на переключение по очереди. Деталей компания снова не сообщила, отметив лишь то, что в кластере из 256 узлов Interactive HPC позволила сократить время переключения с одной задачи на другую с нескольких секунд до 100 мс.

19.11.2023 [22:52], Сергей Карасёв

Dell и Hugging Face упростят развёртывание генеративного ИИ на базе локальной инфраструктурыКомпании Dell Technologies и Hugging Face объявили о заключении соглашения о сотрудничестве, цель которого заключается в том, чтобы помочь корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ. Партнёры сформируют новый портал на платформе Hugging Face. Через него будут доступны специальные контейнеры и сценарии, которые помогут заказчикам быстро и безопасно разворачивать открытые ИИ-модели, доступные в репозитории Hugging Face. Ранее похожее решение было представлено для моделей Llama 2.

Источник изображения: pixabay.com Для локального развёртывания ИИ-приложений будет использоваться оборудование Dell — серверы PowerEdge и СХД. Со временем на портале появятся дополнительные контейнеры с оптимизированными моделями для инфраструктуры Dell, предназначенные для внедрения ИИ-систем нового поколения. Ранее компания представила расширеннное портфолио комплексных решений и сервисов для «локализации» генеративного ИИ.

19.11.2023 [22:42], Сергей Карасёв

16 ускорителей на один сервер: Liqid и Dell представили платформу UltraStack L40SКомпания Liqid в партнёрстве с Dell Technologies анонсировала эталонную архитектуру UltraStack L40S для формирования систем с высокой плотностью компоновки GPU и иных ускорителей — до 16 шт. на один сервер. Такие платформы могут использоваться для ИИ-приложений, работы с большими языковыми моделями (LLM), задач НРС и пр. Новинка доступна в конфигурациях UltraStack x8 и UltraStack x16. В качестве хост-сервера в составе решения выступает Dell PowerEdge R760xa на базе Intel Xeon Sapphire Rapids: применены два процессора Xeon Gold 6430 (32 ядра; 64 потока; 1,9 ГГц). Объём оперативной памяти в первом случае составляет 1 Тбайт, во втором — 2 Тбайт. К серверу подключаются модули Liqid PCIe Chassis. Версия UltraStack x8 использует два таких модуля: задействованы восемь ускорителей NVIDIA L40S с 48 Гбайт памяти GDDR6 и SSD-хранилище вместимостью 30 Тбайт (NVMe). Вариант UltraStack x16 комплектуется тремя модулями Liqid PCIe Chassis: объединены 16 карт NVIDIA L40S, а ёмкость хранилища составляет 60 Тбайт.

Источник изображения: Liqid Платформа UltraStack L40S предполагает применение восьми двухпортовых сетевых адаптеров NVIDIA ConnectX-7 (16 × 200 Гбит/с), DPU BlueField-3, двух хост-адаптеров Liqid Gen 4.0 x16 HBA, а также коммутатора PCIe 4.0 на 24/48 портов. Среднее энергопотребление UltraStack x8 заявлено на уровне 4,5 кВт, UltraStack x16 — 7,5 кВт. Система базируется на ПО Liqid Matrix. Компания Liqid утверждает, что по сравнению с четырьмя серверами формата 2U, каждый из которых содержит четыре ускорителя NVIDIA L40S, её система UltraStack с 16 такими картами обеспечивает на 35 % более высокую производительность, сокращение энергопотребления на 35 % и снижение общей стоимости владения на 25 %.

19.11.2023 [03:00], Сергей Карасёв

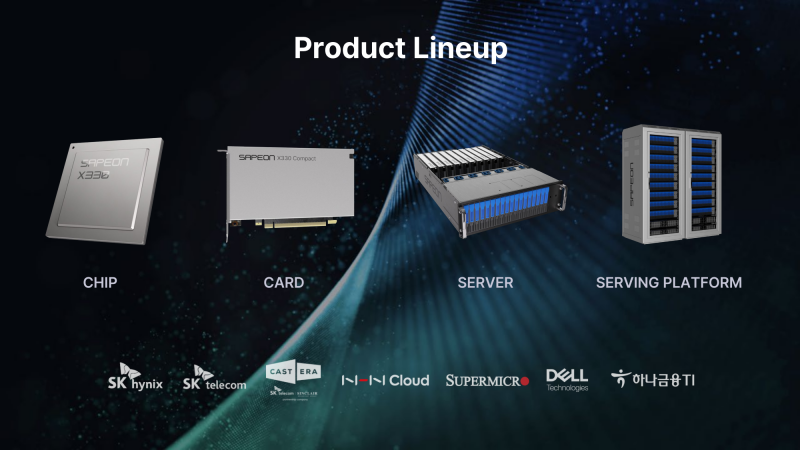

Южнокорейский стартап Sapeon представил 7-нм ИИ-чип X330ИИ-стартап Sapeon, поддерживаемый южнокорейским телекоммуникационным гигантом SK Group, анонсировал чип X330, предназначенный для инференса и обслуживания больших языковых моделей (LLM). Изделие ляжет в основу специализированных ускорителей для дата-центров. Sapeon заявляет, что новый нейропроцессор (NPU) обеспечивает примерно вдвое более высокую производительность и в 1,3 раза лучшую энергоэффективность, чем продукты конкурентов, выпущенные в этом году. По сравнению с предыдущим решением самой компании — Sapeon X220 — достигается увеличение быстродействия в четыре раза и повышение энергоэффективности в два раза. Новинка будет изготавливаться на TSMC по 7-нм технологии. Массовое производство запланировано на I полугодие 2024 года. На базе чипа будут предлагаться два ускорителя — X330 Compact Card и X330 Prime Card. Оба имеют однослотовое исполнение и оснащаются системой пассивного охлаждения. Для подключения применяется интерфейс PCIe 5.0 х16. Карты могут осуществлять вычисления INT8, FP8 и FP16. Модель X330 Compact Card уменьшенной длины несёт на борту 16 Гбайт памяти GDDR6 с пропускной способностью до 256 Гбайт/с. Заявленная производительность на операциях FP8 и FP16 достигает соответственно 367 и 184 Тфлопс. Энергопотребление варьируется в диапазоне от 75 до 120 Вт. Полноразмерная модификация X330 Prime Card получила 32 Гбайт памяти GDDR6 с пропускной способностью до 512 Гбайт/с. Заявленное быстродействие FP8 и FP16 составляет до 734 и 368 Тфлопс. Энергопотребление — 250 Вт. Группа SK в последнее время активно вкладывается в развитие ИИ, инвестируя напрямую или через дочерние структуры как в софт, так и в железо. С ней, в частности, связан ещё один южнокорейский разработчик ИИ-чипов Rebellions, также поддерживаемый правительством страны, которое намерено к 2030 году довести долю отечественных ИИ-чипов в местных дата-центрах до 80 %. Делается это для того, чтобы снизить зависимость от иностранных решений и избежать дефицита. Сама же Sapeon готовит ещё минимум два поколения своих чипов.

19.11.2023 [02:10], Владимир Мироненко

Fujitsu продала свой частный облачный бизнес в Германии инвестиционной компании AEQUITAFujitsu объявила о «стратегической реорганизации» бизнеса в Германии, в рамках которой она заключила сделку по продаже немецкой инвестиционной компании AEQUITA из Мюнхена своего подразделения Fujitsu Services GmbH, предоставляющего услуги частного облака и управляемых сервисов, а также услуги по обеспечению кибербезопасности клиентской базе, включающей средние и крупные предприятия частного и государственного сектора. Ожидается, что сделка будет завершена в начале 2024 года. Её условия не разглашаются. Японская компания сообщила, что «следует своей глобальной стратегии» и что новая организация под эгидой Fujitsu Group предоставит «адаптированный и оптимизированный» портфель услуг. Обновлённые предложения компании будут включать публичные облачные сервисы, портфель решений Uvance для создания устойчивого мира путём цифровых инноваций, приложения и сервисы, связанные с мейнфреймами BS2000, а также бизнес-приложения, которые помогут клиентам ориентироваться в цифровом мире и использовать его потенциал для роста.

Источник изображения: Fujitsu AEQUITA сообщила, что в прошлом году выручка приобретённой Fujitsu Services GmbH составила около €200 млн, и что её штат насчитывает около 1200 сотрудников. Fujitsu Services GmbH предоставляет услуги с опорой на свои ЦОД во Франкфурте, Неккарзульме и Нойенштадте, которые будет использовать и AEQUITA. Во время переходного периода компании будут сотрудничать, чтобы не прерывать бизнес-процессы клиентов. Fujitsu ранее в этом году объявила о закрытии бизнеса ЦОД в США из-за отсутствия мощностей, необходимых для конкуренции на этом рынке. Также компания недавно сообщила о решении поглотить свою облачную «дочку» FJCT. Кроме того, Fujitsu полностью свернёт бизнес в России.

19.11.2023 [01:46], Сергей Карасёв

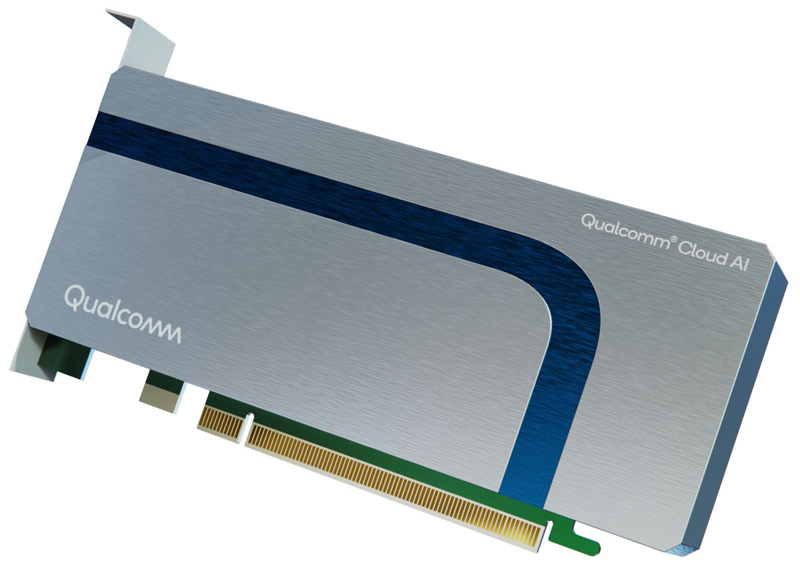

В облаке Cirrascale появились ИИ-ускорители Qualcomm Cloud AI 100Компания Cirrascale Cloud Services сообщила о том, что в её облаке AI Innovation Cloud стали доступны инстансы на основе специализированных ИИ-ускорителей Qualcomm Cloud AI 100. Сервис предназначен для инференса, обработки больших языковых моделей (LLM), генеративных ИИ-систем, приложений машинного зрения и т. п. Решение Qualcomm Cloud AI 100, выполненное в виде однослотовой 75-Вт карты PCIe с пассивынм охлаждением. Ускоритель поддерживает вычисления FP16/32 и INT8/16. Задействованы 16 ядер Qualcomm AI Cores и 16 Гбайт памяти LPDDR4x-2133 с пропускной способностью 136,5 Гбайт/с. Qualcomm Cloud AI 100 обеспечивает быстродействие до 350 TOPS на операциях INT8 и до 175 Тфлопс при вычислениях FP16. Cirrascale Cloud Services предлагает инстансы на базе одной, двух, четырёх и восьми карт Qualcomm Cloud AI 100. Количество vCPU варьируется от 12 до 64, объём оперативной памяти — от 48 до 384 Гбайт. Во всех случаях задействован SSD вместимостью 1 Тбайт (NVMe).

Источник изображения: Qualcomm / Lenovo Разработчики могут использовать комплект Qualcomm Cloud AI SDK, который предлагает различные инструменты в области ИИ — от внедрения предварительно обученных моделей до развёртывания приложений глубокого обучения. Стоимость инстансов варьируется от $329 до $2499 в месяц (при оформлении годовой подписки — от $259 до $2019 в месяц).

19.11.2023 [00:09], Сергей Карасёв

Huawei выпустила All-Flash СХД OceanStor Dorado 2100 с доступностью 99,9999 %Компания Huawei анонсировала СХД OceanStor Dorado 2100 типа All-Flash, рассчитанную на применение в сфере среднего и малого бизнеса (СМБ). Среди ключевых преимуществ новинки разработчик называет простоту использования, высокую надёжность и эффективность. Утверждается, что совокупная стоимость владения (TCO) решения на 30 % ниже, чем у аналогов. Huawei заявляет, что на сегодняшний день OceanStor Dorado 2100 предлагает единственную в отрасли NAS-архитектуру для СМБ с контроллерами, работающими в режиме Active–Active. Система рассчитана на круглосуточную эксплуатацию 24/7 с доступностью 99,9999 %.

Источник изображения: Huawei В одном массиве могут быть объединены до восьми контроллеров, каждый из которых оснащён 64 Гбайт кеш-памяти. Для подключения SSD служит интерфейс SAS-3. Поддерживаются накопители вместимостью от 960 Гбайт до 15,36 Тбайт. Возможно формирование массивов RAID 5/6 и RAID-TP. Максимальное количество SSD в массиве достигает 400. Говорится о совместимости с протоколами NFS, SMB/CIFS, NDMP. Реализованы порты FC8/16/32 и 1/10/25GbE. Габариты устройства составляют 447 × 410 × 86,1 мм, масса — не более 30 кг. К каждому узлу с контроллерами можно подключить до четырёх I/O-модулей. Диапазон рабочих температур — от +5 до +35 °C. Среди поддерживаемых функций упомянуты HyperSnap (мгновенные снимки), HyperReplication (удаленная репликация), HyperClone (клонирование), HyperEncryption (шифрование), HyperMetro (разнесённые массивы в режиме Active–Active), HyperCDP (защита данных), SmartCompression (сжатие) и SmartQoS.

19.11.2023 [00:03], Сергей Карасёв

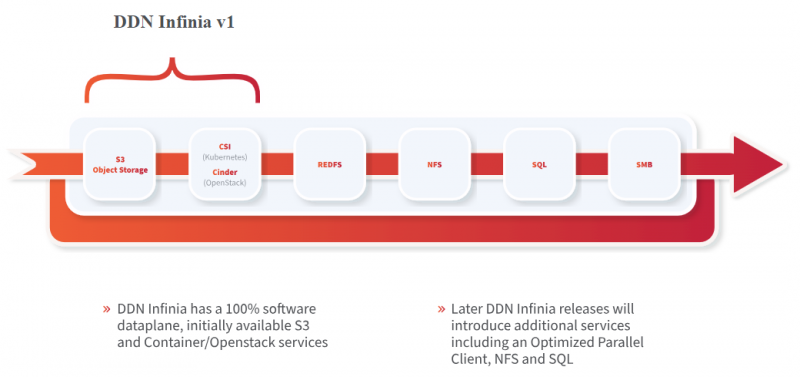

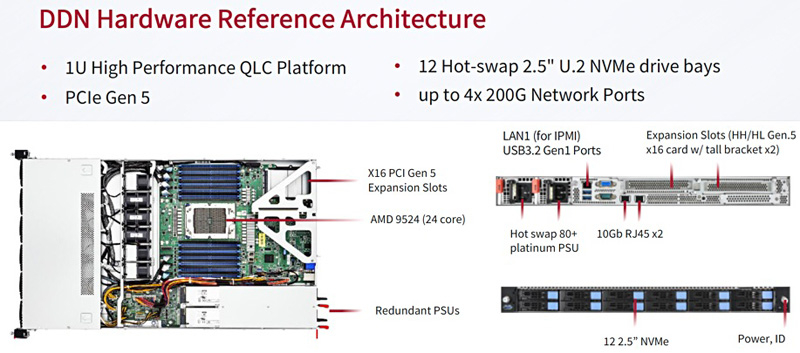

DDN представила масштабируемую All-Flash СХД Infinia для НРС и ИИКомпания DataDirect Networks (DDN), специализирующаяся на платформах хранения данных для НРС-задач, анонсировала масштабируемую СХД Infinia, разработанную в сотрудничестве с Сандийскими национальными лабораториями (SNL) Министерства энергетики США. Infinia — программно-определяемое многопротокольное решение с горизонтальным масштабированием, которое подходит для различных сценариев использования. Это могут быть сложные научные задачи, приложения ИИ, большие языковые модели и пр. Узлами системы могут быть любые серверы с процессорами Intel, Arm или AMD. Говорится, что платформа Infinia может масштабироваться до сотен петабайт. Среди ключевых преимуществ решения разработчик называет простоту управления, высокую производительность и безопасность. Референсная аппаратная платформа представляет собой 1U-узел с 24-ядерным процессором AMD EPYC Genoa. Во фронтальной части предусмотрены отсеки для 12 накопителей SFF формата U.2 (NVMe) с возможностью горячей замены. Предусмотрены два сетевых порта 10GbE и порт 1GbE (все с разъёмами RJ-45), а также слота PCIe 5.0 x16 для HHHL-адаптеров, которые могут предложить до четырёх 200G-портов.

Источник изображения: DDN / StorageNewsletter Шасси имеет габариты 680 × 450 × 44 мм и весит 22,9 кг. СХД оборудована двумя блоками питания мощностью 850 Вт с сертификатом 80 Plus Platinum. В системе воздушного охлаждения применяются шесть вентиляторов. Диапазон рабочих температур — от +10 до +35 °C.

18.11.2023 [23:57], Сергей Карасёв

ИИ-суперкомпьютер «под ключ»: HPE и NVIDIA представили HPC-платформу на базе гибридных суперчипов Grace HopperКомпании HPE и NVIDIA анонсировали модульную суперкомпьютерную систему для генеративного ИИ и обучения моделей на основе частных массивов данных. Комплекс ориентирован на крупные предприятия, исследовательские организации и государственные структуры. В основу решения положена аппаратная платформа Cray EX2500. В состав входят суперчипы NVIDIA GH200 Grace Hopper, содержащие 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. Каждый узел системы использует четыре таких суперчипа. Узлы соединены друг с другом при помощи интерконнекта Slingshot. Говорится, что реализованная архитектура позволяет осуществлять масштабирование до тысяч ускорителей. При этом все мощности могут выделяться для решения одной задачи ИИ, что обеспечивает максимальную эффективность использования ресурсов. По сути, новое решение представляет собой мини-версию ИИ-суперкомпьютера Isambard-AI, который разместится в Бристольском университете (Великобритания). HPE и NVIDIA будут предлагать систему в качестве решения «под ключ» с услугами по установке и настройке.

Источник изображения: HPE Кроме того, предусмотрен стек ПО для решения различных ИИ-задач: это среда HPE Machine Learning Development Environment, набор инструментов HPE Cray Programming Environment, а также пакет NVIDIA AI Enterprise. В целом, как отмечается, новая система предлагает заказчикам производительность и масштабируемость, которые позволяют решать наиболее сложные ИИ-задачи, включая обучение больших языковых моделей (LLM) и создание рекомендательных систем. |

|