Лента новостей

|

31.07.2024 [16:07], Владимир Мироненко

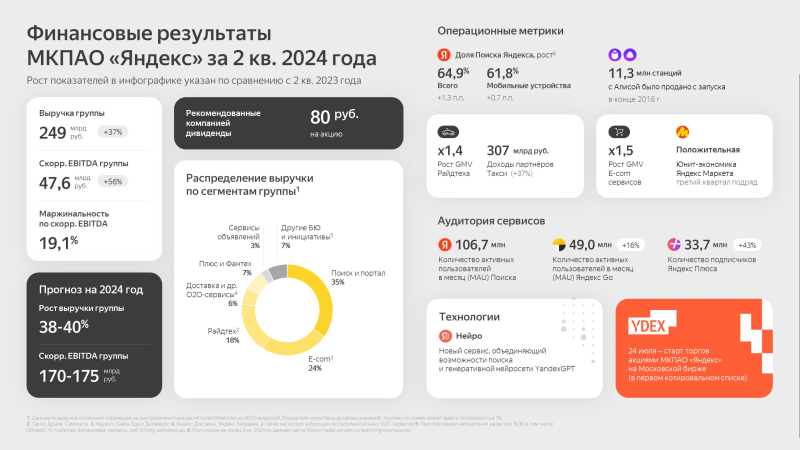

«Яндекс» увеличила за II квартал выручку на 37 %, но сработала с убыткамиМКПАО «Яндекс» объявило неаудированные финансовые результаты за II квартал 2024 года, закончившийся 30 июня. Как сообщается, за отчётный период выручка компании выросла более чем на треть (37 %) до 249,3 млрд руб. с 182,1 млрд руб. годом ранее. При этом скорректированный показатель EBITDA вырос на 56 % до 47,6 млрд руб., составив 19,1 % от выручки. Во II квартале «Яндекс» сработала с убытками, составившими 31,7 млрд руб., тогда как годом ранее у неё была чистая прибыль в размере 22,5 млрд руб. Вместе с тем показатель скорректированной прибыли компании составил 22,7 млрд руб. (рост год к году — 45 %). Численность основного персонала компании выросла на 16 % до 26 701 чел., что связано с увеличением темпов найма в «Поисковом портале», «Облачных сервисах», а также в «Плюсе и развлекательных сервисах». В сегменте «Прочих бизнес-юнитов и инициатив», который включает облачную платформу Yandex Cloud, выручка компании увеличилась на 57 % до 21,9 млрд руб. Вместе с тем убыток по скорректированному показателю EBITDA вырос на 117 % до 14,1 млрд руб., а рентабельность скорректированного показателя EBITDA равна –64,1 % (–17,7 п.п. год к году). В 2024 году «Яндекс» планирует увеличить выручку на 38–40 % год к году. Скорректированный показатель EBITDA за год должен составить в пределах 170–175 млрд руб. Также сообщается, что совет директоров рассмотрит вопрос о выплате первых дивидендов в размере 80 руб. на обыкновенную акцию.

31.07.2024 [15:32], Руслан Авдеев

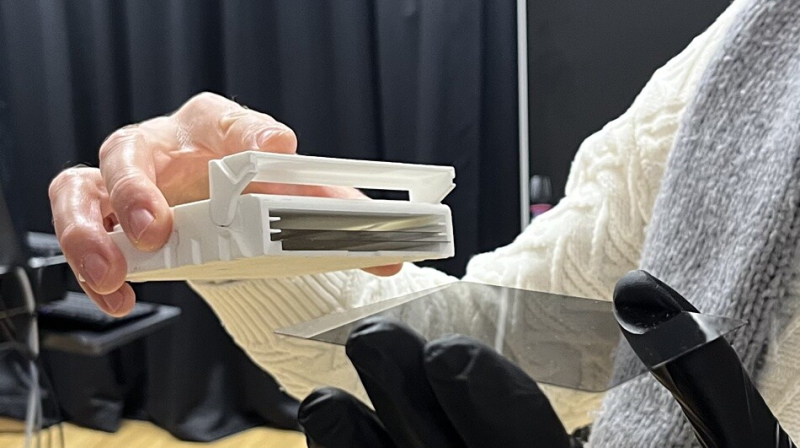

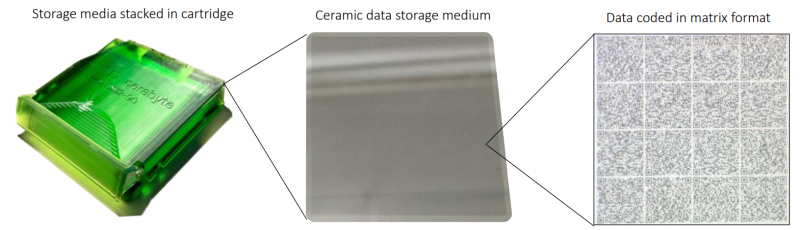

Разработчик «керамических» накопителей Cerabyte получил инвестиции от Pure Storage, занимающейся All-Flash СХДКомпания Pure Storage, разрабатывающая All-Flash СХД, инвестировала неназванную сумму в стартап Cerabyte, занимающийся созданием систем архивного хранения с использованием керамики. Основатель Pure Storage также получит место в совете директоров Cerabyte. В случае успеха новая технология сможет потеснить ленточные накопители, отгрузки которых в последние годы только растут. Сама Pure Storage тем временем намерена окончательно расправиться с HDD. Разработка Cerabyte предусматривает использование покрытого тонким слоем керамики стекла или плёнки. Информация записывается на керамический слой в виде «ямок», быстро наносимых на поверхность лазером. Фактически речь идёт о вариации QR-кодов, считывать которые тоже можно с помощью лазера. Накопители можно хранить в роботизированной библиотеке на манер тех, что используются для ленточных накопителей. Но если последние необходимо менять приблизительно каждые десять лет, данные на керамике хранятся практически вечно, говорят создатели. Кроме того, плотность записи выше, чем у LTO. Объём стратегических инвестиций не раскрывается, но известно, что в совет директоров Cerabyte войдёт основатель и директор по стратегии (Chief Visionary Officer) Pure Storage Джон Колгроув (John Colgrove). По его словам, партнёрство позволит предложить клиентам экобезопасные и надёжные решения для хранения данных, способные произвести революцию в индустрии. В Cerabyte рассчитывают, что партнёрство обеспечит её технологии коммерческое внедрение. В 2023 году компания начала работу в США и уже открыла офисы в Калифорнии и Колорадо. По мнению экспертов Furthur Market Research, мировой запрос на хранилища зеттабайтного уровня плохо удовлетворяется из-за дороговизны и высокого энергопотребления текущих решений. СХД на основе технологий Cerabyte обеспечат экономически и экологически целесообразные альтернативы LTO для корпоративных клиентов. Фактически новое решение в случае успеха может серьёзно подорвать рынок ленточных накопителей и сопутствующих технологий. Демонстрация полностью готовых продуктов (чтение/запись 1+ Гбайт/с, задержка первого обращения не более 15 с, 10–30 Пбайт на стойку) ожидается приблизительно в 2026 году. Пока что у Cerabyte есть только рабочий прототип.

31.07.2024 [12:22], Руслан Авдеев

В отделении ВТБ теперь можно подписаться на облако и ИБ-сервисыВ число продуктов, предлагаемых ВТБ, вошли не только банковские услуги, но и IT-решения. По данным пресс-службы организации, средний и малый бизнес сможет при посредничестве ВТБ получить доступ к средствам защиты информации, разработанным российским «Холдингом Т1» и его же облачным сервисам. Оформить подписки на продукты можно непосредственно в отделениях банка. Распознавание и предотвращения кибератак будет осуществлять экосистема НОТА КУПОЛ. Она включает инструменты против взлома и кражи данных, программное обеспечение и программно-аппаратные комплексы, а также систему управления средствами сетевой защиты. Дополнительно клиенты смогут заказать аудит систем информационной безопасности бизнеса — локальную сеть исследуют на наличие уязвимостей, проведут тесты на возможность проникновения и оценят, насколько её характеристики соответствуют требованиям закона. Предоставляется и облачная платформа, доступная для любой сферы деятельности. Облако позволит создать единое цифровое пространство для сотрудников, поможет защитить данные и оптимизировать затраты на IT-инфраструктуру, говорит компания. Доступен сервис Т1 Облако: Т1 диск, СУБД (PostgreSQL, Mongo DB, Regisrty) и вычислительные мощности. В банке утверждают, что уровень защиты информации в облаке позволяет размещать в нём и обрабатывать персональные и финансовые данные. По словам представителя ВТБ, отмечается рост бизнес-инвестиций в облачное ПО и решения, связанные с защитой информации. Средний чек по итогам первой половины 2024 года вырос год к году на 12 %. При этом в портфолио ВТБ уже имеется более 35 продуктов нефинансового профиля. Например, клиентам доступна круглосуточная юридическая поддержка, помощь с бухгалтерской отчётностью и сервисы по предоставлению ДМС и автоматизация командировок, отмечено в релизе. ВТБ активно занимается импортозамещением IT-систем и сервисов и уже сообщалось, что расходы структуры на эти цели составят 90 млрд руб., в первую очередь речь идёт о тратах на ПО.

31.07.2024 [11:28], Сергей Карасёв

Выручка Canonical в 2023 году превысила четверть миллиарда долларовЧастная британская компания Canonical, занимающаяся развитием Ubuntu, раскрыла финансовые показатели за 2023 год. Как сообщает ресурс Phoronix, соответствующие документы направлены в Регистрационную палату Великобритании. Говорится, что общая выручка Canonical составила приблизительно $251 млн. В 2022-м компания получила около $205 млн. Таким образом, рост равен 22,4 %. Вместе с тем валовая маржа в годовом исчислении снизилась с 82 % до 80 %. Денежный поток Canonical от операционной деятельности в 2023 году составил $47 млн. Это меньше показателя за предыдущий год, когда было зафиксировано значение около $62 млн. Прибыль по итогам года достигла $12,5 млн. Для сравнения: в 2022-м компания заработала $3,9 млн. В финансовых документах также говорится, что в 2023 году расходы на продажи и маркетинг составили 21 % от выручки против 19 % годом ранее. На исследования и разработки потрачено 26 % поступлений — столько же, сколько в 2022 году. Еще 15 % выручки ушло на административные расходы (16 % годом ранее). Штат Canonical по итогам 2023 года расширился до 1034 сотрудников, тогда как в 2022-м в компании работали 858 человек. Отмечается, что повышение ключевых финансовых показателей связано прежде всего с платными клиентами Ubuntu Pro, а также с дополнительными продажами подписок и услуг.

31.07.2024 [11:21], Сергей Карасёв

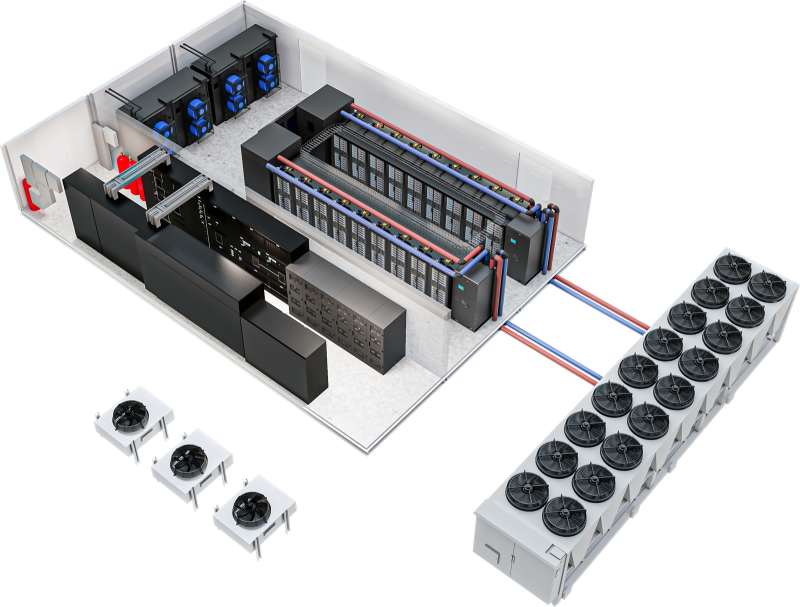

Vertiv представила модульные дата-центры высокой плотности для ИИ-нагрузокКомпания Vertiv представила модульную платформу MegaMod CoolChip, предназначенную для построения дата-центров высокой плотности для задач ИИ. Утверждается, что данное решение позволяет сократить время развёртывания вычислительных мощностей примерно в два раза по сравнению с традиционным строительством. Отмечается, что стремительное развитие генеративного ИИ, машинного обучения и НРС-приложений приводит к необходимости изменения обычной концепции ЦОД. Из-за большого количества мощных ускорителей требуется внедрение более эффективных систем охлаждения. В случае MegaMod CoolChip реализуется гибридный подход с воздушным и жидкостным охлаждением. Инфраструктура MegaMod CoolChip может включать в себя блоки распределения охлаждающей жидкости Vertiv XDU, стойки с поддержкой СЖО Vertiv Liquid-cooled Rack, решения Vertiv Air Cooling, стоечные блоки распределения питания Vertiv rPDU и пр. Модульная архитектура MegaMod CoolChip предусматривает возможность установки до 12 стоек в ряд. Мощность каждой из них может превышать 100 кВт. MegaMod CoolChip поставляется в виде отдельных блоков, которые монтируются непосредственно на месте размещения дата-центра. Возможны различные варианты организации воздушно-жидкостного охлаждения. Для СЖО используется технология однофазного прямого жидкостного охлаждения Direct-To-Chip. Возможно резервирование охлаждающих систем по схеме N+1.

30.07.2024 [21:49], Руслан Авдеев

«Мутят воду»: Microsoft обвинила Amazon и Google в том, что они прикидываются слабыми и беспомощными перед британским регулятором CMAMicrosoft обвнили конкурентов Google и Amazon в том, что те «мутят воду», фактически мешая антимонопольному расследованию в Великобритании, передаёт ComputerWeekly. Соответствующие заявления представлены в публичном обращении Microsoft к британскому регулятору Competition and Markets Authority (CMA). В документах CMA за июнь 2024 года высказано предположение о том, что практика лицензирования продуктов и сервисов Microsoft может ослабить конкуренцию между облачными компаниями в Великобритании — использование лицензионного ПО Microsoft в облаках сторонних бизнесов может быть более дорогим для клиентов и повлиять на конкурентоспособность других облачных провайдеров. Google и AWS неоднократно жаловались британскому регулятору на Microsoft. В материалах Google, посвящённых расследованию, указывается, что практика лицензирования Microsoft ослабляет конкурентов и увеличивает их издержки. Искусственные ограничения делают ПО Microsoft слишком дорогим для использования в сторонних облаках, а конкуренты не могут противопоставить что-либо значительным ценовым различиям. В Google Cloud подчёркивают, что облака помогают цифровой экономике Великобритании, но недобросовестные механизмы лицензирования не дают клиентам свободу выбора и не позволяют внедрять инновации. Аналогичной позиции придерживается и AWS. Компания заявила, что единственным исключением из хорошо действующего рынка IT-услуг Великобритании является именно практика лицензирования Microsoft. В Amazon с оптимизмом смотрят на эволюцию взглядов CMA на предоставление британским пользователям гарантий свободного выбора облака для запуска популярных приложений Microsoft. В самой Microsoft оспаривают заявления и подчёркивают, что ни Google, ни AWS не страдают в той степени, как пытаются изобразить. В Microsoft утверждают, что её условия лицензирования ПО не ведут к существенному повышению затрат при использовании облаков конкурентов. Также заявлено, что бизнесы Amazon и Google, судя по всему, достаточно маржинальны, чтобы получать прибыль даже в условиях конкуренции. В компании напомнили, что капитальные затраты обоих конкурентов составляют $50 млрд и $30 млрд соответственно — это само по себе свидетельствует об их уверенности в прибыльности и конкурентоспособности. Так что речь идёт вовсе не об ослабленных, лишённых надежды конкурентах, какими пытаются представить себя компании, якобы не способные оплатить масштабное использование её интеллектуальной собственности, говорит Microsoft. Более того, за последние пару лет выручка Google и AWS только росла — это плоды конкуренции, а не её отсутствия. В Microsoft прямо заявили, что соперничество не бывает «мягким» или «слабым» — компании «бьют друг друга изо всех сил». По мнению IT-гиганта, Amazon, Google и CISPE попросту «мутят воду» в вопросе определения правильной и неправильной конкуренции. Расследование CMA было начато в октябре 2023 года, крайний срок его завершения — 4 апреля 2025 года. Недавно Microsoft после переговоров добилась примирения с CISPE, согласившись выплатить компенсацию в размере $22 млн в обмен на отказ мелких облачных операторов от претензий к ней. При этом новые правила лицензирования Microsoft в Европе не коснулись AWS, Google Cloud Platform и Alibaba Cloud. Впоследствии выяснилось, Google пыталась предложить CISPE более значимую компенсацию в обмен на продолжение тяжб с Microsoft.

30.07.2024 [21:48], Владимир Мироненко

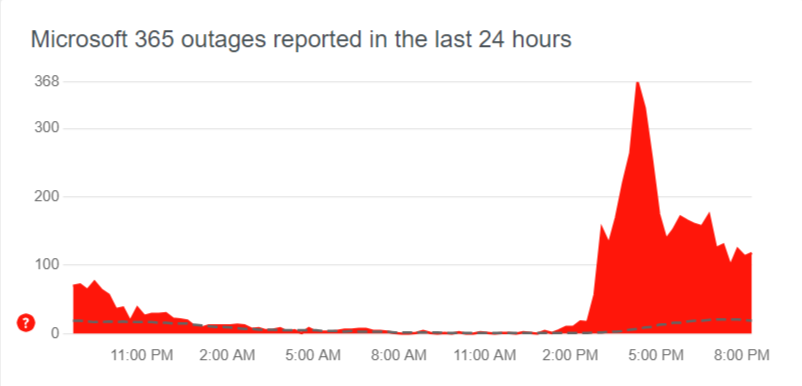

В облаке Microsoft Azure снова произошёл глобальный сбой, затронувший Microsoft 365, Teams, OneDrive, Minecraft и Xbox Live [Обновлено]Microsoft столкнулась с новым глобальным сбоем облака Azure, затронувшим целый ряд служб — от почтового сервиса Outlook до популярной игры Minecraft. Также пользователи по всему миру сообщают о трудностях с подключением к облачной платформе Azure и проблемах в работе с Microsoft 365, Teams, OneDrive и Xbox Live. «В настоящее время мы изучаем проблемы с доступом и снижение производительности нескольких сервисов и функций Microsoft 365», — отреагировали на обращения пользователей в Microsoft. Согласно странице статуса Azure, сбой начался в 11:45 UTC (14:45 мск), когда у целого ряда клиентов возникли проблемы с подключением к службам Microsoft по всему миру, включая Америку, Азиатско-Тихоокеанский регион, Европу и Ближний Восток. Компания сообщила, что внесла изменения в конфигурацию сети, а также задействовала альтернативные маршруты.

Источник изображения: Downdetector Доступность служб повысилась примерно с 14:10 UTC (17:10 мск), но полностью сбои пока не устранены. В частности, сейчас по всему миру всё ещё наблюдаются проблемы с сервисами CDN и Azure Front Door. Напомним, что совсем недавно в облаке Microsoft Azure произошёл масштабный сбой, совпавший во времени с глобальным сбоем из-за неудачного обновления защитного ПО компании CrowdStrike для ПК на Windows, обрушившего работу многих компаний и служб. UPD 31.07.2024: Microsoft объяснила восьмичасовой сбой своего облака масштабной DDoS-атакой. Точнее говоря, проблемой в механизме защиты Azure от таких атак, который вместо того, чтобы отразить DDoS, только ухудшил ситуацию с доступностью сервисов.

30.07.2024 [16:39], Владимир Мироненко

3data ввела в эксплуатацию вторую очередь ЦОД «П29» в Москве, добавив 60 серверных стоекСеть дата-центров 3data сообщила о завершении модернизации ЦОД «П29», находящегося в районе Митино в северо-западной части Москвы, который получил ещё 60 стоек. Также была расширена зона коворкинга для клиентов и увеличена офисная часть объекта, готовая к сдаче в аренду вместе со складскими помещениями. Дата-центр «П29» уровня Tier III приступил к работе в октябре прошлого года. Он стал 16-м действующим ЦОД 3data. Проектная вместимость объекта составляет 180 стойко-мест, мощность — 1,2 МВт. ЦОД имеет статус «шаговой доступности» для заказчиков. Он находится рядом с Пятницким шоссе, вдоль которого располагается множество бизнес-центров и офисов крупных компаний. ЦОД предлагает прямое подключение к международным и городским магистральным линиям связи, доступ ко всем современным облачным сервисам, обеспечивая возможность размещения IT-инфраструктуры для компаний, базирующихся в северо-западных районах Москвы и области.

30.07.2024 [15:17], Руслан Авдеев

Испанская энергокомпания Iberdrola намерена строить ЦОД для гиперскейлеровИспанская энергетическая компания Iberdrola сформировала подразделение, отвественное за строительство и развитие ЦОД. Datacenter Dynamics сообщает, что компания считает дата-центры ключевым драйвером развития энергосетей и возобновляемой энергетики. Будущие дата-центры Iberdrola будут подключены к её же энергосетям. Руководство компании уверено, что спрос на ЦОД будет только расти из-за широкого внедрения систем искусственного интеллекта и облачных вычислений. Iberdola намерена использовать уже имеющиеся связи с компаниями вроде Meta✴, Apple, Microsoft и Amazon (AWS) для того, чтобы получить новые источники спроса. Кроме того, возможно расширение энергосети компании для тех, кто нуждается в новых подключениях. Сегодня у Iberdola уже имеются действующие контракты на поставку 8 ТВт∙ч/год для дата-центров в Испании, США, Великобритании и Германии. По слухам, в этом году компания искала партнёров для создания совместного предприятия для строительства в Испании ЦОД ёмкостью 200 МВт к 2030 году. Долгосрочной целью является создание кампусов ёмкостью 1,2 ГВт, причём Iberdrola рассчитывает в этих проектах на роль миноритарного акционера. В ближайшие годы в Испании ожидаются масштабные инвестиции в дата-центры. Как AWS, так и Microsoft намерены вложить миллиарды долларов в местные облачные мощности и ИИ-инфраструктуру, в первую очередь в Арагоне. Имеет серьёзные планы по развитию бизнеса в стране и Oracle. Iberdrola уже имеет более 40 тыс. клиентов по всему миру и управляет энергосетями ёмкостью более 60 ГВт. Это один из крупнейших поставщиков возобновляемой энергии — крупнейшие операторы ЦОД заключают с ней соглашения о покупке чистой энергии (PPA). Так, в марте Iberdrola подписала PPA с Amazon. Последняя намеренна получать энергию с оффшорной ветряной электростанции East Anglia Three, расположенной у побережья Великобритании в Северном море. Также компании заключили PPA для объектов в Европе, США и Азиатско-Тихоокеанском регионе. Кроме того, Iberdrola заключила PPA и с Meta✴ (в США).

30.07.2024 [14:46], Владимир Мироненко

VK Cloud упростила миграцию «1С» в облакоVK Cloud объявила о запуске решения, которое автоматизирует развёртывание необходимой инфраструктуры для размещения привычных сервисов «1С», что позволит крупным и средним компаниям с сотнями и тысячами активных пользователей ускорить миграцию системы в облако. VK Cloud предоставляет отказоустойчивую гибкую инфраструктуру, которая поддерживает высокую производительность систем «1С», обеспечивая быструю и стабильную работу высоконагруженных приложений «1С» даже при пиковых нагрузках во время сдачи бухгалтерской отчётности или сезона высоких продаж, говорится в пресс-релизе. При этом можно оперативно корректировать объём используемых вычислительных ресурсов, что позволяет снижать издержки на содержание и обслуживание собственного серверного оборудования и ПО, повышая эффективность владения.

Источник изображения: cloud.vk.com При необходимости компании могут подключить на платформе VK Cloud решение для аудита производительности сервисов «1С» и своевременного реагирования на отклонения в их работе — ПО «Алькир» компании Digilabs. Сообщается, что инфраструктура VK Cloud соответствует требованиям 152-ФЗ по высшему уровню защищённости (УЗ-1), стандартам ГОСТ Р 57580, ISO и PCI DSS. Директор по продукту VK Cloud и лидер бизнес-сегмента SaaS VK Tech отметил, что новый сервис VK Cloud упростил миграцию высоконагруженных систем «1С» в облако, а также сделал работу с ними более комфортной: «Специализированный кластер “1С” разворачивается в автоматизированном режиме и обеспечивает стабильную работу приложений. Облачная модель позволяет автоматически и в режиме реального времени масштабировать инфраструктуру, обеспечивая надёжную защиту информации. Кроме того, облако позволяет перевести капитальные затраты на поддержание IT-инфраструктуры в операционные и гибко ими управлять». |

|