Лента новостей

|

30.07.2024 [11:24], Сергей Карасёв

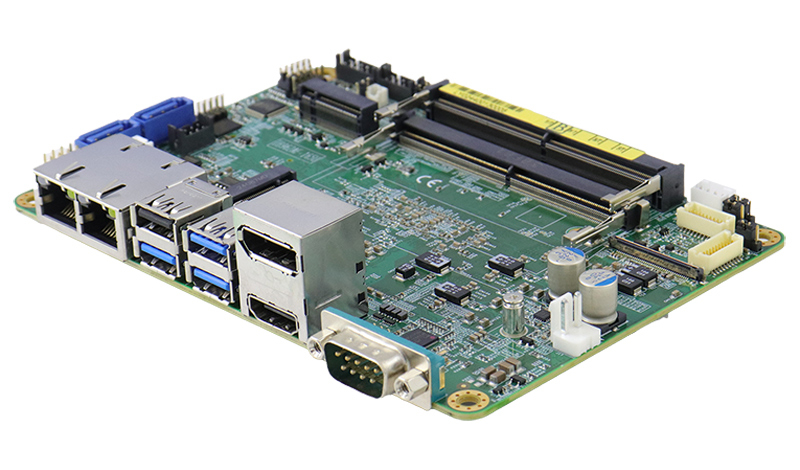

Одноплатный компьютер iBase IB962 на платформе Intel Meteor Lake рассчитан на ИИ-задачиКомпания iBase Technology представила одноплатный компьютер IB962, предназначенный для построения систем автоматизации, оборудования для ретейл-сферы и здравоохранения, а также периферийных устройств с поддержкой ИИ. В основу новинки положена аппаратная платформа Intel Meteor Lake U/H. Изделие имеет размеры 102 × 147 мм. В зависимости от модификации устанавливается процессор Core Ultra 7-165H (6P+8E+2LPE; 22 потока; до 5,0 ГГц) или Core Ultra 7-165U (2P+8E+2LPE; 14 потоков; до 4,9 ГГц). В первом случае присутствует графический контроллер Intel Arc, во втором — Intel Graphics Xe. Чипы наделены нейромодулем Intel AI Boost NPU для ускорения выполнения операций, связанных с ИИ.

Источник изображения: iBase Новинка снабжена двумя слотами SO-DIMM для модулей DDR5-5600 суммарным объёмом до 64 Гбайт. Есть коннекторы M.2 M-Key 2280 для SSD (NVMe; PCIe x4), M.2 E-Key 2230 для адаптера Wi-Fi и M.2 В–Key 3052 для сотового модема 5G/4G. Предусмотрены два порта SATA-3 для накопителей, сетевые контроллеры Intel I226LM 2.5GbE и Intel I226V 2.5GbE, а также I/O-чип Fintek F81804U-I. Одноплатный компьютер располагает двумя последовательными портами RS232/422/485, двумя гнёздами RJ-45 для сетевых кабелей, тремя портами USB 3.2 Type-A, портом USB 2.0, интерфейсами HDMI, DP++, LVDS и eDP. Возможен одновременный вывод изображения на несколько дисплеев высокого разрешения. За безопасность отвечает чип TPM. Имеется звуковой кодек ALC888S. Диапазон рабочих температур простирается от 0 до +60 °C. Напряжение питания может варьироваться от 12 до 24 В.

29.07.2024 [23:05], Владимир Мироненко

Более половины российских компаний с КИИ не успеют перейти на отечественные решения в сфере кибербезопасности к 1 января 2025 годаБольше половины (59 %) средних и крупных компаний с критической информационной инфраструктурой (КИИ) России не успеют полностью перейти на отечественные решения в области информационной безопасности к началу 2025 года, как предписано в указе президента № 250 от 30 марта 2022 года. Об этом сообщили «Ведомости» со ссылкой на исследование компании «К2 кибербезопасность», которая провела анонимный опрос более 80 IT- и ИБ-директоров таких компаний. Согласно указу, до 1 января 2025 года на объектах КИИ должен быть завершён процесс импортозамещения всего ПО и программно-аппаратных комплексов (ПАК). Как пояснили в компании «К2 кибербезопасность», указ касается организаций из 14 сфер деятельности: ТЭК, финсектор, здравоохранение, наука, транспорт, связь и др. 19 % участвовавших в опросе компаний уже заменили зарубежные решения на отечественные аналоги, ещё 22 % находятся в процессе перехода, но, скорее всего, успеют до конца года.

Источник изображения: Tumisu/Pixabay Большая часть респондентов назвали главной сложностью выполнения указа недостаток отечественных аналогов зарубежных ИБ-решений. Ещё 28 % участников опроса сообщили, что имеющиеся аналоги недостаточно качественны, в 14 % опрошенных компаний заявили, что нет необходимых средств и других ресурсов для перехода на российские средства киберзащиты. Еще 8 % респондентов считают главной сложностью нереалистичные сроки, а 6 % — отсутствие готовности инфраструктуры. В свою очередь, в Минцифры сообщили, что настоящее время в рамках исполнения указов президента уже более 84 % зарубежных решений на объектах КИИ заменяются отечественными аналогами, хотя не уточнили, какие классы ПО учтены в приведённом показателе и какой процент импортозамещения реализован именно в сфере информационной безопасности.

29.07.2024 [22:22], Владимир Мироненко

«Группа Астра» увеличила в первом полугодии 2024 года отгрузки на 64 %Российский производитель инфраструктурного программного обеспечения ПАО «Группа Астра» сообщил о росте отгрузок за шесть месяцев 2024 года на 64 % до 5,53 млрд рублей. Это стало возможным благодаря активной экспансии бизнеса, расширению клиентской базы, а также развитию продуктов экосистемы и сервисов. Деятельность компании отличается ярко выраженным сезонным характером, поскольку более 50 % отгрузок традиционно приходится на последний квартал года, в частности на декабрь, хотя расходы распределяются более равномерно на протяжении года. В рамках реализации стратегии роста компания инвестирует в разработки, расширяя клиентскую базу. В апреле–июне «Группа Астра» заключила более 30 соглашений о сотрудничестве с крупными компаниями, включая «Новатэк», «Русгидро», АЛРОСА и «Аэрофлот», а также с правительством Ханты-Мансийского автономного округа.

Источник изображения: «Группа Астра» За отчётный период компания представила инструмент для системных администраторов Astra Configuration Manager. Также «Группа Астра» при участии ICL Техно и совместного предприятия ICL Astra Services анонсировала программно-аппаратный комплекс (ПАК) для построения частного облака, а с ГК «Аквариус» — ПАК для резервного копирования данных. Также сообщается о заключении двух сделок M&A, в рамках которых «Группа Астра» присоединила облачного провайдера Rusonyx и разработчика платформы для управления данными Tantor DLH (ранее — «Сатори»).

29.07.2024 [18:08], Руслан Авдеев

Оператор ЦОД Aruba реактивировал выведенную из эксплуатации микро-ГЭС в итальянском МеленьяноОператор ЦОД Aruba IT приобрёл и заново запустил микро-ГЭС мощностью 800 кВт неподалёку от Милана — в Меленьяно. Datacenter Dynamics сообщает, что дамба и собственно ГЭС были построены ещё в начале 1900-х годов и были выведены из эксплуатации десятилетия назад прежним владельцем. В Aruba заявили, что аккуратные реставрационные работы в здании позволили восстановить все электрические, механические и гидравлические системы микро-ГЭС. Она находится в том же районе, где компании принадлежит ещё одна электростанция, купленная в 2020 году. В апреле 2023 года компания приобрела две гидроэлектростанции общей ёмкостью 2 МВт. В конце 2020 года она приобрела 4 микро-ГЭС на 6 МВт, на тот момент она уже управляла одним объектом такого рода. Теперь Aruba управляет восемью малыми ГЭС на разных итальянских реках с установленной мощностью около 10 МВт. Кампус Aruba Bergamo, расположенный близ Милана, включает три здания ЦОД. Первое здание площадью 17 600 м2 обеспечивает 8000 м2 колокейшн-площадей в 10 помещениях и имеет ёмкость 12 МВт. Здания B и C на 9 и 8 МВт соответственно обеспечивают 4950 м2 и 5950 м2 колокейшн-площадей. Помимо солнечных и гидроэлектрических источников питания, инфраструктура кампуса использует и геотермальные системы. Всего на территории кампуса есть возможности обпеспечения 60 МВт для пяти зданий площадью 200 000 м2. Aruba также управляет двумя объектами в Ареццо, ещё один строится в Риме, и один расположен в Чехии.

29.07.2024 [16:05], Руслан Авдеев

Для подогрева олимпийских бассейнов в Париже используют тепло ЦОД EquinixОлимпиада-2024 в Париже привлекла внимание не только зрелищными выступлениями спорстменов, но и некоторыми удачными технологическими разработками. Datacenter Knowledge сообщает, что значительную роль в этом сыграло решение, позволяющее нагревать бассейны за счёт «мусорного» тепла ЦОД. Во время любой летней Олимпиады требуются большие энергетические ресурсы для обслуживания бассейнов. На текущей Олимпиаде в Париже главным таким объектом является Paris Olympic Aquatic Centre в Сен-Дени, который уже использует разнообразные экобезопасные решения. Тепло для подогрева воды в бассейнах поступает из открытого в 2023 году парижского ЦОД Equinix PA10. Это уже десятый дата-центр, построенный компанией во французской столице за последние 20 лет. Питание PA10 на 100 % компенсируется возобновляемой энергией, а сам он предлагает 5 тыс. м2 места для колокейшн-клиентов (2250 серверных шкафов). ЦОД изначально задумывался и строился с прицелом на использование тепла его оборудования. В компании объявили, что бесплатно в течение 15 лет будут поставлять тепло зоне городского развития Plaine Saulnier, а также Olympic Aquatic Centre, где проходят многие олимпийские мероприятия в 2024 году. После окончания Олимпиады объект будет доступен для посещения всеми желающими. Помимо передачи тепла и «восстановления» воды, новый дата-центр имеет на крыше теплицу и улей. PA10 будет генерировать 10 тыс. МВт∙ч тепла ежегодно, чего достаточно для обогрева более 1 тыс. домохозяйств. Контур внутренней системы охлаждения ЦОД имеет температуру 28 °C круглый год, но перед отдачей тепла наружу тепловые насосы повышают её до 65 °C. Горячая вода через теплообменник отдаётся местному оператору тепловых сетей. Если тепло никуда не передаётся, оно просто выбрасывается в атмосферу, — подчёркивают в компании. PA10 — один из нескольких проектов теплоотдачи, реализуемых Equinix. Сейчас контракты на поставку тепла заключили три площадки, а первый такой проект был реализован в 2010 году в Хельсинки при сотрудничестве с поставщиком энергии Helen. Ещё один объект расположен в Торонто (Канада), где Equinix поставляет тепло из дата-центра TR5 IBX районной энергетической сети Markham District Energy для обогрева жилых объектов, отелей, больницы и торгового центра. Кроме того, многим местным зданиям поставляется и горячая вода. В компании заявляют, что все её новые ЦОД изначально рассчитаны на экспорт тепла — на пути к «экономике замкнутого цикла». В целом тепло ЦОД пытаются применять по всему миру, в том числе в бассейнах и других водных объектах — от ближайшей Великобритании до, например, США. В прошлом месяце дело дошло даже до аквапарков — компания Aventuur получила разрешение на реализацию в Новой Зеландии проекта, обеспечивающего круглогодичный доступ к подогретым ближайшим ЦОД волнам.

29.07.2024 [10:42], Сергей Карасёв

Провайдер облачной ИИ-платформы SMC намерен получить на развитие почти $1 млрдСингапурский стартап Sustainable Metal Cloud (SMC), по информации Bloomberg, рассчитывает привлечь почти $1 млрд для создания специализированной облачной платформы для задач ИИ. Речь идёт о системе на основе высокопроизводительных ускорителей NVIDIA. Фирма SMC основана в 2018 году. Она занимается созданием крупномасштабной инфраструктуры ЦОД: мощности площадки смогут использовать сторонние заказчики для разработки и запуска приложений ИИ. На сегодняшний день платформа SMC в Сингапуре объединяет приблизительно 1200 ускорителей NVIDIA H100. До конца текущего года их количество планируется довести до 5000. При этом реализована возможность масштабирования до 32 тыс. ускорителей. SMC использует технологию иммерсионного (погружного) охлаждения, которая, как утверждается, позволяет сократить выбросы углекислого газа в атмосферу на 48 % по сравнению с традиционными решениями (при работе с моделями ИИ).

Источник изображения: SMC Как сообщает Bloomberg, SMC поддерживается сингапурской компанией ST Telemedia Global Data Centers (STT GDC). Говорится, что SMC находится на завершающей стадии осуществления инвестиционного раунда на сумму около $400 млн. Кроме того, компания намерена получить долговое финансирование в размере $550 млн. Таким образом, общая сумма средств, которые рассчитывает привлечь SMC, составляет $950 млн. Компания SMC создаёт новые облачные регионы в Сингапуре, Индии, Таиланде и Австралии. Оборудование размещается в независимо аккредитованных дата-центрах, что, как утверждается, позволяет формировать высокодоступную и безопасную инфраструктуру.

29.07.2024 [10:00], Сергей Карасёв

Kalray и Pliops объединятся для разработки передовых решений для генеративного ИИКомпании Kalray и Pliops, по сообщению ресурса Storage Newsletter, подтвердили информацию о слиянии. Объединённая структура, как утверждается, займётся разработкой передовых решений SoC (System-on-Chips) для генеративного ИИ и ускорения обработки данных. О том, что стартапы Kalray и Pliops ведут переговоры о слиянии, стало известно в июне 2024 года. Kalray проектирует DPU-ускорители на основе чипов с фирменной архитектурой MPPA. В свою очередь, Pliops разрабатывает ускорители Extreme Data Processor (XDP) для различных задач, включая реляционные базы данных, разнородные СУБД NoSQL, платформы 5G и IoT, приложения ИИ и пр.

Источник изображения: Kalray Объединив технологии Pliops и архитектуру Kalray MPPA, стороны намерены предоставить заказчикам высокопроизводительные SoC для обработки данных в системах ИИ. Слияние будет осуществлено путём обмена ценными бумагами, при этом акционеры Kalray сохранят контрольный пакет. В рамках сделки стороны рассматривают возможность привлечения дополнительных средств из различных источников для ускорения развития. При этом Kalray уже получила финансирование в размере €15 млн в рамках возобновляемого банковского кредита. «Слияние представляет собой важную стратегическую возможность для обеих компаний. Объединив наши сильные стороны, мы намерены стать мировым лидером в области решений по ускорению обработки информации для платформ хранения данных и систем ИИ», — говорит Эрик Баиссус (Eric Baissus), генеральный директор Kalray. Отмечается, что технологии Pliops играют ключевую роль в повышении производительности массивов хранения данных на основе накопителей NVMe и приложений баз данных. Pliops привлекла около $200 млн с момента основания в 2017 году; компания насчитывает примерно 120 сотрудников в Израиле, США и Китае. В число её инвесторов входят AMD, Intel Capital, NVIDIA, SoftBank Ventures Asia, Western Digital и др. После завершения слияния существующие акционеры Pliops станут акционерами Kalray.

29.07.2024 [08:11], Сергей Карасёв

Инсбрукский университет запустил гибридный квантово-классический суперкомпьютерИнсбрукский университет имени Леопольда и Франца (UIBK) в Австрии объявил о том, что его НРС-комплекс LEO5 интегрирован с квантовый системой IBEX Q1 компании AQT. Таким образом, сформирован гибридный квантово-классический суперкомпьютер, который, как утверждается, открывает совершенно новые возможности для решения сложных научных и промышленных задач и создания вычислительных платформ следующего поколения. Машина LEO5, запущенная в 2023 году, объединяет 63 узла, каждый из которых содержит два процессора Intel Xeon 8358 (Ice Lake-SP) с 32 ядрами. Применён интерконнект Infiniband HDR100. В состав 36 узлов входят ускорители NVIDIA — A30, A40 или A100. Производительность достигает 300 Тфлопс на операциях FP64 и 740 Тфлопс на операциях FP32. В свою очередь, лазерная квантовая система IBEX Q1, разработанная специалистами AQT (дочерняя структура UIBK), не требует для работы экстремального охлаждения. Утверждается, что она может функционировать при комнатной температуре, а энергопотребление составляет менее 2 кВт. Квантовое оборудование размещено в двух кастомизированных стойках. Проект по созданию гибридного суперкомпьютера реализован в рамках инициативы HPQC (High-Performance integrated Quantum Computing), финансируемой австрийским Агентством по продвижению и стимулированию прикладных исследований, технологий и инноваций (FFG). Новая платформа, как отмечается, создаёт основу для будущих гетерогенных инфраструктур, ориентированных на решение сложных задач. «Успешная интеграция квантового компьютера в высокопроизводительную вычислительную среду знаменует собой важную веху для австрийских и европейских исследований и развития технологий в целом», — говорит Генриетта Эгерт (Henrietta Egerth), управляющий директор FFG.

28.07.2024 [12:40], Сергей Карасёв

Oracle разрабатывает ИИ для выявления сбоев в дата-центрахКорпорация Oracle, по сообщению ресурса Datacenter Dynamics, разрабатывает систему на основе машинного обучения для точного прогнозирования возможных источников сбоев в ЦОД. Патент на соответствующую технологию (№12,045,123 B2) выдан 23 июля 2024 года Управлением по патентам и товарным знакам США (USPTO). Отмечается, что дата-центры становятся всё более крупными и сложными. В них используется большое количество разнообразного оборудования, а поэтому эффективное определение источника неполадок затрудняется. Новая платформа Oracle позволит выявлять причины проблем практически в реальном времени благодаря применению алгоритмов ИИ. Система получает данные из различных источников, включая серверы и сетевое оборудование, а также системы питания и датчики окружающей среды. Собранные показания анализируются с применением машинного обучения. В случае существования вероятности сбоя генерируется предупреждение с подробным описанием предполагаемой проблемы. Таким образом, операторы ЦОД могут своевременно предпринять необходимые меры и избежать длительных простоев оборудования. В патенте приводится пример отключения энергоснабжения, вызванный выходом из строя источника питания стойки. В такой ситуации ИИ-модель может определить, что уровень мощности источника питания падает ниже порогового уровня и отправить предупреждение. Предлагаемый подход даёт возможность оперативно осуществлять замену вышедших или выходящих из строя компонентов и тем самым повышать эффективность восстановительных работ. Создателями платформы значатся Алекс Гамильтон (Alex Hamilton), директор по разработке ПО Oracle, Амар Монга (Amar Monga), старший менеджер по проектированию софта, и инженер-программист Бин Чен (Bin Chen). В конце прошлого года основатель и технический директор Oracle Ларри Эллисон (Larry Ellison) сообщил, что корпорация намерена развернуть 100 новых ЦОД. Не исключено, что в некоторых из них будет внедрена запатентованная система выявления сбоев для повышения надёжности и стабильности.

28.07.2024 [12:36], Сергей Карасёв

Южнокорейский разработчик ИИ-чипов Rebellions получил $15 млн от нефтяного гиганта AramcoWa’ed Ventures, венчурное подразделение саудовского нефтегазового и химического гиганта Aramco, по сообщению Datacenter Dynamics, инвестировало $15 млн в южнокорейский стартап Rebellions, занимающийся разработкой ИИ-чипов для машинного зрения, чат-ботов и больших языковых моделей (LLM). Компания Rebellions основана в 2020 году. Она создаёт специализированные решения для инференса, которые обеспечивают энергоэффективность и высокую производительность при небольших задержках. В 2023-м Rebellions освоила массовое производство чипов ATOM, способных, как утверждается, конкурировать с NVIDIA A100 в некоторых задачах. Изделия ATOM предназначены для обработки LLM в дата-центрах. В январе нынешнего года Rebellions осуществила раунд финансирования Series B, в ходе которого на развитие было привлечено $124 млн. Инвестиционную программу возглавил оператор KT при участии kt cloud, Shinhan Venture Investment, KDB (Корейский банк развития), Noh& Partners, KB Securities, KB Investment, SV Investment, Mirae Asset Venture Investment, IMM Investment, KT Investment, Seoul Techno Holdings, SDB Investment и ряда других инвесторов. А в июне 2024-го стартап Rebellions объявил о слиянии с разработчиком ИИ-чипов Sapeon Korea, который был выделен из SK Telecom в 2016 году. Rebellions также сотрудничает с Samsung Electronics в рамках проекта по созданию ускорителя для генеративного ИИ. Сообщается, что Wa’ed Ventures присоединилась к раунду финансирования Series B. Соучредитель и генеральный директор Rebellions Сонхён Пак (Sunghyun Park) отметил, что инвестиции будут направлены на создание высокопроизводительных и энергоэффективных ЦОД для задач ИИ в Королевстве Саудовская Аравия. Таким образом, Rebellions стала первым корейским стартапом, получившим стратегическое финансирование от Aramco Wa'ed Ventures. В общей сложности на текущий момент компания привлекла более $215 млн финансирования. |

|