Лента новостей

|

23.10.2024 [10:56], Сергей Карасёв

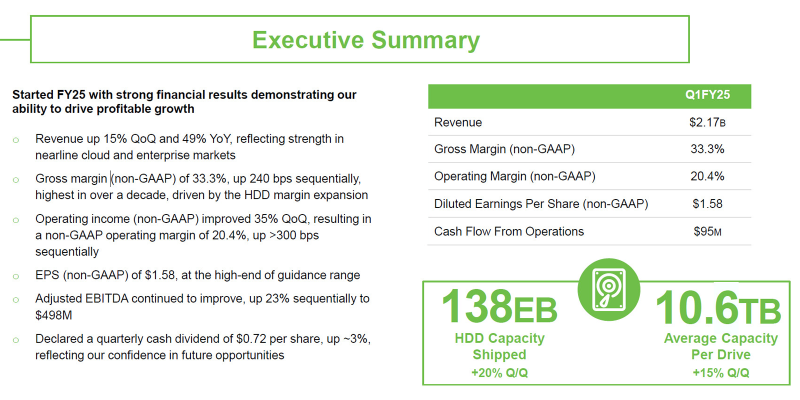

Ёмкость отгруженных за квартал Nearline-накопителей Seagate выросла почти в два разаКомпания Seagate Technology Holdings отчиталась о работе в I четверти 2025 финансового года, которая была закрыта 27 сентября. Выручка одного из крупнейших в мире поставщиков HDD составила $2,17 млрд: это на 49 % больше результата годичной давности, когда было получено $1,45 млрд. По итогам квартала Seagate показала чистую прибыль в размере $305 млн. Для сравнения, в I четверти 2024 финансового года компания понесла чистые убытки около $184 млн. Прибыль в пересчёте на одну ценную бумагу зафиксирована на отметке $1,41. Годом ранее убытки равнялись $0,88 на акцию. В общем объёме денежных поступлений в закрытом квартале на HDD всех типов пришлось приблизительно $2,0 млрд — плюс 55 % год к году. Ещё около $164 млн принесли системы, SSD и прочие продукты: по данному направлению отмечен рост примерно на 3 %. Суммарная вместимость отгруженных за квартал накопителей достигла 137,5 Эбайт. Это на 54 % больше по сравнению с прошлогодним показателем, когда поставки в ёмкостном выражении оценивались в 89,6 Эбайт. В сегменте Nearline-устройств продажи и вовсе выросли практически в два раза — на 95 %: с 56,0 Эбайт до 109,1 Эбайт. Средняя ёмкость HDD за год поднялась на 43 % — с 7,5 до 10,6 Тбайт. Во II квартале 2025 финансового года Seagate рассчитывает продемонстрировать выручку на уровне $2,30 млрд ± $150 млн. Чистая прибыль, как ожидается, окажется на отметке $1,85 ± $0,20 на одну ценную бумагу.

23.10.2024 [10:50], Сергей Карасёв

SSSTC выпустила SSD EJ5 с интерфейсом PCIe 5.0 и вместимостью до 15,36 ТбайтКомпания Solid State Storage Technology Corporation (SSSTC), дочерняя структура Kioxia, представила SSD корпоративного класса EJ5, подходящие для НРС-нагрузок, приложений ИИ и других ресурсоёмких задач. Изделия будут предлагаться в исполнениях U.2 (толщиной 15 мм) и EDSFF E3.S. В основу накопителей положены флеш-чипы 3D eTLC. Для подключения служит интерфейс PCIe 5.0 х4. Заявленная скорость передачи данных в режиме чтения достигает 14 000 Мбайт/с, в режиме записи — 7500 Мбайт/с. Показатель IOPS (операций ввода/вывода в секунду) при произвольных чтении и записи блоками по 4 Кбайт составляет до 2,5 млн и 360 тыс. соответственно. В семейство EJ5 вошли модели вместимостью 3,2, 6,4 и 12,8 Тбайт, которые могут выдерживать до трёх полных перезаписей в сутки (3 DWPD) на протяжении пяти лет. Кроме того, дебютировали варианты ёмкостью 3,84, 7,68 и 15,36 Тбайт с 1 DWPD на протяжении пяти лет. У всех устройств величина MTBF (средняя наработка на отказ) превышает 3 млн часов. Диапазон рабочих температур простирается от 0 до +70 °C.

Источник изображения: SSSTC В накопителях реализована фирменная технология TrueLog 360, которая отвечает за сбор и запись важной информации о состоянии SSD: данные сохраняются каждый час на протяжении всего жизненного цикла. Это обеспечивает возможность непрерывного мониторинга и глубокого анализа, что позволяет корпоративным пользователям отслеживать работоспособность устройств, температурные аномалии, производительность и другие параметры в любое время. Кроме того, упомянута защита от потери питания TruePLP (Power Loss Protection). В оснащение входят высоконадёжные конденсаторы для резервной подачи энергии. В случае сбоя TruePLP предоставляет SSD возможность записать любые данные из памяти DRAM во флеш-память NAND, предотвратив тем самым потерю информации. Говорится также о поддержке TCG Opal.

22.10.2024 [23:19], Владимир Мироненко

Шансы на взыскание долгов с российской «дочки» Oracle близки к нулю — из 1,4 млрд руб. пока нашлось лишь 82,8 млн руб.После того как в марте 2022 года Oracle приостановила деятельность в России, прекратив техподдержку и выполнение действующих контрактов, она была обязана вернуть все неотработанные авансы, чего не было сделано. В итоге задолженность российского подразделения, признанного банкротом, составила более 1,4 млрд руб., на погашение которой конкурсному управляющему удалось взыскать с должников компании к концу сентября всего лишь 82,8 млн руб., пишет РБК. Общая сумма долга «Оракл компьютерное оборудование», российской «дочки» американской Oracle, составляет 1,43 млрд руб. Среди её крупнейших кредиторов — «Форс — Центр разработки» (440 млн руб.), дистрибьютор «Марвел-дистрибуция» (425,2 млн руб.), Альфа-банк (99,4 млн руб.), Сбербанк (77,2 млн руб.), «МегаФон» (44 млн руб.), «Инфосистемы джет» (20 млн руб.) и др. Конкурсный управляющий направил различным организациям и компаниям требования на сумму более 533 млн руб., в том числе на 191,7 млн руб. — Сбербанку, на 149,4 млн руб. — IT-компании «Форс — Центр разработки». По части из них сейчас идут судебные разбирательства, которые могут растянуться на годы. Ещё более 100 млн руб. пытаются взыскать с бывших сотрудников российского юрлица Oracle, подав к ним 51 иск о возврате премий, выплаченных в 2022 году. При этом Oracle не горит желанием возвращать долги. Так, в 2022 году российская «дочка» вывела средства на счета ирландской Oracle EMEA Ltd, а также утилизировала оборудование стоимостью 352,4 млн руб. Эти действия оспариваются в суде, но заседание по данному делу отложено до марта 2025 года. Попутно управляющий пытается привлечь к субсидиарной ответственности бывших директоров компании Наталью Корнилову и Арину Путинцеву, а также акционеров «Оракл Корпорейшн Номиниз Лимитед» и «Оракл Нидерланд Б.В.». По словам одного из кредиторов, пожелавшего остаться анонимным, взыскания в рамках банкротства — всегда очень долгий процесс сбора всех требований, внесения в реестр, ранжирования, продажи имущества и т.д. Процесс возврата может длиться более десяти лет. В свою очередь, партнёр коллегии адвокатов Pen & Paper считает, что у большинства кредиторов российской «дочки» Oracle нет никаких шансов получить какие-либо выплаты, передаёт РБК.

22.10.2024 [18:10], Руслан Авдеев

Индия и NVIDIA обсуждают совместную работу над ИИ-ускорителямиИндийское правительство ведёт переговоры с NVIDIA о возможности совместной разработки ИИ-чипов. Министр Ашвини Ваишнав (Ashwini Vaishnaw), отвечающий за электронику и IT в целом, заявил, что обсуждение находится на начальной стадии, не сообщив никаких деталей, передаёт The Register. В рамках новой стратегии страны приоритетным стало развитие ИИ-инфраструктуры, причём с опорой на собственные решения там, где это возможно. В частности, планируется построить суперкомпьютер с 10 тыс. ускорителей. Также выделены средства на аренду ускорителей для тех, кто не может их купить, а условия поддержки смягчили, дав возможность развиваться небольшим IT-провайдерам. При это страна готова закупать даже урезанные варианты ускорителей NVIDIA, которые из-за санкций не достались Китаю. С соседом у Индии отношения всё ухудшаются и ухудшаются, а некоторые крупные китайские игроки сами уходят из страны, а их место занимают западные и локальные компании. Индия давно стремится к развитию полупроводникового производства и намерена расширить своё влияние в этой сфере. Местные СМИ сообщают, что переговоры властей и NVIDIA якобы касаются разработки чипов, оптимизированных для некоторых сфер. Например, для обеспечения работы систем безопасности разветвлённой сети индийских железных дорог. У NVIDIA уже есть подобные решения на платформе Orin. Но выпуск даже такой платформы на территории Индии пока не представляется возможным, так что речь, вероятнее всего, идёт именно о сотрудничестве в сфере разработки.

22.10.2024 [16:43], Владимир Мироненко

ГК Softline открыла офис в Узбекистане, расширив присутствие в Центральной АзииГК Softline (ПАО «Софтлайн») объявила об открытии офиса в Узбекистане. Это второй офис ГК Softline на территории Центральной Азии, расширяющей своё присутствие в регионе в ходе реализации стратегии международной экспансии. Ранее группа компаний сообщила о формировании представительства в Республике Казахстан. В Узбекистане ГК Softline планирует предоставлять полный комплекс услуг, включая внедрение, сопровождение и обучение. В Центральной Азии группа компаний сосредоточится на продвижении как собственных продуктов, отраслевых решений и экспертизы, так и продукции других вендоров. Локальные заказчики получат помощь в выполнении проектов любого уровня сложности, а вендоры — поддержку со стороны специалистов группы компаний при внедрении и эксплуатации их продуктов, говорит Softline.

Источник изображения: softline.ru В Узбекистане Softline уже начала маркетинговую деятельность, а также приняла участие в мероприятиях «КОД ИБ» и «ИННОПРОМ. Центральная Азия». Был отмечен высокий интерес со стороны заказчиков к продуктам ГК Softline, в частности, к решениям в области кибербезопасности и цифровизации промышленности. ГК Softline отметила, что Узбекистан становится всё более привлекательным рынком сбыта для российской ИТ-продукции, поскольку ИТ-индустрия трансформировалась в один из важнейших элементов развития экономики страны. По словам директора ГК Softline в Центральной Азии, выход на рынки региона является важной составляющей международной стратегии развития группы компаний.

22.10.2024 [14:24], Руслан Авдеев

China Telecom закупит 100 тыс. серверов на базе китайских процессоровТендеры китайского телеком-гиганта China Telecom могут служить своеобразным индикатором настроений на локальном рынке. По данным The Register, в 2024 году большая часть из 156 тыс. серверов, согласно требованиям компании, придётся на местных производителей, использующих «домашние» технологии. China Telecom относится к «большой тройке» принадлежащих государству телеком-провайдеров, доминирующих на китайском рынке услуг связи. По данным на сентябрь 2024 года у оператора насчитывалось 442 млн мобильных абонентов и 196 млн пользователей широкополосного интернета. Кроме того, компания управляет публичным облаком, а также многими другими сервисами. Для обеспечения работы всей инфраструктуры требуется очень много оборудования. В этом году речь идёт о поставках 156 тыс. сереров, всего в 13 вариантах конфигурации. В большинстве случаев речь идёт о машинах «G-класса» — разработанных и выпускаемых в Китае серверах, использующих в том числе чипы местного производства. Это укладывается в общую правительственную политику поддержки местных технологий. Впрочем, компании из других стран тоже заработают, поскольку большинство серверов использует чипы на архитектуре Arm или C86 — лицензированном варианте x86. Так или иначе, для приблизительно 100 тыс. серверов чипы AMD или Intel не подойдут. В числе заявленных закупок — чипы производства китайской Loongson. В перечне одобренных China Telecom CPU значатся и процессоры компании Zhaoxin на архитектуре Yongfeng — они созданы с использованием интеллектуальной собственности VIA (лицензия на x86). Также будут использоваться и RISC-процессоры компании Shenwei (Sunway). Некоторые участники рынка уже отвоевали место в списке закупок China Telecom: речь идёт о Lenovo, Inspur и H3C, а также более мелких местных производителей. Весной 2024 года сообщалось, что китайские телеком-операторы готовы потратить миллиарды долларов на закупку огромного количества ИИ-серверов.

22.10.2024 [13:28], Руслан Авдеев

VMware выплатит инвесторам $102,5 млн, чтобы избежать дальнейших обвинений в манипуляциях с бухгалерской отчётностьюVMware достигла соглашения с инвесторами, подавшими против неё коллективный иск. По информации Channel Insider, истцы обвиняли компанию в заявлениях, вводивших в заблуждение, из-за чего ценность её акций оказалась завышенной. Компания согласилась выплатить $102,5 млн компенсации в рамках мирового соглашения. Иск был подан в марте 2020 года от лица инвесторов, купивших около 55 млн акций VMware за 18 месяцев, с августа 2018-го по февраль 2020-го. После уплаты судебных издержек, группа истцов должна получить $75,6 млн, а иск будет отозван. Впрочем, предложение об урегулировании пока ждёт одобрения федерального суда в Северной Калифорнии. Согласно судебным документам, компания не признаёт своей вины и отклоняет все обвинения. Это уже не первый случай с VMware подобного рода. В сентябре 2022 года VMware удалось добиться соглашения с Комиссии по ценным бумагам и биржам США (SEC). Тогда компанию обвинили в манипуляция с финансовой отчётностью — она умышленно откладывала поставку продуктов для «переноса» выручки на более поздние кварталы, вводя инвесторов в заблуждение относительно показателей бизнеса. В новом деле главный истец, пенсионный фонд Eastern Atlantic States Carpenters, заявил, что VMware нарушила закон Securities Exchange Act от 1934 года и правило SEC Rule 10b-5, сделав ложные и вводящие в заблуждения заявления. По данным фонда, это привело к искусственному росту цены акций компании. Речь снова идёт о переносе выручки на следующие кварталы. По данным фонда, компания манипулировала с отчётностью о продажах за 2019 год и ввела инвесторов в заблуждение относительно того, сможет ли она добиться своих финансовых целей по итогам фискального года. Фактически VMware создала в 2019 году резервный фонд на $500 млн, позволивший продемонстрировать значительный рост выручки в следующем году, несмотря на проблемы в бизнесе. 27 февраля 2020 года VMware сообщила о трёх ключевых проблемах: портфель заказов сократился год к году на 96 %, переход на продукты по подписке проходил с заметными трудностями, не удалось добиться плановых финансовых показателей в IV квартале и 2020 фискальном году. В тот же день SEC начала расследование в отношении компании из-за подозрений в манипуляциях с заказами в декабре 2019 года. Случилось это вскоре после того, как свой пост неожиданно покинул главный бухгалтер VMware. В сентябре 2022 года SEC обвинила компанию во введении инвесторов в заблуждение. В иске указывается, что обнародование данных об этих проблемах привело к значительному падению цены акций VMware. Это привело к финансовым потерям всех, кто приобретал ценные бумаги компании в указанный выше период. После того, как Broadcom поглотила VMware, структура последней была изменена. Broadcom отменила бессрочные лицензии и перевела все продукты на подписную схему, ассортимент ПО подвергся радикальному сокращению, были упразднены скидки и изменён подход к взаимодействию с партнёрами. Всё это породило недовольство со стороны ряда клиентов, некоторые из которых начали изучать возможность перехода на альтернативные решения.

22.10.2024 [12:49], Владимир Мироненко

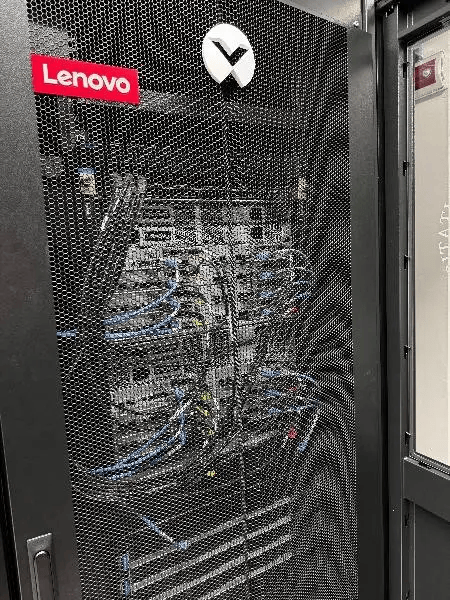

В Пизанском университете установили суперкомпьютер Lenovo на базе Intel Xeon MaxКомпания Lenovo сообщила об установке в дата-центре Пизанского университета (UniPi) нового кластера, благодаря чему HPC-платформа UniPi стала крупнейшей среди университетских суперкомпьютеров в Италии. Система размещена в ЦОД Green Data Center, который включает 104 стойки, где уже размещено 700 узлов (30 тыс. ядер, более ускорителей разных поколений).

Источник изображения: Lenovo Новая HPC-система Lenovo состоит из 16 узлов SD650 V3 с двумя процессорами Intel Xeon Max 9480 (Sapphire Rapids с HBM). Используемая СЖО Lenovo Neptune Direct Water-Cooling позволяет отводить до 98 % тепла, вырабатываемого суперкомпьютером, а также снизить энергопотребление на 40 %. Как утверждает компания, благодаря повышенной эффективности СЖО температура процессоров не достигает критических значений, что позволяет избежать снижения максимальной частоты ядер. Аналогичная платформа используется в суперкомпьютере Cassandra для Европейско-Средиземноморского центра по изменению климата (CMCC) в Лечче (Италия). Как отметил UniPi, решающим фактором при выборе решения Lenovo была адаптивность системы, поскольку проект был изначально разработан с учётом минимального воздействия на окружающую среду с целью создания экологичного ЦОД. Кроме того, стандартизированный подход Lenovo к созданию HPC-узлов упростила и ускорила её установку в ЦОД UniPi. Как ожидается, новый суперкомпьютер будет способен поддерживать рабочие нагрузки HPC и ИИ последнего поколения в течение следующих нескольких лет. UniPi имеет три ЦОД в Пизе. В 2016 году университет запустил проект строительства нового «Зелёного дата-центра» (Green Data Centre) для размещения HPC-нагрузок. По словам UniPi, новый университетский ЦОД является единственным объектом в стране, получившим классификацию «A» от AgID в начале этого года.

22.10.2024 [11:01], Сергей Карасёв

Supermicro представила All-Flash JBOF-массивы на базе NVIDIA BlueField-3 DPUКомпания Supermicro анонсировала высокопроизводительные системы хранения Storage SuperServer типа JBOF All-Flash, оптимизированные для HPC-задач, обучения ИИ-моделей и инференса. Устройства, рассчитанные на монтаж в стойку, выполнены в форм-факторе 2U. Новинки построены на основе DPU NVIDIA BlueField-3. Эти изделия содержат 16 ядер Cortex-A78, поддерживают интерфейс PCIe 5.0 и обеспечивают скорость в 400 Гбит/с. Системы Supermicro JBOF могут использовать до четырёх ускорителей BlueField-3. В число представленных устройств вошли модели SSG-229J-5BU24JBF и SSG-229J-5BE36JBF. Первая рассчитана на 24 накопителя SFF U.2 NVMe, вторая — на 36 накопителей E3.S. Отсеки для SSD расположены во фронтальной части; допускается горячая замена. В обоих случаях имеются два коннектора M.2 для SSD формата 2280/22110 с интерфейсом PCIe 5.0 x4. Предусмотрены три слота для карт PCIe 5.0 x16 FHFL.

Источник изображения: Supermicro Системы оснащены двумя портами 1GbE и дополнительным портом 1GbE на основе контроллера Realtek. Габариты составляют 762 × 449,4 × 88 мм. Питание обеспечивают два блока с сертификатом 80 Plus Titanium мощностью 1600 Вт у SSG-229J-5BU24JBF и 2000 Вт у SSG-229J-5BE36JBF. Установлены шесть вентиляторов охлаждения диаметром 60 мм. Диапазон рабочих температур — от +10 до +35 °C. Supermicro отмечает, что при использовании SSD вместимостью 30,71 Тбайт можно сформировать хранилище суммарной ёмкостью 1,1 Пбайт. Архитектура контроллеров «активный — активный» гарантирует высокую доступность.

22.10.2024 [10:58], Сергей Карасёв

Стартап в области фотоники Oriole Networks привлёк $22 млн, пообещав значительно ускорить обучение ИИ в ЦОДБританский стартап Oriole Networks, специализирующийся на разработке фотонных решений для высоконагруженных дата-центров, сообщил о проведении раунда финансирования, в ходе которого на развитие привлечено $22 млн. В число инвесторов вошли Plural, UCL Technology Fund, XTX Ventures, Clean Growth Fund и Dorilton Ventures. Стартап Oriole Networks, отделившийся от Университетского колледжа Лондона (UCL), основан в 2023 году. В число его учредителей вошли исследователи UCL профессор Джордж Зервас (George Zervas), Алессандро Оттино (Alessandro Ottino) и Джошуа Бенджамин (Joshua Benjamin), а также Джеймс Реган (James Regan), который ранее создал другую компанию в области оптических систем — EFFECT Photonics.

Источник изображения: Oriole Networks Oriole Networks использует фотонику для «формирования сетей ИИ-чипов и объединения их вычислительных ресурсов». Предполагается, что это позволит значительно ускорить процесс обучения больших языковых моделей (LLM), а также существенно снизить энергопотребление ЦОД. В своих решениях стартап использует наработки UCL. Ранее компания получила инвестиции в размере $10 млн. «Наша цель — создать экосистему фотонных сетей, которая поможет трансформировать ИИ-отрасль, устранив существующие узкие места и обеспечив конкуренцию в сегменте GPU», — говорит Реган, занимающий пост генерального директора Oriole Networks. Нужно отметить, что недавно сразу несколько компаний, ведущих разработки в области фотонных технологий, получили финансовую поддержку. Так, разработчик фотонных ускорителей и чиплетного интерконнекта Lightmatter привлёк $400 млн, а стартап Xscape Photonics осуществил раунд финансирования на $44 млн. Кроме того, власти США согласились предоставить $93 млн разработчику оптических решений Infinera на строительство нового завода. |

|