Лента новостей

|

29.10.2024 [11:45], Сергей Карасёв

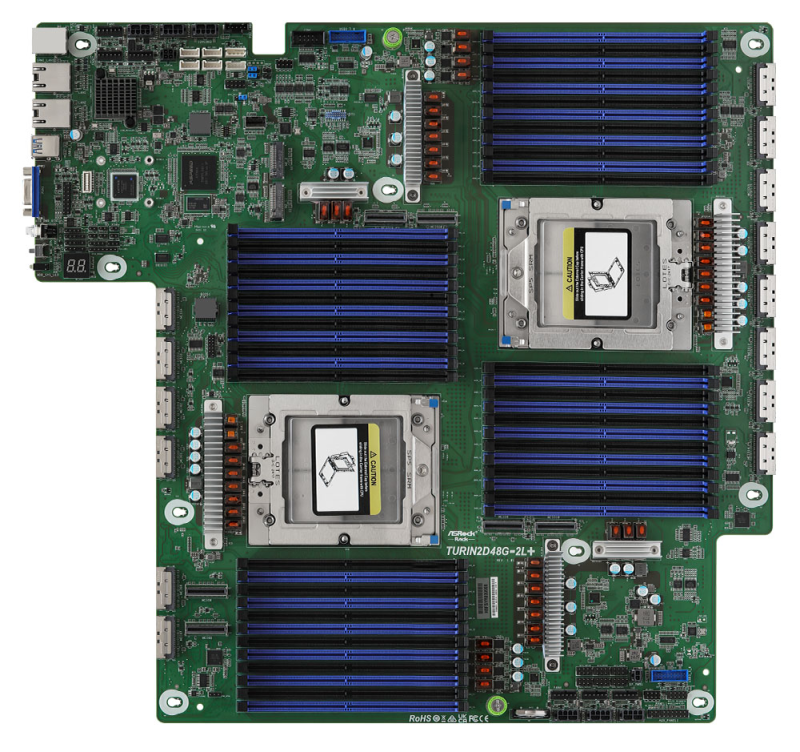

ASRock Rack представила плату TURIN2D48G-2L+, которая поддерживает 24 Тбайт DDR5Компания ASRock Rack анонсировала материнскую плату TURIN2D48G-2L+, предназначенную для построения серверов на платформе AMD. Новинка, выполненная в проприетарном форм-факторе, допускает установку двух процессоров семейства EPYC 9005 (Turin) или EPYC 9004 (Genoa) в исполнении Socket SP5 (LGA 6096) с показателем TDP до 500 Вт. Особенность платы заключается в наличии 48 слотов для модулей DDR5-5200 (24 слота в расчёте на CPU). При использовании изделий RDIMM-3DS ёмкостью 512 Гбайт суммарный объём ОЗУ в системе может достигать 24 Тбайт. Реализованы 12 коннекторов MCIO (PCIe 5.0 / CXL 2.0 x8), четыре разъёма MCIO (PCIe 5.0 / CXL 2.0 x8 или 8 × SATA-3), по два коннектора MCIO (PCIe 5.0 или 8 × SATA-3) и MCIO (PCIe 5.0 x8). Есть также разъём SlimSAS (PCIe 3.0 x2) и два коннектора M.2 для SSD типоразмеров 22110/2280 с интерфейсом PCIe 3.0 x4 или SATA-3. В общей сложности могут быть задействованы до 34 портов SATA-3 для подключения накопителей. В оснащение входят BMC-контроллер ASPEED AST2600, двухпортовый сетевой адаптер Intel i350 стандарта 1GbE и контроллер Realtek RTL8211F, на базе которого выполнен выделенный сетевой порт управления. Интерфейсный блок содержит три гнезда RJ45 для сетевых кабелей, два порта USB 3.2 Gen1 Type-A и аналоговый разъём D-Sub. Через разъёмы на плате можно использовать ещё два порта USB 3.2 Gen1, последовательный порт и пр. Есть шесть гнёзд для подключения вентиляторов охлаждения. Диапазон рабочих температур — от +10 до +35 °C.

28.10.2024 [23:24], Владимир Мироненко

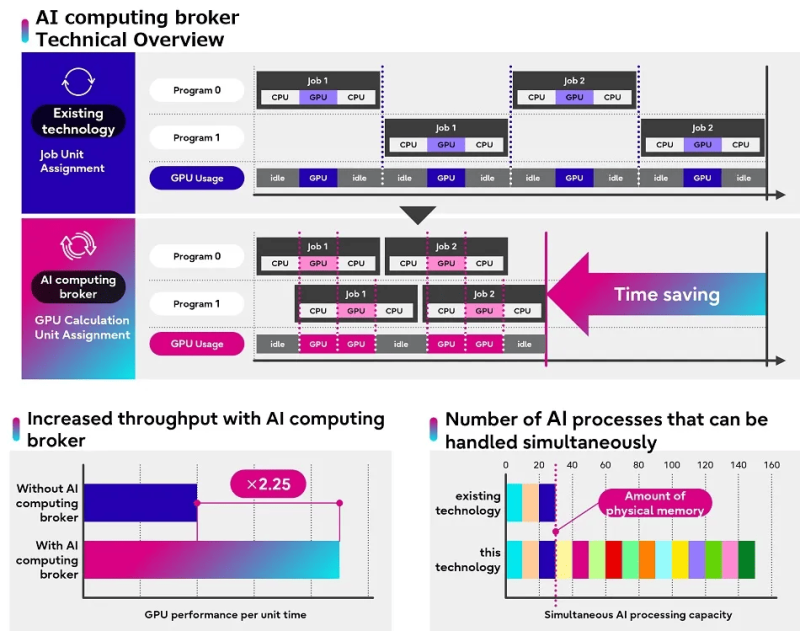

Ускоритель для ускорителя: Fujitsu представила ПО, способное вдвое повысить скорость обработки ИИ-задачFujitsu объявила о доступности ПО (middleware), предназначенного для оптимизации использования ускорителей ИИ. Как указано в пресс-релизе, это решение позволяет повысить эффективность работы ускорителей, что особенно актуально в условиях дефицита вычислительных ресурсов такого типа. ПО различает код, для запуска которого требуется GPU, и тот, что может работать и с использованием одного только CPU, оптимизируя распределение ресурсов и управление памятью на различных платформах и в приложениях ИИ. Кроме того, ПО управляет приоритетностью запуска вычислений, отдавая предпочтение более эффективным процессам. Интересно, что распределение не использует традиционный подход, когда выбор ресурсов основывается на задаче целиком. Компания анонсировала решение (Adaptive GPU Allocator) в ноябре 2023 года. Тогда говорилось о необходимости использования фирменного фреймворка на базе TensorFlow и PyTorch. В нынешнем анонсе про это явно не говорится, но сообщается, что продукт объединяет технологию адаптивного распределения ресурсов каждого отдельного ускорителя с некой оптимизацией на базе ИИ. Более того, новинка позволяет эффективно обрабатывать даже те задачи, которые целиком в памяти ускорителя не помещаются. В ходе тестирования даже удалось наладить обработку 150 Гбайт ИИ-данных на GPU с приблизительно 30 Гбайт свободной RAM. Fujitsu заявила, что решение позволило увеличить в 2,25 раза эффективность ИИ-вычислений в ходе тестирования на реальных задачах компаний AWL, Xtreme-D и Morgenrot. А два крупных заказчика, Tradom и Sakura Internet, уже начали внедрять новый инструмент. «Решая проблемы нехватки ускорителей и энергии, вызванные растущим мировым спросом на ИИ, Fujitsu стремится внести свой вклад в повышение производительности бизнеса и креативности для своих клиентов», — заявила компания. Впрочем, пока решение способно ускорить только работу ускорителей в составе одного сервера, но компания работает над тем, чтобы она могла обслуживать множества GPU, установленных в нескольких серверах. Иными словам она не пока что позволит ускорить целый ИИ-кластер ускориться, но это всё равно удобный способ «выжать больше» из GPU-сервера, отметил ресурс The Register.

28.10.2024 [17:35], Руслан Авдеев

Schneider Electric: ЦОД придётся построить газовые турбины, подключиться к АЭС и лишь потом внедрить SMR, чтобы управиться с дефицитом энергииВ условиях острого дефицита электроэнергии на фоне бурного развития ИИ операторы ЦОД ищут дополнительные источники питания, которые не зависят от магистральных сетей. Вице-президент Schneider Electric Стивен Карлини (Steven Carlini), отвечающий за инновации и технологии для дата-центров, опубликовал статью в блоге компании, где назвал наиболее вероятные источники энергии для таких объектов в кратко-, средне- и долгосрочной перспективах. Сегодня спрос на ёмкость ЦОД часто превышает предложение, особенно в регионах вроде Евросоюза, но девелоперы часто не могут найти достаточно энергии и земли для строительства новых объектов. Тем временем ИИ ЦОД требуют всё больших мощностей — согласно прогнозам экспертов, в США потребление электричества дата-центрами может превысить её поставки в ближайшие несколько лет, в том числе в связи с недостатком ЛЭП. По словам Карлини, в краткосрочной перспективе дополнением к магистральным сетям могут стать газовые турбины, установленные непосредственно на территории ЦОД. Некоторые нефтегазовые компании уже ведут переговоры с операторами ЦОД, при этом к таким проектам пока не предъявляются столь же жёсткие требования, как к стандартным электросетям. В числе прочих опций — солнечная и ветряная энергия, топливные ячейки на том или ином газе. Например, Amazon (AWS) в прошлом году анонсировала планы перевести на топливные элементы некоторые объекты в Орегоне.

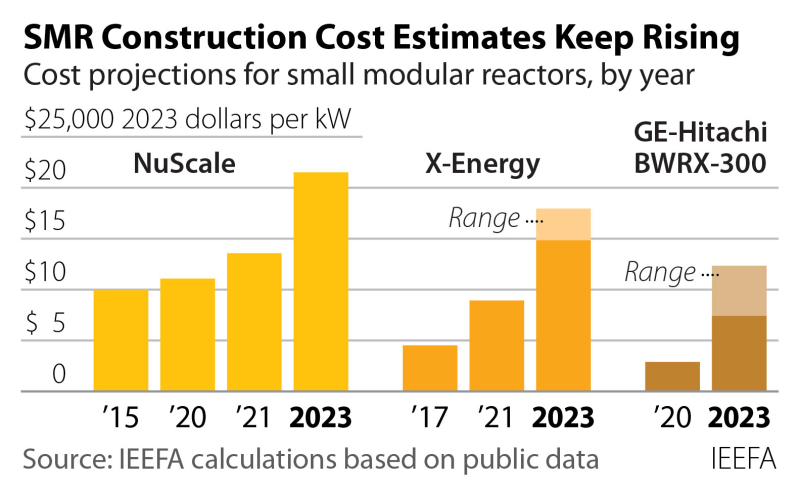

Источник изображения: Oliver B/unsplash.com В среднесрочной перспективе предполагается «оживить» закрытые электростанции. Например, Microsoft заключила соглашение с Constellation Energy о возобновлении работы АЭС Three Mile Island в Пенсильвании, а AWS купила кампус ЦОД рядом с атомной электростанцией в том же штате. АЭС Duane Arnold тоже не прочь вернуть в строй. Google также рассматривает атомную энергетику как один из перспективных источников электричества. В долгосрочной перспективе Карлини предрекает успех малым модульным реакторам (SMR). Он назвал их безопасными, надёжными, эффективными и работающими на «восстановленных» ядерных отходах. Вместе с тем SMR всё ещё должны пройти многоэтапное тестирование и получить одобрение регуляторов, а пока ни одного коммерчески доступного реактора такого типа нет. По поводу целесообразности SMR для ЦОД тоже есть сомнения, отмечает The Register. Согласно докладу Institute for Energy Economics and Financial Analysis (IEEFA), миниатюрные реакторы всё ещё слишком дороги (и продолжают дорожать), слишком медленно создаются и слишком «рискованны», чтобы играть значительную роль в отказе от электростанций на ископаемом топливе. В институте считают, что на SMR деньги буквально выбрасываются, хотя их можно было бы с пользой потратить на возобновляемую энергетику. Сам Карлини считает, что единого решения для всех случаев нет — в будущем дата-центры будут получать энергию из самых разных источников, а энергосети превратятся в комплексные экосистемы с подключением классических электростанций на ископаемом топливе, газовых турбин локального значения, локальных кластеров топливных элементов и локальных же источников солнечной и ветряной энергии. Столь сложные системы должны постоянно контролироваться для бесперебойного энергоснабжения, а системы контроля, по мнению Карлини, конечно же, обеспечит Schneider Electric.

28.10.2024 [16:19], Сергей Карасёв

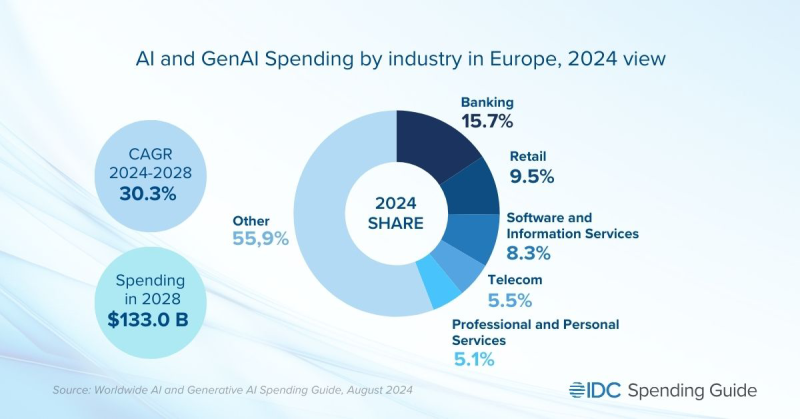

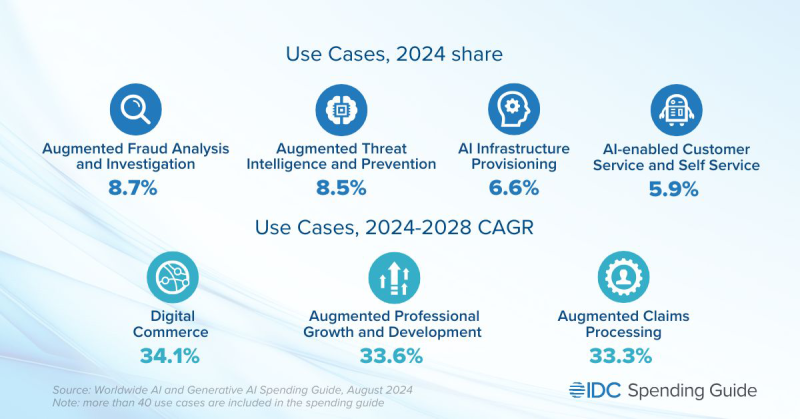

IDC: затраты в области ИИ в Европе к 2028 году превысят $130 млрдКомпания IDC обнародовала свежий прогноз по европейскому рынку ИИ, включая генеративные сервисы. Аналитики говорят, что данная отрасль стремительно расширяется: по итогам 2024 года суммарные затраты ожидаются на уровне $47–$48 млрд. По состоянию на середину 2024-го около 40 % европейских компаний вкладывают значительные средства в генеративный ИИ, планируя в течение следующих 18 месяцев инвестировать в обучение, ПО с улучшенными возможностями и консалтинговые услуги. Кроме того, 30 % компаний в Европе уже развернули приложения и услуги с функциями генеративного ИИ в своих операционных средах. В 2024 году в общем объёме затрат на ИИ в Европе примерно 15,7 % пришлось на банковский сектор. Ещё 9,5 % обеспечил ретейл, 8,3 % — софт и информационные сервисы. На телекоммуникационный сегмент пришлось 5,5 % расходов, на сферу профессиональных и персональных услуг — 5,1 %. Если рассматривать отрасль по типу задач, которые выполняются с применением ИИ, то на расширенный анализ и расследование мошенничества в 2024 году пришлось 8,7 % всех расходов. Инструменты разведки и предотвращения угроз обеспечили 8,5 % выручки. Доля расходов на подготовку инфраструктуры ИИ равна 6,6 %. Платформы обслуживания клиентов и самообслуживания на базе ИИ принесли 5,9 %. Аналитики IDC прогнозируют, что в перспективе показатель CAGR (среднегодовой темп роста в сложных процентах) на европейском рынке ИИ составит 30,3 %: в результате, к 2028-му объём отрасли достигнет $133 млрд. При этом в сегменте генеративного ИИ величина CAGR окажется ещё выше — приблизительно 55 %. «Внедрение генеративного ИИ быстро переходит от раннего тестирования и экспериментов к более интегрированным бизнес-решениям. Ожидается, что среднегодовой темп роста в данном сегменте будет значительно выше, чем у более традиционных технологий ИИ», — говорит Карла Ла Кроче (Carla La Croce), менеджер по исследованиям IDC.

28.10.2024 [15:19], Владимир Мироненко

Мало берёте: Дженсен Хуанг пожурил Европу за слабое развитие ИИ и похвалил Индию за закупки десятков тысяч ускорителейКак пишет Data Center Dynamics, генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил на саммите AI Summit в Мумбаи, что американская компания заключила серию партнёрских соглашений с индийскими фирмами для развёртывания своих чипов и технологий ИИ, расширяя присутсвие на ключевом для себя рынке. С некоторыми из фирм были заключены контракты на поставку десятков тысяч ускорителей H100, в частности, с Tata Communications и Yotta Data Services. Tata Communications модернизирует свою облачную ИИ-инфраструктуру в Индии. Компания начнёт первую фазу крупномасштабного развёртывания NVIDIA Hopper в конце этого года, а на фазе в 2025 году добавит к ним ускорители NVIDIA Blackwell. Как утверждает Tata Communications, её платформа будет одним из крупнейших ИИ-суперкомпьютеров в Индии. Yotta Data Services уже представила шесть новых ИИ-сервисов для своей платформы Shakti Cloud, в том числе на базе NVIDIA NIM. К ним относятся AI Lab, AI Workspace, Serverless AI Inferencing, GPUaaS и др. NVIDIA также сотрудничает с крупнейшим в стране конгломератом Reliance Industries над созданием облачной ИИ-инфраструктуры для обработки данных, обучения сотрудников и создания собственных больших языковых моделей с поддержкой распространённых в стране языков. В рамках партнёрства Reliance развернёт суперускорители GB200. Tech Mahindra намерена использовать чипы и ПО NVIDIA для разработки ИИ-модели на хинди под названием Indus 2.0. Работа над этим проектом будет вестись в Центре передового опыта (Center of Excellence), базирующемся в лабораториях Tech Mahindra в Пуне и Хайдарабаде. На прошлой неделе Дженсен Хуанг также принял участие в церемонии запуска суверенного ИИ-суперкомпьютера Gefion. По данным ресурса The Register, в своём выступлении Хуанг отметил, что ЕС должен ускорить прогресс в области ИИ. «В каждой стране пробуждается понимание того, что данные — это национальный ресурс», — заявил гендиректор NVIDIA. Европейским странам необходимо больше инвестировать в ИИ, если они хотят сократить разрыв с США и Китаем, подчеркнул глава NVIDIA, подразумевая, что лучшим средством для этого будут ускорители его компании.

28.10.2024 [14:43], Андрей Крупин

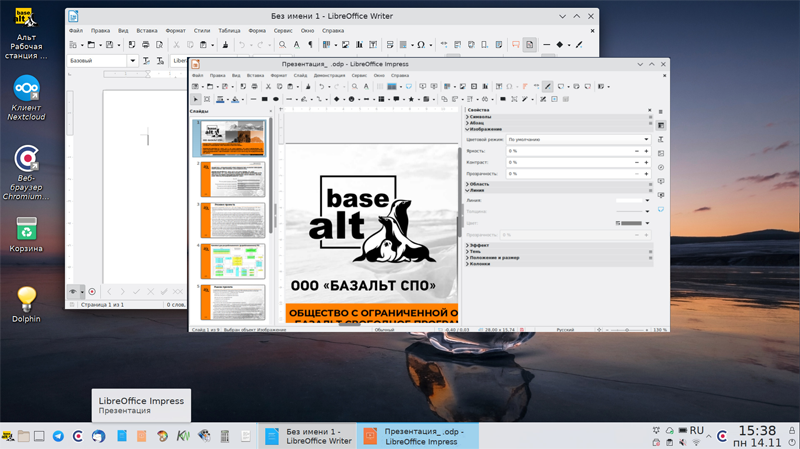

Состоялся релиз новой версии операционной системы «Альт Рабочая станция К» 10.4Компания «Базальт СПО» сообщила о выпуске обновлённой программной платформы «Альт Рабочая станция К» 10.4. Дистрибутив подготовлен для архитектуры x86_64, в качестве графического окружения используется KDE Plasma. Операционная система «Альт Рабочая станция К» представляет собой решение для организации рабочих мест конечных пользователей и подходит для применения как в офисной среде, так и дома. Платформа может быть задействована для решения широкого круга задач: работы с сетевыми ресурсами, видео и звуковыми файлами, сложной графикой и анимацией, создания и редактирования текстов, электронных таблиц, презентаций и т. п. Дистрибутив может использоваться в инфраструктуре Active Directory (аутентификация в домене, доступ к файловым ресурсам и ресурсам печати) и гетерогенной сети под управлением ОС «Альт Сервер».

Источник изображения: basealt.ru Новая версия операционной системы «Альт Рабочая станция К» 10.4 базируется на ядре Linux версии 6.1 (LTS) с актуальными на данный момент исправлениями и патчами. ОС получила функцию ограничения использования USB-устройств через модуль USBGuard, обновлённый набор библиотек KDE Frameworks и расширенные средства отчёта о возникающих в работе ПО сбоях. Также в коде платформы устранены недоработки, препятствовавшие переходу компьютера в режим сна, исправлены ошибки в работе сенсорных панелей и добавлена обработка команд, генерируемых операционной системой при закрытии крышки для некоторых моделей ноутбуков российских производителей. Система «Альт Рабочая станция К» включена в реестр российского ПО как рекомендованная для закупки отечественными организациями и государственными структурами. В соответствии с лицензионным соглашением физические лица могут использовать ОС бесплатно для личных целей.

28.10.2024 [14:18], Руслан Авдеев

Дженсен Хуанг заявил, что Индия должна стать одним из лидеров в области ИИ и создать собственную инфраструктуруНа мероприятии AI Summit в Мумбаи глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что ИИ должен стать драйвером цифровой трансформации Индии, её экономического роста и достижения ведущей роли на мировой арене. Как сообщает пресс-служба компании, Индия имеет для прогресса «поразительные естественные ресурсы» в сфере IT и огромный потенциал, который ещё предстоит раскрыть. По словам Хуанга, страна должна стать разработчиком собственного ИИ, создав национальную ИИ-инфраструктуру с опорой на собственные ресурсы и данные. Ведущие облачные провайдеры страны быстро наращивают ёмкость своих ЦОД, а NVIDIA намерена играть ключевую роль в развитии ИИ и предложить свои ускорители — к концу года их использование должно вырасти десятикратно, став основой экономики, основанной на ИИ-системах. Вместе с NVIDIA эти компании должны совершить крупнейший прорыв в вычислениях, сравнимый с появлением IBM System 360 в 1964 году. А с быстрым развитием ИИ-инфраструктуры «умные» производства тоже станут критически важными для будущего Индии. Хуанг обозначил три ключевых сферы развития ИИ: суверенный ИИ (использование собственных данных для инноваций без передачи их за рубеж), «агентский» ИИ для автоматизации наукоёмких работ и «физический» ИИ для роботизированных и промышленных систем. По словам Хуанга, Индия может стать лидером во всех трёх областях. Местные стартапы уже начали использовать технологии NVIDIA для инновационных решений, которые решения на мировой рынок. После монолога Хуанга состоялся диалог с председателем индийской Reliance Industries Мукешем Амбани (Mukesh Ambani). Главы компаний обсудили перспективы трансформации индийской экономики с помощью ИИ-систем, в том числе энергетики, телекоммуникаций и производства. Амбани подчеркнул, что ИИ используется и в государственном секторе для обработки местных данных, что уже меняет принципы управления и обслуживания. Хуанг пообещал, что ИИ дополнительно демократизирует использование технологий — ИИ может использоваться любым гражданином, что открывает перед всеми невероятные возможности. Конечно, Хуанг подчеркнул роль NVIDIA в этой трансформации. Сейчас компания уже сотрудничает с Infosys, TCS, Tech Mahindra, Wipro и т.д., помогая повышать квалификацию около полумиллиона разработчиков. Амбани, в свою очередь, подчеркнул, что страна уже имеет молодые, технически грамотные кадры. Бизнесмены сошлись во мнении, что с огромным числом талантов, развивающейся технической экосистемой и огромными массивами данных страна имеет большой потенциал для вклада в различные секторы экономики на мировом уровне. Конечно, это может быть сделано только при сотрудничестве компаний — ни одному отдельному игроку такие задачи не под силу. Буквально на днях сообщалось, что Индия на государственном уровне обсуждает с NVIDIA совместную разработку ИИ-чипов, адаптированных к местной специфике. Страна активно осваивает связанные с искусственным интеллектом технологии — потратит $1,2 млрд на суверенный ИИ-суперкомпьютер с 10 тыс. ускорителей и собственные LLM, и готова покупать ускорители в больших объёмах, в том числе ослабленные варианты, не доставшиеся Китаю после ужесточения американских санкций.

28.10.2024 [11:59], Сергей Карасёв

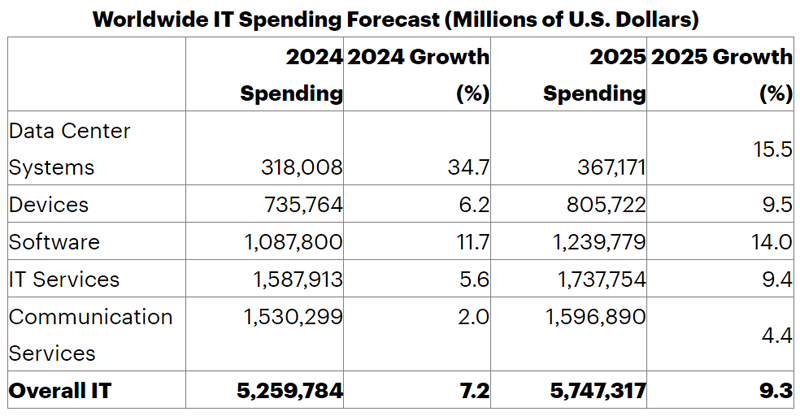

Gartner: мировые затраты на дата-центры в 2024 году выросли на третьКомпания Gartner подвела предварительные итоги исследования глобального IT-рынка в 2024 году, а также сделала прогноз на 2025-й. Отрасль продолжает расширяться, несмотря на макроэкономические сложности и геополитическую обстановку. Подсчитываются расходы на дата-центры, электронные устройства, ПО корпоративного класса, IT-сервисы и телекоммуникационные сервисы. В 2024 году суммарные затраты в обозначенных областях оцениваются в $5,26 трлн. Это на 7,2 % больше по сравнению с предыдущим годом. В сегменте ЦОД затраты по итогам 2024-го составят около $318,01 млрд, что на треть — 34,7 % — больше по сравнению с прошлым годом. В области корпоративного софта ожидается выручка около $1,09 трлн с приростом на 11,7 % в годовом исчислении. Затраты на IT-сервисы и телекоммуникационные сервисы — $1,59 трлн и $1,53 трлн соответственно с прибавкой на 5,6 % и 2,0 %. Электроника принесёт $735,76 млрд, показав рост на 6,2 % по сравнению с 2023-м.

Источник изображения: Gartner Одним из основных драйверов глобального IT-рынка аналитики Gartner называют генеративный ИИ. Внедрение таких сервисов и обучение модулей способствует развитию инфраструктуры дата-центров и сопутствующей экосистемы ПО. В 2025 году суммарные затраты на IT, согласно прогнозам, поднимутся на 9,3 %, достигнув $5,75 трлн. Наиболее высокие темпы роста ожидаются в области ЦОД — плюс 15,5 % с результатом $367,17 млрд в 2025 году. В сегменте ПО рост, по мнению Gartner, составит 14,0 % — до $1,24 трлн. IT-сервисы принесут $1,74 трлн с прибавкой 9,4 %, телекоммуникационные сервисы — $1,60 трлн с ростом 4,4 % по отношению к 2024-му. Электронные устройства обеспечат $805,72 млрд выручки, плюс 9,5 % год к году.

28.10.2024 [11:57], Руслан Авдеев

Nokia сделала ставку на рынок ЦОД, но от телеком-сектора не откажетсяСвязанный с телекоммуникационными системами бизнес более не является приоритетным для Nokia. По данным блога IEEE Communications Society, глава компании Пекка Лундмарк (Pekka Lundmark) объявил в ходе недавнего отчёта за III квартал 2024 года, что теперь его бизнес делает ставку на рынок дата-центров. По его словам, в компании увидели большие возможности для расширения деятельности в этой сфере и инвестируют в расширение продуктового портфеля в соответствующее сетевое оборудование. Хотя Nokia будет уделять внимание и другим сферам, решения для ЦОД останутся в приоритете. В Nokia сообщают, что общий объём целевого рынка (TAM) в сфере телекоммуникаций составляет €84 млрд, тогда как TAM в сфере ЦОД достиг €20 млрд. При этом, по оценкам Лундмарка, значительного роста на рынке телекоммуникаций не ожидается. Развитию компании может помочь покупка Infinera за $2,3 млрд. Ожидается, что объединённый бизнес сможет добиться «двузначного» роста в процентах операционных прибылей в подразделении, занимающемся созданием оптоволоконных сетей (подразделение досталось от Alcatel-Lucent). Сделка, предположительно, будет закрыта в I половине 2025 года, а недавняя продажа Alcatel Submarine Networks (ASN) позволит пересмотреть развитие подразделения Network Infrastructure, которое будет заниматься наземными сетями, IP-сетями и оптическими сетями.

Источник изображения: M. Rennim/unsplash.com Дата-центры требуют всё более быстрых и масштабных оптических сетевых решений для поддержки ИИ-вычислений. Лундмарк считает, что роль оптических решений будет только расти, не только для обеспечения соединений между ЦОД, но и в самих дата-центрах для связи серверов друг с другом, это должно стать важным фактором роста для Nokia. В сентябре компания анонсировала доступность платформы Event-Driven Automation (EDA) для автоматизации работы сети в ЦОД, которое, по словам компании, значительно снижает ошибки, вызванные человеческим фактором, и иные сбои. В том же месяце компания заключила сделку с CoreWeave, выбравшей Nokia для внедрения сетевого оборудования в ЦОД компании по всему миру. Эта сделка важна, поскольку CoreWeave — один из ведущих операторов ИИ-облаков, причём компания пользуется значительной частью продуктов портфолио Nokia. Впрочем, пока нет уверенности в том, что смена приоритетов оправдается для Nokia. Кроме того, ключевые облачные вендоры обычно сами разрабатывают и внедряют собственные ВОЛС-системы в ЦОД и за их пределами. Другими словами, Nokia следует ориентироваться прежде всего на новых игроков рынка ИИ ЦОД.

28.10.2024 [11:48], Сергей Карасёв

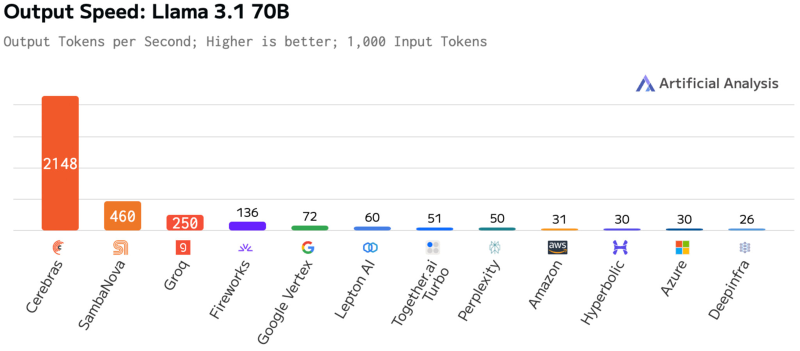

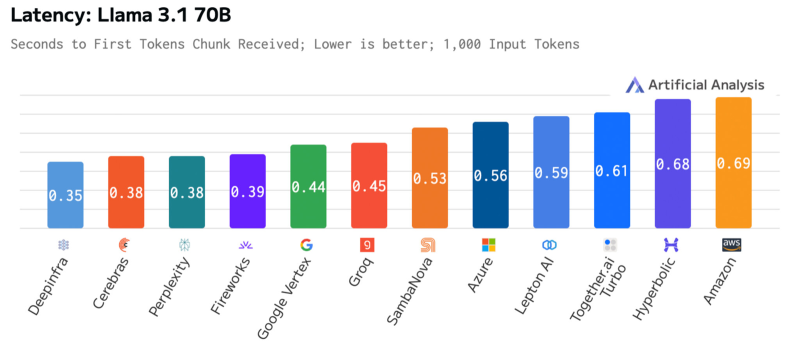

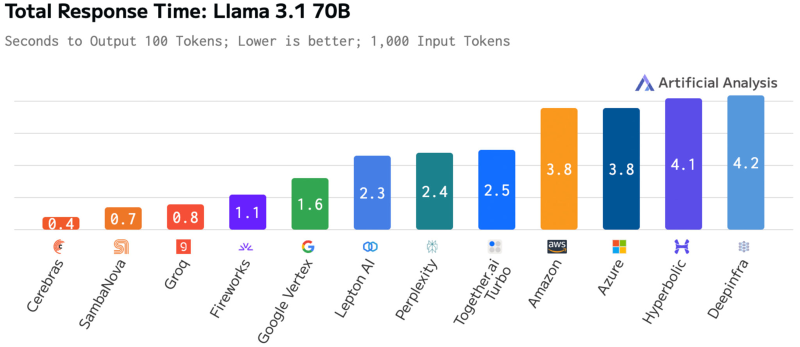

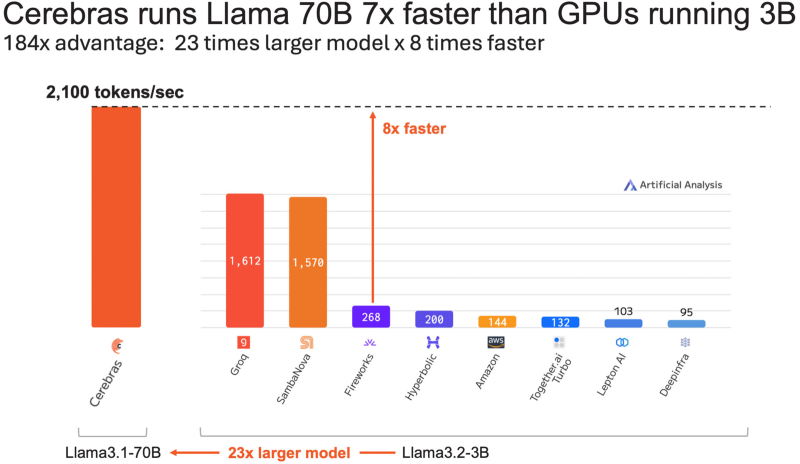

Cerebras втрое повысила производительность своей инференс-платформыАмериканский стартап Cerebras Systems, специализирующийся на разработке ИИ-ускорителей, объявил о самом масштабном обновлении ИИ-платформы Cerebras Inference с момента её запуска. Производительность системы поднялась примерно в три раза. Первый релиз Cerebras Inference состоялся в августе 2024 года. Основой облачной платформы являются ускорители собственной разработки WSE-3. На момент запуска быстродействие составляло до 1800 токенов в секунду на пользователя для ИИ-модели Llama3.1 8B и до 450 токенов в секунду для Llama3.1 70B (FP16). Разработчик заявлял, что Cerebras Inference — это «самая мощная в мире» ИИ-платформа для инференса. Однако в сентябре нынешнего года у Cerebras Inference появился серьёзный конкурент. Компания SambaNova Systems запустила облачный сервис SambaNova Cloud, также назвав его «самой быстрой в мире платформой для ИИ-инференса». Система на основе чипов собственной разработки SN40L демонстрирует быстродействие до 461 токена в секунду при использовании Llama 3.1 70B. В ответ Cerebras Systems усовершенствовала своё решение путём «многочисленных улучшений программного обеспечения, оборудования и алгоритмов». Утверждается, что обновлённая платформа Cerebras Inference при обслуживании Llama3.1 70B обеспечивает быстродействие 2148 токенов в секунду. Для сравнения: у AWS — лидера мирового облачного рынка — этот показатель равен 31 токену в секунду. А у Groq значение находится на уровне 250 токенов в секунду. Данные получены по результатам тестов Artificial Analysis. Время до получения первого токена имеет решающее значение для приложений реального времени. Cerebras находится на втором месте с показателем 0,38 с, уступая только Deep Infra (0,35 с). Вместе с тем Cerebras лидирует по общему времени отклика для 100 токенов на выходе с показателем 0,4 с против 0,7 с у SambaNova, которая находится на втором месте. В целом, как отмечается, платформа Cerebras Inference при работе с Llama3.1 70B опережает сервисы конкурентов на основе GPU, обрабатывающие модель Llama3.1 3B, которая в 23 раза меньше. |

|