Лента новостей

|

18.11.2024 [18:42], Руслан Авдеев

CoreWeave добилась оценки в $23 млрд после вторичной продажи акций, среди инвесторов — Pure StorageОператор ИИ-облака CoreWeave завершил вторичную продажу акций на $650 млн. По данным инсайдеров, теперь компания оценивается в $23 млрд, сообщает Blocks & Files. Ведущими инвесторами стали Jane Street, Magnetar, Fidelity Management и Macquarie Capital, Cisco и, наконец, Pure Storage, на сотрудничество с которой у CoreWeave большие планы. В ходе вторичной продажи акций существующие инвесторы продали свои акции новым. По данным источников, близких к информации о сделке, капитализация CoreWeave за год выросла с $7 млрд до $23 млрд. В мае 2024 года компания оценивалась в $19 млрд после раунда финансирования серии C, лидером которого стала частная инвестиционная компания Coatue. Ожидается, что CoreWeave выйдет на IPO в следующем году. Что касается участия поставщика All-Flash СХД Pure Storage, то компания помимо собственно инвестиций предложит клиентам CoreWeave свои хранилища в рамках стратегического альянса с оператором. Инвестиционный банк William Blair оценивает сделку между Pure Storage и CoreWeave в десятки миллионов долларов. Речь идёт о подписке Evergreen//One, что делает CoreWeave одним из ключевых клиентов Pure Storage. Впрочем, в банке считают, что сделка не является неким крупным соглашением с гиперскейлером, о котором Pure Storage неоднократно сообщала, избегая деталей — CoreWeave пока не входит в десятку крупнейших гиперскейлеров. Как минимум с прошлого года CoreWeave также пользуется хранилищами ещё одного молодого поставщика All-Flash СХД — VAST Data.

18.11.2024 [15:29], Андрей Крупин

Selectel объявил о доступности серверной операционной системы SelectOSРоссийский провайдер сервисов IT-инфраструктуры Selectel сообщил о коммерческом запуске SelectOS — серверной операционной системы корпоративного класса на базе Debian GNU/Linux. SelectOS характеризуется внушительным набором преднастроенного и оптимизированного для работы серверного программного обеспечения. В состав дистрибутива ОС включены веб-серверы Apache, Nginx, балансировщики HAProxy, DPVS, серверы баз данных MariaDB, PostgreSQL, LDAP-системы FreeIPA, Samba, сервисы резервного копирования Bacula, Rsnapshot, средства виртуализации KVM, QEMU, Libvirt, приложения для контейнеризации Docker, Podman, средства аутентификации Kerberos, средства мониторинга Zabbix, Prometheus, а также сервисные пакеты. Платформа интегрирована с облачными сервисами и хранилищем S3 Selectel.

Источник изображения: selectel.ru Операционная система построена с использованием фреймворка DPDK (Data Plane Development Kit), предоставляющего средства для создания высокопроизводительных сетевых приложений, напрямую работающих с сетевым оборудованием и обрабатывающих пакеты минуя сетевой стек ядра. Отдельное внимание уделено безопасности ОС: благодаря собственному репозиторию Selectel обеспечивает оперативное обновление ПО и критически важных компонентов платформы. Регулярный мониторинг и устранение уязвимостей через базы данных CVE обеспечивает высокий уровень безопасности SelectOS. ОС может быть установлена как на новых, так и на существующих серверах, включая те, что находятся вне инфраструктуры Selectel. Обслуживание SelectOS осуществляется по модели SLA — клиенты могут выбрать наиболее подходящий для бизнеса уровень технической поддержки: от базового, доступного только в рабочие часы, до премиального в формате 24/7. В планах компании — дальнейшее развитие операционной системы за счет расширения репозитория приложений, адаптированных под технологию DPDK, внедрение SPDK (Storage Performance Development Kit) для виртуальных дисков и продвинутой системы резервного копирования.

18.11.2024 [13:55], Руслан Авдеев

Flex покупает производителя СЖО JetCoolПроизводитель электроники и инфраструктуры для ЦОД Flex объявил о покупке производителя СЖО для ЦОД JetCool. Приобретение позволит Flex расширить портфолио продуктов для дата-центров, сообщает HPC Wire. Сделка позволит объединить передовые технологии охлаждения JetCool и опыт Flex, связанный с IT-решениями, энергетической инфраструктурой, производством и вертикальной интеграцией для клиентов, нацеленных на масштабное внедрение ИИ-серверов. Как заявляют во Flex, передовые технологии жидкостного охлаждения усиливают возможности компании решать проблемы клиентов с возрастающей энергетической и тепловой плотностью, а также соответствовать требованиям к охлаждению при решении любых задач в области ИИ и HPC. В JetCool уверены, что присоединение к Flex позволит компании добиться новых высот, нарастить производственные возможности и расширить продуктовую номенклатуру. Основанная в 2019 году компания JetCool из Массачусетса предоставляет СЖО на базе т.н. «микроконвективного охлаждения». Компания предлагает широкий спектр продуктов, от водоблоков и систем прямого жидкостного охлаждения чипов до интегрированных систем точечного отвода тепла и комплексных систем охлаждения «под ключ». Не так давно компания представлена CDU для отвода до 300 кВт. Систему можно масштабировать, общая охлаждающая способность увеличивается до более 2 МВт. Около года назад сообщалось, что JetCool в ходе раунда финансирования серии А получила $17 млн на развитие бизнеса. До этого компания в рамках программы COOLERCHIPS получила $1 млн от Агентства передовых исследований в области энергетики (ARPA-E) при Министерстве энергетики США (DOE).

18.11.2024 [13:38], Руслан Авдеев

Foxlink запустила мощнейший на Тайване суперкомпьютер для малого и среднего бизнесаFoxlink Group (Cheng Uei Precision Industry) открыла крупнейший на Тайване суперкомпьютерный центр Ubilink (Ubilink.AI). По данным DigiTimes, центр предназначен для обслуживания предприятий малого и среднего бизнеса (SME), которые не могут позволить себе собственных вычислительных мощностей. Хотя основной деятельностью Foxlink является производство разъёмов, компания расширяет бизнес, осваивая решения для управления электропитанием и коммуникаций, а также выпуск энергетических модулей. Центр Ubilink создан дочерней Shinfox Energy совместно с Asustek Computer и японской Ubitus, занимающейся предоставлением облачных услуг. В Ubitus сообщили, что инфраструктура Ubilink включает 128 серверов Asus, 1024 ускорителя NVIDIA H100 и интерконнект NVIDIA Quantum-2 InfiniBand. Конфигурация обеспечивает до 45,82 Пфлопс (FP64) — система занимает 31-е место в рейтинге TOP500. В будущем станут применять и более современные B100 и B200 — когда те будут доступны. Ожидается, что в 2025 году суммарно будет установлено 10 240 ускорителей H100, B100 и B200. Представители местных властей уже заявили, что Ubilink существенно улучшит позиции Тайваня на рынке ИИ-вычислений, на котором территория сегодня занимает 26-е место. В Asustek добавляют, что достигнутая производительность в 45,82 Пфлопс заметно превышает плановые 40 Пфлопс. Кроме того, центр имеет PUE на уровне 1,2 — ранее ожидалось, что удастся добиться энергоэффективности лишь на уровне 1,38. Благодаря использованию опыта Shinfox Energy в области возобновляемой энергетики, Ubilink стал первым в Азии суперкомпьютерным центром, использующим «зелёные» источники энергии — клиенты могут воспользоваться вычислениями без существенного ущерба окружающей среде.

Источник изображения: UBITUS Предполагается, что Ubilink компенсирует отсутствие мощностей для местных малых и средних компаний, не имеющих доступа к значительным вычислительным ресурсам. Предлагая доступные вычислительные мощности, центр позволяет таким бизнесам расширить свои портфели предложений и конкурировать даже на мировом уровне. Суперкомпьютер уже востребован местными разработчиками чипов, компаний, занимающихся их упаковкой и тестированием, биотехнологическими бизнесами, а также исследовательскими институтами различной направленности. Из-за высокого спроса Foxlink уже рассматривает вторую и третью фазы расширения проекта.

18.11.2024 [10:59], Сергей Карасёв

OpenAI раздумывала, не купить ли разработчика ИИ-ускорителей Cerebras при участии TeslaКомпания OpenAI, по информации ресурса TechCrunch, изучала возможность приобретения американского стартапа Cerebras Systems, специализирующегося на разработке ИИ-ускорителей. Такие сведения вскрылись в рамках судебного процесса по иску Илона Маска (Elon Musk) против OpenAI. Маск является одним из основателей OpenAI — он покинул эту компанию в 2018 году. В начале августа нынешнего года Маск подал в суд на OpenAI и её генерального директора Сэма Альтмана (Sam Altman), обвинив их в нарушении прав и интересов, а также во введении в заблуждение. Как теперь сообщается, в электронном письме, адресованном Альтману и Маску, Илья Суцкевер (Ilya Sutskever), один из соучредителей OpenAI и бывший главный научный сотрудник компании, обсуждал идею покупки Cerebras через Tesla. В другом письме от июля 2017 года Суцкевер затрагивает ряд вопросов, связанных с Cerebras, таких как переговоры об условиях слияния и проверка благонадёжности финансового состояния Cerebras. «Если мы решим купить Cerebras, я твердо уверен, что это будет сделано через Tesla. Но зачем делать это таким образом, если мы могли бы провести сделку изнутри OpenAI? В частности, вызывает беспокойство то, что Tesla имеет обязательство перед акционерами максимизировать их доход, что не соответствует миссии OpenAI», — написал Суцкевер. Cerebras создаёт ИИ-суперускорители размером с целую кремниевую пластину. Флагманским продуктом стартапа является решение Wafer Scale Engine третьего поколения (WSE-3). Это гигантское изделие содержит 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт памяти SRAM. Предполагалось, что слияние с OpenAI будет выгодно обеим сторонам. В частности, Cerebras избежала бы сложного пути, связанного с IPO, тогда как OpenAI смогла бы получить в своё распоряжение мощные аппаратные ускорители для ресурсоёмких ИИ-задач. Однако сделка в итоге провалилась, хотя причины сворачивания переговоров не раскрываются.

18.11.2024 [10:55], Сергей Карасёв

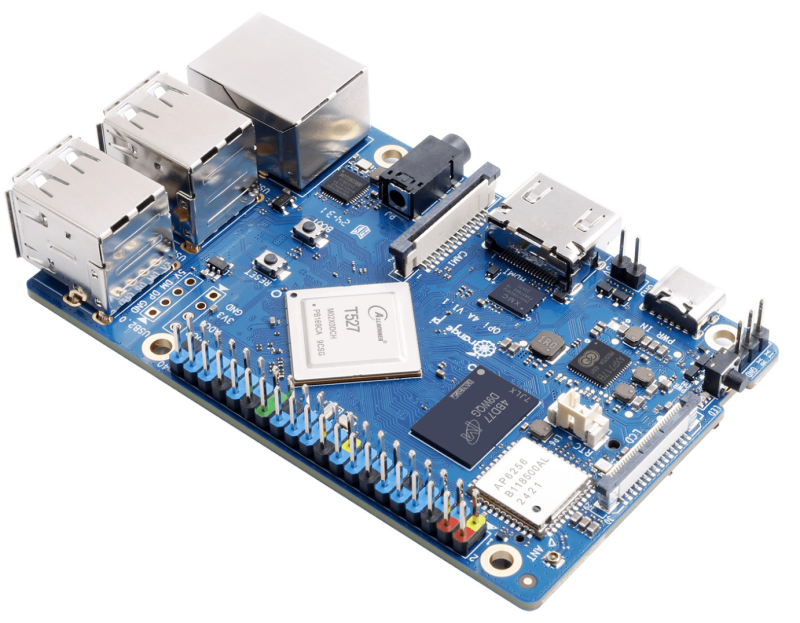

Вышел одноплатный компьютер Orange Pi 4A с RISC-V и Arm-ядрами производительностью 2 TOPSКоманда Orange Pi, по сообщению ресурса CNX Software, выпустила одноплатный компьютер Orange Pi 4A, подходящий для работы с приложениями ИИ. Для новинки, которая уже доступна для заказа, заявлена возможность работы с Ubuntu, Debian и Android 13. В основу устройства положен процессор Allwinner T527. Чип содержит восемь ядер Arm Cortex-A55 (четыре с частотой 1,8 ГГц и четыре с частотой 1,42 ГГц) и одно ядро XuanTie E906 с архитектурой RISC-V (200 МГц). Присутствуют графический ускоритель Arm Mali-G57 MC1 и блок VPU с возможностью декодирования материалов H.265 4Kp60, а также кодирования H.264 4Kp25. Кроме того, имеется нейропроцессорный узел (NPU) с производительностью до 2 TOPS для ускорения ИИ-операций. Одноплатный компьютер может нести на борту 2 или 4 Гбайт памяти LPDDR4/4X, флеш-модуль eMMC вместимостью от 16 до 128 Гбайт, SSD формата M.2 с интерфейсом PCIe 2.0 (NVMe). Есть слот для карты microSD, адаптеры Wi-Fi 5.0 и Bluetooth 5.0 LE (Ampak AP6256), сетевой контроллер 1GbE. В число доступных разъёмов входят интерфейс HDMI 2.0 (4Kp60), четыре порта USB Type-A 2.0, гнездо RJ45 для сетевого кабеля, аудиогнездо на 3,5 мм, коннектор USB Type-C для подачи питания. Упомянуты 40-контактная колодка GPIO, совместимая с Raspberry Pi (GPIO, UART, I2C, SPI, PWM), интерфейсы MIPI-CSI на две и четыре линии, 4-контактная колодка с поддержкой USB 2.0, коннекторы MIPI-DSI (четыре линии), eDP 1.3 и ADC. Габариты составляют 89 × 56 мм, масса — 52 г. Одноплатный компьютер Orange Pi 4A предлагается по цене $35 за модификацию с 2 Гбайт ОЗУ. За вариант с 4 Гбайт памяти придётся заплатить на $5 больше.

17.11.2024 [11:37], Сергей Карасёв

«Систэм Электрик» представила модульные ИБП Excelente VS мощностью до 150 кВтРоссийская компания «Систэм Электрик» (Systême Electric, ранее Schneider Electric в России) объявила о начале продаж локализованных модульных источников бесперебойного питания (ИБП) серии Excelente VS. Устройства, по заявлениям разработчика, предназначены для защиты критически важных нагрузок. Напомним, ранее в семействе Excelente были доступны решения Excelente VM (50–300 кВА), Excelente VL (350–600 кВА) и Excelente VX (100–1200 кВА). Они обеспечивают до 96,6 % КПД в режиме двойного преобразования и до 99 % в режиме ECO. В случае новых ИБП серии Excelente VS мощность со встроенными модульными батареями может варьироваться от 30 до 60 кВА/кВт, с внешними батареями — от 30 до 150 кВА/кВт. В первом случае заказчик получает такие преимущества, как снижение занимаемой площади, удобное обслуживание без необходимости выключения ИБП и сокращение времени обслуживания всей системы питания, говорит компания. Версии с внешними литий-ионными аккумуляторами предлагают длительный срок службы батареи, повышенную ёмкость и более высокую температурную устойчивость. Единичный коэффициент мощности по выходу (PF=1), как заявляет «Систэм Электрик», позволяет рассчитывать необходимый уровень защиты для текущей инфраструктуры без лишних затрат. Диапазон входных напряжений — от 135 до 485 В. Кроме того, говорится о высокой перегрузочной способности. Заявленный КПД достигает 96 % в режиме двойного преобразования (On-Line) и 99 % в режиме ECO. Устройства базируются на модульной архитектуре с возможностью горячей замены. Допускается параллельная работа до шести ИБП одновременно. В оснащение входят информационный дисплей, коммуникационные интерфейсы (SNMP, RS485 и USB), кнопка EPO для аварийного отключения, а также пылевой фильтр с быстрым доступом (находится за фронтальной панелью). Systeme Electric отмечает, что ИБП можно адаптировать для сложных проектов в средних и крупных дата-центрах, а также в сфере критически важной коммерческой и промышленной инфраструктуры. Устройства серии Excelente VS производится на площадке «Систэм Электрик» в особой экономической зоне «Технополис Москва».

17.11.2024 [11:32], Сергей Карасёв

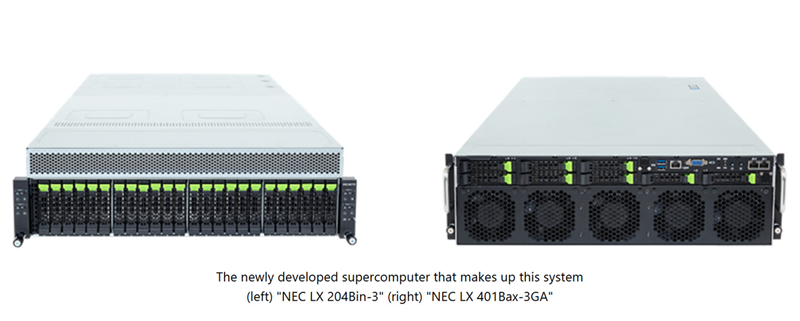

NEC создаст в Японии суперкомпьютер на базе Intel Xeon 6900P и AMD Instinct MI300A для исследований термоядерного синтезаКорпорация NEC займётся созданием нового НРС-комплекса, который планируется ввести в эксплуатацию в Японии в июле 2025 года. Система, базирующаяся на компонентах AMD и Intel, будет использоваться для различных исследований и разработок в области термоядерного синтеза. Заказ на создание суперкомпьютера поступил от Национальных институтов квантовой науки и технологий Японии (QST) при Национальном агентстве исследований и разработок (ANID), а также от Национального института термоядерных наук (NIFS) в составе Национальных институтов естественных наук (NINS). Система будет установлена в Институте термоядерной энергии Rokkasho (входит в QST) в Аомори (Япония). Основой проектируемого суперкомпьютера послужат 360 узлов NEC LX 204Bin-3, в состав каждого из которых войдут два процессора Intel Xeon 6900P поколения Granite Rapids (всего 720 чипов) и память DDR5 MRDIMM. Кроме того, будут задействованы 70 узлов NEC LX 401Bax-3GA, несущих на борту по четыре ускорителя AMD Instinct MI300A (в общей сложности 280 изделий). Говорится о применении интерконнекта InfiniBand с 400G-коммутаторами NVIDIA QM9700, а также хранилища DDN EXAScaler ES400NVX2 вместимостью 42,2 Пбайт с файловой системой Lustre. Для управления рабочими нагрузками будет использоваться софт Altair PBS Professional.

Источник изображения: NEC Ожидается, что производительность суперкомпьютера достигнет 40,4 Пфлопс. Это в 2,7 раза больше суммарных показателей двух нынешних НРС-систем, установленных в рамках независимых проектов QST и NIFS. Учёные намерены применять новый НРС-комплекс для точного прогнозирования экспериментов и создания сценариев работы для Международного экспериментального термоядерного реактора (ITER). Кроме того, мощности суперкомпьютера будут востребованы исследовательскими группами токамака Satellite Tokamak JT-60SA и электростанции DEMO (DEMOnstration Power Plant), использующей термоядерный синтез.

16.11.2024 [21:17], Руслан Авдеев

Bloom Energy поставит ИИ ЦОД топливные элементы на 1 ГВтРазработчик газовых топливных элементов Bloom Energy подписал с одной из крупнейших энергетических компаний США — American Electric Power (AEP) соглашение о поставке твердооксидных ячеек (SOFC) совокупной мощностью до 1 ГВт, которые AEP намерена использовать в качестве ещё одного источника питания ИИ ЦОД. Изначально AEP рассчитывает получить 100 МВт, а в 2025 году заказать ещё одну партию элементов, сообщает Datacenter Dynamics. Топливные элементы Bloom Energy могут работать на водороде или любых смесях природных газов. Впрочем, на данный момент речь идёт только об использовании природного газа, который не считается в отрасли по-настоящему «зелёным» в отличие от некоторых видов водорода. Bloom Energy уже заключила несколько знаковых сделок в секторе ЦОД в 2024 году. В июле облачный провайдер CoreWeave сообщил о намерении внедрять топливные ячейки Bloom в Иллинойсе. Ожидается, что система питания на их основе будет готова к сдаче в III квартале 2025 года. В июле же Bloom Energy заключила соглашение на 15 лет о поставке планируемому дата-центру AWS в Кремниевой долине Amazon (AWS) 20 МВт от топливных элементов. Впрочем, у компании в 2024 году были и некоторые проблемы с реализацией проектов. В июне Amazon отказалась от контракта на покупку ячеек для ЦОД в Орегоне, хотя Bloom Energy в этом не виновата. В 2023 году стороны заключили соглашение, предусматривавшее поставку элементов на 24 МВт. На тот момент их продвигали в качестве локального низкоуглеродного источника питания трёх ЦОД AWS. Однако в данной местности большая часть энергии поступает от ГЭС, поэтому местный регулятор решил, что использование топливных элементов зря приведёт к выбросам, эквивалентным 250 тыс. т CO2 ежегодно.

16.11.2024 [20:59], Сергей Карасёв

Стартап xAI Илона Маска получит от арабов $5 млрд на покупку ещё 100 тыс. ускорителей NVIDIAКак сообщает CNBC, стартап xAI Илона Маска (Elon Musk) привлёк многомиллиардные инвестиции: деньги будут направлены на закупку ускорителей NVIDIA для расширения вычислительных мощностей ИИ-суперкомпьютера. Напомним, в начале сентября нынешнего года компания xAI запустила ИИ-кластер Colossus со 100 тыс. ускорителей NVIDIA H100. В составе платформы применяются серверы Supermicro, узлы хранения типа All-Flash, адаптеры SuperNIC, а также СЖО. Суперкомпьютер располагается в огромном дата-центре в окрестностях Мемфиса (штат Теннесси). Как теперь стало известно, в рамках нового раунда финансирования xAI привлечёт $6 млрд. Из них $5 млрд поступит от суверенных фондов Ближнего Востока, а ещё $1 млрд — от других инвесторов, имена которых не раскрываются. При этом рыночная стоимость стартапа достигнет $50 млрд. О том, что xAI получит дополнительные средства на развитие, также сообщает Financial Times. По данным этой газеты, речь идёт о $5 млрд при капитализации стартапа на уровне $45 млрд.

Источник изображения: NVIDIA Ранее Маск говорил о намерении удвоить производительность Colossus: для этого, в частности, планируется приобрести примерно 100 тыс. ИИ-ускорителей, включая 50 тыс. изделий NVIDIA H200. Судя по всему, привлеченные средства стартап также направит на покупку других решений NVIDIA, в том числе коммутаторов Spectrum-X SN5600 и сетевых карт на базе BlueField-3. Между тем жители Мемфиса выражают недовольство в связи с развитием ИИ-комплекса xAI. Активисты, в частности, обвиняют стартап в том, что используемые на территории его дата-центра генераторы ухудшают качество воздуха в регионе. |

|