Материалы по тегу: сбой

|

23.10.2025 [13:50], Руслан Авдеев

Неудобные вопросы: казначейство Великобритании выясняет, почему сбой AWS по ту сторону океана нарушил работу госведомств Соединённого Королевства

aws

lloyds banking

software

банк

великобритания

госуслуги

информационная безопасность

кии

конфиденциальность

облако

сбой

От правительства Великобритании потребовали ответить, почему многочасовой сбой в работе сервисов AWS (Amazon) на другом берегу Атлантики нарушил функциональность информационных систем британских структур, включая налоговую службу HMRC и Lloyds Banking Group, сообщает Computer Weekly. Многочасовой сбой 20 октября во флагманском регионе AWS US-East-1 в Северной Вирджинии (США) нарушил работу компаний и организаций по всему миру, в том числе и в Соединённом Королевстве. Поэтому в Великобритании и других странах растёт обеспокоенность тем, что частный и государственный сектора зависят от заокеанских служб — вновь появились призывы сохранить услуги национального значения под локальным контролем. Так, Казначейству Великобритании уже предложено отчитаться о том, почему предоставленные в январе этого года полномочия не помогли гарантировать надёжность сервисов в секторе финансовых услуг. В частности, почему платформа AWS (и не только она), которая является облачным провайдером большого числа финансовых учреждений Великобритании, до сих пор не включена в список критически важных третьих сторон (Critical Third Parties, CTP), который позволяет требовать от сторонних компаний соблюдения тех же высоких стандартов, что и от финансовых учреждений. Также чиновников попросили уточнить, не беспокоит ли их тот факт, что ключевые фрагменты британской IT-инфраструктуры размещены за рубежом, с учётом последствий недавнего сбоя. Также предлагается объяснить, какую работу проводят совместно с HMRC, чтобы предотвратить аналогичные сбои в будущем. В Министерстве финансов Великобритании заявили журналистам, что работают с регуляторами над внедрением режима CTP. В AWS же предложили спросить у самой HMRC, почему сбой в США так повлиял на неё. У AWS с 2016 года есть собственный облачный регион в Великобритании, причём платформа позволяет британским структурам получать доступ к локальным версиям публичных облачных сервисов. В AWS придерживаются «модели общей ответственности», при которой клиенты должны сами внимательно выбирать сервисы для размещения в облаке. Утверждается, что такой подход обеспечивает гибкость и контроль со стороны клиента. По мнению некоторых экспертов, сбой свидетельствует о том, что часть инфраструктуры HMRC и Lloyds зависела от американских мощностей, и это мог быть осознанный выбор британских структур, а не вина AWS. С другой стороны, инцидент показал, как сложна и взаимосвязана современная облачная инфраструктура. Заказчики могли не знать какие сервисы размещены в рамках их пакетов услуг в Великобритании и насколько они устойчивы. Например, Microsoft в своё сообщила, что не может гарантировать суверенитет данных полиции Великобритании, хранящихся и обрабатываемых на её платформе. Позже выяснилось, что данные британской полиции могут обрабатываться более чем в 100 странах, причём пользователи об этом не знали. В Forrester сообщают, что AWS осознаёт проблему и намерена запустить в Европе «идеальную копию» своих сервисов в рамках предложения суверенного облака. Первый изолированный регион предусмотрен в Германии. Фактически, единственный надёжный способ избавиться от иностранной зависимости — физическая и логическая изоляция облачных регионов, используемых клиентами. По словам экспертов, чем более «концентрированной» становится инфраструктура, тем более хрупкой и зависимой от внешнего управления она становится. Если Европа настроена на обретение цифрового суверенитета, ей необходимо скорее принять необходимые для этого меры. В частности, следует переосмыслить систему закупок, финансировать суверенные альтернативы и сделать обеспечение надёжности базовым требованием. Ранее эксперты пришли к выводу, что сбой в работе AWS наглядно продемонстрировал опасную зависимость всего мира от нескольких облачных гигантов из США. Европа так и не смогла избавиться от бремени американских гиперскейлеров, которые открыто признают, что даже не могут гарантировать суверенитет данных. При этом к AWS есть вопросы и у других британских регуляторов.

22.10.2025 [12:35], Руслан Авдеев

Сбой в работе AWS показал опасную зависимость мира от нескольких облачных гигантов из СШАМасштабный сбой в работе облака AWS в понедельник коснулся множества сервисов по всему миру во многих секторах экономики и общественной деятельности. Инцидент вызвал разговоры о зависимости пользователей от крупных облачных провайдеров из США, необходимости повышения цифрового суверенитета и диверсификации рисков, сообщает Datacenter Knowledge. В компании объявили, что причина — в «эксплуатационном инциденте» в регионе us-east-1, именно там расположен крупнейший кластер ЦОД провайдера. Облачный регион находится в т.н. «Аллее ЦОД» в Северной Вирджинии и состоит из 158 объектов общей мощностью 2,544 ГВт. По оценкам Amazon, более 90 % компаний из рейтинга Fortune 100 используют именно облачные сервисы AWS. Сбой стал крупнейшим инцидентом в работе интернета с тех пор, как в 2024 году из-за ошибки обновления Crowdstrike из строя по всему миру вышли миллионы систем Microsoft. По словам IDC, последний инцидент демонстрирует, как масштабные вычисления могут привести к масштабным проблемам. Хотя предприятия в целом приняли идею отказа от собственной инфраструктуры ЦОД, происшествие привлекает внимание к необходимости диверсификации рисков. Это может привести к созданию распределённых архитектур, охватывающих несколько облачных регионов в рамках пакетного предложения одного провайдера, и более широкому использованию нескольких облаков разных провайдеров одновременно. Эксперты обеспокоены зависимостью предприятий всего мира от американских гиперскейлеров — последствия инцидента носят трансграничный характер и касаются не только клиентов одного поставщика облачных сервисов. Многие уже задаются вопросом — стоит ли сохранять зависимость государственных учреждений, от налоговых служб государство до крупных банков службам, расположенным на другом побережье Атлантического океана. Европа так и не смогла избавиться от бремени американских гиперскейлеров, которые открыто признают, что даже не могут гарантировать суверенитет данных. Как заявляют в британской Asanti Data Centres, многие организации активно приняли концепцию публичных облаков, но сбой показал, что может случиться, когда всё построено на одном фундаменте. Проблема затронула не только структуры, напрямую использующие сервисы AWS, но и всех остальных в цепочке поставок услуг. Большинство организаций ведут дела с клиентами AWS, в результате чего речь идёт о каскадном, общесистемном ущербе.

Источник изображения: Oğuzhan Akdoğan/unspalsh.com В IDC подчёркивают, что роль в купировании негативных эффектов от будущих инцидентов может сыграть ИИ. Хотя у AWS в целом довольно хорошая репутация среди пользователей, на устранение последствий инцидента потребовалось слишком много времени, поэтому возникают сомнения, сможет ли AWS поддерживать репутацию по мере роста бизнеса и усложнения технологий. ИИ может помочь, создавая агентов, способных заранее выявлять и устранять проблемы до того, как они негативно скажутся на клиентах. Стоит отметить, что концентрация облачных ресурсов в одном месте может действительно крайне негативно сказаться на деятельности целых государств. Недавний пожар в южнокорейском ЦОД показывает, к каким катастрофическим последствиям для государственных услуг может привести консолидация облачных мощностей в одном месте. Более того, даже концентрация крупных ЦОД разных операторов в одном месте грозит тем, что сбой одного из них приведёт к проблемам у соседних. Особенно в случае ИИ ЦОД.

20.10.2025 [21:45], Руслан Авдеев

Fujitsu влила £280 млн в британское подразделение в преддверии выплат компенсаций жертвам багов в её ПО HorizonЗа последние два года британское подразделение Fujitsu получило от японской «метрополии» £280 ($374 млн) в виде акционерного капитала. Это делается для удовлетворения текущих потребностей в финансировании на фоне скандала с ПО Horizon, сообщает The Register. Согласно свежим отчётам Fujitsu Services Limited, головная компания Fujitsu Services Holdings поддержала бизнес вливанием £80 млн в акционерный капитал для укрепления дел компании и удовлетворения текущих потребностей в финансировании. Средства выделяются в дополнение к аналогичному прошлогоднему платежу в объёме £200 млн ($267 млн), сделанному для «восстановления чистого капитала» и сокращения задолженности. По данным Fujitsu Services Limited, в финансовом году, закончившемся в марте 2025 года, выручка снизилась на 9,2 % до £1,06 млрд ($1,41 млрд). Британские почтовые отделения начали внедрять созданное Fujitsu ПО Horizon для бухгалтерского учёта в 1999 году, а после дважды его модернизировали. Непосредственно внедрением занималась местная компания ICL, подконтрольная Fujitsu. Проблема в том, что с 1999 по 2015 гг. около 736 сотрудников почт были неправомерно привлечены к уголовной ответственности за ошибки Horizon, что привело к множеству смертей, в том числе суицидам. Расследование многочисленных судебных ошибок, инициированное в 2021 году, не закончилось до сих пор. Установлено, что руководство Почты Великобритании и сотрудники ICL и Fujitsu должны были знать о сбоях. Хотя скандал вышел громким, Fujitsu дол сих пор не внесла своего вклада в государственную программу компенсаций жертвам, заявив, что принесла извинения, глубоко сожалеет о роли компании в страданиях почтовых сотрудников, готова оказывать всестороннее содействие расследованию и взаимодействует с правительством по вопросу компенсаций. При этом Fujitsu утверждала, что неоднократно предупреждала ответственных лиц о проблемах с ПО Horizon.

Источник изображения: Noralí Nayla/unspalsh.com В финансовом отчёте Fujitsu Services Limited объявила, что масштабы репутационного и финансового рисков нельзя оценить до завершения расследования. Исходя из результатов, компания примет «соразмерные» меры для участия в компенсационных программах властей. Ключевым риском для бизнес-планов названа потеря новых клиентов в будущем из-за нанесённого репутационного ущерба. До завершения расследования якобы принято решение приостановить участие в торгах, касающихся новых госконтрактов — исключения составляют только повторные закупки уже имеющихся клиентов и при их согласии на продление контрактов. Тем не менее, в апреле 2025 года Fujitsu новый контракт на £125 млн ($167 млн) для создания новой земельной кадастровой системы в Северной Ирландии на замену существующей. По данным экспертов, уже после начала скандала с Horizon компания получила контракты в госсекторе Великобритании на £510 млн ($682 млн), включая недавнюю сделку с налоговой службой HMRC на сумму £220 млн ($294) млн, причём без конкурса.

20.10.2025 [17:04], Руслан Авдеев

Не тот кабель: трое британцев попали под каток правосудия из-за ошибки монтажника BTТрибунал по следственным полномочиям (Investigatory Powers Tribunal) Великобритании опубликовал подробности расследования, касавшегося вероятных злоупотреблений британской полиции, сообщает The Register. Трёх граждан необоснованно подозревали в преступлениях, связанных с насилием над детьми и распространением запрещённого контента (IIOC). Как выяснилось, из-за технической ошибки — годы назад техник интернет-провайдера BT ошибся при монтаже кабелей в распределительном щитке. В 2016 году полиция запросила у BT информацию о физическом адресе и сетевой активности пользователя с известным им IP-адресом — оказалось, что у полиции есть инструмент автоматического оповещения об активностях, связанных с запрещённым контентом. В августе того же года полиция провела обыск по указанному BT физическому адресу с изъятием устройств с возможностью выхода в интернет. Расследование не нашло следов неприемлемого контента, допрошенные обитатели дома активно сотрудничали с правоохранительными органами, а само дело закрыли уже в сентябре. Тем не менее, система мониторинга полиции продолжала присылать уведомления о передаче нелегального контента с тех же адресов, уже выясненного физического и IP. В ходе вновь открытого расследования вопросы задавали не только трём жителям, но и, например, их работодателям. Это, к слову, обеспечило алиби одному из них, поскольку он физически не был дома во время одной из зафиксированных мониторингом интернет-сессий. В результате в январе 2017 года полиция совершила второй рейд по тому же адресу, изъяв Xbox, Android-устройства и другую электронику, где снова не было найдено никаких следов противоправного контента. Среди изъятого оборудования был и роутер, что помогло решить загадку. Получаемые им IP-адреса не совпали ни с одним из тех, что были в базе мониторинга. В результате дополнительных запросов к BT выяснилось, что, по-видимому, обслуживавший распределительный щит техник за восемь лет до этого перепутал два кабеля, шедших к соседним домам. После уточнения нового адреса и ареста соседа нашлись и свидетельства преступлений. Трибунал признал, что для невинно пострадавших последствия были довольно печальными — о расследовании и его причине сообщили на рабочие места подозреваемых, родственникам и др., что не могло не сказаться на их карьерах и вызвало серьёзные семейные проблемы, а у девушки, в числе прочих попавшей в жернова государственной машины, на время следствия даже отняли её собственных детей. На претензии пострадавших к полиции трибунал ответил отказом в компенсациях, хотя и признал неблагоприятные последствия расследования. Чиновники подчеркнули, что полиция не виновата и просто делала свою работу, а проблема была в технической ошибке на стороне BT — правоохранительные органы не могли предвидеть «редкого случая» перепутанных физических подключений, что существенно повлияло на ход расследования.

20.10.2025 [14:16], Владимир Мироненко

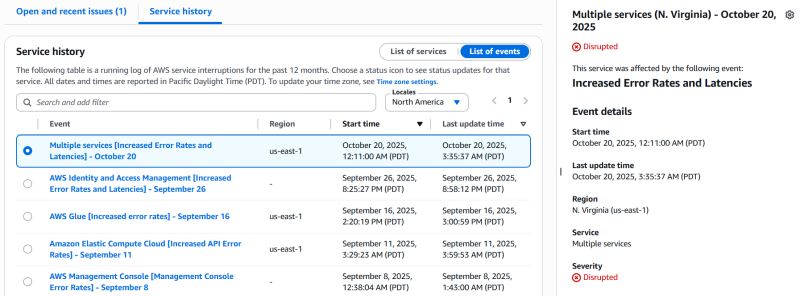

AWS столкнулась с серьёзным сбоем из-за ошибки DNS — падение одного сервиса потянуло за собой ещё 110 служб [Обновлено]Облако Amazon Web Services (AWS) столкнулось со серьёзным сбоем, из-за которого сейчас могут быть недоступны такие онлайн-сервисы, как Perplexity, Snapchat, Fortnite, Airtable, Canva, Amazon, Slack, Signal, PlayStation, Clash Royale, Brawl Stars, Epic Games Store и Ring Cameras, пишет Data Center Dynamics. Согласно отчёту Amazon, наблюдается «значительный уровень ошибок в запросах к DynamoDB в регионе US-EAST-1», который находится в Северной Вирджинии. Компания отметила, что эта проблема также затрагивает другие сервисы AWS в регионе US-EAST-1, а у клиентов может не быть возможности создавать или обновлять запросы в службу поддержки. Первопричиной проблем стала ошибка DNS. AWS её исправила и теперь занимается восстановлением доступности других сервисов. Проблема DynamoDB затронула другие сервисы AWS, включая AWS Global Accelerator, AWS VPCE PrivateLink, AWS Security Token Service, AWS Step Functions, AWS Systems Manager, Amazon CloudFront, Amazon DynamoDB, Amazon Elastic Compute Cloud, Amazon EventBridge, Amazon EventBridge Scheduler, Amazon GameLift Servers, Amazon Kinesis Data Streams, Amazon SageMaker и Amazon VPC Lattice — всего 82 службы. Сбои в работе сервисов AWS наблюдаются в других регионах по всему миру. Проблемы в работе AWS в регионе US-East-1 привели к масштабным сбоям в 2023, 2021 и 2020 годах, в результате чего было отключено множество веб-сайтов и платформ. Лишь спустя несколько часов было восстановлено нормальное обслуживание, сообщил The Verge. UPD: по состоянию на 21:45 МСК AWS продолжает работать над устранением проблем. По уточнённым данным, проблемы наблюдаются в 110 сервисах облака. Работа ещё 25 сервисов восстановлена. В качестве причины названы проблемы с сетью в US-EAST-1.

12.10.2025 [15:22], Руслан Авдеев

Арест за арестом: причиной возгорания в правительственном ЦОД Южной Кореи могло стать не отключенное вовремя резервное питаниеПолиция Южной Кореи полагает, что причиной крупного пожара в ЦОД Национальной службы информационных ресурсов (NIRS) 26 сентября, который привёл к отключению около 700 государственных сервисов и потери 858 Тбайт данных, могло стать некорректное отключение питания перед проведением технического обслуживания литий-ионных батарей. Перед переносом АКБ была отключена основная линия питания, однако вспомогательная, как выяснилось, продолжала работу. Аресты предполагаемых виновных продолжаются, сообщает Datacenter Dynamics. На прошлой неделе полиция арестовала четырёх человек по подозрению в халатности. Представители правоохранительных органов заявляют, что допрошено уже 26 человек, четверо было арестовано, а недавно арестовали пятого. Также проведены обыски в NIRS и трёх компаниях-партнёрах центра, конфискованы различные материалы, в т.ч. проектная документация и журналы работы аккумуляторов. Свидетели говорят, что основное электропитание было отключено примерно за час до начала пожара, однако вспомогательное питание всё ещё работало. Непосредственно возгорание произошло при попытке перемещения одного из аккумуляторов из зала на пятом этаже в подвал, что потребовало отключения силовых кабелей. Не исключено, что именно поэтому загоревшаяся батарея была заряжена на 80–90 %, тогда как многие производители рекомендуют низкий и средний уровень заряда перед перемещением литий-ионных модулей. Представители полиции ссылаются на мнение экспертов, уверенных, что потенциальный ущерб от пожара тем больше, чем выше заряд аккумуляторов. Аккумуляторы ЦОД разберут для дальнейшего изучения, также эксперты проведут эксперименты с идентичными моделями для выяснения причин возгорания. Пожар уничтожил 384 аккумуляторных модулей и 740 единиц IT-оборудования. По состоянию на минувшую пятницу было восстановлено 217 государственных систем — менее трети от общего числа. Считается, что операторы правительственной системы G-Drive, содержавшей 858 Тбайт информации, потеряли её безвозвратно, поскольку резервных копий не существовало. Примечательно, что спустя несколько дней в том же городе случился ещё один пожар, на этот раз в ЦОД Lotte Innovate. Причиной снова названо возгорание ИБП, причём буквально на следующий день после инспекции пожарной службы.

07.10.2025 [13:07], Руслан Авдеев

Консалтинговый гигант Deloitte вернёт австралийским властям часть средств за аналитику с фейковыми ИИ-цитатамиКонсалтинговая компания Deloitte выразила готовность вернуть часть средств, полученных в результате контракта с австралийским правительством — компания признала факт использования генеративного ИИ для создания отчёта, полного поддельных цитат, недействительных ссылок и даже выдержки из постановления Австралийского федерального суда, оказавшейся полностью «выдуманной» ИИ, сообщает The Register. Deloitte подтвердила, что вернёт часть средств, полученных в рамках соглашения на сумму AU$440 тыс. ($291 245) с Министерством занятости и трудовых отношений Австралии (DEWR). Это произошло после того, как министерство на прошлой неделе опубликовало исправленную версию отчёта. Из новой версии удалили более десятка ложных ссылок и сносок, переписали текст, исправили опечатки и т.п., но суть материала не изменилась, утверждают власти. Заказанная в прошлом декабре работа касалась правительственной IT-системы, связанной с наказанием получателей социальных пособий, не выполняющих свои обязательства по поиску работы. Впервые отчёт опубликовали в июле, но учёные Сиднейского университета обнаружили в нём «фальсификации», из-за чего Deloitte пришлось провести специальное расследование. То, что в ошибках виновен чат-бот, учёные предполагали изначально, но Deloitte на тот момент отказалась подтвердить это предположение.

Источник изображения: Deloitte В новой версии Deloitte указывает, что использовала инструменты на базе ИИ-модели Azure OpenAI GPT-4o. Бот помог с анализом и перекрёстными ссылками. По словам учёных, нельзя доверять рекомендациям, если сама основа отчёта построена на ошибочной и «неэкспертной» методологии. Deloitte, в своё время хвалившаяся достижениями в области искусственного интеллекта и предлагавшая клиентам тренинги по «ответственному использованию» ИИ, теперь оказалась в неловкой ситуации — из-за ИИ ошибки оказались в её собственном отчёте. При этом компания зарабатывает более $70 млрд/год по всему миру, а всё большая часть получаемых средств поступает от консультаций по вопросам, связанным с внедрением ИИ — этикой, политикой его внедрения и применения. В этом контексте выявленные ложные цитаты являются наихудшей рекламой деятельности компании. Среди удалённых материалов — ссылки на вымышленные доклады австралийских профессоров и даже выдуманный отрывок из дела Amato v Commonwealth, с упоминанием конкретного судьи. Несмотря на скандал, DEWR настаивает, что суть независимого обзора сохранилась, изменений в рекомендациях не предусмотрено. По некоторым данным, внутренняя проверка Deloitte показала, что причина появления некачественного материала — человеческий фактор, а не злоупотребление ИИ. Тем не менее, для клиентов консалтинговых компаний «Большой четвёрки» (Deloitte, PwC, Ernst & Young и KPMG) новость — повод без лишнего шума проверить полученные за немалые деньги выкладки экспертов на достоверность и наличие «творчества» ИИ. Примечательно, что в июне Deloitte предрекала рост потребность ИИ ЦОД в США в энергии к 2035 году может вырасти в 30 раз — до 123 ГВт с 4 ГВт в 2024 году. Пока неизвестно, насколько активно использовался ИИ при составлении прогноза и можно ли ему верить.

07.10.2025 [00:50], Владимир Мироненко

Бэкапов нет, работа стоит, надежд мало: 858 Тбайт правительственных данных безвозвратно утеряны из-за пожара в ЦОД в Южной КорееВ Южной Корее продолжаются восстановительные работы в ЦОД Национальной службы информационных ресурсов (NIRS) Южной Кореи в Тэджоне, где 26 сентября произошёл масштабный пожар, который привёл к сбою в работе 647 государственных сервисов, пишет газета The Korea JoongAng Daily. В результате пожара утеряно множество важных данных, для которых не делались бэкапы, так что некоторые подразделения теперь вынуждены по крупицам собирать сохранившуюся информацию. Как стало известно, из-за пожара было уничтожено правительственное облачное хранилище G-Drive (никак не связано с Google). Утеряно 858 Тбайт данных примерно 750 тыс. госслужащих. Платформа является обязательной для хранения документов и других файлов госслужащих. Каждому сотруднику на эти цели было выделно порядка 30 Гбайт пространства. По словам NIRS, из-за большой ёмкости и низкой производительности системы внешние резервные копии не создавались, что привело к безвозвратной потере данных. В Министерстве внутренних дел и безопасности Южной Кореи пояснили, что структура G-Drive не позволяет создавать внешние резервные копии, хотя данные большинства систем подлежат резервному копированию в хранилище в этом же ЦОД и на ещё одном физически удалённом объекте. В свою очередь, Data Center Dynamics со ссылкой южнокорейские СМИ сообщил, что G-Drive была одной из 96 полностью уничтоженных в результате пожара систем. Вместе с тем, у остальных 95 систем сохранились резервные копии данных в онлайн- или офлайн-форматах. Некоторые департаменты не пользовались G-Drive, но те, кто использовал, столкнулись с серьёзными проблемами. Сильнее всего пострадало Министерство управления персоналом, издавшее распоряжение хранить всю документацию исключительно на G-Drive. Сейчас оно собирает все оставшиеся на ПК чиновников файлы, а также почтовые сообщения, официальные документы и даже распечатки. Министерство внутренних дел и безопасности Южной Кореи отметило, что официальная отчётность также хранится в правительственной системе OnNara и может быть восстановлена после возобновления её работы. «Заключительные отчёты и официальные документы, представленные правительству, также хранятся в OnNara, поэтому это не полная потеря данных», — заявил директор по государственным услугам Министерства внутренних дел и безопасности Южной Кореи. К прошедшим выходным удалось восстановить лишь 115 из 647 пострадавших сервисов. Ожидается, что полное восстановление займёт около месяца. Правительство заявило, что будут предложены альтернативные варианты на замену наиболее важных сервисов.

04.10.2025 [00:38], Владимир Мироненко

В южнокорейском Тэджоне загорелся уже второй ЦОД за неделю, сразу после инспекции пожарных — виноватым снова назначили ИБПСпустя несколько дней после масштабного пожара в дата-центре национального информационно-ресурсного агентства Южной Кореи (NIRS) в Тэджоне (Daejeon), который вызвал сбой в работе 647 государственных сервисов, ещё в одном ЦОД этого города произошёл пожар, сообщает газета The Korea JoongAng Daily. На этот раз возгорание произошло в дата-центре корейского провайдера Lotte Innovate около 4:59 утра в четверг. Пожарная служба города направила на место происшествия 21 единицу техники и 62 человека личного состава, и к 5:38 утра пожар был потушен. Пострадавших нет, сообщила газета. Под управлением Lotte Innovate находятся четыре ЦОД в Южной Корее. Дата-центр в Тэджоне был введён в эксплуатацию в 2010 году. Согласно предварительной версии, возгорание произошло в модуле источника бесперебойного питания (ИБП) в машинном зале на первом этаже двухэтажного здания. Предполагается, что причиной возгорания могла стать некондиционная батарея, но окончательные выводы будут сделаны после завершения расследования соответствующих органов.

Источник изображения: Max Kukurudziak/unsplash.com Второй пожар в ЦОД менее чем за неделю поставил под сомнение эффективность недавних проверок безопасности ЦОД. После пожара в дата-центре NIRS полиция арестовала четырёх человек, а власти и пожарная служба провели экстренные проверки в пяти крупных местных ЦОД, включая и дата-центр Lotte Innovate, где буквально на следующий день после инспекции произошло возгорание. Как сообщает The Korea JoongAng Daily, полиция и пожарная служба планируют допросить сотрудников Lotte Innovate, чтобы установить точную причину пожара и оценить масштаб ущерба.

01.10.2025 [11:45], Руслан Авдеев

Пожар в южнокорейском ЦОД нарушил работу 647 государственных сервисов — на восстановление уйдёт месяцВласти Южной Кореи предупредили граждан, что на восстановление пострадавших в результате пятничного пожара в дата-центре систем может уйти до месяца, сообщает Datacenter Dynamics. По данным местных госорганов, возгорание аккумуляторов в дата-центре Национальной службы информационных ресурсов (NIRS) в городе Тэджон (Daejeon) в итоге затронуло работу 647 государственных сервисов. Местный штаб по борьбе с чрезвычайными ситуациями сообщил, что по состоянию на понедельник, 29 сентября 2025 года, была восстановлена работа 73 служб, а на восстановление остальных могут уйти недели. По словам властей, сервисы будут развёрнуты на базе государственно-частного облачного кластера, расположенного в штаб-квартире NIRS в городе Тэгу (Daegu). Предполагается, что на получение необходимой IT-инфраструктуры потребуется две недели, на восстановление работы всех систем — ещё две. Ранее власти заявляли, что на устранение последствий возгорания уйдёт лишь две недели. Возгорание литиевых аккумуляторов произошло в 20:20 по местному времени в пятницу, 26 сентября в одном из серверных помещений ЦОД. К тушению привлекли 73 пожарных и 70 единиц специальной техники. От ожогов пострадал как минимум один человек. После того, как пожар полностью потушили в субботу, власти инициировали расследование причин. В группу из 20 следователей входят три эксперта по литиевым АКБ — всех специалистов привлекла полиция Тэджона.

Источник изображения: Guido Jansen/unsplash.com NIRS предоставляет 1,6 тыс. сервисов для граждан в рамках центральной южнокорейской системы госуслуг. Также ведомство выступает поставщиком IT-сервисов для местных и национальных органов власти. Системы компании работают в трёх ЦОД, на площадку в Тэджоне приходится треть мощностей. Системы, отключившиеся в результате пожара, включают местную службу экстренных вызовов 119, сервисы правительственной электронной почты и др. Не так давно инцидент с критически важными службами произошёл в Австралии. Из-за сбоя при обновлении брандмауэра местным телеком-оператором Optus временно исчезла возможность дозвониться в местный аналог службы «911», в результате чего умерли, как минимум, трое местных жителей. UPD: полиция арестовала четырёх человек, подозреваемых в халатности на рабочем месте. Пожар начался на пятом этаже ЦОД из-за вспыхнувшей батареи, что в итоге привело к уничтожению 384 батарейных модулей и 740 единиц IT-оборудования. Объект продолжают преследовать неудачи — сегодня на парковке ЦОД загорелся автомобиль, который оперативно потушили. |

|