Материалы по тегу: к

|

09.04.2024 [12:42], Сергей Карасёв

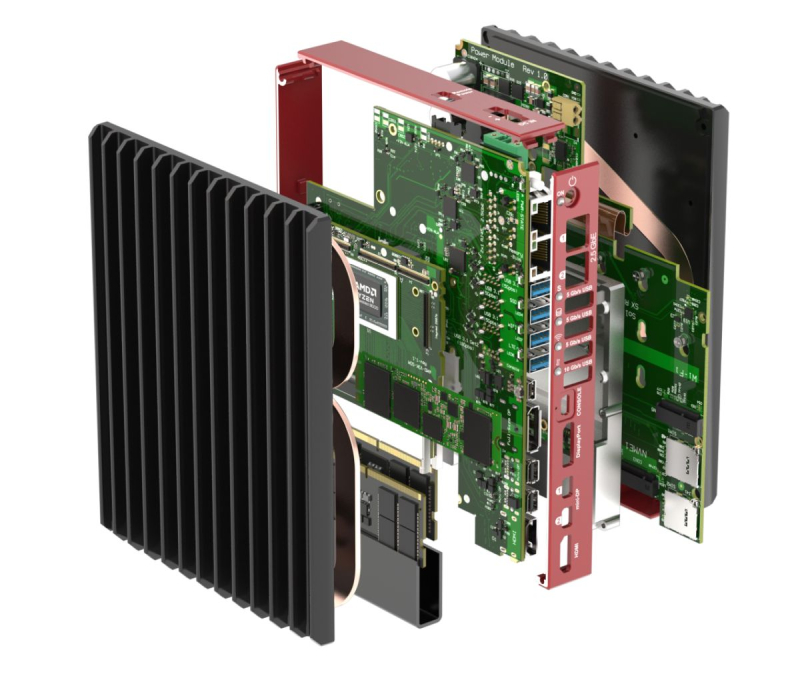

SolidRun представила модульные индустриальные ПК Bedrock R8000 на базе AMD Ryzen EmbeddedКомпания SolidRun анонсировала индустриальные компьютеры серии Bedrock R8000 в небольшом форм-факторе. В основу устройств положены процессоры AMD Ryzen Embedded 8000, в состав которых входит нейропроцессорный движок (NPU) с производительностью до 16 TOPS. Новинки имеют модульную конструкцию. Она включает основную SoM-плату с CPU, слотами для памяти DDR5 и накопителей SSD NVMe, плату NIO (сетевые контроллеры и интерфейсы ввода/вывода), карты расширения (Wi-Fi, 4G/5G и пр.), а также модуль питания Power Module. Для последнего доступны три варианта исполнения — 12–24 В, 12–48 В и 12–60 В. Компьютеры используют пассивное охлаждение. Корпус изготовлен из прочного анодированного алюминия. Габариты основного блока Tile составляют 29 × 160 × 130 мм. В зависимости от конфигурации с одной или двух сторон могут быть закреплены радиаторы охлаждения: в этом случае толщина увеличивается до 45 или 73 мм. Диапазон рабочих температур простирается от -40 до +85 °C. Возможны различные варианты крепления: на стену, DIN-рейку, VESA или использование в настольном режиме. Максимальная конфигурация включает процессор Ryzen 9 8945HS (8 ядер, 16 потоков, 4,0–5,2 ГГц, 45 Вт) с графикой AMD Radeon 780M. Дополнительно могут быть установлены до трёх ИИ-ускорителей Hailo-8 формата M.2 с производительностью 26 TOPS или до двух ИИ-ускорителей Hailo-10 M.2 с быстродействием 40 TOPS. Доступны два слота SO-DIMM для модулей оперативной памяти DDR5-5600 суммарным объёмом до 96 Гбайт. Поддерживаются до трёх SSD стандарта M.2 2280 (NVMe PCIe 4.0 x4) и до четырёх сетевых портов 2.5GbE (контроллер Intel I226). Можно также установить комбинированный адаптер Wi-Fi 6E / Bluetooth 5.3 (Intel AX210) в виде модуля M.2 key-E 2230 и сотовый модем 4G/5G в виде модуля M.2 key-B 3042/3052. В набор интерфейсов входят HDMI 2.1 и DisplayPort 2.1, USB 4.0 (40 Гбит/с) и USB 3.2 Gen2 (10 Гбит/с), а также три порта USB 3.2 Gen2 (5 Гбит/с). Заявлена совместимость с Windows 10/11/IoT и Linux.

08.04.2024 [11:35], Сергей Карасёв

BSC и NVIDIA займутся совместной разработкой HPC- и ИИ-решенийБарселонский суперкомпьютерный центр (Centro Nacional de Supercomputación, BSC-CNS) и NVIDIA объявили о заключении многолетнего соглашения о сотрудничестве, целью которого является совместная разработка инновационных решений, объединяющих технологии НРС и ИИ. Договор рассчитан на пять лет с возможностью последующего продления. При этом каждые шесть месяцев стороны намерены уточнять и оптимизировать направления сотрудничества. Новое соглашение будет действовать параллельно с ранее подписанным документом, касающимся совместных исследований в области сетевых решений. Первоначально сотрудничество между BSC и NVIDIA будет сосредоточено на разработке больших языковых моделей (LLM), а также приложений для метеорологии и анализа изменений климата. Кроме того, стороны займутся адаптацией вычислительной модели цифрового двойника сердца, разработанной в рамках проекта Alya, к различным платформам. Ещё одно направление работ — программная оптимизация процессов для GPU и архитектуры NVIDIA Grace с ядрами Arm, специально разработанной для ИИ и крупномасштабных суперкомпьютерных приложений. Предполагается также, что научный потенциал BSC вкупе с технологическими достижениями и опытом NVIDIA позволят максимизировать вычислительные возможности суперкомпьютера MareNostrum 5, который был запущен в Испании в конце 2023 года. Эта система, использующая ускорители NVIDIA H100, обладает производительностью 314 Пфлопс.

05.04.2024 [14:30], Владимир Мироненко

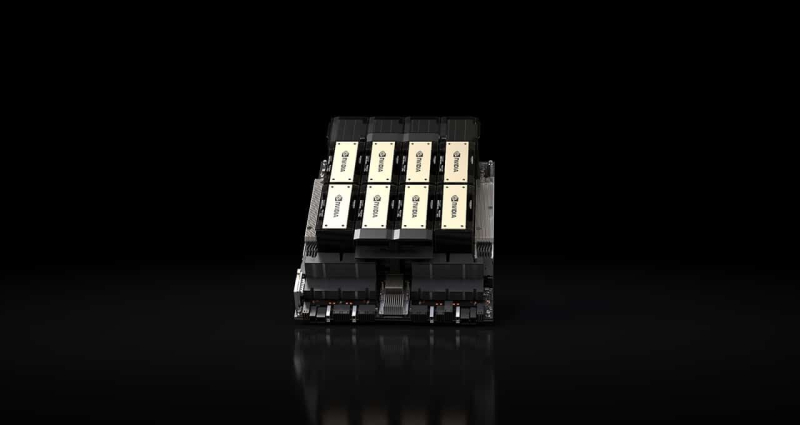

Представлены российские HPC-узлы «РСК Экзастрим ИИ» с восемью ускорителями и фирменной СЖОГруппа компаний РСК представила модульное решение «РСК Экзастрим ИИ», предназначенное, как видно из названия, для развития ИИ-инфраструктуры в России. Новинка представляет собой серверный узел высотой 2U на базе Intel Xeon Sapphire Rapids, который включает до восьми ускорителей, например, NVIDIA H100. 32 слота DDR5 позволяют установить до 8 Тбайт RAM. В узел можно установить до восьми SSD в форм-факторе EDSFF E1.S общим объёмом до 20 Тбайт. Надлежащий температурный режим обеспечивает фирменная СЖО РСК с температурой хладоносителя +40–+50 °C. Спецификации устройства также включают до четырёх подключений Infiniband HDR/NDR, поддержку сети 10GbE и фирменный блок питания с жидкостным охлаждением.

Источник изображений: РСК Пиковая производительность «РСК Экзастрим ИИ» при использовании ускорителей NVIDIA H100 составляет 208/408 Тфлопс (FP64/TF64). В универсальном шкафу «РСК Экзастрим» высотой 42U можно разместить до 21 вычислительного узла «РСК Экзастрим ИИ», благодаря чему суммарная пиковая производительного такой стойки составит 4,368/8,568 Пфлопс (FP64/TF64) при энергопотреблении всего 115 кВт.

28.03.2024 [14:31], Сергей Карасёв

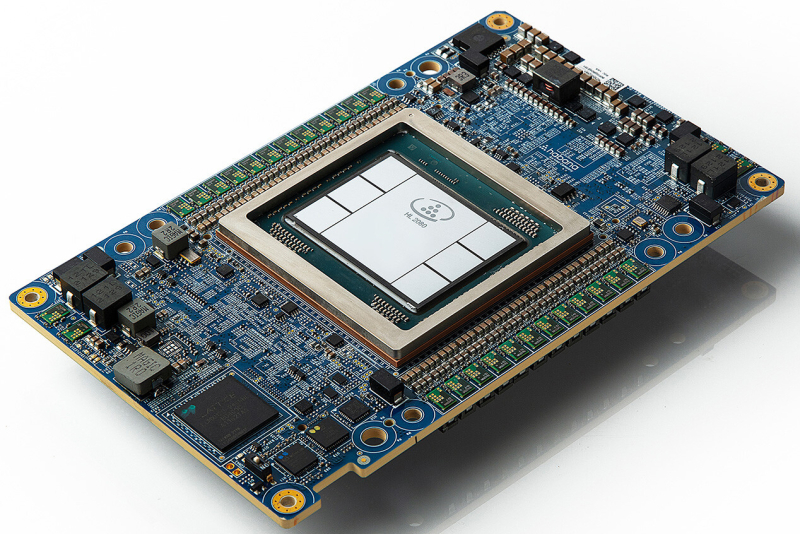

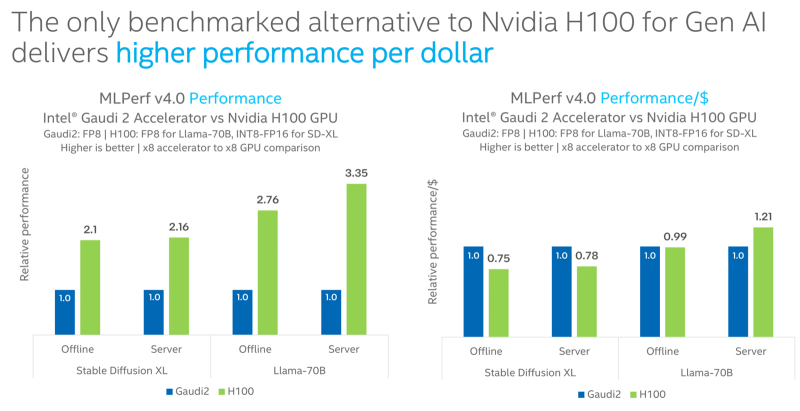

Intel Gaudi2 остаётся единственным конкурентом NVIDIA H100 в бенчмарке MLPerf InferenceКорпорация Intel сообщила о том, что её ИИ-ускоритель Habana Gaudi2 остаётся единственной альтернативой NVIDIA H100, протестированной в бенчмарке MLPerf Inference 4.0. При этом, как утверждается, Gaudi2 обеспечивает высокое быстродействие в расчёте на доллар, хотя именно чипы NVIDIA являются безоговорочными лидерами. Отмечается, что для платформы Gaudi2 компания Intel продолжает расширять поддержку популярных больших языковых моделей (LLM) и мультимодальных моделей. В частности, для MLPerf Inference v4.0 корпорация представила результаты для Stable Diffusion XL и Llama v2-70B. Согласно результатам тестов, в случае Stable Diffusion XL ускоритель H100 превосходит по производительности Gaudi2 в 2,1 раза в оффлайн-режиме и в 2,16 раза в серверном режиме. При обработке Llama v2-70B выигрыш оказывается более значительным — в 2,76 раза и 3,35 раза соответственно. Однако на большинстве этих задач (кроме серверного режима Llama v2-70B) решение Gaudi2 выигрывает у H100 по показателю быстродействия в расчёте на доллар. В целом, ИИ-ускоритель Gaudi2 в Stable Diffusion XL показал результат в 6,26 и 6,25 выборок в секунду для оффлайн-режима и серверного режима соответственно. В случае Llama v2-70B достигнут показатель в 8035,0 и 6287,5 токенов в секунду соответственно. Говорится также, что серверные процессоры Intel Xeon Emerald Rapids благодаря улучшениям аппаратной и программной составляющих в бенчмарке MLPerf Inference v3.1 демонстрируют в среднем в 1,42 раза более высокие значения по сравнению с чипами Xeon Sapphire Rapids. Например, для GPT-J с программной оптимизацией и для DLRMv2 зафиксирован рост быстродействия примерно в 1,8 раза.

27.03.2024 [22:29], Алексей Степин

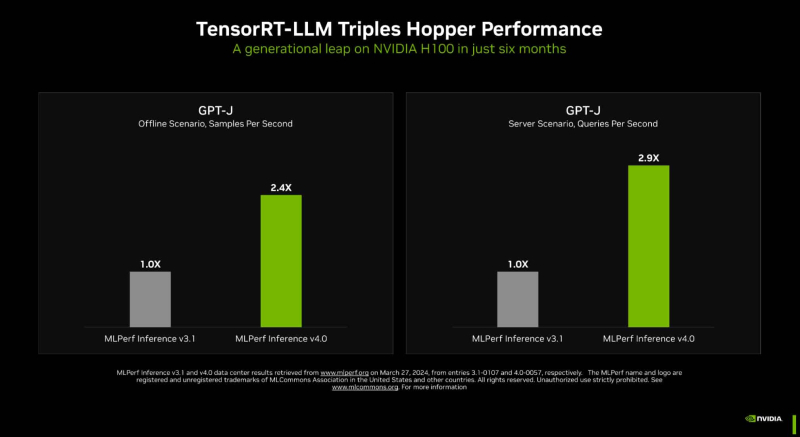

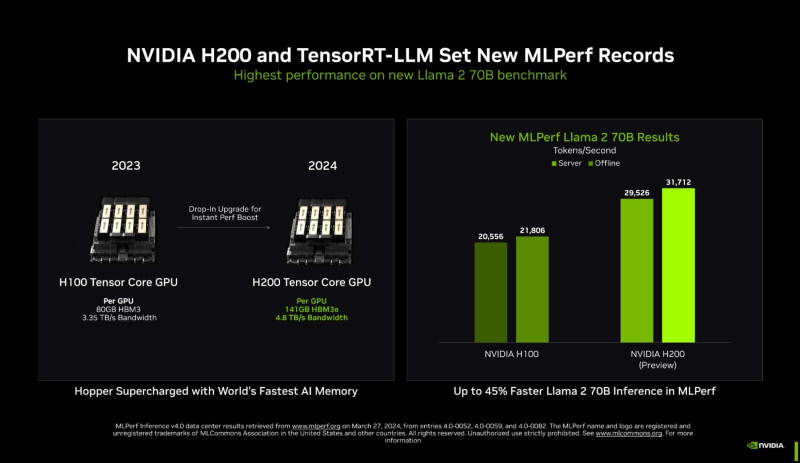

Новый бенчмарк — новый рекорд: NVIDIA подтвердила лидерские позиции в MLPerf InferenceКомпания NVIDIA опубликовала новые, ещё более впечатляющие результаты в области работы с большими языковыми моделями (LLM) в бенчмарке MLPerf Inference 4.0. За прошедшие полгода и без того высокие результаты, демонстрируемые архитектурой Hopper в инференс-сценариях, удалось улучшить практически втрое. Столь внушительный результат достигнут благодаря как аппаратным улучшениям в ускорителях H200, так и программным оптимизациям. Генеративный ИИ буквально взорвал индустрию: за последние десять лет вычислительная мощность, затрачиваемая на обучение нейросетей, выросла на шесть порядков, а LLM с триллионом параметров уже не являются чем-то необычным. Однако и инференс подобных моделей тоже является непростой задачей, к которой NVIDIA подходит комплексно, используя, по её же собственным словам, «многомерную оптимизацию». Одним из ключевых инструментов является TensorRT-LLM, включающий в себя компилятор и прочие средства разработки, учитывающие архитектуру ускорителей компании. Благодаря ему удалось почти втрое повысить производительность инференса GPT-J на ускорителях H100 всего за полгода. Такой прирост достигнут благодаря оптимизации очередей на лету (inflight sequence batching), применению страничного KV-кеша (paged KV cache), тензорному параллелизма (распределение весов по ускорителям), FP8-квантизации и использованию нового ядра XQA (XQA kernel). В случае ускорителей H200, использующих ту же архитектуру Hopper, что и H100, важную роль играет память: 141 Гбайт HBM3e (4,8 Тбайт/с) против 80 Гбайт HBM3 (3,35 Тбайт/с). Такой объём позволяет разместить модель уровня Llama 2 70B целиком в локальной памяти. В тесте MLPerf Llama 2 70B ускорители H200 на 28 % производительнее H100 при том же теплопакете 700 Вт, а увеличение теплопакета до 1000 Вт (так делают некоторые вендоры в своих MGX-платформах) даёт ещё 11–14 % прироста, а итоговая разница с H100 в этом тесте может доходить до 45 %. В специальном разделе новой версии MLPerf NVIDIA продемонстрировала несколько любопытных техник дальнейшей оптимизации: «структурированную разреженность» (structured sparsity), позволяющую поднять производительность в тесте Llama 2 на 33 %, «обрезку» (pruning), упрощающую ИИ-модель и позволяющую повысить скорость инференса ещё на 40 %, а также DeepCache, упрощающую вычисления для Stable Diffusion XL и дающую до 74 % прироста производительности. На сегодня платформа на базе модулей H200, по словам NVIDIA, является самой быстрой инференс-платформой среди доступных. Результатами GH200 компания похвасталась ещё в прошлом раунде, а вот показатели ускорителей Blackwell она не предоставила. Впрочем, не все считают результаты MLPerf показательными. Например, Groq принципиально не участвует в этом бенчмарке.

26.03.2024 [16:06], Сергей Карасёв

«Аэродиск» представила СХД Engine AQ на платформе «Аквариуса»Компания «Аэродиск» анонсировала системы хранения данных серии Engine AQ, построенные на аппаратной платформе «Аквариуса». Изделия подходят для широкого круга задач, таких как виртуализация, базы данных, видеонаблюдение и высоконагруженные приложения корпоративного класса. В семейство вошли СХД среднего уровня Engine AQ 440/450/460 на базе Aquarius FS440/FS450/FS46. Они оснащаются процессорами Intel Xeon, а объём оперативной памяти в стандартной конфигурации составляет 256 Гбайт. Первая из названных систем выполнена в формате 4U с двумя контроллерами в едином корпусе. Допускается установка 24 накопителей SFF/LFF с интерфейсом SAS. Модификация FS450 использует шасси 2U+2U с двумя отдельно стоящими контроллерами: применяются дисковые модули расширения с общим количеством накопителей до 608 в расчёте на систему. Форм-фактор дисковых полок — 2U (12 × LFF/SFF), 2U (24 × SFF), 4U (24 × LFF/SFF), 4U (60 × LFF) и 4U (72 × LFF). Наконец, система FS46 получила исполнение 4U с двумя контроллерами в едином корпусе. Предусмотрены отсеки для 24 накопителей SFF/LFF с интерфейсом SAS.

Источник изображения: «Аэродиск» Говорится, что одной из ключевых особенностей СХД серии Engine AQ является возможность репликации данных, что значительно повышает надёжность хранения информации. Кроме того, поддерживается организация метрокластера, обеспечивающего бесперебойную работу и доступность данных в распределённых вычислительных средах. «Новая СХД представляет собой идеальное решение для организаций, стремящихся максимизировать производительность и надёжность своих информационных систем с возможностью гибкой настройки под специфические бизнес-потребности», — говорится в сообщении «Аэродиска». Возможна организация All-Flash массивов исключительно на основе SSD. Архитектура обеспечивает дублирование всех компонентов СХД, что позволяет организовать доступность данных на уровне 99,999 %. В перспективе планируется выпуск СХД начального уровня Engine AQ «Лайт» для предприятий малого и среднего бизнеса.

24.03.2024 [15:05], Сергей Карасёв

Nutanix обвиняет бывших сотрудников и стартап Tessell в краже интеллектуальной собственностиКомпания Nutanix, разработчик решений в области гибридных мультиоблачных платформ и HCI, по сообщению The Register, подала в федеральный окружной суд Северной Калифорнии иск против троих своих бывших сотрудников и основанного ими стартапа Tessell, который специализируется на облачных продуктах DBaaS (база данных как услуга). В деле фигурируют Бала Кучибхотла (Bala Kuchibhotla), Камалдип Хануджа (Kamaldeep Khanuja) и Бакул Бантиа (Bakul Banthia). По заявления истцов, они использовали мощности, оборудование, сервисы Nutanix и даже исходный код Nutanix Era при разработке решений Tessell. Продукт Nutanix Era — это специализированный софт, который автоматизирует и упрощает администрирование баз данных.

Источник изображения: pixabay.com В иске утверждается, что названные лица, будучи сотрудниками Nutanix, «спланировали, разработали, получили первоначальное финансирование и продемонстрировали прототипы конкурирующего продукта» с использованием ресурсов Nutanix. Более того, один из прототипов решения Tessell работал на серверах Nutanix. Таким образом, как отмечается в судебных документах, ответчики якобы завладели исходным кодом Era и использовали его для создания своих собственных продуктов в рамках участия в стартапе Tessell. Проведенное специалистами Nutanix расследование выявило кражу интеллектуальной собственности. Бывшие сотрудники обвиняются в нарушении контракта и хищении корпоративной информации, тогда как фирме Tessell вменяется незаконное использование чужой интеллектуальной собственности. Говорится, что Tessell «осознанно и преднамеренно» нарушила авторские права и патенты Nutanix. Ответчики ситуацию пока никак не комментируют.

24.03.2024 [15:03], Сергей Карасёв

Tencent увеличит инвестиции в облака на Ближнем ВостокеTencent, по сообщению Bloomberg, намерена расширить свой облачный бизнес на Ближнем Востоке на фоне стремительного развития ИИ. Речь идёт о реализации проектов в Саудовской Аравии и ОАЭ. Исполнительный вице-президент Tencent Доусон Тонг (Dowson Tong) в ходе выступления в Эр-Рияде отметил, что инвестиции компании в указанном регионе «всё ещё находятся на начальной стадии», но будут быстро расти. Tencent считает, что этот рынок имеет большой потенциал, особенно в свете необходимости наращивания вычислительных мощностей и ресурсов для хранения данных. На первом этапе Tencent сосредоточится на развитии облачных хранилищ — как для сторонних клиентов (в частности, из сфер развлечений и игр), так и для своих собственных нужд. Недавно Tencent выпустила арабскую версию Honor of Kings — одной из самых популярных мобильных игр. Кроме того, Tencent намерена развернуть на Ближнем Востоке вычислительные мощности для приложений ИИ. В эту сферу Саудовская Аравия и ОАЭ вкладывают значительные средства, фокусируясь в том числе на разработке региональных больших языковых моделей. Проекты в сегменте дата-центров и облаков на Ближнем Востоке активно развивают и другие крупные компании. Так, Aramco Digital и Groq сообщили о намерении создать в Саудовской Аравии крупнейший в мире центр по развитию ИИ. Строительством ЦОД в этой стране занимаются Saudi Call и China Mobile, тогда как Oracle и Microsoft развернут здесь новые облачные регионы. Huawei уже запустила в Эр-Рияде свой первый облачный регион на Ближнем Востоке, тогда как HPE ввела в эксплуатацию предприятие по выпуску серверов. Вместе с тем Microsoft, Oracle и Du намерены сформировать суверенные облака в ОАЭ.

22.03.2024 [23:59], Руслан Авдеев

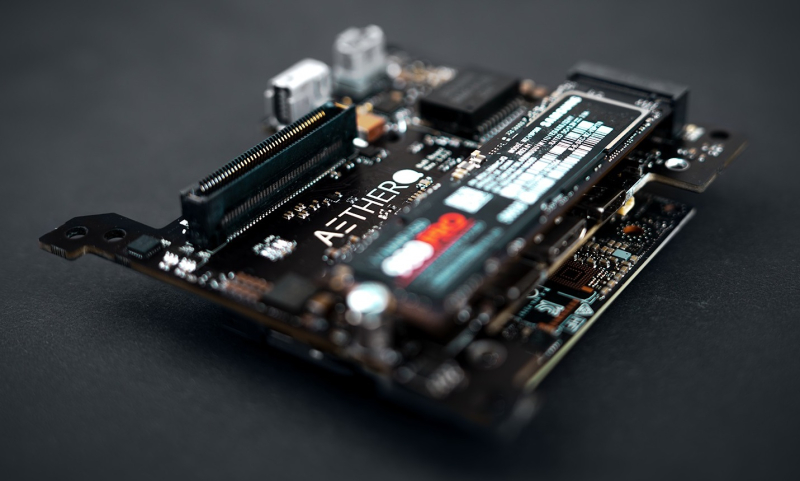

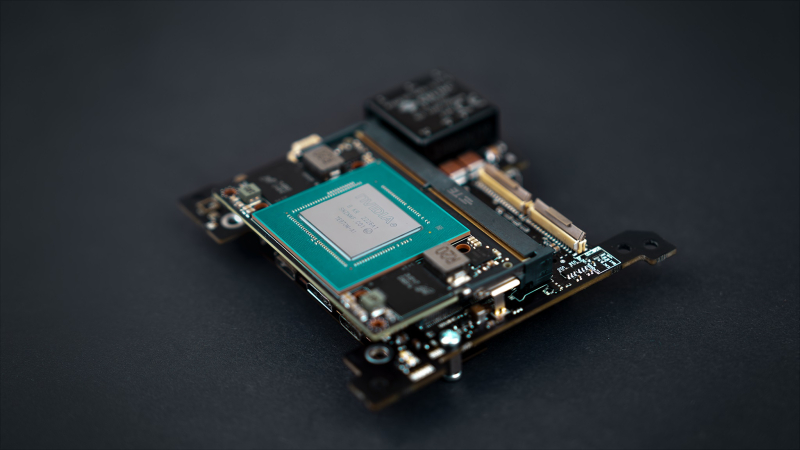

Aethero намерена стать «Intel или NVIDIA в космической индустрии», разработав защищённые ИИ-платформы для спутников и станцийХотя сенсоры многочисленных орбитальных спутников собирают немало информации, у космических аппаратов не хватает вычислительных способностей, чтобы обрабатывать данные на месте. TechCrunch сообщает, что стартап Aethero намерен стать «Intel или NVIDIA в космической индустрии» — компания разрабатывает защищённые от радиации компьютеры для периферийных вычислений на спутниках. Несколько лет назад основатели Aethero создали стартап Stratodyne, занимавшийся строительством стратостатов для дистанционного зондирования (ДЗЗ). Позже компания закрылась, а создатели вернулись к изучению встраиваемых систем для агрессивных сред. Как заявляет Aethero, современные компьютеры для космоса используют устаревшие FPGA и не способны выполнять сложные вычисления вроде тренировки на орбите ИИ-моделей или обслуживания систем компьютерного зрения. Aethero, привлёкшая $1,7 млн, намерена только в этому году трижды отправить свои разработки в космос. Одна из миссий будет выполнена SpaceX уже в июне. Целью является демонстрация работоспособности прототипов вроде возможности обновления набортных моделей компьютерного зрения или тренировки таких моделей непосредственно в космосе на собранных здесь же данных. Космический компьютер первого поколения ECM-NxN использует чип NVIDIA Jetson Orin Nano. В компании утверждают, что сегодня это лучший периферийный ИИ-ускоритель на рынке, а надёжное оборудование собственной разработки позволит сохранить его работоспособность на низкой околоземной орбите в течение 7–10 лет. При этом платформа уместится даже в небольшом аппарате вроде кубсата и обеспечивает производительность в 20 раз выше в сравнении с уже существующими решениями. Впоследствии Aethero намерена выпустить более крупный модуль ECM-NxA на базе NVIDIA AGX, а потом перейти к разработке собственного RISC-V чипа для модуля ECM-0x1. Утверждается, что тот будет потреблять меньше энергии и будет производительнее, чем продукты техногигантов. Выпуск планируется совместно с Intel приблизительно в 2026 году, хотя обстоятельства могут измениться. В Aethero отмечает, что подобные решения могут быть интересны операторам ДЗЗ, орбитальным сервисам и будущим частным космическим станциям. Например, только МКС генерирует терабайты данных ежедневно, напоминает компания. Правда, на МКС работает уже второе поколение космического суперкомпьютера HPE Spaceborne-2, разработчики которого отмечали проблемы с SSD и кешами процессоров из-за радиации. На МКС была протестирована и edge-платформа AWS Snowcone. Более того, ИИ-софт AWS для анализа снимков уже успел поработать на низкоорбитальном спутнике.

22.03.2024 [15:44], Владимир Мироненко

Schneider Electric и NVIDIA разработают эталонные проекты инфраструктуры ЦОД для ИИ-нагрузокФранцузская корпорация Schneider Electric объявила о сотрудничестве с NVIDIA с целью оптимизации инфраструктуры ЦОД, что позволит добиться новых достижений в области искусственного интеллекта (ИИ) и технологий цифровых двойников. Используя опыт в области инфраструктуры ЦОД и передовые ИИ-технологии NVIDIA, Schneider Electric разработает первые в своём роде общедоступные эталонные проекты дата-центров, призванные переопределить стандарты развёртывания и эксплуатации ИИ в экосистемах ЦОД. Эти проекты будут адаптированы для кластеров ускорителей NVIDIA и предназначены для поддержки нагрузок инженерного моделирования, автоматизации электронного проектирования, автоматизированного проектирования лекарств и генеративного ИИ. Особое внимание будет уделено обеспечению системам распределения большой мощности, системам жидкостного охлаждения и средствам управления для обеспечения простого ввода в эксплуатацию и надёжной работы высокоплотных кластеров. Эталонные проекты предложат надёжную основу для внедрения аппаратных платформ NVIDIA в ЦОД, одновременно оптимизируя производительность, масштабируемость и общую устойчивость объектов. Эти же проекты можно будет использовать для развёртывания ИИ-серверов высокой плотности в существующих ЦОД. В рамках объявленного сотрудничества AVEVA, дочерняя компания Schneider Electric, подключит свою платформу цифровых двойников к NVIDIA Omniverse, создав единую среду для виртуального моделирования и совместной работы. Это позволит ускорить проектирование и развёртывание сложных систем, а также сократить время их вывода на рынок и затраты. «Технологии NVIDIA расширяют возможности AVEVA по созданию реалистичного и захватывающего опыта совместной работы, основанного на богатых данных и возможностях интеллектуального цифрового двойника AVEVA», — отметил глава AVEVA. |

|