Материалы по тегу: ии

|

14.05.2025 [00:23], Владимир Мироненко

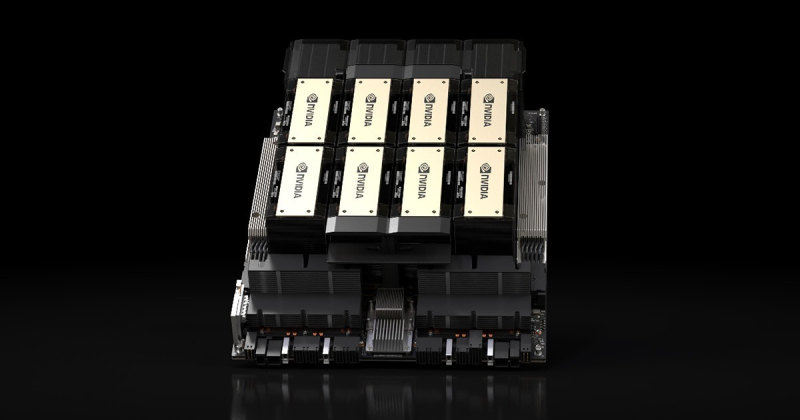

Саудовская Аравия всерьёз намерена стать лидером в ИИ: госстартап Humain договорился о многомиллиардном партнёрстве с NVIDIA, AMD и AWSНаследный принц Саудовской Аравии Мухаммед ибн Салман аль-Сауд (Mohammed bin Salman Al Saud) основал новую компанию Humain по разработке ИИ-технологий, пишет Reuters. Развитие этого направления является одним из приоритетов при трансформации экономики страны в соответствии с целями программы «Видение – 2030» (Vision 2030), призванной снизить её зависимость от добычи ископаемого топлива. На сегодняшней встрече Мухаммеда ибн Салмана с президентом США Дональдом Трампом (Donald Trump), находящимся с четырёхдневным визитом в регионе, которая прошла при участии миллиардера Илона Маска (Elon Musk), а также на совместном саудовско-американском инвестиционном форуме в Эр-Рияде, ИИ был одной из центральных тем повестки дня. Humain возглавляет сам наследный принц в качестве председателя. Гендиректором назначен Тарек Амин (Tareq Amin). Компания принадлежит Суверенному фонду Саудовской Аравии, взявшему на себя обязательство вложить значительные средства в развитие ИИ-технологий в стране. Как пишет Bloomberg со ссылкой на агентство Saudi Press Agency, новая компания займётся запуском ЦОД, развертыванием ИИ-инфраструктуры и облачных сервисов, а также разработкой больших языковых моделей (LLM) с поддержкой арабского языка. Компания намерена создать полностью готовую интегрированную ИИ-платформу для решения практических задач. В заявлении компании также указано, что она станет ИИ-центром для таких секторов, как энергетика, здравоохранение, производство и финансовые услуги страны. Поможет ей в этом целый ряд американских технологических компаний. В частности, было объявлено о сотрудничестве с NVIDIA, в рамках которого компании «будут использовать платформы и опыт NVIDIA, чтобы сделать Саудовскую Аравию мировым лидером в области ИИ, облачных GPU-вычислений и цифровой трансформации для стимулирования инноваций и роста во всем мире». В течение следующих пяти лет Humain произведёт крупные инвестиции в строительство ИИ-фабрик в Саудовской Аравии мощностью до 500 МВт, использующих сотни тысяч передовых ускорителей NVIDIA. На первом этапе будет установлено 18 тыс. суперускорителей NVIDIA GB300 с интерконнектом NVIDIA InfiniBand. Эти ИИ ЦОД предоставят надёжную базовую инфраструктуру для обучения и развёртывания суверенных ИИ-моделей, что позволит Саудовской Аравии и другим странам ускорить инновации и цифровую трансформацию, отмечено в пресс-релизе. Сообщается, что Humain также развернёт платформу NVIDIA Omniverse, что позволит таким отраслям, как производство, логистика и энергетика, создавать полностью интегрированные цифровые двойники, повышая эффективность, безопасность и устойчивость производств, а также ускоряя движение страны к «Индустрии 4.0». Также было объявлено о партнёрстве Humain с AMD, в рамках которого будет инвестировано в течение пяти лет до $10 млрд в развертывание в стране ИИ-инфраструктуры мощностью 500 МВт. «Вместе мы создаём глобально значимую ИИ-платформу, которая обеспечивает производительность, открытость и охват на беспрецедентном уровне», — заявила генеральный директор AMD Лиза Су (Lisa Su). Предполагается, что часть мощностей будет введена в эксплуатацию в 2026 году. Humain будет предоставлять услуги клиентам, а AMD — поставлять чипы и ПО. Также Humain подписала соглашение о сотрудничестве с AWS с целью реализации проекта по созданию «Зоны ИИ» (AI Zone) в Саудовской Аравии стоимостью $5 млрд, пишет TechCrunch. Зона будет включать специализированную ИИ-инфраструктуру AWS, серверы, сети. Упомянуты и программы обучения и сертификации. Humain сообщила о планах разрабатывать решения в области ИИ с использованием технологий AWS и работать с AWS над предоставлением доступа к инструментам и ПО для ИИ-стартапов из Саудовской Аравии. Саудовская Аравия обязала компании и ИИ-сервисы хранить данные на территории королевства, стимулируя провайдеров размещать свои объекты в стране, чтобы не потерять имеющиеся контракты. В частности, Google и Oracle объявили о планах по расширению присутствия в регионе. Ранее страна ообъявила о $14,9 млрд инвестиций в ИИ-сектор.

13.05.2025 [15:13], Руслан Авдеев

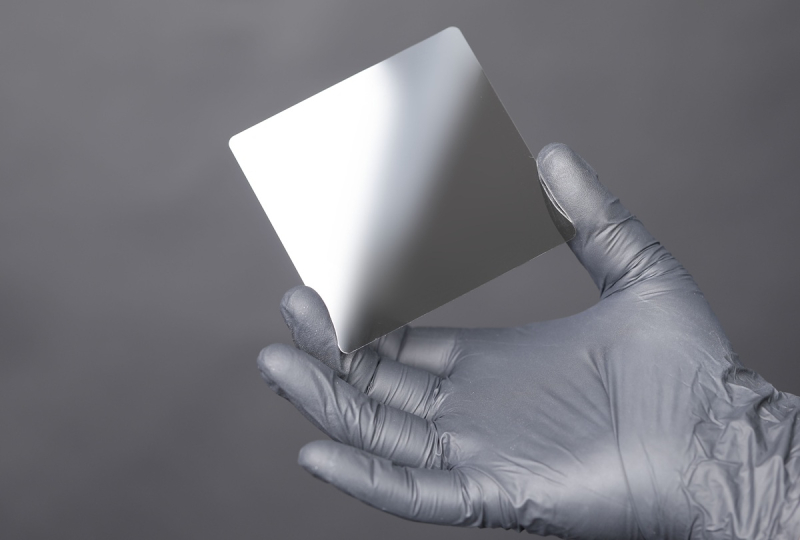

Western Digital стала ключевым спонсором революционных керамических накопителей CerabyteРазрабатывающая инновационные керамические накопители данных компания Cerabyte объявила о получении стратегических инвестиций от Western Digital. Ожидается, что данные меры позволят ускорить развитие технологии, позволяющей надёжно хранить данные в течение 5 тыс. лет, сообщает Tom’s Hardware. Cerabyte была основана в Германии, а позже открыла офисы в Калифорнии и Колорадо. Директором компании стал Стеффен Хеллмолд (Steffen Hellmold), до этого несколько лет занимавший пост вице-президента Western Digital по корпоративной стратегии. Ожидается, что он поможет Cerabyte в коммерциализации продукта. Технология Cerabyte не только рассчитана на постоянную эксплуатацию, но и способна обеспечить хранение данных в немыслимых ранее масштабах. Информация записывается лазером в виде наноуглублений, формирующих подобие QR-кодов: заявленная скорость достигает 2 млн бит на лазерный импульс. По заявлениям разработчика, технология до 2030 года позволит добиться вместимости до 100 Пбайт на стойку при использовании фирменных картриджей CeraMemory.

Источник изображения: Cerabyte Как заявили в Western Digital, компания с нетерпением ждет технологического партнёрства Cerabyte для коммерциализации технологии. Инвестиции в Cerabyte соответствуют приоритетам компании по расширению использования её продукции в системах долгосрочного хранения данных. В самой Cerabyte подчёркивают, что рады сотрудничать с Western Digital, поскольку это расширит возможности масштабирования технологий стартапа. Не так давно Cerabyte продемонстрировала устойчивость своих накопителей — она кипятила их в солёной воде, прожаривала в духовых шкафах и пр. Керамическая поверхность защищена от температур и огня, влаги и воды, ультрафиолета, радиации и электромагнитных импульсов, говорит компания.

Источник изображения: Cerabyte Уже к 2030 году Cerabyte рассчитывает снизить стоимость хранения до менее $1/Тбайт — для современных альтернатив цена совершенно недостижимая. Как сообщает Blocks & Files, прототипы носителей были созданы в 2023 году, а теперь компания работает с партнёрами над созданием коммерческого продукта вроде автоматизированной библиотеки с пластинами и развитием производственных мощностей. Cerabyte уже сумела заинтересовать PureStorage, занимающейся All-Flash СХД, а также In-Q-Tel, инвестирующую в технологии в интересах ЦРУ и других структур. Более того, в конце 2024 года компания получила поддержку от Европейского совета по инновациям.

13.05.2025 [13:53], Сергей Карасёв

Анонсирован настольный ИИ-суперкомпьютер MSI EdgeXpert MS-C931 на базе NVIDIA DGX SparkКомпания MSI анонсировала устройство EdgeXpert MS-C931 — так называемый ИИ-суперкомпьютер в «настольном» формате. В основу решения положена платформа NVIDIA DGX Spark. Компьютер заключён в корпус с габаритами 151 × 151 × 52 мм, а масса составляет около 1,2 кг. Задействован суперчип Grace Blackwell GB10, который объединяет ускоритель Blackwell и процессор Grace с 20 ядрами Arm в виде связки 10 × Arm Cortex-X925 и 10 × Arm Cortex-A725. Производительность достигает 1000 TOPS на операциях FP4. Питается новинка от внешнего БП мощностью около 240 Вт. В оснащение EdgeXpert MS-C931 входят 128 Гбайт памяти LPDDR5x, M.2 NVMe SSD вместимостью до 4 Тбайт, контроллеры Wi-Fi 7 и Bluetooth 5.3, сетевой адаптер NVIDIA ConnectX-7 SmartNIC. Разъёмы сосредоточены в тыльной части: это четыре порта USB 3.2 Type-С (до 20 Гбит/с), гнездо RJ45 (10GbE), интерфейс HDMI 2.1a, а также два порта для объединения нескольких устройств в кластер.

Источник изображения: MSI Используется программная платформа NVIDIA DGX OS — модификации Ubuntu, адаптированной для работы с ИИ. Утверждается, что устройство может использоваться для решения таких задач, как настройка ИИ-моделей, насчитывающих до 70 млрд параметров, инференс, тестирование приложений ИИ и пр. Кроме того, EdgeXpert MS-C931 подходит для использования на периферии — например, в составе систем машинного зрения или робототехнических комплексов. Среди основных категорий пользователей названы разработчики, специалисты в области данных и исследователи в сфере ИИ.

13.05.2025 [09:16], Руслан Авдеев

Microsoft надеется, что ИИ ускорит создание термоядерных реакторов, которые смогут запитать ещё больше ЦОД для ИИВ Microsoft уверены, что искусственный интеллект способен помочь ускорить разработку экономически эффективных коммерческих термоядерных реакторов, которые смогут обеспечить энергией сами ИИ ЦОД, сообщает The Register. Пока что ни одного такого реактора не существует. По словам Microsoft Research, стремление использовать ядерный синтез как источник безграничной и чистой энергии «уже давно является одной из самых амбициозных научных целей человечества». Исследователи подчёркивают, что до появления масштабируемой термоядерной энергетики ещё много лет, но уже сейчас изучается вопрос, как ИИ мог бы помочь ускорить разработки. На первом саммите Microsoft Research Fusion Summit, посвящённом термоядерному синтезу, представитель Microsoft Research Accelerator подчеркнул перспективность использования ИИ для дальнейших исследований в области обеспечения экоустойчивости. В настоящее время ИИ-технологии экоустойчивыми не считаются. ООН в прошлому году отмечала, что ИИ ЦОД генерируют электронные отходы, потребляют много воды, критически важных минералов и редкоземельных элементов, при добыче которых также нередко применяют не особенно экобезопасные технологии. И, главное, такие ЦОД используют огромное количество электроэнергии, стимулируя выбросы парниковых газов. Microsoft пытается компенсировать воздействие ЦОД на окружающую среду углеродными кредитами, покупкой «чистой» энергии, оптимизацией оборудования и ПО. Ускоренное развитие технологий ядерного синтеза могло бы компенсировать воздействие бизнеса компании на экологию. По словам представителя Принстонской лаборатории физики плазмы (Princeton Plasma Physics Laboratory, PPPL) Стивена Коули (Steven Cowley), выступившего на Fusion Summit с основным докладом, необходимы дополнительные исследования, чтобы понять, является ли ИИ ключевым звеном для поиска оптимальных решений в термоядерной энергетике. Впрочем, придётся запастись терпением — считается, что до запуска экспериментальных термоядерных установок в эксплуатацию пройдёт не менее десятилетия. Как считают в Национальных академиях наук, инженерии и медицины США (National Academies of Sciences, Engineering, and Medicine, NASEM), частные и государственные инвестиции позволят создать пилотную термоядерную электростанцию 2035–2040 гг. Это приблизительно совпадает с планируемой датой начала работы международного проекта ITER (International Thermonuclear Experimental Reactor). Microsoft надеется, что её наработки в области ИИ для материаловедения, для решения дифференциальных уравнений и для других исследовательских задач помогут найти способ экономически эффективного термоядерного синтеза. Лаборатория Коули уже заключила меморандум о взаимопонимании с Microsoft. Учёные уверены, что ИИ поможет сократить время разработок необходимого профиля. Во всяком случае ИИ является хорошей альтернативой десятилетиям разработки методом проб и ошибок. Microsoft не одинока в своих стремлениях. Например, разработчик атомных технологий Type One Energy и государственная компания Tennessee Valley Authority (TVA) заключили соглашение о совместной разработке планов строительства термоядерной электростанции. OpenAI намерена закупать термоядерную энергию у компании Helion в «огромных объёмах». Последняя в конце января привлекла $425 млн.

12.05.2025 [20:55], Владимир Мироненко

«Давайте нам деньги и вычислительные ресурсы и не путайтесь под ногами»: OpenAI и Microsoft пытаются договориться о продолжении сотрудничества на фоне роста амбиций стартапаВ прессе появились сообщения о переговорах между OpenAI и Microsoft по поводу пересмотра условий их дальнейшего партнёрства. В то время как OpenAI ищет пути для выхода на IPO, стремясь привлечь больше финансирования, необходимого для обеспечения разработки более мощного ИИ, Microsoft рассчитывает и в дальнейшем иметь доступ к новейшим разработкам создателя ChatGPT, пишет The Financial Times со ссылкой на информированные источники. Существующий контракт OpenAI и Microsoft был подписан в 2019 году, когда Microsoft инвестировала в стартап $1 млрд. В общей сложности софтверный гигант инвестировал в OpenAI более чем $13 млрд, получая взамен доступ к интеллектуальной собственности, а также долю дохода продаж продуктов. Действие контракта истекает в 2030 году. Microsoft хотела бы и в дальнейшем иметь доступ к новейшим разработкам OpenAI, ради чего готова пожертвовать частью своей доли доходах OpenAI, сообщили источники The Financial Times.

Источник изображения: Headway / Unsplash Стартап был создан как некоммерческая организация, что стало препятствием для расширения его финансирования. Компания не скрывает намерений перейти на коммерческие рельсы, однако решила изменить подход. На прошлой неделе OpenAI объявила об отказе от разделения на некоммерческое и коммерческое подразделения, выбрав вместо этого реструктуризацию бизнес-подразделения в корпорацию общественного блага (PBC). Это позволит ему привлекать инвестиции, не меняя социальные приоритеты. Данной корпоративной модели придерживаются Anthropic и xAI. Это также даст возможность OpenAI по-прежнему предлагать инвесторам долю в бизнесе. По словам источника, изменение является ключевым требованием инвесторов, и оно гарантирует, что «IPO станет возможным» в будущем. Но для реализации этого плана также требуется одобрение Microsoft, крупнейшего финансового спонсора OpenAI. Переговоры между OpenAI и Microsoft осложняются охлаждением между компаниями, поскольку с момента начала их партнёрства амбиции стартапа выросли, сейчас он параллельно работает с её конкурентами — SoftBank и Oracle — для создания собственной обширной ИИ-инфраструктуры Stargate стоимостью сотни миллиардов долларов. Один из топ-менеджеров раскритиковал OpenAI за высокомерие. «Отчасти трения возникают из-за стиля. OpenAI говорит Microsoft: ”Давайте нам деньги и вычислительные ресурсы и не путайтесь под ногами: будьте счастливы работать с нами". Естественно, это приводит к напряжённости», — отметил он. Вместе с тем в Microsoft сохраняют оптимизм по поводу того, что стороны уладят разногласия и придут к соглашению.

Источник изображения: Headway / Unsplash Разработка ИИ-технологий предполагает громадные расходы. В октябре прошлого года OpenAI привлёк $6,6 млрд от SoftBank, Microsoft и венчурных капиталистов, включая Thrive Capital и Altimeter Capital. В марте он получил ещё $40 млрд в раунде финансирования, возглавляемом SoftBank, причём в контрактах инвесторов оговорено, какой капитал они получат, когда OpenAI преобразуется в новую структуру. Инвесторы имеют возможность вернуть часть или все вложенные ими средства, если OpenAI не сможет стать коммерческой корпорацией. Вместе с тем в OpenAI уверены, что инвесторы сохранят приверженность компании, даже если реструктуризация будет отложена по каким-либо причинам. По словам источника, требование о преобразовании в более традиционную коммерческую структур является «признанием на высоком уровне того, что это требуется для привлечения такой суммы денег». Он добавил, что привлечение «$40 млрд в рамках структуры с ограниченной прибылью недостижимо». Даже в случае положительного исхода переговоров с Microsoft, стартап ожидают дополнительные препятствия. В понедельник OpenAI пообещал, что его бизнес-подразделение будет контролироваться некоммерческим советом, предоставив совету существенную долю в акционерном капитале корпорации общественного блага и право назначать его директоров.

Источник изображения: Headway / Unsplash Но критики считают, что OpenAI ставит под угрозу свою миссию, ставя прибыль выше остального. В частности, Маск, покинувший OpenAI после ссоры с главой OpenAI Сэмом Альтманом (Sam Altman), пообещал продолжить судебные разбирательства, чтобы заблокировать любую корпоративную реструктуризацию. Комментируя решение OpenAI провести преобразование в PBC, адвокат Маска Марк Тоберофф (Marc Toberoff) заявил агентству Bloomberg, что это ничего меняет. «Благотворительная организация по-прежнему передаёт свои активы и технологии частным лицам ради личной выгоды — включая Сэма Альтмана — и при этом переводит всю фактическую работу благотворительной организации по ИИ/AGI в гигантскую коммерческую корпорацию», — отметил он. Кроме того, OpenAI предстоит убедить власти Калифорнии и Делавэра — штатов, в которых находится её штаб-квартира и зарегистрирована организация, — что данное предложение будет соответствовать миссии компании по принесению пользы обществу. Генеральный прокурор штата Делавэр Кэти Дженнингс (Kathy Jennings) заявила о планах проверить намеченную реструктуризацию OpenAI на предмет соответствия законодательству Делавэра и благотворительным целям, а также то, что в новой структуре некоммерческая организация сохранит надлежащий контроль над коммерческой. Провал нового плана по реструктуризации может больно ударить по OpenAI, предупреждают эксперты, поскольку стартап не сможет привлекать больше денег, добиваться будущего размещения акций и получать финансовые ресурсы для оказания конкуренции крупным технологическим компаниям, таким как Google.

12.05.2025 [17:27], Владимир Мироненко

Облако.ру предлагает ИИ-системы, которые позволят запускать даже мощные ИИ-моделиВедущий российский поставщик решений для облачной инфраструктуры Облако.ру предлагает различные специализированные интегрированные решения для обработки ресурсоёмких нагрузок, включая обучение и запуск ИИ-моделей. GPU-серверы, доступные в Облако.ру, отлично справляются со сложными задачами с использованием больших объёмов данных и вычислений. Использование услуг по аренде вычислительных мощностей позволяет избежать существенных капитальных затрат. Главное отличие GPU от CPU заключается в его способности параллельно выполнять множество операций, распределяя задачи между своими ядрами, что предоставляет ему возможность выполнения громадных объёмов вычислений, лежащих в основе ИИ, в гораздо более короткие сроки и обеспечивает значительное преимущество в таких областях, как обработка изображений и видео, научное моделирование, машинное обучение, где используются большие наборы данных и сложные алгоритмы. Изначально созданные для обработки изображений GPU стали крайне важными для ИИ-индустрии, позволяя обучать и развёртывать продвинутые ИИ модели, обеспечивающие широкие возможности в сфере ИИ — от распознавания изображений до обработки естественного языка. Благодаря ускорению процессов обучения и инференса использование серверных GPU позволяет разрабатывать и развёртывать модели ИИ быстрее и эффективнее, чего невозможно добиться, используя только классические CPU. А по мере роста сложности ИИ-моделей потребность в GPU будет только расти. Так, для локального запуска компактной версии популярной ИИ-модели DeepSeek R1 8B, разработанной посредством дистилляции нейросеть Llama 3.2 и демонстрирующей высокую эффективность в задачах текстовой генерации, обработки естественного языка, создания программного кода и анализа данных, потребуется система с 4 Гбайт VRAM (видеопамяти) для инференса с низкой и целочисленной точностью вычислений (FP8/INT8), 8 Гбайт VRAM для инференса с половинной точностью (FP16) и 16 Гбайт VRAM для инференса с полной точностью (FP32). Точность вычислений влияет на качество и скорость ответов ИИ-модели. Если же использовать DeepSeek R1 8B в качестве основы для собственных моделей, ориентированных на конкретные бизнес-задачи, то при обучении с низкой и целочисленной точностью (FP8/INT8) потребуется система с 8 Гбайт VRAM, при обучении с половинной точностью (FP16) — с 16 Гбайт VRAM, а и при обучении с полной точностью (FP32) — с 32 Гбайт VRAM. С увеличением количества параметров модели, определяющих её «эрудицию» и знания о мире или предметной области, одновременно растут и требования к доступной памяти и вычислительной мощности GPU. Кроме того, т.н. размышляющие модели, к которым относится и семейство DeepSeek R1, тем лучше и оперативнее отвечают на запросы, чем больше им доступно ресурсов. Предлагаемые Облако.ру системы позволяют запускать не только базовые модели уровня DeepSeek R1 8B, которым требуется 8–12 Гбайт VRAM, но и более мощные ИИ-модели, такие как DeepSeek R1 14B, которая подходит для большинства профессиональных рабочих процессов. DeepSeek R1 14B, содержащая 14 млрд параметров и созданая с помощью метода дистилляции модели Qwen 2.5, предназначена для решения сложных задач, требующих высокой точности и производительности, таких, как написание сложных текстов, анализ больших объёмов данных, написание кода уровня Senior и т.д. Для инференса с использованием DeepSeek R1 14B с низкой и целочисленной точностью (FP8/INT8) потребуется система с 7 Гбайт VRAM, с полной точностью (FP32) — с 28 Гбайт VRAM. Для обучения с низкой и целочисленной точностью (FP8/INT8) требуется система с 14 Гбайт VRAM, с половинной точностью (FP16) — с 28 Гбайт VRAM, с полной точностью (FP32) — с 56 Гбайт VRAM. Облако.ру предлагает различные системы с серверными GPU, которые способны удовлетворить нужды практически любого заказчика. Доступны системы с самыми простыми ускорителями NVIDIA T4, с ускорителями среднего класса 3 × RTX6000 (суммарно 72 Гбайт) и с ускорителями топового уровня. К последним относятся конфигурации сразу с восемью PCIe-ускорителями с суммарным объёмом памяти 640 Гбайт, 1 Тбайт системной памяти и парой 24-ядерных AMD EPYC 9224. А для самых требовательных заказчиков предлагается платформа с восемью ускорителями, объединёнными быстрой шиной (900 Гбайт/с) и 1128 Гбайт VRAM, которые работают как единое целое. Компанию им составляют два 48-ядерных Intel Xeon Platinum 8558 и 2 Тбайт RAM. При этом во всех случаях речь идёт именно о физических серверах, что гарантирует полную доступность всех вычислительных ресурсов.

10.05.2025 [14:59], Руслан Авдеев

xAI может построить 1,56-ГВт газовую электростанцию для очередного ИИ-суперкомпьютераЭкоактивисты уверены, что компания xAI, основанная Илоном Маском (Elon Musk), может построить электростанцию на природном газе для нового дата-центра в Мемфисе. Мощность электростанции составит 1,56 ГВт, а состоять она будет из десятков газовых турбин, сообщает Datacenter Dynamics. Согласно мартовскому отчёту агентства Trinity Consultants, подготовленному для xAI, возможно развёртывание 40–90 газовых турбин на Тулейн-роуд (Tulane Road) мощностью до 1,56 ГВт в одном из районов Мемфиса — данные получены экогруппой Southern Environmental Law Center (SELC). Ранее местная коммунальная компания Memphis, Light, Gas and Water (MLGW) заявляла, что xAI пока не подала заявку на электроснабжение объекта, но изучила несколько вариантов присоединения в диапазоне от 260 МВт до 1,1 ГВт. По данным отчёта Trinity, новая электростанция сможет применять два вида турбин Solar Turbines — PGM-130 и Solar Titan 350. По словам юристов SELC, xAI, вероятно, готовится к установке «ошеломляющего» количества загрязняющих воздух генераторов для второго ЦОД компании в Южном Мемфисе, одновременно эксплуатируя поблизости турбины, разрешение для которых вообще не получено. Деятельность xAI в Мемфисе неоднократно вызывала споры в городе с момента открытия в нём первого ЦОД на территории бывшего завода Electrolux, где разместился суперкомпьютер Colossus. Пока местный бизнес приветствовал появление компании в городе и тот стимул, который она обеспечит экономике Мемфиса, местные жители начали выражать обеспокоенность возможным влиянием на доступность электроэнергии и воды, а также влиянием объекта на качество воздуха. Для питания Colossus компания разместила 35 газовых турбин общей мощностью 422 МВт. По данным местных властей, примерно половина из них будет демонтирована в течение двух месяцев. Остальные продолжат функционировать до ввода в эксплуатацию второй подстанции на 150 МВт осенью 2025 года, после чего турбины переведут в резервную систему питания. Таким образом, власти косвенным образом признали, что xAI действительно воспользовалась лазейкой в законах, развернув 35 турбин вместо изначально разрешённых 15. От имени xAI было объявлено, что компания выводит из эксплуатации турбины в округе Шелби и не имеет планов размещения турбин на площадке в районе Тулейн-роуд. Компания продолжит рассматривать энергетические решения для объектов в Мемфисе с учётом всех применимых нормативных ограничений. Впрочем, ей никто не мешает снова повторить трюк с размещением нужного количества генераторов.

10.05.2025 [10:07], Сергей Карасёв

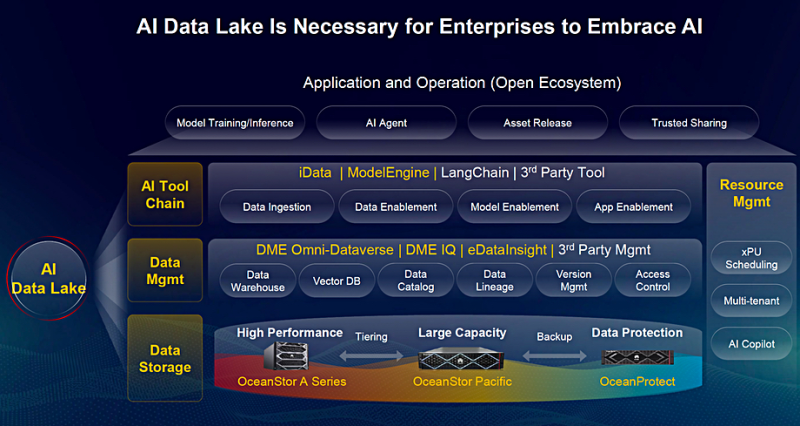

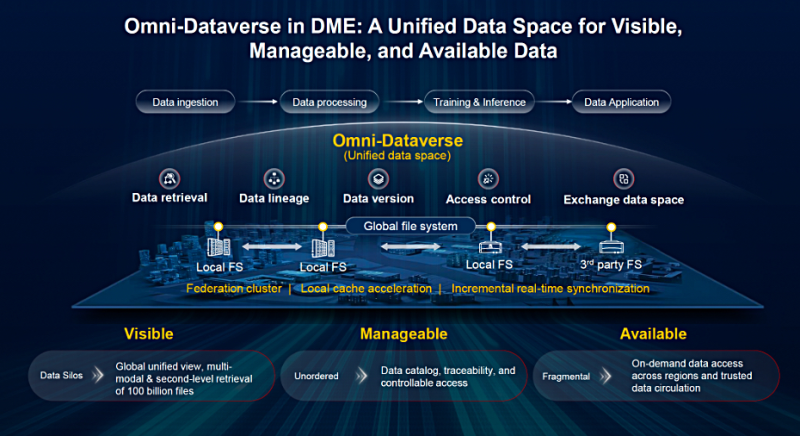

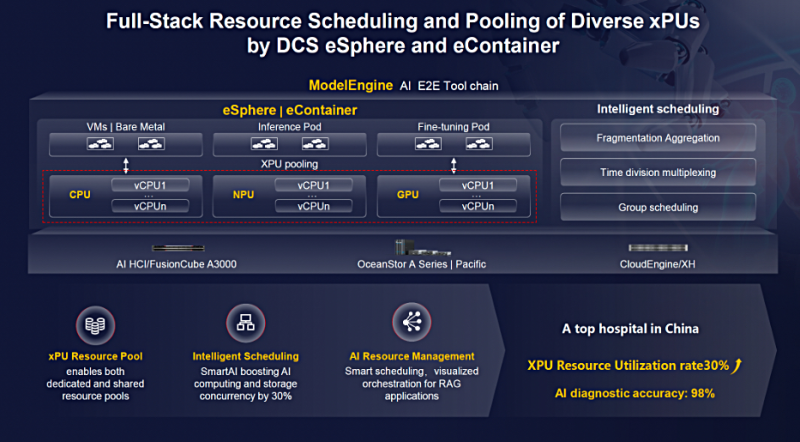

Huawei представила комплексную платформу хранения и обработки ИИ-данныхКомпания Huawei на форуме Innovative Data Infrastructure (IDI) в Мюнхене (Германия) анонсировала решение AI Data Lake для хранения и обработки данных, призванное ускорить внедрение ИИ в различных отраслях. Платформа ориентирована на обучение больших языковых моделей (LLM), инференс и другие нагрузки. Аппаратная составляющая AI Data Lake предполагает использование СХД трёх типов: Huawei OceanStor A Series для быстрого доступа к информации, Huawei OceanStor Pacific для Nearline-хранения с динамическим распределением по уровням и Huawei OceanProtect для резервного копирования из системы Pacific. В частности, OceanProtect E8000 вмещает до 16 Пбайт данных с пропускной способностью до 255 Тбайт/ч. Поверх аппаратного массива работают два программных уровня — слой управления данными и слой инструментов ИИ. Уровень управления базируется на движке Data Management Engine (DME) и включает три продукта: DME Omni-Dataverse, DME IQ и eDataInsight. Они отвечают за такие векторные БД, каталог данных, управление версиями, контроль доступа и пр. Omni-Dataverse — глобальная файловая система и фреймворк управления данными для устранения разрозненности информации в географически распределённых ЦОД: достигается это путём предоставления единого пространства имён. Иными словами, формируется единый виртуальный репозиторий (озеро данных), который охватывает несколько отдельных хранилищ в публичном облаке, на площадке клиента или в гибридной среде. Omni-Dataverse предоставляет средства для получения, индексации, обработки данных и их предоставления для обучения LLM, инференса и других задач. По заявлениям Huawei, система способна индексировать и/или извлекать наборы данных в масштабе экзабайт. Возможна обработка более 100 млрд файлов за считаные секунды с использованием более 15 критериев поиска. Omni-Dataverse поддерживает динамическое распределение данных между СХД OceanStor A Series и OceanStor Pacific. Устаревшие и неиспользуемые файлы удаляются. DME IQ — это облачная система на базе аналитики больших данных и AIOps для автоматизированного оповещения о неполадках и отслеживания проблем в режиме реального времени. В свою очередь, программный уровень ИИ-инструментов предназначен для предоставления наборов данных из хранилища для обработки различными аппаратными движками: Huawei iData, ModelEngine и др. Концепция виртуализации дата-центра DCS (Data Center Solution) объединяет вычисления, хранение, сетевые технологии и управление. Задействованы средства eSphere с использованием Omni-Dataverse для доступа к единому глобальному пространству имен.

10.05.2025 [09:45], Руслан Авдеев

NVIDIA ослабит и без того урезанные ускорители H20, чтобы вернуть возможность поставок в КитайNVIDIA планирует представить искусственно ухудшенные версии ИИ-ускорителей H20 для Китая в ближайшие пару месяцев. Это позволит обойти экспортные ограничения, введённые в отношении исходной модели, сообщает Reuters со ссылкой на три источника, знакомых с вопросом. По информации двух из них, американский производитель чипов уведомил ключевых китайских покупателей, включая ведущих облачных провайдеров, что намерен представить модифицированную версию H20 в июле. Это последняя из попыток NVIDIA сохранить присутствие на китайском рынке, являющемся для компании одним из ключевых — при этом официальный Вашингтон всеми силами стремится ограничить доступ Поднебесной к передовым полупроводниковым технологиям. До недавнего времени H20 были самыми производительными ИИ-чипами, допущенными американскими властями к продаже в Китай, но в прошлом месяце компанию уведомили, что на их поставки в страну потребуется специальная экспортная лицензия, что фактически означает запрет массовых продаж. Правда, многие компании из КНР успели сделать большие запасы H20.

Источник изображения: NVIDIA NVIDIA уже подготовила новое техническое задание на новую версию чипов. В результате H20 будут значительно ослаблены, в частности, по словам одного из источников, новинкам уменьшат ёмкость памяти. Правда, один из источников сказал, что потребители смогут перенастраивать модули для изменения производительности чипа. В самой NVIDIA новость не комментируют, как и в Министерстве торговли США. В минувшем фискальном году, закончившемся 26 января, на рынок Китая приходилось $17 млрд или 13 % общей выручки NVIDIA, а в прошлом году глава компании Дженсен Хуанг (Jensen Huang) лично засвидетельствовал важность китайского рынка, нанеся в страну визит — всего через несколько дней после того, как американские власти анонсировали новые торговые ограничения, касавшиеся поставок H20. В ходе встреч с китайскими чиновниками он подчеркнул важность рынка страны для компании. Стоит отметить, что это не первое искусственное ухудшение чипов, инициированное американскими властями. Ранее NVIDIA пришлось представить модели A800 и H800 вместо A100 и H100, а позже, в октябре 2023 года их тоже посчитали слишком производительными и появилась модель H20. На фоне роста спроса на ИИ-решения ключевые китайские IT-гиганты вроде Tencent, Alibaba и ByteDance нарастили закупки для использования эффективных ИИ-моделей компаний вроде DeepSeek. По данным Reuters, с января NVIDIA получила заказы на H20 на сумму $18 млрд. Впрочем, в марте сообщалось, что H20 не соответствуют новым китайским требованиям к энергоэффективности ИИ-ускорителей и местные бизнесы негласно вынуждают применять отечественные, китайские решения вроде Ascend 910B. Для Huawei это шанс закрепиться на рынке, компания уже готовит ускорители Ascend 910D и 920.

09.05.2025 [14:04], Сергей Карасёв

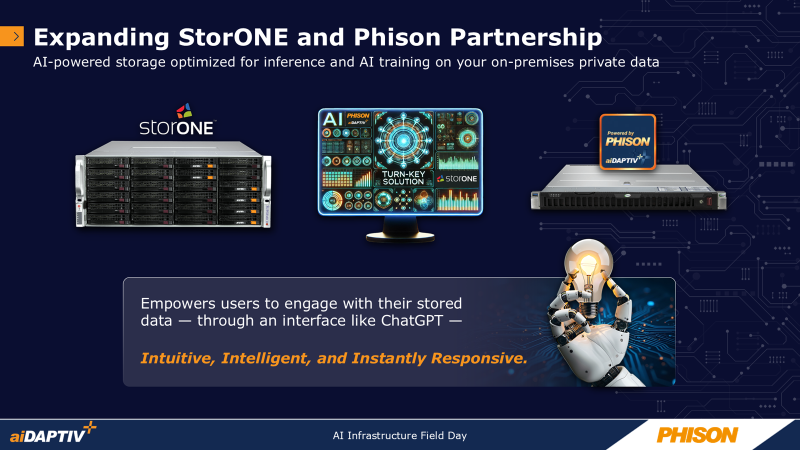

StorONE и Phison предложат СХД для ИИ-задач, с которой можно будет поговоритьКомпании StorONE и Phison объявили о расширении стратегического сотрудничества с целью создания новой платформы хранения данных для локальных развёртываний. Речь идёт о системе, оптимизированной для различных ИИ-задач, таких как разработка больших языковых моделей (LLM), их обучение и инференс в режиме реального времени. В рамках партнёрства будет осуществлена интеграция технологии Phison aiDAPTIV+ с высокопроизводительной программно-определяемой платформой хранения StorONE. Система aiDAPTIV+ позволяет «расширять» память GPU-ускорителей путём использования системной памяти и SSD. Благодаря этому компании могут закупать меньшее количество GPU, что снижает входные барьеры для локального использования LLM. Совместное решение StorONE и Phison обеспечит возможность развёртывания ИИ СХД на площадках клиентов, что важно для отраслей, где большое значение имеет конфиденциальность информации: здравоохранение, финансы, государственное управление и пр. Благодаря технологии aiDAPTIV+ компании и организации смогут использовать в собственных ЦОД крупные модели ИИ. При этом встроенный чат-бот поможет в управлении и оптимизации конфигурации хранилища: делать запросы и отдавать команды пользователи смогут на естественном языке. Ожидается, что первое интегрированное решение в рамках партнёрства станет доступно во II квартале текущего года. Оно объединит массивы хранения данных с высокой пропускной способностью StorONE и усовершенствованную систему aiDAPTIV+. Ключевыми сферами применения названы локальное обучение LLM, мультимодальный ИИ и генеративные приложения. |

|