Материалы по тегу: ии

|

17.06.2025 [12:27], Руслан Авдеев

AWS готовит крупнейшие в истории Австралии инвестиции в ЦОД, ИИ и облакоВ ближайшие четыре года AWS обязалась потратить AU$20 млрд (US$13 млрд) на инфраструктуру дата-центров в Австралии. Это крупнейшие инвестиции в технологическую сферу страны за всю её историю из числа заявленных публично, сообщает Tech Republic. Для того, чтобы инициативы Amazon соответствовали местным энергетическим требованиям, компания планирует реализовать три солнечных энергопроекта в провинциях Виктория и Квинсленд (Victoria и Queensland) общей мощностью более 170 МВт. Проекты будут управляться датской компанией European Energy, занимающейся «зелёной» энергетикой. Расширение инфраструктуры должно помочь удовлетворить спрос на ИИ и облачные вычисления в Австралии. По мнению экспертов, технологии автоматизации будут добавлять в австралийский ВВП к 2030 году по AU$600 млрд ежемесячно, а облачные вычисления принесут ещё AU$81 млрд в 2024–2029 гг. AWS говорит, что инвестиции в Австралии обеспечат доступ к ИИ и облачным сервисам местным компаниями, что позволит модернизировать ведение бизнеса, повысить продуктивность и т. п. с соблюдением требований местных регуляторов. Также компания продолжит поддержку образовательных программ для подготовки новых кадров для работы с ИИ и облаками.

Источник изображения: Caleb/unspalsh.com По данным издания, несмотря на высокие позиции в глобальных рейтингах конкурентоспособности, Австралия демонстрирует низкий уровень развития предпринимательства. Эксперты связывают это с различными факторами, в том числе — довольно простой экономикой, ограниченным ассортиментом продукции и низкой «технологичностью» экспортируемых товаров. Возможно, AWS поможет стране раскрыть свой скрытый потенциал. Впрочем, не все рады попыткам компании захватить рынок. В 2023 году местные парламентарии получили жалобы на то, что доминирующее положение AWS на рынке затрудняет конкуренцию для малого бизнеса. Кроме того, AWS предлагала контракты и тарифы, усложняющие переход к другому оператору. В AWS утверждали, что на деле у неё немало соперников. По словам одного из экспертов, облака AWS «слишком дороги» — некоторые бизнесы попросту исчезли потому, что не смогли оплачивать облачные счета.

Источник изображения: Tobias Keller/unsplash.com Дата-центры AWS также повысят нагрузку на местные электросети, что потенциально вызовет рост цен на электроэнергию. В прошлом году инвестиционный банк UBS предрекал, что к 2030 году в пиковые часы оптовые цены на электричество могут вырасти на 70 %. Проблемой также могут стать отключения электроэнергии, поэтому местный регулятор Australian Energy Market Commission формирует новые правила работы для предотвращения сбоев. Amazon же рассматривает строительство новых солнечных электростанций как способ поддержать новую инфраструктуру. Для того, чтобы компенсировать негативное влияние, Amazon намерена масштабировать своё портфолио в возобновляемой энергетике. В Новом Южном Уэльсе, Квинсленде и Виктории уже функционируют солнечные и ветряные проекты, которые вместе с тремя новыми солнечными электростанциями должны дать AWS более 1,4 ГВт∙ч ежегодно. Австралия — не единственный регион, где AWS активно занимается строительством. Новые ЦОД компания намерена строить в Южной Корее, облачный регион запущен на Тайване и ещё один планируется в Чили.

17.06.2025 [11:15], Руслан Авдеев

SK Group и AWS построят ИИ ЦОД на 60 тыс. ускорителей — крупнейший в Южной КорееКорейская SK Group и Amazon Web Services (AWS) совместно построят ИИ ЦОД в Ульсане (Ulsan, Южная Корея), в 305 км от Сеула. Дата-центр разместят в национальном промышленном комплексе Mipo, объект рассчитан на размещение 60 тыс. ИИ-ускорителей, сообщает Datacenter Dynamics. Хотя это не особенно типичная локация для размещения ЦОД, её выбрали из-за доступа к большим энергетическим мощностям. Дело в том, что поблизости находится ТЭС SK Gas, работающая на сжиженном природном газе. По данным местных СМИ, новый ЦОД будут строить поэтапно. На первом этапе, уже к ноябрю 2027 года, будет обеспечена мощность 41 МВт. К февралю 2029 года она должна вырасти до 103 МВт, а в будущем кампус должны расширить до 1 ГВт. Церемонию торжественного старта проекта запланирована на июнь, а закладка первого камня ЦОД — на август 2025 года. SK Telecom и SK Broadband намерены вложить в ИИ-инициативы ₩3,4 трлн ($2,5 млрд), причём только в совместный проект с AWS готовятся вложить триллионы. По данным СМИ, к 2028 году AWS, в свою очередь, намерена вложить в проект около $4 млрд. По данным SK Group, речь идёт о строительстве крупнейшего в стране ЦОД на сегодняшний день.

Источник изображения: rawkkim/unsplash.com Ранее компания уже объявляла о планах строительства гигаваттных ИИ ЦОД в ключевых регионах на территории страны, но пока неизвестно, входит ли совместная инициатива в их число. Ранее южнокорейские власти объявляли о намерении создать Национальный вычислительный ИИ-центр (National AI Computing Center) на 15 тыс. ускорителей. SK Telecom (SKT) активно развивает связанный с ИИ-бизнес, делая ставку на инфраструктуру (дата-центры, GPU-as-a-Service) и ИИ-сервисы для потребителей и корпоративных клиентов. Несмотря на пока небольшой доход от ИИ-направления (около $115 млн в первом квартале), SKT сотрудничает с международными партнёрами, включая альянс Global Telecom Alliance и американские Anthropic и Lambda. Материнский холдинг SK Group обеспечивает мощную поддержку, имея $88 млрд выручки в прошлом году. В марте 2025 года сообщалось, что SK Telecom займётся созданием ИИ ЦОД совместно с Elice, Schneider Electric и Giga Computing. AWS располагает в Сеуле собственным облачным регионом с четырьмя зонами доступности, запущенными в 2016 году. Также компания строит собственный ЦОД в Согу, Инчхон (Seo-gu, Incheon). В 2021 году компания заявила, что намерена построить объект для сервиса AWS Ground Station в кампусе ЦОД в Сеуле. Также ранее компания уже сотрудничала с SK Telecom в своей зоне Wavelength. Не так давно AWS обязалась потратить $13 млрд на расширение инфраструктуры ЦОД в Австралии и запустила облачный регион на Тайване, а также готовится потратить $4 млрд на создание облачного региона в Чили.

16.06.2025 [17:59], Руслан Авдеев

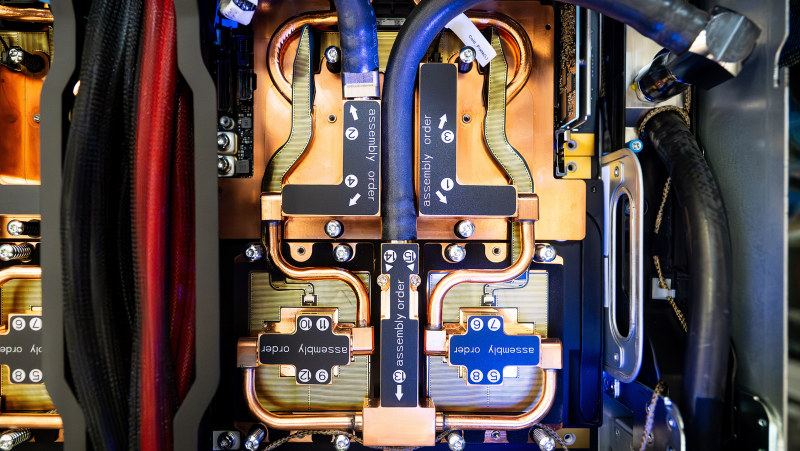

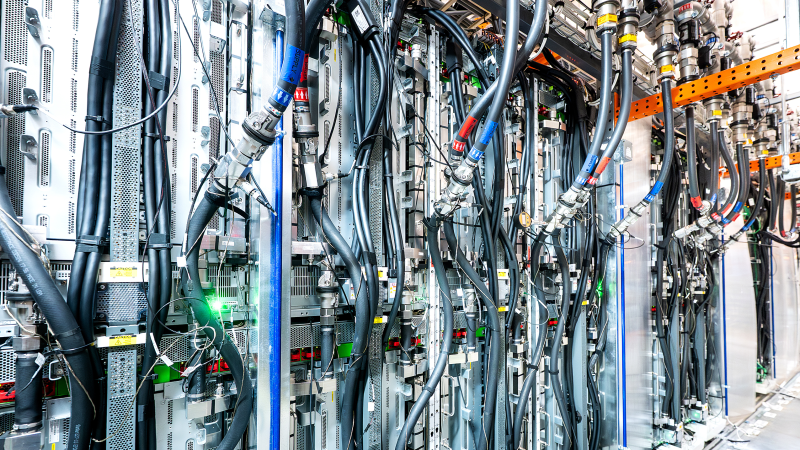

AWS с нуля разработала и начала выпуск собственной СЖО для ИИ ЦОД всего за 11 месяцевAmazon Web Services (AWS) разработала и ввела в эксплуатацию собственную систему жидкостного охлаждения для дата-центров за 11 месяцев — этой быстрый ответ на стремительно растущие запросы всё более мощных ИИ-ускорителей, сообщает пресс-служба компании. Именно охлаждение сегодня переживает революцию: индустрия ЦОД массово переходит с воздушного охлаждения на СЖО, говорит компания. При этом в компании подчёркивают, что цель — не создавать «комфортные» для чипов условия на уровне 20 °C, а защита серверов от перегрева при минимально расходе как воды, так и энергии. Современные ИИ-чипы выделяют очень много тепла, но для повышения производительности их приходится размещать максимально близко друг к другу. В этом случае поток воздуха должен быть столь интенсивным, что классическую схему фрикулинга применять просто неэффективно и дорого. В AWS утверждают, что индустрия миновала порог, после которого использование СЖО выгоднее для теплоотвода. Команда AWS изучила уже имеющиеся на рынке продукты, после чего решила разработать собственный вариант. Было выбрано прямое охлаждение чипов (DLC) — водоблок монтируется непосредственно на ускоритель, через него циркулирует теплоноситель с температурой на уровне «джакузи», отводя тепло к специальной системе для сброса тепла. Цикл замкнутый, т.ч. жидкость циркулирует многократно, не увеличивая расхода воды дата-центром. От формирования концепции до создания готового прототипа прошло четыре месяца. За 11 месяцев AWS завершила проектирование, отрегулировала цепочки поставок, разработала ПО для управления системой, протестировала её и запустила в производство. Важнейшим элементом является собственный модуль распределения жидкости (CDU), который в компании оценивают, как более производительный и экономичный, чем имеющиеся на рынке готовые решения. В AWS подчёркивают, что он сконструирован специально под задачи гиперскейлера, благодаря чему снизились затраты и увеличилась эффективность работ. Первую систему испытали в исследовательском центре AWS, а позже установили в действующем ЦОД. Летом 2025 года должно начаться масштабное внедрение системы — её будут монтировать всё в большем количестве дата-центров компании, с учётом современных потребностей ресурсоёмкой вычислительной инфраструктуры. Ещё в конце 2024 года сообщалось, что Amazon представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную. В частности сообщалось, что новые решения связаны с электропитанием и охлаждением — СЖО предполагалось монтировать даже на уже действующих площадках IT-гиганта. Примечательно, что новые ускорители Tranium 3 действительно требуют эффективных систем охлаждения — их энергопотребление может достигать 1000 Вт.

16.06.2025 [14:45], Руслан Авдеев

Schneider Electric и NVIDIA предложат европейцам модульные ИИ ЦОД с мегаваттными стойкамиSchneider Electric и NVIDIA предложат инфраструктурные решения для предлагаемого Еврокомиссией проекта AI Continent Action Plan, в рамках которого Европу планируется превратить в ИИ-континент, сообщает Datacenter Dynamics. В рамках проекта предполагается потратить €20 млрд ($22 млрд) на ИИ-фабрики, в которых разместятся около 100 тыс. ускорителей нового поколения, в том числе при участии консорциума EuroHPC JU. NVIDIA же заявила, что Европа получит ускорители Blackwell суммарной производительностью более 3000 Эфлопс (точность не указана). «Континентальный» план предусматривает строительство пяти «ИИ-гигафабрик» в ЕС, а также 13 объектов поменьше в рамках частно-государственного финансирования. По словам главы NVIDIA Дженсена Хуанга (Jensen Huang), компания будет строить ИИ-фабрики вместе со Schneider Electric. Речь идёт о ключевой инфраструктуре, которая позволит обеспечить ИИ любую компанию, отрасль промышленности или сферу общественной жизни. Инициатива Schneider Electric и NVIDIA стала своеобразным ответом на план Еврокомиссии, основы взаимодействия были заложены на базе оговоренного ранее неэксклюзивного партнёрства. Schneider и NVIDIA совместно работали над эталонными серверными архитектурами и архитектурами ЦОД с прошлого года, а также над «цифровыми двойниками» в Omniverse. Schneider в рамках партнёрства будет работать над физической инфраструктурой, включающей системы питания и охлаждения, собственно стойки, ПО для индуcтриального оборудования и т.п. Как отмечает The Register, в свете новых договорённостей Schneider пополнила портфолио EcoStruxure, представив готовые модульные блоки (Prefabricated Modular EcoStruxure Pod Data Center), предназначенные для быстрого развёртывания энергоёмких ИИ-кластеров — 1 МВт на стойку и более. Компания предлагает усиленные стойки с увеличенными габаритами и грузоподъёмностью NetShelter SX Advanced Enclosures, а также обновлённые блоки распределения питания с поддержкой высоких мощностей NetShelter Rack PDU Advanced. Кроме того, анонсированы стойки с открытой архитектурой NetShelter Open Architecture, совместимые со стандартами OCP, в том числе с поддержкой кластеров на базе NVIDIA GB200 NVL72. Также предлагаются системы распределения электроэнергии и охлаждения, включая интегрированные в стойки технологии прямого жидкостного охлаждения чипов на базе СЖО Motivair (компания приобрела бизнес в прошлом году). По словам Schneider, рынок ЦОД всё более тяготеет к заранее собранным на заводе модульными решениям. При строительстве таких решений с нуля экономия может составить до 30 % в сравнении с классическими дата-центрами, а внедрение инфраструктуры может проходить намного быстрее.

16.06.2025 [12:21], Руслан Авдеев

Великобритания инвестирует почти $20 млрд в АЭС Sizewell C и множество малых модульных реакторов ради ИИ ЦОДВ свете растущего спроса дата-центров на энергию Великобритании делает ставку на атомную энергетику — правительство анонсировало инвестиции в объёме £14,2 млрд ($19,2 млрд) в строительство АЭС Sizewell C в Суффолке (Suffolk) и малых модульных реакторов (SMR), сообщает The Register. По словам Министерства энергетики, атомная энергетика нужна для достижения «золотого века» с изобилием «чистой» энергии. Это единственный способ защитить финансы, вернуть контроль над национальной энергетикой и справиться с климатическим кризисом. Строительство атомной электростанции к северо-востоку от Лондона одобрено Казначейством Великобритании. Сообщается, что 70 % контрактов в рамках этого проекта получат компании из британской цепочки поставок. Электрическая мощность Sizewell C должна составить около 3,2 ГВт. Помимо этого, правительство выразило приверженность идее строительства малых модульных реакторов. В частности, контракт на строительство выиграл промышленный гигант Rolls-Royce — речь идёт о создании реактора с генерацией 300 МВт электроэнергии — это будет первый из серии подобных SMR. Согласно правительственным данным, когда SMR и станция Sizewell C заработают в 2030-х годах, а в строй будет введена новая электростанция Hinkley Point C, которая сейчас всё ещё достраивается французской EDF, Великобритания будет отдавать в энергосеть больше «новой» атомной энергии, чем в предыдущие полвека. А энергия стране нужна и для электрификации транспорта в ответ на климатические изменения, и для ИИ ЦОД. В мае глава AWS Мэтт Гарман (Matt Garman) заявил, что Великобритании придётся создать новые технологии для обеспечения будущего спроса на электричество, в частности со стороны ИИ ЦОД. По его словам, атомная энергетика — большая часть нового проекта с расчётом на десятилетнюю перспективу. AWS пообещала инвестировать £8 млрд ($10,6 млрд) в Великобритании до конца 2028 года для удовлетворения спроса клиентов и партнёров в облачных сервисах. Группа гиперскейлеров, включающая Amazon, Meta✴ и Google уже заявили, что мир должен утроить генерацию атомной энергии к 2050 году для того, чтобы удовлетворить растущий спрос на электричество и намерены поддерживать соответствующие проекты. Не так давно в Великобритании уже было объявлено о намерении стать «ИИ-сверхдержавой» именно с упором на использование атомной энергетики. Правда, ещё в апреле местные политики и эксперты ломали головы над тем, где именно в кратчайшие сроки взять столько энергетических ресурсов.

16.06.2025 [09:20], Владимир Мироненко

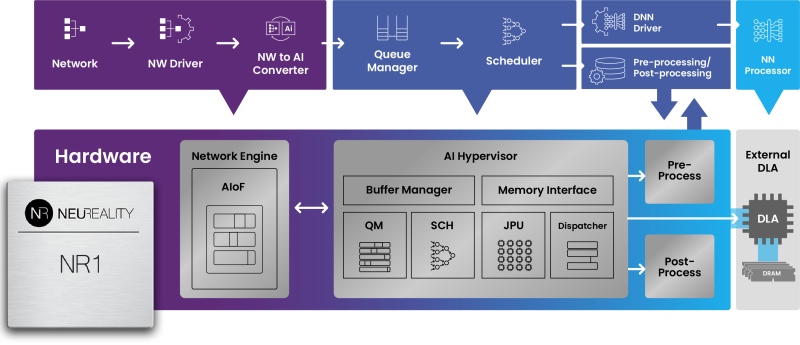

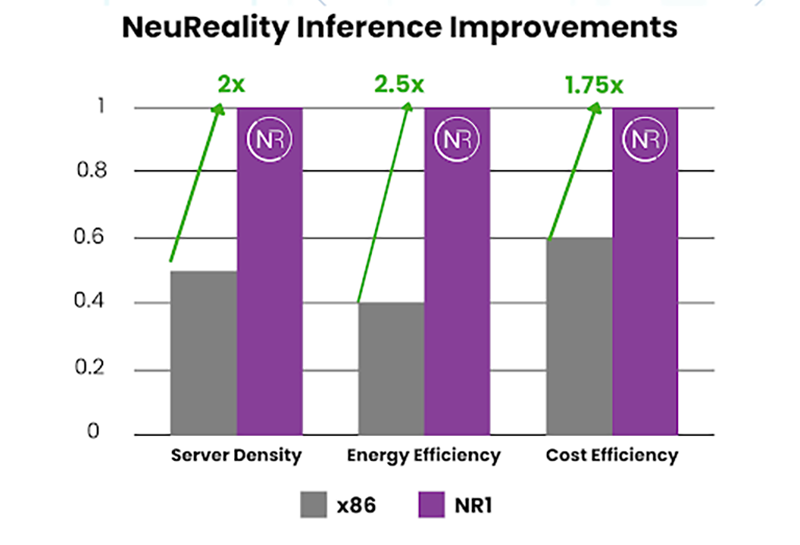

x86 не нужен: «недопроцессор» NeuReality NR1 кратно ускоряет инференс на любых GPUNeuReality объявила о выходе чипа NR1, специально созданного для оркестрации инференса, передаёт HPCwire. Он сочетается с любым GPU или ИИ-ускорителем, позволяя повысить эффективность использование GPU почти до 100 % по сравнению со средним показателем в 30–50 % при традиционном сочетании классического процессора и сетевого адаптера в современных серверах. Чип NR1 призван заменить традиционные CPU и NIC, которые являются узким местом для ИИ-нагрузок, предлагая вместе с тем шестикратное увеличение вычислительной мощности для обеспечения максимальной пропускной способности ускорителей и масштабного ИИ-инференса, утверждает разработчик. Как отметила компания, в течение многих лет разработчики развивали GPU, чтобы соответствовать требованиям ИИ, делая их быстрее и мощнее. Но традиционные CPU, разработанные для эпохи интернета, а не эпохи ИИ, в основном не менялись, становясь узким местом, поскольку ИИ-модели становятся всё более сложными, а запросы ИИ-нагрузок растут в объёме. NR1 включает все базовые функции CPU, необходимые для работы с ИИ-задачами, выделенные обработчики мультимедиа и данных, аппаратный гипервизор и комплексные сетевые IP-блоки, что обеспечивает значительно более высокую производительность, более низкое энергопотребление и окупаемость инвестиций. В тестах самой компании исполнение одной и той же модели на базе генеративного ИИ на одном и том же ИИ-ускорителе её чип NR1 позволяет получить в 6,5 раза больше токенов, чем x86-сервер при той же стоимости и энергопотреблении.  В соответствии с текущей тенденцией на разделение ресурсов хранения и вычислений, дезагрегация ИИ-ресурсов обеспечивает оптимизированную изоляцию ИИ-вычислений, отметила NeuReality. Такое разделение особенно важно в ЦОД и облаках. Традиционные программно-управляемые платформы, ориентированные на CPU, сталкиваются с такими проблемами, как высокая стоимость, энергопотребление и узкие места в системе при обработке задач ИИ-инференса. Сложность современной инфраструктуры и высокая стоимость часто ограничивают использование всех возможностей инференса, утверждает NeuReality. NR1 ориентирован на комплексную разгрузку ИИ-конвейера. Аппаратный ИИ-гипервизор отвечает за обработку путей данных и планирование заданий, охватывая механизмы пред- и постобработки данных, а также сетевой движок AI-over-Fabric. Благодаря этому достигнуто оптимальное соотношение цены и производительности и самые низкие эксплуатационные расходы, характеризующиеся низким энергопотреблением, минимальной задержкой и линейной масштабируемостью, говорит компания. Для DevOps и MLOps компания предоставляет полный SDK и сервисный слой на основе Kubernetes. Новый чип предлагается использовать для решения задач в сфере финансов и страхования, здравоохранении и фармацевтике, госуслугах и образовании, телекоммуникации, ретейле и электронной коммерции, для нагрузок генеративного и агентного ИИ, компьютерного зрения и т.д. NeuReality NR1 включает:

16.06.2025 [08:56], Руслан Авдеев

Meta✴ подписала новое соглашение о поставках геотермальной энергииMeta✴ наращивает использование геотермальной энергии для своих ИИ ЦОД. В Нью-Мексико компания заключила сделку с компанией XGS Energy, разрабатывающей геотермальные технологии нового поколения — они позволяют использовать тепло Земли там, где ранее это было невозможно, сообщает The Verge. Согласно пресс-релизу, в рамках сделки региональная энергосистема, питающая в том числе дата-центры Meta✴, получит дополнительные 150 МВт. Гиперскейлеры отчаянно нуждаются в новых источниках энергии для своих ИИ ЦОД, желательно экологичных. По словам Meta✴, геотермальные технологии нового поколения готовы к масштабированию. ГеоЭС вырабатывают электричество, используя тепло Земли, например, горячей воды и пара из природных резервуаров — для обеспечения работы турбин. При этом удобных для использования источников в США не особенно много, поэтому США получают лишь около 0,5 % энергии из геотермальных источников. Некоторые стартапы пытаются изменить ситуацию, сделав подобную энергию более доступной. В прошлом году Meta✴ заключила сделку на 150 МВт с Sage Geosystems для строительства новых геотермальных электростанций. Sage работает над технологиями извлечения энергии из горячих сухих скальных образований, в которых путём бурения и закачки воды формируются искусственные резервуары. Google сотрудничает со стартапом Fervo, работающим над схожей технологией. XGS Energy тоже намерена использовать горячие сухие породы, но путём формирования закрытого водного контура, который предотвращает утечки закачиваемой воды в скальные трещины — вода фактически циркулирует внутри стальной конструкции. Экономия особенно важна в засушливых штатах вроде Нью-Мексико, где Meta✴ расширяет кампус дата-центров Los Lunas. В Meta✴ отказались раскрыть сумму сделки с XGS, но известно, что компании намерены реализовать проект в два этапа к 2030 году. В своё время Meta✴ обязалась добиться нулевых выбросов к концу десятилетия, но энергоёмкие ИИ ЦОД могут помешать достижению этих целей, если не появится возможности поставлять им более «чистую» энергию. Совсем недавно Meta✴ объявила о намерении получать больше «безуглеродного» электричества, намереваясь помочь поддержать в Иллинойсе жизнь в старой АЭС Clinton Clean Energy Center, принадлежащей Constellation. Впрочем, есть и менее «зелёные» проекты — свой самый крупный ИИ ЦОД в Луизиане Meta✴ запитает от газовых электростанций.

15.06.2025 [23:53], Руслан Авдеев

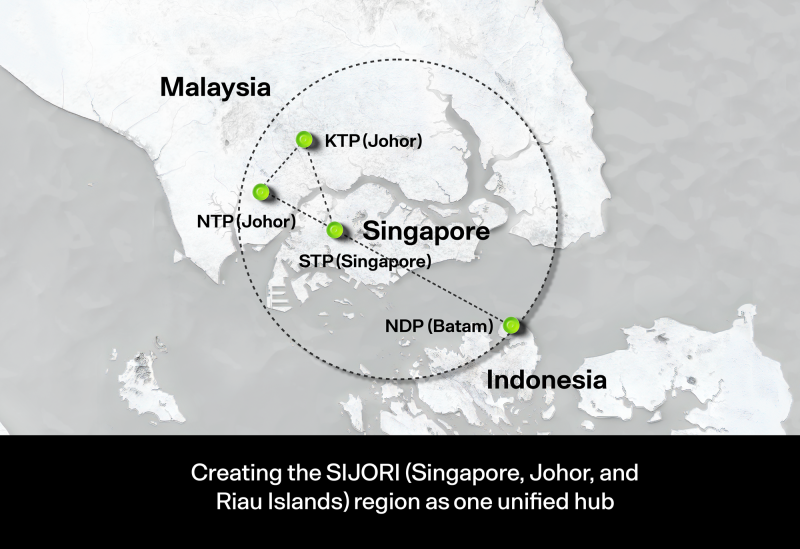

DayOne получила $3,5 млрд на развитие ЦОД в малазийском ДжохореDayOne Data Centers Singapore (ранее GDS International) привлекла 15 млрд ринггитов ($3,6 млрд) «мультивалютного» финансирования для поддержки создания экобезопасных дата-центров в малазийском штате Джохор, сообщает Bloomberg со ссылкой на Oversea-Chinese Banking Corporation (OCBC). DayOne является международным подразделением китайского оператора ЦОД GDS Holding. Компания провела ребрендинг малайзийского подразделения в начале 2025 года и получила внешние инвестиции от SoftBank Vision Fund, Citadel CEO Kenneth Griffin, Coatue Management и Baupost Group. Банк OCBC Bank и его малазийский филиал OCBC выступили в качестве совместных координаторов синдицированного финансирования DayOne на RM7,5 млрд ринггитов по системе исламского банкинга и ещё $1,7 млрд из зарубежных источников. В финансировании также приняли участие DBS Group Holdings, United Overseas Bank (UOB), CIMB Group Holdings, Malayan Banking, Credit Agricole CIB и Standard Chartered. По данным UOB, это — один из крупнейших проектов финансирования ЦОД в Юго-Восточной Азии. Malayan Banking заявил, что предоставил RM2,5 млрд.

Источник изображения: DayOne По данным Datacenter Dynamics, в портфолио оператора входят около 480 МВт действующих и строящихся ЦОД в Гонконге, Сингапуре, Малайзии, Индонезии и Японии. Недавно компания начала строительство ЦОД в Таиланде и получила заём на $412 млн для ЦОД в Батаме (Batam, Индонезия). В Малайзии DayOne управляет двумя кампусами ЦОД в Nusajaya Tech Park и Kempas Tech Park в Джохоре — суммарно 120 МВт. Полученные средства DayOne намерена использовать для рефинансирования и на развитие своих ЦОД в Джохоре. Последние, как ожидается, получат сертификаты «зелёной» цифровой инфраструктуры и станут частью инвестиций в особую экономическую зону Джохор–Сингапур (JS-SEZ). Также недавно сообщалось, что Yondr Group передала дата-центр в Джохоре своему клиенту — объект на 25 МВт, первый для компании в Азиатско-Тихоокеанском регионе. Его сдали на полгода раньше, чем планировалось, это первый этап проекта на 98 МВт в Sedenak Tech Park. При полной застройке кампус будет мощность более 300 МВт, на его создание выделено $900 млн.

Источник изображения: DayOne Джохор — всё более популярный рынок для операторов благодаря близости к финансовому хабу Сингапура, поэтому не будет ничего удивительного, что компания стремится расширить своё присутствие в регионе. Ожидается, что к 2030 году в Джохоре будет размещено 60 % от общей мощности дата-центров Малайзии, при этом около 30 проектов уже завершены или находятся в стадии строительства, а еще 20 ожидают одобрения местных властей. Конкуренцию Малайзии в секторе ЦОД пытается составить Индонезия, у которой тоже есть близкая к Сингапуру территория — остров Батам (Batam).

15.06.2025 [23:29], Владимир Мироненко

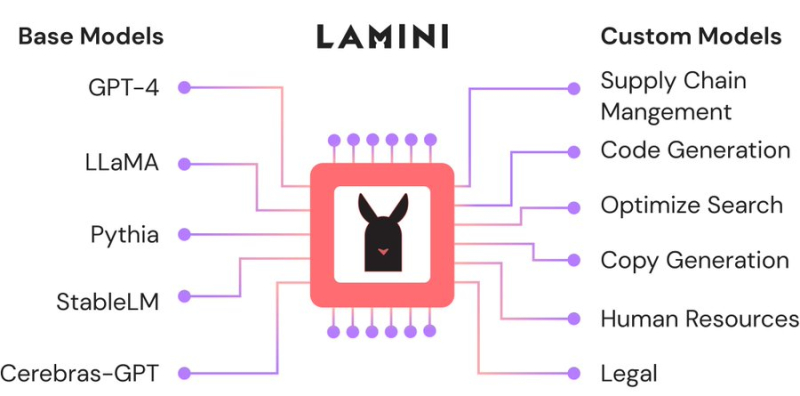

Большая жатва: AMD назначила вице-президентом по ИИ гендиректора ИИ-стартапа Lamini, в который сама же и вложиласьAMD продолжает укреплять команду специалистов в сфере ИИ за счёт привлечения талантливых разработчиков, а также поглощения ИИ-стартапов. На минувшей неделе Шарон Чжоу (Sharon Zhou, вторая справа на фото ниже), соучредитель и гендиректор ИИ-стартапа Lamini (PowerML Inc.) сообщила в соцсети X, что она и несколько сотрудников присоединяются к AMD. Комментируя переход, представитель AMD сообщил ресурсу CRN, что это было наймом специалистов, а не приобретением команды, как это было в случае с разработчиком ИИ-чипов Untether AI, который фактически прекратил существование после сделки. В настоящее время неизвестно, какой будет дальнейшая судьба Lamini, которую в прошлом году покинул Грег Диамос (Greg Diamos), бывший архитектор ПО NVIDIA CUDA, основавший компанию вместе с Чжоу в 2022 году. До основания Lamini Чжоу работала менеджером по ML-продуктам в Google, менеджером по продуктам в ИИ-стартапах Kensho Technologies и Tamr, а также занимала должность внештатного преподавателя компьютерных наук в Стэнфордском университете, где она получила докторскую степень по этой же специальности. В AMD её назначили на должность вице-президента по ИИ. Платформа Lamini позволяет компаниям настраивать и кастомизировать большие языковые модели (LLM) с использованием собственных данных. В частности, Lamini предложила новый подход под названием Mixture of Memory Experts (MoME), направленный на повышение производительности LLM и фактической точности путем радикального снижения частоты галлюцинаций с 50 % до 5 %. Утверждается, что этот подход позволяет значительно сократить объём вычислительных ресурсов для обучения LLM, а также продолжительность этого процесса. В 2023 году AMD представила Lamini как одного из первых независимых поставщиков ПО, поддержавших её ускорители Instinct. В сентябре того же года Lamini сообщила, что использует более чем 100 ускорителей серии Instinct MI200 и что платформа AMD ROCm «достигла программного паритета» с NVIDIA CUDA. До определённого момента ИИ-платформа Lamini была единственной коммерческой платформой, целиком и полностью работающей на базе AMD Instinct. В прошлом году стартап привлек финансирование в размере $25 млн от нескольких инвесторов, включая венчурное подразделение AMD, Эндрю Ына (Andrew Ng), гендиректора Dropbox Дрю Хьюстона (Drew Houston), и Лип-Бу Тана (Lip-Bu Tan), который в начале этого года стал гендиректором Intel. Помимо команды Untether AI, AMD приобрела в течение последних нескольких неделе разработчика систем кремниевой фотоники Enosemi и стартапа Brium, специализирующегося на инструментах оптимизации ИИ ПО для различной аппаратной инфраструктуры.

14.06.2025 [17:04], Владимир Мироненко

Scale AI получила от Meta✴ более $14 млрд, но потеряла гендиректора и рискует лишиться крупных контрактов с Gooogle, Microsoft, OpenAI и xAIИИ-стартап Scale AI, занимающийся подготовкой, оценкой и разметкой данных для обучения ИИ-моделей, объявил о крупной инвестиционной сделке с Meta✴, по результатм которой его рыночная стоимость превысила $29 млрд. Сделка существенно расширит коммерческие отношения Scale и Meta✴. Также её условиями предусмотрен переход гендиректора Scale AI Александра Ванга (Alexandr Wang) и ещё ряда сотрудников в Meta✴. Вместо Ванга, который останется в совете директоров стартапа, временно исполняющим обязанности гендиректора Scale AI назначен Джейсон Дроги (Jason Droege), директор по стратегии, имеющий «20-летний опыт создания и руководства знаковыми технологическими компаниями, включая Uber Eats и Axon». Представитель Scale AI уточнил в интервью ресурсу CNBC, что Meta✴ вложит в компанию $14,3 млрд, в результате чего получит в ней 49-% долю акций, но без права голоса. «Мы углубим совместную работу по созданию данных для ИИ-моделей, а Александр Ванг присоединится к Meta✴ для работы над нашими усилиями по созданию суперинтеллекта», — рассказал представитель Meta✴. Переманивая Ванга, который не имея опыта в R&D, сумел с нуля создать крупный бизнес в сфере ИИ, гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) делает ставку на его организаторские способности, полагая, что укрепить позиции Meta✴ в сфере ИИ под силу опытному бизнес-лидеру, больше похожему на Сэма Альтмана (Sam Altman), чем на учёных, стоящих у руля большинства конкурирующих ИИ-лабораторий, пишет Reuters. Инвестиции в Scale AI станут вторыми по величине в истории Meta✴ после приобретения WhatsApp за $19 млрд. Однако сделка может оказаться не совсем выгодной для Scale AI, предупреждает Reuters, поскольку многие компании, являющиеся клиентами Scale AI, могут отказаться от дальнейшего сотрудничества из-за опасений по поводу того, что Ванг, оставаясь в совете директоров стартапа, будет предоставлять Meta✴ внутреннюю информацию о приоритетах конкурентов. Представитель Scale AI заверил, что инвестиции Meta✴ и переход Ванга не повлияют на клиентов стартапа, и что Meta✴ не будет иметь доступа к его какой-либо деловой информации или данным. Тем не менее, по словам источников Reuters, Google, один их крупнейших клиентов Scale AI, планирует разорвать отношения со стартапом. Источники сообщили, что Google планировала потратить $200 млн только в этом году на услуги Scale AI по подгтовке и разметке данных людьми. После объявления о сделке поисковый гигант уже провёл переговоры с несколькими конкурентами Scale AI. Scale AI получила в 2024 году размере $870 млн, из них около около $150 млн от Google, утверждают источники. По их словам, другие крупные клиенты, включая Microsoft, OpenAI и xAI, тоже планируют отказаться от услуг Scale AI. Официальных подтверждений этой информации пока не поступало. А финансовый директор OpenAI заявил в пятницу, что компания, которой источники тоже приписывают намерение отказаться от услуг Scale AI, продолжит работать со стартапом, как с одним из своих многочисленных поставщиков данных. |

|