Материалы по тегу: sk hynix

|

28.01.2026 [23:51], Владимир Мироненко

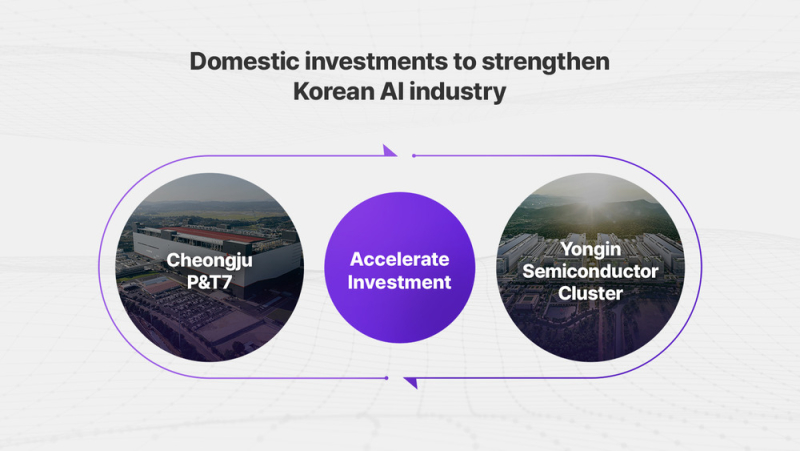

SK hynix создала на базе Solidigm американскую «дочку» для инвестиций в ИИ-решенияЮжнокорейская компания SK hynix объявила о создании в США новой компании, специализирующейся на решениях в сфере ИИ с предварительным названием AI Company (AI Co.). Новая компания будет сформирована путём реструктуризации Solidigm (SK hynix NAND Product Solutions Corp.), калифорнийской «дочки» SK hynix по производству SSD корпоративного класса, образованной в 2021 году в результате покупки NAND-бизнеса Intel за $9 млрд. При этом её бизнес-операции будут переданы новой дочерней компании, которая будет называться Solidigm Inc., «для обеспечения преемственности бренда». Новая структура призвана укрепить конкурентоспособность SK hynix в области технологий памяти для ИИ-платформ, включая высокоскоростную память (HBM). Компания заявила, что эта инициатива знаменует собой переход от традиционной роли производителя памяти к роли ключевого партнёра в решениях для ИИ ЦОД. Полученные в этой роли возможности будут объединены для создания синергии с дочерними компаниями и филиалами SK Group. SK hynix отметила, что благодаря своему бизнесу по производству SSD корпоративного класса, Solidigm уже является ключевым игроком в экосистеме ИИ ЦОД. Включение Solidigm в состав AI Company направлено на поиск возможностей для сотрудничества и развития бизнеса, которые могут создать синергию с различными направлениями бизнеса в ИИ-индустрии. Официальное название AI Company будет объявлено в феврале. Сначала будет сформирована временная управленческая команда и совет директоров, после чего запланирован переход к постоянной управленческой группе, состоящей из местных экспертов с глубокими знаниями рынка США. Для обеспечения первоначального финансирования SK hynix инвестирует в AI Company $10 млрд. Причём эта сумма будет структурирована как резерв на привлечение капитала, в рамках которого средства будут использоваться по запросу AI Co. для финансирования инвестиций. SK hynix планирует осуществлять через AI Co. стратегические инвестиции в ИИ-компании и расширять сотрудничество с американскими новаторами в сфере ИИ. SK hynix стремится укрепить своё лидерство в области производства памяти, одновременно развивая возможности решений по всей цепочке создания стоимости в ИИ ЦОД, поскольку растёт спрос на оптимизацию на системном уровне для решения проблем с узкими местами в передаче данных, отметил ресурс Korea IT Times. Первоначально SK hynix планирует сосредоточиться на ПО для оптимизации ИИ-систем, а затем постепенно расширять инвестиции в экосистему ИИ ЦОД. Недавно сообщалось о том, что SK hynix на три месяца ускорила график запуск завода по производству микросхем в южнокорейском Йонъине (Yongin), поскольку компания вкладывает большие деньги в освоение ИИ-волны. На поставках для ЦОД можно заработать ещё больше, поскольку, по крайней мере в краткосрочной перспективе, это создало дефицит памяти в потребительском секторе, отметил ресурс Hothardware. Также в этом месяце стало известно, что SK hynix инвестирует ₩19 трлн ($12,9 млрд) в строительство нового завода по упаковке и тестированию чипов для ИИ-технологий в Чхонджу (Cheongju). Планы по созданию нового предприятия в США также соответствуют политике США, стимулирующей размещение производства в стране с помощью регулирования пошлин на поставки извне. SK hynix уже строит в Индиане научно-исследовательский центр по производству современных микросхем и их упаковке стоимостью $3,87 млрд, о котором было объявлено ещё в 2024 году. Завод будет производить HBM для ИИ-ускорителей, начало его работы запланировано на 2028 год, пишет ресурс CNBC.

17.12.2025 [10:11], Сергей Карасёв

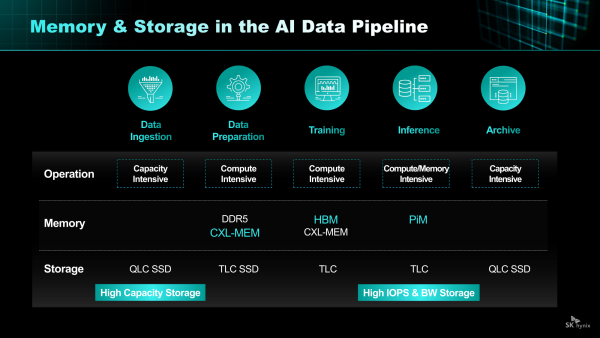

SK hynix и NVIDIA объединили усилия для создания сверхбыстрых SSD для ИИ-системКомпании SK hynix и NVIDIA, по сообщениям сетевых источников, занимаются совместной разработкой сверхбыстрых SSD, которые, как ожидается, помогут устранить узкие места современных ИИ-платформ. Проект получил название Storage Next: он предполагает создание чипов флеш-памяти NAND и сопутствующих контроллеров следующего поколения. По информации ресурса ZDNet, первые прототипы изделий партнёры намерены представить к концу следующего года. Речь идёт о накопителях с интерфейсом PCIe 6.0, которые смогут демонстрировать показатель IOPS (операций ввода/вывода в секунду) на уровне 25 млн. Более того, в 2027-м, как ожидается, будет выпущено устройство с величиной IOPS до 100 млн. Для сравнения, современные высокопроизводительные SSD корпоративного класса имеют значение IOPS на уровне 2–3 млн. В основу накопителей Storage Next лягут наработки SK hynix в области памяти AI-N (AI-NAND), оптимизированной для ИИ. В частности, упоминаются решения AI-N P: предполагается, что такие устройства будут выполнены в форм-факторе EDSFF E3.x. Они получат контроллер, предназначенный для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. По мере того, как ИИ-платформы переходят от обучения к инференсу, возможностей памяти HBM с высокой пропускной способностью оказывается недостаточно: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ИИ-ускорителей на базе GPU. Цель проекта Storage Next состоит в том, чтобы решить эту проблему путём использования инноваций в области NAND. По сравнению с современными SSD накопители Storage Next смогут демонстрировать увеличение показателя IOPS в 30–50 раз. Кроме того, SK hynix разрабатывает память AI DRAM (AI-D) для ИИ-платформ: эти изделия, как предполагается, помогут справиться с нехваткой памяти.

04.11.2025 [16:35], Сергей Карасёв

SK hynix разрабатывает AI-D — память для устранения узких мест в ИИ-системахКомпания SK hynix, по сообщению ресурса Blocks & Files, проектирует память нового типа AI DRAM (AI-D) для высокопроизводительных ИИ-платформ. Изделия нового типа будут предлагаться в трёх модификациях — AI-D O (Optimization), AI-D B (Breakthrough) и AI-D E (Expansion), что, как ожидается, позволит устранить узкие места современных систем. SK hynix является одним из лидеров рынка памяти HBM (Hgh Bandwidth Memory) для ИИ-ускорителей. Однако достижения в данной сфере отстают от развития GPU, из-за чего возникает препятствие в виде «стены памяти»: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ускорителей. Проще говоря, GPU простаивают в ожидании данных. Одним из способов решения проблемы является создание кастомизированных чипов HBM, предназначенных для удовлетворения конкретных потребностей клиентов. Вторым вариантом SK hynix считает выпуск специализированной памяти AI-D, спроектированной для различных ИИ-нагрузок. В частности, вариант AI-D O предполагает разработку энергосберегающей высокопроизводительной DRAM, которая позволит снизить общую стоимость владения ИИ-платформ. Для таких изделий предусмотрено применение технологий MRDIMM, SOCAMM2 и LPDDR5R. Продукты семейства AI-D B помогут решить проблему нехватки памяти. Такие изделия будут отличаться «сверхвысокой ёмкостью с возможностью гибкого распределения». Упомянуты технологии CMM (Compute eXpress Link Memory Module) и PIM (Processing-In-Memory). Это означает интеграцию вычислительных возможностей непосредственно в память, что позволит устранить узкие места в перемещении данных и повысить общее быстродействие ИИ-систем. Ёмкость AI-D B составит до 2 Тбайт — в виде массива из 16 модулей SOCAMM2 на 128 Гбайт каждый. Причём память отдельных ускорителей сможет объединяться в общее адресное пространство объёмом до 16 Пбайт. Любой GPU сможет заимствовать свободную память из этого пула для расширения собственных возможностей по мере роста нагрузки. Наконец, архитектура AI-D E подразумевает использование памяти, включая HBM, за пределами дата-центров. SK hynix планирует применять DRAM в таких областях, как робототехника, мобильные устройства и платформы промышленной автоматизации.

30.10.2025 [13:51], Владимир Мироненко

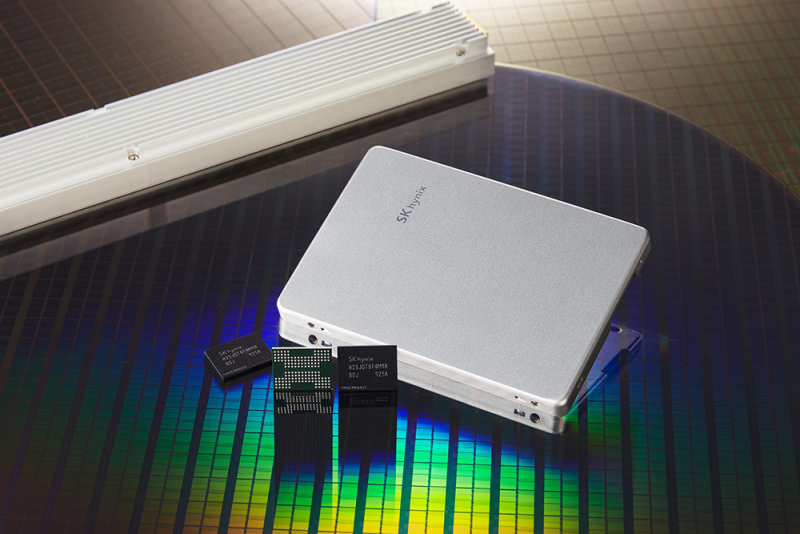

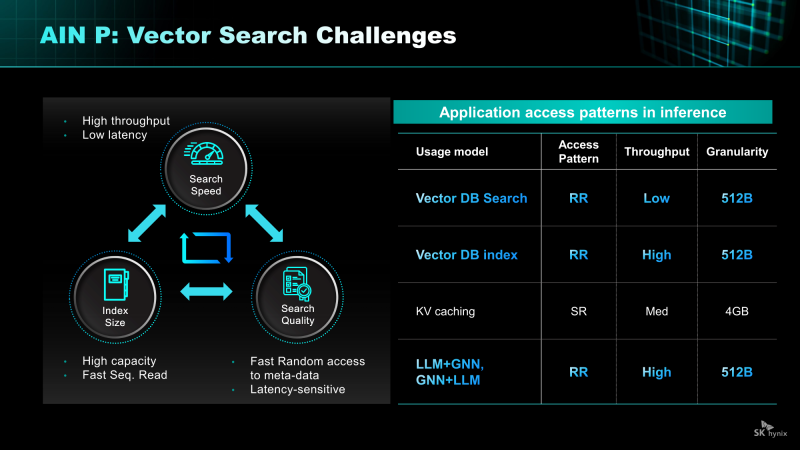

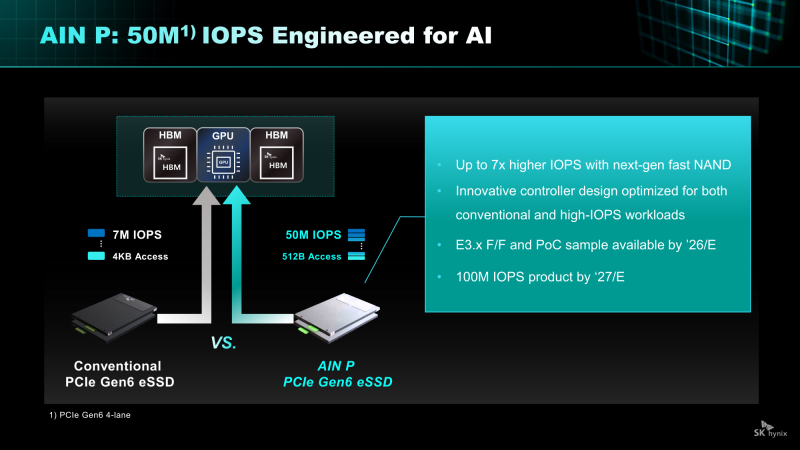

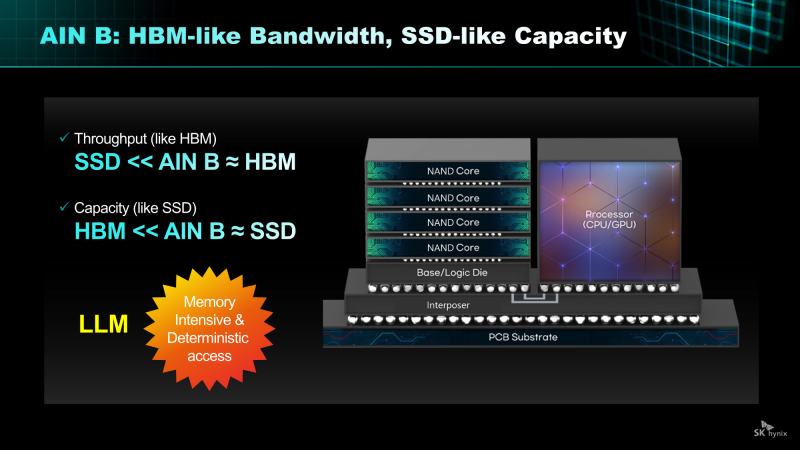

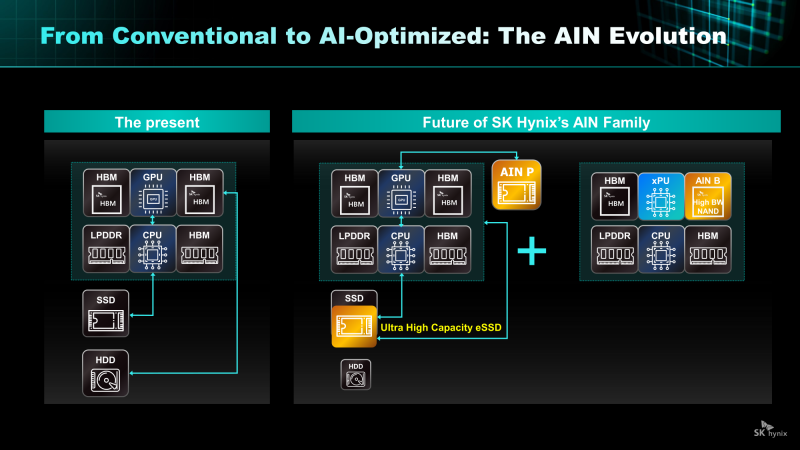

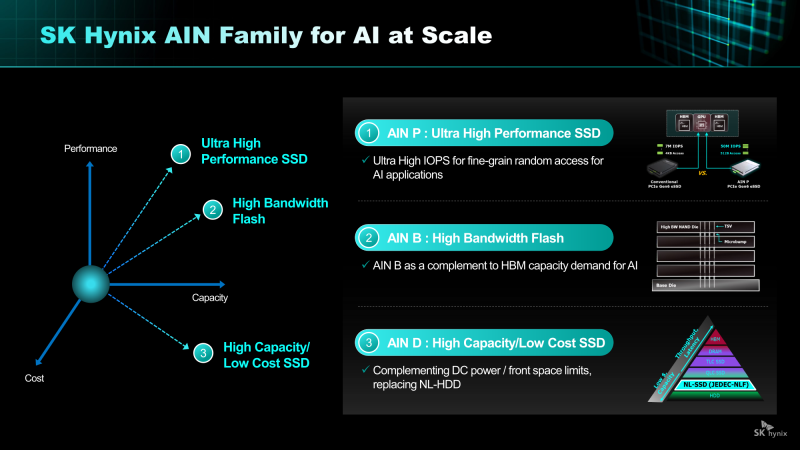

От Nearline SSD до HBF: SK hynix анонсировала NAND-решения AIN для ИИ-платформКомпания SK hynix представила стратегию развития решений хранения на базе NAND нового поколения. SK hynix заявила, что в связи с быстрым ростом рынка ИИ-инференса спрос на хранилища на базе NAND, способных быстро и эффективно обрабатывать большие объёмы данных, стремительно растёт. Для удовлетворения этого спроса компания разрабатывает серию решений AIN (AI-NAND), оптимизированных для ИИ. Семейство будет включать решения AIN P, AIN B и AIN D, оптимизированные по производительности, пропускной способности и плотности соответственно. AIN P (Performance) — это решение для эффективной обработки больших объёмов данных, генерируемых в рамках масштабных рабочих нагрузок ИИ-инференса. Продукт значительно повышает скорость обработки и энергоэффективность, минимизируя узкие места между хранилищем и ИИ-операциями. SK hynix разрабатывает NAND-память и контроллеры с новыми возможностями и планирует выпустить образцы к концу 2026 года. Как пишет Blocks & Files, накопитель AIN P, как ожидается, получит поддержку PCIe 6.0 и обеспечит 50 млн IOPS на 512-байт блоках, тогда как сейчас производительность случайного чтения и записи с 4-Кбайт блоками составляет порядка 7 млн IOPS у накопителей PCIe 6.0. То есть AIN P будет в семь раз быстрее, чем нынешние корпоративные PCIe 6.0 SSD, и, по заявлению SK hynix, достичь 100 млн IOPS можно будет уже в 2027 году. Такой SSD будет выполнен в форм-факторе EDSFF E3.x и оснащён контроллером, предназначенным для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. AIN D (Density) — это высокоплотное решение Nearline (NL) SSD для хранения больших объёмов данных с низкими энергопотреблением и стоимостью, подходящее для хранения ИИ-данных. Компания стремится увеличить плотность QLC SSD с Тбайт до Пбайт, создав решение среднего уровня, сочетающее в себе скорость SSD и экономичность HDD. AIN D от SK hynix как раз предназначен для замены жёстких дисков. Компания также упоминает некий стандарт JEDEC-NLF (Near Line Flash?), который пока не существует. При этом SK hynix пока не упоминает PLC NAND и не приводит данные о ёмкости AIN D. AIN B (Bandwidth) — это HBF-память с увеличенной за счёт вертикального размещения нескольких модулей NAND пропускной способностью. Ключевым в данном случае является сочетание структуры стекирования HBM с высокой плотностью и экономичностью флеш-памяти NAND. AIN B предложит большую ёмкость, чем HBM, примерно на уровне ёмкости SSD. AIN B может увеличить эффективную ёмкость памяти GPU и, таким образом, устранить необходимость покупки/аренды дополнительных GPU для увеличения ёмкости HBM, например, для хранения содержимого KV-кеша. Компания рассматривает различные стратегии развития AIN B, например, совместное использование с HBM для повышения общей ёмкости системы, поскольку стек HBF может быть совмещён со стеком HBM на одном интерпозере. SK hynix и Sandisk работают над продвижением стандарта HBF. Они провели в рамках 2025 OCP Global Summit мероприятие HBF Night, посвящённое этому вопросу. Рании компании подписали меморандум о стандартизации HBF в целях расширения технологической экосистемы. «Благодаря OCP Global Summit и HBF Night мы смогли продемонстрировать настоящее и будущее SK hynix как глобального поставщика решений памяти, процветающего на быстро развивающемся ИИ-рынке», — заявила SK hynix, добавив, что на рынке устройств хранения данных на базе NAND следующего поколения SK hynix будет тесно сотрудничать с клиентами и партнёрами, чтобы стать ключевым игроком.

17.10.2025 [10:47], Сергей Карасёв

SK hynix показала 245-Тбайт SSD серии PS1101 для дата-центровКомпания SK hynix в ходе мероприятия Dell Technologies Forum 2025 в Сеуле (Южная Корея) продемонстрировала свои новейшие SSD, оптимизированные для высокопроизводительных серверов и дата-центров для ИИ. В частности, показаны устройства PEB110, PS1010, PS1012 и PS1101.

Источник изображения: SK hynix Особого внимания заслуживает накопитель PS1101. Это решение, выполненное в форм-факторе E3.L, вмещает 245 Тбайт информации. Новинка ориентирована на крупномасштабные ИИ ЦОД и облачные среды, где критически важны высокая плотность хранения данных и энергоэффективность. В основу SSD положены чипы флеш-памяти QLC NAND, а для подключения служит интерфейс PCIe 5.0 х4. Скоростные показатели и величина IOPS пока не раскрываются. Устройству PS1101 предстоит конкурировать с другими SSD аналогичной ёмкости, о подготовке которых уже сообщили некоторые игроки рынка. В частности, Kioxia в июле нынешнего года анонсировала накопитель серии LC9 типоразмера EDSFF E3.L, рассчитанный на хранение 245,76 Тбайт данных. Кроме того, Sandisk представила NVMe SSD UltraQLC SN670 объёмом 256 Тбайт, предназначенный для ИИ-систем и НРС-платформ. А компания Samsung проектирует SSD с интерфейсом PCIe 6.0, вместимость которых будет достигать 512 Тбайт. Возвращаясь к новинкам SK hynix, можно выделить изделие PS1012 в форм-факторе U.2, которое вмещает до 61,44 Тбайт данных. Устройство выполнено на чипах флеш-памяти QLC NAND и оснащено интерфейсом PCIe 5.0 х4. В свою очередь, модель PEB110 типоразмера E1.S имеет вместимость до 8 Тбайт: этот продукт базируется на чипах TLC NAND с подключением посредством PCIe 5.0 х4. Наконец, изделие PS1010 получило исполнение E3.S, чипы TLC NAND, интерфейс PCIe 5.0 х4 и ёмкость до 15 Тбайт.

01.10.2025 [18:15], Руслан Авдеев

OpenAI построит ИИ ЦОД Stargate в Южной Корее, а Samsung поможет ей создать плавучие дата-центрыOpenAI подписала с Samsung Electronics и SK hynix письмо о намерениях, предусматривающее поставку чипов памяти знаменитому ИИ-стартапу. Дополнительно сообщается о намерении построить ЦОД Stargate на юго-западе Южной Кореи при участии SK Group. Кроме того, SK Telecom создаёт независимую ИИ-компанию с инвестициями $3,5 млрд в течение пяти лет. В рамках сотрудничества южнокорейские компании планируют нарастить выпуск DRAM — до 900 тыс. пластин в месяц, которые понадобятся для передовых моделей OpenAI. Samsung и её дочерние структуры Samsung SDS, Samsung C&T (Construction and Trading) и Samsung Heavy Industries помогут в реализации проекта Stargate Korea, в том числе со строительством и эксплуатацией ЦОД, облачными сервисами, консалтингом, а также внедрением и управлением сервисами для бизнесов, желающих интегрировать ИИ-модели OpenAI в свои внутренние системы. Упоминаются даже судостроение и морское дело. В частности, сотрудничество предусматривает совместную разработку плавучих ЦОД. Подобные объекты имеют определённые преимущества перед традиционными, поскольку им не требуется свободных участков земли, лишних расходов на охлаждение и углеродные выбросы таких проектов обычно невелики. Компании также изучают возможности создания плавучих электростанций и центров управления.

Источник изображения: Mathew Schwartz/unsplash.com Проект Stargate был запущен OpenAI в январе, при содействии Oracle, SoftBank, и MGX из Абу-Даби и уже заработали его первые ЦОД. Планируется инвестировать $500 млрд в цифровую инфраструктуру в следующие четыре года для обслуживания вычислительных потребностей OpenAI. На прошлой неделе OpenAI анонсировала строительство новых ЦОД Stargate в США, включая дата-центры в Техасе, Нью-Мексико и на Среднем Западе. Планируется реализация проектов Stargate и в других странах помимо Южной Кореи, например — в Великобритании и Норвегии.

15.09.2025 [11:44], Сергей Карасёв

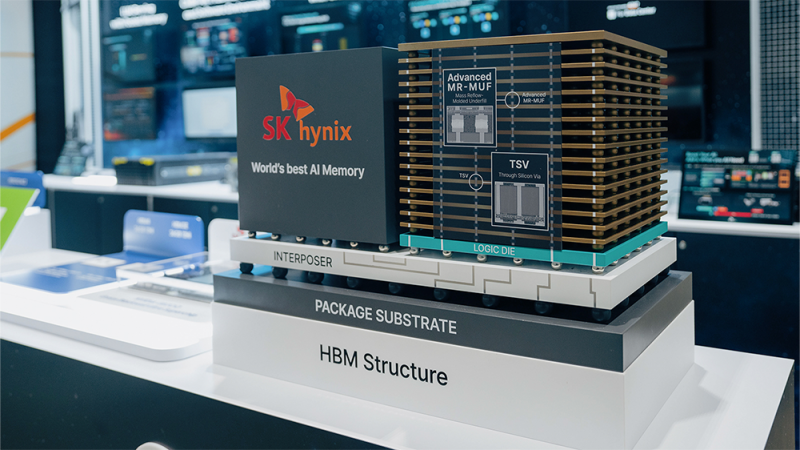

SK hynix завершила разработку памяти HBM4 для ИИ-системКомпания SK hynix объявила о том, что она первой среди участников отрасли завершила разработку памяти с высокой пропускной способностью HBM4 для ИИ-систем. В настоящее время готовится организация массового производства таких изделий. HBM4 — это шестое поколение памяти данного типа после оригинальных решений HBM, а также HBM2, HBM2E, HBM3 и HBM3E. Ожидается, что чипы HBM4 будут применяться в продуктах следующего поколения AMD, Broadcom, NVIDIA и др. Стеки памяти HBM4 от SK hynix оснащены 2048-бит IO-интерфейсом: таким образом, разрядность интерфейса HBM удвоилась впервые с 2015 года. Заявленная скорость передачи данных превышает 10 Гбит/с, что на 25 % превосходит значение в 8 Гбит/с, определённое официальным стандартом JEDEC. Пропускная способность HBM4 увеличилась вдвое по сравнению с предыдущим поколением НВМ, тогда как энергоэффективность повысилась на 40 %.

Источник изображения: SK hynix При изготовлении чипов HBM4 компания SK hynix будет применять 10-нм технологию пятого поколения (1bnm) и методику Advanced Mass Reflow Molded Underfill (MR-MUF). Последняя представляет собой способ объединения нескольких чипов памяти на одной подложке посредством спайки: сразу после этого пространство между слоями DRAM, базовым кристаллом и подложкой заполняется формовочным материалом для фиксации и защиты структуры. Технология Advanced MR-MUF позволяет выдерживать высоту HBM-стеков в пределах спецификации и улучшать теплоотвод энергоёмких модулей памяти. SK hynix не раскрывает ни количество слоёв DRAM в своих изделиях HBM4, ни их ёмкость. Как отмечает ресурс Tom's Hardware, по всей видимости, речь идёт об 12-Hi объёмом 36 Гбайт, которые будут использоваться в ускорителях NVIDIA Rubin. По заявлениям SK hynix, внедрение HBM4 позволит увеличить производительность ИИ-ускорителей на 69 % по сравнению с нынешними решениями. Это поможет устранить узкие места в обработке информации в ИИ ЦОД.

08.08.2025 [01:05], Владимир Мироненко

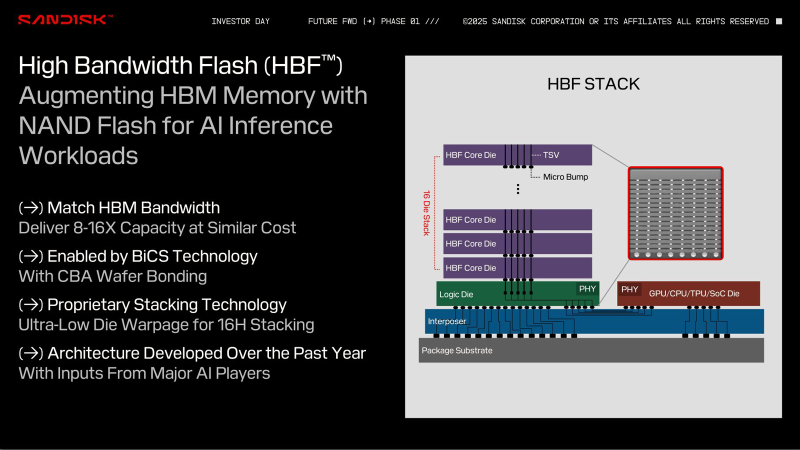

Sandisk и SK hynix разработают спецификации высокоскоростной флеш-памяти HBFSandisk объявила о подписании Меморандума о взаимопонимании (МОВ) с SK hynix, предусматривающего совместную разработку спецификации высокоскоростной флеш-памяти (HBF). В рамках сотрудничества компании планируют стандартизировать спецификацию, определить технологические требования и изучить возможность создания технологической экосистемы для высокоскоростной флеш-памяти. Технология HBF, анонсированная Sandisk в феврале этого года, обеспечит ускорители быстрым доступом к большим объёмам памяти NAND, что позволит ускорить обучение и инференс ИИ без длительных обращений к PCIe SSD. Как и HBM, чип HBF состоит из слоёв, в данном случае NAND, с TSV-каналами, соединяющими каждый слой с базовым интерпозером, что обеспечивает быстрый доступ к памяти — на порядки быстрее, чем в SSD. При сопоставимой с HBM пропускной способности и аналогичной цене HBF обеспечит в 8–16 раз большую, чем у HBM, ёмкость на стек. Вместе с тем HBF имеет более высокую задержку, чем DRAM, что ограничивает её применение определёнными рабочими нагрузками. На этой неделе Sandisk представила прототип памяти HBF, созданный с использованием фирменных технологий BiCS NAND и CBA (CMOS directly Bonded to Array). Меморандум о взаимопонимании подразумевает, что SK hynix может производить и поставлять собственные модули памяти HBF. Как отметил ресурс Blocks & Files, это подтверждает тот факт, что Sandisk осознаёт необходимость наличия рынка памяти HBF с несколькими поставщиками. Такой подход позволит гарантировать клиентам, что они не будут привязаны к одному поставщику. Также это обеспечит конкуренцию, которая ускорит разработку HBF. Sandisk планирует выпустить первые образцы памяти HBF во II половине 2026 года и ожидает, что образцы первых устройств с HBF для инференса появятся в продаже в начале 2027 года. Это могут быть как портативные устройства, так и ноутбуки, десктопы и серверы.

23.06.2025 [16:53], Владимир Мироненко

SK hynix выпустит кастомную HBM4E-память для NVIDIA, Microsoft и BroadcomСогласно данным The Korea Economic Daily, южнокорейская компания SK hynix заключила контракты на поставку кастомной памяти HBM с NVIDIA, Microsoft и Broadcom, опередив конкурента Samsung Electronics на рынке кастомной HBM, который, по прогнозам TrendForce и Bloomberg Intelligence к 2033 году вырастет до $130 млрд с $18,2 млрд в 2024 году. Ожидается, что поставки SK hynix кастомных чипов начнутся во второй половине 2025 года. По данным отраслевых источников, Samsung также ведёт переговоры с Broadcom и AMD о поставках кастомной HBM4. Ранее, в ходе квартального отчёта в апреле компания сообщила, что начнёт поставки памяти HBM4 в I половине 2026 года. Для наращивания производства HBM и передовой памяти DRAM компания SK hynix переоборудовала свой завод M15X в Чхонджу (Cheongju), изначально предназначенный для производства флеш-памяти NAND. Объём запланированных инвестиций составляет ₩20 трлн ($14,5 млрд). Кастомные HBM, предназначенные для удовлетворения конкретных потребностей клиентов, пользуются всё большим спросом, поскольку крупные технологические компании, стремясь оптимизировать производительность своих ИИ-решений, отказываются от использования универсальной памяти. О заключении контрактов стало известно примерно через 10 месяцев после того, как SK hynix объявила о получении запросов на поставку кастомной HBM от «Великолепной семёрки»: Apple, Microsoft, Google, Amazon, NVIDIA, Meta✴ и Tesla.

Источник изображения: SK hynix По словам источника The KED в полупроводниковой отрасли, «учитывая производственные мощности SK hynix и сроки запуска ИИ-сервисов крупными технологическими компаниями, удовлетворить все запросы “Великолепной семёрки” не представляется возможным». Тем не мене, он допустил, что SK hynix с учётом условий рынка может заключить контракты ещё с несколькими клиентами. Ранее SK hynix сообщила, что с поколением HBM4E она полностью перейдет на модель индивидуального производства. Текущее массовое внедрение сосредоточено вокруг HBM3E, а отрасль готовится в ближайшем будущем к переходу на шестое поколение памяти HBM — HBM4. По словам источников, выпуск кастомной памяти седьмого поколения HBM4E компания освоит во II половине 2026 года, а массовое производство HBM4 начнёт во второй II 2025 года. Начиная с HBM4, логические кристаллы для памяти SK hynix выпускает TSMC, поскольку усовершенствованный чип требует более продвинутых техпроцессов. До этого компания обходилась собственными мощностями. По данным TrendForce, SK hynix контролирует половину мирового рынка HBM, за ней следуют Samsung и Micron с долями рынка в размере 30 % и 20 % соответственно.

29.03.2025 [10:57], Владимир Мироненко

SK hynix распродала почти всю память HBM, которую выпустит в 2026 годуНа этой неделе состоялось ежегодное собрание акционеров компании SK hynix, на котором Квак Но-чжун (Kwak Noh-jung) заявил, что переговоры компании с клиентами о продажах памяти HBM в 2026 году близки к завершению. Как пишет The Register, заявление гендиректора было воспринято как знак того, что, как и в прошлом году, SK hynix распродаст весь объём выпуска HBM на год вперёд. На мероприятии было объявлено, что в последние недели наблюдается всплеск заказов на поставки HBM, поскольку компании стремятся заключить контракты до ожидаемого увеличения США пошлин на импортируемые полупроводники. Напомним, что в феврале президент США Дональд Трамп (Donald Trump) заявил о намерении ввести тарифы на импорт полупроводников на уровне 25 % и выше, добавив, что в течение года они могут вырасти до 50 % и даже 100 %.

Источник изображений: SK hynix Квак также сообщил акционерам, что SK hynix ожидает «взрывного» роста продаж HBM. На вопрос о том, представляет ли угрозу планам компании то, что DeepSeek использует для обучения своих ИИ-моделей сравнительно небольшие вычислительные мощности, глава SK hynix заявил, что достижения китайского стартапа станут стимулом для более широкого внедрения ИИ, что повлечёт за собой ещё больший спрос на продукцию SK hynix со стороны большего количества покупателей. Такой ответ стал почти стандартным для руководителей компаний, предоставляющих оборудование для обработки рабочих ИИ-нагрузок, на вопрос о том, формируется ли на ИИ-рынке «ценовой пузырь» и что может произойти, если он лопнет, отметил The Register. На прошлой неделе компания заявила, что отправила клиентам первые образцы 12-слойной памяти HBM4, отметив, что «образцы были доставлены с опережением графика» и что «она намерена завершить подготовку к массовому производству 12-слойной продукции HBM4 во второй половине года». |

|