Материалы по тегу: s

|

05.08.2024 [12:32], Сергей Карасёв

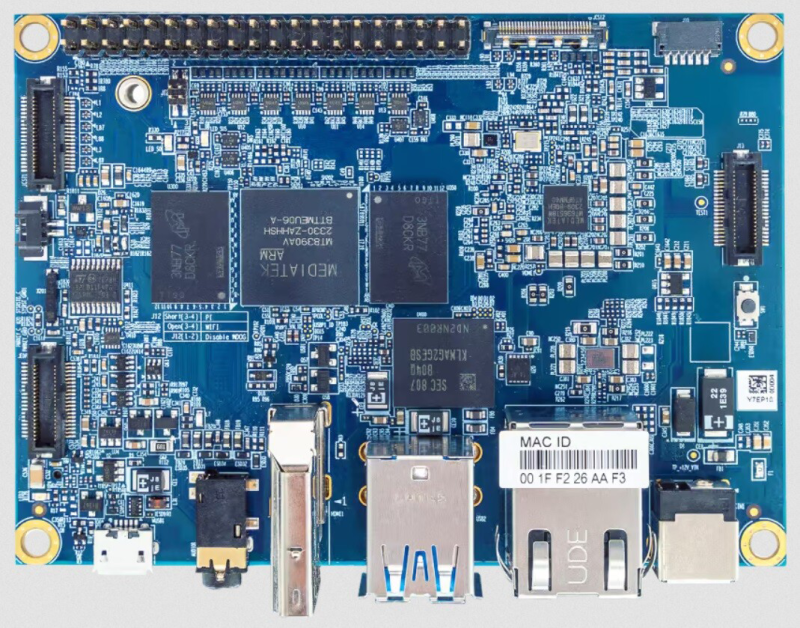

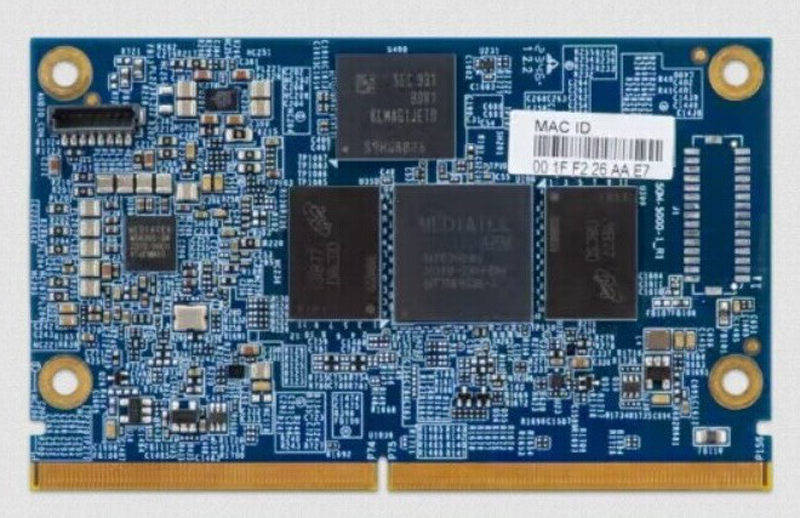

VIA представила edge-решения на платформе MediaTek Genio 700Компания VIA Technologies представила вычислительный модуль SOM-5000, одноплатный компьютер VAB-5000 и встраиваемую систему Artigo A5000 на аппаратной платформе MediaTek. Новинки предназначены для построения различных edge-решений с поддержкой ИИ-функций. Во всех изделиях применён процессор Genio 700. Чип содержит восемь вычислительных ядер: 2 × Arm Cortex A78 (2,2 ГГц) и 6 × Arm Cortex A55 (2,0 ГГц). В состав Genio 700 входит графический узел Arm Mali-G57 MC3 с поддержкой OpenGL ES 1.1/2.0/3.2, OpenCL ES 2.2, Vulkan 1.0/1.1. Возможно кодирование видео H.265 и H.264 в формате 4K (до 30 к/с).

Источник изображений: VIA Technologies Модуль SOM-5000 может нести на борту 4 или 8 Гбайт оперативной памяти LPDDR4X и 16 Гбайт флеш-памяти (eMMC). Поддерживаются интерфейсы 2 × MIPI DSI (4 линии), 2 × MIPI CSI (4 и 2 линии), HDMI 2.0, DisplayPort, USB 3.1, 3 × USB 2.0, 2 × SPI, I2S, 6 × I2C, 3 × UART, PCIe, SDIO, 1GbE, 11 × GPIO. Для модуля доступна плата SOMDB7 Carrier Board с набором разъёмов, включая HDMI, 2 × USB 3.1, Micro-USB 2.0, 2 × RJ-45 и 3,5-мм аудиогнездо. Диапазон рабочих температур — от -10 до +60 °C. Одноплатный компьютер VAB-5000 может комплектоваться 4 или 8 Гбайт памяти LPDDR4X и флеш-чипом eMMC на 16 Гбайт. В оснащение входит сетевой контроллер Realtek RTL8211F(I)-CG 1GbE. Предусмотрены интерфейс HDMI, два порта USB 3.1, порт Micro-USB 2.0, коннектор RJ-45 для сетевого кабеля и 3,5-мм аудиогнездо. Имеется слот M.2 для сотового модема 4G/5G (плюс разъём для карты Nano-SIM). Упомянута 40-контактная колодка GPIO в стиле Raspberry Pi. Изделие выполнено в формате Pico-ITX с размерами 100 × 72 мм. Плату можно использовать при температурах от -20 до +60 °C. Мини-компьютер Artigo A5000 выполнен в корпусе с размерами 118,61 × 37,6 × 82,2 мм. Технические характеристики аналогичны одноплатному компьютеру VAB-5000. Все новинки могут работать с Android 13, Yocto 4.0.x и Debian 12. Питание (12 В) подаётся через DC-разъём.

05.08.2024 [08:16], Сергей Карасёв

Новые кластеры Supermicro SuperCluster с ускорителями NVIDIA L40S ориентированы на платформу Omniverse

emerald rapids

hardware

intel

l40

nvidia

omniverse

sapphire rapids

supermicro

xeon

ии

кластер

сервер

Компания Supermicro расширила семейство высокопроизводительных вычислительных систем SuperCluster, предназначенных для обработки ресурсоёмких приложений ИИ/HPC. Представленные решения оптимизированы для платформы NVIDIA Omniverse, которая позволяет моделировать крупномасштабные виртуальные миры в промышленности и создавать цифровых двойников. Системы SuperCluster for NVIDIA Omniverse могут строиться на базе серверов SYS-421GE-TNRT или SYS-421GE-TNRT3 с поддержкой соответственно восьми и четырёх ускорителей NVIDIA L40S. Обе модели соответствуют типоразмеру 4U и допускают установку двух процессоров Intel Xeon Emerald Rapids или Sapphire Rapids в исполнении Socket E (LGA-4677) с показателем TDP до 350 Вт (до 385 Вт при использовании СЖО). Каждый из узлов в составе новых систем SuperCluster несёт на борту 1 Тбайт оперативной памяти DDR5-4800, два NVMe SSD вместимостью 3,8 Тбайт каждый и загрузочный SSD NVMe M.2 на 1,9 Тбайт. В оснащение включены четыре карты NVIDIA BlueField-3 (B3140H SuperNIC) или NVIDIA ConnectX-7 (400G NIC), а также одна карта NVIDIA BlueField-3 DPU Dual-Port 200G. Установлены четыре блока питания с сертификатом Titanium мощностью 2700 Вт каждый. В максимальной конфигурации система SuperCluster for NVIDIA Omniverse объединяет пять стоек типоразмера 48U. В общей сложности задействованы 32 узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3, что в сумме даёт 256 или 128 ускорителей NVIDIA L40S. Кроме того, в состав такого комплекса входят три узла управления Supermicro SYS-121H-TNR Hyper System, три коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами, ещё два коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами для хранения/управления, два коммутатора управления NVIDIA Spectrum SN2201 Ethernet 1G с 48 портами. При необходимости конфигурацию SuperCluster for NVIDIA Omniverse можно оптимизировать под задачи заказчика, изменяя масштаб вплоть до одной стойки. В этом случае применяются четыре узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3.

03.08.2024 [18:49], Владимир Мироненко

В ЕС безоговорочно одобрили сделку по покупке HPE компании JuniperЕвропейская комиссия объявила на этой неделе о безоговорочном одобрении в соответствии с Регламентом ЕС о слияниях приобретения Juniper Networks, Inc. компанией Hewlett Packard Enterprise Company (HPE). В результате проведенного расследования Еврокомиссия пришла к выводу, что сделка не вызовет проблем с конкуренцией в Европейской экономической зоне (ЕЭЗ). Сумма сделки составляет $14 млрд. О намерении купить Juniper Networks компания HPE объявила в январе этого года. Компания отметила, что приобретение Juniper Networks позволит ей удвоить объём сетевого бизнеса, создав возможности для укрепления позиций на этом рынке с обширным продуктовым ассортиментом. Согласно подсчётам HPE, в течение года после закрытия сделки у неё начнётся рост скорректированную прибыли на акцию.

Источник изображения: Juniper Networks Еврокомиссия исследовала влияние сделки на следующие рынки: мировой рынок поставок оборудования для беспроводных локальных сетей (WLAN); мировой рынок поставок точек беспроводного доступа (WAP); рынок поставок коммутаторов для кампусных сетей Ethernet в масштабах ЕЭЗ и мировой рынок поставок коммутаторов для ЦОД. Относительно рынка оборудования WLAN, WAP и кампусных коммутаторов Ethernet Еврокомиссия установила, что в ЕЭЗ объединённая компания «продолжит сталкиваться с соперничеством со стороны широкого круга конкурентов, включая сильных и устоявшихся игроков на каждом из рынков». Клиенты имеют определённый уровень уравновешивающей покупательской силы, что позволяет им реагировать в случае повышения цен компанией HPE на продукцию Juniper, сообщил регулятор. Также было установлено, что объединённая компания не будет иметь значительной степени рыночной власти ни на рынке поставок серверов среднего уровня, ни на рынке поставок систем HPC. После слияния компания не получит значительного преимущества, предлагая коммутаторы Juniper для ЦОД в комплекте либо с серверами HPE, либо с системами HPC, поскольку конкуренты могут копировать и оспаривать любые связанные или объединённые продукты. Кроме того, циклы закупок каждого из видов продуктов различны, а следовательно, «не способствуют какой-либо антиконкурентной привязке или объединению». Между тем эта сделка привлекла внимание Управления по конкуренции и рынкам Великобритании (CMA), начавшего расследование по этому поводу. Также сообщается, что акционеры Juniper Networks подали в суд на компанию в связи с возможным нарушением Закона о ценных бумагах и биржах США. Ранее HPE получила одобрение на сделку в Бразилии. UPD 08.08.2024: британский регулятор CMA также одобрил сделку.

03.08.2024 [12:33], Сергей Карасёв

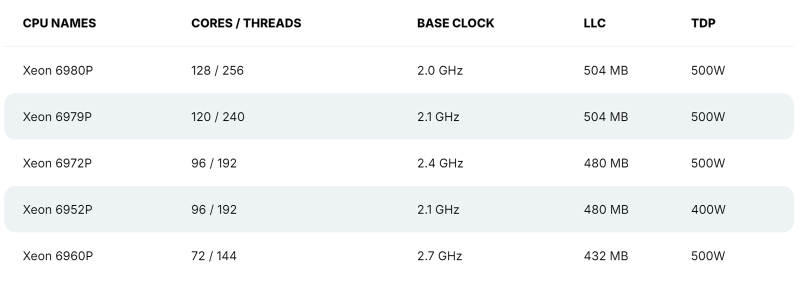

128 P-ядер, 504 Мбайт кеша и TDP 500 Вт: утекли характеристики Intel Xeon Granite RapidsВ распоряжении сетевых источников, по сообщению ресурса VideoCardz, оказалась информация о характеристиках части процессоров Intel Xeon 6 семейства Granite Rapids, в основу которых лягут производительные ядра P-core. Речь идёт о чипах Xeon 6900P, которые, как ожидается, появятся на рынке в текущем квартале. Формальная презентация Xeon 6 Granite Rapids состоялась в начале июня текущего года — вместе с изделиями Xeon 6 Sierra Forest, построенными на энергоэффективных ядрах E-core. Для платформы Xeon 6 предусмотрено использование разъёмов LGA-4710 и LGA-7529: в первом случае заявлена поддержка чипов с TDP до 350 Вт и 8-канальной памяти, во втором — 500 Вт и 12-канальной памяти. При этом в обоих вариантах возможно построение двухсокетных серверов. Как стало известно, в семейство Xeon 6 Granite Rapids войдут модели с 32, 44, 56, 72, 96, 120 и 128 ядрами Redwood Cove. Они получат поддержку SMT и до 504 Мбайт L3-кеша. Величина TDP составит до 500 Вт. В частности, говорится о подготовке процессоров Xeon Platinum 6980P, 6979P, 6972P, 6952P и 6960P. Их базовая тактовая частота варьируется от 2,0 до 2,7 ГГц (см. характеристики). Для чипов Xeon 6 Granite Rapids заявлена поддержка памяти DDR5-6400 и MCR-8800, до 96 линий PCIe Gen 5.0/CXL 2.0 и до 6 линий UPI 2.0.

03.08.2024 [00:33], Владимир Мироненко

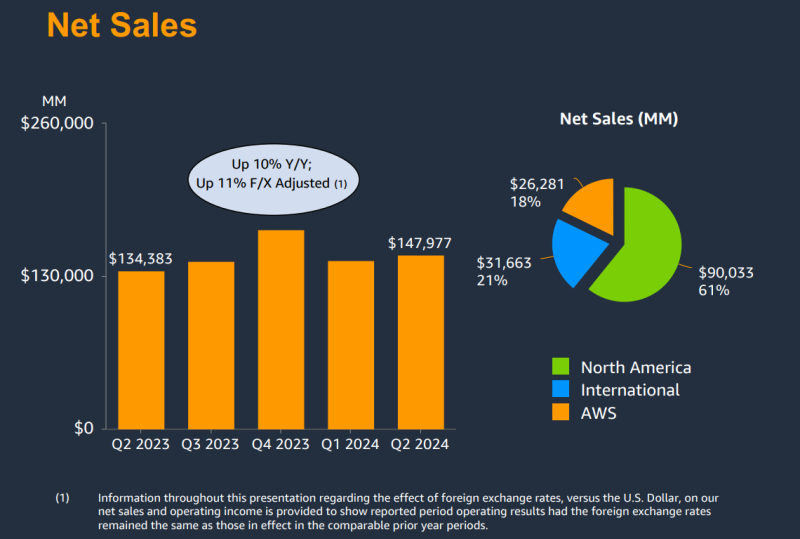

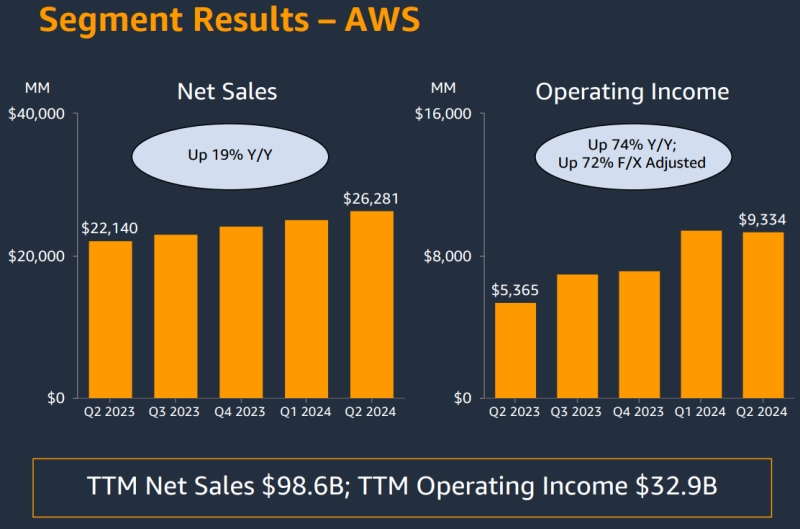

AWS увеличила выручку на 19 %, но по-прежнему отстаёт по темпам роста от Microsoft Azure и Google CloudКомпания Amazon.com, Inc. объявила результаты II квартала 2024 года, завершившегося 30 июня 2024 года. В связи с более низким, чем прогнозировали аналитики Уолл-стрит доходом, а также слабым прогнозом, акции компании упали на 6 % на расширенных торгах. Тем не менее, компания продолжает вкладывать всё больше средств в развитие облачной инфраструктуры, в том числе для ИИ-нагрузок. Выручка Amazon составила $147,98 млрд, превысив на 10 % показатель аналогичного периода прошлого года, равный $134,38 млрд. Вместе с тем выручка оказалась ниже консенсус-прогноза аналитиков, опрошенных LSEG, в размере $148,56 млрд. Операционная прибыль компании выросла до $14,67 млрд с $7,68 млрд годом ранее. Чистая прибыль увеличилась с $6,75 млрд ($0,65 на разводнённую акцию) в прошлом году до $13,48 млрд ($1,26 на разводнённую акцию) при консенсус-прогнозе аналитиков Уолл-стрит $1,03 на разводнённую акцию. Облачное подразделение Amazon Web Services (AWS) увеличило продажи год к году на 19 % до $26,28 млрд за квартал с $22,14 млрд годом ранее при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в размере $26,0 млрд. Операционная прибыль увеличилась с $5,36 млрд во II квартале 2023 года до $9,33 млрд. Хотя AWS превзошло прогнозы аналитиков по выручке, темпы роста у него ниже чем у облачных подразделений Microsoft и Google, увеличивших продажи на 29 %. Впрочем, объявленные ими цифры включают не только облачную инфраструктуру. В связи с высоким спросом на технологии ИИ Amazon тратит значительные суммы на расширение своей облачной инфраструктуры AWS. Капитальные затраты Amazon и лизинг составили $30,5 млрд за I половину года, и ожидается, что эта цифра вырастет во II половине года, говорит финансовый директор Amazon Брайан Олсавски (Brian Olsavsky). «Большая часть расходов будет направлена на поддержку растущей потребности в инфраструктуре AWS, поскольку мы по-прежнему видим высокий спрос как на генеративный ИИ, так и на негенеративный ИИ», — цитирует ресурс GeekWire его слова. Amazon прогнозирует выручку в текущем квартале в диапазоне от $154 до $158,5 млрд, что представляет собой рост на 8–11 % в годовом исчислении. Средняя точка этого диапазона, $156,25 млрд, отстаёт от средней оценки аналитиков, опрошенных LSEG, в $158,24 млрд.

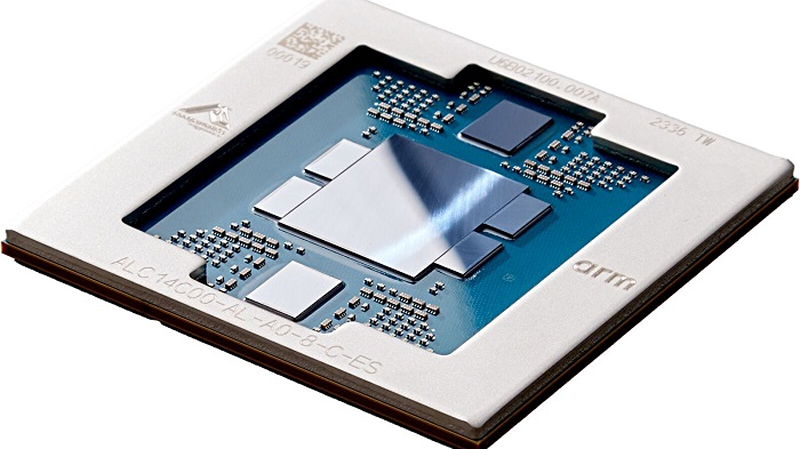

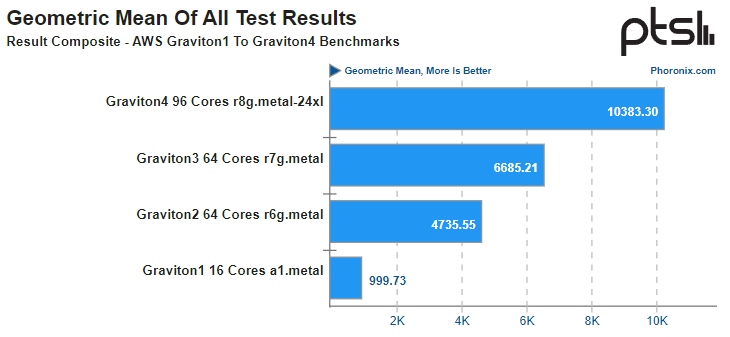

01.08.2024 [23:55], Алексей Степин

Arm-процессоры AWS Graviton4 успешно конкурируют с актуальными Intel Xeon, а иногда обгоняют даже AMD EPYCВсего за пять лет Amazon успела разработать и внедрить четыре поколения серверных Arm-процессоров Graviton. 4-нм Graviton4 получили 96 ядер и 12 каналов памяти DDR5-5600, а также поддержку PCIe 5.0. Всё это дало AWS основание утверждать, что Graviton4 производительнее предшественника на 30 %, а пропускная способность памяти у него выше на 75 %. Насколько это соответствует истине, выяснил ресурс Phoronix, который заодно сравнил новинки с другими современными процессорами. В тестировании Phoronix приняли участие следующие модели Graviton:

Источник: AWS Платформа Graviton в последней итерации выглядит вполне достойно. Она использует современный набор инструкций Arm, а по количеству ядер и каналов памяти сопоставима с новейшими решениями Intel и AMD. Производительность по мере смены поколений у Graviton растёт практически линейно, за исключением перехода от первого поколения ко второму, что легко объясняется возросшим сразу вчетверо количеством ядер. Что касается Graviton4, то новые процессоры в среднем быстрее Graviton3 примерно в 1,55 раза, а первенца серии они превосходят в 10,4 раза. В некоторых случаях выигрыш выходит далеко за рамки теоретических 1,5x, поскольку у Graviton4 более совершенная архитектура, новее набор инструкций, вдвое больший объем кеша на ядро и существенно более производительная подсистема памяти. Такое поведение, к примеру, характерно для тестов srsRAN, задач криптографии и особенно работы с базами данных.

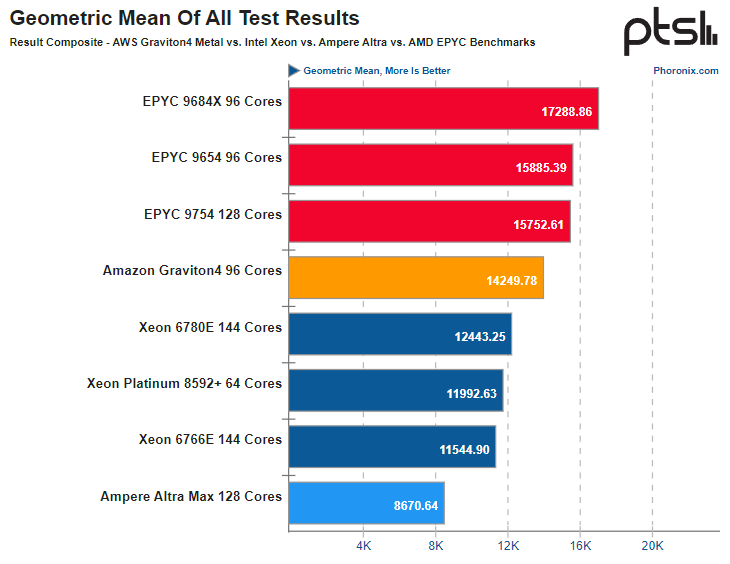

Источник здесь и далее: Phoronix В другом исследовании Phoronix процессорам Graviton4 довелось столкнуться с серьёзными соперниками из мира x86, включая 128-ядерный AMD EPYC 9754 (Bergamo) и 144-ядерные Intel Xeon 67xx (Sierra Forest), а также с ближайшим конкурентом по Arm-платформе, 128-ядерным процессором Ampere Altra Max. К сожалению, метрик энергопотребления в текущей версии инстанса r8g.metal-24xl получить не удалось, но и без этого результаты получены весьма интересные. С первых тестов очевидно, что Altra Max уже не соперник современным решениям, несмотря на сопоставимое количество ядер — сказывается не самая новая архитектура. А вот Graviton4 чувствует себя неплохо и в тестах на компиляцию может опережать даже AMD EPYC 9754. Хороша новинка и в базах данных, она лишь немного уступает процессорам Genoa и зачастую опережает 144-ядерное решение Intel c E-ядрами. И даже в HPC-нагрузках, для которых характерно активное использование FP-вычислений у Graviton4 всё хорошо! Неплохо себя детище AWS чувствует и в сценариях (де-)компрессии данных и кодировании видео.  В итоговом зачёте AWS Graviton4 уверенно занимает место в середине таблицы, опережая оба Xeon — и 64-ядерный Platinum 8592+ (Emerald Rapids), и 144-ядерный Xeon 6780E, но до уровня AMD EPYC 9754 всё же несколько недотягивая. Это вполне даёт основание считать, что платформа AWS Graviton достигла зрелости. Она вполне конкурентоспособна даже на фоне x86-монстров. Более того, на сегодня Graviton4 можно считать самым продвинутым серверным процессором с архитектурой AArch64. Впрочем, вскоре предстоят сражения с Granite Rapids, Turin и AmpereOne (а на подходе ещё и Aurora с HBM).

01.08.2024 [14:30], Руслан Авдеев

Amazon подала на Nokia в суд за нарушение облачных патентов, не преминув напомнить об ошибках прошлогоКомпания Amazon подала в штате Делавэр (США) иск к Nokia, обвинив последнюю в нарушении дюжины патентов, связанных с облачными вычислениями. Как передаёт Reuters, в материалах дела указывается, что Nokia злоупотребляла технологиями AWS, используя их в собственных облачных решениях. Год назад Nokia сама обратилась в суд с просьбой призвать к ответственности Amazon в связи с нарушением патентов на технологии видеостриминга. Сейчас Nokia заявила, что намерена изучить претензии Amazon и активно защищать свои права в суде. Amazon утверждает, что финская компания без разрешения использует технологии, изобретённые ей ещё в начале 2000-х годов, и просит суд заблокировать использование нарушающих её патенты решений Nokia, а также назначить денежную компенсацию. В Amazon заявляют, что с момента основания AWS в 2006 году компания фундаментально трансформировала вычисления и коммуникации. До появления AWS масштабные вычисления, связанные с большими объёмами данных, полагались в основном на om-premise серверную инфраструктуру компаний. В Amazon добавили, что через 14 лет после запуска AWS Nokia анонсировала новую стратегию, связанную с облачными вычислениями, открыв подразделение Cloud and Network Services. AWS утверждает, что облачные решения Nokia предусматривают использование интеллектуальной собственности Amazon. Так, Nokia CloudBand опирается на патентованные механизмы конфигурирования виртуальных машин, управления распределённым выполнением приложений, автоматического масштабирования ресурсов и т.д. А Nokia Nuage Networks нарушает патенты, связанные с управлением коммуникациями в виртуальных сетях и эмуляцией физических сетевых устройств, дополняет DataCenter Dynamics. Amazon не удержалась от колкостей, упомянув в иске, что неспособность Nokia оценить важность смартфонов чуть не довела компания до банкротства в 2013 году. В 186-страничном иске кропотливо упоминаются все случаи нарушения патентного законодательства, с цитатами маркетинговых и технических материалов Nokia, посвящённых облачным сервисам компании. Не исключено, что взаимные иски связаны. Процесс, инициированный Nokia против Amazon в октябре 2023 года, до сих пор не закончен. Утверждается, что Amazon Prime Video и устройства для стриминга нарушают пакет мультимедийных патентов Nokia, связанных с разнообразными технологиями, включая методы сжатия и доставки видео, системы рекомендации контента и даже аппаратные решения. Иск Amazon довольно необычен, поскольку Nokia практически забросила облачный бизнес летом 2023 года, признав, что у неё не хватит ресурсов, чтобы выдержать конкуренцию в этой области. Более того, Nokia является облачным партнёром AWS в Германии. Неизвестно, готова ли Amazon сражаться в суде до конца или просто пытается вынудить Nokia сесть за стол переговоров. Часто такие споры завершаются внесудебными договорённостями.

01.08.2024 [11:26], Сергей Карасёв

Addlink представила SSD серий D60 и D20 в форматах M.2 и SFF для NAS-устройствКомпания Addlink Technology анонсировала SSD семейств D60 и D20, предназначенные для использования в сетевых хранилищах (NAS). Устройства выполнены в форм-факторах M.2 2280 и SFF соответственно, а для обмена данными задействован интерфейс PCIe 4.0 x4 (NVMe 1.4) и SATA-3. Все решения построены на чипах флеш-памяти 3D TLC NAND. Диапазон рабочих температур простирается от 0 до +70 °C. Средняя наработка на отказ (показатель MTBF) достигает 2 млн часов. Производитель предоставляет на SSD пятилетнюю гарантию. Накопители Addlink D60 доступны в модификациях вместимостью 480, 960 и 1920 Гбайт. Гарантированный объём записанной информации (показатель TBW) — 920, 1900 и 3800 Тбайт соответственно. Скорость последовательного чтения данных составляет до 6000 Мбайт/с, скорость последовательной записи — до 2000 Мбайт/с. Значение IOPS на операциях произвольного чтения и записи — до 800 тыс. и 60 тыс. Устройства рассчитаны на одну полную перезапись в сутки (показатель DWPD) на протяжении пяти лет. В свою очередь, изделия Addlink D20, выполненные в корпусе толщиной 7 мм, представлены в версиях на 960 Гбайт, а также 1,92, 3,84, 7,68 и 15,36 Тбайт. Значение TBW достигает 815, 1631, 3263, 13 061 и 10 725 Тбайт; показатель DWPD равен 1. Скорости последовательного чтения и записи — до 530 и 500 Мбайт/с. Величина IOPS составляет до 98 тыс. при произвольном чтении и до 40 тыс. при произвольной записи. Отмечается, что накопители Addlink D60 подходят для высокопроизводительных NAS, которые эксплуатируются в круглосуточном режиме. Изделия Addlink D20 могут применяться для формирования систем большой вместимости.

29.07.2024 [10:00], Сергей Карасёв

Kalray и Pliops объединятся для разработки передовых решений для генеративного ИИКомпании Kalray и Pliops, по сообщению ресурса Storage Newsletter, подтвердили информацию о слиянии. Объединённая структура, как утверждается, займётся разработкой передовых решений SoC (System-on-Chips) для генеративного ИИ и ускорения обработки данных. О том, что стартапы Kalray и Pliops ведут переговоры о слиянии, стало известно в июне 2024 года. Kalray проектирует DPU-ускорители на основе чипов с фирменной архитектурой MPPA. В свою очередь, Pliops разрабатывает ускорители Extreme Data Processor (XDP) для различных задач, включая реляционные базы данных, разнородные СУБД NoSQL, платформы 5G и IoT, приложения ИИ и пр.

Источник изображения: Kalray Объединив технологии Pliops и архитектуру Kalray MPPA, стороны намерены предоставить заказчикам высокопроизводительные SoC для обработки данных в системах ИИ. Слияние будет осуществлено путём обмена ценными бумагами, при этом акционеры Kalray сохранят контрольный пакет. В рамках сделки стороны рассматривают возможность привлечения дополнительных средств из различных источников для ускорения развития. При этом Kalray уже получила финансирование в размере €15 млн в рамках возобновляемого банковского кредита. «Слияние представляет собой важную стратегическую возможность для обеих компаний. Объединив наши сильные стороны, мы намерены стать мировым лидером в области решений по ускорению обработки информации для платформ хранения данных и систем ИИ», — говорит Эрик Баиссус (Eric Baissus), генеральный директор Kalray. Отмечается, что технологии Pliops играют ключевую роль в повышении производительности массивов хранения данных на основе накопителей NVMe и приложений баз данных. Pliops привлекла около $200 млн с момента основания в 2017 году; компания насчитывает примерно 120 сотрудников в Израиле, США и Китае. В число её инвесторов входят AMD, Intel Capital, NVIDIA, SoftBank Ventures Asia, Western Digital и др. После завершения слияния существующие акционеры Pliops станут акционерами Kalray.

28.07.2024 [12:36], Сергей Карасёв

Южнокорейский разработчик ИИ-чипов Rebellions получил $15 млн от нефтяного гиганта AramcoWa’ed Ventures, венчурное подразделение саудовского нефтегазового и химического гиганта Aramco, по сообщению Datacenter Dynamics, инвестировало $15 млн в южнокорейский стартап Rebellions, занимающийся разработкой ИИ-чипов для машинного зрения, чат-ботов и больших языковых моделей (LLM). Компания Rebellions основана в 2020 году. Она создаёт специализированные решения для инференса, которые обеспечивают энергоэффективность и высокую производительность при небольших задержках. В 2023-м Rebellions освоила массовое производство чипов ATOM, способных, как утверждается, конкурировать с NVIDIA A100 в некоторых задачах. Изделия ATOM предназначены для обработки LLM в дата-центрах. В январе нынешнего года Rebellions осуществила раунд финансирования Series B, в ходе которого на развитие было привлечено $124 млн. Инвестиционную программу возглавил оператор KT при участии kt cloud, Shinhan Venture Investment, KDB (Корейский банк развития), Noh& Partners, KB Securities, KB Investment, SV Investment, Mirae Asset Venture Investment, IMM Investment, KT Investment, Seoul Techno Holdings, SDB Investment и ряда других инвесторов. А в июне 2024-го стартап Rebellions объявил о слиянии с разработчиком ИИ-чипов Sapeon Korea, который был выделен из SK Telecom в 2016 году. Rebellions также сотрудничает с Samsung Electronics в рамках проекта по созданию ускорителя для генеративного ИИ. Сообщается, что Wa’ed Ventures присоединилась к раунду финансирования Series B. Соучредитель и генеральный директор Rebellions Сонхён Пак (Sunghyun Park) отметил, что инвестиции будут направлены на создание высокопроизводительных и энергоэффективных ЦОД для задач ИИ в Королевстве Саудовская Аравия. Таким образом, Rebellions стала первым корейским стартапом, получившим стратегическое финансирование от Aramco Wa'ed Ventures. В общей сложности на текущий момент компания привлекла более $215 млн финансирования. |

|