Материалы по тегу: pc

|

26.08.2022 [12:45], Алексей Степин

Интерконнект NVIDIA NVLink 4 открывает новые горизонты для ИИ и HPCПотребность в действительно быстром интерконнекте для ускорителей возникла давно, поскольку имеющиеся шины зачастую становились узким местом, не позволяя «прокормить» данными вычислительные блоки. Ответом NVIDIA на эту проблему стало создание шины NVLink — и компания продолжает активно развивать данную технологию. На конференции Hot Chips 34 было продемонстрировано уже четвёртое поколение, наряду с новым поколением коммутаторов NVSwitch.

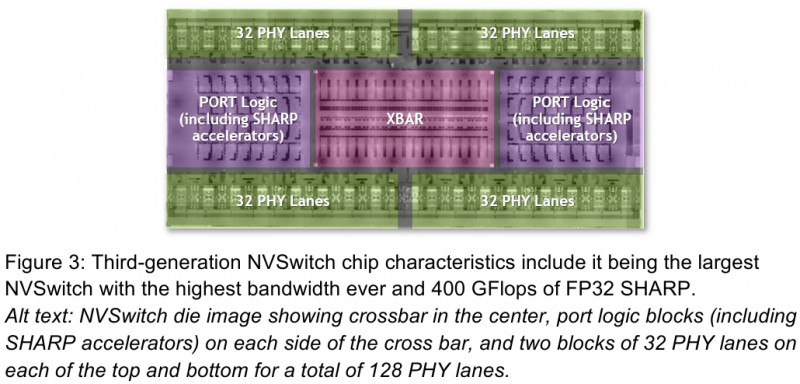

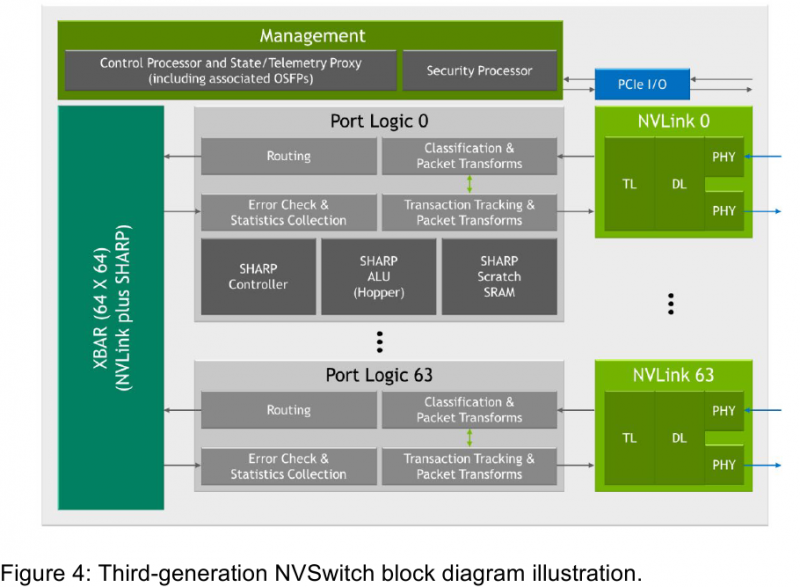

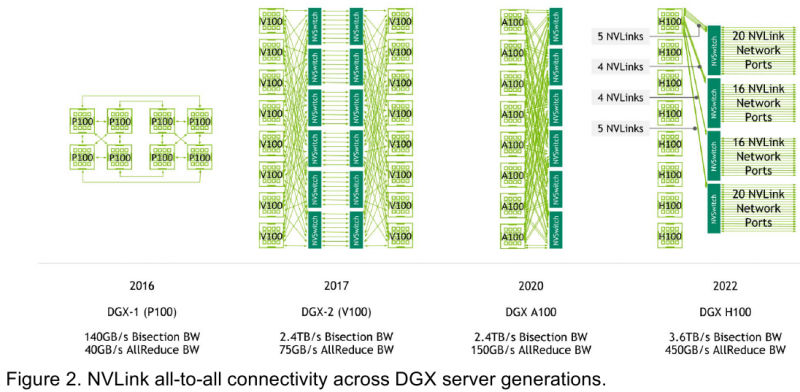

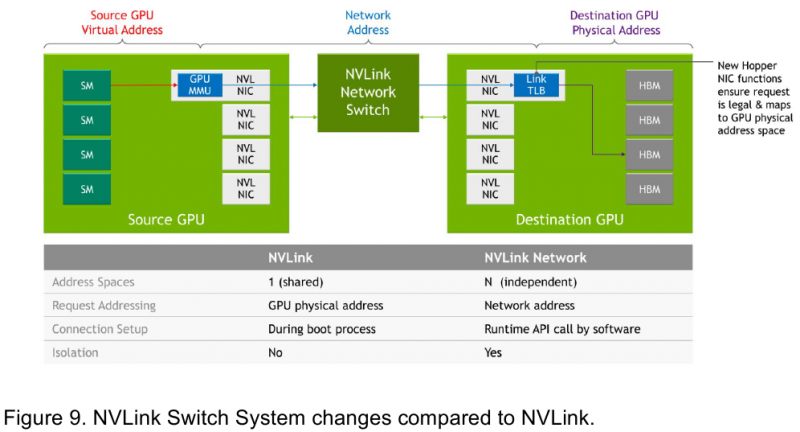

Изображения: NVIDIA Возможность использования коммутаторов для NVLink появилась не сразу, изначально использовалось соединение блоков ускорителей по схеме «точка-точка». Но дальнейшее наращивание числа ускорителей по этой схеме стало невозможным, и тогда NVIDIA разработала коммутаторы NVSwitch. Они появились вместе с V100 и предлагали до 50 Гбайт/с на порт. Нынешнее же, третье поколение NVSwitch и четвёртое поколение NVLink сделали важный шаг вперёд — теперь они позволяют вынести NVLink-подключения за пределы узла. Так, совокупная пропускная способность одного чипа NVSwitch теперь составляет 3,2 Тбайт/с в обе стороны в 64 портах NVLink 4 (x2). Это, конечно, отразилось и на сложности самого «кремния»: 25,1 млрд транзисторов (больше чем у V100), техпроцесс TSMC 4N и площадь 294мм2. Скорость одной линии NVLink 4 осталась равной 50 Гбайт/с, но новые ускорители H100 имеют по 18 линий NVLink, что даёт впечатляющие 900 Гбайт/с. В DGX H100 есть сразу четыре NVSwitch-коммутатора, которые объединяют восемь ускорителей по схеме каждый-с-каждым и дополнительно отдают ещё 72 NVLink-линии (3,6 Тбайт/с). При этом у DGX H100 сохраняются прежние 400G-адаптеры Ethernet/InfiniBand (ConnectX-7), по одному на каждый ускоритель, и пара DPU BlueField-3, тоже класса 400G. Несколько упрощает физическую инфраструктуру то, что для внешних NVLink-подключений используются OSFP-модули, каждый из которых обслуживает 4 линии NVLink. Любопытно, что электрически интерфейсы совместимы с имеющейся 400G-экосистемой (оптической и медной), но вот прошивки для модулей нужны будут кастомные. Подключаются узлы DGX H100 к 1U-коммутатору NVLink Switch, включающему два чипа NVSwitch третьего поколения: 32 OSFP-корзины, 128 портов NVLink 4 и агрегированная пропускная способность 6,4 Тбайт/с. В составе DGX SuperPOD есть 18 коммутаторов NVLink Switch и 256 ускорителей H100 (32 узла DGX). Таким образом, можно связать ускорители и узлы 900-Гбайт/с каналом. Как конкретно, остаётся на усмотрение пользователя, но сама NVLink-сеть поддерживает динамическую реконфигурацию на лету. Ещё одна особенность нового поколения NVLink — продвинутые аппаратные SHARP-движки, которые избавляют CPU/GPU от части работ по подготовке и предобработки данных и избавляющие саму сеть от ненужных передач. Кроме того, в NVLink-сети реализованы разделение и изоляция, брандмауэр, шифрование, глубокая телеметрия и т.д. В целом, новое поколение NVLink получило полуторакратный прирост в скорости обмена данными, а в отношении дополнительных сетевых функций он стал трёхкратным. Всё это позволит освоить новые класса HPC- и ИИ-нагрузок, однако надо полагать, что удовольствие это будет недешёвым.

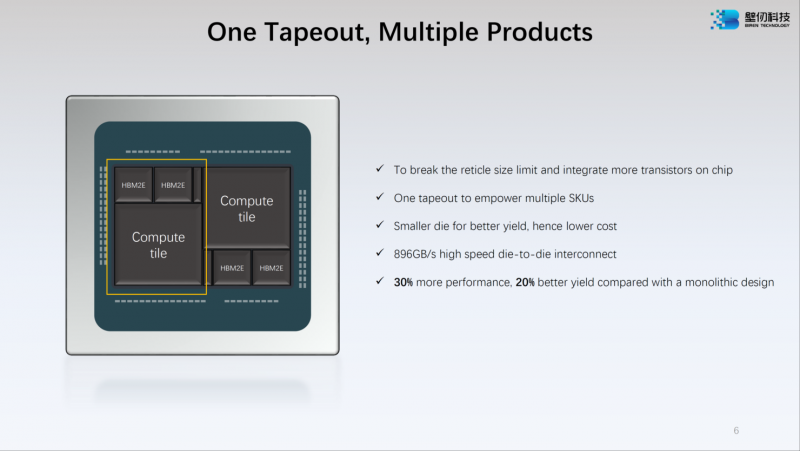

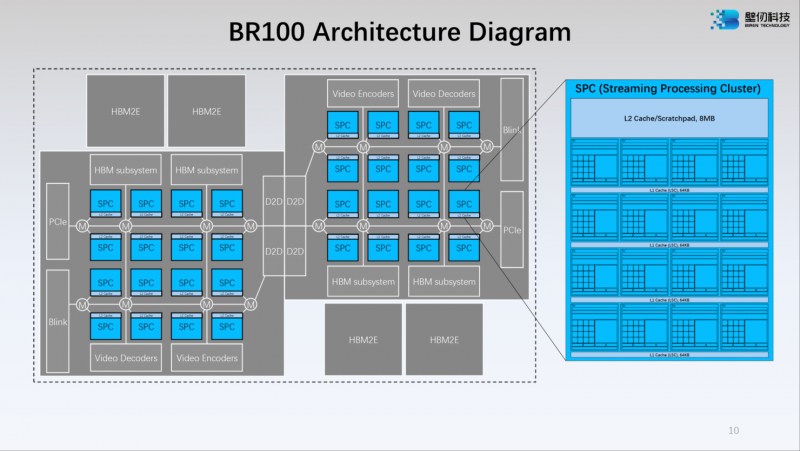

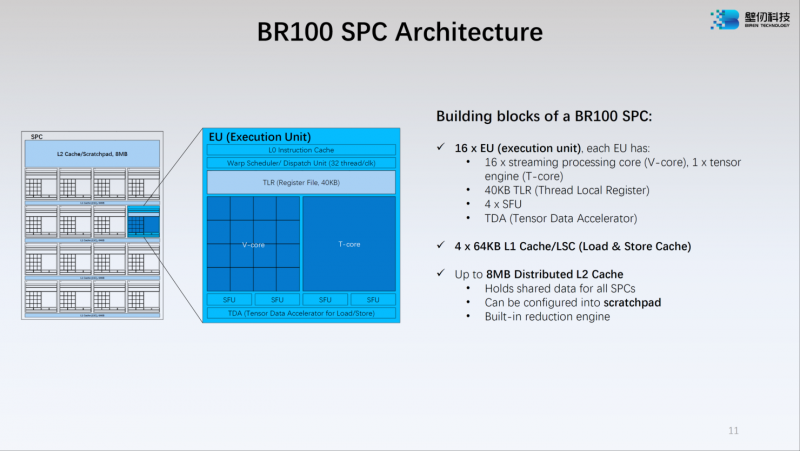

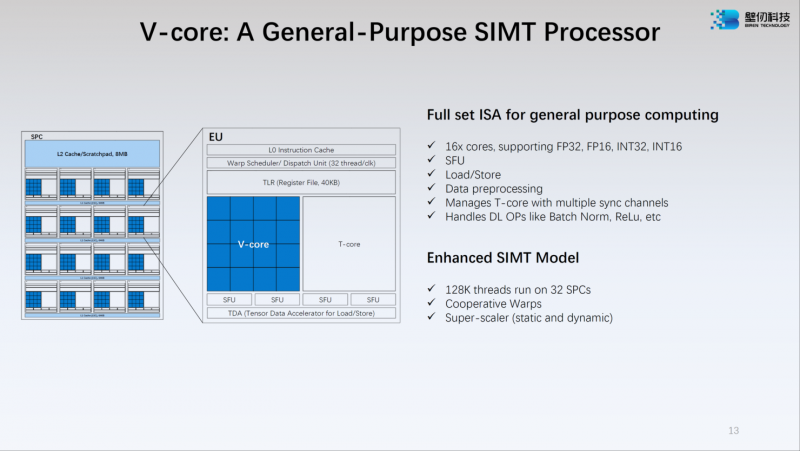

22.08.2022 [20:55], Алексей Степин

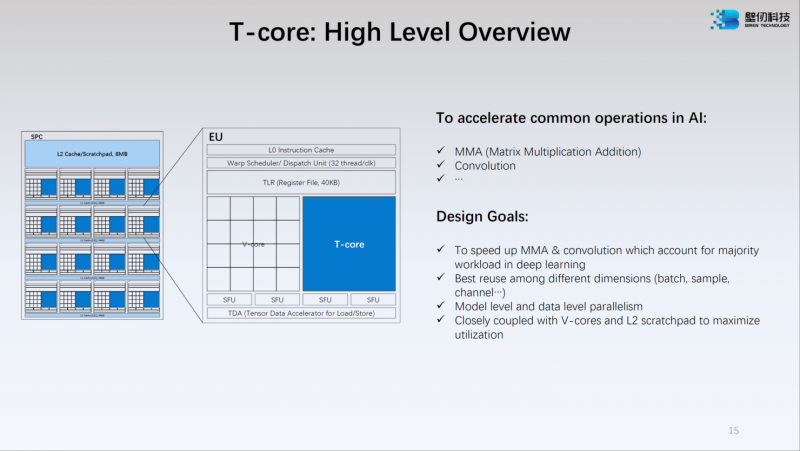

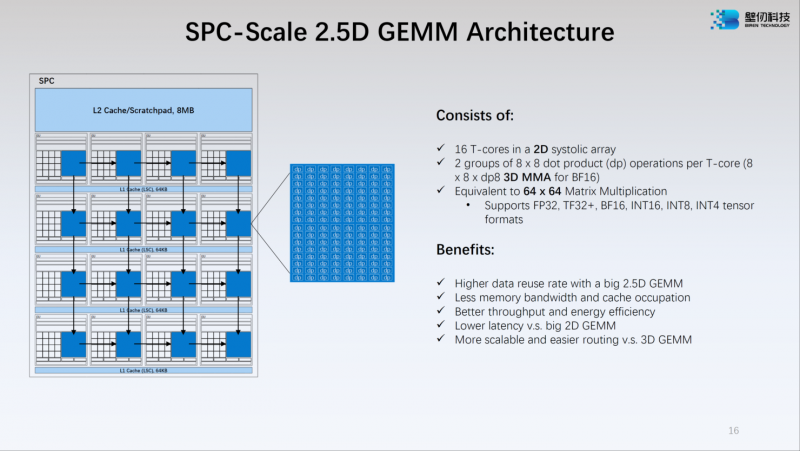

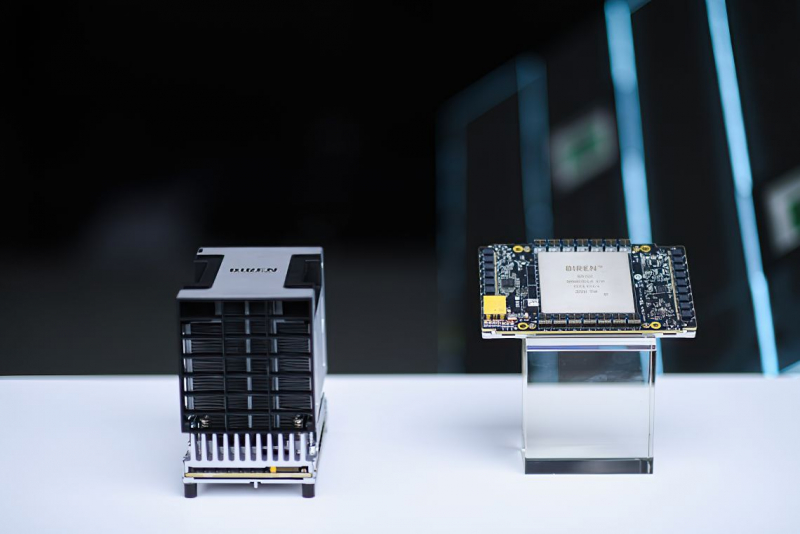

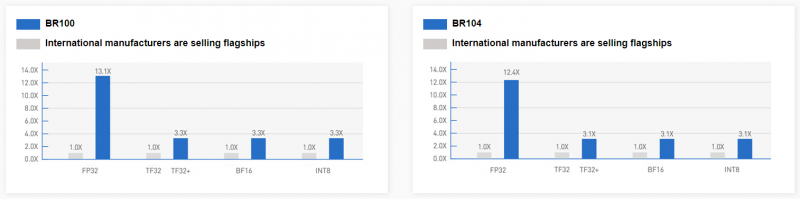

Китайский ускоритель Birentech BR100 готов бросить вызов NVIDIA A100Как известно, Китай первым в мире успешно ввёл в эксплуатацию суперкомпьютеры экзафлопсного класса, но современная HPC-система практически немыслима без ускорителей. Однако и здесь китайские разработчики подготовили прорыв: на конференции Hot Chips 34 компания Birentech рассказала о чипе BR100, решении, которое может бросить вызов как AMD, так и NVIDIA. Новинка базируется на архитектуре собственной разработки под кодовым названием Bi Liren. Это первый китайский ускоритель общего назначения, использующий чиплетную компоновку и поддерживающий PCI Express 5.0/CXL. Новые ускорители будут сопровождаться полноценной программной поддержкой, начиная с драйверов и библиотек и заканчивая популярными фреймворками, такими, как TensorFlow и PyTorch. Сложность BR100 внушает уважение: новый чип состоит из 77 млрд транзисторов, скомпонованных воедино с использованием 7-нм техпроцесса и технологии TSMC 2.5D CoWoS. Площадь чипа составляет 1074 мм2, правда, не очень понятно, идёт ли речь исключительно о кристалле, т.н. «вычислительном тайле», или о сборке в целом, поскольку в состав BR100 входит 64 Гбайт памяти HBM2e. Среди особенностей можно отметить наличие быстрого кеша объёмом 300 Мбайт (256 Мбайт L2) — для сравнения, у NVIDIA A100 он составляет всего 40 Мбайт, и даже у новейшего H100 он увеличен лишь до 50 Мбайт. Что касается ПСП, то она составляет 1,64 Тбайт/с. Модульная компоновка BR100 включает в себя два вычислительных тайла и четыре сборки HBM2e. Между собой кристаллы соединены интерконнектом с пропускной способностью 896 Гбайт/с, а для дальнейшего масштабирования в составе нового ускорителя предусмотрен фирменный интерконнект BLink (8 линий) с производительностью 2,3 Тбайт/с. Каждый из двух кристаллов несёт в себе по 16 потоковых вычислительных кластеров (SPC), а каждый такой кластер, в свою очередь, содержит 16 исполнительных блоков (EU). Каждый блок EU содержит 16 потоковых ядер V-Core и одно тензорное ядро T-Core, так что всего в составе BR100 имеется 8192 классических ядра и 512 тензорных. Каждый SPC имеет свой кеш L2 объёмом 8 Мбайт, суммарно 256 Мбайт на всю сборку BR100. Ядро V-Core имеет архитектуру SIMT (Single Instructions, Multiple Thread) и поддерживает вычисления в форматах INT16/32, FP16 и FP32. Тензорные ядра T-Core предназначены для выполнения операций типа MMA, свёртки и прочих, характерных для современных задач машинного обучения. Предельное количество потоков у BR100 в суперскалярном режиме — 128 тысяч. Компания-разработчик приводит некоторые цифры производительности для BR100: это 256 Тфлопс в режиме FP32, вдвое больше в режиме TF32+, 1024 Тфлопс в формате BF16 и целых 2048 Топс в режиме INT8. Это серьёзная заявка: с такими показателями BR100 должен опережать NVIDIA A100. Заявлено превосходство от 2,5х до 2,8х в зависимости от задачи и сценария. Любопытно, что BR100 несильно уступает NVIDIA H100 по количеству транзисторов (77 против 80 млрд), но, естественно, использование более грубого 7-нм техпроцесса против N4 у последней разработки NVIDIA означает и большее тепловыделение. Этот параметр у BR100 составляет 550 Вт в то время, как PCIe-вариант H100 укладывается в стандартные 350 Вт. Это не единственная новинка: в арсенале Birentech заявлен и менее мощный чип BR104. Он вдвое медленнее старшей модели по всем показателям и несёт 32 Гбайт памяти против 64, но в отличие от BR100, использует монолитный, а не чиплетный дизайн. На его основе будут выпущены ускорители в формате PCIe с TDP в районе 300 Вт, тогда как старшая версия будет доступна только в виде OAM-модуля.

20.08.2022 [22:30], Алексей Степин

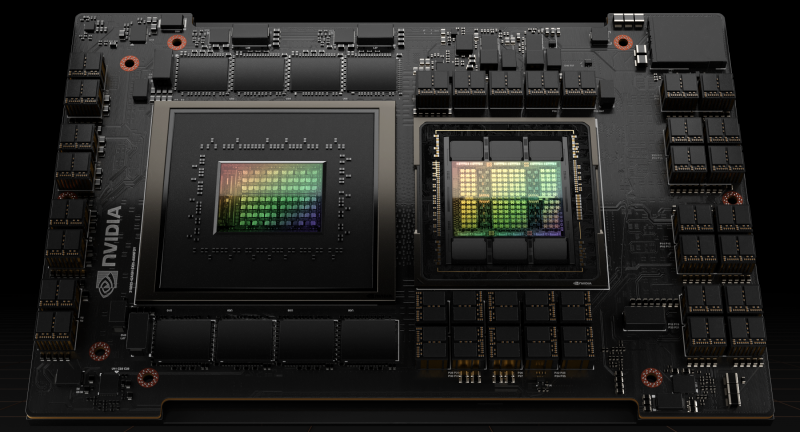

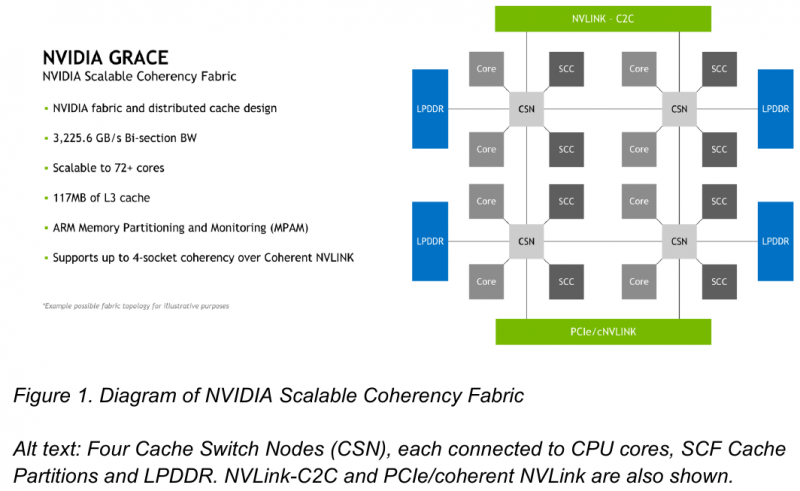

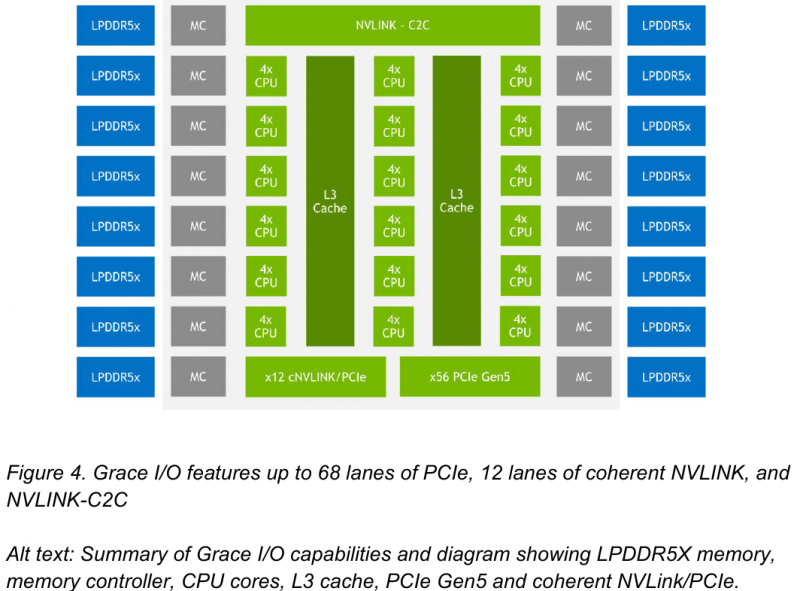

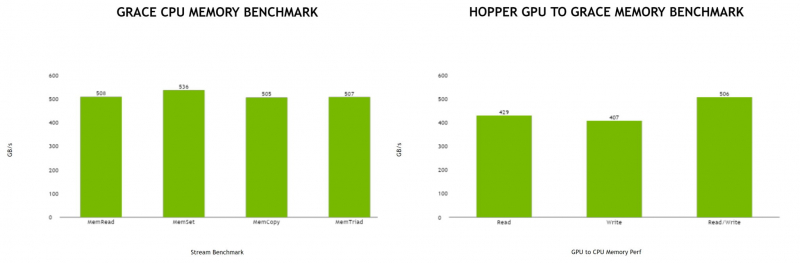

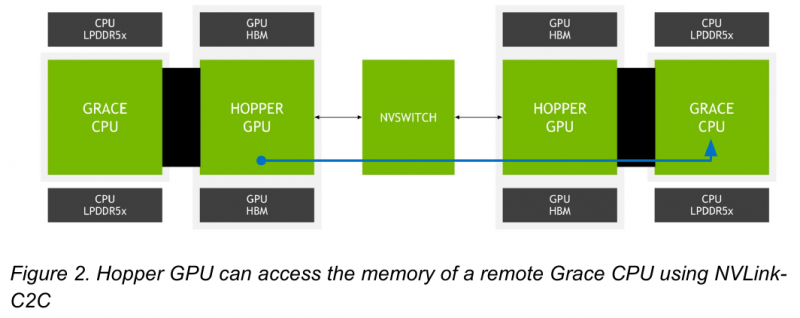

NVIDIA поделилась некоторыми деталями о строении Arm-процессоров Grace и гибридных чипов Grace HopperНа GTC 2022 весной этого года NVIDIA впервые заявила о себе, как о производителе мощных серверных процессоров. Речь идёт о чипах Grace и гибридных сборках Grace Hopper, сочетающих в себе ядра Arm v9 и ускорители на базе архитектуры Hopper, поставки которых должны начаться в первой половине следующего года. Многие разработчики суперкомпьютеров уже заинтересовались новинками. В преддверии конференции Hot Chips 34 компания раскрыла ряд подробностей о чипах. Grace производятся с использованием техпроцесса TSMC 4N — это специально оптимизированный для решений NVIDIA вариант N4, входящий в серию 5-нм процессов тайваньского производителя. Каждый кристалл процессорной части Grace содержит 72 ядра Arm v9 с поддержкой масштабируемых векторных расширений SVE2 и расширений виртуализации с поддержкой S-EL2. Как сообщалось ранее, NVIDIA выбрала для новой платформы ядра Arm Neoverse. Процессор Grace также соответствует ряду других спецификаций Arm, в частности, имеет отвечающий стандарту RAS v1.1 контроллер прерываний (Generic Interrupt Controller, GIC) версии v4.1, блок System Memory Management Unit (SMMU) версии v3.1 и средства Memory Partitioning and Monitoring (MPAM). Базовых кристаллов у Grace два, что в сумме даёт 144 ядра — рекордное количество как в мире Arm, так и x86. Внутренние блоки Grace соединяются посредством фабрики Scalable Coherency Fabric (SCF), вариации NVIDIA на тему сети CMN-700, применяемой в дизайнах Arm Neoverse. Производительность данного интерконнекта составляет 3,2 Тбайт/с. В случае Grace он предполагает наличие 117 Мбайт кеша L3 и поддерживает когерентность в пределах четырёх сокетов (посредством новой версии NVLink). Но SCF поддерживает масштабирование. Пока что в «железе» она ограничена двумя блоками Grace, а это уже 144 ядра и 234 Мбайт L3-кеша. Ядра и кеш-разделы (SCC) рапределены по внутренней mesh-фабрике SCF. Коммутаторы (CSN) служат интерфейсами для ядер, кеш-разделов и остальными частями системы. Блоки CSN общаются непосредственно друг с другом, а также с контроллерами LPDDR5X и PCIe 5.0/cNVLink/NVLink C2C. В чипе реализована поддержка PCI Express 5.0. Всего контроллер поддерживает 68 линий, 12 из которых могут также работать в режиме cNVLink (NVLink с когерентностью). x16-интерфейс посредством бифуркации может быть превращен в два x8. Также на приведённой NVIDIA диаграмме можно видеть целых 16 двухканальных контроллеров LPDDR5x. Заявлена ПСП на уровне свыше 1 Тбайт/с для сборки (до 546 Гбайт/с на кристалл CPU). Основной же межчиповой связи NVIDIA видит новую версию NVLink — NVLink-C2C, которая в семь раз быстрее PCIe 5.0 и способна обеспечить двунаправленную скорость передачи данных на уровне до 900 Гбайт/с, будучи при этом в пять раз экономичнее. Удельное потребление у новинки составляет 1,3 пДж/бит, что меньше, нежели у AMD Infinity Fabric с 1,5 пДж/бит. Впрочем, существуют и более экономичные решения, например, UCIe (~0,5 пДж/бит).

Новый вариант NVLink обеспечит кластер на базе Grace Hopper единым пространством памяти. Источник: NVIDIA NVLink-C2C позволяет реализовать унифицированный «плоский» пул памяти с общим адресным пространством для Grace Hopper. В рамках одного узла возможно свободное обращение к памяти соседей. А вот для объединения нескольких узлов понадобится уже внешний коммутатор NVSwitch. Он будет занимать 1U в высоту, и предоставлять 128 портов NVLink 4 с агрегированной пропускной способностью до 6,4 Тбайт/с в дуплексе.

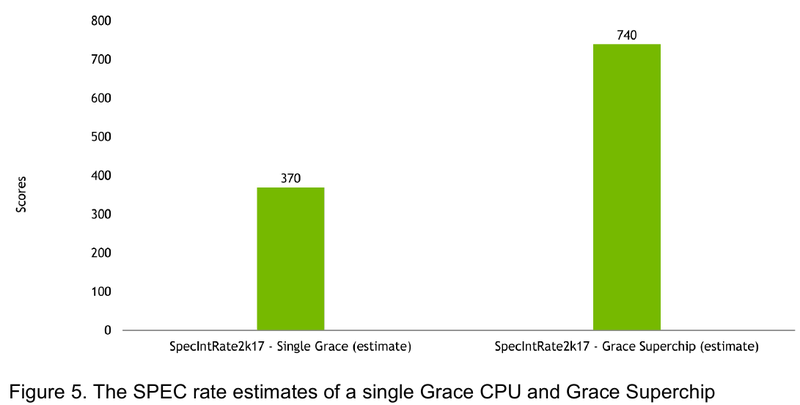

Источник: NVIDIA Производительность Grace также обещает быть рекордно высокой благодаря оптимизированной архитектуре и быстрому интерконнекту. Даже по предварительным цифрам, опубликованным NVIDIA, речь идёт о 370 очках SPECrate2017_int_base для одного кристалла Grace и 740 очках для 144-ядерной сборки из двух кристаллов — и это с использованием обычного компилятора GCC без тонких платформенных оптимизаций. Последняя цифра существенно выше результатов, показанных 128-ядерными Alibaba T-Head Yitian 710, также использующим архитектуру Arm v9, и 64-ядерными AMD EPYC 7773X.

10.08.2022 [22:05], Владимир Мироненко

На пути к Aurora: запущен «тренировочный» суперкомпьютер PolarisАргоннская национальная лаборатория (ANL) Министерства энергетики США объявила о доступности суперкомпьютера Polaris, ранний вариант которого занял 14-е место в последней версии списка TOP500. Он будет использоваться для проведения научных исследований и в качестве испытательного стенда для 2-Эфлопс суперкомпьютера Aurora, запуск которой намечен на ближайшие месяцы. Правда, аппаратно Aurora и Polaris отличаются. Созданная HPE система Polaris состоит из 560 узлов Apollo 6500, каждый из которых оснащён процессором AMD EPYC Milan, четырьмя ускорителями NVIDIA A100 (40 Гбайт) и 512 Гбайт DDR4-памяти. Эти узлы объединены в сеть интерконнектом HPE Slingshot 10 (осенью он будет обновлен до Slingshot 11) и подключены к сдвоенному 100-Пбайт Lustre-хранилищу (Grand и Eagle). Заявленная пиковая производительность должна составить 44 Пфлопс. «Polaris примерно в четыре раза быстрее нашего суперкомпьютера Theta, что делает его самым мощным компьютером в Аргонне на сегодняшний день», — отметил Майкл Папка (Michael Papka), директор Argonne Leadership Computing Facility (ALCF). Он добавил, что возможности Polaris позволят пользователям выполнять моделирование, анализ данных и ИИ-задачи с такими масштабом и скоростью, которые были невозможны с предыдущими вычислительными системами. Помимо работы над подготовкой к запуску Aurora, суперкомпьютер Polaris будет обслуживать внутренние потребности лаборатории, например, работу с комплексом Advanced Photon Source (APS) X-ray. «Благодаря тесной интеграции суперкомпьютеров ALCF с APS, CNM и другими экспериментальными установками мы можем помочь ускорить проведение анализа данных и предоставить информацию, которая позволит исследователям управлять своими экспериментами в режиме реального времени», — заявил Майкл Папка.

09.08.2022 [18:09], Игорь Осколков

Китайская компания Biren представила ИИ-ускоритель BR100, который обгоняет по производительности NVIDIA A100Шанхайская компания Biren Technology, основанная в 2019 году и уже получившая более $280 млн инвестиций, официально представила серию ускорителей BR100, которые способные потягаться с актуальными решениями от западных IT-гигантов. Утверждается, что это первое изделие подобного класса, созданное в Поднебесной. Компания уже подписала соглашение о сотрудничестве с ведущим производителем серверов Inspur. Новинка содержит 77 млрд транзисторов, использует чиплетную компоновку, изготавливается по 7-нм техпроцессу на TSMC и имеет 2.5D-упаковку CoWoS. Для сравнения — грядущие NVIDIA H100 имеют такую же упаковку, но включают 80 млрд транзисторов и изготавливаются по более современному техпроцессу TSMC N4. При этом BR100 примерно вдвое производительнее 7-нм NVIDIA A100 и примерно вдвое же медленнее H100. Впрочем, Biren приводит только данные о вычислениях пониженной точности, да и в целом говорит о том, что новинка предназначена в первую очередь для ИИ-нагрузок. В серию входят два решения: BR100 и BR104. Оба варианта оснащаются интерфейсом PCIe 5.0 x16 с поддержкой CXL. Первый вариант имеет OAM-исполнение с TDP на уровне 550 Вт. Он позволяет объединить до восьми ускорителей на UBB-плате, связав их между собой фирменным интерконнектом BLink (512 Гбайт/с) по схеме каждый-с-каждым. BR100 полагается 300 Мбайт кеш-памяти и 64 Гбайт HBM2e (4096 бит, 1,64 Тбайт/c). Также он способен одновременно кодировать до 64 потоков FullHD@30 HEVC/H.264, а декодировать — до 512. Кроме того, доступно создание до 8 аппаратно изолированных инстансов Secure Virtual Instance (SVI) по аналогии с NVIDIA MIG. Заявленная производительность составляет 256 Тфлопс для FP32-вычислений, 512 Тфлопс для TF32+ (по-видимому, подразумевается некая совместимость с фирменным форматом NVIDIA TF32), 1024 Тфлопс для BF16 и, наконец, 2048 Топс для INT8.

BR104 BR104 представляет более традиционную FHFL-карту с TDP на уровне 300 Вт. По производительности она ровно вдвое медленнее старшей версии BR100, способна обрабатывать вдвое меньшее количество видеопотоков и предлагает только до 4 SVI-инстансов. BR104 имеет 150 Мбайт кеш-памяти, 32 Гбайт HBM2e (2048 бит, 819 Гбайт/c) и три 192-Гбайт/с интерфейса BLink. Для работы с ускорителями компания предлагает собственную программную платформу BIRENSUPA, совместимую с популярными фреймворками PyTorch, TensorFlow и PaddlePaddle.

22.07.2022 [21:52], Алексей Степин

Бразильская нефтегазовая компания Petrobras получит самый мощный суперкомпьютер в Латинской Америке — PegasusСовременный суперкомпьютер, а лучше несколько, стремится иметь любая страна или корпорация, и гонка HPC-решений проходит не только между США и Китаем — так, крупнейшая бразильская нефтегазовая компания Petrobras анонсировала создание нового кластера в Рио-де-Жанейро. Будущий суперкомпьютер получил имя Pegasus, и он должен стать самой мощной HPC-системой в латиноамериканском регионе с производительностью около 21 Пфлопс. Система будет включать в себя 2016 ускорителей неизвестной пока модели и 678 Тбайт оперативной памяти, а в качестве интерконнекта планируется использовать 400-Гбит/с сеть. Вероятно, это будeт InfiniBand NDR.

Рио-де-Жанейро. Источник: Pixabay Суперкомпьютеры активно применяются в нефтегазовой отрасли в самых различных сценариях, от поиска новых месторождений до повышения эффективности существующих процессов переработки природных ресурсов. Petrobras уже располагает солидными вычислительными мощностями, составляющими 42 Пфлопс. Главной задачей Pegasus будет обработка обширных массивов данных в рамках геологоразведывательного проекта EXP100, а также поиск способов ускорить начало разработок новых нефтегазовых полей в проекте PROD1000.

Машинный зал Dragão. Источник: Agência Petrobras В июне 2021 года компания Petrobras запустила систему Dragão с 200 Тбайт памяти и 100G-интерконнектом. Система на базе процессоров Xeon Gold 6230R занимает 60 место в TOP500 с пиковой теоретической производительностью 14,01 Пфлопс. Также у Petrobras есть машины Atlas (8,84 Пфлопс) и Fênix (5,37 Пфлопс). Для сравнения — система HPC5, принадлежащая итальянской нефтегазовой компании Eni S.p.A., сейчас находится на 12 месте TOP500 и имеет пиковую теоретическую производительность 51,72 Пфлопс. До момента ввода в строй Pegasus, который запланирован на декабрь 2022 года, Dragão продолжит оставаться мощнейшей латиноамериканской HPC-системой. К концу 2022 года компания намеревается нарастить свой пул вычислительных мощностей до 80 Пфлопс, но пока явно отстаёт от графика. Впрочем, темпы роста впечатляют: ещё в 2018 году в распоряжении Petrоbras было лишь 3 Пфлопс.

12.07.2022 [00:28], Игорь Осколков

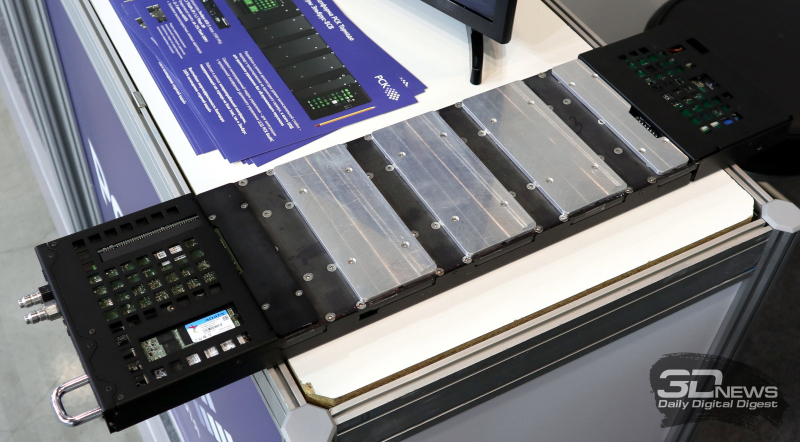

Суперкомпьютер в дорогу: РСК показала на Иннопроме обновлённый мобильный ЦОДГруппа компаний РСК, ведущий российский разработчик суперкомпьютеров и систем для высокопроизводительных вычислений (HPC), дата-центров, облачных платформ и систем хранения данных (СХД) показала на выставке Иннопром-2022 обновлённую версию своей платформы для автономных периферийных вычислений, которая позволяет оперативно, в течение часа силами двух человек, развернуть HPC-кластер практически в любом месте. Решение упаковано в несколько контейнеров (0,7 × 0,7 × 1,1 м), которые можно транспортировать независимо друг от друга и собирать уже на месте. Один контейнер вмещает собственно вычислительную часть, второй — полностью интегрированный модуль распределения теплоносителя с узлом управления, а третий, опциональный — ИБП с инвертором. Дополняет их компактный внешний модуль охлаждения. Вся система имеет весьма солидный запас по возможности отвода тепла — до 60 кВт. Правда, сейчас столько и не требуется. Вычислительный блок фактически является уменьшенной копией платформы «РСК Торнадо»: 2 колонны по 10 слотов. Поэтому мобильная платформа позволяет совмещать в одной системе серверы «Торнадо» с процессорами x86-64 (AMD EPYC и Intel Xeon) и «Эльбрус» (сейчас 8С/8СВ, в перспективе 16С) с любым уровнем TDP, GPGPU-серверы (по два PCIe-ускорителя на сервер, без ограничений по TDP) и серверы хранения (до 12 × M.2 All-Flash). В текущем варианте платформы каждый слот рассчитан на 2 кВт тепловой нагрузки (и столько же по питанию), хотя нынешние серверы укладываются в среднем в 700–800 Вт, а серверы следующего поколения потребуют чуть больше 1 кВт. Подсистема питания имеет два домена, по одному на колонну, и требует однофазный ввод AC 230 В/50 Гц, хотя фактически может работать в диапазоне 105–280 В. Запитать систему можно от генератора, а подстраховать — ИБП. Но возможно и специсполнение с поддержкой 48 В DC. Сетевая подсистема может быть представлена ToR-коммутаторами как двойной (на обе колонны) ширины, так и одиночной. В том числе есть варианты с жидкостным охлаждением. Доступен даже InfiniBand — у Mellanox есть коммутаторы в подходящем форм-факторе, рассчитанные на промышленное применение. Также предоставляется 1 GbE-коммутатор для развёртывания служебной сети. Самая интересная часть — это охлаждение. Как и в «большой» версии платформы здесь используется фирменная СЖО, которая покрывает все компоненты серверов, так что вычислительная часть не требует активного воздушного охлаждения и способна работать даже с закрытыми крышками контейнера. Защиты по какому-либо классу IP в стандартном варианте не предусмотрено, но опять-таки по заказу возможно специсполнение. СЖО всё так же поддерживает охлаждение горячей водой, причём на всех компонентах температура не превышает +45 °C. Для запуска вычислительного модуля необходимо, чтобы он находился в помещении с плюсовой температурой и чтобы не было образования конденсата. А вот внешний контур охлаждения менее прихотлив и способен работать при температурах от -65 °C. Верхний же предел — не менее +40 °C. Требования по питанию у него те же, что и у серверов. Узел управления автоматически отслеживает и регулирует параметры всех компонентов системы во время запуска и работы. По умолчанию используется сценарий защиты оборудования, так что при неблагоприятных условиях серверы могут выключаться. Но возможны и другие сценарии, например, «работа до последнего», когда потеря данных оказывается дороже потери оборудования. Управляется мобильная платформа фирменной системой оркестрации «РСК БазИС», которая позволяет задействовать все возможности компонуемой, программно определяемой инфраструктуры, в том числе для реализации HCI-платформы. «РСК БазИС» предлагает GUI, CLI, открытые API и SDK для интеграции с другими приложениями. Таким образом, заказчик получает полностью интегрированное программно-аппаратное решение, готовое к быстрому развёртыванию и использованию. Изначально платформа создавалась для нужд добывающего сектора, но этой сферой её возможности не ограничиваются. Она также подходит для научных экспедиций и промышленных предприятий (срочная обработка больших массивов данных), медиасферы и обслуживания массовых мероприятий (рендеринг, стриминг с множества камер) и т.д. В общем, везде, где на время требуется действительно мощная, но компактная и удобная в доставке, развёртывании и эксплуатации вычислительная платформа.

15.06.2022 [23:40], Алексей Степин

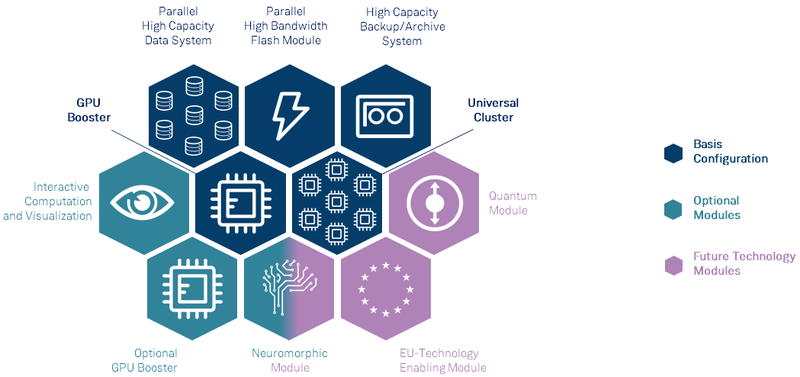

Анонсирован первый европейский суперкомпьютер экзафлопсного класса — JUPITERВсемирная гонка суперкомпьютеров экзафлопсного класса продолжается, и теперь в игру, наконец, вступил Евросоюз — консорциума EuroHPC сегодня раскрыл некоторые подробности о первой европейской система подобного уровня. Им станет машина под названием JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research), которая должна будет войти в строй в следующем году. Система будет смонтирована в Юлихском исследовательском центре (FZJ) в Германии. Сведений об аппаратной начинке JUPITER пока не так много, но в конструкции нового HPC-монстра будет применён тот же модульный подход, что был опробован на его предшественнике, суперкомпьютере JUWELS. Последний вступил в строй в 2018 году и на данный момент содержит несколько кластеров и бустеров с различной архитектурой.

Архитектура европейской экзафлопсной системы включает необычные средства. Источник: FZJ Новая система получит отдельные модули, куда входят вычислительные узлы, пулы памяти, узлы с различными ускорителями, узлы визуализации и т.д. Более того, она может быть дополнена блоками, которые содержат нейроморфные и квантовые системы, а также любые вычислительные модули, построенные на технологиях Евросоюза. Стоимость JUPITER оценивается примерно в €502 млн. Половину оплатит EuroHPC, четверть предоставит Министерство образования и науки Германии, оставшаяся четверть придётся на долю Министерства культуры и науки Северной Рейн-Вестфалии.

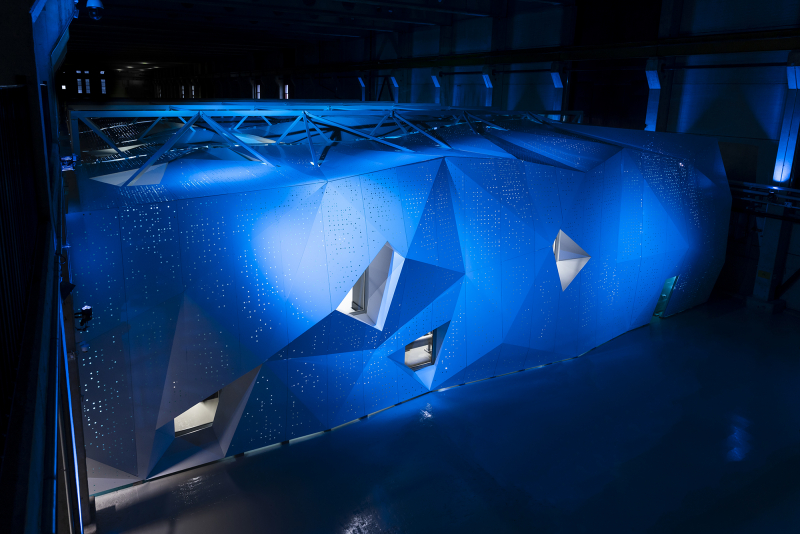

Машинный зал JUWELS. Источник: FZJ Проектировщики уделят серьёзное внимание энергоэффективности новой системы. Ожидается, что её потребление составит около 15 МВт, то есть она будет экономичнее нынешнего лидера TOP500 в лице Frontier. Для питания JUPITER планируется задействовать возобновляемые источники энергии, а СЖО будет использовать теплоноситель с относительно высокой рабочей температурой. Рассматривается возможность утилизации выделяемого системой тепла, как это реализовано в финском LUMI.

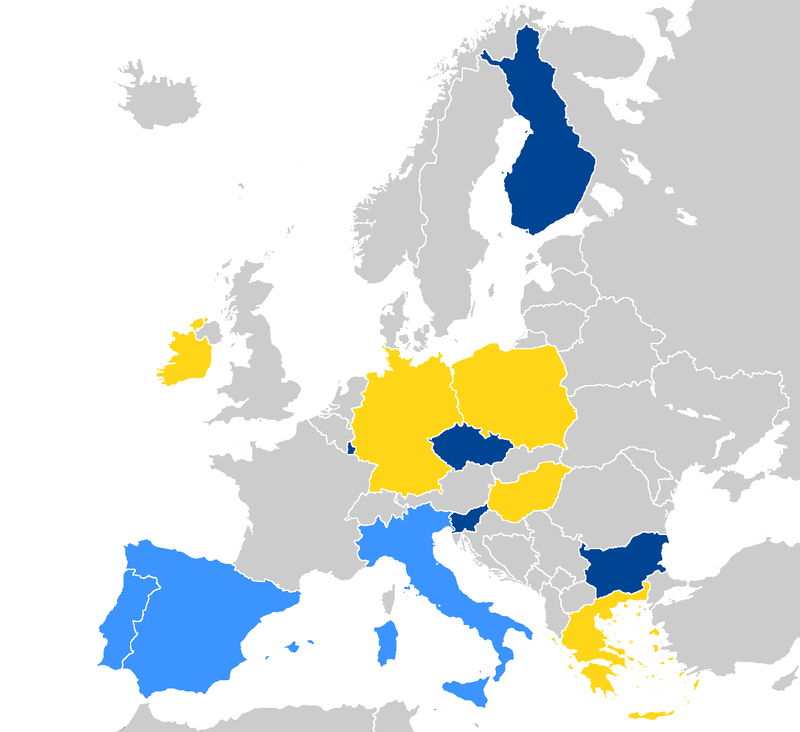

Страны, уже запустившие системы EuroHPC отмечены тёмно-синим, светло-синие — в процессе, жёлтым отмечены новички. Источник: EuroHPC Консорциум также анонсировал ещё четыре, более скромных суперкомпьютера. Это греческий DAEDALUS, венгерский LEVENTE, ирландский CASPIr и польский EHPCPL. В течение следующих нескольких лет EuroHPC планирует ввести в строй ещё минимум два суперкомпьютера экзафлопсного класса, так что гонка за зеттафлопом станет ещё интереснее. Впрочем, и Европе, и США надо опасаться в первую очередь Китая.

14.06.2022 [16:33], Владимир Мироненко

В Финляндии официально запущен LUMI, самый мощный суперкомпьютер в ЕвропеHPE и EuroHPC официально ввели в эксплуатацию вычислительную систему LUMI, установленную в ЦОД центре IT Center for Science (CSC) в Каяани (Финляндия), которая на данный момент считается самым мощным суперкомпьютером в Европе. LUMI — это первая система предэкзафлопсного класса, созданная в рамках совместного европейского проекта EuroHPC. LUMI будет в основном использоваться для решения важных для общества задач, включая исследования в области изменения климата, медицины, наук о жизни и т.д. Система будет применяться для приложений, связанных с высокопроизводительными вычислениями (HPC), искусственным интеллектом и аналитикой данных, а также в областях их пересечения. Для отдельных пользователей суперкомпьютер будет доступен в рамках второй пилотной фазы в августе, а полностью укомплектованная система станет общедоступной в конце сентября. Суперкомпьютер стоимостью €202 млн принадлежит EuroHPC (JU). Половина из этой суммы была предоставлена Евросоюзом, четверть — Финляндией, а остальная часть средств поступила от остальных членов консорциума, включающего 10 стран. По состоянию на 30 мая LUMI занимал третье место в списке TOP500 самых быстрых суперкомпьютеров мира. Сейчас его производительность составляет 151,9 Пфлопс при энергопотреблении 2,9 МВт. LUMI (снег в переводе с финского) базируется на системе HPE Cray EX. Система состоит из двух комплексов. Блок с ускорителями включает 2560 узлов, каждый из которых состоит из одного 64-ядерного кастомного процессора AMD EPYC Trento и четырёх AMD Instinct MI250X. Второй блок под названием LUMI-C содержит только 64-ядерные CPU AMD EPYC Milan в 1536 двухсокетных узлах, имеющих от 256 Гбайт до 1 Тбайт RAM. LUMI также имеет 64 GPU NVIDIA A40, используемых для рабочих нагрузок визуализации, и узлы с увеличенным объёмом памяти (до 32 Тбайт на кластер). Основной интерконнект — Slingshot 11. Хранилище LUMI построено на базе СХД Cray ClusterStor E1000 c ФС Lustre: 8 Пбайт SSD + 80 Пбайт HDD. Также есть объектное Ceph-хранилище ёмкостью 30 Пбайт. Агрегированная пропускная способность СХД составит 2 Тбайт/с. В ближайшее время суперкомпьютер получит дополнительные узлы. После завершения всех работ производительность суперкомпьютера, как ожидается, вырастет примерно до 375 Пфлопс, а пиковая производительность потенциально превысит 550 Пфлопс. Общая площадь комплекса составит порядка 300 м2, а энергопотребление вырастет до 8,5 МВт. Впрочем, запас у площадки солидный — от ГЭС она может получить до 200 МВт. «Мусорное» тепло идёт на обогрев местных домов.

13.06.2022 [16:34], Руслан Авдеев

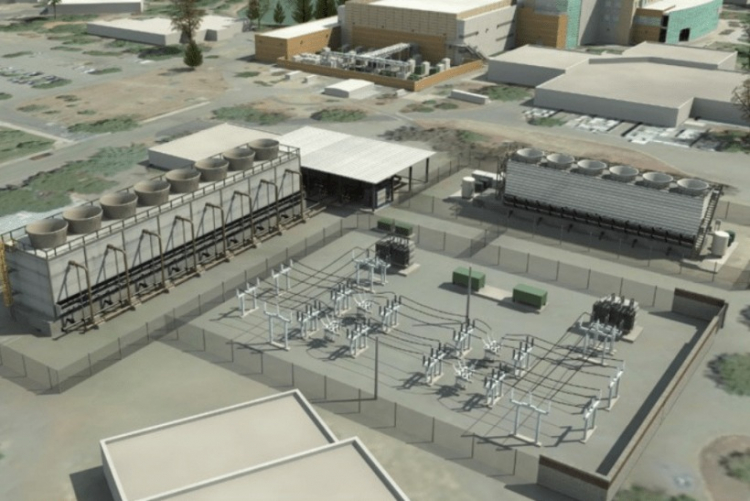

Площадка для будущего 2-Эфлопс суперкомпьютера El Capitan готова: 85 МВт + мощная система охлажденияНациональное управление ядерной безопасности (NNSA) при Министерстве энергетики США официально закончило реконструкцию ЦОД при Ливерморской национальной лаборатории (LLNL) в рамках проекта Exascale Computing Facility Modernization. Обновлены энергетическая система и система охлаждения местного вычислительного центра для использования вычислительных мощностей экзафлопсного уровня. Первой новой действующей системой NNSA станет 2-Эфлопс суперкомпьютер El Capitan, предназначенный для выполнения задач Ливерморской лаборатории, Лос-Аламосской национальной лаборатории и Сандийской национальной лаборатории. По словам представителя NNSA, экзафлопсные вычисления помогут стране в важных, неотложных проектах модернизации вооружений.

Источник изображения: Department of Energy Обновление позволит Ливерморской лаборатории выполнять ресурсоёмкие задачи, 3D-моделирование и симуляцию процессов, связанных с реализацией военных проектов — это необходимо для того, чтобы соответствовать требованиям к сертификации Программы сопровождения ядерного арсенала, реализуемой под эгидой NNSA, основной миссией которой декларируется расширение возможностей американских средств ядерного сдерживания. Сейчас стадия обновления ЦОД завершена и намечен переход к следующим этапам. В результате реализации проекта более, чем удвоилась охлаждающая мощность объекта — теперь он способен ежедневно поглощать количество тепла, достаточного для того, чтобы растопить 28 тыс. тонн льда. Энергетическая мощность ЦОД увеличена с 45 до 85 МВт, а в процессе строительства были обновили линии электропередач, подстанции и управляющее оборудование. Ожидается, что итоговая производительность El Capitan составит более 2 Эфлопс, а потреблять он будет порядка 30–35 МВт. Проработать он должен до 2029 года, однако параллельно будет строиться ещё один суперкомпьютер нового поколения. Некоторые предполагают, что подобные площадки станут последними в своём роде, в первую очередь из-за проблем с электропитанием. |

|