Материалы по тегу: pc

|

25.01.2024 [14:41], Сергей Карасёв

Для звёзд — Xeon, для гравитации — EPYC: Lenovo обновила HPC-кластер Кардиффского университетаКомпания Lenovo поставила в Кардиффский университет в Великобритании 90 серверов ThinkSystem, которые позволили поднять производительность кластера Hawk HPC приблизительно в два раза. Система применяется для решения сложных задач в таких областях, как астрофизика и наука о жизни. Lenovo и британский поставщик IT-решений Logicalis предоставили HPC-ресурсы для двух исследовательских групп в Кардиффском университете. Одна из них — научная коллаборация, участвующая в проекте лазерно-интерферометрической гравитационно-волновой обсерватории (LIGO). Эта инициатива нацелена на обнаружение гравитационных волн. Сообщается, что для проекта LIGO компания Lenovo предоставила 75 серверов ThinkSystem SR645, оснащённых процессорами AMD EPYC Genoa. Эти системы поддерживают до 6 Тбайт оперативной памяти DDR5-4800 в виде 24 модулей и до трёх ускорителей PCIe (2 × PCIe 5.0 и 1 × PCIe 4.0). Отмечается, что установка серверов позволила удвоить вычислительные мощности, доступные исследователям. Вторая исследовательская группа в Кардиффском университете, изучающая процессы звёздообразования, получила 15 серверов Lenovo ThinkSystem SR630 на платформе Intel Xeon Sapphire Rapids и два сервера хранения ThinkSystem SR650 с возможностью установки 20 накопителей LFF или 40 накопителей SFF. Группа сосредоточена на анализе спиральных галактик, таких как наш Млечный Путь. Приобретённые серверы помогут в выполнении сложных задач моделирования.

24.01.2024 [14:50], Сергей Карасёв

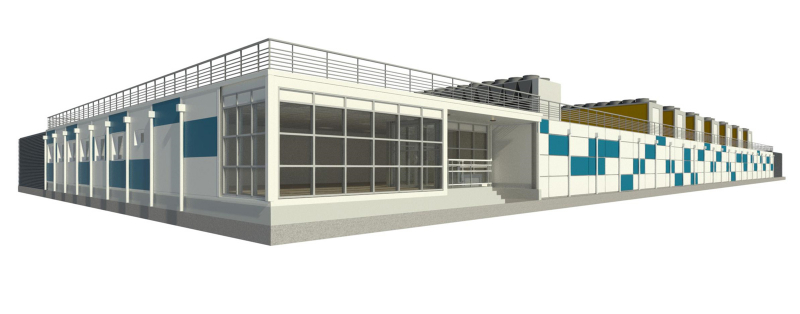

Европейский экзафлопсный суперкомпьютер Jupiter будет построен на базе модульного ЦОДЮлихский исследовательский центр (FZJ) в Германии раскрыл информацию о конфигурации дата-центра для первого европейского суперкомпьютера экзафлопсного класса — системы JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research). Напомним, Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) заключило контракт на создание JUPITER с консорциумом, в который входят Eviden (подразделение Atos) и ParTec, немецкая компания по производству суперкомпьютерного оборудования. Ввод суперкомпьютера в эксплуатацию запланирован на осень 2024 года. Сообщается, что JUPITER будет построен на базе модульного ЦОД, за создание которого отвечает Eviden. Этот дата-центр займёт площадь приблизительно 2300 м2. Модульная архитектура на основе контейнеров обеспечит ряд преимуществ: значительное сокращение времени планирования и монтажа, а также снижение затрат на строительство и эксплуатацию. Кроме того, в дальнейшем облегчится модернизация, тогда как инфраструктура электропитания и охлаждения может гибко адаптироваться к новым требованиям. Eviden заявляет, что благодаря модульности сроки поставки необходимых узлов сократятся на 50 %. Конфигурация ЦОД включает около 50 взаимозаменяемых модулей, в том числе 20 IT-контейнеров, 15 контейнеров энергоснабжения, а также примерно 10 логистических контейнеров со складскими помещениями, инженерными комнатами и пр. В состав IT-модулей войдут по два контейнера, объединяющих 20 стоек платформы BullSequana XH3000 с прямым жидкостным охлаждением. Модули данных будут содержать четыре контейнера с накопителями. Модульный ЦОД финансируется Федеральным министерством образования и исследований (BMBF). При этом BMBF и Министерство культуры и науки земли Северный Рейн-Вестфалия (MKW NRW) обеспечат равное финансирование технического оборудования. В состав суперкомпьютера войдут модули NVIDIA Quad GH200, а также энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea. Быстродействие на операциях обучения ИИ составит до 93 Эфлопс, а FP64-производительность «незначительно превысит 1 Эфлопс».

24.01.2024 [14:50], Руслан Авдеев

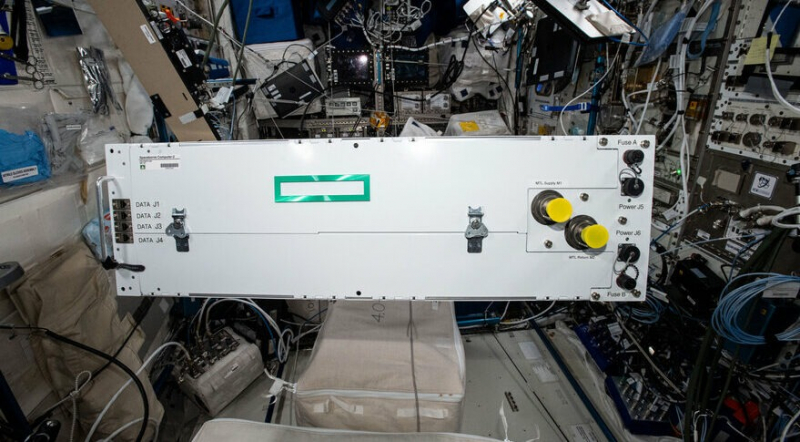

Обновлённый космический суперкомпьютер HPE Spaceborne-2 готов к отправке на МКСНа следующей неделе планируется запуск на Международную космическую станцию (МКС) обновлённого варианта специального вычислительного модуля HPE Spaceborne Computer-2. Как сообщает Национальная лаборатория МКС, это коммерческая версия суперкомпьютера из серийных компонентов, созданная на основе серверов семейств HPE EdgeLine и ProLiant. Организаторами запуска выступают NASA, Northrop Grumman и SpaceX. Старт должен состояться 29 января 2024 года в рамках миссии NG-20 — борту корабля Northrop Grumman Cygnus планируется доставить на станцию различные научные материалы, оборудование и компоненты. Одним из грузов будет и обновлённая версия Spaceborne-2, ранее отправленного на МКС в феврале 2021 года и вернувшегося на Землю 11 января 2023. Первый компьютер серии Spaceborne отправили на МКС 14 августа 2017 года, возвращение состоялось 4 июня 2019.

Источник изображения: NASA По данным Datacenter Dynamics, в состав системы всё ещё входят x86-серверы HPE Edgeline EL4000 с одним GPU и HPE DL360 Gen10. Обновлённая система протестирована HPE и передана NASA. Всего по требованию NASA пришлось внести 516 корректировок. Например, HPE в сотрудничестве с KIOXIA оснастила систему дополнительным хранилищем. Суперкомпьютер поможет продолжающимся на МКС исследованиям, обеспечив более быструю обработку наблюдений со станции за Землёй и более эффективный мониторинг здоровья астронавтов.

24.01.2024 [13:55], Сергей Карасёв

Итальянская нефтегазовая компания Eni получит 600-Пфлопс суперкомпьютер HPC6 на базе AMD Instinct MI250XИтальянская нефтегазовая компания Eni, по сообщению ресурса Inside HPC, заказала суперкомпьютер HPE Cray EX4000 на аппаратной платформе AMD. Быстродействие этой машины, как ожидается, составит около 600 Пфлопс. Известно, что в состав системы, получившей название HPC6, войдут 3472 узла, каждый из которых получит 64-ядерный процессор AMD EPYC и четыре ускорителя AMD Instinct MI250X. Таким образом, общее количество ускорителей составит 13 888. Судя по всему, компания смогла достаточно полно адаптировать своё ПО для работы на современных ускорителях AMD, эксперименты с которыми она начала ещё несколько лет назад. Комплекс будет использовать хранилище HPE Cray ClusterStor E1000 с интерконнектом HPE Slingshot. Узлы суперкомпьютера будут организованы в 28 стоек. Предусмотрено применение технологии прямого жидкостного охлаждения, которая, по заявлениям Eni, рассеивает 96 % вырабатываемого тепла. Максимальная потребляемая мощность — 10,17 МВт.

Источник изображения: AMD Новый суперкомпьютер разместится в ЦОД Eni Green Data Center в Феррера-Эрбоньоне, который, как утверждается, является одним из самых энергоэффективных и экологически чистых вычислительных центров в Европе. По производительности HPC6 значительно превзойдёт комплексы HPC4 и HPC5, совокупная вычислительная мощность которых составляет 70 Пфлопс. При производительности 600 Пфлопс система HPC6 займёт второе место в текущем списке TOP500 самых мощных суперкомпьютеров мира.

17.01.2024 [08:08], Владимир Мироненко

300 кВт на стойку: Aligned представила СЖО DeltaFlow~ для своих дата-центровКомпания Aligned представила новую систему жидкостного охлаждения DeltaFlow~, которая позволяет увеличить плотность размщения вычислительных мощностей 300 кВт на стойку, сообщил ресур Datacenter Dynamics. DeltaFlow~ — это готовое решение, поддерживающее текущие и будущие технологии жидкостного охлаждения, включая прямое охлаждение direct-to-chip с CDU, охлаждение с использованием теплообменника на задней дверце (Rear-door Heat Exchanger, RDHx) и иммерсионное охлаждение. Решение опирается на систему с замкнутым контуром без использования наружного воздуха или воды. По словам Alidned, новая СЖО позволяет клиентам по-максимуму использовать современные чипы и ускорителя, сокращая время выхода на рынок, затраты и риски. DeltaFlow~ также интегрируется с технологией воздушного охлаждения Delta3 (Delta Cube) без изменений в подаче электроэнергии или существующей температуры в машинных залах. Delta3 вместо традиционного холодного коридора использует вентиляторы и теплообменники, расположенные непосредственно за стойками и подключённые к водяному контуру, уходящему к чиллерам. Delta3 позволяет добиться плотности до 50 кВт на стойку. Aligned стала одной из последних компаний, анонсировавшей платформу для оборудования высокой плотности, основанное на жидкостном охлаждении. Ранее в этом месяце Stack представила решение с использованием погружного охлаждения, которое позволяет поддерживать мощность 300 кВт или выше на стойку. Летом прошлого года CyrusOne анонсировала новую архитектуру ЦОД для ИИ-нагрузок, где тоже используется погружное охлаждение и тоже можно получить 300 кВт на стойку. Тогда же Digital Realty запустила услугу колокации с поддержкой размещений до 70 кВт на стойку, а в декабре Equinix объявила о планах по расширению поддержки передовых технологий СЖО в значительной части своих ЦОД, хотя и не указала предельную плотность. DataBank также переработала конструкцию машинных залов для поддержки размещений высокой плотностью с использованием жидкостного охлаждения.

16.01.2024 [22:51], Руслан Авдеев

Заброшенные шахты могут стать хранилищами «мусорного» тепла эдинбургского суперкомпьютераМеждународная группа учёных намеревается выяснить, можно ли сохранить «мусорное» тепло суперкомпьютера Эдинбургского университета в старых шахтах для того, чтобы впоследствии направить его на отопление местных домов. По словам учёных, в шахтах много воды, поэтому они способны стать идеальным хранилищем тепла. При этом для более чем 800 тыс. шотландских домохозяйств отопление является дорогим удовольствием, так что дешёвый источник тепла им не помешает. Исследование обойдётся в £2,6 млн ($3,3 млн), сообщает Datacenter Dynamics. Эдинбургский университет выделит £500 тыс. ($633 тыс). из собственно фонда, связанного со снижением вредных выбросов, а правительство Шотландии предоставило грант на сумму £1 млн ($1,27 млн). Подключатся и другие структуры, включая даже Министерство энергетики США с грантом $1 млн. Дата-центр Advanced Computing Facility (ACF) на территории Эдинбургского университета уже обслуживает один суперкомпьютер, а в 2025 году к нему присоединится машина экзафлопсного уровня, первый суперкомпьютер такого класса в Великобритании. В рамках исследования Edinburgh Geobattery, проводимого специалистами в области геотермальной энергетики TownRock Energy совместно с представителями науки и промышленности, будет оцениваться, возможно и целесообразно ли хранить тёплую воду (+40 °C) в заброшенных шахтах до того, как передать её на нужды городского отопления. Предполагается, что тепло ACF поможет обогреть не менее 5 тыс. домохозяйств, если тесты подтвердят теоретические выкладки. ACF выделяет до 70 ГВт·ч тепла ежегодно, но после запуска нового суперкомпьютера этот показатель увеличится до 272 ГВт·ч. Новая машина, оснащённая СЖО, будет построена в специально возведённом крыле ACF, которое само по себе обойдётся в £31 млн ($39,24 млн). Использование тепла ЦОД обычно считается довольно эффективным методом дополнительной эксплуатации дата-центров. Тем не менее, такая технология имеет серьёзный недостаток, поскольку передавать тепло туда, где оно востребовано, не всегда целесообразно. Некоторые европейские системы располагаются в «шаговой» доступности от систем районного отопления, а другие представляют собой небольшие вычислительные модули, которые предлагается размещать непосредственно в зданиях. Есть и проекты централизованного управления передачей тепла ЦОД. В непосредственной близости от Эдинбурга находятся заброшенные угольные, сланцевые и другие шахты, частично затопленные подземными водами. Проект предусматривает передачу тепла ЦОД естественными потоками грунтовых вод, с последующим использованием теплонасосов для обогрева зданий. Более того, в университете утверждают, что четверть британских домов расположена над бывшими шахтами, поэтому гипотетически получить тепло таким способом могут до 7 млн домохозяйств.

05.01.2024 [01:08], Владимир Мироненко

Варяг на княжение: Intel назначила вице-президентом группы DCAI Джастина Хотарда из HPEКорпорация Intel объявила о назначении с 1 февраля исполнительным вице-президентом и генеральным менеджером подразделения Data Center and AI Group (DCAI) Джастина Хотарда (Justin Hotard), до этого занимавшего должность исполнительного вице-президента и генерального менеджера по высокопроизводительным вычислениям (HPC), ИИ и лабораториям в Hewlett Packard Enterprise (HPE). До прихода в HPE в 2015 году Хотард занимал пост президента NCR Small Business, а также работал в компаниях Symbol Technologies и Motorola Inc., где занимался корпоративным развитием и операционной деятельностью. Хотард получил степень бакалавра наук в области электротехники в Университете Иллинойса в Урбана-Шампейне и степень магистра делового администрирования в Школе менеджмента Слоуна при Массачусетском технологическом институте.

Источник изображения: Intel Джастин Хотард сменит на посту Сандру Риверу (Sandra Rivera), которая 1 января стала главным исполнительным директором Programmable Solutions Group (PSG), самостоятельного подразделения Intel. Аналогичная судьба постигла и Аруна Субраманьяна (Arun Subramaniyan), теперь уже бывшего вице-президента и генерального менеджера DCAI, который был переведён в формально независимую компанию Articul8, ответственную за программную ИИ-платформу для корпоративных заказчиков. Сам по себе приход на столь высокую должность человека, который ранее не работал в Intel, для корпорации несколько необычен. Хотард будет подчиняться непосредственно главе корпорации Пэту Гелсингеру (Patrick Gelsinger). Он будет отвечать за набор продуктов Intel для ЦОД, охватывающий корпоративные и облачные технологии, включая процессоры Xeon, GPU и ускорители. Он также будет заниматься внедрением и развитием технологий ИИ.

04.01.2024 [00:31], Владимир Мироненко

Китай построил 500-Пфлопс публичную ИИ-платформу Shangzhuang, которая вскоре станет втрое мощнееКитай запустил облачную ИИ-платформу, управляемую окологосударственным холдингом Beijing Energy Holding (BEH). «Пекинская публичная вычислительная платформа» (Beijing AI Public Computing Platform), также известная как проект Shangzhuang, поможет смягчить «острую нехватку вычислительных мощностей» в стране, необходимых для развития технологий ИИ. Платформа доступна для использования образовательными учреждениями, исследовательскими центрами, а также малыми и средними предприятиями. Её первая фаза с вычислительной мощностью 500 Пфлопс (FP16) была официально запущена в самом конце 2023 года. В I квартале 2024 года планируется завершить вторую фазу строительства, доведя производительность Shangzhuang до 1,5 Эфлопс. А в будущем остаётся возможность построить ещё 2 Эфлопс мощностей. BEH заявил о своём стремлении сделать проект максимально экологически дружественным, выразив намерение в будущем полностью обеспечивать платформу чистой энергией. С этой целью BEH подписал соглашения о стратегическом сотрудничестве с Alibaba Cloud Computing, Sugon Information Industry и стартапом Zhipu AI для совместной работы в области зелёной энергетики, публичного облака и инфраструктуры интеллектуальных вычислений.

28.12.2023 [16:33], Сергей Карасёв

Стоимость активов российского производителя суперкомпьютеров «Т-платформы» рухнула в 16 разАрбитражный суд Москвы, как сообщает «Интерфакс», определил действительную стоимость активов российского разработчика суперкомпьютеров АО «Т-платформы». Она установлена в размере 343 млн руб., тогда как в конце 2016 года компания оценивалась в 5,6 млрд руб. Таким образом, показатель рухнул более чем в 16 раз. Проблемы у «Т-платформ» начались ориентировочно в 2019 году, когда по делу о поставке компьютеров в российское МВД на сумму 357,1 млн руб. был арестован основатель компании Всеволод Опанасенко. После этого «Т-платформы» фактически прекратили реальную деятельность, что, в конечном итоге, привело к банкротству предприятия. Согласно данным бухгалтерского баланса АО «Т-Платформы» за 2022 год, стоимость активов компании составляла 342,95 млн руб. Именно такую сумму конкурсный управляющий компании указал в заявлении, направленном в столичный арбитраж. Установление действительной стоимости активов предприятия необходимо для «целей дополнительного страхования ответственности арбитражного управляющего».

Источник изображения: pixabay.com Господин Опанасенко, который по версии следствия хотел незаконным путём получить преимущественные условия при заключении госконтракта на поставку компьютерного оборудования МВД, в мае 2023 года был приговорён к двум годам и четырём месяцам колонии общего режима. При этом основатель «Т-платформ» был освобождён от отбытия наказания с учётом сроков его ареста и заочного ареста до суда. Для Опанасенко также назначен штраф в размере 300 тыс. руб. Отмечается, что в мошенническую схему был вовлечён бывший начальник управления связи департамента информационных технологий, связи и защиты информации МВД России Александр Александров. Согласно материалам дела, ему было известно, что поставляемое «Т-Платформами» оборудование с процессорами «Байкал-Т1» не соответствует техническим характеристикам, необходимым для нужд МВД. Ущерб, нанесённый государству, оценён более чем в 350 млн руб. Суд взыскал с Опанасенко и Александрова 357 тыс. руб. по иску МВД России и с Александрова — 122 тыс. руб. по гражданскому иску Воронежского института МВД.

13.11.2023 [17:00], Игорь Осколков

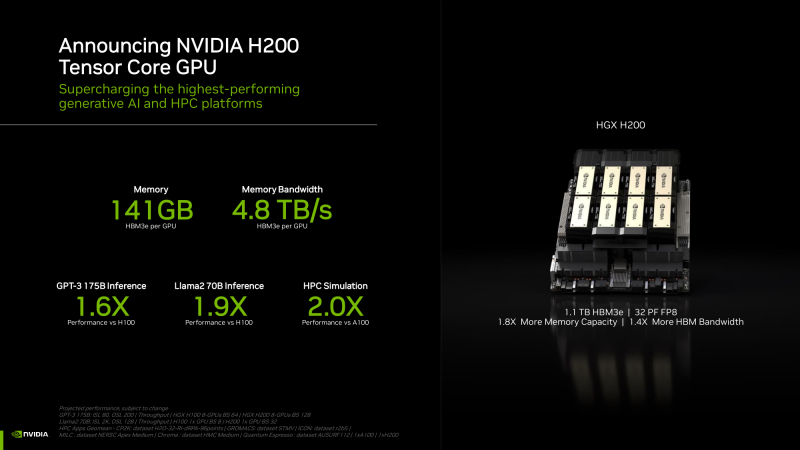

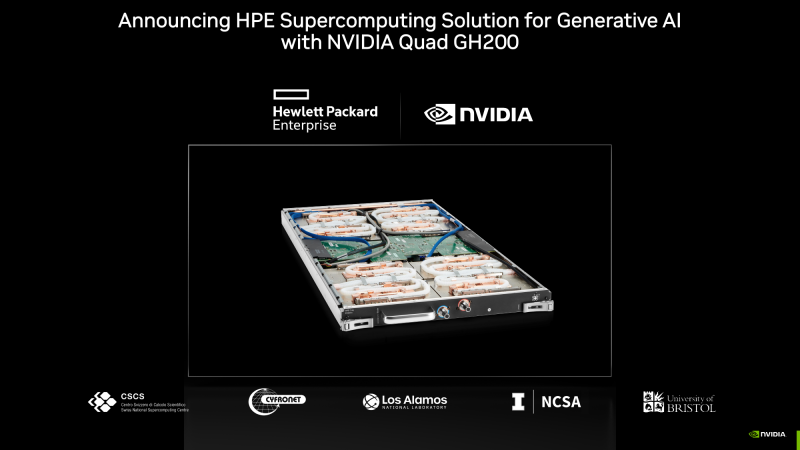

NVIDIA анонсировала ускорители H200 и «фантастическую четвёрку» Quad GH200NVIDIA анонсировала ускорители H200 на базе всё той же архитектуры Hopper, что и их предшественники H100, представленные более полутора лет назад. Новый H200, по словам компании, первый в мире ускоритель, использующий память HBM3e. Вытеснит ли он H100 или останется промежуточным звеном эволюции решений NVIDIA, покажет время — H200 станет доступен во II квартале следующего года, но также в 2024-м должно появиться новое поколение ускорителей B100, которые будут производительнее H100 и H200.

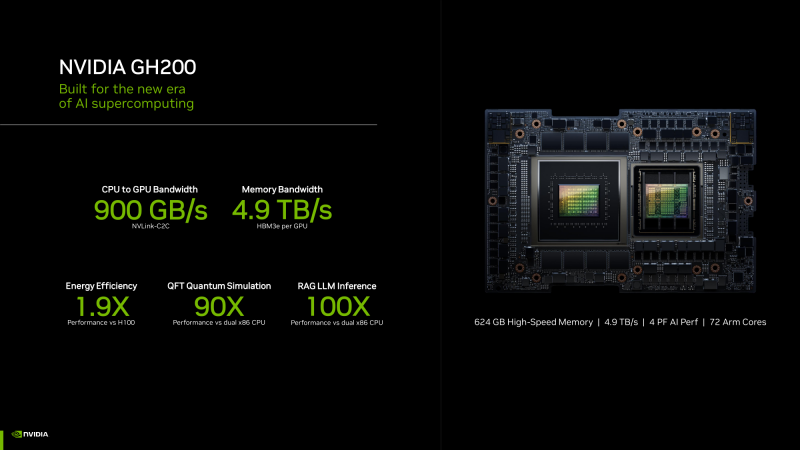

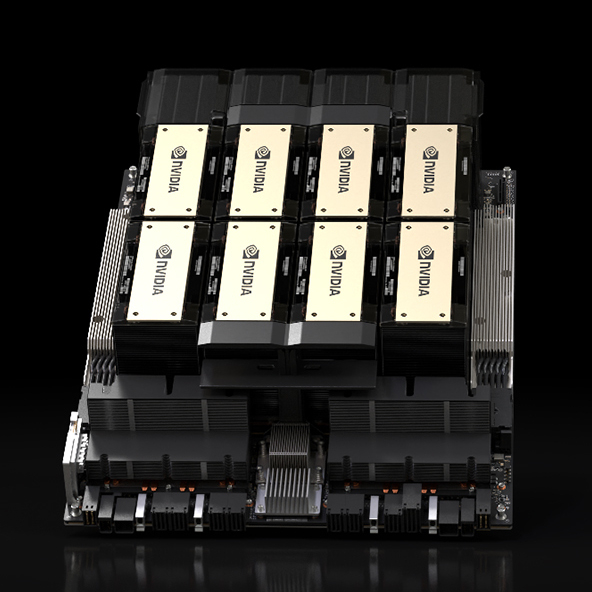

HGX H200 (Источник здесь и далее: NVIDIA) H200 получил 141 Гбайт памяти HBM3e с суммарной пропускной способностью 4,8 Тбайт/с. У H100 было 80 Гбайт HBM3, а ПСП составляла 3,35 Тбайт/с. Гибридные ускорители GH200, в состав которых входит H200, получат до 480 Гбайт LPDDR5x (512 Гбайт/с) и 144 Гбайт HBM3e (4,9 Тбайт/с). Впрочем, с GH200 есть некоторая неразбериха, поскольку в одном месте NVIDIA говорит о 141 Гбайт, а в другом — о 144 Гбайт HBM3e. Обновлённая версия GH200 станет массово доступна после выхода H200, а пока что NVIDIA будет поставлять оригинальный 96-Гбайт вариант с HBM3. Напомним, что грядущие конкурирующие AMD Instinct MI300X получат 192 Гбайт памяти HBM3 с ПСП 5,2 Тбайт/с. На момент написания материала NVIDIA не раскрыла полные характеристики H200, но судя по всему, вычислительная часть H200 осталась такой же или почти такой же, как у H100. NVIDIA приводит FP8-производительность HGX-платформы с восемью ускорителями (есть и вариант с четырьмя), которая составляет 32 Пфлопс. То есть на каждый H200 приходится 4 Пфлопс, ровно столько же выдавал и H100. Тем не менее, польза от более быстрой и ёмкой памяти есть — в задачах инференса можно получить прирост в 1,6–1,9 раза. При этом платы HGX H200 полностью совместимы с уже имеющимися на рынке платформами HGX H100 как механически, так и с точки зрения питания и теплоотвода. Это позволит очень быстро обновить предложения партнёрам компании: ASRock Rack, ASUS, Dell, Eviden, GIGABYTE, HPE, Lenovo, QCT, Supermicro, Wistron и Wiwynn. H200 также станут доступны в облаках. Первыми их получат AWS, Google Cloud Platform, Oracle Cloud, CoreWeave, Lambda и Vultr. Примечательно, что в списке нет Microsoft Azure, которая, похоже, уже страдает от недостатка H100. GH200 уже доступны избранным в облаках Lamba Labs и Vultr, а в начале 2024 года они появятся у CoreWeave. До конца этого года поставки серверов с GH200 начнут ASRock Rack, ASUS, GIGABYTE и Ingrasys. В скором времени эти чипы также появятся в сервисе NVIDIA Launchpad, а вот про доступность там H200 компания пока ничего не говорит. Одновременно NVIDIA представила и базовый «строительный блок» для суперкомпьютеров ближайшего будущего — плату Quad GH200 с четырьмя чипами GH200, где все ускорители связаны друг с другом посредством NVLink по схеме каждый-с-каждым. Суммарно плата несёт более 2 Тбайт памяти, 288 Arm-ядер и имеет FP8-производительность 16 Пфлопс. На базе Quad GH200 созданы узлы HPE Cray EX254n и Eviden Bull Sequana XH3000. До конца 2024 года суммарная ИИ-производительность систем с GH200, по оценкам NVIDIA, достигнет 200 Эфлопс. |

|