Материалы по тегу: nvidia

|

31.01.2025 [16:44], Руслан Авдеев

США подозревают DeepSeek в получении подсанкционных ИИ-ускорителей NVIDIA через посредников в СингапуреАмериканские власти намерены выяснить, не покупал ли китайский ИИ-стартап DeepSeek передовые ускорители NVIDIA у сингапурских компаний в обход введённых США санкций. Недавно китайская компания представила модели R1 и V3, в некоторых отношениях сопоставимые по возможностям с американскими решениями или даже превосходящие их, при этом гораздо более дешёвых. Это косвенно свидетельствует о том, что ИИ в Китае развивается гораздо успешнее, чем считалось, сообщает Bloomberg. Эксперты уже отметили экономическую эффективность и производительность бота, а соперники задумались, не имели ли стартап доступ к подсанкционным западным технологиям. Представители Белого дома и ФБР пытаются выяснить, мог ли DeepSeek воспользоваться услугами посредников из Сингапура для покупки чипов NVIDIA, запрещённых к официальным поставкам в КНР. В самой китайской компании не ответили на запрос журналистов, а в NVIDIA заявили, что её партнёры соблюдают все соответствующие законы. Если появится информация об обратном, NVIDIA будет «действовать соответствующим образом». Ранее компания предположила, что DeepSeek не нарушает американских санкций. В Министерстве торговли США полагают, что DeepSeek обошла экспортные ограничения на чипы NVIDIA, закупая их «тоннами». Чиновники заявили: если китайская компания хочет конкурировать, пусть делает это без использования американских инструментов, и пообещали проводить жёсткую политику в отношении экспортного контроля. Однако самая ситуация привела к дебатам об эффективности американских попыток отрезать КНР от передовых технологий. Ограничения, касающиеся самых передовых ускорителей и инструментов для их производства, должны были замедлить развитие ИИ в Китае. DeepSeek утверждает, что для обучения моделей она использовала 10 тыс. ускорителей NVIDIA A100 и 2048 ускорителей NVIDIA H800 с «урезанной» функциональностью, выпускавшихся специально для Китая. В октябре 2023 года власти США запретили продавать в Китай и H800, поэтому NVIDIA выпустила ещё более слабые ускорители H20 для этого рынка. Теперь ведутся дискуссии, стоит ли запретить продавать в КНР и их. В 2023 году США ввели ограничения в отношении более 40 стран, которые могли служить посредниками для переправки ускорителей в Китай. Запрет коснулася большинства стран Ближнего Востока и ряда государств Юго-Восточной Азии, но Сингапур в их число не вошёл. В 2025 году действие ограничений расширили на большую часть планеты — за исключением горстки союзников. Теперь крупные поставки в Сингапур требуют специальной разрешения. Важно, что на Сингапур приходится около 20 % выручки NVIDIA, но, по некоторым данным, большинство заказов фактически уходит в другие регионы, а в сам город-государство поступало довольно мало ускорителей. В NVIDIA настаивают, что огромная выручка от торговли с Сингапуром не связана с утечкой в Китай. В компании заявляют, что многие компании имеют структуры в Сингапуре, которые выпускают продукты, предназначенные для США и Запада в целом. Впрочем, члены Палаты представителей США от обеих правящих партий уже обратились к советнику президента по национальной безопасности. Они заявили, что необходимо ввести строгое лицензирование экспорта для стран вроде Сингапура, «не желающих пресечь» поставки в Китай.

28.01.2025 [18:40], Владимир Мироненко

«Рынки ошибаются»: DeepSeek не угрожает NVIDIA и другим американским IT-гигантам

deepseek

fortune

hardware

nvidia

анализ рынка

ии

инференс

китай

прогноз

санкции

сша

ускоритель

финансы

Рост популярности ИИ-технологий способствовал росту рыночной стоимости NVIDIA выше $3 трлн. Однако её акции обрушились в понедельник на 17 %, вызвав падение рыночной стоимости компании почти на $600 млрд, после анонса китайским стартапом DeepSeek ИИ-моделей V3 и R1, способных соперничать с лучшими моделями любой американской компании, хотя и были обучены за малую часть стоимости на менее продвинутых чипах NVIDIA H800 и A100, пишет Fortune. Также в начале недели приложение AI Assistant стартапа DeepSeek вышло на первое место в рейтинге самых популярных бесплатных приложений в интернет-магазине в Apple App Store в США, опередив ИИ-чат-бот ChatGPT от OpenAI. Более того, модель DeepSeek R1, призванная бросить вызов модели «рассуждений» OpenAI o1, можно запустить на рабочей станции, а не в ЦОД. Поскольку мощные ускорители NVIDIA являются одной из самых больших статей расходов на разработку самых передовых моделей ИИ, инвесторы начали пересматривать свои представления относительно вложений в ИИ-бизнес. Да, DeepSeek явно потряс рынок ИИ, однако разговоры о крахе NVIDIA могут быть преждевременными, равно как и заявления о том, что успех DeepSeek означает, что США следует отказаться от политики, направленной на ограничение доступа Китая к самым передовым ИИ-чипам, предупреждают аналитики Fortune. DeepSeek утверждает, что использует 10 тыс. ускорителей NVIDIA A100, а также чипы H800, что на порядок меньше, чем используют американские компании для обучения своих самых передовых ИИ-моделей. Например, Xai Илона Маска (Elon Musk) построила вычислительный кластер Colossus в Теннесси на базе 100 тыс. ускорителей NVIDIA H100, его планирует расширить до 1 млн чипов. Это дало повод некоторым экспертам утверждать, что введение ограничений США подстегнуло инновации в Китае. В Fortune считают такие умозаключения недальновидными и утверждают, что влияние DeepSeek может, как это ни парадоксально звучит на первый взгляд, увеличить спрос на передовые чипы ИИ — как NVIDIA, так и её конкурентов. Причина отчасти заключена в феномене, известном как парадокс Джевонса (Jevons Paradox). Парадокс Джевонса, также известный как эффект отскока, назван в честь британского экономиста XIX века Уильяма Стэнли Джевонса (William Stanley Jevons), который заметил: когда технический прогресс делает использование ресурса более эффективным, общее потребление этого ресурса имеет тенденцию к увеличению. Это имеет смысл, если спрос на что-либо относительно эластичен — снижающаяся из-за повышения эффективности цена создаёт ещё больший спрос на продукт. Одной из причин слабого внедрения ИИ-моделей в крупных организациях была их дороговизна. Это особенно касалось новых «рассуждающих» моделей, таких как o1 от OpenAI. Модели DeepSeek гораздо дешевле конкурентов в эксплуатации, так что теперь компании могут позволить себе развёртывать их для многих сценариев использования. В масштабах отрасли это может привести к резкому росту спроса на вычислительную мощность. В понедельник гендиректор Microsoft Сатья Наделла (Satya Nadella) и бывший гендиректор Intel Пэт Гелсингер (Pat Gelsinger) указали на это в сообщениях в социальных сетях. Наделла напрямую сослался на парадокс Джевонса, в то время как Гелсингер сказал, что «вычисления подчиняются» тому, что он назвал «законом газа». «Если сделать его значительно дешевле, рынок для него расширится… это сделает ИИ гораздо более широко распространенным, — написал он. — Рынки ошибаются». В Fortune задались вопросом: «Какая именно вычислительная мощность потребуется?». Топовые ускорители NVIDIA оптимизированы для обучения крупнейших больших языковых моделей (LLM), таких как GPT-4 от OpenAI или Claude 3-Opus от Anthropic. Для инференса чипы NVIDIA меньше подходят, чем изделия конкурентов, включая AMD и, например, Groq, чипы которых позволяют исполнять ИИ-нагрузки быстрее и намного эффективнее. Google и Amazon также создают свои собственные чипы ИИ, некоторые из которых оптимизированы для инференса. NVIDIA сейчас занимает более 80 % рынка ИИ-вычислений на базе ЦОД (если исключить кастомные ASIC облачных провайдеров, её доля может составить до 98 %) и вряд ли утратит доминирование быстро или полностью, отметили в Fortune. Ёе ускорители также могут использоваться для инференса, а программная платформа CUDA имеет большое и лояльное сообщество разработчиков, которое вряд ли откажется от него в одночасье. Если общий спрос на ИИ-чипы увеличится из-за парадокса Джевонса, общие доходы NVIDIA всё равно смогут вырасти даже при падении доли на рынке из-за увеличившегося рынка. Ещё одна причина, по которой спрос на передовые ИИ-чипы, вероятно, продолжит рост, связана с особенностями работы моделей рассуждений, таких как R1. В то время как способности предыдущих типов LLM росли по мере увеличения доступной вычислительной мощности во время обучения, то модели рассуждений зависят от вычислительных ресурсов во время инференса — чем их больше, тем лучше ответы. Запустив R1 на ноутбуке, можно получить хороший ответ на сложный математический вопрос, скажем, через час, в то время как при использовании ускорителей в облаке на тот же ответ уйдут считанные секунды. Для многих бизнес-приложений задержка или время, необходимое модели для ответа, имеет большое значение. И чтобы сократить время выполнения задачи, по-прежнему будут нужны передовые ИИ-ускорители. Кроме того, многие эксперты сомневаются в правдивости заявления DeepSeek о том, что её модель V3 была обучена примерно на 2048 урезанных ускорителях NVIDIA H800 или что её модель R1 была обучена на столь малом количестве чипов. Александр Ван (Alexandr Wang), генеральный директор Scale AI, сообщил в интервью CNBC, что, по его данным, DeepSeek тайно получила доступ к кластеру из 50 тыс. ускорителей H100. Также известно, что хедж-фонд HighFlyer, которому принадлежит DeepSeek, успел закупить до введения санкций значительное количество менее производительных ускорителей NVIDIA. Так что вполне возможно, что NVIDIA находится в лучшем положении, чем предполагают паникующие инвесторы, и что проблема с экспортным контролем США заключается не в политике, а в её реализации, подытожили аналитики Fortune.

28.01.2025 [12:10], Сергей Карасёв

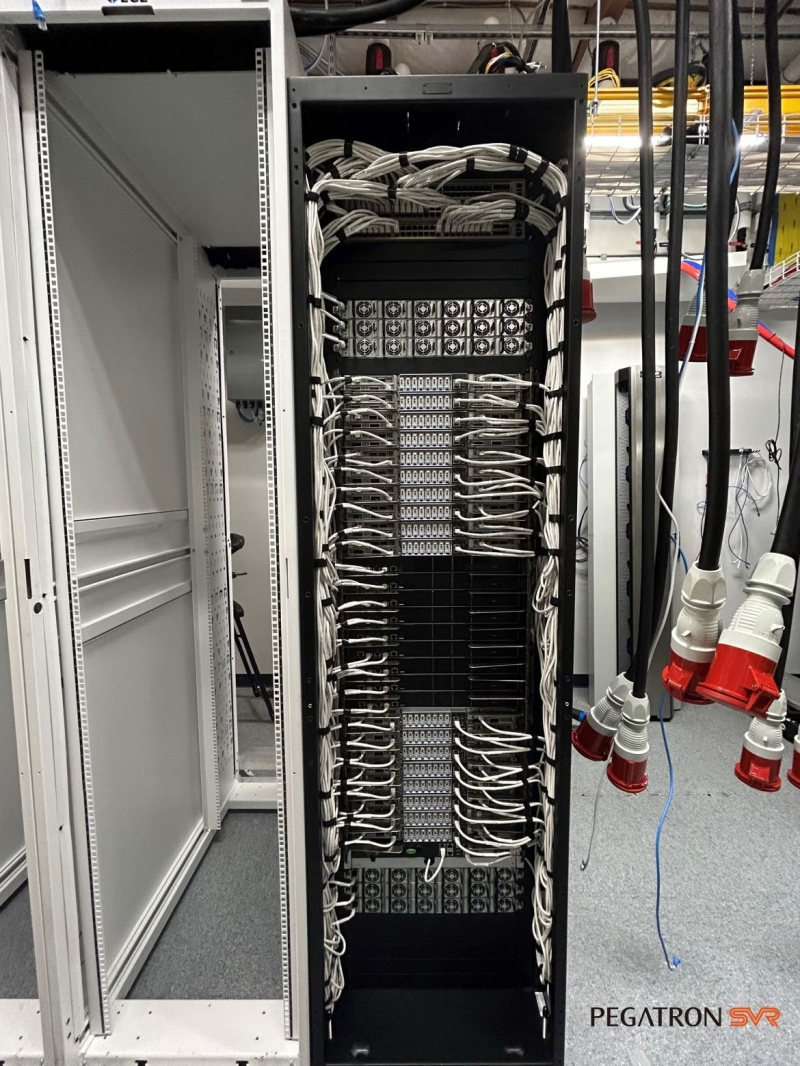

Pegatron поставит суперускорители NVIDIA GB200 NVL72 ИИ-стартапу Lambda LabsСтартап Lambda Labs, по сообщению ресурса Datacenter Dynamics, заключил партнёрское соглашение с серверным подразделением тайваньского ODM-производителя компьютерных комплектующих Pegatron. В рамках договора Pegatron развернёт суперускорители NVIDIA GB200 NVL72 для ИИ-инфраструктуры Lambda Labs. Напомним, фирма Lambda Labs была основана в 2012 году. Она предоставляет услуги облачных ИИ-вычислений с использованием собственных систем, оснащённых ускорителями NVIDIA, а также процессорами AMD и Intel. Кроме того, компания продаёт рабочие станции на базе GPU и предоставляет услуги колокации. Lambda Labs провела несколько раундов финансирования: полученные средства направляются на наращивание вычислительных мощностей и увеличение штата. В июле 2024 года сообщалось, что у суперускорителей с чипами NVIDIA GB200 возникли проблемы с СЖО: из-за дефектных компонентов фиксировались протечки. А в ноябре появилась информация, что стойки NVL72 перегревались, в связи с чем NVIDIA была вынуждена обратиться к поставщикам с просьбой внести ряд изменений в конструкцию стоек. Кроме того, NVIDIA и Schneider Electric занялись разработкой эталонной архитектуры охлаждения для ЦОД на основе GB200 NVL72. Впрочем, на текущий момент все проблемы устранены, а NVIDIA и партнёры организовали полномасштабное производство серверов на базе Blackwell. При этом клиенты уже приступили к монтажу суперускорителей GB200 NVL72. Такие системы, в частности, устанавливает стартап xAI Илона Маска (Elon Musk). Как отмечается, стратегическое партнёрство с Lambda Labs позволит Pegatron выйти на стремительно расширяющийся рынок ИИ-серверов. Первая система GB200 NVL72 (производства Supermicro), принадлежащая Lambda, была запущена на прошедших выходных в «водородном» дата-центре EdgeCloudLink.

28.01.2025 [00:14], Владимир Мироненко

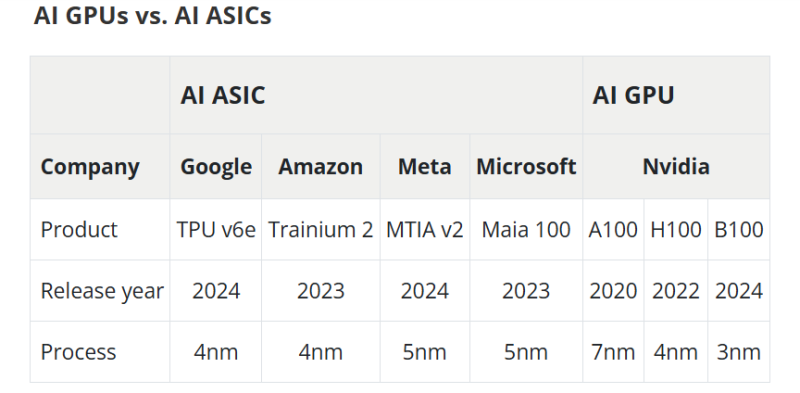

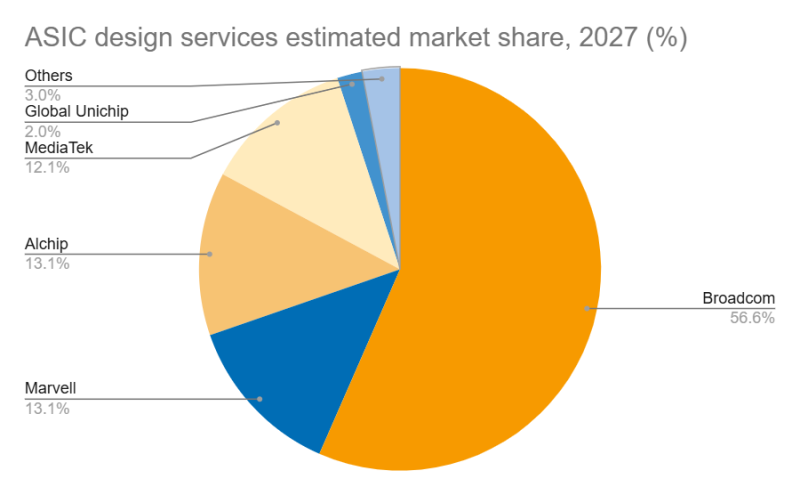

Дороговизна и высокое энергопотребление ИИ-ускорителей NVIDIA открыли новые горизонты для Marvell и BroadcomВзрывной рост популярности ChatGPT и других решений на базе генеративного ИИ вызвал беспрецедентный спрос на вычислительные мощности, что привело к дефициту ИИ-ускорителей, пишет DIGITIMES. NVIDIA занимает львиную долю рынка ИИ-чипов, а ведущие поставщики облачных услуг, такие как Google, Amazon и Microsoft, активно занимаются проектами по разработке собственных ускорителей, стремясь снизить свою зависимость от внешних поставок. Всё большей популярностью у крупных облачных провайдеров пользуются ASIC, поскольку они стремятся оптимизировать чипы под свои конкретные требования, отметил DIGITIMES. ASIC обеспечивают высокую производительность и энергоэффективность в узком спектре задач, что делает их альтернативой универсальным ускорителям NVIDIA. Несмотря на доминирование NVIDIA на рынке, высокое энергопотребление её чипов в сочетании с высокой стоимостью позволило ASIC занять конкурентоспособную нишу. Особенно хорошо ASIC подходят для обучения и инференса ИИ-моделей, предлагая значительно более высокие показатели производительности в пересчёте на 1 Вт по сравнению с GPU общего назначения. Также ASIC предоставляют заказчикам больший контроль над своим технологическим стеком. На рынке разработки ASIC основными конкурентами являются Broadcom и Marvell, которые используют разные технологии и стратегические подходы. Marvell укрепила свои позиции на рынке, в частности, благодаря партнёрству с Google в разработке серверных Arm-чипов, расширив при этом стратегическое сотрудничество со своим основным клиентом — Amazon. TPU v6e от Google представляет собой самую передовую ASIC ИИ среди чипов, разработанных четырьмя ведущими облачными провайдерам, приближаясь по производительности к H100. Однако она всё ещё отстает от ускорителей NVIDIA примерно на два года, утверждает DIGITIMES. Созданный Marvell и Amazon ускоритель Trainium 2 по производительности находится между NVIDIA A100 и H100. В ходе последнего отчёта о финансовых результатах Marvell поделилась прогнозом значительного роста выручки от ASIC, начиная с 2024 года (2025 финансовый год), обусловленного Trainium 2 и Google Axion. В частности, совместный с Amazon проект Marvell Inferential ASIC предполагается запустить в массовое производство в 2025 году (2026 финансовый год), в то время как Microsoft Maia, как ожидается, начнет приносить доход с 2026 года (2027 финансовый год). Как утверждают в Morgan Stanley, хотя бизнес Marvell по производству кастомных чипов является ключевым драйвером роста его подразделения по разработке решений для ЦОД, он также несёт в себе значительную неопределённость. Краткосрочные прогнозы Morgan Stanley для продуктов Marvell/Trainium положительны, что подтверждается возросшими мощностями TSMC по упаковке чипов методом CoWoS, планами Amazon по расширению производства и уверенностью Marvell в рыночном спросе. Однако в долгосрочной перспективе конкурентная среда создает проблемы. Появление компаний вроде WorldChip Electronics в секторе вычислительных чипов может заставить Marvell переориентироваться на сетевые решения. Кроме того, потенциальное снижение прибыли от Trainium после 2026 года означает, что Marvell нужно будет обеспечить запуск новых проектов для поддержания динамики роста, говорят аналитики. Broadcom и Marvell являют собой примеры разных стратегий развития в секторе ASIC, отмечает DIGITIMES. Broadcom отдаёт приоритет крупномасштабной интеграции и проектированию платформ, подкрепляя свой подход значительными инвестициями в НИОКР и сложной технологической интеграцией. В свою очередь, Marvell развивается за счёт стратегических приобретений, например, Cavium, Avera и Innovium, благодаря чему расширяет своё портфолио технологий.

27.01.2025 [18:43], Руслан Авдеев

Индийская Reliance заявила, что построит «крупнейший ЦОД в мире» мощностью 3 ГВтИндийская Reliance Industries намерена построить «крупнейший в мире» дата-центр в городе Джамнагар (штат Гуджарат, Индия). Планы реализации проекта в штате впервые обнародовали в сентябре 2024 года, теперь ожидается, что Reliance закупит для него ускорители NVIDIA, сообщает Datacenter Dynamics. Ранее компании объявили о совместной разработке ИИ-суперкомпьютеров в Индии и создании больших языковых моделей (LLM) на разных языках страны. В планы входит совместная постройка ИИ-инфраструктуры на территории всей страны. Для запланированного ЦОД гигаваттного уровня NVIDIA готова была поставлять чипы семейства Blackwell. Правда, пока непонятно, как план будет реализован на фоне введённых США ограничений. Индийскую инициативу поддержал глава NVIDIA Дженсен Хуанг (Jensen Huang), заявивший, что стране не стоит «экспортировать муку, чтобы импортировать хлеб». Другими словами, нужно создавать собственные ИИ-мощности. Параллельно NVIDIA сотрудничает с другим индийским гигантом — Tata Group. Недавно пообещало поддержать развитие ИИ в стране и правительство Индии, выделив около ₹100 млрд ($1,16 млрд) на ИИ-стартапы и проекты.

Источник изображения: Olha Kolesnyk/Unsplash.com Впрочем, это далеко не единственный крупный проект в Индиии. В штате Телингана планируется создать несколько ЦОД в Хайдарабаде. Так, Blackstone намерена построить объект на 150 МВт за ₹45 млрд ($521 млн), Ursa Clusters — на 100 МВт за ₹50 млрд ($580 млн), а Tillman Global Holdings — на 300 МВт за ₹150 млрд рупий ($1,7 млрд) в Хайдарабаде. При полной загрузке он обеспечит мощность в 300 МВт. Власти Телинганы заявляют, что инвестиции компании сами по себе свидетельствуют о дружественной политике штата по отношению к бизнесу. В Мумбаи свой многомиллиардный вклад сделает и AWS. Хайдарабад с недавних пор превращается в хаб для ЦОД с присутствием таких компаний, как Iron Mountain, AdaniConneX, Nxtra, Microsoft и Tata Communications. AWS также располагает в Хайдарабаде облачным регионом, в прошлом году она даже объявила о планах по расширению ЦОД в городе. Наконец, в январе 2025 года STT GDC и CtrlS представили планы создания кампусов ЦОД в Хайдарабаде. Хотя Reliance и утверждает, что её ЦОД будет крупнейшим в мире, в это трудно поверить. Так, в США проект Stargate стоимостью до $500 млрд намерен построить не один гигаваттный дата-центр. Китай готов выделить на развитие ИИ в стране $138 млрд. Впрочем, даже одиночные компании инвестируют в дата-центры немалые суммы. Так, Meta✴ в этом году выделит до $65 млрд на развитие ИИ-инфраструктуры и уже начала строительство первого 2-ГВт кампуса, а Microsoft и вовсе готова потратить на ИИ ЦОД $80 млрд.

23.01.2025 [19:45], Руслан Авдеев

ByteDance намерена потратить $12 млрд на ИИ-ускорители в 2025 годуКитайская ByteDance намерена потратить в 2025 году более $12 млрд на ИИ-инфраструктуру. Она делает ставку на использование передовых технологий для роста, хотя и находится под давлением американских властей, намеренных заставить её продать часть популярной социальной сети TikTok, сообщает The Financial Times. Правда, огромный бюджет на новые закупки планировали до последних изменений американской политики. В частности, по данным источников, компания намерена выделить ¥40 млрд ($5,5 млрд) на покупку ИИ-чипов в 2025 году. Это вдвое больше, чем было потрачено на эти же цели в 2024-м. Около 60 % заказов компании на чипы в Китае придётся на местных производителей вроде Huawei и Cambricon (в основном для инференса), остальное достанется NVIDIA. По некоторым данным, Пекин неофициально рекомендовал китайским бизнесам закупать не менее 30 % чипов у производителей из Поднебесной. За первые три квартала выручка NVIDIA в Китае, включая Гонконг, составила $11,6 млрд, или 13 % от общих денежных поступлений. ByteDance является крупнейшим покупателем в Китае, но может приобретать для китайских ЦОД только модели H20, соответствующие американским экспортным ограничениям. По данным Omdia, в 2024 году компания заказала около 230 тыс. чипов NVIDIA, в основном именно H20. Ещё столько же купила Tencent. Для сравнения — в тот же период Microsoft приобрела 485 тыс. чипов семейства Hopper, а Meta✴ — 224 тыс. Также ByteDance планирует инвестировать около $6,8 млрд за пределами Китая, чтобы нарастить возможности обучения ИИ-моделей с использованием передовых чипов NVIDIA. Но с этим могут возникнуть проблемы из-за недавнего ужесточения США экспортного контроля, призванного сдержать технологическое развитие Китая. В любом случае компания является одним из лидеров ИИ-гонки в Китае и активно наращивает соответствующую инфраструктуру. Она уже развернула вычислительные мощности в Юго-Восточной Азии (в частности, Малайзии). Хотя китайским компаниям сильно ограничен доступ к ИИ-чипам NVIDIA, они сохранили доступ к ним, арендуя мощности в «нейтральных» странах. Эту лазейку закрыла предыдущая администрация США. Хотя Трамп может пересмотреть эти правила, если их всё же будут строго придерживаться, это серьёзно ограничит доступ ByteDance к вычислениям. По данным источников, в этом году ByteDance заключила много соглашений об аренде вычислительных мощностей. Их должно хватить для обеспечения большинства потребностей компании в 2025 году, но что может случиться после, пока неизвестно. Судьба TikTok в США пока остаётся под вопросом. У соцсети есть 75 дней, чтобы определиться со стратегией работы или уйти из страны. Власти США хотят, чтобы американское подразделение TikTok продало долю в 50 %, пригрозив новыми санкциями в случае отказа. Ситуация может помешать планам ByteDance по выходу на биржу (IPO). Не так давно компания предварительно оценила себя приблизительно в $300 млрд. UPD: По данным Reuters, капитальные затраты компании в 2025 году составят ¥150 млрд ($20,64 млрд). Срос на ресурсы привёл к тому, что компания стала одним из крупнейших клиентов Microsoft в Азии в сфере облачных вычислений. Ведущим приложением компании является чат-бот Duobao с 75 млн пользователей, имеется бот для преобразования текстов в видео Jimeng, а также инструмент Kouzi для разработчиков ботов и сервис Maoxing, обеспечивающий эмоциональную поддержку людям. Некоторые приложения компании доступны за рубежом — Duobao известен на международном рынке как Cici, а Jimeng — как Dreamina.

21.01.2025 [12:44], Сергей Карасёв

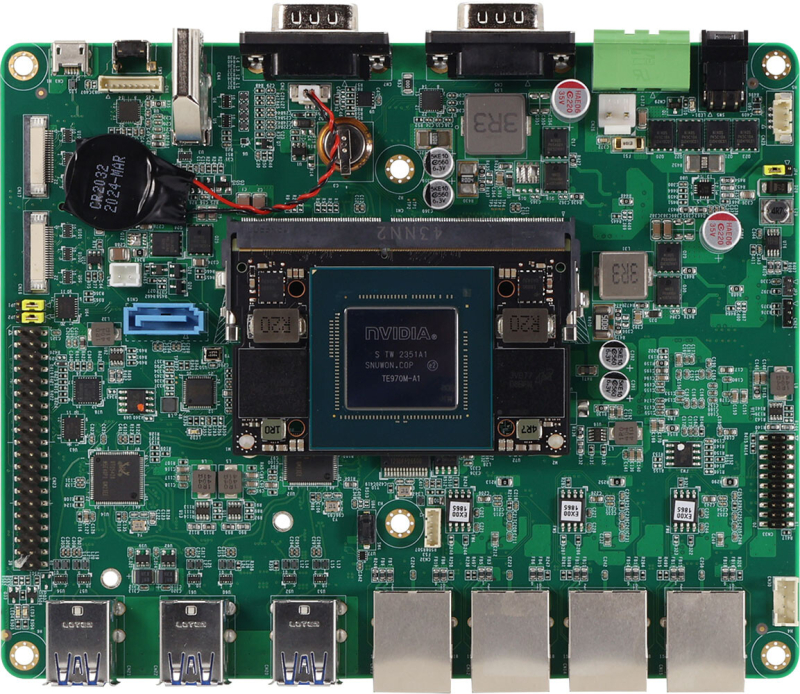

AAEON выпустила плату Boxer-8654AI-Kit на базе NVIDIA Jetson Orin NXКомпания AAEON анонсировала платформу Boxer-8654AI-Kit для разработчиков, проектирующих различные устройства с ИИ-функциями, например, IoT-оборудование, системы периферийных вычислений и пр. В основу новинки положен модуль NVIDIA Jetson Orin NX. Изделие предлагается в двух вариантах: на базе Orin NX с 8 и 16 Гбайт памяти и шестью и восемью ядрами Arm Cortex-A78AE соответственно. Задействован графический блок на архитектуре NVIDIA Ampere с 1024 ядрами. Возможно кодирование видео в форматах 4K60 (H.265; один поток) или 4K30 (H.265; три потока), а также декодирование материалов 8K30 (H.265; один поток), 4K60 (H.265; два потока), 4K30 (H.265; четыре потока) и пр. Плата располагает коннектором M.2 M-Key 2280 для NVMe SSD и портом SATA-3. Доступны также разъём M.2 2230 E-Key для адаптера Wi-Fi и коннектор M.2 2242/3042/3052 B-Key для модема 5G (плюс слот для SIM-карты). Предусмотрены четыре сетевых порта 1GbE с опциональной поддержкой PoE (25,6 Вт на порт). Новинка располагает выходом HDMI 1.4, двумя интерфейсами MIPI CSI (по четыре линии), четырьмя портами RJ-45 для подключения сетевых кабелей, шестью портами USB 3.2 Gen2 Type-A, двумя последовательными портами (плюс коннектор на плате для RS-232/422/485), 40-контактной колодкой GPIO, а также разъёмом Micro-USB. Питание (12–24 В) подаётся через DC-разъём. Плата имеет размеры 166 × 133 мм и весит около 190 г. Диапазон рабочих температур простирается от -25 до +70 °C. Изделие Boxer-8654AI-Kit поставляется с пакетом NVIDIA Jetpack 6.0 SDK (Ubuntu Linux). Цена составляет $1283 за версию с 8 Гбайт памяти и $1691 за модификацию с 16 Гбайт.

18.01.2025 [22:31], Владимир Мироненко

CoreWeave поставит IBM ИИ-суперкомпьютер на базе NVIDIA GB200 NVL72 для обучения моделей GraniteCoreWeave и IBM заключили соглашение о сотрудничестве, в рамках которого стартап поставит IBM один из первых своих ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72 с интерконнектом Quantum-2 InfiniBand. В качестве хранилища будет использоваться высокопроизводительная All-Flash СХД IBM Storage Scale System. IBM будет использовать облачную платформу CoreWeave для обучения семейства больших языковых моделей (LLM) Granite. Сообщается, что облачная платформа CoreWeave специально создана для обеспечения ведущей в отрасли производительности, надёжности и отказоустойчивости с безопасностью корпоративного уровня. Фирменный набор ПО и облачные сервисы предоставляют инструменты, необходимые для управления самой сложной и масштабной ИИ-инфраструктурой. В рамках соглашения о сотрудничестве клиенты CoreWeave получат доступ к платформе IBM Storage. По словам вице-президента по ИИ в IBM Research, платформа CoreWeave позволит дополнить возможности IBM при разработке передовых, производительных и экономичных моделей для поддержки корпоративных приложений и ИИ-агентов. В свою очередь, IBM Storage Scale System расширяет возможности CoreWeave. «В рамках сотрудничества мы будем использовать этот суперкомпьютер для продвижения открытых технологий, таких как Kubernetes, которые будут поддерживать вычисления ИИ в гибридной облачной среде», — добавил представитель IBM. Вероятно, IBM не хватает собственных вычислительных ресурсов — в ноябре появилась информация о том, что компания готова арендовать у AWS ИИ-ускорители за почти полмиллиарда долларов.

17.01.2025 [15:17], Владимир Мироненко

NVIDIA строит в Израиле ИИ-суперкомпьютер стоимостью $500 млнNVIDIA построит за $500 млн на севере Израиля 30-МВт научно-исследовательский суперкомпьютер на базе ускорителей Blackwell последнего поколения стоимостью около полмиллиарда долларов, сообщил The Register. Строительство кластера началось ещё в прошлом году, а закончить его планируется в I полугодии 2025 года. Кластер будет располагаться на объекте площадью 10 тыс. м2 в научно-промышленном парке Mevo Carmel недалеко от Йокнеам-Илита (Yokne'am Illit). По словам компании, он получит сотни систем Blackwell с фирменным жидкостным охлаждением, DPU BlueField-3 SuperNIC, коммутаторами Spectrum-X800 и Quantum-X800. Как полагает The Register, кластер будет использоваться NVIDIA для разработки технологий ЦОД следующего поколения. Точное количество ускорителей не указано. У NVIDIA есть несколько эталонных систем Blackwell с жидкостным охлаждением и различным количеством ускорителей. Согласно публикациям израильских СМИ, полная конфигурация нового суперкомпьютера будет включать «несколько тысяч» GPU, что позволит ему соперничать с национальным суперкомпьютером Israel-1. Israel-1 построен на 2048 ускорителях NVIDIA H100, объединённых с помощью 80 коммутаторов Spectrum-4. Суперкомпьютер имеет пиковую FP64-производительность до 137 Пфлопс, а FP8 — до 8 Эфлопс. The Register отметил, что на реализации проекта могут отразиться новые экспортные ограничения США. Согласно правилам AI Diffusion rule, Израиль относится к странам второго уровня с квотой на поставку до 50 тыс. передовых ускорителей в течение двухлетнего периода (2025–2027 гг.). Впрочем, эти правила вступят в силу через 120 дней с момента публикации, поэтому у NVIDIA в запасе достаточно времени для поставки необходимого количества ускорителей в Израиль. С учётом прочных связей Израиля с США есть большая вероятность того, что стране будет предоставлен статус National Verified End User, что увеличит лимит импорта до 320 тыс. ускорителей в течение двухлетнего периода, отметил The Register.

11.01.2025 [22:37], Владимир Мироненко

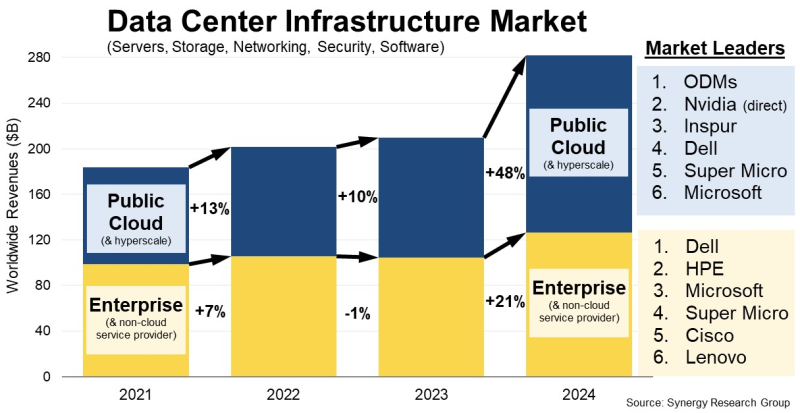

На волне бума генеративного ИИ продажи оборудования для ЦОД в 2024 году выросли до исторического максимумаСогласно данным Synergy Research Group, мировые расходы на оборудование и ПО для ЦОД в 2024 году выросли по сравнению с 2023 годом на 34 %, достигнув исторического максимума. Хотя рост наблюдался во всех сегментах рынка, в значительной мере он был обусловлен 48 % скачком расходов на инфраструктуру публичного облака, на которую теперь приходится 55 % общего объёма рынка. После незначительного роста, наблюдавшегося в течение предыдущих пяти лет, в 2024 году было отмечено оживление продаж корпоративным клиентам, увеличившихся на 21 %. Аналитики Synergy Research Group отметили, что уже 15 лет рост услуг публичного облака стимулирует рост инвестиций в облачную инфраструктуру, что ведёт к ограничению расходов на собственные ЦОД предприятий. Эта тенденция продолжилась и в 2024 году, но новым драйвером рынка, обеспечившим огромный рост расходов, стал генеративный ИИ. Провайдеры облачных услуг и предприятия в равной степени стремились приобретать ускорители. Бум на рынке ИИ повлёк за собой взрывной рост выручки NVIDIA, прямые продажи которой гиперскейлерам и корпоративным клиентам вывели её в число ведущих поставщиков оборудования для ЦОД. Также был отмечен рост продаж Inspur, SuperMicro и продолжающееся доминирование ODM-производителей, поставляющих оборудование гиперскейлерам. Согласно прогнозу Synergy, общие доходы от продаж оборудования инфраструктуры ЦОД, включая облачное, а также от ПО, достигнут $282 млрд в 2024 году. Из них $156 млрд придётся на инфраструктуру публичного облака. Цифры основаны на фактических данных за первые три квартала 2024 года, а также прогнозе Synergy на IV квартал. На серверы, хранилища и сетевые решения в совокупности пришлось 85 % рынка инфраструктуры ЦОД. Остальная часть включает ПО, ПО для виртуализации, управления облаком и сетевой безопасности. Synergy отметила, что если исключить ODM, то Dell является лидером по доходам сегмента серверов и хранилищ, а Inspur — лидером по продажам серверов публичным облакам. Cisco лидирует в сетевом сегменте. А Microsoft выбилась в лидеры благодаря серверным ОС и виртуализации. NVIDIA занимает ведущие позиции в качестве поставщика как для вендоров, так и для поставщиков услуг. Помимо перечисленных пяти компаний в число ведущих поставщиков на рынке также входят HPE, SuperMicro, Lenovo, VMware, Huawei, IBM и Arista Networks. ИИ-ускорители и системы генеративного ИИ вызвали настоящий ажиотаж на рынке в 2024 году, что привело к рекордным темпам роста отрасли, отметил Джон Динсдейл (John Dinsdale), главный аналитик Synergy Research Group. Он сообщил, что корпоративный сегмент рынка снова растёт, хотя в долгосрочной перспективе публичные облака останутся основными инвесторами в ЦОД: «Десять лет назад продажи поставщикам публичных облачных сервисов составляли всего 20 % рынка. В 2024 году этот показатель вырос до 55 %, и, по нашему прогнозу, через пять лет он достигнет почти 65 %». |

|