Материалы по тегу: hardware

|

27.06.2025 [12:23], Сергей Карасёв

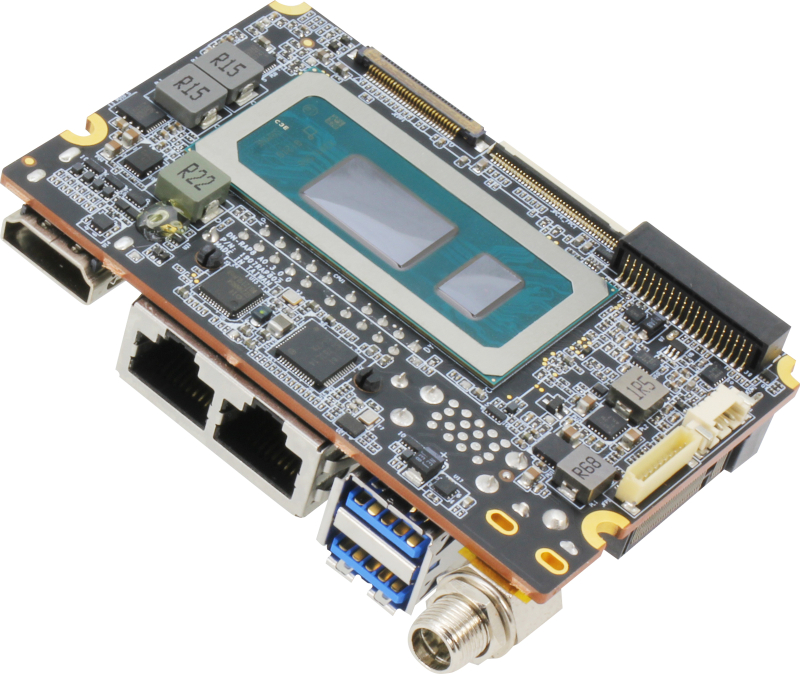

Самый маленький в мире одноплатный компьютер на базе Intel Core Raptor Lake — AAEON de next-RAP8Компания AAEON анонсировала одноплатный компьютер de next-RAP8: это, как утверждается, самое компактное в мире изделие с процессором Intel Core 13-го поколения (Raptor Lake). Размеры новинки составляют 86 × 55 мм. Плата предназначена для использования в беспилотных летательных аппаратах, роботизированных системах и пр. В зависимости от модификации используется процессор Core i7-1365UE (10 ядер, 12 потоков, 1,7–4,9 ГГц, графика Intel Iris Xe), Core i5-1335UE (10 ядер, 12 потоков, 1,3–4,5 ГГц, графика Intel Iris Xe) или Core i3-1315UE (6 ядер, 8 потоков, 1,2–4,5 ГГц, графика Intel UHD). У всех этих чипов показатель TDP равен 15 Вт. Объём оперативной памяти LPDDR5X может достигать 16 Гбайт. Одноплатный компьютер располагает портом SATA-3 для накопителя, разъёмом M.2 2280 M-Key (PCIe x2) для адаптера Wi-Fi или модема 4G, а также FPC-коннектором (PCIe 3.0 x4), который позволяет подключать ИИ-ускорители, SSD и пр. В оснащение входят сетевые контроллеры 1GbE (Intel I219-LM) и 2.5GbE (Intel I226-LM) с разъёмами RJ45 для подсоединения кабелей. Есть два порта USB 3.2 Gen2 Type-A и интерфейс HDMI 1.4b. Через 40-контактную колодку можно задействовать четыре порта USB 2.0 и два последовательных порта RS-232/422/285. Упоминается 4-контактный коннектор для подсоединения вентилятора охлаждения. Питание (12 В) подаётся через DC-разъём. Диапазон рабочих температур простирается от 0 до +60 °C. Заявлена совместимость с Windows 10 и Ubuntu 22.04.3 (Kernel 6.2). Приём заказов на одноплатный компьютер de next-RAP8 уже начался: цена варьируется от $750 до $1267 в зависимости от установленного процессора.

27.06.2025 [11:49], Сергей Карасёв

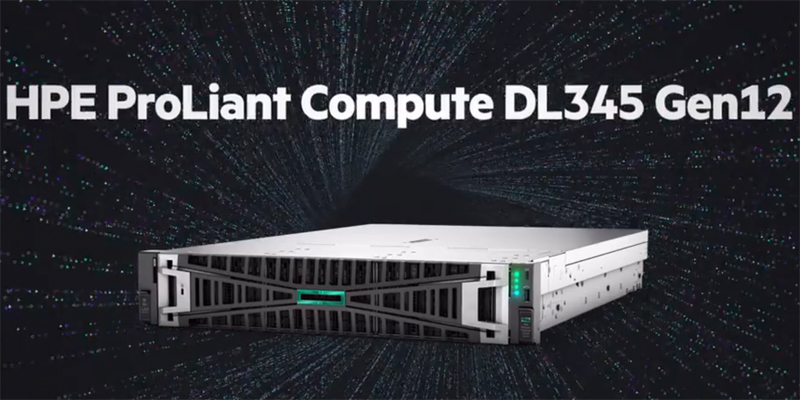

HPE анонсировала серверы ProLiant Compute Gen12 на базе AMD EPYC TurinКомпания HPE представила серверы ProLiant Compute DL325 и DL345 поколения Gen12, оптимизированные для рабочих нагрузок с интенсивным использованием памяти, таких как виртуализация и периферийные вычисления. В основу новинок положена аппаратная платформа AMD EPYC Turin. Серверы 12-го поколения на базе Intel Xeon 6 компания представила зимой. Поставки систем будут организованы в июле нынешнего года. Тогда же, по-видимому, будт раскрыты полные характеристики новинок. Пока известно, что модель ProLiant Compute DL325 Gen12 выполнена в форм-факторе 1U. Она имеет односокетную конфигурацию с возможностью использования воздушного и жидкостного охлаждения. Доступны 24 слота для модулей оперативной памяти, а максимально поддерживаемый объём ОЗУ составляет 6 Тбайт.

Источник изображений: HPE Сервер будет предлагаться в различных конфигурациях, в том числе с возможностью установки до четырёх однослотовых GPU. Есть два разъёма OCP NIC 3.0 SFF. Во фронтальной части расположены отсеки для SFF-накопителей: в частности, предусмотрено исполнение с восемью посадочными местами для таких устройств. Сзади находятся порты USB, гнездо RJ45 для сетевого кабеля, аналоговый интерфейс D-Sub. Упомянуты средства управления HPE Integrated Lights-Out (HPE iLO 7). Говорится о защите от будущих кибератак, основанных на квантовых вычислениях.  Вариант ProLiant Compute DL345 Gen12, по сути, представляет собой модификацию DL325 в формате 2U. Ключевые характеристики остались прежними: один разъём для процессора EPYC Turin (до 192 вычислительных ядер), 24 слота для модулей ОЗУ и два разъёма OCP NIC 3.0 SFF. При этом предоставляются более широкие возможности в плане формирования подсистемы хранения данных и установки карт расширения. Прочие технические характеристики серверов пока не раскрываются.

27.06.2025 [09:35], Руслан Авдеев

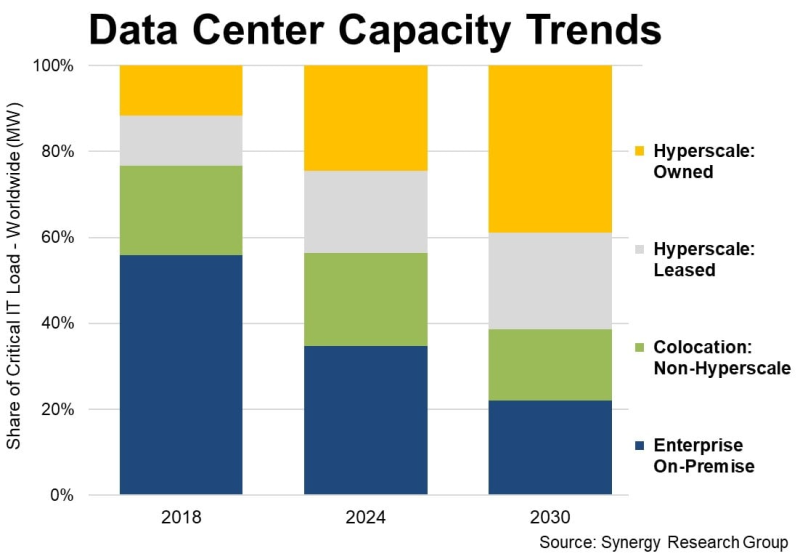

У гиперскейлеров есть уже 1,2 тыс. дата-центров, а через пять лет они будут доминировать на рынке ЦОДУже к 2030 году на гиперскейлеров будет приходиться 61 % всех мощностей ЦОД в мире, что обусловлено ростом облачных сервисов и увеличением спроса на ИИ-вычисления, Synergy Research Group. Доклад Synergy Research показал, что рост доли мощностей AWS, Microsoft и Google не связан со снижением доли корпоративных ЦОД. Напротив, on-premise и колокейшн-площадки тоже развиваются, но рост гиперскейлеров значительно опережает остальных игроков. В распоряжении гиперскейлеров на конец I квартала уже имелось 1189 ЦОД. Вместе на долю IT-гигантов приходится 44 % мировой мощности ЦОД. Из них более половины приходится на кампусы собственной постройки, остальное — на арендованные объекты. С учётом того, что на колокейшн-ЦОД, не связанных с гиперскейлерами, приходится ещё 22 % от общей мощности, на долю корпоративных ЦОД остаётся всего 34 %, хотя всего шесть лет назад на них приходилось 56 % ёмкости. В будущем же, вероятно, на объекты гиперскейлеров будет приходиться 61 %, а инфраструктуре on-premise останется всего 22 %. За указанный период будет расти мощность дата-центров всех типов, но основным драйвером станет трёхкратный рост мощности ЦОД гиперскейлеров в следующие шесть лет.

Источник изображения: Synergy Research Важно, что прирост ёмкости колокейшн-объектов тоже будет исчисляться двузначными значениям в процентах, но их доля всё равно будет сокращаться. Почти то же касается и корпоративных дата-центров. После долгой стагнации благодаря внедрению ИИ их масштаб вновь начнёт расти, но доля будет снижаться приблизительно на 2 п.п./год в течение всего прогнозируемого периода. По словам аналитиков, облачные и другие ключевые сервисы стали основными драйверами расширения мощностей дата-центров, а стремительное развитие технологий и ИИ-приложений даёт дополнительный импульс. Впрочем, в компании подчёркивают, что рыночные показатели мощностей значительно отличаются от региона к региону. Так, доля мощностей ЦОД в США значительно больше, чем в регионах EMEA (Европа, Ближний Восток и Африка) и странах Азиатско-Тихоокеанского региона, хотя в целом наблюдается общий вектор. Во всех регионах ожидаются двузначные годовые темпы роста общей мощности дата-центров в прогнозируемом периоде. Кроме того, во всех регионах доля мощностей ЦОД, принадлежащих гиперскейлерам, будет расти не менее чем на 20 % ежегодно. Немалую роль в прогнозах играет предположение о дальнейшем развитии ИИ-проектов. Впрочем, некоторые эксперты говорят, что существует риск перегрева рынка и появления «пузыря» подобного тому, что сопровождал бум и крах доткомов в конце 1990-х годах.

26.06.2025 [23:00], Владимир Мироненко

«Аквариус» передал в залог структуре «Сбера» доли в двух компаниях

hardware

аквариус

импортозамещение

инвестиции

реструктуризация

россия

сбер

сбербанк

сделано в россии

сделка

финансы

Один из крупнейших российских производителей компьютерной техники, ГК «Аквариус» передал 16 июня в залог структуре «Сбера» — ООО «Сбербанк Инвестиции» — 70-% долю в своём головном юрлице «Ай кью холдинг» (ранее «Смарт Холдинг») и 99,99-% долю в ООО «Аквариус технологии», сообщил «Коммерсантъ» со ссылкой на данные «Спарк-Интерфакса». Аналитики не исключают, что передача долей может быть частью более широкой сделки со «Сбером», связанной с реструктуризацией или возможным вхождением банка в капитал. В прошлом году «Сбербанк Инвестиции» уже получили 12-% долю в «Аквариусе». В «Аквариусе» пояснили «Коммерсанту», что частичный залог долей отдельных компаний группы является стандартной практикой при корпоративном кредитовании, и это не означает по умолчанию никакой продажи. Представитель ФГ «Финам» отметил, что в российской практике распространены сделки через посредничество банков, когда сначала банк выкупает актив и потом перепродаёт его. Впрочем, эксперты не исключают продажу компании и самому «Сбера», который является крупным потребителем IT-инфраструктуры. Как сообщает источник «Коммерсанта», знакомый с планами компании, у неё высокая долговая нагрузка и ей «не хватает средств на операционную деятельность». По его словам, в связи с этим в «Аквариусе» изначально рассматривали продажу компании новым инвесторам для расчётов с кредиторами либо её переход в управление «Сбера». Возможность проблем не исключил и другой собеседник издания, связавший их это с сокращением госзакупок и ростом ключевой ставки ЦБ. Как утверждает источник «Коммерсанта» на рынке разработчиков электроники, одной из проблем отрасли в целом остаётся «привязка к госзакупкам»: основные процедуры приходятся на начало года, средства поступают неравномерно, а поддерживать производство надо постоянно. По данным «Регблока», задолженность АО «А-холдинг» по кредитам и займам составляла 4,5 млрд руб., кредиторская задолженность ООО «Ай кью холдинг» — 1 млрд руб., что соответствует умеренному уровню. Вместе с тем эксперт ИК «Финам» отметил, что группа компаний может быть уязвима. В начале прошлого года сообщалось, что «Сбербанк» организовал производство собственных серверов. Весной этого года «Сбербанк» инициировал банкротство российского производителя OCP-серверов Gagar>n.

26.06.2025 [18:07], Андрей Крупин

VK Tech открыл доступ к сервису Bare Metal в дата-центрах VKРазработчик корпоративного программного обеспечения VK Tech (входит в экосистему VK) запустил Bare Metal — сервис предоставления физических серверов в центрах обработки данных VK. Решение нативно интегрировано с облачной инфраструктурой VK Cloud и позволяет заказчикам размещать высоконагруженные сервисы на физических серверах с полным контролем над вычислительными ресурсами и управлением через интерфейс облака. Серверное оборудование Bare Metal размещено в дата-центрах Московского региона, отвечающих уровню надёжности Tier IV, требованиям 152‑ФЗ, стандартам ISO и PCI DSS, соответствие которым гарантирует безопасность обрабатываемых персональных и банковских данных.

Источник изображения: Thomas Jensen / unsplash.com Сервис Bare Metal может быть востребован организациями, которым необходима мощная инфраструктура для работы с высоконагруженными приложениями, корпоративными ERP/CRM-системами, аналитическими и транзакционными операциями. Также мощности Bare Metal могут быть использованы для аналитики больших данных и решения задач с использованием технологий машинного обучения и искусственного интеллекта на базе нейронных сетей. Для этого в составе сервиса представлены серверные конфигурации с новым поколением графических ускорителей GPU, которые, как утверждается, ускоряют обучение больших языковых моделей на 15–320 % и инференс на 100–570 % по сравнению с Nvidia H100 и A100 в зависимости от используемых видеокарт и сценариев использования. Интеграция с VK Cloud позволяет выстроить масштабируемую и отказоустойчивую инфраструктуру.

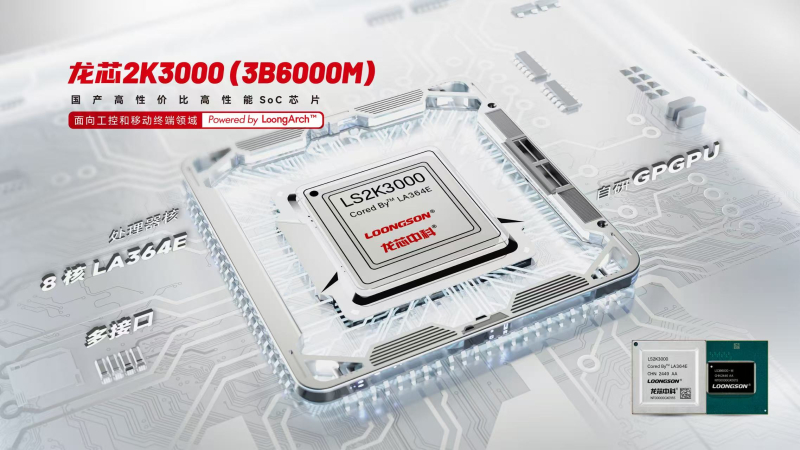

26.06.2025 [17:49], Алексей Степин

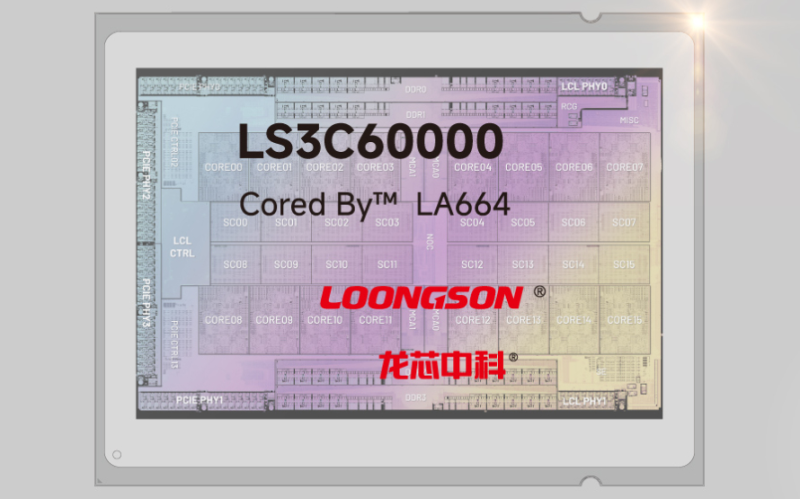

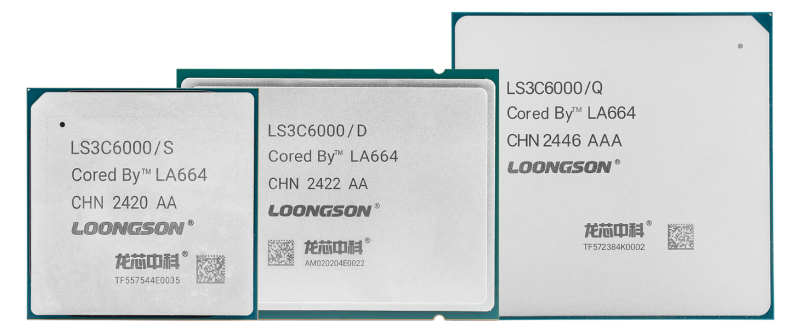

Loongson представила 64-ядерные серверные процессоры 3C6000 на базе LoongArchLoongson получила опытные образцы процессоров 3C6000 на базе архитектуры LoongArch ещё год назад, а сегодня китайская компания официально представила новинки. Эти процессоры, предназначенные для внутреннего рынка КНР, имеют чиплетную компоновку и содержат до 64 ядер LA664 с поддержкой SMT2. Это уже четвёртое поколение процессоров Longsoon с архитектурой LoongArch. Чиплетную компоновку сегодня используют все, и Loongson не исключение. Чиплетов в составе процессоров 3C6000 может быть от одного до четырёх. Чипы с литерой S имеют единственный чиплет, с D — два, а возглавляющие модельный ряд модели c индексом Q в названии несут на борту четыре 16-ядерных чиплета. Помимо стандартного набора инструкций LoongArch, имеется поддержка 126/256-бит векторных расширений. Дополнительно наличествует ядро LA264 (Loongson SE), выполняющее роль сопроцессора безопасности. Ядра LA664 имеют по 64 Кбайт кеша инструкций и данных, 256 Кбайт кеша L2, но кеш L3 общий, объёмом 32 Мбайт на чиплет. Дизайн ядер суперскалярный, с внеочередным исполнением с обработкой шести инструкций за такт. Каждое ядро содержит четыре целочисленных блока, четыре блока векторных операций и четыре модуля доступа к памяти. Подсистема памяти представлена четырёхканальным контроллером DDR4-3200, но многоядерные модели серий D и Q включают уже восемь каналов, а также могут работать в составе двух- и четырёхсокетных платформ. Базовые тактовые частоты ядер Loongson 3C6000 лежат в пределах 2,0–2,2 ГГц, но архитектура LA664 на частоте 2,2 ГГц показывает себя эффективнее в обработке целочисленных данных, нежели Xeon Scalable третьего поколения (Ice Lake-SP) на частоте 2,4 ГГц, хотя в вычислениях с плавающей запятой она, как было показано на презентации, несколько слабее. Речь о тестах SPEC CPU 2017, в ближайшее время ожидаются первые результаты новинок в других бенчмарках. На официальной сайте даны следующие показатели FP64-производительности: 844,8 Гфлопс на частоте 2,2 ГГц у S-модели, 1612,8 Гфлопс на частоте 2,1 ГГц у D-модели и 3072 Гфлопс на частоте 2,0 ГГц у Q-модели. Для связи между чиплетами применён фирменный интерконнект DragonChain. С внешним же миром процессоры общаются посредством интерфейса PCI Express 4.0 — 64 линии имеется даже у младших S-моделей, а у D и Q их уже 128. Теплопакет у одночиплетных процессоров укладывается в диапазон от 100 до 120 Вт, для более мощных моделей этот показатель варьируется в пределах 180 — 200 Вт для чипов D, для наиболее мощных Q он составляет от 250 до 300 Вт. Вместе с 3C6000 компания анонсировала процессоры 2K3000 и 3B6000M. Это сравнительно маломощные решения на базе архитектуры LA364E, содержащие до 8 ядер с частотой до 2,5 ГГц, а также интегрированный видеоускоритель LG200 (в предыдущих моделях использовался LG100) с производительностью 256 Гфлопс в режиме FP32. Имеется и ИИ-сопроцессор мощностью 8 Топс (INT8). Эти решения нацелены на применение в индустриальных системах, умных киосках и мобильных терминалах. Анонс новых решений Loongson очень важен для китайского рынка и страны в целом, особенно на фоне санкций со стороны США, не позволяющих КНР использовать решения Intel и AMD в вычислительных системах государственного сектора. Начало массового производства новых многоядерных процессоров Loongson 3C6000 должно если не решить проблему полностью, то заметно сгладить её.

26.06.2025 [15:44], Руслан Авдеев

АЭС Three Mile Island начнёт поставлять энергию Microsoft на год раньше, чем планировалосьРаботы Constellation Energy по перезапуску АЭС Three Mile Island (Crane Clean Energy Center) продвигаются быстрее, чем ожидалось — станция заработает в 2027 году, а не 2028-м, сообщает Bloomberg. Отчасти изменение сроков связано с тем, что АЭС может подключиться к энергосети PJM Interconnection быстрее, чем планировалось. После ввода в эксплуатацию станция будет снабжать электричеством Microsoft, которой нужна безуглеродная энергия для ИИ ЦОД. В Constellation заявили, что закрытие станции было ошибкой — достаточно понаблюдать за параметрами энергосети несколько дней, чтобы понять, насколько необходимо возобновить проект. Three Mile Island является одной из двух атомных электростанций США, закрытых по экономическим причинам. Теперь их возвращают к жизни для удовлетворения спроса на электроэнергию. Так, Holtec International работает над перезапуском АЭС Palisades в Мичигане, закрытой в 2022 году. Сегодня интерес в США к ядерной энергетике получил «второе дыхание». Это обусловлено тем, что потребность ЦОД, заводов и домохозяйств в стране растёт. В мае президент США Дональд Трамп (Donald Trump) подписал указы, призванные ускорить строительство АЭС в стране.

Источник изображения: Constellation В сентябре 2024 года Constellation Energy объявила о заключении 20-летнего контракта с Microsoft на поставку электроэнергии (PPA), которая будет производиться на АЭС Three Mile Island. Мощность АЭС составит 837 МВт. Этого хватит, чтобы обеспечить работу всех дата-центров компании в Пенсильвании, Чикаго, Вирджинии и Огайо. Сейчас ведётся перезапуск энергоблока Unit 1, остановленного в 2019 году. Ожидается, что перезапуск принесёт $3 млрд в виде государственных и федеральных налогов. Печально известный Unit 2, на котором в 1979 году произошла авария, выводится из эксплуатации. Ранее AWS приобрела за $650 млн кампус Talen Energy рядом с АЭС Susquehanna Steam Electric Station в Пенсильвании. Предполагалось, что станция обеспечит ЦОД до 960 МВт. Впрочем, из-за противодействия общественников и регуляторов, пришлось прибегнуть к покупке энергии обходными путями. На днях также сообщалось, что Нью-Йорк построит гигаваттную АЭС для ИИ ЦОД и других отраслей — это крупнейший в США проект новой АЭС за 15 лет.

26.06.2025 [12:05], Сергей Карасёв

HPE представила ИИ-систему Compute XD690 на базе NVIDIA HGX B300Компания HPE анонсировала высокопроизводительный сервер Compute XD690, предназначенный для решения таких ресурсоёмких задач, как обучение ИИ-моделей, инференс и пр. В основу новинки положены процессоры Intel и ускорители NVIDIA на архитектуре Blackwell. Поставки новинки компания планирует организовать в октябре нынешнего года. Система Compute XD690 выполнена в форм-факторе 10U с воздушным охлаждением. Полностью технические характеристики не раскрываются, но известно, что конфигурация включает два чипа Intel Xeon 6. Задействована платформа NVIDIA HGX B300 с восемью модулями Blackwell Ultra SXM. Заявленная производительность на операциях FP64 достигает 10 Тфлопс, на операциях FP4 — 144 Пфлопс. Суммарный объём памяти HBM3e составляет около 2,3 Тбайт. Применяется интерконнект NVLink пятого поколения с общей пропускной способностью 14,4 Тбайт/с. Говорится о поддержке XDR InfiniBand и Spectrum-X Ethernet.

Источник изображения: HPE Как отмечает HPE, ускорители Blackwell Ultra обеспечивают на 50 % более высокую производительность FP4 и удвоенную пропускную способность GPU↔CPU по сравнению с решениями на архитектуре Blackwell предыдущего поколения. Благодаря этому возможна работа со сложными ИИ-моделями, агентами ИИ, рассуждающими системами и пр. Среди других вариантов использования названы генерация фотореалистичных видеоматериалов и симуляция детализированного 3D-окружения для робототехнических сред и самоуправляемых транспортных средств.

26.06.2025 [12:00], Сергей Карасёв

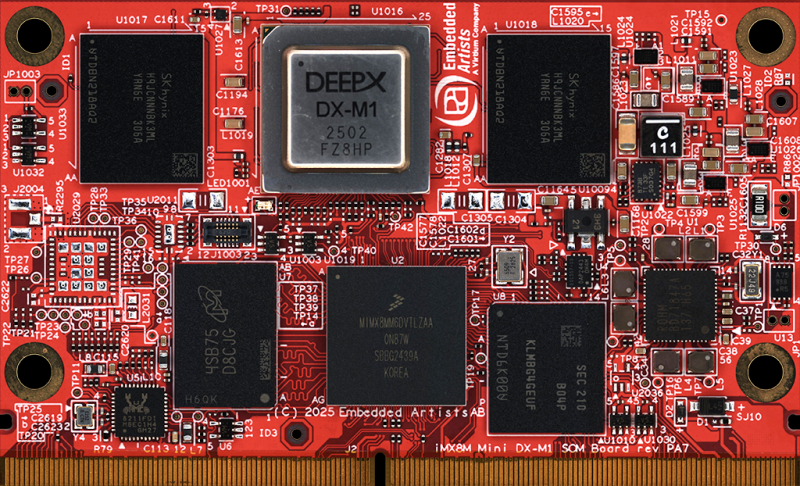

Вычислительный модуль iMX8M Mini DX-M1 оснащён ИИ-ускорителем Deepx DX-M1Компания Virtium Embedded Artists анонсировала вычислительный модуль iMX8M Mini DX-M1 SoM, предназначенный для использования в составе систем машинного зрения с поддержкой ИИ. Это могут быть дроны, платформы видеонаблюдения и обеспечения безопасности, средства автоматизированного контроля и мониторинга, транспортные комплексы и пр. В основу изделия положен чип NXP i.MX 8M Mini с четырьмя ядрами Arm Cortex-A53 с тактовой частотой 1,6 ГГц (индустриальная версия) или 1,8 ГГц (коммерческий вариант) и ядром реального времени Cortex-M4F с частотой 400 МГц. Предусмотрены графические блоки Vivante GC320 2D GPU и Vivante GCNanoUltra 2D/3D GPU с поддержкой OpenVG 1.1, OpenGL ES 2.0, а также VPU-модуль с возможностью декодирования видео 1080p60 H.265, H.264, VP8, VP9 и кодирования материалов 1080p60 H.264, VP8. Объём оперативной памяти LPDDR4-3000 составляет 2 Гбайт, вместимость встроенного флеш-накопителя eMMC — 16 Гбайт.

Источник изображения: Virtium Embedded Artists Особенностью новинки является наличие ИИ-ускорителя Deepx DX-M1 AI Booster, обеспечивающего производительность до 25 TOPS. Этот NPU функционирует на частоте 1 ГГц и использует 4 Гбайт памяти LPDDR5-5600. Модуль iMX8M Mini DX-M1 наделён сетевым 1GbE-контроллером Realtek RTL8211FDI, а опционально может быть добавлен адаптер Murata LBEE5HY2FY (2FY), отвечающий за поддержку Wi-Fi 6E (802.11a/b/g/n/ac/ax) и Bluetooth 5.4 (BR/EDR/BLE). Предусмотрены интерфейс SDIO на основе чипсета Infineon CYW55513, а также интерфейсы MIPI CSI (4 линии) и MIPI-DSI (4 линии; до 1080p60). Изделие имеет размеры 82 × 50 × 5 мм. Диапазон рабочих температур у индустриальной версии простирается от -40 до +85 °C, у коммерческой — от 0 до +70 °C. Для модуля iMX8M Mini DX-M1 будет доступна сопутствующая плата с набором разъёмов, включая порты USB.

26.06.2025 [08:46], Руслан Авдеев

Рынок ЦОД стал настолько привлекательным, что даже высокий порог входа не останавливает неквалифицированных инвесторовПривлекательность инвестиций в дата-центры во многом обусловлена почти гарантированной выручкой при их сдаче в аренду. По мнению инвесторов, когда контракты с арендаторами подходят к концу, клиенты обычно предпочитают оставаться в том же ЦОД, сообщает The Register. Ажиотаж вокруг ИИ привлекает на рынок ЦОД всё новые инвестиционные компании, увидевшие возможность заработать на растущем спросе. Управляющий директор Macquarie Asset Management Наталия Акст (Natalia Akst) высоко оценила финансовую привлекательность рынка дата-центров, при этом отметив, что порог входа на него довольно высок. Сама Macquarie действует на рынке уже несколько лет. Как заявила Акст, при оценке активов факторами их выбора для инвестиций является их критическая важность для общества, стабильное поступление выручки и, наконец, высокий порог входа с низким уровнем конкуренции. В случае с ЦОД порог как раз довольно высок — требуются большие капиталовложения, большие усилия, доступ к электроэнергии — не все компании «с улицы» способны войти в этот бизнес.

Источник изображения: Glenov Brankovic/unsplash.com Вместе с тем в некоторых регионах строительство новых дата-центров становится всё сложнее из-за нехватки подходящих земель или электроэнергии. Впрочем, это не отпугивает инвесторов — если препятствия удаётся преодолеть, по окончании действия контрактов клиенты обычно предпочитают не менять локацию, поскольку перейти на другую площадку бывает довольно трудно и невыгодно по ряду причин. Ранее в текущем году Macquarie заявила об инвестициях более $17 млрд в два американских оператора ЦОД. Из них $5 млрд достанется Applied Digital, ещё $12 млрд пойдут на расширение Aligned Data Centers. В первую очередь речь идёт о средствах под управлением Macquarie. Ещё одним важным инвестором является Blackstone, вложившая в 2024 году £10 млрд ($13,4 млрд) в крупный ИИ ЦОД на северо-востоке Англии — потенциально «крупнейший дата-центр в Европе». Впрочем, некоторые полагают, что ажиотаж может привести к возникновению «пузыря» — на рынок «из ниоткуда» приходят инвесторы, не имеющие никакого опыта и представления об ИИ и ЦОД. Ранее председатель Alibaba Group Джо Цай (Joe Tsai) выразил обеспокоенность по поводу огромных вливаний в строительство ЦОД, предупредив, что его объёмы могут превысить реальный спрос. Бизнесмен подчеркнул, что многие привлекают средства для строительства, даже не имея покупателя или арендатора, определённых ещё до начала работ. Впрочем, сама Alibaba намерена потратить на облачную и ИИ-инфраструктуру $52 млрд в следующие три года. |

|