Материалы по тегу: hardware

|

08.04.2024 [11:35], Сергей Карасёв

BSC и NVIDIA займутся совместной разработкой HPC- и ИИ-решенийБарселонский суперкомпьютерный центр (Centro Nacional de Supercomputación, BSC-CNS) и NVIDIA объявили о заключении многолетнего соглашения о сотрудничестве, целью которого является совместная разработка инновационных решений, объединяющих технологии НРС и ИИ. Договор рассчитан на пять лет с возможностью последующего продления. При этом каждые шесть месяцев стороны намерены уточнять и оптимизировать направления сотрудничества. Новое соглашение будет действовать параллельно с ранее подписанным документом, касающимся совместных исследований в области сетевых решений. Первоначально сотрудничество между BSC и NVIDIA будет сосредоточено на разработке больших языковых моделей (LLM), а также приложений для метеорологии и анализа изменений климата. Кроме того, стороны займутся адаптацией вычислительной модели цифрового двойника сердца, разработанной в рамках проекта Alya, к различным платформам. Ещё одно направление работ — программная оптимизация процессов для GPU и архитектуры NVIDIA Grace с ядрами Arm, специально разработанной для ИИ и крупномасштабных суперкомпьютерных приложений. Предполагается также, что научный потенциал BSC вкупе с технологическими достижениями и опытом NVIDIA позволят максимизировать вычислительные возможности суперкомпьютера MareNostrum 5, который был запущен в Испании в конце 2023 года. Эта система, использующая ускорители NVIDIA H100, обладает производительностью 314 Пфлопс.

08.04.2024 [11:07], Руслан Авдеев

100-МВт солнечная электростанция AmpIn в Раджастхане компенсирует энергозатраты индийских дата-центров AWSИндийская AmpIn Energy Transition (ранее Amp Energy India) ввела в эксплуатацию солнечную электростанцию, компенсирующую потребление электроэнергии дата-центрами Amazon Web Services (AWS). Datacenter Dynamics сообщает, что речь идёт о проекте возобновляемой энергетики общей мощностью 100 МВт (в пике до 135 МВт). Электростанция площадью 235 га расположена в «солнечном парке» Bhadla в пустыне Тар (штат Раджастхан). Как заявляет оператор электростанции, сотрудничество с Amazon над столь значимым проектом подчёркивает приверженность AmpIn к переходу страны на возобновляемую энергетику, а также свидетельствует о поддержке правительственной миссии Цифровая Индия (Digital India). В AmpIn заявляют, что в Раджастхане ей сегодня реализуются проекты по выработке возобновляемой энергии на 1 ГВт. Ранее она заключила энергетическую сделку с Nxtra. Площадка Bhadla — один из трёх проектов общей мощностью 420 МВт, в которые инвестирует Amazon в Раджастхане. Кроме того, гиперскейлер участвует ещё в трёх стройках на территории Индии на 500 МВт, а также занят возведением ветряной электростанции на 198 МВт. Компания уже располагает многочисленными солнечными элементами непосредственно на территории своих объектов в Индии — дата-центров, складов и др. Ещё в 2022 году Amazon анонсировала 37 проектов по выработке возобновляемой энергии по всему миру, а в 2023 году и вовсе стала крупнейшим корпоративным покупателем возобновляемой энергии в мире.

08.04.2024 [09:59], Сергей Карасёв

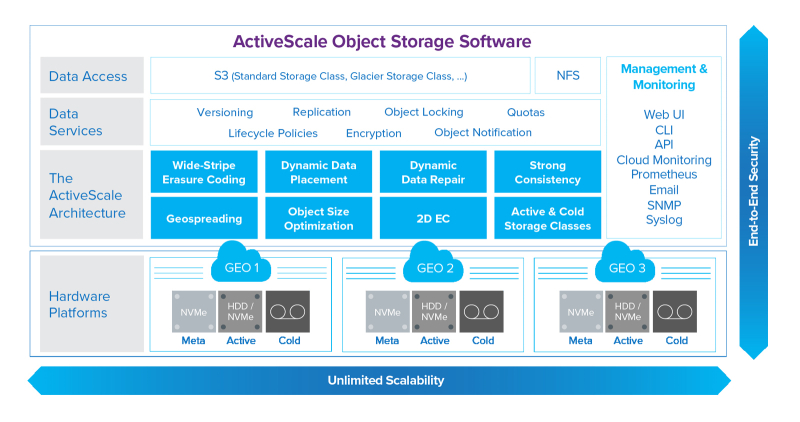

Quantum представила объектную СХД ActiveScale Z200 типа All-FlashQuantum анонсировала объектную СХД ActiveScale Z200, предназначенную для работы с приложениями ИИ и задачами, которые предусматривают интенсивный обмен информацией. Благодаря гибкому масштабированию новинка подходит для формирования крупных озёр данных, говорит компания. ActiveScale Z200 относится к решениям All-Flash. Устройство выполнено в форм-факторе 1U (437 × 43 × 597 мм, 13,02 кг) и рассчитано на установку десяти NVMe SSD вместимостью 15,36 Тбайт. Таким образом, общая ёмкость узла составляет 153,6 Тбайт. Предусмотрены два сетевых интерфейса 10/25GbE. Система ActiveScale Z200 Scale-Out предполагает трёхузловую конфигурацию с 30 накопителями на 15,36 Тбайт, то есть общая ёмкость достигает 460,8 Тбайт. Причём решение может масштабироваться до неограниченной вместимости — вплоть до экзабайт. Задействована программная платформа ActiveScale OS 7.x. Поддерживаются протоколы доступа RESTful S3 и NFS v3, а также интерфейсы управления ActiveScale SM Real-time System Management Console, CLI, RESTful API, ActiveScale View. Возможно шифрование информации по алгоритму AES-256. Компания Quantum отмечает, что СХД ActiveScale Z200 обеспечивает до пяти раз более высокую пропускную способность (Гбайт/с) и до девяти раз большую скорость обработки транзакций (объектов в с) по сравнению с традиционными решениями объектного хранения на базе HDD. Новинка подходит для работы и с «горячими», и с «холодными» данными. Утверждается, что при формировании масштабных озёр данных, облаков хранения и долгосрочных архивов достигается сокращение финансовых затрат до 80 % по сравнению с альтернативными решениями.

08.04.2024 [09:53], Сергей Карасёв

Разработчик ИИ-чипов Hailo привлёк $120 млн на развитие продуктового семействаКомпания Hailo Technologies, специализирующаяся на разработке ИИ-чипов, сообщила о проведении инвестиционного раунда Series C, в ходе которого на развитие получено $120 млн. Таким образом, на сегодняшний день стартап привлёк в общей сложности более $340 млн. Фирма Hailo была основана в Израиле в 2017 году. Представительства расположены в США, Европе, Японии, Южной Корее, Китае и на Тайване. Компания поставляет свои ИИ-решения более чем 300 клиентам по всему миру. Стартап проектирует ИИ-ускорители, которые позволяют перенести определённые нагрузки из облака или ЦОД на периферию: это сокращает задержки и снижает зависимость от пропускной способности интернет-соединения. Недавно дебютировало ИИ-решение Hailo-10 в виде модуля M.2 2242/2280, которое обеспечивает производительность до 40 TOPS. При этом энергопотребление на типовых задачах составляет менее 3,5 Вт. В раунде C приняли участие существующие и новые инвесторы. Это, в частности, семья Зисапель (Zisapel), Гиль Агмон (Gil Agmon), Альфред Акиров (Alfred Akirov), DCLBA, Vasuki, OurCrowd, Talcar, Comasco, Automotive Equipment (AEV) и Poalim Equity. Полученные средства будут направлены на укрепление рыночного положения и развитие продуктового семейства. «Закрытие нового раунда финансирования позволит нам создать основу для долгосрочного роста. Вместе с выпуском ИИ-ускорителя Hailo-10 это поможет во внедрении классического и генеративного ИИ на периферии», — говорит глава Hailo.

08.04.2024 [09:48], Сергей Карасёв

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели.

08.04.2024 [01:50], Владимир Мироненко

Groq больше не продаёт свои ИИ-ускорители, предлагая вместо этого совместно создавать ЦОД и облачные сервисыСтартап Groq, создавший ускоритель LPU на базе собственного массивно-параллельного тензорного процессора TSP, больше не продаёт оборудование, предлагая вместо этого воспользоваться его облачными ИИ-сервисами или стать партнёром в создании ЦОД. Об этом генеральный директор Groq Джонатан Росс (Jonathan Ross) сообщил ресурсу EE Times. Он пояснил, что для стартапа заниматься продажами чипов слишком сложно, потому что «минимальная сумма покупки, чтобы это имело смысл, высока, затраты высоки, и никто не хочет рисковать, покупая большое количество оборудования — неважно, насколько оно потрясающее». По его словам, в облаке GroqCloud для инференса больших языковых моделей (LLM) в реальном времени уже зарегистрировано 70 тыс. разработчиков и запущено более 19 тыс. новых приложений. В случае поступления заказов на поставку больших объёмов чипов для очень крупных систем Groq вместо продажи предлагает партнёрство по развёртыванию ЦОД. Groq подписала соглашение с саудовской государственной нефтяной компанией Aramco, которое предполагает масштабное развёртывание LPU. Похожее соглашение в ОАЭ подписала Cerebras, ещё один молодой разработчик ИИ-ускорителей. «Правительство США и его союзники — единственные, кому мы готовы продавать оборудование, — говорит Росс. — Для всех остальных мы лишь (совместно) создаём коммерческие облака». По его словам, в этом году Groq планирует разместить 42 тыс. LPU в GroqCloud, при этом Aramco и другие партнёры «завершают» свои сделки по получению такого же количества чипов. Компания способна выпустить 220 тыс. LPU только в этом году, а общий объём производства на ближайшее время составляет 1,5 млн ускорителей. Около 1 млн из них всё ещё не зарезверированы, но это количество быстро сокращается. Росс пообещал, что к концу 2025 году компания развернёт столько LPU, что их вычислительная мощность будет эквивалентна ИИ-мощностям всех гиперскейлерам вместе взятых. Росс с оптимизмом смотрит на перспективы Groq, поскольку чипы TSP не используют память HBM, на которую полагаются решения конкурентов, включая NVIDIA, и поставки которой расписаны до конца 2024 года. Что касается LPU следующего поколения, то компания планирует сразу перейти с 14-нм техпроцесса (Global Foundries) на 4-нм. По словам Росса, новый чип будет оптимизирован для генеративного ИИ, но у него в силу универсальности архитектуры не будет каких-то специальных функций для обработки LLM. Будет ли новый ускоритель всё так же изготавливаться на территории США, не уточняется. Groq, похоже, достаточно уверена в своих чипах, которые в бенчмарках действительно обгоняют конкурентов. После анонса архитектуры NVIDIA Blackwell, обеспечивающей кратное увеличение производительности в задачах генеративного ИИ, компания выпустил в ответ пресс-релиз из одного предложения: «Groq всё ещё быстрее». А чуть позже даже раскритиковала NVIDIA.

07.04.2024 [23:52], Руслан Авдеев

Утром — деньги, вечером — SMR: Equinix заплатила $25 млн за право получить до 500 МВт от малых модульных реакторов OkloEquinix заключила предварительное соглашение с создателем малых модульных реакторов (SMR) Oklo, поддерживаемым главой OpenAI Сэмом Альтманом (Sam Altman). По данным Datacenter Dynamics, это первый договор, подписанный оператором, предусматривающий использование SMR. В заявлении по форме S4, поданном AltC Acquisition Corp в Комиссию по ценным бумагам и биржам США (SEC), раскрываются некоторые детали сделки. В частности, Equinix внесла в качестве предоплаты $25 млн. Считается, что в данном случае речь идёт о финансировании акционерного капитала — Equinix получает возможность купить долю в 1,5-1,9 % в бизнесе Oklo. Сейчас разработчик реакторов находится в стадии обратного слияния со SPAC-компанией AltC Acquisition, намеренной вывести специалистов по атомной энергетике на IPO в июле 2024 года. Вместо акций Equinix также может получить дисконт на приобретение энергии. Модульные реакторы Oklo на быстрых нейтронах способны генерировать до 15 МВт каждый и работать до 10 лет без перезарядки. Equinix будет получать энергию от SMR Oklo в США в течение 20 лет. Конкретные объёмы будут оговариваться в будущих соглашениях о покупке энергии (PPA), а в будущем Equinix сможет обновить и расширить PPA ещё на 20 лет. Оператор ЦОД также получил право преимущественной покупки энергии, вырабатываемой определёнными реакторами, сроком на 36 месяцев — выкупаемая мощность составит 100–500 МВт. SMR, разрабатываемые также NuScale, Rolls-Royce и другими компаниями, предлагаются в качестве источника «низкоуглеродного» экобезопасного питания для ЦОД — это позволит дата-центрам работать без подключения к магистральным электросетям. В прошлом году Standard Power анонсировала планы приобрести 24 SMR у NuScale, хотя позже его назвали фейковым.

07.04.2024 [14:12], Сергей Карасёв

Разработчик ИИ-чипов SiMa.ai получил на развитие ещё $70 млнСтартап SiMa.ai, разрабатывающий аппаратные и программные решения для обработки ИИ-задач на периферии, объявил о проведении раунда финансирования на сумму в $70 млн. Таким образом, в общей сложности компания привлекла на развитие $270 млн. Ключевым продуктом SiMa.ai является изделие Machine Learning System-on-Chip (MLSoC). Оно специально спроектировано с прицелом на периферийные ИИ-приложения. Это могут быть роботы, дроны, системы машинного зрения, автомобильные платформы, медицинское оборудование и пр. В состав MLSoC входит ряд блоков. Это, в частности, ИИ-ускоритель с 25 Мбайт интегрированной памяти, обеспечивающий производительность до 50 TOPS (INT8) или 10 TOPS/Вт. Он дополнен процессором приложений на базе четырёх вычислительных ядер Arm Cortex-A65 с частотой 1,15 ГГц. Присутствует четырёхъядерный узел компьютерного зрения Synopsys ARC EV74. Изделие также несёт на борту блоки (де-)кодирования видео в формате H.264. Реализована поддержка четырёх портов 1GbE, интерфейсов PCIe 4.0 х8, SPIO, I2C и GPIO. Чип MLSoC доступен в составе платы для разработчиков. Компания также предоставляет специализированный набор инструментов под названием Pallet, упрощающий создание ПО для чипа. Этот комплект включает, в частности, компилятор, который преобразует модели ИИ в формат, оптимизированный для работы в системах на основе MLSoC. Сообщается, что раунд финансирования на $70 млн проведён под руководством Maverick Capital. В нём также приняли участие Point72, Jericho, Amplify Partners, Dell Technologies Capital, предприниматель Лип-Бу Тан (Lip-Bu Tan) и др. Полученные средства пойдут на разработку 6-нм чипа MLSoC второго поколения, который будет выпущен на TSMC в I квартале 2025 года. Известно, что это решение объединит CPU на базе Arm Cortex-A и модуль компьютерного зрения Synopsys EV74.

07.04.2024 [13:35], Сергей Карасёв

Accelsius и OptiCool предложат комбинированные двухфазные СЖО для дата-центровКомпании Accelsius и OptiCool объявили о стратегическом партнёрстве, целью которого является создание инновационных СЖО для дата-центров. Предполагается, что внедрение таких систем поможет повысить энергоэффективность ЦОД, ориентированных на ресурсоёмкие задачи ИИ. Accelsius является разработчиком двухфазных систем NeuCool, которые используют технологию прямого жидкостного охлаждения Direct-To-Chip (DTC). В свою очередь, OptiCool занимается поставками решений для отвода тепла. Стороны намерены использовать в своих системах диэлектрическую жидкость. Отмечается, что исторически в однофазных СЖО использовалась вода. Вместе с тем Accelsius и OptiCool отмечают «значительный рост интереса клиентов» к инфраструктурам охлаждения, которые не требуют применения воды в первичном контуре. Такой подход исключает любое потенциальное повреждение серверов и IT-оборудования в результате утечек. Для дата-центров, ориентированных на задачи ИИ и НРС, это означает «защиту инвестиций на миллионы долларов», говорят компании.

Источник изображения: Opticool Партнёры намерены предлагать клиентам двухфазные СЖО типа DTC с активным отводом тепла через заднюю дверцу. Эти системы будут адаптироваться под потребности заказчиков, одновременно исключая риск повреждения оборудования водой. Отмечается, что в системах OptiCool используется R134a — нетоксичный синтетический хладагент. «Это сотрудничество имеет большое значение для индустрии ЦОД, поскольку нацелено на удовлетворение растущего спроса на эффективные и устойчивые решения. Объединив наш опыт, мы можем создать комплексную систему охлаждения, отвечающую меняющимся потребностям рынка», — говорит генеральный директор OptiCool.

07.04.2024 [13:22], Руслан Авдеев

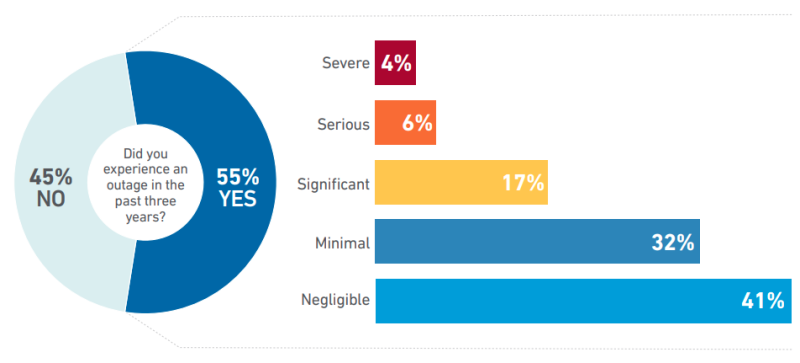

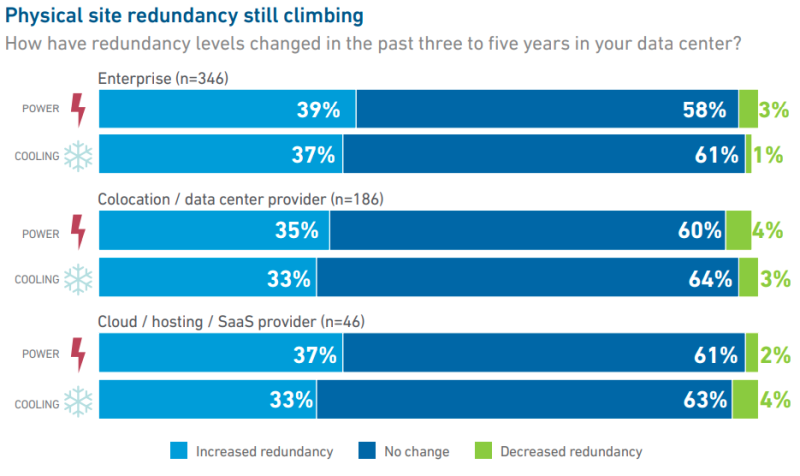

Проблемы с питанием чаще всего становятся причиной сбоев ЦОД, но избавиться от них не позволяет человеческий факторЧастота и серьёзность сбоев в ЦОД постепенно снижается относительно общей ёмкости объектов. Тем не менее, сообщает The Register, нарушения работы могут очень дорого обойтись операторам и их клиентам, а проблемы с электропитанием ведут к особенно серьёзным последствиям. Ёмкость дата-центров постоянно увеличивается, так что общее количество инцидентов тоже растёт, но по данным Uptime Institute, частота и тяжесть происшествий увеличивается относительно медленными темпами. И хотя их стало больше в абсолютном значении, темпы прироста заметно упали в последние годы. На то имеется ряд причин, включая тот факт, что многие организации стали интенсивно вкладываться в обеспечение надёжности работы оборудования. Среди других причин называются переход клиентов в облака и внедрение новых технологий для соответствия требованиям регуляторов.

Источник изображения: Uptime Institute Однако Uptime Institute предупреждает, что данные о перебоях могут оказаться не вполне точными, потому что операторы зачастую не желают раскрывать информацию об инцидентах из-за возможного репутационного ущерба, так что сведения приходится собирать из открытых источников. В докладе Annual Outage Analysis 2024 констатируется, что 55 % опрошенных представителей операторов подтвердили, что в последние три года в их ЦОД были перебои. С другой стороны, годом ранее речь шла о 60 %, а в 2021 году — о 69 %. В то же время только 10 % сбоев за последний год оценили как «серьёзные» или «тяжёлые», тогда как двумя годами ранее таковых было на 14 п.п. больше. 54 % респондентов отметили, что самые значимые происшествия в их компаниях обошлись более чем $100 тыс., а 16 % — более $1 млн. Главной причиной называлась проблема с системой распределения энергии на местах, в докладе эта тема отмечается в 52 % инцидентов. Исследователи говорят, что переход на более «динамичные» электросети с возобновляемыми источниками энергии сделал сети питания менее надёжными. При этом в ряде случаев ИБП/генераторы не смогли корректно отреагировать на отказ сети. Например, ровно это вызвало перебои с сервисами Microsoft Azure в Европе в 2023 году.

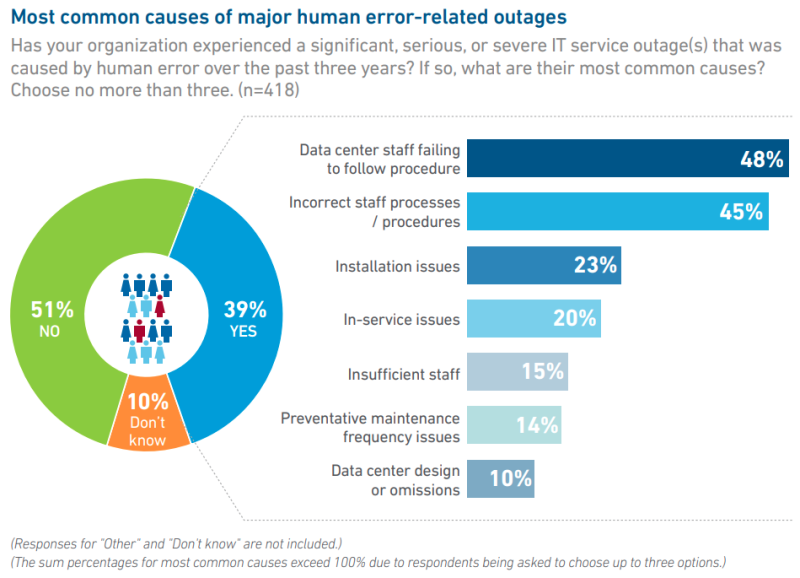

Источник изображения: Uptime Institute Вторая из ключевых причин сбоев — поломка или недостаточная производительность охлаждающего оборудования. Эксперты отметили, что количество проблем со сторонними сервисами выросло с 2020 года вдвое — на них приходится порядка 10 % сбоев в 2023 году. Это связано с ростром популярности облачных сервисов, в том числе SaaS, услуг хостинга и колокации. Во многих случаях играют роль человеческие ошибки — на них приходится от ⅔ до ⅘ всех инцидентов. Виной некорректное соблюдение процедур по обслуживанию оборудования или некорректность самих процедур. Например, в прошлом году на Нью-йоркской фондовой бирже (NYSE) сотрудник не смог корректно восстановить работу систем после сбоя во вспомогательном ЦОД, что привело к неверному ценообразованию на следующий день. Предполагается, что количество сбоев можно будет уменьшить благодаря более интенсивным тренировкам персонала и аудиту вероятных слабых мест.

Источник изображения: Uptime Institute По данным Uptime Institute, каждый год случается 10–20 крупных отказов оборудования ЦОД в мире, что ведёт к серьёзным финансовым потерям и перебоям в обслуживании клиентов, а во многих случаях и к репутационным издержкам. В любом случае недавно в Uptime Institute сообщали, что в ближайшие годы затраты на строительство и обслуживание дата-центров будут только расти. |

|