Материалы по тегу: hardware

|

10.01.2025 [14:21], Руслан Авдеев

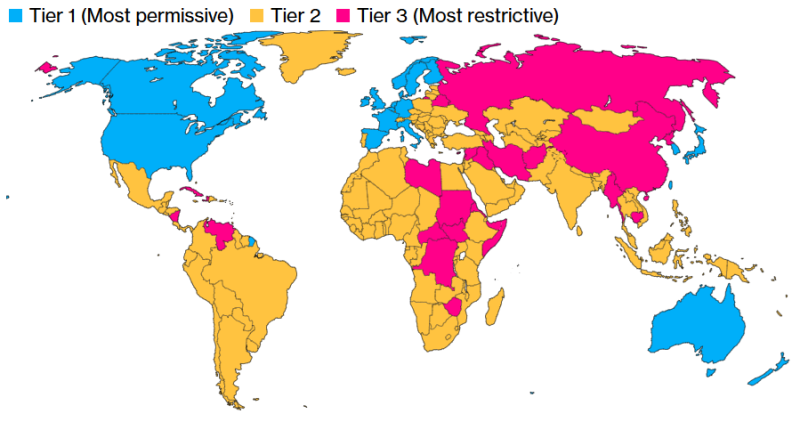

ИИ по квотам: США распространят ограничения на поставку ускорителей и обучение моделей почти на весь мирАдминистрация действующего президента США Джо Байдена (Joe Biden) до окончания своих полномочий намерена провести очередной раунд ограничений на экспорт ИИ-чипов. Это новая попытка перекрыть доступ к передовым технологиям Китаю, Ирану, России и другим странам, сообщает Bloomberg. После появления новостей акции NVIDIA и AMD несколько упали в цене. По данным источников, США намерены ограничить продажи ИИ-полупроводников для ЦОД как на уровне стран, так и на уровне отдельных компаний. Основная цель — обеспечить развитие передовых ИИ-систем только «дружественным» государствам и приведение мирового бизнеса в соответствие с американскими стандартами. В результате ограничения в той или иной степени распространятся почти на весь мир. Неограниченный доступ к современным технологиям сохранит только небольшая группа союзников США вроде Канады, ряда стран ЕС, Южной Кореи и Японии. Остальным доступ постараются перекрыть максимально, а большая часть мира, по мнению администрации, оказалась недостаточно благонадёжной, чтобы покупать ИИ-ускорители без ограничений. Появятся квоты, ограничивающие вычислительные способности каждой отдельной страны. Компании, базирующиеся в таких странах, могут обойти подобные ограничения — но для этого им необходимо будет привести свой бизнес в соответствие с американскими стандартами. Для этого вводится термин «проверенный конечный пользователь» (Validated End User, VEU). Разумеется, в NVIDIA выступили против инициативы, подчеркнув, что ограничение экспорта не прекратит злоупотребления, но создаст угрозу экономическому росту и поставит под вопрос лидерство США. Пока общемировой интерес к ускоренным вычислениям в повседневной жизни — невероятная возможность для экономики Соединённых Штатов. Многолетние санкции уже ограничивают возможности NVIDIA, AMD и др. компаний поставлять передовые чипы любому заказчику. Теперь США пытаются ограничить доступ к чипам через посредников на Ближнем Востоке и в Юго-Восточной Азии. Против инициативы выступает и Ассоциация полупроводниковой промышленности (Semiconductor Industry Association). Ассоциация не одобряет принятия решения в период смены президентов, без учёта мнения отрасли — это может сказаться на конкурентоспособности США в мире. Китай имеет собственные ИИ-чипы, хотя и не такие производительные и, возможно, будет поставлять их и другим странам, усиливая своё влияние. Новые меры готовятся ввести на фоне гигантского спроса на ИИ-ускорители. Буквально каждая страна намерена использовать их в своих ЦОД, в чём и заключается «уникальная возможность» США и в политической плоскости — чтобы, по словам конгрессменов, «увести компании и страны с орбиты Пекина». К первому «разряду» (Tier I), по данным источников издания, отнесут США и 18 союзников, включая Канаду, Австралию, Японию, Великобританию, Германию, Францию, Южную Корею и Тайвань. Компании из этих регионов могут свободно пользоваться вычислительными ресурсами, а их штаб-квартиры в этих странах смогут получить разрешение на поставку чипов в ЦОД практически по всему миру. Однако им запрещено размещать более 25 % вычислительных мощностей за пределами стран Tier I и более 7 % — в любой из стран Tier II. Кроме того, они должны будут соблюдать требования к безопасности, выдвигаемые американским правительством. Компании со штаб-квартирами в США должны будут размещать не менее половины вычислительных мощностей на американской земле. В целом США и приближённые страны, согласно новому плану, должны располагать большими вычислительными мощностями, чем весь остальной мир. Подавляющее большинство стран относится ко второму разряду (Tier II). Каждой из них можно внедрить порядка 50 тыс. ИИ-ускорителей с 2025 по 2027 гг. При этом отдельные компании могут добиться гораздо больших лимитов, если получат статус VEU в каждой стране, где намерены оснастить ЦОД. Для этого необходимо иметь доказанную историю соблюдения американских норм и стандартов в сфере прав человека, или, как минимум, иметь убедительные планы для достижения необходимых результатов. Если компания получит статус VEU, её импорт чипов не будет сказываться на общей квоте страны. Это поощряет бизнес приводить свою деятельность в соответствие с американскими стандартами. Вместе с тем накладываются и требования по физической безопасности объектов, кибербезопасности и отбору персонала. Наконец, больше всего ограничения коснутся России, Беларуси, Китая, Ирана, КНДР, а также всех стран, на которые распространяется американское эмбарго на поставки вооружений. Речь идёт приблизительно о двух дюжинах государств уровня Tier III. Поставки ИИ-ускорителей в ЦОД этих стран будут запрещены. Помимо контроля над полупроводниками, новые правила также ограничивают и экспорт закрытых ИИ-моделей. Компаниям будет запрещён их хостинг в странах Tier III, а страны Tier II должны будут выполнять ряд требований. Конечно, ограничения не распространяются на страны, получившие универсальный статус VEU. Открытых моделей эти правила не коснутся, то же касается и маломощных закрытых моделей, менее производительных, чем имеющиеся в свободном доступе. Тем не менее, если компания захочет настроить открытую модель для выполнения специальных задач и этот процесс потребует значительных вычислительных мощностей, ей также понадобится подавать заявку на получение разрешения США для выполнения подобных задач в странах Tier II. Ранее США запрещали поставки в страны вроде России на неопределённый срок. В Китай разрешено было поставлять версии с ограниченной функциональностью, а в ноябре прошлого года появилась новость, что США запретили TSMC выпускать передовые ускорители по заказу китайских компаний. На большинство стран мира ограничения не распространялись, что способствовало стремительному росту бизнеса NVIDIA.

10.01.2025 [08:20], Руслан Авдеев

Siemens: спрос на энергию со стороны ИИ ЦОД нормализуется, но «зелёных» источников всё равно на всех не хватитПо словам представителя Siemens Маттиаса Ребеллиуса (Matthias Rebellius), ИИ ЦОД не могут полагаться только на «зелёные» источники для удовлетворения своего спроса на электричество. Им придётся прибегнуть к помощи поставщиков других типов электроэнергии, сообщает The Wall Street Journal. Несмотря на то, что крупнейшие гиперскейлеры заключают долгосрочные соглашения о покупке возобновляемой энергии, Ребеллиус заявил, что это не решение для энергетических запросов сектора. По его словам, мир нуждается в новом плане по быстрому наращиванию генерирующих мощностей в короткие сроки. В 2024 году гиперскейлеры активно уделяли внимание атомной энергетике в качестве низкоуглеродной альтернативы ископаемому топливу. AWS и Microsoft заключили соглашения о выкупе энергии у крупных атомных электростанций. Кроме того, Equinix, AWS и Google подписали контракты питание от малых модульных реакторов (SMR). Впрочем, коммерческих SMR пока не существует, а внедрять их начнут не раньше 2030-х гг. При этом традиционная атомная энергетика доступна далеко не везде и не всем, поэтому она не сможет удовлетворить спрос на электричество в ближайшем будущем. В Siemens считают, что рост спроса на энергию в связи с развитием ИИ неизбежно нормализуется после текущей фазы быстрого роста. Ребеллиус утверждает, что ежегодного прироста на уровне 50 % ждать не придётся, хотя Siemens и другие компании всё же ожидают со стороны дата-центров двузначного роста в процентном выражении на энергии, что, впрочем, всё равно вдвое выше, чем на обычном инфраструктурном рынке. Чтобы удовлетворить спрос, энергетические компании в США используют все доступные источники энергии, а некоторые из них анонсировали, что отложат закрытие электростанций на ископаемом топливе или перезапустят уже закрытые в связи с беспрецедентным спросом. Некоторые операторы уже объявили, что в «ультракороткой перспективе» дата-центры могут полагаться на энергию газовых электростанций из-за высочайшего спроса на электричество. Это послужит своеобразным «мостиком» при переходе на низкоуглеродные источники энергии. Ранее в докладе S&P Global сообщалось, что спрос на природный газ для обеспечения энергией дата-центров в США может вырасти до 85 млн или даже 170 млн м3 в день для обеспечения потребностей ИИ. Кроме того, не так давно сообщалось о намерении запустить на территории старых атомных и классических электростанций в США новые реакторы.

10.01.2025 [01:20], Руслан Авдеев

США упростят подключение ИИ ЦОД к геотермальным источникам энергииУходящее в ближайшие дни правительство США намерено упростить получение разрешений на работу с геотермальной энергией. Новая инициатива будет реализована в рамках более общей программы поддержки ИИ ЦОД, сообщает Bloomberg. Приказ будет одним из последних, подписанных действующим президентом США Джо Байденом (Joe Biden) до того, как тот оставит должность. Ожидается, что документ будет опубликован на следующей неделе. Новые меры в числе прочего предусматривают упрощение процесса строительства дата-центров на федеральных землях, а также ускорение выдачи разрешений для реализации геотермальных и атомных проектов. Министерство внутренних дел США выделит зоны приоритетного развития геотермальной энергетики, а Министерство обороны и Министерство энергетики определят площадки, принадлежащие федеральным ведомствам, где можно будет построить крупные дата-центры. Расположенные на федеральных землях объекты должны соответствовать особым стандартам и нормам кибербезопасности, на них будут распространяться ограничения на иностранное финансирование. Кроме того, участвующим в проектах бизнесам придётся выделить часть вычислительных ресурсов на национальные исследования в области ИИ. В последнее время уходящая администрация США буквально фонтанирует всевозможными приказами. Не исключено, что после прихода нового президента Дональда Трампа (Donald Trump), часть из них может быть отменена. Впрочем, вряд ли это касается сектора ЦОД. Администрация Трампа дала понять, что развитие дата-центров останется в приоритете — это вопрос обеспечения национальной безопасности. Будущие власти обещают предоставить ИИ ЦОД все доступные виды энергии. Некоторые гиперскейлеры уже подписали с геотермальными электростанциями соглашения на поставку энергии для их ЦОД. В августе 2024 года Meta✴ анонсировала 150-МВт сделку со стартапом Sage Geosystems. Первая фаза проекта должна завершиться введением объектов в эксплуатацию в 2027 году. Ранее Google договорилась о сотрудничестве с Fervo Energy и NV Energy о покупке более 100 МВт геотермальной энергии в Неваде, а Microsoft подписала связанные с геотермальной энергетикой соглашения о покупке энергии (PPA) в Новой Зеландии с Contact Energy, а также развивает геотермальный проект в Кении.

10.01.2025 [01:09], Владимир Мироненко

Tencent потеряла $35 млрд капитализации после попадания в чёрный список ПентагонаМинистерство обороны США объявило в начале недели о включении ИТ-гиганта Tencent, производителя аккумуляторов CATL и ещё целого ряда компаний из КНР в чёрный список, также известный как «список раздела 1260H». В него Пентагон с 2021 года добавляет компании, которые, по его мнению, помогают модернизировать армию Китая, пишет Fortune.com. Черный список Пентагона не налагает никаких конкретных санкций на включённые в него компании, кроме запрета предоставлять услуги армии США. Тем не менее аналитики Morningstar предупреждают, что попадание в него может привести к «репутационному ущербу» и отказу других компаний от сотрудничества с Tencent и CATL. В этот список уже попали Huawei, чипмейкеры SMIC и YMTC, а также производитель дронов DJI. Акции Tencent на бирже в Гонконге упали во вторник на 7,3 %, в связи чем компания потеряла около HK$275 млрд (порядка $35,4 млрд) рыночной стоимости. Акции CATL, зарегистрированные в Шэньчжэне, закрылись со снижением на 2,8 %, что привело к потере ¥32,2 млрд (около $4,4 млрд) рыночной стоимости. Представитель Tencent назвал включение фирмы в чёрный список «явной ошибкой» и отметил, что это не окажет никакого влияния на её бизнес. «Мы не военная компания и не поставщик [армии]… Тем не менее мы будем работать с Министерством обороны, чтобы устранить любые недоразумения», — заявил он. Министерство иностранных дел Китая выступило с критикой этого решения. «Китай всегда решительно выступал против обобщения американской стороной концепции национальной безопасности, создания различных дискриминационных списков, необоснованного подавления китайских предприятий и сдерживания развития Китая», — заявил журналистам пресс-секретарь Го Цзякунь (Guo Jiakun). Morningstar считает, что у Tencent «хорошие шансы» отменить включение в «чёрный» список через суд, ссылаясь на то, что её бизнес-модель в основном нацелена на сегменты социальных сетей и видеоигр. Так, китайскому производителю телефонов Xiaomi, включённому в чёрный список в конце работы первой администрации Трампа, которая запретила инвестиции США в компанию, удалось доказать в суде, что это было «незаконным и неконституционным». И спустя четыре месяца Министерство обороны США исключило Xiaomi из списка. И таких примеров можно привести несколько. Министерство обороны США отметило, что компании, включённые в список, имеют право потребовать пересмотра решения. Пентагон уже исключил несколько компаний из чёрного списка, включая Beijing Megvii Technology Co., China Marine Information Electronics Co., China Railway Construction Corp., China State Construction Group Co., China Telecommunications Corp. и ShenZhen Consys Science & Technology Co.

09.01.2025 [17:57], Владимир Мироненко

SoftBank и Arm заинтересовались покупкой Ampere, но о переговорах говорить раноЯпонский холдинг SoftBank Group вместе с британской компанией Arm, в которой он владеет 90 % акцией, проявляют интерес к покупке поддерживаемого Oracle стартапа Ampere Computing из Санта-Клары (Калифорния, США), специализирующегося на разработке серверных Arm-процессоров, пишет Bloomberg со ссылкой на информированные источники. По словам источников, на данный момент идёт обсуждение потенциальной сделки и нет гарантий, что дело дойдёт до переговоров. Возможно, что на покупку Ampere найдётся другой претендент. Ранее стало известно, что компания Ampere привлекала финансового консультанта, чтобы обсудить возможные варианты поглощения более крупной компанией. В 2021 году, когда SoftBank планировал инвестировать в компанию, Ampere Computing была оценена в $8 млрд. В какую сумму оценивается рыночная стоимость Ampere Computing на данный момент при обсуждении сделки, выяснить не удалось. Согласно документам, поданным Ampere Computing в регулирующие органы, Oracle инвестировала сотни миллионов долларов в стартап с момента его основания. Oracle заявила в прошлом году, что владеет 29 % стартапа и может снова инвестировать в компанию, чтобы получить полный контроль над производителем чипов. Oracle, по-видимому, является крупнейшим заказчиком продуктов Ampere. Arm постепенно отходит от лицензирования своих разработок, становясь полноценным производителем чипов. Привлечение инженеров Ampere, многие из которых ранее работали в подразделении Intel по производству серверных чипов, может добавить экспертные знания и импульс для выхода Arm на этот рынок, считает Bloomberg. Основатель и генеральный директор Ampere Рене Джеймс (Renee James), бывший топ-менеджер Intel, рассматривала в 2022 году возможность вывода Ampere на биржу в США. Некоторые эксперты предполагали, что компания изначально ориентировалась на поглощение одним из крупных гиперскейлеров, но в итоге AWS, Google Cloud и Microsoft Azure стали развивать собственные Arm-процесоры Graviton, Axion и Cobalt 100.

09.01.2025 [17:23], Руслан Авдеев

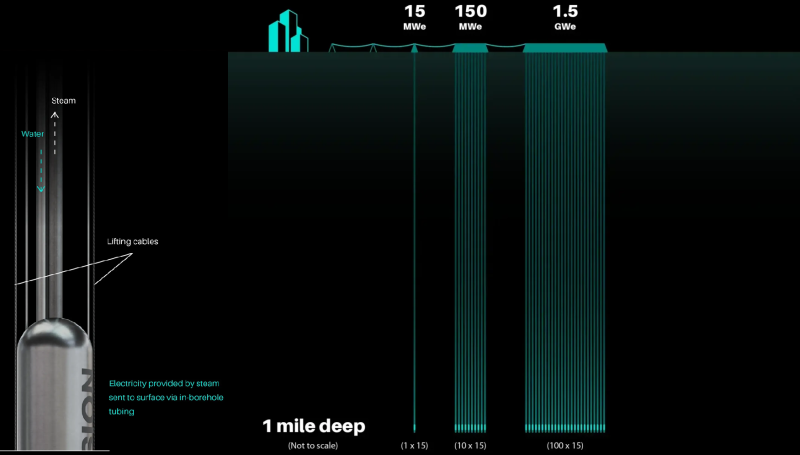

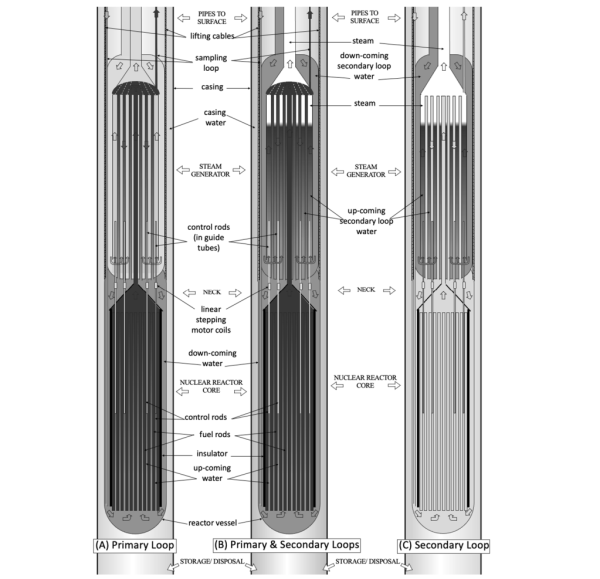

Deep Fission запитает ЦОД Endeavour от подземных малых ядерных реакторов на глубине более 1,5 кмDeep Fission, разрабатывающая малые модульные реакторы (SMR), подписала соглашение с американским девелопером экоустойчивой инфраструктуры Endeavour Energy, в рамках которого дата-центры Endeavour Edged будут запитаны от реакторов суммарной мощностью 2 ГВт. В Deep Fission утверждают, что пока стоимость энергии, получаемой от SMR довольно высока, но технология компании чрезвычайно безопасна и позволит поставлять электричество без углеродных выбросов по цене 5–7 центов за кВт∙ч. Модель Deep Fission Borehole Reactor 1 (DFBR-1) представляет собой водно-водяной реактор под давлением (PWR), обеспечивающий 15 МВт тепловой и 5 МВт электрической энергии. Одной загрузки топлива должно хватить на 10–20 лет непрерывной работы. DFBR-1 будут размещаться в скважинах диаметром около 0,76 м на глубине более 1,5 км, где давление достаточно велико для того, чтобы можно было отказаться от толстой оболочки реактора. Как утверждают в компании, такой подход снижает себестоимость реактора и повышает его безопасность. Даже если случится утечка, то никакой значимой радиоактивной угрозы не будет, поскольку топливо останется внизу, не попав ни на поверхность, ни в водоносные слои. Новый реактор после окончания срока работы старого можно разместить в скважине поблизости или в той старой скважине на чуть меньшей глубине, буквально поверх предшественника. Разработчики уверяют, что подобное решение позволит сократить как себестоимость строительства, так и сроки реализации проекта в сравнении с наземными вариантами. Также может быть обеспечена плотность в более чем 100 МВт на площади в 0,1 га. Калифорнийская Deep Fission основана в 2023 году, а в августе прошлого года она анонсировала раунд предварительного финансирования на сумму $4 млн для ускорения своих попыток нанять специалистов, получить одобрение регуляторов и обеспечить коммерциализацию SMR. Edged является ЦОД-подразделением Endeavour. Компания основана в 2021 году и владеет дата-центра в США и на Пиренейском полуострове. Она специализируется на ИИ ЦОД высокой плотности с безводными системами охлаждения. В 2024 году SMR стали популярные в секторе ЦОД. В октябре 2024 года AWS заключила соглашение с Energy Northwest, X-Energy и Dominion Virginia, чтобы поддержать внедрение реакторов на 600 МВт. До этого Google подписала корпоративное соглашение для покупки атомной энергии от многочисленных SMR Karios Power, внедрение ожидается в 2030 году. Наконец, строитель ЦОД Switch подписал соглашение о покупке до 12 ГВт с SMR компании Oklo. Этот договор стал для последней уже пятым соглашением с операторами ЦОД в 2024 году. Хотя ни одного коммерческого SMR в мире ещё нет, компания уже имеет договоры на поставку 14 ГВт.

09.01.2025 [12:43], Руслан Авдеев

DeepGreenX и Sente Ventures направят $25 млрд на развитие «зелёных» ЦОДЮжнокорейская DeepGreenX заключила рамочное соглашение с Sente Ventures для создания новой стратегической инвестиционной программы сроком на пять лет на сумму $25 млрд. Инвестициями смогут воспользоваться компании, предлагающие решения в области производства «чистой» энергии, виртуальных энергосетей, энергохранилищ, микрореакторной энергетики и инфраструктуры ЦОД, сообщает Datacenter Dynamics. В рамках нового партнёрства создано совместное предприятие DXG-Hues. DXG-Hues сформирует два фонда по $5 млрд каждый для проектов в сфере «зелёной» энергетики, ИИ и вычислительных мощностей в США, Европе и странах Юго-Восточной Азии. Планируется использовать программу привлечения клиентов, ориентированных на устойчивое развитие, и внедрение передовых решений для платформы DeepGreenX, предназначенной для монетизации данных на основе ИИ-алгоритмов. В DeepGreenX рассчитывают, что программа откроет новые возможности для компаний и проектов, связанных с «зелёной» энергетикой. Сеульская DeepGreenX, основанная в 2020 году, действует в 20 странах, занимаясь торговлей углеродными кредитами, сертификацией «зелёной» энергии и управлением активами для секторов ЦОД и технологий в целом. Sente Ventures — венчурный инвестор из Чикаго, специализирующийся на снижении инвестиционных рисков в низкоуглеродные технологии. Компания действует в 24 странах. Азиатский банк развития и инвестиций (Asia Development and Investment Bank, ADIB) объявил в ноябре о стратегических вложениях в DeepGreenX. В частности, компания получит $140 млрд на инжиниринг, закупки, строительство и управление данными. При этом банк получит 36 % акций компании. Впрочем, слишком много «зелёной» энергии — тоже не всегда хорошо: в прошлом году Нидерланды приняли новые нормы работы энергосетей, страдающих от эпизодических перегрузок в результате многочисленных подключений частных электростанций на возобновляемой энергии.

09.01.2025 [12:27], Руслан Авдеев

Microsoft инвестирует $3 млрд в ИИ и облачные вычисления в ИндииКомпания Microsoft намерена инвестировать порядка $3 млрд в расширение ИИ и облачных мощностей в Индии. Об инвестициях объявил 7 января в Бангалоре глава компании Сатья Наделла (Satya Nadella) в ходе поездки Microsoft AI Tour, сообщает Datacenter Dynamics. По его словам, ИИ не существует сам по себе, он требует полного вычислительного стека. Глава Microsoft добавил, что инфраструктура должна быть высочайшим приоритетом, компания внедряет инновации на каждом её уровне. Анонс инвестиций последовал за встречей Наделлы с премьер-министром Индии. 6 января последний сообщил в соцсети X, что в восторге от визита гендиректора Microsoft и рад узнать об амбициозных планах экспансии и инвестиций компании в стране. Microsoft уже располагает несколькими облачными регионами в Индии, а всего в мире у неё есть более 60 облачных регионов и 300 дата-центров. В рамках инициативы ADVANTA(I)GE INDIA компания планирует к 2030 году обучить навыкам работы с ИИ в стране 10 млн человек.

Источник изображения: Yadu Krishnan K S/unsplash.com В 2015 году компания открыла в Индии три облачных региона Azure: в Пуне (Центральная Индия), Ченнаи (Южная Индия), а также Мумбаи (Западная Индия). С тех пор компания отключила регион в Мумбаи, который, возможно, будет превращён в регион резервного доступа. В 2024 году компания приобрела участок на 6,5 га в пригороде Пуна для строительства нового ЦОД. Также компания приобрела 20 га в Хайдарабаде. Недавно компания сообщила, что намерена потратить $80 млрд на строительство ИИ ЦОД в 2025 финансовом году, речь идёт о значительном росте в сравнении с годом ранее. Более половины инвестиций придётся на Соединённые Штаты.

09.01.2025 [00:55], Владимир Мироненко

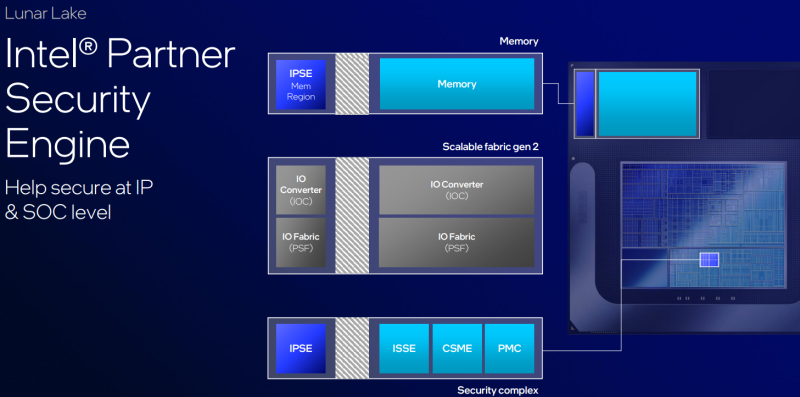

Процессоры Lunar Lake получили обновлённую платформу Intel vProIntel объявила, что новые процессоры серии Core Ultra 200V (Lunar Lake) получили обновлённую платформу Intel vPro с новыми функциями безопасности и управления. По словам компании, эта аппаратная платформа просто необходима организациям. Как ожидает Intel, в 2025 году начнётся один из крупнейших циклов обновления парка компьютеров в новейшей истории, который будет даже масштабнее цикла обновления времён COVID-19. В октябре Microsoft прекратит выпуск обновлений безопасности и техническую поддержку Windows 10. По оценкам, у 450 млн пользователей компьютеры слишком старые для обновления до Windows 11, поэтому им понадобятся новые ПК. Кроме того, сейчас наступает эра ИИ ПК, влекущая за собой необходимость использования нового класса ПО, с которым могут справить именно новые CPU. Наконец, после инцидента с CrowdStrike многие организации задумались об обновлении платформ. Ожидаемое масштабное обновление в рамках нового цикла означает, что специалисты по информационным технологиям (ИТ) в компаниях будут искать платформу, которая позволит им удалённо управлять всем парком ПК — от единиц до десятков тысяч машин. При этом им требуются максимально возможные безопасность и защита конфиденциальности, сообщила Intel. И именно обновлённая платформа vPro позволит решить многие вопросы. Intel vPro бесшовно интегрируется в корпоративные системы и помогает ИТ-отделам сократить количество выездов для ремонта, устраняя и диагностируя неполадки удалённо, даже если устройство выключено. Во время сбоя 8,5 млн корпоративных ПК команда Intel vPro сотрудничала с CrowdStrike, чтобы помочь клиентам в устранении его последствий. По словам Intel, именно благодаря vPro многие компании смогли восстановить свою работу всего за несколько часов после сбоя, в то время как их конкуренты потеряли несколько дней. Сбой продемонстрировал необходимость наличия диверсифицированных стратегий безопасности и надёжного плана восстановления после сбоев, а также риск зависимости от одного поставщика критически важных решений. Обновлённая платформа vPro реализует в «кремнии» более 30 защитных механизмов. Аппаратная реализация значительно быстрее программных решений и дополнительно затрудняет для киберпреступников обход или отключение систем защиты. Кроме того, vPro позволяет изолировать конфиденциальные данные и их обработку на уровне процессора, что затрудняет доступ к ним вредоносного ПО. Intel хвастается, что именно её система защиты с аппаратной поддержкой впервые прошла проверку MITRE ATT&CK, доказав свою способность противодействовать более чем 150 реальным методам кибератак. Также в составе vPro теперь есть Intel Partner Security Engine, выделенный и изолированный движок безопасности, который может запускать стороннее встроенное ПО, например, Microsoft Pluton. Наконец, отмечается, что в более ранних версиях vPro клиентам нужно было пройти 24 шага, чтобы активировать весь доступный набор инструментов защиты. Теперь же количество шагов сокращено до шести, а организациями больше не нужна собственная инфраструктура облачных серверов, отметила Intel. Обновлённую платформу Intel vPro уже взяли на вооружение более 10 мировых OEM-производителей, включая Acer, Asus, Dell, HP, Lenovo, LG, MSI и Samsung. В этом месяце она будет доступна на более чем 30 моделях ПК. В ходе исследования в 2024 году, проведенного по заказу Intel совместно с Forrester, было опрошено 500 клиентов с целью оценки общего экономического эффекта от использования платформы Intel vPro. Было отмечено до 213 % возврата инвестиций (ROI) за три года, до 90 % сокращения количества выездов специалистов на место и до 65 % сокращения времени, затрачиваемого на управление парком устройств.

08.01.2025 [16:09], Руслан Авдеев

Дубайская DAMAC инвестирует $20 млрд в строительство дата-центров в СШАДональд Трамп (Donald Trump) объявил о намерении дубайского девелопера элитной недвижимости DAMAC вложить $20 млрд в строительство ЦОД в Соединённых Штатах, сообщает The Register. В какие сроки будет истрачена указанная сумма, не сообщается, но сам Трамп говорит об «очень коротком промежутке времени». Для сравнения — одна только Microsoft намерена в 2025 финансовом году потратить более $40 млрд на ИИ ЦОД в США. В DAMAC напомнили о своих достижениях — компания уже построила 45 тыс. объектов элитной недвижимости по всему миру и намерена построить ещё 45 тыс. в 20 странах. Кроме того, компания инвестирует в ЦОД в 10 странах, в частности, в Таиланде. Не исключается, что в строительство ЦОД для ИИ и гиперскейлеров будет вложено даже больше $20 млрд, «если позволят обстоятельства». Основателем DAMAC является Хусейн Саджвани (Hussain Sajwani), близкий друг Трампа. Трамп ожидает, что инвестиции поддержат создание крупных дата-центров на Среднем Западе и Юге. По словам будущего президента, первую фазу проекта реализуют в Техасе и Аризоне, Оклахоме, Луизиане, Огайо, Иллинойсе, Мичигане и Индиане. Политик добавил, что желающие инвестировать $1 млрд и более будут проходить природоохранные проверки по ускоренному сценарию, поэтому не попадут в «трясину экологических норм». Однако воздействие ЦОД на окружающую среду уже вызывает опасения. Недавно в Google заявили, что с 2019 года выбросы её ЦОД выросли на 48 %. В первую очередь это результат развития ИИ-технологий — так, ИИ-запросы в поиске требуют в 10 раз больше энергии, чем традиционные. По некоторым оценкам, мировой спрос ЦОД на энергию может удвоиться к 2026 году. Сейчас в США работают более 5 тыс. ЦОД и до 2030 года их число будет расти в среднем на 9 % в год. Регулятор NTIA сообщает, что американские ЦОД потребляли более 4 % электричества в США в 2022 году, а к 2030 году этот показатель вырастет до 9 %, причём доля ИИ ЦОД стремительно растёт. National Parks Conservation Association (NPCA) отмечает, что всё больше зелёных зон переводят в категорию индустриальных. Группы экоактивистов и даже сотрудников гиперскейлеров тоже не вполне разделяют энтузиазм строителей. Есть и ещё один нюанс. Так, Citizens Action Coalition of Indiana (CACI) подсчитали, что выделенная дата-центрам энергия обеспечила бы больше рабочих мест, если бы ей нашли применение в других отраслях. Так, по их данным на 1 МВт ЦОД создаётся 0,26 рабочих мест, а в других отраслях — на два порядка больше. Тем временем OpenAI продвигает строительство в стране сети 5-ГВт ЦОД, каждый из которых, как ожидается, позволит создать 40 тыс. рабочих мест. Кроме того, каждый такой ЦОД обеспечит вклад буквально в десятки миллиардов долларов в ВВП штатов. |

|