Материалы по тегу: cpu

|

08.02.2022 [00:30], Владимир Мироненко

Ventana, разработчик серверных процессоров RISC-V, объявил о стратегическом партнёрстве с IntelСтартап Ventana Micro Systems Inc., разработчик высокопроизводительных серверных процессоров на базе архитектуры RISC-V, объявил о стратегическом партнёрстве с Intel — ядра и чиплеты Ventana будут доступны в рамках Intel Foundry Services (IFS) для крупных клиентов ЦОД, операторов сетей 5G, потребителей в областях ИИ и машинного обучения, автомобильной индустрии и т. д. Ventana разрабатывает серверные CPU с расширяемыми возможностями, поставляемые в виде SoC с чиплетной компоновкой или IP-блоков. Процессоры предназначены для обеспечения лучшей в своём классе однопоточной производительности и могут быть оптимизированы для высокопроизводительных и облачных вычислений, ЦОД-нагрузок, 5G и периферийных вычислений, выполнения задач ИИ и машинного обучения, автомобильных и клиентских приложений.

Источник изображения: ventanamicro.com Модульная и масштабируемая продуктовая стратегия Ventana, основанная на использовании чиплетов, позволяет обеспечить быстрое коммерческое внедрение со значительной экономией времени и стоимости разработки по сравнению с преобладающими на рынке IP-моделями. Собственные ядра CPU компания намерена выпускать на TSMC по 5-нм нормам, но для остальных блоков могут использоваться сторонние производства. В рамках партнёрства с Intel ядра Ventana можно будет интегрировать в SoC конечных заказчиков. Кроме того, Ventana планирует предложить масштабируемую вычислительную платформу, которая позволит гиперскейлерам и крупным OEM-производителям гибко подбирать и настраивать функциональные блоки у заказываемых чипов, значительно сокращая время и стоимость разработки. Боб Бреннан (Bob Brennan), вице-президент Intel Foundry Services по разработке клиентских решений отметил, что у Ventana «самая совершенная и хорошо разработанная платформа» на базе Open Chiplet, которая полностью соответствует видению Intel. По его словам, чиплеты Ventana позволят IFS предоставлять модульные решения, повышающие производительность, снижающие энергопотребление и затраты на разработку, и ускоряющие время выхода продуктов на рынок.

24.01.2022 [20:09], Алексей Степин

Arm выпустила прототип платы с процессором повышенной безопасности MorelloВ современном мире процессоров уже никого не удивляет нахождение очередной уязвимости, а иногда тропинкой для злоумышленника становятся технологии, изначально призванные повысить уровень безопасности. Ряд исследователей небезосновательно считает, что «заплатками» отделаться не получится и надо менять глубинные принципы, лежащие в основе процессорных архитектур. Один из таких проектов, развиваемый с 2010 года усилиями SRI International и Кембриджского университета — это CHERI. В 2019 к нему присоединилась Arm, недавно представившая первый прототип платы с процессором Morello, который базируется на двух ключевых принципах, заложенных в CHERI — масштабируемая компартментализация и тонко настраиваемая защита содержимого памяти. Оба принципа реализованы аппаратно и сами по себе не новы.

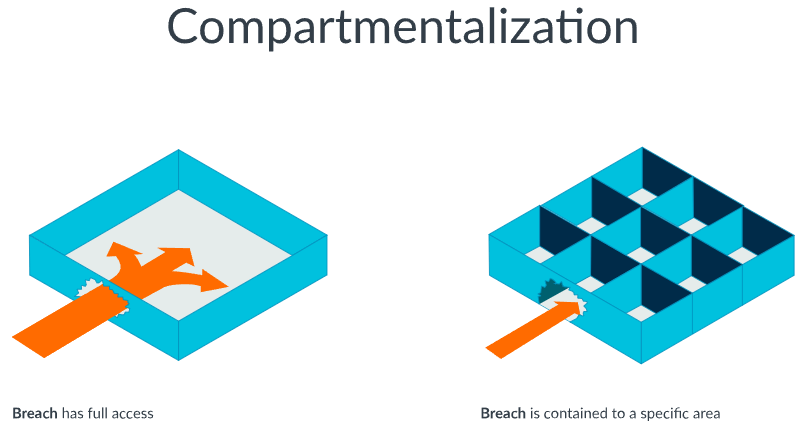

Изображения: Arm По сути речь идёт о расширении стандартного набора инструкций, с помощью которого даже написанное с использованием языков, позволяющих относительно легко сделать ошибки при работе с памятью (а это обычно C/C++), ПО можно заставить работать без образования серьёзных дыр в защите. Тщательная компартментализация (т.е. разделение) кода ОС и приложений хотя и не исключает наличие уязвимостей, но серьёзно ограничивает область возможного нанесения вреда.  В частности, любая инструкция типа load/store и любая операция выборки должны быть авторизованы на аппаратном уровне со стороны процессора. Разумеется, это не высокоуровневая защита, а скорее набор базовых блоков для построения таковой. Принцип компартментализации ещё проще: если в классической архитектуре взломщик может получить контроль над всей системой, то в изолированных друг от друга ОС и приложениях, он лишь проникнет в одну из множества небольших «ячекк», а его действия послужат сигналом для защитных механизмов.

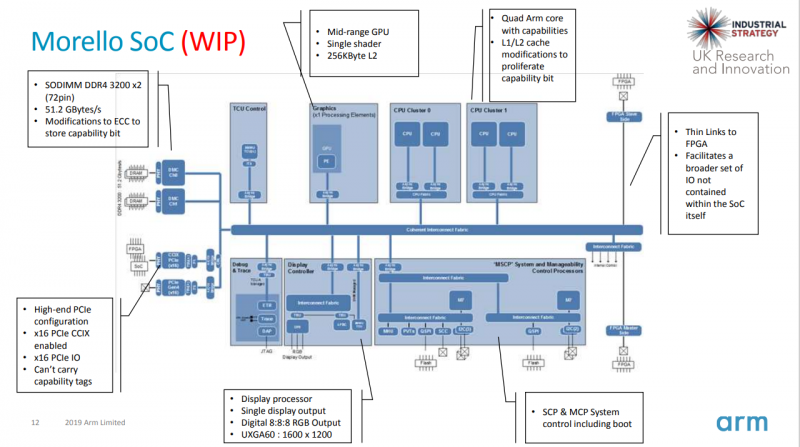

Блок-схема Arm Morello Arm Morello — первый чип на базе CHERI. Текущая аппаратная реализация использует модифицированные ядра Neoverse N1 (ARMv8.2) с частотой 2,5 ГГц. Первые платы с новым процессором предназначены таким IT-гигантам как Google и Microsoft, а также заинтересованным партнёрам образовательным учреждениям. На текущий момент разработчики предлагают модифицированное ядро FreeBSD, часть стандартных UNIX-программ, а также некоторые другие приложения. С появлением готовых плат и процессоров процесс адаптации ПО должен значительно ускориться.

07.01.2022 [00:05], Алексей Степин

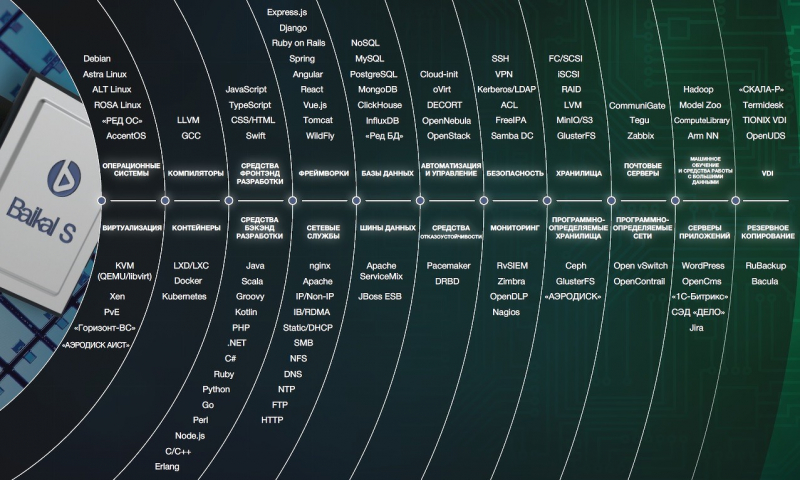

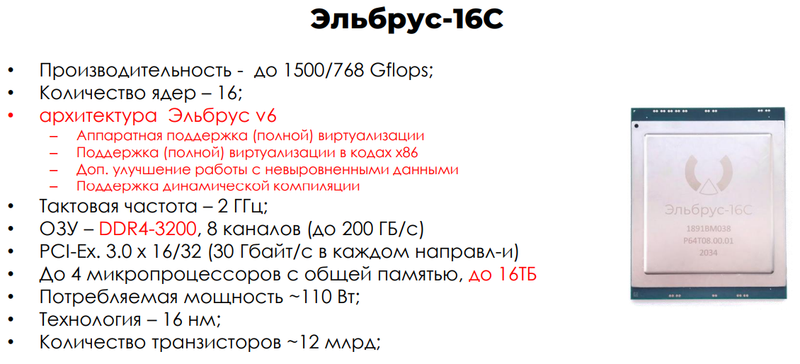

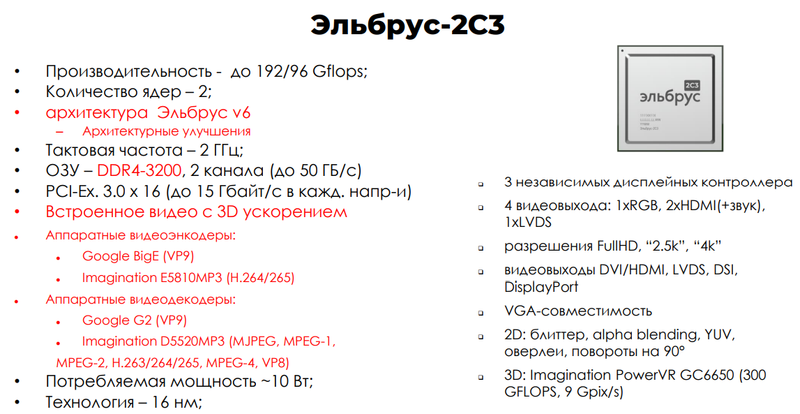

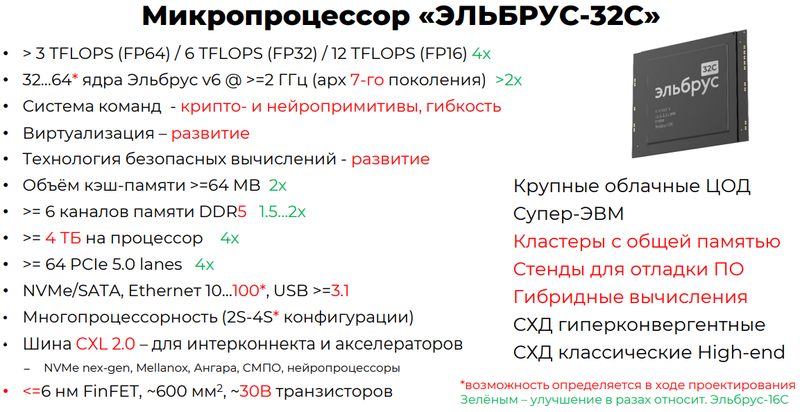

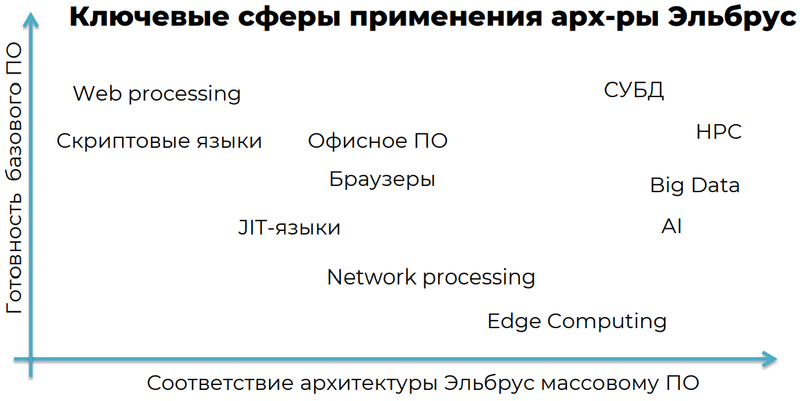

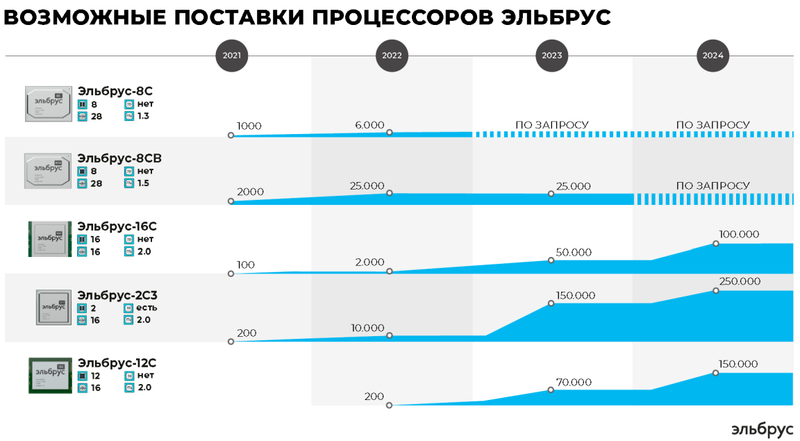

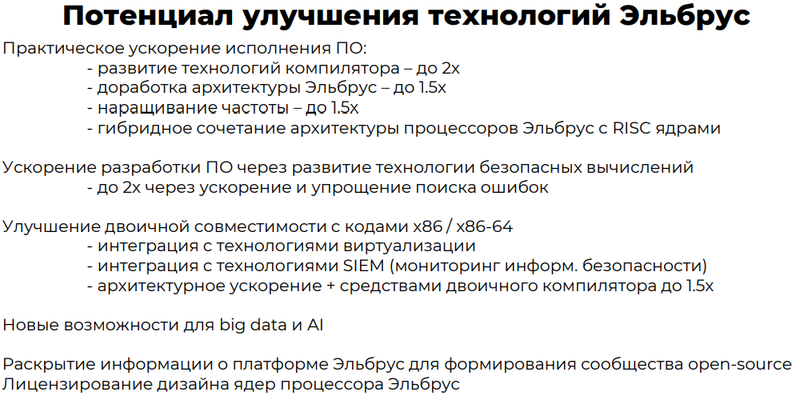

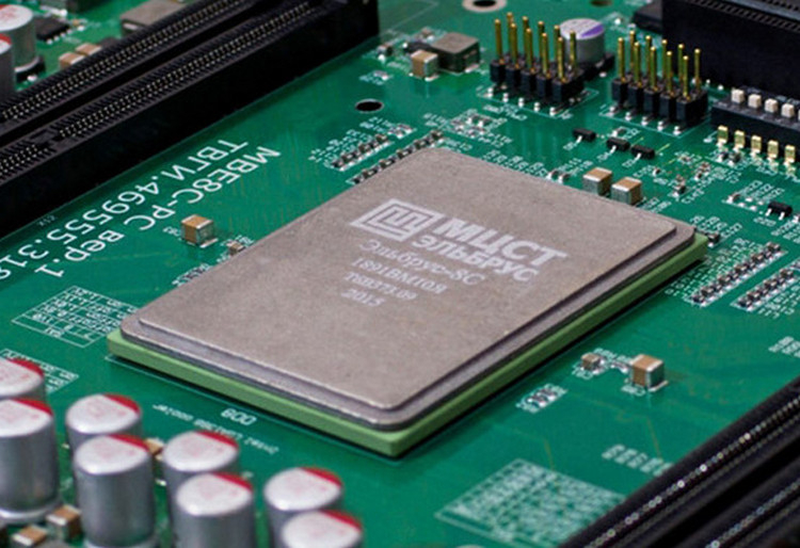

Серийное производство Эльбрус-16С и 2С3 начнётся в этом годуРоссийские процессоры Эльбрус, разрабатываемые компанией МЦСТ, вызывают немало споров вокруг самой архитектуры и доступности изделий на её основе. Но платформа продолжает жить и развиваться, несмотря на все трудности. Для всех процессоров разработан типовой ряд модулей и системных плат, от простых вариантов с одним CPU до высокоплотных четырёхсокетных. Есть решения и для обычных настольных ПК, а также модули для встраиваемых и терминальных систем. В конце прошлого года на очередной партнёрской конференции МЦСТ были опубликованы новые доклады, в том числе, освещающие изменения в ситуации с доступностью процессоров и решений на их основе. А изменений этих немало. Во-первых, окончательно устаревшими можно признать чипы Эльбрус-8. Им на смену пришла усовершенствованная версия Эльбрус-8СВ. Крупная партия этих чипов в настоящее время уже получена и находится в процессе таможенного оформления. Этот чип, напомним, лишён целого ряда недостатков, присущих Эльбрус-8С.  Однако 28-нм техпроцесс себя исчерпал, и в 2022 году на смену придут 16-нм процессоры Эльбрус-16С, Эльбрус-12С и Эльбрус-2С3. В их основу легла новая, шестая версия VLIW-архитектуры МЦСТ. Она сопровождается отказом от уже устаревшей и медленной схемотехники подсистем ввода-вывода, реализованной в предыдущем поколении Эльбрус на базе моста КПИ-2 и переходом на интегрированный контроллер PCI Express.  Старший 16-ядерный вариант получил 8-канальный контроллер DDR4-3200, что вполне отвечает требованиям современности. Планка максимального объёма оперативной памяти поднята до 16 Тбайт в четырёхпроцессорной системе (4х4 Тбайт). Благодаря новому техпроцессу удалось удержать в приличных рамках теплопакет, выросший с 80 до 110 ватт при вдвое большем количестве ядер.  Современный серверный процессор немыслим без виртуализации, и в новых решениях МЦСТ её аппаратная поддержка реализована в полном объёме, в том числе, для кода x86. Появилась поддержка динамической компиляции, дополнительно оптимизирована работа с невыровненными данными. Но главное, что образцы Эльбрус-16С и 2С3 получены и успешно прошли тесты. Подготовлена вторая ревизия, данные по ней уже переданы контрактному производителю.  Младший Эльбрус-2С3 в дополнение к интегрированному GPU получил продвинутый набор аппаратных кодеков, который включает VP9 и H.264/H.265. Процессор пойти в серию в течение этого года, а рабочие прототипы систем на его базе уже есть. 12-ядерный Эльбрус-12С наиболее интересный, как платформа для рабочих станций разработки ПО для данной архитектуры, пока ждёт второй ревизии, которая должна быть готова в течение первой половины 2022 года.  Не забывает МЦСТ и о корнях — разработке архитектур на базе SPARC. Образцы процессора R2000+ также получены и прошли инженерные тесты. Это чип, ориентированный на сверхэкономичные системы — его теплопакет составляет всего 5 Ватт, но при этом он имеет встроенное графическое ядро с функциями 3D-ускорения.  Что касается приверженности самой архитектуре VLIW, то МЦСТ продолжает настаивать на преимуществах явного параллелизма команд, осознавая, разумеется, необходимость качественного компилятора. Интерес представляет диаграмма применимости архитектуры Эльбрус: она не очень подходит для веб-задач и скриптовых языков, а лучше всего, по мнению разработчиков, раскрывает себя в задачах HPC/Big Data, СУБД и ИИ-системах.  Что касается внедрения, то серверы на базе процессоров Эльбрус активно внедряются в государственных учреждениях: ЦОД для ГИС «Мир» содержит порядка 200 серверов, а МВД России недавно закупило более 400 серверов для автоматизированной системы фиксации нарушений. РЖД внедряет тонкие клиенты на базе Эльбрус, а также использует его в системах автоматики управления стрелочным хозяйством. Силами Ростелеком создано первое облако на базе Эльбрус-8С/СВ.  Но, пожалуй, наибольшего успеха в импортозамещении добились энергетики: удалось разработать и внедрить самый широкий спектр решений на базе Эльбрус, от систем автоматики для подстанций до полноценной АСУ ТП «ПАК МАРС» для компании Россети. В последнем случае Эльбрус используется во всех компонентах, от клиентских рабочих мест до серверов и СХД.  С точки зрения программной экосреды наиболее интересна система двоичной трансляции, позволяющая запускать ПО, разработанное для х86-64, которое затем постепенно можно оптимизировать и переводить в «родной режим». Начаты работы по внедрению механизмов динамической оптимизации на базе LCC и LLVM. Также стоит отметить появление поддержки LLVM 13-ой ветки и бета-версию систем виртуализации на базе KVM + QEMU + libvirt.  МЦСТ заботится о разработчиках: первые 100 экземпляров плат на базе Эльбрус-16С и 2С3 уже разосланы партнёрам для реализации пилотных проектов. Компания готовится сертифицировать дизайн-центры и контрактные производства, а также сообщает о том, что появились первые дистрибьюторы, работающие с продукцией на базе Эльбрус.  Весьма интересны как планы МЦСТ по выпуску новых процессоров на базе VLIW-архитектуры седьмого поколения, так и данные относительно нововведений в этой архитектуре. В планах создание процессора с числом ядер до 64 и с системой команд, включающей крипто- и нейропримитивы, продвинутыми средствами виртуализации и безопасных вычислений, и, что немаловажно, поддержкой прогрессивного универсального стандарта CXL 2.0.  Запланировано использование 6-нм техпроцесса, а также выпуск чипов с меньшим количеством ядер для рабочих станций и ноутбуков. Также рассматривается возможность создания гибридного процессора, сочетающего ядра Эльбрус и RISC-V. Такой чип с учётом поддержки бинарной трансляции сможет претендовать на звание самого универсального ЦП в мире.  Ознакомиться полнее с материалами конференции можно на сайте МЦСТ. В целом, архитектура Эльбрус выглядит живой и развивающейся, решения на базе уже освоенных 8-ядерных процессоров активно внедряются в России, а более новые 12 и 16-ядерные CPU гораздо лучше соответствуют современным требованиям. Что касается Эльбрус-32С, то это амбициозный проект, в котором сочетаются как новейшие технологии (DDR5 и CXL 2.0), так и уникальные архитектурные особенности.

17.12.2021 [01:35], Алексей Степин

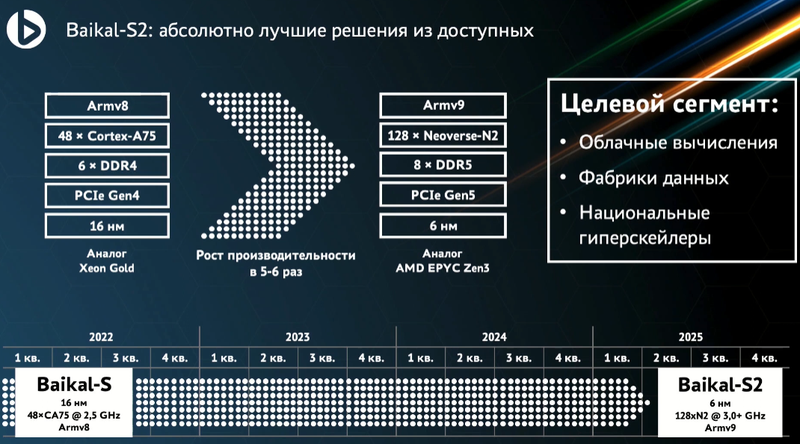

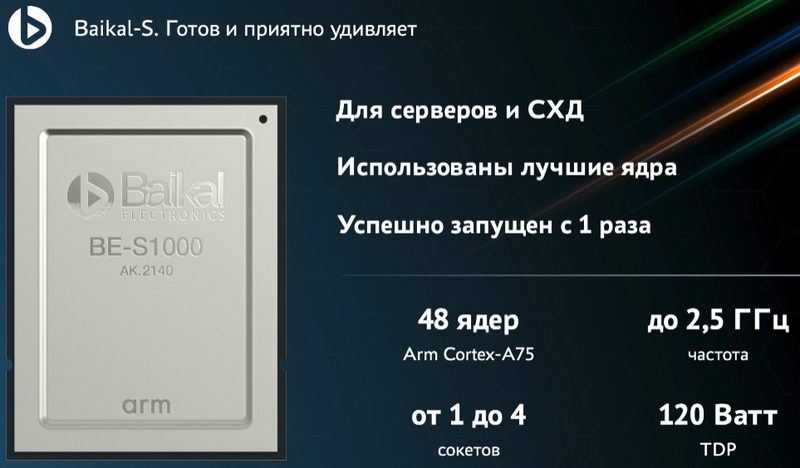

Российский серверный процессор Baikal-S2 получит чиплетную компоновку, 128 ядер Armv9 с частотой 3 ГГц, 8 каналов DDR5, 192 линии PCIe 5.0 и CXL 2.0На ежегодной итоговой конференции Байкал Электроникс состоялся анонс 128-ядерных серверных Arm-процессоров второго поколения Baikal-S2, были показаны результаты тестов 48-ядерных Baikal-S, анонсированы первые же российские серверы и СХД на их основе, а также было объявлено о заключении стратегических сделок и планах на будущее. Если говорить о сделках, то можно смело сказать, что рамками только Arm Байкал себя уже не ограничивает: получение доли в CloudBEAR означает и получение основы для разработки собственных чипов с архитектурой RISC-V, и первым же проектом станет создание сертифицированной системы доверенной загрузки для процессоров Baikal-L и Baikal-S2. Но среди равноправных партнёров значатся не только российские разработчики — заключена сделка с Esperanto Technologies.

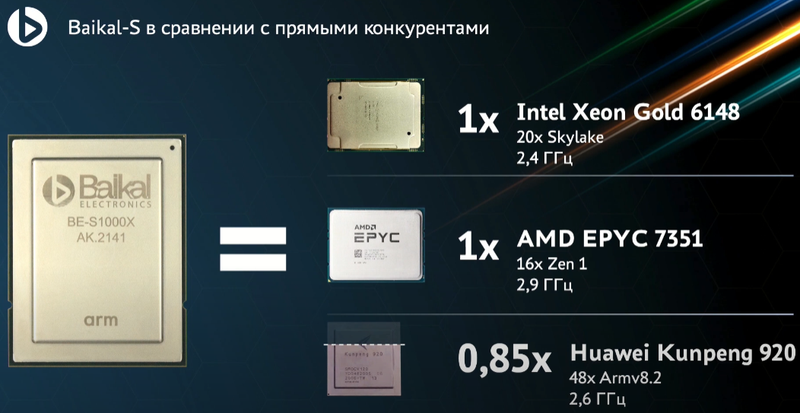

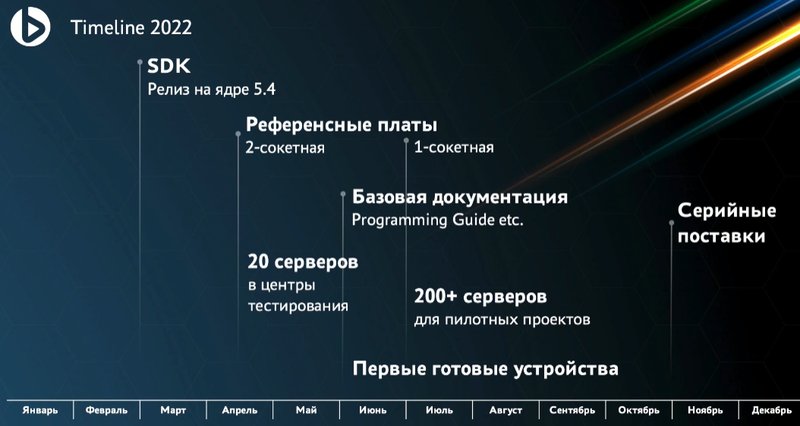

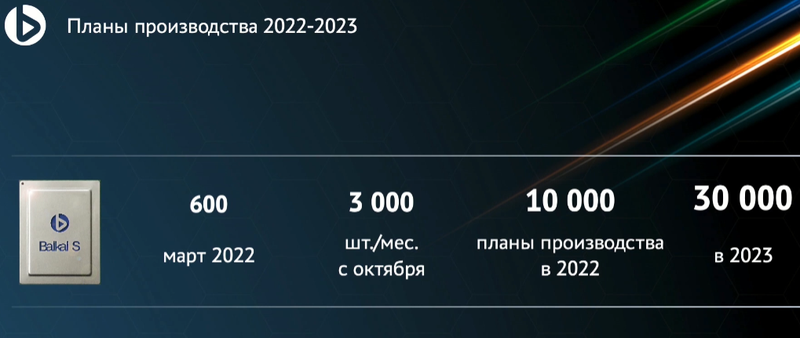

Тестовая плата с процессором Baikal-S (Изображения: Байкал Электроникс) Данная сделка позволит получить доступ к весьма серьёзным разработкам: напомним, Esperanto создала ET-SoC-1, мощнейший ИИ-ускоритель с более чем тысячью ядер RISC-V в составе. Связка из четырёх таких чипов развивает более 800 Топс в задачах инференса, потребляя всего 120 Вт. Надо ли говорить, насколько это важно в эпоху нейросетей, машинного обучения и разнообразных сопроцессоров-ускорителей.  Несмотря на то, что Baikal-S «старичком» назвать никак нельзя, компания анонсировала уже второе поколение чипов — Baikal-S2 базируется на новейшей архитектуре Neoverse-N2 (ARMv9). Процессор будет выполнен по 6-нм техпроцессу с использованием чиплетной компоновки и получит 128 ядер с частотой порядка 3 ГГц, 8 каналов DDR5 (возможно, будет и больше), 192 линии PCIe 5.0, поддержку CXL 2.0 и CCIX 2.0. Ожидается, что он станет аналогом AMD EPYC Milan. Разработку планируется закончить к 2025 году.  Что касается текущего поколения Baikal-S, то осенью этого года была получена первая партия чипов, а также было анонсировано несколько решений на его основе. Как теперь отрапортовали разработчики, первые чипы оказались очень удачными во всех отношениях, так что больших препятствий на пути их внедрения быть не должно. На конференции были представлены одно- и двухсокетные серверы и СХД от российских компаний 3Logic, Aquarius, ICL, iRU, Норси-Транс. Впоследствии появятся и четырёхпроцессорные системы.  Напомним, что Baikal-S содержит в своём составе 48 ядер Arm Cortex-A75 с частотой до 2,5 ГГц и имеет TDP 120 Вт. Шестиканальный контроллер памяти поддерживает до 768 Гбайт DDR4-3200. Современно выглядит и поддержка PCI Express 4.0 (80 линий), и наличие выделенного управляющего ядра для организации доверенных вычислений, и аппаратная виртуализация.  В синтетических тестах новинка показала результаты, сравнимые с Intel Xeon Gold 6148 или AMD EPYC 7351, а своему китайскому «коллеге» в лице HiSilicon Kunpeng 920 процессор уступил лишь в некоторых тестах. Разработчики уверены, что процессор получился универсальным и его можно использовать практически везде: в серверах любых профилей, СХД, суперкомпьютерах, устройствах сетевой безопасности и даже в базовых станциях 5G. Результаты тестов также доступны и на сайте Geekbench.  Ожидается, что SDK для новой платформы будет доступен уже в конце февраля следующего года. Весной появятся двухпроцессорные платы и первые 20 серверов попадут в центры тестирования, а к середине лета 200 с лишним серверов примут своё участие в пилотных проектах. Старт серийного производства CPU намечен на октябрь-ноябрь 2022 года — речь идёт примерно о 10 тыс. процессоров. В 2023 году этот объём будет утроен и при необходимости увеличен.  Таким образом, Байкал Электроникс доказала, что может создавать достойные серверные решения, не уступающие зарубежным, причём, как на базе x86-64, так и на базе Arm. Уже сейчас процессоры Baikal-S могут стать основой для производительных серверов российской разработки, а сделка с Esperanto сделает российские HPC-системы и комплексы машинного обучения по-настоящему мощными.

14.12.2021 [19:41], Алексей Степин

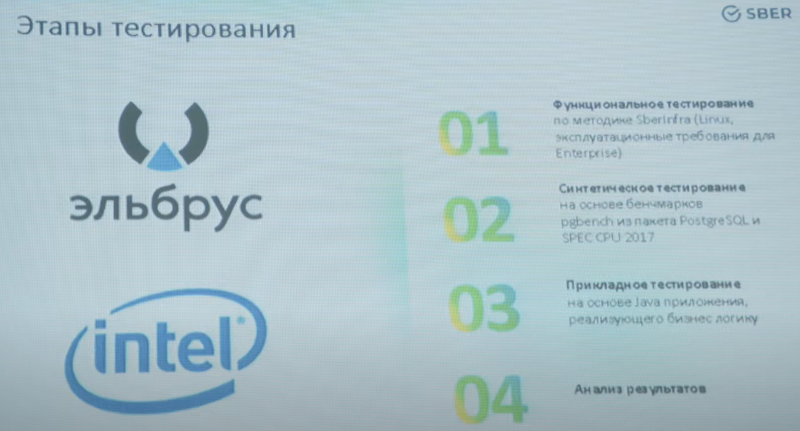

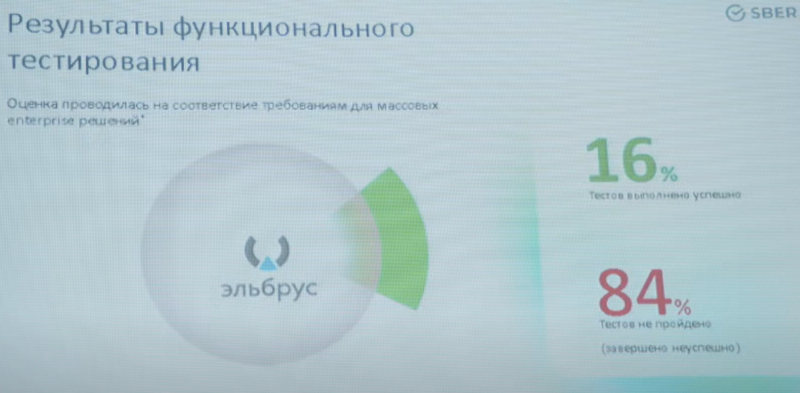

Серверы на базе «Эльбрус» не прошли тесты Сбербанка, но не всё потеряноВ рамках программы импортозамещения СберТех провёл тестирование серверов на базе процессоров Эльбрус-8С. По результатам системы признаны работоспособными, но не отвечающими предъявляемым требованиям по целому ряду параметров. Все пожелания и замечания переданы МЦСТ, разработчику Эльбрус. Банковские информационные системы — критически важная часть любого государства. Поэтому неудивительно стремление использовать в них решения собственной разработки, дабы меньше зависеть от чужих чипов и серверов. Примеры Huawei это подтверждают, но в данной заметке речь пойдёт не о китайских процессорах, а о российских. Лаборатория СберТех провела полноценное тестирование серверов на базе процессоров Эльбрус-8С, результаты которого, к сожалению, трудно назвать удовлетворительными.

Фото: МЦСТ Это первое полномасштабное испытание процессоров Эльбрус в «полевых условиях», то есть, на уровне реальных серверов и задач, которые эти серверы должны выполнять. В испытаниях приняли участие платформы с двумя и четырьмя чипами Эльбрус-8С (VLIW, 8C/8T, 1,3 ГГц, 16 Мбайт L3-кеш, 70 Вт TDP, 28 нм). В качестве оппонентов выступили «типичные системы» на базе Intel Xeon Gold 6230 (x86-64, Cascade Lake-SP, 20C/40T, 2,1-3,9 ГГц, 27,5 Мбайт кеш, 125 Ватт TDP, 14 нм), которых в Сбере тысячи и тысячи.

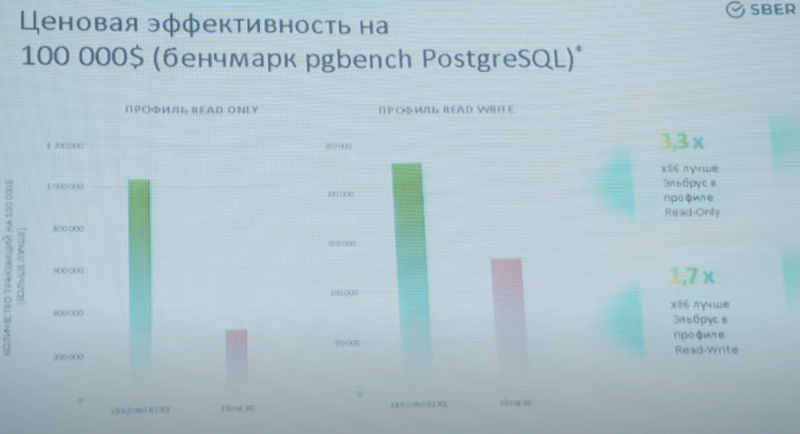

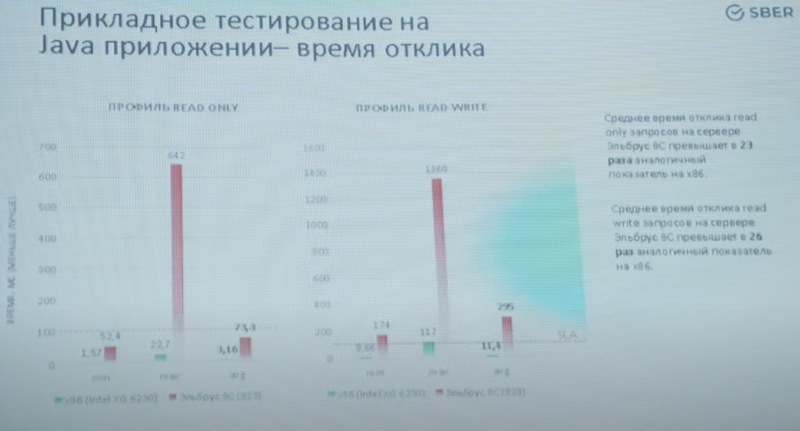

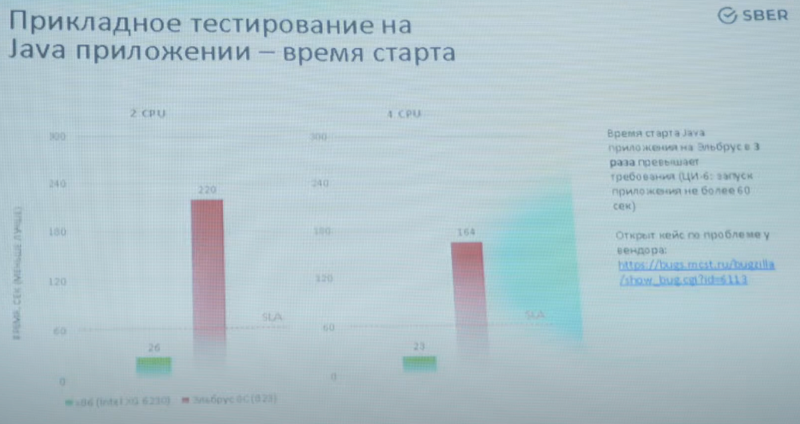

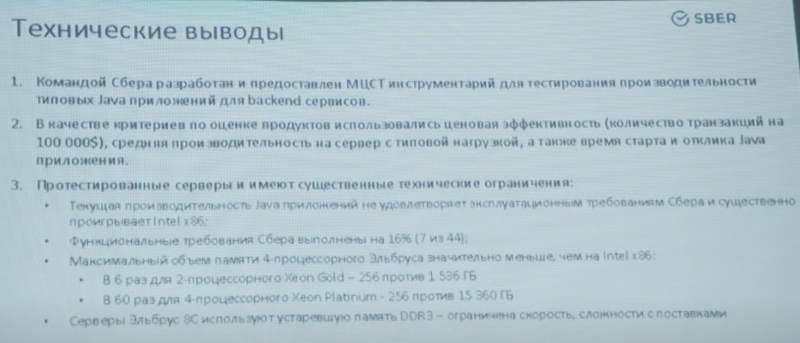

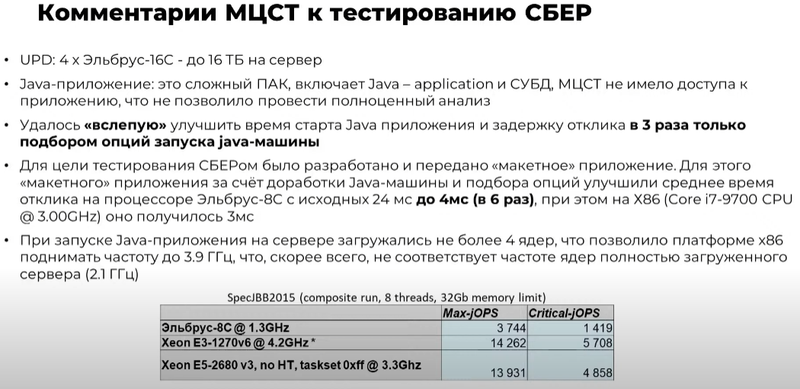

Изображения: YouTube/ElbrusTV По итогам тестирования серверы признаны работоспособными, но показавшими неудовлетворительный уровень производительности. Озвучены основные выводы: «мало памяти, медленная и устаревшая память, мало ядер, низкая тактовая частота». Особенно низкой оказалась производительность в приложениях, использующих Java.  Если в тестах PGbench/PostreSQL Xeon опередил Эльбрус в 1,7-3,3 раза, то в тестах на время отклика Java-приложения разница составила 23-26 раз. Запуск приложения, который по нормативам СберТеха должен укладываться в 60 секунд, занял у серверов Эльбрус 220 секунд в двухпроцессорном варианте и 164 секунды — в четырёхпроцессорном.  Кроме того, в рамках стандартных спецификаций компании системы на базе Эльбрус-8С смогли пройти всего по 7 параметрам из 44 предъявляемых. Если отсутствие монтажных стоечных рельсов можно отнести к «мелким претензиям», которые легко решаются, то отсутствие системы удалённого управления — недоработка весьма серьёзная, поскольку затраты на увеличение штата ИТ-специалистов окажутся непомерно велики.  Стоит, однако, отметить, что Эльбрус-8С уже устарел в рамках собственной экосистемы: МЦСТ обещает представить на тестирование усовершенствованные варианты серверов на базе Эльбрус-8СВ с более высокой частотой (1,5 против 1,3 ГГц), удвоенной производительностью в операциях над числами с плавающей запятой, а также использующие память DDR4-2400 (до 1 Тбайт на сервер) вместо окончательно устаревшей DDR3-1600. Однако массовые поставки таких серверов при заказе 1-5 тыс. единиц возможны не ранее IV квартала 2022 года при заказе в III квартале 2021 года.  Признана необходимость проведения тестов систем на базе Эльбрус под управлением ОС, сертифицированных ФСТЭК по профилю не ниже ОС.А4 (использование для обработки персональных данных и ГИС). Также отмечена необходимость введения полноценной поддержки технологий виртуализации, а не только контейнеризации.  Отметим также, что МЦСТ успешно завершила разработку Эльбрус-16С, в котором ряд фундаментальных недостатков, присущих процессорам Эльбрус-8С/8СВ успешно устранён. Новый чип будет иметь 16 ядер с возросшей до 2 ГГц частотой, восьмиканальный контроллер памяти DDR4-3200 (до 16 Тбайт на сервер), контроллер 10GbE и интегрированный контроллер PCIe 3.0 (32 линии). Последний снимает серьёзные ограничения по пропускной способности чипов Эльбрус-8C/CB к периферийным устройствам. Также с 8 до 48 Гбайт/с возрастёт скорость межпроцессорного обмена данными.  Представитель МЦСТ отметил, что низкие результаты в Java-тестах отчасти обусловлены «слепым тестированием», в котором разработчикам не были предоставлены данные, необходимые для полноценной оптимизации Java-машины. Простым подбором опций МЦСТ удалось улучшить показатели в три раза, а «макет» оптимизированного приложения СберТеха позволил сократить время отклика с 24 до 4 мс, что практически равнозначно показателям систем на базе процессоров Intel (Core i7-9700, 3 мс).

04.12.2021 [03:42], Игорь Осколков

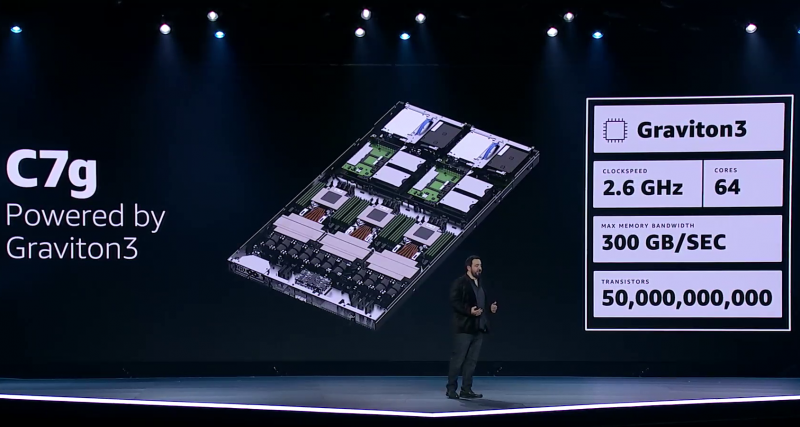

Процессор Amazon Graviton3: 64 ядра Arm, 5-нм техпроцесс, чиплетная компоновка и DDR5 с PCIe 5.0Анонсированный на днях Arm-процессор Graviton3, создававшийся специально для нужд Amazon и AWS, неожиданно оказался по ряду параметров на голову выше ещё даже не вышедших EPYC и Xeon следующего поколения. И это не самый хороший сигнал для AMD, Intel, Qualcomm и прочих производителей.

Amazon Graviton3. Фото: Ian Colle Graviton3 — первый массовый (самой Amazon и рядом избранных клиентов он используется уже не один месяц) серверный процессор с поддержкой DDR5 и PCIe 5.0. CPU выполнен по 5-нм техпроцессу TSMC и содержит примерно 55 млрд транзисторов. Для удешевления он использует BGA-корпусировку и чиплетную компоновку из семи отдельных кристаллов — два PCIe-контроллера и четыре двухканальных контроллера DDR5 вынесены за пределы собственно CPU.

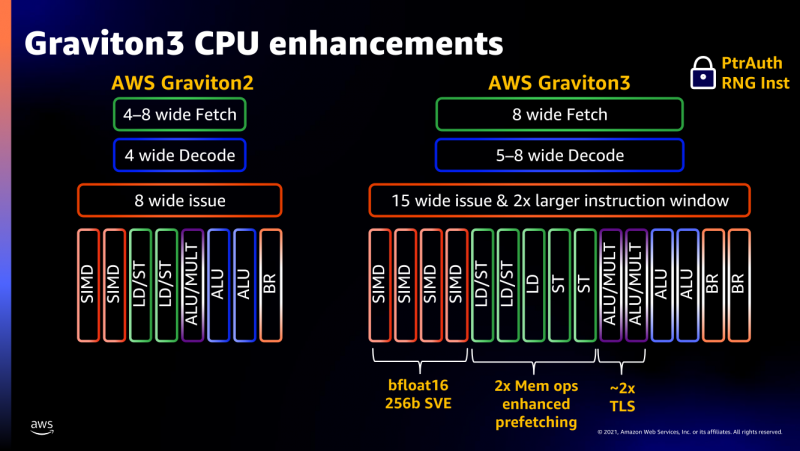

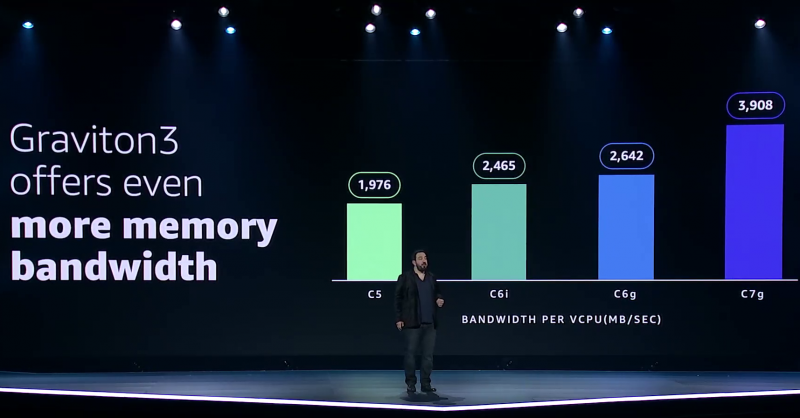

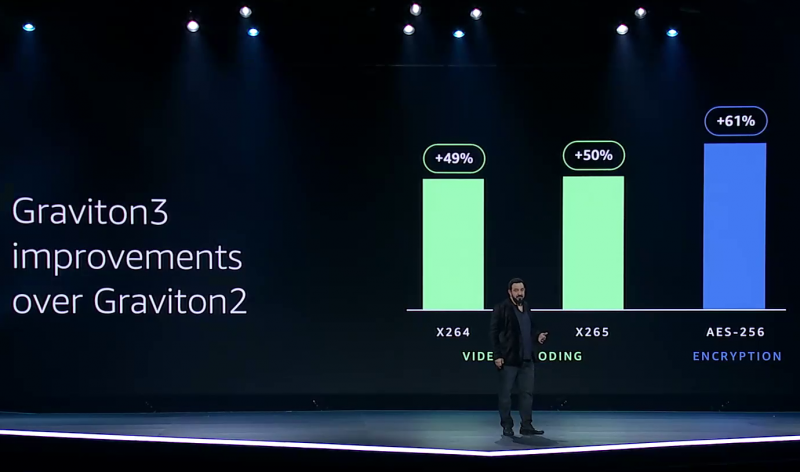

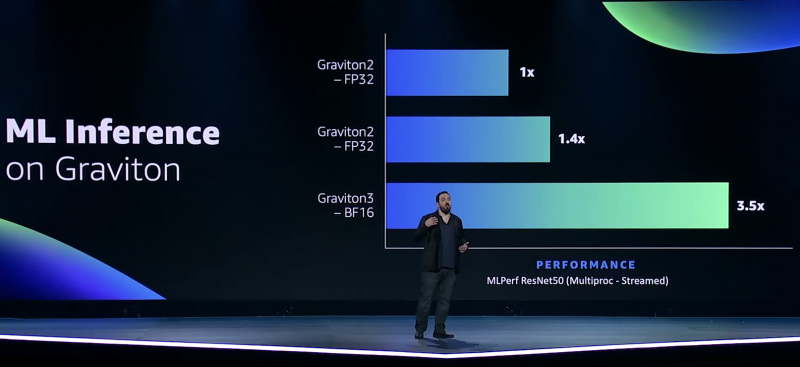

Узел EC2 C7g. Здесь и ниже изображения Amazon AWS Более того, их упаковка использует передовые решения с каналами длиной менее 55 мкм, что вдвое меньше, чем у других серверных CPU. Уменьшение длины проводников положительно сказывается на энергоэффективности, которая очень важна для любого гиперскейлера. Этим же объясняется и относительно небольшое по современным меркам число ядер (всего 64) и их частота (2,6 ГГц). Всё это позволило добиться энергопотребления примерно в 100 Вт.  Есть и ещё один важный плюс в сохранении числа ядер — переход на DDR5-4800 позволил не только достичь пиковой суммарной пропускной способности памяти в 300 Гбайт/с на чип, но и повысить реальную скорость работы с памятью каждого vCPU (фактически ядра) в полтора раза по сравнению с прошлым поколением. Та же ситуация и с PCIe 5.0 — для достижения той же пропускной способности, что ранее, нужно вдвое меньше линий.  Для удешевления используются готовые IP-блоки сторонних компаний и, судя по всему, ядра тоже несильно отличаются от референсов Arm. А вот какие именно, узнаем не сразу, поскольку Amazon явно не указала, будут ли это Neoverse V1 (Zeus) или N2 (Perseus). Вероятно, это всё же V1 (ARMv8.5-A), поскольку по описанию Graviton3 похожи именно на эту архитектуру. Новые ядра стали значительно «шире» прежних — они забирают 8 инструкций, декодируют от 5 до 8 из них и отправляют на исполнение сразу 15 инструкций. Соответственно и число исполнительных блоков по сравнению с Neoverse-N1 (Graviton2) практически удвоилось.  Кроме того, они обзавелись поддержкой 256-бит векторных инструкций SVE, что повысило не только скорость выполнения «классических» FP-операций (например, для задач медиакодирования и шифрования), но и благодаря поддержке bfloat16 позволило утверждать Amazon, что новые чипы годятся и для инференса. Среди упомянутых ранее мер защиты есть, например, принудительное шифрование оперативной памяти, изолированные кеши для каждого vCPU (ядра), аппаратная защита стека.

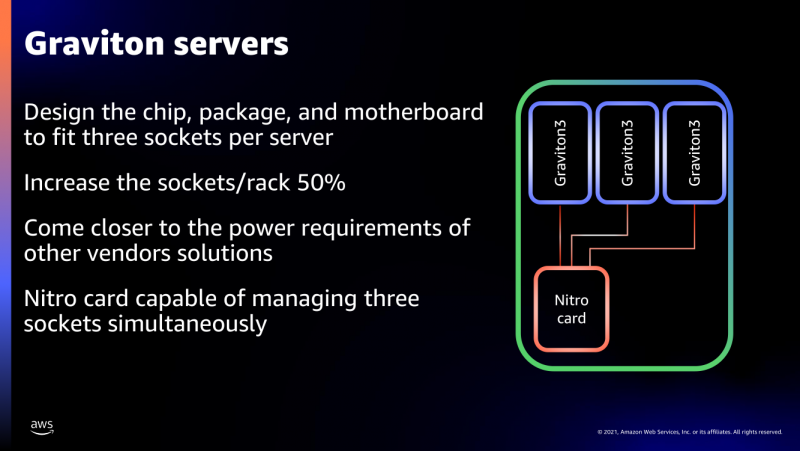

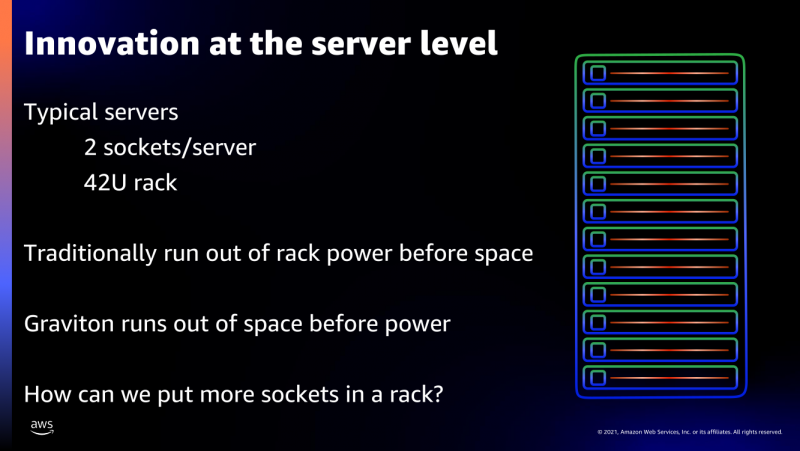

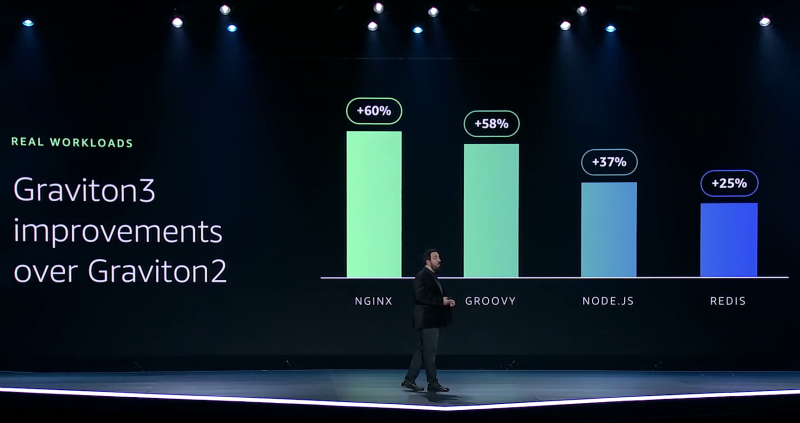

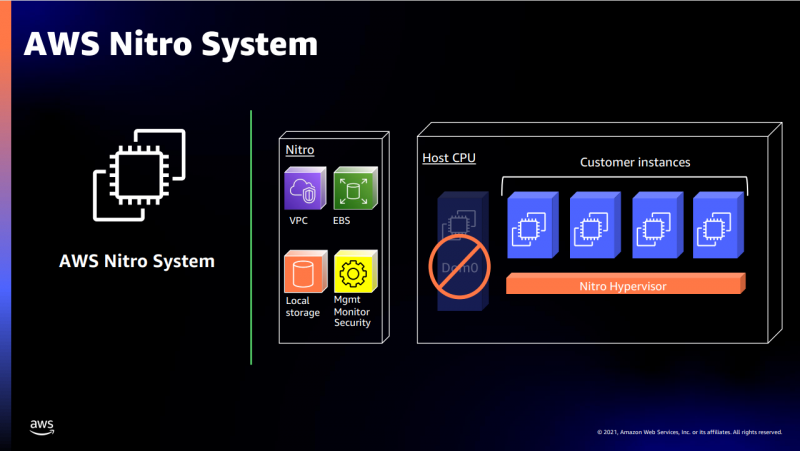

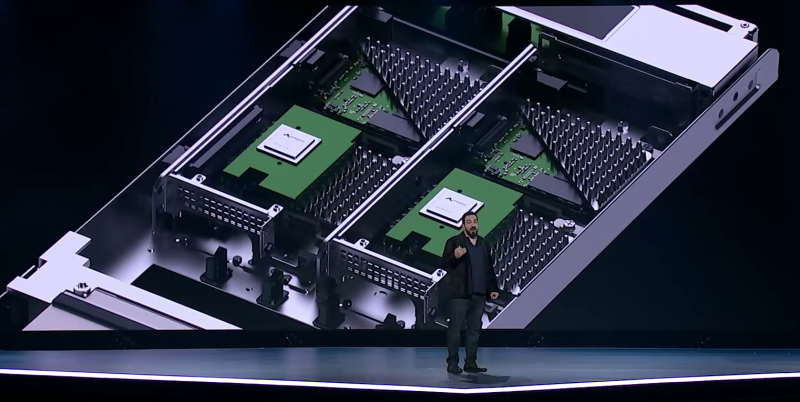

В подписи второго столбца явная опечатка В целом, средний прирост производительности Graviton3 по сравнению с Graviton2 составил 25 %, но в некоторых задачах он достигает 60 %. И всё это при сохранении того же уровня энергопотребления и тепловыделения. Всё это позволило уместить в одном 1U-узле с воздушным охлаждением сразу три процессора Graviton3. И они разительно отличаются от грядущих 128-ядерных процессоров Altra Max и EPYC Bergamo, которые Ampere и AMD позиционируют как решения для гиперскейлеров. Зато в чём-то похожи на Yitian 710 от Alibaba Cloud.  Но CPU — это лишь часть платформы, фундамент для которой несколько лет назад заложило появление чипов Nitro. Их сейчас стоило бы назвать DPU/IPU, хотя на момент их появления такого понятия, можно сказать, и не было. Nitro берёт на себя все задачи по обслуживанию гипервизора, обеспечению безопасности, работе с хранилищем и сетью и т.д., высвобождая, с одной стороны, все ресурсы CPU, памяти и SSD для обработки задачи клиента, а с другой — позволяя практически полностью дезагрегировать всю инфраструктуру.

Узел с Nitro SSD Впрочем, Amazon пошла ещё дальше — теперь она самостоятельно закупает NAND-чипы и производит SSD, тоже под управлением Nitro. То есть у компании под контролем практически полный стек современных аппаратных решений: CPU, DPU, SSD, ИИ-ускорители для обучения (Trainium) и инференса (Inferentia). Она активно переносит на него собственные сервисы и предлагает их клиентам. И именно это и должно обеспокоить крупных вендоров, поскольку их решения вряд ли позволят добиться такого же уровня TCO, а гиперскейлеров, желающих перейти на аналогичную модель, немало. UPD 06.12.21: презентация новых процессоров стала доступна публично, поэтому в материал добавлены некоторые иллюстрации, а в галерее ниже приведены результаты тестов производительности.

08.11.2021 [20:00], Игорь Осколков

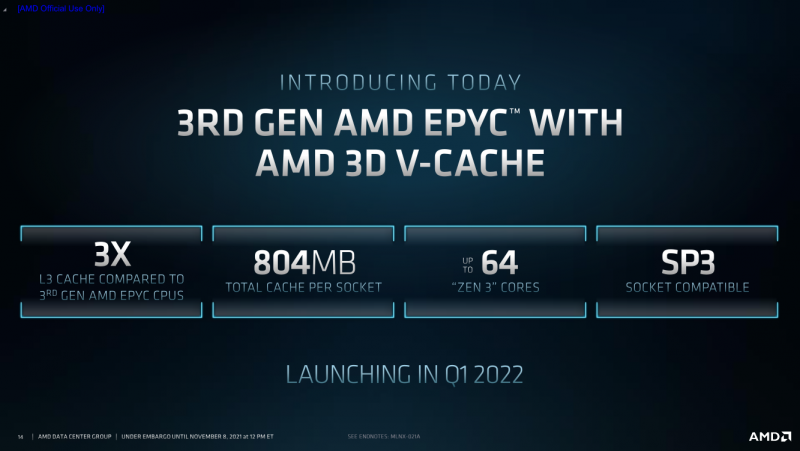

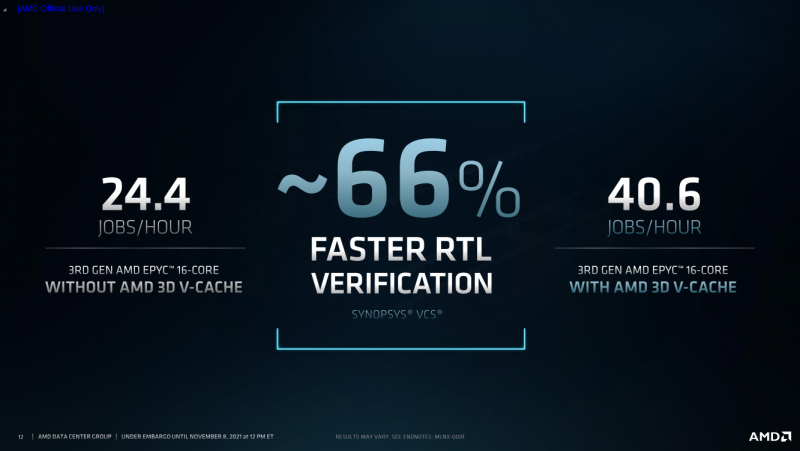

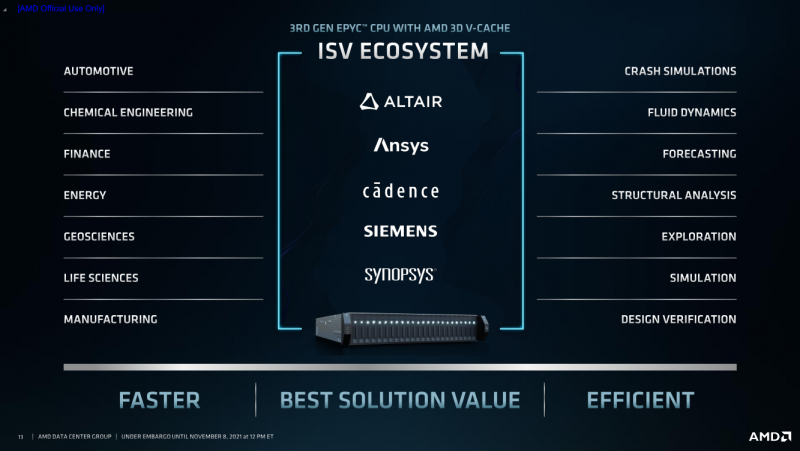

AMD анонсировала процессоры EPYC Milan-X с 3D V-Cache: 804 Мбайт кеша и 64 ядра Zen3AMD анонсировала серию своих серверных процессоров под кодовым названием Milan-X. Новинки являются развитием EPYC 7003 (Milan), представленных весной этого года, и рассчитаны в первую очередь на высокопроизводительные вычисления (HPC). Главным же отличием от «обычных» Milan станет резко увеличенный объём кеш-памяти, что позволило AMD снова назвать свои процессоры самими быстрыми в мире.

AMD EPYC Milan-X с 3D V-Cache (Здесь и ниже изобржаения AMD) Откуда берётся цифра в 804 Мбайт? Математика простая. На каждое ядро Zen3 приходится по 32 Кбайт L1-кеша для инструкций и данных + 512 Кбайт L2-кеша. На восемь ядер в CCX-комплексе приходится 32 Мбайт общего L3-кеша. И вот к ним добавляются ещё 64 Мбайт 3D V-Cache — в максимальной конфигурации на 8 CCX получается суммарно 768 Мбайт 3D V-Cache в дополнение к иерархии нижележащих кешей. Таким образом, конкретно по этому показателю побит рекорд IBM z15, хотя данный CPU ориентирован на совсем другие задачи. А вот среди x86-64 равных Milan-X сейчас нет. Более того, по словам AMD, реализация 3D V-Cache на текущий момент является уникальной в индустрии. Дополнительный кеш имеет непосредственно подключение к CCX по медным каналами, что позволяет значительно повысить плотность упаковки и энергоэффективность, снизить задержки и улучшить температурный режим. Правда, детальные характеристики V-Cache пока не приводятся.  Что важно, новинки будут совместимы с имеющимися SP3-платформами для Milan, что упростит тестирование и валидацию — для них будет выпущено обновление BIOS. Увы, пока данные по частотам, TDP и цене компания не приводит — выпуск Milan-X запланирован на I квартал 2022 года. Но в сносках к презентации, в частности, упоминаются не только 64-ядерные Milan-X, но и 16-ядерные. Надо полагать, что такие «бутерброды» будут дороже обычных CCX, поскольку здесь цена брака будет выше. Также заявлена совместимость с имеющимся ПО, но и с разработчиками уже ведётся активная работа по дополнительной оптимизации их решений. Наибольшую выгоду от увеличенного кеша получат нагрузки, для которых критична скорость работы с памятью и задержки доступа. Среди таковых AMD упоминает метод конечных элементов, структурный анализ, вычислительную гидродинамику и автоматизированные системы проектирования электроники (EDA). Для последних на примере Synopsys VCS рост производительности составил 66%.

26.10.2021 [22:45], Игорь Осколков

Получена первая партия российских серверных Arm-процессоров Baikal-S: 48 ядер, 6 каналов DDR4-3200 и 80 линий PCIe 4.0Компания «Байкал Электроникс» сообщила о получении первой партии инженерных образцов серверных Arm-процессоров Baikal-S объёмом 400 шт. Следующую партию компания ожидает получить в первом квартале следующего года, а первые массовые поставки (партия более 10 тыс. шт.) должны начаться до конца третьего квартала. Инженерные платы для разработчиков, созданы «Гаоди рус» (Dannie Group) и выпущены компанией «Рутек». Baikal-S, изготавливаемый по 16-нм техпроцессу на TSMC, имеет 48 ядер Arm Cortex-A75 на базе достаточно свежей 64-бит архитектуры ARMv8.2-A, которая была анонсирована в 2017 году. Частота составляет до 2,2 ГГц, а уровень TDP равен 120 Вт. Заявленный диапазон рабочих температур простирается от 0 до +70 °C. Производительность в HPL составляет 385 Гфлопс, а рейтинг в SPEC CPU2006 INT — до 600. Ориентировочная цена одного процессора ожидается на уровне $3 тыс.  L1-кеш имеет объём по 64 Кбайт для данных и инструкций, а L2 — 512 Кбайт на ядро. Любопытно, что в дополнение к L3-кешу (по 2 Мбайт на кластер) есть ещё и L4-кеш на 32 Мбайт. Контроллер памяти имеет шесть каналов DDR4-3200 ECC и обслуживает до 128 Гбайт на канал (суммарно 768 Гбайт на сокет). Кроме того, каждый процессор имеет 80 линий PCIe 4.0, из которых 48 линий делятся тремя интерфейсами CCIX x16. Также есть пара 1GbE-интерфейсов. При этом новинка поддерживает аппаратную виртуализацию, Arm TrustZone и позволяет создавать четырёхсокетные платформы. Всё это делает её привлекательным решением не только для традиционных серверов и СХД, но и для и HCI- и HPC-систем. С экосистемой ПО проблемы вряд ли будут. Во-первых, для «малого» Байкал-М уже сейчас есть отечественные ОС и другие продукты. Во-вторых, серверные платформы Arm в мире развивают сразу несколько игроков, да и сама Arm стимулирует процесс разработки и портирования ПО. Кроме того, «Байкал Электроникс» имеет тесные связи с ГК Astra Linux.

19.10.2021 [19:39], Алексей Степин

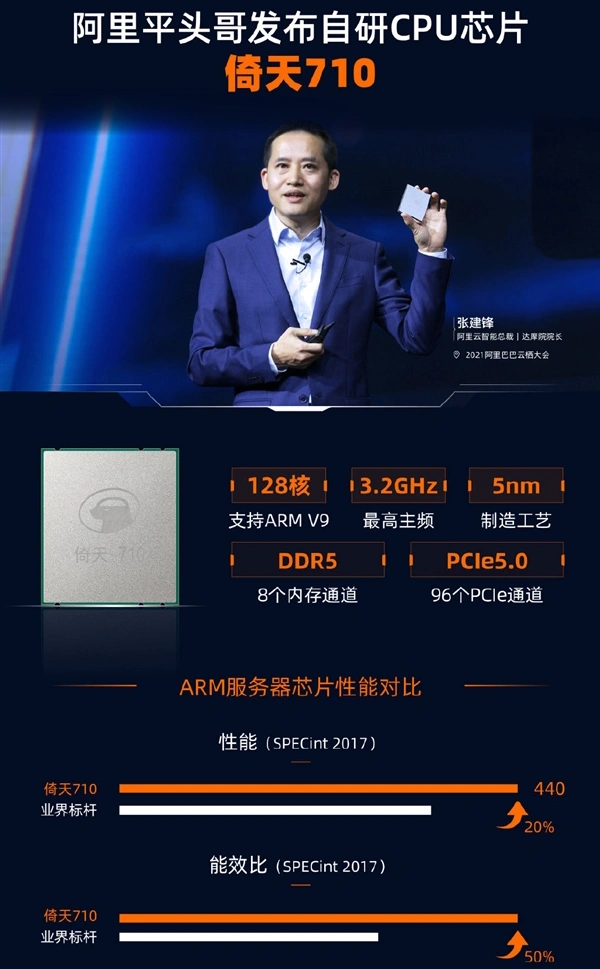

Alibaba Cloud представила серверный 128-ядерный Armv9-процессор Yitian 710Эпоха неоспоримого господства x86-64 в серверах, похоже, постепенно всё же подходит к концу. Ampere, AWS, Fujitsu, HiSilicon, Phytium и другие производители Arm-процессоров дают бой x86-64 и выигрывает его, пусть и не во всех областях. Эффективность серверных Arm-решений уже неоспорима, количество ядер уже перевалило за сотню, а теперь ещё один крупный провайдер облачных услуг, китайская компания Alibaba Cloud, анонсировала свой вариант высокопроизводительного CPU на базе Arm. Первые попытки Arm проникнуть на рынок серверов или рабочих станций были робкими и неуверенными, но за последние несколько лет ситуация сильно изменилась: уверенно показывают себя такие интересные чипы, как Ampere Altra, недавно доросшие уже до 128 ядер, Amazon активно предлагает инстансы на базе Graviton2, а Huawei даже открывает первый в России ЦОД на базе своих чипов Kunpeng 920.  Более того, мощные многоядерные Arm-процессоры обрастают собственной инфраструктурой: появляются собственные процессорные разъёмы, системные платы, не уступающие x86-моделям, и даже варианты в виде рабочих станций для разработчиков программного обеспечения, без которого любая платформа мертва. Тем интереснее выглядит анонс Alibaba Cloud. Компания сообщила о выпуске нового процессора, который послужит основой для её облачных. И по ряду характеристик можно видеть, что это весьма передовые решения. Новинка носит название Yitian 710, она имеет собственный процессорный сокет и инфраструктуру сопутствующей «обвязки» (есть и референс-дизайн сервера, Panjiu). Впрочем, интереснее то, что эти процессоры — как и Altra Max — могут иметь до 128 ядер.  Но если текущее поколение Ampere Altra базируется на наборе инструкций Armv8.2 с некоторыми заимствованиями из v8.3 и v8.4, то китайский гигант использует более новый вариант, Armv9. Эта версия архитектуры была анонсирована только весной этого года, она, как минимум, на треть быстрее v8, поддерживает аппаратную ускорение работы контейнеров и виртуальных машин, а также наделена востребованными нынче векторными инструкциями со средствами ускорения машинного обучения (SVE2). 5-нм процессоры Yitian 710 поставляются с июля этого года. Они содержат примерно 60 млрд транзисторов и могут иметь тактовую частоту до 3,2 ГГц, а также включают 128 Мбайт L3-кеша, восьмиканальный контроллер DDR5-4400 и 96 линий PCIe 5.0. TDP равен 250 Вт. Так что это один из самых передовых на сегодня серверных процессоров не только в плане чистой производительности. Сама Alibaba называет свое детище универсальным, одинаково хорошо подходящим для нагрузок общего назначения, развёртывания СХД и ИИ-нагрузок, но, разумеется, приоритет отдаётся задачам, характерным для облачных сред.

Alibaba Cloud: Yitian 710 превосходит всех ARM-соперников и в своём классе является лучшим Ввиду санкционных трений решение Alibaba Cloud разработать собственный мощный процессор выглядит вполне обоснованно, как и принятое ранее решение о создании собственной ИИ-платформы Hanguang 800. И это не единственные разработки Alibaba Cloud. Компания собирается сделать открытым дизайн не только четырёх чипов XuanTie (RISC-V), но и некоторых будущих ядер. Открыт будет и сопутствующий набор ПО, так что Alibaba Cloud всерьёз намеревается вырастить вокруг своего «кремния» развитую инфраструктуру аппаратного и программного обеспечения.

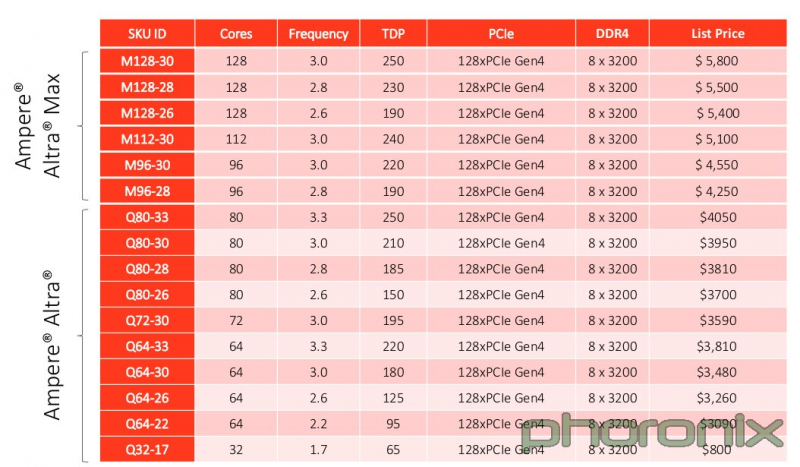

30.09.2021 [16:15], Сергей Карасёв

128-ядерный Arm-процессор Ampere Altra Max оказался на треть дешевле флагманских Xeon и EPYCРесурс Phoronix раскрыл стоимость многоядерных процессоров Ampere Altra Max, предназначенных для использования в высокопроизводительных серверах. Наблюдатели отмечают, что эти изделия, насчитывающие до 128 вычислительных ядер, предлагаются по цене ниже флагманских серверных чипов Intel Xeon и AMD EPYC. Arm-процессоры Ampere Altra Max M128-30 с частотой 3,0 ГГц изготавливаются по 7-нм технологии и предлагают 128 линий PCIe 4.0 и восемь каналов оперативной памяти DDR4-3200. Тесты Phoronix показывают, что в целом ряде задач чипы Ampere Altra Max M128-30 могут вполне конкурировать со старшими моделями Intel Xeon Ice Lake и AMD EPYC Milan. Итак, сообщается, что цена Ampere Altra Max M128-30 составляет $5800. Для сравнения: чип Intel Xeon Platinum 8380 сейчас предлагается за $8099, тогда как AMD EPYC 7763 стоит $8600. Процессор Ampere Altra Q80-30 с 80 вычислительными ядрами можно приобрести по цене $3950, а самая младшая 32-ядерная модель Ampere Altra Q32-17 стоит всего $800. Правда, надо учитывать, что всё это рекомендованные цены, а у AMD с Intel намного больше возможностей по их снижению для конечных заказчиков. |

|