Материалы по тегу: c

|

06.04.2025 [14:05], Сергей Карасёв

Начато создание европейского суперкомпьютера Daedalus с производительностью 89 ПфлопсЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) сообщило о подписании соглашения с компанией НРЕ на создание суперкомпьютера Daedalus, который расположится в Греции и будет интегрирован с ИИ-фабрикой Pharos. Контракт с НРЕ заключён при участии Национальной инфраструктуры исследований и технологий GRNET S.A. в Афинах. Общая стоимость создания Daedalus оценивается в €36 млн. Из этой суммы 35 % предоставит EuroHPC JU, а остальные 65 % будут привлечены в рамках Национального плана восстановления и обеспечения устойчивости «Греция 2.0». В проекте также участвуют Кипр, Черногория и Северная Македония, вошедшие в специально сформированный консорциум Daedalus. Производительность нового суперкомпьютера составит более 89 Пфлопс (FP64). С таким показателем быстродействия в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500 комплекс Daedalus мог бы занять 17-е или 18-е место. Для НРС-платформы предусмотрено применение возобновляемых источников энергии и передовых систем охлаждения, которые значительно повысят энергетическую эффективность. Суперкомпьютер Daedalus станет доступен в начале 2026 года широкому кругу пользователей по всей Европе, включая научное сообщество, промышленную сферу и государственный сектор. Машина расположится в новом дата-центре в здании бывшей электростанции Технологического культурного парка Лаврион Национального технического университета Афин (NTUA). Доступ к вычислительным ресурсам комплекса будет совместно управляться EuroHPC JU и консорциумом Daedalus пропорционально их инвестициям. Ожидается, что Daedalus ускорит научные достижения Европы в различных областях, включая ИИ, медицину, метеорологию, анализ больших данных и разработку интеллектуальных транспортных систем. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они разместятся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Аналогичные комплексы также появятся в Австрии, Болгарии, Франции, Германии, Польше и Словении.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

03.04.2025 [15:26], Руслан Авдеев

В Пенсильвании построят газовую электростанцию мощностью 4,5 ГВт для ИИ ЦОД на месте заброшенной угольнойНа месте крупнейшей угольной электростанции Пенсильвании появится новая газовая станция мощностью 4,5 ГВт. Проект предполагает создание ЦОД для ИИ и HPC, а станцию должны ввести в эксплуатацию в 2027 году, сообщает The Register. За реализацию проекта отвечает Homer City Redevelopment (HCR). Потребуется порядка $10 млрд только на развитие энергетической инфраструктуры и подготовку площадки. Ещё миллиарды уйдут на строительство самого дата-центра. Электростанция и ЦОД будут находиться рядом друг с другом. Для преобразования угольных мощностей в газовые потребуется полная перестройка объекта. Зато можно будет использовать оставшуюся энергетическую инфраструктуру, включая линии электропередач и подстанции. HCR не рассказывает о будущих арендаторах, основное внимание уделяется подготовке дата-центра и энергетической инфраструктуре. Проект ориентирован на обеспечение работы ИИ-платформ и гиперскейлеров. Предусмотрено использование газовых турбин General Electric Vernova (GE Vernova), сообщает пресс-служба HCR. Установки предназначены для работы на природном газе, но в будущем их могут перевести и на водород. Впрочем, пока сроки поставок «зелёного» водорода — под вопросом. Хотя предполагается использование в генераторах природного газа, проект позиционируется как «низкоуглеродный», поскольку, по данным HCR, новая станция позволяет сократить выбросы парниковых газов на 60–65 % в сравнении с угольными мощностями, ранее работавшими там же.

Источник изображения: silas Tarus/unsplash.com Место выбрали не случайно. Территория бывшей угольной электростанции в Хомер-Сити (Homer City) уже имеет инфраструктуру, включая линии электропередач, подстанции и доступ к воде. Благодаря этому строительство и подключение к энергосистеме ускорятся и упростятся. Стройка, которую возглавит Kiewit Power Constructors, должна начаться уже в 2025 году, первые турбины планируют установить в 2026 году, а ввод в эксплуатацию намечен на 2027 год, как раз к появлению 600-кВт стоек NVIDIA Rubin Ultra NVL576. Новые электростанции для дата-центров — один из последних трендов в деле обеспечения энергией ИИ ЦОД. Meta✴ строит дата-центр для ИИ в Луизиане и совместно с Entergy готовят газовую электростанцию на 2,2 ГВт. Её также могут перевести на водород в будущем. Microsoft заключила соглашение с Constellation Energy о перезапуске реактора АЭС Three Mile Island. Amazon (AWS) приобрела кампус Cumulus Data в Пенсильвании, расположенный рядом с атомной электростанцией Susquehanna. Meta✴ и Oracle также активно изучают возможности ядерной энергетики. Первая рассчитывает приобрести до 4 ГВт атомной энергии к 2030-м годам, а Oracle намерена построить дата-центр на 1 ГВт с питанием от трёх малых модульных реакторов (SMR). Наконец, в марте появились новости о том, что и Crusoe, и Chevron получат газовые турбины GE Vernova для снабжения электричеством своих ЦОД, тоже по 4,5 ГВт — пока остаётся только догадываться, не идёт ли во всех случаях речь об одних и тех же турбинах. В конце марта сообщалось, что производители газовых генераторов с трудом справляются с заказами для ИИ ЦОД, но расширять производство опасаются из-за возможной низкой маржинальности проектов.

29.03.2025 [10:44], Сергей Карасёв

OWC представила хранилища данных Jellyfish B24 и S24 для создателей контентаКомпания Other World Computing (OWC) анонсировала стоечные СХД Jellyfish B24 и Jellyfish S24, рассчитанные прежде всего на создателей контента. Обе новинки допускают подключение модулей расширения, что позволяет наращивать вместимость по мере необходимости. Модель Jellyfish B24 на основе HDD представляет собой упрощённую версию мощного решения Jellyfish R24, разработанную для совместной работы небольших команд. Допускается установка 24 накопителей формата LFF суммарной вместимостью до 576 Тбайт. При необходимости можно подключить до четырёх модулей расширения Jellyfish B24-E посредством интерфейса mini-SAS, получив хранилище общей ёмкостью до 2,8 Пбайт.

Источник изображений: OWC Устройство Jellyfish B24 выполнено в форм-факторе 4U. Задействован неназванный процессор Intel Xeon Silver, работающий в тандеме с 64 Гбайт оперативной памяти DDR4 ECC. В оснащение входит кеширующий SSD на 2 Тбайт. Есть два порта 1GbE, а при необходимости могут быть добавлены сетевые интерфейсы 10GbE (RJ45/SFP+), 25GbE (QSFP), 50GbE (QSFP28) и 100GbE (QSFP28). Предусмотрены четыре порта USB 3.0 и разъём D-Sub. За питание отвечает блок мощностью 875 Вт с резервированием. Габариты СХД составляют 432 × 318 × 198 мм, масса — 15,9 кг без установленных накопителей. Поддерживаются протоколы SMB, NFS, FTP и SSH.  Вариант Jellyfish S24, в свою очередь, рассчитан на 24 SSD формата SFF. При подключении модуля расширения Jellyfish S24-E можно получить суммарную вместимость до 736 Тбайт на основе твердотельных накопителей. Добавив четыре модуля Jellyfish R24-E или B24-E, можно создать гибридное хранилище ёмкостью до 2,3 Пбайт. СХД располагает двумя портами 10GbE RJ45 и двумя блоками питания мощностью 650 Вт с возможностью горячей замены. Форм-фактор — 2U. Упомянуты протоколы SMB, NFS, FTP и SSH.

29.03.2025 [10:11], Алексей Степин

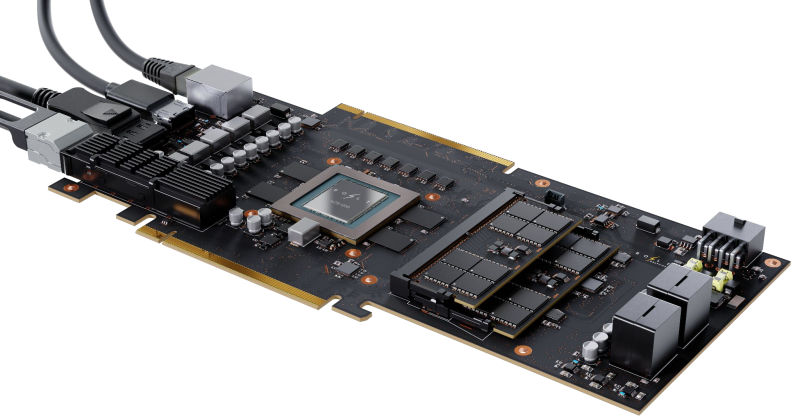

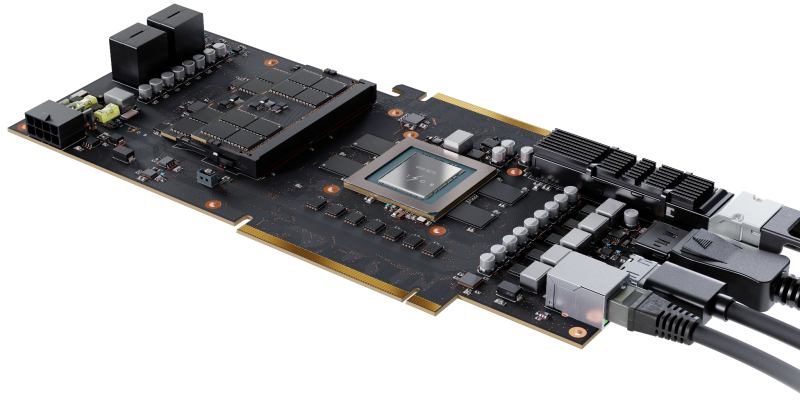

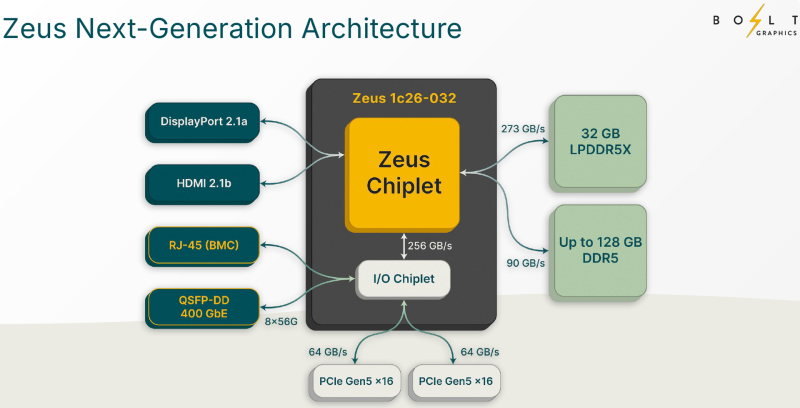

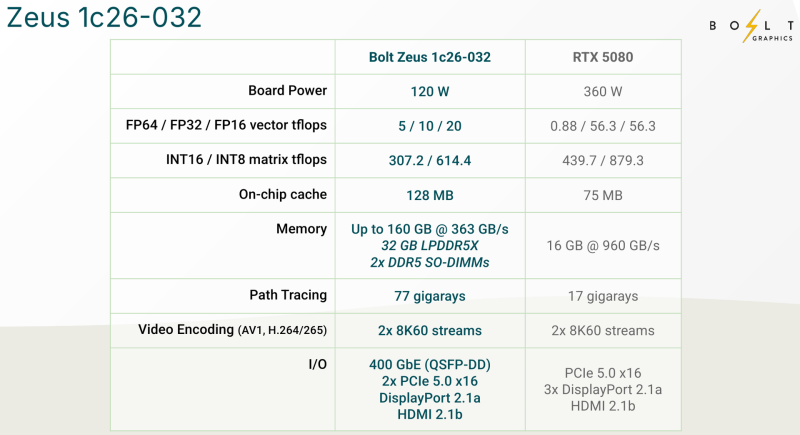

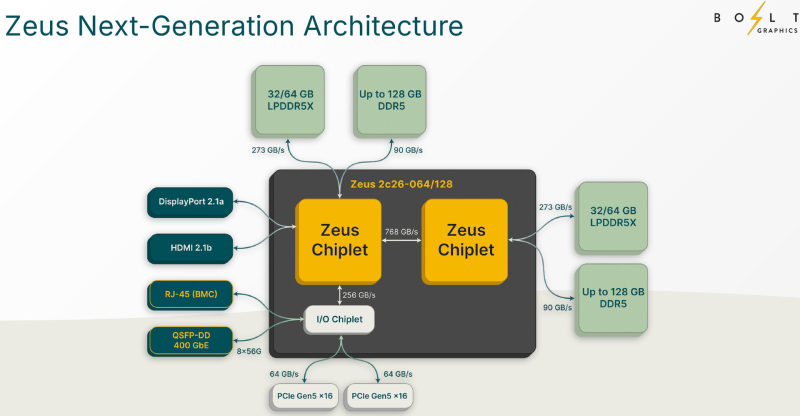

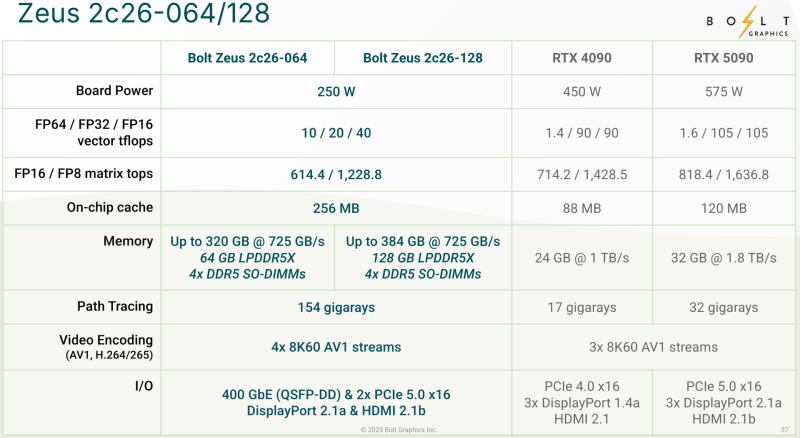

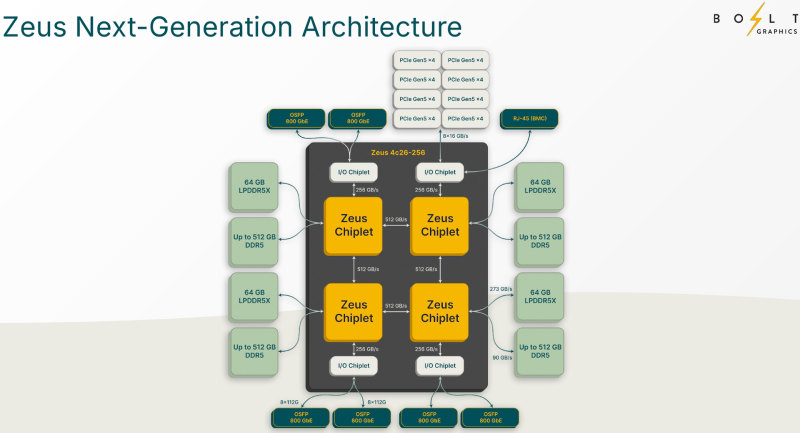

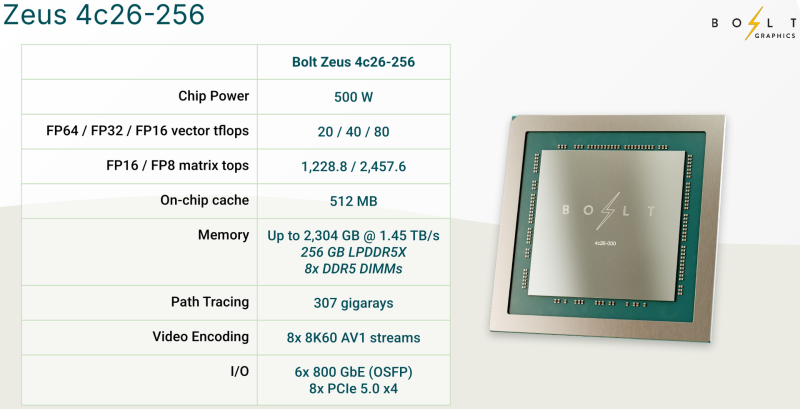

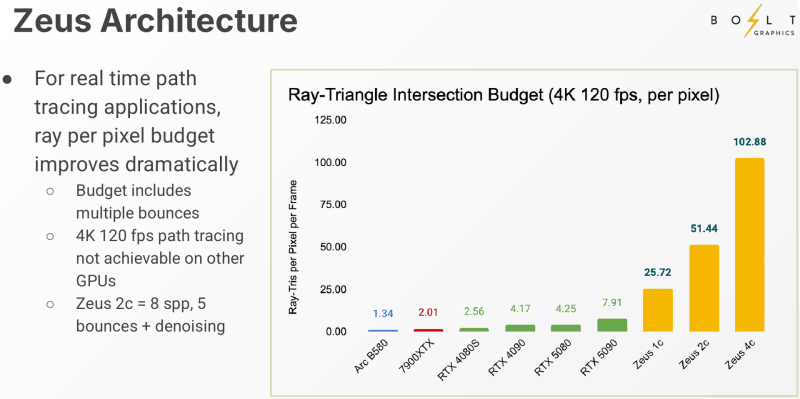

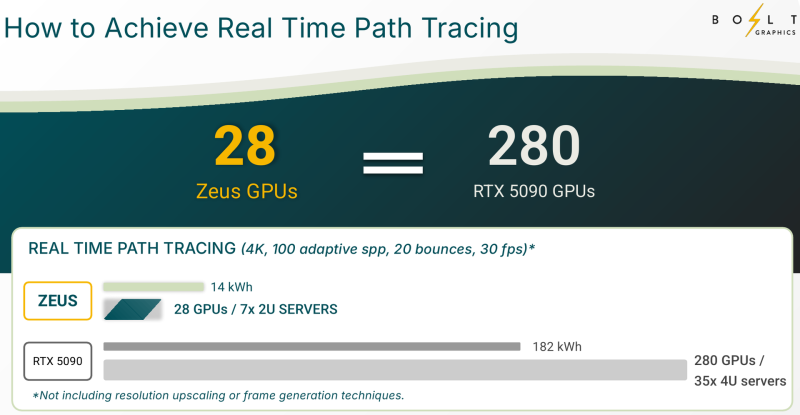

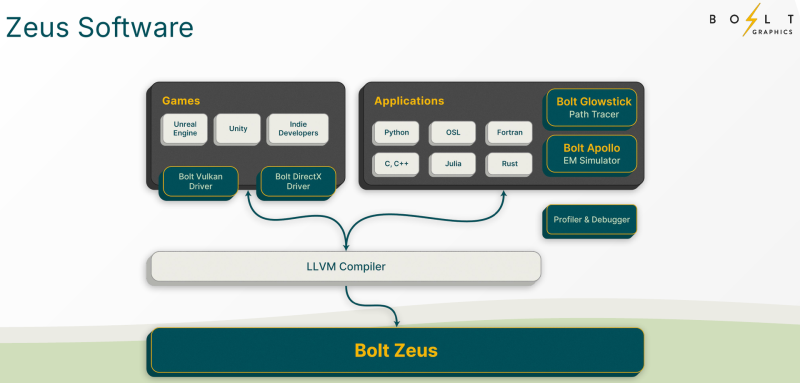

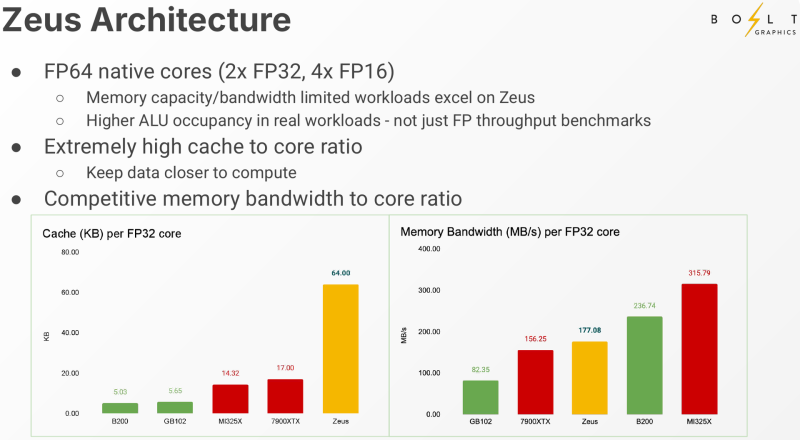

Bolt Graphics анонсировала универсальную видеокарту со слотами SO-DIMM, которая может потягаться с RTX 5080Все современные графические ускорители предлагаются с жёстко заданным при производстве объёмом видеопамяти, а в наиболее производительных моделях память типа HBM вообще интегрирована на одной с основным кристаллом подложке. Однако требования к объёму памяти в последнее время растут быстрее, а за дополнительный объём вендор просят всё больше. Кардинально иной подход предлагает компания Bolt Graphics, недавно анонсировавшая серию ускорителей Zeus. Несмотря на «ИИ-пандемию», Bolt Graphics в своём анонсе не делает упор на искусственный интеллект, а называет Zeus первым GPU, специально созданным для целей HPC, рендеринга, трассировки лучей и даже компьютерных игр. Что интересно, в основе Zeus лежит не некая закрытая архитектура: скалярная часть нового GPU построена на базе спецификации RISC-V RVA23, векторная представлена FP64 ALU на базе несколько модифицированной RVV 1.0. Прочие функции реализованы путём кастомных расширений и отдельных блоков-ускорителей. Все они пользуются общим кешем объёмом 128 Мбайт. Дополняет картину блок телеметрии и внутренний интерконнект для общения с другими вычислительным блоками. Используется чиплетный подход. Базовый «строительный блок» Zeus 1c26-032 включает GPU-чиплет, который соединён с 32 Гбайт набортной памяти LPDDR5x (273 Гбайт/с) и контроллером внешней памяти DDR5 (90 Гбайт/с), т.е. при желании можно установить ещё 128 Гбайт RAM (два модуля SO-DIMM). В GPU-чиплет встроены контроллеры DisplayPort 2.1a и HDMI 2.1b, а с внешним миром он общается посредством IO-чиплета, с которым он соединён 256-Гбайт/с каналом. IO-чиплет предлагает необычный набор портов. Помимо сразу двух интерфейсов PCIe 5.0 x16 (64 Гбайт/с каждый) имеется выделенный порт RJ-45 для BMC и 400GbE-порт QSFP-DD. Наконец, есть аппаратный блок видеокодирования, способный справиться с двумя потоками 8K@60 AV1/H.264/H.265. Заявленный уровень производительности в векторных FP64/FP32/FP16-вычислениях составляет 5/10/20 Тфлопс, а в матричных INT16/INT8 — 307,2/614,4 Топс. Аппаратный блок ускорения лучей (path tracing) выдаёт до 77 гигалучей. Для сравнения: NVIDIA RTX 5090 способна выдавать 32 гигалуча, а FP64-производительность составляет 1,6 Тфлопс. В то же время в расчётах пониженной точности актуальные решения NVIDIA всё равно быстрее Zeus 1c26-032. Однако у новинки есть важное преимущество — её уровень TDP составляет всего 120 Вт. Второй интерфейс PCIe 5.0 x16 можно использовать для прямого объединения двух карт. Вариант ускорителя с двумя чиплетами носит название Zeus 2c26-064/128, а с четырьмя — 4c26-256. Последние числа обозначают объём распаянной памяти LPDDR5X. Что касается расширяемой памяти, то количество доступных разъёмов SO-DIMM также зависит от модели и составляет до восьми, так что во флагманской конфигурации базовые 256 Гбайт LPDDR5x можно дополнить аж 2 Тбайт DDR5. Производительность с увеличением количеств GPU-чиплетов растёт практически пропорционально, но есть некоторые другие нюансы. Так, в Zeus 2c26-064 и Zeus 2c26-128 (оба варианта имеют TDP 250 Вт) есть только один IO-чиплет, а GPU-чиплеты объединены шиной со скоростью 768-Гбайт. Zeus 4c26-256 имеет сразу четыре I/O чиплета в составе, которые дают восемь контроллеров PCIe 5.0 x4 (один чиплет, совокупно 32 линии) и шесть 800GbE-портов OSFP (три чиплета). Между собой GPU-чиплеты объединены шиной со скоростью 512-Гбайт/с. Каждый из них соединён с собственным IO-чиплетом на скорости 256 Гбайт/с. Теплопакет флагмана составляет 500 Ватт, ускоритель, если верить Bolt Graphnics, развивает 20 Тфлопс в режиме FP64, почти 2500 Топс на вычислениях FP8 и способен обрабатывать до 307 гигалучей. Разработчики явно заложили в своё детище широкие возможности кластеризации, о чём свидетельствует наличие мощной сетевой подсистемы. Поддерживаются как скромные конфигурации из двух GPU, соединённых непосредственно по Ethernet 400GbE, так и масштабные системы уровня стойки, содержащей 80 плат Zeus 4c26-256, соединённых как с коммутатором, так и напрямую друг с другом. Такой кластер потребляет 44 кВт, но зато способен обеспечивать запуск крупных физических симуляций или обучение ИИ моделей за счёт огромного массива общей памяти, составляющего 160 Тбайт. Вычислительная производительность такого кластера достигает 1,6 Пфлопс в режиме FP64 и 196 Попс в режиме FP8. Одной из особенностей новинок является трассировщик лучей Glowstick, способный работать в режиме реального времени практически во всех современных пакетах 3D-моделирования или видеоредактирования, таких как Maya, 3ds Max, Blender, SketchUp, Houdini и Nuke. Он будет дополнен фирменной библиотекой Bolt MaterialX, содержащей более 5000 текстур высокого качества. А благодаря поддержке стандарта OpenUSD он сможет легко интегрироваться в любую цепочку рендеринга и пост-обработки. Также запланирован электромагнитный симулятор Bolt Apollo. Обещаны фирменные драйверы Vulkan/DirectX и SDK с использованием LLVM. Ранний доступ к комплектам разработчика Bolt Graphics наметила на IV квартал текущего года. В III квартале 2026 года должны появиться 2U-серверы на базе Zeus, а массовые поставки серверов и PCIe-карт начнутся не ранее IV квартала того же года. Пока сложно сказать, насколько хорошо новая архитектура себя проявит, но если верить предварительным тестам Zeus, выигрыш в сравнении с существующими ускорителями существенен, особенно в энергопотреблении.

29.03.2025 [10:01], Сергей Карасёв

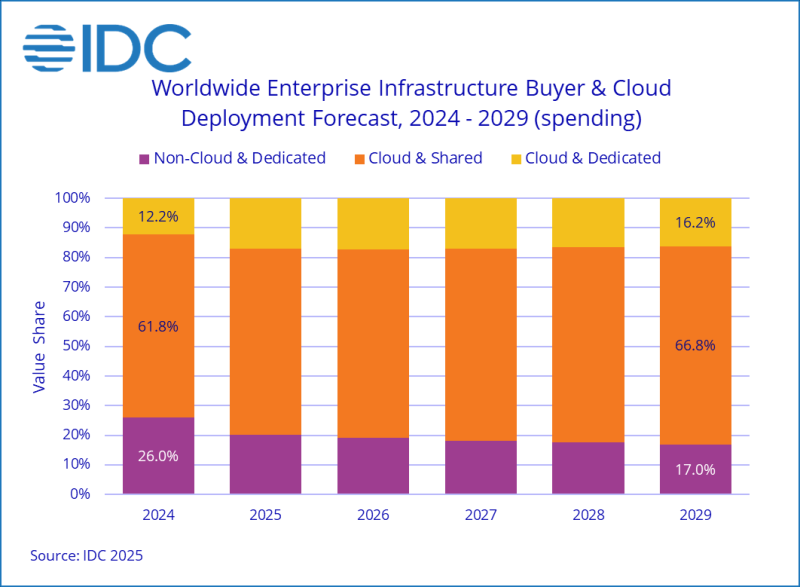

Квартальные затраты на облачную инфраструктуру выросли вдвое на фоне бума ИИПо оценкам компании International Data Corporation (IDC), мировые затраты на облачную инфраструктуру в IV квартале 2024 года достигли $67 млрд: это на 99,3 %, т.е. практически в два раза, больше по сравнению с аналогичным периодом предыдущего года. При этом необлачный сегмент показал рост на 25,8 % — до $22 млрд. Аналитики учитывают продажи серверов и СХД для выделенных и публичных облачных платформ. Главным драйвером отрасли является ИИ, в частности, «рассуждающие» модели и агенты ИИ. Облачные провайдеры активно закупают дорогостоящие системы с ускорителями на базе GPU, а также инвестируют средства в расширение сетей дата-центров. Расходы на публичную облачную инфраструктуру достигли $57 млрд в IV квартале 2024 года, увеличившись на 124,4 % по сравнению с предыдущим годом. В секторе выделенных облаков отмечен рост на 21,8 % в годовом исчислении — до $10 млрд. Таким образом, на публичные платформы пришлось 64,0 % от общих затрат. В географическом разрезе расходы на облачную инфраструктуру в последней четверти 2024 года увеличились во всех регионах. В частности, максимальный рост зафиксирован в Канаде и США — плюс 151,8 % и 125,3 % в годовом исчислении соответственно. Китай, Япония, Азиатско-Тихоокеанский регион (за исключением КНР и Японии), Западная Европа, Ближний Восток / Африка, а также Латинская Америка показали прибавку в 99,6 %, 76,2 %, 48,0 %, 36,8 %, 28,1 % и 14,3 % соответственно. В Центральной и Восточной Европе отмечено увеличение на 5,6 %. IDC прогнозирует, что в 2025 году расходы на облачную инфраструктуру поднимутся на 33,3 % по сравнению с 2024-м, составив $271,5 млрд. При этом публичные платформы покажут рост на 25,7 % в годовом исчислении — до $213,7 млрд. В сегменте выделенных облаков ожидается прибавка около 71,8 % — до $57,8 млрд. Расходы на необлачную инфраструктуру, по мнению IDC, в 2025 году снизятся на 4,9 %, составив $68,1 млрд.

26.03.2025 [10:36], Сергей Карасёв

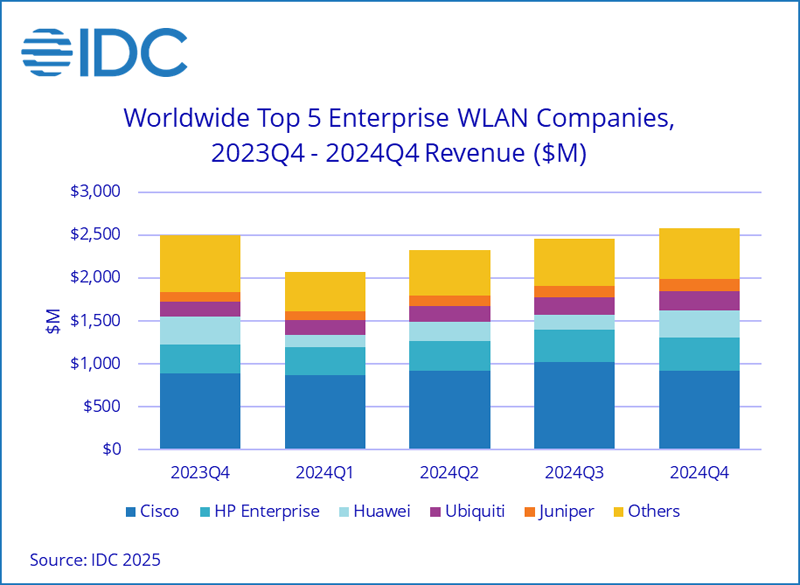

Объём рынка корпоративного WLAN-оборудования в 2024 году сократился на 12,7 %Компания International Data Corporation (IDC) опубликовала результаты исследования мирового рынка корпоративного оборудования для беспроводных локальных сетей (WLAN). В IV квартале 2024 года продажи увеличились на 3,2 % по сравнению с последней четвертью 2023-го, достигнув $2,6 млрд. Однако по итогам прошлого года в целом отмечено падение на 12,7 % — до $9,4 млрд. В IV квартале 2024 года на точки доступа Dependent Access Point стандарта Wi-Fi 6E пришлось 29,0 % в общем объёме выручки в соответствующем сегменте. Для сравнения: годом ранее доля такого оборудования оценивалась в 22,5 %. Изделия Wi-Fi 7 обеспечили 10,2 % от суммарной выручки сегмента Dependent Access Point.

Источник изображения: IDC С географической точки зрения, американский рынок корпоративного WLAN-оборудования сократился на 16,7 % в 2024 году. В США зафиксирован годовой спад на 17,3 %, в регионе EMEA (Европа, Ближний Восток и Африка) — на 9,3 %. В Азиатско-Тихоокеанском регионе выручка снизилась на 8,8 % по сравнению с 2023 годом. В Китае отмечено падение на 14,2 %. Крупнейшим игроком глобального рынка является Cisco, у которой продажи снизились на 19,1 % в 2024 году, составив $3,7 млрд: доля компании — 39,5 %. На втором месте в рейтинге ведущих производителей располагается HPE Aruba Networking с выручкой в размере $1,4 млрд, что на 8,3 % меньше по сравнению с 2023-м: компания удерживает 15,2 % отрасли. Замыкает тройку Huawei, у которой продажи снизились за год на 1,6 % — до $851 млн, а доля составила 9,0 %. В пятёрку также входят Ubiquiti и Juniper Networks с $800 млн (+20,5 % год к году) и $484 млн (+9,6 % по отношению к 2023 году) и долями 8,5 % и 5,1 % соответственно.

26.03.2025 [09:03], Руслан Авдеев

Производители газовых турбин с трудом справляются с заказами для ИИ ЦОД, но расширять производство опасаютсяКомпании, выпускающие газовые турбины для электростанций, с трудом справляются с растущим спросом со стороны операторов дата-центров. Однако они не спешат наращивать производство, опасаясь за маржинальность проектов, сообщает Datacenter Dynamics. В последнее время природный газ становится ключевым источником энергии для ЦОД в США. Тем не менее, согласно отчёту аналитиков Sightline Climate (CTVC), производители турбин столкнулись со сложностями при выполнении заказов, а сроки поставок уже растянулись до 2029 года и далее. Большую часть подходящих газовых турбин выпускают три компании — GE Vernova, Siemens и Mitsubishi Heavy Industries. У GE Vernova достаточно мощностей, чтобы выпустить турбины на 50 ГВт в следующие пять лет. Тем не менее, как сообщает Heatmap, производители не стремятся к инвестициям в расширение производства, стремясь сохранить не только высокую маржу, но и снизить риски чрезмерных вложений, если ставка на ИИ ЦОД не оправдается в полной мере. Опасения только усилились после триумфа китайского стартапа DeepSeek, выпустившего чрезвычайно экономичные модели, требующие небольших ресурсов. И, хотя они оказались не столь фантастически хороши, как преподносилось, достижения DeepSeek неоспоримы.

Источник изображения: Max Bender/unsplash.com В результате некоторые поставщики электричества «на всякий случай» поставили под вопрос газовую генерацию. В прошлом месяце энергокомпания Engie отменила строительство двух запланированных газовых электростанций в Техасе из-за длительных сроков реализации проекта и возросших затрат. А операторов ЦОД уже предупреждают, что на поставку новых турбин может потребоваться семь-восемь лет, что с учётом относительно малых сроков строительства новых ЦОД неприемлемо. Неопределённость в индустрии привела к тому, что некоторые её представители вовсе начали сомневаться в целесообразности использования природного газа в качестве «мостика» для перехода на низкоуглеродные альтернативы, такая идея продвигалась ранее. Впрочем, многие операторы ЦОД и поставщики природного газа сохраняют оптимизм относительно роли, которую тот будет играть в обеспечении новых ИИ ЦОД. В январе 2025 года Chevron заключила соглашение с Engine No. 1 для сотрудничества с GE Vernova и создания электростанций мощностью несколько гигаватт с использованием семь газовых турбин GE Vernova 7HA. Ввода в эксплуатацию запланирован на конец 2027 года. Турбины, как ожидается, будут поставлять электроэнергию Crusoe, которая намерена построить масштабные кампусы ЦОД в США. Недавно сообщалось, что использовать семь генераторов и строить собственные ЦОД намерена сама Chevron, поэтому заинтересованным сторонам стоит дождаться дополнительных разъяснений. До этого в декабре 2024 года Exxon объявила о намерении построить электростанцию на 1,5 ГВт на природном газе, тоже предназначенную для сектора ЦОД.

26.03.2025 [01:00], Владимир Мироненко

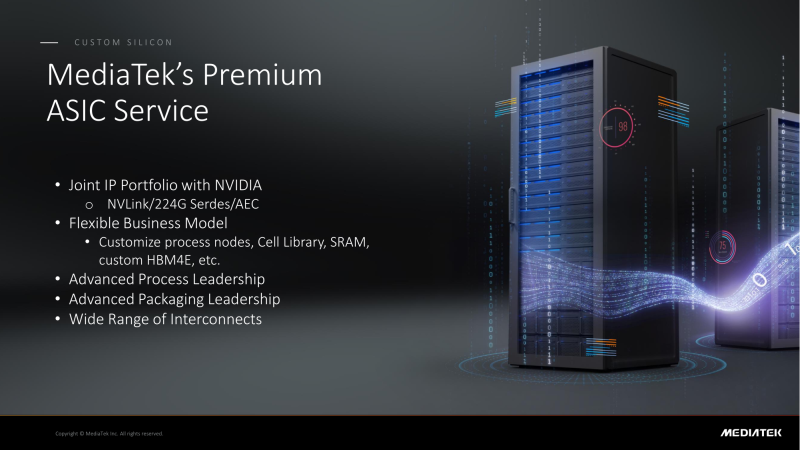

NVIDIA поделится с MediaTek фирменным интерконнектом NVLink для создания кастомных ASICMediaTek объявила о планах расширить сотрудничество с NVIDIA, интегрировав NVLink в разрабатываемые ей ASIC, сообщил ресурс DigiTimes. В свою очередь, ресурс smbom.com пишет, что партнёры намерены совместно разрабатывать передовые решения с использованием NVLink и 224G SerDes. Аналитики предполагают, что выход NVIDIA в сектор ASIC позволит ей ускорить дальнейшее продвижение на рынке с использованием опыта MediaTek и при этом решать имеющиеся проблемы. Как ожидают аналитики, по мере развития сотрудничества двух компаний всё больше провайдеров облачных услуг будет проявлять интерес к работе с MediaTek. Внедрение NVLink в ASIC MediaTek может значительно повысить привлекательность сетевых решений NVIDIA. Объединив усилия, NVIDIA и MediaTek смогут предложить комплексную разработку кастомных ASIC, которая будет включать поддержку HBM4e, обширную библиотеку IP-блоков, передовые процессы производства и упаковки. MediaTek отдельно подчеркнула, что её SerDes-блоки является ключевым преимуществом при разработке ASIC. Компании расширяют сотрудничество с ведущими мировыми производствами полупроводников, ориентируясь на передовые техпроцессы. Применяя технологию совместной оптимизации проектирования (DTCO), они стремятся достичь оптимального соотношения между производительностью, энергопотреблением и площадью (PPA). Сообщается, что несколько облачных провайдеров уже изучают объединённое IP-портфолио NVIDIA и MediaTek. По неофициальным данным, Google уже прибегла к услугам MediaTek при разработке 3-нм TPU седьмого поколения, которое поступит в массовое производство к III кварталу 2026 года. Ожидается, что переход на 3-нм процесс принесет MediaTek более $2 млрд дополнительных поступлений. По данным источников в цепочке поставок, восьмое поколение TPU перейдёт на 2-нм процесс TSMC, что вновь укрепит позиции MediaTek. Также прогнозируется, что предстоящий выход чипа GB10 совместной разработки NVIDIA и MediaTek, и долгожданного чипа N1x, значительно улучшат бизнес-операции MediaTek и ещё больше укрепят позиции компании в полупроводниковой отрасли. Эксперты отрасли считают, что MediaTek имеет все возможности для того, что стать ключевым бенефициаром роста спроса на ИИ-технологии, особенно для малых и средних предприятий.

23.03.2025 [14:08], Сергей Карасёв

Итальянский суперкомпьютер Leonardo будет интегрирован с квантовым компьютером IQM Radiance на 54 кубитаИтальянский суперкомпьютерный центр Cineca объявил о заключении соглашения с компанией IQM Quantum Computers на поставку самого мощного в стране квантового вычислительного комплекса. Речь идёт о системе IQM Radiance в конфигурации с 54 кубитами. Cineca является одним из крупнейших вычислительных центров Италии. Некоммерческий консорциум состоит из 69 итальянских университетов и 21 национальной исследовательской организации. Своей задачей консорциум ставит поддержку итальянского научного сообщества путём предоставления суперкомпьютеров и инструментов визуализации. Монтаж IQM Radiance планируется осуществить в IV квартале нынешнего года. Это будет первый локальный квантовый компьютер на площадке Cineca в Болонье. Суперкомпьютерный центр намерен использовать новую систему для оптимизации квантовых приложений, квантовой криптографии, квантовой связи и квантовых алгоритмов ИИ. Комплекс IQM Radiance 54 будет интегрирован с вычислительной системой Leonardo, которая является одним из самых быстрых суперкомпьютеров в мире. В ноябрьском рейтинге TOP500 эта машина занимает девятое место с теоретической пиковой производительностью 306,31 Пфлопс. В основу суперкомпьютера положены платформы Atos BullSequana X2610 и X2135. Система построена в рамках сотрудничества EuroHPC, которое сейчас занято развёртыванием сети европейских квантовых компьютеров и ИИ-фабрик. Компания IQM Quantum Computers основана в Хельсинки (Финляндия) в 2018 году. Она поставляет полнофункциональные квантовые компьютеры и специализированные решения для HPC, научно-исследовательских институтов, университетов и предприятий. Ранее IQM заявляла, что к выпуску готовится версия Radiance со 150 кубитами, которую планировалось представить в I квартале 2025 года. |

|