Материалы по тегу: схд

|

14.10.2025 [15:49], Андрей Крупин

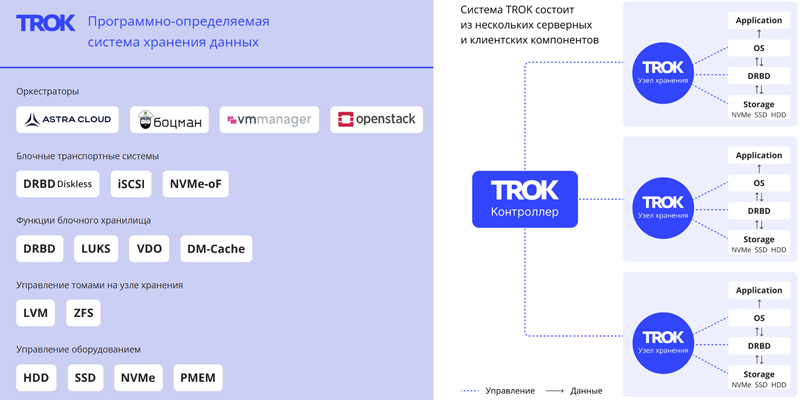

«Группа Астра» представила программно-определяемую систему хранения данных TROK«Группа Астра» объявила о выпуске TROK — российского программно-определяемого хранилища данных (Software-defined storage, SDS), предназначенного для построения отказоустойчивых облачных инфраструктур и корпоративных систем хранения. Система TROK может быть развёрнута на любом типовом сервере с архитектурой x86-64, amd64 или Arm. Решение позволяет управлять виртуальными устройствами, поддерживает разные протоколы доступа (блочный, файловый, объектный), параллельную синхронную репликацию данных между узлами хранения, возможность подключения по iSCSI, NVMEoF Target, NFS и различные механизмы восстановления данных. Доступен API управления хранилищем с поддержкой аутентификации. Продукт интегрирован в экосистему «Группы Астра» и совместим с отечественными платформами, включая ОС Astra Linux и СУБД Tantor.

Источник изображения: trok-sds.ru По заверениям разработчика, TROK подходит для построения частных, гибридных, публичных облаков и обеспечивает снижение совокупной стоимости владения (TCO) до 50 % по сравнению с проприетарными СХД. Стоимость TROK зависит от количества поддерживаемых виртуальных блочных устройств (доступны варианты на 10 Тбайт и 1 Пбайт), типа лицензии (бессрочная или подписка) и срока технической поддержки. Платформа зарегистрирована в реестре отечественного программного обеспечения и полностью подходит для задач импортозамещения.

14.10.2025 [10:00], Сергей Карасёв

«Базис» и MIND Software представляют первое в России коробочное HCI-решение для ускорения цифровой трансформации бизнесаКомпании MIND Software и «Базис» объявили о запуске первого в России полностью интегрированного HCI-решения. В его основу легла платформа для управления динамической инфраструктурой Basis Dynamix Standard, в которую встроена распределённая программно-определяемая система хранения данных MIND uStor. Разработанное MIND Software и «Базис» решение позволяет бизнесу создавать гиперконвергентную инфраструктуру (HCI, Hyper Converged Infrastructure), максимально сбалансированную по утилизации аппаратных ресурсов, без избыточных сервисов и точек отказа. Все необходимые для создания инструменты доступны заказчику «из коробки», без сложной настройки и длительного внедрения — для запуска системы достаточно нескольких кликов, и через 15 минут кластер полностью готов к работе. Управление гиперконвергентной инфраструктурой осуществляется из единой панели с графическим интерфейсом. Представленный продукт объединяет преимущества платформы Basis Dynamix Standard, такие как лёгкость развёртывания и гибкость управления, с надёжностью и экономичностью СХД MIND uStor. Новое HCI-решение позволяет значительно сократить время развёртывания ИТ-инфраструктуры и снизить операционные издержки, что особенно актуально для компаний, стремящихся ускорить цифровую трансформацию. Антон Груздев, генеральный директор MIND Software, отметил: «Интеграция MIND uStor и Dynamix Standard позволяет нам сделать современные технологии хранения данных более доступными и простыми во внедрении. Мы стремимся избавить заказчиков от сложностей с настройкой и дать им возможность сразу сосредоточиться на эффективности и масштабировании бизнеса». Дмитрий Сорокин, технический директор компании «Базис», добавил: «Поиск технологических партнёров и новых возможностей для развития продуктов — важная часть стратегии "Базиса". Мы давно и успешно сотрудничаем с MIND, и глубокая интеграция с MIND uStor — логичный шаг в развитии нашей платформы Dynamix Standard. Кроме того, мы видим значительный интерес бизнеса к HCI-платформам с прозрачной архитектурой и высокой степенью автоматизации, а значит, наше сотрудничество принесёт пользу рынку в целом».

10.10.2025 [01:23], Владимир Мироненко

Ложная надежда: Synology смягчила требования к использованию сторонних HDD/SSD, но профессиональных систем это не коснулосьSynology объявила о выпуске системы DiskStation Manager (DSM) 7.3, которая, как указано в пресс-релизе, обеспечивает повышенную эффективность хранения, усиленную безопасность и надёжность, а также получила новые функции для повышения производительности. Вместе с тем компания под давлением пользователей ослабила политику ограничения использования сторонних накопителей в своих NAS. Однако поблажки сделаны только для SOHO-пользователей. Как отметил ресурс NAScompares.com, с выпуском DSM 7.3 компания официально представила самый подробный на сегодняшний день пакет политик совместимости с указанием, какие жёсткие диски и твердотельные накопители поддерживаются в её экосистеме. Ограничения DSM 7.2 на использование накопителей сторонних брендов, сделавшее жёсткие диски Seagate, Toshiba и WD, практически непригодными для использования в новых моделях серии DiskStation Plus вызвало серьёзную негативную реакцию со стороны пользователей, которые полагались на гибкий выбор дисков. Представленный в DSM 7.3 фреймворк HCL 5.0 частично смягчает введенные ранее ограничения для DiskStation Plus и серии J 2025 модельного года, возвращая возможность использования неперечисленных в списке совместимых HDD и SSD с интерфейсом SATA для создания пулов. Synology описала это как прагматичную эволюцию своей политики, которая соответствует ожиданиям клиентов. Компания продолжит сотрудничать с основными производителями накопителей для проверки дополнительных моделей. С точки зрения Synology есть три типа накопителей:

Источник изображения: Synology DSM 7.3 теперь отображает более понятные уведомления в диспетчере хранения, различая совместимые, несовместимые и прочие диски, что позволяет оценить влияние выбора оборудования на работу системы до создания томов и кешей. Кроме того, Synology пояснила, что для прохождения сертификации и попадания в список совместимых накопители должны пройти тесты на термические нагрузки, устойчивость к циклам вкл./выкл. и аварийное выключение. В DSM 7.3 Synology пересмотрела подход своих NAS к работе с SATA-дисками, которых нет в списке совместимых и нет в списке несовместимых. Для моделей DS+ Plus 2025 года, включая DS1525+, DS925+ и DS725+, эти диски теперь считаются полностью функциональными и в работе ничем не отличаются от официально совместимых накопителей, поддерживая установку, создание/расширение пулов/томов, работу со снимками и шифрование, использование HyperBackup и т.д., а DSM больше не «ругается» на них. DSM 7.2 блокировала создание пула, если установленный диск не входил в список совместимых. С M.2 NVMe SSD ситуация особая. Для создания новых кешей или пулов хранения требуются только накопители из списка совместимых, поскольку такие диски подвергаются более высоким постоянным нагрузкам записи и выделяют больше тепла при непрерывной работе NAS. Ранее сконфигурированные NVMe SSD по-прежнему можно использовать только при миграции со старых NAS на новые. Гарантия предоставляется в полном объёме, но техподдержка Synology может отказать в помощи с проблемами, которые, как доказано, вызваны оборудованием, не входящим в список совместимых. В то же время корпоративные серии СХД Synology FS, HD, SA, UC, XS+, XS, RS+, RS и DP продолжают работать в соответствии с более строгими правилами, согласно которым для полноценной работы требуются только диски SAS/SATA/NVMe из списка совместимых. SATA-накопители, не входящие в список совместимых, можно использовать только для миграции. Кеширующие накопители вне списка совместимых также запрещены к использованию. Synology объясняет это тем, что для корпоративных нагрузок требуются надёжные накопители с устойчивостью к различным сбоям, в том числе в многоузловых конфигурациях, способностью к корректному восстановлению после сбоев и с заданным уровнем производительности. Похожие аргументы приводятся и в пользу допустимости использования в СХД DVR/NVR SATA-накопителей вне списка совместимых только для миграции данных со старых систем. Совместимые накопители также должны пройти отдельные тесты на возможность непрерывной записи с малым временем отклика. Проблема в том, что Synology не спешит сертифицировать сторонние накопители. Так, Seagate IronWolf/SkyHawk и WD Purple в списках толком нет. Параллельно Synology подталкивает к использованию фирменных накопителей HAT/HAS/SAT. При покупке NAS/СХД вместе с ними можно получить расширенную гарантию сроком до пяти лет. Также Synology запустила программу экспресс-замены, позволяющую производить немедленную замену дисков в течение гарантийного срока, не дожидаясь отправки и проверки неисправного устройства.

01.10.2025 [15:40], Владимир Мироненко

YADRO анонсировала поддержку NVMe over TCP — более доступной и производительной альтернативы FC и iSCSIКомпания YADRO объявила о предстоящем выходе технологии NVMe over TCP (Non-Volatile Memory Express с транспортным протоколом TCP), которая станет доступна с осенним релизом v3.2 СХД TATLIN.UNIFIED. Новое решение YADRO позволяет снизить задержки, увеличить производительность и достигнуть максимальной простоты работы с данными. Уже сейчас его можно протестировать в режиме предварительного доступа. Компания отметила, что работа по протоколу Fibre Channel (FC) становится сложнее из-за выросшей стоимости использования и сложности обслуживания оборудования, в то время как протокол iSCSI часто не отвечает требованиям задач бизнеса из-за ограничений по производительности и проблем с надёжностью и отказоустойчивостью. Согласно данным внутреннего тестирования, при использовании NVMe/TCP ускорение операций ввода-вывода по сравнению с FC составило до 30 %, сокращение задержек — 25 %. По сравнению с iSCSI новое решение обеспечивает производительность выше на 62 %. NVMe over TCP снижает нагрузку на операционную систему, упрощает процесс обнаружения изменений в хранилище и легко интегрируется с ОС на базе ядра Linux, позволяя оптимизировать скорость работы с ресурсоёмкими задачами и высоконагруженными корпоративными приложениями. Встроенная функция многопутевого ввода-вывода (Native NVMe Multipath) обеспечивает стабильную работу даже при подключении тысячи ресурсов/логических томов. Также следует отметить доступную стоимость внедрения и простоту эксплуатации новой технологии. Для перехода на неё с iSCSI не требуется дополнительное оборудование, а при переходе с FC компания предлагает заказчикам решение на базе сетевых коммутаторов KORNFELD, которые поддерживают NVMe/TCP и интегрированы с СХД TATLIN для построения единой end-to-end NVMe-инфраструктуры. В настоящее время YADRO ведёт проработку интеграции технологии с решениями технологических партнёров. Некоторые из них уже выпустили или готовят к выпуску в ближайшее время собственных решений с использованием NVMe over TCP. Компания отметила, что помимо NVMe/TCP в релизе 3.2 будет представлен целый ряд улучшений, включая поддержку LACP на виртуальных портах для файлового доступа, VLAN на виртуальных портах для блочного и файлового доступа и Root squash для файловых ресурсов. Также будут увеличены лимиты ресурсов на систему и повышена производительность и безопасность.

26.09.2025 [09:53], Сергей Карасёв

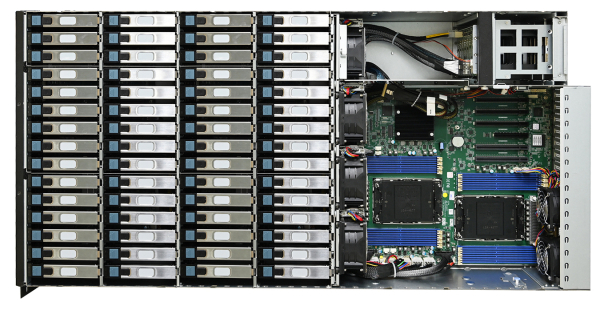

Сервер хранения AIC SB407-VA допускает установку 60 накопителей LFF SATA/SASКомпания AIC представила сервер хранения данных SB407-VA, выполненный в форм-факторе 4U на аппаратной платформе Intel. Новинка допускает установку в общей сложности 70 накопителей разных типов, что позволяет сформировать массив большой ёмкости для таких задач, как аналитика данных, периферийные ИИ-приложения и пр. Сервер может комплектоваться двумя процессорами Xeon Sapphire Rapids или Emerald Rapids. Доступны 16 слотов для модулей DDR5-5600/4800 суммарным объёмом до 4 Тбайт (3DS RDIMM). Предусмотрены четыре слота расширения PCIe x16 и один разъём PCIe x8: во всех случаях могут монтироваться карты формата FHHL. Предусмотрены посадочные места для 60 накопителей LFF с интерфейсом SATA/SAS и возможностью горячей замены. Кроме того, могут быть установлены восемь SFF-устройств в конфигурации 6 × NMVe (PCIe 4.0) и 2 × SATA с поддержкой горячей замены. Плюс к этому есть два коннектора M.2 M Key 2280 для SSD с интерфейсом PCIe 4.0. Модель AIC SB407-VA наделена контроллером Aspeed AST2600. Реализованы два сетевых порта 1GbE на базе Broadcom BCM5720 и выделенный сетевой порт управления 1GbE на основе Realtek RTL8211FS. Во фронтальной части расположен один порт USB3.0 Type-A, в тыльной — три гнезда RJ45 для сетевых кабелей, два разъёма USB 3.1 Gen1 Type-A и коннектор D-Sub. Габариты составляют 434 × 853 × 176 мм. Питание обеспечивают четыре блока мощностью 800 Вт с сертификатом 80 Plus Platinum/Titanium. Задействовано воздушное охлаждение, а диапазон рабочих температур простирается от 0 до +35 °C.

29.08.2025 [23:15], Владимир Мироненко

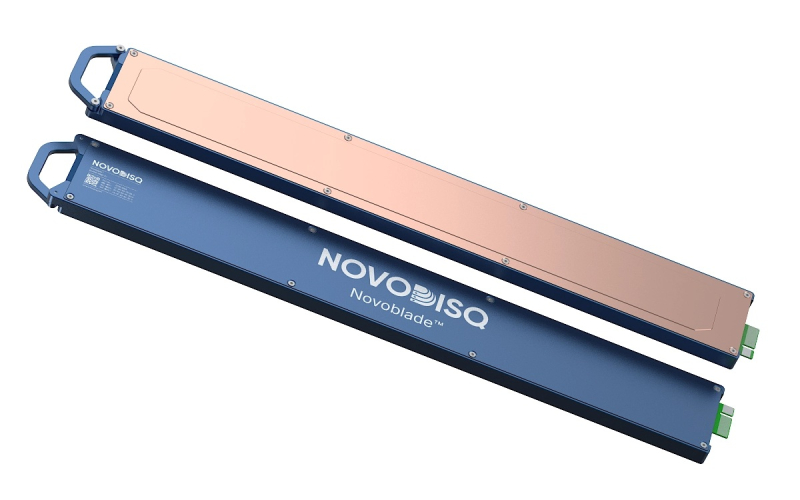

11,5 Пбайт в 2U: Novodisq представил блейд-сервер для ИИ и больших данныхСтартап Novodisq представил блейд-сервер формата 2U ёмкостью 11,5 Пбайт с функцией ускорения ИИ и др. задач. Гиперконвергентная кластерная система разработан для замены или дополнения традиционных решений NAS, SAN и публичных облачных сервисов. Новинка поддерживает платформы Ceph, MinIO и Nextcloud (также планируется поддержка DAOS), предлагая доступ по NFS, iSCSI, NVMe-oF и S3. Сервер содержит до 20 модулей Novoblade с фронтальной загрузкой. В каждом из них имеется до четырёх встроенных E2 SSD Novoblade объёмом 144 Тбайт каждый, на базе TLC NAND с шиной PCIe 4.0 x4. Накопители поддерживают NVMe v2.1 и ZNS, обеспечивая последовательную производительность чтения/записи до 1000 Мбайт/с, а на случайных операциях — до 70/30 тыс. IOPS. Надёжность накопителей составляет до 24 PBW. Энергопотребление: от 5 до 10 Вт. Система Novoblade предназначена для «тёплого» и «холодного» хранения данных. Модули Novoblade объединяют вычислительные возможности, ускорители и хранилища. Основной модулей являются гибридные SoC AMD Versal AI Edge Gen 2 (для ИИ-нагрузок) или Versal Prime Gen 2 (для традиционных вычислений) c FPGA, 96 Гбайт DDR5, 32 Гбайт eMMC, модулем TPM2 и двумя интерфейсам 10/25GbE с RoCE v2 RDMA и TSN. Энергопотребление не превышает 60 Вт. Есть функции шифрования накопителей, декодирования видео, ускорения ИИ-обработки, оркестрации контейнеров и т.д. Платформа специально разработана для задач с большими объёмами данных, таких как геномика, геопространственная визуализация, видеоархивация и периферийные ИИ-вычисления. Сервер может работать под управлением стандартных дистрибутивов Linux (RHEL и Ubuntu LTS) с поддержкой Docker, Podman, QEMU/KVM, Portainer и OpenShift. 2U-шасси глубиной 1000 мм рассчитано на установку до двадцати модулей Novodisq и оснащено двумя (1+1) БП мощностью 2600 Вт каждый (48 В DC). Возможно горизонтальное масштабирование с использованием каналов 100–400GbE. В базовой конфигурации шасси включает четыре 200GbE-модуля с возможностью горячей замены, каждый из которых имеет SFP28-корзины, а также управляемый L2-коммутатор. Предусмотрен набор средств управления, включая BMC с веб-интерфейсом, CLI и поддержкой API Ansible, SNMP и Redfish. Novoblade поддерживает локальное и удалённое управление, может интегрироваться в существующий стек или предоставляться с помощью инструментов «инфраструктура как код» (Infrastructure-as-Code). По словам разработчика, система Novoblade обеспечивает плотность размещения примерно в 10 раз выше, чем у сервера на основе жестких дисков, и снижает энергопотребление на 90–95 % без необходимости в механическом охлаждении. Novodisq утверждает, что общая стоимость владения системой «обычно на 70–90 % ниже, чем у традиционных облачных или корпоративных решений в течение 5–10 лет». «Это обусловлено несколькими факторами: уменьшенным пространством в стойке, низким энергопотреблением, отсутствием платы за передачу данных, минимальным охлаждением, длительным сроком службы и значительным упрощением управления. В отличие от облака, ваши расходы в основном фиксированы, а значит, предсказуемы, и, в отличие от традиционных систем, Novodisq не требует дорогостоящих лицензий, внешних контроллеров или постоянных циклов обновления. Вы получаете высокую производительность, долгосрочную надёжность и более высокую экономичность с первого дня», — приводит Blocks & Files сообщение компании. Для сравнения, узлы Dell PowerScale F710 и F910 на базе 144-Тбайт Solidigm SSD ёмкостью 122 Тбайт, 24 отсеками в 2U-шасси и коэффициентом сжатия данных 2:1 обеспечивают почти 6 Пбайт эффективной емкости, что почти вдвое меньше, чем у сервера Novoblade.

12.08.2025 [11:15], Владимир Мироненко

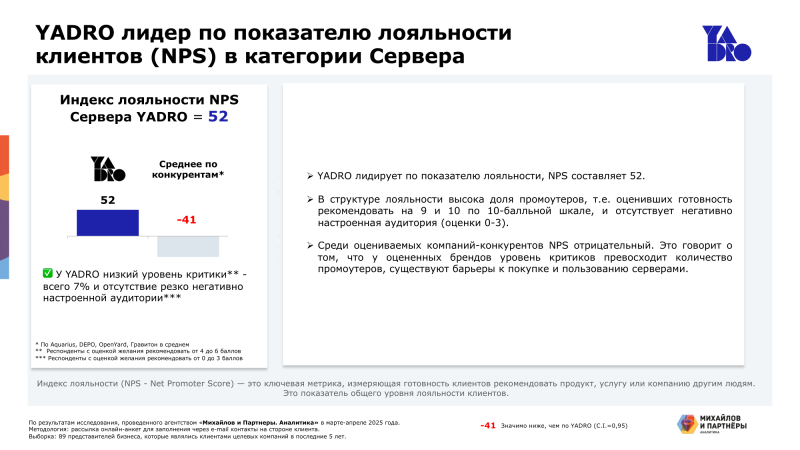

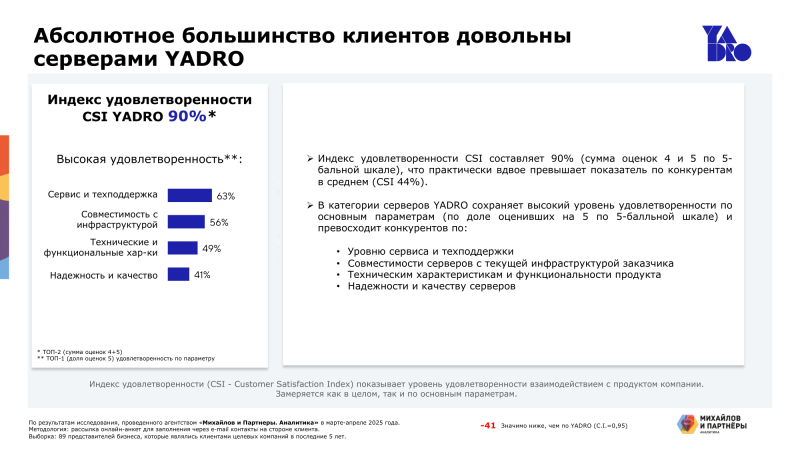

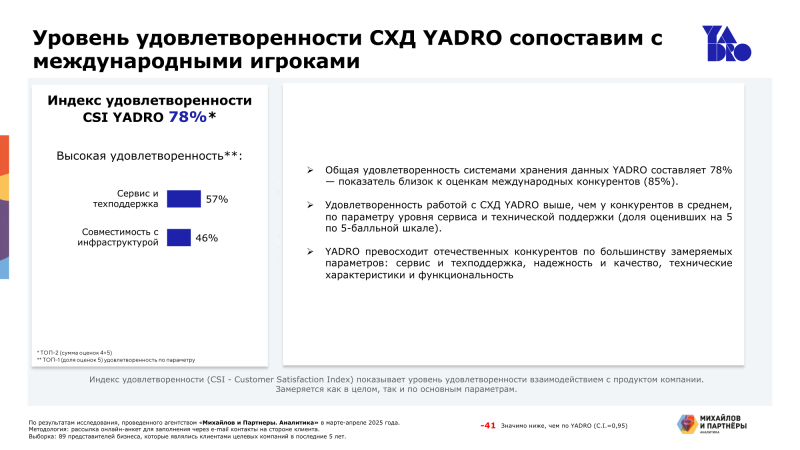

YADRO лидирует по показателю лояльности среди отечественных производителей серверов и СХДРешения YADRO в категориях серверы и СХД получили одни из самых высоких оценок лояльности среди российских и международных производителей, показав результаты, существенно превышающие среднерыночные значения. Об этом сообщили аналитики агентства «Михайлов и Партнеры. Аналитика» по итогам исследования лояльности и удовлетворенности заказчиков на основе индекса лояльности клиентов (NPS, Net Promoter Score) — одного из ключевых показателей, отражающих готовность рекомендовать продукт и влияющих на выбор поставщика. В исследовании, прошедшем в марте–апреле 2025 года, приняли участие российские заказчики оборудования для ЦОД, включая предприятия финансового сектора, промышленности, телекоммуникаций и ретейла. Всего было опрошено 89 представителей бизнесов заказчиков из России, включая как пользователей продуктов YADRO, так и клиентов других российских и международных производителей. Показатель NPS для серверов YADRO составил +52 при среднем значении −41 у конкурентов. В сегменте СХД индекс NPS компании равен +33, что соответствует показателю крупнейших международных вендоров и заметно выше среднего показателя отечественных производителей (−42). Среди факторов, определяющих удовлетворенность заказчиков, важнейшим считается сервис и техническая поддержка: 63 % респондентов в категории серверов и 57 % в категории СХД выразили полную удовлетворенность уровнем клиентского сервиса и технической поддержки YADRO, назвав их ключевым преимуществом вендора. Также высокую оценку получила совместимость с инфраструктурой: 56 % пользователей серверов и 46 % пользователей СХД положительно оценили удобство интеграции решений YADRO в существующую ИТ-инфраструктуру. Примерно половина (49 %) пользователей серверов выделили высокую производительность и функциональные возможности оборудования компании. 41 % клиентов в сегменте серверов подчеркнули стабильную работу и отказоустойчивость продуктов YADRO, что говорит о надёжности и высоком качестве её оборудования. YADRO продолжает укреплять свои позиции, инвестировав более 60 млрд руб. в разработку собственных решений. В настоящее время у неё в разработке находится около 30 новых продуктов. В этом году YADRO уже представила целый ряд технологических новинок. В их числе — All-Flash СХД TATLIN.AFA с end-to-end NVMe-архитектурой, рассчитанная на выполнение ресурсоёмких задач, таких как работа с высоконагруженными базами данных, машинное обучение и ИИ. Также был анонсирован сервер VEGMAN R220S четвёртого поколения — новое решение в линейке YADRO. Выпуск ключевого обновления ПО для коммутаторов KORNFELD существенно расширил возможности по развёртыванию и интеграции сетевых решений компании. YADRO обеспечивает возможность заказчикам построить полноценную ИТ-инфраструктуру на базе единого вендора — от серверов и СХД до сетевых решений. Это гарантирует стабильность, высокую производительность и надёжность всех компонентов с минимальными затратами времени и ресурсов на их интеграцию.

07.08.2025 [10:00], Владимир Мироненко

«Кит-системс» использовал для модернизации инфраструктуры решения YADROКомпания YADRO объявила о завершении поставки серверного и инфраструктурного оборудования для интегратора «Кит-системс». Ключевые ИТ-сервисы интегратора теперь используют отечественную технологическую платформу на базе серверов VEGMAN и СХД TATLIN. Миграция на решения YADRO была выполнена в рамках стратегической трансформации ИТ-инфраструктуры «Кит-системс», включающей переход на надёжную, масштабируемую и полностью отечественную аппаратную платформу для развития внутренних сервисов и новых направлений бизнеса. Выбор «Кит-системс» пал на решения YADRO не только из-за производительности и надёжности, но и благодаря доступности долгосрочной технической поддержки. Немаловажную роль также сыграл опыт эксплуатации в предыдущих проектах и позитивные отзывы заказчиков, использующих решения YADRO в своих ИТ-инфраструктурах. «Мы особенно ценим, что выбор YADRO был сделан на основе практического опыта и обратной связи от наших заказчиков. Решения, которые доказали свою эффективность в реальных проектах, становятся основой для новых инфраструктур — надёжных, масштабируемых и технологически зрелых. Это важный показатель зрелости отечественного ИТ-рынка и доверия к нашим разработкам», — подчеркнул Павел Егоров, директор по продуктам YADRO. В основе новой инфраструктуры «Кит-системс» лежат высокопроизводительные серверы YADRO VEGMAN R220 G2, использование которых гарантирует стабильную работу ключевых сервисов, высокую скорость обработки данных и надёжную защиту информации. Надёжное хранение данных обеспечивается с помощью компактного all-flash решения TATLIN.FLEX.TWIN с 24-дисковым массивом. Обладая компактными размерами, система обеспечивает высокую производительность и отказоустойчивость, поддерживает блочный и файловый доступ, предлагая расширенные механизмы защиты данных. На данный момент на платформе хранится около 20 Тбайт данных, тогда как общий объём корпоративного хранилища составляет 250 Тбайт. После успешного завершения тестовых испытаний «Кит-системс» перевёл на новую платформу свои ключевые ИТ-сервисы: служба каталогов AD, системы DNS и DFS и программное обеспечение для управления ресурсами. Всего на миграцию потребовалось менее двух месяцев, включая перенос корпоративных сервисов и данных.

05.08.2025 [11:28], Владимир Мироненко

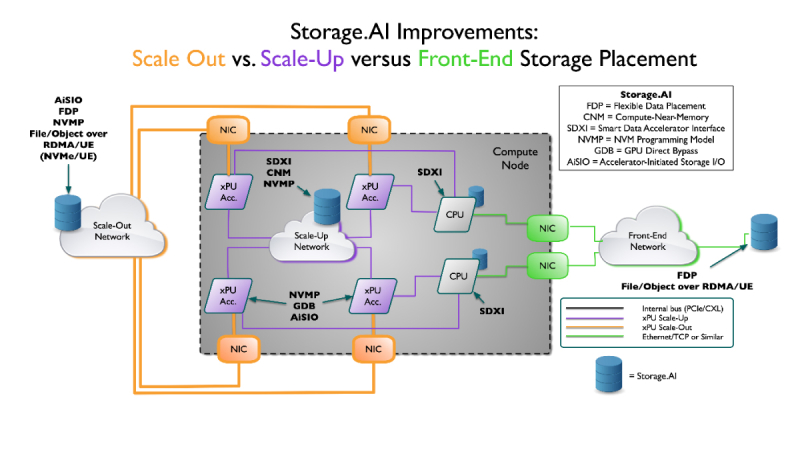

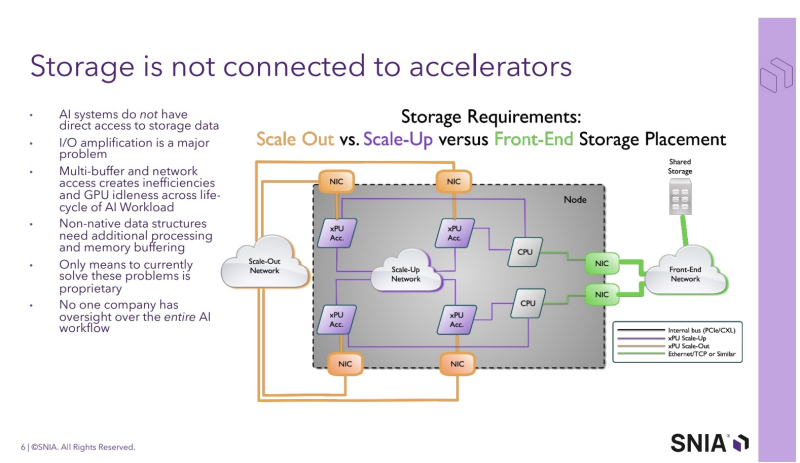

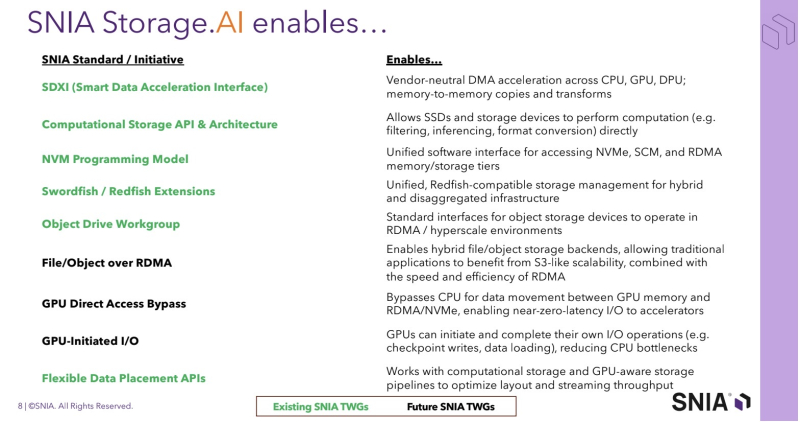

SNIA анонсировала проект Storage.AI для стандартизации обработки ИИ-нагрузокStorage Networking Industry Association (SNIA) — некоммерческая организация, специализирующаяся на технологиях обработки и оптимизации данных — анонсировала проект Storage.AI, основанный на открытых стандартах для эффективных сервисов обработки данных, связанных с рабочими ИИ-нагрузками. Проект будет сфокусирован на стандартных для отрасли, непатентованных и нейтральных подходах к решению задач, связанных с обработкой данных для ИИ, с целью оптимизации производительности, энергоэффективности и экономичности соответствующих рабочих процессов. К инициативе уже присоединились AMD, Cisco, DDN, Dell, IBM, Intel, KIOXIA, Microchip, Micron, NetApp, Pure Storage, Samsung, Seagate, Solidigm и WEKA. Отдельно отмечается отсутствие NVIDIA — крупнейшего поставщика ИИ-ускорителей. Как указано в пресс-релизе, рабочие ИИ-нагрузки чрезвычайно сложны и ограничены такими факторами, как задержки, доступное пространство, энергопотребление и охлаждение, объём памяти и стоимость. Решение этих проблем в рамках открытой отраслевой инициативы рассматривается как наиболее быстрый путь к оптимизации и широкому внедрению ИИ. По словам Дж. Метца (J Metz), председателя SNIA, беспрецедентные требования со стороны ИИ требуют целостного взгляда на весь конвейер данных — от храненилищ и памяти до сетевых технологий и вычислений. Он подчеркнул, что Storage.AI предоставляет отраслевому сообществу независимую от вендоров платформу, предназначенную для координации широкого спектра сервисов обработки данных и создания эффективных, открытых решений, необходимых для ускоренного внедрения ИИ-технологий. Инициатива координирует ряд технических спецификаций, которые до сих пор существовали обособленно и не были адаптированы под нужды ИИ-нагрузок. Первоначальный набор спецификаций включает:

Предполагается, что в рамках проекта Storage.AI будет создана открытая экосистема эффективных сервисов обработки данных, способных справляться с наиболее сложными задачами, связанными с ИИ-нагрузками, и устранять текущие пробелы в обработке и доступе к данным. В обеспечении широкой поддержки экосистемы также примут участие партнёры SNIA, включая UEC, NVM Express, OCP, OFA, DMTF и SPEC.

23.07.2025 [09:37], Владимир Мироненко

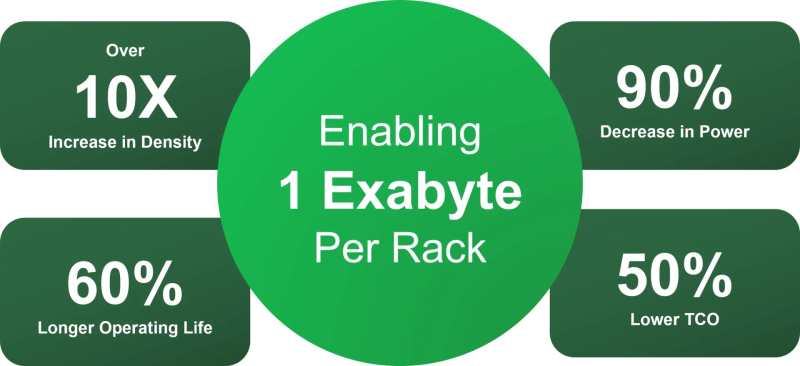

SSD не нужны: OFP обещает на порядок повысить плотность All-Flash СХД и наполовину снизить расходы на инфраструктуруИнициатива Open Flash Platform (OFP) призвана полностью пересмотреть работу с флеш-памятью в ИИ ЦОД. Участники OFP — Hammerspace, Linux Foundation, Лос-Аламосская национальная лаборатория (LANL), ScaleFlux, SK hynix и Xsight Systems — намерены отказаться от традиционных All-Flash хранилищ и контроллеров. Вместо них предложено использовать флеш-картриджи с минимумом аппаратной начинки, а доступ к таким массивам предоставлять посредством DPU и pNFS. Как отмечено в пресс-релизе, OFP отвечает многим фундаментальным требованиям, возникающим в связи со следующим этапом развития СХД для ИИ. Для ИИ требуются поистине огромные массивы данных, но вместе с тем ЦОД сталкиваются с дефицитом энергии, повышением температуры и недостатком свободного места. Именно поэтому в OFP решили, что инфраструктуры хранения для ИИ лучше разработать с чистого листа. Если 10 лет назад технология NVMe вывела флеш-память на новый уровень производительности благодаря отказу от устаревших шин данных и контроллеров, то теперь OFP обещает раскрыть возможности флеш-памяти, исключив посредников в виде серверов хранения и проприетарных программных стеков. OFP же опирается на открытые стандарты и open source решения, в частности, Parallel NFS (pNFS) и стандартный Linux, для размещения флеш-памяти непосредственно в SAN. А отказ от традиционных СХД обеспечит на порядок большую плотность размещения данных, существенную экономию энергии и значительно более низкую совокупную стоимость владения. OFP отметила, что существующие решения изначально привязаны к модели сервера хранения, которая требует чрезмерных ресурсов для повышения производительности и возможностей. Конструкции всех современных поставщиков AFA не оптимизированы для достижения максимальной плотности размещения флеш-памяти и привязаны к сроку службы CPU (обычно пять лет), тогда как срок службы флеш-памяти в среднем составляет восемь лет. Эти серверы хранения также предлагают проприетарные структуры и уровни хранения данных, что приводит к увеличению количества копий данных и добавлению расходов на лицензирование для каждого узла. Комментируя инициативу, ресурс Blocks & Files отметил, что Pure Storage и другие поставщики AFA уже предлагают оптимизированные схемы лицензирования и подписки, в том числе с обновлением контроллеров и дисковых полок. Та же Pure Storage предлагает более высокую плотность хранения, чем многие другие поставщики, хотя и использует проприетарные решения. Поддержкой DPU тоже удивить нельзя. Например, VAST Data уже поддерживает работу своего ПО на NVIDIA BlueField-3. А большинство поставщиков флеш-массивов и так поддерживают RDMA и GPUDirect. OFP выступает за открытый, основанный на стандартах подход, включающий несколько основных элементов:

Благодаря использованию открытых архитектур и компонентов, соответствующих отраслевым стандартам, реализация OFP приведёт к значительному повышению эффективности хранения данных, утверждают основатели инициативы. Так, обещано десятикратное увеличение плотности размещения данных, что позволит «упаковать» в одну стойку 1 Эбайт, попутно снизив энергопотребление на 90 %, увеличив срок службы флеш-памяти на 60 % и уменьшив совокупную стоимость владения (TCO) на 60 % по сравнению со стандартными массивами хранения. По мнению Blocks & Files, в текущем виде OFP выглядит скорее как маркетинговая инициатива, от которой в первую очеред выиграют её участники. Концепция же «сетевых» SSD сама по себе не нова. Весной Kioxia показала SSD с «оптикой». Да, тут речь идёт скорее о блочном доступе и NVMe-oF, но, например, Nimbus Data в прошлом году представила ExaDrive EN с поддержкой NFS. |

|