Материалы по тегу: стандарты

|

16.02.2026 [16:47], Руслан Авдеев

Для безопасности и совместимости: IT-гиганты сформировали трансграничное объединение Trusted Tech AllianceВ ходе мероприятия Munich Security Conference мировые лидеры в сфере IT-технологий и ключевые игроки ИИ-рынка заключили соглашение о создании объединения Trusted Tech Alliance (TTA), объединяющего 15 компаний, из Африки, Азии, Европы и Северной Америки для продвижения общих принципов безопасных и совместимых технологий, сообщает Converge! Digest. Интересы группы охватывают весь цифровой стек, от технологий связи до облачных решений и полупроводников, ПО и ИИ. Объединение позиционируется, как трансграничная коалиция, ориентированная на прозрачность, безопасность и защиты данных на фоне растущей геополитической фрагментации. Среди основателей числятся AWS, Microsoft, Google Cloud, Nokia, Ericsson и Anthropic, а также Cassava Technologies, Cohere, Hanwha Group, Jio Platforms, Nscale, NTT, Rapidus, Saab и SAP. От участников объединения требуется соблюдение пяти принципов: прозрачное корпоративное управление, безопасные методы разработки, контроль цепочки поставок, открытость и устойчивость цифровых экосистем, уважение верховенства закона и защиты данных. Участники обязаны применять обязывающие на уровне контрактов гарантии обеспечения надёжности и качества в отношениях поставщиков и поддерживать независимые механизмы оценки.

Источник изображения: krakenimages/unsplash.com Группа подчёркивает, что будет работать с лицами, принимающими решения (ЛПР), и клиентами, чтобы согласовать доверенные технологические практики с целью обеспечения национальной безопасности и экономической конкурентоспособности. Также планируется расширить членство в TTA и сформировать унифицированные подходы к разработке совместимых глобальных технологических стандартов. 15 основателей находятся в десяти странах на четырёх континентах. По словам Ericsson, ни одна компания или страна не может создать безопасный и надёжный цифровой стек в одиночку — доверия и безопасности можно добиться только совместно. Лидеры TTA позиционируют инициативу как ответ на растущий скептицизм, касающийся цифровых технологий и роста спроса со стороны правительств и корпоративных клиентов на надёжную, суверенную и безопасную инфраструктуру. Как отмечает Converge, создание TTA отражает ускоренное согласование позиций между облачными гиперскейлерами, телеком-вендорами, разработчиками ИИ-моделей и игроками полупроводникового рынка по мере того, как правительства ужесточают требования, касающиеся суверенитета данных, прозрачности цепочек поставок и управления ИИ-проектами. С учётом того, что участники контролируют ключевые точки ИИ-рынка, от Rapidus, предлагающей передовые решения для разработки ИИ-полупроводников до Anthropic и Cohere, разрабатывающих передовые модели, речь фактически идёт о том, что TTA берёт под контроль важнейшие узлы индустрии в стеке ИИ-инфраструктуры, пытаясь переформатировать стандарты до того, как «нормативная фрагментация» между регионами ужесточится.

20.11.2025 [09:34], Владимир Мироненко

Представлены спецификации CXL 4.0: PCIe 7.0, агрегация портов и поддержка четырёх ретаймеровКонсорциум CXL Consortium объявил о выходе спецификации Compute Express Link (CXL) 4.0, которая более соответствует растущим требованиям рабочих нагрузок в современных ЦОД. По словам Дерека Роде (Derek Rohde), президента CXL Consortium, также занимающего пост главного инженера в NVIDIA, выпуск спецификации CXL 4.0 открывает новую веху в развитии когерентной работы с памятью, удваивая пропускную способность по сравнению с предыдущим поколением и предлагая новые функции. Он отметил, что выпуск отражает стремление компаний-членов консорциума продвигать открытые стандарты, которые способствуют инновациям и открывают всей отрасли возможность масштабироваться для будущих моделей использования. Новый стандарт CXL 4.0 получил поддержку линий с пропускной способности в 128 ГТ/с, что вдвое больше по сравнению с предыдущим, причём без увеличения задержки. Фактически стандарт приведён в соответствие с PCI Express 7.0. Также были сохранены ранее реализованные улучшения протокола CXL 3.0: FLIT-кадры размером 256 байт, FEC и CRC. Сохраняется и полная обратная совместимость со всеми предыдущими версиями — CXL 3.x, 2.0, 1.1 и 1.0. Впрочем, тут есть нюансы. В CXL 4.0 появилась агрегация физических портов (Bundled Ports) в один логический порт, позволяющая одному устройству Type 1/2 одновременно подключаться к нескольким root-портам хоста или коммутатора для увеличения пропускной способности. При этом один из физических портов должен быть полнофункциональным, тогда как остальные порты могут быть оптимизированы исключительно для передачи данных. Агрегированные порты также поддерживают 256-байт FLIT-режим, но как минимум один физический порт должен поддерживать 68-байт режим ради обратной совместимости. Также спецификация реализует поддержку до четырёх ретаймеров для увеличения дальности передачи сигнала, повышение надёжности (RAS), снижение количества возможных ошибок, а также более детальные и актуальные отчёты о проблемах. Кроме того, появилась функция Post Package Repair (PPR), позволяющая хосту инициировать проверку устройства во время загрузки, т.е. до запуска рабочих нагрузок. Комментируя выход CXL 4.0, Alibaba заявила, что как член-учредитель консорциума CXL, она активно поддерживает экосистему CXL: «Мы рады выпуску CXL 4.0, поддерживающей PCIe 7.0 и объединение портов, что отвечает растущим требованиям к пропускной способности памяти для современных облачных рабочих нагрузок. Кроме того, CXL 4.0 повышает надёжность и удобство обслуживания памяти благодаря расширенным возможностям оповещения об ошибках и резервирования памяти. Мы считаем, что CXL 4.0 представляет собой еще одну важную веху на пути к компонуемым, масштабируемыми надёжным стоечным архитектурам для ЦОД нового поколения».

08.11.2025 [12:53], Сергей Карасёв

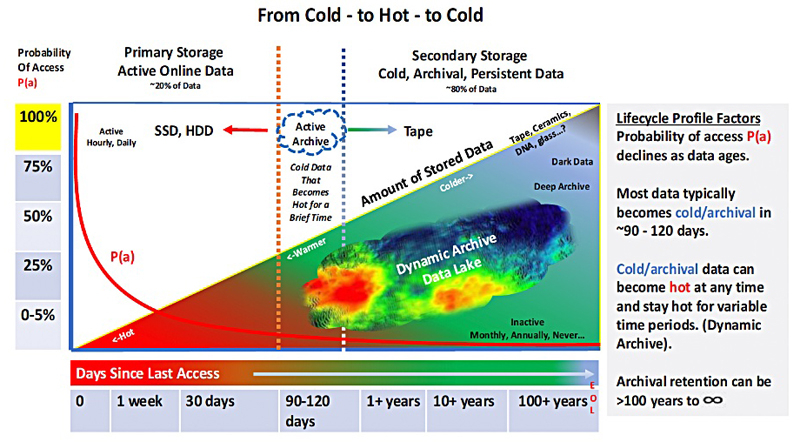

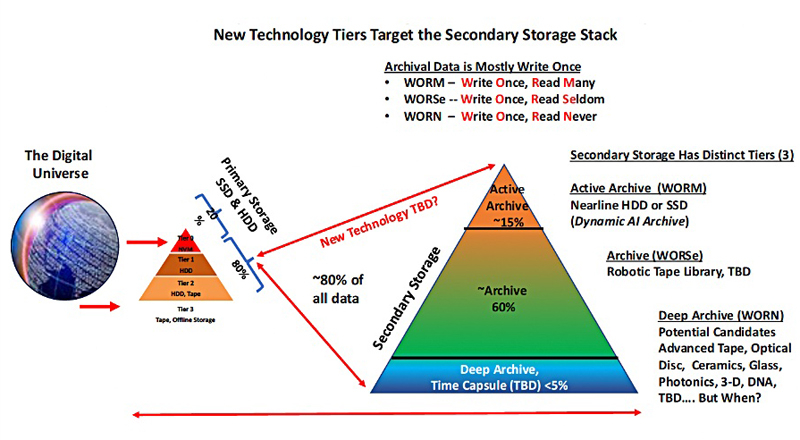

WORM, WORSe и WORN — определены три уровня архивного хранения данных для ИИ-системОрганизация Active Archive Alliance, по сообщению ресурса Blocks & Files, определила три основных уровня архивного хранения данных в эпоху ИИ. Предложенная концепция поможет преобразовать архивы из пассивных хранилищ в активные механизмы с возможностью быстрого извлечения нужных сведений. Active Archive Alliance — это отраслевая группа, сформированная в 2010 году для продвижения концепции «активных архивов». Такие системы обеспечивают упрощённый и быстрый доступ к любым данным в любое время. В состав альянса входят Arcitecta, BDT Media Automation GmbH, Cerebyte, FujiFilm, IBM, Iron Mountain, MagStor, Point, Savartus, Spectra Logic, Wasabi, Western Digital и XenData.

Источник изображений: Horison Information Strategies / Blocks & Files Отмечается, что на фоне стремительного развития ИИ организациям в различных отраслях всё чаще требуется быстрый доступ к огромным объёмам исторической информации. Помочь в удовлетворении таких потребностей призван «активный архив». Архитектура таких платформ предполагает применение накопителей разных типов — SSD, HDD, оптических дисков и ленточных устройств. Распределение данных между ними управляется при помощи специального интеллектуального ПО. Сами накопители могут размещаться локально или в облаках. Предусмотрены различные слои архивирования: «горячие» (SSD, HDD), «тёплые» (HDD, оптические диски) и «холодные» (LTO). Данные по мере старения перемещаются от горячего до холодного слоя, но могут вернуться обратно в случае необходимости.  При этом Active Archive Alliance предлагает три уровня доступа к информации — WORM (Write Once, Read Many), WORSe (Write Once, Read Seldom) и WORN (Write Once, Read Never.) Первый предполагает однократную запись и многократное чтение, второй — однократную запись и редкое чтение, третий — однократную запись при практически полном отсутствии операций чтения. Эти уровни соответствуют трём типам хранилищ — активному, архивному и глубокому. Все они относятся к вторичным массивам, на которые, по оценкам, приходится около 80 % данных (ещё 20 % располагаются в первичных высокопроизводительных системах). Причём активный ярус хранения обеспечивает около 15 % ёмкости, архивный — 60 %, глубокий — только 5 %.

21.10.2025 [16:14], Руслан Авдеев

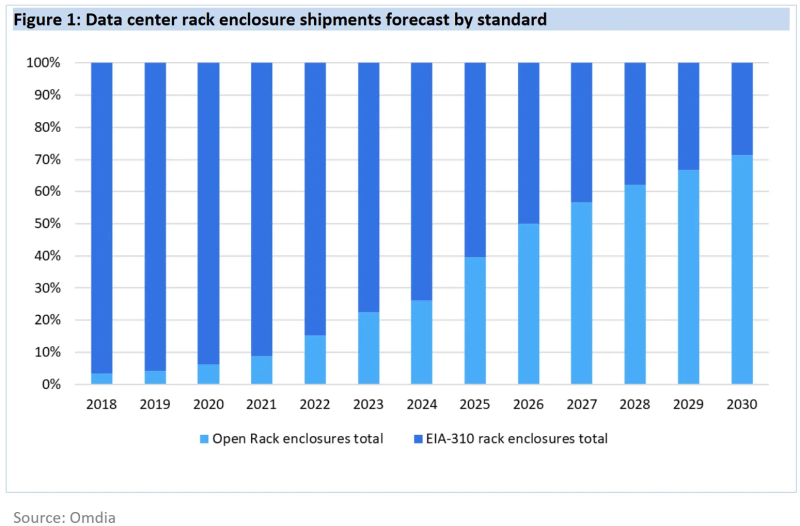

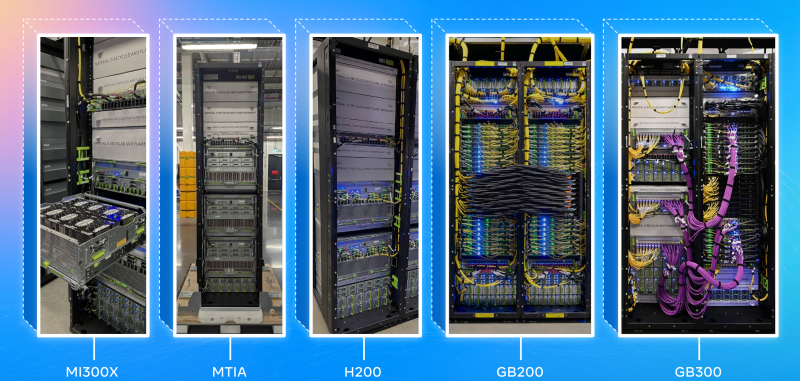

К 2030 году 21″ OCP-стойки станут доминирующим стандартом в ЦОДДата-центры намерены стандартизировать использование более крупных 21″ стоек вместо обычных 19″ к 2030 году. По данным Omdia, гиперскейлеры и производители серверов полностью поддерживают такой переход, а корпоративные ЦОД всё ещё будут придерживаться старого типоразмера, сообщает The Register. По некоторым данным, 19″ стойки (EIA-310) ведут свою «родословную» от релейных шкафов на железных дорогах — там подобный стандарт появился ещё до того, как его приняли телефонные компании, а позже и IT-индустрия. Meta✴ (Facebook✴) ещё в 2012 году столкнулась с ограничениями старого формата и основала OCP для того, чтобы организовать разработку и принятие более эффективных индустриальных стандартов. По прогнозам аналитиков, на более крупный формат, продвигаемый OCP, к концу десятилетия придётся более 70 % поставок, поскольку он активно внедряется крупными вендорами вроде Dell и HPE — одними из лидеров в гонке по выпуску ИИ-оборудования. По данным Omdia, на сегодня все крупнейшие сервис-провайдеры, включая Microsoft, Amazon, Meta✴, Google, ByteDance, Huawei и Oracle уже перешли на использование 21″ стоек в своих ЦОД. Так, Huawei ещё в 2019 году объявила, что её дата-центры будут опираться на 21″ стандарт.

Источник изображения: Meta✴ Преимуществами более крупных стоек является лучшая циркуляция воздуха и возможность устанавливать более крупные массивы вентиляторов, что улучшает охлаждение. Кроме того, такие стойки допускают установку более крупных модулей питания и трубок СЖО, что важно для ИИ-серверов. При этом сохраняется совместимость с 19″ решениями. В Omdia ожидают, что полностью укомплектованные стойки вроде NVIDIA DGX GB200 NVL72 станут фактическим стандартом. Кроме того, Dell и HPE продвигают предложенную OCP модульную серверную архитектуру Data Center Modular Hardware System (DC-MHS), которая позволяет по отдельности обновлять IO-модули и остальное «железо». Omdia прогнозирует, что на долю ИИ-серверов будет приходиться всё большая часть расходов на серверы в целом. Уже в 2024 году речь шла о 66 %, причём ключевые игроки рынка, включая гиперскейлеров и облачных ИИ-провайдеров, поддерживают именно 21″ стандарт, поэтому победа OCP над другими стандартами стала лишь вопросом времени.

16.10.2025 [13:39], Руслан Авдеев

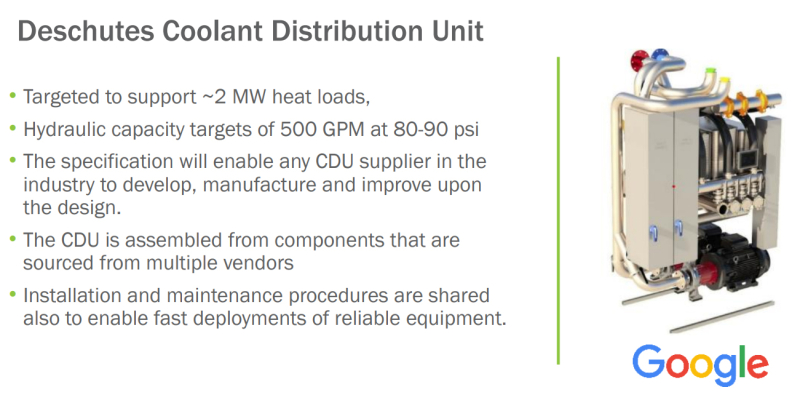

Унификация, стандартизация, совместимость: Google призвала создавать взаимозаменяемые компоненты для ИИ ЦОДВ ходе мероприятия OCP Summit компания Google выступила с общеотраслевой инициативой «переосмысления» архитектуры ЦОД, оптимизированных для эпохи ИИ. В рамках сообщества Open Compute Project (OCP) предлагается создать рабочее направление по разработке «гибких, взаимозаменяемых ЦОД», сообщает пресс-служба компании. Google подчеркнула, что скорость внедрения и неоднородность ИИ-технологий растёт, что затрудняет создание общей системы, проектирования, развёртывания и обслуживания ЦОД. Представленный Google проект предусматривает создание модульных, совместимых друг с другом решений для ЦОД, позволяющих легко адаптироваться к стремительному развитию ИИ и изменению рабочих нагрузок. Говорится о «начале революции» в сфере ИИ — мир радикально изменился и необходимо создавать дата-центры, способные меняться не менее быстро. По данным компании, за последние 24 месяца использование ИИ-ускорителей внутри Google увеличилось в 15 раз, объём хранилищ для машинного обучения Hyperdisk ML — в 37 раз, а количество обработанных токенов — до двух квадрлн/мес. В Google сравнивают исследователей ИИ с исследователями космоса, а участников OCP, строителей инфраструктуры — со строителями ракет. Сама инфраструктура компании, как утверждается, поддерживает ИИ-трансформацию на всех уровнях экосистемы, от пользовательских приложений (на основе Gemini) до корпоративных сервисов и научных изысканий в самых разных областях. Особое внимание уделяется обеспечению взаимозаменяемости и гибкости: модульные компоненты, спроектированные различными участниками отрасли, должны быть совместимы с компонентами и системами других поколений и вендоров, причём принципы унификации должны применяться ко всем компонентам ЦОД, включая электропитание, охлаждение, вычислительное оборудование, сетевые технологии и др. Стратегия самой Google строится вокруг т.н. ИИ-гиперкомпьютера — комплексной архитектуры, в которой все компоненты от чипов до электросетей разработаны с учётом общих особенностей системы для обеспечения максимальной эффективности. Благодаря использованию собственных TPU, оптических коммутаторов и СЖО, компания добилась роста энергоэффективности и снижения затрат в 10–100 раз за последние 10 лет. Google уже развернула мегаваттами инфраструктуры с жидкостным охлаждением. Компания вместе с партнёрами организовала в рамках OCP рабочую группу, целью которой является создание единых стандартов обеспечения модульности и совместимости компонентов, а также общих интерфейсов в области вычислений, сетей, хранилищ, безопасности и устойчивости. В частности, участники OCP договорились о разработке гибких систем электропитания для современных ЦОД. Речь идёт о стандартизации 400-В архитектур и модульных системах Mt. Diablo с использованием твердотельных преобразователей. Также ведутся работы в сфере микросетей и аккумуляторных хранилищ. Всё вместе это позволит сглаживать пики потребления энергии, характерные для обучения ИИ, а в перспективе и возвращать излишки энергии обратно в энергосети. Охлаждение также переосмысливается в эпоху ИИ. В начале 2025 года OCP представлено современное решение для жидкостного охлаждения Project Deschutes. Теперь оно получит широкое распространение среди вендоров, включая поставщиков жидкостного охлаждения вроде Boyd, CoolerMaster, Delta, Envicool, Nidec, nVent и Vertiv. Сообщество работает над унификацией интерфейсов охлаждения, новых теплообменников. Важную роль играет стандартизация компонентов и интерфейсов в колокейшн- и сторонних ЦОД. Наконец, Google подчёркивает необходимость унификации физических стандартов: высоты, ширины, глубины и даже грузоподъёмности стоек; ширины и планировки проходов, интерфейсов стоечного и сетевого оборудования. Также требуются единые стандарты для телеметрии и мехатроники, которые лягут в основу строительства и эксплуатации дата-центров следующего поколения. Совместно с партнёрами по OCP ведутся работы над стандартизацией интеграции телеметрии для сторонних дата-центров. Помимо физической инфраструктуры, по словам Google, необходимо внедрение открытых стандартов для обеспечения масштабируемости и безопасности систем:

Для измерения воздействия на окружающую среду предложена методология измерения потребления энергии, воды и подсчёта выбросов в ходе ИИ-нагрузок. В частности, с их помощью выяснилось, что медианный промпт Gemini тратит менее 5 капель воды и электричество в объёме, достаточном для просмотра телевизора в течение менее девяти секунд. Эти методы подсчёта касаются и других, совместных с OCP проектов, включая выпуск экобезопасного бетона, чистой резервной энергии и др. Google приглашает принять участие в инициативе OCP Open Data Center for AI Strategic для разработки общих стандартов. Наконец, сообщество OCP призвали работать над проектами «ИИ для ИИ» — использованием искусственного интеллекта для разработки ИИ-систем следующего поколения. Так, проект AlphaChip предусматривает использование ИИ для размещения компонентов чипов, что уже позволило улучшить показатели мощности, производительности и др., одновременно сократив время проектирования. Предполагается, что создание ИИ систем с помощью ИИ, от полупроводников до программного обеспечения, позволит достигнуть нового уровня эффективности технологий.

14.10.2025 [19:00], Сергей Карасёв

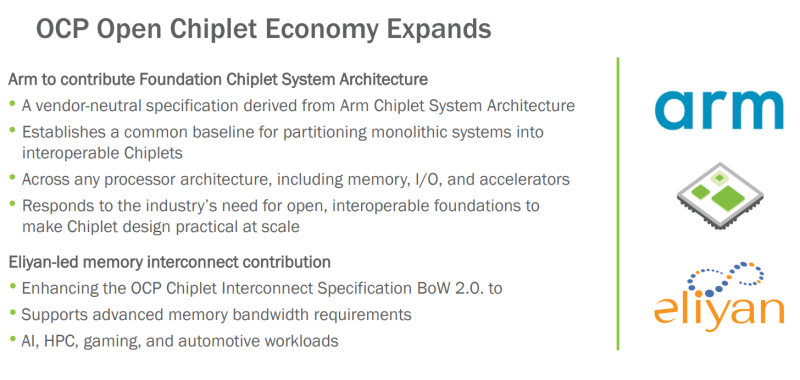

OCP поможет в унификации чиплетов с применением открытых стандартов: Arm и Eliyan поделились наработкамиНекоммерческая организация Open Compute Project Foundation (OCP) сообщила о расширении так называемой «открытой чиплетной экономики» (Open Chiplet Economy). Свои наработки в данной сфере сообществу передали компании Arm и Eliyan. Open Chiplet Economy — это инициатива OCP Server Project Group. Она позволяет разработчикам чиплетов посредством открытого рынка взаимодействовать с производителями продукции. Речь идет о формировании унифицированной экосистемы, за поддержание которой в актуальном состоянии отвечает OCP. В рамках проекта компания Arm передала организации OCP и её участникам архитектуру FCSA (Foundation Chiplet System Architecture), основанную на CSA (Chiplet System Architecture). Она определяет общие базовые стандарты для разделения монолитных систем на чиплеты, которые затем могут использоваться в составе различных изделий, включая память, устройства ввода-вывода и ускорители. Такой подход, как ожидается, упростит создание новых продуктов благодаря повторному использованию уже разработанных блоков. Кроме того, повысится гибкость за счёт отказа от привязки к проприетарным стандартам чиплетов. В свою очередь, Eliyan предоставит сообществу разработки, которые помогут расширить спецификацию интерконнекта для чиплетов OCP BoW 2.0 (Bunch of Wires). В частности, будут добавлены функции для систем, которым требуется высокая пропускная способность: это могут быть приложения ИИ, НРС, игры, автомобильные платформы и пр. Целевым показателем является поддержка скоростей памяти HBM4 (2 Тбайт/с для чтения или записи) вместе с дополнительным каналом связи для сигналов ECC и управления.

14.10.2025 [02:00], Сергей Карасёв

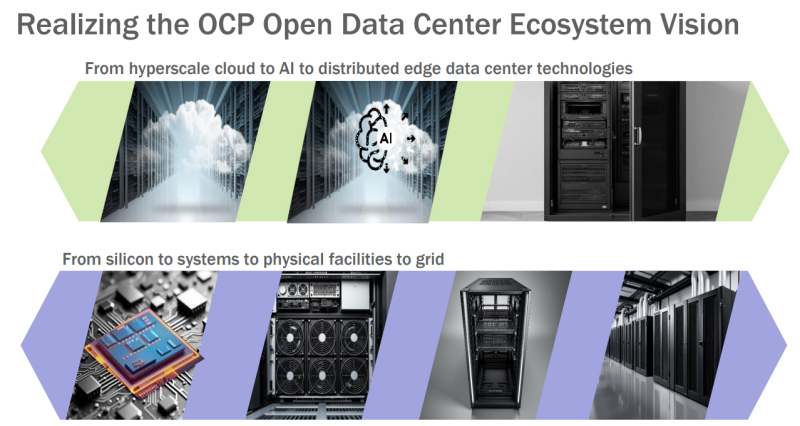

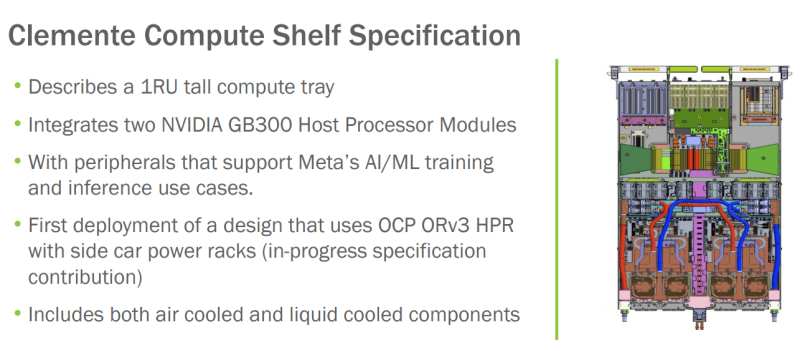

OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойкамиНекоммерческая организация Open Compute Project Foundation (OCP) анонсировала инициативу Open Data Center for AI по стандартизации компонентов физической инфраструктуры дата-центров, ориентированных на задачи ИИ и другие ресурсоёмкие нагрузки. Проект Open Data Center for AI является частью программы OCP Open Systems for AI, которая была представлена в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель заключается в разработке открытых стандартов для кластеров ИИ и ЦОД, в которых размещаются такие системы. Запуск Open Data Center for AI продиктован быстрым развитием экосистемы дата-центров, результатами, полученными в рамках OCP Open Systems for AI, и новым открытым письмом о сотрудничестве, подготовленным Google, Meta✴ и Microsoft. В настоящее время, как отмечается, отрасль ЦОД сталкивается с проблемами, связанными с тем, что разрозненные усилия её участников, включая гиперскейлеров и колокейшн-провайдеров, порождают различные требования к проектированию инфраструктуры. Это замедляет внедрение инноваций и увеличивает сроки развёртывания передовых площадок. Цель Open Data Center for AI заключается в том, чтобы стандартизовать требования к системам электропитания, охлаждения и телеметрии, а также к механическим компонентам в ЦОД. Предполагается, что это обеспечит взаимозаменяемость элементов физической инфраструктуры дата-центров. При реализации инициативы Open Data Center for AI планируется использовать уже имеющиеся наработки сообщества OCP в области блоков распределения охлаждающей жидкости (CDU) и блоков распределения питания (PDU). Это, в частности, проект Mt. Diablo, который реализуется Meta✴, Microsoft и Google. Он предполагает создание общих стандартов электрических и механических интерфейсов. Идея заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. При этом планируется переход от единой шины питания постоянного тока с напряжением 48 В на архитектуру 400 В DC (Diablo 400). Ещё одним проектом, наработки которого пригодятся в рамках Open Data Center for AI, назван CDU Deschutes, разработанный Google. Это решение с резервными теплообменниками и насосами обеспечивает уровень доступности 99,999 %. Система Deschutes рассчитана на тепловые нагрузки до 2 МВт. Открытая спецификация позволит любой компании совершенствовать конструкцию CDU и производить изделия данного типа. Наконец, упоминаются серверные шасси Clemente, разработанные в Meta✴. Это узлы 1U, содержащие два суперчипа NVIDIA Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Платформа предполагает применение жидкостного охлаждения для CPU, GPU и коммутатора, а также воздушного охлаждения для других компонентов.

11.08.2025 [10:46], Сергей Карасёв

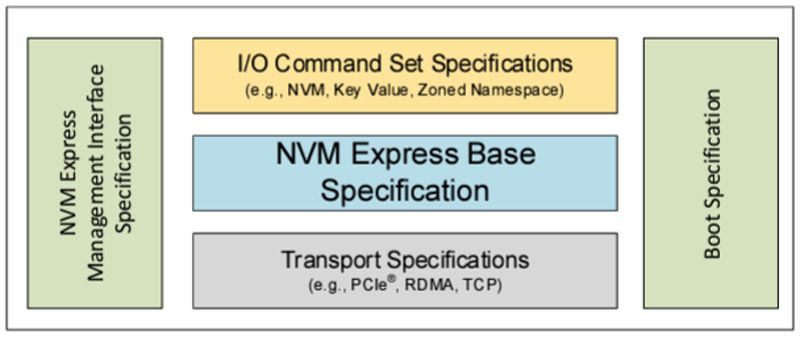

SSD под контролем: консорциум NVM Express обновил спецификации, добавив быстрое восстановление после сбоевКонсорциум NVM Express обнародовал ряд новых спецификаций, призванных ускорить и упростить разработку изделий с архитектурой NVMe. Реализованы функции, которые помогают в решении эксплуатационных задач, предоставляя администраторам улучшенную прозрачность и контроль над хранилищами для критически важных бизнес-приложений и нагрузок в дата-центрах. В частности, обновлены базовая спецификация NVMe 2.3, спецификация набора команд (NVM Command Set 1.2, ZNS Command Set 1.4, Key Value Command Set 1.3, Subsystem Local Memory Command Set 1.2, Computational Programs Command Set 1.2), транспортная спецификация (NVMe over PCIe Transport 1.3, NVMe over RDMA Transport 1.2, NVMe over TCP Transport 1.2), а также спецификации NVM Express Management Interface (NVMe-MI) 2.1 и NVMe Boot 1.3.

Источник изображения: NVM Express Одной из новых функций является восстановление после сбоев Rapid Path Failure Recovery. Этот инструмент обеспечивает связь с подсистемой NVM через альтернативные каналы, что позволяет быстро восстанавливать подключение в случае потери связи с контроллером, избегая повреждения данных и дублирования невыполненных команд. Кроме того, появилась возможность ограничения мощности (Power Limit Config): эта функция обеспечивает полный контроль над максимальной мощностью устройств NVMe, что особенно важно для старых платформ с ограниченным потенциалом в плане питания. В свою очередь, режим Self-reported Drive Power позволяет хосту измерять и контролировать мощность устройства NVMe, а также энергопотребление в течение всего срока его службы. Это помогает в решении вопросов, связанных с обслуживанием хранилищ и устойчивым развитием. Инструмент Sanitize Per Namespace обеспечивает криптографическую очистку отдельных пространств имен, не затрагивая всю подсистему NVM. Кроме того, упомянут механизм индивидуальной настройки устройств Configurable Device Personality.

05.08.2025 [11:28], Владимир Мироненко

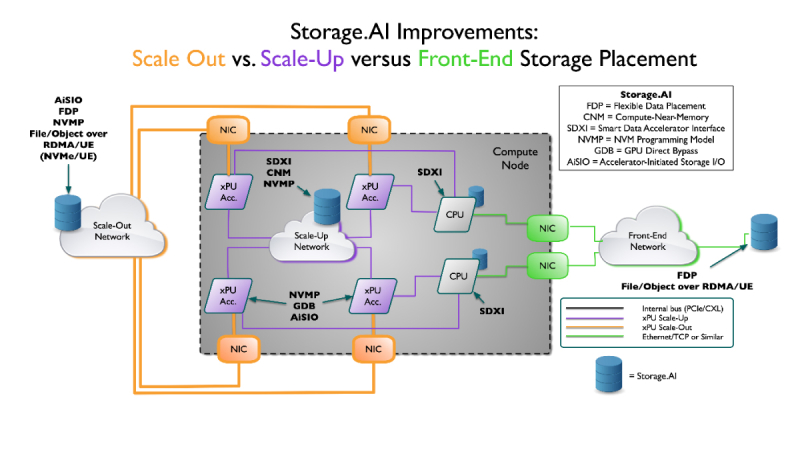

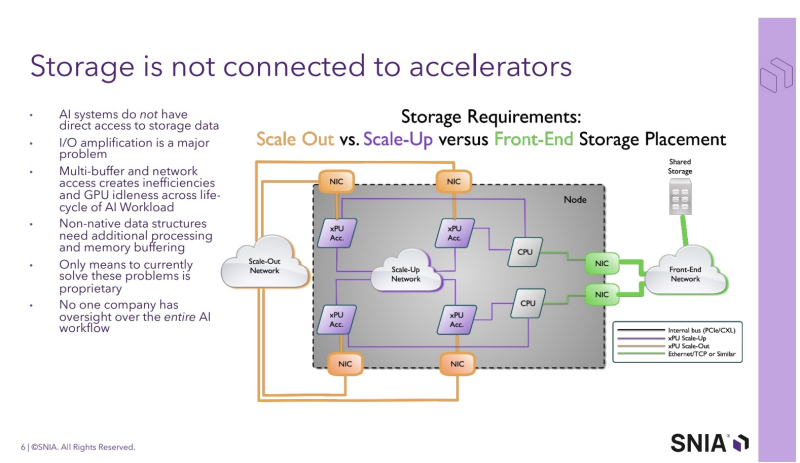

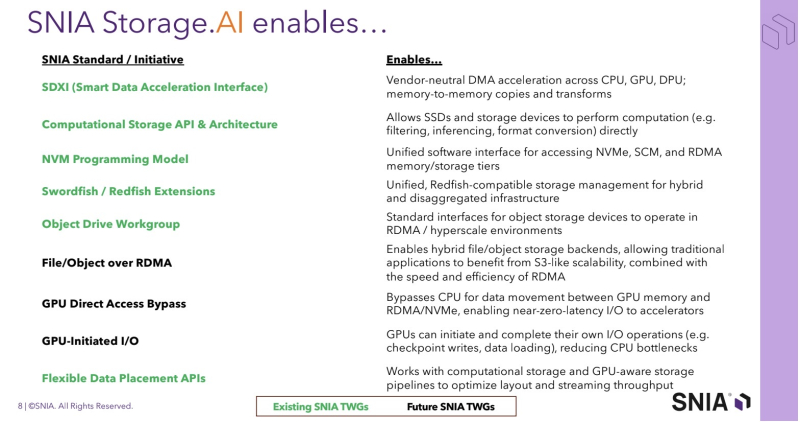

SNIA анонсировала проект Storage.AI для стандартизации обработки ИИ-нагрузокStorage Networking Industry Association (SNIA) — некоммерческая организация, специализирующаяся на технологиях обработки и оптимизации данных — анонсировала проект Storage.AI, основанный на открытых стандартах для эффективных сервисов обработки данных, связанных с рабочими ИИ-нагрузками. Проект будет сфокусирован на стандартных для отрасли, непатентованных и нейтральных подходах к решению задач, связанных с обработкой данных для ИИ, с целью оптимизации производительности, энергоэффективности и экономичности соответствующих рабочих процессов. К инициативе уже присоединились AMD, Cisco, DDN, Dell, IBM, Intel, KIOXIA, Microchip, Micron, NetApp, Pure Storage, Samsung, Seagate, Solidigm и WEKA. Отдельно отмечается отсутствие NVIDIA — крупнейшего поставщика ИИ-ускорителей. Как указано в пресс-релизе, рабочие ИИ-нагрузки чрезвычайно сложны и ограничены такими факторами, как задержки, доступное пространство, энергопотребление и охлаждение, объём памяти и стоимость. Решение этих проблем в рамках открытой отраслевой инициативы рассматривается как наиболее быстрый путь к оптимизации и широкому внедрению ИИ. По словам Дж. Метца (J Metz), председателя SNIA, беспрецедентные требования со стороны ИИ требуют целостного взгляда на весь конвейер данных — от храненилищ и памяти до сетевых технологий и вычислений. Он подчеркнул, что Storage.AI предоставляет отраслевому сообществу независимую от вендоров платформу, предназначенную для координации широкого спектра сервисов обработки данных и создания эффективных, открытых решений, необходимых для ускоренного внедрения ИИ-технологий. Инициатива координирует ряд технических спецификаций, которые до сих пор существовали обособленно и не были адаптированы под нужды ИИ-нагрузок. Первоначальный набор спецификаций включает:

Предполагается, что в рамках проекта Storage.AI будет создана открытая экосистема эффективных сервисов обработки данных, способных справляться с наиболее сложными задачами, связанными с ИИ-нагрузками, и устранять текущие пробелы в обработке и доступе к данным. В обеспечении широкой поддержки экосистемы также примут участие партнёры SNIA, включая UEC, NVM Express, OCP, OFA, DMTF и SPEC.

11.06.2025 [23:59], Игорь Осколков

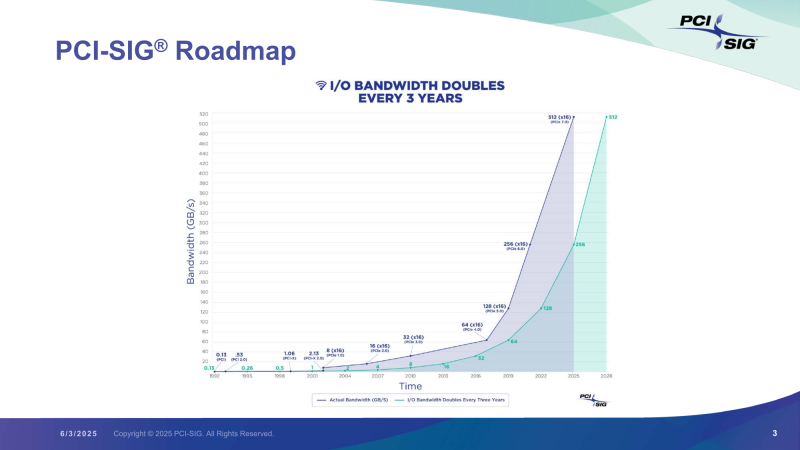

Представлена финальная спецификация PCI Express 7.0Консорциум PCI-SIG официально объявил о релизе спецификаций PCI Express 7.0 версии 1.0. Базовые характеристики интерфейса изменений не претерпели: «сырая» скорость 128 ГТ/с на линию, которая конвертируется в 512 Гбайт/с в двустороннем режиме в конфигурации x16; кодирование PAM4; поддержка Flit-режима; универсальность и обратная совместимость с предыдущими версиями PCIe; повышенная энергоэффективность; расширенная коррекция ошибок и т.д. Новый стандарт ориентирован на решения с интенсивным обменом данными, которым требуются низкая задержка, высокая скорость и повышенная надёжность: ИИ-платформы, 800G-сети, облака гиперскейлеров, квантовые системы и т.п. Впрочем, как и стандарты прошлого поколения, PCIe 7.0 сохранит гибкость, предоставляя 11 различных профилей, которые охватывают весь спектр возможных применений интерфейса, от мобильных платформ до HPC-систем. Консорциум придерживается выбранного темпа выпуска спецификаций — каждые три года появляется новый стандарт, который, по мнению PCI-SIG, всегда чуть опережает текущие потребности индустрии. Здесь есть два важных момента. Во-первых, PCI-SIG не пытается добиться максимально возможной скорости (за NVLink уже не угнаться), а старается дать максимум скорости по приемлемой цене. Во-вторых, уже сейчас разработчики IP говорят о возможных проблемах насыщения данными даже одной линии PCIe 7.0 в некоторых приложениях и сложностях физической и логической реализации нового интерфейса. Впрочем, до появления первых реальных продуктов с поддержкой PCIe 7.0 ещё долго. На 2027 год запланирован старт предварительного «тестирования на соответствие» (FYI, First Year Inventory Compliance Program), так что внедрение нового стандарта начнётся не раньше 2028 года. Внедрение PCIe 6.0, представленного ещё в январе 2022 года, тоже только-только начинается и займёт ещё год-два. Анонсированная почти два года назад оптическая версия PCIe продолжает разрабатываться. В PCIe 7.0 и PCIe 6.4 впервые были добавлены спецификации ретаймеров, которые позволят передавать сигнал PCIe по оптоволокну. Это позволит сделать интерконнект на базе PCIe значительно компактнее, чем при использовании традиционных медных соединений, а также позволит эффективно вывести PCIe за пределы узла. Впрочем, пока что речь идёт скорее о масштабах стойки или нескольких, а не целого ЦОД. |

|