Лента новостей

|

08.12.2023 [16:31], Сергей Карасёв

Gigabyte представила серверы с ускорителями AMD Instinct MI300 для задач ИИ и HPCКомпания Giga Computing (Gigabyte) анонсировала серверы G383-R80, G593-ZX1 и G593-ZX2 на аппаратной платформе AMD, предназначенные для решения ресурсоёмких задач: это могут быть приложения ИИ и HPC. Все новинки оборудованы ускорителями серии Instinct MI300. Модель G383-R80, выполненная в формате 3U, несёт на борту четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Во фронтальной части расположены 8 отсеков для SFF-накопителей NVMe SSD.

Источник изображений: Gigabyte Могут быть задействованы до 12 слотов расширения для карт FHFL с интерфейсом PCIe 5.0. Есть слот для SSD стандарта М.2 2280/22110 с интерфейсом PCIe 5.0 x4, два сетевых порта 10GbE (Broadcom BCM57416), выделенный порт управления 1GbE, контроллер Aspeed AST2600, два порта USB 3.2 Gen1 и разъём D-Sub. Питание обеспечивают четыре блока мощностью 2200 Вт каждый с сертификатом 80 Plus Titanium. Серверы G593-ZX1 и G593-ZX2, в свою очередь, имеют типоразмер 5U. Они комплектуются двумя процессорами AMD EPYC Genoa с показателем TDP до 300 Вт и восемью ускорителями Instinct MI300X OAM со 192 Гбайт памяти HBM3. Для модулей ОЗУ стандарта DDR5-4800 доступны 24 разъёма. Спереди находятся восемь отсеков для SFF-накопителей NVMe SSD.  Эти серверы оборудованы двумя слотами для SSD формата М.2 2280/22110 с интерфейсом PCIe 3.0 (по одному х1 и х4), двумя портами 10GbE (Intel X710-AT2), выделенным сетевым портом управления 1GbE, контроллером Aspeed AST2600, двумя портами USB 3.2 Gen1 и разъёмом D-Sub. Предусмотрены четыре слота PCIe 5.0 x16 для карт FHHL и восемь слотов PCIe 5.0 x16 для LP-карт. Версия G593-ZX1 получила восемь root-портов, модель G593-ZX2 — четыре. Установлены шесть блоков питания на 3000 Вт с сертификатом 80 Plus Titanium.

08.12.2023 [16:17], Сергей Карасёв

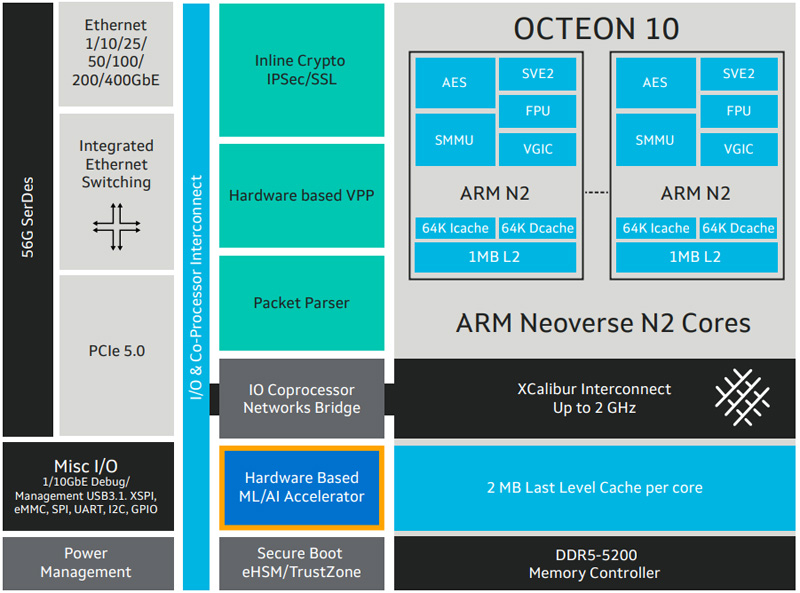

Marvell представила новые DPU серии Octeon 10Компания Marvell расширила семейство чипов Octeon 10, анонсировав изделия CN102 и CN103, которые относятся к классу DPU (Data Processing Unit). Новинки предназначены для построения высокопроизводительного сетевого оборудования, в частности, брандмауэров, маршрутизаторов, устройств SD-WAN, малых сот 5G, коммутаторов и пр. Представленные чипы объединяют до восьми 64-битных ядер Arm Neoverse N2 с частотой до 2,7 ГГц. Объём кеш-памяти L2/L3 составляет 8/16 Мбайт. Заявлена поддержка DDR5-5600 и интерфейсов PCIe 3.0 (у CN102) и PCIe 5.0 (только CN103). Изделия производятся по 5-нм техпроцессу. Утверждается, что они обеспечивают в три раза более высокую производительность по сравнению с решениями Marvell DPU предыдущего поколения при одновременном снижении энергопотребления на 50 % — до 25 Вт. Чипы могут применяться в качестве разгрузочного сопроцессора или в качестве основного процессора в сетевых устройствах.

Источник изображения: Marvell Модель CN102 имеет поддержку сетевых портов в следующей конфигурации: 4 × 10GbE + 2 × 10GbE или 16 × 1GbE. У версии CN103 схема такова: 4 × 50/25/10GbE + 2 × 10GbE или 16 × 1GbE. Энергопотребление составляет соответственно 10–20 Вт и 10–25 Вт. Старшая версия получила SerDes-блоки 56G. Среди прочего упомянуты аппаратное ускорение пакетов с оптимизацией VPP, поддержка IPsec и Secure Boot. Показатель SPECint (2017) достигает 37. Поставки образов Octeon 10 CN102 и CN103 уже начались, а массовое производство запланировано на IV квартал 2023-го и на I четверть 2024 года соответственно.

07.12.2023 [23:02], Владимир Мироненко

Dell выпустит серверы с ИИ-ускорителями AMD Instinct MI300XDell и AMD объявили о расширении портфеля решений Dell Generative AI Solutions с целью ускорения обработки сложных рабочих нагрузок и предоставления компаниям больше возможностей для развёртывания приложений генеративного ИИ. Новые решения включают серверы Dell PowerEdge XE9680 с ускорителями AMD Instinct MI300X. Сервер будет оснащён восемью ускорителями, что даст общую ёмкость HBM3 1,5 Тбайт и FP16-производительность более 10 Пфлопс. Использование PowerEdge XE9680 с MI300X позволит компаниям сократить занимаемую площадь в ЦОД, снизить совокупную стоимость владения и получить конкурентное преимущество, говорит Dell. Для масштабирования нагрузок компания предлагет Ethernet-фабрику с 400G-коммутаторами PowerSwitch Z9664F-ON. PowerEdge XE9680 поставляется с приложением Dell OpenManage Enterprise для администрирования и мониторинга систем. Также сообщается, что сервер обеспечивает высокую защищённость данных благодаря интегрированной киберзащите и использованию концепции Zero Trust.

Источник изображения: Dell Dell также пополнила платформу Dell Generative AI Solutions решением Dell Validated Design for Generative AI with AMD, которое упрощает надёжное развёртывание генеративного ИИ. Его выход ожидается в следующем году с ИИ-платформами на базе AMD ROCm и открытых больших языковых моделей (LLM). Dell PowerEdge XE9680 с ускорителями AMD Instinct MI300X и Dell Validated Design for Generative AI with AMD появится на рынке в I половине 2024 года.

07.12.2023 [21:04], Сергей Карасёв

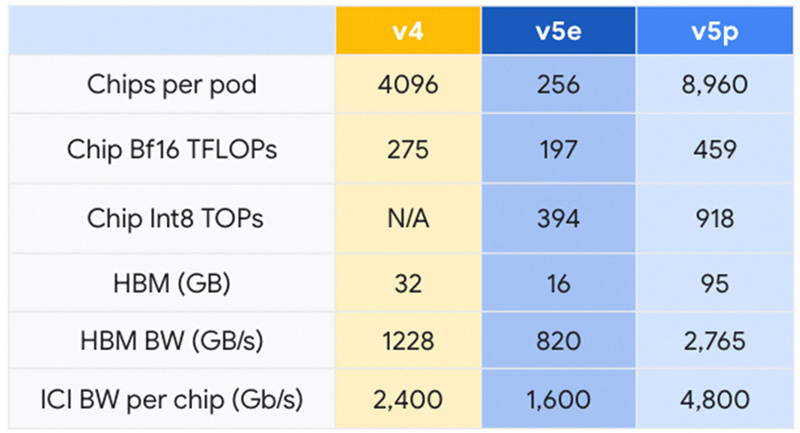

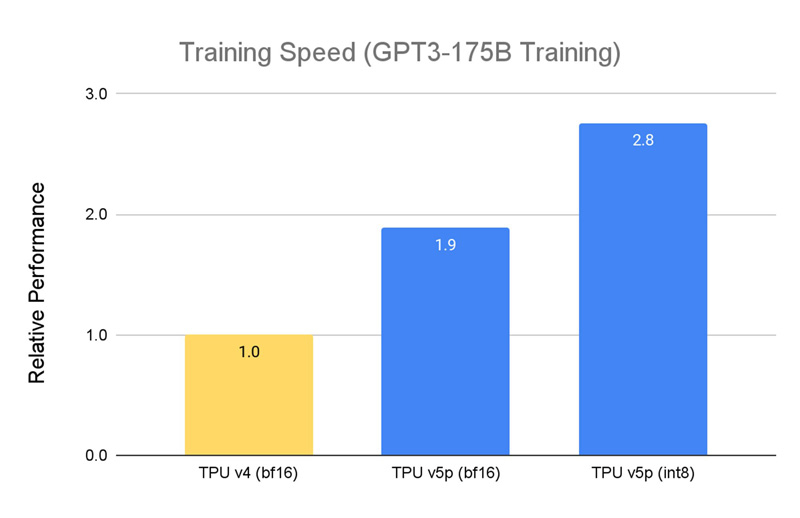

Google представила Cloud TPU v5p — свой самый мощный ИИ-ускорительКомпания Google анонсировала свой самый высокопроизводительный ускоритель для задач ИИ — Cloud TPU v5p. По сравнению с изделием предыдущего поколения TPU v4 обеспечивается приблизительно 1,7-кратный пророст быстродействия на операциях BF16. Впрочем, для Google важнее то, что она наряду с AWS является одной из немногих, кто при разработке ИИ не зависит от дефицитных ускорителей NVIDIA. К этому же стремится сейчас и Microsoft. Решение Cloud TPU v5p оснащено 95 Гбайт памяти HBM с пропускной способностью 2765 Гбайт/с. Для сравнения: конфигурация TPU v4 включает 32 Гбайт памяти HBM с пропускной способностью 1228 Гбайт/с.

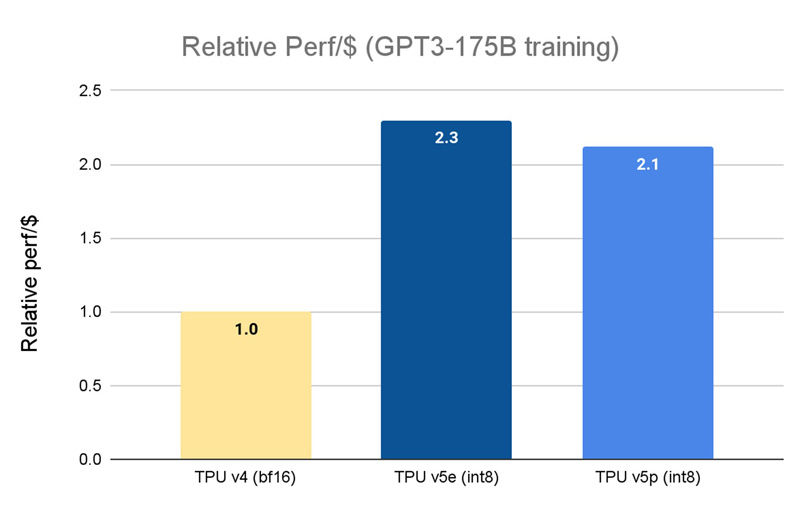

Источник изображений: Google Кластер на базе Cloud TPU v5p может содержать до 8960 чипов, объединённых высокоскоростным интерконнектом со скоростью передачи данных до 4800 Гбит/с на чип. В случае TPU v4 эти значения составляют соответственно 4096 чипов и 2400 Гбит/с. Что касается производительности, то у Cloud TPU v5p она достигает 459 Тфлопс (BF16) против 275 Тфлопс у TPU v4. На операциях INT8 новинка демонстрирует результат до 918 TOPS.  В августе нынешнего года Google представила ИИ-ускоритель TPU v5e, созданный для обеспечения наилучшего соотношения стоимости и эффективности. Это изделие с 16 Гбайт памяти HBM (820 Гбит/с) показывает быстродействие 197 Тфлопс и 394 TOPS на операциях BF16 и INT8 соответственно. При этом решение обеспечивает относительную производительность на доллар на уровне $1,2 в пересчёте на чип в час. У TPU v4 значение равно $3,22, а у новейшего Cloud TPU v5p — $4,2 (во всех случаях оценка выполнена на модели GPT-3 со 175 млрд параметров).  По заявлениям Google, чип Cloud TPU v5p может обучать большие языковые модели в 2,8 раза быстрее по сравнению с TPU v4. Более того, благодаря SparseCores второго поколения скорость обучения моделей embedding-dense увеличивается приблизительно в 1,9 раза. На базе TPU и GPU компания предоставляет готовый программно-аппаратный стек AI Hypercomputer для комплексной работы с ИИ. Система объединяет различные аппаратные ресурсы, включая различные типы хранилищ и оптический интерконнект Jupiter, сервисы GCE и GKE, популярные фреймворки AX, TensorFlow и PyTorch, что позволяет быстро и эффективно заниматься обучением современных моделей, а также организовать инференс.

07.12.2023 [20:49], Руслан Авдеев

Евросоюз готовит суверенный облачный проект с государственной поддержкой до €1,2 млрдЕврокомиссия намерена выделить до €1,2 млрд средств на финансирование проекта IPCEI Cloud. Как сообщает The Register, планируется привлечь ещё €1,4 млрд частных средств. Предполагается, что это позволит продвигать местные региональные интересы в секторе, контролируемом американскими IT-гигантами. Ожидается, что проект Important Project of Common European Interest (IPCEI) обеспечит серьёзный вклад в рост региона, позволит создать новые рабочие места, осуществить переход на «зелёные» и цифровые технологии и повысит конкурентоспособность местной промышленности и экономики. Основная проблема в том, что на облачном рынке Евросоюза доминируют игроки из США, включая AWS, Microsoft и Google. По данным Synergy Research, они сообща занимают уже 72 % рынка, а локальные провайдеры за пять снизили свою долю практически вдвое. Средства на получение облачного суверенитета выделят из фондов семи стран — участниц Евросоюза, включая Германию, Францию, Венгрию, Нидерланды, Италию, Польшу и Испанию. В рамках проекта предполагается объединить облачные и периферийные вычисления множества европейских игроков локального масштаба. Всего выделено четыре направления работы. В рамках первого займутся разработкой интерфейсов для уже существующей инфраструктуры, в рамках второго разработают «эталонную» архитектуру, позволяющую объединить мощности разных провайдеров. Ещё два направления предусматривают создание инструментов и приложений для связи облачной инфраструктуры в единую сеть.

Источник изображения: Christian Lue/unsplash.com Первые результаты должны появиться к концу 2027 года. Это, как рассчитывают в Евросоюзе, позволит создать 1 тыс. рабочих мест в ИИ-индустрии, сегментах, связанных с обеспечением кибербезопасности, разработкой и т.п. Ещё 5 тыс. мест появится, когда реализация проекта достигнет коммерческой фазы. Исследования, разработка и внедрение будут происходить с 2023 по 2031 гг. — участие принимают 19 компаний, включая SAP, Orange и Deutsche Telecom. Государственное финансирование смягчит негативный эффект в случае провала некоторых инициатив, а компании, разрабатывающие ПО с открытым кодом, обеспечат лицензии для его использования без ограничений всем заинтересованным сторонам. Кроме того, 20 % мощностей облачной инфраструктуры, финансируемой за счёт государства, необходимо будет выделить третьим сторонам, а если дела у получателей помощи не пойдут, компании должны будут вернуть предоставленные средства. К сожалению европейских властей, облачные и IT-проекты в регионе развиваются не так успешно, как могли бы. Например, общеевропейский облачный проект предложили реализовать ещё в 2019 году, но по данным на конец 2023 года, работы всё ещё не завершились. В конце 2021 года сообщалось о запуске в ЕС проекта Alliance for Industrial Data, Edge and Cloud без участия китайских и американских компаний. Кроме того, Brexit значительно повлиял на планы развития IT-индустрии в Европе.

07.12.2023 [20:34], Сергей Карасёв

CoreWeave привлекла более $640 млн для развития облачной ИИ-платформыКомпания CoreWeave, предоставляющая облачные услуги для решения ИИ-задач, сообщила о привлечении дополнительных инвестиций в размере $642 млн. Программу финансирование возглавляет Fidelity Management & Research Company при участии Investment Management Corporation of Ontario (IMCO), Jane Street, J. P. Morgan Asset Management, Nat Friedman & Daniel Gross, Goanna Capital, Zoom Ventures и др. CoreWeave, основанная в 2017 году, начинала свой бизнес с майнинга криптовалют, а затем сосредоточила внимание на вычислениях общего назначения и хостинге проектов генеративного ИИ. Затем компания переориентировалась на предоставление специализированных облачных ИИ-решений. Именно это направление CoreWeave активно развивает в настоящее время.

Источник изображения: CoreWeave В качестве аппаратной основы облачных сервисов CoreWeave выступают ускорители NVIDIA. В августе нынешнего года CoreWeave объявила о привлечении $2,3 млрд долгового финансирования под залог ускорителей NVIDIA. Причём полученные средства компания направит на закупку дополнительного аппаратного обеспечения той же NVIDIA. В апреле 2023-го CoreWeave получила $221 млн в рамках инвестиционной программы Series B, а позднее закрыла раунд финансирования ещё на $200 млн. «Индустрия искусственного интеллекта находится на переломном этапе, и CoreWeave сыграла ключевую роль в её развитии, предоставив клиентам дифференцированную инфраструктуру», — сказал Майкл Интратор (Michael Intrator), соучредитель и генеральный директор компании. CoreWeave, по её собственным заявлениям, интегрирует передовые ускорители, сетевые технологии и средства хранения данных в наиболее дифференцированную инфраструктуру ИИ. Компания обеспечивает облачный доступ к изделиям NVIDIA H100, а также A100, A40 и RTX A6000.

07.12.2023 [17:27], Сергей Карасёв

Adlink выпустила модуль COM Express Type 7 на базе AMD Ryzen Embedded V3000Компания Adlink Technology анонсировала модуль Express-VR7 в формате COM Express Type 7 с возможностью работы в широком температурном диапазоне — от -40 до +85 °C. Новинка подходит для создания периферийного сетевого оборудования и серверов, систем промышленной автоматизации, 5G-устройств и пр. В основу легла платформа AMD Ryzen Embedded V3000. Максимальная конфигурация включает процессор Ryzen V3C48 (8 ядер; 16 потоков; 3,3–3,8 ГГц; 45 Вт). Поддерживается до 64 Гбайт оперативной памяти DDR5-4800 ECC/non-ECC в виде двух модулей SO-DIMM. Для подключения накопителей можно задейстовать два порта SATA-3. Доступны 14 линий PCIe 4.0, два интерфейса 10GBASE-KR и один интерфейс 2.5GbE, четыре порта USB 3.x/2.0/1.1, по четыре интерфейса GPO и GPI, два порта UART. В оснащение включён модуль Infineon TPM 2.0. Кроме того, предусмотрена 40-контактная многоцелевая колодка для отладки. Размеры платы Express-VR7 составляют 125 × 95 мм. В оснащение включён контроллер SEMA Board для мониторинга напряжения/тока, управления режимами AT/ATX, контроля вентиляторов охлаждения и пр. Говорится о совместимости с Yocto Linux и Ubuntu 20.04.3 LTS. Новинка удовлетворяет требованиям стандартов IEC 60068-2-64, IEC-60068-2-27 и MIL-STD-202F в отношении стойкости к механическим внешним воздействующим факторам, включая вибрацию. В качестве аксессуаров предлагаются модули охлаждения, включая низкопрофильные радиаторы.

07.12.2023 [17:24], Сергей Карасёв

VAST Data провела новый раунд финансирования и почти утроила капитализацию — до $9,1 млрдКомпания VAST Data, специализирующаяся на разработке решений для управления данными, сообщила о проведении раунда финансирования Series E, в ходе которого на развитие привлечено $118 млн. В результате рыночная оценка стартапа выросла практически втрое, достигнув $9,1 млрд. Фирма VAST Data, основанная в 2016 году, предоставляет программную платформу, которую клиенты могут использовать для построения локальной инфраструктуры хранения данных. Решение позволяет осуществлять раздельное масштабирование СХД и вычислительных ресурсов, благодаря чему достигается экономия средств и энергии.

Источник изображения: VAST Data Кроме того, платформа VAST Data даёт возможность отказаться от многоуровневой архитектуры хранения на основе HDD и SSD в пользу только накопителей на основе флеш-памяти. Благодаря применению алгоритмов сжатия и дедупликации значительно возрастает эффективная ёмкость All-Flash хранилиша. Таким образом, по стоимости в расчёте на 1 Гбайт хранимой информации SSD становятся сопоставимыми с HDD, что позволяет полностью отказаться от последних. Платформа VAST Data оптимизирована для хранения неструктурированных данных, которые могут использоваться для обучения моделей ИИ. По заявлениям VAST Data, её инструменты управляют более чем 10 Эбайт информации для провайдера облачной ИИ-инфраструктуры CoreWeave и других клиентов. Средства в рамках раунда Series E предоставили Fidelity Management & Research Company, New Enterprise Associates (NEA), BOND Capital и Drive Capital. Деньги будут использованы для создания новой инфраструктуры, ставящей данные в центр внимания. В общей сложности на сегодняшний день VAST Data получила от инвесторов более $380 млн.

07.12.2023 [17:18], Сергей Карасёв

Scale Computing представила компактный компьютер HE153 на базе Intel Raptor Lake для периферийных вычисленийКомпания Scale Computing анонсировала первые устройства серии HE100, в основу которых положены компьютеры небольшого форм-фактора ASUS Next Unit of Computing (NUC). Решения, выполненные на платформе Intel Raptor Lake, предназначены для организации периферийных вычислений. Максимальная конфигурация включает процессор Core i7-1370P (6Р+8Е; 20 потоков; 1,4–5,2 ГГц; 20–28 Вт; Intel Iris Xe Graphics). Объём оперативной памяти может составлять 16, 32 или 64 Гбайт. Допускается установка одного SSD формата M.2 (NVMe) вместимостью 1, 2, 4 или 8 Тбайт. Дебютировали модели HE153 и HE153s: первая оснащена двумя сетевыми портами 2.5GbE, вторая — одним. На устройствах применена фирменная «самовосстанавливающаяся» программная платформа, позволяющая приложениям автономно функционировать на периферии. Прочие характеристики новинок пока не раскрываются.

Источник изображения: Scale Computing Благодаря небольшим размерам три компьютера серии HE100 могут бок о бок монтироваться в серверное шасси типоразмера 1U. В качестве альтернативного варианта допускается установка нескольких устройств стопкой друг на друга. На фронтальную панель изделий выведены два порта USB 3.х Type-A. Сзади находится интерфейс HDMI. В продажу новинки поступят в I половине 2024 года по цене от $5400 за кластер из трёх узлов.

07.12.2023 [16:54], Сергей Карасёв

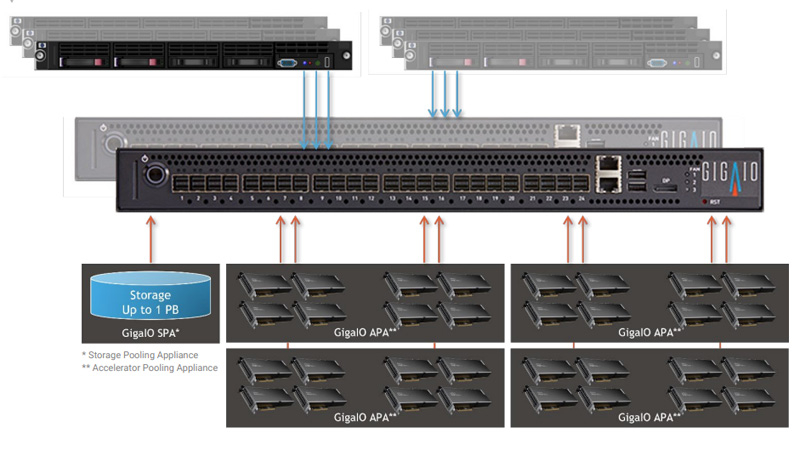

GigaIO создаст уникальное ИИ-облако с тысячами ускорителей AMD Instinct MI300XКомпания GigaIO объявила о заключении соглашения по созданию инфраструктуры для специализированного ИИ-облака TensorNODE, которое создаётся провайдером TensorWave. В составе платформы будут применяться ускорители AMD Instinct MI300X, оснащённые 192 Гбайт памяти HBM3. Основой TensorNODE послужат мини-кластеры SuperNODE, дебютировавшие летом уходящего года. Особенность этого решения заключается в том, что оно позволяет связать воедино 32 и даже 64 ускорителя посредством распределённого интерконнекта на базе PCI Express. TensorWave будет использовать FabreX для формирования пулов памяти петабайтного масштаба. На первом этапе в начале 2024 года платформа TensorNODE объединит до 5760 ускорителей Instinct MI300X в одном домене. Таким образом, при решении сложных задач можно будет получить доступ более чем к 1 Пбайт памяти с любого узла. Это, как отмечается, позволит обрабатывать даже самые ресурсоёмкие нагрузки в рекордно короткие сроки.

Источник изображения: GigaIO В течение следующего года планируется развернуть несколько систем TensorNODE. Архитектура GigaIO обеспечит улучшенную гибкость по сравнению с традиционными решениями: инфраструктуру можно будет оптимизировать «на лету» для удовлетворения как текущих, так и будущих потребностей в области ИИ и больших языковых моделей (LLM). Отмечается, что TensorNODE полностью базируется на ключевых компонентах AMD. Помимо ускорителей Instinct MI300X, это процессоры EPYC Genoa. Облако TensorWave обеспечит снижение энергозатрат и общей стоимости владения благодаря исключению из конфигурации избыточных серверов и связанного с ними сетевого оборудования. |

|