Лента новостей

|

03.08.2024 [10:01], Сергей Карасёв

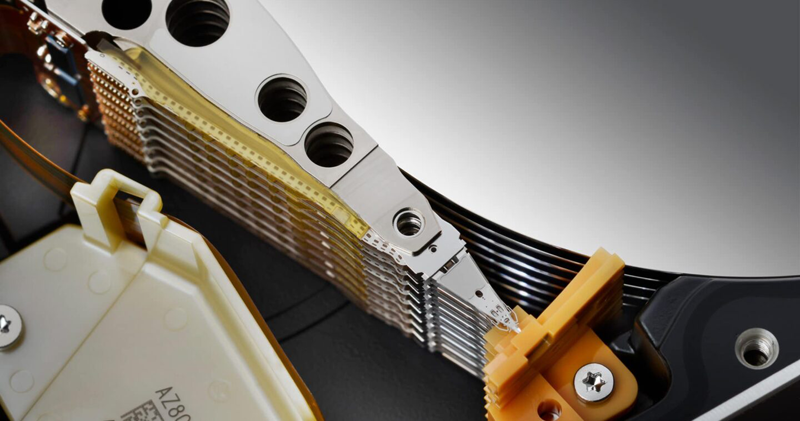

Western Digital начала пробные поставки SMR HDD вместимостью 32 ТбайтКомпания Western Digital сообщила о начале пробных отгрузок nearline-накопителей ёмкостью 32 Тбайт, ориентированных на гиперскейлеров. Устройства, выполненные по технологии черепичной магнитной записи (SMR), на сегодняшний день являются самыми вместительными HDD производства Western Digital. Как отмечает AnandTech, в новинках задействованы наиболее передовые технические решения Western Digital. Это, в частности, технология магнитной записи с энергетической поддержкой (EAMR/ePMR 2), а также система черепичной магнитной записи нового поколения UltraSMR, которая повышает плотность хранения данных на 20 % по сравнению с методикой традиционной магнитной записи (CMR).

Источник изображения: Western Digital Кроме того, в накопителях применены трёхступенчатые приводы для улучшения позиционирования головок и система двухмерной магнитной записи TDMR (Two-Dimensional Magnetic Recording), которая представляет собой методику считывания дорожки при помощи двух головок одновременно. Реализована также технология OptiNAND, использующая встроенную флеш-память iNAND для выполнения основных функций по обслуживанию: благодаря этому повышается надёжность, улучшается производительность и снижается энергопотребление. Упомянуты проприетарные средства коррекции ошибок ECC. «Мы поставляем образцы наших nearline-дисков UltraSMR/ePMR вместимостью 32 Тбайт избранным клиентам», — сказал Дэвид Гекелер (David Goeckeler), исполнительный директор Western Digital. Нужно отметить, что ранее корпорация Toshiba продемонстрировала HDD на базе HAMR (магнитная запись с подогревом), способный хранить 32 Тбайт данных. До этого Seagate смогла выпустить HAMR-накопители объёмом 30 Тбайт с классической геометрией записи благодаря технологии Mozaic 3+, тогда как отметка в 32 Тбайт была достигнута путём использования SMR.

03.08.2024 [00:33], Владимир Мироненко

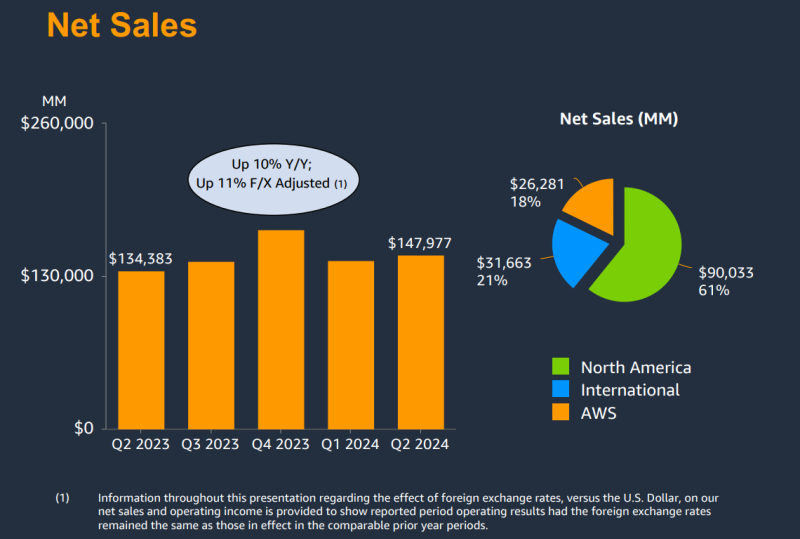

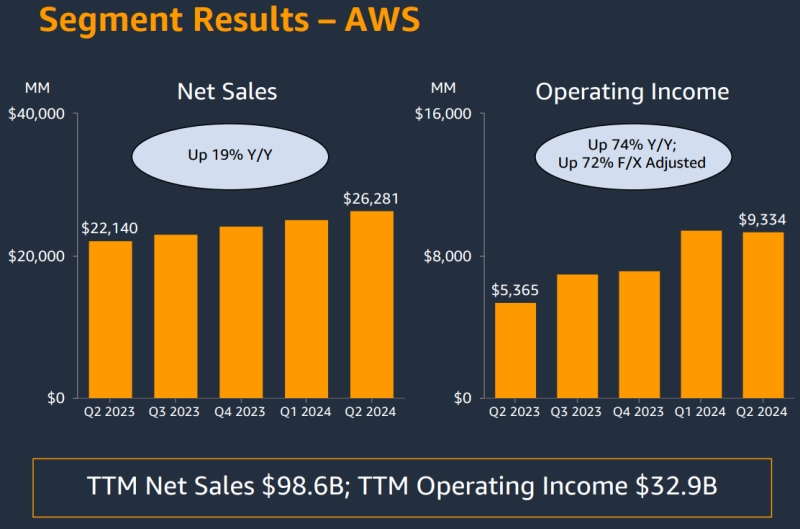

AWS увеличила выручку на 19 %, но по-прежнему отстаёт по темпам роста от Microsoft Azure и Google CloudКомпания Amazon.com, Inc. объявила результаты II квартала 2024 года, завершившегося 30 июня 2024 года. В связи с более низким, чем прогнозировали аналитики Уолл-стрит доходом, а также слабым прогнозом, акции компании упали на 6 % на расширенных торгах. Тем не менее, компания продолжает вкладывать всё больше средств в развитие облачной инфраструктуры, в том числе для ИИ-нагрузок. Выручка Amazon составила $147,98 млрд, превысив на 10 % показатель аналогичного периода прошлого года, равный $134,38 млрд. Вместе с тем выручка оказалась ниже консенсус-прогноза аналитиков, опрошенных LSEG, в размере $148,56 млрд. Операционная прибыль компании выросла до $14,67 млрд с $7,68 млрд годом ранее. Чистая прибыль увеличилась с $6,75 млрд ($0,65 на разводнённую акцию) в прошлом году до $13,48 млрд ($1,26 на разводнённую акцию) при консенсус-прогнозе аналитиков Уолл-стрит $1,03 на разводнённую акцию. Облачное подразделение Amazon Web Services (AWS) увеличило продажи год к году на 19 % до $26,28 млрд за квартал с $22,14 млрд годом ранее при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в размере $26,0 млрд. Операционная прибыль увеличилась с $5,36 млрд во II квартале 2023 года до $9,33 млрд. Хотя AWS превзошло прогнозы аналитиков по выручке, темпы роста у него ниже чем у облачных подразделений Microsoft и Google, увеличивших продажи на 29 %. Впрочем, объявленные ими цифры включают не только облачную инфраструктуру. В связи с высоким спросом на технологии ИИ Amazon тратит значительные суммы на расширение своей облачной инфраструктуры AWS. Капитальные затраты Amazon и лизинг составили $30,5 млрд за I половину года, и ожидается, что эта цифра вырастет во II половине года, говорит финансовый директор Amazon Брайан Олсавски (Brian Olsavsky). «Большая часть расходов будет направлена на поддержку растущей потребности в инфраструктуре AWS, поскольку мы по-прежнему видим высокий спрос как на генеративный ИИ, так и на негенеративный ИИ», — цитирует ресурс GeekWire его слова. Amazon прогнозирует выручку в текущем квартале в диапазоне от $154 до $158,5 млрд, что представляет собой рост на 8–11 % в годовом исчислении. Средняя точка этого диапазона, $156,25 млрд, отстаёт от средней оценки аналитиков, опрошенных LSEG, в $158,24 млрд.

02.08.2024 [22:44], Владимир Мироненко

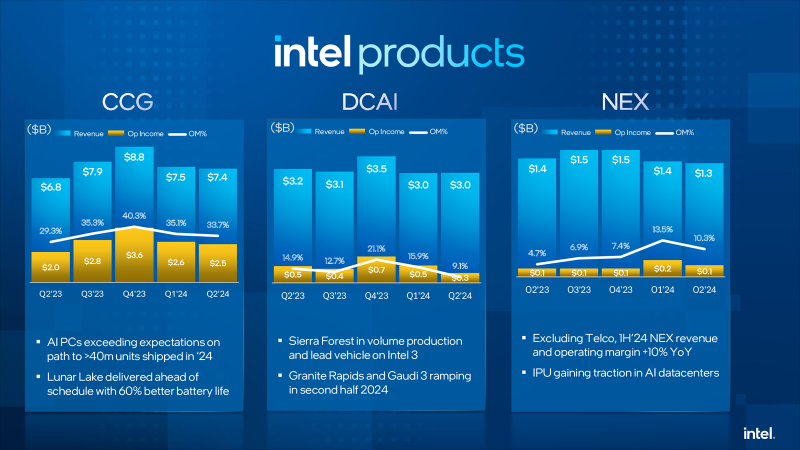

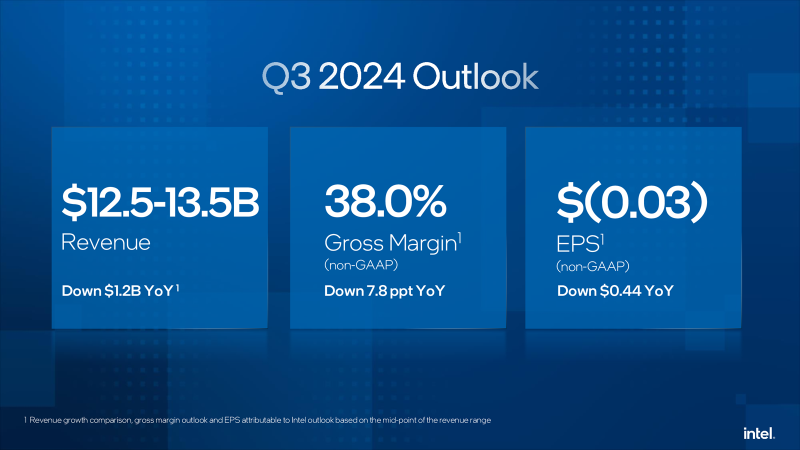

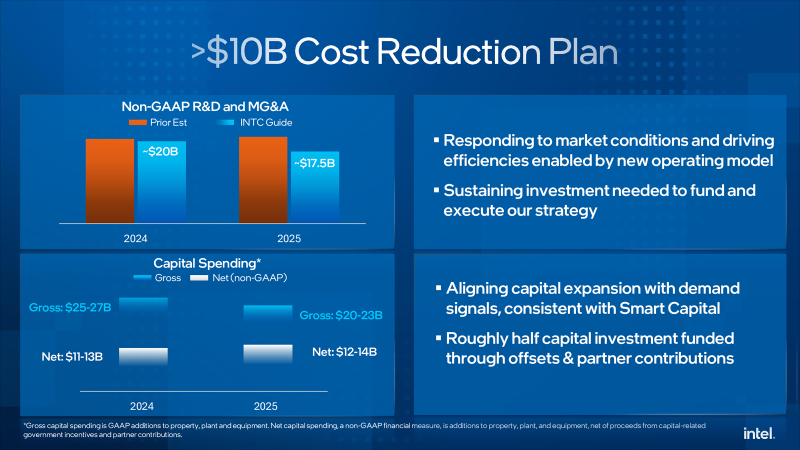

Intel пережила рекордное падение стоимости акций, но надеется со временем отыграться благодаря сегменту ЦОД и ИИКомпания Intel объявила результаты II квартала 2024 года, завершившегося 29 июня. Выручка компании составила $12,83 млрд, что меньше на 1 % год к году, а также ниже консенсус-прогноза аналитиков, опрошенных LSEG, равного $12,94 млрд. Intel завершила квартал с убытками в размере $1,61 млрд или $0,38 на акцию, хотя годом ранее у неё была чистая прибыль в размере $1,48 млрд или $0,35 на акцию. Скорректированная прибыль (Non-GAAP) составила $85 млн или $0,02 на акцию (падение год к году на 85 %), что ниже консенсус-прогноза аналитиков в размере $0,10 на акцию. Рынок отреагировал на результаты Intel, а также слабый прогноз на текущий квартал падением стоимости акций, обрушившейся на 26 % после открытия торгов в Нью-Йорке в пятницу, сократив рыночную стоимость компании примерно на $32 млрд. Это было самое большое дневное падение акций по крайней мере с 1982 года, пишет Bloomberg. Выручка когда-то самого прибыльного подразделения Datacenter and AI Group (DCAI), поставляющего решения для ЦОД и платформ ИИ, снизилась по сравнению с аналогичным кварталом прошлого года на 3 % до $3,05 млрд, оказавшись также ниже консенсунс-прогноза StreetAccount в размере $3,14 млрд. Как отметил ресурс Bloomberg, «это подразделение пока не достигло ничего похожего на присутствие на рынке NVIDIA в чипах-ускорителях, используемых в системах ИИ». Intel объявила, что более 130 млн процессоров Intel Xeon обеспечивают работу ЦОД по всему миру. У подразделения Network and Edge Group (NEX), специализирующегося на сетевых продуктах и периферийных вычислениях, выручка сократилась на 1 % до $1,34 млрд. Выручка подразделения Intel Foundry Service, занимающегося контрактным производством чипов, составила $4,32 млрд (рост год к году — 4 %). Группа Intel Client Computing, которая производит чипы для ПК, принесла $7,41 млрд, превысив прошлогодний результат на 9 % при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $7,42 млрд. В III квартале Intel прогнозирует скорректированный чистый убыток в размере $0,03 на акцию при выручке в ранее объявленном диапазоне $12,5–$13,5 млрд. Согласно прогнозу аналитиков, опрошенных LSEG, у компании показатель скорректированной прибыли составит $0,35 на акцию при выручке $14,35 млрд. По словам финансового директора Intel Дэйва Зинссера (Dave Zinsser), доход DCAI должен последовательно расти во II половине финансового года, «поскольку спрос на традиционные серверы немного улучшается». В текущем квартале компания планирует начать выпуск процессоров Xeon 6 на базе производительных ядер P-core (Granite Rapids). Также готовятся к выпуску в этом квартале ИИ-ускорители Gaudi3. Intel также объявила план сокращения расходов, включающий ряд инициатив по созданию устойчивого финансового драйвера, который ускорит рост прибыли и обеспечит дальнейшую операционную эффективность и гибкость, а также создаст возможности для постоянных стратегических инвестиций в технологии и лидерство в производстве. План предполагает структурную и операционную перестройку компании, сокращение штата, а также снижение операционных расходов и капитальных затрат более чем на $10 млрд в 2025 году. Так, компания намерена оптимизировать свою деятельность и существенно сократит расходы и численность персонала (более чем на 15 %,), сократив траты на НИОКР и маркетинг, общие и административные расходы (MG&A) без учёта GAAP примерно на $20 млрд в 2024 году и примерно на $17,5 млрд в 2025 году, с дальнейшим сокращением в 2026 году. Большую часть увольнений, которые коснутся по подсчётам ресурса The Verge около 19 тыс. сотрудников, компания намерена произвести до конца 2024 года. Также предполагается сократить валовые капитальные затраты в 2024 году более чем на 20 % по сравнению с предыдущими прогнозами, в результате они составят за год от $25 до $27 млрд, а чистые капитальные затраты в 2024 году будут находиться в диапазоне от $11 до $13 млрд. В 2025 году компания планирует валовые капитальные расходы от $20 до $23 млрд и чистые капитальные расходы от $12 до $14 млрд. Также, начиная с IV квартала, компания прекращает выплачивать дивиденды.

02.08.2024 [18:01], Руслан Авдеев

ИИ и ЦОД: капитальные затраты Meta✴ во II квартале выросли до $8,5 млрдВ Meta✴ продолжают активно вкладывать средства в серверы, дата-центры и сетевую инфраструктуру — компания выстраивает экосистему для искусственного интеллекта. По информации Datacenter Dynamics, капитальные затраты во II квартале составили $8,5 млрд, ожидается, что они будут расти и в дальнейшем. Выручка за отчётный период превзошла прогнозы экспертов и составила $39,07 млрд, на 22 % больше в сравнении с аналогичным периодом прошлого года. Чистая прибыль в прошедшем квартале — $13,46 млрд, рост составил 73 %. Прогноз выручки на следующий квартал — $38,5-$41 млрд. Капитальные затраты оказались несколько ниже ($8,5 млрд), чем предполагали отраслевые эксперты ($9,51 млрд), тем не менее рост составил 32,8 % год к году. Компания ожидает и дальнейшего значительного роста капитальных вложений в 2025 году, при этом имеется достаточный запас гибкости. Та же инфраструктура, что построена для обучения генеративного ИИ, будет использована и для инференса. Кроме того, инфраструктуру можно будет модифицировать для других задач, включая ранжирование, рекомендательные системы и др. Как утверждают в Meta✴, несмотря на рост инвестиций, генеративный ИИ не должен стать значимым драйвером выручки в 2024 году. Впрочем, по словам главы компании Марка Цукерберга (Mark Zuckerberg), он скорее рискнёт создать лишнюю ёмкость до того, как она понадобится, чем станет добиваться её строительства с опозданием, с учётом довольно длительной реализации новых внутренних проектов. Ожидается, что для тренировки ИИ-модели Llama 4 понадобится почти в 10 раз больше вычислительных мощностей, чем было необходимо для Llama 3. Для последующих моделей потребуется ещё больше. К концу года компания будет использовать ускорители эквивалентные по вычислительной способности 600 тыс. экземпляров NVIDIA H100. По словам финансового директора Meta✴ Сьюзан Ли (Susan Li), компания применяет стратегию поэтапного строительства ЦОД, позволяющую быстро увеличивать общую ёмкость для удовлетворения спроса. При этом в будущем капитальные затраты снизятся, поскольку не будет необходимости сразу сдавать большие объекты.

02.08.2024 [17:55], Руслан Авдеев

ЦОД на дровах: Google заключила уникальное соглашение о покупке «зелёной» энергии в СингапуреGoogle заключила довольно необычное 10-летнее соглашение о покупке возобновляемой энергии (PPA) для своих дата-центров в Сингапуре. По данным Datacenter Dynamics, это первый в своём роде вариант PPA, который предусматривает получение возобновляемой энергии из деревянных отходов. Подобная «чистая» энергия будет обеспечивать экобезопасные операции Google в Сингапуре и, в конечном счёте, содействовать достижению компанией нулевого углеродного выброса к 2030 году. Google заключила контракт с энергокомпанией PacificLight Energy (PLE), которая будет поставлять возобновляемую энергию от электростанции Rexus Bioenergy (Rexus). Сама Rexus утверждает, что её электростанция класса WWtE («отходы древесины в энергию») мощностью 13,2 МВт будет первой в своём роде в Сингапуре. Для питания будут использоваться не подлежащие традиционное переработке древесные остатки. Это и отходы сельского хозяйства, и отходы логистических компаний вроде грузовых поддонов. Этот мусор будет не только сжигаться, но и использоваться для получения биомассы, которая, вероятно, тоже будет источником энергии. Также установка будет связана с системой захвата углеродных выбросов (CO2). Начало коммерческого использования электростанции запланировано на 2026 год. Google управляет в Сингапуре тремя ЦОД и недавно выделила ещё $5 млрд на развитие инфраструктуры в стране. С 2019 года в Сингапуре действует мораторий на строительство новых дата-центров — не хватает как энергии, так и места для размещения ЦОД. Впрочем, ранее в этом году было решено «разблокировать» ещё 300 МВт. В PacificLight намерены развивать зелёную биоэнергетику и со временем стать «низкоуглеродной» компанией, что соответствует целям города-государства.

02.08.2024 [14:11], Руслан Авдеев

Nano Nuclear Energy и Blockfusion намерены разместить ядерные микрореакторы в ЦОД при Ниагарском водопадеКомпания Nano Nuclear Energy Inc. подписала меморандум о взаимопонимании с криптомайнингвой Blockfusion Ventures — дочерней структурой Blockfusion USA, Inc. — документ предусматривает использование атомной энергии для питания ЦОД, передаёт Datacenter Dynamics. Nano Nuclear изучит возможность интеграции своих микрореакторов в ЦОД Blockfusion, который размещается на месте закрытой и реконструированной угольной электростанции. ЦОД для криптомайнинга запитан от ГЭС, связанной с Ниагарским водопадом. Его ёмкость может составлять до 50 МВт. Впрочем, текущее состояние ЦОД под вопросом. В 2022 году на объекте взорвался трансформатор и случился пожар. Предполагается, что причиной стало неисправное оборудование энергоснабжающей организации. Вскоре после ремонта компания на время вынужденно остановила работу объекта по приказу местных властей. Основанная в 2021 году компания Nano разрабатывает портативные атомные микрореакторы. Модель Zeus, создаваемая для размещения в 45″ контейнере, оснащена модулем, который позволяет вырабатывать 1–2 МВт и не требует жидкого охладителя. Дополнительно разрабатывается реактор Odin с охлаждающей жидкостью низкого давления. В Nano рассказывают, что давно присматривались к ЦОД, занятыми ИИ, квантовыми вычислениями и майнингом. Впрочем, аналитики Hunterbrook Capital сомневаются в жизнеспособности Nano Nuclear, говоря, что у компании нет доходов и продукции, а руководители работают на полставки. Малые модульные реакторы (SMR) часто рассматриваются в качестве оптимальных источников энергии с низким углеродным выбросом для дата-центров, они могли бы обеспечить объектам автономную работу и независимость от локальных энергосетей. В прошлом году блокчейн-компания Standard Power объявила о намерении приобрести 24 SMR у NuScale для двух ЦОД в США. А Equinix и Wyoming Hyperscale подписали соглашения о поставках SMR с компанией Oklo.

02.08.2024 [13:17], Сергей Карасёв

SSD с «компрессором»: ScaleFlux представила вычислительные NVMe-накопители CSD5000Компания ScaleFlux анонсировала высокопроизводительные вычислительные SSD семейства CSD5000 на базе фирменного контроллера FX5016, предназначенные для поддержания ресурсоёмких рабочих нагрузок, связанных с ИИ, машинным обучением, аналитикой данных и НРС. Устройства будут доступны в исполнениях U.2/U.3, E3.S, E1.S и E1.L. Для обмена данными служит интерфейс PCIe 5.0 (NVMe 2.0b): один порт x4 или два x2. Заявлена поддержка TCG Opal 2.02 и шифрования AES-256, NVMe Thin Provisioned Namespaces Virtualization (48PF/32VF), ZNS, FDP, а также совместимость со спецификациями OCP, в том числе в части телеметрии и мониторинга задержек. Реализовано сжатие информации непосредственно на SSD: разработчик подчеркивает, что это позволяет значительно увеличить долговечность накопителей по сравнению с обычными изделиями. В семейство входят модели вместимостью 3,84, 7,68, 15,36, 30,72, 61,44 и 122,88 Тбайт. С учётом компрессии эффективная ёмкость может достигать приблизительно 256 Тбайт. Заявленная скорость последовательного чтения информации составляет до 14 Гбайт/с, скорость последовательной записи — до 11 Гбайт/с. Показатель IOPS (операций ввода/вывода в секунду) при произвольных чтении и записи данных блоками по 4 Кбайт находится на уровне 3,2 млн и 430 тыс. соответственно. При использовании сжатия 2:1, как утверждает разработчик, скорость последовательной записи возрастает до 13 Гбайт/с, а значение IOPS при произвольной записи — до 1,2 млн. ScaleFlux заявляет, что устройства семейства CSD5000 обеспечивают до 3 раз более высокую производительность в расчёте на ватт затрачиваемой энергии по сравнению с конкурирующими изделиями Samsung и Kioxia, поддерживающими интерфейс PCIe 5.0. Энергопотребление составляет менее 18 Вт в активном режиме и менее 5 Вт в режиме простоя. Средняя наработка на отказ (величина MTBF) — 2 млн часов.

02.08.2024 [12:17], Сергей Карасёв

«Систэм Электрик» представила чиллеры CoolFlow с гибкими возможностями кастомизацииРоссийская компания «Систэм Электрик» (Systême Electric; ранее — Schneider Electric) объявила о выпуске чиллеров семейства CoolFlow, которые, как утверждается, обладают широкими возможностями для адаптации под индивидуальные требования заказчика. Новинки ориентированы на применение в современных дата-центрах. Отмечается, что новые решения сочетают в себе передовые технологии для достижения высокой энергетической эффективности и улучшения экологических показателей. Чиллеры обеспечивают надёжное охлаждение серверного оборудования, одновременно минимизируя энергопотребление и углеродный след. В семейство CoolFlow входят устройства воздушного охлаждения с опцией фрикулинга двух типов. Это модели на базе спиральных компрессоров холодопроизводительностью от 30 до 700 кВт, а также чиллеры на основе винтовых компрессоров холодопроизводительностью от 300 до 1500 кВт. Решения оснащены встроенным гидромодулем, который включает в себя все необходимые компоненты для выполнения только одного подключения к чиллеру — без необходимости внешних подсоединений к вспомогательному оборудованию, например, насосам. Устройства изначально оснащены специальным зимним комплектом, который позволяет эксплуатировать их при температурах до -45 °C. При необходимости может быть добавлен высоконапорный насос. Преимуществом чиллеров семейства CoolFlow названы широкие возможности в плане кастомизации. Устройства можно адаптировать к индивидуальным требованиям каждого проекта, оптимизируя их для конкретных условий эксплуатации. Благодаря модульной конструкции достигается гибкость масштабирования: допускается создание систем различной мощности, подходящих для разных объектов — от небольших до крупных дата-центров. Чиллеры CoolFlow могут применяться не только для строительства и эксплуатации ЦОД, но и в других отраслях промышленности, а также для создания микроклимата в офисах и бизнес-центрах. «Систэм Электрик» предлагает возможность изменения стандартных размеров чиллеров и модификации их базовых характеристик. В частности, заказчики могут выбрать двойной или раздельный ввод питания, определённую насосную группу (1/1+1/1 с VSD/1+1 c VSD), а также установку источника бесперебойного питания на контроллер, расходомеров, накопительного бака, сетевых карт RS485 или SNMP, металлических сетчатых фильтров на теплообменники и пр.

02.08.2024 [10:18], Руслан Авдеев

Индонезийская Star Energy Geothermal предложила строить ЦОД рядом с геотермальными электростанциямиИндонезийская Star Energy Geothermal, входящая в холдинг Barito Renewables и занимающаяся геотермальной энергетикой, ведёт переговоры с операторами дата-центров о поставках «чистой» энергии при условии, что они будут строить объекты рядом с её ГеоТЭС, передаёт Datacenter Knowledge. Индонезия, по данным Азиатского банка развития, имеет, возможно, крупнейший в мире потенциал в области геотермальной энергетики — на неё приходится 2,1 ГВт или 13 % мировых мощностей такого типа. Star Energy Geothermal намерена уйти от продажи электричества только государственным коммунальным компаниям и привлечь клиентов, желающих покупать в Индонезии возобновляемую энергию. Также рассматриваются поставки «зелёной» энергии в соседние страны. Компания рассчитывает, что быстрый рост ИИ-сектора, требующего всё больше энергии (предпочтительно «чистой»), привлечёт операторов ЦОД. При этом геотермальные источники являются стабильным поставщиком энергии в местностях, где погода слишком переменчива для регулярной солнечной и ветряной энергетики. Обычно геотермальные электростанции строятся возле вулканов, гейзеров и иных мест, где природное тепло подходит близко к поверхности Земли. По оценкам Азиатского банка развития, Индонезия, фактически окружённая т.н. «Тихоокеанским огненным кольцом», имеет сильнейший в мире потенциал развития геотермальной энергетики. Однако операторы ЦОД могут и не захотеть строить свои объекты вблизи подобных источников, расположенных зачастую в отдалённых местах. По данным СМИ, хотя на возобновляемые источники приходится лишь малая часть глобальной энергетики, в индустрии снова наблюдается рост интереса со стороны инвесторов. Так, вложения в геотермальные электростанции в 2023 году достигли $8 млрд, что намного больше, чем в предыдущие годы. Немало внимания уделяется геотермальной энергетике и в других странах. Например, Кения готова вложить $4,5 млрд в развитие этой и других технологий, а в мае Microsoft и G42 заявили о намерении построить ЦОД за $1 млрд рядом с геотермальными источниками.

02.08.2024 [08:05], Владимир Мироненко

«Альт Платформа» от «Базальт СПО» сделает сборку ПО и дистрибутивов ОС проще и удобнее«Базальт СПО», российский разработчик ОС семейства «Альт», предложил вниманию разработчиков технологический комплекс «Альт Платформа», который, по словам создателей, имеет всё необходимое для сборки ПО и выпуска дистрибутивов операционных систем и значительно упрощает выполнение этих задач. Решение включено в Единый реестр российского ПО под №21540. «Альт Платформа» может использоваться для широкого круга задач, включая создание специализированных сборок под конкретное оборудование (банкоматы, промышленные контроллеры и т. п.) и под нужды крупных организаций, локализованных ОС, а также для формирования дистрибутивов с предустановленным дополнительным ПО и для разработки прикладного ПО, совместимого с ОС серии «Альт» и другими созданными на «Альт Платформе» дистрибутивами. В состав «Альт Платформы» входят:

«Базальт СПО» готова обучить специалистов заказчика пользоваться программным комплексом «Альт Платформа», вести свой репозиторий и дополнять его сторонним ПО, а также предлагает техническую поддержку трёх уровней: базового, стандартного и расширенного. «Базальт СПО» с 2001 года развивает собственную инфраструктуру разработки, на которой создано уже десять поколений операционных систем. Её центральное звено — бесплатный репозиторий «Сизиф» — один из крупнейших в мире технологически независимых репозиториев, наряду с Debian, Red Hat и SUSE. Репозиторий формируется из свободного ПО международных проектов и собственных разработок компании. Он поддерживается «Базальт СПО» и находится на территории и под юрисдикцией РФ. Каждые несколько лет разработчики «Базальт СПО» выделяют из «Сизифа» бранч — стабильную ветку репозитория. Все помещаемые в него пакеты тестируются, уязвимости исправляются и для всех них обеспечивают совместимость, благодаря чему формируется банк проверенных пакетов с системой контроля зависимостей, на основе которого выпускаются дистрибутивы. Помимо бинарных пакетов в стабильный бранч входит исходный код практически всех пакетов. Бранч можно использовать как для обновления ОС «Альт», так и для создания и обновления собственных дистрибутивов. |

|