Материалы по тегу: вычисления

|

25.11.2025 [11:24], Сергей Карасёв

Стартап Kneron представил чип KL1140 для работы с ИИ-моделями на периферииАмериканский стартап Kneron, по сообщению ресурса SiliconANGLE, разработал ИИ-чип KL1140, предназначенный для запуска больших языковых моделей (LLM) на периферийных устройствах. Утверждается, что изделие обеспечивает ряд существенных преимуществ перед облачными развёртываниями. Kneron, основанная в 2015 году, базируется в Сан-Диего (Калифорния, США). Стартап проектирует чипы для всевозможного оборудования с ИИ-функциями: это могут быть роботы, подключённые автомобили и пр. Ранее Kneron представила решение KL730, которое объединяет четырёхъядерный CPU на архитектуре Arm и акселератор для задач инференса. В 2023 году компания привлекла на развитие $49 млн от Foxconn and HH-CTBC Partnership (Foxconn Co-GP Fund), Alltek, Horizons Ventures, Liteon Technology Corp, Adata и Palpilot. В общей сложности на сегодняшний день Kneron получила более $200 млн от различных инвесторов. Характеристики нового чипа KL1140 полностью пока не раскрываются. Kneron заявляет, что это первый нейронный процессор, способный полноценно работать с сетями-трансформерами на периферии. Связка из четырёх чипов KL1140, как утверждается, обеспечивает производительность на уровне GPU при работе с ИИ-моделями, насчитывающими до 120 млрд параметров. При этом энергопотребление сокращается на 50–66 %. Суммарные затраты на оборудование могут быть снижены в 10 раз по сравнению с существующими облачными решениями. Среди других преимуществ запуска LLM на периферийных устройствах названы уменьшение задержки, отсутствие необходимости отправки конфиденциальных данных на внешние серверы и возможность использования даже без подключения к интернету. Чип KL1140 ориентирован на такие задачи, как обработка естественного языка в реальном времени, голосовые интерфейсы, системы машинного зрения, интеллектуальные платформы видеонаблюдения и др. Разработчики могут применять изделие для безопасного локального развёртывания приложений ИИ без необходимости использования облачных ресурсов.

06.11.2025 [22:34], Владимир Мироненко

Qualcomm и Arm разошлись во мнениях по поводу развития ИИ-вычисленийQualcomm и Arm опубликовали в среду квартальные отчёты, дав разные прогнозы относительно рынка процессоров для инференса, пишет The Register. Генеральный директор Qualcomm Криштиану Амон (Cristiano Amon) сообщил аналитикам в ходе телефонной конференции, посвященной квартальным финансовым результатам о том, что его компания выйдет на рынок ЦОД с чипами, предназначенными для выполнения задач инференса и потребляющими меньше энергии, чем «железо» конкурентов. Амон рассказал, что Qualcomm разрабатывает SoC и плату для неё, поскольку «рост ИИ-ЦОД смещается от обучения к специализированным рабочим нагрузкам инференса, и ожидается, что эта тенденция усилится в ближайшие годы». Вместе с тем он отметил, что Qualcomm не сможет отчитаться о «существенной» выручке в сегменте ЦОД до 2027 года. Генеральный директор Arm Рене Хаас (Rene Haas) тоже придерживается мнения, что энергопотребление является «узким местом» в ЦОД, и что спрос сместится с обучения на инференс, вместе с тем считая, что такого рода задачи будут выполняться и за пределами дата-центров. Он отметил растущий спрос на различные архитектуры и вычислительные решения, позволяющие выполнять инференс не в облаке. «Очевидно, что вы не будете полностью полагаться на что-то, что находится на периферии. Но сегодня всё наоборот. Всё на 100 % зависит от облака. И мы думаем, что это изменится», — заявил Хаас во время телефонной конференции с аналитиками, посвящённой финансовому отчёту Arm. Qualcomm анонсировала новую серию чипов для ИИ ЦОД AI200/AI250, заявив, что ИИ-стартап Humain, основанный суверенным фондом Саудовской Аравии, станет одним из их заказчиков. В ходе телефонной конференции Амон сообщил, что Qualcomm ведёт переговоры с другим крупным заказчиком-гиперскейлером, отметив, что они проходят успешно, пишет Reuters. Выручка Qualcomm в IV квартале 2025 финансового года, завершившемся 28 сентября 2025 года, составила $11,27 млрд, что на 10 % больше, чем годом ранее, и выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $10,79 млрд. В полупроводниковом сегменте (QCT) выручка компании составила $9,82 млрд, превысив результат годичной давности на 13 %. При этом выручка в автомобильном сегменте выросла на 17 % до $1,05 млрд, в сегменте Интернета вещей — на 7 % до $1,81 млрд. Скорректированная прибыль на акцию составила $3,00 при прогнозе от LSEG в размере $2,88. Из-за единовременной налоговой выплаты в размере $5,7 млрд компания завершила квартал с чистым убытком в $3,12 млрд, или $2,89 на акцию, тогда как годом ранее у неё была чистая прибыль в размере $2,92 млрд, или $2,59 на акцию. Выручка Qualcomm за 2025 финансовый год составила $44,3 млрд, что на 14 % больше показателя предыдущего финансового года. Чистая годовая прибыль снизилась на 45 % до $5,5 млрд. В I квартале 2026 финансового года Qualcomm прогнозирует выручку в размере $11,8–$12,6 млрд, что соответствует среднему значению в $12,2 млрд. По данным LSEG, это превышает консенсус-прогноз аналитиков в $11,62 млрд. Скорректированная прибыль на акцию, согласно ожиданиям компании, составит $3,30–$3,50 при прогнозе Уолл-стрит в размере $3,31 на акцию. Arm объявила о выручке во II квартале 2026 финансового года в размере $1,14 млрд, что на 34 % больше, чем годом ранее, а также больше прогноза аналитиков в размере $1,06 млрд, пишет Reuters. Третий квартал подряд выручка компании превышает $1 млрд. Выручка компании от роялти выросла год к году на 21 % до рекордных $620 млн, а от лицензирования — на 56 % до $515 млн благодаря новым крупным соглашениям в сфере вычислительных технологий нового поколения. Скорректированная операционная прибыль (Non-GAAP), достигла $467 млн, а скорректированная прибыль на акцию (Non-GAAP), составила $0,39, что в обоих случаях превышает прогноз, отметил ресурс Converge! Network Digest. Финансовый директор Джейсон Чайлд (Jason Child) сообщил инвесторам, что наибольший вклад в рост выручки внесли смартфоны, но «более высокие ставки роялти за чип в ЦОД, где мы по-прежнему наблюдаем рост доли кастомных чипов для гиперскейлеров», безусловно, не были помехой. Arm отметила, что набирает обороты вклад своей архитектуры в развитие облачного ИИ: более 1 млн ядер Arm Neoverse уже развёрнуто в инфраструктуре гиперскейлеров. Ожидается, что доля процессоров Arm в установленных ведущими гиперскейлерами чипах в этом году достигнет почти 50 %. Среди новых игроков на этом рынке компания отметила Google, которая уже перенесла более 30 тыс. облачных приложений на Arm-чипы Axion, включая Gmail и YouTube, и намерена перенести большую часть из более чем 100 тыс. своих приложений. Также в минувшем квартале Microsoft расширила использование процессоров Cobalt 100 на базе Arm до 29 регионов по всему миру. «Открытие пяти новых ЦОД Stargate AI, все из которых основаны на Arm как стратегической вычислительной платформе, подчёркивает роль Arm в обеспечении масштабируемого ИИ», — отметила компания. Доля Arm на рынке серверных процессоров действительно достигла 25 %, но во многом благодаря внедрению интегированных в суперчипы NVIDIA процессорам Grace.

04.11.2025 [15:26], Сергей Карасёв

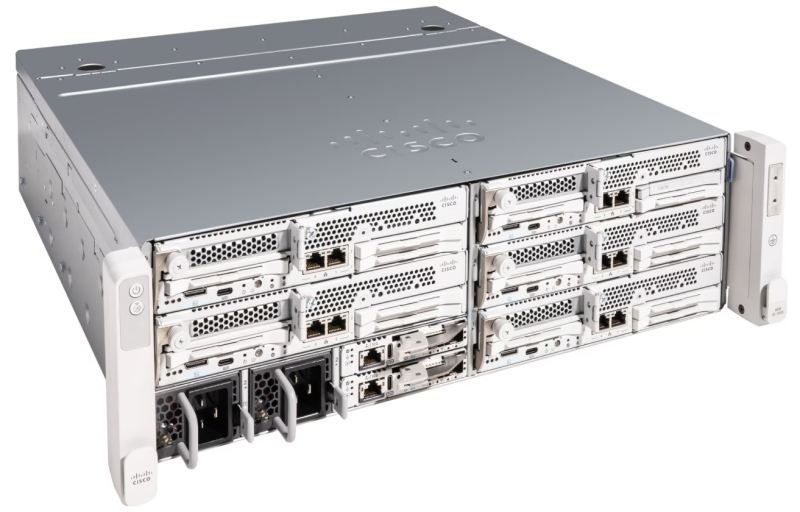

Cisco представила платформу Unified Edge для периферийных ИИ-нагрузокКомпания Cisco анонсировала аппаратную платформу Unified Edge, объединяющую вычислительные ресурсы, сетевые функции, а также средства хранения данных и защитные инструменты. Решение разработано с прицелом на распределённые рабочие нагрузки ИИ. Cisco Unified Edge имеет модульную архитектуру. Система состоит из шасси Cisco UCS XE9305 и вычислительных узлов Cisco UCS XE130c M8. Шасси выполнено в форм-факторе 3U. Оно оборудовано двумя контроллерами Cisco Edge Chassis Management Controller с возможностью горячей замены: каждый из них содержит пять портов 25GbE, два порта 10GbE SFP+, сетевой порт управления 1GbE RJ45 и два разъёма USB Type-C. Кроме того, система наделена двумя блоками питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium, а также пятью «акустически оптимизированными» вентиляторами диаметром 80 мм (допускается горячая замена). Есть слот PCIe 5.0 для HHHL-карты мощностью до 75 Вт (например, NVIDIA L4). В шасси могут быть установлены до пяти узлов Cisco UCS XE130c M8. Каждый из них несёт на борту процессор Intel Xeon 6 поколения Granite Rapids с 12, 20 или 32 P-ядрами. Доступны восемь слотов для модулей оперативной памяти DDR5-6400. Есть два тыльных порта 25GbE и два фронтальных разъёма 10GbE RJ45, коннекторы KVM м USB Type-C. Возможна установка одного GPU с интерфейсом PCIe 5.0 формата HHHL (до 75 Вт). Кроме того, может быть добавлена одна карта расширения PCIe 5.0 HHHL — NIC, DPU, IPU и пр. Для вычислительных узлов предлагаются различные конфигурации подсистемы хранения данных. Это могут быть два SSD стандарта M.2 вместимостью 960 Гбайт каждый в конфигурации RAID 1, а также три или четыре E3.S NVMe SSD на 30 Тбайт каждый с фронтальным доступом. Диапазон рабочих температур простирается от +5 до +45 °C. Платформа Cisco Unified Edge уже доступна для заказа: поставки планируется организовать до конца текущего года. Новинка ориентирована на розничные торговые сети, медицинские учреждения, различные предприятия и организации, которым требуется агентный ИИ и инференс в реальном времени.

31.10.2025 [13:49], Сергей Карасёв

NVIDIA представила платформу IGX Thor для «физического ИИ» на периферииКомпания NVIDIA анонсировала аппаратную платформу IGX Thor, предназначенную для «переноса» ИИ из цифрового мира в физический. Решение разработано специально для промышленных, робототехнических и медицинских сред. IGX Thor позволяет проектировать периферийные устройства с ИИ-функциями, поддерживающие получение информации от различных датчиков. В семейство IGX Thor входят комплекты для разработчиков IGX Thor Developer Kit и IGX Thor Developer Kit Mini, а также решения IGX T7000 (плата Micro-ATX) и IGX T5000 («система на модуле»). Комплекты IGX Thor Developer Kit, в свою очередь, представлены в версиях с ускорителем NVIDIA RTX PRO 6000 Blackwell Max-Q Workstation Edition и NVIDIA RTX Pro Blackwell 5000. Вариант IGX Thor Developer Kit Mini не предполагает наличие дискретного GPU. Старшая из новинок, IGX Thor Developer Kit с ускорителем NVIDIA RTX PRO 6000 Blackwell Max-Q Workstation Edition, содержит GPU на архитектуре Blackwell с 24 064 ядрами. Предусмотрено 96 Гбайт памяти GDDR7 с пропускной способностью до 1792 Гбайт/с. Заявленная ИИ-производительность достигает 5581 Тфлопс в режиме FP4-Sparse. Модификация IGX Thor Developer Kit на базе NVIDIA RTX Pro Blackwell 5000 несёт на борту GPU поколения Blackwell с 14 080 ядрами. Объём встроенной памяти составляет 48 Гбайт, её пропускная способность — 1344 Гбайт/с. Быстродействие ИИ достигает 4293 Тфлопс (FP4-Sparse). Все три новинки, включая версию Mini (обладает ИИ-быстродействием 2070 Тфлопс), располагают интегрированным GPU на архитектуре Blackwell с 2560 ядрами и максимальной частотой 1,57 ГГц. Присутствует CPU с 14 ядрами Arm Neoverse-V3AE с частотой до 2,6 ГГц. Изделия оборудованы 128 Гбайт памяти LPDDR5X с пропускной способностью 273 Гбайт/с, а также накопителем M.2 NVMe (PCIe 5.0 x2) вместимостью 1 Тбайт. Старшие модели наделены двумя слотами PCIe 5.0 (x8 и x16), младшая — разъёмом M.2 Key E, в который установлен комбинированный адаптер Wi-Fi 6e / Bluetooth. Изделия поддерживают различные интерфейсы, включая (в зависимости от модели) USB 3.2 Gen2 Type-C, USB-3.2 Gen2 Type-A, DisplayPort 1.4a, HDMI 2.0b, 1/5GbE (RJ45), 25GbE (QSFP28), 100GbE (QSFP28) и пр. Для новинок гарантированы 10-летний жизненный цикл и долгосрочная поддержка программного стека NVIDIA AI. В продажу все изделия поступят в декабре нынешнего года.

29.10.2025 [11:55], Сергей Карасёв

NVIDIA представила интерконнект NVQLink для гибридных вычислений на базе GPU и QPUКомпания NVIDIA анонсировала NVQLink — открытую системную архитектуру, предназначенную для тесной интеграции графических (GPU) и квантовых (QPU) процессоров с целью создания гибридных вычислительных платформ. В разработке интерконнекта NVQLink приняли участие Брукхейвенская национальная лаборатория (BNL), Национальная ускорительная лаборатория им. Ферми (Fermilab), Национальная лаборатория имени Лоуренса в Беркли (LBNL), Лос-Аламосская национальная лаборатория (LANL), Национальная лаборатория Ок-Ридж (ORNL), Национальные лаборатории Сандия (SNL) и Тихоокеанская северо-западная национальная лаборатория (PNNL), которые принадлежат Министерству энергетики США (DoE). Кроме того, были вовлечены специалисты Линкольнской лаборатории Массачусетского технологического института (MIT Lincoln Laboratory). Отмечается, что NVQLink обеспечивает открытый подход к квантовой интеграции. Максимальная пропускная способность в системах GPU — QPU заявлена в 400 Гбит/с, тогда как минимальная задержка (FPGA-GPU-FPGA) составляет менее 4 мкс. Интерконнект может применяться в составе ИИ-платформ, обладающих производительностью до 40 Пфлопс (FP4). Решение NVQLink оптимизировано для крупномасштабных квантовых вычислений в реальном времени. В целом, NVQLink обеспечивает возможность непосредственного взаимодействия QPU разных типов и систем управления квантовым оборудованием с ИИ-суперкомпьютерами. Технология предоставляет готовое унифицированное решение для преодоления ключевых проблем интеграции, с которыми сталкиваются исследователи в области квантовых вычислений при масштабировании своих систем. Разработчики могут получить доступ к NVQLink благодаря интеграции с программной платформой NVIDIA CUDA-Q. В число партнёров, вносящих вклад в NVQLink, входят разработчики квантового оборудования Alice & Bob, Anyon Computing, Atom Computing, Diraq, Infleqtion, IonQ, IQM Quantum Computers, ORCA Computing, Oxford Quantum Circuits, Pasqal, Quandela, Quantinuum, Quantum Circuits, Quantum Machines, Quantum Motion, QuEra, Rigetti, SEEQC и Silicon Quantum Computing, а также разработчики квантовых систем управления, включая Keysight Technologies, Quantum Machines, Qblox, QubiC и Zurich Instruments.

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории.

24.09.2025 [09:37], Владимир Мироненко

Расходы ИИ-отрасли к 2030 году могут оказаться на $800 млрд больше её доходовЗаявления ИИ-компаний о планах потратить гигантские суммы на расширение инфраструктуры вызывают у аналитиков резонные вопросы о том, насколько такие вложения экономически и технологически обоснованы и подтверждены расчётами, отмечает Bloomberg. Так, OpenAI намерена со временем потратить триллионы долларов на ИИ ЦОД, но пока не спешит продемонстрировать, как она заработает, чтобы покрыть такие расходы. По оценкам консалтинговой фирмы Bain & Co., дефицит средств может быть гораздо больше, чем предполагалось ранее. Согласно отчёту Bain Global Technology Report к 2030 году компаниям в сфере ИИ потребуется $2 трлн совокупной годовой выручки для покрытия затрат на вычислительные мощности, необходимые для удовлетворения прогнозируемого спроса. Но их выручка, вероятно, будет на $800 млрд меньше этой суммы, поскольку, по прогнозам Bain, монетизация сервисов вроде ChatGPT отстаёт от потребностей в расходах на ЦОД и связанную с ними инфраструктуру. Экономическая эффективность ИИ-решений, т.е. прибыль ИИ-компаний, отстаёт от темпов роста спроса на вычислительные мощности и электроэнергию. OpenAI ежегодно теряет миллиарды долларов и ставит во главу угла рост, а не прибыль, но ожидает выхода на положительный денежный поток к 2029 году, сообщает Bloomberg. По данным Bloomberg Intelligence, к началу следующего десятилетия общие годовые расходы крупнейших технологических компаний, включая Microsoft., Amazon и Meta✴, на ИИ-технологии вырастут до более чем $500 млрд. Выпуск новых ИИ-моделей от OpenAI, DeepSeek и др. стимулирует спрос на ИИ-сервисы и побуждает всю отрасль увеличивать инвестиции. По оценкам Bain, к 2030 году глобальные ИИ-мощности вырастут до 200 ГВт, при этом на США будет приходиться половина этого объёма. Прорывы в разработке технологий и алгоритмов позволят облегчить задачу, однако ограничения в цепочке поставок или дефицит электричества могут помешать прогрессу, утверждают аналитики. «Если нынешние законы масштабирования останутся в силе, ИИ будет создавать всё большую нагрузку на цепочки поставок по всему миру», — отмечает Bain. Помимо инфраструктуры, компании в сфере ИИ тратят огромные средства на разработку продуктов. Одним из направлений является создание ИИ-агентов, способных автономно выполнять многоэтапные задачи. По оценкам Bain, в течение следующих трёх-пяти лет до 10 % расходов компаний на технологии будут приходиться на развитие основных возможностей ИИ, включая платформы ИИ-агентов. Отчёт Bain также содержит прогноз роста в таких областях, как квантовые вычисления. Эта новая технология может увеличить рыночную стоимость на $250 млрд в таких отраслях, как финансы, фармацевтика, логистика и материаловедение. Несмотря на ожидания некоторых аналитиков прорыва, Bain прогнозирует постепенный рост рынка квантовых вычислений с ранним внедрением в узких областях в течение следующих 10 лет и более широким внедрением со временем. Bain также отметила, что гуманоидные роботы становятся всё более распространёнными, привлекая инвестиции, но их внедрение находится на ранней стадии и в значительной степени зависит от человеческого контроля. По словам консалтинговой компании, коммерческий успех этого направления будет зависеть от готовности экосистемы, и компании, которые первыми начнут внедрять роботов, скорее всего, станут лидерами отрасли.

09.09.2025 [17:00], Владимир Мироненко

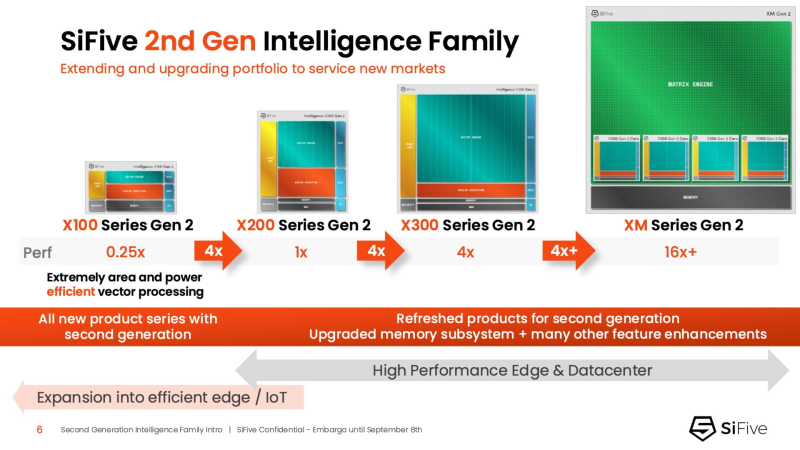

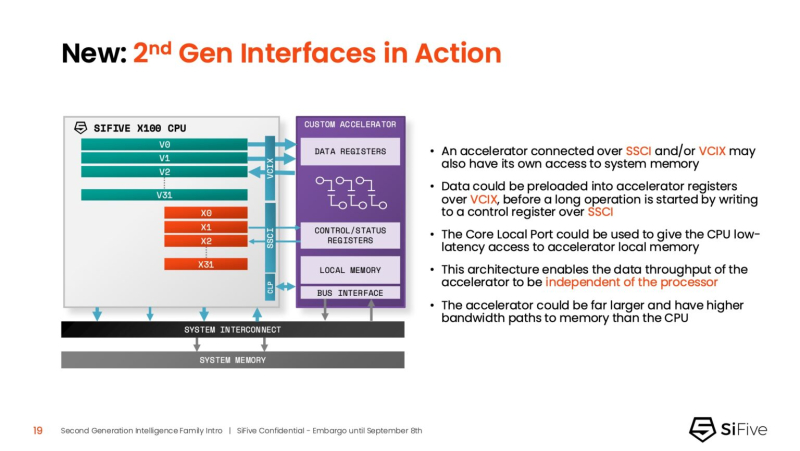

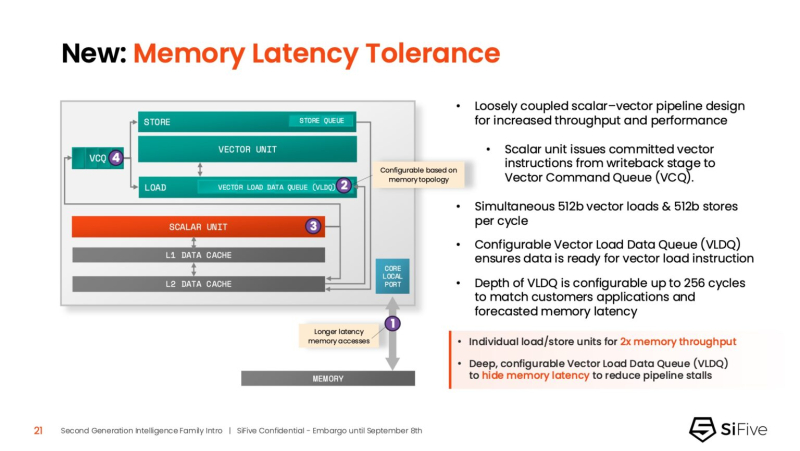

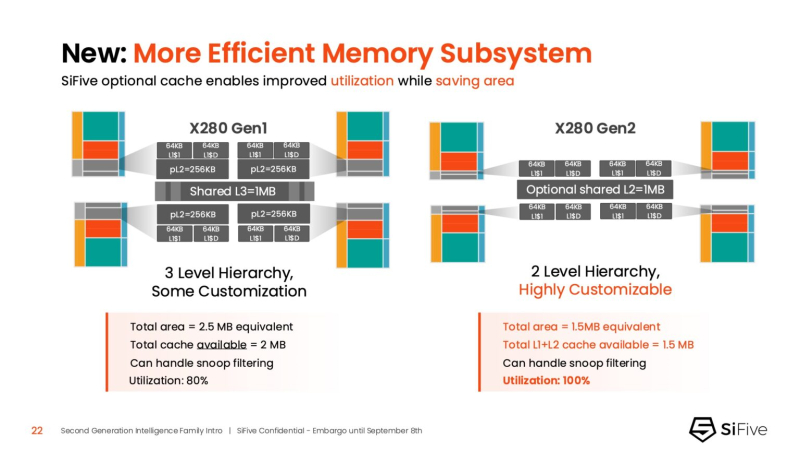

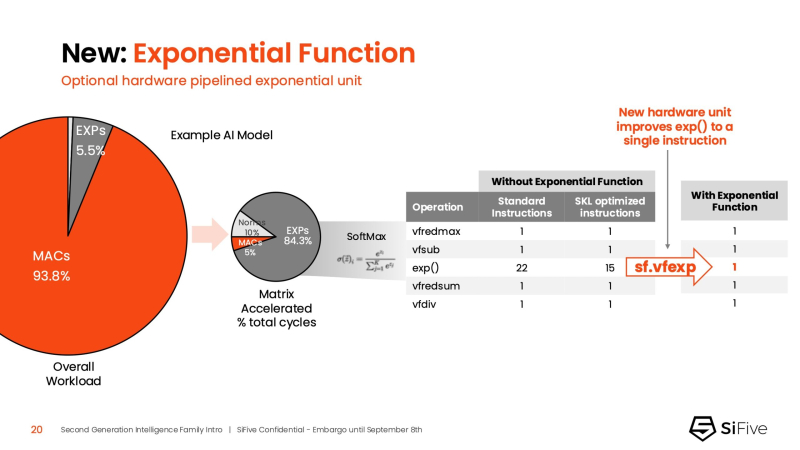

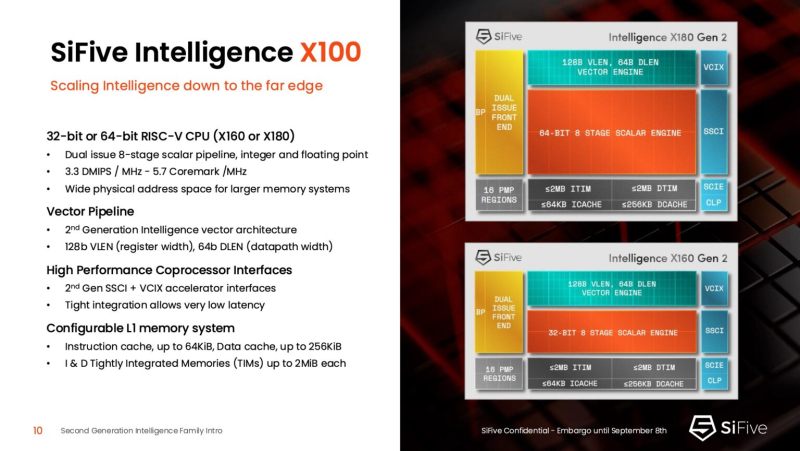

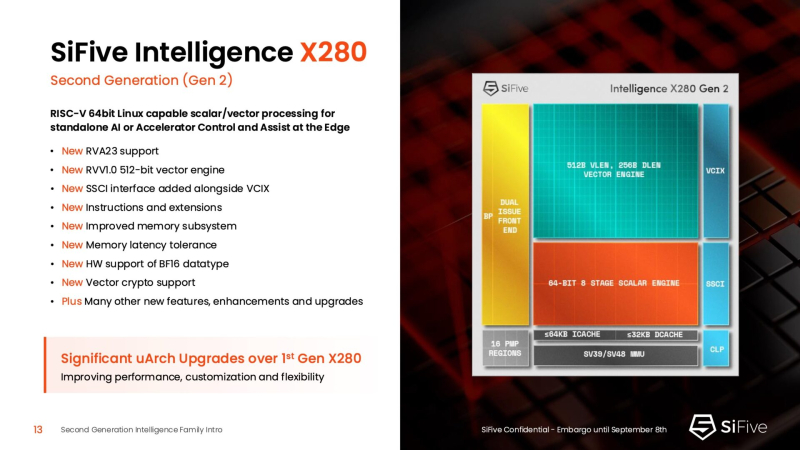

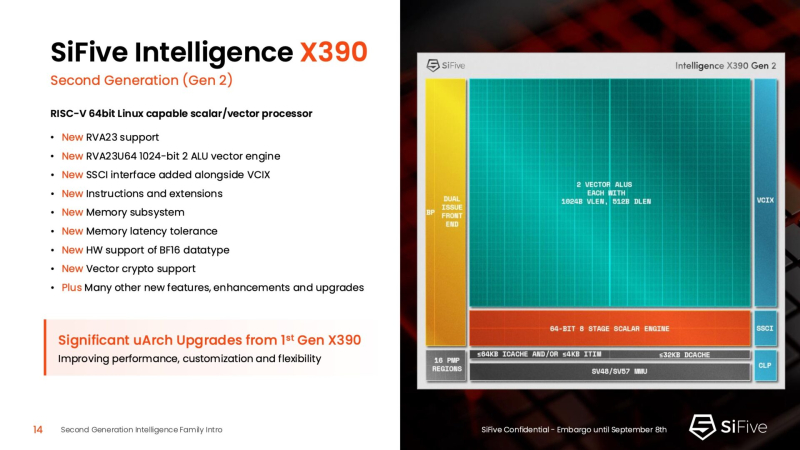

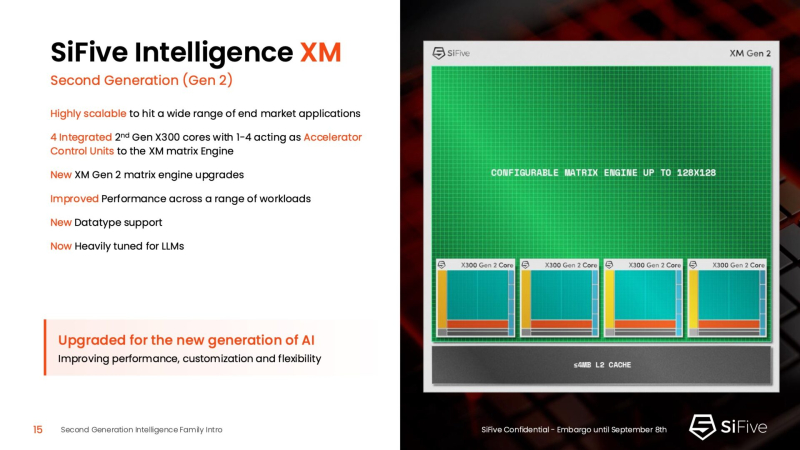

Быстрее и «умнее»: SiFive представила второе поколени RISC-V-ядер IntelligentSiFive представила семейство ядер Intelligent второго поколения с архитектурой RISC-V, включающее новые ядра X160 Gen 2 и X180 Gen 2, а также обновлённые решения X280 Gen 2, X390 Gen 2 и XM Gen 2. Новые решения разработаны для расширения возможностей скалярной, векторной и, в случае серии XM, матричной обработки данных, адаптированных для современных задач в сфере ИИ. Как отметил ресурс EE Times, анонсируя новую линейку продуктов, SiFive стремится воспользоваться быстрорастущим спросом на решения для обработки ИИ-нагрузок, который, по прогнозам Deloitte, вырастет как минимум на 20 % во всех технологических средах, включая впечатляющий скачок на 78 % в сфере периферийных вычислений с использованием ИИ. Ядра SiFive второго поколения позволяют решать критически важные задачи в области внедрения ИИ, в частности, в области управления памятью и ускорения нелинейных функций. Ключевым нововведением в процессорах серии X является их способность функционировать в качестве блока управления ускорителем (ACU). Это позволяет ядрам SiFive обеспечивать основные функции управления и поддержки для ускорителя заказчика через интерфейсы SiFive Scalar Coprocessor Interface (SSCI) и Vector Coprocessor Interface eXtension (VCIX). Данная архитектура позволяет заказчикам сосредоточиться на инновациях в обработке данных на уровне платформы, оптимизируя программный стек. Джон Симпсон (John Simpson), главный архитектор SiFive, сообщил ресурсу EE Times, что интеллектуальные ядра SiFive обеспечивают гибкость, сокращают трафик системной шины за счёт локальной обработки на чипе ускорителя и обеспечивают более тесную связь для задач пред- и постобработки. Он рассказал, что SiFive представила два важных усовершенствования в архитектуре, которые напрямую устраняют узкие места производительности: устойчивость к задержкам памяти и более эффективную подсистему памяти. Функцию Memory Latency Tolerance позволяет снизить задержку загрузки. Симпсон рассказал, что блок скалярных вычислений, обрабатывающий все инструкции, отправляет векторные инструкции в очередь векторных команд (VCQ). При обнаружении такого инструкции одновременно отправляется запрос в подсистему памяти (кеш L2 или выше). Ранняя отправка запросов, отделённая от исполнения, позволяет быстрее получить ответ от памяти и поместить его в переупорядочиваемую настраиваемую очередь загрузки векторных данных (VLDQ). Это гарантирует готовность данных к моменту, когда инструкция в конечном итоге покинет VCQ, что приводит к «загрузке вектора в течение одного цикла». Симпсон подчеркнул конкурентное преимущество решения, отметив: «Xeon, представленный на Hot Chips, может обслуживать 128 невыполненных запросов, и это топовый показатель для Xeon, а в нашем четырёхъядерном процессоре этот показатель составляет 1024». Эта «прекрасная технология» обеспечивает непрерывную обработку данных, эффективно предотвращая простои конвейера. Более эффективная подсистема памяти, которая представляет собой ещё одно существенное обновление, основана на переходе от инклюзивной к неинклюзивной иерархии кешей. В инклюзивной системе кеширования предыдущего поколения данные из общего кеша L3 реплицировались в частные кеши L1/L2, что компания посчитала неэффективным расходом «кремния». Конструкция ядер второго поколения исключает копирование, что, по словам Симпсона, даёт «в 1,5 раза большую производительность по сравнению с первым поколением» при меньшей занимаемой площади на кристалле. SiFive также интегрировала новый аппаратный конвейерный экспоненциальный блок. В то время как MAC-операции доминируют в рабочих ИИ-нагрузках, возведение в степень становится следующим серьёзным узким местом. Например, в BERT LLM, ускоренных матричным движком, операции softmax, включающие возведение в степень, занимают более 50 % оставшихся циклов. Программными оптимизациями SiFive сократила выполнение функции возведения в степень с 22 до 15 циклов, а новый аппаратный блок сокращает её до одной инструкции, уменьшая общее время выполнения функции до пяти циклов. Программный стек для семейства Intelligence второго поколения поддерживает масштабируемость. В серии XM среда выполнения машинного обучения уже распределяет рабочие нагрузки между несколькими кластерами XM на одном кристалле. Впрочем, пока масштабирование за пределы одного кристалла требует дальнейшей разработки библиотеки межпроцессорного взаимодействия (IPC). Флагманские решения X160 Gen 2 и X180 Gen 2 могут быть настроены для работы под управлением операционной системы реального времени, пишет SiliconANGLE. 32-бит IP-ядро Intelligence X160 разработано для оптимизации энергоэффективности и приложений с жесткими ограничениями по площади кристалла, в то время как 64-бит IP-ядро Intelligence X180 обеспечивает более высокую производительность и лучшую интеграцию с более крупными подсистемами памяти, сообщил ресурс CNX-Software. X160 поставляется с кеш-памятью объёмом до 200 КиБ и памятью объёмом 2 МиБ. Помимо промышленного оборудования, ядро может найти применение в потребительских устройствах, таких как фитнес-трекеры. Кроме того, X160 можно установить в системах с несколькими ИИ-ускорителями для управления чипами и предотвращения изменения прошивки. Благодаря двум встроенным кешам общей ёмкостью более 4 МиБ ядро позволяет работать с большим объёмом данных. По данным SiFive, X160 подходит для обучения ИИ-моделей и использования в оборудовании ЦОД. В свою очередь, ядро X280 ориентировано на потребительские устройства, такие как гарнитуры дополненной реальности, а X390 также может использоваться в автомобилях и инфраструктурных системах. Последнее ядро выполняет векторную обработку в четыре раза быстрее, чем X280. Все пять продуктов Intelligence Gen 2 уже доступны для лицензирования, а появление первых чипов на их основе ожидается во II квартале 2026 года. SiFive сообщила, что два ведущих американских производителя полупроводников лицензировали новую серию X100 ещё до её публичного анонса. Они используют IP-ядро X100 в двух различных сценариях: одна компания задействует сочетание скалярного векторного ядра SiFive с матричным движком, выступающим в качестве блока управления ускорителем, а вторая использует векторный движок в качестве автономного ИИ-ускорителя.

08.09.2025 [19:09], Сергей Карасёв

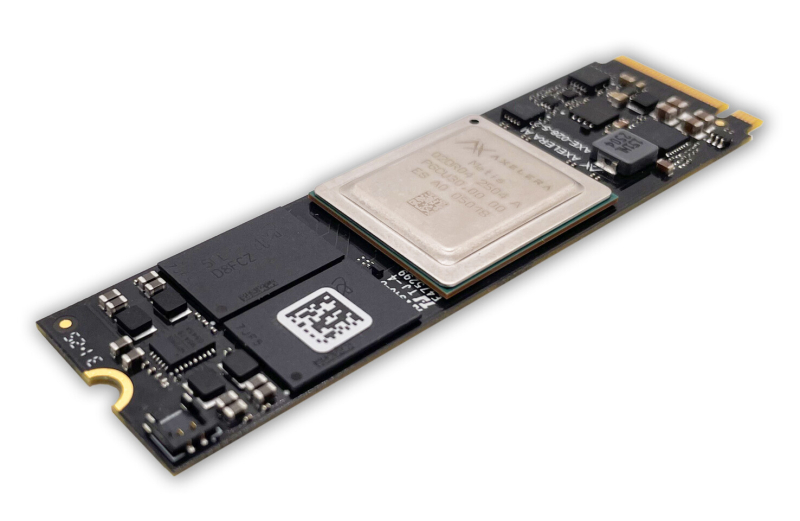

Axelera AI представила ускоритель Metis M.2 Max для ИИ-задач на периферииСтартап Axelera AI B.V. из Нидерландов анонсировал ускоритель Metis M.2 Max, предназначенный для ИИ-инференса на периферии. Новинка может использоваться, в частности, для работы с большими языковыми моделями (LLM) и визуально-языковыми моделями (VLM). Metis M.2 Max представляет собой улучшенную версию изделия Metis M.2, дебютировавшего в 2023 году. В основу положен чип Axelera Metis AIPU, содержащий четыре ядра с открытой архитектурой RISC-V: ИИ-производительность достигает 214 TOPS на операциях INT8. Ускорители выполнены в форм-факторе M.2 2280, а для обмена данными служит интерфейс PCIe 3.0 x4. У модели Metis M.2 Max по сравнению с оригинальной версией в два раза повысилась пропускная способность памяти (точные значения не приводятся). Её объём в зависимости от модификации составляет 1, 4, 8 или 16 Гбайт. Реализованы расширенные средства обеспечения безопасности, включая защиту целостности прошивки. Новинка будет предлагаться в вариантах со стандартным и расширенным диапазоном рабочих температур: в первом случае он простирается от -20 до +70 °C, во втором — от -40 до +85 °C. Благодаря этому, как утверждается, Metis M.2 Max подходит для применения в самых разных областях, в том числе в промышленном секторе, розничной торговле, в сферах здравоохранения и общественной безопасности и пр. Разработчикам компания Axelera AI предлагает комплект Voyager SDK, который позволяет полностью раскрыть потенциал чипа Metis AIPU и упрощает развёртывание коммерческих приложений. Продажи ИИ-ускорителя Metis M.2 Max начнутся в IV квартале текущего года. Устройство будет поставляться отдельно и в комплекте с опциональным низкопрофильным радиатором охлаждения.

03.09.2025 [18:03], Руслан Авдеев

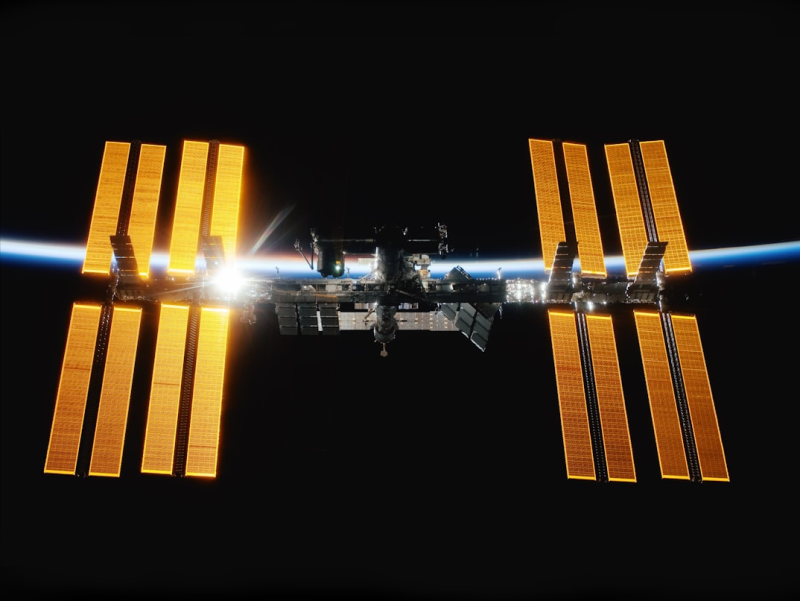

Прототип орбитального ЦОД Axiom Space и Red Hat для экспериментов с периферийными вычислениями прибыл на МКС24 августа Axiom Space и Red Hat отправили на МКС прототип орбитального ЦОД, который уже прибыл на станцию в составе 33-й коммерческой грузовой миссии SpaceX, сообщает Datacenter Knowledge. Целью эксперимента является проверка возможности автономной работы современной вычислительной инфраструктуры в космосе, не полагаясь на зависимость от дорогих спутниковых каналов связи. Новое решение оснащено модулем Axiom Space AxDCU-1, работающем на платформе Red Hat Device Edge, специально разработанной для сред с ограниченными ресурсами. Система использует облегчённый вариант Kubernetes-окружения — платформу Red Hat MicroShift, дающую возможность запускать контейнеризированные рабочие нагрузки в космосе. Задачи выполняются в контейнерах, которые можно удалённо обновлять с Земли. Ключевая особенность системы — её способность работать автономно, без постоянной связи, самостоятельно справляясь с длительными перерывами в коммуникации, которые возникают из-за быстрого движения МКС по орбите. Red Hat Device Edge решает проблему с помощью автоматического отката состояния и функций самовосстановления без вмешательства человека, а также встроенного мониторинга работоспособности и производительности. Для экономии трафика используют дельта-обновления ПО. Сообщается, что дефицит сетевых и вычислительных ресурсов всегда был проблемой на МКС, многие годы было трудно анализировать и передавать данные в режиме реального времени. Орбитальный ЦОД поможет решить эту проблему, с локальной обработкой информации и отправкой на Землю уже готовых результатов. Предполагается, что полезнее всего это будет для экспериментов в сфере естественных наук и биомедицины. В ходе таких исследований часто генерируются большие объёмы данных, но необходимость передавать их на Землю может привести к потерям более ценной и срочной информации. Axiom Space разрабатывает и собственную коммерческую станцию, которая будет оснащена значительными по меркам космоса вычислительными мощностями. По мере развития новой станции будет расти и потребность в масштабируемых, независимых вычислительных средах. «Контейнерный» подход предназначен для поддержки периферийного ИИ, автоматизации и поддержки критически важного ПО на будущих платформах. Впрочем, инновации для космоса найдут место и на Земле, где тоже немало мест с экстремальными условиями. По словам представителя компании-разработчика, извлекаемые «уроки» приносят прямую пользу — повышение надёжности критической инфраструктуры, развитие автономных систем, периферийного ИИ и др. для удалённых или ограниченных в ресурсах регионах напрямую способствуют улучшению качества жизни на Земле. |

|