Материалы по тегу: samsung

|

16.01.2025 [16:16], Руслан Авдеев

США вводят очередные ограничения на выпуск и экспорт современных чиповМинистерство торговли США вводит новый пакет экспортных ограничений, призванных помешать Китаю и другим странам закупать передовые чипы, сообщает Silicon Angle. В частности, ограничения коснутся предприятий, выпускающих микросхемы, а также работающих по заказу других организаций. Так, новые меры коснутся TSMC и Samsung Electronics, а также упаковщиков чипов, включая ту же TSMC. Новые правила предусматривают получение производителями чипов и упаковщиками полупроводников лицензий на экспорт «определённых передовых чипов» в ряд регионов. Власти откажутся от подобных требований, если производитель чипов получит технические аттестации от доверенных участников цепочек поставок. Так, разработчики чипов могут получить от американских властей статус «одобренных» или «авторизованных». Если разработчик подтверждает, что его чипы не достигают по своим характеристикам установленных США порогов производительности, лицензионные требования к ним отменяются. То же касается фабрик и компаний-упаковщиков. Если характеристики производимых чипов не превышают определённого порога, новые экспортные ограничения не применяются. Объявлено и о ряде других нормативных изменений. В частности, запускается процесс утверждения компаний в перечне одобренных дизайн-центров и поставщиков чипов и услуг OSAT (Outsourced Semiconductor Assembly and Test). Также оптимизированы процедуры раскрытия информации в случаях, если производитель принимает заказ клиента, потенциально способного перенаправить продукцию в Китай. В связи с новыми правилами в чёрный список Entity List отправятся 16 новых организаций, включая некоторые ИИ-компании, поддерживающие развитие производства передовых чипов в Китае. Одной из таких компаний стала Sophgo — в прошлом году выяснилось, что она якобы передала выпущенную для неё продукцию компании Huawei, давно пребывающей в американском чёрном списке, после чего TSMC прекратила выполнение её заказов и поставки. Министерство торговли вводит новые правила всего через несколько дней после того, как администрация уходящего президента США ввела глобальные ограничения на поставки ИИ-чипов и передовых моделей ИИ. Ранее американские власти уже вводили санкции, ограничивающие возможности китайской полупроводниковой индустрии. Речь идёт о закупках чипов NVIDIA, памяти HBM и других компонентов. Не щадят и союзников. Нидерландской ASML запрещено поставлять в КНР оборудование для DUV-литографии, на котором можно изготавливать 5- и 7-нм полупроводники.

03.12.2024 [13:34], Руслан Авдеев

Бывший завод Samsung в Калуге задействовали для сборки серверов «Гравитон»В Калуге бывший завод Samsung перепрофилировали. По данным «Ведомостей», теперь объект арендован российским дистрибутором VVP Group и на нём уже стартовал сбор серверов под брендом «Гравитон». Впрочем, официальных сведений о выпуске серверов «Гравитон» на данном заводе пока нет — представители бренда не комментируют новость, а VVP Group не отвечает на запрос журналистов. В своё время на калужском заводе Samsung выпускала все телевизоры и мониторы для российского рынка. Оттуда же шли поставки в Казахстан, Молдавию, Монголию, Азербайджан, Армению, Белоруссию и Грузию. После заморозки компанией поставок комплектующих в Россию в 2022 году были приостановлены и поставки компонентов на собственный завод. В 2024 году подразделение ООО «Самсунг электроникс рус Калуга», владеющее объектом, передало его в аренду VVP Group, последняя сначала наладила сдачу помещений в субаренду, а потом запустила первое контрактное производство телевизоров для «М.Видео-Эльдорадо». По оценкам экспертов речь может идти о выпуске до полумиллиона единиц продукции в год, благодаря чему завод вернётся к полной загрузке мощностей.

Источник изображения: Homa Appliances/unsplash.com По данным самой «Гравитон», под соответствующим брендом сейчас выпускается по 20 тыс. серверов на собственных объектах, дополнительно «Гравитон» с лета 2024 года заказывает выпуск на сторонней площадке OpenYard, расположенной в Рязанской области. Всего запланировано выпускать более 50 тыс. плат для клиентских устройств и серверного оборудования. В сентябре «Гравитон» стал заказывать выпуск мониторов и печатных плат под своим брендом (тоже для мониторов). Пробная партия составила 1 тыс. мониторов, а до конца I квартала следующего года предполагается выпустить 60 тыс. изделий. Бренд «Гравитон» принадлежит ООО «Революционные технологии», по 50 % которого находятся в собственности у Александра Башлыкова и вендора 3Logic Group (ООО «Новый ай ти проект»). В 2022 году зарубежные производители серверов начали покидать Россию и многие продукты доступны лишь через параллельный импорт, из-за чего возник дефицит. По мнению экспертов для компенсации дефицита нужны объёмные поставки компонентов от процессоров до материнских плат и систем охлаждения, а также глубокая интеграция оборудования с ПО. В 2023 году российский рынок серверов составил около 150 млрд руб., но в текущем году он, вероятно, вырастет ещё на 10 %.

30.08.2024 [13:39], Руслан Авдеев

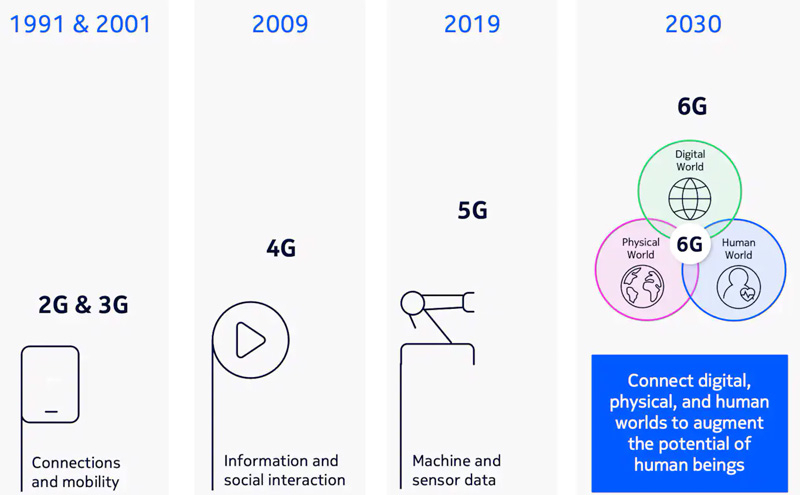

Nokia опровергла слухи о продаже Samsung подразделения, занимающегося оборудованием для мобильной связиАктивы Nokia, связанные с оборудованием для мобильных сетей, вызывают интерес у многих компаний, одной из которых является Samsung Electronics. По данным Bloomberg, не исключается, что ей продадут соответствующее подразделение — в самой Nokia якобы разочарованы перспективами мобильного бизнеса, не приносящего желанных результатов. Samsung от комментариев отказалась, а Nokia официально опровергла все слухи. Как сообщают источники издания, компания якобы обсуждает варианты развития бизнеса, связанного с мобильными сетями, включая его полную или частичную продажу, выделение подразделения в отдельную бизнес-структуру или создание совместного предприятия с конкурентами. Целиком подразделение оценивается в $10 млрд и к покупке некоторых активов уже проявила интерес Samsung, которая не против расширить свои возможности по созданию оборудования для мобильных сетей, пишет Bloomberg. Рыночная капитализация компании достигла в последние дни €22,3 млрд ($24,7 млрд), с начала года она выросла на 30 %. Хотя с развёртыванием 5G-сетей по всему миру компания получила мощный импульс, в последнее время спрос со стороны телеком-операторов начал снижаться, поэтому компания ищет новые направления бизнеса, не так сильно зависящие от потребностей мобильных компаний, и избавляется от непрофильных активов вроде Alcatel Submarine Networks (ASN). Когда-то Nokia была одним из лидеров на рынке мобильных телефонов, но была вынуждена продать свой бизнес, уступив первенство Apple и Samsung. С тех пор компания занимается в первую очередь оборудованием для сетей связи. В самой Samsung отказываются комментировать тему, а в Nokia выступили с развёрнутым опровержением возможной сделки. В компании опубликовали обращение, свидетельствующее о том, что она стремится к успеху направления мобильных сетей, которое для компании остаётся стратегическим и показывает хорошие результаты. В компании добавляют, что «анонсировать нечего» и никаких внутренних проектов на тему продажи бизнеса просто не существует. Напротив, компания увеличила оборот с уже существующими клиентами и даже привлекла новых. Подразделение Nokia, разрабатывающее и выпускающее оборудование для мобильных сетей, поставляет клиентам со всего мира базовые станции, серверы и разнообразные решения для систем радиосвязи. На него приходится 44 % выручки компании за прошлый год — фактически это крупнейший сегмент Nokia. Тем не менее, как утверждает издание, в последнее время бизнес страдает, поскольку мобильные операторы, особенно в Европе, откладывают дорогостоящие апгрейды своих мобильных сетей. Власти западных стран чрезвычайно обеспокоены доминированием Huawei в сфере телекоммуникационного оборудования и отсутствием у китайского гиганта сильных соперников. Вашингтон бьёт тревогу, утверждая, что Пекин может использовать оборудование Huawei для шпионажа, поскольку компания успешно внедряет его по всему миру. Возможное сотрудничество Nokia и Huawei сорвалось из-за трений между США и Китаем. При этом Nokia сама является крупным поставщиком оборудования для мобильной связи в Китае.

Источник изображения: Nokia Хотя в Nokia и отрицают вероятность сделки, возможное объединение мобильного бизнеса Nokia с соответствующим подразделением одного из конкурентов потенциально позволяет создать сильную структуру, способную лучше конкурировать в сфере новых технологий. Выбор у операторов связи невелик, поскольку предложений на рынке немного. Samsung также занимается выпуском телеком-оборудования для мобильной связи, но масштабы внедрения слишком малы в сравнении с Nokia, Huawei и Ericsson. Чувствительный удар Nokia нанесли в прошлом году, когда американский оператор AT&T выбрал Ericsson для контракта на $14 млрд. При этом в Nokia заявляют, что являются единственной компанией в мире за пределами Китая, способной поставлять все ключевые компоненты мобильной сетевой инфраструктуры, от ПО для ядра сети до всех аппаратных элементов, причём как для мобильной, так и для наземной связи. Компания отмечает рост в подразделении, занимающимся оборудованием для кабельных сетей. В июне компания согласилась приобрести американскую Infinera за $2,3 млрд, сделав ставку на бум ИИ-технологий. Бизнес Infinera чрезвычайно интересен Nokia, поскольку располагает технологиями для обеспечения связи в ЦОД. Ожидается, что этот сектор будет одним из самых быстрорастущих на телеком-рынке. Это крупнейшая сделка Nokia с момента покупки за €10,6 млрд компании Alcatel-Lucent в 2016 году.

27.08.2024 [17:46], Руслан Авдеев

ИИ-ускорители Rebellions Rebel Quad получат 144 Гбайт памяти Samsung HBM3eЮжнокорейский стартап Rebellions представила на днях план развития своих ИИ-ускорителей. Как сообщает Business Korea, компания ускорит выпуск ИИ-чипов нового поколения, которые получат 4-нм модули памяти HBM3e производства Samsung. Samsung же будет отвечать за объединение чипов и HBM в одной упаковке. Изначально к концу 2024 года планировалось наладить выпуск продукта Rebel Single с одним модулем памяти, но потом было решено выпустить гораздо более производительный вариант Rebel Quad с четырьмя 12-слойными (12-Hi) модулями HBM3e суммарной ёмкостью 144 Гбайт, тоже к концу текущего года. Новинка придёт на смену ускорителю ATOM, который оснащён всего лишь 16 Гбайт GDDR6. Использование ёмкой и быстрой HBM3e-памяти считается одним из главных преимуществ Rebel Quad, по этому показателю новинки сравнимы с последними ускорители NVIDIA семейства Blackwell. При этом обещано, что новинки будут значительно энергоэффективнее решений NVIDIA и даже ускорителей Groq. Это по-прежнему серверные ускорители для обработки LLM вроде ChatGPT, но подойдут ли они для обучения ИИ-моделей, пока не уточняется. Сейчас Rebellions ориентируется на поставки комплексных ИИ-решений «стоечного уровня». В рамках концепуии Rebellion Scalable Design (RDS) будет предложены программно-аппаратные комплексы, которые позволят органично взаимодействовать многочисленным ускорителями и серверам с максимальной производительностью и энергоэффективностью. Речь идёт о решении, теоретически способном конкурировать с NVIDIA CUDA.

09.08.2024 [22:50], Алексей Степин

Звание самого быстрого SSD перешло к Samsung PM1753На мероприятии FMS 2024 компания Samsung показала новые серверные SSD PM1753 и BM1743. Последний был ансонирован месяц назад, а на FMS был впервые показана модификация объёмом 128 Тбайт, ставшая достойным ответом решениям Solidigm, Pascari (Phison) и Western Digital.

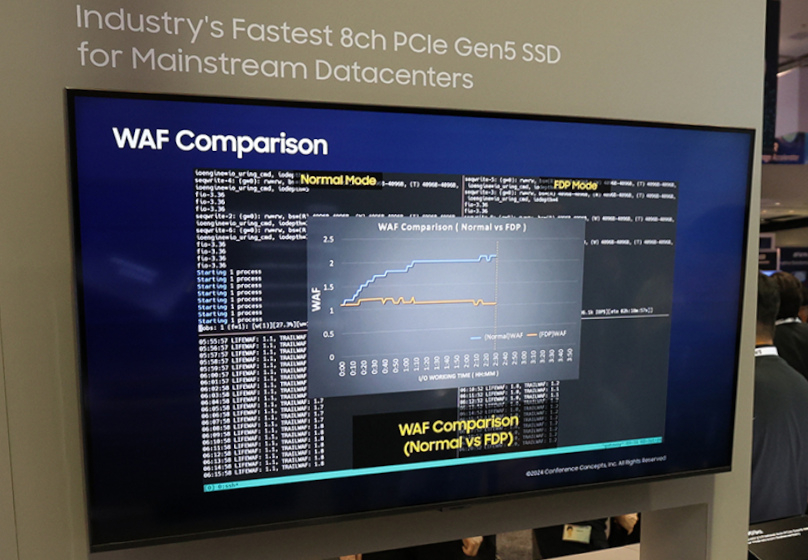

Источник изображений: Samsung Несмотря на использование QLC (v7 vNAND), у BM1743 достаточно высокие показатели производительности: линейные скорости чтения и записи составляют 7,5 Гбайт/с и 3,5 Гбайт/с соответственно. На случайных операциях SSD развивает 1,6 млн и 45 тыс IOPS. BM1743 использует форм-фактор U.2 и интерфейс PCIe 4.0, а с последними версиями прошивки он стал заметно экономичнее и потребляет в режиме простоя лишь около 2 Вт. Где-то в 2024–2026 гг. Samsung должна представить массовые решения объёмом 256 Тбайт, а в следующие за ним пару лет довести ёмкость и до 512 Тбайт. В последнем случае, как ожидается, накопители будут представлены исключительно в форм-факторе EDSFF E3.L. К 2035 году компания намеревается выпустить SSD объёмом 1 Пбайт. А вот Samsung PM1753 относится к совсем иному классу решений. Новинка ориентирована на ЦОД нового поколения с инфраструктурой PCI Express 5.0 и будет поставляться в форм-факторах U.2 и E3.S. Предельный объём здесь составляет 32 Тбайт, зато производительность благодаря 16-канальному контроллеру у него приличная: чтение 14,8 Гбайт/с, запись 11 Гбайт/с. Для случайных операций заявлены 3,4 млн и 600 тыс IOPS соответственно. Таким образом, меньше чем за месяц звание самого быстрого SSD перешло от Micron 9550 к Solidigm D7-PS1010, а теперь и к Samsung PM1753, если, конечно, не учитывать формальный рекорд Kioxia CM7-R ещё двухлетней давности. В основе PM1753 лежит девятое поколение TLC V-NAND, обеспечивающее повышенную в 1,6–1,7 раза энергоэффективность в сравнении с решениями предыдущего поколения. В простое PM1753, как обещается, будет потреблять лишь 4 Ватта. Естественно, новинки ориентированы на современные ИИ-инфраструктуры.  Интересны и Samsung PM9D3a, представленные в форм-факторах M.2, U.2 и E1.S/E3.S 1T. В первом случае ёмкость ограничена значением 4 Тбайт, более крупные форматы включают в себя модели объёмом до 32 Тбайт. Они используют 8-канальный контроллер с PCIe 5.0, обеспечивающий при записи до 50 тыс IOPS на каждый Тбайт. Производительность при случайном чтении у этой новинки достигает 1,8 млн IOPS, линейные скорости чтения и записи составляют 12 Гбайт/с и 7 Гбайт/с, соответственно. PM9D3a являются первыми накопителями Samsung с технологией Flexible Data Placement (FDP), которая позволяет группировать данные для совместной записи по команде хоста. Эти накопители отличаются высокой гибкостью конфигурирования, улучшенной энергоэффективностью, предсказуемой и настраиваемой производительностью, а также низким TCO. Поэтому нацелены они в первую очередь на гиперскейлеров.

07.08.2024 [12:28], Руслан Авдеев

Китайские компании набивают склады HBM-памятью Samsung в ожидании новых американских санкцийКитайские техногиганты, включая игроков вроде Huawei и Baidu, а также стартапы активно запасают HBM-чипы Samsung Electronics. По данным агентства Reuters, это делается в ожидании новых ограничений со стороны США на поставки в КНР чипов, использующих американские технологии. Как сообщают источники издания, компании наращивают закупки соответствующих чипов ещё с начала 2024 года, на долю китайских покупателей придётся порядка 30 % выручки Samsung от продаж HBM в I половине 2024 года. Экстренные меры наглядно демонстрируют нежелание Китая отказываться от технологических амбиций даже на фоне торговых войн с США и их союзниками. Ранее Reuters сообщало, что американские власти намерены представить новые санкционные ограничения ещё до конца текущего месяца. Они призваны ограничить возможности китайской полупроводниковой индустрии. Источники сообщают, что в документах будут заданы и параметры для ограничений на поставки HBM-памяти. Министерство торговли США отказалось от комментариев, но на прошлой неделе заявило, что постоянно обновляет правила экспортного контроля для защиты национальной безопасности США и технологической экосистемы страны.

Источник изображения: Samsung HBM-чипы считаются критически важными компонентами при разработке передовых ИИ-ускорителей. Возможности выпуска HBM пока доступны только трём производителям: южнокорейским SK Hynix и Samsung, а также американской Micron Technology. По данным информаторов Reuters, в Китае особым спросом пользуется вариант HBM2E, который отстаёт от передового HBM3E. Глобальный бум ИИ-технологий привёл к дефициту наиболее передовых решений. По мнению экспертов, поскольку собственные китайские технологии в этой области ещё не слишком зрелые, спрос китайских компаний и организаций на сторонние HBM-чипы чрезвычайно велик, а Samsung оставалась единственной опцией, поскольку производственные мощности других производителей уже забронированы американскими ИИ-компаниями. Хотя объёмы и стоимость запасённых Китаем HBM-чипов оценить нелегко, известно, что они используются компаниями самого разного профиля, а Huawei, например, применяет Samsung HBM2E для выпуска передовых ИИ-ускорителей Ascend. Впрочем, Huawei и CXMT уже сфокусировали внимание на разработке чипов HBM2 — они на три поколения отстают от HBM3E. Тем не менее, американские санкции могут помешать новым китайским проектам. Более того, от них может больше пострадать Samsung, чем её ключевые соперники, которые меньше связаны с китайским рынком. Micron не продаёт HBM-чипы в Китай с прошлого года, а SK Hynix, чьими ключевыми клиентами являются компании вроде NVIDIA, специализируются на более современных решениях.

03.07.2024 [13:21], Сергей Карасёв

Samsung представила QLC SSD вместимостью 61,44 ТбайтКомпания Samsung анонсировала SSD корпоративного уровня BM1743. Накопитель, выполненный по технологии v7 QLC V-NAND, имеет вместимость 61,44 Тбайт. Новинка призвана составить конкуренцию изделию Solidigm D5-P5336 аналогичной ёмкости, которое дебютировало приблизительно год назад. Устройство Samsung BM1743 является преемником модели BM1733a, которая изготавливается по технологии v5 QLC V-NAND. Оба решения выполнены в SFF-стандарте U.2. Основной сферой применения названы дата-центры и облачные сервисы, в том числе связанные с ИИ-нагрузками.

Источник изображения: Samsung Благодаря использованию интерфейса PCIe 4.0 производительность новинки увеличена примерно в два раза по сравнению с предшественником. Скорость последовательного чтения информации достигает 7200 Мбайт/с, скорость последовательной записи — 2000 Мбайт/с. Показатель IOPS при работе с блоками данных по 4 Кбайт составляет до 1,6 млн при произвольном чтении и до 110 тыс. при произвольной записи. В SSD применяются 176-слойные флеш-чипы NAND. Устройство рассчитано на 0,26 полных перезаписи в сутки (показатель DWPD) на протяжении срока службы. Срок гарантированной сохранности данных при выключении питания увеличился с одного месяца до трёх в сравнении с решением предыдущего поколения. Говорится о подготовке варианта в формате E3.S с поддержкой PCIe 5.0. Кроме того, в перспективе свет увидит модификация вместимостью 122,88 Тбайт.

22.06.2024 [15:01], Сергей Карасёв

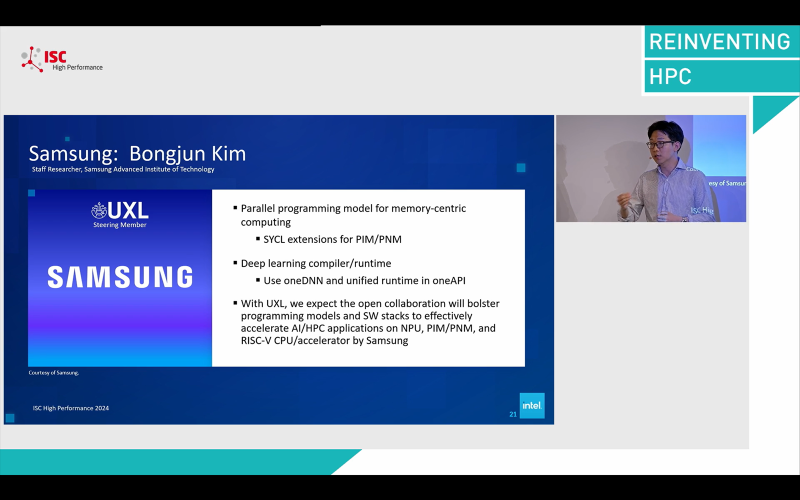

Samsung случайно упомянула о разработке RISC-V чипа для ИИ-задачВ ходе конференции ISC 2024 компания Samsung, по сообщению HPC Wire, намекнула на разработку некоего чипа на открытой архитектуре RISC-V. Предполагается, что это изделие будет использоваться при решении задач, связанных с ИИ и НРС. На одном из продемонстрированных южнокорейским производителем слайдов упоминается изделие CPU/ИИ-ускоритель на базе RISC-V («RISC-V CPU/AI accelerator from Samsung»). О чём именно идёт речь, сказать трудно. Возможно, Samsung проектирует процессор RISC-V с нейромодулем для ускорения ИИ-операций. С другой стороны, это может быть самостоятельный чип, предназначенный для работы в связке с ИИ-ускорителем. Например, Google уже использует RISC-V процессоры SiFive вместе со своим TPU. Отмечается, что слайд был показан на сессии ISC 2024, посвящённой инициативе UXL Foundation (Unified Acceleration Foundation). Целью данного проекта является создание универсального открытого ПО, которое позволит разработчикам ИИ-решений отказаться от CUDA и использовать ускорители других производителей. В состав UXL входят Intel, Qualcomm, Samsung, Arm и Google. На слайде также упоминается модель параллельного программирования в контексте вычислений в памяти. Данная концепция позволяет повысить производительность, в том числе при обучении ИИ-моделей. Ранее Samsung и AMD представили экспериментальный ИИ-суперкомпьютер, скрестив «вычислительную» память HBM-PIM и ускорители Instinct MI100. Кроме того, Samsung работает над похожей концепцией PNM (processing-near-memory), которая будет использоваться в модулях памяти CXL. Samsung также работает над собственными ИИ-ускорителями Mach-1, которые уже заказала ведущая южнокорейская интернет-компания Naver. По заявлениям Samsung, изделие Mach-1 позволяет выполнять инференс больших языковых моделей (LLM) даже с маломощной памятью. Таким образом, есть вероятность, что новый RISC-V-процессор Samsung сможет работать в связке с ИИ-ускорителями компании для максимизации производительности.

23.04.2024 [11:45], Сергей Карасёв

Samsung откроет в Кремниевой долине лабораторию по созданию ИИ-чипов на базе RISC-V, чтобы побороться с NVIDIAКомпания Samsung Electronics, по сообщению ресурса Business Korea, откроет новую научно-исследовательскую и опытно-конструкторскую (R&D) лабораторию в Кремниевой долине. Её специалисты займутся прежде всего созданием ИИ-чипов на открытой архитектуре RISC-V. По имеющейся информации, Технологический институт Samsung SAIT (Samsung Advanced Institute of Technology) учредил исследовательский центр Advanced Processor Lab (APL). Южнокорейская компания намерена расширить свои возможности в области разработки ИИ-решений, чтобы в перспективе бросить вызов американским корпорациям, в числе которых называется NVIDIA. Около месяца назад Samsung сформировала лабораторию Semiconductor AGI Computing Lab, сотрудники которой разрабатывают чипы следующего поколения для ИИ-приложений. Офисы данного подразделения располагаются в Южной Корее и США. Основным направлением исследований являются системы «общего искусственного интеллекта» (Artificial General Intelligence, AGI). В заявлении в LinkedIn глава Samsung Semiconductor Ке Хён Гён (Kye Hyun Kyung) отметил, что на первом этапе лаборатория сосредоточит усилия на разработке чипов для больших языковых моделей (LLM), тогда как реализация проектов в области AGI начнётся позднее.

Источник изображения: pixabay.com Между тем власти США в рамках «Закона о чипах» выделили Samsung $6,4 млрд безвозвратных субсидий на строительство предприятий в Техасе. По условиям соглашения, в городе Тейлоре будут построены два завода по выпуску полупроводниковых изделий с нормами 4 и 2 нм. «Мы считаем, что полупроводниковые технологии нового поколения, созданные с использованием ИИ и компьютерной техники, сыграют ключевую роль в повышении качества жизни. Именно поэтому SAIT тесно сотрудничает с учёными и экспертами в поисках новых долгосрочных драйверов роста для Samsung», — говорит Гёйонг Джин (Gyoyoung Jin), президент SAIT.

08.04.2024 [09:48], Сергей Карасёв

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели. |

|